Lernpfad

Snowflake ist eine cloudbasierte Datenplattform, die die grundlegenden Herausforderungen des modernen Datenmanagements angeht. Sie wurde 2014 eingeführt und bietet Unternehmen eine zentrale Lösung für die Speicherung und Verarbeitung großer Datenmengen.

Herkömmliche Datenmanagementsysteme stellen Unternehmen oft vor erhebliche Einschränkungen. Bei diesen Systemen müssen die Unternehmen in der Regel zwischen Abfrageleistung, gleichzeitigem Benutzerzugriff und Kosteneffizienz wählen. Die Architektur von Snowflake wurde entwickelt, um diese Einschränkungen durch ihren Ansatz zur Datenspeicherung und -berechnung zu beseitigen.

In diesem Leitfaden werden der architektonische Rahmen und die operativen Mechanismen von Snowflake untersucht. Obwohl die Plattform komplexe Technologien beinhaltet, konzentriert sich diese Erklärung darauf, diese Konzepte für Leser mit einem grundlegenden Verständnis von Datensystemen zugänglich zu machen.

Der Leitfaden behandelt:

- Die Grundprinzipien des Datenspeichersystems von Snowflake

- Die architektonischen Komponenten, die seine Infrastruktur bilden

- Der Ansatz der Plattform für gleichzeitigen Datenzugriff

- Die technischen Vorteile, die seine Einführung vorantreiben

Diese Analyse vermittelt dir ein grundlegendes Verständnis dafür, wie Snowflake in einer modernen Dateninfrastruktur funktioniert.

Für Leser, die Snowflake noch nicht kennen, ist die Einführung in Snowflake für Einsteiger vermittelt wichtiges Hintergrundwissen.

Kernkonzepte der Snowflake-Architektur

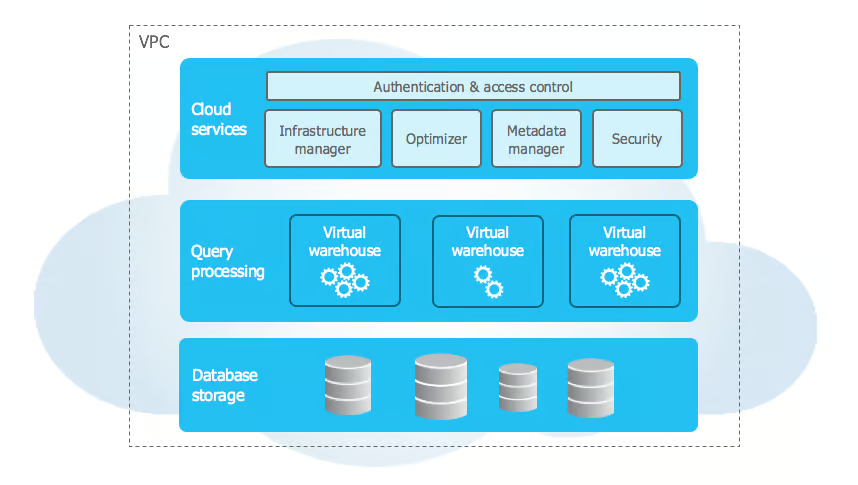

Die Architektur von Snowflake unterscheidet sich von traditionellen Data Warehouse durch die Nutzung moderner Cloud-Prinzipien zur Lösung von Skalierbarkeits- und Leistungsproblemen. Die Architektur implementiert einen mehrschichtigen Ansatz, der Speicher, Rechenleistung und Dienste in separate, aber miteinander verbundene Komponenten aufteilt.

Snowflake Architektur Schichten

Quelle: Snowflake Dokumentation

Die Architektur von Snowflake basiert auf einem einzigartigen Drei-Schichten-Design, das die Kernfunktionen voneinander trennt und gleichzeitig eine nahtlose Integration ermöglicht. Schauen wir uns jede Ebene im Detail an:

1. Speicherschicht

Die Speicherebene von Snowflake stützt sich auf Cloud Object Storage (Amazon S3, Azure Blob Storageoder Google Cloud Storage) und organisiert die Daten in unveränderlichen Mikropartitionen (50-500 MB) in einem komprimierten Spaltenformat. Diese Mikropartitionen speichern Metadaten wie Min/Max-Spaltenwerte und ermöglichen so ein effizientes Abfragepruning.

Diese Schicht ist selbstoptimierend und erfordert keine manuelle Wartung. Sie wählt auf intelligente Weise den besten Komprimierungsalgorithmus pro Spalte auf der Grundlage von Datentyp und -mustern aus und sorgt so für hohe Komprimierungsraten und schnelle analytische Abfragen, indem sie nur die notwendigen Spalten liest.

2. Compute-Schicht

Die Rechenschicht besteht aus virtuellen Lagern - unabhängigen MPP-Clustern, die SQL-Abfragen und DML-Operationen ausführen. Jedes Lagerhaus betreibt mehrere Knotenpunkte parallel und arbeitet völlig isoliert, um Leistungsstörungen zu vermeiden.

Diese zustandslosen Ressourcen können gestartet, gestoppt, in der Größe verändert oder geklont werden, ohne dass die Daten davon betroffen sind. Durch die Größenanpassung wird die Arbeitslast automatisch umverteilt, während die Funktion zur automatischen Unterbrechung inaktive Lager pausiert und bei Bedarf innerhalb von Sekunden wieder aufnimmt.

3. Dienstleistungsebene

Die Serviceschicht orchestriert den Betrieb von Snowflake und verwaltet einen verteilten Metadatenspeicher, der Tabellen, Ansichten, Sicherheitsrichtlinien und Abfragen verfolgt. Der Query Optimizer nutzt diese Metadaten, um effiziente Ausführungspläne auf der Grundlage der Datenverteilung, der Rechenressourcen und der Zugriffsmuster zu erstellen.

Sie gewährleistet ACID-Konformität mit fortschrittlicher Gleichzeitigkeitskontrolle, während die Authentifizierung über SSO, MFA und rollenbasierte Zugriffskontrolle auf allen Ebenen erfolgt. Diese Schicht verwaltet auch die Sitzungsverwaltung und die Durchsetzung der Sicherheit.

Wie die Schichten zusammenarbeiten

Die Interaktion zwischen den Snowflake-Schichten ermöglicht leistungsstarke Funktionen wie sichere Datenfreigabe, Multi-Cluster-Computing und dynamische Skalierbarkeit. Die gemeinsame Nutzung von Daten ist metadatengesteuert - es werden nur Zeiger ausgetauscht, während der Zugriff mit feinkörnigen Sicherheitsrichtlinien kontrolliert wird. Verbraucher können gemeinsam genutzte Daten mit ihren eigenen Rechenressourcen abfragen, ohne sie zu duplizieren.

Multicluster-Computing ermöglicht es unabhängigen Rechenclustern, auf dieselbe Speicherebene zuzugreifen und gleichzeitig getrennte Caches zu unterhalten und die Konsistenz zu gewährleisten. Workloads können isoliert werden, indem Warehouses für ETL, BI oder Data Science reserviert werden. Die Architektur von Snowflake unterstützt auch dynamische Skalierbarkeit, so dass Speicher und Rechenleistung unabhängig voneinander skaliert werden können, während die Dienstebene die Ressourcenzuweisung und die Abfrageleistung optimiert.

Wenn du tiefer in diese Konzepte und mehr eintauchen möchtest, kannst du dir den Kurs Einführung in Snowflake.

Snowflake's Data Warehouse Architektur

Die Data-Warehouse-Architektur von Snowflake basiert auf einem dreischichtigen Design, das eine flexible Datenmodellierung und eine effiziente Abfrageverarbeitung ermöglicht. Sie unterstützt strukturierte und halbstrukturierte Daten, optimiert die Leistung und vereinfacht die Verwaltung.

Datenmodell

Snowflake verarbeitet strukturierte Daten mit Hilfe von relationalen Datenbankkonzepten und unterstützt SQL-Datentypen, Constraints und Beziehungen durch Primär- und Fremdschlüssel. Sensible Informationen profitieren von der Verschlüsselung auf Spaltenebene. Für semi-strukturierte Daten verarbeitet Snowflake nativ JSON, XML, Parquet und Avro mit dem Datentyp VARIANT, leitet automatisch Schemata ab und ermöglicht effiziente Abfragen mit speziellen Funktionen wie FLATTEN und PARSE_JSON.

Auf der Speicherebene werden die Daten automatisch in 50-500 MB große Mikropartitionen unterteilt, die jeweils Metadaten wie Min/Max-Spaltenwerte und Nullhäufigkeiten speichern. Snowflake verfolgt die natürliche Clusterbildung und reorganisiert die Daten regelmäßig, um die Abfrageeffizienz zu verbessern, sodass eine manuelle Partitionsverwaltung überflüssig wird.

Architektur der Abfrageverarbeitung

Snowflake verarbeitet Abfragen durch mehrere koordinierte Schichten, die die Ausführung optimieren. Der Query Optimizer wandelt SQL-Abfragen in logische Ausführungspläne um und wertet mehrere physische Pläne auf der Grundlage von Tabellengröße, Indizierung und Caching aus. Mithilfe eines Kostenmodells wählt es den effizientesten Ansatz aus und bestimmt Join-Algorithmen, Sortiermethoden und Datenverschiebungsstrategien.

Die Ausführungsmaschine verteilt die Abfragen auf parallele Verarbeitungsknoten. Durch die Nutzung von Metadaten werden unnötige Partitionen entfernt und nur relevante Spalten im Snowflake-Spaltenformat gelesen, was die Effizienz erhöht. Ein 24-Stunden-Ergebnis-Cache verbessert die Leistung weiter, indem er bereits berechnete Abfrageergebnisse wiederverwendet, wenn die zugrunde liegenden Daten unverändert bleiben.

Die Architektur von Snowflake ermöglicht effiziente Datenzugriffsmuster. Das Null-Kopie-Klonen ermöglicht die sofortige Duplizierung von Tabellen, ohne dass Daten kopiert werden müssen, während die Zeitreise historische Versionen für Point-in-Time-Abfragen bewahrt. Die Multi-Versions-Concurrency-Control (MVCC) sorgt für die Konsistenz der Transaktionen und ermöglicht so Workloads mit hoher Parallelität ohne Sperrkonflikte. Diese Optimierungen in Kombination mit intelligentem Caching und Partition Pruning ermöglichen es Snowflake, skalierbare, leistungsstarke Analysen mit minimalen manuellen Eingriffen zu liefern.

Erweiterte Snowflake-Funktionen

Snowflake bietet fortschrittliche Funktionen in den Bereichen Ressourcenmanagement, Sicherheit, Integration und Überwachung, um die Möglichkeiten des Unternehmens zu verbessern.

Ressourcenmanagement

Das dynamische Ressourcenmanagement umfasst die Planung von Lagern und die automatische Skalierung, wobei inaktive Lager automatisch pausiert und die Rechenressourcen an die Arbeitslast angepasst werden. Administratoren können automatische Start-/Stopp-Zeitpläne festlegen und detaillierte Ressourcenmetriken nutzen, um Kosten und Leistung zu optimieren.

Query Governance

Die Query-Governance-Funktionen bieten eine präzise Kontrolle über den Ressourcenverbrauch, einschließlich dynamischer Limits, intelligenter Warteschlangen und benutzerdefinierter Abfrageweiterleitung, um ein effizientes Workload-Management zu gewährleisten.

Unternehmensintegration

Für die Unternehmensintegration unterstützt Snowflake gespeicherte Prozeduren in JavaScript und Java, so dass Entwickler komplexe Geschäftslogik über SQL hinaus implementieren können.

Die Versionskontrolle ermöglicht ein einfaches Rollback, während die Fehlerbehandlung eine reibungslose Ausführung mit detaillierter Protokollierung gewährleistet. Der sichere Datenaustausch der Plattform ermöglicht es Organisationen, Datensätze über private Datenmarktplätze zu teilen und zu vermarkten.

Unternehmen können den Zugang kontrollieren, die Nutzung nachverfolgen und eine automatische Abrechnung einführen, um neue Einnahmequellen zu erschließen und gleichzeitig die Einhaltung von Vorschriften und die Sicherheit zu gewährleisten.

Diese Funktionen stärken die Position von Snowflake als umfassende Datenplattform, die Skalierbarkeit, Automatisierung und Sicherheit bietet. Mit intelligentem Workload-Management, nahtlosen Integrationen und robusten Governance-Tools können Unternehmen ihre Leistung optimieren, Kosten senken und sicher mit ihren Datenbeständen zusammenarbeiten.

Architektur-Vergleiche

Vergleichen wir die Architektur von Snowflake mit traditionellen Data Warehouses und modernen Wettbewerbern, um sein einzigartiges Leistungsversprechen zu verstehen.

Traditionelle Data Warehouses

Die wichtigsten architektonischen Unterschiede:

- Traditionelle Systeme koppeln Speicher und Rechner eng miteinander

- Physische Datenpartitionierung erfordert manuelle Pflege

- Hardware-Kapazitätsplanung für Arbeitsspitzen erforderlich

- Begrenzte Fähigkeit, halbstrukturierte Daten zu verarbeiten

Vergleich der Kostenmodelle:

- Traditionell erfordert eine Vorabinvestition in Hardware

- Kapazität muss zukünftiges Wachstum berücksichtigen

- Wartungskosten umfassen Hardware und Einrichtungen

- Lizenzkosten basieren in der Regel auf Prozessorkernen

Leistungsmerkmale:

- Begrenzt durch physische Hardware-Einschränkungen

- Skalierung für gleichzeitige Benutzer erfordert Hardware-Upgrades

- Die Abfrageleistung nimmt mit der Anzahl der Nutzer ab

- Ressourcenkonkurrenz zwischen Arbeitslasten

Moderne Wettbewerber

1. Amazon Redshift

- Architektur: Clusterbasiert; manuelle Absaugvorgänge; verwendet Zonenkarten

- Kosten: Knotenbasierte Stundensätze; beschränkt auf das AWS-Ökosystem

2. Google BigQuery

- Architektur: Serverlos mit Slot-basierter Preisgestaltung; automatische Zwischenspeicherung von Abfragen (24 Stunden Speicherung)

- Kosten: Pay-per-byte gescannt; begrenzte Kontrolle über die Datenverarbeitung

3. Azure Synapse

- Architektur: Hybrid (serverlose & dedizierte Pools); komplexe Ressourcenverwaltung; unterstützt sowohl Rowstore als auch Columnstore

- Kosten: DTU- oder vCore-basierte Preisgestaltung; Integration mit Azure-Diensten

Zusätzliche Leistungsüberlegungen:

1. Abfrageoptimierung

- BigQuery: Automatische Optimierung, begrenzte Benutzerkontrolle

- Redshift: Manuelles Saugen und Analysieren

- Synapse: Erfordert Statistikaktualisierungen und Indexierung

2. Handhabung der Gleichzeitigkeit

- BigQuery: System der Slot-Zuweisung

- Redshift: Warteschlangenbasiertes Workload-Management

- Synapse: Ressourcenklassenzuweisungen

3. Speicherarchitektur

- BigQuery: Säulenspeicher mit automatischem Sharding

- Redshift: Knotenbasierte Verteilung mit Slice Management

- Synapse: Rowstore und columnstore Optionen

4. Unterschiede in der Kostenstruktur

- BigQuery: Bezahlung pro gescanntem Byte

- Redshift: Knotenbasierte Stundensätze

- Synapse: DTU- oder vCore-basierte Preisgestaltung

5. Integrationsfähigkeit

- BigQuery: Native GCP-Dienstintegration

- Redshift: Integration in das AWS-Ökosystem

- Synapse: Azure Plattform Dienste

Diese architektonischen Unterschiede wirken sich aus:

- Operative Komplexität

- Ressourcenmanagement

- Vorhersehbarkeit der Kosten

- Leistungsoptimierung

- Ökosystem-Integration

Einen strukturierten Ansatz zur Beherrschung dieser Konzepte findest du im umfassenden Snowflake Lernleitfaden.

Hier ist eine Tabelle, die diese Unterschiede zusammenfasst:

| Aspekt | BigQuery | Redshift | Synapse | Snowflake |

|---|---|---|---|---|

| Architektur | Serverlos | Cluster-basiert | Hybrid (serverlos & dediziert) | Multi-Cluster, gemeinsame Daten |

| Lagerung | Säulenförmig mit automatischer Aufteilung | Knotenbasierte Verteilung | Rowstore & columnstore | Mikro-gegliederte Säulen |

| Abfrage-Optimierung | Automatische, begrenzte Kontrolle | Manuelles Saugen/Analysieren | Manuelle Indexierung & Statistiken | Automatische Optimierung |

| Gleichzeitigkeit | Slot-basierte Zuweisung | Warteschlangenbasiertes WLM | Ressourcen-Klassen | Skalierung des virtuellen Lagers |

| Preismodell | Pro gescanntem Byte | Knotenbasiert stündlich | DTU/vCore-based | Pro-Sekunde-Lagernutzung |

| Integration | GCP-eigene Dienste | AWS-Ökosystem | Azure-Plattform | Multi-Cloud-Unterstützung |

| Ressourcenmanagement | Automatisiert | Manuelle Knotenverwaltung | Komplexe Poolverwaltung | Automatisiert mit manueller Steuerung |

| Datentyp-Unterstützung | Stark halbstrukturiert | Begrenzte halb-strukturierte | Begrenzte halb-strukturierte | Native halbstrukturiert |

| Wartung | Minimal | Regelmäßiges Vakuum erforderlich | Indexpflege erforderlich | Null Wartung |

| Caching | 24-Stunden-Automatik | Benutzerverwaltetes | Begrenzt eingebaut | Automatisches Zwischenspeichern von Ergebnissen |

Fazit

Snowflake hat die Art und Weise, wie Unternehmen mit Daten in der Cloud arbeiten, verändert, weil es einfacher und effizienter ist als ältere Systeme. Snowflake ist so aufgebaut, dass die Unternehmen ihre Daten getrennt speichern und verarbeiten können, was ihnen hilft, Geld zu sparen und trotzdem schnelle Ergebnisse zu erzielen. Dank der starken Sicherheitsfunktionen von Snowflake können Unternehmen sicher sein, dass ihre Daten geschützt sind. Das System funktioniert reibungslos über verschiedene Cloud-Anbieter hinweg und gibt Unternehmen mehr Flexibilität, wo sie ihre Daten aufbewahren.

Für alle, die mehr über Snowflake erfahren möchten, gibt es auf DataCamp viele hilfreiche Ressourcen und Schulungsmaterialien.

- Snowflake Tutorial für Anfänger: Von der Architektur zum Betrieb von Datenbanken

- Einführung in die Datenmodellierung in Snowflake Kurs

- So lernst du Snowflake im Jahr 2025: Ein vollständiger Leitfaden

Die Plattform wächst weiter mit neuen Funktionen wie künstlicher Intelligenz, die sie für Unternehmen noch leistungsfähiger machen. Unternehmen, die Snowflake nutzen, können sich schnell anpassen, wenn sich ihr Datenbedarf im Laufe der Zeit ändert. Die Zukunft von Snowflake sieht rosig aus, denn immer mehr Unternehmen entscheiden sich für diese Plattform für die Datenverwaltung.

Snowflake Architektur FAQs

Wodurch unterscheidet sich die Architektur von Snowflake von herkömmlichen Data Warehouses?

Snowflake verwendet eine einzigartige dreischichtige Architektur, die Speicher, Rechenleistung und Dienste voneinander trennt. Im Gegensatz zu herkömmlichen Systemen, die diese Komponenten eng miteinander koppeln, ermöglicht Snowflake eine unabhängige Skalierung, ein besseres Ressourcenmanagement und eine höhere Kosteneffizienz.

Wie handhabt Snowflake den gleichzeitigen Benutzerzugriff?

Snowflake verwaltet den gleichzeitigen Zugriff über virtuelle Lagerhäuser - unabhängige Rechencluster, die je nach Bedarf auf- oder abgebaut werden können. Mehrere Warehouses können ohne Leistungseinbußen gleichzeitig auf dieselben Daten zugreifen, während die Serviceschicht die Datenkonsistenz gewährleistet.

Was ist die Medaillon-Architektur in Snowflake?

Die Medaillon-Architektur ist ein Datenorganisationsmuster mit drei Schichten: Bronze (Rohdaten), Silber (standardisierte Daten) und Gold (geschäftsfähige Daten). Diese Struktur ermöglicht eine schrittweise Verfeinerung der Daten bei gleichzeitiger Wahrung der Datenherkunft und Qualitätskontrolle.

Wie funktioniert das Speichersystem von Snowflake?

Snowflake verwendet Mikropartitionen (50-500 MB große Einheiten), die in einem Spaltenformat mit automatischer Optimierung gespeichert werden. Das System verwaltet Metadaten über den Inhalt jeder Partition und ermöglicht eine effiziente Abfrageverarbeitung durch Partition Pruning und intelligentes Caching.

Wie schneidet Snowflake im Vergleich zu anderen Cloud Data Warehouses ab?

Snowflake unterscheidet sich von Konkurrenten wie Redshift, BigQuery und Synapse durch seine Multi-Cloud-Unterstützung, die automatischen Optimierungsfunktionen und das einzigartige Preismodell, das auf der sekundengenauen Nutzung des Warehouse basiert. Jede Plattform hat ihre eigene Herangehensweise an das Ressourcenmanagement und die Verarbeitung von Anfragen.

Ich bin ein Data Science Content Creator mit über 2 Jahren Erfahrung und einem der größten Follower auf Medium. Ich schreibe gerne ausführliche Artikel über KI und ML mit einem etwas sarkastischen Stil, denn man muss etwas tun, damit sie nicht so langweilig sind. Ich habe mehr als 130 Artikel verfasst und einen DataCamp-Kurs gemacht, ein weiterer ist in Vorbereitung. Meine Inhalte wurden von über 5 Millionen Augenpaaren gesehen, von denen 20.000 zu Followern auf Medium und LinkedIn wurden.