programa

Snowflake es una plataforma de datos basada en la nube que aborda los retos fundamentales de la gestión moderna de datos. Lanzada en 2014, proporciona a las organizaciones una solución centralizada para almacenar y procesar operaciones de datos a gran escala.

Los sistemas tradicionales de gestión de datos suelen presentar a las organizaciones importantes limitaciones. Estos sistemas suelen obligar a las empresas a elegir entre el rendimiento de las consultas, el acceso simultáneo de los usuarios y la rentabilidad. La arquitectura de Snowflake se desarrolló para eliminar estas limitaciones mediante su enfoque del almacenamiento de datos y el cálculo.

Esta guía examina el marco arquitectónico y los mecanismos operativos de Snowflake. Aunque la plataforma incorpora tecnologías complejas, esta explicación se centrará en hacer estos conceptos accesibles a los lectores con conocimientos básicos de sistemas de datos.

La guía abordará:

- Los principios fundamentales del sistema de almacenamiento de datos de Snowflake

- Los componentes arquitectónicos que forman su infraestructura

- El enfoque de la plataforma para el acceso concurrente a los datos

- Las ventajas técnicas que impulsan su adopción

Este análisis te proporcionará una comprensión básica de cómo funciona Snowflake dentro de la infraestructura de datos moderna.

Para los lectores nuevos en Snowflake, la Introducción a Snowflake para principiantes proporciona conocimientos básicos esenciales.

Conceptos básicos de la arquitectura Snowflake

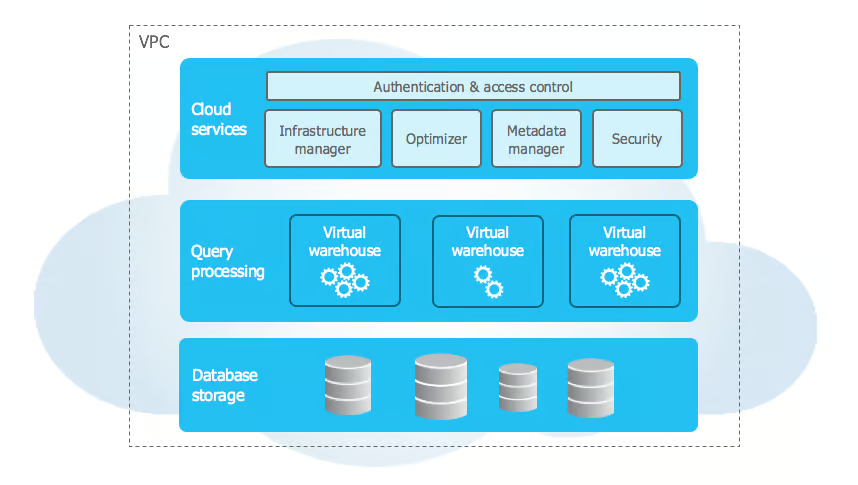

La arquitectura de Snowflake difiere de la tradicional almacén de datos utilizando los principios modernos de la nube para resolver los retos de escalabilidad y rendimiento. La arquitectura implementa un enfoque multicapa que divide el almacenamiento, la informática y los servicios en componentes separados pero conectados.

Capas de la arquitectura copo de nieve

Fuente: Documentación sobre el copo de nieve

La arquitectura de Snowflake utiliza un diseño único de tres capas que separa las funcionalidades básicas manteniendo una integración perfecta. Examinemos cada capa en detalle:

1. Capa de almacenamiento

La capa de almacenamiento de Snowflake se basa en el almacenamiento de objetos en la nube (Amazon S3, Azure Blob Storageo Google Cloud Storage) y organiza los datos en microparticiones inmutables (50-500 MB) en un formato columnar comprimido. Estas microparticiones almacenan metadatos como los valores mínimo/máximo de las columnas, lo que permite una poda eficaz de las consultas.

Esta capa se autooptimiza, por lo que no requiere mantenimiento manual. Selecciona de forma inteligente el mejor algoritmo de compresión por columna en función del tipo de datos y los patrones, garantizando altos ratios de compresión y consultas analíticas rápidas al leer sólo las columnas necesarias.

2. Capa de cálculo

La capa informática consiste en clusters MPP independientes de almacenes virtuales que ejecutan consultas SQL y operaciones DML. Cada almacén ejecuta varios nodos en paralelo, funcionando de forma totalmente aislada para evitar interferencias en el rendimiento.

Estos recursos sin estado pueden iniciarse, detenerse, redimensionarse o clonarse sin afectar a los datos. El redimensionamiento redistribuye las cargas de trabajo automáticamente, mientras que la función de suspensión automática pausa los almacenes inactivos y los reanuda en cuestión de segundos cuando es necesario.

3. Capa de servicios

La capa de servicios orquesta las operaciones de Snowflake, gestionando un almacén de metadatos distribuido que rastrea tablas, vistas, políticas de seguridad y consultas. El optimizador de consultas aprovecha estos metadatos para generar planes de ejecución eficientes basados en la distribución de los datos, los recursos informáticos y los patrones de acceso.

Garantiza el cumplimiento de ACID con un control de concurrencia avanzado, a la vez que gestiona la autenticación mediante SSO, MFA y el control de acceso basado en roles en todos los niveles. Esta capa también gestiona el manejo de la sesión y la aplicación de la seguridad.

Cómo funcionan juntas las capas

La interacción entre las capas de Snowflake permite potentes capacidades como el intercambio seguro de datos, la computación multiclúster y la escalabilidad dinámica. El intercambio de datos se basa en metadatos: sólo se intercambian punteros, mientras que el acceso se controla con políticas de seguridad muy precisas. Los consumidores pueden consultar los datos compartidos utilizando sus propios recursos informáticos sin duplicarlos.

La informática multiclúster permite que clústeres de cálculo independientes accedan a la misma capa de almacenamiento, manteniendo cachés separadas y garantizando la coherencia. Las cargas de trabajo pueden aislarse dedicando los almacenes a ETL, BI o ciencia de datos. La arquitectura de Snowflake también admite la escalabilidad dinámica, permitiendo que el almacenamiento y la informática escalen independientemente mientras la capa de servicios optimiza la asignación de recursos y el rendimiento de las consultas.

Para profundizar en estos conceptos y más, puedes explorar el curso Curso de Introducción a Snowflake.

Arquitectura del almacén de datos de Snowflake

La arquitectura del almacén de datos de Snowflake se basa en su diseño de tres capas para proporcionar un modelado flexible de los datos y un procesamiento eficaz de las consultas. Admite datos estructurados y semiestructurados, al tiempo que optimiza el rendimiento y simplifica la gestión.

Modelo de datos

Snowflake acomoda datos estructurados utilizando conceptos de bases de datos relacionales, soportando tipos de datos SQL, restricciones y relaciones a través de claves primarias y foráneas. La información sensible se beneficia de la encriptación a nivel de columna. Para los datos semiestructurados, Snowflake maneja de forma nativa JSON, XML, Parquet y Avro utilizando el tipo de datos VARIANT, infiriendo automáticamente esquemas y permitiendo consultas eficientes con funciones especializadas como FLATTEN y PARSE_JSON.

A nivel de almacenamiento, los datos se dividen automáticamente en microparticiones de 50-500 MB, cada una de las cuales almacena metadatos como valores de columna mín/máx y frecuencias nulas. Snowflake rastrea la agrupación natural y reorganiza los datos periódicamente para mejorar la eficacia de las consultas, eliminando la necesidad de gestionar manualmente las particiones.

Arquitectura de procesamiento de consultas

Snowflake procesa las consultas a través de múltiples capas coordinadas que optimizan la ejecución. El optimizador de consultas transforma las consultas SQL en planes de ejecución lógicos y evalúa múltiples planes físicos en función del tamaño de la tabla, la indexación y el almacenamiento en caché. Utilizando un modelo de costes, selecciona el enfoque más eficiente, determinando algoritmos de unión, métodos de ordenación y estrategias de movimiento de datos.

El motor de ejecución distribuye las consultas entre los nodos de procesamiento paralelo. Aprovechando los metadatos, depura las particiones innecesarias y lee sólo las columnas relevantes en el formato de almacenamiento columnar de Snowflake, mejorando la eficiencia. Una caché de resultados de 24 horas mejora aún más el rendimiento al reutilizar los resultados de consulta calculados previamente cuando los datos subyacentes no cambian.

La arquitectura de Snowflake permite patrones eficientes de acceso a los datos. La clonación de copia cero permite duplicar tablas al instante sin copiar datos, mientras que el viaje en el tiempo conserva versiones históricas para consultas puntuales. El control de concurrencia multiversión (MVCC) garantiza la coherencia de las transacciones, permitiendo cargas de trabajo de alta concurrencia sin conflictos de bloqueo. Estas optimizaciones, combinadas con el almacenamiento en caché inteligente y la poda de particiones, permiten a Snowflake ofrecer análisis escalables y de alto rendimiento con una intervención manual mínima.

Funciones avanzadas del copo de nieve

Snowflake ofrece funciones avanzadas de gestión de recursos, seguridad, integración y supervisión para mejorar las capacidades de la empresa.

Gestión de recursos

Su gestión dinámica de recursos incluye la programación de almacenes y el autoescalado, pausando automáticamente los almacenes inactivos y ajustando los recursos informáticos en función de las demandas de carga de trabajo. Los administradores pueden establecer calendarios automatizados de inicio y parada y aprovechar las métricas detalladas de los recursos para optimizar los costes y el rendimiento.

Gobernanza de la consulta

Las funciones de gobernanza de consultas proporcionan un control preciso sobre el consumo de recursos, incluyendo límites dinámicos, colas inteligentes y enrutamiento personalizado de consultas, garantizando una gestión eficaz de la carga de trabajo.

Integración empresarial

Para la integración empresarial, Snowflake admite procedimientos almacenados en JavaScript y Java, lo que permite a los desarrolladores implementar lógica empresarial compleja más allá de SQL.

El control de versiones permite retroceder fácilmente, mientras que la gestión de errores garantiza una ejecución fluida con un registro detallado. El marco de intercambio seguro de datos de la plataforma permite a las organizaciones compartir y monetizar conjuntos de datos a través de mercados de datos privados.

Las empresas pueden controlar el acceso, hacer un seguimiento del uso e implantar la facturación automatizada, creando nuevas oportunidades de ingresos al tiempo que mantienen el cumplimiento y la seguridad.

Estas características refuerzan colectivamente la posición de Snowflake como plataforma de datos integral, que ofrece escalabilidad, automatización y seguridad. Con una gestión inteligente de la carga de trabajo, integraciones sin fisuras y sólidas herramientas de gobernanza, las organizaciones pueden optimizar el rendimiento, reducir los costes y colaborar de forma segura en los activos de datos.

Comparaciones de arquitectura

Comparemos la arquitectura de Snowflake con los almacenes de datos tradicionales y los competidores modernos para comprender su propuesta de valor única.

Almacenes de datos tradicionales

Principales diferencias arquitectónicas:

- Los sistemas tradicionales acoplan estrechamente el almacenamiento y el cálculo

- La partición física de datos requiere mantenimiento manual

- Necesidad de planificar la capacidad del hardware para los picos de carga de trabajo

- Capacidad limitada para manejar datos semiestructurados

Comparación de modelos de costes:

- El tradicional requiere una inversión inicial en hardware

- La capacidad debe tener en cuenta el crecimiento futuro

- Los costes de mantenimiento incluyen el hardware y las instalaciones

- Los costes de licencia suelen basarse en los núcleos del procesador

Características de funcionamiento:

- Limitado por restricciones físicas de hardware

- El escalado de usuarios simultáneos requiere actualizaciones de hardware

- El rendimiento de la consulta disminuye con el número de usuarios

- Contención de recursos entre cargas de trabajo

Competidores modernos

1. Amazon Redshift

- Arquitectura: Basado en grupos; operaciones manuales de vacío; utiliza mapas de zonas

- Coste: Precio por hora basado en nodos; limitado al ecosistema de AWS

2. Google BigQuery

- Arquitectura: Sin servidor con precios basados en franjas horarias; almacenamiento automático en caché de las consultas (retención de 24 horas)

- Coste: Escaneado de pago por byte; control limitado del cálculo

3. Azure Synapse

- Arquitectura: Híbrido (sin servidor y pools dedicados); gestión compleja de recursos; admite tanto rowstore como columnstore

- Coste: Precios basados en DTU o vCore; integración con los servicios Azure

Consideraciones adicionales sobre el rendimiento:

1. Optimización de consultas

- BigQuery: Optimización automática, control limitado del usuario

- Redshift: Aspira manualmente y analiza las operaciones

- Sinapsis: Requiere actualización de estadísticas e indexación

2. Gestión de la concurrencia

- BigQuery: Sistema de asignación de franjas horarias

- Redshift: Gestión de la carga de trabajo basada en colas

- Sinapsis: Asignaciones de clases de recursos

3. Arquitectura de almacenamiento

- BigQuery: Almacenamiento en columnas con fragmentación automática

- Redshift: Distribución basada en nodos con gestión de porciones

- Sinapsis: Opciones de almacén de filas y almacén de columnas

4. Variaciones de la estructura de costes

- BigQuery: Pago por byte escaneado

- Redshift: Precios por hora basados en nodos

- Sinapsis: Precios basados en DTU o vCore

5. Capacidad de integración

- BigQuery: Integración nativa de servicios GCP

- Redshift: Integración en el ecosistema de AWS

- Sinapsis: Servicios de la plataforma Azure

Estas diferencias arquitectónicas repercuten:

- Complejidad operativa

- Gestión de recursos

- Previsibilidad de los costes

- Optimización del rendimiento

- Integración del ecosistema

Para un enfoque estructurado del dominio de estos conceptos, consulta la guía completa de aprendizaje Snowflake.

Aquí tienes una tabla que resume estas diferencias:

| Aspecto | BigQuery | Redshift | Sinapsis | Copo de nieve |

|---|---|---|---|---|

| Arquitectura | Sin servidor | Basado en grupos | Híbrido (sin servidor y dedicado) | Multi-clúster, datos compartidos |

| Almacenamiento | Columnar con autodistribución | Distribución basada en nodos | Almacén de filas y columnas | Columnar microparticionado |

| Optimización de consultas | Control automático y limitado | Aspiración/análisis manual | Indexación manual y estadísticas | Optimización automática |

| Concurrencia | Asignación por franjas horarias | WLM basado en colas | Clases de recursos | Escalado del almacén virtual |

| Modelo de precios | Por byte escaneado | Por hora basada en nodos | Basado en DTU/vCore | Uso del almacén por segundo |

| Integración | Servicios nativos de GCP | Ecosistema AWS | Plataforma Azure | Soporte multi-nube |

| Gestión de recursos | Automatizado | Gestión manual de nodos | Gestión compleja de la piscina | Automatizado con control manual |

| Soporte de tipos de datos | Semiestructurado fuerte | Semiestructurado limitado | Semiestructurado limitado | Nativo semiestructurado |

| Mantenimiento | Mínimo | Es necesario aspirar con regularidad | Necesidad de mantenimiento del índice | Mantenimiento cero |

| Almacenamiento en caché | Automático 24 horas | Gestionado por el usuario | Incorporado limitado | Almacenamiento automático de resultados |

Conclusión

Snowflake ha cambiado la forma en que las empresas trabajan con los datos en la nube, haciéndolo más fácil y eficaz que los sistemas antiguos. La forma en que está construido Snowflake permite a las empresas almacenar y procesar sus datos por separado, lo que les ayuda a ahorrar dinero sin dejar de obtener resultados rápidos. Gracias a las sólidas funciones de seguridad de Snowflake, las empresas pueden estar seguras de que sus datos están protegidos. El sistema funciona sin problemas en distintos proveedores de la nube, lo que da a las empresas más flexibilidad a la hora de decidir dónde guardan sus datos.

Para quien quiera aprender más sobre Snowflake, hay muchos recursos útiles y materiales de formación disponibles en DataCamp.

- Tutorial de copos de nieve para principiantes: De la arquitectura a la ejecución de bases de datos

- Curso de Introducción al Modelado de Datos en Snowflake

- Cómo aprender copo de nieve en 2025: Guía completa

La plataforma sigue creciendo con nuevas funciones, como las capacidades de inteligencia artificial, que la hacen aún más potente para las empresas. Las empresas que utilizan Snowflake pueden adaptarse rápidamente a medida que sus necesidades de datos cambian con el tiempo. El futuro parece brillante para Snowflake a medida que más organizaciones lo eligen como plataforma principal para gestionar datos.

Preguntas frecuentes sobre la arquitectura en copo de nieve

¿Qué diferencia la arquitectura de Snowflake de los almacenes de datos tradicionales?

Snowflake utiliza una arquitectura única de tres capas que separa el almacenamiento, la informática y los servicios. A diferencia de los sistemas tradicionales que acoplan estrechamente estos componentes, el diseño de Snowflake permite un escalado independiente, una mejor gestión de los recursos y una mayor rentabilidad.

¿Cómo gestiona Snowflake el acceso simultáneo de usuarios?

Snowflake gestiona el acceso concurrente a través de almacenes virtuales, clusters informáticos independientes que pueden ampliarse o reducirse según sea necesario. Múltiples almacenes pueden acceder simultáneamente a los mismos datos sin degradación del rendimiento, mientras que la capa de servicios garantiza la coherencia de los datos.

¿Qué es la arquitectura del medallón en Copo de Nieve?

La arquitectura medallón es un patrón de organización de datos con tres capas: Bronce (datos brutos), Plata (datos normalizados) y Oro (datos listos para la empresa). Esta estructura permite el refinamiento progresivo de los datos, manteniendo su linaje y el control de calidad.

¿Cómo funciona el sistema de almacenamiento de Snowflake?

Snowflake utiliza microparticiones (trozos de 50-500 MB) almacenadas en un formato columnar con optimización automática. El sistema mantiene metadatos sobre el contenido de cada partición, lo que permite un procesamiento eficaz de las consultas mediante la poda de particiones y el almacenamiento inteligente en caché.

¿Cómo se compara Snowflake con otros almacenes de datos en la nube?

Snowflake se diferencia de competidores como Redshift, BigQuery y Synapse por su compatibilidad con múltiples nubes, sus funciones de optimización automática y su exclusivo modelo de precios basado en el uso por segundo del almacén. Cada plataforma tiene enfoques distintos para la gestión de recursos y el procesamiento de consultas.

Soy un creador de contenidos de ciencia de datos con más de 2 años de experiencia y uno de los mayores seguidores en Medium. Me gusta escribir artículos detallados sobre IA y ML con un estilo un poco sarcastıc, porque hay que hacer algo para que sean un poco menos aburridos. He publicado más de 130 artículos y un curso DataCamp, y estoy preparando otro. Mi contenido ha sido visto por más de 5 millones de ojos, 20.000 de los cuales se convirtieron en seguidores tanto en Medium como en LinkedIn.