Programa

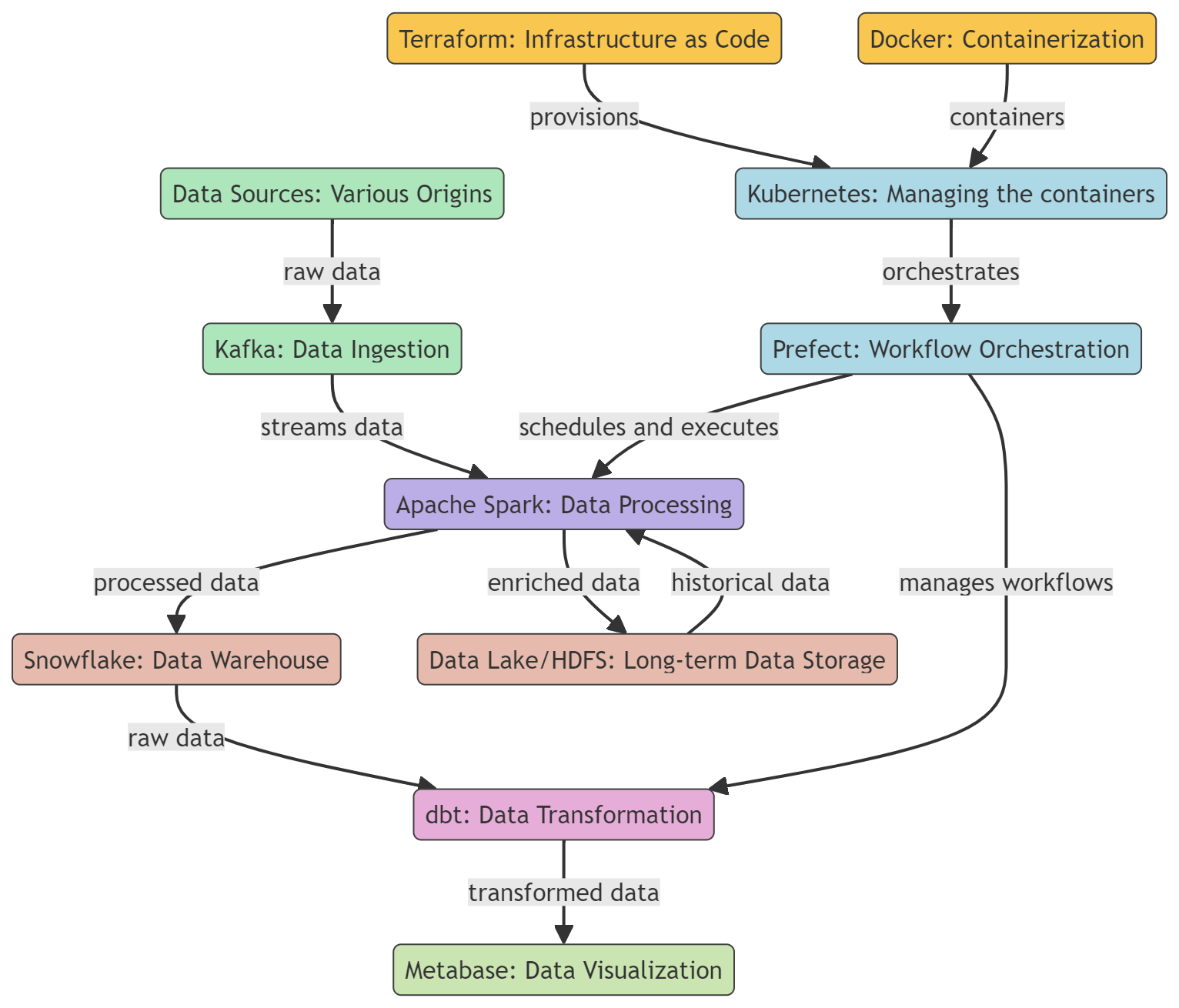

Os engenheiros de dados são responsáveis por criar pipelines de dados que possam coletar, processar e entregar dados para vários destinos, como bancos de dados, warehouse e plataformas de análise. Ao criar e manter esses canais de dados, os engenheiros de dados permitem que os cientistas e analistas de dados acessem dados em tempo real para análise e tomada de decisões.

Os engenheiros de dados modernos precisam fazer ainda mais coisas. Eles também precisam manter e implementar soluções de dados, gerenciar fluxos de trabalho, supervisionar warehouses, transformar e visualizar dados, além de usar várias ferramentas de processamento em lote e streaming para otimizar, inserir e processar diferentes tipos de dados.

Descubra o que é engenharia de dados, como ela difere da ciência de dados, seu escopo e maneiras de aprendê-la lendo nosso guia, O que é engenharia de dados?

Neste post, vamos aprender sobre as ferramentas essenciais que são populares e, às vezes, necessárias para os engenheiros de dados. Essas ferramentas são usadas para ingestão, processamento, armazenamento, transformação e visualização de dados. Além disso, vamos dar uma olhada nas ferramentas para contêinerização e gerenciamento de fluxo de trabalho.

Aprenda habilidades essenciais de engenharia de dados lendo nosso blog Como se tornar um engenheiro de dados.

Ferramentas de conteinerização

As ferramentas de conteinerização oferecem uma maneira padronizada de empacotar, distribuir e gerenciar aplicativos em diferentes ambientes. Isso garante consistência, escalabilidade e eficiência dos fluxos de trabalho de engenharia de dados.

1. Docker

O Docker é uma plataforma de conteinerização bem popular que costuma ser usada em engenharia de dados pra desenvolver, enviar e rodar ferramentas e aplicativos de dados. Ele oferece uma maneira leve, portátil e consistente de empacotar e implantar ferramentas e aplicativos de dados, tornando-o a escolha ideal para engenheiros de dados.

O Docker pode ser usado para criar e gerenciar contêineres para várias ferramentas de dados, como bancos de dados, warehouse de dados, estruturas de processamento de dados e ferramentas de visualização de dados. Dá uma olhada no nosso tutorial Docker para Ciência de Dados pra saber mais.

2. Kubernetes

O Kubernetes é uma plataforma de código aberto pra automatizar a implantação, o dimensionamento e o gerenciamento de aplicativos em contêineres, incluindo aqueles criados com o Docker.

O Docker é uma ferramenta que pode ser usada para empacotar aplicativos de processamento de dados, bancos de dados e ferramentas de análise em contêineres. Isso garante a consistência nos ambientes e isola as aplicações. Depois que os contêineres são criados, o Kubernetes entra em ação para gerenciá-los, cuidando da implantação, do dimensionamento com base na carga de trabalho e garantindo alta disponibilidade.

Saiba mais sobre a conteinerização usando Docker e Kubernetes em um artigo separado.

Ferramentas de infraestrutura como código

A Infraestrutura como Código (IaC) simplifica a implantação e a manutenção da infraestrutura em nuvem usando linguagens de programação genéricas ou configurações YAML. Essa abordagem ajuda a criar ambientes consistentes, repetíveis e automatizados, facilitando transições mais suaves entre as fases de desenvolvimento, teste e produção.

3. Terraform

O Terraform é uma ferramenta de código aberto de infraestrutura como código (IaC) criada pela HashiCorp. Permite que os engenheiros de dados definam e implementem infraestruturas de dados, como bancos de dados e pipelines de dados, de forma consistente e confiável, usando uma linguagem de configuração declarativa, que descreve o estado final desejado da infraestrutura, em vez das etapas necessárias para chegar a esse estado.

O Terraform dá suporte ao controle de versão, gerenciamento de recursos por meio de código, colaboração em equipe e integração com várias ferramentas e plataformas.

4. Pulumi

Pulumi é uma ferramenta de infraestrutura como código de código aberto que permite aos desenvolvedores criar, implantar e gerenciar infraestruturas em nuvem usando linguagens de programação de uso geral, como JavaScript, TypeScript, Java, Python, Go e C#. Ele dá suporte a vários provedores de nuvem, como AWS, Azure, GCP e Kubernetes.

A estrutura Pulmi oferece uma interface de linha de comando (CLI) para download, um kit de desenvolvimento de software (SDK) e um mecanismo de implantação para fornecer uma plataforma robusta para provisionamento, atualização e gerenciamento de infraestrutura em nuvem.

Torne-se um engenheiro de dados

Ferramentas de coordenação de fluxo de trabalho

As ferramentas de orquestração de fluxo de trabalho automatizam e gerenciam a execução de fluxos de trabalho complexos de processamento de dados, garantindo que as tarefas sejam executadas na ordem certa enquanto gerenciam as dependências.

5. Prefeito

O Prefect é uma ferramenta de código aberto pra organizar fluxos de trabalho modernos e processos ETL (extrair, transformar, carregar). Ajuda engenheiros e cientistas de dados a automatizar e gerenciar pipelines de dados complexos, garantindo que os dados fluam suavemente da fonte ao destino com confiabilidade e eficiência.

A Prefect oferece um modelo de execução híbrido que junta as vantagens do gerenciamento baseado em nuvem com a segurança e o controle da execução local. Sua interface de usuário intuitiva e API avançada facilitam o monitoramento e a solução de problemas nos fluxos de trabalho de dados.

6. Luigi

Luigi é um pacote Python de código aberto que ajuda você a criar pipelines de dados complexos para tarefas em lote de longa duração. Foi desenvolvido pela Spotify para lidar com resolução de dependências, gerenciamento de fluxo de trabalho, visualização, tratamento de falhas e integração com linha de comando.

O Luigi foi feito pra cuidar de várias tarefas, tipo processamento, validação e agregação de dados, e pode ser usado pra criar fluxos de trabalho de dados simples e sofisticados. O Luigi pode ser integrado a várias ferramentas e plataformas, como o Apache Hadoop e o Apache Spark, permitindo que os usuários criem pipelines de dados para processar e analisar grandes volumes de dados.

Ferramentas de warehouse de dados

Os data warehouses oferecem soluções baseadas em nuvem que são super escaláveis para armazenar, consultar e gerenciar grandes conjuntos de dados.

7. Snowflake

O Snowflake é um warehouse na nuvem que permite guardar, processar e fazer consultas analíticas em grandes quantidades de dados. É baseado em uma arquitetura única que separa armazenamento e computação, permitindo que eles sejam dimensionados de forma independente.

O Snowflake pode ajustar dinamicamente a quantidade de recursos de computação com base na demanda. Isso garante que as consultas sejam processadas de forma rápida, eficiente e econômica. É compatível com os principais provedores de nuvem, como AWS, GCP e Azure.

Dá uma olhada no nosso curso Introdução ao Snowflake pra conhecer essa ferramenta com mais detalhes.

8. PostgreSQL

O PostgreSQL é um sistema de gerenciamento de banco de dados relacional (RDBMS) de código aberto bem poderoso que também pode ser usado como um data warehouse. Como um warehouse, o PostgreSQL oferece um repositório centralizado para guardar, gerenciar e analisar grandes volumes de dados estruturados de várias fontes.

O PostgreSQL tem recursos como particionamento, indexação e execução paralela de consultas, que permitem lidar com consultas complexas e grandes conjuntos de dados de forma eficiente.

Lembre-se de que um warehouse PostgreSQL é uma solução local que pode não ser tão escalável quanto algumas soluções totalmente gerenciadas. Requer mais administração e manutenção manual em comparação com essas soluções.

Saiba mais no nosso Guia para Iniciantes do PostgreSQL.

Ferramentas de engenharia analítica

As ferramentas de engenharia analítica simplificam a transformação, o teste e a documentação dos dados no warehouse.

9. dbt

O dbt (data build tool) é uma ferramenta de linha de comando e estrutura de código aberto feita pra facilitar o fluxo de trabalho de transformação de dados e modelagem num ambiente de warehouse. Ele dá suporte a todos os principais warehouses, incluindo Redshift, BigQuery, Snowflake e PostgreSQL.

O dbt pode ser acessado através do dbt Core ou do dbt Nuvem. O dbt Cloud oferece uma interface de usuário baseada na web, uma CLI com tecnologia dbt Cloud, um ambiente hospedado, um agendador de tarefas no aplicativo e integrações com outras ferramentas.

Você pode entender os fundamentos do dbt com nosso curso Introdução ao dbt.

10. Metabase

O Metabase é uma ferramenta de inteligência empresarial (BI) e análise de código aberto que permite aos usuários criar e compartilhar painéis interativos e relatórios analíticos. Ele foi feito pra ser fácil de usar, permitindo que quem não tem conhecimentos técnicos possa consultar dados, ver os resultados e entender melhor as coisas sem precisar saber SQL ou outras linguagens de consulta.

Ele oferece configuração fácil, suporte para várias fontes de dados, uma interface de usuário simples, recursos de colaboração, notificações personalizáveis e segurança robusta para exploração, análise e compartilhamento de dados.

A análise de dados e a criação de painéis fazem parte da ciência de dados. Saiba mais sobre as diferenças entre um cientista de dados e um engenheiro de dados lendo este artigo: Cientista de dados vs. Engenheiro de dados.

Ferramentas de processamento em lote

Essas ferramentas de engenharia de dados permitem o processamento eficiente de grandes volumes de dados em lotes, executando tarefas computacionais complexas, análise de dados e aplicações de machine learning em ambientes de computação distribuída.

11. Apache Spark

O Apache Spark é uma estrutura de computação distribuída de código aberto super poderosa, feita pra processar e analisar dados em grande escala. Embora seja conhecido por sua capacidade de lidar com dados de streaming em tempo real, o Spark também se destaca no processamento em lote, tornando-se uma ferramenta valiosa nos fluxos de trabalho de engenharia de dados.

O Apache Spark tem conjuntos de dados distribuídos resilientes (RDDs), APIs completas para várias linguagens de programação, processamento de dados em vários nós em um cluster e integração perfeita com outras ferramentas. É super escalável e rápido, o que o torna ideal para processamento em lote em tarefas de engenharia de dados.

12. Apache Hadoop

O Apache Hadoop é uma estrutura de código aberto bem popular para armazenamento e processamento distribuídos de grandes conjuntos de dados. No centro do ecossistema Hadoop estão dois componentes principais: o Hadoop Distributed File System (HDFS) para armazenamento e o modelo de programação MapReduce para processamento.

O Apache Hadoop é uma ferramenta poderosa e escalável para engenheiros de dados, oferecendo armazenamento econômico, tolerância a falhas, recursos de processamento distribuído e integração perfeita com outras ferramentas de processamento de dados.

Ferramentas de streaming

As ferramentas de streaming são uma maneira incrível de criar pipelines de dados em tempo real, permitindo a ingestão, o processamento e a análise contínuos de dados de streaming.

13. Apache Kafka

O Apache Kafka é uma plataforma distribuída de streaming de eventos projetada para processamento de dados em tempo real de alto desempenho e otimização de pipelines de dados em grande escala. É usado para criar pipelines de dados em tempo real, análise de streaming, integração de dados e aplicativos de missão crítica.

O Kafka é um sistema que consegue lidar com uma grande quantidade de dados com pouca latência. Ele guarda os dados de um jeito distribuído e tolerante a falhas, garantindo que os dados continuem disponíveis mesmo se acontecer alguma falha de hardware ou problema de rede.

O Kafka é super escalável e dá suporte a vários assinantes. Ele também se integra bem com diferentes ferramentas e estruturas de processamento de dados, como Apache Spark, Apache Flink e Apache Storm.

14. Apache Flink

O Apache Flink é uma plataforma de código aberto para processamento distribuído de fluxos e lotes. Ele consegue processar fluxos de dados em tempo real, o que o torna uma escolha popular para criar pipelines de dados de streaming e aplicativos de análise em tempo real.

O Flink é uma ferramenta de processamento de dados que oferece recursos rápidos e eficientes de processamento de dados em tempo real e em lote. Ele suporta várias APIs (incluindo Java, Scala e Python), permite uma integração perfeita com outras ferramentas de processamento de dados e oferece um gerenciamento de estado eficiente. Por isso, é uma escolha popular para análises em tempo real, detecção de fraudes e aplicações de IoT, porque consegue processar dados de alto rendimento com pouca latência.

Conclusão

Isso encerra nossa lista, mas não precisa ser o fim da sua jornada na engenharia de dados. Inscreva-se no programa de Engenheiro de Dados em Python para aprender sobre Python, SQL, design de banco de dados, computação em nuvem, limpeza de dados e visualização. Depois de concluir o programa, você pode fazer o exame de Certificação Profissional em Engenharia de Dados e se tornar um engenheiro de dados certificado.

Os engenheiros de dados têm um papel super importante na criação e manutenção dos fluxos de dados que alimentam as análises e a tomada de decisões nas organizações. Com o volume e a complexidade dos dados crescendo cada vez mais, os engenheiros de dados precisam usar as ferramentas certas para coletar, processar, armazenar e entregar dados de qualidade de forma eficiente.

A gente falou sobre as 14 principais ferramentas de engenharia de dados para conteinerização, provisionamento de infraestrutura, automação de fluxo de trabalho, warehouse de dados, engenharia analítica, processamento em lote e streaming em tempo real.

Se você é novo na área de engenharia de dados, comece aprendendo Docker, Kubernetes, Terraform, Prefect, Snowflake, dbt, Apache Spark, Apache Kafka e muito mais.

Depois de se tornar proficiente nessas ferramentas, você deve revisar as 21 principais perguntas, respostas e exemplos de entrevistas sobre engenharia de dados para se preparar para o próximo passo na sua carreira.

Obtenha a certificação para a função de engenheiro de dados dos seus sonhos

Nossos programas de certificação ajudam você a se destacar e a provar que suas habilidades estão prontas para o trabalho para possíveis empregadores.

Sou um cientista de dados certificado que gosta de criar aplicativos de aprendizado de máquina e escrever blogs sobre ciência de dados. No momento, estou me concentrando na criação e edição de conteúdo e no trabalho com modelos de linguagem de grande porte.