Cursus

Les ingénieurs de données sont chargés de créer des pipelines de données capables d'ingérer, de traiter et de fournir des données à divers points de terminaison, tels que des bases de données, des entrepôts de données et des plateformes d'analyse. En créant et en entretenant ces pipelines de données, les ingénieurs de données permettent aux scientifiques et aux analystes de données d'accéder à des données en temps réel pour les analyser et prendre des décisions.

Les ingénieurs de données modernes sont appelés à accomplir un nombre croissant de tâches. Ils doivent également assurer la maintenance et le déploiement de solutions de données, gérer les flux de travail, superviser les entrepôts de données, transformer et visualiser les données, et utiliser divers outils de traitement par lots et de streaming pour optimiser, ingérer et traiter différents types de données.

Découvrez ce qu'est l'ingénierie des données, en quoi elle diffère de la science des données, son champ d'application et les moyens de l'apprendre en lisant notre guide intitulé « Qu'est-ce que l'ingénierie des données ? ».

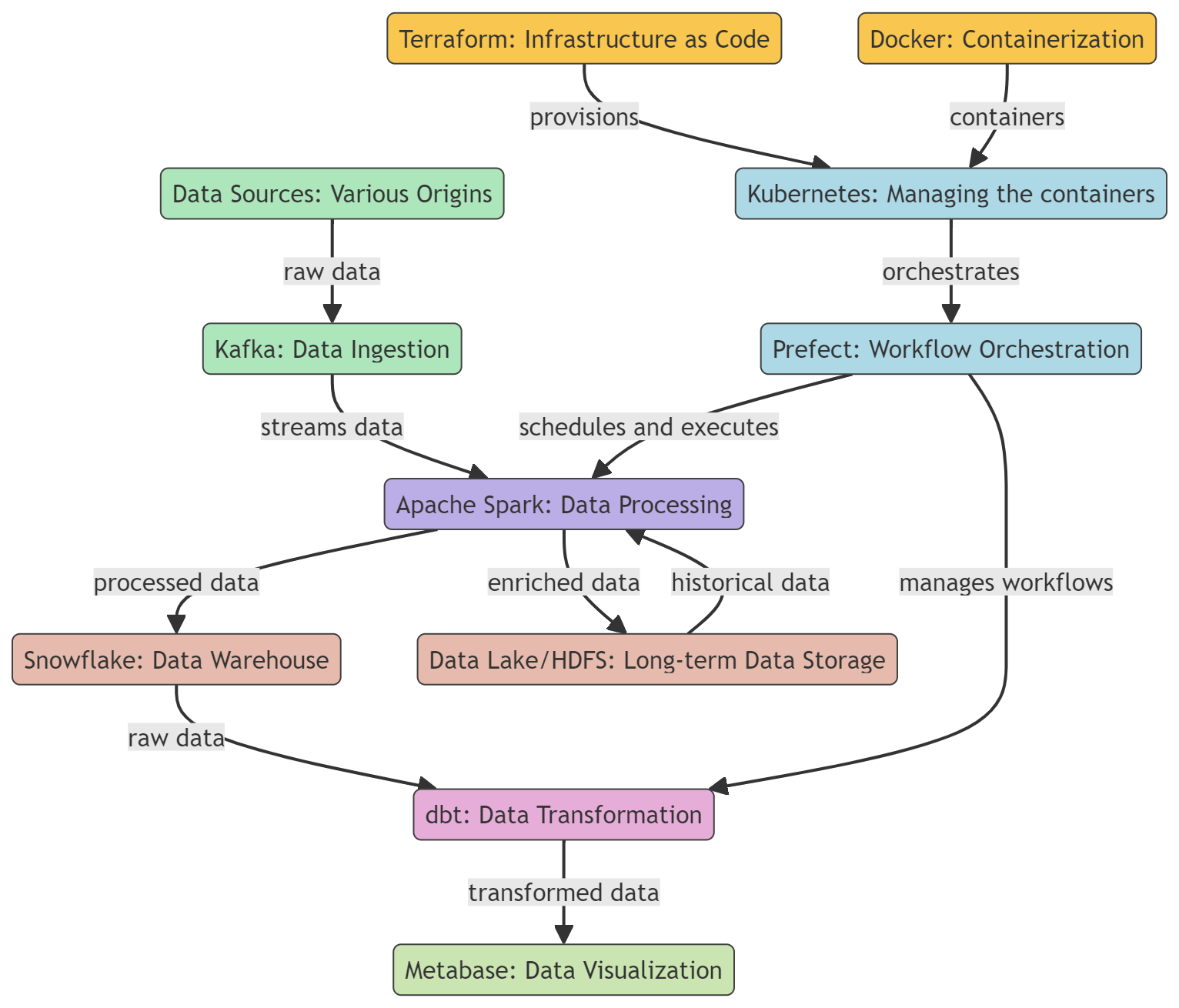

Dans cet article, nous allons découvrir les outils essentiels qui sont populaires et parfois indispensables pour les ingénieurs de données. Ces outils sont utilisés pour l'ingestion, le traitement, le stockage, la transformation et la visualisation des données. De plus, nous examinerons les outils de conteneurisation et de gestion des flux de travail.

Acquérez les compétences essentielles en ingénierie des données en consultant notre blog « Comment devenir ingénieur de données ».

Outils de conteneurisation

Les outils de conteneurisation offrent une méthode standardisée pour packager, distribuer et gérer des applications dans différents environnements. Il garantit la cohérence, l'évolutivité et l'efficacité des flux de travail liés à l'ingénierie des données.

1. Docker

Docker est une plateforme de conteneurisation très répandue, fréquemment utilisée en ingénierie des données pour développer, livrer et exécuter des outils et des applications de données. Il offre un moyen léger, portable et cohérent de regrouper et de déployer des outils et des applications de données, ce qui en fait un choix idéal pour les ingénieurs de données.

Docker peut être utilisé pour créer et gérer des conteneurs pour divers outils de données, tels que des bases de données, des entrepôts de données, des cadres de traitement de données et des outils de visualisation de données. Veuillez consulter notre tutoriel Docker pour la science des données pour en savoir plus.

2. Kubernetes

Kubernetes est une plateforme open source permettant d'automatiser le déploiement, la mise à l'échelle et la gestion d'applications conteneurisées, y compris celles développées à l'aide de Docker.

Docker est un outil permettant de regrouper des applications de traitement de données, des bases de données et des outils d'analyse dans des conteneurs. Cela garantit la cohérence des environnements et isole les applications. Une fois les conteneurs créés, Kubernetes intervient pour les gérer en assurant leur déploiement, leur mise à l'échelle en fonction de la charge de travail et leur haute disponibilité.

Pour en savoir plus sur la conteneurisation à l'aide de Docker et Kubernetes, veuillez consulter un article distinct.

Outils d'infrastructure en tant que code

L'infrastructure en tant que code (IaC) simplifie le déploiement et la maintenance de l'infrastructure cloud en utilisant des langages de programmation polyvalents ou des configurations YAML. Cette approche favorise la création d'environnements cohérents, reproductibles et automatisés, facilitant ainsi des transitions plus fluides entre les phases de développement, de test et de production.

3. Terraform

Terraform est un outil open source d'infrastructure en tant que code (IaC) développé par HashiCorp. Il permet aux ingénieurs de données de définir et de déployer une infrastructure de données, telle que des bases de données et des pipelines de données, de manière cohérente et fiable à l'aide d'un langage de configuration déclaratif, qui décrit l'état final souhaité de l'infrastructure plutôt que les étapes nécessaires pour atteindre cet état.

Terraform prend en charge le contrôle de version, la gestion des ressources via le code, la collaboration en équipe et l'intégration avec divers outils et plateformes.

4. Pulumi

Pulumi est un outil open source d'infrastructure en tant que code qui permet aux développeurs de créer, déployer et gérer une infrastructure cloud à l'aide de langages de programmation polyvalents tels que JavaScript, TypeScript, Java, Python, Go et C#. Il prend en charge un large éventail de fournisseurs de cloud, notamment AWS, Azure, GCP et Kubernetes.

Le framework Pulmi fournit une interface de ligne de commande (CLI) téléchargeable, un kit de développement logiciel (SDK) et un moteur de déploiement afin d'offrir une plateforme robuste pour l'approvisionnement, la mise à jour et la gestion de l'infrastructure cloud.

Devenez ingénieur en données

Outils d'orchestration des flux de travail

Les outils d'orchestration des flux de travail automatisent et gèrent l'exécution de flux de travail complexes liés au traitement des données, garantissant ainsi que les tâches sont exécutées dans l'ordre correct tout en gérant les dépendances.

5. Préfet

Prefect est un outil open source d'orchestration des flux de travail destiné aux flux de données modernes et aux processus ETL (extraction, transformation, chargement). Il aide les ingénieurs et les scientifiques spécialisés dans les données à automatiser et à gérer des pipelines de données complexes, garantissant ainsi un flux de données fluide, fiable et efficace, de la source à la destination.

Prefect propose un modèle d'exécution hybride qui combine les avantages de la gestion basée sur le cloud avec la sécurité et le contrôle de l'exécution locale. Son interface utilisateur conviviale et son API riche facilitent la surveillance et le dépannage des flux de données.

6. Luigi

Luigi est un package Python open source qui facilite la création de pipelines de données complexes pour les tâches batch de longue durée. Il a été développé par Spotify pour gérer la résolution des dépendances, la gestion des flux de travail, la visualisation, le traitement des échecs et l'intégration de la ligne de commande.

Luigi est conçu pour gérer diverses tâches, notamment le traitement, la validation et l'agrégation des données, et peut être utilisé pour créer des flux de données simples et sophistiqués. Luigi peut être intégré à divers outils et plateformes, tels qu'Apache Hadoop et Apache Spark, permettant aux utilisateurs de créer des pipelines de données pour traiter et analyser de grands volumes de données.

Outils d'entrepôt de données

Les entrepôts de données proposent des solutions cloud hautement évolutives pour le stockage, l'interrogation et la gestion de grands ensembles de données.

7. Snowflake

Snowflake est un entrepôt de données basé sur le cloud qui permet le stockage, le traitement et l'analyse de requêtes sur de grands volumes de données. Il repose sur une architecture unique qui sépare le stockage et le calcul, leur permettant ainsi d'évoluer indépendamment.

Snowflake est en mesure d'ajuster de manière dynamique la quantité de ressources informatiques en fonction de la demande. Cela garantit que les demandes sont traitées de manière rapide, efficace et rentable. Il est compatible avec les principaux fournisseurs de cloud, tels qu'AWS, GCP et Azure.

Nous vous invitons à consulter notre cours Introduction à Snowflake pour découvrir cet outil plus en détail.

8. PostgreSQL

PostgreSQL est un système de gestion de base de données relationnelle (SGBDR) open source performant qui peut également servir d'entrepôt de données. En tant qu'entrepôt de données, PostgreSQL fournit un référentiel centralisé pour stocker, gérer et analyser de grands volumes de données structurées provenant de diverses sources.

PostgreSQL propose des fonctionnalités telles que le partitionnement, l'indexation et l'exécution parallèle de requêtes, qui lui permettent de traiter efficacement des requêtes complexes et des ensembles de données volumineux.

Veuillez noter qu'un entrepôt de données PostgreSQL est une solution locale qui peut ne pas être aussi évolutive que certaines solutions entièrement gérées. Il nécessite davantage d'administration et de maintenance manuelles par rapport à ces solutions.

Pour en savoir plus, veuillez consulter notre Guide du débutant sur PostgreSQL.

Outils d'ingénierie analytique

Les outils d'ingénierie analytique optimisent la transformation, les tests et la documentation des données dans l'entrepôt de données.

9. dbt

dbt (data build tool) est un outil en ligne de commande et un framework open source conçu pour faciliter le workflow de transformation des données et la modélisation dans un environnement d'entrepôt de données. Il prend en charge tous les principaux entrepôts de données, y compris Redshift, BigQuery, Snowflake et PostgreSQL.

Il est possible d'accéder à dbt via dbt Core ou dbt Cloud. Le dbt Cloud propose une interface utilisateur Web, une interface CLI optimisée par dbt Cloud, un environnement hébergé, un planificateur de tâches intégré à l'application et des intégrations avec d'autres outils.

Vous pouvez acquérir les bases de dbt grâce à notre cours Introduction à dbt.

10. métabase

Metabase est un outil open source de veille économique (BI) et d'analyse qui permet aux utilisateurs de créer et de partager des tableaux de bord interactifs et des rapports d'analyse. Il est conçu pour être convivial, permettant aux utilisateurs non techniciens d'interroger des données, de visualiser les résultats et d'obtenir des informations sans avoir besoin de connaître le langage SQL ou d'autres langages de requête.

Il offre une configuration simple, la prise en charge de diverses sources de données, une interface utilisateur intuitive, des fonctionnalités de collaboration, des notifications personnalisables et une sécurité robuste pour l'exploration, l'analyse et le partage des données.

L'analyse des données et la création de tableaux de bord font partie de la science des données. Découvrez les différences entre un Data Scientist et un Data Engineer en lisant cet article : Data Scientist et Data Engineer.

Outils de traitement par lots

Ces outils destinés aux ingénieurs de données permettent le traitement efficace de grands volumes de données par lots, l'exécution de tâches informatiques complexes, l'analyse de données et les applications d'apprentissage automatique dans des environnements informatiques distribués.

11. Apache Spark

Apache Spark est un puissant framework informatique distribué open source conçu pour le traitement et l'analyse de données à grande échelle. Bien qu'il soit généralement reconnu pour sa capacité à traiter des données en streaming en temps réel, Spark excelle également dans le traitement par lots, ce qui en fait un outil précieux dans les workflows d'ingénierie des données.

Apache Spark propose des ensembles de données distribués résilients (RDD), des API riches pour divers langages de programmation, le traitement des données sur plusieurs nœuds d'un cluster et une intégration transparente avec d'autres outils. Il est hautement évolutif et rapide, ce qui le rend idéal pour le traitement par lots dans les tâches d'ingénierie des données.

12. Apache Hadoop

Apache Hadoop est un framework open source très répandu pour le stockage et le traitement distribués de grands ensembles de données. Au cœur de l'écosystème Hadoop se trouvent deux composants clés : le système de fichiers distribués Hadoop (HDFS) pour le stockage et le modèle de programmation MapReduce pour le traitement.

Apache Hadoop est un outil puissant et évolutif destiné aux ingénieurs de données, offrant un stockage rentable, une tolérance aux pannes, des capacités de traitement distribué et une intégration transparente avec d'autres outils de traitement des données.

Outils de streaming

Les outils de streaming constituent un moyen efficace de créer des pipelines de données en temps réel, permettant l'ingestion, le traitement et l'analyse continus des données en streaming.

13. Apache Kafka

Apache Kafka est une plateforme distribuée de streaming d'événements conçue pour le traitement haute performance et en temps réel des données, ainsi que pour la rationalisation des pipelines de données à grande échelle. Il est utilisé pour la construction de pipelines de données en temps réel, l'analyse en continu, l'intégration de données et les applications critiques.

Kafka est un système capable de traiter un volume important de données avec une faible latence. Il stocke les données de manière distribuée et tolérante aux pannes, garantissant ainsi leur disponibilité même en cas de défaillance matérielle ou de problème réseau.

Kafka est hautement évolutif et prend en charge plusieurs abonnés. Il s'intègre également parfaitement à divers outils et frameworks de traitement des données, tels qu'Apache Spark, Apache Flink et Apache Storm.

14. Apache Flink

Apache Flink est une plateforme open source pour le traitement distribué de flux et de lots. Il est capable de traiter des flux de données en temps réel, ce qui en fait un choix populaire pour la création de pipelines de données en continu et d'applications d'analyse en temps réel.

Flink est un outil de traitement de données qui offre des capacités de traitement rapide et efficace des données en temps réel et par lots. Il prend en charge plusieurs API (notamment Java, Scala et Python), permet une intégration transparente avec d'autres outils de traitement des données et offre une gestion efficace des états. Par conséquent, il s'agit d'un choix populaire pour l'analyse en temps réel, la détection des fraudes et les applications IoT en raison de sa capacité à traiter des données à haut débit avec une faible latence.

Conclusion

Ceci conclut notre liste, mais cela ne signifie pas nécessairement la fin de votre parcours dans le domaine de l'ingénierie des données. Inscrivez-vous au cursus « Ingénieur de données en Python » pour acquérir des connaissances en Python, SQL, conception de bases de données, cloud computing, nettoyage de données et visualisation. Une fois que vous aurez terminé le cursus, vous pourrez passer l'examen de certification professionnelle en ingénierie des données et devenir un ingénieur de données certifié.

Les ingénieurs de données jouent un rôle essentiel dans la création et la maintenance des pipelines de données qui alimentent l'analyse et la prise de décision au sein des organisations. Alors que les volumes et la complexité des données continuent d'augmenter de manière exponentielle, les ingénieurs de données doivent utiliser les outils appropriés pour collecter, traiter, stocker et fournir efficacement des données de qualité.

Nous avons présenté les 14 principaux outils d'ingénierie des données pour la conteneurisation, l'approvisionnement en infrastructure, l'automatisation des flux de travail, le stockage des données, l'ingénierie analytique, le traitement par lots et le streaming en temps réel.

Si vous débutez dans le domaine de l'ingénierie des données, commencez par vous familiariser avec Docker, Kubernetes, Terraform, Prefect, Snowflake, dbt, Apache Spark, Apache Kafka, et bien d'autres encore.

Une fois que vous maîtriserez ces outils, nous vous recommandons de consulter les 21 questions, réponses et exemples les plus fréquents lors d'entretiens d'embauche dans le domaine de l'ingénierie des données afin de vous préparer pour votre prochaine évolution de carrière.

Obtenez une certification pour le poste de Data Engineer de vos rêves

Nos programmes de certification vous aident à vous démarquer et à prouver aux employeurs potentiels que vos compétences sont adaptées à l'emploi.

En tant que data scientist certifié, je suis passionné par l'utilisation des technologies de pointe pour créer des applications innovantes d'apprentissage automatique. Avec une solide expérience en reconnaissance vocale, en analyse de données et en reporting, en MLOps, en IA conversationnelle et en NLP, j'ai affiné mes compétences dans le développement de systèmes intelligents qui peuvent avoir un impact réel. En plus de mon expertise technique, je suis également un communicateur compétent, doué pour distiller des concepts complexes dans un langage clair et concis. En conséquence, je suis devenu un blogueur recherché dans le domaine de la science des données, partageant mes idées et mes expériences avec une communauté grandissante de professionnels des données. Actuellement, je me concentre sur la création et l'édition de contenu, en travaillant avec de grands modèles linguistiques pour développer un contenu puissant et attrayant qui peut aider les entreprises et les particuliers à tirer le meilleur parti de leurs données.