Lernpfad

Dateningenieure kümmern sich darum, Datenpipelines zu erstellen, die Daten aufnehmen, verarbeiten und an verschiedene Endpunkte wie Datenbanken, Data Warehouses und Analyseplattformen liefern können. Durch den Aufbau und die Pflege dieser Datenpipelines machen es Dateningenieure möglich, dass Datenwissenschaftler und Analysten auf Echtzeitdaten zugreifen können, um Analysen durchzuführen und Entscheidungen zu treffen.

Von modernen Dateningenieuren wird erwartet, dass sie noch mehr Aufgaben übernehmen. Außerdem müssen sie Datenlösungen pflegen und einsetzen, Arbeitsabläufe verwalten, Datenlager überwachen, Daten umwandeln und visualisieren sowie verschiedene Batch-Verarbeitungs- und Streaming-Tools nutzen, um verschiedene Arten von Daten zu optimieren, zu erfassen und zu verarbeiten.

Lies unseren Leitfaden „Was ist Data Engineering?“ und finde heraus, was Data Engineering ist, wie es sich von Data Science unterscheidet, welchen Umfang es hat und wie man es lernen kann.

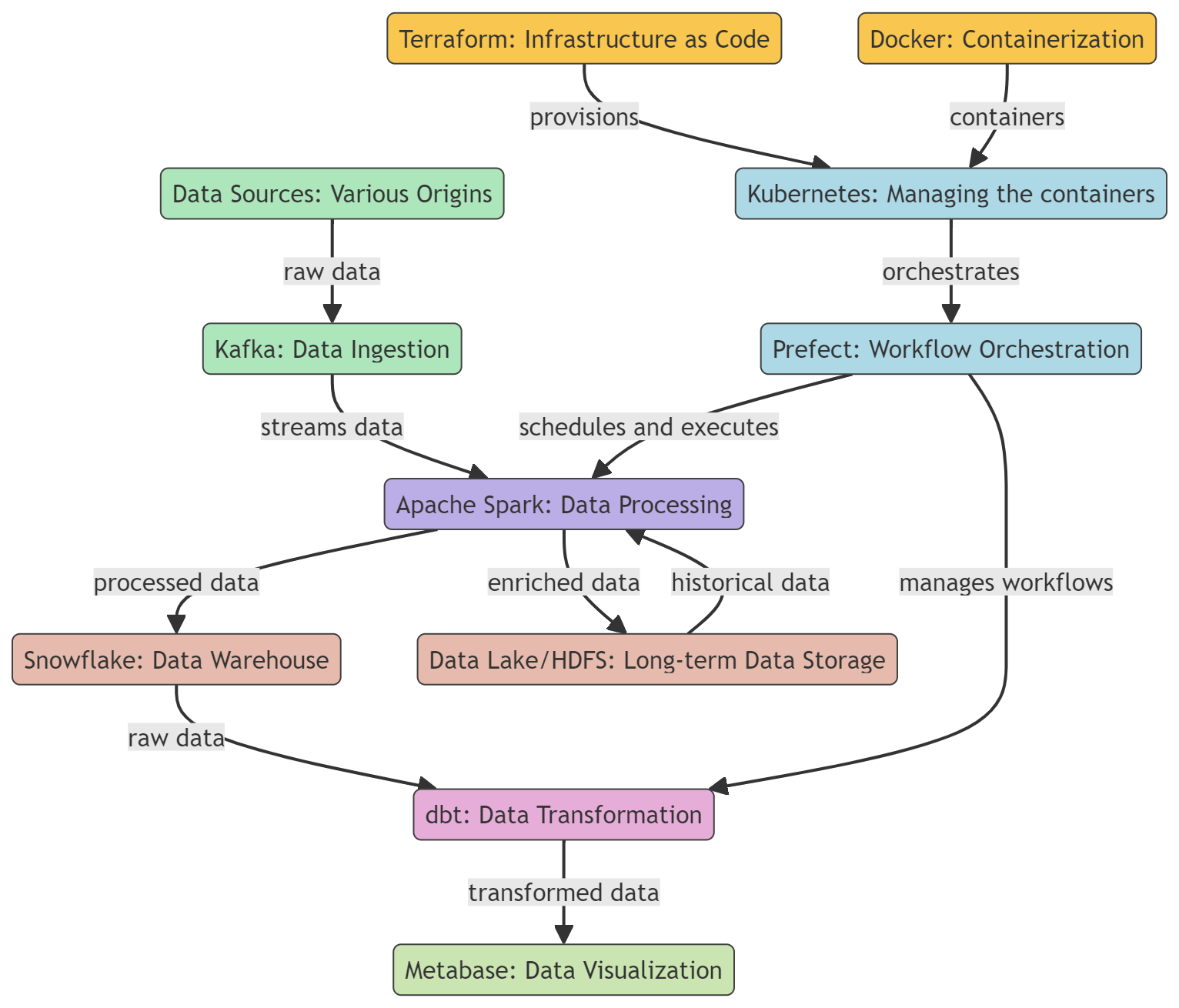

In diesem Beitrag schauen wir uns die wichtigsten Tools an, die bei Dateningenieuren beliebt und manchmal auch echt wichtig sind. Diese Tools werden für die Datenerfassung, -verarbeitung, -speicherung, -umwandlung und -visualisierung verwendet. Außerdem schauen wir uns Tools für die Containerisierung und das Workflow-Management an.

Lerne wichtige Datenverarbeitungskenntnisse, indem du unseren Blogbeitrag „Wie werde ich Datenverarbeiter? “ liest.

Containerisierungstools

Containerisierungstools bieten eine standardisierte Möglichkeit, Anwendungen über verschiedene Umgebungen hinweg zu verpacken, zu verteilen und zu verwalten. Es sorgt dafür, dass die Datenverarbeitungsprozesse einheitlich, skalierbar und effizient laufen.

1. Docker

Docker ist eine beliebte Containerisierungsplattform, die oft im Bereich Data Engineering genutzt wird, um Daten-Tools und -Anwendungen zu entwickeln, zu liefern und auszuführen. Es bietet eine einfache, tragbare und einheitliche Möglichkeit, Datentools und Anwendungen zu packen und einzusetzen, was es zu einer super Wahl für Dateningenieure macht.

Mit Docker kann man Container für verschiedene Datentools erstellen und verwalten, wie zum Beispiel Datenbanken, Data Warehouses, Datenverarbeitungs-Frameworks und Datenvisualisierungstools. Schau dir unser Tutorial „Docker für Data Science“ an, um mehr zu erfahren.

2. Kubernetes

Kubernetes ist eine Open-Source-Plattform, die die Bereitstellung, Skalierung und Verwaltung von containerisierten Anwendungen automatisiert, auch von solchen, die mit Docker erstellt wurden.

Docker ist ein Tool, mit dem man Datenverarbeitungsanwendungen, Datenbanken und Analysetools in Container packen kann. Das sorgt für einheitliche Umgebungen und trennt Anwendungen voneinander. Sobald die Container erstellt sind, übernimmt Kubernetes deren Verwaltung, indem es sich um deren Bereitstellung kümmert, sie je nach Auslastung skaliert und für hohe Verfügbarkeit sorgt.

Mehr über Containerisierung mit Docker und Kubernetes erfährst du in einem separaten Artikel.

Infrastruktur als Code-Tools

Infrastructure as Code (IaC) macht die Bereitstellung und Wartung von Cloud-Infrastrukturen einfacher, indem es allgemeine Programmiersprachen oder YAML-Konfigurationen nutzt. Dieser Ansatz hilft dabei, konsistente, wiederholbare und automatisierte Umgebungen zu schaffen, was für einen reibungsloseren Übergang zwischen den Entwicklungs-, Test- und Produktionsphasen sorgt.

3. Terraform

Terraform ist ein Open-Source-Tool für Infrastructure as Code (IaC), das von HashiCorp entwickelt wurde. Es hilft Dateningenieuren dabei, Dateninfrastrukturen wie Datenbanken und Datenpipelines auf eine einheitliche und zuverlässige Art und Weise zu definieren und einzusetzen. Dazu wird eine deklarative Konfigurationssprache genutzt, die den gewünschten Endzustand der Infrastruktur beschreibt und nicht die Schritte, die nötig sind, um diesen Zustand zu erreichen.

Terraform unterstützt Versionskontrolle, Ressourcenverwaltung über Code, Teamzusammenarbeit und die Integration mit verschiedenen Tools und Plattformen.

4. Pulumi

Pulumi ist ein Open-Source-Tool für Infrastructure as Code, mit dem Entwickler Cloud-Infrastrukturen mit gängigen Programmiersprachen wie JavaScript, TypeScript, Java, Python, Go und C# erstellen, bereitstellen und verwalten können. Es unterstützt viele Cloud-Anbieter, wie AWS, Azure, GCP und Kubernetes.

Das Pulmi-Framework bietet eine herunterladbare Befehlszeilenschnittstelle (CLI), ein Software Development Kit (SDK) und eine Bereitstellungs-Engine, um eine robuste Plattform für die Bereitstellung, Aktualisierung und Verwaltung der Cloud-Infrastruktur zu schaffen.

Werde Dateningenieur

Tools zur Workflow-Orchestrierung

Workflow-Orchestrierungstools automatisieren und verwalten die Ausführung komplexer Datenverarbeitungsabläufe und sorgen dafür, dass Aufgaben in der richtigen Reihenfolge ausgeführt werden, während sie gleichzeitig Abhängigkeiten verwalten.

5. Präfekt

Prefect ist ein kostenloses Tool, das man für moderne Datenabläufe und ETL-Prozesse (Extrahieren, Transformieren, Laden) nutzen kann. Es hilft Dateningenieuren und Wissenschaftlern dabei, komplexe Datenpipelines zu automatisieren und zu verwalten, sodass Daten zuverlässig und effizient von der Quelle zum Ziel fließen.

Prefect hat ein Hybrid-Ausführungsmodell, das die Vorteile von Cloud-basiertem Management mit der Sicherheit und Kontrolle einer lokalen Ausführung verbindet. Dank der benutzerfreundlichen Oberfläche und der umfangreichen API kannst du Daten-Workflows ganz einfach überwachen und Probleme lösen.

6. Luigi

Luigi ist ein Open-Source-Python-Paket, mit dem du komplexe Datenpipelines für lang laufende Batch-Jobs erstellen kannst. Es wurde von Spotify entwickelt, um Abhängigkeiten zu klären, Workflows zu verwalten, Sachen zu visualisieren, Fehler zu bearbeiten und die Befehlszeile zu integrieren.

Luigi ist dafür gemacht, verschiedene Aufgaben zu erledigen, wie Datenverarbeitung, Datenvalidierung und Datenaggregation, und kann zum Aufbau einfacher und komplexer Daten-Workflows genutzt werden. Luigi lässt sich mit verschiedenen Tools und Plattformen wie Apache Hadoop und Apache Spark verbinden, sodass man Datenpipelines erstellen kann, um große Datenmengen zu verarbeiten und zu analysieren.

Data-Warehouse-Tools

Data Warehouses bieten Cloud-basierte Lösungen, die super skalierbar sind, um große Datensätze zu speichern, abzufragen und zu verwalten.

7. Snowflake

Snowflake ist ein Cloud-basiertes Data Warehouse, mit dem man große Datenmengen speichern, verarbeiten und analysieren kann. Es basiert auf einer einzigartigen Architektur, die Speicher und Rechenleistung trennt, sodass sie unabhängig voneinander skaliert werden können.

Snowflake kann die Menge an Rechenressourcen je nach Bedarf dynamisch anpassen. So stellen wir sicher, dass Anfragen schnell, effizient und kostengünstig bearbeitet werden. Es funktioniert mit den großen Cloud-Anbietern wie AWS, GCP und Azure.

Schau dir unseren Kurs „Einführung in Snowflake“ an, um mehr über dieses Tool zu erfahren.

8. PostgreSQL

PostgreSQL ist ein echt starkes Open-Source-Relationales Datenbankmanagementsystem (RDBMS), das man auch als Data Warehouse nutzen kann. Als Data Warehouse bietet PostgreSQL einen zentralen Speicherplatz zum Speichern, Verwalten und Analysieren großer Mengen strukturierter Daten aus verschiedenen Quellen.

PostgreSQL hat Funktionen wie Partitionierung, Indizierung und parallele Abfrageausführung, mit denen es komplexe Abfragen und große Datensätze effizient verarbeiten kann.

Denk dran, dass ein PostgreSQL-Data Warehouse eine lokale Lösung ist, die vielleicht nicht so gut skalierbar ist wie manche komplett verwaltete Lösungen. Im Vergleich zu diesen Lösungen braucht es mehr manuelle Verwaltung und Wartung.

Mehr Infos findest du in unserem Einsteigerleitfaden zu PostgreSQL.

Analytik-Engineering-Tools

Analytics-Engineering-Tools machen die Umwandlung, das Testen und die Dokumentation von Daten im Data Warehouse einfacher.

9. dbt

dbt (Data Build Tool) ist ein Open-Source-Befehlszeilentool und -Framework, das entwickelt wurde, um den Datenumwandlungs-Workflow und die Modellierung in einer Data-Warehouse-Umgebung zu vereinfachen. Es unterstützt alle gängigen Data Warehouses, darunter Redshift, BigQuery, Snowflake und PostgreSQL.

Du kannst über dbt Core oder dbt Cloud auf dbt zugreifen. Die dbt Cloud hat eine Web-basierte Benutzeroberfläche, eine dbt Cloud-basierte CLI, eine gehostete Umgebung, einen Job-Scheduler in der App und lässt sich mit anderen Tools verbinden.

Mit unserem Kurs „Einführung in dbt“ kannst du die Grundlagen von dbt lernen.

10. Metabase

Metabase ist ein kostenloses Tool für Business Intelligence (BI) und Analysen, mit dem man interaktive Dashboards und Analyseberichte erstellen und teilen kann. Es ist so gemacht, dass es einfach zu bedienen ist, sodass Leute ohne technische Kenntnisse Daten abfragen, Ergebnisse anschauen und Erkenntnisse gewinnen können, ohne sich mit SQL oder anderen Abfragesprachen auskennen zu müssen.

Es ist einfach einzurichten, unterstützt verschiedene Datenquellen, hat eine einfache Benutzeroberfläche, Funktionen für die Zusammenarbeit, anpassbare Benachrichtigungen und starke Sicherheitsfunktionen für die Datenexploration, -analyse und -freigabe.

Datenanalyse und Dashboarding gehören zur Datenwissenschaft. Lies diesen Artikel, um mehr über die Unterschiede zwischen einem Datenwissenschaftler und einem Dateningenieur zu erfahren: Datenwissenschaftler vs. Dateningenieur.

Tools für die Stapelverarbeitung

Diese Tools für Dateningenieure machen es möglich, große Datenmengen in Stapeln effizient zu verarbeiten, komplexe Rechenaufgaben auszuführen, Datenanalysen durchzuführen und Anwendungen für maschinelles Lernen in verteilten Rechenumgebungen zu nutzen.

11. Apache Spark

Apache Spark ist ein starkes Open-Source-Framework für verteiltes Rechnen, das für die Verarbeitung und Analyse großer Datenmengen entwickelt wurde. Spark ist zwar bekannt dafür, dass es Echtzeit-Streaming-Daten gut verarbeiten kann, aber es ist auch super bei der Stapelverarbeitung, was es zu einem echten Pluspunkt in Datenverarbeitungs-Workflows macht.

Apache Spark bietet Resilient Distributed Datasets (RDDs), umfangreiche APIs für verschiedene Programmiersprachen, Datenverarbeitung über mehrere Knoten in einem Cluster hinweg und nahtlose Integration mit anderen Tools. Es ist super skalierbar und schnell, was es perfekt für die Stapelverarbeitung bei Datenverarbeitungsaufgaben macht.

12. Apache Hadoop

Apache Hadoop ist ein bekanntes Open-Source-Framework für die verteilte Speicherung und Verarbeitung großer Datenmengen. Im Mittelpunkt des Hadoop-Ökosystems stehen zwei wichtige Teile: das Hadoop Distributed File System (HDFS) für die Speicherung und das MapReduce-Programmiermodell für die Verarbeitung.

Apache Hadoop ist ein echt starkes und skalierbares Tool für Dateningenieure, das kostengünstigen Speicherplatz, Fehlertoleranz, verteilte Verarbeitungsfunktionen und nahtlose Integration mit anderen Datenverarbeitungstools bietet.

Streaming-Tools

Streaming-Tools sind echt praktisch, um Echtzeit-Datenpipelines aufzubauen, mit denen man Streaming-Daten ständig einlesen, verarbeiten und analysieren kann.

13. Apache Kafka

Apache Kafka ist eine verteilte Event-Streaming-Plattform, die für die leistungsstarke Echtzeit-Datenverarbeitung und die Optimierung großer Datenpipelines entwickelt wurde. Es wird für den Aufbau von Echtzeit-Datenpipelines, Streaming-Analysen, Datenintegration und geschäftskritischen Anwendungen genutzt.

Kafka ist ein System, das viele Daten mit geringer Latenzzeit verarbeiten kann. Es speichert Daten verteilt und fehlertolerant, sodass die Daten auch bei Hardwareausfällen oder Netzwerkproblemen verfügbar bleiben.

Kafka ist super skalierbar und kann mehrere Abonnenten gleichzeitig bedienen. Es lässt sich auch super mit verschiedenen Datenverarbeitungs-Tools und Frameworks wie Apache Spark, Apache Flink und Apache Storm verbinden.

14. Apache Flink

Apache Flink ist eine Open-Source-Plattform für verteilte Stream- und Batch-Verarbeitung. Es kann Datenströme in Echtzeit verarbeiten und ist deshalb super beliebt für den Aufbau von Streaming-Datenpipelines und Echtzeit-Analyseanwendungen.

Flink ist ein Tool zur Datenverarbeitung, das schnelle und effiziente Funktionen für die Echtzeit- und Batch-Datenverarbeitung bietet. Es unterstützt mehrere APIs (wie Java, Scala und Python), lässt sich super mit anderen Datenverarbeitungstools verbinden und bietet ein effizientes Statusmanagement. Deshalb ist es eine beliebte Wahl für Echtzeitanalysen, Betrugserkennung und IoT-Anwendungen, weil es Daten mit hohem Durchsatz und geringer Latenz verarbeiten kann.

Fazit

Das war's mit unserer Liste, aber das muss noch lange nicht das Ende deiner Reise in die Welt des Data Engineering sein. Mach den Lernpfad „Data Engineer in Python“, um mehr über Python, SQL, Datenbankdesign, Cloud Computing, Datenbereinigung und Visualisierung zu lernen. Sobald du den Lernpfad abgeschlossen hast, kannst du die Prüfung zur Data Engineer Career Certification machen und zertifizierter Data Engineer werden.

Dateningenieure sind super wichtig, wenn es darum geht, die Datenpipelines aufzubauen und zu pflegen, die Analysen und Entscheidungen in Unternehmen unterstützen. Da die Datenmengen und die Komplexität immer weiter wachsen, müssen Dateningenieure die richtigen Tools nutzen, um hochwertige Daten effizient zu erfassen, zu verarbeiten, zu speichern und bereitzustellen.

Wir haben die 14 besten Data-Engineering-Tools für Containerisierung, Infrastrukturbereitstellung, Workflow-Automatisierung, Data Warehousing, Analytics Engineering, Stapelverarbeitung und Echtzeit-Streaming vorgestellt.

Wenn du neu im Bereich Data Engineering bist, fang damit an, Docker, Kubernetes, Terraform, Prefect, Snowflake, dbt, Apache Spark, Apache Kafka und mehr zu lernen.

Wenn du diese Tools gut beherrschst, solltest du dir die 21 wichtigsten Fragen, Antworten und Beispiele für Vorstellungsgespräche im Bereich Data Engineering ansehen , um dich auf deinen nächsten Karriereschritt vorzubereiten.

Lass dich für deine Traumrolle als Data Engineer zertifizieren

Unsere Zertifizierungsprogramme helfen dir, dich von anderen abzuheben und potenziellen Arbeitgebern zu beweisen, dass deine Fähigkeiten für den Job geeignet sind.

Als zertifizierter Data Scientist ist es meine Leidenschaft, modernste Technologien zu nutzen, um innovative Machine Learning-Anwendungen zu entwickeln. Mit meinem fundierten Hintergrund in den Bereichen Spracherkennung, Datenanalyse und Reporting, MLOps, KI und NLP habe ich meine Fähigkeiten bei der Entwicklung intelligenter Systeme verfeinert, die wirklich etwas bewirken können. Neben meinem technischen Fachwissen bin ich auch ein geschickter Kommunikator mit dem Talent, komplexe Konzepte in eine klare und prägnante Sprache zu fassen. Das hat dazu geführt, dass ich ein gefragter Blogger zum Thema Datenwissenschaft geworden bin und meine Erkenntnisse und Erfahrungen mit einer wachsenden Gemeinschaft von Datenexperten teile. Zurzeit konzentriere ich mich auf die Erstellung und Bearbeitung von Inhalten und arbeite mit großen Sprachmodellen, um aussagekräftige und ansprechende Inhalte zu entwickeln, die sowohl Unternehmen als auch Privatpersonen helfen, das Beste aus ihren Daten zu machen.