Die Art und Weise, wie wir mit Technologie umgehen, entwickelt sich ständig weiter. Eine der spannendsten Entwicklungen der letzten Zeit ist im Bereich der künstlichen Intelligenz (KI), wo Maschinen so trainiert werden, dass sie wie Menschen denken, lernen und sogar kommunizieren können. Unter den vielen Entwicklungen in Bereichen wie generativer KI gibt's eine subtile Kunst, die immer mehr an Bedeutung gewinnt: Prompt Engineering.

Stell dir vor, du redest mit einer Maschine, gibst ihr einen Hinweis oder eine „Aufforderung“ und sie antwortet mit relevanten Infos oder Aktionen. Das ist das Wesentliche von Prompt Engineering. Es geht darum, die richtigen Fragen oder Anweisungen zu entwickeln, um KI-Modelle, vor allem große Sprachmodelle (LLMs), so zu steuern, dass sie die gewünschten Ergebnisse liefern. Egal, ob du ein Technikfan bist, der sich für die neuesten Entwicklungen im Bereich der KI interessiert, oder ein Profi, der die Möglichkeiten von Sprachmodellen nutzen will – es ist super wichtig, sich mit Prompt Engineering auszukennen.

In diesem Artikel erklären wir die technischen Feinheiten des Prompt Engineering und zeigen dir, wie wichtig es in der breiteren KI-Landschaft ist. Und für alle, die tiefer in die Welt der KI und Sprachverarbeitung eintauchen wollen, haben wir eine Reihe von Ressourcen zusammengestellt, die euch dabei helfen, mehr zu erfahren.

KI-Upskilling für Einsteiger

Was ist Prompt Engineering?

Im Grunde ist Prompt Engineering so ähnlich wie einem Kind durch Fragen was beizubringen. Genauso wie eine gut formulierte Frage die Gedanken eines Kindes lenken kann, kann eine gut gemachte Eingabeaufforderung ein KI-Modell, vor allem ein großes Sprachmodell (LLM), zu einem bestimmten Ergebnis führen. Lass uns dieses Konzept genauer anschauen.

Definition und Kernkonzepte

Prompt Engineering ist die Praxis, Prompts – also Fragen oder Anweisungen – zu entwerfen und zu verfeinern, um bestimmte Antworten von KI-Modellen zu bekommen. Sieh es dir als Schnittstelle zwischen menschlicher Absicht und Maschinenleistung an.

Im Bereich der KI, wo Modelle mit riesigen Datensätzen trainiert werden, kann die richtige Eingabe den Unterschied machen, ob ein Modell deine Anfrage versteht oder falsch interpretiert.

Wenn du zum Beispiel schon mal mit Sprachassistenten wie Siri oder Alexa gesprochen hast, hast du dich mit einer einfachen Form des Prompt Engineering beschäftigt. Wie du deine Bitte formulierst – „Spiel entspannende Musik“ im Gegensatz zu „Spiel Beethovens Sinfonie“ – kann zu ganz unterschiedlichen Ergebnissen führen.

Die technische Seite des Prompt Engineering

Prompt Engineering hat seine Wurzeln in der Sprachwissenschaft, ist aber auch eng mit den technischen Feinheiten von KI-Modellen verbunden. Hier ein genauerer Blick auf die technische Seite:

- Modellarchitekturen. Große Sprachmodelle (LLMs) wie GPT (Generative Pre-trained Transformer) und Mata's LLaMAbasieren auf Transformer-Architekturen. Mit diesen Architekturen können Modelle riesige Datenmengen verarbeiten und durch Selbstaufmerksamkeitsmechanismen den Kontext verstehen. Um gute Eingabeaufforderungen zu erstellen, muss man oft diese zugrunde liegenden Strukturen verstehen.

- Trainingsdaten und Tokenisierung. LLMs werden mit riesigen Datensätzen trainiert, wobei die Eingabedaten zur Verarbeitung in kleinere Einheiten (Token) zerlegt werden. Die Wahl der Tokenisierung (wortbasiert, Byte-Paar usw.) kann beeinflussen, wie ein Modell eine Eingabe interpretiert. Zum Beispiel kann ein Wort, das anders tokenisiert wird, unterschiedliche Ergebnisse bringen.

- Modellparameter. LLMs haben Millionen, wenn nicht sogar Milliarden von Parametern. Diese Parameter, die während des Trainingsprozesses genau abgestimmt werden, bestimmen, wie das Modell auf eine Eingabe reagiert. Wenn man die Beziehung zwischen diesen Parametern und den Modellergebnissen versteht, kann man effektivere Eingabeaufforderungen erstellen.

- Temperatur und Top-k-Sampling. Beim Erzeugen von Antworten nutzen Modelle Techniken wie Temperatureinstellung und Top-k-Sampling, um die Zufälligkeit und Vielfalt der Ergebnisse zu bestimmen. Zum Beispiel könnte eine höhere Temperatur zu vielfältigeren (aber möglicherweise weniger genauen) Antworten führen. Prompt-Ingenieure ändern diese Einstellungen oft, um die Ergebnisse der Modelle zu verbessern.

- Verlustfunktionen und Gradienten. Auf einer tieferen Ebene wird das Verhalten des Modells bei der schnellen Reaktion von seinen Verlustfunktionen und Gradienten beeinflusst. Diese mathematischen Konstrukte leiten den Lernprozess des Modells. Auch wenn Prompt-Ingenieure diese normalerweise nicht direkt anpassen, kann das Verständnis ihrer Auswirkungen Einblicke in das Modellverhalten geben.

Für alle, die wissen wollen, wie solche Modelle funktionieren, gibt's in unserem Tutorial „Transformers and Hugging Face“ einen tiefen Einblick in die Mechanismen hinter beliebten LLMs.

Warum schnelles Engineering wichtig ist

Prompt Engineering ist die Brücke, die eine gute Kommunikation zwischen Mensch und KI sicherstellt. Es geht nicht nur darum, die richtige Antwort zu finden, sondern auch darum, dass die KI den Kontext, die Feinheiten und die Absicht hinter jeder Anfrage versteht.

Die Entwicklung der Technik treibt voran

Prompt Engineering ist zwar eine ziemlich neue Sache, hat aber echt lange Wurzeln in der Geschichte der natürlichen Sprachverarbeitung (NLP) und des maschinellen Lernens. Wenn man seine Entwicklung versteht, bekommt man einen Eindruck von seiner heutigen Bedeutung.

Die Anfänge von NLP

Die Anfänge von NLP gehen auf die Mitte des 20. Jahrhunderts zurück, als digitale Computer aufkamen. Die ersten Versuche im Bereich der natürlichen Sprachverarbeitung (NLP) waren regelbasiert und stützten sich auf manuell erstellte Regeln und einfache Algorithmen. Diese Systeme waren ziemlich starr und hatten echt Probleme mit den Feinheiten und Nuancen der menschlichen Sprache.

Statistisches NLP und maschinelles Lernen

Mit der zunehmenden Rechenleistung und den immer größeren Datensätzen hat sich Ende des 20. und Anfang des 21. Jahrhunderts ein Trend zu statistischen Methoden entwickelt. Algorithmen für maschinelles Lernen haben angefangen, eine wichtige Rolle zu spielen, weil sie flexiblere und datengesteuerte Sprachmodelle ermöglichen. Allerdings hatten diese Modelle immer noch Probleme beim Verstehen von Zusammenhängen und beim Erstellen von zusammenhängenden längeren Texten.

Aufstieg von transformatorbasierten Modellen

Die Vorstellung der Transformer-Architektur in dem Artikel„Attention is All You Need” im Jahr 2017 war ein wichtiger Wendepunkt. Transformatoren können mit ihren Selbstaufmerksamkeitsmechanismen riesige Datenmengen verarbeiten und komplizierte Sprachmuster erfassen. Das hat zur Entwicklung von Modellen wie Googles BERT geführt, die Aufgaben wie Textklassifizierung und Stimmungsanalyse total verändert haben.

Die Auswirkungen von OpenAI's GPT

Die Generative Pre-trained Transformer (GPT)-Serie von OpenAI, vor allem GPT-2 und GPT-3, hat Transformer auf ein neues Level gebracht. Diese Modelle mit ihren Milliarden von Parametern haben eine echt coole Fähigkeit gezeigt, zusammenhängende, kontextbezogene und oft kaum von menschlich erstellten Texten zu unterscheidende Texte zu generieren. Der Aufstieg der GPT-Modelle hat gezeigt, wie wichtig Prompt Engineering ist, weil die Qualität der Ergebnisse stark von der Genauigkeit und Klarheit der Prompts abhängt.

Prompt Engineering heute

Da Modelle mit Transformatoren in der Industrie, Forschung und im Alltag immer mehr genutzt werden, ist das Prompt Engineering zu einem wichtigen Bereich geworden. Es ist die Brücke, die dafür sorgt, dass diese leistungsstarken Modelle effektiv genutzt werden und KI-Tools zugänglicher und benutzerfreundlicher werden. Mit dem neuen o1 pro-Modus von OpenAI ist es wichtiger denn je, genaue und effektive Eingabeaufforderungen zu haben. Wir sehen sogar KI-Agenten-Tools wie den Computer von Anthropic, die deinen Computer mit den richtigen Eingabeaufforderungen automatisieren können.

Ob du mit generativer KI deine Kreativität entfesseln oder chatGPT für Datenwissenschaftsprojekte nutzen willst – es wird immer wichtiger zu verstehen, wie Prompts funktionieren.

Neueste Entwicklungen im Bereich Prompt Engineering

Ende 2024 entwickelt sich der Bereich des Prompt Engineering immer noch schnell weiter, was zeigt, wie dynamisch KI und ihre Anwendungen sind. Die neuesten Entwicklungen haben echt viel dazu beigetragen, wie wir mit KI-Modellen, vor allem mit großen Sprachmodellen (LLMs), umgehen. Hier sind ein paar der wichtigsten Entwicklungen:

Besseres Verständnis des Kontexts

Die neuesten Fortschritte bei LLMs, vor allem bei Modellen wie GPT-4o und darüber hinaus, haben echt beeindruckende Verbesserungen beim Verständnis von Kontext und Nuancen gebracht. Diese Modelle können jetzt besser mit komplizierten Eingaben umgehen, den größeren Zusammenhang berücksichtigen und genauere und differenziertere Antworten liefern. Dieser Sprung nach vorne ist zum Teil auf die ausgeklügelteren Trainingsmethoden zurückzuführen, bei denen vielfältige und umfangreiche Datensätze zum Einsatz kommen, sodass die Modelle die Feinheiten der menschlichen Kommunikation besser verstehen können.

Adaptive Aufforderungstechniken

Adaptive Aufforderungen sind ein neuer Trend, bei dem KI-Modelle entwickelt werden, die ihre Antworten an den Eingabestil und die Vorlieben des Benutzers anpassen. Dieser Ansatz zur Personalisierung soll die Interaktion mit KI natürlicher und benutzerfreundlicher machen. Wenn jemand zum Beispiel eher kurze Fragen stellt, passt sich die KI an und gibt kurze Antworten, oder umgekehrt. Diese Entwicklung ist besonders vielversprechend, um die Benutzererfahrung bei KI-gesteuerten Anwendungen wie virtuellen Assistenten und Chatbots zu verbessern.

Multimodales Prompt-Engineering

Die Integration von multimodalen Funktionen in KI-Modelle hat neue Möglichkeiten im Bereich des Prompt Engineering eröffnet. Multimodale Modelle können Eingaben verarbeiten und darauf reagieren, die eine Mischung aus Text, Bildern und manchmal sogar Audio-Eingaben sind. Dieser Fortschritt ist echt wichtig, weil er den Weg für umfassendere KI-Anwendungen ebnet, die besser verstehen und interagieren können, ähnlich wie wir Menschen wahrnehmen und kommunizieren.

Echtzeit-Optimierung

Dank der Fortschritte bei der Echtzeit-Prompt-Optimierungstechnologie können KI-Modelle jetzt sofort sagen, wie gut Prompts funktionieren. Diese Technologie checkt, wie klar die Eingabeaufforderung ist, ob sie vielleicht voreingenommen ist und ob sie mit dem gewünschten Ergebnis übereinstimmt, und gibt dann Verbesserungsvorschläge. Diese Echtzeit-Anleitung ist echt super für Anfänger und erfahrene Nutzer und macht das Erstellen von effektiven Eingabeaufforderungen einfacher.

Integration mit domänenspezifischen Modellen

Prompt Engineering wird auch mit domänenspezifischen KI-Modellen kombiniert. Diese speziellen Modelle werden mit branchenspezifischen Daten trainiert, sodass sie in Bereichen wie Medizin, Recht und Finanzen genauer und relevanter auf Eingaben reagieren können. Die Kombination aus schneller Entwicklung und diesen maßgeschneiderten Modellen macht KI in speziellen Bereichen noch genauer und nützlicher.

Die Kunst und Wissenschaft des Erstellens von Eingabeaufforderungen

Eine gute Aufforderung zu schreiben ist echt eine Kunst und eine Wissenschaft. Es ist eine Kunst, weil es Kreativität, Intuition und ein tiefes Verständnis der Sprache braucht. Es ist eine Wissenschaft, weil es darauf basiert, wie KI-Modelle Antworten verarbeiten und generieren.

Die Feinheiten der Aufforderung

Jedes Wort in einer Eingabeaufforderung zählt. Schon eine kleine Änderung im Wortlaut kann bei einem KI-Modell zu ganz anderen Ergebnissen führen. Wenn du zum Beispiel ein Modell fragst, „Beschreibe den Eiffelturm“ oder „Erzähle die Geschichte des Eiffelturms“, kriegst du ganz unterschiedliche Antworten. Das erste könnte eine physische Beschreibung liefern, während das zweite sich mit seiner historischen Bedeutung beschäftigt.

Es ist echt wichtig, diese Feinheiten zu verstehen, vor allem wenn man mit LLMs arbeitet. Diese Modelle, die mit riesigen Datensätzen trainiert wurden, können auf Basis der eingehenden Signale eine Vielzahl von Antworten generieren. Es geht nicht nur darum, eine Frage zu stellen, sondern sie so zu formulieren, dass sie zu dem Ergebnis passt, das du haben willst.

Wir haben das in unserem Leitfaden zur Verwendung von Midjourney zum Erstellen von Grafiken gesehen – wenn du deinen Eingaben für den Begriff „Raumschiff“ unterschiedliche Gewichte gibst, kannst du entweder Bilder von Science-Fiction-Raumschiffen oder von einem Schiff, das durch den Weltraum segelt, bekommen.

Wichtige Elemente einer Aufforderung

Schauen wir uns mal an, was eine gute Aufforderung ausmacht:

- Anleitung. Das ist die wichtigste Anweisung der Eingabeaufforderung. Es sagt dem Modell, was du von ihm willst. Zum Beispiel gibt „Fasse den folgenden Text zusammen“ dem Modell eine klare Aufgabe vor.

- Context. Der Kontext liefert zusätzliche Infos, die dem Modell helfen, das Gesamtbild oder den Hintergrund besser zu verstehen. Zum Beispiel gibt „Angesichts des wirtschaftlichen Abschwungs Anlageberatung leisten“ dem Modell einen Rahmen, in dem es seine Antwort formulieren kann.

- Daten eingeben. Das sind die spezifischen Infos oder Daten, die das Modell verarbeiten soll. Es könnte ein Absatz, eine Reihe von Zahlen oder sogar ein einzelnes Wort sein.

- Ausgangsanzeige. Besonders nützlich in Rollenspielszenarien, hilft dieses Element dem Modell dabei, das gewünschte Antwortformat oder die gewünschte Antwortart zu finden. Zum Beispiel gibt „Schreib den folgenden Satz im Stil von Shakespeare um“ dem Modell eine stilistische Richtung vor.

In unserem Leitfaden speziell zum Thema chatGPT-Prompt-Engineering haben wir uns ein paar konkrete Beispiele für gute Prompts für das Tool angesehen.

chatGPT-Prompt-Engineering in der Praxis

Für einen praktischen Ansatz bietet der Kurs „Building Chatbots in Python ” von DataCamp Übungen zum Erstellen von Eingabeaufforderungen für Chatbot-Interaktionen.

Techniken im Prompt Engineering

Die perfekte Eingabeaufforderung zu finden, braucht oft ein bisschen Experimentieren. Hier sind ein paar Tipps, die helfen können:

Grundtechniken

Das sind Tipps, mit denen jeder seine Eingabeaufforderungen verbessern kann.

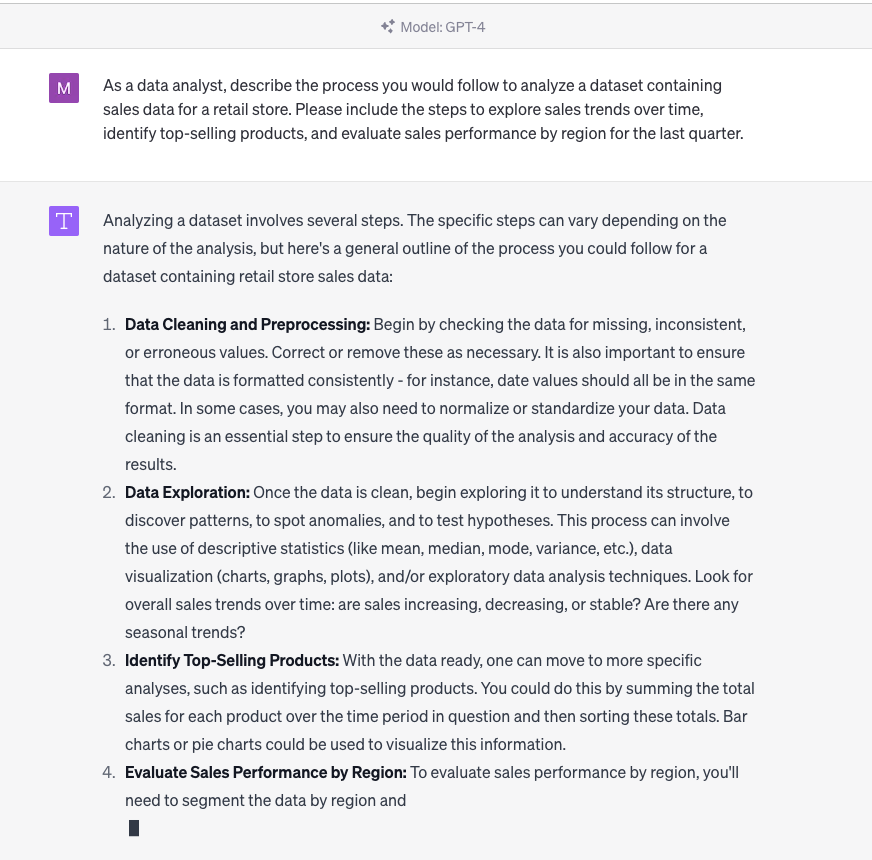

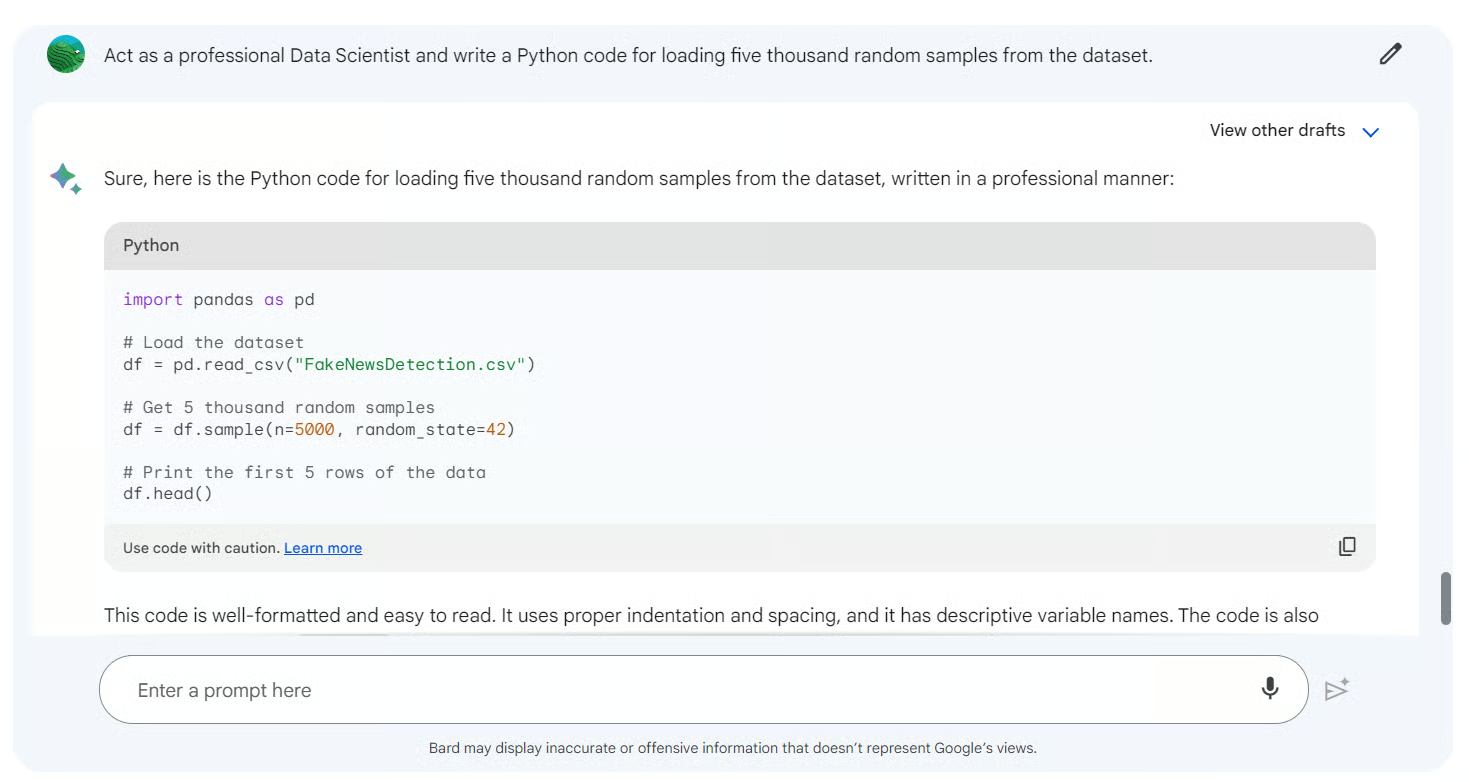

- Rollenspiel. Indem du das Modell wie eine bestimmte Person agieren lässt, zum Beispiel wie einen Historiker oder Wissenschaftler, kannst du maßgeschneiderte Antworten bekommen. Zum Beispiel könnte die Frage „Als Ernährungsberater, schau dir mal diesen Diätplan an“ eine Antwort bringen, die auf Ernährungswissenschaft basiert.

- Iterative Verfeinerung. Fang mit einer allgemeinen Eingabeaufforderung an und verfeinere sie nach und nach anhand der Antworten des Modells. Dieser wiederholte Prozess hilft dabei, die Eingabeaufforderung zu perfektionieren.

- Feedback-Schleifen. Nutze die Ergebnisse des Modells, um nachfolgende Eingabeaufforderungen anzupassen. Diese dynamische Interaktion sorgt dafür, dass die Antworten des Modells mit der Zeit immer besser zu dem passen, was die Nutzer erwarten.

Fortgeschrittene Techniken

Hier sehen wir komplexere Strategien, die ein tieferes Verständnis des Verhaltens des Modells erfordern.

- Zero-Shot-Prompting. Bei dieser Technik bekommt das Modell eine Aufgabe, die es während des Trainings noch nicht gesehen hat. Es checkt, ob das Modell gut verallgemeinern und sinnvolle Ergebnisse liefern kann, ohne sich auf frühere Beispiele zu verlassen.

- Few-Shot-Prompting/kontextbezogenes Lernen. Hier kriegt das Modell ein paar Beispiele (Aufnahmen), um seine Reaktion zu steuern. Durch das Bereitstellen von Kontext oder früheren Beispielen kann das Modell die gewünschte Ausgabe besser verstehen und generieren. Zum Beispiel, indem man einem Modell mehrere Beispiele übersetzter Sätze zeigt, bevor man es bittet, einen neuen Satz zu übersetzen.

- Gedankenkette (CoT). Bei dieser fortgeschrittenen Technik wird das Modell durch eine Reihe von Argumentationsschritten geführt. Indem es eine komplizierte Aufgabe in kleinere Schritte oder „Argumentationsketten“ aufteilt, kann das Modell Sprache besser verstehen und genauere Ergebnisse liefern. Das ist so, als würde man jemanden Schritt für Schritt durch eine komplizierte Matheaufgabe führen.

Für alle, die sich näher mit den Methoden hinter diesen Techniken beschäftigen wollen, bietet unser Kurs zu fortgeschrittenem NLP mit spaCy praktische Übungen und Beispiele aus der Praxis.

Die Balance zwischen Spezifität und Offenheit

Auch wenn eine genaue Frage zu genaueren Antworten führen kann, ist es manchmal gut, Fragen ein bisschen offen zu lassen. Dadurch kann das Modell auf sein umfangreiches Training zurückgreifen und Einblicke oder Antworten liefern, die vielleicht nicht sofort offensichtlich sind. Zum Beispiel ist „Erzähl mir was Interessantes über das Sonnensystem“ eine offene Frage, die aber echt spannende Einblicke vom Modell bringen kann.

Mit Tools wie Google Bard kannst du so konkret oder offen sein, wie du willst.

Wie Prompt Engineering funktioniert

Die erste Eingabe zu machen, ist nur der Anfang. Um die Möglichkeiten von KI-Modellen voll auszuschöpfen und sicherzustellen, dass sie den Absichten der Nutzer entsprechen, ist es wichtig, die Eingabeaufforderungen zu verfeinern und zu optimieren. Dieser iterative Prozess ist eine Mischung aus Kunst und Wissenschaft, die sowohl Intuition als auch datengestützte Erkenntnisse erfordert.

1. Mach eine passende Eingabeaufforderung

Wir haben in einem separaten Artikel ein paar chatGPT-Prompts für das Marketing angeschaut und außerdem ein chatGPT-Spickzettel zusammengestellt, der viele Details zu diesem Tool enthält. Es gibt aber viele Tools (wie LlamaIndex und Langchain ), die Eingabeaufforderungen brauchen. Hier sind ein paar allgemeine Regeln für die Erstellung von Eingabeaufforderungen für KI-Tools:

- Klarheit ist super wichtig. Stell sicher, dass die Aufforderung klar und eindeutig ist. Vermeide Fachjargon, es sei denn, er ist im Kontext echt nötig.

- Probier mal Rollenspiele aus. Wie schon gesagt, wenn man dem Modell eine bestimmte Rolle gibt, kann das zu besser angepassten Antworten führen.

- Einschränkungen nutzen. Grenzen oder Einschränkungen festzulegen kann dabei helfen, das Modell zum gewünschten Ergebnis zu führen. Zum Beispiel gibt „Beschreibe den Eiffelturm in drei Sätzen“ eine klare Vorgabe für die Länge.

- Vermeide Suggestivfragen. Suggestive Fragen können die Ergebnisse des Modells beeinflussen. Es ist wichtig, neutral zu bleiben, um eine unvoreingenommene Antwort zu bekommen.

Für alle, die praktische Übungen zur Verfeinerung von Eingabeaufforderungen machen wollen, bietet das Tutorial zur Feinabstimmung von GPT-3 nützliche Einblicke.

2. Wiederholen und bewerten

Der Prozess der Verfeinerung von Eingabeaufforderungen läuft immer wieder ab. Hier ist ein typischer Arbeitsablauf:

- Schreib die erste Eingabeaufforderung. Je nachdem, was du machen willst und was du am Ende haben willst.

- Probier mal die Eingabeaufforderung aus. Benutz das KI-Modell, um eine Antwort zu machen.

- Schau dir das Ergebnis an. Schau mal, ob die Antwort mit der Absicht übereinstimmt und die Kriterien erfüllt.

- Mach die Eingabeaufforderung genauer. Mach die notwendigen Anpassungen auf der Grundlage der Bewertung.

- Wiederhole das. Mach einfach weiter, bis du die gewünschte Qualität hast.

Bei diesem Prozess ist es auch wichtig, verschiedene Inputs und Szenarien zu berücksichtigen, um sicherzustellen, dass die Eingabeaufforderung in einer Reihe von Situationen gut funktioniert.

3. Kalibrieren und feinabstimmen

Neben der Verbesserung der Eingabeaufforderung selbst kann man auch das KI-Modell anpassen oder optimieren. Dabei werden die Parameter des Modells angepasst, damit sie besser zu bestimmten Aufgaben oder Datensätzen passen. Auch wenn das eine fortgeschrittenere Technik ist, kann sie die Leistung des Modells für spezielle Anwendungen echt verbessern.

Wenn du dich genauer mit der Modellkalibrierung und Feinabstimmung beschäftigen willst, check unseren Kurs zu LLM-Konzepten aus, der sich mit Feinabstimmungstechniken und Training beschäftigt.

Die Rolle eines Prompt Engineers

Da KI immer mehr Branchen verändert und die Art und Weise, wie wir mit Technologie umgehen, neu definiert, ist eine neue Rolle in den Vordergrund gerückt: der Prompt Engineer. Diese Rolle ist super wichtig, um die Lücke zwischen menschlicher Absicht und maschinellem Verständnis zu schließen und sicherzustellen, dass KI-Modelle effektiv kommunizieren und relevante Ergebnisse liefern.

Ein neuer Karriereweg in der KI?

Die schnellen Fortschritte in der Verarbeitung natürlicher Sprache (Natural Language Processing, NLP) und die weit verbreitete Nutzung von großen Sprachmodellen (Large Language Models, LLMs) haben einen Nischenmarkt geschaffen, auf dem Experten, die effektive Eingabeaufforderungen erstellen können, echt gefragt sind. Diese Leute, die man als Prompt-Ingenieure bezeichnet, sind nicht nur Techniker, sondern Künstler, die die Feinheiten von Sprache, Kontext und KI-Verhalten verstehen.

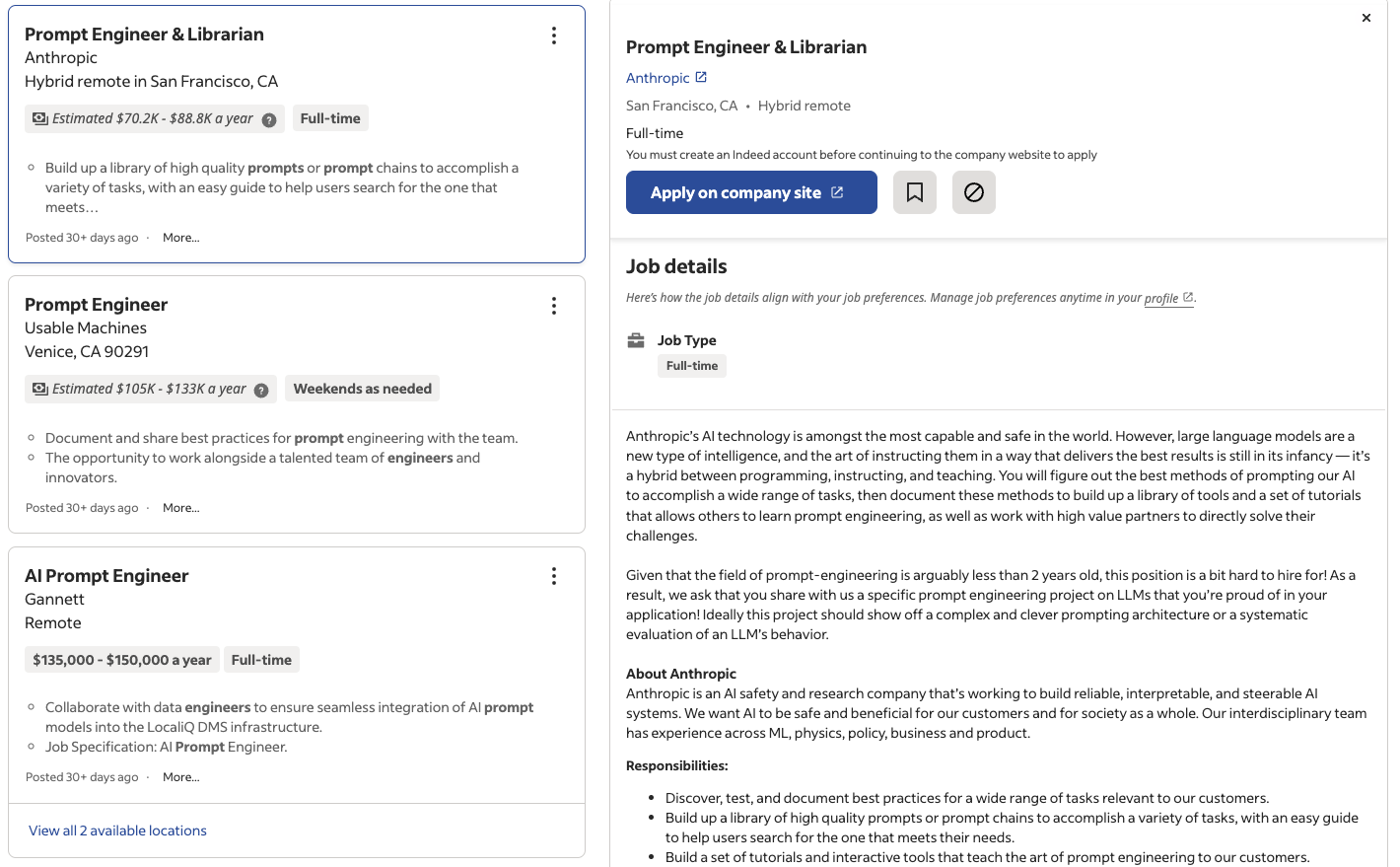

Wie unter anderem im Time Magazine berichtet, erkennen Unternehmen, von Tech-Giganten bis hin zu Start-ups, den Wert spezialisierter Prompt-Engineering-Funktionen. Da KI-basierte Lösungen immer mehr in Produkte und Dienstleistungen eingebaut werden, sorgt das Know-how eines Prompt Engineers dafür, dass diese Lösungen effektiv, benutzerfreundlich und kontextbezogen sind.

Jobportale wie Indeed und LinkedIn haben schon Tausende Stellenangebote für Prompt-Ingenieure allein in den USA, mit Gehältern zwischen 50.000 und über 150.000 Dollar pro Jahr.

Ingenieursjobs, die auf Indeed ausgeschrieben sind

Technische Fähigkeiten für die schnelle Entwicklung

Je nachdem, was genau die Aufgabe ist und wie technisch sie ist, braucht ein Prompt Engineer ein gutes Verständnis in verschiedenen technischen Bereichen:

- Verständnis von NLP. Man braucht echt gute Kenntnisse über Techniken und Algorithmen der natürlichen Sprachverarbeitung.

- Vertrautheit mit LLMs. Erfahrungen mit Modellen wie GPT, PaLM2 und anderen neuen Modellen und ihren zugrunde liegenden Architekturen.

- Experimentieren und wiederholen. Die Möglichkeit, Eingabeaufforderungen anhand der Modellergebnisse zu testen, zu verfeinern und zu optimieren.

- Datenanalyse. Modellantworten analysieren, Muster erkennen und datengestützte Entscheidungen treffen.

Für alle, die ihre technischen Fähigkeiten verbessern wollen, haben wir mit unserem Skill Track „Natural Language Processing in Python“ ein umfassendes Programm, das perfekt für angehende Prompt Engineers ist.

Nicht-technische Fähigkeiten für die schnelle Entwicklung

Technisches Know-how ist zwar super wichtig, aber ein guter Ingenieur braucht auch ein paar nicht-technische Fähigkeiten:

- Kommunikation. Die Fähigkeit, Ideen rüberzubringen, mit Teams zusammenzuarbeiten und die Bedürfnisse der Nutzer zu verstehen.

- Fachwissen. Je nach dem, was man macht, kann Fachwissen echt super nützlich sein.

- Sprachkenntnisse. Beherrschung von Sprache, Grammatik und Semantik, um effektive Eingabeaufforderungen zu erstellen.

- Kritisches Denken. Modellausgaben checken, Verzerrungen erkennen und faire KI-Praktiken sicherstellen.

- Kreativität. Über den Tellerrand schauen, mit neuen Arten von Eingabeaufforderungen rumprobieren und innovative Lösungen finden.

Diese Soft Skills, zusammen mit technischem Know-how, machen die Rolle eines Prompt Engineers sowohl herausfordernd als auch lohnend und ebnen den Weg für eine neue Ära der Zusammenarbeit zwischen Mensch und KI.

Die Zukunft des Prompt Engineering

Da wir kurz vor dem Beginn eines KI-gesteuerten Zeitalters stehen, wird Prompt Engineering eine wichtige Rolle dabei spielen, die Zukunft der Interaktion zwischen Mensch und KI zu gestalten. Obwohl das Gebiet noch ziemlich neu ist, hat es echt viel Potenzial und Aussichten auf Wachstum.

Laufende Forschung und Entwicklung

Die Welt der KI ist echt dynamisch, mit Forschung und Innovationen, die schnell auftauchen. Im Zusammenhang mit Prompt Engineering:

- Adaptive Aufforderung. Forscher suchen nach Möglichkeiten, wie Modelle ihre eigenen Eingabeaufforderungen je nach Kontext selbst generieren können, damit weniger manuelle Eingaben nötig sind.

- Multimodale Eingabeaufforderungen. Mit dem Aufkommen von multimodalen KI-Modellen, die sowohl Text als auch Bilder verarbeiten können, wird das Feld des Prompt Engineering um visuelle Hinweise erweitert.

- Ethische Aufforderung. Da KI-Ethik immer wichtiger wird, geht's darum, Anweisungen zu entwickeln, die Fairness, Transparenz und die Reduzierung von Voreingenommenheit sicherstellen.

Für alle, die über die neuesten Entwicklungen auf dem Laufenden bleiben wollen, geht unser Artikel über Ethik in der generativen KI auf einige der großen Fragen ein, mit denen wir uns gerade beschäftigen. Du kannst auch die Fähigkeiten von KI-Ingenieuren und ihre Überschneidungen mit dem Prompt Engineering in einem separaten Leitfaden erkunden.

Der langfristige Wert und die Bedeutung

Prompt Engineering ist nicht nur so ein kurzer Trend. Da KI-Modelle immer komplexer werden und in viele verschiedene Bereiche reinkommen – von der Gesundheitsversorgung bis zur Unterhaltungsbranche – wird es echt wichtig, dass die Kommunikation gut klappt. Prompt-Ingenieure sind die Leute, die dafür sorgen, dass diese Modelle zugänglich, benutzerfreundlich und kontextbezogen sind.

Außerdem wird sich die Rolle eines Prompt Engineers weiterentwickeln, wenn KI immer mehr Leute ohne technisches Know-how nutzen und mit diesen Modellen arbeiten. Sie werden dafür zuständig sein, intuitive Benutzeroberflächen zu entwickeln, benutzerfreundliche Eingabeaufforderungen zu erstellen und sicherzustellen, dass KI ein Tool bleibt, das die menschlichen Fähigkeiten erweitert.

Herausforderungen und Chancen

Wie jedes neue Gebiet hat auch das Prompt Engineering seine Herausforderungen:

- Komplexität der Modelle. Je größer und komplexer die Modelle werden, desto schwieriger wird es, gute Eingabeaufforderungen zu erstellen.

- Voreingenommenheit und Fairness. Sicherstellen, dass Eingabeaufforderungen nicht aus Versehen Verzerrungen in den Modellergebnissen verursachen oder verstärken.

- Interdisziplinäre Zusammenarbeit. Prompt Engineering ist eine Mischung aus Linguistik, Psychologie und Informatik, was die Zusammenarbeit zwischen verschiedenen Fachbereichen erfordert.

Diese Herausforderungen bieten aber auch Chancen. Sie treiben Innovationen voran, fördern die Zusammenarbeit zwischen verschiedenen Fachbereichen und ebnen den Weg für die nächste Generation von KI-Tools und -Lösungen.

Ethische Überlegungen beim Prompt Engineering

Da KI in vielen Branchen immer wichtiger wird, sind ethische Fragen beim Prompt Engineering jetzt echt wichtig. Die Aufgabe von Prompt-Ingenieuren geht über das Erstellen effektiver Prompts hinaus – sie müssen auch dafür sorgen, dass KI-Modelle fair, unvoreingenommen und ethisch mit den Nutzern interagieren. Hier sind die wichtigsten Schwerpunkte:

Verringerung von Voreingenommenheit

Prompt-Ingenieure sind echt wichtig, um Verzerrungen in KI-Ergebnissen zu reduzieren, die durch die Trainingsdaten oder die Formulierung der Prompts selbst entstehen können. Strategien umfassen:

- Neutrales Prompt-Design: Vermeide Suggestivfragen oder Aufforderungen, die das Modell dazu bringen könnten, voreingenommene Antworten zu geben.

- Auf Fairness prüfen: Teste die Eingabeaufforderungen regelmäßig mit verschiedenen Eingaben, um sicherzustellen, dass die Ergebnisse über verschiedene demografische Gruppen oder Kontexte hinweg ausgewogen sind.

- Bewusstsein für Datenverzerrungen: Verstehen, welche Datensätze zum Trainieren von LLMs benutzt werden, und die Eingabeaufforderungen so anpassen, dass sie etwaigen inhärenten Verzerrungen entgegenwirken.

Faire KI-Interaktionen

Um faire Interaktionen zu gewährleisten, können schnelle Ingenieure:

- Verwende kontextbezogene Eingabeaufforderungen: Hilf den Models dabei, in ihren Antworten breitere Perspektiven zu berücksichtigen, wie zum Beispiel auch unterrepräsentierte Standpunkte einzubeziehen.

- EthischeStandardsüberwachen: Ethische Richtlinien in die Entwicklung von Prompt-Engineering-Verfahren einbauen, zum Beispiel indem man Prompts vermeidet, die schädliche oder diskriminierende Ergebnisse hervorrufen könnten.

Transparenz und Erklärbarkeit

Prompt-Entwickler sollten auf Transparenz setzen, indem sie Prompts erstellen, die klare und verständliche KI-Interaktionen ermöglichen. Das umfasst:

- Die Grenzen der KI bei Antworten aufzeigen.

- Entwerfen von Aufforderungen, die das Modell dazu bringen, Quellen anzugeben oder seine Argumentation zu erklären.

Abschließende Gedanken

Der Bereich der künstlichen Intelligenz ist riesig, kompliziert und entwickelt sich ständig weiter. Während wir uns mit den Feinheiten des Prompt Engineering beschäftigt haben, ist klar geworden, dass es hier um mehr als nur Technik geht – es ist eine Brücke zwischen dem, was wir Menschen wollen, und dem, was Maschinen verstehen. Es geht darum, die richtigen Fragen zu stellen, um die gewünschten Antworten zu kriegen.

Prompt Engineering ist zwar noch ziemlich neu, aber es ist echt wichtig, um das volle Potenzial von KI-Modellen, vor allem von großen Sprachmodellen, auszuschöpfen. Da diese Modelle immer mehr in unseren Alltag reinkommen, kann man gar nicht genug betonen, wie wichtig gute Kommunikation ist. Egal, ob es um einen Sprachassistenten geht, der bei alltäglichen Aufgaben hilft, einen Chatbot, der Kundensupport leistet, oder ein KI-Tool, das Forschern hilft – die Qualität der Interaktion hängt von den Eingabeaufforderungen ab, die sie steuern.

Für Datenbegeisterte, Profis und sogar die breite Öffentlichkeit geht es beim Verständnis von Prompt Engineering nicht nur um eine bessere KI-Kommunikation. Es geht darum, sich eine Zukunft vorzustellen, in der KI einfach in unser Leben passt, unsere Fähigkeiten erweitert und unsere Erfahrungen bereichert.

Im Moment sieht die Zukunft von Prompt Engineering echt vielversprechend aus, mit vielen Herausforderungen, die wir meistern müssen, und Meilensteinen, die wir erreichen wollen. Für alle, die sich für dieses Gebiet interessieren, fängt die Reise gerade erst an. Lerne die Grundlagen des Prompt Engineering in unserem Kurs kennen und finde in unserem separaten Leitfaden heraus, wie du KI lernen kannst, oder lerne in unserem Tutorial, wie du dein eigenes LLM mit PyTorch trainieren kannst.

Verdiene eine Top-KI-Zertifizierung

Autorin und Redakteurin im Bereich der Bildungstechnologie. Engagiert bei der Erforschung von Datentrends und begeistert davon, Data Science zu lernen.

Häufig gestellte Fragen zum Prompt Engineering

Was genau ist ein Prompt im Zusammenhang mit KI?

Eine Eingabeaufforderung ist eine Frage oder Anweisung an ein KI-Modell, vor allem an ein großes Sprachmodell (LLM), um eine bestimmte Antwort zu bekommen. Es ist die Schnittstelle zwischen dem, was wir wollen, und dem, was die Maschine macht.

Warum ist Prompt Engineering wichtig?

Prompt Engineering sorgt dafür, dass KI-Modelle genaue und relevante Ergebnisse liefern. Es geht darum, gute Eingabeaufforderungen zu erstellen, die das Verhalten des Modells steuern und so eine gute Kommunikation zwischen Mensch und KI sicherstellen.

Brauche ich einen Hintergrund in KI oder maschinellem Lernen, um Prompt Engineering zu verstehen?

Ein Hintergrund in KI kann zwar hilfreich sein, ist aber nicht unbedingt nötig. Bei der Prompt-Entwicklung geht es genauso um Sprache und Kommunikation wie um technisches Know-how. Mit den richtigen Ressourcen und dem richtigen Wissen kann jeder die Grundlagen verstehen.

Was hat Prompt Engineering mit Chatbots und Sprachassistenten zu tun?

Chatbots und Sprachassistenten hängen stark von Eingabeaufforderungen ab. Die Fragen, die du stellst, oder die Befehle, die du gibst, sind im Grunde genommen Aufforderungen. Effektives Prompt Engineering sorgt dafür, dass diese Tools die Anfragen der Nutzer richtig verstehen und darauf reagieren.

Gibt's irgendwelche Risiken bei der schnellen Entwicklung?

Wie bei jeder KI-Anwendung kann auch das Prompt Engineering Probleme mit sich bringen. Voreingenommene oder schlecht formulierte Eingabeaufforderungen können zu ungenauen oder voreingenommenen Modellergebnissen führen. Es ist wichtig, dass man bei der schnellen Entwicklung vorsichtig vorgeht und auf Fairness und Transparenz achtet.