Kurs

DevOps ist mehr als nur eine Methode. Es ist ein kultureller Wandel, der die Softwareentwicklung (Dev) mit dem IT-Betrieb (Ops) verbindet, um einen effizienteren, kooperativen Arbeitsablauf zu schaffen.

Das Ziel ist es, die traditionellen Silos zwischen den Teams aufzubrechen und eine gemeinsame Verantwortung für die Leistung, Sicherheit und Bereitstellung von Software zu ermöglichen.

Ich habe die DevOps-Prinzipien selbst eingeführt und kann sagen, dass sie die Art und Weise, wie Teams Software entwickeln und einsetzen, wirklich verändern. Deshalb werde ich dich in diesem Leitfaden Schritt für Schritt durch eine Roadmap führen, die dir hilft, DevOps zu meistern.

> Um mit den grundlegenden DevOps-Konzepten zu beginnen, schau dirk den Kurs DevOps-Konzepte.

Die DevOps-Mentalität verstehen

Um die DevOps-Mentalität zu verstehen, ist es wichtig, DevOps zunächst zu definieren und zu erkennen, wie es sich von traditionellen Ansätzen unterscheidet.

Was ist DevOps?

DevOps ist eine Philosophie, die Entwicklungs- und Betriebsteams integriert, um die Geschwindigkeit, Zuverlässigkeit und Effizienz der Softwarebereitstellung zu verbessern.

Traditionelle Softwareentwicklungsmodelle wie der Wasserfall-Ansatz führten oft zu Engpässen, langsamen Einsätzen und Missverständnissen zwischen den Teams.

DevOps hat sich als Lösung für diese Herausforderungen herauskristallisiert, die es Unternehmen ermöglicht, einen agileren und reaktionsschnelleren Ansatz für die Softwarebereitstellung zu wählen.

Im Gegensatz zu traditionellen Modellen, bei denen die Entwickler den Code schreiben und ihn zur Bereitstellung an den Betrieb weitergeben, fördert DevOps eine enge Zusammenarbeit, gemeinsame Verantwortlichkeiten und Automatisierung.

DevOps kann Teams dabei helfen, Software kontinuierlich und mit minimalen Unterbrechungen zu integrieren und bereitzustellen.

Das wiederum sorgt dafür, dass die Anwendungen skalierbar, sicher und leistungsstark bleiben.

> Um besser zu verstehen, wie DevOps und MLOps im Vergleich zueinander stehen, schau dirk MLOps vs DevOps an: Unterschiede, Überschneidungen und Anwendungsfälle. Du kannst auch erkunden, wie Automatisierung beim maschinellen Lernen skaliert, mit diesem Kurs über vollautomatisierte MLOps.

Die wichtigsten Grundsätze von DevOps

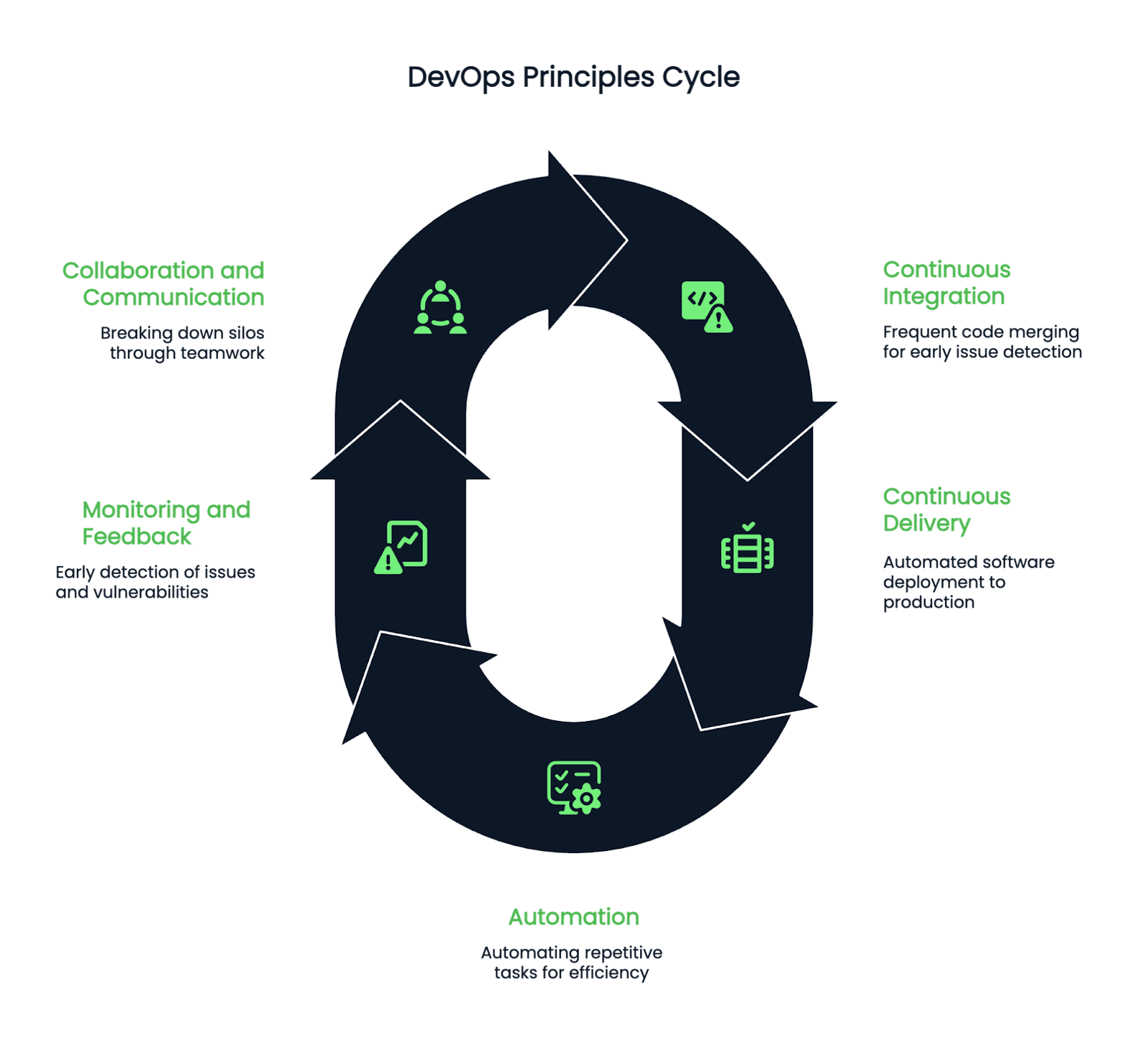

DevOps wird von mehreren grundlegenden Prinzipien geleitet, die die Kernpraktiken definieren:

- Kontinuierliche Integration (CI): Die Entwickler führen häufig Codeänderungen in einem gemeinsamen Repository zusammen, was eine frühzeitige Erkennung von Integrationsproblemen ermöglicht und potenzielle Fehler bei der Bereitstellung reduziert.

- Continuous Delivery (CD): Die Software wird automatisch erstellt, getestet und bereitgestellt, so dass Aktualisierungen mit minimalem menschlichem Aufwand in die Produktionsumgebung eingespielt werden können.

- Automatisierung: Sich wiederholende Aufgaben wie Tests, Konfigurationsmanagement und Infrastrukturbereitstellung werden automatisiert, um die Effizienz zu steigern und menschliche Fehler zu reduzieren.

- Überwachung und Feedback: Mit Observability-Tools können Teams Leistungsprobleme, Sicherheitsschwachstellen und Systemanomalien frühzeitig im Entwicklungsprozess erkennen.

- Zusammenarbeit und Kommunikation: Starke Teamarbeit, Transparenz und Wissensaustausch helfen dabei, Silos zwischen Entwicklungs- und Betriebsteams aufzubrechen.

Bild mit den fünf Phasen des DevOps-Lebenszyklus. Erstellt mit Napkin AI.

Vorteile der Einführung von DevOps

Die Implementierung von DevOps in deinen Arbeitsablauf kann sowohl für die Entwicklung als auch für den Betrieb von Vorteil sein.

- Ein entscheidender Vorteil sind schnellere Veröffentlichungszyklen. Die Automatisierung von CI/CD-Pipelines hilft den Teams, Updates schnell und effizient ohne große Verzögerungen zu verteilen.

- Außerdem fördert DevOps höhere Softwarequalitätda automatisierte Tests und kontinuierliche Überwachung dazu beitragen, Fehler frühzeitig im Entwicklungszyklus zu erkennen.

- Ein weiterer wichtiger Vorteil ist die geringere Ausfallrate. Da DevOps den Schwerpunkt auf inkrementelle Änderungen und automatisierte Rollbacks legt, können sich die Teams schnell von Fehlern erholen und so Ausfallzeiten und Betriebsrisiken minimieren.

- Schließlich fördert DevOps die bessere Teamausrichtungda Entwickler, Tester, Sicherheitsingenieure und Betriebsteams zusammenarbeiten, um einen reibungslosen und effizienten Entwicklungsprozess zu gewährleisten.

Vorausgesetzte Kenntnisse und Fertigkeiten

Um bei DevOps erfolgreich zu sein, sind Grundkenntnisse in Skripting, Betriebssystemen und Versionskontrollsystemen wichtig.

Grundlegende Programmierung/Skripterstellung

Grundlegende Programmier- und Scripting-Kenntnisse sind für jeden, der in den DevOps-Bereich einsteigen will, unerlässlich.

Skriptsprachen wie Python, Bash und PowerShell werden häufig verwendet, um sich wiederholende Aufgaben zu automatisieren, z. B. Softwareverteilung, Serverkonfigurationen und Protokollanalysen.

Vor allem Python ist eine leistungsstarke und vielseitige Sprache, die häufig für die Automatisierung der Infrastruktur, das Konfigurationsmanagement und die API-Integration verwendet wird.

Bash-Skripte sind ebenfalls wichtig, vor allem für Linux-basierte Umgebungen.

Wenn du weißt, wie du Shell-Skripte schreibst, Systemprozesse verwaltest und Kommandozeilenaufgaben automatisierst, kannst du deine Effizienz als DevOps Engineer erheblich steigern.

PowerShell ist nützlich für alle, die in Windows-Umgebungen arbeiten. Sie bietet Automatisierungsfunktionen für die Verwaltung von Servern, Active Directory und Cloud-Diensten.

Verständnis von Betriebssystemen

Da DevOps-Fachleute Infrastruktur- und Cloud-Umgebungen verwalten, ist ein gutes Verständnis für Betriebssysteme unerlässlich.

Linux ist das bevorzugte Betriebssystem in den meisten DevOps-Workflows aufgrund seiner Flexibilität, Leistung und umfangreichen Unterstützung für Open-Source-Tools.

Das Verständnis von Linux-Dateisystemen, Prozessmanagement, Benutzerrechten, Netzwerken und Paketmanagement wird dir helfen, komplexe Infrastrukturherausforderungen zu meistern.

Außerdem brauchst du Kenntnisse über Netzwerkkonzepte wie DNS, HTTP, Firewalls und Lastverteilung.

DevOps-Ingenieure arbeiten oft mit Cloud-basierten und lokalen Netzwerken. Daher ist es wichtig, dass sie sich mit Netzwerksicherheit, IP-Adressierung und der Behebung von Netzwerkproblemen auskennen.

Versionskontrollsysteme

Versionskontrolle ist ein wesentlicher Bestandteil der modernen Softwareentwicklung, und Git ist das am häufigsten verwendete Versionskontrollsystem.

DevOps-Ingenieure müssen Git beherrschen, um Quellcode effizient zu verwalten, Änderungen zu verfolgen und mit Teams auf Plattformen wie GitHub, GitLab oder Bitbucket zusammenzuarbeiten.

Zu den wichtigsten Konzepten, die du beherrschen musst, gehören Verzweigungsstrategien, Zusammenführen, Pull-Requests und das Lösen von Konflikten.

Das Erlernen von GitOps, einer Erweiterung von DevOps, die Git-Repositories als einzige Quelle der Wahrheit für die Automatisierung der Infrastruktur nutzt, kann ebenfalls von Vorteil sein.

> Wenn du neugierig bist, wie du GitOps in deinen Arbeitsablauf integrieren kannst, schau dirden Kurs "MLOps-Konzepte " an.

Infrastruktur und Konfigurationsmanagement

Die effektive Verwaltung der Infrastruktur, der Konfigurationen und des sicheren Zugriffs auf sensible Informationen ist entscheidend für erfolgreiche DevOps-Praktiken.

Infrastruktur als Code (IaC)

Infrastructure as Code (IaC) ist eine DevOps-Praxis, die es den Teams ermöglicht, die Infrastruktur mithilfe von Code zu definieren und zu verwalten, anstatt manuelle Konfigurationen vorzunehmen.

Dieser Ansatz gewährleistet Konsistenz, Skalierbarkeit und Wiederholbarkeit in verschiedenen Umgebungen.

Beliebte IaC-Tools sind Terraform und AWS CloudFormation. Terraform ist ein Cloud-unabhängiges Tool, mit dem Ingenieure mithilfe von deklarativen Konfigurationsdateien Infrastrukturen für mehrere Cloud-Anbieter bereitstellen können.

AWS CloudFormation hingegen ist speziell für die Verwaltung von AWS-Ressourcen über JSON- oder YAML-Vorlagen konzipiert.

Die Implementierung von IaC kann Teams dabei helfen, die Infrastrukturbereitstellung zu automatisieren, Konfigurationsabweichungen zu reduzieren und die Zusammenarbeit durch versionskontrollierte Infrastrukturdefinitionen zu verbessern.

Konfigurationsmanagement

Konfigurationsmanagement-Tools helfen dabei, die Systemkonsistenz aufrechtzuerhalten, indem sie Softwareinstallationen, Systemaktualisierungen und Umgebungskonfigurationen automatisieren.

Beliebte Tools in dieser Kategorie sind Ansible, Chef und Puppet.

Ansible ist ein leichtgewichtiges, agentenloses Automatisierungstool, das YAML-basierte Playbooks verwendet, um Server zu konfigurieren und Anwendungen bereitzustellen.

Chef und Puppet sind zwar komplexer, bieten aber leistungsstarke Automatisierungsfunktionen für die Verwaltung umfangreicher Infrastrukturen mit deklarativen Konfigurationen.

Geheimnisse und Zugangsverwaltung

Sicherheit ist ein wichtiger Aspekt von DevOps, und die Verwaltung sensibler Informationen wie API-Schlüssel, Passwörter und Zertifikate ist unerlässlich.

HashiCorp Vault ist ein weit verbreitetes Tool zur sicheren Speicherung und Verwaltung von Geheimnissen, mit dem Teams den Zugriff auf sensible Daten durch Authentifizierungsrichtlinien kontrollieren können.

AWS Secrets Manager bietet ähnliche Funktionen für Cloud-native Umgebungen und hilft Unternehmen, Anmeldeinformationen sicher zu verwalten.

Darüber hinaus kann die Verwendung von Umgebungsvariablen zur Speicherung von Geheimnissen und die Integration von rollenbasierten Zugriffskontrollen (RBAC) die Sicherheit in DevOps-Pipelines weiter erhöhen.

Kontinuierliche Integration und kontinuierliche Lieferung (CI/CD)

Die Umsetzung effektiver CI/CD-Praktiken erfordert ein Verständnis der Grundprinzipien, den Einsatz geeigneter Tools und die Integration automatisierter Tests.

CI/CD-Grundlagen

CI/CD ist das Herzstück von DevOps, das sicherstellt, dass Codeänderungen kontinuierlich integriert, getestet und bereitgestellt werden.

Bei der kontinuierlichen Integration (Continuous Integration, CI) geht es darum, die Code-Integration von mehreren Entwicklern zu automatisieren, automatisierte Tests durchzuführen und Build-Artefakte zu erzeugen.

Continuous Delivery (CD) erweitert CI, indem es die Softwareverteilung in Staging- und Produktionsumgebungen automatisiert.

Eine effektive CI/CD-Pipeline besteht aus mehreren Phasen: Quellcode-Integration, automatisierte Tests, Build und Paketierung, Speicherung von Artefakten und Bereitstellung.

Diese Pipeline hilft Teams, Software schnell, sicher und zuverlässig zu veröffentlichen.

> Wenn du einen tieferen Einblick in die Automatisierung deiner CI/CD-Workflows haben möchtest, schau dirden Kurs CI/CD für maschinelles Lernen.

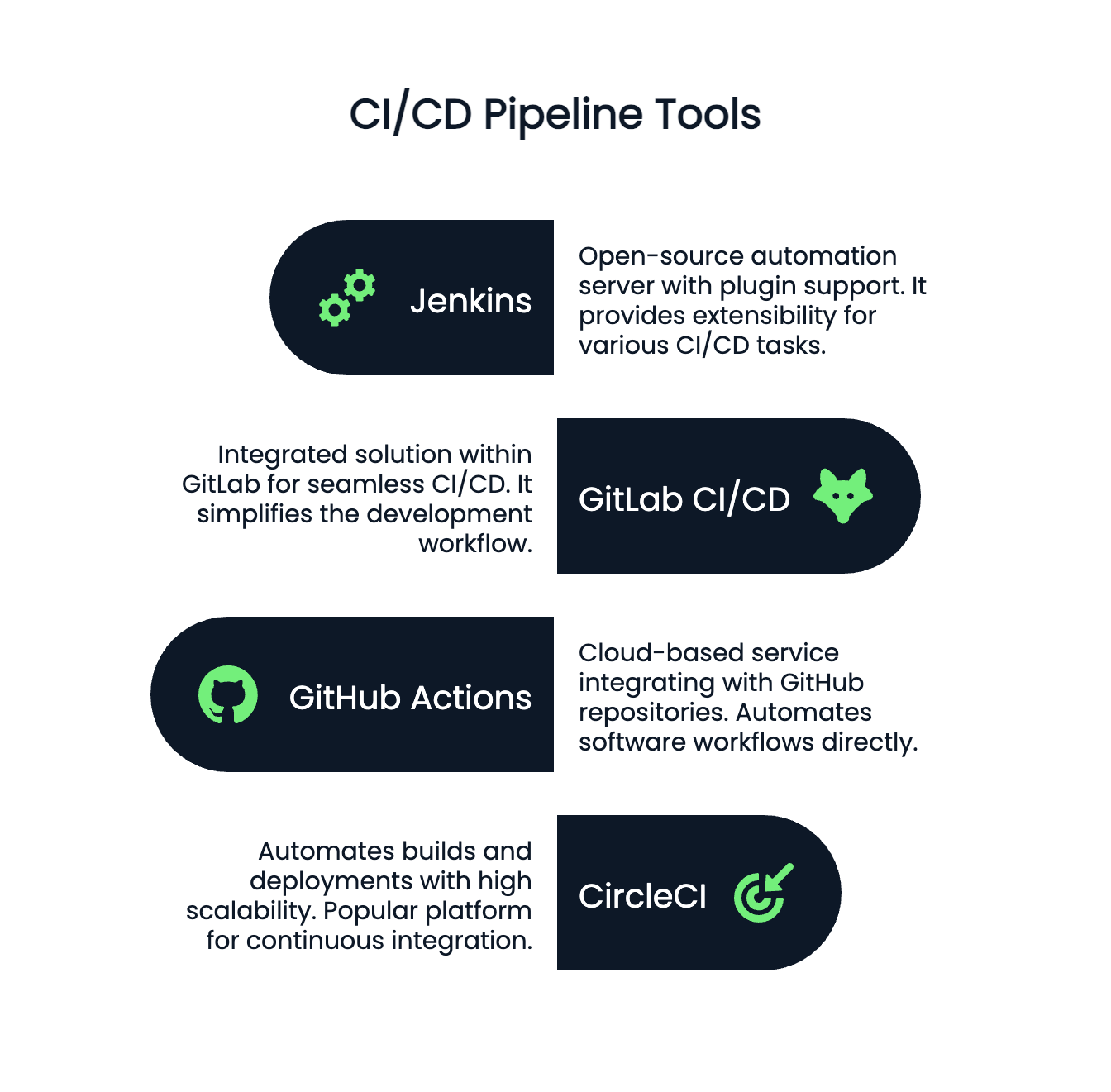

CI/CD-Werkzeuge

Für die Implementierung von CI/CD-Pipelines werden in der Regel mehrere Tools verwendet:

- Jenkins: Ein Open-Source-Automatisierungsserver, der Plugin-basierte Erweiterungen unterstützt.

- GitLab CI/CD: Eine integrierte Lösung in GitLab, die eine nahtlose Integration ermöglicht.

- GitHub-Aktionen: Ein Cloud-basierter CI/CD-Dienst, der sich direkt mit GitHub-Repositories verbinden lässt.

- CircleCI: Eine beliebte CI/CD-Plattform, die Builds und Deployments mit hoher Skalierbarkeit automatisiert.

Image hebt Jenkins, GitHub Actions, GitLab CI/CD und CircleCI als wichtige Tools für Automatisierung und kontinuierliche Integration hervor. Erstellt mit Napkin AI.

Automatisierung bauen und testen

Automatisierte Tests stellen sicher, dass Codeänderungen keine Bugs oder Schwachstellen einführen.

Unit-Tests, Integrationstests und funktionale Tests sollten in die CI/CD-Pipeline integriert werden, um Fehler frühzeitig zu erkennen.

Containerisierung und Orchestrierung

Um containerisierte Anwendungen effektiv zu verwalten, musst du Docker und die Orchestrierung durch Kubernetes beherrschen und Tools wie Helm und Operators nutzen.

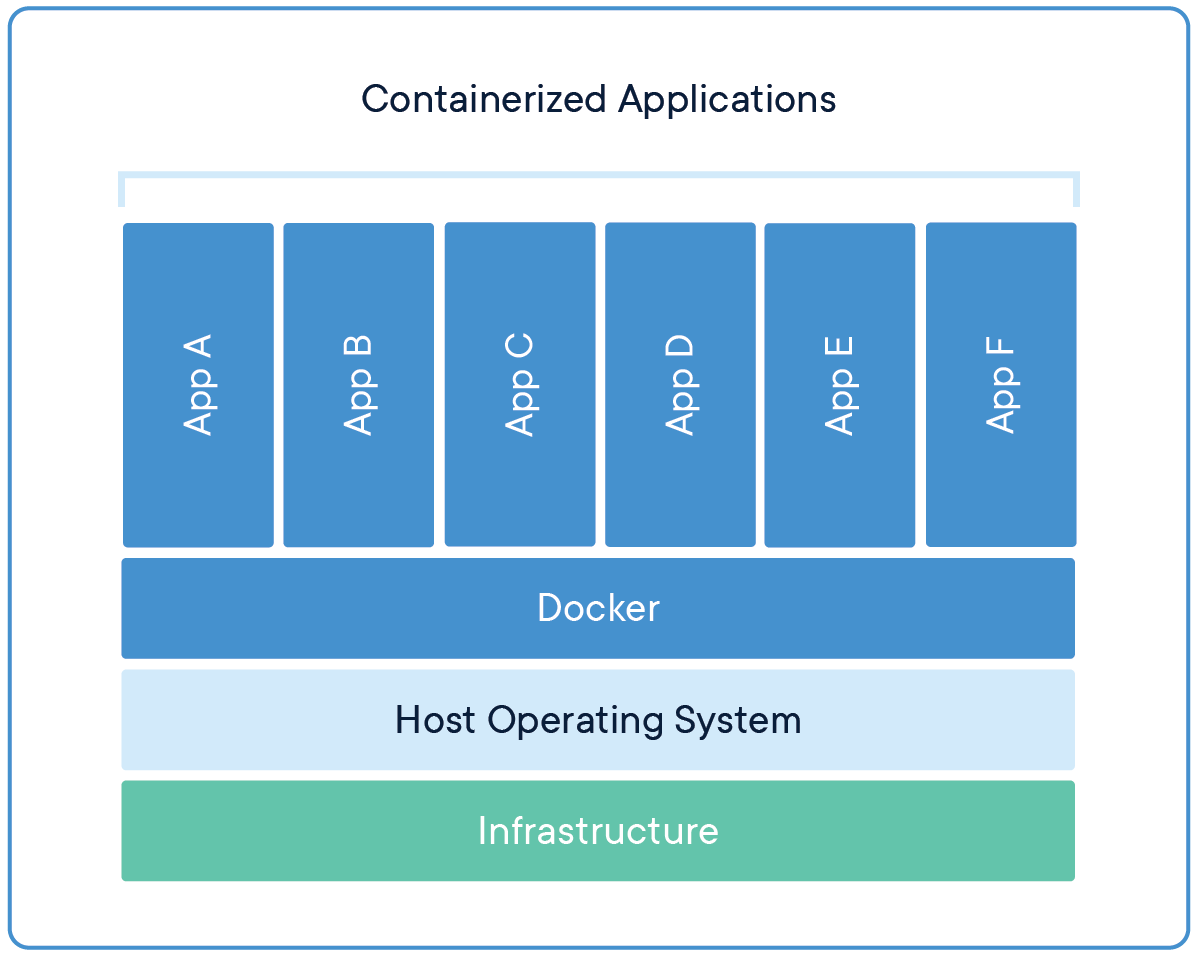

Docker Grundlagen

Containerisierung ist ein wichtiger Bestandteil der modernen DevOps-Landschaft.

Es ermöglicht Entwicklern, Anwendungen und ihre Abhängigkeiten in portablen Containern zu verpacken, die in verschiedenen Umgebungen konsistent ausgeführt werden können.

Docker ist das beliebteste Tool zur Containerisierung, mit dem Teams Anwendungen in isolierten Umgebungen erstellen, ausliefern und ausführen können.

Bild mit der Docker-Architektur, das zeigt, wie containerisierte Anwendungen auf Docker laufen. Quelle: Docker Ressourcen

Ein Docker-Container ist ein leichtgewichtiges, eigenständiges Paket, das alles enthält, was die Software zum Laufen braucht: den Anwendungscode, die Laufzeit, die Systembibliotheken und die Einstellungen.

Docker-Container werden mithilfe eines Dockerfiles definiert, das die Schritte zur Erstellung des Containers beschreibt.

Sobald das Image erstellt ist, kann es in einer Docker-Registry gespeichert und mit anderen geteilt werden.

Um Docker zu beherrschen, musst du wissen, wie du Docker-Images erstellst, Dockerdateien schreibst und Container lokal und in Cloud-Umgebungen ausführst.

Docker Compose, ein Tool zum Definieren und Ausführen von Docker-Anwendungen mit mehreren Containern, hilft auch bei der Verwaltung komplexer Systeme mit mehreren miteinander verbundenen Diensten.

> Für eine schrittweise Aufschlüsselung, wie manarn Docker zu erlernen, ist dieser Leitfaden für Anfänger eine hilfreiche Ressource.

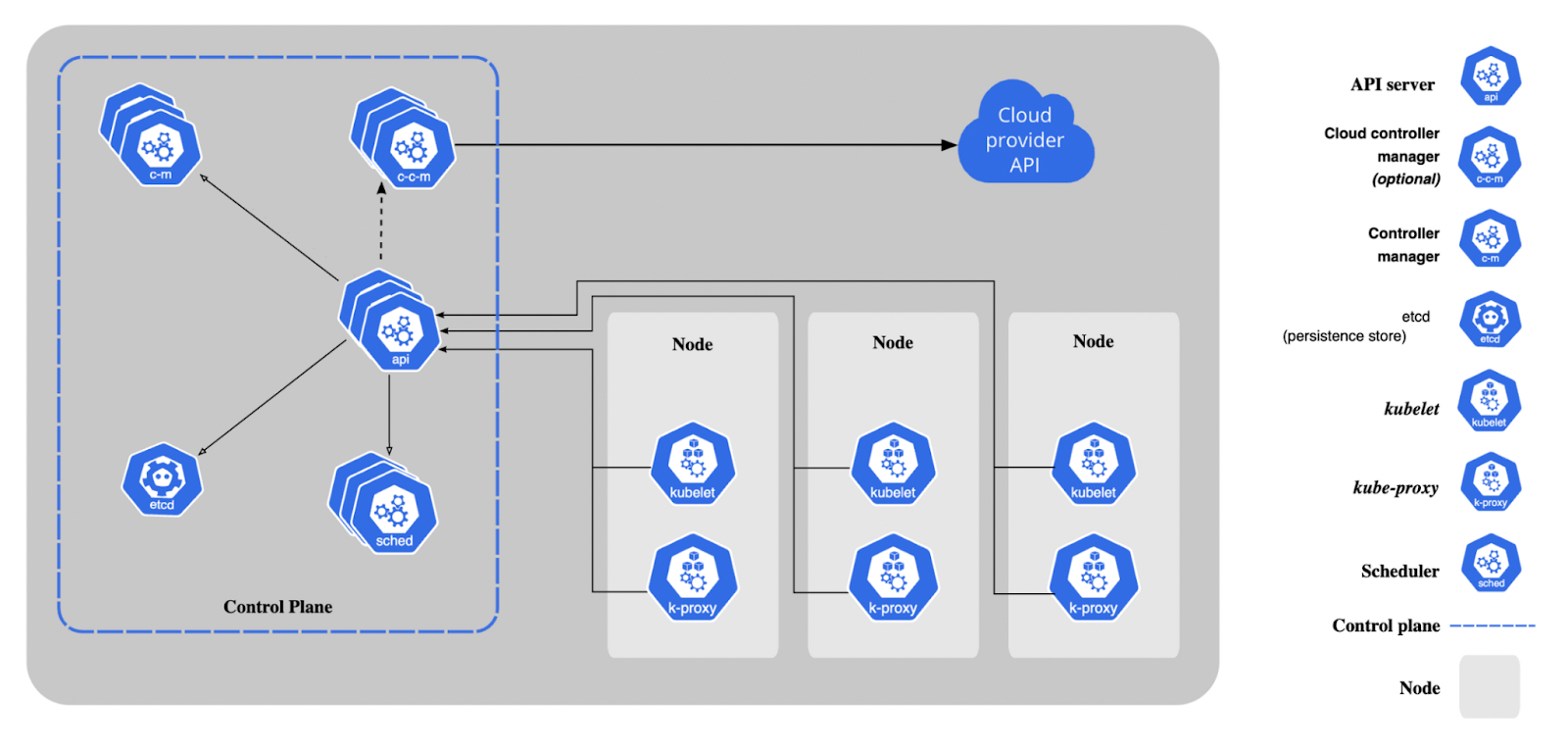

Kubernetes-Grundlagen

Während Docker einzelne Container erstellt und verwaltet, ist Kubernetes (K8s) die Orchestrierungsplattform, die hilft, containerisierte Anwendungen in der Produktion zu skalieren und zu verwalten.

Kubernetes automatisiert die Bereitstellung, Skalierung und Verwaltung von containerisierten Anwendungen, was die Handhabung großer, verteilter Systeme erleichtert.

> Wenn du neu in Kubernetes bist, bietet dir dieser einsteigerfreundliche Kurs eine handfesteds-on Einführung in die Container-Orchestrierung.

Kubernetes organisiert Container in Pods, den kleinsten einsatzfähigen Einheiten in Kubernetes.

Jeder Pod kann einen oder mehrere Container enthalten, und Kubernetes verwaltet die Pods über einen Cluster von Maschinen.

Zu den wichtigsten Konzepten gehören Services (zur Bereitstellung von Containern), Deployments (zur Verwaltung des Lebenszyklus von Anwendungen) und Namespaces (zur Organisation von Ressourcen innerhalb eines Clusters).

Das Bild zeigt die Kubernetes-Architektur mit den Komponenten der Steuerungsebene. Quelle: Kubernetes Docs

Kubernetes bietet außerdem erweiterte Funktionen wie automatische Skalierung, Selbstheilung und rollende Updates.

Das Erlernen von Kubernetes ist für DevOps-Ingenieure, die mit Microservices-Architekturen arbeiten, unverzichtbar, da es sicherstellt, dass Anwendungen hochverfügbar, skalierbar und widerstandsfähig sind.

> Wenn du verstehen willst, wie Kubernetes im Vergleich zu Dockerr ist, lies Kubernetes vs. Docker: Unterschiede, die jeder Entwickler kennen sollte.

Steuer und Bediener

Für Teams, die komplexe Kubernetes-Umgebungen verwalten, bieten Helm und Kubernetes Operators Lösungen, die das Anwendungsmanagement vereinfachen und automatisieren.

Helm ist ein Paketmanager für Kubernetes, mit dem du Kubernetes-Anwendungen mithilfe von Helm-Charts definieren, installieren und aktualisieren kannst.

Diese Diagramme sind wiederverwendbare Konfigurationen, die festlegen, wie Kubernetes-Ressourcen eingesetzt werden sollen.

Kubernetes Operators hingegen sind benutzerdefinierte Controller, die die Verwaltung komplexer, zustandsabhängiger Anwendungen in Kubernetes automatisieren.

Betreiber erweitern Kubernetes, um bestimmte Anwendungszustände zu verwalten, z. B. die Bereitstellung einer Datenbank, die Durchführung von Backups oder die Skalierung einer Anwendung auf der Grundlage benutzerdefinierter Metriken.

Helm und Operators sind beide unverzichtbar für die Verwaltung anspruchsvoller Workloads und die Aufrechterhaltung von Hochverfügbarkeit und Konsistenz in containerisierten Umgebungen.

Docker und Kubernetes beherrschen

Cloud-Plattformen und -Dienste

Um sich in modernen Cloud-Umgebungen zurechtzufinden, muss man die wichtigsten Cloud-Anbieter kennen, die wichtigsten Cloud-Dienste beherrschen und Multi-Cloud- oder Hybrid-Strategien effektiv verwalten.

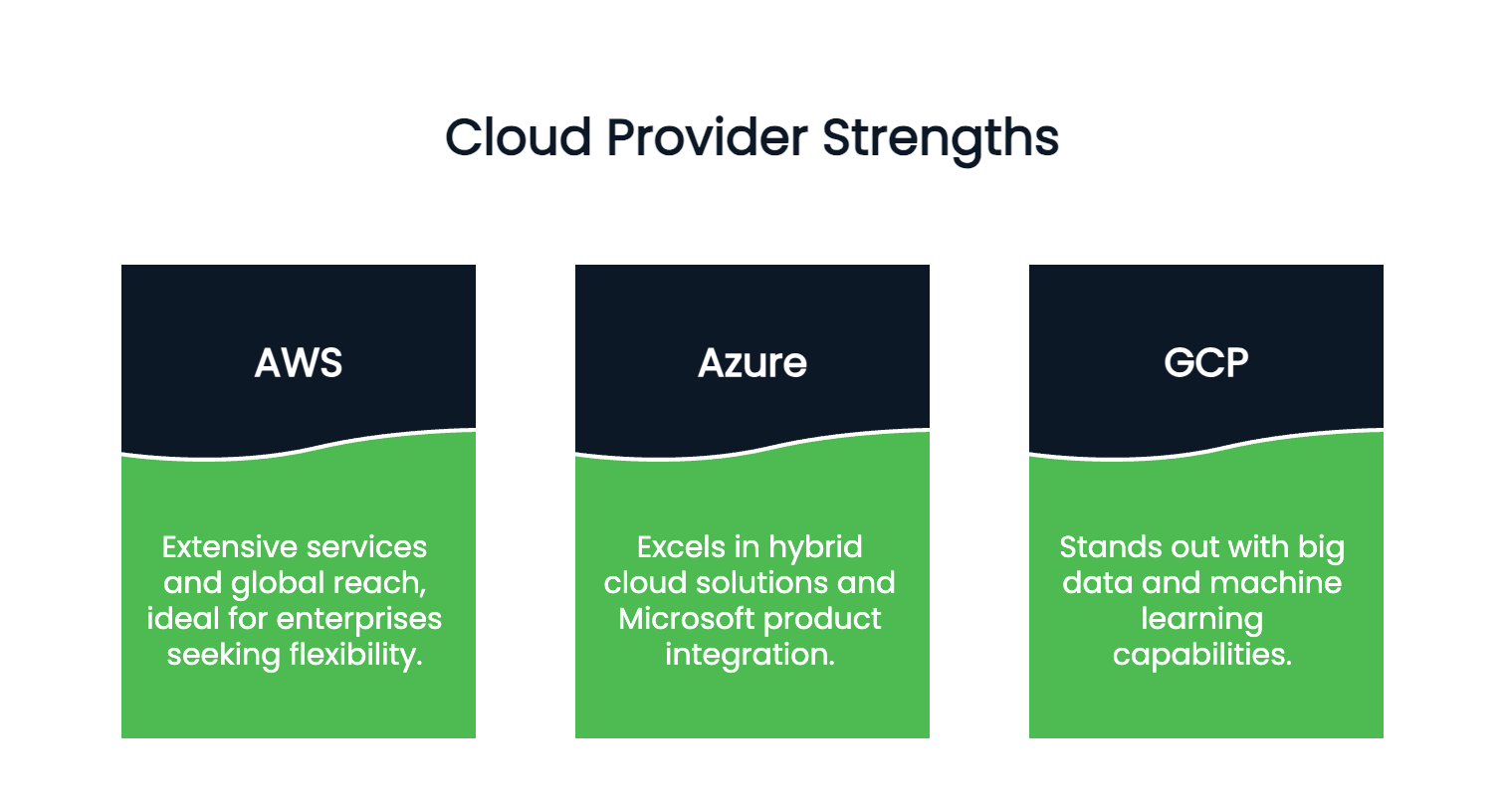

Cloud-Anbieter

Der Aufstieg des Cloud Computing hat die Art und Weise verändert, wie Unternehmen Anwendungen entwickeln, einsetzen und skalieren.

Beliebte Cloud-Anbieter wie Amazon Web Services (AWS), Microsoft Azure und Google Cloud Platform (GCP) bieten eine breite Palette von Diensten an, die DevOps-Praktiken unterstützen - von Rechenleistung und Speicherplatz bis hin zu Netzwerken und Sicherheit.

Jeder Cloud-Anbieter hat seine eigenen Angebote und Stärken.

- AWS ist bekannt für sein umfangreiches Serviceangebot und seine globale Reichweite, was es ideal für Unternehmen macht, die Flexibilität und Skalierbarkeit suchen.

- Azure zeichnet sich durch hybride Cloud-Lösungen und die Integration mit Microsoft-Produkten aus.

- GCP zeichnet sich durch seine Big Data- und Machine Learning-Fähigkeiten aus.

Bild, das die Stärken der wichtigsten Cloud-Anbieter gegenüberstellt. Erstellt mit Napkin AI.

Als DevOps-Ingenieur ist es wichtig, mindestens einen Cloud-Anbieter und seine Kerndienste gut zu kennen.

Die Vertrautheit mit mehreren Cloud-Plattformen kann ebenfalls von Vorteil sein, insbesondere für Unternehmen, die Multi-Cloud-Strategien verfolgen.

> In diesem Tutorial lernst du, wie du Apps mit Azure DevOps in diesem Schritt-für-Schritt-Tutorial.

Die wichtigsten Cloud-Dienste, die du kennen solltest

Cloud-Anbieter bieten eine Vielzahl von Diensten an, die DevOps-Workflows unterstützen, darunter Rechenleistung, Speicherplatz, Netzwerke und mehr.

Hier sind einige wichtige Cloud-Dienste, mit denen du vertraut sein solltest:

- Compute-Dienste: Mit diesen Diensten kannst du Anwendungen und Workloads in der Cloud ausführen. AWS EC2, Azure Virtual Machines und Google Compute Engine sind Beispiele für Rechenservices, die skalierbare virtuelle Maschinen bereitstellen.

- Lagerdienste: Cloud-Speicherdienste wie AWS S3, Azure Blob Storage und Google Cloud Storage bieten skalierbare und dauerhafte Speicherlösungen für Daten. Für jeden DevOps-Ingenieur ist es wichtig zu wissen, wie man Daten in der Cloud verwaltet und sichert.

- Vernetzungsdienste: Cloud-Netzwerkdienste, wie VPC (Virtual Private Cloud) in AWS, Azure Virtual Network und Google Cloud VPC, helfen bei der Konfiguration und Verwaltung von Netzwerkressourcen.

Du musst mit der Konfiguration von Subnetzen, Load Balancern und VPNs vertraut sein, um eine nahtlose Kommunikation zwischen den Diensten sicherzustellen.

Multi-Cloud- und Hybrid-Cloud-Strategien

Viele Unternehmen setzen heute auf Multi-Cloud- oder Hybrid-Cloud-Strategien, um sich nicht an einen Anbieter zu binden und von den einzigartigen Stärken der einzelnen Cloud-Anbieter zu profitieren.

In einer Multi-Cloud-Umgebung nutzen Unternehmen Dienste von mehreren Cloud-Anbietern, während sie in einer hybriden Cloud-Installation ihre lokale Infrastruktur mit cloudbasierten Ressourcen kombinieren.

DevOps-Ingenieure müssen wissen, wie sie Multi-Cloud-Umgebungen effektiv verwalten und überwachen können.

Tools wie Terraform und Kubernetes können dabei helfen, die Bereitstellung und Orchestrierung der Infrastruktur über verschiedene Cloud-Plattformen hinweg zu automatisieren und so konsistente Bereitstellungen und Konfigurationen zu gewährleisten.

Überwachung, Protokollierung und Alarmierung

Die Aufrechterhaltung zuverlässiger und leistungsstarker Systeme erfordert die Beherrschung von Beobachtungspraktiken, den Einsatz effektiver Überwachungswerkzeuge und die zentrale Speicherung von Protokollen zur Analyse.

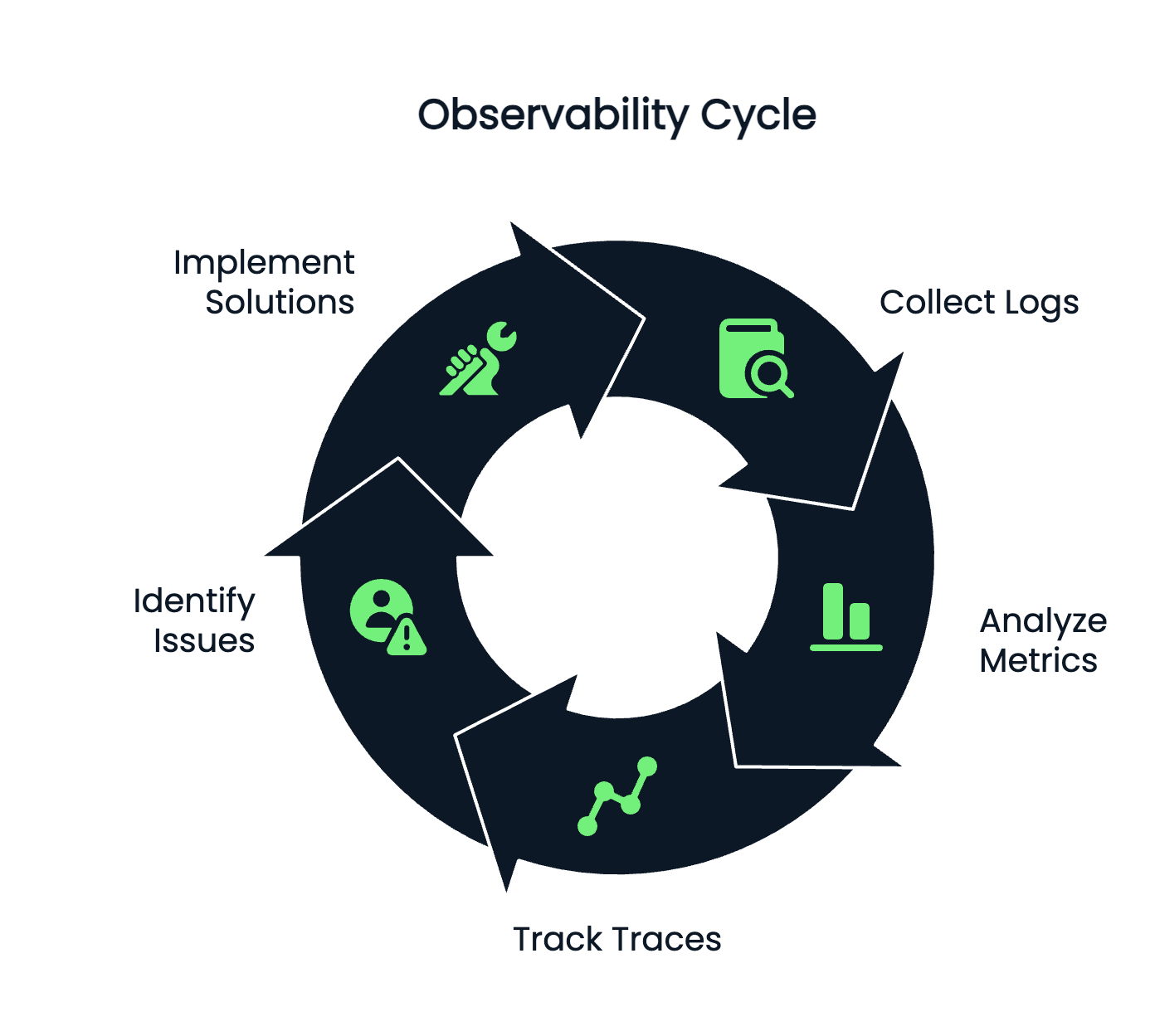

Konzepte zur Beobachtbarkeit

Überwachung, Protokollierung und Alarmierung sind wichtige Aspekte von DevOps, die den Zustand und die Leistung von Anwendungen und Infrastruktur sicherstellen.

Beobachtbarkeit ist die Praxis, Einblicke in die internen Abläufe eines Systems auf der Grundlage von externen Ausgaben wie Protokollen, Metriken und Traces zu gewinnen.

- Protokolle erfassen detaillierte Informationen über Systemereignisse und Fehler. Sie sind wichtig für die Fehlersuche und -behebung.

- Metriken liefern quantitative Daten über die Leistung und das Verhalten von Anwendungen, z. B. CPU-Nutzung, Speichernutzung und Antwortzeiten.

- Traces bieten einen detaillierten Überblick über den Fluss der Anfragen durch verteilte Systeme und helfen Teams, die Leistung einzelner Dienste zu verfolgen und Engpässe zu erkennen.

Zusammen bilden diese drei Säulen (Logs, Metriken und Traces) das Fundament der Beobachtbarkeit.

Sie ermöglichen es den Teams, Probleme proaktiv zu erkennen und zu beheben, was ein reibungsloses und zuverlässiges Nutzererlebnis gewährleistet.

Das Bild zeigt den Lebenszyklus der Beobachtbarkeit. Erstellt mit Napkin AI.

Überwachungsinstrumente

Mit Monitoring-Tools können Teams den Zustand und die Leistung von Systemen in Echtzeit verfolgen.

Beliebte Monitoring-Tools, die in DevOps eingesetzt werden, sind u.a:

- Prometheus: Ein Open-Source-Tool zur Überwachung und Alarmierung, das häufig mit Kubernetes verwendet wird. Er sammelt und speichert Zeitreihendaten, mit denen du die Systemleistung verfolgen kannst.

- Grafana: Grafana wird oft zusammen mit Prometheus verwendet und ist ein Visualisierungstool, mit dem du Echtzeit-Dashboards zur Überwachung von Anwendungsmetriken erstellen kannst.

- Datadog: Eine Cloud-basierte Überwachungs- und Analyseplattform, die Infrastruktur- und Anwendungsüberwachung, Log-Management und User-Experience-Monitoring bietet.

- AWS CloudWatch: Ein von AWS bereitgestellter Überwachungsdienst, mit dem du die Leistung von AWS-Ressourcen verfolgen, Alarme einrichten und benutzerdefinierte Metriken erstellen kannst.

> Um eine effiziente Bereitstellung von Datenpipelines zu gewährleisten, wirf einen Blick auf die CI/CD in Data Engineering: Ein Leitfaden für den nahtlosen Einsatz.

Tools zur Log-Aggregation

Tools zur Log-Aggregation helfen dabei, Logs aus verschiedenen Quellen zu sammeln und zu zentralisieren, was das Durchsuchen, Analysieren und Visualisieren von Log-Daten erleichtert.

Zu den am häufigsten verwendeten Tools zur Log-Aggregation gehören:

- ELK Stack (Elasticsearch, Logstash, Kibana): Eine leistungsstarke Suite von Tools, mit denen du Logdaten sammeln, speichern und analysieren kannst. Elasticsearch wird für die Speicherung von Logs verwendet, Logstash für deren Verarbeitung und Kibana für die Visualisierung und Erkundung der Daten.

- Fluentd: Ein Open-Source-Datensammler, der die Sammlung und den Transport von Logdaten über mehrere Quellen hinweg vereinheitlicht. Es wird oft zusammen mit Elasticsearch und Kibana für die zentrale Protokollierung verwendet.

Effektive Protokollierung und Überwachung sind entscheidend für die Aufrechterhaltung der Systemzuverlässigkeit, die Reduzierung von Ausfallzeiten und die Verbesserung der Leistung.

Sicherheit und Compliance

Um robuste Sicherheit und Compliance in DevOps zu gewährleisten, müssen Sicherheitspraktiken in die gesamte Pipeline integriert, Schwachstellen proaktiv identifiziert und die Einhaltung gesetzlicher Standards automatisiert werden.

DevSecOps

Sicherheit hat bei DevOps oberste Priorität und DevSecOps integriert die Sicherheit in jede Phase der DevOps-Pipeline.

Anstatt Sicherheit als separate Funktion zu behandeln, die von einem anderen Team bearbeitet wird, ermutigt DevSecOps Entwickler, Betriebsingenieure und Sicherheitsexperten, zusammenzuarbeiten, um sicherzustellen, dass die Sicherheit in den Entwicklungsprozess eingebettet ist.

Die Automatisierung von Sicherheitstests, Code-Reviews und Schwachstellen-Scans ermöglicht es DevSecOps-Teams, Probleme frühzeitig zu erkennen, was das Risiko von Sicherheitsverletzungen und Schwachstellen in der Produktion verringert.

Scannen auf Schwachstellen

DevOps-Ingenieure müssen bewährte Sicherheitspraktiken wie Schwachstellen-Scans einsetzen, um Schwachstellen in Code und Infrastruktur zu erkennen.

Tools wie Snyk, Trivy und OWASP Dependency-Check helfen dabei, Codebases und Container-Images auf bekannte Schwachstellen zu scannen, damit Teams Sicherheitsprobleme beheben können, bevor sie die Produktion erreichen.

Compliance-Automatisierung

In regulierten Branchen ist die Einhaltung von Vorschriften ein wichtiger Aspekt, und DevOps-Teams müssen sicherstellen, dass Anwendungen und Infrastrukturen den Branchenstandards und gesetzlichen Anforderungen entsprechen.

Tools zur Automatisierung der Einhaltung von Richtlinien helfen dabei, Lernpfade zu verfolgen und durchzusetzen, Audits durchzuführen und Berichte zu erstellen.

Frameworks wie CIS (Center for Internet Security) und SOC2 (System and Organization Controls) bieten Richtlinien für sichere und konforme DevOps-Praktiken.

Soft Skills und Tools für die Zusammenarbeit

Um in DevOps erfolgreich zu sein, sind eine starke Zusammenarbeit, effektive Kommunikation, die Beherrschung agiler Praktiken und die Fähigkeit, Prozesse und Wissen klar zu dokumentieren, erforderlich.

Agile und Scrum Praktiken

DevOps ist eng mit den agilen Methoden verbunden, da beide die kontinuierliche Verbesserung, die Zusammenarbeit und die iterative Entwicklung betonen.

Wenn du agile Praktiken wie Scrum und Kanban verstehst, kannst du deine Fähigkeit, Entwicklungszyklen zu verwalten und Prioritäten zu setzen, deutlich verbessern.

Scrum konzentriert sich auf kurze, zeitlich begrenzte Iterationen (Sprints genannt), die schrittweise Verbesserungen bringen.

DevOps-Teams profitieren von den agilen Prinzipien, indem sie in kürzeren Zyklen arbeiten und so eine schnellere Lieferung und häufigere Releases gewährleisten.

Tools für die Zusammenarbeit

Bei DevOps dreht sich alles um Zusammenarbeit, und die richtigen Tools für Kommunikation und Projektmanagement sind unerlässlich.

Beliebte Tools für die Zusammenarbeit sind:

- Slack: Eine Team-Messaging-Plattform, die die Kommunikation zwischen Entwicklern, Betrieb und anderen Beteiligten erleichtert.

- Jira: Ein Projektmanagement-Tool zum Verfolgen von Aufgaben, User Stories und Problemen in agilen Arbeitsabläufen.

- Confluence: Eine Plattform für die Zusammenarbeit zur Erstellung und gemeinsamen Nutzung von Dokumentationen wie Runbooks, Einsatzleitfäden und Vorfallsberichten.

- Begriff: Ein flexibles Arbeitsbereichstool zur Organisation von Unterlagen, Besprechungsnotizen und Projektzeitplänen.

Dokumentation und Kommunikation

Eine klare und effektive Dokumentation ist der Schlüssel zu einer erfolgreichen DevOps-Kultur.

Ob es um das Schreiben von Runbooks für die Reaktion auf Vorfälle oder die Dokumentation von Systemarchitekturen geht, eine detaillierte Dokumentation stellt sicher, dass die Teams schnell auf Probleme reagieren und ihr Wissen effektiv teilen können.

Außerdem sind starke Kommunikationsfähigkeiten bei DevOps entscheidend, da Teams abteilungsübergreifend zusammenarbeiten müssen, um gemeinsame Ziele zu erreichen.

Erstellung deines DevOps-Lernplans

Um einen effektiven DevOps-Lernplan zu erstellen, musst du deine Kompetenzentwicklung strukturieren. Dazu gehört auch, dass du dich in praktischen Projekten engagierst und relevante Zertifizierungen anstrebst.

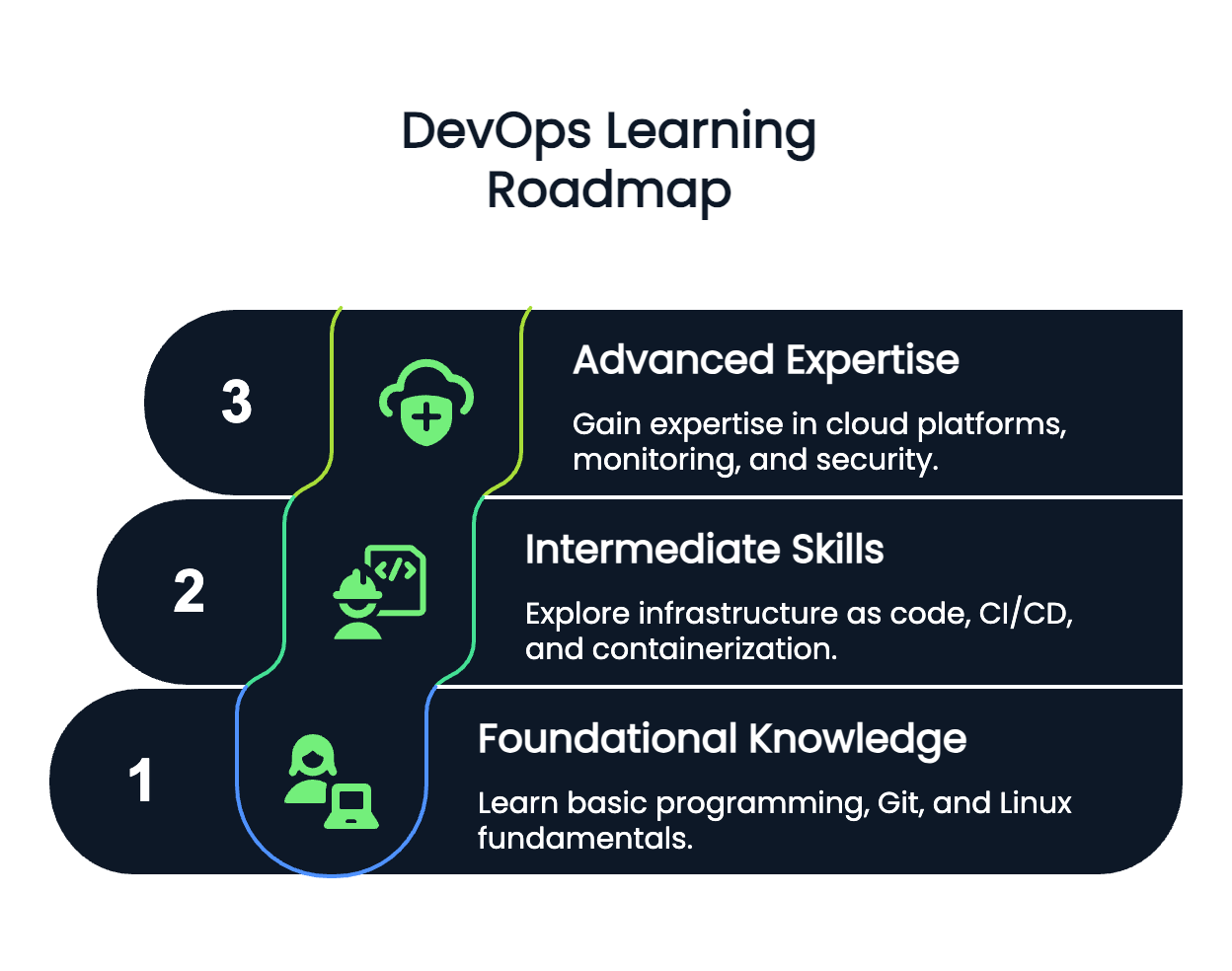

Lernpfade und Progression

DevOps ist ein weites Feld, und um es zu meistern, ist ein strukturierter Ansatz erforderlich.

Als Anfänger konzentrierst du dich auf Grundkenntnisse wie Skripting, Versionskontrolle und das Verständnis von Betriebssystemen.

Nachdem du dich mit den Grundlagen vertraut gemacht hast, kannst du dich mit fortgeschritteneren Themen wie Containerisierung, Cloud-Plattformen und CI/CD-Pipelines beschäftigen.

Hier ist ein Vorschlag für den Verlauf deiner DevOps-Reise:

- Anfänger: Lerne grundlegende Programmierung/Skripting, Git, Linux-Grundlagen und Versionskontrolle.

- Intermediate: Erkunde Infrastruktur als Code, CI/CD-Pipelines, Containerisierung mit Docker und Kubernetes.

- Fortgeschrittene: Erwerbe Fachwissen über Cloud-Plattformen, Überwachung, Protokollierung und Sicherheitspraktiken.

Das Bild zeigt eine vorgeschlagene DevOps-Lern-Roadmap. Erstellt mit Napkin AI.

Praxisnahe Projekte

Der beste Weg, DevOps zu lernen, ist die praktische Erfahrung. Baue und verteile deine eigenen CI/CD-Pipelines, experimentiere mit Containerisierung und automatisiere die Cloud-Infrastruktur mit Tools wie Terraform.

Übe mit realen Projekten, wie z.B. der Bereitstellung einer Microservices-basierten Anwendung oder der Automatisierung der Bereitstellung einer Webanwendung.

Optionen für die Zertifizierung

Zertifizierungen können helfen, deine Fähigkeiten zu bestätigen und deinen Lernweg zu strukturieren.

Zu den beliebten Zertifizierungen für DevOps-Fachleute gehören:

- AWS DevOps Engineer (Professional)

- Zertifizierter Kubernetes-Administrator (CKA)

- Docker Certified Associate

> Bereite dich auf deine Zertifizierung vor mit these curated AWS Certified DevOps Engineer: Studienplan, Tipps und Ressourcen.

Fazit

Die DevOps-Reise ist eine Reise des ständigen Lernens und Wachstums.

Wenn du die DevOps-Roadmap verstanden hast, wirst du mir sicher zustimmen, dass es nicht nur um die Beherrschung von Tools und Technologien geht, sondern auch darum, eine Denkweise zu entwickeln, die Zusammenarbeit, Effizienz und Innovation fördert.

Damit solltest du gut gerüstet sein, um die Herausforderungen einer modernen DevOps-Rolle mithilfe der in diesem Leitfaden genannten Fähigkeiten und Praktiken zu meistern.

Wenn du demnächst ein Vorstellungsgespräch hast, kannst du dichmit den 31 Top Azure DevOps Interviewfragen oder den Top 24 AWS DevOps Interviewfragenauf den neuesten Stand bringen.

FAQs

Was ist DevOps, und warum ist es wichtig?

DevOps ist eine Reihe von Praktiken, die die Softwareentwicklung (Dev) und den Betrieb (Ops) kombinieren, um die Zusammenarbeit, die Automatisierung und die kontinuierliche Bereitstellung von Anwendungen zu verbessern. Es hilft Unternehmen, Software schneller und mit höherer Qualität zu liefern.

Welche Tools sollte ich als DevOps-Einsteiger zuerst lernen?

Als Anfänger solltest du dich darauf konzentrieren, grundlegende Programmier- oder Skripterkenntnisse (Python, Bash), Git zur Versionskontrolle und die Grundlagen von Betriebssystemen, insbesondere Linux, zu erlernen.

Warum ist Cloud Computing für DevOps so wichtig?

Cloud Computing bietet skalierbare Ressourcen für die Bereitstellung von Anwendungen, Speicherplatz und Rechenleistung. Sie ist ein wesentlicher Bestandteil von DevOps, da sie die schnelle Bereitstellung, Automatisierung und Skalierung von Anwendungen auf flexible und kostengünstige Weise ermöglicht.

Was ist Infrastructure as Code (IaC), und warum sollte ich es lernen?

Infrastructure as Code (IaC) ermöglicht es dir, deine Infrastruktur mithilfe von Code zu definieren und zu verwalten, was sie reproduzierbar und automatisierbar macht. Das Erlernen von IaC-Tools - wie Terraform und AWS CloudFormation - ist für die effiziente Verwaltung der Cloud-Infrastruktur in einer DevOps-Pipeline unerlässlich.

Wie kann ich praktische Erfahrungen mit DevOps sammeln?

Um praktische Erfahrungen zu sammeln, kannst du mit Projekten wie dem Aufbau einer CI/CD-Pipeline, der Bereitstellung von Anwendungen mit Docker und der Automatisierung der Infrastruktur mit Tools wie Terraform beginnen. Praktische Erfahrung ist der Schlüssel zur Beherrschung von DevOps.

Sind DevOps-Zertifizierungen erstrebenswert?

Ja, DevOps-Zertifizierungen wie AWS DevOps Engineer, Certified Kubernetes Administrator (CKA) und Docker Certified Associate können deine Fähigkeiten bestätigen und dir helfen, deine Karriere voranzutreiben, indem du dein Fachwissen in diesem Bereich nachweist.

Wie lange dauert es, DevOps Engineer zu werden?

In der Regel dauert es 6 bis 18 Monate, bis du berufsreif bist, je nach Ausgangslage, Zeitaufwand und praktischer Projekterfahrung.

Brauche ich Programmierkenntnisse für DevOps?

Ja, ein solides Verständnis der Skripterstellung (insbesondere in Python, Bash oder PowerShell) ist für die Automatisierung von Aufgaben und die Verwaltung der Infrastruktur unerlässlich.

Ist DevOps nur etwas für Entwickler?

Nein. DevOps beinhaltet die Zusammenarbeit zwischen Entwicklung, Betrieb, Qualitätssicherung und Sicherheit. Er ist ideal für Ingenieure mit Interesse an Automatisierung und Systemen.

Kann ich DevOps auch ohne einen Informatikabschluss lernen?

Auf jeden Fall. Viele erfolgreiche DevOps-Ingenieure haben keinen CS-Hintergrund. Was am meisten zählt, ist praktisches Wissen, Neugierde und konsequentes Lernen.