Curso

Los rumores sobre el próximo lanzamiento de Anthropic han estado circulando durante los últimos días. Aunque muchos esperaban Claude Sonnet 5, el primer lanzamiento del año llega en forma de Claude Opus 4.6.

Con una ventana contextual de 1 millón de tokens, pensamiento adaptativo, compactación de conversaciones y una serie de benchmarks que encabezan las listas, Claude Opus 4.6 supone una mejora con respecto a Opus 4.5. Según Anthropic, han mejorado su modelo más inteligente. Junto con el modelo, Anthropic también lanzó equipos de agentes en Claude Code y Claude en PowerPoint.

En este artículo, abordaremos todas las novedades de Claude Opus 4.6, analizando las nuevas funciones, explorando los puntos de referencia y poniéndolo a prueba con varios ejemplos prácticos.

Para obtener más información sobre algunas de las últimas funciones de Claude, te recomiendo que consultes nuestras guías sobre Claude Cowork y Claude Code, así como nuestro tutorial de OpenClaw.

¿Qué es Claude Opus 4.6?

Claude Opus 4.6 es el último modelo de lenguaje grande de Anthropic. A continuación de Opus 4.5, representa una mejora significativa en la gama de modelos «más inteligentes» de la empresa.

En el blog del lanzamiento, Anthropic afirma que se centra más en la codificación agencial, el razonamiento profundo y la autocorrección. Esto significa que hay un cambio de la acción a la acciónsostenida .

Opus 4.6 está diseñado para planificar con mayor cuidado, ha mejorado la coherencia en períodos más largos e identifica errores en tu propio funcionamiento. Todo esto significa que Claude Opus 4.6 encabeza varias pruebas de rendimiento, incluida la máxima puntuación en la evaluación de codificación Terminal-Bench 2.0, y supera a todos los demás modelos de vanguardia en Humanity’s Last Exam.

Una de las cosas que más me llama la atención es la mejora de la ventana de contexto en Claude Opus 4.6. Con un millón de tokens en la versión beta, este nuevo modelo se equipara al Gemini 3, lo que significa que puede procesar más información sin perder de vista el contexto.

¿Qué hay de nuevo en Claude Opus 4.6?

Hay varias características nuevas destacables en Claude Opus 4.6, muchas de las cuales se centran en los flujos de trabajo de los agentes. Veamos algunos de los puntos clave:

Equipos de agentes

Los equipos de agentes son una mejora con respecto a los «subagentes» que veíamos en versiones anteriores de Claude. Los equipos de agentes te permiten crear múltiples instancias de Claude totalmente independientes que pueden funcionar en paralelo. Una sesión es el agente «líder» que coordina las cosas, mientras que los «compañeros de equipo» se encargan de la ejecución real.

Lo que me parece más interesante es que cada miembro del equipo tiene su propia ventana de contexto, lo que permite una ejecución más minuciosa. Cada miembro del equipo también puede comunicarse directamente con los demás miembros del equipo.

Por supuesto, esta característica tiene un posible inconveniente: el coste. Como cada agente tiene su propia ventana de contexto, pronto empezarás a agotar tus tokens. Por ello, Anthropic recomienda utilizarlos en situaciones que presenten un mayor nivel de complejidad.

Compactación de conversaciones

Una característica interesante de Claude Opus 4.6 es la compactación de contexto. Esta mejora en la calidad de vida ayuda a evitar problemas cuando ejecutas flujos de trabajo largos que agotan las ventanas de contexto. Normalmente, te encontrarías con un obstáculo contextual en el que el rendimiento comenzaría a degradarse.

Con la compactación de conversaciones, Claude Opus 4.6 puede detectar automáticamente cuándo una conversación alcanza un umbral de tokens y resumir la conversación existente en un bloque conciso (un bloque de compactación).

Esta función debería ayudarte a conservar lo esencial de tus interacciones y, al mismo tiempo, liberar espacio para que puedas continuar con tu trabajo. Si tienes pensado utilizar agentes orientados a tareas que deben ejecutarse durante mucho tiempo, esto podría mantenerlos en marcha con una memoria muy mejorada.

Pensamiento adaptativo y esfuerzo

Hay dos características de Claude Opus 4.6 que determinan si necesita utilizar el pensamiento extendido y cuánto esfuerzo dedica a ese pensamiento.

El pensamiento adaptativo permite al modelo determinar la complejidad de tu solicitud. En función de la simplicidad o complejidad, se decidirá si se utiliza el pensamiento extendido. En lugar de tener una configuración manual para el número de tokes que se utilizan para esto, Claude ajustará su presupuesto en función de la complejidad de cada solicitud.

El parámetro «esfuerzo» te permite establecer cuán entusiasta o conservador es Claude a la hora de gastar fichas. Básicamente, significa que puedes equilibrar la eficiencia de los tokens y la exhaustividad de las respuestas.

Al utilizar Claude Opus 4.6 en la API, puedes configurar estos parámetros manualmente. Por ejemplo:

- Máximo esfuerzo: Claude siempre utiliza un pensamiento amplio y no hay limitaciones en cuanto a profundidad.

- , un gran esfuerzo: Con esta configuración predeterminada, Claude siempre piensa y ofrece un razonamiento profundo.

- Esfuerzo medio: Esto activa un pensamiento moderado y puede omitir el pensamiento para las consultas más simples.

- Bajo esfuerzot: Claude omite pensar en tareas sencillas y minimiza el pensamiento en favor de la velocidad.

Claude en PowerPoint

Recientemente hemos hablado de Claude en Excel, mostrando cómo el complemento puede ayudarte con diversas tareas en un panel lateral de tu hoja de cálculo de Excel. Además de mejorar la funcionalidad de esta herramienta, Anthropic anunció Claude en PowerPoint.

Esta integración respeta tus plantillas de diapositivas, fuentes y diseños. Puedes introducir una plantilla corporativa y pedirle que cree una sección específica, o seleccionar una diapositiva y pedirle que convierta un texto denso en un diagrama nativo y editable.

El énfasis en generar objetos PowerPoint editables en lugar de simples «imágenes de diapositivas» convierte a esta herramienta en un auténtico instrumento de productividad, más allá de un simple generador de conceptos.

Claude en PowerPoint se encuentra actualmente en fase de vista previa de investigación para usuarios Max y Enterprise.

Probando Claude Opus 4.6: Ejemplos prácticos

Muchas de las afirmaciones principales de Opus 4.6 se centran en tareas de programación más difíciles y un razonamiento más profundo. Todas estas habilidades se basan en una base determinada: la capacidad de tener en cuenta múltiples restricciones, razonar a lo largo de muchos pasos y detectar errores.

Teniendo esto en cuenta, sometimos a Opus 4.6 a una serie de retos de lógica, matemáticas y programación de varios pasos. Queríamos ver si podíamos poner de manifiesto algunas debilidades conocidas y comunes de los LLM, como los errores de cálculo en cascada, el razonamiento espacial (siempre un problema) y las preguntas que implican restricciones. También incluimos una tarea específica de depuración porque el anuncio de Anthropic alardeaba de lo bueno que era Opus 4.6 con el análisis de causas raíz y otros problemas de depuración.

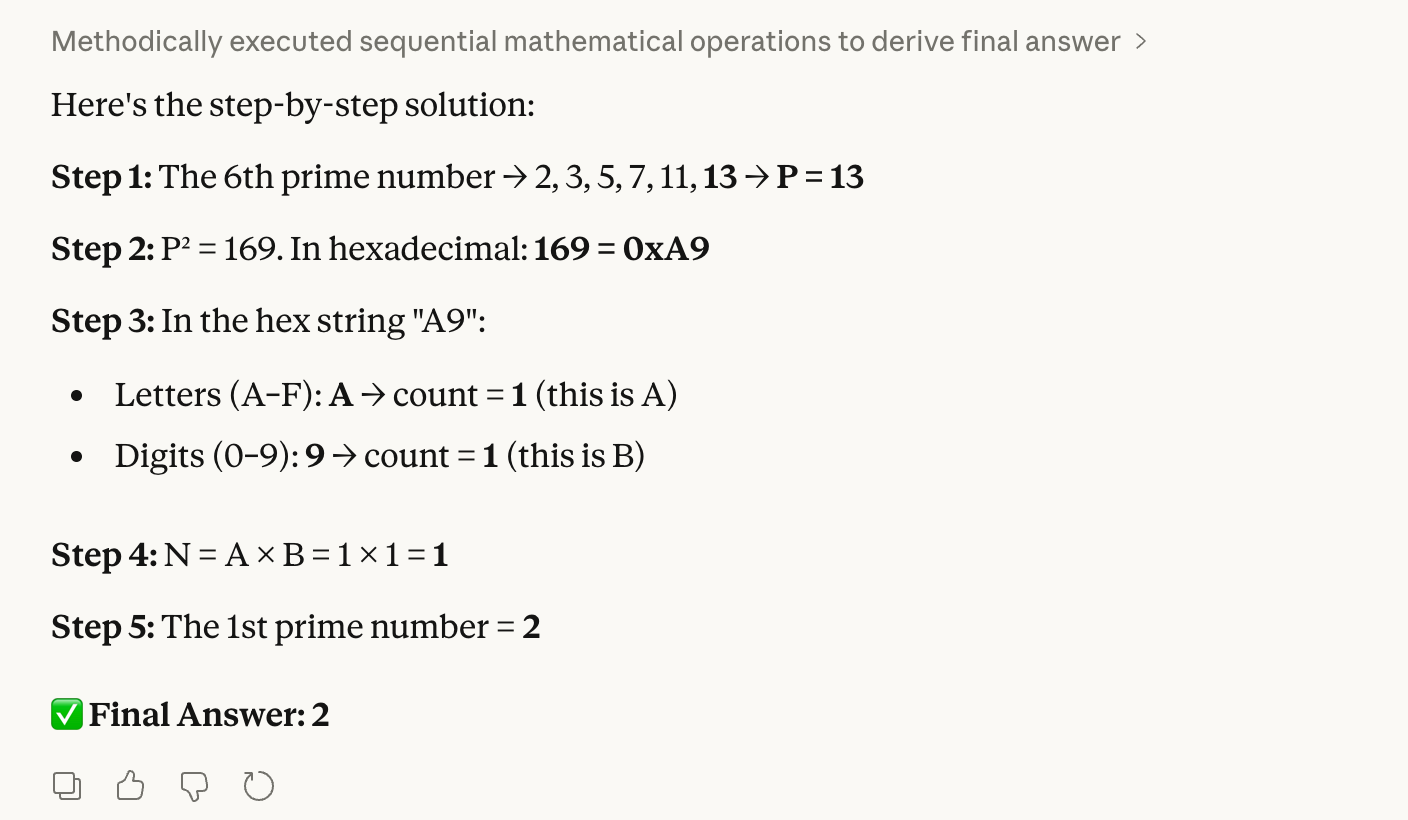

Prueba 1: Lógica hexadecimal a decimal

Nuestra primera prueba combina números primos, hexadecimales y conteo:

Step 1: Find the 6th prime number. Let this be P.

Step 2: Convert the square of P into hexadecimal.

Step 3: Count the letters (A–F) and digits (0–9) in that hex string. Let these be A and B.

Step 4: Multiply A × B. Let this be N.

Step 5: Find the Nth prime number.Suena un poco complejo, pero esta prueba es bastante fácil de verificar para los seres humanos. La respuesta correcta que sabemos es 2 porque el sexto número primo es 13; 13 al cuadrado es 169, que es «A9» en hexadecimal. Esto tiene 1 letra × 1 dígito, lo que equivale a 1 cuando los multiplicamos, y el primer número primo es 2.

La preocupación es que un modelo podría fallar con la conversión hexadecimal, lo que daría lugar a una respuesta final completamente errónea. Como puedes ver, Opus 4.6 no tuvo ningún problema:

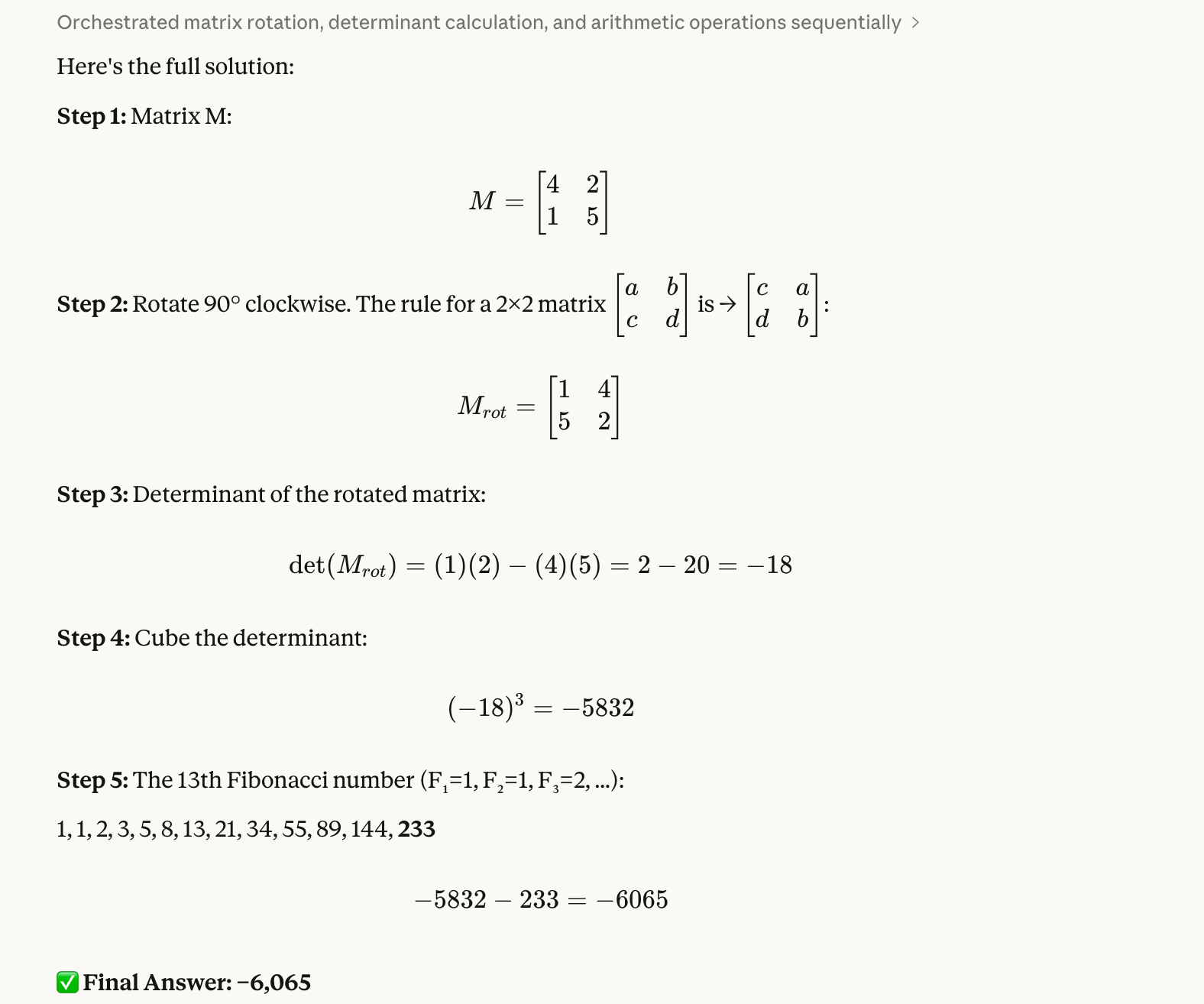

Prueba 2: Rotación de una matriz

La segunda prueba evalúa el razonamiento espacial y el manejo de números negativos:

Step 1: Create a 2×2 matrix M with top row [4, 2] and bottom row [1, 5].

Step 2: Rotate M 90 degrees clockwise.

Step 3: Calculate the determinant of the rotated matrix.

Step 4: Cube that determinant.

Step 5: Subtract the 13th Fibonacci number from the result.Este nos llevó un poco más de trabajo verificar por vuestra parte. La respuesta correcta es -6.065. Sabemos esto porque la matriz girada es [[1, 4], [5, 2]]; entonces, podemos usar Python para hallar el determinante, que es -18, y cuando elevamos este número al cubo, obtenemos -5832; finalmente, restamos 233 y obtenemos -6065.

Nos gustó la idea de esta prueba porque sabemos por experiencia que los modelos a menudo intercambian incorrectamente los elementos de la matriz o pierden el signo negativo en algún momento. Una vez más, Opus 4.6 no tuvo ningún problema:

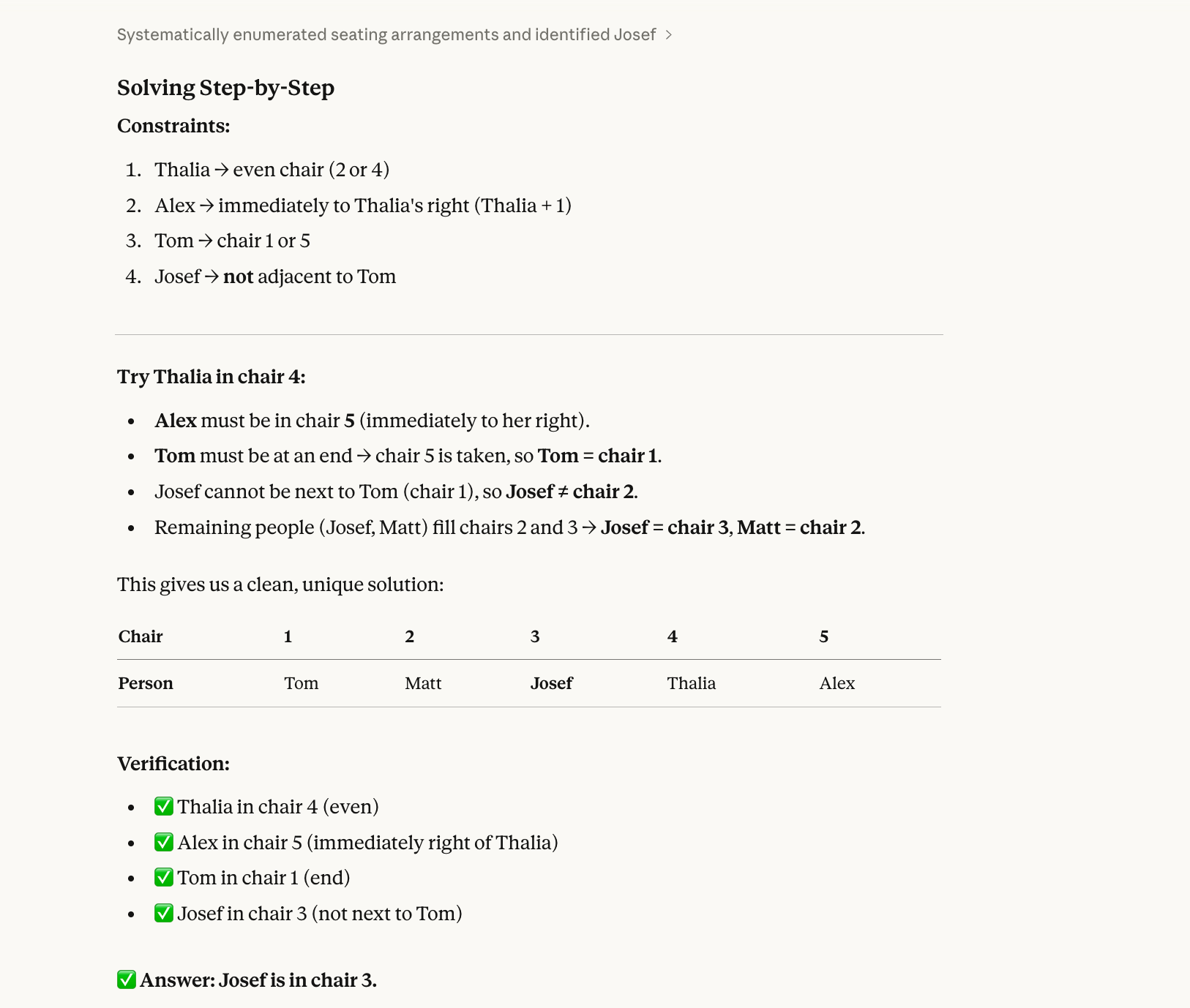

Prueba 3: Un cuestionario sobre la distribución de los asientos

Para nuestra tercera prueba, probamos un problema de satisfacción de restricciones que requiere retroceso:

Five people (Alex, Josef, Matt, Thalia, Tom) sit in chairs 1–5.

Thalia is in an even-numbered chair.Alex is immediately to Thalia’s right.Tom is at one end.Josef is not next to Tom.Who is in chair 3?La respuesta correcta a esta prueba es Josef. (Alex-1, Matt-2, Josef-3, Thalia-4, Tom-5.) Puedes resolverlo en un papel con un poco de esfuerzo.

La razón fundamental por la que un modelo puede fallar en este tipo de preguntas es que, históricamente, los modelos se han resuelto de forma secuencial, no holística. Leen «Thalia está en una silla par» y eligen una (por ejemplo, la silla 2) sin comprobar si esa elección cumple con todas las demás restricciones. Entonces se comprometen con ello, ocupan más sillas y, finalmente, se encuentran con un conflicto, pero para entonces ya se han metido en un callejón sin salida y no vuelven atrás para probar con Thalia en la silla 4.

Opus 4.6 también acertó en este caso:

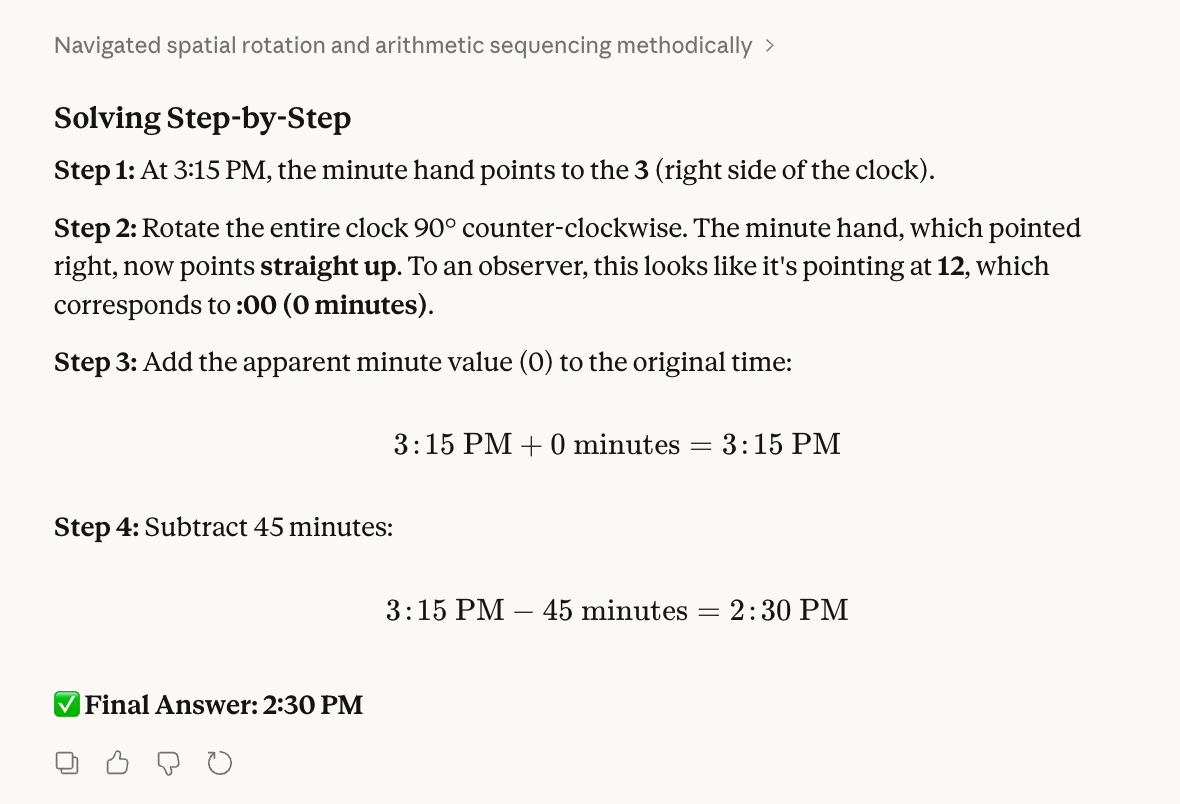

Prueba 4: Un rompecabezas de reloj

Nuestra cuarta prueba evalúa la visualización espacial y la intuición física:

Step 1: Imagine a clock currently showing 3:15 PM.

Step 2: Rotate the clock 90 degrees counter-clockwise (physically turning the whole clock face). After the rotation, what time does the minute hand appear to be pointing at?

Step 3: Take that new "apparent" minute value and add it to the original time (3:15 PM).

Step 4: Subtract 45 minutes from that result.

Step 5: What is the final time?Para comprobarlo, me quité el reloj de la muñeca y lo hice girar.

La respuesta correcta es 2:30 p. m. A las 3:15, el minutero señala el «3». Cuando apunté con el 12 a la ventana de tu izquierda, el «3» se movió al lugar donde estaba el «12». Luego sumé 0 a 3:15, resté 45 minutos y obtuve las 2:30 p. m.

Al diseñar la prueba, esperábamos que los modelos pudieran confundir la rotación de la esfera del reloj con el movimiento de la manecilla. También hemos oído que los modelos tienden a considerar sospechoso añadir un 0 y, por lo tanto, intentarán imponer un número diferente.

Sin embargo, Opus 4.6 logró resolver este problema; también obtuvo la respuesta correcta:

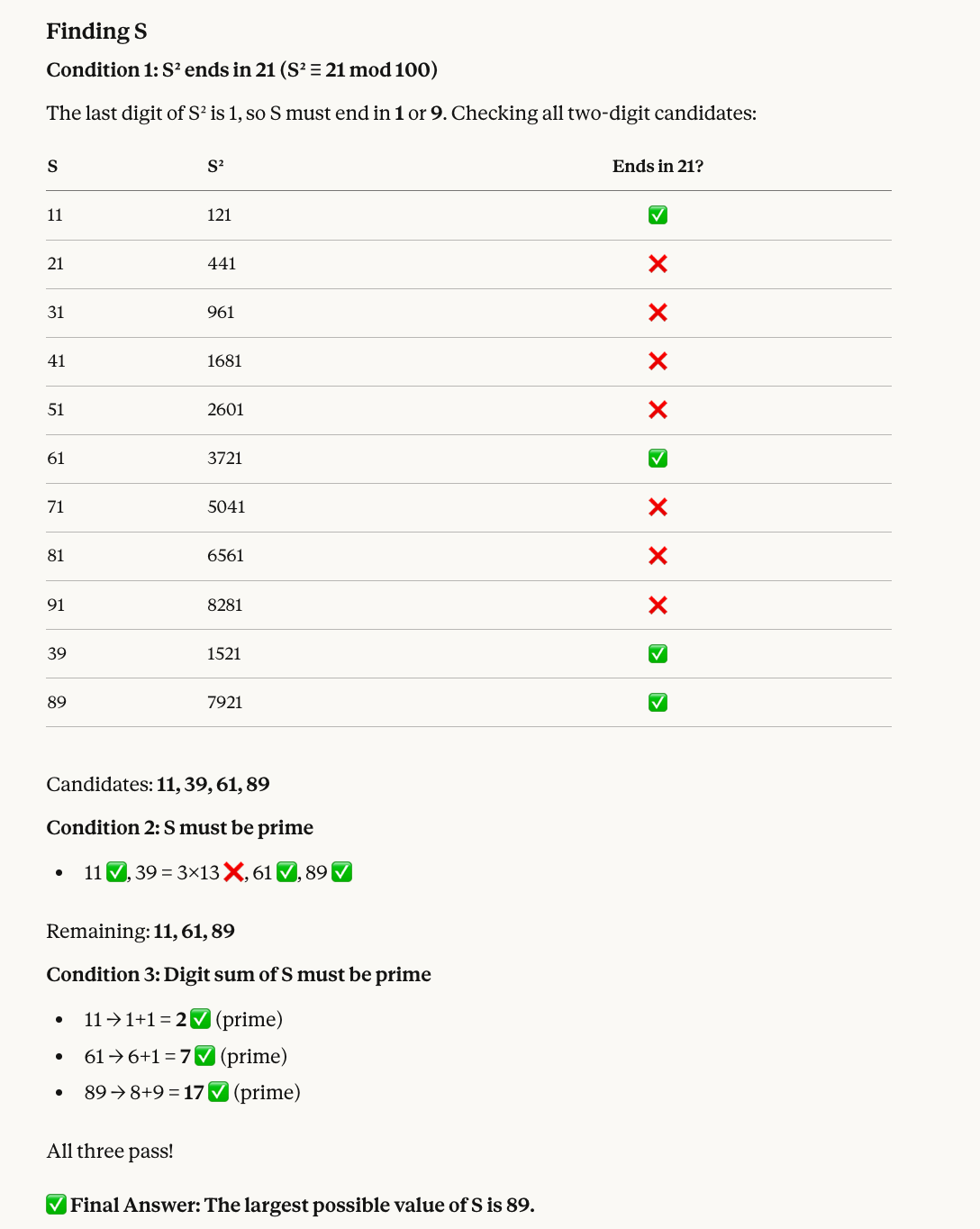

Prueba 5: Un acertijo de teoría de números

Nuestra quinta prueba combina la aritmética modular con el filtrado de números primos:

Find a two-digit number S that satisfies all of the following:

* When S is squared, the last two digits of the result are 21.

* S must be a prime number.

* The sum of the digits of S must also be a prime number.

What is the largest possible value of S?He aquí por qué el número correcto es 89: Los números cuyos cuadrados terminan en 21 son 11, 39, 61 y 89. De estos, 39 no es primo, así que nos quedan 11, 61 y 89. Los tres tienen sumas de dígitos que son primos (2, 7 y 17, respectivamente), por lo que el mayor es 89.

Opus 4.6 volvió a dar con la respuesta correcta y, en esta ocasión, también incluyó una útil representación visual:

Prueba 6: Invertir los dígitos

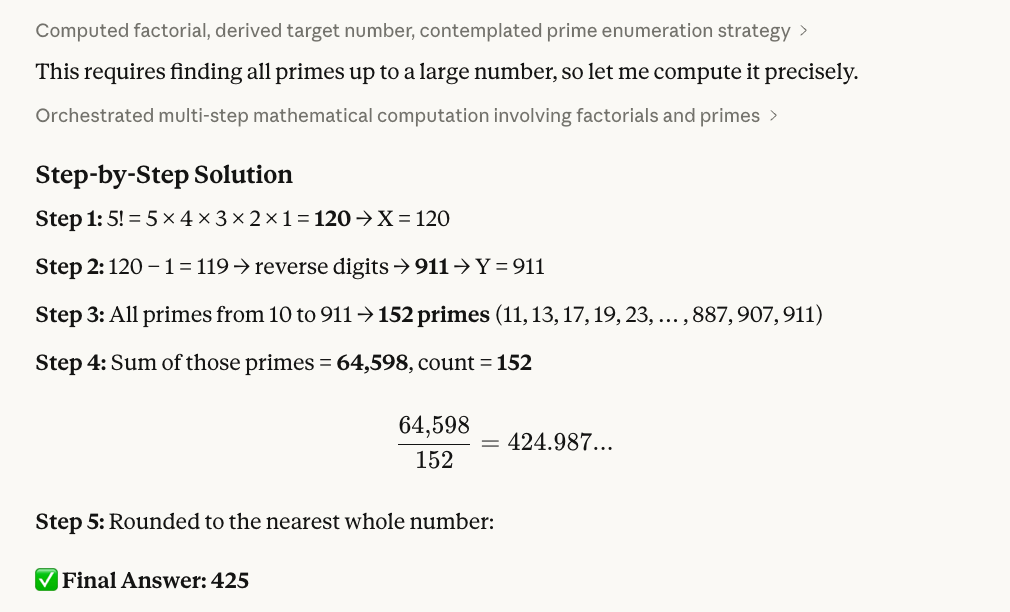

La siguiente prueba combina matemáticas factoriales, manipulación de cadenas y números primos:

Step 1: Calculate 5! (5 factorial). Let this result be X.

Step 2: Take X, subtract 1, and reverse the digits of the result. Let this new number be Y.

Step 3: Identify all prime numbers (p) such that 10 ≤ p ≤ Y.

Step 4: Calculate the sum of these primes and divide it by the total count of primes found in that range.

Step 5: Provide the final average, rounded to the nearest whole number.Así es como verificamos que 425 era la respuesta correcta: 5 = 120; resta 1 para obtener 119; invierte los dígitos para obtener 911. A continuación, utilizando un código R (que se muestra a continuación), pudimos ver que hay 152 números primos entre 10 y 911, y que su suma es 64 598. Por último, utilizando de nuevo R, dividimos y redondeamos: 64 598 ÷ 152 ≈ 425.

Este es el script R que utilizamos:

# Step 1: Calculate 5!

X <- factorial(5)

cat("Step 1: X =", X, "\n")

# Step 2: Subtract 1 and reverse digits

result <- X - 1

Y <- as.numeric(paste0(rev(strsplit(as.character(result), "")[[1]]), collapse = ""))

cat("Step 2:", X, "- 1 =", result, "-> reversed ->", Y, "\n")

# Step 3: Find all primes between 10 and Y

is_prime <- function(n) {

if (n < 2) return(FALSE)

if (n == 2) return(TRUE)

if (n %% 2 == 0) return(FALSE)

for (i in 3:floor(sqrt(n))) {

if (n %% i == 0) return(FALSE)

}

return(TRUE)

}

primes <- Filter(is_prime, 10:Y)

cat("Step 3: Found", length(primes), "primes between 10 and", Y, "\n")

# Step 4: Sum and average

total <- sum(primes)

count <- length(primes)

avg <- total / count

cat("Step 4: Sum =", total, ", Count =", count, ", Average =", avg, "\n")

# Step 5: Round

cat("Step 5: Rounded =", round(avg), "\n")Prueba 7: Depuración de código

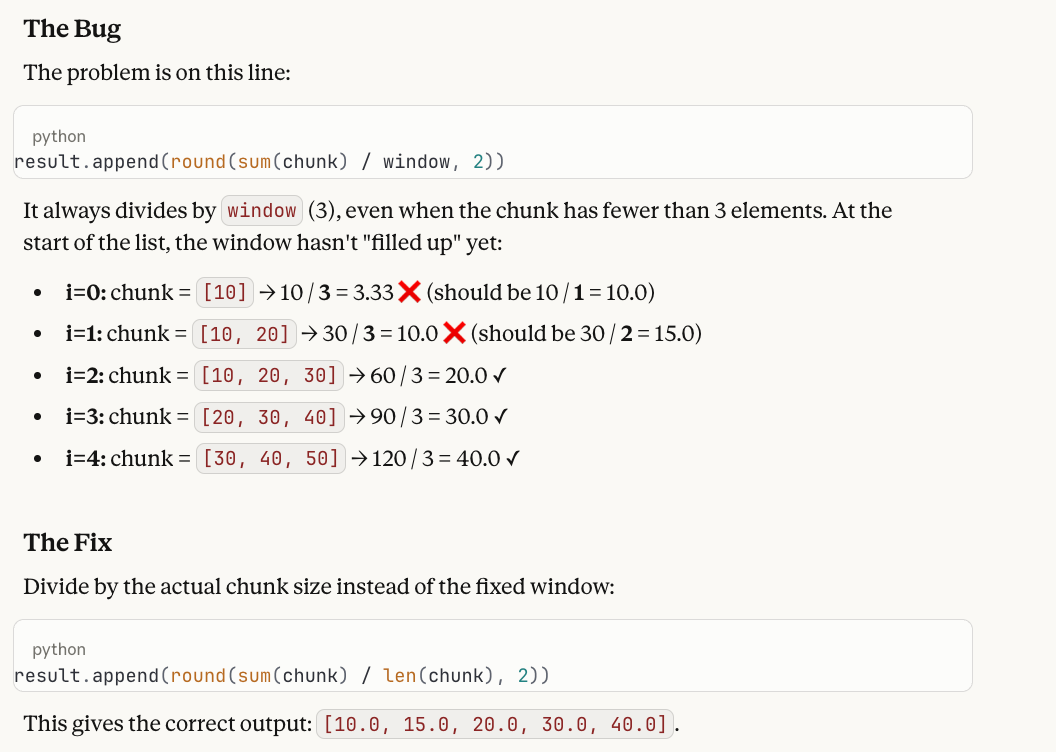

Nuestra siguiente prueba se centra en una de las principales reivindicaciones de Opus 4.6: el diagnóstico de errores en el código. Sabemos que los modelos suelen rastrear el código correctamente línea por línea, pero no logran conectar el rastreo con el fallo subyacente.

A developer wrote this Python function to compute a running average:

def running_average(data, window=3):

result = []

for i in range(len(data)):

start = max(0, i - window + 1)

chunk = data[start:i + 1]

result.append(round(sum(chunk) / window, 2))

return result

When called with running_average([10, 20, 30, 40, 50]), the first two values in the output seem wrong. Why? Please help me fix what is wrong!Aquí está la respuesta y por qué funciona como prueba: la función siempre divide por un window (3), incluso cuando el fragmento tiene menos de 3 elementos al principio de la lista. La salida errónea es [3.33, 10.0, 20.0, 30.0, 40.0], pero los dos primeros valores deberían ser 10.0 y 15.0, ya que esos fragmentos solo contienen 1 y 2 elementos, respectivamente. La solución consiste en cambiar / window por / len(chunk).

Nos gusta esta prueba porque los modelos suelen recorrer el bucle a la perfección, pero luego informan de que «el resultado parece correcto»: ven cómo se realizan los cálculos paso a paso y no señalan que dividir un solo elemento por 3 es incorrecto. Requiere que el modelo mantengauna intenció e (lo que debería hacer un promedio móvil) junto con la ejecución (lo que realmente hace el código) y detecte la diferencia entre ambos.

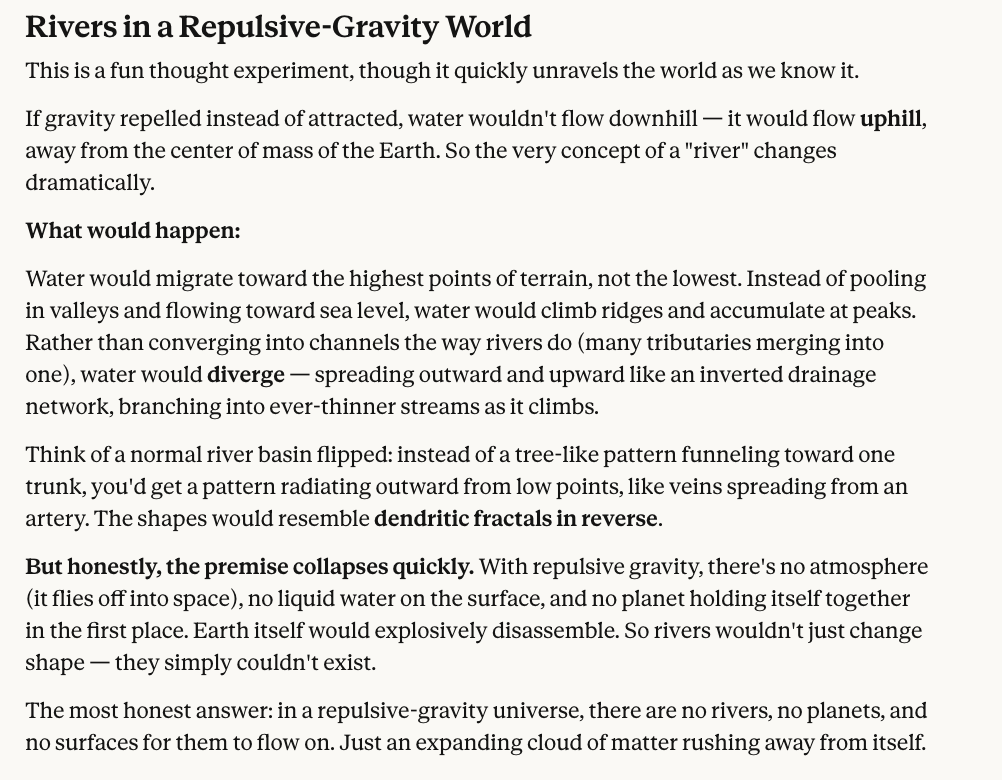

Prueba 8: Un experimento mental de física

Nuestra prueba final no incluye matemáticas, solo razonamiento contrafactual.

In a world where gravity repels objects instead of attracting them, what shape would rivers take?Es cierto que no hay una única respuesta correcta y que es difícil imaginarnos a nosotros mismos. Pero buscamos un modelo que, como mínimo, razone las implicaciones, y creemos que la respuesta de Claude Opus 4.6 parece bastante razonable.

En resumen, Opus 4.6 obtuvo una puntuación perfecta, aunque, como has visto, incluimos una pregunta cuya respuesta era un poco subjetiva, por lo que tú puedes ser el juez final.

Pruebas de rendimiento de Claude Opus 4.6

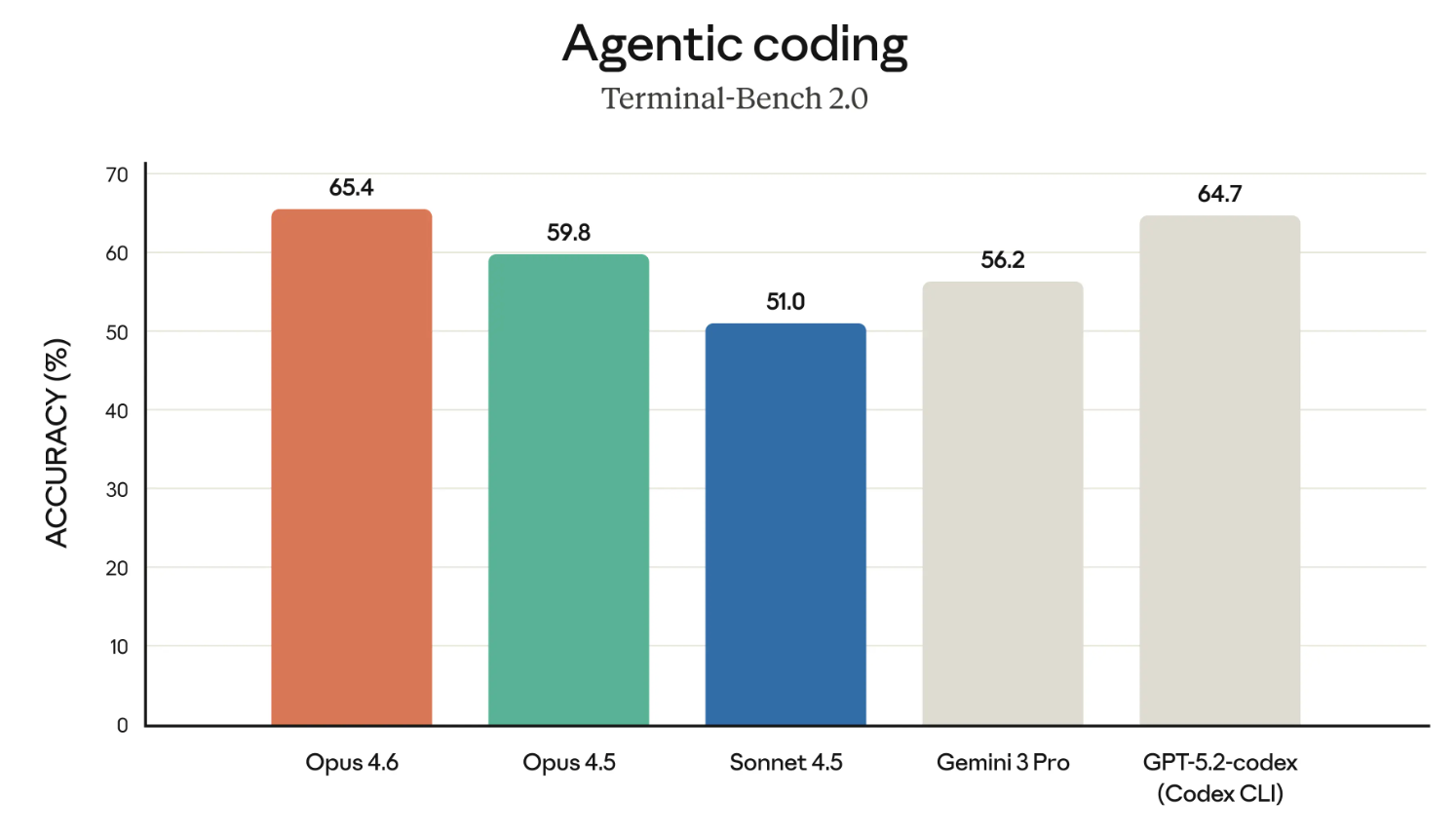

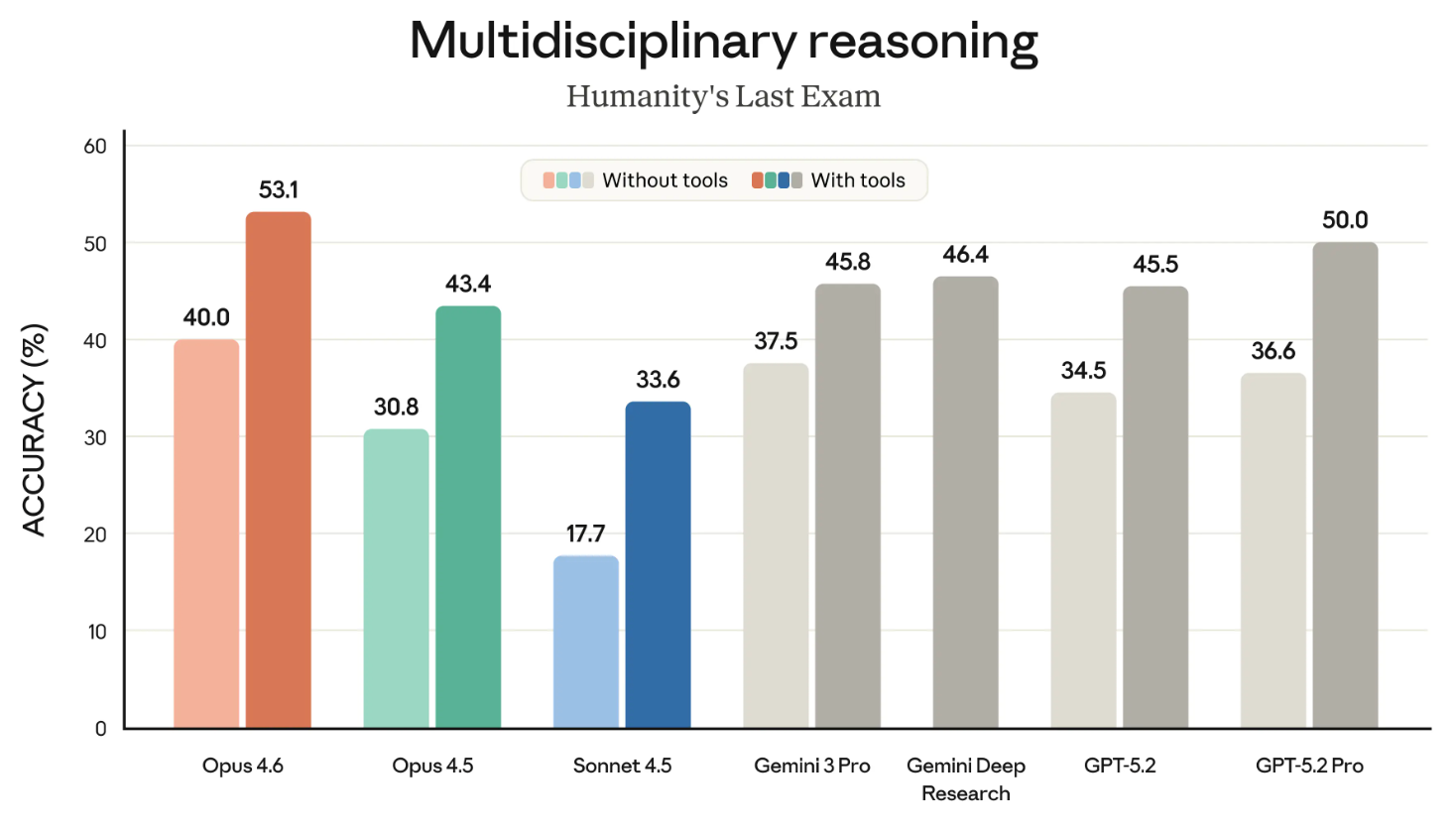

Opus 4.6 es el líder indiscutible en al menos cuatro importantes pruebas de rendimiento:

- Terminal-Bench 2.0

- El último examen de la humanidad

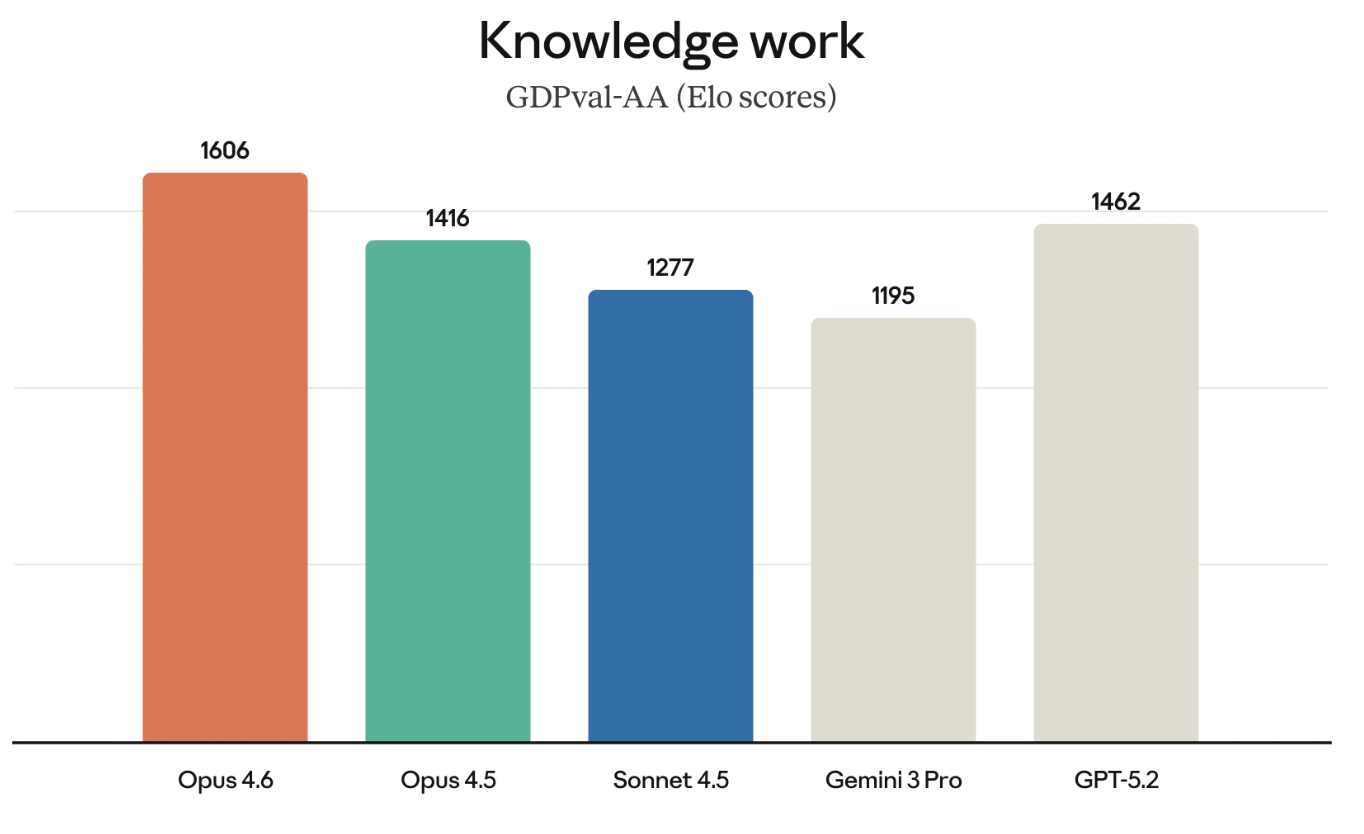

- GDPval-AA

- BrowseComp

Terminal-Bench 2.0 es un punto de referencia de codificación agencial; Humanity’s Last Exam es una prueba de razonamiento complejo; GDPval-AA evalúa el rendimiento del trabajo intelectual; BrowseComp mide la capacidad de un modelo para encontrar información difícil de encontrar en Internet.

Terminal-Bench 2.0

Los modelos Claude tienen una merecida reputación como uno de los mejores codificadores. Empecemos por ver los resultados de la prueba Terminal-Bench 2.0.

Si el gráfico anterior parece destacar Opus 4.6 en relación con GPT-5.2-codex, bueno, sin duda es intencionado. Anthropic ha estado desafiando directamente a OpenAI en varias áreas recientemente, y está defendiendo su uso empresarial.

El último examen de la humanidad

El último examen de la humanidad es uno de los puntos de referencia más conocidos, y todos lo seguimos muy de cerca. Mide la capacidad de razonamiento general de un modelo.

El siguiente gráfico muestra el éxito de los diferentes modelos fronterizos en el benchmark HLE, tanto con herramientas como sin ellas. («Con herramientas» significa que se permitió al modelo utilizar capacidades externas, como buscar en la web y ejecutar código).

Este gráfico quedaría mejor si se dividiera en dos gráficos. Dejando de lado ese pequeño detalle, la conclusión es clara: Opus 4.6 es líder tanto en la categoría «con herramientas» como en la categoría «sin herramientas».

GDPVal-AA

El GDPVal-AA (como su nombre indica) es una prueba que evalúa lo que se considera trabajo intelectual de valor económico. Piensa en cosas como ejecutar modelos financieros o hacer investigaciones.

El GDPVal-AA y otros índices de referencia similares están cobrando cada vez más importancia, ya que miden realmente los tipos de trabajo por los que las empresas están pagando. El éxito de Opus 4.6 en GDPVal-AA también supone otro desafío directo para la suite de modelos GPT, ya que OpenAI y Anthropic compiten por muchos de los mismos clientes.

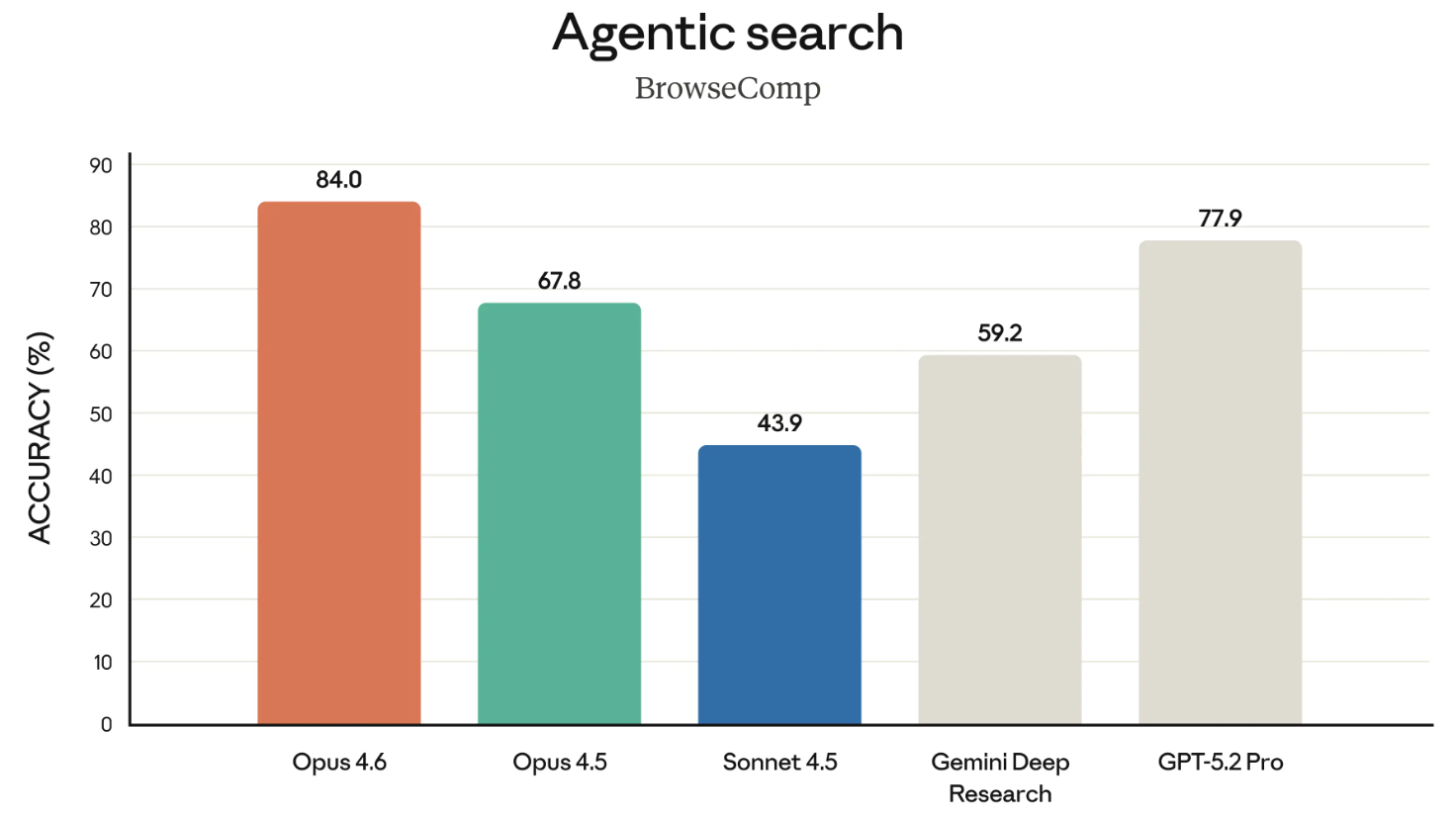

BrowseComp

BrowseComp es el último punto de referencia que vale la pena mencionar de esta versión. Mide la capacidad de un modelo para localizar información difícil de encontrar en Internet. Un poco de historia: OpenAI desarrolló BrowseComp para mostrar las capacidades de búsqueda de sus propios modelos.

En una jugada deliberada, en este comunicado, Anthropic ha hecho referencia directa al anuncio realizado por OpenAI en abril de 2025 sobre el desarrollo de BrowseComp al destacar que Opus 4.6 encabeza las listas de este programa. Fue una jugada un poco turbia, citarles tu propio punto de referencia de OpenAI de esa manera.

Claude 4.6 Precios y disponibilidad

Opus 4.6 está ampliamente disponible en el momento de redactar este artículo. Sin embargo, no puedes acceder a Opus 4.6 sin actualizar a una cuenta pro, que incluye otras ventajas, como permitirte usar Claude en Excel.

Si eres programador, debes utilizar la API de Claude ( claude-opus-4-6 ). El precio no ha cambiado: Sigue siendo 5 $/25 $ por cada millón de tokens. Si estás confundido con los dos números, debes saber que el primero es lo que pagas por enviar tokens a la modelo (me refiero a tus indicaciones) y el segundo es lo que pagas por los tokens que ella genera a cambio (las respuestas).

Reflexiones finales

Claude Opus 4.6 encabeza la clasificación en importantes pruebas de rendimiento como GPDVal-AA, que mide el rendimiento de un modelo en tareas de importancia económica, que es lo que te interesa a los clientes de grandes empresas. OpenAI podría estar nervioso por este avance, ya que solo unas horas antes del lanzamiento de Opus 4.6, anunciaron OpenAI Frontier, una nueva plataforma empresarial para crear, implementar y gestionar agentes de IA en producción.

En otras palabras, en lugar de competir en términos de referencia de modelos, Frontier nos muestra que OpenAI se centra en la infraestructura que rodea a su conjunto de modelos, concretamente proporcionando a los agentes de IA un contexto empresarial compartido, permisos y la capacidad de recibir y aprender de los comentarios a lo largo del tiempo. Al perder terreno en los puntos de referencia, OpenAI está indicando que su plataforma está mejor posicionada para hacer que los agentes sean realmente útiles en una empresa.

Si se trata de un giro estratégico o de una admisión tácita de que están perdiendo la carrera por el modelo, eso lo debes decidir tú.

En general, sin embargo, estamos impresionados con lo que Anthropic ofrece con Claude Opus 4.6, y estamos deseando poner en práctica los equipos de agentes. Si deseas obtener más información sobre la familia Claude, no te pierdas el curso curso Introducción a los modelos Claude.

Escritora y editora de contenidos en el ámbito de la tecnología educativa. Comprometido con la exploración de tendencias de datos y entusiasmado con el aprendizaje de la ciencia de datos.