Curso

Rumores sobre o próximo lançamento da Anthropic têm circulado nos últimos dias. Embora muitos esperassem o Claude Sonnet 5, o primeiro lançamento do ano veio na forma do Claude Opus 4.6.

Com uma janela de contexto de 1 milhão de tokens, pensamento adaptativo, compactação de conversas e uma série de benchmarks no topo das paradas, o Claude Opus 4.6 é uma melhoria em relação ao Opus 4.5. Como a Anthropic diz, eles melhoraram o modelo mais inteligente deles. Junto com o modelo, a Anthropic também lançou equipes de agentes no Claude Code e no Claude no PowerPoint.

Neste artigo, vamos falar sobre todas as novidades do Claude Opus 4.6, ver os novos recursos, explorar os benchmarks e testá-lo com vários exemplos práticos.

Pra saber mais sobre algumas das funcionalidades mais recentes do Claude, recomendo dar uma olhada nos nossos guias sobre Claude Cowork e Claude Code, além do nosso tutorial do OpenClaw.

O que é o Claude Opus 4.6?

Claude Opus 4.6 é o mais recente modelo de linguagem grande da Anthropic. Continuando a partir do Opus 4.5, representa uma atualização significativa para a linha de modelos “mais inteligentes” da empresa.

No blog de lançamento, a Anthropic diz que tá mais focada em codificação agênica, raciocínio profundo e autocorreção. Isso quer dizer que rolou uma mudança de ação para uma açãosustentada .

O Opus 4.6 foi feito pra planejar com mais cuidado, tem uma coerência melhor em períodos mais longos e identifica erros no próprio funcionamento. Tudo isso significa que o Claude Opus 4.6 está no topo de vários benchmarks, incluindo a pontuação máxima na avaliação de codificação Terminal-Bench 2.0 e superando todos os outros modelos de ponta no Humanity’s Last Exam.

Uma das coisas que mais me chama a atenção é a janela de contexto melhorada. janela de contexto no Claude Opus 4.6. Com 1 milhão de tokens na versão beta, isso deixa o novo modelo igual ao Gemini 3, ou seja, ele consegue processar mais informações sem perder o contexto.

O que há de novo no Claude Opus 4.6?

Tem várias novidades legais no Claude Opus 4.6, muitas delas focadas em fluxos de trabalho de agentes. Vamos dar uma olhada em alguns dos pontos principais:

Equipes de agentes

As equipes de agentes são uma melhoria em relação aos “subagentes” que vimos nas versões anteriores do Claude. As equipes de agentes permitem que você crie várias instâncias Claude totalmente independentes que podem funcionar em paralelo. Uma sessão é o agente “líder” que coordena as coisas, enquanto os “colegas de equipe” cuidam da execução de verdade.

O que eu acho mais interessante é que cada membro da equipe tem sua própria janela de contexto, o que permite uma execução mais completa. Cada colega de equipe também pode falar diretamente com os outros da equipe.

Claro, esse recurso tem um lado ruim: o custo. Como cada agente tem sua própria janela de contexto, você pode começar a gastar seus tokens rapidamente. Por isso, a Anthropic recomenda que você use isso em situações mais complicadas.

Compactação de conversas

Uma característica interessante do Claude Opus 4.6 é a compactação de contexto. Essa melhoria na qualidade de vida ajuda a evitar problemas quando você está executando fluxos de trabalho longos que maximizam as janelas de contexto. Normalmente, você vai bater numa parede de contexto onde o desempenho começa a piorar.

Com a compactação de conversas, o Claude Opus 4.6 consegue detectar automaticamente quando uma conversa está chegando a um limite de tokens e resumir a conversa existente em um bloco conciso (um bloco de compactação).

Esse recurso deve ajudar a manter o essencial das suas interações e, ao mesmo tempo, liberar espaço para você continuar trabalhando. Se você está pensando em usar agentes orientados a tarefas que precisam funcionar por muito tempo, isso pode mantê-los em dia com uma memória bem melhor.

Pensamento e esforço adaptativos

Tem duas coisas no Claude Opus 4.6 que decidem se ele precisa pensar mais e o quanto ele se esforça pra pensar.

O raciocínio adaptativo permite que o modelo descubra o quão complexo é o seu prompt. Dependendo da simplicidade ou complexidade, vai decidir se usa o raciocínio ampliado. Em vez de ter uma configuração manual para quantos toques são usados para isso, o Claude vai ajustar seu orçamento com base na complexidade de cada solicitação.

O parâmetro de esforço permite definir o quanto Claude é ansioso ou conservador em relação ao gasto de tokens. Basicamente, isso quer dizer que você pode equilibrar a eficiência dos tokens e o nível de detalhe das respostas.

Ao usar o Claude Opus 4.6 na API, você pode definir esses parâmetros manualmente. Por exemplo:

- : Claude sempre pensa bem e não tem limites pra profundidade.

- de alto esforço: Com essa configuração padrão, Claude sempre pensa e apresenta um raciocínio profundo.

- , esforço médio: Isso faz você pensar com calma e pode até deixar de pensar nas perguntas mais simples.

- Baixo esforçot: Claude deixa de pensar em tarefas simples e minimiza o raciocínio em favor da rapidez.

Claude no PowerPoint

Recentemente, falamos sobre Claude no Excel, mostrando como o complemento pode te ajudar com várias tarefas em um painel lateral da sua planilha do Excel. Além de melhorar a funcionalidade dessa ferramenta, a Anthropic anunciou o Claude no PowerPoint.

Essa integração respeita seus modelos de slides, fontes e layouts. Você pode inserir um modelo corporativo e pedir para ele criar uma seção específica, ou selecionar um slide e pedir para ele converter um texto denso em um diagrama nativo e editável.

A ênfase em criar objetos editáveis do PowerPoint, em vez de só “imagens de slides”, faz com que essa ferramenta seja realmente produtiva, e não só um gerador de ideias.

O Claude no PowerPoint tá atualmente em pré-visualização de pesquisa pra usuários Max e Enterprise.

Testando o Claude Opus 4.6: Exemplos práticos

Muitas das principais afirmações do Opus 4.6 focam em tarefas de codificação mais complexas e raciocínio mais profundo. Todas essas habilidades dependem de uma base: a capacidade de manter várias restrições em mente, raciocinar em várias etapas e detectar erros.

Pensando nisso, colocamos o Opus 4.6 pra passar por uma série de desafios de lógica, matemática e programação com várias etapas. Queríamos ver se conseguíamos expor algumas fraquezas conhecidas e comuns do LLM – coisas como erros de cálculo em cascata, raciocínio espacial (sempre um problema) e questões que envolvem restrições. Também colocamos uma tarefa específica de depuração porque o anúncio da Anthropic se gabava de como o Opus 4.6 era bom em análise de causa raiz e outras questões de depuração.

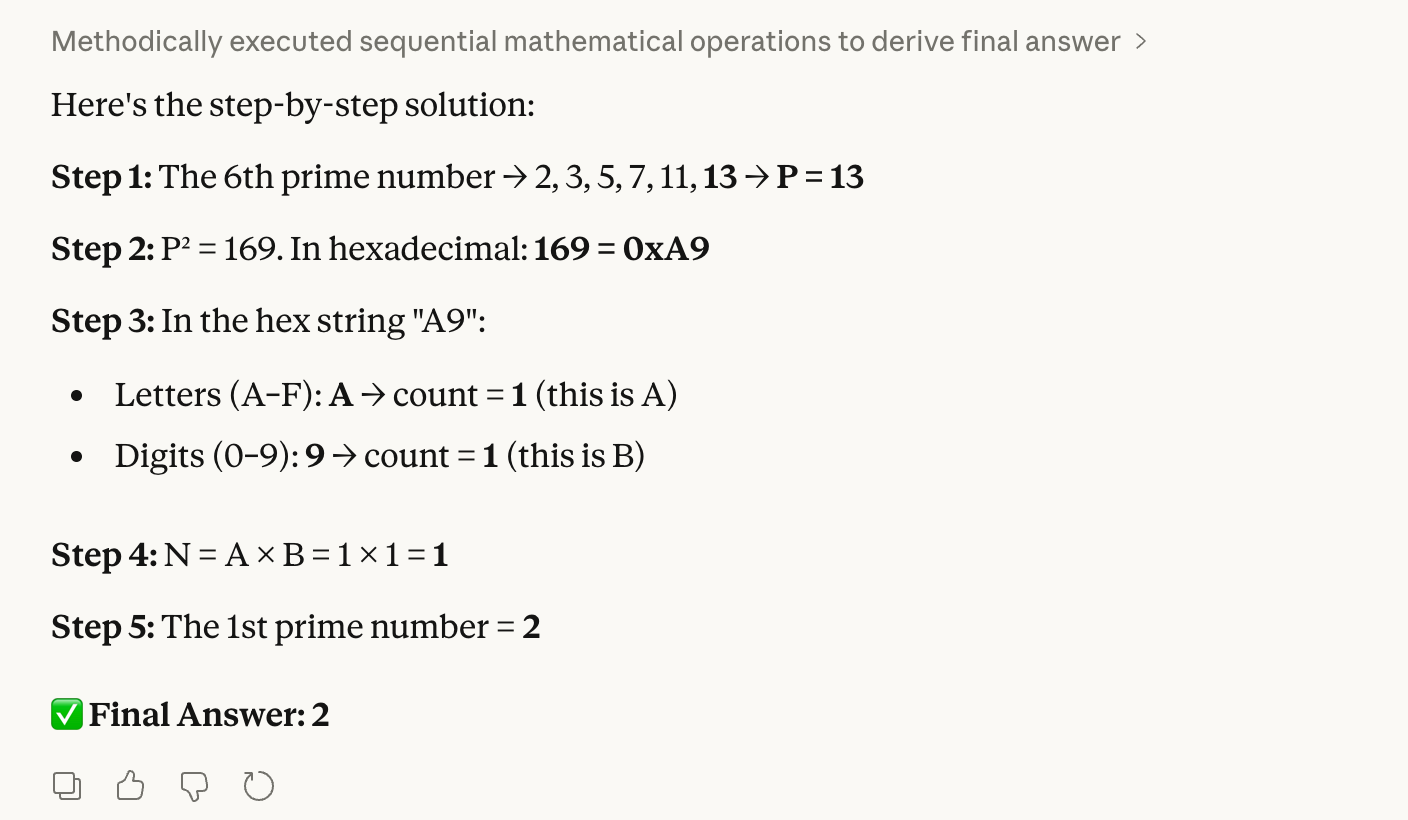

Teste 1: Lógica hexadecimal para decimal

Nosso primeiro teste junta números primos, hexadecimais e contagem:

Step 1: Find the 6th prime number. Let this be P.

Step 2: Convert the square of P into hexadecimal.

Step 3: Count the letters (A–F) and digits (0–9) in that hex string. Let these be A and B.

Step 4: Multiply A × B. Let this be N.

Step 5: Find the Nth prime number.Parece um pouco complicado, mas esse teste é bem fácil de verificar para nós, humanos. A resposta certa que sabemos é 2 porque o sexto número primo é 13; 13 ao quadrado é 169, que é “A9” em hexadecimal. Isso tem 1 letra × 1 dígito, que dá 1 quando a gente multiplica, e o primeiro primo é 2.

A preocupação é que um modelo possa tropeçar na conversão hexadecimal, o que levaria a uma resposta final completamente errada. Como você pode ver, o Opus 4.6 não teve nenhum problema:

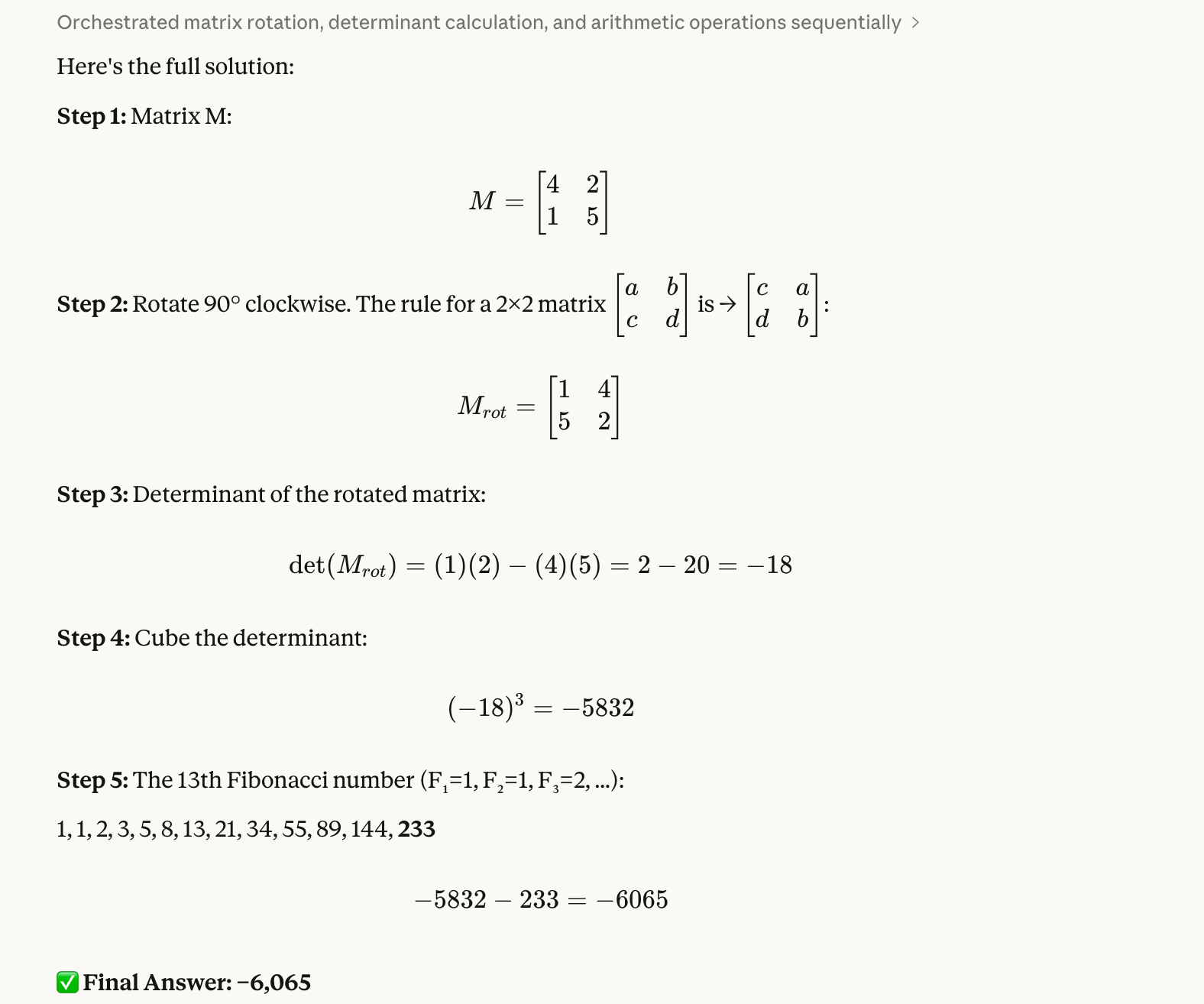

Teste 2: Girando uma matriz

Nosso segundo teste é sobre raciocínio espacial e como lidar com números negativos:

Step 1: Create a 2×2 matrix M with top row [4, 2] and bottom row [1, 5].

Step 2: Rotate M 90 degrees clockwise.

Step 3: Calculate the determinant of the rotated matrix.

Step 4: Cube that determinant.

Step 5: Subtract the 13th Fibonacci number from the result.Esse aqui deu um pouco mais de trabalho pra gente verificar. A resposta certa é -6.065. Sabemos disso porque a matriz girada é [[1, 4], [5, 2]]; então, podemos usar Python para achar o determinante, que é -18, e quando elevamos esse número ao cubo, temos -5.832; por fim, tiramos 233 e ficamos com -6.065.

Gostamos da ideia desse teste porque sabemos por experiência própria que os modelos muitas vezes trocam os elementos da matriz de forma errada ou perdem o sinal negativo no meio do caminho. Mais uma vez, o Opus 4.6 não teve nenhum problema:

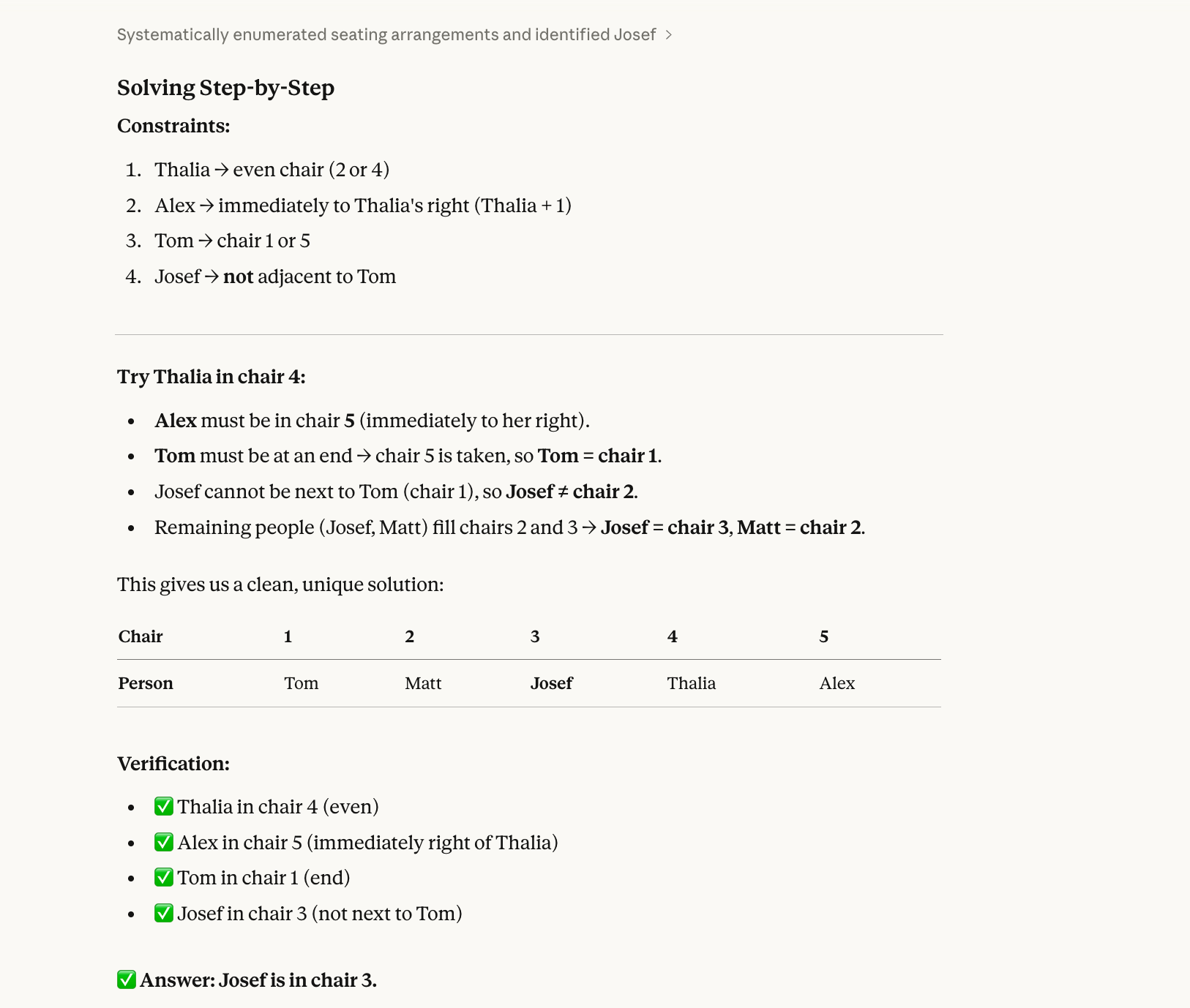

Teste 3: Um quiz sobre a disposição dos lugares

No nosso terceiro teste, tentamos resolver um problema de satisfação de restrições que precisa de backtracking:

Five people (Alex, Josef, Matt, Thalia, Tom) sit in chairs 1–5.

Thalia is in an even-numbered chair.Alex is immediately to Thalia’s right.Tom is at one end.Josef is not next to Tom.Who is in chair 3?A resposta certa pra esse teste é Josef. (Alex-1, Matt-2, Josef-3, Thalia-4, Tom-5.) Você pode resolver isso em um pedaço de papel com um pouco de esforço.

A principal razão pela qual um modelo pode errar esse tipo de questão é porque os modelos sempre resolveram as coisas de forma sequencial, e não holística. Eles leem “Thalia está em uma cadeira par” e escolhem uma (digamos, a cadeira 2) sem verificar se essa escolha funciona com todas as outras restrições. Então eles se comprometem com isso, preenchem mais cadeiras e, eventualmente, entram em conflito, mas, a essa altura, já se colocaram em uma situação complicada e não voltam atrás para tentar Thalia na cadeira 4.

O Opus 4.6 também acertou nessa:

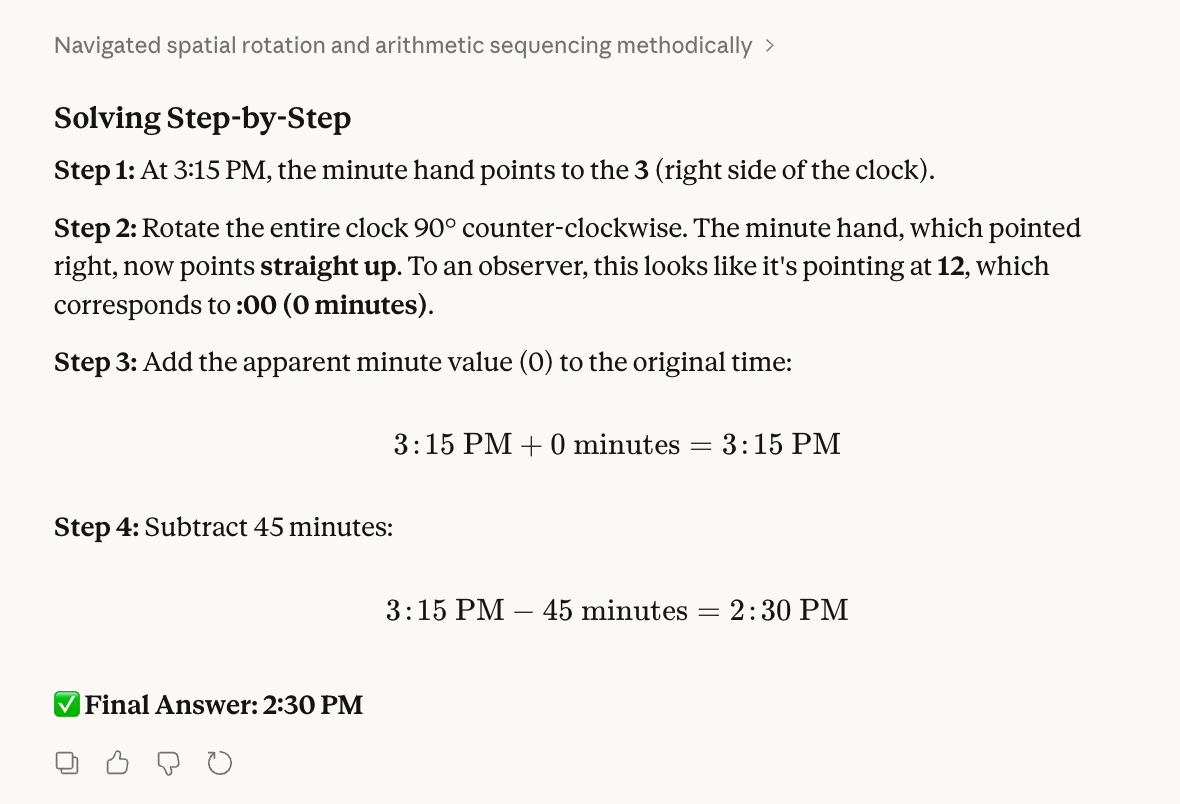

Teste 4: Um quebra-cabeça de relógio

Nosso quarto teste avalia a visualização espacial e a intuição física:

Step 1: Imagine a clock currently showing 3:15 PM.

Step 2: Rotate the clock 90 degrees counter-clockwise (physically turning the whole clock face). After the rotation, what time does the minute hand appear to be pointing at?

Step 3: Take that new "apparent" minute value and add it to the original time (3:15 PM).

Step 4: Subtract 45 minutes from that result.

Step 5: What is the final time?Para verificar isso, eu realmente tirei o relógio do meu pulso e o girei.

A resposta certa é 14h30. Às 3:15, o ponteiro dos minutos está apontando para o “3”. Quando apontei o 12 para a janela à minha esquerda, o “3” foi para onde estava o “12”. Então, somei 0 a 3:15, tirei 45 minutos e cheguei às 14:30.

Ao projetar o teste, esperávamos que os modelos pudessem confundir girar o mostrador do relógio com mover o ponteiro. Também ouvimos dizer que os modelos tendem a achar que adicionar 0 é suspeito e, por isso, tentam forçar um número diferente.

Mas o Opus 4.6 conseguiu resolver esse problema; ele também deu a resposta certa:

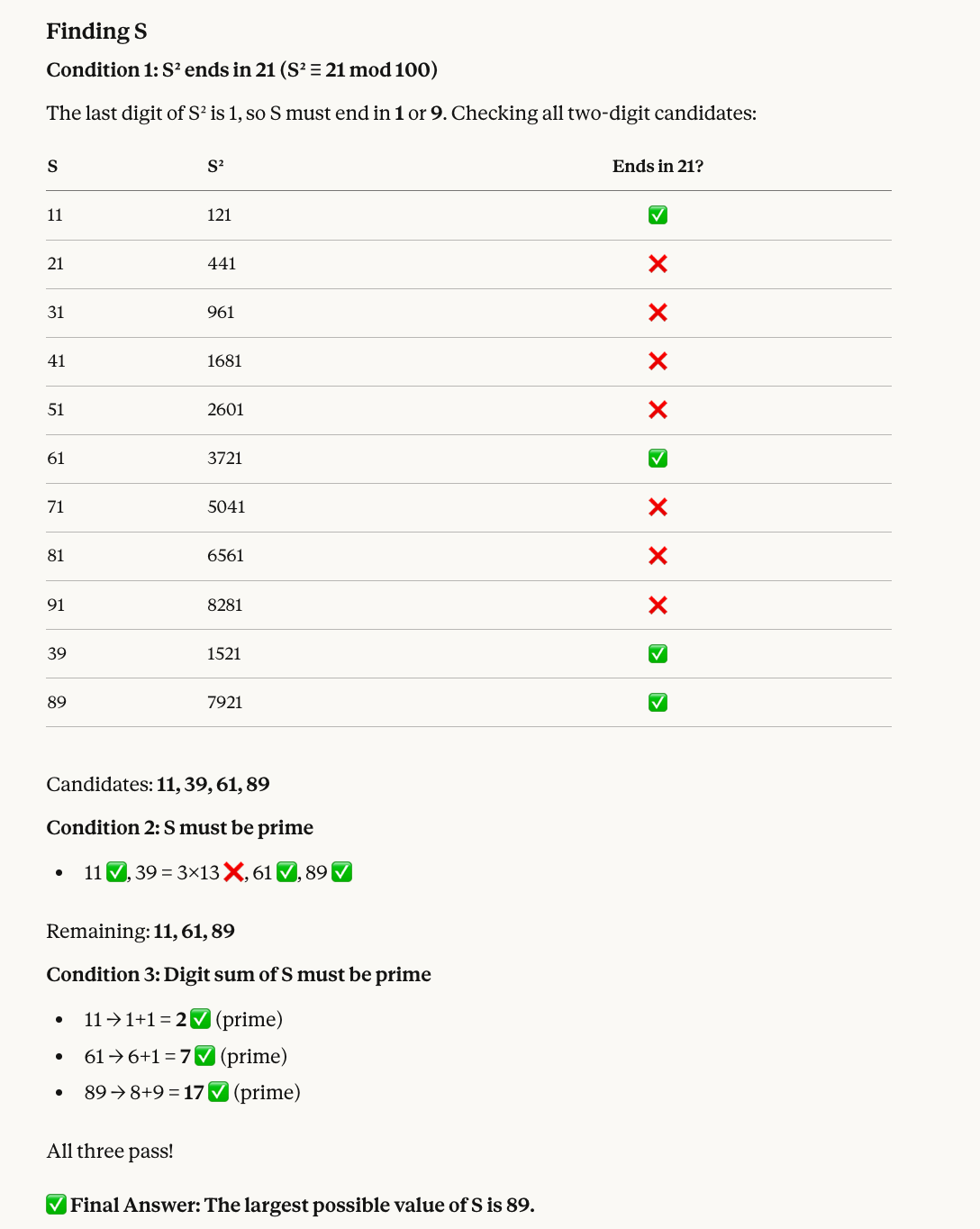

Teste 5: Um quebra-cabeça de teoria dos números

Nosso quinto teste junta aritmética modular com filtragem de números primos:

Find a two-digit number S that satisfies all of the following:

* When S is squared, the last two digits of the result are 21.

* S must be a prime number.

* The sum of the digits of S must also be a prime number.

What is the largest possible value of S?Eis porque o número certo é 89: Os números cujos quadrados terminam em 21 incluem 11, 39, 61 e 89. Desses, 39 não é primo, então ficamos com 11, 61 e 89. Todos os três têm somas de dígitos que são números primos (2, 7 e 17, respectivamente), então o maior é 89.

O Opus 4.6 acertou a resposta mais uma vez, e dessa vez ainda incluiu um visual bem útil:

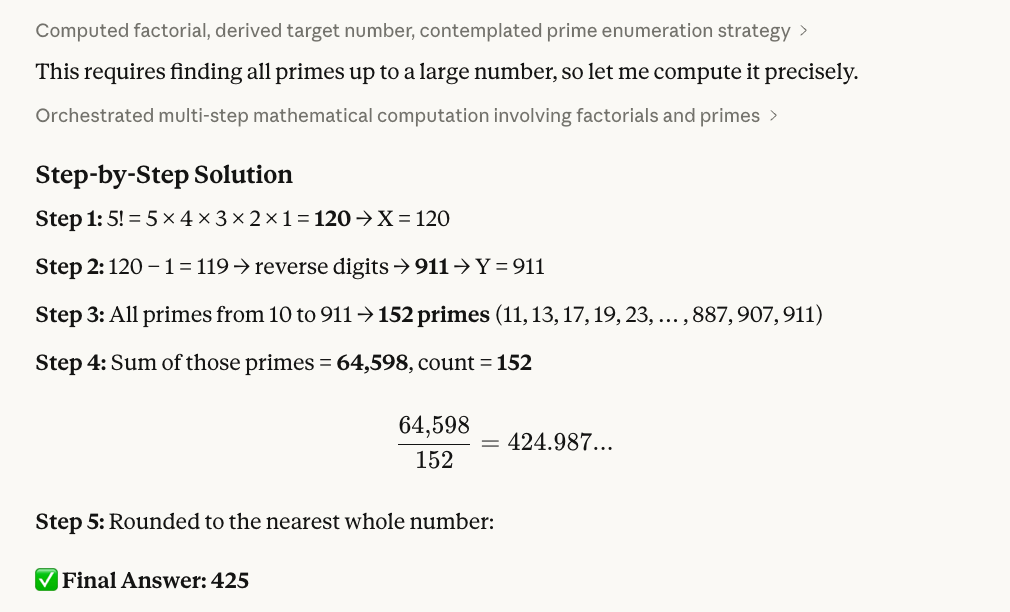

Teste 6: Invertendo os dígitos

O próximo teste junta matemática fatorial, manipulação de strings e números primos:

Step 1: Calculate 5! (5 factorial). Let this result be X.

Step 2: Take X, subtract 1, and reverse the digits of the result. Let this new number be Y.

Step 3: Identify all prime numbers (p) such that 10 ≤ p ≤ Y.

Step 4: Calculate the sum of these primes and divide it by the total count of primes found in that range.

Step 5: Provide the final average, rounded to the nearest whole number.Veja como verificamos que 425 é a resposta certa: 5! = 120; tire 1 pra chegar em 119; inverta os números pra chegar em 911. Então, usando um código R (mostrado abaixo), a gente viu que tem 152 números primos entre 10 e 911, e a soma deles é 64.598. Por fim, usando o R de novo, a gente divide e arredonda: 64.598 ÷ 152 ≈ 425.

Aqui está o script R que usamos:

# Step 1: Calculate 5!

X <- factorial(5)

cat("Step 1: X =", X, "\n")

# Step 2: Subtract 1 and reverse digits

result <- X - 1

Y <- as.numeric(paste0(rev(strsplit(as.character(result), "")[[1]]), collapse = ""))

cat("Step 2:", X, "- 1 =", result, "-> reversed ->", Y, "\n")

# Step 3: Find all primes between 10 and Y

is_prime <- function(n) {

if (n < 2) return(FALSE)

if (n == 2) return(TRUE)

if (n %% 2 == 0) return(FALSE)

for (i in 3:floor(sqrt(n))) {

if (n %% i == 0) return(FALSE)

}

return(TRUE)

}

primes <- Filter(is_prime, 10:Y)

cat("Step 3: Found", length(primes), "primes between 10 and", Y, "\n")

# Step 4: Sum and average

total <- sum(primes)

count <- length(primes)

avg <- total / count

cat("Step 4: Sum =", total, ", Count =", count, ", Average =", avg, "\n")

# Step 5: Round

cat("Step 5: Rounded =", round(avg), "\n")Teste 7: Depuração de código

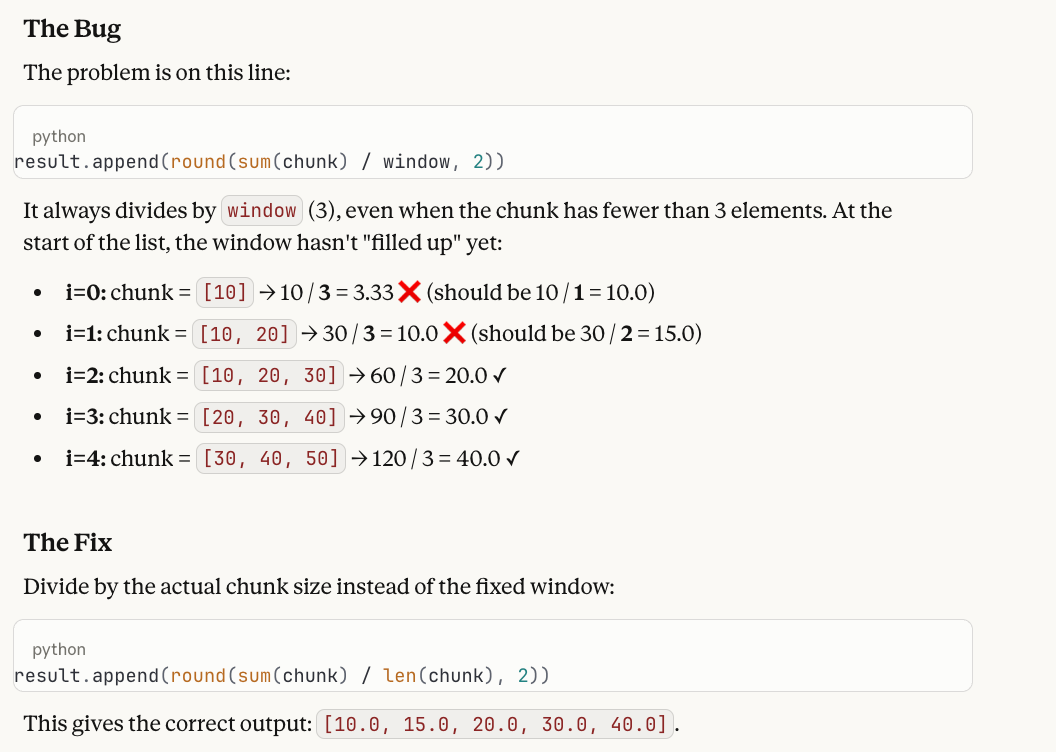

Nosso próximo teste foca em uma das principais promessas do Opus 4.6: diagnosticar bugs no código. A gente sabe que os modelos geralmente rastreiam o código linha por linha corretamente, mas não conseguem conectar o rastreamento à falha subjacente.

A developer wrote this Python function to compute a running average:

def running_average(data, window=3):

result = []

for i in range(len(data)):

start = max(0, i - window + 1)

chunk = data[start:i + 1]

result.append(round(sum(chunk) / window, 2))

return result

When called with running_average([10, 20, 30, 40, 50]), the first two values in the output seem wrong. Why? Please help me fix what is wrong!Aqui está a resposta e por que funciona como um teste: a função sempre divide por um window (3), mesmo quando o bloco tem menos de 3 elementos no início da lista. A saída com erro é [3.33, 10.0, 20.0, 30.0, 40.0], mas os dois primeiros valores deveriam ser 10.0 e 15.0, já que esses blocos têm só 1 e 2 elementos, respectivamente. A correção é mudar / window para / len(chunk).

Gostamos desse teste porque os modelos geralmente traçam o loop perfeitamente, mas depois dizem que “a saída parece correta” — eles veem a matemática acontecendo passo a passo e não sinalizam que dividir um único elemento por 3 está errado. Isso exige que o modelo tenhauma intenção e e (o que uma média móvel deve fazer) junto com a execução (o que o código realmente faz) e identifique a diferença entre elas.

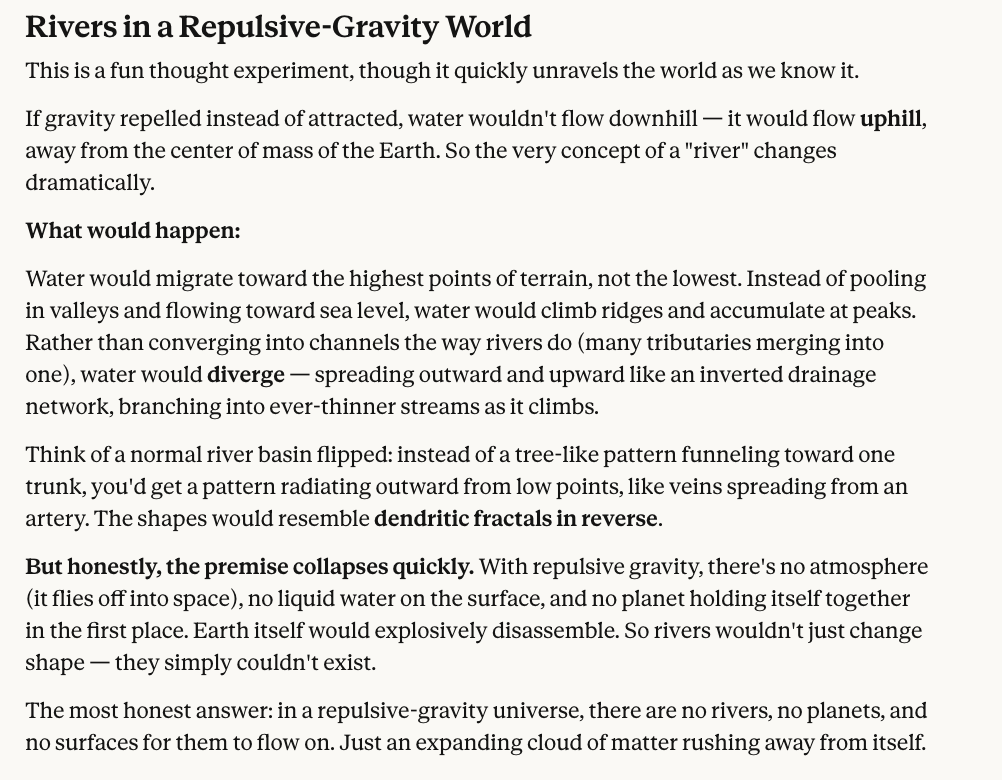

Teste 8: Um experimento mental de física

Nosso teste final não tem matemática, só raciocínio contrafactual.

In a world where gravity repels objects instead of attracting them, what shape would rivers take?Claro, não tem uma resposta certa pra isso, e é difícil imaginar a gente mesmo. Mas a gente tá procurando um modelo que pelo menos pense nas implicações, e achamos que a resposta do Claude Opus 4.6 parece bem razoável.

Resumindo, o Opus 4.6 teve uma nota perfeita, mas, como você viu, colocamos uma pergunta cuja resposta era meio subjetiva, então você pode ser o juiz final.

Claude Opus 4.6 Benchmarks

O Opus 4.6 é o líder indiscutível em pelo menos quatro benchmarks importantes:

- Terminal-Bench 2.0

- A última prova da humanidade

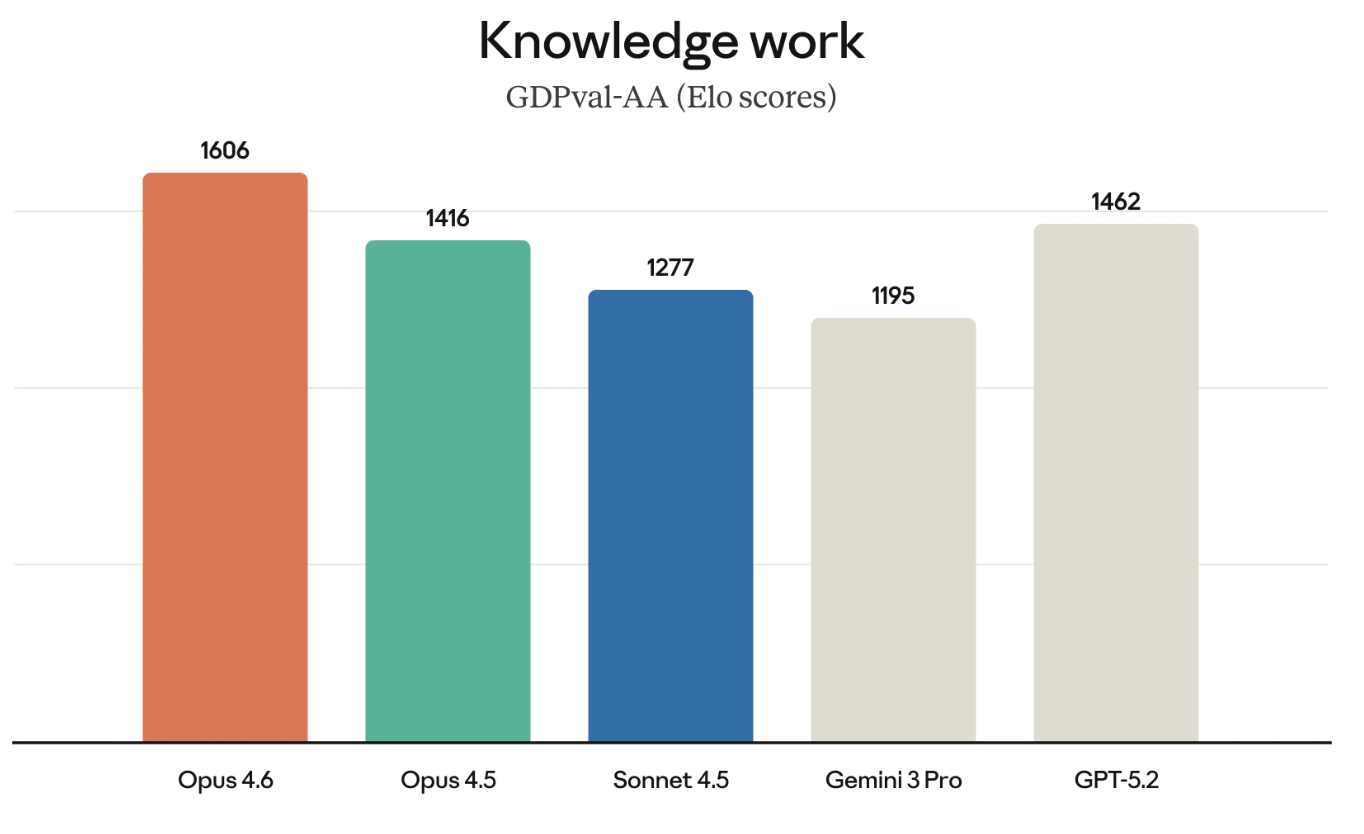

- GDPval-AA

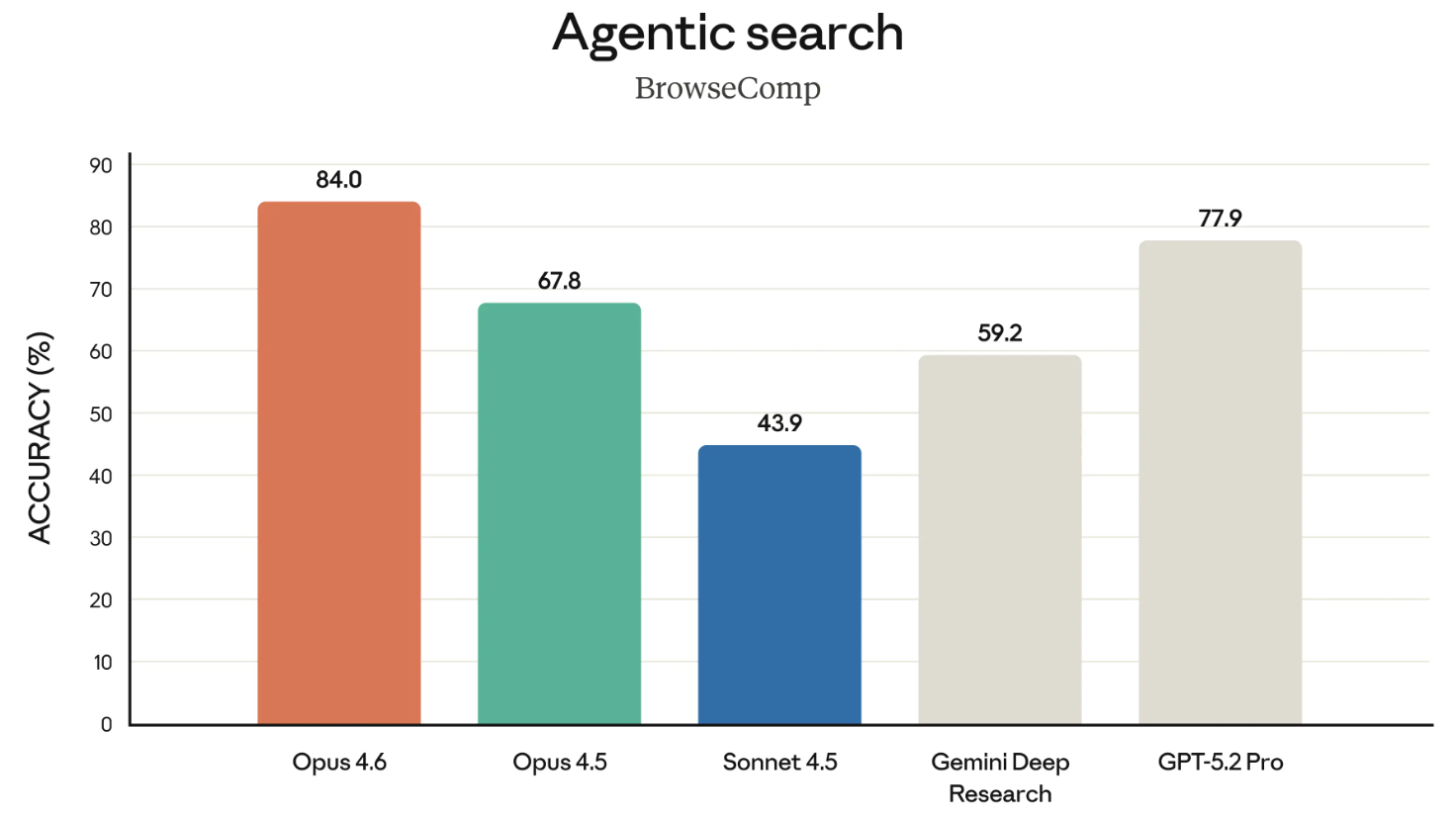

- BrowseComp

O Terminal-Bench 2.0 é um benchmark de codificação agênica; o Humanity’s Last Exam é um teste de raciocínio complexo; o GDPval-AA testa o desempenho do trabalho intelectual; BrowseComp mede a capacidade de um modelo de encontrar informações difíceis de encontrar online.

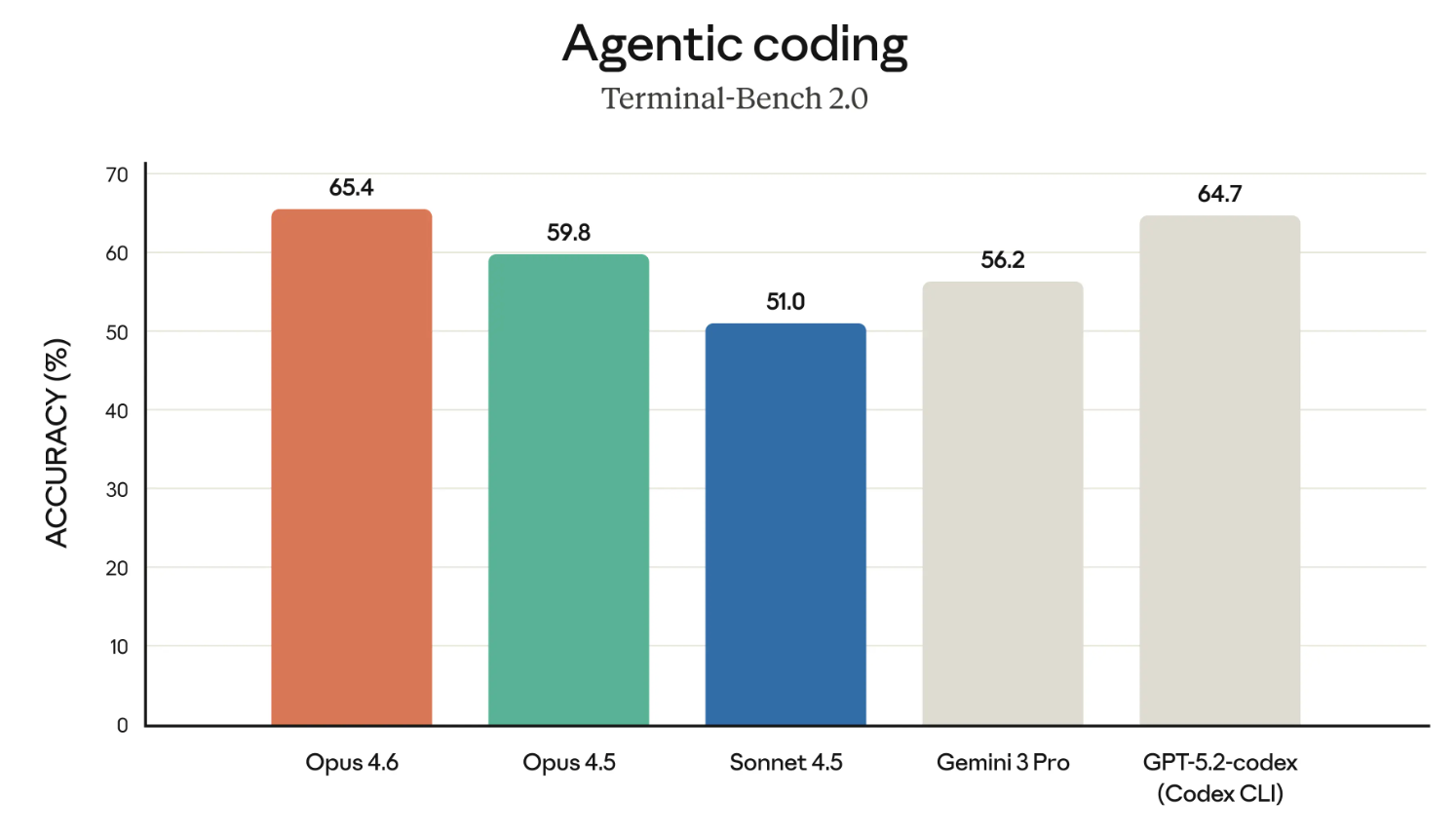

Terminal-Bench 2.0

Os modelos Claude têm uma reputação merecida como um dos melhores codificadores. Então, vamos começar analisando os resultados do benchmark Terminal-Bench 2.0.

Se o gráfico acima parece destacar o Opus 4.6 em relação ao GPT-5.2-codex, bem, isso é certamente intencional. A Anthropic tem desafiado diretamente a OpenAI em várias áreas recentemente e está defendendo o uso corporativo.

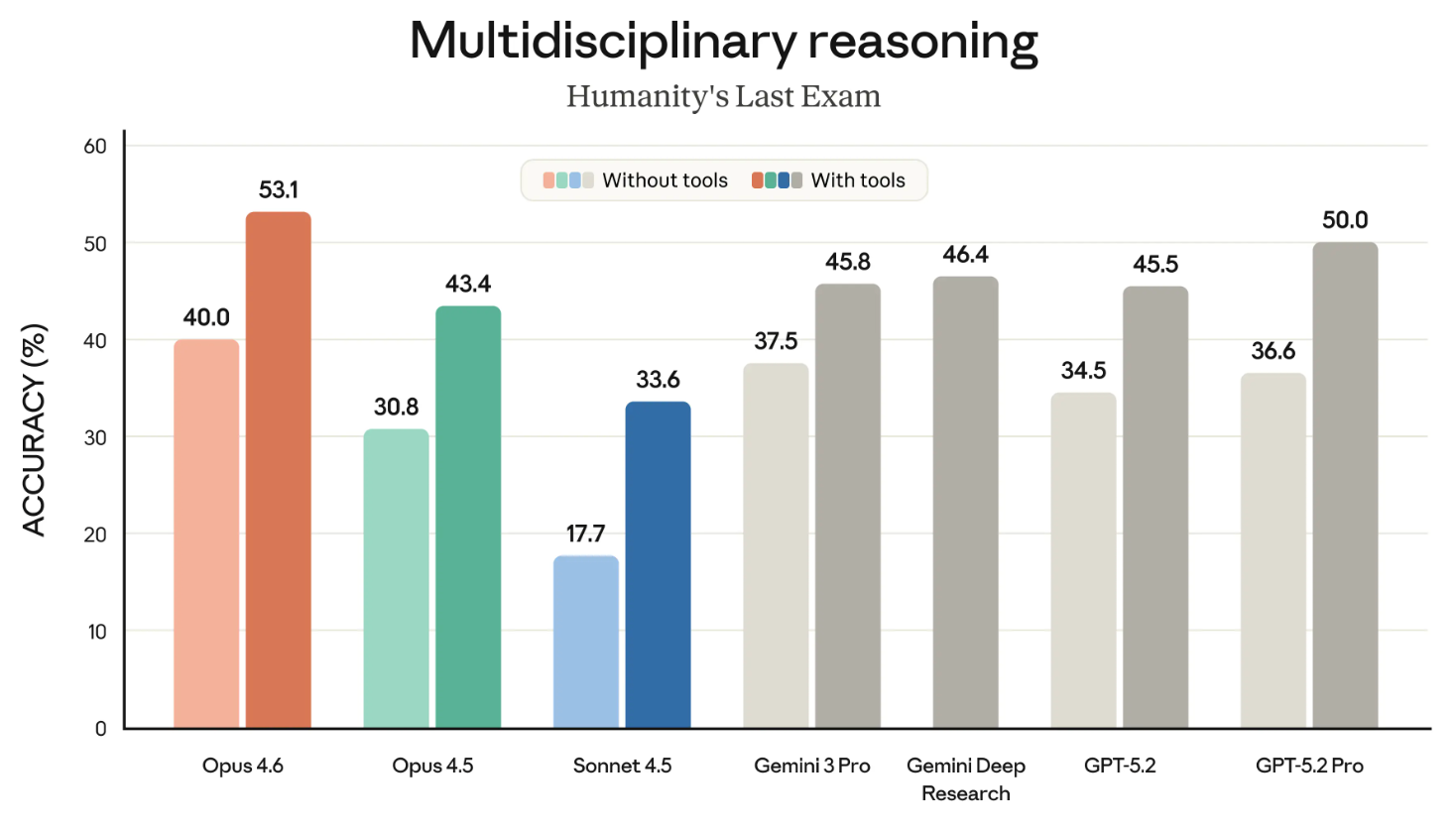

A última prova da humanidade

O Último Exame da Humanidade é um dos benchmarks mais conhecidos, e todos nós o acompanhamos de perto. Ele mede a capacidade de raciocínio geral de um modelo.

O gráfico a seguir mostra o sucesso dos diferentes modelos de fronteira no benchmark HLE, com e sem ferramentas. (“Com ferramentas” significa que o modelo podia usar recursos externos, como pesquisar na web e executar código.)

Esse gráfico ficaria melhor se fosse dividido em dois gráficos. Esse pequeno detalhe à parte, a conclusão é clara: O Opus 4.6 é o líder nas categorias “com ferramentas” e “sem ferramentas”.

GDPVal-AA

O GDPVal-AA (como o nome já diz) é um teste pra ver o que é considerado trabalho intelectual economicamente valioso. Pense em coisas como executar modelos financeiros ou fazer pesquisas.

O GDPVal-AA e outros benchmarks parecidos estão ficando cada vez mais importantes porque medem de verdade os tipos de trabalho pelos quais as empresas estão realmente pagando. O sucesso do Opus 4.6 no GDPVal-AA também é outro desafio direto para o conjunto de modelos GPT, porque a OpenAI e a Anthropic estão competindo por muitos dos mesmos clientes.

BrowseComp

O BrowseComp é o último benchmark que vale a pena mencionar do lançamento. Ele mede a capacidade de um modelo de encontrar informações difíceis de encontrar online. Um pouco de história: A OpenAI desenvolveu o BrowseComp para mostrar os recursos de pesquisa de seus próprios modelos.

Numa jogada certeira, neste comunicado, a Anthropic ligou diretamente ao anúncio da OpenAI, em abril de 2025, sobre o desenvolvimento do BrowseComp, ao destacar que o Opus 4.6 está no topo das tabelas nesse programa. Foi meio suspeito usar o próprio benchmark da OpenAI contra eles dessa forma.

Preços e disponibilidade do Claude 4.6

O Opus 4.6 está amplamente disponível no momento da publicação deste artigo. Mas, você não pode acessar o Opus 4.6 sem fazer upgrade para uma conta pro, que traz outras vantagens, como usar o Claude no Excel.

Se você é desenvolvedor, deve usar a API Claude ( claude-opus-4-6 ). O preço não mudou: Ainda é US$ 5/US$ 25 por milhão de tokens. Se você tá confuso com esses dois números, saiba que o primeiro é o que você paga pra mandar tokens pra modelo (ou seja, suas solicitações), e o segundo é o que você paga pelos tokens que ela gera de volta (as respostas).

Considerações finais

O Claude Opus 4.6 está no topo do ranking em benchmarks importantes como o GPDVal-AA, que mede o desempenho de um modelo em tarefas economicamente importantes, que é o que interessa aos clientes de grandes empresas. A OpenAI pode estar preocupada com essa novidade porque, poucas horas antes do lançamento do Opus 4.6, eles anunciaram OpenAI Frontier, que é uma nova plataforma empresarial para criar, implementar e gerenciar agentes de IA em produção.

Em outras palavras, em vez de competir em benchmarks de modelos, a Frontier mostra que a OpenAI está focada na infraestrutura em torno de seu conjunto de modelos, especificamente dando aos agentes de IA contexto de negócios compartilhado, permissões e a capacidade de receber e aprender com o feedback ao longo do tempo. Perder terreno nos benchmarks, a OpenAI está mostrando que sua plataforma está melhor posicionada para realmente tornar os agentes úteis em uma empresa.

Se isso é uma mudança estratégica ou uma admissão de que eles estão perdendo a corrida dos modelos, você decide.

No geral, a gente tá impressionado com o que a Anthropic tem pra oferecer com o Claude Opus 4.6 e tá ansioso pra colocar a mão na massa com as equipes de agentes. Se você quiser saber mais sobre a família Claude, não deixe de conferir o curso curso Introdução aos Modelos Claude.

Escritor e editor de conteúdo na área de edtech. Comprometido com a exploração de tendências de dados e entusiasmado com o aprendizado da ciência de dados.