Kurs

Seit ein paar Tagen gibt's Gerüchte über die nächste Veröffentlichung von Anthropic. Während viele Claude Sonnet 5 erwartet haben, kommt die erste Veröffentlichung des Jahres in Form von Claude Opus 4.6.

Mit einem Kontextfenster von 1 Million Token, adaptivem Denken, Konversationsverdichtung und einer Reihe von Spitzenwerten bei Benchmarks ist Claude Opus 4.6 eine Verbesserung gegenüber Opus 4.5. Wie Anthropic es nennt, haben sie ihr cleverstes Modell verbessert. Neben dem Modell hat Anthropic auch Agententeams in Claude Code und Claude in PowerPoint gestartet.

In diesem Artikel schauen wir uns alles an, was es Neues bei Claude Opus 4.6 gibt. Wir checken die neuen Funktionen, schauen uns die Benchmarks an und testen das Programm mit ein paar praktischen Beispielen.

Um mehr über einige der neuesten Funktionen von Claude zu erfahren, schau dir am besten unsere Anleitungen zu folgenden Themen an Claude Cowork und Claude Codesowie unser OpenClaw-Tutorial.

Was ist Claude Opus 4.6?

Claude Opus 4.6 ist das neueste große Sprachmodell von Anthropic. Anknüpfend an Opus 4.5ist das ein echtes Upgrade für die „smarteste” Modellreihe des Unternehmens.

Im Release-Blog sagt Anthropic, dass sie sich mehr auf agentenbasiertes Codieren, tiefes Denken und Selbstkorrektur konzentrieren. Das heißt, es geht weg von bloßem Handeln hin zu einemnachhaltigen Handeln.

Opus 4.6 ist so gemacht, dass man besser planen kann, es läuft über längere Zeiträume stabiler und findet Fehler in seiner eigenen Arbeit. Das heißt, Claude Opus 4.6 ist bei mehreren Benchmarks ganz vorne, zum Beispiel hat es die höchste Punktzahl bei der Terminal-Bench 2.0-Codierungsbewertung und schlägt alle anderen Modelle bei Humanity’s Last Exam.

Was mir besonders auffällt, ist das verbesserte Kontextfenster in Claude Opus 4.6. Mit 1 Million Tokens in der Beta-Version passt das neue Modell jetzt zu Gemini 3, was heißt, dass es mehr Infos verarbeiten kann, ohne den Kontext aus den Augen zu verlieren.

Was gibt's Neues bei Claude Opus 4.6?

Claude Opus 4.6 hat ein paar coole neue Features, von denen viele auf agentenbasierte Arbeitsabläufe ausgerichtet sind. Schauen wir uns mal ein paar wichtige Punkte an:

Agententeams

Agententeams sind eine Verbesserung gegenüber den „Unteragenten“, die wir in früheren Versionen von Claude gesehen haben. Mit Agententeams kannst du mehrere, komplett unabhängige Claude-Instanzen starten, die parallel laufen können. Eine Sitzung ist der „Leiter“, der alles koordiniert, während die „Teamkollegen“ die eigentliche Umsetzung übernehmen.

Was ich am interessantesten finde, ist, dass jedes Teammitglied sein eigenes Kontextfenster hat, was eine gründlichere Ausführung ermöglicht. Jeder Teamkollege kann auch direkt mit den anderen im Team quatschen.

Klar, diese Funktion hat auch einen möglichen Nachteil – die Kosten. Da jeder Agent sein eigenes Kontextfenster hat, kannst du deine Tokens schnell verbrauchen. Deshalb sagt Anthropic, dass du diese in Situationen mit höherer Komplexität nutzen solltest.

Gesprächsverdichtung

Eine coole Funktion von Claude Opus 4.6 ist die Kontextverdichtung. Dieses Upgrade für mehr Komfort hilft dir, Probleme zu vermeiden, wenn du lange Arbeitsabläufe durchführst, die die Kontextfenster voll ausnutzen. Normalerweise stößt man auf eine Kontexthürde, an der die Leistung nachlässt.

Mit der Konversationsverdichtung kann Claude Opus 4.6 automatisch erkennen, wann eine Konversation einen bestimmten Schwellenwert erreicht, und die vorhandene Konversation in einem übersichtlichen Block (einem Verdichtungsblock) zusammenfassen.

Diese Funktion soll dir helfen, das Wichtigste deiner Interaktionen zu behalten und gleichzeitig Platz zu schaffen, damit du weiterarbeiten kannst. Wenn du vorhast, aufgabenorientierte Agenten zu nutzen, die lange laufen müssen, könnte das mit einem viel besseren Speicher dafür sorgen, dass sie auf Kurs bleiben.

Anpassungsfähiges Denken und Bemühungen

Es gibt zwei Sachen bei Claude Opus 4.6, die entscheiden, ob es mehr nachdenken muss und wie sehr es sich dabei anstrengt.

Durch adaptives Denken kann das Modell erkennen, wie kompliziert deine Eingabe ist. Je nachdem, wie einfach oder kompliziert die Sache ist, wird entschieden, ob man weiter darüber nachdenkt. Anstatt eine manuelle Einstellung für die Anzahl der dafür verwendeten Tokes zu haben, passt Claude sein Budget je nach Komplexität jeder Anfrage an.

Mit dem Parameter „Effort“ kannst du einstellen, wie eifrig oder zurückhaltend Claude beim Ausgeben von Tokens ist. Im Grunde genommen heißt das, dass du die Effizienz der Token und die Gründlichkeit der Antworten gut ausbalancieren kannst.

Wenn du Claude Opus 4.6 in der API benutzt, kannst du diese Parameter manuell einstellen. Zum Beispiel:

- Maximale Anstrengung: Claude denkt immer weit und es gibt keine Grenzen, wie tief er dabei geht.

- Hoher Aufwand: Mit dieser Standardeinstellung denkt Claude immer nach und liefert fundierte Argumente.

- Mittlere Anstrengung: Das regt zum moderaten Denken an und kann dazu führen, dass man bei den einfachsten Fragen gar nicht mehr nachdenkt.

- Einfach zu bedienent: Claude denkt bei einfachen Aufgaben nicht groß nach und denkt lieber weniger, um schneller zu sein.

Claude in PowerPoint

Wir haben kürzlich über Claude in Excelbeschrieben und gezeigt, wie das Add-on dir bei verschiedenen Aufgaben in einem Seitenbereich deiner Excel-Tabelle helfen kann. Neben der Verbesserung der Funktionen dieses Tools hat Anthropic Claude in PowerPoint angekündigt.

Diese Integration behält deine Folienvorlagen, Schriftarten und Layouts bei. Du kannst ihm eine Unternehmensvorlage geben und sagen, dass er einen bestimmten Abschnitt erstellen soll, oder eine Folie auswählen und ihn bitten, dichten Text in ein natives, bearbeitbares Diagramm umzuwandeln.

Der Fokus liegt darauf, bearbeitbare PowerPoint-Objekte zu erstellen und nicht nur „Bilder von Folien“. Das macht es zu einem echten Produktivitätswerkzeug und nicht nur zu einem Konzeptgenerator.

Claude in PowerPoint ist gerade in der Forschungsvorschau für Max- und Enterprise-Nutzer.

Claude Opus 4.6 testen: Praktische Beispiele

Viele der Schlagzeilen zu Opus 4.6 drehen sich um schwierigere Programmieraufgaben und komplexeres Denken. Diese Fähigkeiten basieren alle auf einer bestimmten Grundlage: der Fähigkeit, mehrere Einschränkungen im Kopf zu behalten, über viele Schritte hinweg zu denken und Fehler zu erkennen.

Deshalb haben wir Opus 4.6 einer Reihe von mehrstufigen Aufgaben in den Bereichen Logik, Mathematik und Programmierung unterzogen. Wir wollten mal schauen, ob wir ein paar bekannte und häufige Schwächen von LLM aufdecken können – Sachen wie sich häufende Rechenfehler, räumliches Denken (immer ein Problem) und Fragen, die Einschränkungen beinhalten. Wir haben auch eine spezielle Debugging-Aufgabe eingebaut, weil Anthropic in seiner Ankündigung damit geprahlt hat, wie gut Opus 4.6 bei der Ursachenanalyse und anderen Debugging-Problemen ist.

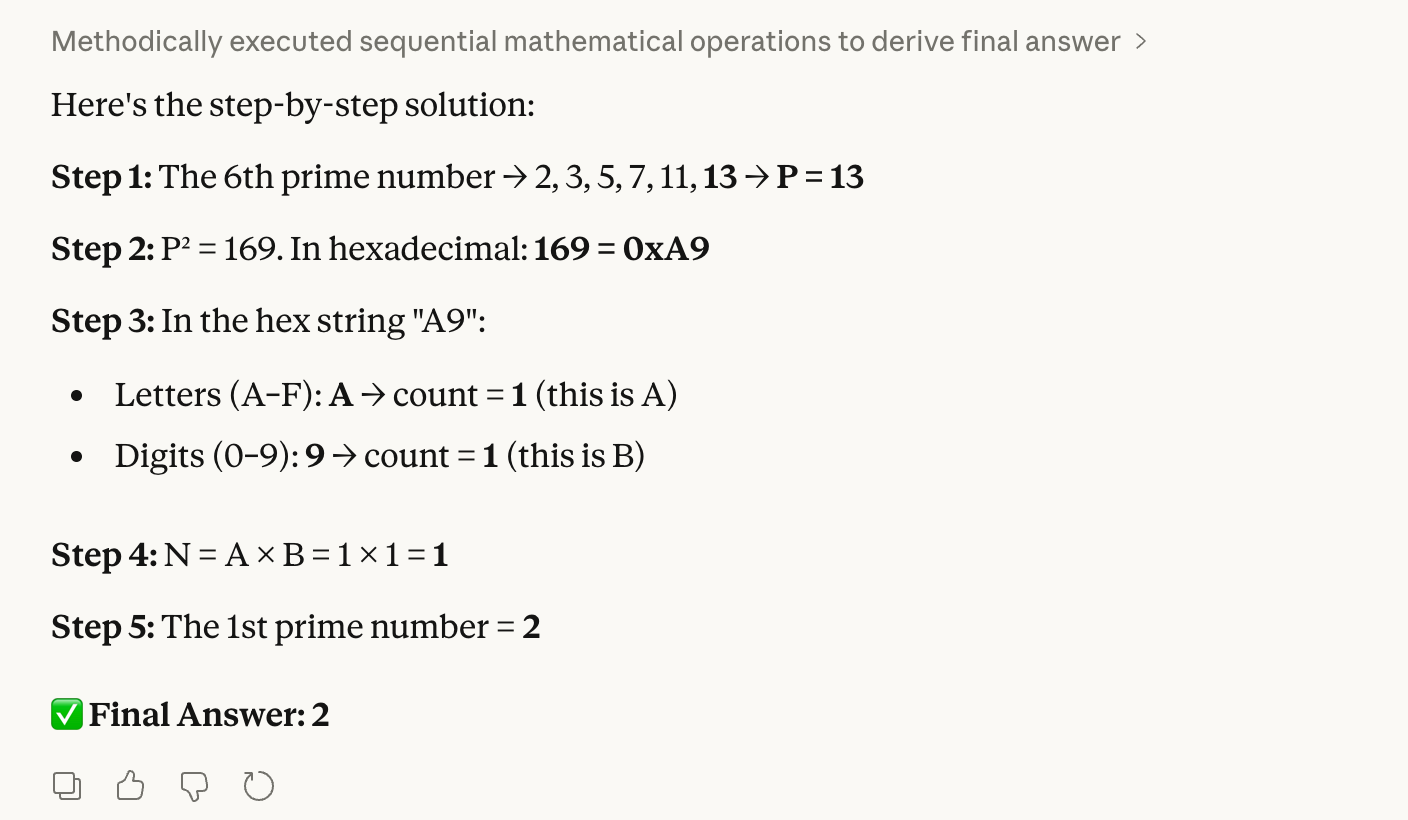

Test 1: Hexadezimal-Dezimal-Logik

Unser erster Test mischt Primzahlen, Hexadezimalzahlen und Zählen:

Step 1: Find the 6th prime number. Let this be P.

Step 2: Convert the square of P into hexadecimal.

Step 3: Count the letters (A–F) and digits (0–9) in that hex string. Let these be A and B.

Step 4: Multiply A × B. Let this be N.

Step 5: Find the Nth prime number.Das klingt ein bisschen kompliziert, aber dieser Test ist für uns Menschen ziemlich einfach zu überprüfen. Die richtige Antwort ist 2, weil die sechste Primzahl 13 ist; 13 zum Quadrat ist 169, was in Hexadezimal „A9“ ist. Das hat 1 Buchstabe × 1 Ziffer, was zusammen 1 ergibt, und die erste Primzahl ist 2.

Die Sorge ist, dass ein Modell bei der Hexadezimalumwandlung hängenbleiben könnte, was zu einem komplett falschen Endergebnis führen würde. Wie du sehen kannst, hatte Opus 4.6 keine Probleme:

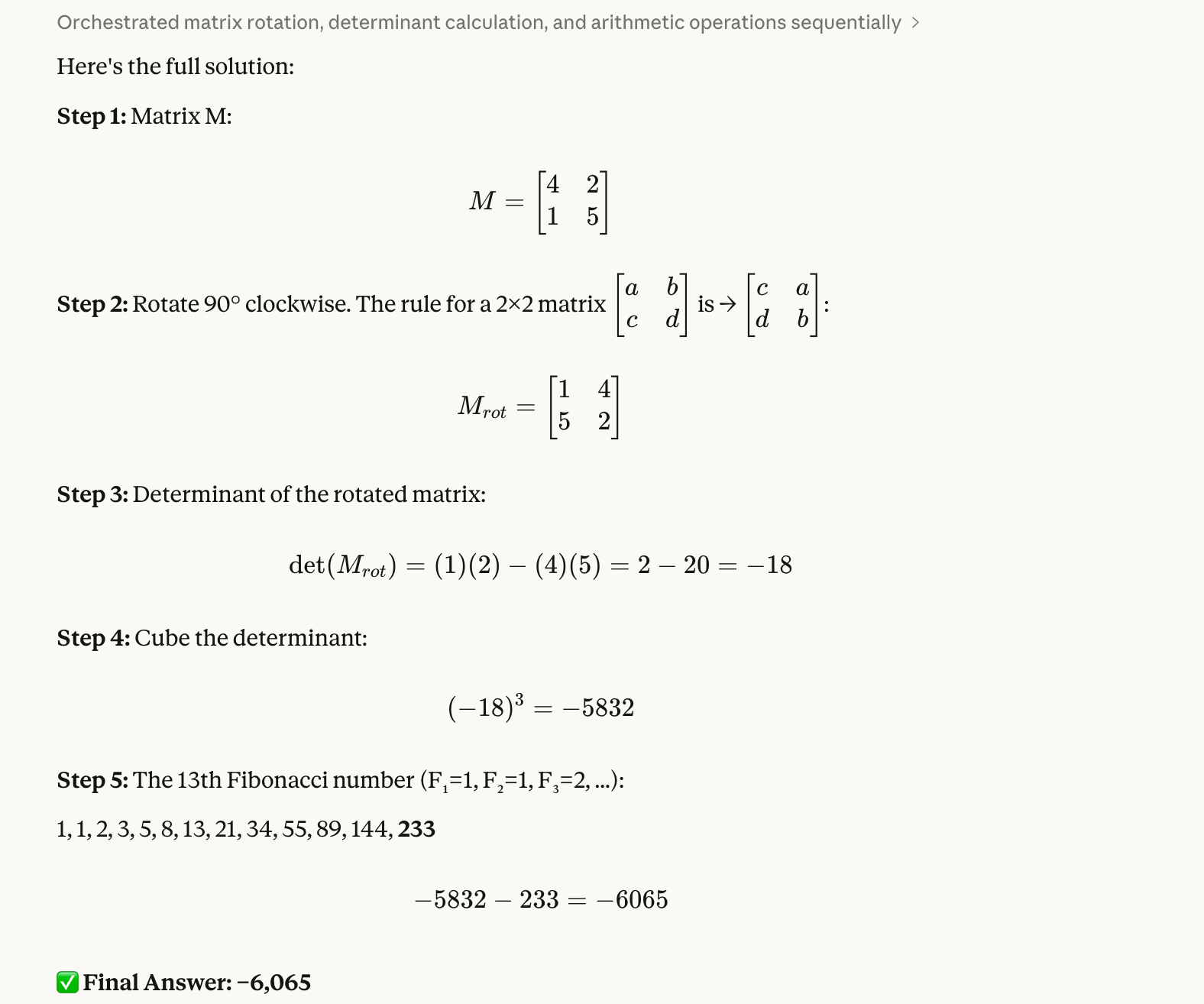

Test 2: Eine Matrix drehen

Unser zweiter Test checkt räumliches Denken und den Umgang mit negativen Zahlen:

Step 1: Create a 2×2 matrix M with top row [4, 2] and bottom row [1, 5].

Step 2: Rotate M 90 degrees clockwise.

Step 3: Calculate the determinant of the rotated matrix.

Step 4: Cube that determinant.

Step 5: Subtract the 13th Fibonacci number from the result.Das hier war für uns etwas aufwendiger zu überprüfen. Die richtige Antwort ist -6.065. Wir wissen das, weil die gedrehte Matrix [[1, 4], [5, 2]] ist. Dann können wir mit Python die Determinante berechnen, die -18 ist. Wenn wir diese Zahl kubieren, kriegen wir -5.832. Zum Schluss ziehen wir 233 ab und kriegen -6.065.

Die Idee mit diesem Test hat uns gefallen, weil wir aus Erfahrung wissen, dass Modelle oft Matrixelemente falsch austauschen oder unterwegs das Minuszeichen verlieren. Auch hier hatte Opus 4.6 keine Probleme:

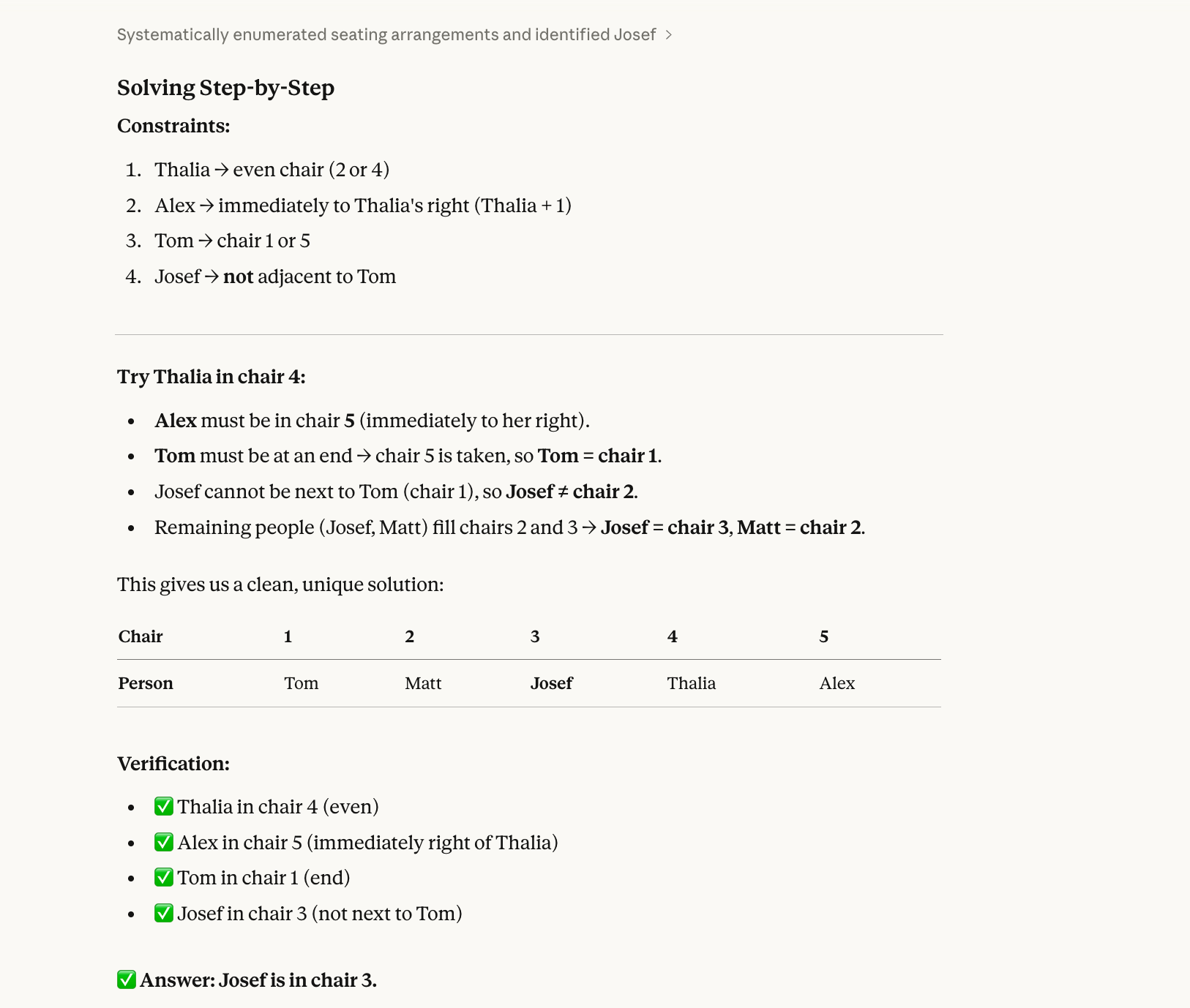

Test 3: Ein Quiz zur Sitzordnung

Für unseren dritten Test haben wir ein Constraint-Satisfaction-Problem ausprobiert, das Backtracking braucht:

Five people (Alex, Josef, Matt, Thalia, Tom) sit in chairs 1–5.

Thalia is in an even-numbered chair.Alex is immediately to Thalia’s right.Tom is at one end.Josef is not next to Tom.Who is in chair 3?Die richtige Antwort auf diese Frage ist Josef. (Alex-1, Matt-2, Josef-3, Thalia-4, Tom-5.) Du kannst das mit ein bisschen Mühe auf einem Blatt Papier ausrechnen.

Der Hauptgrund, warum ein Modell bei dieser Art von Frage daneben liegen könnte, ist, dass Modelle bisher immer sequenziell und nicht ganzheitlich gelöst haben. Sie lesen „Thalia sitzt auf einem geraden Stuhl“ und wählen einen Stuhl aus (z. B. Stuhl 2), ohne zu überprüfen, ob diese Wahl mit allen anderen Einschränkungen vereinbar ist. Dann machen sie mit, setzen sich auf mehr Stühle und geraten irgendwann in einen Konflikt, aber da haben sie sich schon in eine Sackgasse geschrieben und versuchen nicht mehr, stattdessen Thalia auf Stuhl 4 zu setzen.

Opus 4.6 hat das auch richtig gemacht:

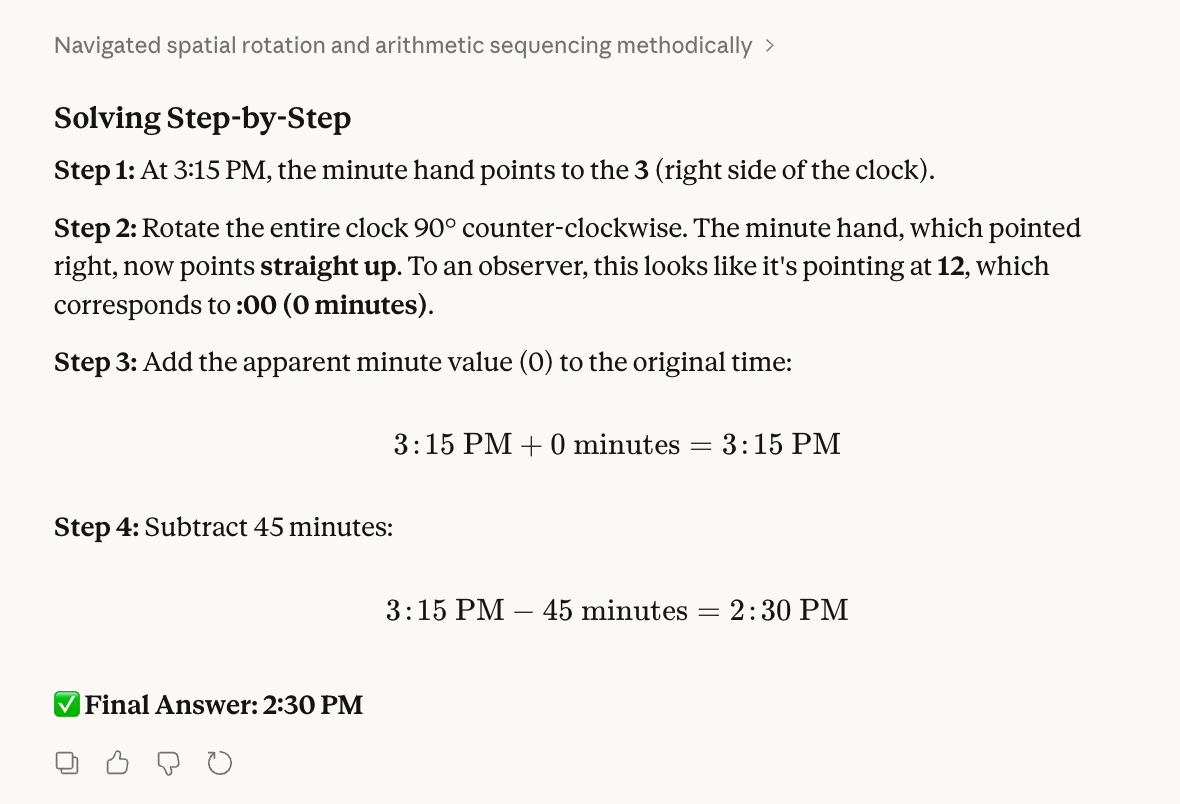

Test 4: Ein Uhrenrätsel

Unser vierter Test checkt räumliches Vorstellungsvermögen und physikalisches Verständnis:

Step 1: Imagine a clock currently showing 3:15 PM.

Step 2: Rotate the clock 90 degrees counter-clockwise (physically turning the whole clock face). After the rotation, what time does the minute hand appear to be pointing at?

Step 3: Take that new "apparent" minute value and add it to the original time (3:15 PM).

Step 4: Subtract 45 minutes from that result.

Step 5: What is the final time?Um das zu checken, hab ich die Uhr echt von meinem Handgelenk genommen und sie gedreht.

Die richtige Antwort ist 14:30 Uhr. Um 3:15 Uhr zeigt der Minutenzeiger auf die „3“. Als ich die 12 auf das Fenster links von mir richtete, ging die „3“ dahin, wo vorher die „12“ war. Dann hab ich 0 zu 3:15 hinzugefügt, 45 Minuten abgezogen und bin auf 14:30 Uhr gekommen.

Bei der Gestaltung des Tests dachten wir, dass die Modelle das Drehen des Zifferblatts mit dem Bewegen des Zeigers verwechseln könnten. Wir haben auch gehört, dass Models dazu neigen, das Hinzufügen von 0 als verdächtig zu betrachten und deshalb versuchen, eine andere Zahl durchzusetzen.

Opus 4.6 hat dieses Problem aber gelöst und auch die richtige Antwort gefunden:

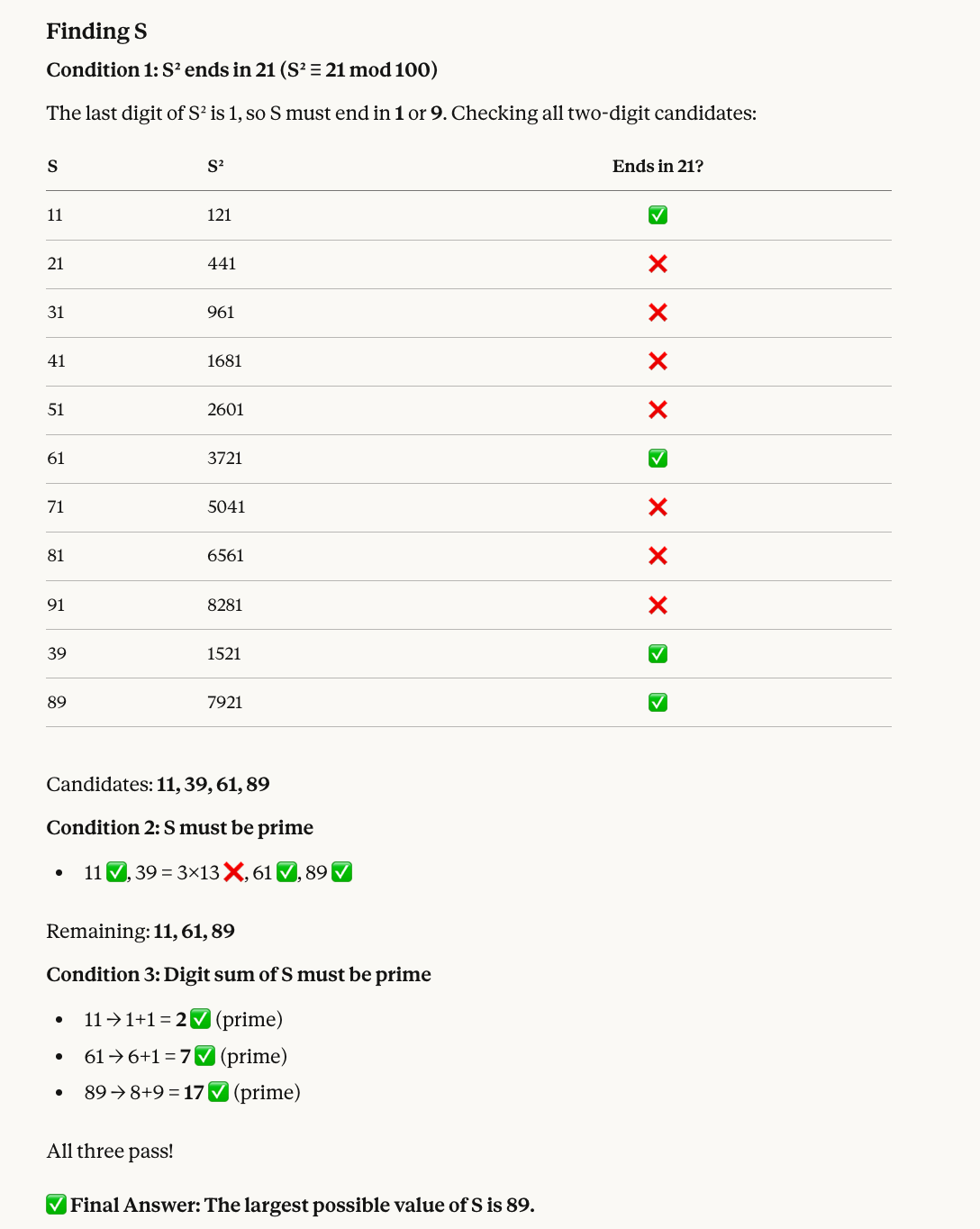

Test 5: Ein Rätsel aus der Zahlentheorie

Unser fünfter Test kombiniert modulare Arithmetik mit Primzahlfilterung:

Find a two-digit number S that satisfies all of the following:

* When S is squared, the last two digits of the result are 21.

* S must be a prime number.

* The sum of the digits of S must also be a prime number.

What is the largest possible value of S?Hier ist der Grund, warum die richtige Zahl 89 ist: Zahlen, deren Quadrate mit 21 enden, sind zum Beispiel 11, 39, 61 und 89. Davon ist 39 keine Primzahl, also bleiben uns 11, 61 und 89. Alle drei haben Primziffernsummen (2, 7 und 17), also ist die größte 89.

Opus 4.6 hat wieder die richtige Antwort gefunden, und diesmal gab's auch noch eine hilfreiche Grafik dazu:

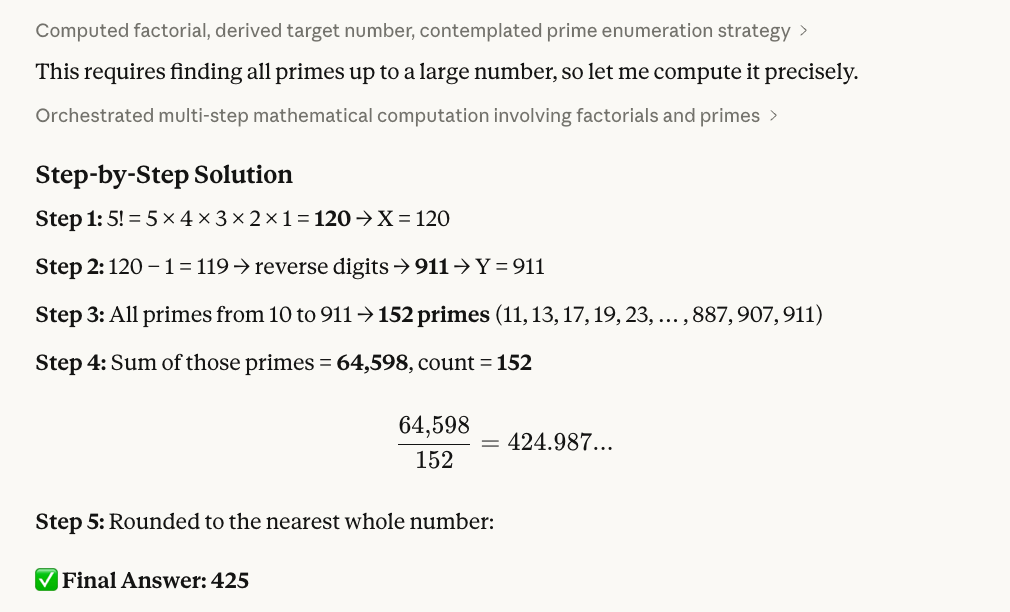

Test 6: Ziffern umkehren

Der nächste Test verbindet Faktorrechnung, Zeichenfolgenbearbeitung und Primzahlen miteinander:

Step 1: Calculate 5! (5 factorial). Let this result be X.

Step 2: Take X, subtract 1, and reverse the digits of the result. Let this new number be Y.

Step 3: Identify all prime numbers (p) such that 10 ≤ p ≤ Y.

Step 4: Calculate the sum of these primes and divide it by the total count of primes found in that range.

Step 5: Provide the final average, rounded to the nearest whole number.So haben wir überprüft, dass 425 die richtige Antwort ist: 5! = 120; zieh 1 ab, um 119 zu kriegen; dreh die Ziffern um, um 911 zu kriegen. Dann konnten wir mit etwas R-Code (siehe unten) sehen, dass es zwischen 10 und 911 152 Primzahlen gibt, deren Summe 64.598 ist. Zum Schluss teilen und runden wir wieder mit R: 64.598 ÷ 152 ≈ 425.

Hier ist das R-Skript, das wir benutzt haben:

# Step 1: Calculate 5!

X <- factorial(5)

cat("Step 1: X =", X, "\n")

# Step 2: Subtract 1 and reverse digits

result <- X - 1

Y <- as.numeric(paste0(rev(strsplit(as.character(result), "")[[1]]), collapse = ""))

cat("Step 2:", X, "- 1 =", result, "-> reversed ->", Y, "\n")

# Step 3: Find all primes between 10 and Y

is_prime <- function(n) {

if (n < 2) return(FALSE)

if (n == 2) return(TRUE)

if (n %% 2 == 0) return(FALSE)

for (i in 3:floor(sqrt(n))) {

if (n %% i == 0) return(FALSE)

}

return(TRUE)

}

primes <- Filter(is_prime, 10:Y)

cat("Step 3: Found", length(primes), "primes between 10 and", Y, "\n")

# Step 4: Sum and average

total <- sum(primes)

count <- length(primes)

avg <- total / count

cat("Step 4: Sum =", total, ", Count =", count, ", Average =", avg, "\n")

# Step 5: Round

cat("Step 5: Rounded =", round(avg), "\n")Test 7: Fehlerbehebung im Code

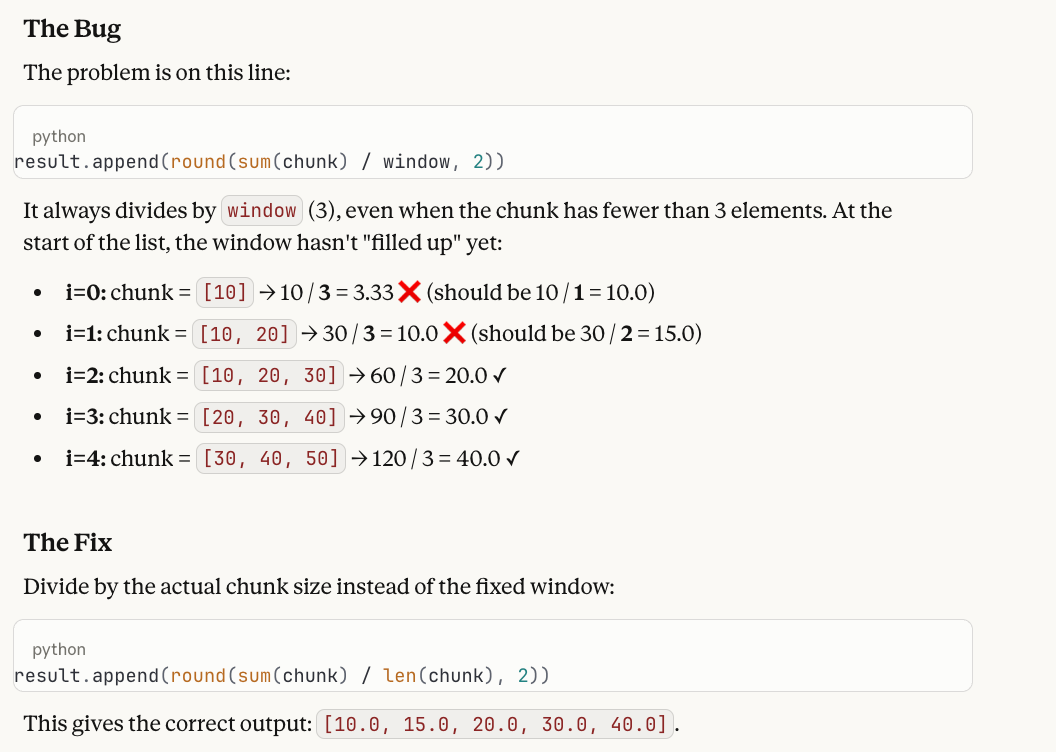

Unser nächster Test geht um eine der wichtigsten Aussagen von Opus 4.6: Fehler im Code finden. Wir wissen, dass Modelle den Code oft Zeile für Zeile richtig verfolgen, aber nicht den Fehler finden können.

A developer wrote this Python function to compute a running average:

def running_average(data, window=3):

result = []

for i in range(len(data)):

start = max(0, i - window + 1)

chunk = data[start:i + 1]

result.append(round(sum(chunk) / window, 2))

return result

When called with running_average([10, 20, 30, 40, 50]), the first two values in the output seem wrong. Why? Please help me fix what is wrong!Hier ist die Antwort und warum es als Test funktioniert: Die Funktion teilt immer durch „ window (3) “, auch wenn der Chunk am Anfang der Liste weniger als drei Elemente hat. Die fehlerhafte Ausgabe lautet „ [3.33, 10.0, 20.0, 30.0, 40.0] “, aber die ersten beiden Werte sollten eigentlich „ 10.0 “ und „ 15.0 “ sein, weil diese Blöcke nur 1 bzw. 2 Elemente haben. Die Lösung ist, / window in / len(chunk) zu ändern.

Wir mögen diesen Test, weil Modelle oft die Schleife perfekt durchlaufen, aber dann melden, dass „die Ausgabe korrekt aussieht“ – sie sehen die Berechnungen Schritt für Schritt und merken nicht, dass die Division eines einzelnen Elements durch 3 falsch ist. Das Modell muss neben der Ausführung (was der Code tatsächlich macht) auchdie Absicht ( ) berücksichtigen (was ein gleitender Durchschnitt machen soll) und die Lücke zwischen beiden erkennen.

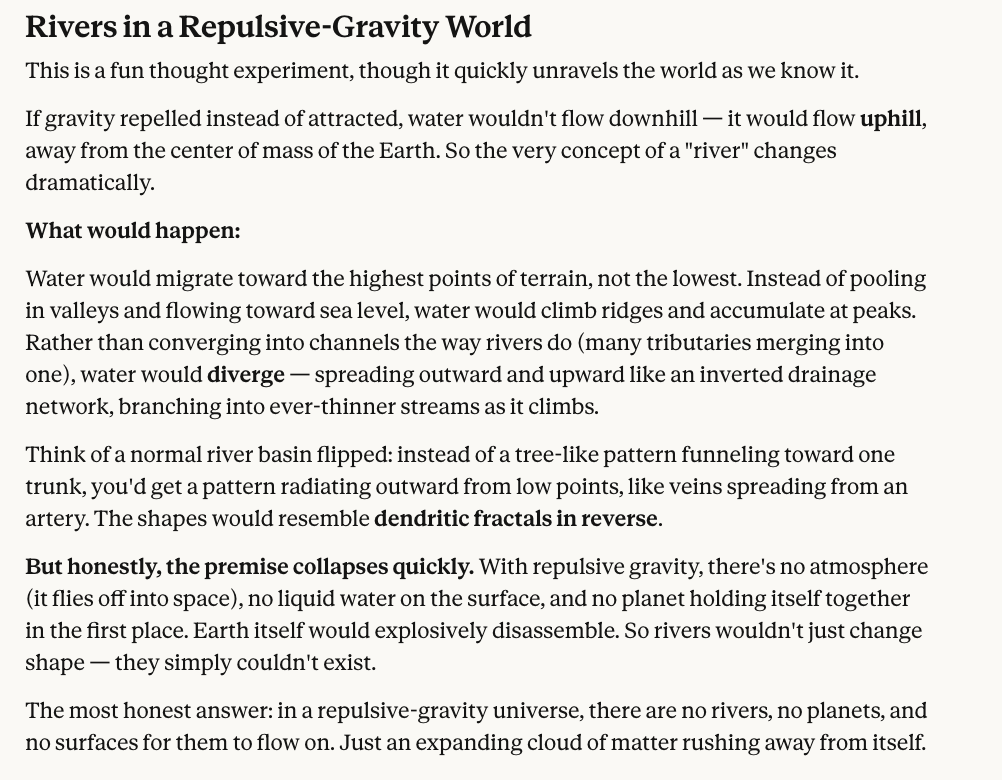

Test 8: Ein Gedankenexperiment aus der Physik

Unser letzter Test hat nichts mit Mathe zu tun, sondern nur mit kontrafaktischem Denken.

In a world where gravity repels objects instead of attracting them, what shape would rivers take?Klar, es gibt hier keine einzige richtige Antwort, und es ist schwer, sich das vorzustellen. Aber wir wollen, dass das Modell wenigstens die Auswirkungen durchdenkt, und wir finden, dass die Antwort von Claude Opus 4.6 ziemlich vernünftig klingt.

Alles in allem, kurz gesagt, hat Opus 4.6 die volle Punktzahl bekommen, obwohl wir, wie du gesehen hast, eine Frage mit einer etwas subjektiven Antwort dabei hatten, sodass du das letzte Wort hast.

Claude Opus 4.6 Benchmarks

Opus 4.6 ist in mindestens vier wichtigen Benchmarks ganz klar die Nummer eins:

- Terminal-Bench 2.0

- Die letzte Prüfung der Menschheit

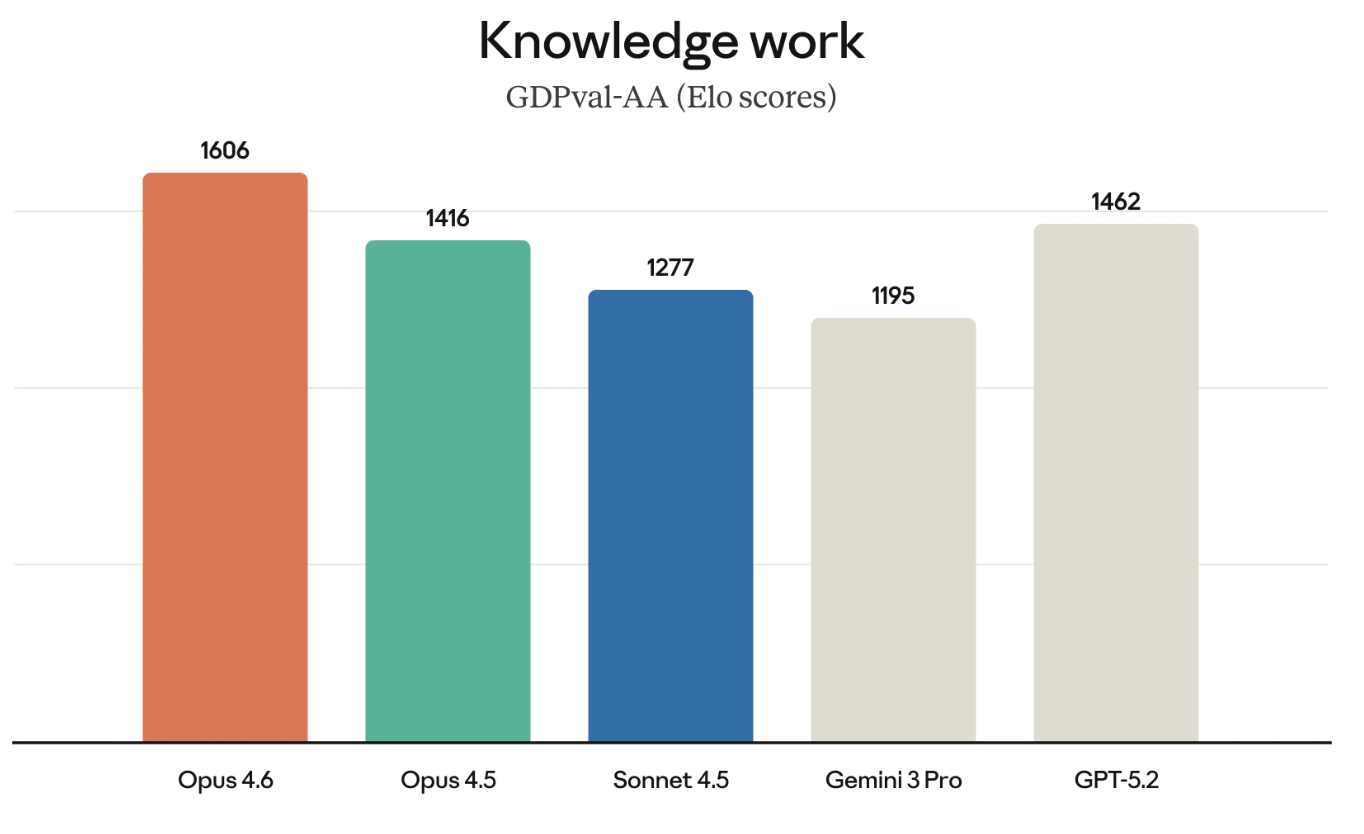

- GDPval-AA

- BrowseComp

Terminal-Bench 2.0 ist ein Benchmark für agentenbasiertes Codieren; Humanity’s Last Exam ist ein Test für komplexes Denken; GDPval-AA checkt, wie gut man mit Wissen umgehen kann; BrowseComp schaut, wie gut ein Modell schwer zu findende Infos im Internet finden kann.

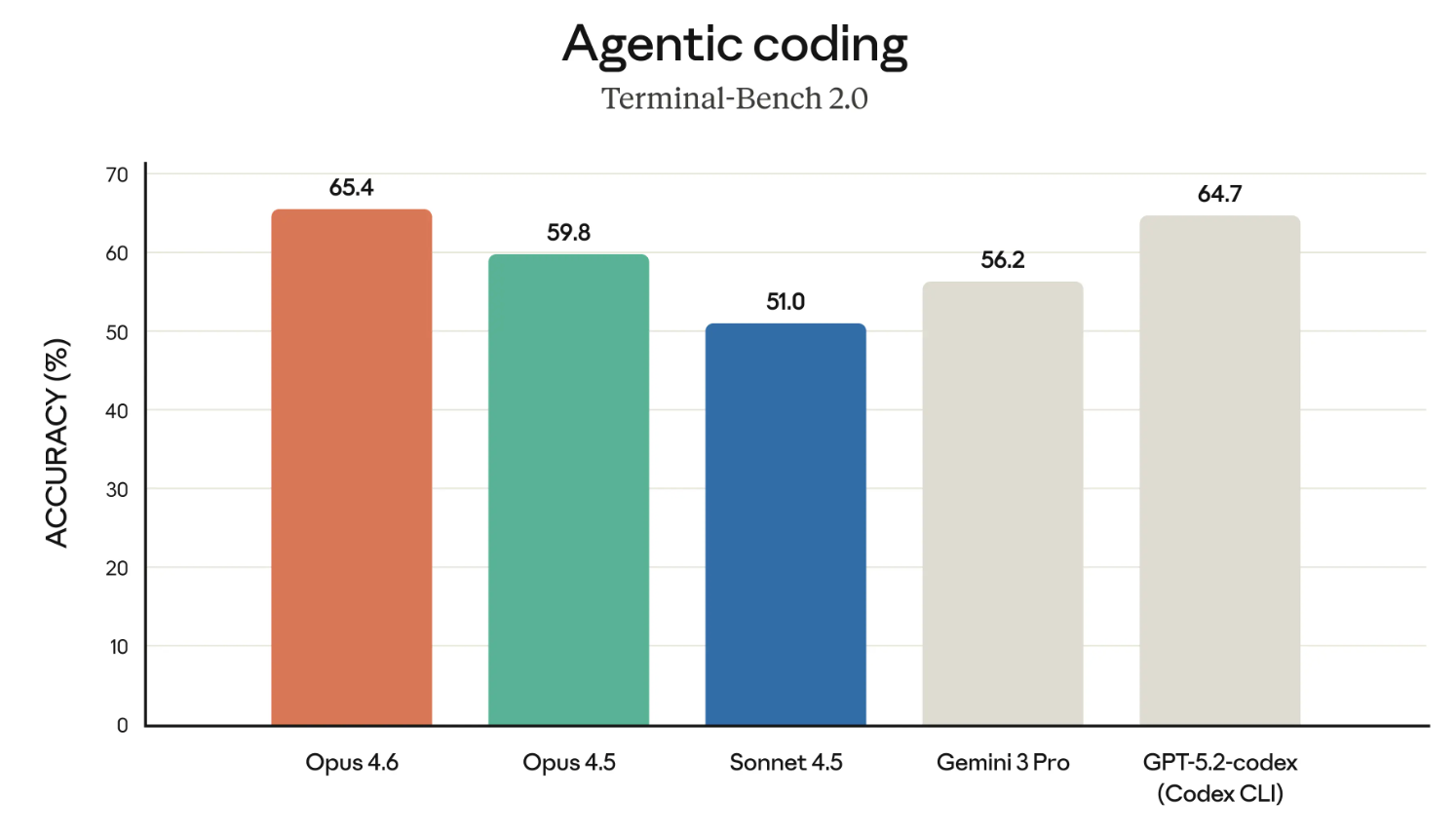

Terminal-Bench 2.0

Die Claude-Modelle haben den Ruf, echt gut im Codieren zu sein. Schauen wir uns also erst mal die Ergebnisse des Terminal-Bench 2.0-Benchmarks an.

Wenn die Grafik oben Opus 4.6 im Vergleich zu GPT-5.2-Codex hervorhebt – ja, das ist sicher so gewollt. Anthropic hat OpenAI in letzter Zeit in mehreren Bereichen direkt herausgefordert und wirbt für den Einsatz in Unternehmen.

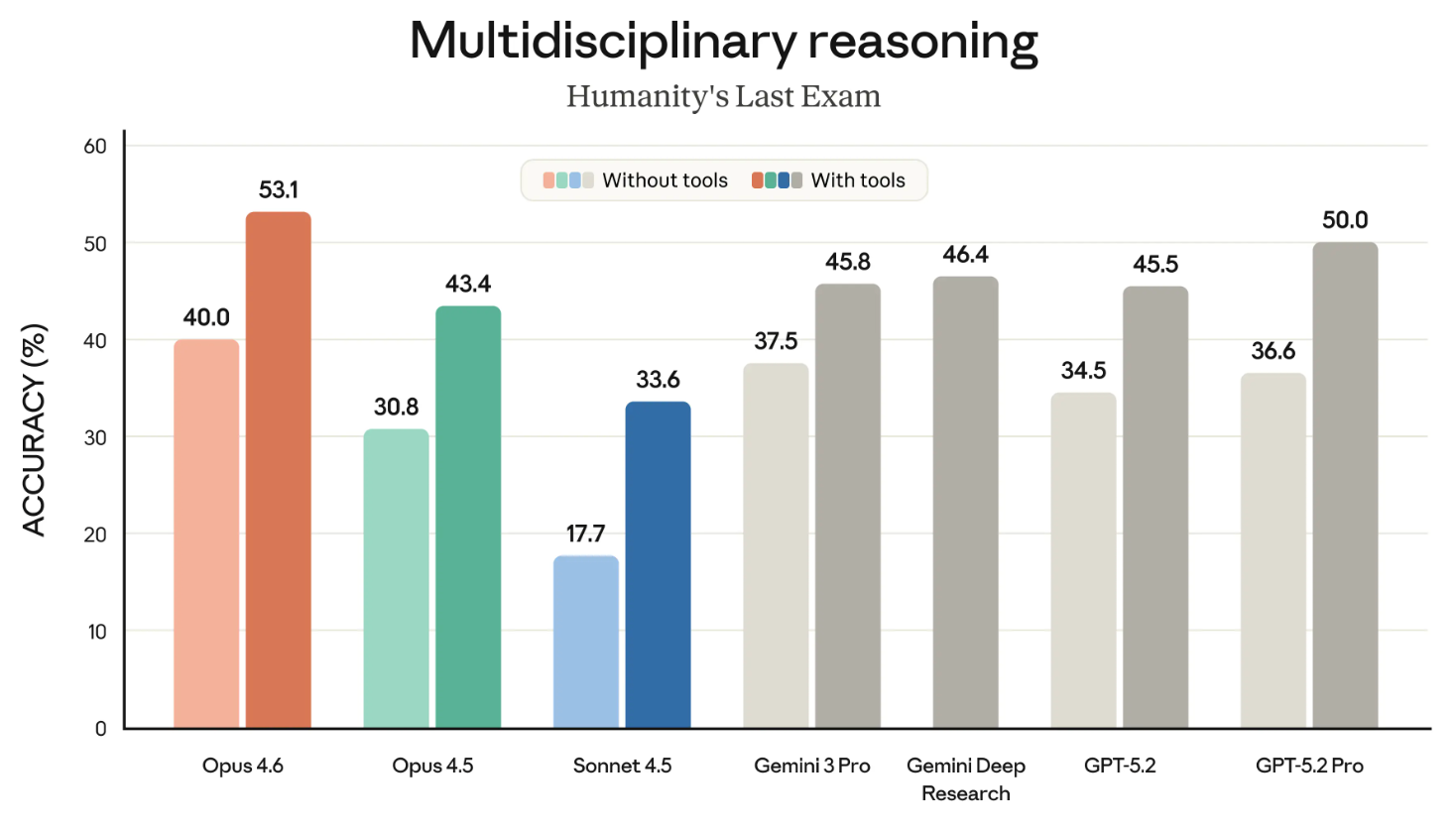

Die letzte Prüfung der Menschheit

Die letzte Prüfung der Menschheit ist einer der bekanntesten Benchmarks, den wir alle genau beobachten. Es misst, wie gut ein Modell generell denken kann.

Die folgende Grafik zeigt, wie gut die verschiedenen Frontier-Modelle beim HLE-Benchmark mit und ohne Tools abschneiden. („Mit Tools” heißt, dass das Modell externe Funktionen wie das Durchsuchen des Internets und das Ausführen von Code nutzen durfte.)

Diese Grafik wäre vielleicht besser als zwei separate Grafiken. Abgesehen von diesem kleinen Punkt ist die Schlussfolgerung klar: Opus 4.6 ist der Marktführer sowohl in der Kategorie „mit Tools” als auch in der Kategorie „ohne Tools”.

GDPVal-AA

GDPVal-AA ist (wie der Name schon sagt) ein Test, der prüft, was als wirtschaftlich wertvolle Wissensarbeit gilt. Denk mal an Sachen wie Finanzmodelle durchspielen oder recherchieren.

GDPVal-AA und andere ähnliche Benchmarks werden immer wichtiger, weil sie wirklich die Arten von Arbeit messen, für die Unternehmen tatsächlich bezahlen. Der Erfolg von Opus 4.6 bei GDPVal-AA ist auch eine direkte Herausforderung für die GPT-Modellreihe, weil OpenAI und Anthropic um viele der gleichen Kunden konkurrieren.

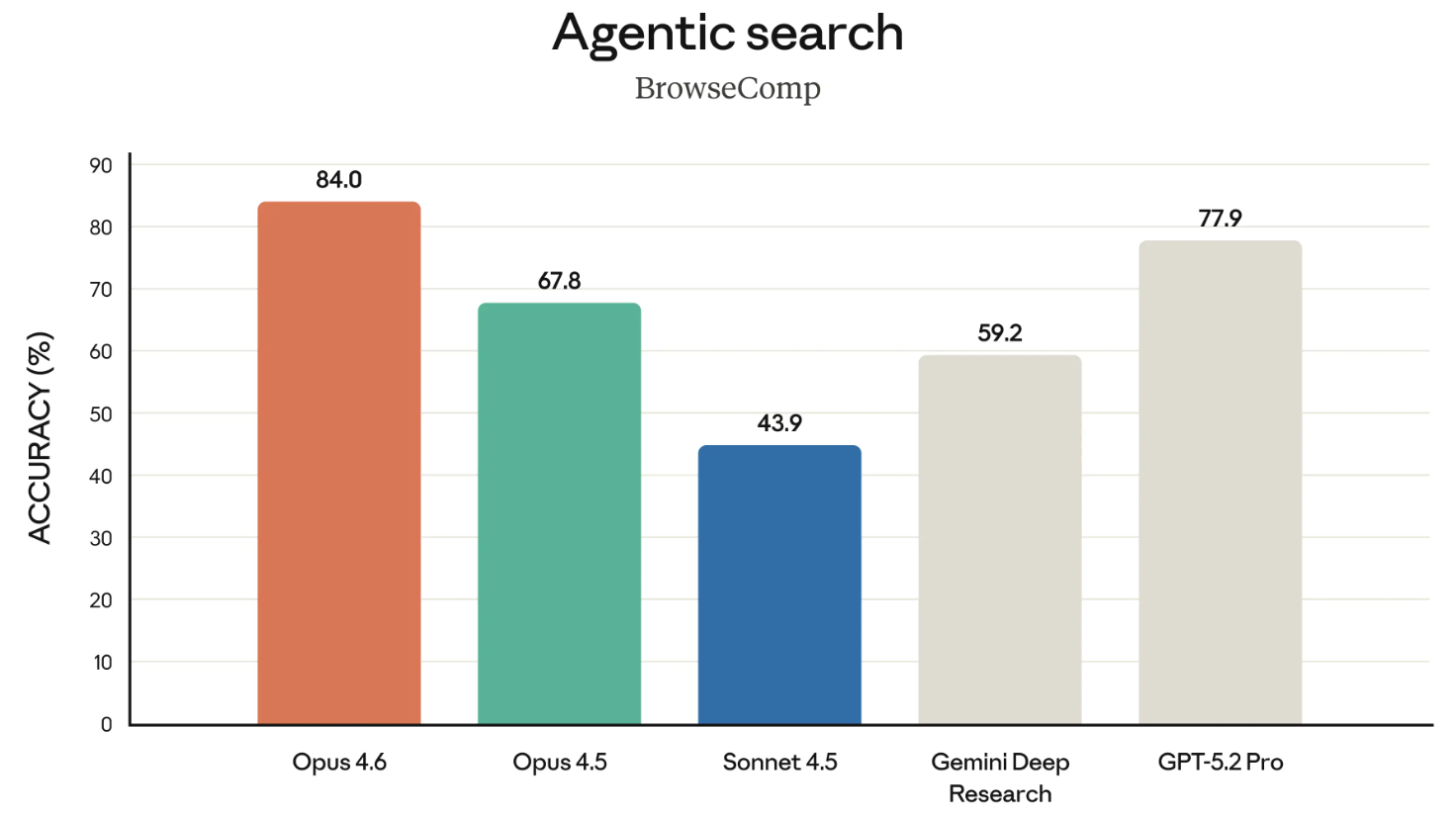

BrowseComp

BrowseComp ist der letzte erwähnenswerte Benchmark aus dieser Version. Es misst, wie gut ein Modell schwer auffindbare Infos im Internet finden kann. Ein bisschen Geschichte: OpenAI hat BrowseComp eigentlich entwickelt, um die Suchfunktionen ihrer eigenen Modelle zu zeigen.

In einer gezielten Aktion hat Anthropic in dieser Pressemitteilung direkt auf die Ankündigung von OpenAI vom April 2025 zur Entwicklung von BrowseComp verwiesen und dabei betont, dass Opus 4.6 dort ganz oben steht. Es war ein bisschen fragwürdig, OpenAI einfach so auf ihren eigenen Maßstab hinzuweisen.

Claude 4.6 Preise und Verfügbarkeit

Opus 4.6 ist zum Zeitpunkt dieses Artikels weit verbreitet. Allerdings kannst du Opus 4.6 nur nutzen, wenn du ein Pro-Konto hast. Das hat noch andere Vorteile, wie zum Beispiel, dass du Claude in Excel verwenden kannst.

Wenn du Entwickler bist, solltest du die Funktion „ claude-opus-4-6 “ in der Claude-API nutzen. Die Preise sind gleich geblieben: Es sind immer noch 5 $/25 $ pro Million Token. Wenn du dir über die beiden Zahlen nicht im Klaren bist: Die erste Zahl ist das, was du bezahlst, um Token an das Modell zu senden (also deine Eingaben), und die zweite Zahl ist das, was du für die Token bezahlst, die es zurückgibt (die Antworten).

Abschließende Gedanken

Claude Opus 4.6 führt die Rangliste bei wichtigen Benchmarks wie GPDVal-AA an, die messen, wie gut ein Modell bei wirtschaftlich wichtigen Aufgaben abschneidet, was für große Unternehmenskunden wichtig ist. OpenAI könnte von dieser Entwicklung nervös werden, weil sie nur ein paar Stunden vor der Veröffentlichung von Opus 4.6 angekündigt haben, dass OpenAI Frontierangekündigt, eine neue Unternehmensplattform zum Erstellen, Bereitstellen und Verwalten von KI-Agenten in der Produktion.

Mit anderen Worten: Anstatt sich auf Modell-Benchmarks zu konzentrieren, zeigt uns Frontier, dass OpenAI sich auf die Infrastruktur rund um seine Modellsuite konzentriert, insbesondere indem es KI-Agenten einen gemeinsamen Geschäftskontext, Berechtigungen und die Möglichkeit gibt, im Laufe der Zeit Feedback zu bekommen und daraus zu lernen. OpenAI verliert bei den Benchmarks an Boden und meint, dass seine Plattform besser drauf ist, um Agenten in einem Unternehmen wirklich nützlich zu machen.

Ob das ein strategischer Kurswechsel ist oder ein stillschweigendes Eingeständnis, dass sie den Wettlauf um das beste Modell verlieren, musst du selbst entscheiden.

Insgesamt sind wir aber echt beeindruckt von dem, was Anthropic mit Claude Opus 4.6 zu bieten hat, und freuen uns schon darauf, die Agententeams auszuprobieren. Wenn du mehr über die Familie Claude erfahren möchtest, schau dir unbedingt den Kurs Kurs „Einführung in die Claude-Modelle“an.

Autorin und Redakteurin im Bereich der Bildungstechnologie. Engagiert bei der Erforschung von Datentrends und begeistert davon, Data Science zu lernen.