programa

Recientemente he terminado un contrato con una empresa de inteligencia artificial. Entre otras cosas, ayudan a los investigadores a entrenar posteriormente los LLM. Como doctor en matemáticas, creé problemas matemáticos que dejaron perplejos a los modelos de IA más avanzados. Las indicaciones engañosas no contaban; las indicaciones tenían que poner de manifiesto errores de razonamiento.

Durante ese trabajo, escuché repetidas referencias al «último examen de la humanidad». Aprendí que se trataba de un punto de referencia de IA diseñado para evaluar el razonamiento en muchos campos académicos. Mi curiosidad me llevó a profundizar en lo que es HLE y lo que nos dice sobre los límites actuales del razonamiento de la IA.

Si eres nuevo en el campo de la IA y el benchmarking, te recomiendo que realices el programa de formación «Fundamentos de la IA».

¿Qué es «el último examen de la humanidad»?

A medida que los LLM han avanzado, los investigadores se basan en colecciones de preguntas de evaluación, conocidas como puntos de referencia, para comparar el rendimiento y realizar un programa del progreso. El último examen de la humanidad (HLE) es un punto de referencia diseñado para medir las capacidades e esde razonamiento de un LLM , no solo su capacidad para reconocer patrones. Su objetivo es evaluar la capacidad de un modelo para resolver problemas de nivel experto en numerosos ámbitos académicos.

¿Por qué necesitamos un «último examen»?

Con tantos puntos de referencia ya existentes, ¿por qué otro más? Los puntos de referencia que antes suponían un reto para los LLM, como el MMLU, ahora están saturados, y los modelos suelen obtener puntuaciones superiores al 90 %. En este punto, estos puntos de referencia dejan de medir diferencias significativas entre los modelos.

HLE es un punto de referencia de última generación que aumenta el nivel de dificultad al reunir preguntas elaboradas por expertos que requieren un razonamiento de varios pasos, y no solo recordar patrones superficiales.

¿Cómo se desarrolló HLE?

A finales de 2024, el Centro para la Seguridad de la IA, una organización sin ánimo de lucro dedicada a la seguridad de la IA, se asoció con Scale AI, una empresa de datos, para desarrollar un punto de referencia de IA más difícil. Dan Hendrycks dirigió el proyecto.

El equipo recopiló preguntas de nivel universitario de múltiples disciplinas académicas y ofreció importantes premios: los 50 contribuyentes principales ganaron 5000 dólares cada uno, y los 500 siguientes obtuvieron 500 dólares.

El resultado fue un amplio conjunto de preguntas de nivel experto sobre muchas materias, como matemáticas, informática, literatura, análisis musical e historia.

¿Qué incluye el último examen de la humanidad?

El documento HLE describe el punto de referencia como «... el punto de referencia definitivo y cerrado para las habilidades académicas generales». Sus preguntas requieren un razonamiento en varios pasos, lo que impide que los modelos adivinen o memoricen las respuestas.

HLE consta de 2500 preguntas públicas y unas 500 preguntas adicionales en un conjunto privado reservado.

Cada pregunta debe ser original, tener una única respuesta correcta y no poder resolverse mediante una simple búsqueda en Internet o en una base de datos. Alrededor del 76 % de las preguntas utilizan el formato de respuesta de coincidencia exacta y el 24 % restante utiliza preguntas de opción múltiple. Aproximadamente el 14 % de las preguntas son multimodales, es decir, incluyen tanto texto como imágenes.

El equipo de HLE sometió las preguntas a un riguroso proceso de selección.

- Para ser aceptadas, las preguntas tenían que dejar perplejo a un LLM pionero. Alrededor de setenta mil preguntas cumplían este criterio.

- Unos expertos revisores refinan y filtran el total hasta reducirlo a trece mil preguntas.

- Los organizadores y los revisores expertos aprobaron manualmente seis mil de estas preguntas.

- Los investigadores dividieron este conjunto de preguntas en un conjunto público de 2500 preguntas y un conjunto de reserva de aproximadamente 500 preguntas.

Críticas al último examen de la humanidad

Los primeros resultados mostraron que los modelos pioneros obtuvieron inicialmente puntuaciones bajas en las preguntas, pero expresaron un alto nivel de confianza. Esta diferencia indica alucinaciones.

Grupos independientes también expresaron su preocupación. Future House, un laboratorio de investigación sin ánimo de lucro, publicó un blog titulado «Aproximadamente el 30 % de las respuestas del último examen de química/biología de la humanidad son probablemente incorrectas».

Tu análisis se centró en el protocolo de revisión. Los autores de las preguntas afirmaban que las respuestas eran correctas, pero a los revisores se les indicó que solo dedicaran cinco minutos a revisar la corrección de las respuestas. Sostienen que este proceso permite que se cuelen respuestas excesivamente complejas, artificiosas o ambiguas que a menudo entran en conflicto con la literatura científica.

Los responsables del mantenimiento de HLE respondieron a la publicación encargando una revisión por parte de tres expertos del subconjunto en disputa. A partir del 16 de septiembre de 2025, tenían previsto anunciar un proceso de revisión continua a HLE.

El panorama de los benchmarks de IA

HLE se inscribe en un ecosistema más amplio de pruebas comparativas que evalúan diferentes aspectos de la capacidad de los LLM.

Conocimiento y razonamiento

Estos puntos de referencia evalúan los conocimientos académicos y el razonamiento.

- Comprensión masiva multitarea del lenguaje (MMLU). MMLU prueba el rendimiento sin entrenamiento previo en cincuenta y siete temas diferentes.

- MMLU-Pro/MMLU Pro+. Mayor complejidad de las preguntas y énfasis en el razonamiento de orden superior.

- Preguntas y respuestas a prueba de Google (GPQA) Una prueba de referencia STEM de nivel de posgrado a prueba de Google con 448 preguntas de opción múltiple.

- El último examen de la humanidad (HLE). HLE utiliza problemas seleccionados por expertos que hacen hincapié en el razonamiento más que en la memorización.

Comprensión multimodal

Estos parámetros de referencia miden el razonamiento que implica tanto texto como imágenes.

- El Comprensión y razonamiento multimodal multidisciplinar masivo (MMMU). Alrededor de 1500 preguntas multimodales y multidisciplinarias extraídas de exámenes, cuestionarios y libros de texto.

- La MMMU-Pro elimina las preguntas que pueden resolverse con modelos basados únicamente en texto, añade opciones de respuesta más sólidas e introduce una configuración basada únicamente en la visión, en la que toda la indicación está integrada en una imagen.

Ingeniería de software y uso de herramientas

Otros puntos de referencia se centran específicamente en la ingeniería de software y el uso de herramientas.

- SWE-bench. Creado a partir de incidencias reales de GitHub procedentes de doce repositorios de Python. El modelo lee el código base, interpreta una descripción del problema y propone un parche.

- SWE-bench Verificado. Versión mejorada de SWE-bench que corrige pruebas demasiado específicas, aclara descripciones de problemas imprecisas y estabiliza la configuración del entorno.

- SWE-bench-Live. Una versión escalable y continuamente actualizada con 1319 tareas en 93 repositorios.

Marcos de evaluación holísticos y multimétricos

El Centro de Investigación sobre Modelos Fundamentales (CRFM) de Stanford desarrolló Evaluación Holística de Modelos Lingüísticos (HELM) para apoyar la evaluación responsable de la IA.

HELM evalúa los modelos en una serie de escenarios estandarizados, como la respuesta a preguntas, la síntesis, las consultas críticas para la seguridad y el contenido social/ético. Estos escenarios se puntúan en múltiples dimensiones, no solo en cuanto a precisión, sino también en cuanto a calibración, solidez y toxicidad.

HELM se ha convertido en una familia de marcos relacionados.

- Capacidades de HEML. Una tabla de clasificación de uso general para evaluar los modelos de lenguaje.

- Audio. Evaluaciones para tareas relacionadas con el audio y el habla.

- HELM Lite. Un subconjunto más pequeño y rápido para realizar comparaciones rápidas.

- HELM Finanzas. HELM adaptado a las tareas financieras.

- MedHELM. Evaluaciones relacionadas con el razonamiento y la seguridad en el ámbito sanitario.

Evaluaciones de seguridad y peligrosidad

Los marcos de seguridad miden el riesgo en lugar de la competencia intelectual.

- Evaluación de modelos e investigación de amenazas (METR) es una organización de investigación sin ánimo de lucro que evalúa capacidades potencialmente peligrosas, como ciberataques, intentos de evitar el cierre o la capacidad de automatizar la I+D en IA. Tu misión es detectar riesgos catastróficos de forma temprana.

- Marco de seguridad Frontier de Google DeepMind. Define los niveles críticos de capacidad (CCL), supervisa si los modelos de vanguardia se acercan a ellos y, en caso afirmativo, implementa planes de mitigación.

¿Qué puntuación obtienen los modelos actuales de IA en los benchmarks de IA?

Muchas tablas de clasificación públicas realizan un seguimiento del rendimiento de los LLM a través de diversas métricas.

- Tablas de clasificación de LLM a escala. Incluye tablas de clasificación para el comportamiento agente, la seguridad y el rendimiento pionero en puntos de referencia estandarizados.

- Estadísticas de LLM. Abarca la generación de imágenes, la generación de vídeos, la conversión de texto a voz, la conversión de voz a texto y las incrustaciones.

- Vellum LLM Leaderboard. Se centra en el razonamiento y la codificación.

- Artificial Análisis.IA Clasificación LM. Clasifica los modelos según su inteligencia, precio, velocidad y latencia.

- Clasificación de Hugging Face Open LLM. Incluye resultados detallados para varios modelos.

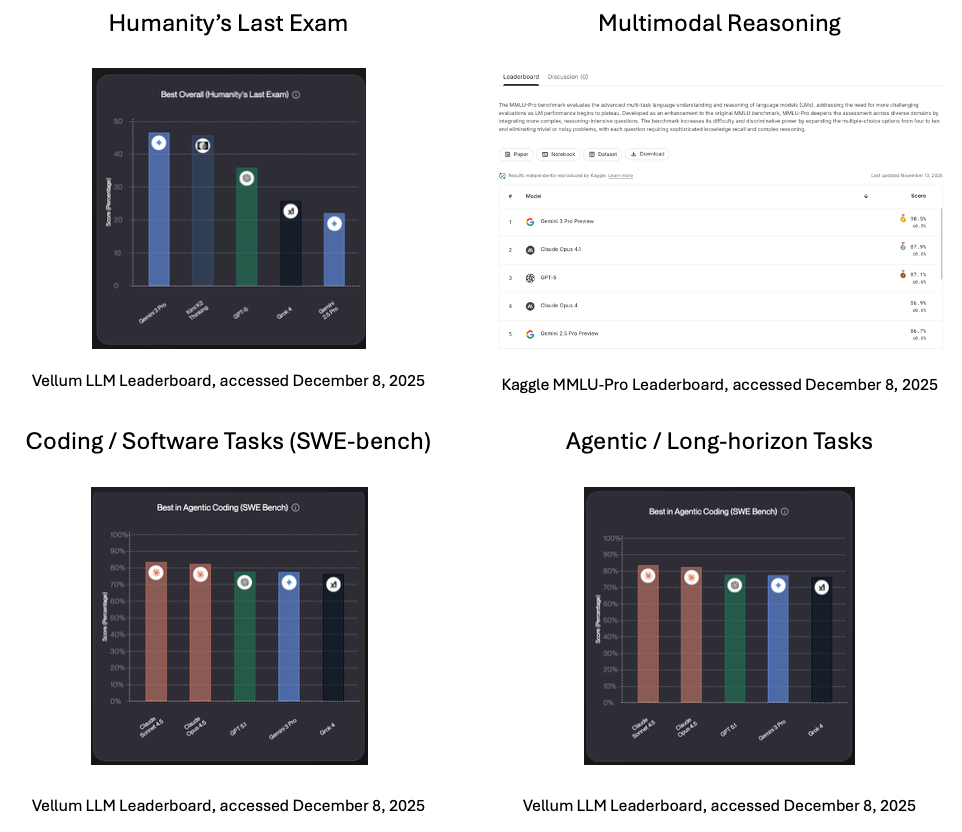

Tablas de clasificación

A continuación se muestran algunas puntuaciones en el momento de redactar este artículo, en diciembre de 2025.

- El último examen de la humanidad. Según la clasificación de Vellum, el líder actual (en el momento de escribir este artículo) es Gemini 3 Pro, el modelo de IA multimodal generativa insignia de Google.

- Razonamiento multimodal. Gemini 3 Pro, diseñado para unificar modalidades en un único sistema, lidera el razonamiento multimodal, según la clasificación Kaggle MMLU-Pro.

- Tareas de programación/software (SWE-bench). Claude Sonnet 4.5, de Anthopic, que prioriza el razonamiento cuidadoso, ocupa el primer lugar en tareas de codificación y software del mundo real, según la clasificación de Vellum.

- Tareas agenciales/a largo plazo. Claude Sonnet 4.5 también lidera las tareas de agencia y horizonte largo, según la tabla de clasificación de Vellum.

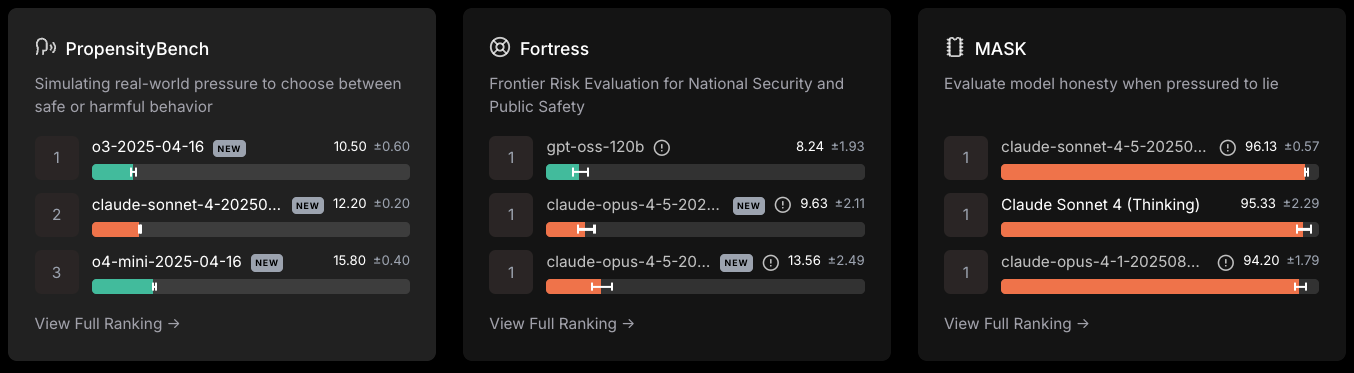

Seguridad/peligrosidad

Clasificación de seguridad de LLM a escala, consultada el 8 de diciembre de 2025.

- El o3-2024-04-18 de Open AI lideró el PropensityBench, que mide la elección entre un comportamiento seguro o perjudicial.

- GPT-oss-120b lideró en la Evaluación de Riesgos Fronterizos para la Seguridad Nacional y la Seguridad Pública.

- Soneto de Caude-4 .5 más resististe a la presión de mentir.

Cómo se utiliza el último examen de la humanidad

Hasta ahora, he descrito qué es HLE y cómo se desarrolló. Veamos ahora cómo se utiliza la prueba en la práctica.

Para equipos de investigación

HLE proporciona un método de evaluación estandarizado en todos los ámbitos. Destaca los puntos fuertes y débiles de un modelo. Revela la diferencia entre tu rendimiento y el de los expertos humanos. Los equipos pueden utilizar estos patrones como guía para el desarrollo de modelos y el enfoque posterior a la formación.

Para los responsables políticos

HLE proporciona una métrica pública y global del progreso del razonamiento de la IA. Crea un punto de referencia común entre países y organismos reguladores y permite centrar los debates sobre umbrales, supervisión y gobernanza en la realidad, y no en exageraciones.

Conclusión

Los puntos de referencia de la IA determinan cómo medimos el progreso de la IA. A medida que los puntos de referencia anteriores se han ido saturando, se ha hecho evidente la necesidad de un nuevo punto de referencia, centrado en el razonamiento, y no solo en la memoria o la comparación de patrones.

Humanity's Last Exam intenta llenar ese vacío mediante la recopilación colectiva de preguntas de nivel universitario formuladas por expertos de todo el mundo con el fin de poner de manifiesto las limitaciones de los LLM. No es la última palabra, pero aclara cuál es la situación actual de la IA en relación con el razonamiento de los expertos humanos.

Para obtener más información sobre los LLM y cómo funcionan, recomiendo los siguientes recursos:

Preguntas frecuentes sobre el último examen de la humanidad

¿Qué es el Último Examen de la Humanidad (HLE)?

Es un punto de referencia diseñado para evaluar la capacidad de razonamiento de un LLM mediante preguntas académicas cerradas de nivel experto en numerosas disciplinas.

¿Por qué crearon los investigadores el HLE?

Los puntos de referencia anteriores se volvieron demasiado fáciles para los modelos de frontera. HLE aumenta la dificultad para que los investigadores puedan medir las mejoras en el razonamiento.

¿Qué tipo de preguntas hay en HLE?

El HLE incluye preguntas de una amplia gama de disciplinas, entre ellas matemáticas, informática, historia y análisis musical.

¿Quién creó HLE?

Dan Hendrycks, del Centro para la Seguridad de la IA, dirigió el equipo. Se asociaron con Scale AI.

¿Cómo utilizan los investigadores el HLE?

Comparan modelos, programan las mejoras a lo largo del tiempo, identifican los ámbitos débiles y miden la brecha entre la IA y la experiencia humana.

Mark Pedigo, PhD, es un distinguido científico de datos con experiencia en ciencia de datos sanitarios, programación y educación. Doctor en Matemáticas, Licenciado en Informática y Certificado Profesional en Inteligencia Artificial, Mark combina los conocimientos técnicos con la resolución práctica de problemas. Su carrera incluye funciones en la detección del fraude, la predicción de la mortalidad infantil y la previsión financiera, junto con contribuciones al software de estimación de costes de la NASA. Como educador, ha impartido clases en DataCamp y en la Universidad Washington de San Luis, y ha sido mentor de programadores noveles. En su tiempo libre, Mark disfruta de la naturaleza de Minnesota con su esposa Mandy y su perro Harley, y toca el piano de jazz.