programa

Las empresas dependen de datos precisos para tomar decisiones, o al menos deberían hacerlo. Una canalización de datos fallida o unos datos poco fiables pueden perturbar considerablemente los procesos organizativos.

Imagínate este escenario:

Un equipo de marketing utiliza datos de clientes para crear anuncios dirigidos, pero debido a un problema de datos inadvertido, se envía información obsoleta o incorrecta, quizá incluso a las personas equivocadas.

El error puede pasar desapercibido hasta que los clientes empiecen a presentar reclamaciones. Para entonces, ya es demasiado tarde. El daño ya está hecho: se ha malgastado tiempo y dinero, y es probable que se necesiten aún más recursos para hacer frente a las consecuencias.

La observabilidad de los datos pretende evitar que esto ocurra. En este artículo hablaremos de cómo. ¡Vamos a ello!

¿Qué es la Observabilidad de los Datos?

La observabilidad de los datos se refiere a la capacidad de supervisar y comprender la salud de tus datos a medida que se mueven a través de conductos y sistemas. Su objetivo principal es garantizar que los datos sigan siendo precisos, coherentes y fiables, de modo que puedan detectarse y resolverse posibles problemas antes de que causen problemas mayores.

Por ejemplo, si formas parte del equipo de ventas y confías en los informes diarios para hacer un seguimiento del rendimiento y determinar los siguientes pasos, cualquier problema con los datos que alimentan esos informes podría echar por tierra toda tu estrategia. La observabilidad de los datos te permite detectar estos problemas en tiempo real, solucionarlos y mantener las cosas funcionando sin problemas.

Así pues, en esencia, la observabilidad de los datos consiste en supervisar tus datos a medida que se mueven por los distintos sistemas para asegurarte de que son precisos y fluyen según lo esperado. Lo único que haces es detectar cualquier problema antes de que influya en decisiones críticas.

En concreto, ayuda la observabilidad de los datos:

- Mantén la calidad de los datos: Detecta automáticamente los datos que faltan o son inexactos, permitiendo a los equipos solucionar los problemas antes de que conduzcan a malas decisiones.

- Evita el tiempo de inactividad de los datos: Supervisa los conductos en busca de anomalías (por ejemplo, caídas de volumen, esquemas rotos) y alerta a los equipos antes de que se agraven las interrupciones.

- Gobernanza y cumplimiento: Identifica la calidad de los datos o las brechas de seguridad, ayudando a cumplir normativas de privacidad como GDPR o CCPA.

- Genera confianza en los datos: Proporcionar transparencia sobre cómo se recogen, procesan y gestionan los datos, fomentando la confianza en la toma de decisiones.

Conviértete en Ingeniero de Datos

Los pilares de la observabilidad de los datos

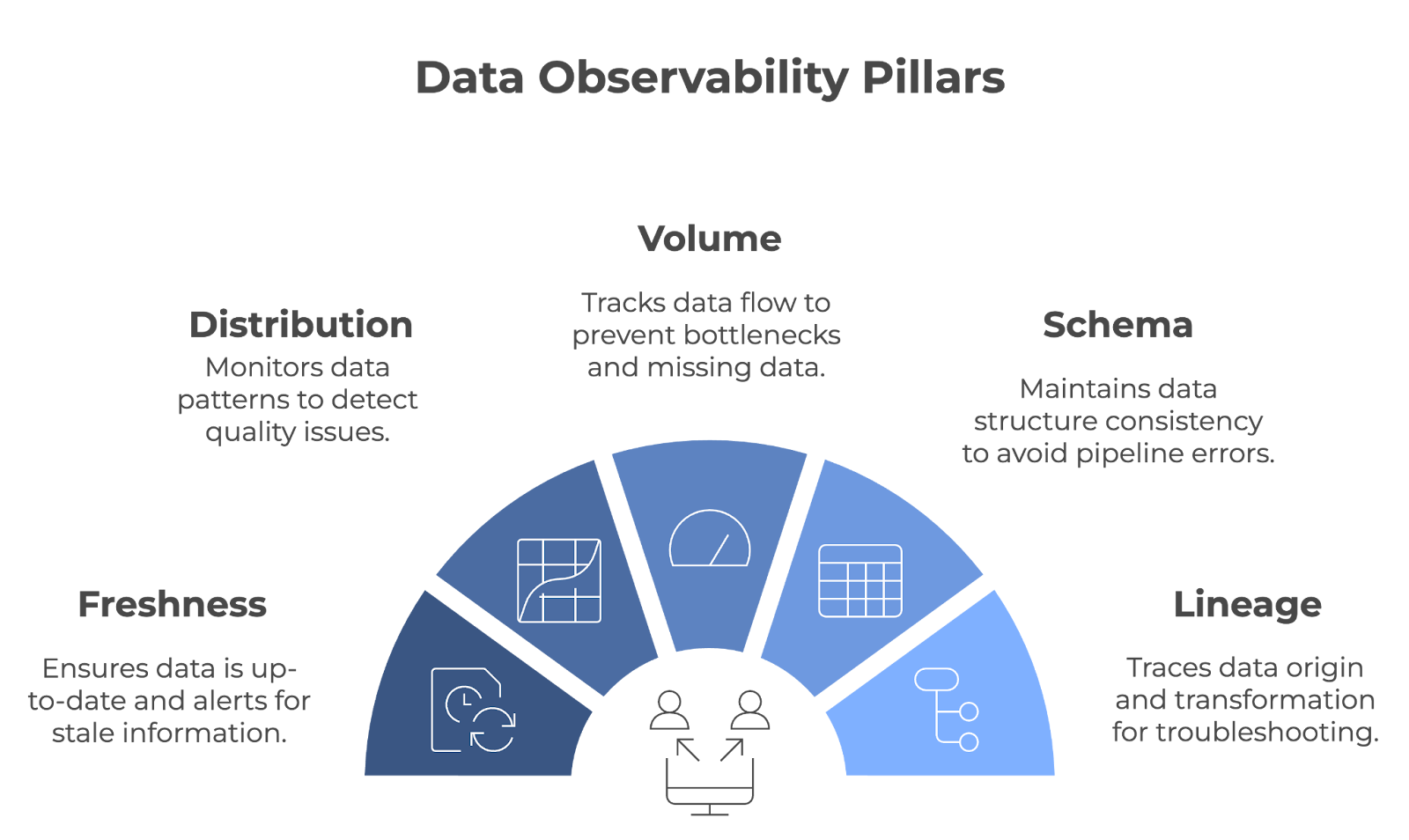

La observabilidad de los datos se basa en cinco pilares fundamentales: Frescura, distribución, volumen, esquema y linaje. Juntos, estos pilares garantizan que los conductos de datos funcionen sin problemas y que los datos sigan siendo precisos, completos y fiables.

Los cinco pilares de la observabilidad de los datos. Imagen del autor (creada con napkin.ai)

¡Examinemos cada pilar en detalle!

Frescura

La frescura te indica lo actualizados que están tus datos. Registra cuándo se actualizaron los datos por última vez y te avisa si se quedan obsoletos. Este pilar es importante para los equipos que dependen de datos en tiempo real o casi real para tomar decisiones.

- Ejemplo: Imagina que un minorista ajusta los niveles de inventario basándose en datos de ventas en directo. Si esos datos no se actualizan a tiempo, la empresa puede acabar teniendo demasiadas o muy pocas existencias. La frescura ayuda a evitarlo, asegurando que las decisiones se basen en la información más reciente.

Distribución

La distribución se refiere al seguimiento de los patrones y valores específicos de tus datos (por ejemplo, media, mediana, desviación típica, etc.). Controlar estos valores ayuda a detectar cuando algo no parece correcto, lo que puede ser un signo de problemas de calidad de los datos. Las comprobaciones periódicas de la distribución garantizan que los datos permanezcan coherentes a lo largo del tiempo.

- Ejemplo: Una plataforma online probablemente analizaría las métricas de compromiso del cliente. Para comprobar la coherencia, pueden controlar las distribuciones de datos de métricas como la duración de la sesión, las tasas de conversión, etc. Un pico o una caída repentinos de estas métricas podrían indicar problemas con el proceso de recogida de datos o un error subyacente del sistema.

Volumen

El volumen de datos se refiere a la cantidad de datos que fluyen por un sistema. Esta métrica se controla para garantizar que se está ingiriendo y procesando la cantidad de datos esperada, sin caídas ni picos inesperados. El volumen de datos se supervisa para detectar rápidamente problemas como la falta de datos o los cuellos de botella en las canalizaciones.

- Ejemplo: Una empresa de logística que dependa de los datos GPS de una flota de vehículos controlaría el volumen de datos de localización que se transmiten. Si el volumen de datos cae inesperadamente, podría indicar fallos de comunicación con determinados vehículos, lo que provocaría lagunas en el seguimiento.

Esquema

La observabilidad del esquema rastrea la estructura de los datos: es importante que permanezca constante a lo largo del tiempo. Cuando tu esquema cambia inesperadamente, puede romper tus canalizaciones de datos y provocar errores en el procesamiento.

- Ejemplo: Imagina que tu equipo de marketing segmenta a los clientes por edad y ubicación. Para evitar que se rompa tu canalización de datos, tu equipo tendría que asegurarse de que los cambios en el esquema (por ejemplo, cambiar el nombre de las columnas, alterar los tipos de datos, etc.) no provocan errores en su sistema de informes. Cualquier cambio inadvertido podría conducir a una segmentación errónea de los clientes.

Linaje

Lineage provides una visión clara de dónde proceden tus datos, cómo se transforman y dónde acaban. Esto es clave para solucionar problemas y mantener la calidad de los datos en sistemas complejos. Cuando surgen problemas, el linaje te permite rastrear los puntos de datos a través de la tubería para encontrar el origen del problema.

- Ejemplo: En un banco, el linaje de datos puede utilizarse para rastrear un punto de datos concreto, como el saldo de una cuenta, hasta su origen. Si surgen discrepancias, el linaje permite a los ingenieros de datos identificar en qué punto de la cadena se produjo el problema.

Cómo funciona la observabilidad de los datos

A lo largo de este artículo, hemos aludido a la observabilidad de los datos supervisando activamente los conductos de datos, enviando alertas cuando surgen problemas y ayudando a los equipos a encontrar rápidamente la causa raíz de los problemas.

Exploremos cómo funciona cada componente en la práctica.

Supervisión de los conductos de datos

Las herramientas de observabilidad de datos detectan los errores mediante la supervisión constante de los conductos de datos. Pueden realizar el seguimiento de muchos aspectos de una cadena de datos, pero normalmente se configuran para centrarse en métricas específicas o en las áreas más críticas para las necesidades de la organización.

Estas herramientas a menudo se integran con tecnologías como Apache Kafka, Apache Airflow, o servicios basados en la nube como AWS Glue o Google Cloud Dataflow para recopilar información en varias fases del proceso. Por ejemplo:

- Validación del esquema: Herramientas como Great Expectations pueden aplicar reglas de esquema, garantizando que los datos entrantes se adhieren a formatos predefinidos (por ejemplo, tipos de datos, presencia de columnas y restricciones de longitud).

- Detección de anomalías: Plataformas como Monte Carlo o Databand.ai utilizan el aprendizaje automático para identificar patrones inusuales en el volumen de datos, los tiempos de procesamiento o las distribuciones que podrían indicar un problema.

- Seguimiento del linaje: Herramientas como OpenLineage o Apache Atlas visualizan cómo fluyen los datos por los sistemas, facilitando el seguimiento del impacto de los cambios o errores.

Alertas y automatización

¿Qué sentido tiene detectar rápidamente los problemas si nadie está informado? Las herramientas de observabilidad de datos alertan automáticamente a las personas adecuadas y, a veces, toman medidas basándose en configuraciones predefinidas.

Estas alertas suelen configurarse en función de umbrales o desencadenantes, como registros que faltan, cambios en el esquema o retrasos inesperados en los datos. Por ejemplo:

- Si falla una canalización en Apache Airflow, una herramienta de observabilidad podría detectar un descenso repentino del volumen de datos y notificarlo automáticamente al equipo de ingeniería de datos a través de Slack.

- Algunas plataformas, como Datafold o Soda, ofrecen opciones de reparación automatizada. Por ejemplo, un sistema podría hacer retroceder un conjunto de datos a su último estado verificado o redirigir los datos entrantes a una ubicación de almacenamiento de copia de seguridad utilizando herramientas en la nube como AWS Lambda.

Análisis de la causa raíz

El análisis de la causa raíz es un proceso sistemático para identificar la razón fundamental de un problema o cuestión. En el contexto de la observabilidad de los datos, implica rastrear un problema de datos hasta su origen, en lugar de limitarse a tratar sus síntomas.

Las plataformas de observabilidad de datos a menudo proporcionan ricas capacidades de diagnóstico, integrándose con sistemas de gestión de registros como Elasticsearch o plataformas de monitorización como Prometheus y Grafana para sacar a la superficie detalles granulares. Por ejemplo:

- Una herramienta podría rastrear una transformación fallida en dbt hasta un desajuste de esquema en una base de datos fuente.

- Al analizar los datos de linaje, la plataforma puede destacar qué informes o cuadros de mando posteriores están afectados, lo que permite a los equipos priorizar las correcciones en consecuencia.

Herramientas para la Observabilidad de los Datos

A menudo, los ingenieros de datos implementan internamente las funciones de observabilidad. Sin embargo, hoy en día existen varias herramientas potentes que permiten a los equipos poner en práctica la observabilidad de los datos de forma eficaz. ¡Echemos un vistazo a los más populares!

Monte Carlo

Montecarlo es una potente plataforma de observabilidad de datos diseñada para ayudar a los equipos a mantener la salud de sus sistemas de datos. Creada por un equipo de antiguos ingenieros de empresas como LinkedIn y Facebook, la plataforma surgió del deseo de resolver el creciente problema del tiempo de inactividad de los datos. Proporciona:

- Comprobaciones automatizadas de la calidad de los datos: Rastrea los cambios de esquema, la frescura, el volumen y la distribución para detectar anomalías.

- Análisis de la causa raíz: Ayuda a los equipos a localizar el origen de los problemas, como tuberías rotas o datos que faltan.

- Línea de datos de extremo a extremo: Visualiza el flujo de datos para comprender el impacto de los cambios o interrupciones.

Montecarlo se integra con herramientas como Snowflake, dbt y Looker, por lo que es ideal para los equipos que trabajan en ecosistemas de datos modernos.

Patudo

Bigeye fue fundada en 2020 por un grupo de ingenieros de datos. Es una plataforma de observabilidad de datos diseñada para mantener la calidad y fiabilidad de los datos a lo largo de su ciclo de vida.

La plataforma se centra en la automatización de la supervisión de la calidad de los datos, la detección de anomalías y la resolución de problemas con los datos, para que los flujos de datos fluyan sin problemas y las partes interesadas puedan confiar en datos precisos para la toma de decisiones. Entre sus características se incluyen:

- Monitorización personalizable: Permite a los equipos establecer umbrales específicos para métricas como integridad, frescura y precisión de los datos.

- Detección de anomalías: Utiliza el aprendizaje automático para identificar valores atípicos o cambios inesperados en los datos.

- Herramientas de colaboración: Proporciona alertas e informes que se integran con Slack y Jira para agilizar la resolución de incidencias.

Banda de datos

Databand es una plataforma de observabilidad de datos para gestionar de forma proactiva la salud de los datos, proporcionando visibilidad de las canalizaciones de datos. Fundada en 2019, Databand se creó para hacer frente a la creciente complejidad y escala del entorno de datos.

La plataforma se construyó para ayudar a los ingenieros de datos a detectar problemas en tiempo real, comprender el flujo de datos y garantizar la exactitud de los conjuntos de datos en toda la organización. Sus características son:

- Supervisión de tuberías: Realiza un seguimiento de métricas como el tiempo de ejecución, el volumen de datos y los errores en herramientas como Apache Airflow y Spark.

- Análisis del impacto de los datos: Resalta las dependencias descendentes para priorizar las correcciones críticas.

- Capacidades de integración: Funciona con plataformas como BigQuery, Kafka y Kubernetes para una visibilidad de extremo a extremo.

Datadog

Datadog es una plataforma de monitorización y análisis basada en la nube que proporciona observabilidad en tiempo real. Fundada en 2010 por Olivier Pomel y Alexis Lê-Quôc, Datadog se creó para hacer frente a la complejidad de las aplicaciones modernas en la nube.

Datadog es ideal para empresas que necesitan una supervisión exhaustiva de varios sistemas. La plataforma es especialmente útil para empresas nativas de la nube o con sistemas distribuidos complejos. Entre sus características se incluyen:

- Monitorización unificada: Rastrea métricas, registros y rastros en aplicaciones, infraestructura y canalizaciones de datos.

- Alerta en tiempo real: Envía notificaciones personalizables por correo electrónico, Slack o PagerDuty.

- Ecosistema de integración: Admite más de 500 integraciones, incluidas AWS, Google Cloud y Docker.

Comparación de Herramientas de Observabilidad de Datos

|

Herramienta |

Áreas de interés |

Integraciones |

Ideal para |

|

Monte Carlo |

Calidad de datos, detección de anomalías, linaje de datos |

Copo de nieve, dbt, Looker |

Los ecosistemas de datos modernos necesitan una observabilidad automatizada |

|

Patudo |

Supervisión de la calidad de los datos, detección de anomalías, interfaz de usuario fácil de usar |

Slack, Jira, grandes lagos de datos y almacenes |

Industrias con grandes necesidades de fiabilidad de datos (por ejemplo, finanzas, sanidad) |

|

Banda de datos |

Supervisión de tuberías, análisis del impacto de los datos, alertas en tiempo real |

Apache Airflow, Spark, BigQuery, Kafka |

Equipos que gestionan flujos de datos complejos y de gran volumen |

|

Datadog |

Supervisión unificada, alertas en tiempo real, soporte nativo en la nube |

AWS, Google Cloud, Docker, Kubernetes |

Empresas con sistemas distribuidos o configuraciones nativas de la nube |

Buenas prácticas para implementar la observabilidad de los datos

Para implantar eficazmente la observabilidad de los datos, céntrate en estas buenas prácticas:

Empieza con canalizaciones de alto impacto

Céntrate en supervisar primero los conductos de datos más críticos, los que tienen un impacto empresarial más significativo. Puedes mitigar el riesgo asegurándote de que estos pipelines están sanos mientras construyes gradualmente una estrategia de observabilidad más amplia en otros pipelines.

Establece métricas y KPI claros

Unas métricas claramente definidas son la clave para evaluar la salud de los datos: debes saber qué aspecto tiene el éxito (y el fracaso). Estas métricas deben estar alineadas con los objetivos generales de la empresa para reflejar lo que realmente importa. Esta claridad te ayudará a mantenerte centrado y a evaluar sus progresos con eficacia.

Automatiza la supervisión de la calidad de los datos

Los sistemas de supervisión y alerta reducen la intervención manual y mejoran los tiempos de respuesta. Los sistemas automatizados pueden detectar problemas con antelación y activar acciones inmediatas para evitar el tiempo de inactividad de los datos. Haz de la automatización una prioridad.

Integrar la observabilidad con los procesos existentes

Incorporar la observabilidad a tus procesos diarios te permite responder más rápida y eficazmente, haciendo que la gestión de datos sea más proactiva y menos reactiva.

Conclusión

La observabilidad de los datos es clave para construir canalizaciones de datos fiables y de alta calidad. Al supervisar continuamente los aspectos críticos de los datos, los equipos pueden identificar y abordar los problemas antes de que afecten a los resultados empresariales. A medida que los datos sigan impulsando las decisiones empresariales, la observabilidad seguirá siendo un elemento esencial para gestionar y optimizar los conductos de datos.

Para comprender plenamente la importancia de la observabilidad y aplicarla eficazmente, es necesario entender conceptos relacionados como la arquitectura, la gobernanza y la gestión de datos. Si buscas profundizar en tus conocimientos:

- Comprender la Arquitectura Moderna de Datos proporciona información sobre cómo se estructuran y gestionan los datos en las organizaciones.

- Explora los Conceptos de Gobernanza de Datos para comprender cómo las políticas y los procesos garantizan la calidad, la seguridad y el cumplimiento de los datos.

- Conoce los principios más generales de la gestión eficaz de datos con Conceptos de Gestión de Datos.

Por último, si eres nuevo en este campo, ¡Entender la Ingeniería de Datos es un gran punto de partida para explorar cómo se diseñan y mantienen los conductos de datos!

Conviértete en Ingeniero de Datos

Preguntas frecuentes

¿Qué diferencia hay entre observabilidad de datos y monitorización de datos?

La monitorización de datos se centra en el seguimiento de métricas o sistemas específicos, mientras que la observabilidad de datos te proporciona una comprensión más profunda de cómo se comportan los datos a lo largo de su ciclo de vida. En concreto, la observabilidad de los datos permite conocer la causa raíz de los problemas de los datos, ofreciendo así una visión más completa que la simple supervisión.

¿Qué sectores se benefician más de la observabilidad de los datos?

Las industrias con grandes necesidades de fiabilidad de los datos -como las finanzas, la sanidad, el comercio electrónico y la logística- se benefician significativamente de la observabilidad de los datos. Estas industrias dependen en gran medida de datos precisos y puntuales para el cumplimiento, la satisfacción del cliente y la eficacia operativa.

¿Cómo gestionan las herramientas de observabilidad de datos las canalizaciones de datos en tiempo real frente a las canalizaciones de datos por lotes?

Las herramientas de observabilidad de datos pueden supervisar tanto los conductos en tiempo real como los conductos por lotes. Para los datos en tiempo real, rastrean métricas como la latencia, el rendimiento y las anomalías a medida que se producen. Para los procesos por lotes, garantizan la integridad de los datos, validan el cumplimiento del esquema y comprueban si hay anomalías después de cada ejecución.

¿Cuáles son algunos retos a la hora de aplicar la observabilidad de los datos?

Algunos retos comunes son la selección de las herramientas adecuadas para tu pila de datos, la alineación de las prácticas de observabilidad con los objetivos empresariales y la gestión de la sobrecarga adicional que supone la supervisión de canalizaciones complejas. Garantizar la implicación del equipo y asignar recursos para la configuración y el mantenimiento también es fundamental para el éxito de la implantación.