Lernpfad

Unternehmen sind auf genaue Daten angewiesen, um Entscheidungen treffen zu können - oder zumindest sollten sie das. Eine ausgefallene Datenpipeline oder unzuverlässige Daten können organisatorische Abläufe erheblich stören.

Stell dir folgendes Szenario vor:

Ein Marketingteam nutzt Kundendaten, um gezielte Werbung zu erstellen, aber aufgrund eines unbemerkten Datenproblems werden veraltete oder falsche Informationen verschickt, vielleicht sogar an die falschen Personen.

Der Fehler könnte unbemerkt bleiben, bis die Kunden anfangen, Beschwerden einzureichen. Dann ist es schon zu spät. Der Schaden ist bereits angerichtet - Zeit und Geld wurden bereits verschwendet, und es werden wahrscheinlich noch mehr Ressourcen benötigt, um die Folgen zu beseitigen.

Die Beobachtbarkeit der Daten soll dies verhindern. In diesem Artikel erfahren wir, wie das geht. Lass uns loslegen!

Was ist die Beobachtbarkeit von Daten?

Datenbeobachtung bezieht sich auf die Fähigkeit, den Zustand deiner Daten zu überwachen und zu verstehen, während sie sich durch Pipelines und Systeme bewegen. Ihr Hauptziel ist es, sicherzustellen, dass die Daten genau, konsistent und zuverlässig bleiben, damit potenzielle Probleme erkannt und behoben werden können, bevor sie größere Probleme verursachen.

Wenn du zum Beispiel zum Verkaufsteam gehörst und dich auf tägliche Berichte verlässt, um die Leistung zu verfolgen und die nächsten Schritte festzulegen, könnte jedes Problem mit den Daten, die diese Berichte speisen, deine gesamte Strategie über den Haufen werfen. Die Beobachtung von Daten ermöglicht es dir, diese Probleme in Echtzeit zu erkennen, sie zu beheben und dafür zu sorgen, dass die Dinge reibungslos laufen.

Im Kern geht es bei der Datenbeobachtung also darum, deine Daten zu überwachen, während sie verschiedene Systeme durchlaufen, um sicherzustellen, dass sie korrekt sind und wie erwartet fließen. Das Einzige, was du tust, ist, Probleme zu erkennen, bevor sie wichtige Entscheidungen beeinflussen.

Vor allem die Beobachtbarkeit der Daten ist hilfreich:

- Halte die Datenqualität aufrecht: Erkenne automatisch fehlende oder ungenaue Daten, damit die Teams Probleme beheben können, bevor sie zu schlechten Entscheidungen führen.

- Verhindere Datenausfallzeiten: Überwache die Pipelines auf Anomalien (z. B. abnehmendes Volumen, defekte Schemata) und alarmiere die Teams, bevor die Störungen eskalieren.

- Governance und Compliance: Identifiziere Datenqualitäts- oder Sicherheitsverletzungen und hilf dabei, Datenschutzbestimmungen wie GDPR oder CCPA einzuhalten.

- Schaffe Vertrauen in Daten: Transparenz darüber schaffen, wie Daten gesammelt, verarbeitet und verwaltet werden, um das Vertrauen in die Entscheidungsfindung zu stärken.

Werde Dateningenieur

Die Säulen der Beobachtbarkeit von Daten

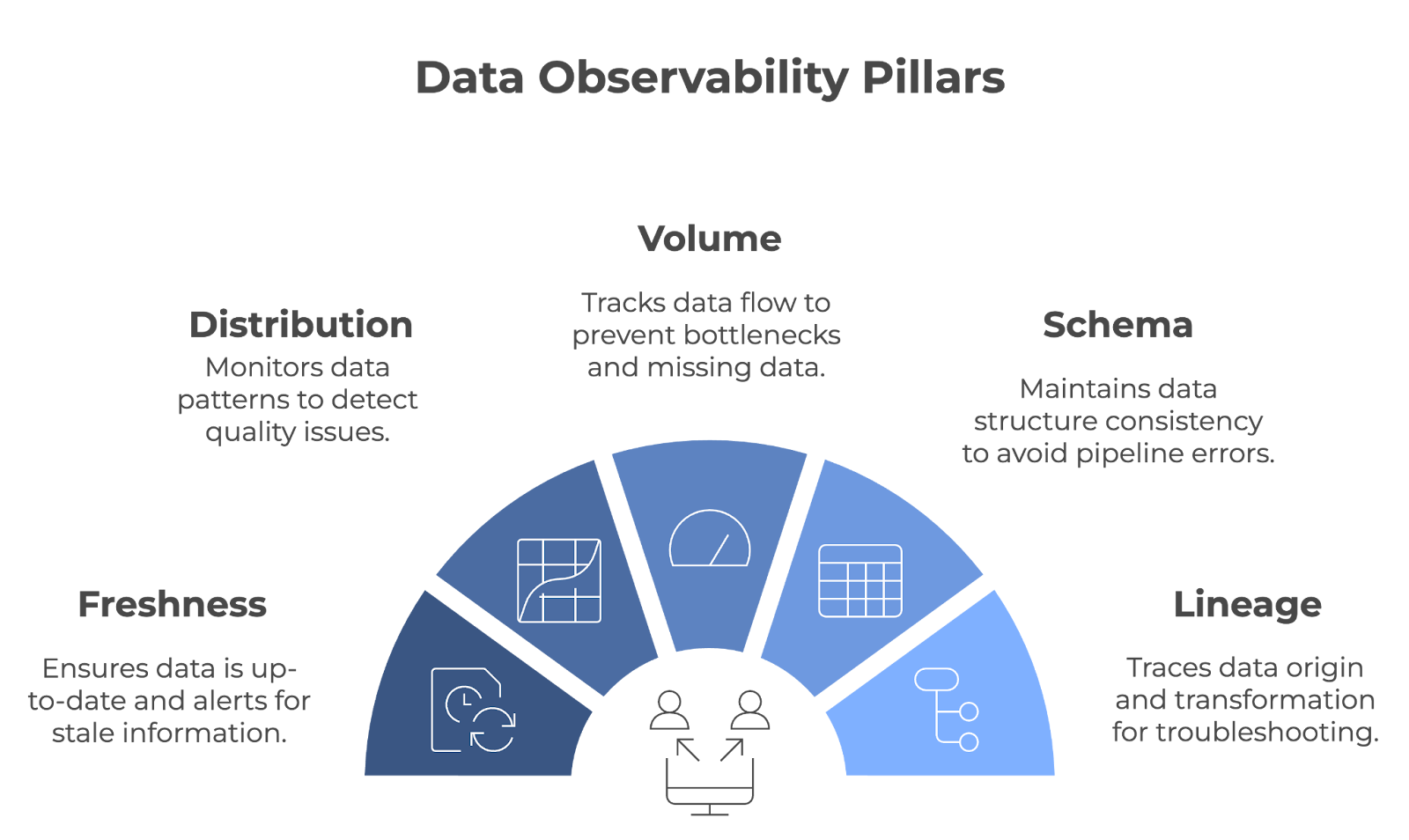

Die Beobachtbarkeit von Daten beruht auf fünf wichtigen Säulen: Frische, Verteilung, Volumen, Schema und Abstammung. Gemeinsam sorgen diese Säulen dafür, dass die Datenpipelines reibungslos funktionieren und dass die Daten genau, vollständig und zuverlässig bleiben.

Die fünf Säulen der Beobachtbarkeit von Daten. Bild vom Autor (erstellt mit napkin.ai)

Schauen wir uns jede Säule im Detail an!

Frische

Die Freshness sagt dir, wie aktuell deine Daten sind. Der Lernpfad zeigt an, wann die Daten zuletzt aktualisiert wurden und warnt dich, wenn sie veraltet sind. Diese Säule ist wichtig für Teams, die bei ihren Entscheidungen auf Echtzeit- oder echtzeitnahe Daten angewiesen sind.

- Beispiel: Stell dir vor, ein Einzelhändler passt seine Bestände anhand der aktuellen Verkaufsdaten an. Wenn diese Daten nicht rechtzeitig aktualisiert werden, kann es passieren, dass das Unternehmen am Ende zu viel oder zu wenig Bestand hat. Frische hilft, dies zu verhindern, indem sie sicherstellt, dass die Entscheidungen auf den neuesten Informationen basieren.

Vertrieb

Die Verteilung bezieht sich auf die Verfolgung von Mustern und bestimmten Werten in deinen Daten (z. B. Mittelwert, Median, Standardabweichung usw.). Die Überwachung dieser Werte hilft dabei, zu erkennen, wenn etwas nicht stimmt, was ein Zeichen für Probleme mit der Datenqualität sein kann. Regelmäßige Überprüfungen der Verteilung garantieren, dass die Daten im Laufe der Zeit konsistent bleiben.

- Beispiel: Eine Online-Plattform würde wahrscheinlich die Metriken zur Kundenbindung analysieren. Um die Konsistenz zu überprüfen, können sie die Datenverteilungen für Kennzahlen wie Sitzungsdauer, Konversionsraten usw. überwachen. Ein plötzlicher Anstieg oder ein plötzlicher Abfall dieser Kennzahlen könnte auf Probleme bei der Datenerfassung oder einen zugrunde liegenden Systemfehler hinweisen.

Band

Das Datenvolumen bezieht sich auf die Menge der Daten, die durch ein System fließen. Dieser Lernpfad wird verfolgt, um sicherzustellen, dass die erwartete Datenmenge aufgenommen und verarbeitet wird, ohne dass es zu unerwarteten Einbrüchen oder Ausschlägen kommt. Das Datenvolumen wird überwacht, um Probleme wie fehlende Daten oder Engpässe in der Pipeline schnell zu erkennen.

- Beispiel: Ein Logistikunternehmen, das auf die GPS-Daten einer Fahrzeugflotte angewiesen ist, würde das Volumen der übermittelten Standortdaten überwachen. Wenn das Datenvolumen unerwartet abfällt, könnte dies auf Kommunikationsstörungen mit bestimmten Fahrzeugen hindeuten, was zu Lücken in der Verfolgung führt.

Schema

Die Beobachtbarkeit des Schemas verfolgt die Struktur der Daten - es ist wichtig, dass sie im Laufe der Zeit konsistent bleibt. Wenn sich dein Schema unerwartet ändert, kann dies deine Datenpipelines unterbrechen und zu Fehlern bei der Verarbeitung führen.

- Beispiel: Stell dir vor, dein Marketingteam segmentiert Kunden nach Alter und Standort. Damit deine Datenpipeline nicht zusammenbricht, muss dein Team sicherstellen, dass Änderungen am Schema (z. B. das Umbenennen von Spalten, das Ändern von Datentypen usw.) keine Fehler in ihrem Berichtssystem verursachen. Jede unbemerkte Veränderung könnte zu einer fehlerhaften Kundensegmentierung führen.

Abstammung

Lineage provides einen klaren Überblick darüber, woher deine Daten kommen, wie sie umgewandelt werden und wo sie am Ende landen. Das ist der Schlüssel für die Fehlersuche und die Erhaltung der Datenqualität in komplexen Systemen. Wenn Probleme auftreten, kannst du die Datenpunkte durch die Pipeline zurückverfolgen, um die Ursache des Problems zu finden.

- Beispiel: In einer Bank kann die Datenabfolge verwendet werden, um einen bestimmten Datenpunkt, wie z.B. einen Kontostand, zu seiner Quelle zurückzuverfolgen. Wenn es zu Unstimmigkeiten kommt, können die Dateningenieure anhand des Verlaufs feststellen, wo in der Pipeline das Problem aufgetreten ist.

Wie die Beobachtbarkeit von Daten funktioniert

In diesem Artikel haben wir bereits angedeutet, dass die Datenbeobachtung Datenpipelines aktiv überwacht, bei Problemen Warnungen sendet und den Teams hilft, die Ursache von Problemen schnell zu finden.

Lass uns herausfinden, wie jede Komponente in der Praxis funktioniert!

Überwachung von Datenpipelines

Tools zur Datenbeobachtung erkennen Fehler, indem sie die Datenpipelines ständig überwachen. Sie können viele Aspekte einer Datenpipeline verfolgen, sind aber in der Regel so konfiguriert, dass sie sich auf bestimmte Kennzahlen oder Bereiche konzentrieren, die für die Bedürfnisse des Unternehmens am wichtigsten sind.

Diese Tools werden oft mit Technologien wie Apache Kafka, Apache Airflow oder Cloud-basierten Diensten wie AWS Glue oder Google Cloud Dataflow integriert, um in verschiedenen Phasen der Pipeline Erkenntnisse zu sammeln. Zum Beispiel:

- Schema-Validierung: Tools wie Great Expectations können Schemaregeln durchsetzen und so sicherstellen, dass die eingehenden Daten die vordefinierten Formate einhalten (z. B. Datentypen, vorhandene Spalten und Längenbeschränkungen).

- Anomalieerkennung: Plattformen wie Monte Carlo oder Databand.ai nutzen maschinelles Lernen, um ungewöhnliche Muster im Datenvolumen, in den Verarbeitungszeiten oder in den Verteilungen zu erkennen, die auf ein Problem hinweisen könnten.

- Lernpfad zur Abstammung: Tools wie OpenLineage oder Apache Atlas visualisieren, wie die Daten durch die Systeme fließen und machen es einfacher, die Auswirkungen von Änderungen oder Fehlern nachzuvollziehen.

Warnungen und Automatisierung

Was nützt es, Probleme schnell zu erkennen, wenn niemand informiert wird? Tools zur Datenbeobachtung alarmieren automatisch die richtigen Leute und ergreifen manchmal Maßnahmen auf der Grundlage von vordefinierten Konfigurationen.

Diese Warnungen werden oft auf der Grundlage von Schwellenwerten oder Auslösern konfiguriert, z. B. bei fehlenden Datensätzen, Schemaänderungen oder unerwarteten Datenverzögerungen. Zum Beispiel:

- Wenn eine Pipeline in Apache Airflow ausfällt, kann ein Observability-Tool einen plötzlichen Rückgang des Datenvolumens feststellen und das Data Engineering Team automatisch über Slack benachrichtigen.

- Einige Plattformen, wie Datafold oder Soda, bieten automatische Korrekturmöglichkeiten an. So kann ein System zum Beispiel einen Datensatz auf seinen letzten verifizierten Zustand zurücksetzen oder eingehende Daten mithilfe von Cloud-Tools wie AWS Lambda an einen Backup-Speicherort umleiten.

Analyse der Grundursache

Die Ursachenanalyse ist ein systematischer Prozess, um den grundlegenden Grund für ein Problem oder eine Frage zu ermitteln. Im Zusammenhang mit der Beobachtbarkeit von Daten geht es darum, ein Datenproblem bis zu seinem Ursprung zurückzuverfolgen, anstatt nur die Symptome zu bekämpfen.

Plattformen zur Datenbeobachtung bieten oft umfangreiche Diagnosefunktionen, die mit Log-Management-Systemen wie Elasticsearch oder Überwachungsplattformen wie Prometheus und Grafana integriert werden können, um granulare Details anzuzeigen. Zum Beispiel:

- Ein Tool könnte eine fehlgeschlagene Transformation in dbt auf eine Schemafehlanpassung in einer Quelldatenbank zurückführen.

- Durch die Analyse der Verlaufsdaten kann die Plattform aufzeigen, welche nachgelagerten Berichte oder Dashboards betroffen sind, so dass die Teams die Fehlerbehebung entsprechend priorisieren können.

Tools für die Beobachtung von Daten

Oftmals implementieren Dateningenieure die Funktionen zur Beobachtung selbst. Heute gibt es jedoch mehrere leistungsstarke Tools, mit denen Teams die Datenbeobachtung effektiv umsetzen können. Werfen wir einen Blick auf die beliebtesten davon!

Monte Carlo

Monte Carlo ist eine leistungsstarke Plattform zur Datenbeobachtung, die Teams dabei hilft, den Zustand ihrer Datensysteme zu erhalten. Die Plattform wurde von einem Team aus ehemaligen Ingenieuren von Unternehmen wie LinkedIn und Facebook gegründet und entstand aus dem Wunsch heraus, das wachsende Problem der Datenausfallzeiten zu lösen. Es bietet:

- Automatisierte Datenqualitätsprüfungen: Verfolgt Lernpfade, Aktualität, Volumen und Verteilung, um Anomalien zu erkennen.

- Ursachenanalyse: Hilft den Teams, die Ursache von Problemen zu finden, z. B. unterbrochene Pipelines oder fehlende Daten.

- End-to-End-Datenabfolge: Visualisiert den Datenfluss, um die Auswirkungen von Änderungen oder Störungen zu verstehen.

Monte Carlo lässt sich mit Tools wie Snowflake, dbt und Looker integrieren und ist damit ideal für Teams, die in modernen Datenökosystemen arbeiten.

Großaugen

Bigeye wurde im Jahr 2020 von einer Gruppe von Dateningenieuren gegründet. Es ist eine Plattform zur Datenbeobachtung, die die Qualität und Zuverlässigkeit von Daten während ihres gesamten Lebenszyklus sicherstellt.

Die Plattform konzentriert sich auf die Automatisierung der Überwachung der Datenqualität, die Erkennung von Anomalien und die Lösung von Datenproblemen, damit die Datenpipelines reibungslos funktionieren und die Beteiligten sich bei ihren Entscheidungen auf genaue Daten verlassen können. Seine Funktionen umfassen:

- Anpassbare Überwachung: Ermöglicht Teams, bestimmte Schwellenwerte für Kennzahlen wie Vollständigkeit, Aktualität und Genauigkeit der Daten festzulegen.

- Anomalieerkennung: Verwendet maschinelles Lernen, um Ausreißer oder unerwartete Veränderungen in Daten zu erkennen.

- Kollaborationstools: Bietet Warnmeldungen und Berichte, die mit Slack und Jira integriert werden können, um die Problemlösung zu optimieren.

Databand

Databand ist eine Plattform zur Datenbeobachtung, die proaktiv den Zustand der Daten verwaltet, indem sie Einblicke in die Datenpipelines gewährt. Databand wurde 2019 gegründet, um der zunehmenden Komplexität und Größe der Datenumgebung zu begegnen.

Die Plattform wurde entwickelt, um Dateningenieure dabei zu unterstützen, Probleme in Echtzeit zu erkennen, den Datenfluss zu verstehen und die Genauigkeit der Datensätze im gesamten Unternehmen zu gewährleisten. Seine Merkmale sind:

- Pipeline-Überwachung: Lernpfad für Metriken wie Laufzeit, Datenvolumen und Fehler in Tools wie Apache Airflow und Spark.

- Analyse der Datenauswirkungen: Hebt nachgelagerte Abhängigkeiten hervor, um kritische Korrekturen zu priorisieren.

- Integrationsmöglichkeiten: Arbeitet mit Plattformen wie BigQuery, Kafka und Kubernetes für eine durchgängige Transparenz.

Datadog

Datadog ist eine Cloud-basierte Überwachungs- und Analyseplattform, die Echtzeitbeobachtung ermöglicht. Datadog wurde 2010 von Olivier Pomel und Alexis Lê-Quôc gegründet, um die Komplexität moderner Cloud-Anwendungen zu bewältigen.

Datadog ist ideal für Unternehmen, die eine umfassende Überwachung über verschiedene Systeme hinweg benötigen. Die Plattform ist besonders nützlich für Cloud-native Unternehmen oder solche mit komplexen, verteilten Systemen. Seine Funktionen umfassen:

- Vereinheitlichte Überwachung: Verfolgt Lernpfade, Logs und Traces über Anwendungen, Infrastruktur und Datenpipelines hinweg.

- Alarmierung in Echtzeit: Sendet anpassbare Benachrichtigungen per E-Mail, Slack oder PagerDuty.

- Integration Ökosystem: Unterstützt über 500 Integrationen, darunter AWS, Google Cloud und Docker.

Vergleich der Tools zur Beobachtung von Daten

|

Tool |

Schwerpunktbereiche |

Integrationen |

Ideal für |

|

Monte Carlo |

Datenqualität, Erkennung von Anomalien, Datenreihenfolge |

Snowflake, dbt, Looker |

Moderne Datenökosysteme, die automatisierte Beobachtbarkeit benötigen |

|

Großaugen |

Überwachung der Datenqualität, Erkennung von Anomalien, benutzerfreundliche UI |

Slack, Jira, große Data Lakes und Lagerhäuser |

Branchen mit hohen Anforderungen an die Zuverlässigkeit der Daten (z. B. Finanzwesen, Gesundheitswesen) |

|

Databand |

Pipeline-Überwachung, Datenauswirkungsanalyse, Echtzeit-Warnungen |

Apache Airflow, Spark, BigQuery, Kafka |

Teams, die große, komplexe Datenströme verwalten |

|

Datadog |

Einheitliche Überwachung, Echtzeit-Alarmierung, Cloud-native Unterstützung |

AWS, Google Cloud, Docker, Kubernetes |

Unternehmen mit verteilten Systemen oder Cloud-Native-Setups |

Best Practices für die Implementierung von Datenbeobachtung

Um die Datenbeobachtung effektiv umzusetzen, solltest du dich auf diese Best Practices konzentrieren:

Beginne mit hochwirksamen Pipelines

Konzentriere dich zuerst auf die Überwachung der kritischsten Datenpipelines, also derjenigen mit den größten Auswirkungen auf das Geschäft. Du kannst das Risiko mindern, indem du sicherstellst, dass diese Pipelines gesund sind, während du schrittweise eine breitere Beobachtungsstrategie für andere Pipelines aufbaust.

Lege klare Messgrößen und KPIs fest

Klar definierte Kennzahlen sind der Schlüssel zur Bewertung der Datenqualität - du musst wissen, wie Erfolg (und Misserfolg) aussieht. Diese Kennzahlen müssen mit den allgemeinen Unternehmenszielen übereinstimmen, damit sie das widerspiegeln, was wirklich wichtig ist. Diese Klarheit wird dir helfen, dich zu konzentrieren und ihre Fortschritte effektiv zu bewerten.

Automatisieren Sie die Überwachung der Datenqualität

Überwachungs- und Warnsysteme reduzieren manuelle Eingriffe und verbessern die Reaktionszeiten. Automatisierte Systeme können Probleme frühzeitig erkennen und sofortige Maßnahmen einleiten, um Datenausfälle zu verhindern. Mach die Automatisierung zu einer Priorität.

Integration der Beobachtbarkeit in bestehende Prozesse

Indem du die Beobachtbarkeit in deine täglichen Prozesse einbaust, kannst du schneller und effektiver reagieren und so das Datenmanagement proaktiver und weniger reaktiv gestalten.

Fazit

Die Beobachtbarkeit von Daten ist der Schlüssel zum Aufbau hochwertiger, zuverlässiger Datenpipelines. Durch die kontinuierliche Überwachung kritischer Datenaspekte können Teams Probleme erkennen und beheben, bevor sie sich auf die Geschäftsergebnisse auswirken. Da Daten weiterhin die Grundlage für Geschäftsentscheidungen sind, wird die Beobachtbarkeit ein Kernelement für die Verwaltung und Optimierung von Datenpipelines bleiben.

Um die Bedeutung der Beobachtbarkeit vollständig zu erfassen und sie effektiv umzusetzen, ist es notwendig, verwandte Konzepte wie Datenarchitektur, Governance und Management zu verstehen. Wenn du dein Wissen auf vertiefen willst:

- Das Verständnis der modernen Datenarchitektur bietet Einblicke in die Art und Weise, wie Daten in Unternehmen strukturiert und verwaltet werden.

- Erforsche die Konzepte der Data Governance, um zu verstehen, wie Richtlinien und Prozesse Datenqualität, Sicherheit und Compliance gewährleisten.

- Lerne mit Data Management Concepts die allgemeinen Prinzipien der effektiven Datenverwaltung kennen.

Wenn du neu auf dem Gebiet bist, ist Understanding Data Engineering ein großartiger Ausgangspunkt, um herauszufinden, wie Datenpipelines entworfen und gepflegt werden!

Werde Dateningenieur

FAQs

Was ist der Unterschied zwischen Datenbeobachtung und Datenüberwachung?

Die Datenüberwachung konzentriert sich auf die Verfolgung bestimmter Kennzahlen oder Systeme, während die Datenbeobachtung dir ein tieferes Verständnis dafür vermittelt, wie sich Daten über ihren gesamten Lebenszyklus hinweg verhalten. Die Datenbeobachtung ermöglicht nämlich Einblicke in die Ursache von Datenproblemen und bietet damit einen umfassenderen Blick als die einfache Überwachung.

Welche Branchen profitieren am meisten von der Beobachtbarkeit von Daten?

Branchen mit einem hohen Bedarf an zuverlässigen Daten - wie das Finanzwesen, das Gesundheitswesen, der elektronische Handel und die Logistik - profitieren erheblich von der Beobachtbarkeit der Daten. Diese Branchen sind für die Einhaltung von Vorschriften, die Kundenzufriedenheit und die betriebliche Effizienz in hohem Maße auf genaue und zeitnahe Daten angewiesen.

Wie gehen Tools für die Datenbeobachtung mit Echtzeit- und Batch-Datenpipelines um?

Tools zur Datenbeobachtung können sowohl Echtzeit- als auch Batch-Pipelines überwachen. Für Echtzeitdaten verfolgen sie Lernpfade wie Latenz, Durchsatz und Anomalien, sobald sie auftreten. Bei Batch-Pipelines stellen sie die Vollständigkeit der Daten sicher, überprüfen die Schemakonformität und kontrollieren nach jedem Lauf auf Anomalien.

Was sind die Herausforderungen bei der Umsetzung der Datenbeobachtung?

Zu den häufigsten Herausforderungen gehören die Auswahl der richtigen Tools für deinen Datenstapel, die Abstimmung der Beobachtungspraktiken mit den Geschäftszielen und die Bewältigung des zusätzlichen Aufwands für die Überwachung komplexer Pipelines. Die Zustimmung des Teams und die Zuweisung von Ressourcen für die Einrichtung und Wartung sind ebenfalls entscheidend für eine erfolgreiche Umsetzung.