Programa

As empresas dependem de dados precisos para tomar decisões - ou, pelo menos, deveriam. Uma falha no pipeline de dados ou dados não confiáveis podem interromper significativamente os processos organizacionais.

Imagine este cenário:

Uma equipe de marketing usa dados de clientes para criar anúncios direcionados, mas, devido a um problema de dados não percebido, informações desatualizadas ou incorretas são enviadas, talvez até para as pessoas erradas.

O erro pode passar despercebido até que os clientes comecem a registrar reclamações. A essa altura, já é tarde demais. O dano já está feito - tempo e dinheiro já foram desperdiçados, e provavelmente serão necessários ainda mais recursos para lidar com as consequências.

A observabilidade dos dados busca evitar que isso aconteça. Neste artigo, discutiremos como você pode fazer isso. Vamos lá!

O que é observabilidade de dados?

A observabilidade dos dados refere-se à capacidade de monitorar e entender a integridade dos seus dados à medida que eles passam por pipelines e sistemas. Seu principal objetivo é garantir que os dados permaneçam precisos, consistentes e confiáveis, para que possíveis problemas possam ser detectados e resolvidos antes que causem problemas maiores.

Por exemplo, se você faz parte da equipe de vendas e depende de relatórios diários para acompanhar o desempenho e determinar as próximas etapas, qualquer problema com os dados que alimentam esses relatórios pode prejudicar toda a sua estratégia. A observabilidade dos dados permite que você detecte esses problemas em tempo real, corrija-os e mantenha as coisas funcionando sem problemas.

Portanto, em sua essência, a observabilidade dos dados é o monitoramento dos seus dados à medida que eles passam por diferentes sistemas para garantir que sejam precisos e fluam conforme o esperado. Tudo o que você está fazendo é identificar quaisquer problemas antes que eles influenciem decisões críticas.

Especificamente, a observabilidade dos dados ajuda:

- Manter a qualidade dos dados: Detecte automaticamente dados ausentes ou imprecisos, permitindo que as equipes corrijam os problemas antes que eles levem a decisões erradas.

- Evite o tempo de inatividade dos dados: Monitore os pipelines em busca de anomalias (por exemplo, quedas no volume, esquemas quebrados) e alerte as equipes antes que as interrupções aumentem.

- Governança e conformidade: Identifique a qualidade dos dados ou as violações de segurança, ajudando a atender às normas de privacidade, como o GDPR ou a CCPA.

- Crie confiança nos dados: Fornecer transparência sobre como os dados são coletados, processados e gerenciados, promovendo a confiança na tomada de decisões.

Torne-se um engenheiro de dados

Os pilares da observabilidade dos dados

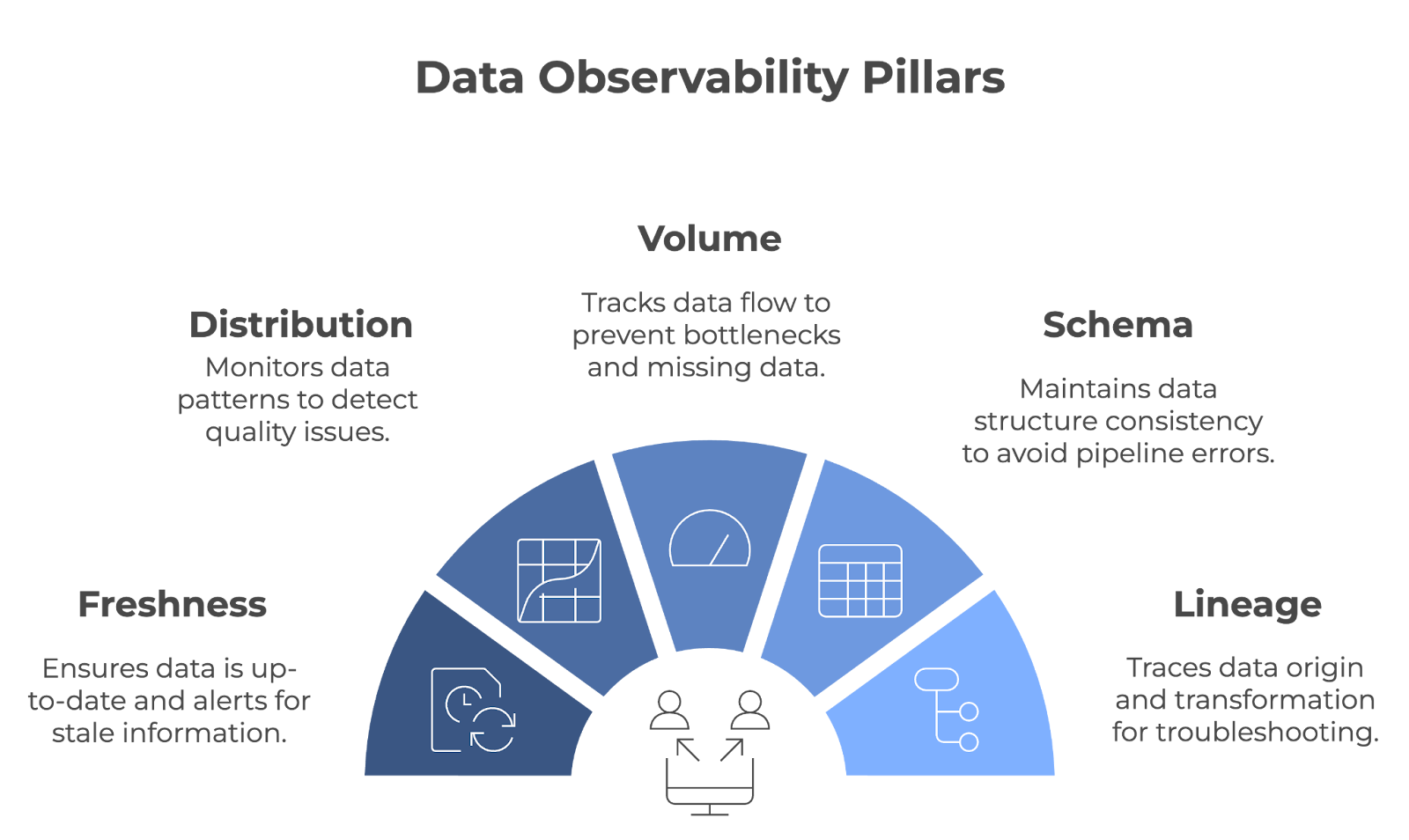

A observabilidade dos dados é construída sobre cinco pilares principais: Frescor, distribuição, volume, esquema e linhagem. Juntos, esses pilares garantem que os pipelines de dados funcionem sem problemas e que os dados permaneçam precisos, completos e confiáveis.

Os cinco pilares da observabilidade dos dados. Imagem do autor (criada com napkin.ai)

Vamos examinar cada pilar em detalhes!

Frescor

O frescor informa a você o quanto seus dados estão atualizados. Ele rastreia quando os dados foram atualizados pela última vez e alerta você se eles se tornarem obsoletos. Esse pilar é importante para as equipes que dependem de dados em tempo real ou quase em tempo real para tomar decisões.

- Exemplo: Imagine um varejista ajustando os níveis de estoque com base em dados de vendas em tempo real. Se esses dados não forem atualizados a tempo, a empresa pode acabar com um estoque excessivo ou insuficiente. O frescor ajuda a evitar isso, garantindo que as decisões sejam baseadas nas informações mais recentes.

Distribuição

A distribuição refere-se ao rastreamento dos padrões e valores específicos em seus dados (por exemplo, média, mediana, desvio padrão, etc.). O monitoramento desses valores ajuda a identificar quando algo parece errado, o que pode ser um sinal de problemas de qualidade de dados. Verificações regulares de distribuição garantem que os dados permaneçam consistentes ao longo do tempo.

- Exemplo: Uma plataforma on-line provavelmente analisaria as métricas de envolvimento do cliente. Para verificar a consistência, eles podem monitorar as distribuições de dados para métricas como duração da sessão, taxas de conversão, etc. Um pico ou queda repentina nessas métricas pode indicar problemas com o processo de coleta de dados ou um erro de sistema subjacente.

Volume

O volume de dados refere-se à quantidade de dados que flui por um sistema. Essa métrica é rastreada para garantir que a quantidade esperada de dados esteja sendo ingerida e processada sem quedas ou picos inesperados. O volume de dados é monitorado para detectar rapidamente problemas como dados ausentes ou gargalos no pipeline.

- Exemplo: Uma empresa de logística que depende de dados de GPS de uma frota de veículos monitoraria o volume de dados de localização que está sendo transmitido. Se o volume de dados cair inesperadamente, isso pode indicar falhas de comunicação com determinados veículos, resultando em lacunas no rastreamento.

Esquema

A observabilidade do esquema rastreia a estrutura dos dados - é importante que ela permaneça consistente ao longo do tempo. Quando o esquema muda inesperadamente, isso pode interromper os pipelines de dados e levar a erros no processamento.

- Exemplo: Imagine que sua equipe de marketing segmenta os clientes por idade e local. Para evitar que o pipeline de dados seja interrompido, sua equipe precisa garantir que as alterações no esquema (por exemplo, renomear colunas, alterar tipos de dados etc.) não causem erros no sistema de relatórios. Qualquer mudança despercebida pode levar a uma segmentação falha do cliente.

Linhagem

Lineage provides uma visão clara de onde seus dados vêm, como são transformados e onde terminam. Isso é fundamental para solucionar problemas e manter a qualidade dos dados em sistemas complexos. Quando surgem problemas, a linhagem permite que você rastreie os pontos de dados no pipeline para encontrar a origem do problema.

- Exemplo: Em um banco, a linhagem de dados pode ser usada para rastrear um ponto de dados específico, como o saldo de uma conta, até sua origem. Se surgirem discrepâncias, a linhagem permite que os engenheiros de dados identifiquem em que ponto do pipeline ocorreu o problema.

Como funciona a observabilidade dos dados

Ao longo deste artigo, fizemos alusão à observabilidade dos dados, monitorando ativamente os pipelines de dados, enviando alertas quando surgem problemas e ajudando as equipes a encontrar rapidamente a causa raiz dos problemas.

Vamos explorar como cada componente funciona na prática!

Monitoramento de pipelines de dados

As ferramentas de observabilidade de dados detectam erros por meio do monitoramento constante dos pipelines de dados. Eles podem rastrear muitos aspectos de um pipeline de dados, mas normalmente são configurados para se concentrar em métricas específicas ou nas áreas mais importantes para as necessidades da organização.

Essas ferramentas geralmente se integram a tecnologias como Apache Kafka, Apache Airflow ou serviços baseados em nuvem, como AWS Glue ou Google Cloud Dataflow, para coletar insights em vários estágios do pipeline. Por exemplo:

- Validação do esquema: Ferramentas como o Great Expectations podem aplicar regras de esquema, garantindo que os dados recebidos sigam os formatos predefinidos (por exemplo, tipos de dados, presença de colunas e restrições de comprimento).

- Detecção de anomalias: Plataformas como a Monte Carlo ou a Databand.ai usam o aprendizado de máquina para identificar padrões incomuns no volume de dados, nos tempos de processamento ou nas distribuições que podem indicar um problema.

- Rastreamento de linhagem: Ferramentas como o OpenLineage ou o Apache Atlas visualizam como os dados fluem pelos sistemas, facilitando o rastreamento do impacto de alterações ou erros.

Alertas e automação

Qual é a vantagem de detectar problemas rapidamente se ninguém for informado? As ferramentas de observabilidade de dados alertam automaticamente as pessoas certas e, às vezes, tomam medidas com base em configurações predefinidas.

Esses alertas geralmente são configurados com base em limites ou acionadores, como registros ausentes, alterações de esquema ou atrasos inesperados nos dados. Por exemplo:

- Se um pipeline no Apache Airflow falhar, uma ferramenta de observabilidade poderá detectar uma queda repentina no volume de dados e notificar automaticamente a equipe de engenharia de dados via Slack.

- Algumas plataformas, como Datafold ou Soda, oferecem opções de correção automatizadas. Por exemplo, um sistema pode reverter um conjunto de dados para seu último estado verificado ou redirecionar os dados recebidos para um local de armazenamento de backup usando ferramentas de nuvem como o AWS Lambda.

Análise de causa raiz

A análise de causa raiz é um processo sistemático para identificar o motivo fundamental por trás de um problema ou questão. No contexto da observabilidade dos dados, isso envolve o rastreamento de um problema de dados até a sua origem, em vez de apenas abordar seus sintomas.

As plataformas de observabilidade de dados geralmente oferecem recursos avançados de diagnóstico, integrando-se a sistemas de gerenciamento de logs, como o Elasticsearch, ou a plataformas de monitoramento, como o Prometheus e o Grafana, para exibir detalhes granulares. Por exemplo:

- Uma ferramenta pode rastrear uma transformação com falha no dbt até uma incompatibilidade de esquema em um banco de dados de origem.

- Ao analisar os dados de linhagem, a plataforma pode destacar quais relatórios ou painéis downstream foram afetados, permitindo que as equipes priorizem as correções adequadamente.

Ferramentas para observabilidade de dados

Em geral, os engenheiros de dados implementam recursos de observabilidade internamente. No entanto, há várias ferramentas poderosas disponíveis atualmente que permitem que as equipes implementem a observabilidade de dados pronta para uso de forma eficaz. Vamos dar uma olhada nos mais populares!

Monte Carlo

O Monte Carlo é uma poderosa plataforma de observabilidade de dados projetada para ajudar as equipes a manter a integridade de seus sistemas de dados. Criada por uma equipe de ex-engenheiros de empresas como LinkedIn e Facebook, a plataforma foi construída a partir do desejo de solucionar o crescente desafio do tempo de inatividade dos dados. Ele fornece:

- Verificações automatizadas da qualidade dos dados: Rastreia alterações de esquema, atualização, volume e distribuição para detectar anomalias.

- Análise de causa raiz: Ajuda as equipes a identificar a origem dos problemas, como pipelines quebrados ou dados ausentes.

- Linhagem de dados de ponta a ponta: Visualiza o fluxo de dados para que você entenda o impacto das alterações ou interrupções.

O Monte Carlo se integra a ferramentas como Snowflake, dbt e Looker, tornando-o ideal para equipes que trabalham em ecossistemas de dados modernos.

Olho grande

A Bigeye foi fundada em 2020 por um grupo de engenheiros de dados. É uma plataforma de observabilidade de dados projetada para manter a qualidade e a confiabilidade dos dados durante todo o seu ciclo de vida.

A plataforma se concentra na automação do monitoramento da qualidade dos dados, na detecção de anomalias e na resolução de problemas de dados para manter os pipelines de dados fluindo sem problemas e garantir que as partes interessadas possam confiar em dados precisos para a tomada de decisões. Seus recursos incluem:

- Monitoramento personalizável: Permite que as equipes definam limites específicos para métricas como integridade, atualização e precisão dos dados.

- Detecção de anomalias: Usa o aprendizado de máquina para identificar exceções ou alterações inesperadas nos dados.

- Ferramentas de colaboração: Fornece alertas e relatórios que se integram ao Slack e ao Jira para agilizar a resolução de problemas.

Banda de dados

O Databand é uma plataforma de observabilidade de dados para gerenciar proativamente a integridade dos dados, fornecendo visibilidade dos pipelines de dados. Fundada em 2019, a Databand foi criada para lidar com a crescente complexidade e escala do ambiente de dados.

A plataforma foi criada para ajudar os engenheiros de dados a detectar problemas em tempo real, entender o fluxo de dados e garantir a precisão dos conjuntos de dados em toda a organização. Seus recursos são:

- Monitoramento de dutos: Rastreia métricas como tempo de execução, volume de dados e erros em ferramentas como Apache Airflow e Spark.

- Análise do impacto dos dados: Destaca as dependências downstream para priorizar as correções críticas.

- Recursos de integração: Trabalha com plataformas como BigQuery, Kafka e Kubernetes para proporcionar visibilidade de ponta a ponta.

Datadog

O Datadog é uma plataforma de monitoramento e análise baseada em nuvem que oferece observabilidade em tempo real. Fundada em 2010 por Olivier Pomel e Alexis Lê-Quôc, a Datadog foi criada para lidar com a complexidade dos aplicativos modernos em nuvem.

O Datadog é ideal para empresas que precisam de monitoramento abrangente em vários sistemas. A plataforma é especialmente útil para empresas nativas da nuvem ou com sistemas complexos e distribuídos. Seus recursos incluem:

- Monitoramento unificado: Rastreia métricas, logs e traços em aplicativos, infraestrutura e pipelines de dados.

- Alerta em tempo real: Envia notificações personalizáveis por e-mail, Slack ou PagerDuty.

- Ecossistema de integração: Oferece suporte a mais de 500 integrações, incluindo AWS, Google Cloud e Docker.

Comparação de ferramentas de observabilidade de dados

|

Ferramenta |

Áreas de foco |

Integrações |

Ideal para |

|

Monte Carlo |

Qualidade de dados, detecção de anomalias, linhagem de dados |

Snowflake, dbt, Looker |

Ecossistemas de dados modernos que precisam de observabilidade automatizada |

|

Olho grande |

Monitoramento da qualidade dos dados, detecção de anomalias, interface de usuário amigável |

Slack, Jira, grandes lagos de dados e armazéns |

Setores com grandes necessidades de confiabilidade de dados (por exemplo, finanças, saúde) |

|

Banda de dados |

Monitoramento de pipeline, análise de impacto de dados, alertas em tempo real |

Apache Airflow, Spark, BigQuery, Kafka |

Equipes que gerenciam fluxos de dados complexos e de grande volume |

|

Datadog |

Monitoramento unificado, alertas em tempo real, suporte nativo da nuvem |

AWS, Google Cloud, Docker, Kubernetes |

Empresas com sistemas distribuídos ou configurações nativas da nuvem |

Práticas recomendadas para implementar a observabilidade de dados

Para implementar efetivamente a observabilidade dos dados, concentre-se nestas práticas recomendadas:

Comece com pipelines de alto impacto

Concentre-se em monitorar primeiro os pipelines de dados mais críticos - aqueles com o impacto comercial mais significativo. Você pode reduzir o risco certificando-se de que esses pipelines estejam saudáveis e, ao mesmo tempo, criando gradualmente uma estratégia de observabilidade mais ampla em outros pipelines.

Definir métricas e KPIs claros

Métricas claramente definidas são fundamentais para avaliar a integridade dos dados - você precisa saber o que é sucesso (e fracasso). Essas métricas devem estar alinhadas com as metas gerais da empresa para refletir o que realmente importa. Essa clareza ajudará você a manter o foco e a avaliar o progresso deles de forma eficaz.

Automatize o monitoramento da qualidade dos dados

Os sistemas de monitoramento e alerta reduzem a intervenção manual e melhoram os tempos de resposta. Os sistemas automatizados podem detectar problemas antecipadamente e acionar ações imediatas para evitar o tempo de inatividade dos dados. Faça da automação uma prioridade.

Integrar a observabilidade aos processos existentes

A incorporação da observabilidade em seus processos diários permite que você responda de forma mais rápida e eficaz, tornando o gerenciamento de dados mais proativo e menos reativo.

Conclusão

A observabilidade dos dados é fundamental para a criação de pipelines de dados confiáveis e de alta qualidade. Ao monitorar continuamente os aspectos críticos dos dados, as equipes podem identificar e resolver problemas antes que eles afetem os resultados comerciais. Como os dados continuam a orientar as decisões de negócios, a observabilidade continuará sendo um elemento essencial para gerenciar e otimizar os pipelines de dados.

Para compreender totalmente a importância da observabilidade e implementá-la de forma eficaz, é necessário entender conceitos relacionados, como arquitetura de dados, governança e gerenciamento. Se você deseja aprofundar seu conhecimento:

- Ao entender a arquitetura de dados moderna, você terá insights sobre como os dados são estruturados e gerenciados nas organizações.

- Explore os conceitos de governança de dados para entender como as políticas e os processos garantem a qualidade, a segurança e a conformidade dos dados.

- Aprenda sobre os princípios mais amplos de gerenciamento de dados de forma eficaz com o Data Management Concepts.

Por fim, se você é novo na área, Understanding Data Engineering é um ótimo ponto de partida para explorar como os pipelines de dados são projetados e mantidos!

Torne-se um engenheiro de dados

Perguntas frequentes

Qual é a diferença entre observabilidade de dados e monitoramento de dados?

O monitoramento de dados concentra-se no rastreamento de métricas ou sistemas específicos, enquanto a observabilidade dos dados oferece a você uma compreensão mais profunda de como os dados se comportam em todo o seu ciclo de vida. Ou seja, a observabilidade dos dados fornece insights sobre a causa raiz dos problemas dos dados, oferecendo assim uma visão mais abrangente do que o simples monitoramento.

Quais setores se beneficiam mais da observabilidade dos dados?

Os setores com alta necessidade de confiabilidade de dados, como finanças, saúde, comércio eletrônico e logística, beneficiam-se significativamente da observabilidade dos dados. Esses setores dependem muito de dados precisos e oportunos para conformidade, satisfação do cliente e eficiência operacional.

Como as ferramentas de observabilidade de dados lidam com pipelines de dados em tempo real e em lote?

As ferramentas de observabilidade de dados podem monitorar pipelines em tempo real e em lote. Para dados em tempo real, eles rastreiam métricas como latência, taxa de transferência e anomalias à medida que elas ocorrem. Para pipelines em lote, eles garantem a integridade dos dados, validam a conformidade do esquema e verificam se há anomalias após cada execução.

Quais são alguns desafios na implementação da observabilidade dos dados?

Alguns desafios comuns incluem a seleção das ferramentas certas para sua pilha de dados, o alinhamento das práticas de observabilidade com as metas comerciais e o gerenciamento da sobrecarga adicional do monitoramento de pipelines complexos. Garantir a adesão da equipe e alocar recursos para a configuração e a manutenção também são essenciais para uma implementação bem-sucedida.