Cursus

Les entreprises dépendent de données précises pour prendre des décisions - ou du moins, elles le devraient. Un pipeline de données défaillant ou des données non fiables peuvent perturber considérablement les processus organisationnels.

Imaginez ce scénario :

Une équipe de marketing utilise les données des clients pour créer des publicités ciblées, mais en raison d'un problème de données passé inaperçu, des informations obsolètes ou incorrectes sont envoyées, peut-être même aux mauvaises personnes.

L'erreur peut passer inaperçue jusqu'à ce que les clients commencent à déposer des plaintes. Il est alors trop tard. Le mal est fait - du temps et de l'argent ont déjà été gaspillés, et des ressources encore plus importantes seront probablement nécessaires pour faire face aux retombées.

L'observabilité des données vise à empêcher cela. Dans cet article, nous allons voir comment. Allons-y !

Qu'est-ce que l'observabilité des données ?

L'observabilité des données fait référence à la capacité de surveiller et de comprendre l'état de vos données au fur et à mesure qu'elles transitent par les pipelines et les systèmes. Son objectif principal est de garantir que les données restent précises, cohérentes et fiables, afin que les problèmes potentiels puissent être détectés et résolus avant qu'ils n'entraînent des problèmes plus importants.

Par exemple, si vous faites partie de l'équipe de vente et que vous vous appuyez sur des rapports quotidiens pour suivre les performances et déterminer les prochaines étapes, tout problème concernant les données qui alimentent ces rapports pourrait remettre en cause l'ensemble de votre stratégie. L'observabilité des données vous permet de détecter ces problèmes en temps réel, de les résoudre et d'assurer le bon déroulement des opérations.

Ainsi, à la base, l'observabilité des données consiste à surveiller vos données lorsqu'elles passent par différents systèmes afin de s'assurer qu'elles sont exactes et qu'elles circulent comme prévu. Tout ce que vous faites, c'est repérer les problèmes avant qu'ils n'influencent des décisions cruciales.

En particulier, l'observabilité des données est utile :

- Maintenir la qualité des données: Détectez automatiquement les données manquantes ou inexactes, ce qui permet aux équipes de résoudre les problèmes avant qu'ils ne conduisent à de mauvaises décisions.

- Prévenez l'indisponibilité des données: Surveillez les pipelines pour détecter les anomalies (par exemple, les baisses de volume, les schémas défectueux) et alertez les équipes avant que les perturbations ne s'aggravent.

- Gouvernance et conformité: Identifiez la qualité des données ou les failles de sécurité, ce qui vous aide à respecter les réglementations en matière de protection de la vie privée telles que le GDPR ou le CCPA.

- Renforcez la confiance dans les données: Fournir une transparence sur la manière dont les données sont collectées, traitées et gérées, afin de renforcer la confiance dans la prise de décision.

Devenez ingénieur en données

Les piliers de l'observabilité des données

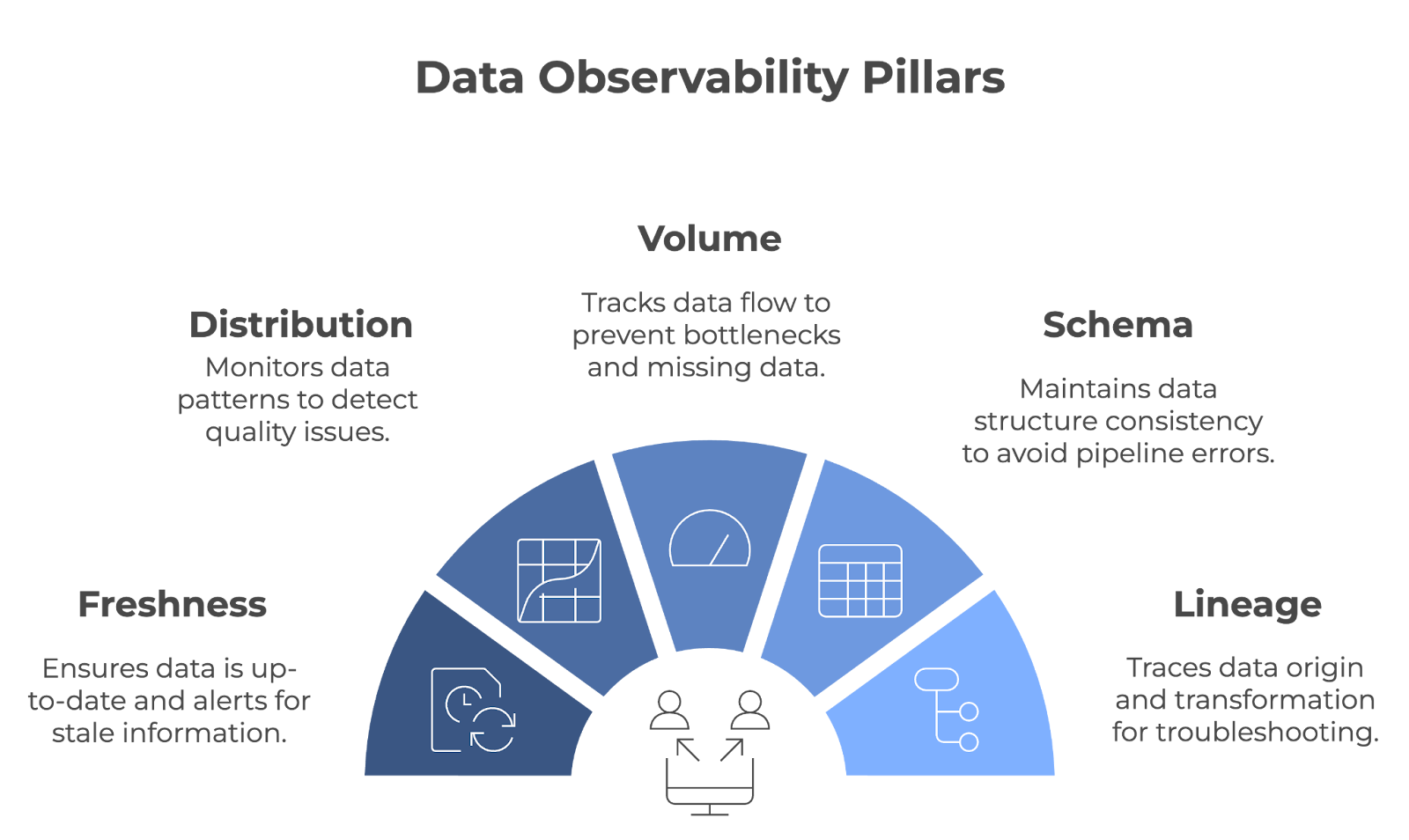

L'observabilité des données repose sur cinq piliers essentiels : Fraîcheur, distribution, volume, schéma et lignée. Ensemble, ces piliers garantissent le bon fonctionnement des pipelines de données et l'exactitude, l'exhaustivité et la fiabilité des données.

Les cinq piliers de l'observabilité des données. Image par l'auteur (créée avec napkin.ai)

Examinons chaque pilier en détail !

Fraîcheur

La fraîcheur vous indique dans quelle mesure vos données sont à jour. Il cursus la date de la dernière mise à jour des données et vous alerte si elles deviennent périmées. Ce pilier est important pour les équipes qui s'appuient sur des données en temps réel ou quasi réel pour prendre des décisions.

- Exemple : Imaginez un détaillant qui ajuste ses niveaux de stocks en fonction des données de vente en temps réel. Si ces données ne sont pas mises à jour à temps, l'entreprise peut se retrouver avec un stock trop important ou trop faible. La fraîcheur permet d'éviter cela en s'assurant que les décisions sont basées sur les informations les plus récentes.

Distribution

La distribution fait référence au cursus et aux valeurs spécifiques de vos données (par exemple, la moyenne, la médiane, l'écart type, etc.). Le contrôle de ces valeurs permet de repérer les anomalies, qui peuvent être le signe de problèmes de qualité des données. Des contrôles réguliers de la distribution garantissent la cohérence des données dans le temps.

- Exemple : Une plateforme en ligne analyserait probablement les mesures d'engagement des clients. Pour vérifier la cohérence, ils peuvent contrôler la distribution des données pour des paramètres tels que la durée des sessions, les taux de conversion, etc. Un pic ou une chute soudaine de ces mesures peut signaler des problèmes dans le processus de collecte des données ou une erreur sous-jacente du système.

Volume

Le volume de données fait référence à la quantité de données qui circulent dans un système. Ce paramètre fait l'objet d'un cursus afin de s'assurer que la quantité de données attendue est ingérée et traitée sans baisse ni pic inattendus. Le volume de données est contrôlé afin de détecter rapidement les problèmes tels que les données manquantes ou les goulets d'étranglement dans le pipeline.

- Exemple : Une entreprise de logistique qui utilise les données GPS d'une flotte de véhicules surveillera le volume des données de localisation transmises. Si le volume de données chute de manière inattendue, cela pourrait indiquer des défaillances de communication avec certains véhicules, entraînant des lacunes dans le cursus.

Schéma

L'observabilité du schéma permet de suivre la structure des données - il est important qu'elle reste cohérente dans le temps. Lorsque votre schéma change de manière inattendue, cela peut perturber vos pipelines de données et entraîner des erreurs de traitement.

- Exemple : Imaginez que votre équipe de marketing segmente les clients en fonction de leur âge et de leur localisation. Pour éviter que votre pipeline de données ne s'interrompe, votre équipe doit s'assurer que les modifications apportées au schéma (par exemple, renommer les colonnes, modifier les types de données, etc.) ne provoquent pas d'erreurs dans leur système de reporting. Tout changement passé inaperçu peut entraîner une segmentation erronée de la clientèle.

Lignée

Lineage provides une vision claire de l'origine de vos données, de leur transformation et de leur destination finale. Il s'agit d'un élément clé pour le dépannage et le maintien de la qualité des données dans des systèmes complexes. Lorsque des problèmes surviennent, le lignage vous permet de remonter les points de données à travers le pipeline pour trouver la source du problème.

- Exemple : Dans une banque, la traçabilité des données peut être utilisée pour remonter à la source d'un point de données spécifique, tel que le solde d'un compte. En cas de divergences, le lignage permet aux ingénieurs des données d'identifier l'endroit du pipeline où le problème s'est produit.

Comment fonctionne l'observabilité des données

Tout au long de cet article, nous avons fait allusion à l'observabilité des données en surveillant activement les pipelines de données, en envoyant des alertes en cas de problème et en aidant les équipes à trouver rapidement la cause première des problèmes.

Voyons comment chaque élément fonctionne en pratique !

Surveillance des pipelines de données

Les outils d'observabilité des données détectent les erreurs en surveillant constamment les pipelines de données. Ils peuvent curer de nombreux aspects d'un pipeline de données, mais sont généralement configurés pour se concentrer sur des mesures spécifiques ou sur les domaines les plus critiques pour les besoins de l'organisation.

Ces outils s'intègrent souvent à des technologies comme Apache Kafka, Apache Airflow, ou à des services basés sur le cloud comme AWS Glue ou Google Cloud Dataflow pour recueillir des informations à différentes étapes du pipeline. Par exemple :

- Validation du schéma: Des outils tels que Great Expectations peuvent appliquer des règles de schéma, garantissant que les données entrantes respectent des formats prédéfinis (par exemple, les types de données, la présence de colonnes et les restrictions de longueur).

- Détection des anomalies: Des plateformes comme Monte Carlo ou Databand.ai utilisent l'apprentissage automatique pour identifier des schémas inhabituels dans le volume de données, les temps de traitement ou les distributions qui pourraient signaler un problème.

- Suivi de la lignée cursus: Des outils tels que OpenLineage ou Apache Atlas permettent de visualiser la manière dont les données circulent dans les systèmes, ce qui facilite le suivi de l'impact des changements ou des erreurs.

Alertes et automatisation

Quel est l'intérêt de détecter rapidement les problèmes si personne n'est informé ? Les outils d'observabilité des données alertent automatiquement les bonnes personnes et prennent parfois des mesures sur la base de configurations prédéfinies.

Ces alertes sont souvent configurées en fonction de seuils ou de déclencheurs, tels que des enregistrements manquants, des modifications de schéma ou des retards de données inattendus. Par exemple :

- Si un pipeline d'Apache Airflow tombe en panne, un outil d'observabilité peut détecter une baisse soudaine du volume de données et en informer automatiquement l'équipe d'ingénierie des données via Slack.

- Certaines plateformes, comme Datafold ou Soda, proposent des options de remédiation automatisées. Par exemple, un système pourrait ramener un ensemble de données à son dernier état vérifié ou rerouter les données entrantes vers un emplacement de stockage de sauvegarde à l'aide d'outils cloud comme AWS Lambda.

Analyse des causes profondes

L'analyse des causes profondes est un processus systématique visant à identifier la raison fondamentale d'un problème ou d'une question. Dans le contexte de l'observabilité des données, il s'agit de remonter à l'origine d'un problème de données plutôt que de se contenter d'en traiter les symptômes.

Les plateformes d'observabilité des données offrent souvent de riches capacités de diagnostic, en s'intégrant à des systèmes de gestion des journaux comme Elasticsearch ou à des plateformes de surveillance comme Prometheus et Grafana pour faire apparaître des détails granulaires. Par exemple :

- Un outil peut retracer l'échec d'une transformation dans dbt en raison d'une incompatibilité de schéma dans une base de données source.

- En analysant les données d'historique, la plateforme peut mettre en évidence les rapports ou tableaux de bord en aval qui sont affectés, ce qui permet aux équipes de prioriser les correctifs en conséquence.

Outils pour l'observabilité des données

Souvent, les ingénieurs de données mettent en œuvre les fonctions d'observabilité en interne. Cependant, il existe aujourd'hui plusieurs outils puissants qui permettent aux équipes de mettre en œuvre efficacement l'observabilité des données prête à l'emploi. Jetons un coup d'œil aux plus populaires d'entre eux !

Monte Carlo

Monte Carlo est une puissante plateforme d'observabilité des données conçue pour aider les équipes à maintenir la santé de leurs systèmes de données. Créée par une équipe d'anciens ingénieurs d'entreprises telles que LinkedIn et Facebook, la plateforme est née de la volonté de résoudre le problème croissant de l'indisponibilité des données. Il prévoit :

- Contrôles automatisés de la qualité des données: Cursus des modifications de schémas, de la fraîcheur, du volume et de la distribution pour détecter les anomalies.

- Analyse des causes profondes: Aide les équipes à identifier la source des problèmes, tels que les ruptures de pipeline ou les données manquantes.

- Lignage des données de bout en bout: Visualise le flux de données pour comprendre l'impact des changements ou des perturbations.

Monte Carlo s'intègre à des outils tels que Snowflake, dbt et Looker, ce qui le rend idéal pour les équipes travaillant dans des écosystèmes de données modernes.

Bigeye

Bigeye a été fondée en 2020 par un groupe d'ingénieurs en données. Il s'agit d'une plateforme d'observabilité des données conçue pour maintenir la qualité et la fiabilité des données tout au long de leur cycle de vie.

La plateforme se concentre sur l'automatisation du contrôle de la qualité des données, la détection des anomalies et la résolution des problèmes liés aux données afin d'assurer la fluidité des flux de données et de veiller à ce que les parties prenantes puissent s'appuyer sur des données exactes pour prendre leurs décisions. Ses caractéristiques sont les suivantes :

- Surveillance personnalisable: Permet aux équipes de définir des seuils spécifiques pour des mesures telles que l'exhaustivité, la fraîcheur et l'exactitude des données.

- Détection des anomalies: Utilise l'apprentissage automatique pour identifier les valeurs aberrantes ou les changements inattendus dans les données.

- Outils de collaboration: Fournit des alertes et des rapports qui s'intègrent à Slack et Jira pour rationaliser la résolution des problèmes.

Bande de données

Databand est une plateforme d'observabilité des données qui permet de gérer de manière proactive la santé des données en offrant une visibilité sur les pipelines de données. Fondée en 2019, Databand a été créée pour répondre à la complexité et à l'échelle croissantes de l'environnement de données.

La plateforme a été conçue pour aider les ingénieurs en données à détecter les problèmes en temps réel, à comprendre le flux de données et à garantir l'exactitude des ensembles de données dans l'ensemble de l'organisation. Ses caractéristiques sont les suivantes :

- Surveillance des pipelines: Coule les métriques telles que la durée d'exécution, le volume de données et les erreurs à travers des outils comme Apache Airflow et Spark.

- Analyse de l'impact des données: Met en évidence les dépendances en aval afin de hiérarchiser les correctifs critiques.

- Capacités d'intégration: Fonctionne avec des plateformes comme BigQuery, Kafka et Kubernetes pour une visibilité de bout en bout.

Datadog

Datadog est une plateforme de surveillance et d'analyse basée sur le cloud qui offre une observabilité en temps réel. Fondée en 2010 par Olivier Pomel et Alexis Lê-Quôc, Datadog a été créée pour répondre à la complexité des applications cloud modernes.

Datadog est idéal pour les entreprises qui ont besoin d'une surveillance complète de différents systèmes. La plateforme est particulièrement utile pour les entreprises natives du cloud ou celles qui disposent de systèmes complexes et distribués. Ses caractéristiques sont les suivantes :

- Surveillance unifiée: Coule les métriques, les journaux et les traces dans les applications, l'infrastructure et les pipelines de données.

- Alerte en temps réel: Envoie des notifications personnalisées par e-mail, Slack ou PagerDuty.

- Ecosystème d'intégration: Prend en charge plus de 500 intégrations, notamment AWS, Google Cloud et Docker.

Comparaison des outils d'observabilité des données

|

Outil |

Domaines d'intervention |

Intégrations |

Idéal pour |

|

Monte Carlo |

Qualité des données, détection des anomalies, lignage des données |

Snowflake, dbt, Looker |

Les écosystèmes de données modernes ont besoin d'une observabilité automatisée |

|

Bigeye |

Contrôle de la qualité des données, détection des anomalies, interface utilisateur conviviale |

Slack, Jira, les principaux lacs de données et entrepôts. |

Industries ayant des besoins importants en matière de fiabilité des données (par exemple, finance, soins de santé) |

|

Bande de données |

Surveillance du pipeline, analyse de l'impact des données, alertes en temps réel |

Apache Airflow, Spark, BigQuery, Kafka, etc. |

Équipes gérant des flux de données complexes et volumineux |

|

Datadog |

Surveillance unifiée, alertes en temps réel, prise en charge cloud-native. |

AWS, Google Cloud, Docker, Kubernetes, etc. |

Entreprises avec des systèmes distribués ou des configurations cloud-natives. |

Bonnes pratiques pour la mise en œuvre de l'observabilité des données

Pour mettre en œuvre efficacement l'observabilité des données, concentrez-vous sur les meilleures pratiques suivantes :

Commencez par les pipelines à fort impact

Concentrez-vous d'abord sur la surveillance des pipelines de données les plus critiques, ceux dont l'impact sur l'entreprise est le plus important. Vous pouvez limiter les risques en veillant à ce que ces pipelines soient en bonne santé tout en mettant progressivement en place une stratégie d'observabilité plus large pour d'autres pipelines.

Définir des mesures et des indicateurs clés de performance clairs

Des mesures clairement définies sont essentielles pour évaluer la santé des données - vous devez savoir à quoi ressemble le succès (et l'échec). Ces mesures doivent être alignées sur les objectifs généraux de l'entreprise afin de refléter ce qui compte vraiment. Cette clarté vous aidera à rester concentré et à évaluer efficacement leurs progrès.

Automatiser le contrôle de la qualité des données

Les systèmes de surveillance et d'alerte réduisent les interventions manuelles et améliorent les temps de réponse. Les systèmes automatisés peuvent détecter les problèmes à un stade précoce et déclencher des actions immédiates pour éviter l'interruption des données. Faites de l'automatisation une priorité.

Intégrer l'observabilité dans les processus existants

L'intégration de l'observabilité dans vos processus quotidiens vous permet de réagir plus rapidement et plus efficacement, rendant ainsi la gestion des données plus proactive et moins réactive.

Conclusion

L'observabilité des données est essentielle pour créer des pipelines de données fiables et de haute qualité. En surveillant en permanence les aspects critiques des données, les équipes peuvent identifier et traiter les problèmes avant qu'ils n'aient un impact sur les résultats de l'entreprise. Alors que les données continuent de guider les décisions des entreprises, l'observabilité restera un élément essentiel de la gestion et de l'optimisation des pipelines de données.

Pour bien saisir l'importance de l'observabilité et la mettre en œuvre efficacement, il est nécessaire de comprendre des concepts connexes tels que l'architecture, la gouvernance et la gestion des données. Si vous cherchez à approfondir vos connaissances :

- Comprendre l'architecture moderne des données permet de comprendre comment les données sont structurées et gérées au sein des organisations.

- Explorez les concepts de gouvernance des données pour comprendre comment les politiques et les processus garantissent la qualité, la sécurité et la conformité des données.

- Apprenez les principes généraux de la gestion efficace des données avec Concepts de gestion des données.

Enfin, si vous êtes nouveau dans le domaine, Comprendre l'ingénierie des données est un excellent point de départ pour explorer la façon dont les pipelines de données sont conçus et maintenus !

Devenez ingénieur en données

FAQ

Quelle est la différence entre l'observabilité et la surveillance des données ?

La surveillance des données se concentre sur le cursus de métriques ou de systèmes spécifiques, tandis que l'observabilité des données vous permet de mieux comprendre le comportement des données tout au long de leur cycle de vie. En effet, l'observabilité des données permet de comprendre les causes profondes des problèmes liés aux données, offrant ainsi une vision plus complète qu'un simple contrôle.

Quels sont les secteurs qui bénéficient le plus de l'observabilité des données ?

Les secteurs qui ont des besoins importants en matière de fiabilité des données, tels que la finance, les soins de santé, le commerce électronique et la logistique, bénéficient considérablement de l'observabilité des données. Ces secteurs dépendent fortement de données précises et opportunes pour la conformité, la satisfaction des clients et l'efficacité opérationnelle.

Comment les outils d'observabilité des données gèrent-ils les pipelines de données en temps réel ou par lots ?

Les outils d'observabilité des données peuvent surveiller les pipelines en temps réel et par lots. Pour les données en temps réel, ils suivent des mesures telles que la latence, le débit et les anomalies au fur et à mesure qu'elles se produisent. Pour les pipelines de traitement par lots, ils s'assurent de l'exhaustivité des données, valident la conformité des schémas et vérifient les anomalies après chaque exécution.

Quels sont les défis liés à la mise en œuvre de l'observabilité des données ?

Parmi les défis les plus courants, citons le choix des bons outils pour votre pile de données, l'alignement des pratiques d'observabilité sur les objectifs de l'entreprise et la gestion des frais généraux supplémentaires liés à la surveillance de pipelines complexes. L'adhésion de l'équipe et l'allocation de ressources pour l'installation et la maintenance sont également essentielles pour une mise en œuvre réussie.