programa

Google acaba de lanzar Gemini 2.5 Prosu modelo de razonamiento más capaz hasta la fecha y el primero de la familia Gemini 2.5.

En mi opinión, su mayor punto fuerte es la enorme ventana de contexto de 1 millón de fichas, con planes para ampliarla a 2 millones. Combinar un modelo de razonamiento con tanto contexto abre un verdadero valor empresarial, sobre todo teniendo en cuenta lo limitada que es todavía la adopción de la IA en la mayoría de las empresas.

Para poner las cosas en perspectiva: El o3-mini de OpenAI admite 200.000 tokens, el Sonnet de Claude 3.7 también tiene un tope de 200.000, el DeepSeek R1 tiene un máximo de 128.000 y el Grok 3 es el único modelo que iguala actualmente al Gemini con 1 millón.

Dado que uno de los casos de uso más comunes de la IA es la generación de código, un modelo que pueda razonar a través del código y leer una gran base de código en una sola pasada, sin necesidad de RAG, puede aportar un valor empresarial significativo. Ya mostramos en un blog anterior cómo procesar documentos grandes sin RAG utilizando Géminis 2.0 Flash.

En este post, te explicaré lo que ofrece Gemini 2.5 Pro, los tipos de entradas que admite y cómo acceder a él. También realizaré algunas pruebas prácticas y veré cómo se compara en puntos de referencia clave con Claude, DeepSeek, Grok y los últimos modelos de OpenAI.

Perfeccionamiento en IA para principiantes

¿Qué es Gemini 2.5 Pro?

Gemini 2.5 Pro es el primer modelo de la familia Gemini 2.5 de Google. Actualmente está etiquetado como experimental y está disponible a través del plan Gemini Avanzado y Google AI Studio.

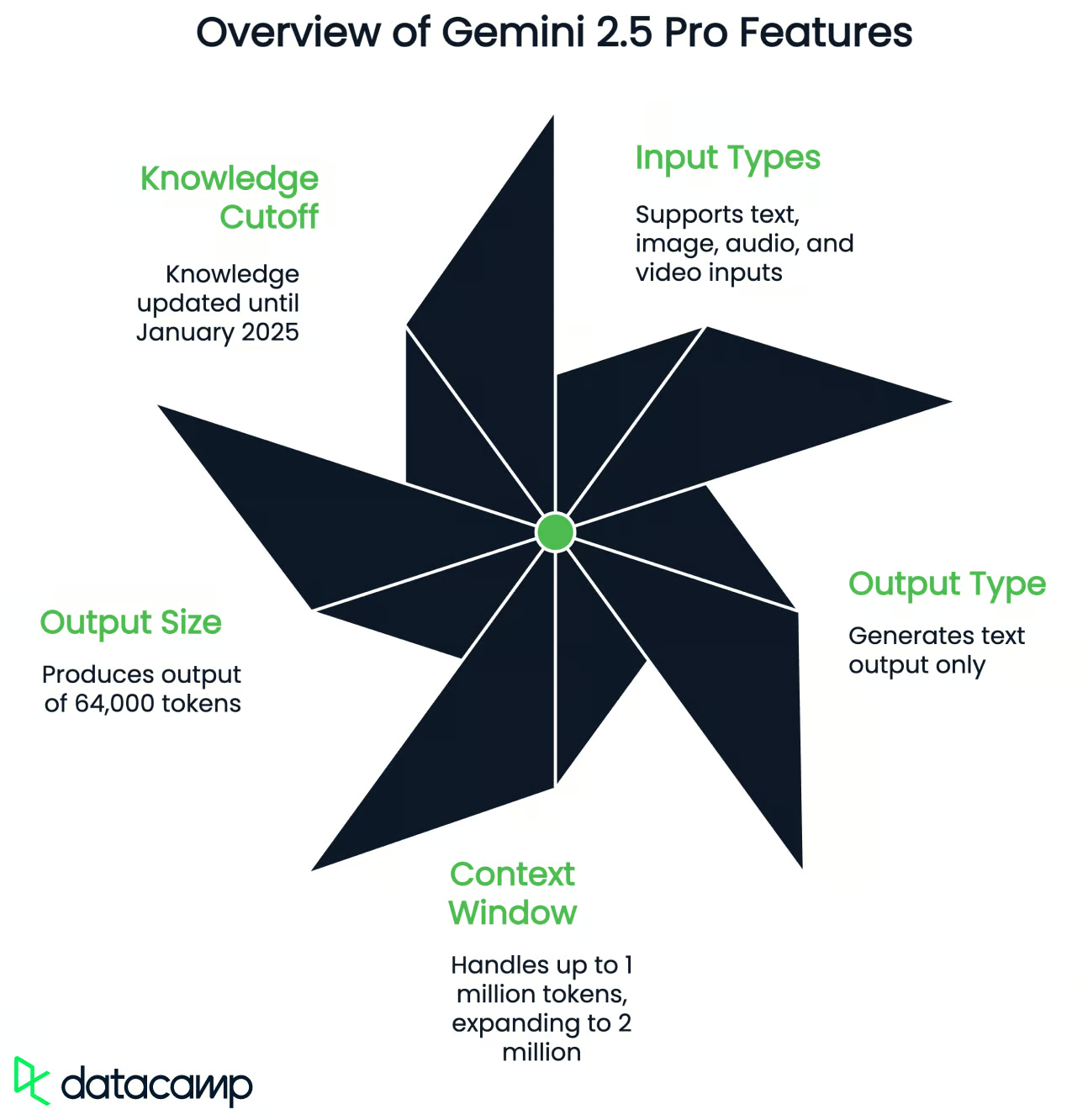

Según Google, es su mejor modelo de razonamiento hasta la fecha, con mejoras en el uso de herramientas, el manejo de entradas multimodales y el rendimiento en contextos largos. Aquí tienes un breve resumen de lo que admite:

- Tipos de entrada: Texto, imagen, audio y vídeo

- Tipo de salida: Sólo texto

- Ventana contextual: Hasta 1 millón de fichas de entrada (ampliación prevista a 2 millones)

- Tamaño de salida: 64.000 fichas

- Límite de conocimientos: Enero de 2025

Gemini 2.5 Pro admite el uso de herramientas, lo que significa que puede llamar a funciones externas, generar salidas estructuradas (como JSON), ejecutar código y utilizar la búsqueda. Esto permite que el modelo resuelva tareas de varios pasos, llame a API o formatee respuestas para sistemas descendentes específicos.

Como es un modelo de razonamiento, Géminis 2.5 Pro es especialmente fuerte en codificación, matemáticas, lógica y ciencias. Para la mayoría de las tareas cotidianas, puedes seguir utilizando un modelo generalista como Gemini 2.0 Flash, porque es mucho más rápido.

Ahora, vamos a probar Gemini 2.5 Pro para ver su rendimiento.

Probando Gemini 2.5 Pro

Juego P5js

En primer lugar, quise probar el juego del dinosaurio que Google ofrecía como ejemplo, y utilicé la misma instrucción que en vídeo de demostración (lo probé en la aplicación Géminis):

Make me a captivating endless runner game. Key instructions on the screen. p5js scene, no HTML. I like pixelated dinosaurs and interesting backgrounds.Veamos el resultado:

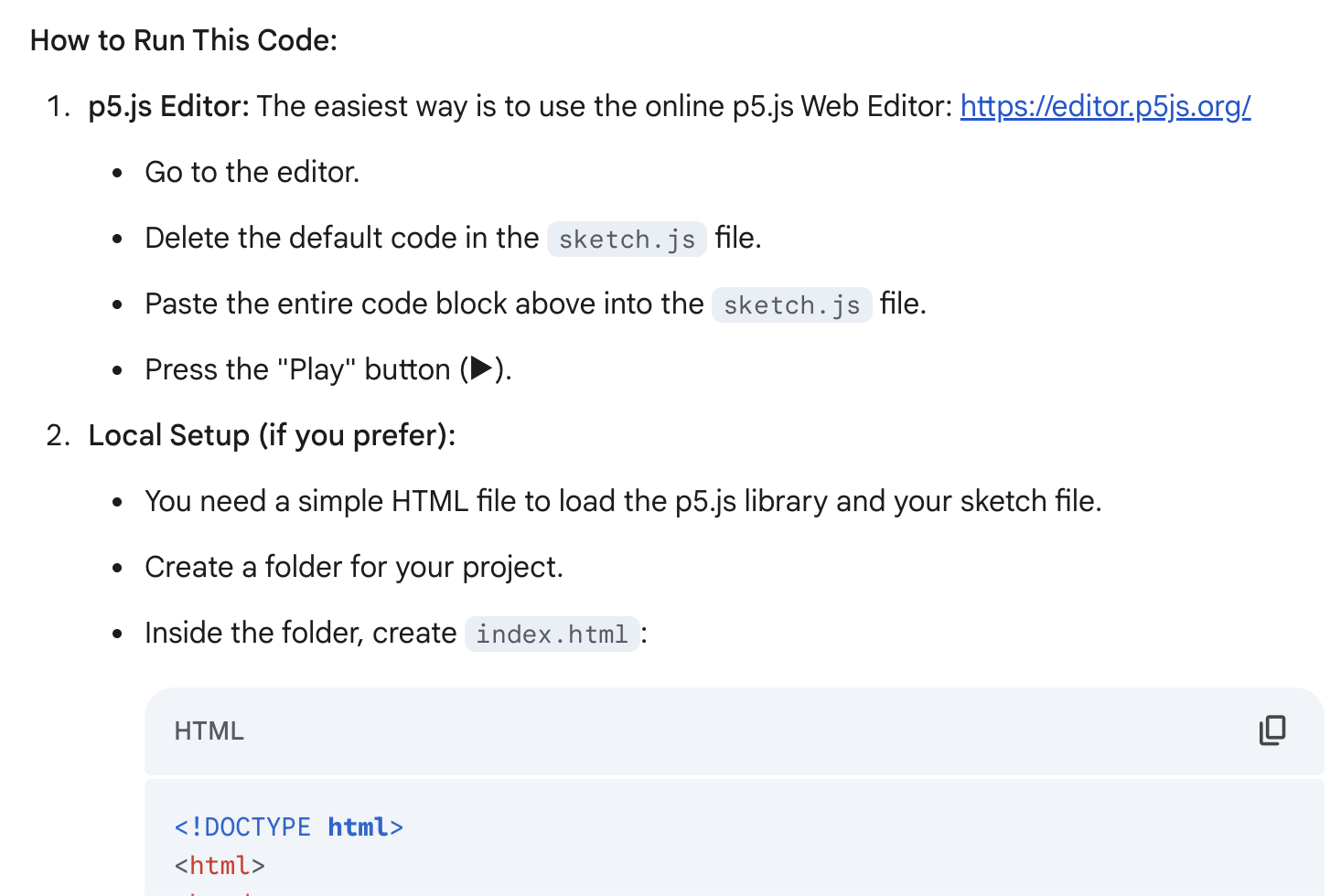

¡Eso está muy bien para un solo aviso! La generación fue rápida (menos de 30 segundos), y también me gustaron las instrucciones detalladas sobre cómo ejecutar este código: me ofrecía dos formas de ejecutarlo:

No me gustaba que el juego se iniciara inmediatamente después de ejecutar el código, así que quería cambiar esto:

I don't like that the game starts immediately after I run the code. Add a starting screen where the user can be the one who starts the game (keep instructions on the screen)Veamos el resultado:

¡Exactamente lo que quería! Todavía hay muchas cosas que cambiaría, pero el resultado es muy bueno en relación con mi esfuerzo (dos indicaciones) y mi objetivo (sólo construir un prototipo).

Entrada multimodal (vídeo y texto)

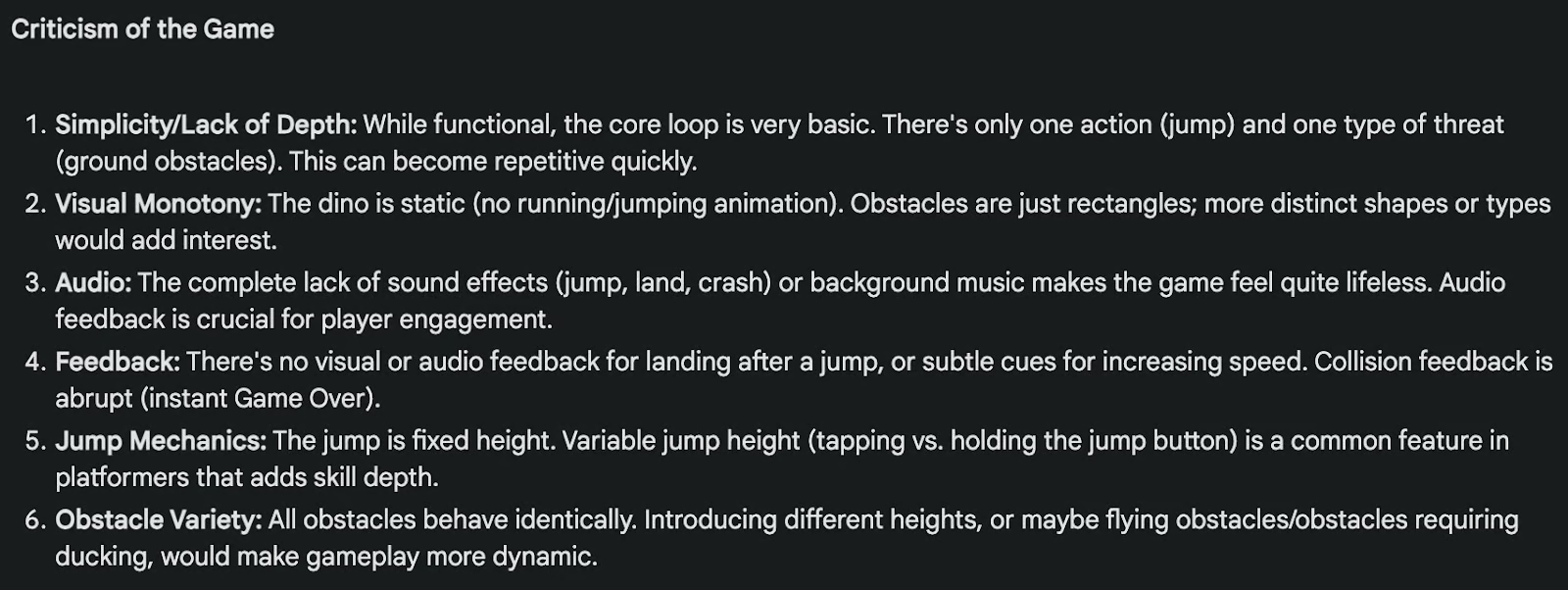

A continuación, quise probar las capacidades multimodales de Gemin 2.5 Pro. He subido el vídeo anterior con el juego y le he dado a Gemini 2.5 Pro esta indicación en Google AI Studio (no he podido añadir el vídeo como entrada en la aplicación Gemini):

Analyze the game in the video, criticize both the game and the code I will give you below, and indicate what changes I could make to this game to make it better.

Code:

(truncated fo readability)¡El resultado fue bastante bueno! Para facilitar la lectura, sólo mostraré aquí la crítica del juego, que muestra indirectamente una buena comprensión del vídeo y del código:

Procesar documentos de gran tamaño

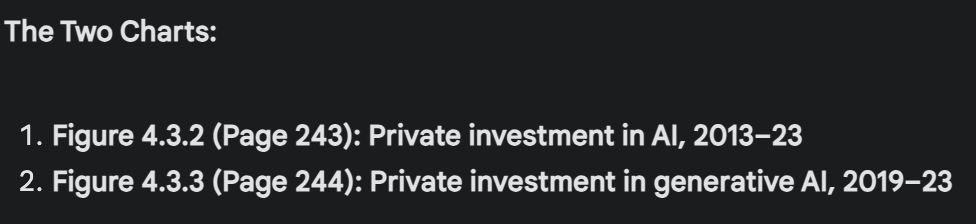

Por último, quise probar Gemini 2.5 Pro en un documento relativamente grande, y utilicé Informe del Índice de Inteligencia Artificial 2024 de Stanford. Después de subir el documento de 502 páginas (129.517 fichas), pregunté a Gemini 2.5 Pro:

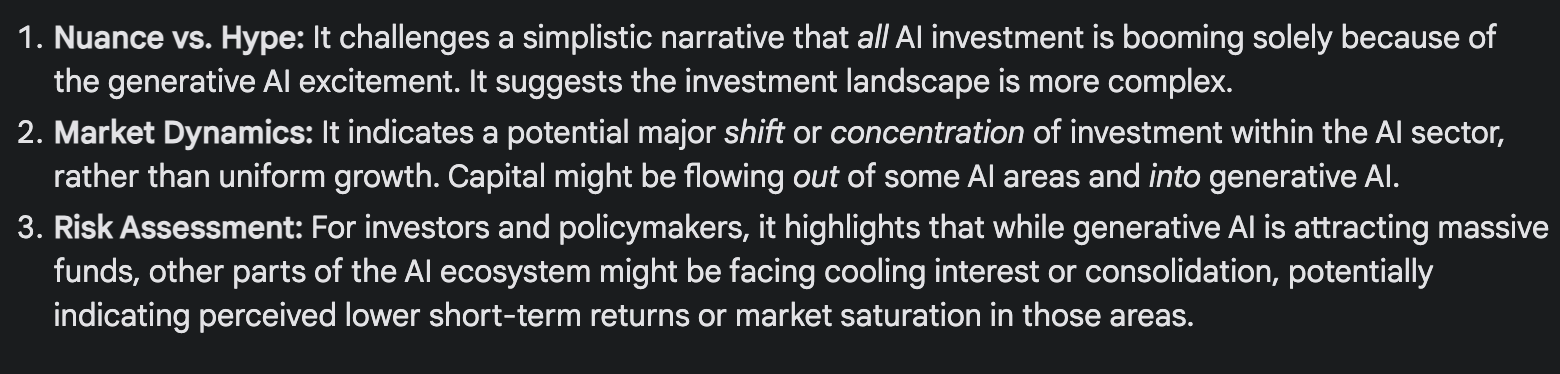

Pick two charts in this report that appear to show opposing or contradictory trends. Describe what each chart says, why the contradiction matters, and propose at least one explanation that reconciles the difference. Mention the page of the charts so I can double-check. If there's no such contradiction, don't try to artificially find one.Por alguna razón, no podía analizar directamente los gráficos dentro del documento PDF en la aplicación Géminis. Cambié a Google AI Studio y funcionó. Gemini 2.5 Pro consiguió encontrar dos gráficos relativos a la inversión en IA que muestran una tendencia contradictoria: la inversión privada en IA está bajando a pesar de que la inversión privada en IA generativa está subiendo.

Localizó perfectamente los gráficos por el número de página (tal como pedí), el número de figura y los títulos (recomiendo comprobar el PDF para comprobarlo y ver los gráficos).

Resumía muy bien la tendencia contradictoria: ¿Cómo puede estar disminuyendo la inversión privada total en IA cuando la inversión en su subcampo más publicitado y visible, la IA generativa, está explotando?

Y explicó por qué estamos viendo esta tendencia aparentemente contradictoria:

Puntos de referencia de Gemini 2.5 Pro

Google comparó Gemini 2.5 Pro con algunos de los mejores modelos disponibles en la actualidad, entre ellos Claude 3.7 Sonnet, o3-mini de OpenAI, DeepSeek R1y Grok 3. Aunque el rendimiento varía según la tarea, Gemini 2.5 Pro suele rendir bien en razonamiento, codificación, matemáticas y tareas de contexto largoks.

|

Categoría |

Punto de referencia |

Géminis 2.5 Pro |

Competidores más cercanos |

|

Razonamiento y Conocimientos Generales |

El Último Examen de la Humanidad (sin herramientas) |

18.8% |

o3-mini (14%), Claude 3.7 (8,9%), DeepSeek R1 (8,6%) |

|

GPQA Diamond (pass@1) |

84.0% |

Grok 3 Beta (80,2%), o3-mini (79,7%), Claude 3.7 Sonnet (78,2%) |

|

|

Matemáticas y Lógica |

AIME 2024 (aprobado@1) |

92.0% |

o3-mini (87,3%), Grok 3 Beta (83,9%) |

|

AIME 2025 (pass@1) |

86.7% |

o3-mini (86,5%), Grok 3 Beta (77,3%) |

|

|

Codificación |

LiveCodeBench v5 |

70.4% |

o3-mini (74,1%), Grok 3 Beta (70,6%) |

|

Aider Políglota (edición de archivos completos) |

74.0% |

— |

|

|

SWE-bench Verificado |

63.8% |

Claude 3,7 (70,3%) |

|

|

Contexto largo y multimodal |

MRCR (128K context) |

91.5% |

GPT-4,5 (48,8%), o3-mini (36,3%) |

|

MMMU (comprensión multimodal; pass@1) |

81.7% |

Grok 3 Beta (76,0%), Claude 3.7 Sonnet (75%) |

Así queurce: Google

Razonamiento y conocimientos generales

Gemini 2.5 Pro muestra un gran rendimiento en pruebas de referencia diseñadas para poner a prueba el razonamiento en varios pasos y el conocimiento del mundo real:

- El Último Examen de la Humanidad (sin herramientas): Gemini 2.5 Pro obtiene un 18,8%, por delante de o3-mini (14%) y muy por encima de Claude 3.7 (8,9%) y DeepSeek-R1 (8,6%). Esta prueba está diseñada para imitar los exámenes de nivel experto en más de 100 asignaturas.

- GPQA Diamond: Un punto de referencia fáctico de garantía de calidad en STEM y humanidades. Gemini 2.5 Pro lidera la puntuación con un 84,0% (para un solo intento/pase@1), seguido de Grok 3 Beta con un 80,2%.

Matemáticas y lógica

Estos son puntos de referencia en los que la arquitectura de razonamiento de Géminis parece brillar:

- AIME 2024: Géminis 2.5 Pro lidera con un 92,0% para intento individual/pase@1.

- AIME 2025: Gemini 2.5 Pro baja al 86,7% en el conjunto de problemas 2025, y lidera marginalmente este punto de referencia para intento único/pase@1, seguido de o3-mini (86,5%).

Codificación

En las pruebas que comprueban la generación de código, la depuración y el razonamiento multiarchivo, Géminis rinde bien, pero no domina:

- LiveCodeBench v5 (generación de código): Gemini 2.5 Pro obtiene una puntuación del 70,4%, por detrás de o3-mini (74,1%) y Grok 3 Beta (70,6%).

- Aider Políglota (archivo completo): Gemini alcanza el 74,0%, lo que es sólido, sobre todo teniendo en cuenta que maneja varios idiomas. Este punto de referencia mide la edición de código.

- SWE-bench verificado (codificación agéntica): Gemini obtiene una puntuación del 63,8%, situándose por delante de o3-mini y DeepSeek R1, pero por detrás de Claude 3.7 Sonnet (70,3%).

Tareas de contexto largo y multimodales

Aquí es donde Gemini 2.5 Pro destaca más claramente:

- MRCR (comprensión lectora en contexto largo): Gemini 2.5 Pro alcanza el 91,5% para una longitud de contexto de 128.000, y está muy por delante de o3-mini (36,3%) y GPT-4.5 (48,8%).

- MMMU (comprensión multimodal): Gemini 2.5 Pro lidera la comparativa con una puntuación del 81,7%.

Cómo acceder a Gemini 2.5 Pro

Hay varias formas de probar Gemini 2.5 Pro, dependiendo de si eres un usuario ocasional o estás construyendo algo más técnico.

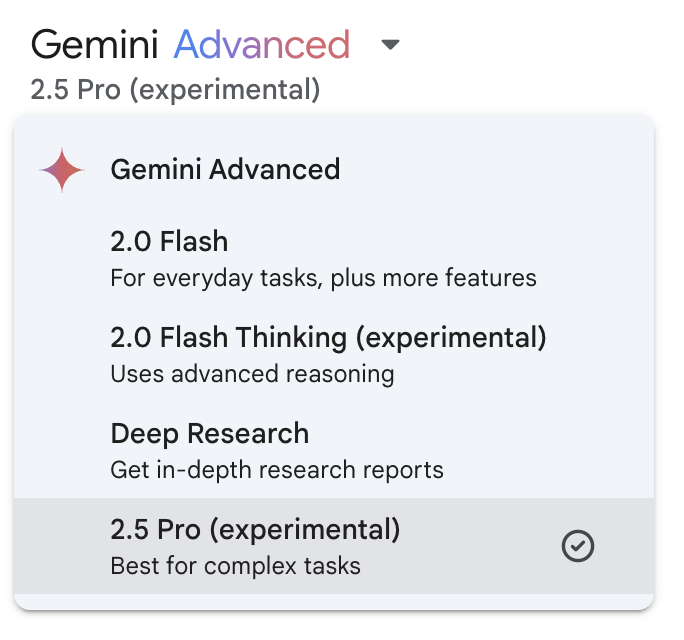

Aplicación Géminis

La forma más sencilla de acceder a Gemini 2.5 Pro es a través de la aplicación Gemini (en el móvil o en la web).

Si eres suscriptor de Gemini Advanced, verás Gemini 2.5 Pro en el menú desplegable de modelos.

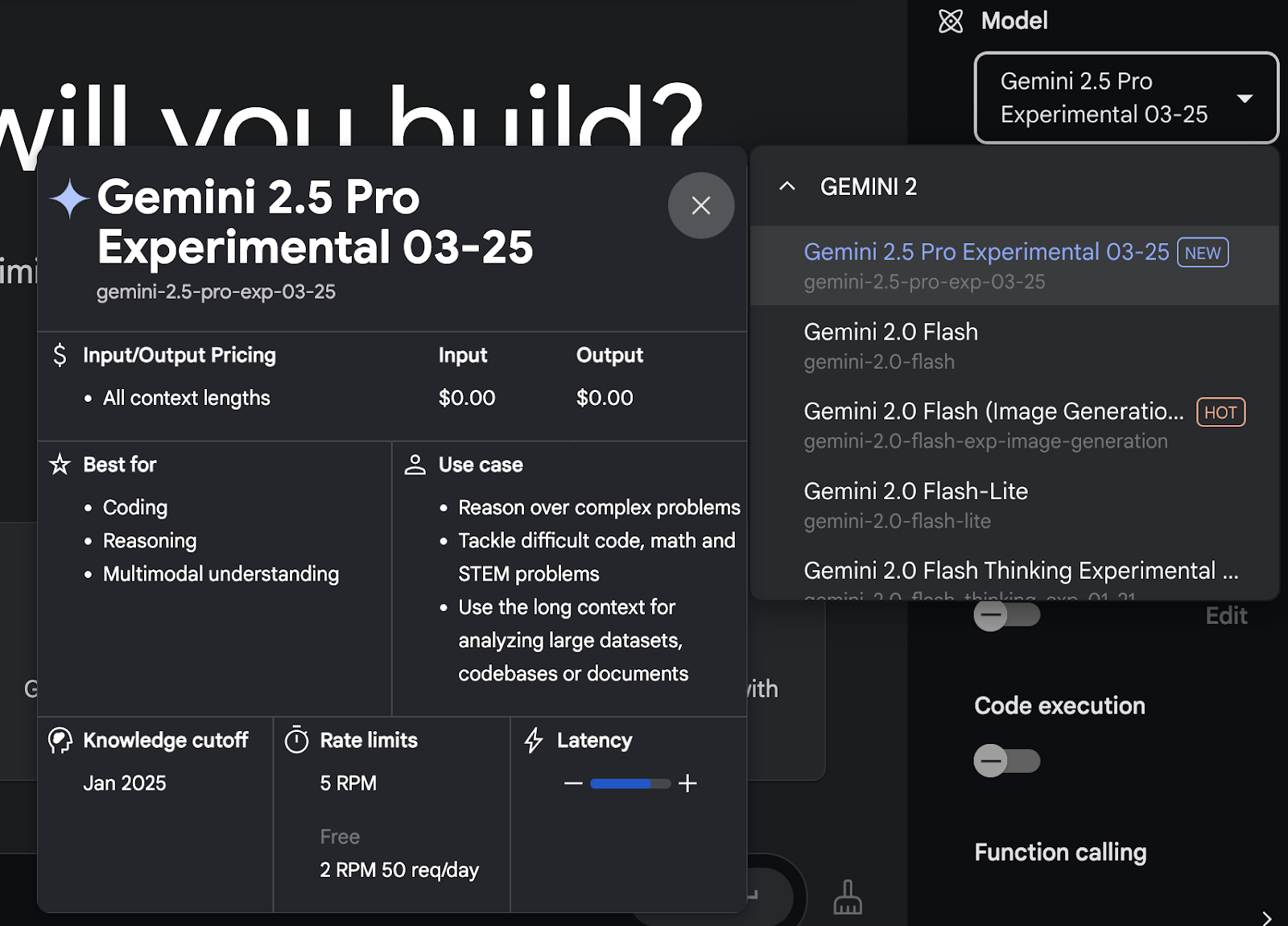

Google AI Studio

Si quieres más control sobre las entradas, el uso de herramientas o las indicaciones multimodales, te recomiendo que utilices Google AI Studio.

Este entorno te da acceso a Gemini 2.5 Pro de forma gratuita (por ahora) y admite entradas de texto, imagen, vídeo y audio. También funciona mejor que la app Géminis para subir archivos o probar el uso de herramientas, especialmente cuando se trata de documentos grandes o flujos de trabajo personalizados.

Después de crear una cuenta, puedes seleccionar Gemini 2.5 Pro en el menú desplegable de modelos.

API Gemini 2.5 Pro

Para el acceso programático, puedes utilizar la API Gemini, compatible con Gemini 2.5 Pro.

Esto te da más flexibilidad si vas a integrar el modelo en una aplicación o flujo de trabajo. Puedes llamar directamente al modelo con el uso de herramientas activado, obtener respuestas estructuradas o procesar documentos largos de forma automatizada.

Puedes encontrar más información técnica aquí.

Gemini 2.5 Pro en Vertex AI

Google dice que Gemini 2.5 Pro también estará disponible pronto en Vertex AI, que forma parte de Google Cloud. La principal diferencia entre utilizar directamente la API de Géminis y acceder a ella a través de Vertex AI está en la infraestructura, la escala y la integración.

Si sólo estás probando o creando herramientas internas, AI Studio o la API deberían ser suficientes. Si estás desplegando algo en producción con requisitos estrictos de rendimiento o seguridad, Vertex AI será la mejor opción una vez que lance la compatibilidad con Gemini 2.5 Pro.

Conclusión

Cada vez es más difícil dejarse impresionar por los lanzamientos de nuevos modelos. La mayoría de los lanzamientos siguen el mismo patrón: algunos ejemplos escogidos, algunos puntos de referencia llamativos y un montón de afirmaciones sobre ser el mejor en todo. Pero Géminis 2.5 Pro realmente me dio unos momentos en los que me detuve y pensé: "Vale, esto es realmente útil".

La ventana contextual de 1 millón de tokens cambia la forma en que puedes abordar tareas que antes requerían más trabajo, especialmente las que implican documentos largos, bases de código desordenadas o razonamientos de varios pasos. No tuve que trocear las entradas ni configurar un conducto RAG. Acabo de cargar el archivo, he formulado mi pregunta y he recibido de vuelta algo coherente y fundamentado en la fuente.

Si la ventana contextual de 2 millones de fichas se despliega pronto, eso por sí solo podría convertirlo en uno de los modelos más prácticos para el trabajo en el mundo real.

Preguntas frecuentes

¿Qué tipos de entrada admite Gemini 2.5 Pro?

Gemini 2.5 Pro admite entradas de texto, imagen, vídeo y audio.

¿Dónde puedo acceder a Gemini 2.5 Pro?

Gemini 2.5 Pro está disponible a través de Google AI Studio y para los suscriptores de Gemini Advanced mediante la aplicación Gemini.

¿Cuáles son los principales casos de uso de Gemini 2.5 Pro?

Gemini 2.5 Pro destaca en codificación, tareas de razonamiento complejas y manejo de entradas multimodales.

¿Es Gemini 2.5 Pro adecuado para aplicaciones en tiempo real?

Aunque es potente, su estado experimental aconseja precaución en las implantaciones en tiempo real hasta que se confirme una mayor estabilidad.

Soy editora y redactora de blogs, tutoriales y noticias sobre IA, y me aseguro de que todo se ajuste a una sólida estrategia de contenidos y a las mejores prácticas de SEO. He escrito cursos de ciencia de datos sobre Python, estadística, probabilidad y visualización de datos. También he publicado una novela premiada y dedico mi tiempo libre a escribir guiones y dirigir películas.