Programa

O Google acaba de lançar o Gemini 2.5 Proseu modelo de raciocínio mais capaz até o momento e o primeiro da família Gemini 2.5.

Na minha opinião, seu maior ponto forte é a enorme janela de contexto de 1 milhão de tokens, com planos de expansão para 2 milhões. A combinação de um modelo de raciocínio com esse contexto gera um valor comercial real, especialmente considerando que a adoção da IA ainda é limitada na maioria das empresas.

Para colocar as coisas em perspectiva: O o3-mini da OpenAI suporta tokens de 200K, o Claude 3.7 Sonnet também tem limite de 200K, o DeepSeek R1 tem limite de 128K e o Grok 3 é o único outro modelo que atualmente se equipara ao Gemini com 1 milhão.

Como um dos casos de uso mais comuns de IA é a geração de código, um modelo que possa raciocinar por meio do código e ler uma grande base de código em uma única passagem, sem precisar de RAG, pode trazer um valor comercial significativo. Já mostramos em um blog anterior como processar documentos grandes sem o RAG usando o Gemini 2.0 Flash.

Nesta publicação, explicarei o que o Gemini 2.5 Pro oferece, os tipos de entradas que ele suporta e como você pode acessá-lo. Também farei alguns testes práticos e verei como ele se compara aos principais benchmarks com os modelos mais recentes do Claude, DeepSeek, Grok e OpenAI.

Aprimoramento de IA para iniciantes

O que é o Gemini 2.5 Pro?

O Gemini 2.5 Pro é o primeiro modelo da família Gemini 2.5 do Google. No momento, ele está classificado como experimental e está disponível no plano Gemini Advanced e no Google AI Studio.

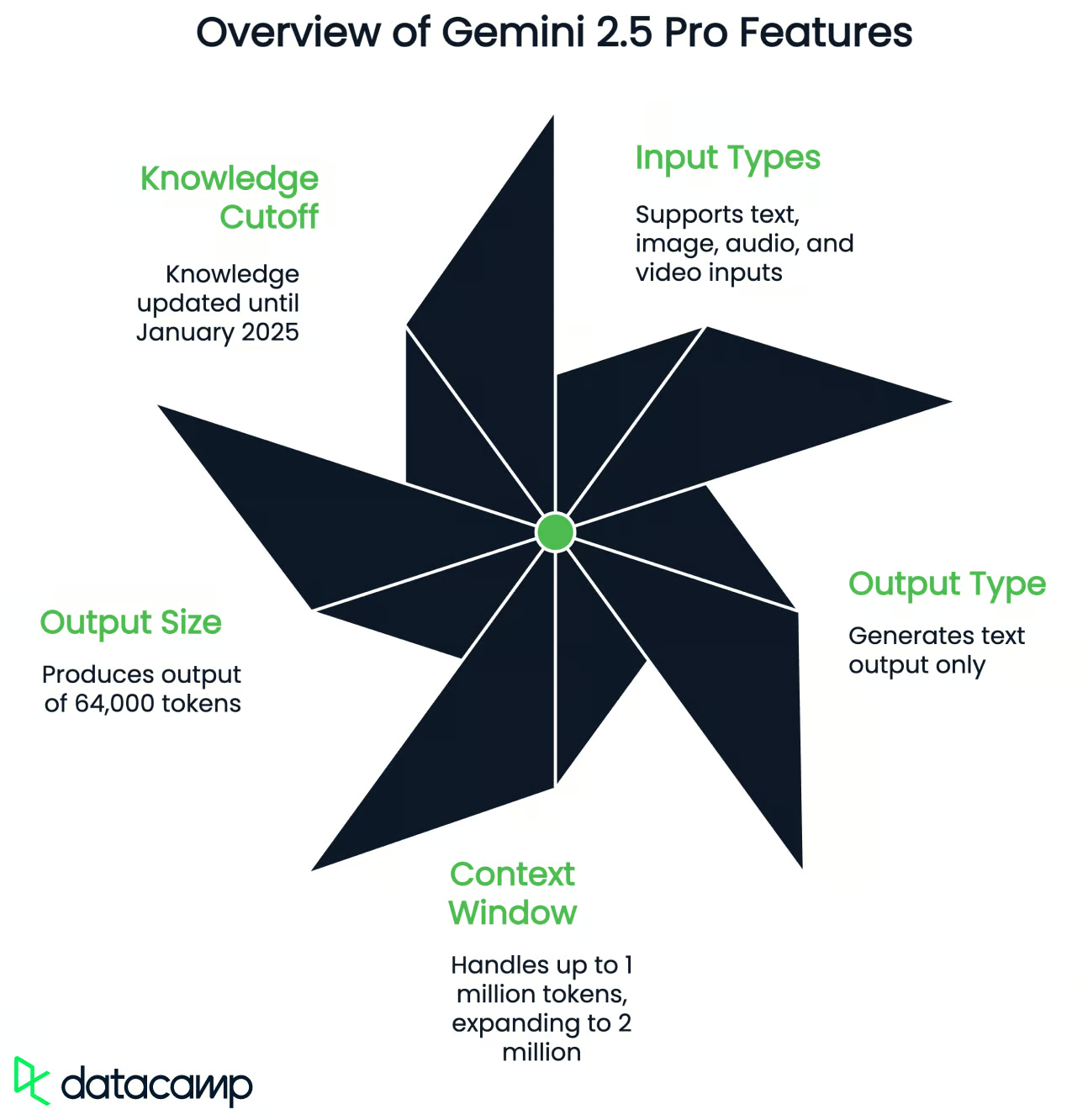

De acordo com o Google, esse é o melhor modelo de raciocínio até o momento, com melhorias no uso de ferramentas, no tratamento de entradas multimodais e no desempenho em contextos longos. Aqui está uma visão geral rápida do que ele suporta:

- Tipos de entrada: Texto, imagem, áudio e vídeo

- Tipo de saída: Somente texto

- Janela de contexto: Até 1 milhão de tokens para entrada (expansão planejada para 2 milhões)

- Tamanho da saída: 64.000 tokens

- Limite de conhecimento: Janeiro de 2025

O Gemini 2.5 Pro suporta o uso de ferramentas, o que significa que ele pode chamar funções externas, gerar saída estruturada (como JSON), executar código e usar pesquisa. Isso permite que o modelo resolva tarefas de várias etapas, chame APIs ou formate respostas para sistemas downstream específicos.

Como se trata de um modelo de raciocínio, o Gemini 2.5 Pro é especialmente forte em codificação, matemática, lógica e ciências. Para a maioria das tarefas diárias, você ainda pode usar um modelo generalista como o Gemini 2.0 Flash porque ele é muito mais rápido.

Agora, vamos testar o Gemini 2.5 Pro para ver como ele se comporta.

Testando o Gemini 2.5 Pro

Jogo P5js

Primeiro, eu queria testar o jogo do dinossauro que o Google ofereceu como exemplo, e usei o mesmo prompt que você usou no vídeo de demonstração (experimentei no aplicativo Gemini):

Make me a captivating endless runner game. Key instructions on the screen. p5js scene, no HTML. I like pixelated dinosaurs and interesting backgrounds.Vamos ver o resultado:

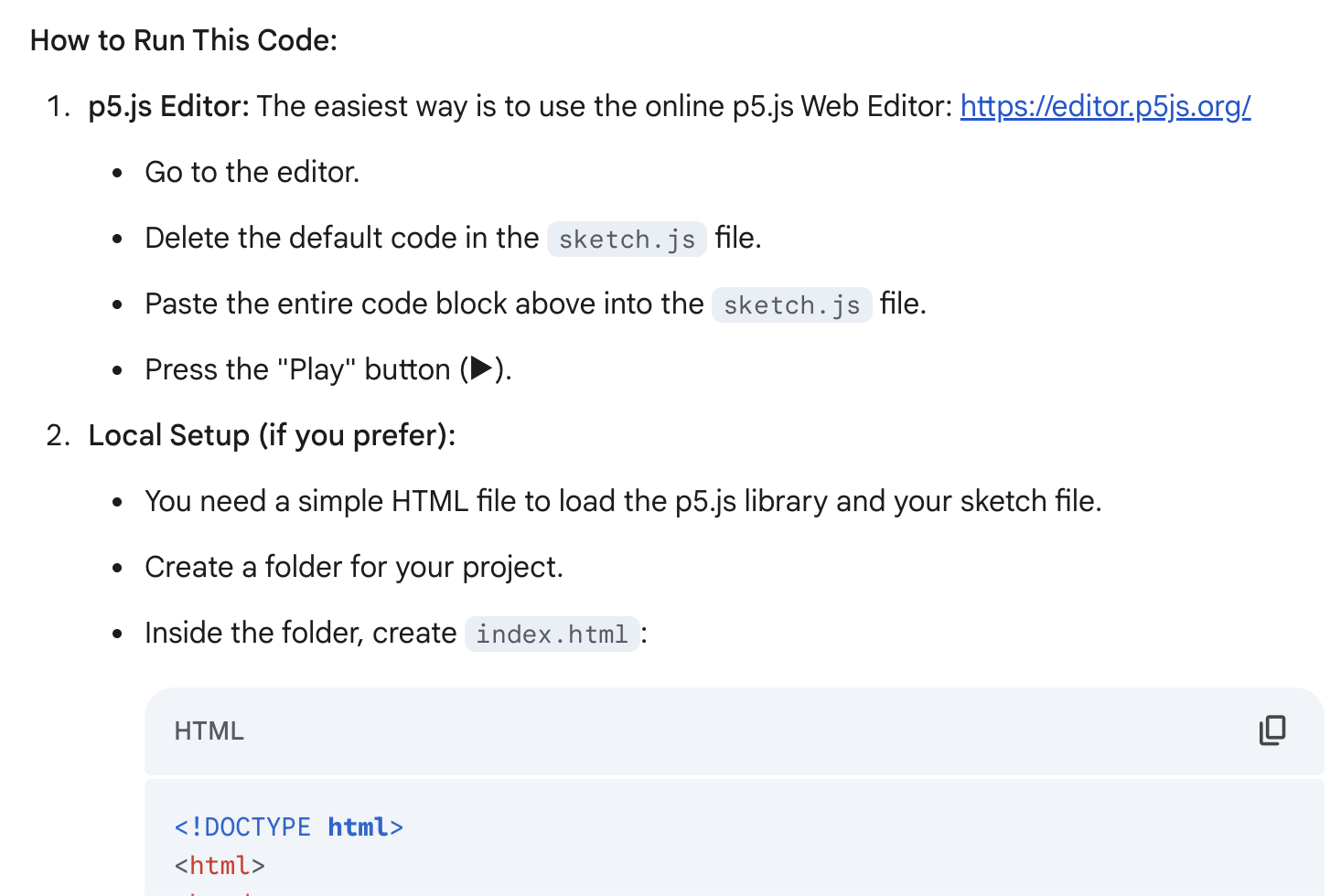

Isso é muito legal para apenas uma solicitação! A geração foi rápida (menos de 30 segundos), e eu também gostei das instruções detalhadas sobre como executar esse código - ele me ofereceu duas maneiras de executá-lo. Você pode usar o código de duas maneiras:

Não gostei do fato de o jogo começar imediatamente após a execução do código, por isso quis mudar isso:

I don't like that the game starts immediately after I run the code. Add a starting screen where the user can be the one who starts the game (keep instructions on the screen)Vamos ver o resultado:

Exatamente o que eu queria! Ainda há muitas coisas que eu mudaria, mas o resultado é muito bom em relação ao meu esforço (dois prompts) e à minha meta (apenas construir um protótipo).

Entrada multimodal (vídeo e texto)

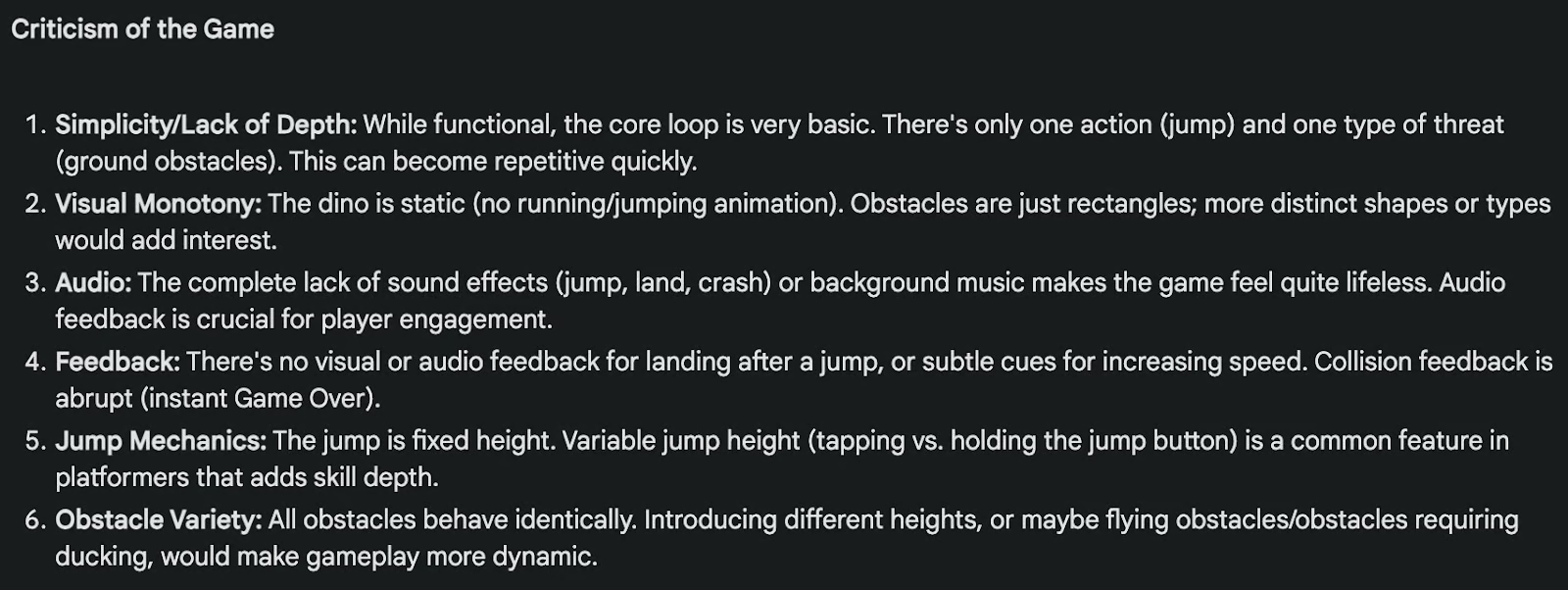

Em seguida, eu queria testar os recursos multimodais do Gemin 2.5 Pro. Carreguei o vídeo acima com o jogo e dei ao Gemini 2.5 Pro esse prompt no Google AI Studio (não consegui adicionar vídeo como entrada no aplicativo Gemini):

Analyze the game in the video, criticize both the game and the code I will give you below, and indicate what changes I could make to this game to make it better.

Code:

(truncated fo readability)O resultado foi muito bom! Para facilitar a leitura, mostrarei aqui apenas as críticas ao jogo, o que indiretamente demonstra um bom entendimento do vídeo e do código:

Processamento de documentos grandes

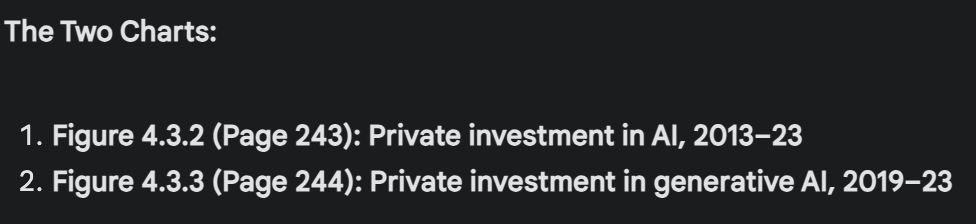

Por fim, eu queria testar o Gemini 2.5 Pro em um documento relativamente grande e usei Relatório do Índice de Inteligência Artificial de Stanford 2024. Depois de fazer o upload do documento de 502 páginas (129.517 tokens), perguntei ao Gemini 2.5 Pro:

Pick two charts in this report that appear to show opposing or contradictory trends. Describe what each chart says, why the contradiction matters, and propose at least one explanation that reconciles the difference. Mention the page of the charts so I can double-check. If there's no such contradiction, don't try to artificially find one.Por algum motivo, não foi possível analisar diretamente os gráficos dentro do documento PDF no aplicativo Gemini. Mudei para o Google AI Studio e funcionou. O Gemini 2.5 Pro conseguiu encontrar dois gráficos referentes ao investimento em IA que mostram uma tendência contraditória: o investimento privado em IA está diminuindo, apesar de o investimento privado em IA generativa estar aumentando.

Ele localizou perfeitamente os gráficos pelo número da página (como eu pedi), o número da figura e os títulos (recomendo que você verifique o o PDF você mesmo para verificar novamente e ver os gráficos).

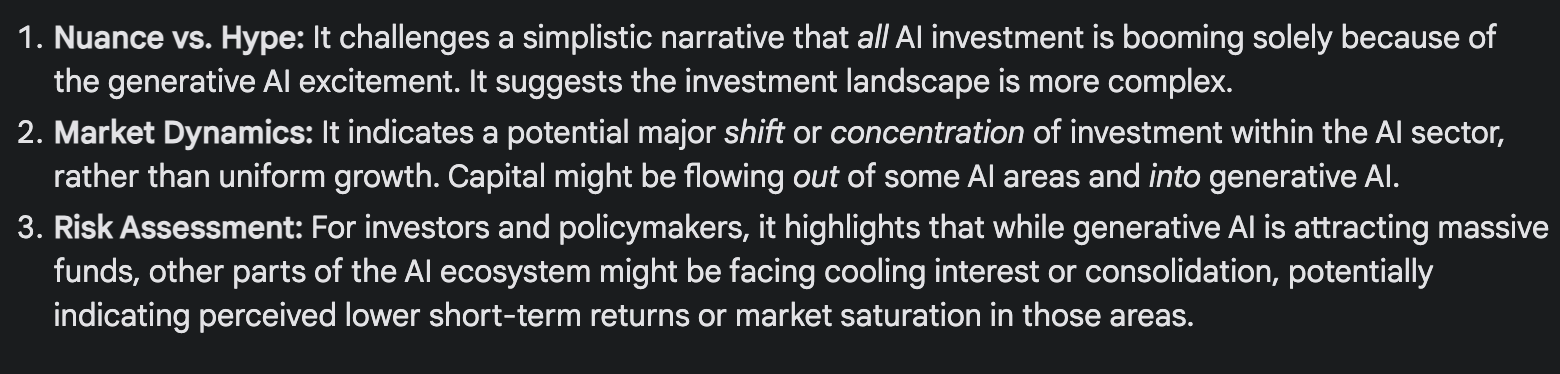

Ele resumiu muito bem a tendência contraditória: Como o investimento privado total em IA pode estar diminuindo quando o investimento em seu subcampo mais badalado e visível, a IA generativa, está explodindo?

E explicou por que estamos observando essa tendência aparentemente contraditória:

Benchmarks do Gemini 2.5 Pro

O Google comparou o Gemini 2.5 Pro com alguns dos principais modelos disponíveis atualmente, incluindo Claude 3.7 Sonnet, o3-mini da OpenAI, DeepSeek R1e Grok 3. Embora o desempenho varie de acordo com a tarefa, o Gemini 2.5 Pro geralmente apresenta bom desempenho em tarefas de raciocínio, codificação, matemática e de contexto longo.ks.

|

Categoria |

Benchmark |

Gemini 2.5 Pro |

Concorrentes mais próximos |

|

Raciocínio e conhecimento geral |

O último exame da humanidade (sem ferramentas) |

18.8% |

o3-mini (14%), Claude 3.7 (8.9%), DeepSeek R1 (8.6%) |

|

GPQA Diamond (pass@1) |

84.0% |

Grok 3 Beta (80,2%), o3-mini (79,7%), Claude 3.7 Sonnet (78,2%) |

|

|

Matemática e lógica |

AIME 2024 (pass@1) |

92.0% |

o3-mini (87,3%), Grok 3 Beta (83,9%) |

|

AIME 2025 (pass@1) |

86.7% |

o3-mini (86,5%), Grok 3 Beta (77,3%) |

|

|

Codificação |

LiveCodeBench v5 |

70.4% |

o3-mini (74,1%), Grok 3 Beta (70,6%) |

|

Aider Polyglot (edição de arquivos inteiros) |

74.0% |

— |

|

|

SWE-bench Verificado |

63.8% |

Claude 3,7 (70,3%) |

|

|

Contexto longo e multimodal |

MRCR (contexto de 128K) |

91.5% |

GPT-4.5 (48,8%), o3-mini (36,3%) |

|

MMMU (compreensão multimodal; pass@1) |

81.7% |

Grok 3 Beta (76,0%), Claude 3.7 Sonnet (75%) |

Portanto,urce: Google

Raciocínio e conhecimento geral

O Gemini 2.5 Pro apresenta um bom desempenho em benchmarks projetados para testar o raciocínio em várias etapas e o conhecimento do mundo real:

- Humanity's Last Exam (sem ferramentas): O Gemini 2.5 Pro tem pontuação de 18,8%, à frente do o3-mini (14%) e bem acima do Claude 3.7 (8,9%) e do DeepSeek-R1 (8,6%). Esse teste foi projetado para imitar exames de nível de especialista em mais de 100 matérias.

- GPQA Diamond: Uma referência de controle de qualidade factual em STEM e ciências humanas. A pontuação do Gemini 2.5 Pro lidera com 84,0% (para tentativa única/passagem@1), seguida pelo Grok 3 Beta com 80,2%.

Matemática e lógica

Esses são benchmarks em que a arquitetura de raciocínio do Gemini parece se destacar:

- AIME 2024: O Gemini 2.5 Pro lidera com 92,0% para tentativa única/passagem@1.

- AIME 2025: O Gemini 2.5 Pro cai para 86,7% no conjunto de problemas 2025 e lidera marginalmente esse benchmark para tentativa única/passagem@1, seguido pelo o3-mini (86,5%).

Codificação

Em benchmarks que testam a geração de código, a depuração e o raciocínio de vários arquivos, o Gemini tem um bom desempenho, mas não domina:

- LiveCodeBench v5 (geração de código): O Gemini 2.5 Pro tem pontuação de 70,4%, atrás do o3-mini (74,1%) e do Grok 3 Beta (70,6%).

- Aider Polyglot (arquivo completo): O Gemini atinge 74,0%, o que é sólido, especialmente considerando que ele lida com vários idiomas. Esse benchmark mede a edição de código.

- SWE-bench verificado (codificação agêntica): O Gemini obteve 63,8% de pontuação, ficando à frente do o3-mini e do DeepSeek R1, mas atrás do Claude 3.7 Sonnet (70,3%).

Tarefas multimodais e de contexto longo

É nesse ponto que o Gemini 2.5 Pro se destaca mais claramente:

- MRCR (compreensão de leitura de contexto longo): O Gemini 2.5 Pro atinge 91,5% para uma extensão de contexto de 128.000, e está quilômetros à frente do o3-mini (36,3%) e do GPT-4.5 (48,8%).

- MMMU (compreensão multimodal): O Gemini 2.5 Pro lidera o benchmark com uma pontuação de 81,7%.

Como acessar o Gemini 2.5 Pro

Há algumas maneiras de experimentar o Gemini 2.5 Pro, dependendo se você é um usuário casual ou está criando algo mais técnico.

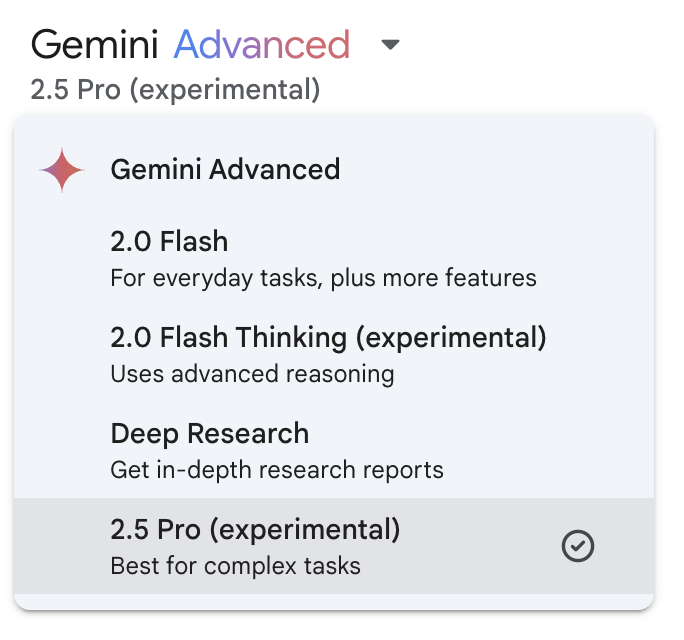

Aplicativo Gemini

A maneira mais fácil de acessar o Gemini 2.5 Pro é por meio do aplicativo Gemini (no celular ou na Web).

Se você for assinante do Gemini Advanced, verá o Gemini 2.5 Pro listado no menu suspenso de modelos.

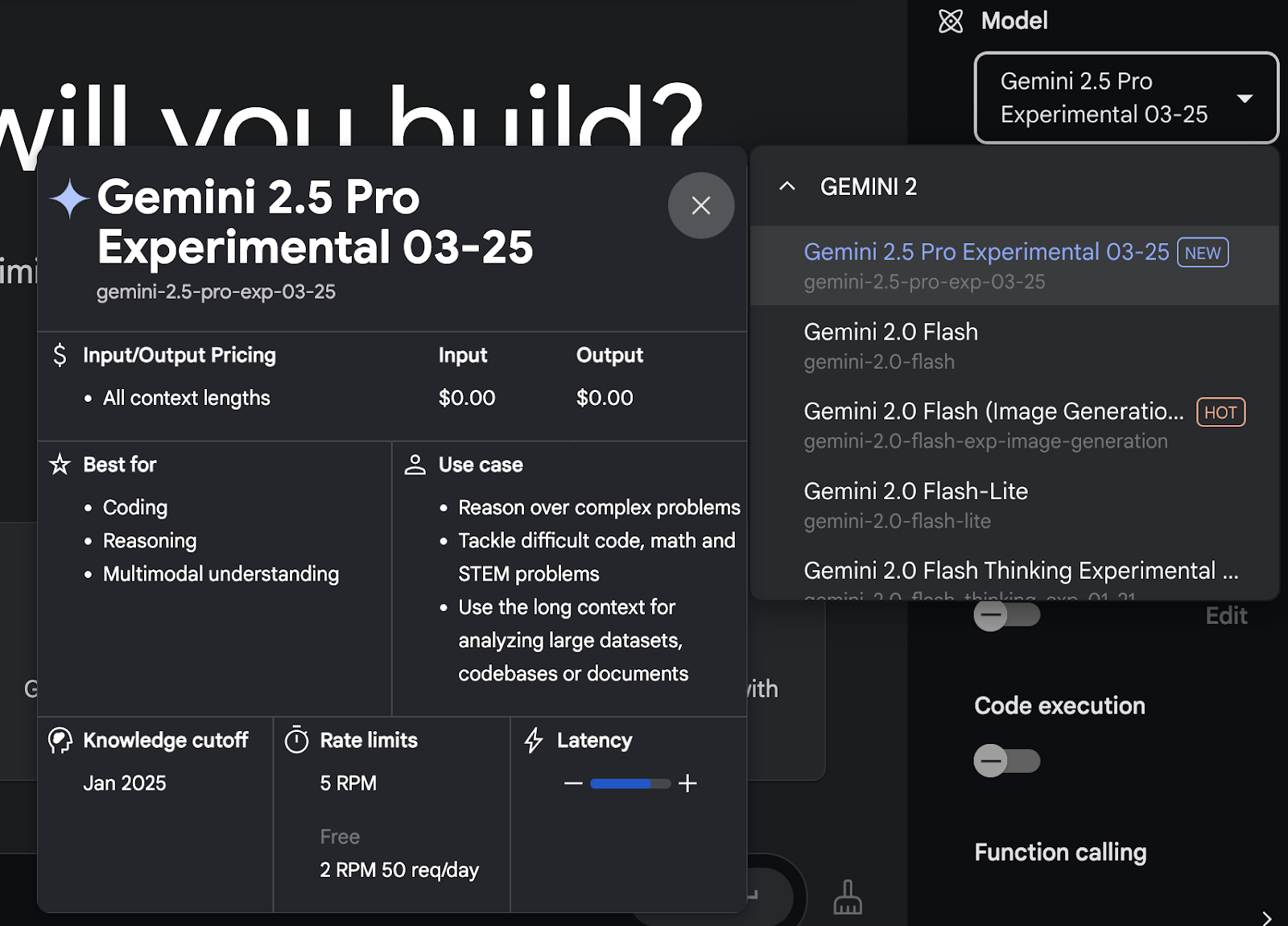

Google AI Studio

Se você quiser ter mais controle sobre as entradas, o uso da ferramenta ou os avisos multimodais, recomendo usar o Google AI Studio.

Esse ambiente dá a você acesso ao Gemini 2.5 Pro gratuitamente (a partir de agora) e oferece suporte a entradas de texto, imagem, vídeo e áudio. Ele também funciona melhor do que o aplicativo Gemini para carregar arquivos ou testar o uso da ferramenta, especialmente quando você lida com documentos grandes ou fluxos de trabalho personalizados.

Depois de criar uma conta, você pode selecionar o Gemini 2.5 Pro no menu suspenso do modelo.

API do Gemini 2.5 Pro

Para acesso programático, você pode usar a API do Gemini, que é compatível com o Gemini 2.5 Pro.

Isso lhe dá mais flexibilidade se você estiver integrando o modelo a um aplicativo ou fluxo de trabalho. Você pode chamar o modelo diretamente com o uso da ferramenta ativado, obter respostas estruturadas ou processar documentos longos de forma automatizada.

Você pode encontrar mais informações técnicas aqui.

Gemini 2.5 Pro no Vertex AI

Segundo o Google, o Gemini 2.5 Pro também estará disponível em breve no Vertex AI, que faz parte do Google Cloud. A principal diferença entre usar a API Gemini diretamente e acessá-la por meio do Vertex AI está na infraestrutura, na escala e na integração.

Se você estiver apenas testando ou criando ferramentas internas, o AI Studio ou a API devem ser suficientes. Se você estiver implantando algo na produção com requisitos rigorosos de desempenho ou segurança, o Vertex AI será a melhor opção quando lançar o suporte para o Gemini 2.5 Pro.

Conclusão

Está cada vez mais difícil ficar impressionado com os lançamentos de novos modelos. A maioria dos lançamentos segue o mesmo padrão: alguns exemplos escolhidos a dedo, alguns benchmarks chamativos e muitas afirmações de que você é o melhor em tudo. Mas o Gemini 2.5 Pro realmente me proporcionou alguns momentos em que fiz uma pausa e pensei: "Ok, isso é realmente útil".

A janela de contexto de 1 milhão de tokens muda a forma como você pode abordar tarefas que costumavam exigir trabalho extra, especialmente as que envolvem documentos longos, bases de código confusas ou raciocínio em várias etapas. Não precisei dividir as entradas em partes ou configurar um pipeline RAG. Acabei de fazer upload do arquivo, fiz minha pergunta e recebi de volta algo coerente e fundamentado na fonte.

Se a janela de contexto de 2 milhões de tokens for lançada em breve, isso por si só poderá torná-lo um dos modelos mais práticos para o trabalho no mundo real.

Perguntas frequentes

Quais tipos de entrada são compatíveis com o Gemini 2.5 Pro?

O Gemini 2.5 Pro é compatível com entradas de texto, imagem, vídeo e áudio.

Onde posso acessar o Gemini 2.5 Pro?

O Gemini 2.5 Pro está disponível no Google AI Studio e para os assinantes do Gemini Advanced por meio do aplicativo Gemini.

Quais são os principais casos de uso do Gemini 2.5 Pro?

O Gemini 2.5 Pro é excelente em codificação, tarefas de raciocínio complexas e manipulação de entradas multimodais.

O Gemini 2.5 Pro é adequado para aplicativos em tempo real?

Embora eficiente, seu status experimental sugere cautela para implementações em tempo real até que a estabilidade seja confirmada.

Sou editor e redator de blogs, tutoriais e notícias sobre IA, garantindo que tudo se encaixe em uma estratégia de conteúdo sólida e nas práticas recomendadas de SEO. Escrevi cursos de ciência de dados em Python, estatística, probabilidade e visualização de dados. Também publiquei um romance premiado e passo meu tempo livre escrevendo roteiros e dirigindo filmes.