Programa

A OpenAI lançou o GPT-4o mini, uma versão mais acessível do poderoso GPT-4o. Esse novo modelo visa equilibrar o desempenho com a eficiência de custo, atendendo às necessidades de empresas e desenvolvedores que desejam soluções avançadas de IA a um preço mais baixo.

Em 2024, a narrativa em torno da IA parece estar mudando de modelos maiores e melhores para opções mais econômicas, especialmente para aplicativos B2B. Há uma mudança da IA baseada em nuvem para a IA local. IA localtornando os modelos menores mais importantes.

Até agora, a OpenAI não tinha um candidato forte para esse espaço desde o GPT-3.5. O GPT-4o mini muda isso, tornando a IA avançada acessível e econômica para integração em todos os aplicativos e sites.

Neste artigo, exploraremos os principais recursos do GPT-4o mini, como ele se compara a outros LLMs semelhantes e o que esse lançamento significa para os desenvolvimentos de IA.

O que é o GPT-4o Mini?

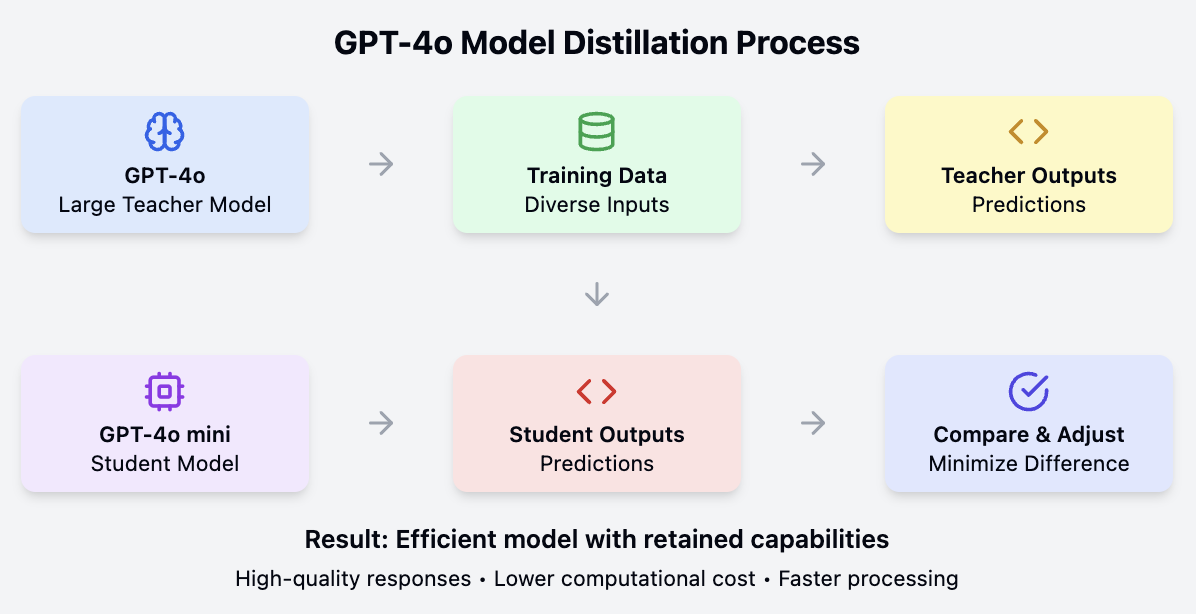

O GPT-4o mini é derivado do modelo maior GPT-4o por meio de um processo de destilação. Esse processo envolve o treinamento de um modelo menor para imitar o comportamento e o desempenho do modelo maior e mais complexo, resultando em uma versão econômica e altamente capaz do original.

Principais recursos

- Janela de contexto grande: O GPT-4o mini mantém a janela de contexto de token de 128k do GPT-4o, o que permite que ele manipule textos longos com eficiência. Isso é ideal para aplicativos que precisam de contexto extenso, como a análise de documentos grandes ou a manutenção do histórico de conversas.

- Recursos multimodais: O modelo processa entradas de texto e imagem, com suporte futuro planejado para entradas e saídas de vídeo e áudio. Essa versatilidade o torna adequado para várias aplicações, desde a análise de texto até o reconhecimento de imagens.

- Custo reduzido: O GPT-4o mini é muito mais econômico do que seus antecessores. Ele custa US$ 0,15 por milhão de tokens de entrada e US$ 0,60 por milhão de tokens de saída, significativamente mais barato do que o modelo GPT-4o, que custa US$ 5,00 por milhão de tokens de entrada e US$ 15,00 por milhão de tokens de saída. Em comparação com o GPT-3.5 Turbo, o GPT-4o mini é mais de 60% mais barato.

- Segurança aprimorada: O modelo inclui os mesmos recursos de segurança do GPT-4o e é o primeiro da API a usar o método de hierarquia de instruções. Isso aumenta sua resistência a jailbreaks, injeções de prompt e extrações de prompt do sistema, tornando-o mais seguro para uso em vários aplicativos.

Mini competição Gpt-4o

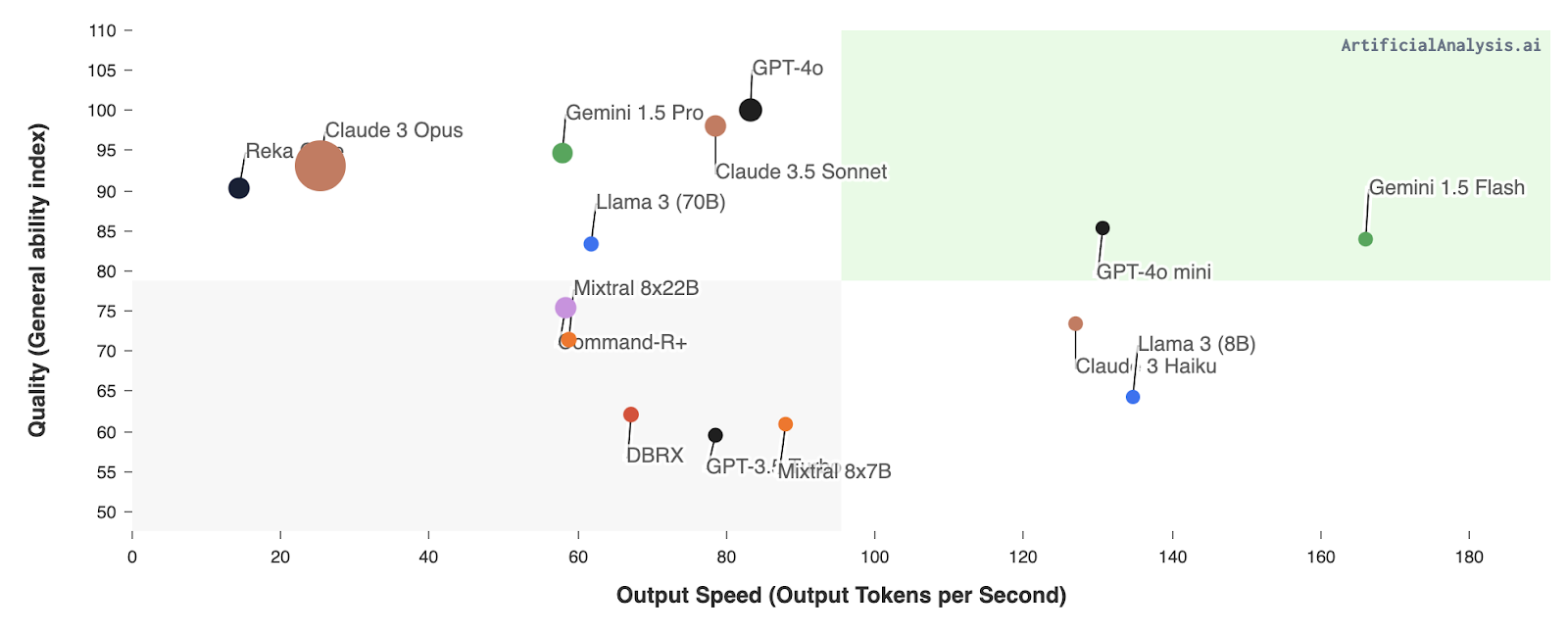

O GPT-4o mini concorre com modelos como Llama 3 8BGemini 1.5 Flash e Claude Haiku, bem como o GPT-3.5 Turbo da OpenAI. Esses modelos oferecem funcionalidades semelhantes, mas geralmente têm custos mais altos ou métricas de desempenho menos avançadas.

- Gemini 1.5 Flash: Embora o Gemini 1.5 Flash tenha uma velocidade de saída um pouco maior, o GPT-4o mini se sobressai em qualidade, o que o torna uma opção mais equilibrada para aplicações que precisam de velocidade e alta precisão.

- Claude 3 Haiku e Llama 3 (8B): O GPT-4o mini supera esses modelos em qualidade e velocidade de saída, demonstrando sua eficiência e eficácia.

- GPT-3.5 Turbo: O GPT-4o mini supera o GPT-3.5 Turbo em velocidade de saída e qualidade geral e oferece recursos de visão que o GPT-3.5 Turbo não possui.

Fonte: Análise Artificial

Como o GPT-4o Mini funciona: A mecânica da destilação

O GPT-4o mini alcança seu equilíbrio de desempenho e eficiência por meio de um processo conhecido como destilação modelo. Em essência, isso envolve o treinamento de um modelo menor e mais simplificado (o "aluno") para imitar o comportamento e o conhecimento de um modelo maior e mais complexo (o "professor").

O modelo maior, neste caso, o GPT-4o, foi pré-treinado em grandes quantidades de dados e possui uma compreensão profunda dos padrões de linguagem, da semântica e até mesmo das habilidades de raciocínio. No entanto, seu tamanho o torna computacionalmente caro e menos adequado para determinados aplicativos.

A destilação de modelos resolve esse problema transferindo o conhecimento e os recursos do modelo GPT-4o maior para o GPT-4o mini menor. Normalmente, isso é feito fazendo com que o modelo menor aprenda a prever os resultados do modelo maior em um conjunto diversificado de dados de entrada. Por meio desse processo, o GPT-4o mini "destila" efetivamente os conhecimentos e as habilidades mais importantes de sua contraparte maior.

O resultado é um modelo que, embora menor e mais eficiente, mantém grande parte do desempenho e dos recursos do original. O GPT-4o mini pode lidar com tarefas de linguagem complexas, entender o contexto e gerar respostas de alta qualidade, tudo isso consumindo menos recursos computacionais. Isso o torna uma solução prática e econômica para uma ampla gama de aplicações, especialmente aquelas em que a velocidade e o custo-benefício são importantes.

GPT-4o Mini Performance

O GPT-4o mini apresenta um desempenho impressionante em vários benchmarks. Eu criei Artefatos do Claude para cada benchmark para explicar o que é cada benchmark do LLM e o que ele mede.

Tarefas de raciocínio

Para tarefas de raciocínio, avaliamos o GPT-4o mini da seguinte forma:

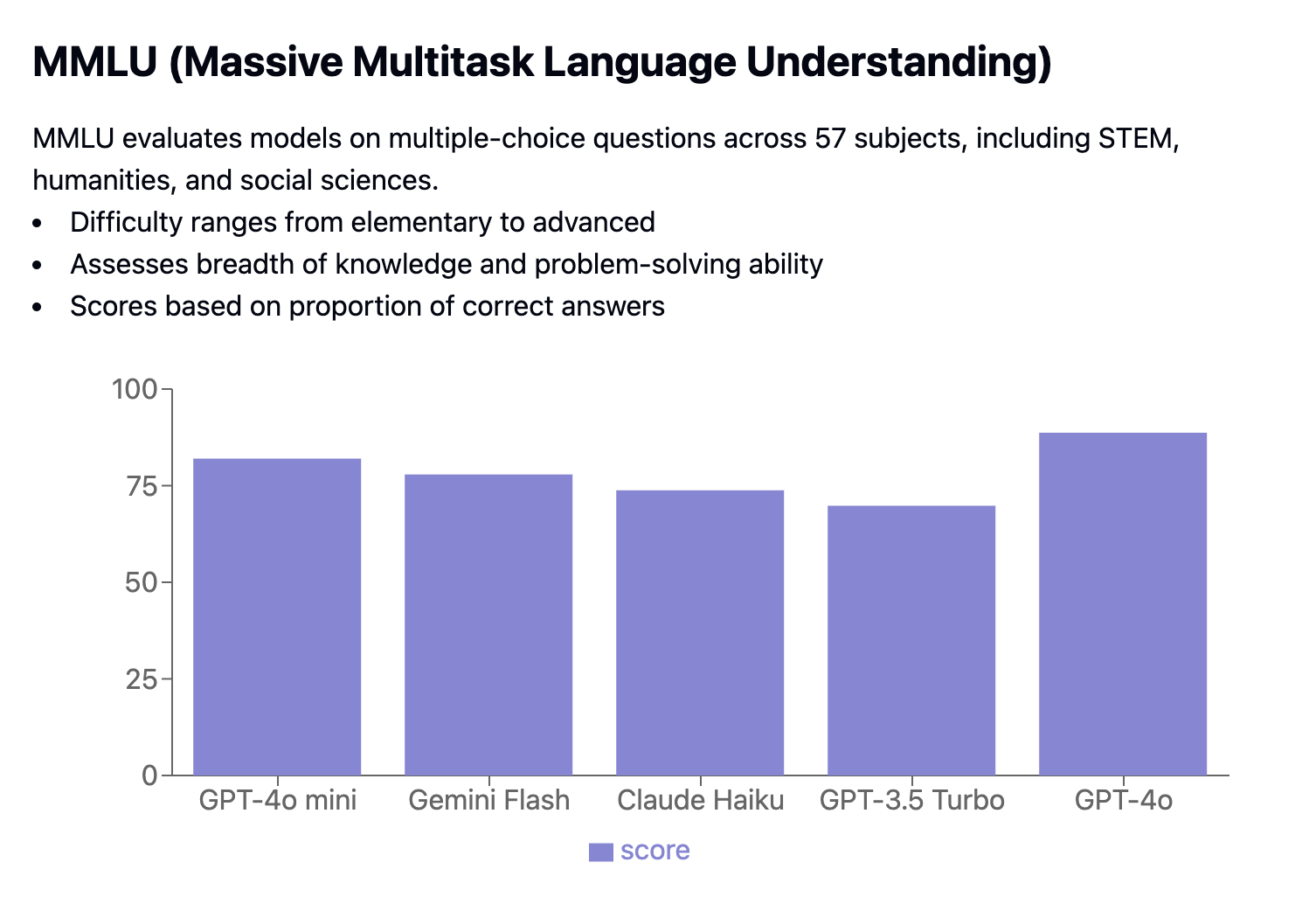

O MMLU (Massive Multitask Language Understanding) é um benchmark que testa modelos com perguntas de múltipla escolha em 57 assuntos diferentes, incluindo STEM, humanidades e ciências sociais. As perguntas variam em dificuldade, de básicas a avançadas. Ele mede quantas respostas estão corretas e exige correspondências exatas. O GPT-4o Mini obteve 82,0% de pontuação, superando concorrentes como o Gemini Flash (77,9%) e o Claude Haiku (73,8%).

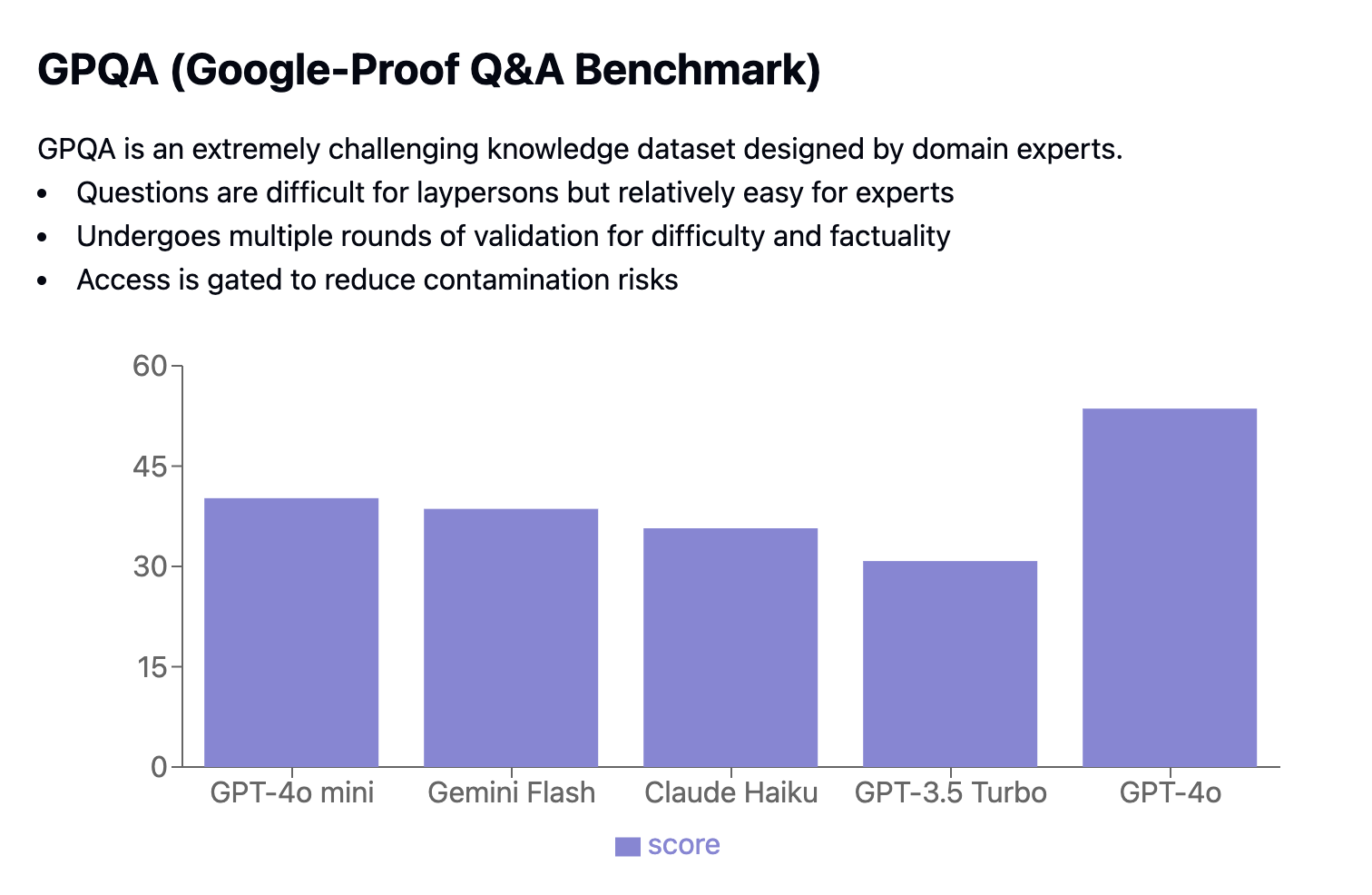

O GPQA (Google-Proof Q&A Benchmark) é um conjunto de dados difícil com perguntas elaboradas por especialistas para desafiar quem não é especialista e, ao mesmo tempo, ser gerenciável para especialistas. As perguntas são cuidadosamente validadas quanto à dificuldade e à precisão em várias rodadas para reduzir os riscos de contaminação.

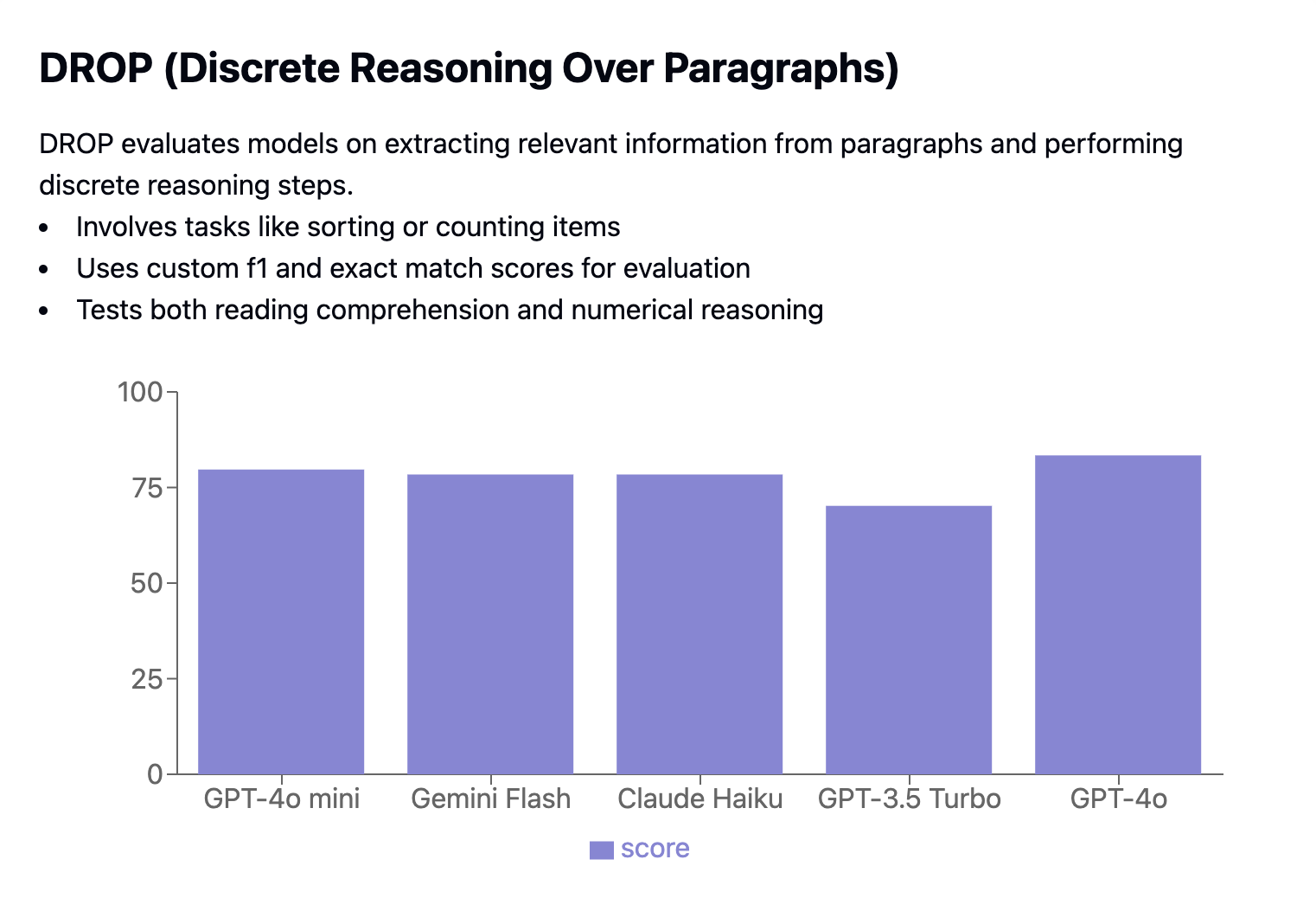

O DROP (Discrete Reasoning Over Paragraphs) testa a capacidade dos modelos de extrair informações relevantes de parágrafos e realizar tarefas de raciocínio, como classificação ou contagem. O desempenho é avaliado usando pontuações personalizadas de F1 e de correspondência exata.

Proficiência em matemática e codificação

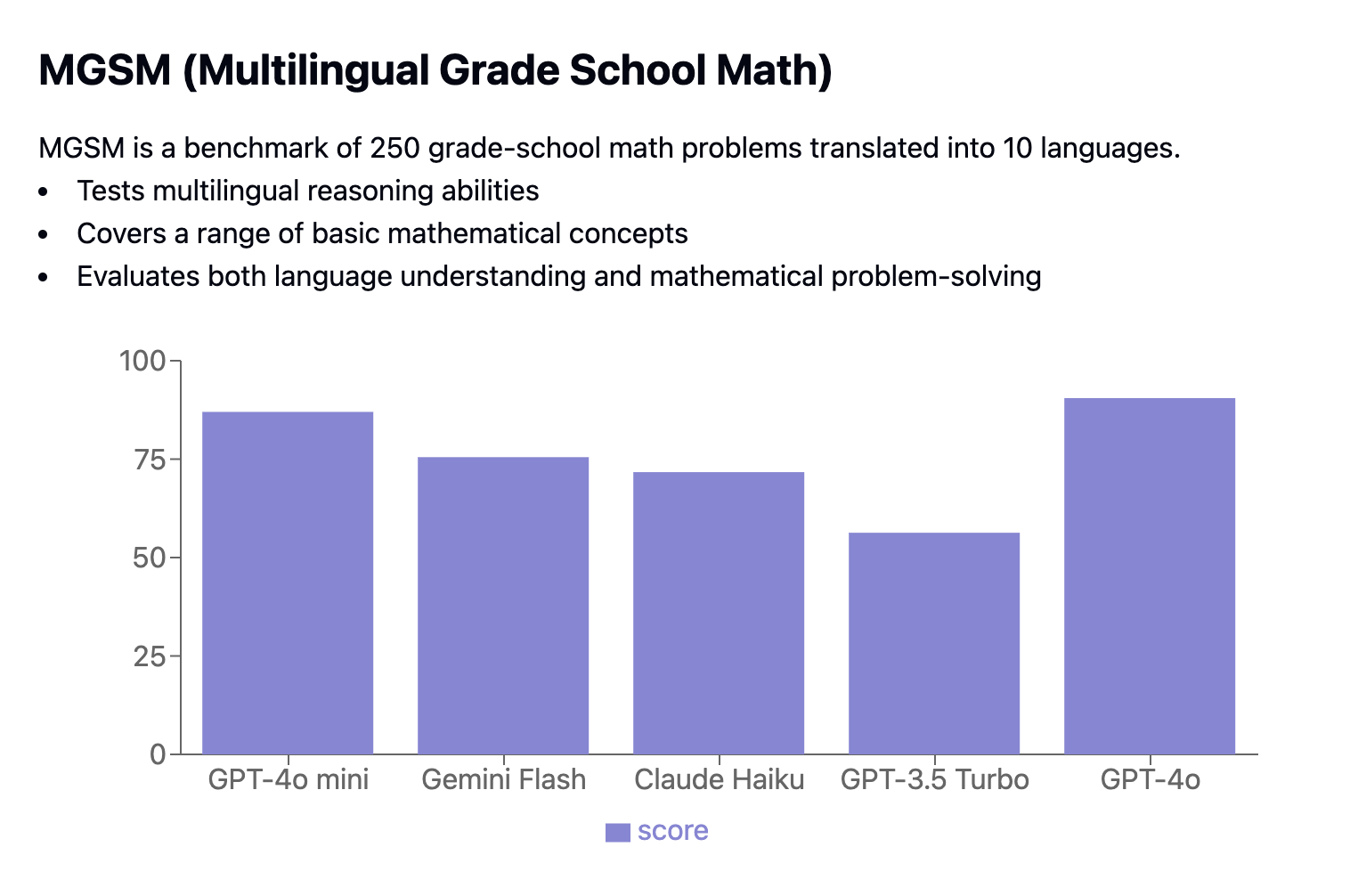

O MGSM benchmark inclui 250 problemas de matemática da escola primária traduzidos em 10 idiomas, testando as habilidades de raciocínio multilíngue.

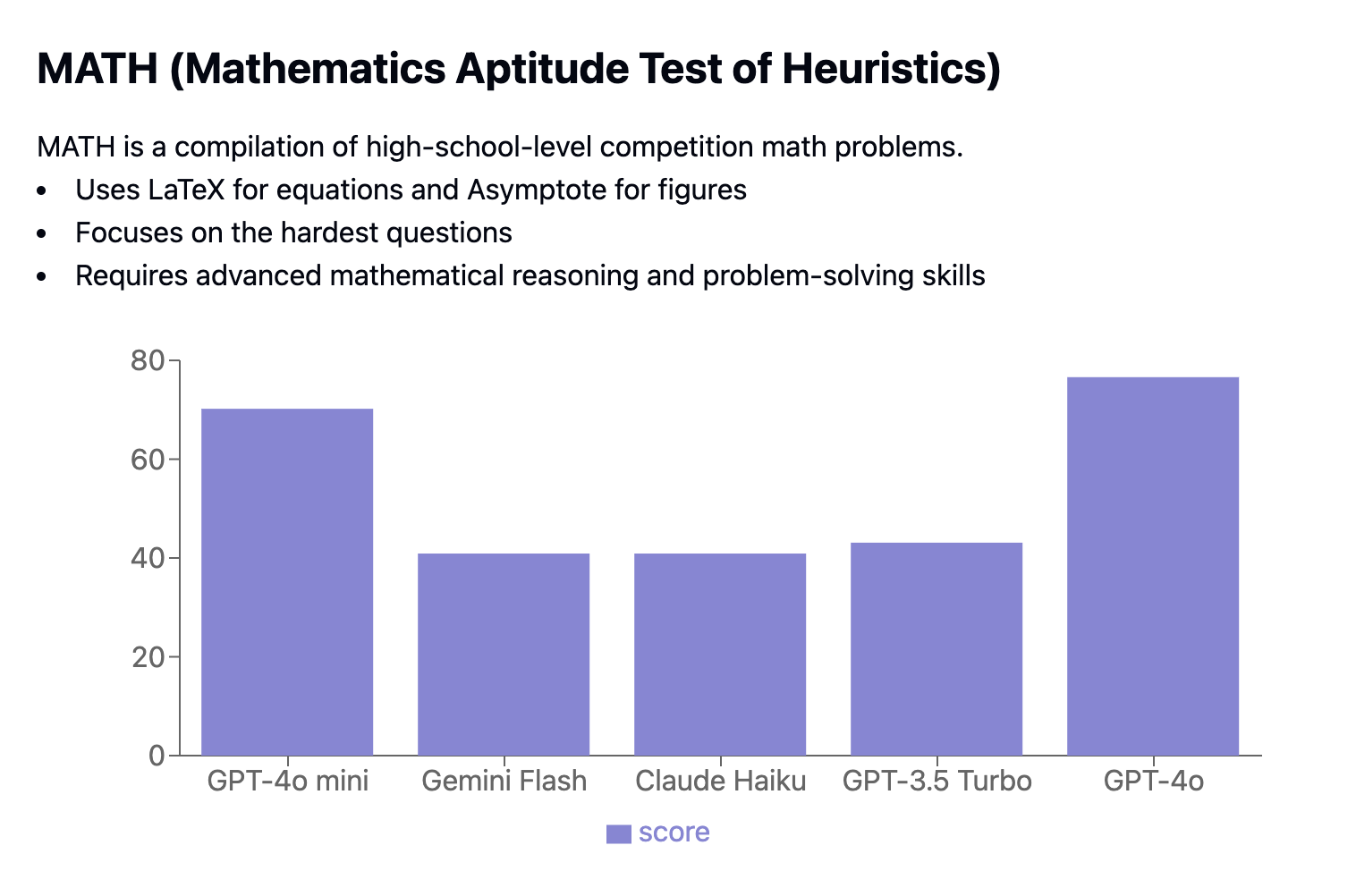

O Mathematics Aptitude Test of Heuristics (MATH) apresenta problemas de competição em nível de ensino médio. Ele avalia os modelos quanto à sua capacidade de resolver problemas matemáticos complexos formatados em Latex e Asymptote, concentrando-se nas perguntas mais desafiadoras.

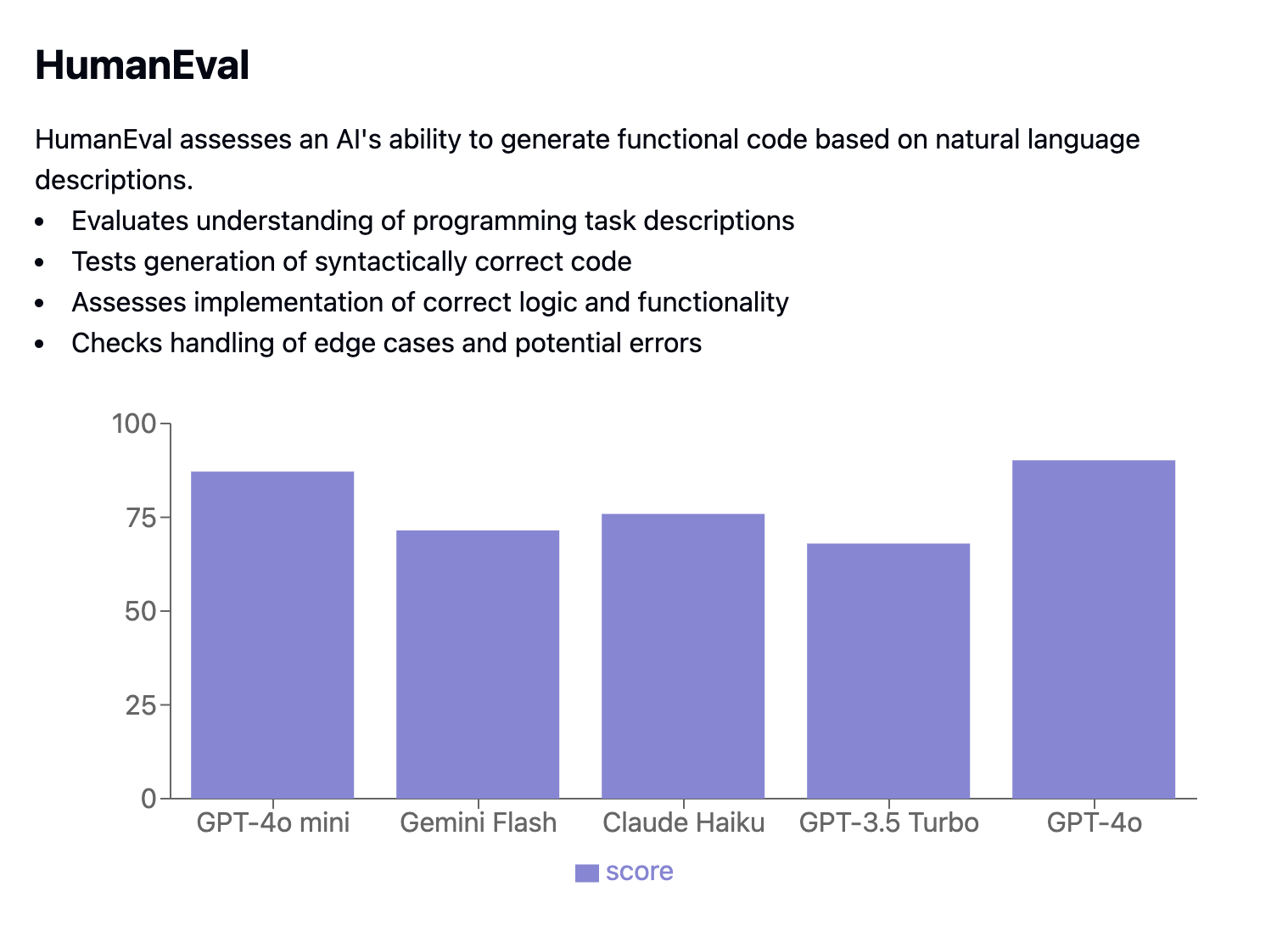

O benchmark HumanEval mede o desempenho da geração de código, avaliando se o código gerado passa em testes de unidade específicos. Ele usa a métrica pass@k para determinar a probabilidade de que pelo menos uma das k soluções para um problema de codificação passe nos testes.

Raciocínio multimodal

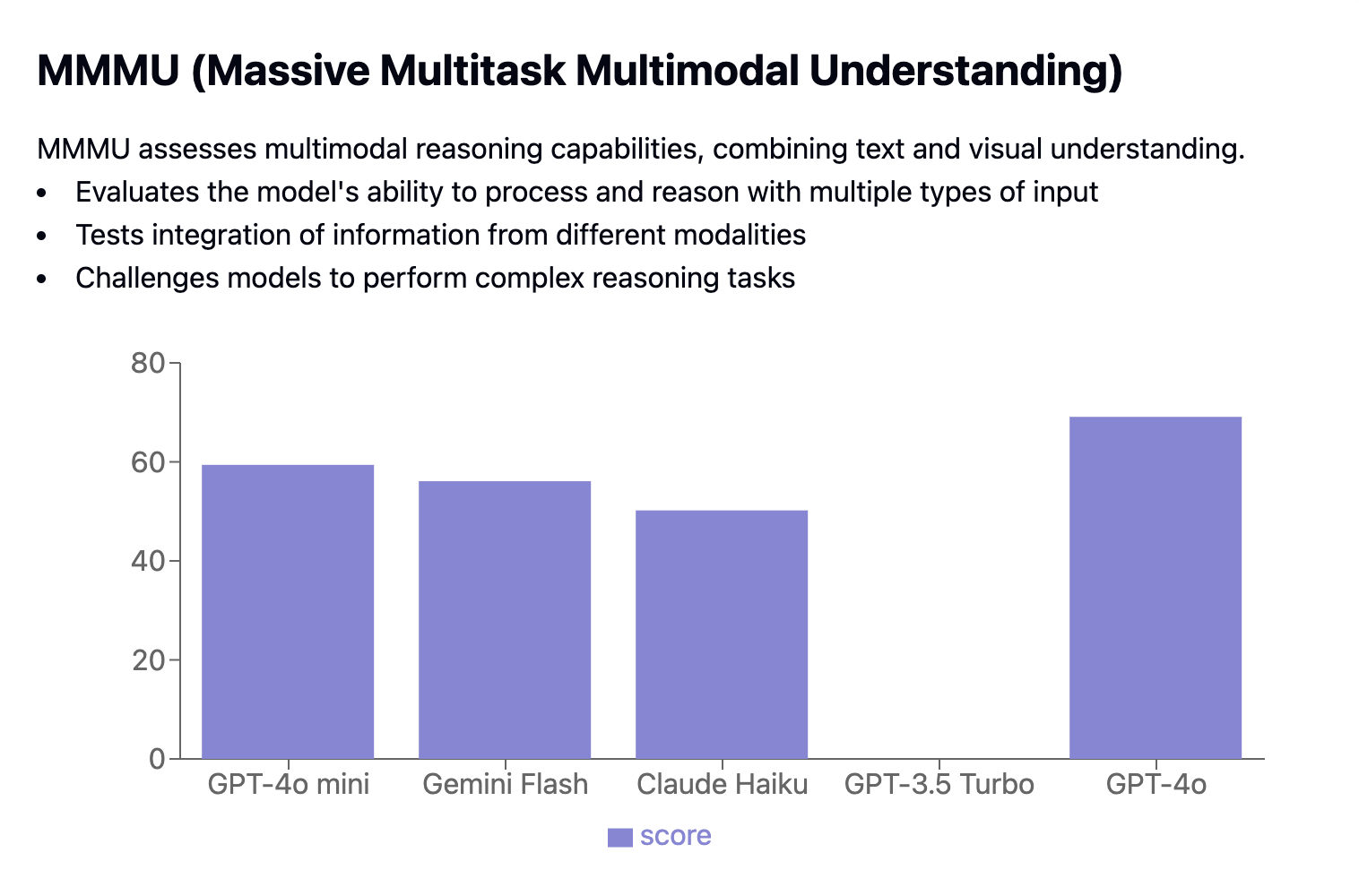

O benchmark Massive Multitask Language Understanding (MMLU) testa a amplitude de conhecimento de um modelo, a profundidade da compreensão da linguagem natural e as habilidades de solução de problemas. Ele apresenta mais de 15.000 perguntas de múltipla escolha que abrangem 57 assuntos, desde conhecimentos gerais até campos especializados. O MMLU avalia os modelos em configurações de poucos disparos e zero disparos, medindo a precisão entre os sujeitos e calculando a média dos resultados para obter uma pontuação final.

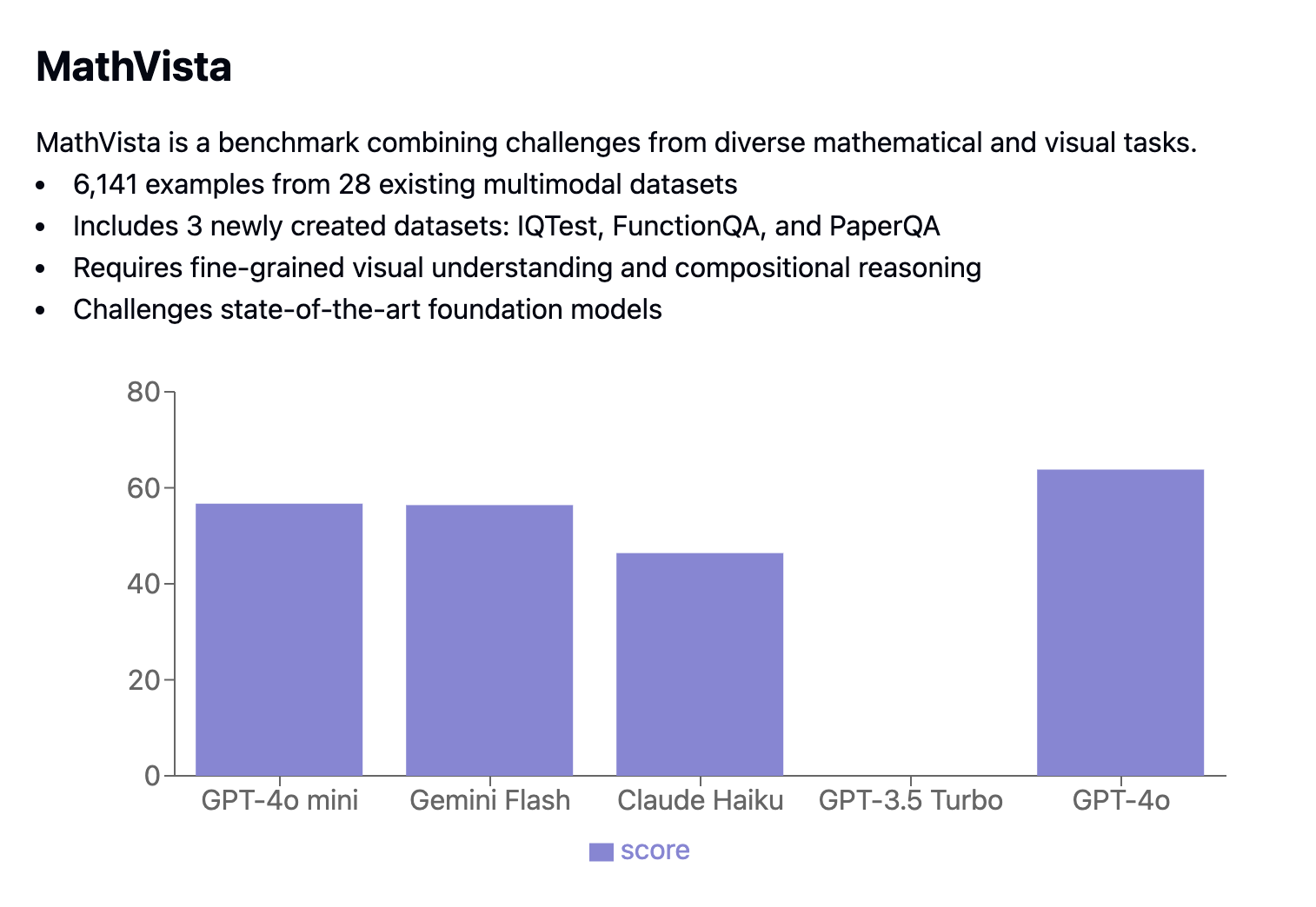

O benchmark MathVista combina tarefas matemáticas e visuais, apresentando 6.141 exemplos extraídos de 28 conjuntos de dados multimodais existentes e 3 conjuntos de dados recém-criados (IQTest, FunctionQA e PaperQA). Ele desafia os modelos com tarefas que exigem compreensão visual avançada e raciocínio de composição complexo.

Casos de uso do Gpt 4o Mini

O tamanho pequeno, o baixo custo e o forte desempenho do GPT-4o mini o tornam perfeito para uso em dispositivos pessoais, prototipagem rápida e em ambientes com recursos limitados. Além disso, sua capacidade de resposta em tempo real melhora os aplicativos interativos. Veja como o GPT-4o mini pode ser usado de forma eficaz:

|

Categoria de caso de uso |

Benefícios |

Exemplos de aplicativos |

|

IA no dispositivo |

O tamanho menor permite o processamento local em laptops, smartphones e servidores de borda, reduzindo a latência e melhorando a privacidade. |

Aplicativos de aprendizagem de idiomas, assistentes pessoais, ferramentas de tradução off-line |

|

Prototipagem rápida |

A iteração mais rápida e os custos mais baixos permitem a experimentação e o refinamento antes de você escalar para modelos maiores. |

Testar novas ideias de chatbot, desenvolver protótipos com tecnologia de IA, experimentar diferentes recursos de IA de forma econômica |

|

Aplicativos em tempo real |

O tempo de resposta rápido aprimora as experiências interativas. |

Chatbots, assistentes virtuais, tradução de idiomas em tempo real, narrativa interativa em jogos e realidade virtual |

|

Uso educacional |

Acessível e de baixo custo para instituições educacionais, proporcionando experiência prática com IA. |

Sistemas de tutoria com tecnologia de IA, plataformas de aprendizado de idiomas, ferramentas de prática de codificação |

Como acessar o Gpt 4o Mini

Você pode usar o GPT-4o Mini por meio da API OpenAIque inclui opções como a API de assistentes, a API de conclusões de bate-papo e a API de lote. Aqui está um guia simples sobre como usar o GPT-4o Mini com a API OpenAI.

Primeiro, você precisará se autenticar usando sua chave de API - substitua your_api_key_here pela sua chave de API real. Depois de configurado, você pode começar a gerar texto com o GPT-4o Mini:

from openai import OpenAI

MODEL="gpt-4o-mini"

## Set the API key

client = OpenAI(api_key="your_api_key_here")

completion = client.chat.completions.create(

model=MODEL,

messages=[

{"role": "system", "content": "You are a helpful assistant that helps me with my math homework!"},

{"role": "user", "content": "Hello! Could you solve 20 x 5?"}

]

)Para obter mais detalhes sobre como configurar e usar a API OpenAI, confira o Tutorial da API do GPT-4o.

Conclusão

O GPT-4o mini se destaca como um modelo de IA potente e econômico, alcançando um equilíbrio notável entre desempenho e preço acessível.

Sua destilação do modelo maior GPT-4o, combinada com sua grande janela de contexto, recursos multimodais e recursos de segurança aprimorados, torna-o uma opção versátil e acessível para uma ampla gama de aplicações.

Como a demanda por soluções de IA eficientes e acessíveis continua a crescer, o GPT-4o mini está bem posicionado para desempenhar um papel significativo na democratização da tecnologia de IA.

Perguntas frequentes

Qual é a principal diferença entre o GPT-4o e o GPT-4o Mini?

A principal diferença está em seu tamanho e custo. O GPT-4o é um modelo maior e mais potente, mas tem um preço mais alto. O GPT-4o Mini é uma versão destilada do GPT-4o, tornando-o menor, mais acessível e mais rápido para determinadas tarefas.

O GPT-4o Mini pode processar imagens, vídeo e áudio?

Atualmente, o GPT-4o Mini suporta entradas de texto e imagem, com suporte para vídeo e áudio planejado para o futuro.

Como o desempenho do GPT-4o Mini se compara ao de outros modelos?

O GPT-4o Mini supera o desempenho de vários modelos semelhantes, incluindo o Llama 3 (8B), o Claude 3 Haiku e o GPT-3.5 Turbo, em termos de qualidade e velocidade. Embora o Gemini 1.5 Flash possa ter uma ligeira vantagem na velocidade de saída, o GPT-4o Mini se destaca na qualidade geral.

O GPT-4o Mini é adequado para aplicativos em tempo real?

Sim, seu processamento rápido e a baixa latência o tornam ideal para aplicativos em tempo real, como chatbots, assistentes virtuais e experiências de jogos interativos.

Como posso acessar o GPT-4o Mini?

Você pode acessar o GPT-4o Mini por meio da API OpenAI, que oferece diferentes opções, como a API Assistants, a API Chat Completions e a API Batch.