Curso

Como exploramos en nuestro artículo sobre Primeros pasos con MLOps, MLOps se basa en los fundamentos de DevOps, la estrategia de desarrollo de software para escribir, desplegar y ejecutar eficazmente aplicaciones empresariales.

Es un enfoque para gestionar proyectos de aprendizaje automático a escala. Los MLOps mejoran la colaboración entre los equipos de desarrollo, operativos y de ciencia de datos. Como resultado, obtienes un despliegue más rápido del modelo, una productividad optimizada del equipo, una reducción del riesgo y del coste, y una supervisión continua del modelo en producción.

Aprende por qué son importantes los MLOps y qué problemas pretenden resolver leyendo nuestro blog sobre el Pasado, Presente y Futuro de los MLOps.

En este post, vamos a conocer las mejores herramientas MLOps para el desarrollo, despliegue y monitorización de modelos, con el fin de estandarizar, simplificar y agilizar el ecosistema del aprendizaje automático. Para obtener una introducción completa a los Fundamentos de MLOps, consulta nuestra Ruta de habilidades.

¿Quieres iniciarte en la IA Generativa?

Aprende a trabajar con LLMs en Python directamente en tu navegador

Marco de los Grandes Modelos Lingüísticos (LLM)

Con la introducción de GPT-4 y posteriormente GPT-4o, ha comenzado la carrera para producir grandes modelos lingüísticos y aprovechar todo el potencial de la IA moderna. Los LLM necesitan bases de datos vectoriales y marcos de integración para crear aplicaciones inteligentes de IA.

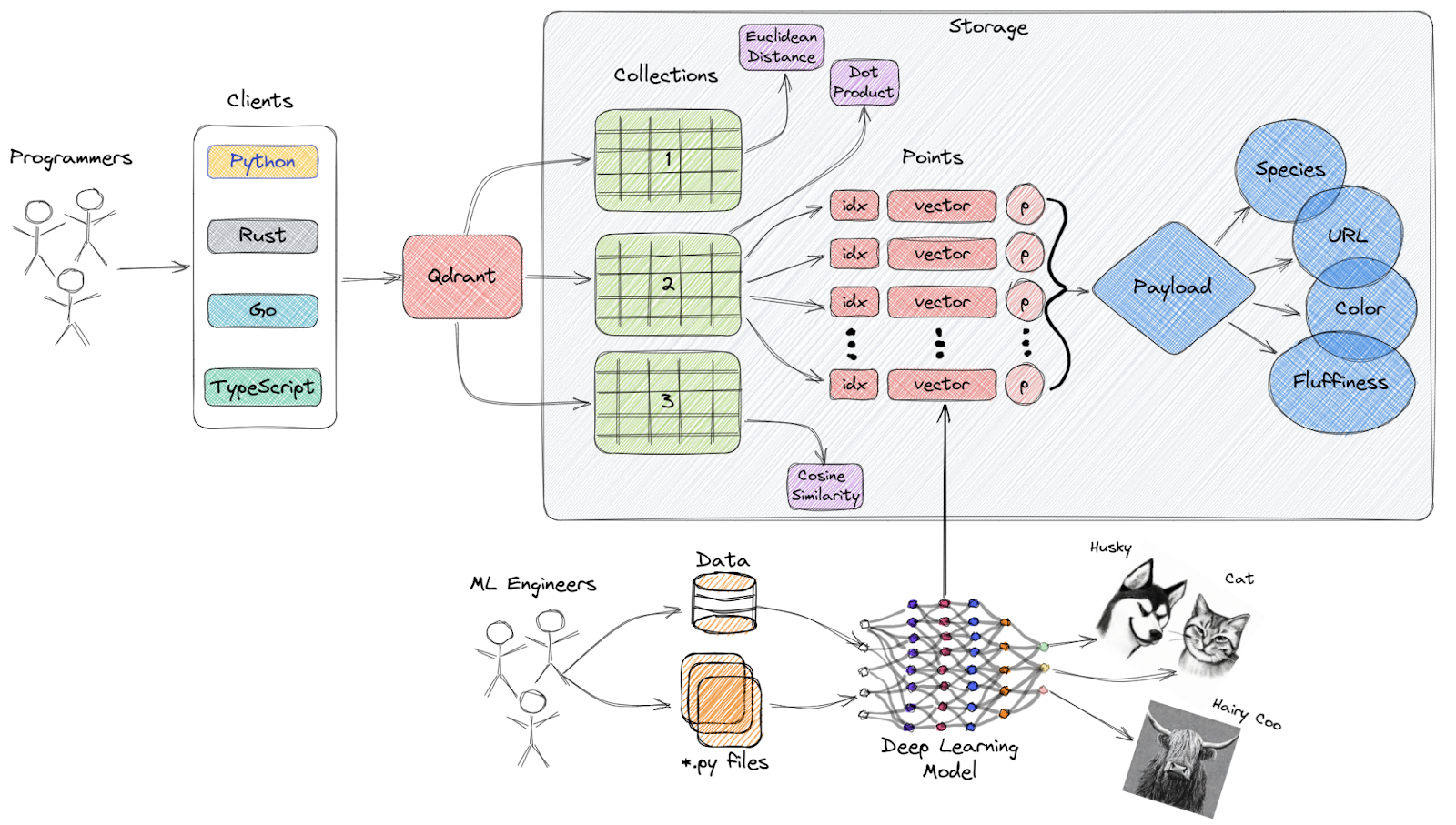

1. Qdrant

Qdrant es un motor de búsqueda de similitud vectorial y una base de datos vectorial de código abierto que proporciona un servicio listo para la producción con una cómoda API, que te permite almacenar, buscar y gestionar incrustaciones vectoriales.

Visión general de alto nivel de la arquitectura de Qdrant

Características principales:

- API fácil de usar: Proporciona una API Python fácil de usar y también permite a los desarrolladores generar bibliotecas cliente en varios lenguajes de programación.

- Rápido y preciso: Utiliza una modificación personalizada única del algoritmo HNSW para la Búsqueda Aproximada del Vecino Más Cercano, que proporciona velocidades de búsqueda de última generación sin comprometer la precisión.

- Tipos de datos enriquecidos: Qdrant admite una amplia variedad de tipos de datos y condiciones de consulta, como coincidencias de cadenas, rangos numéricos, geolocalizaciones y mucho más.

- Distribuido: Es nativo en la nube y puede escalar horizontalmente, permitiendo a los desarrolladores utilizar la cantidad justa de recursos informáticos para cualquier cantidad de datos que necesiten servir.

- Eficaz: Qdrant está desarrollado íntegramente en Rust, un lenguaje conocido por su rendimiento y eficiencia de recursos.

Descubre las mejores bases de datos vectoriales leyendo Las 5 mejores bases de datos vectoriales | Una lista con ejemplos.

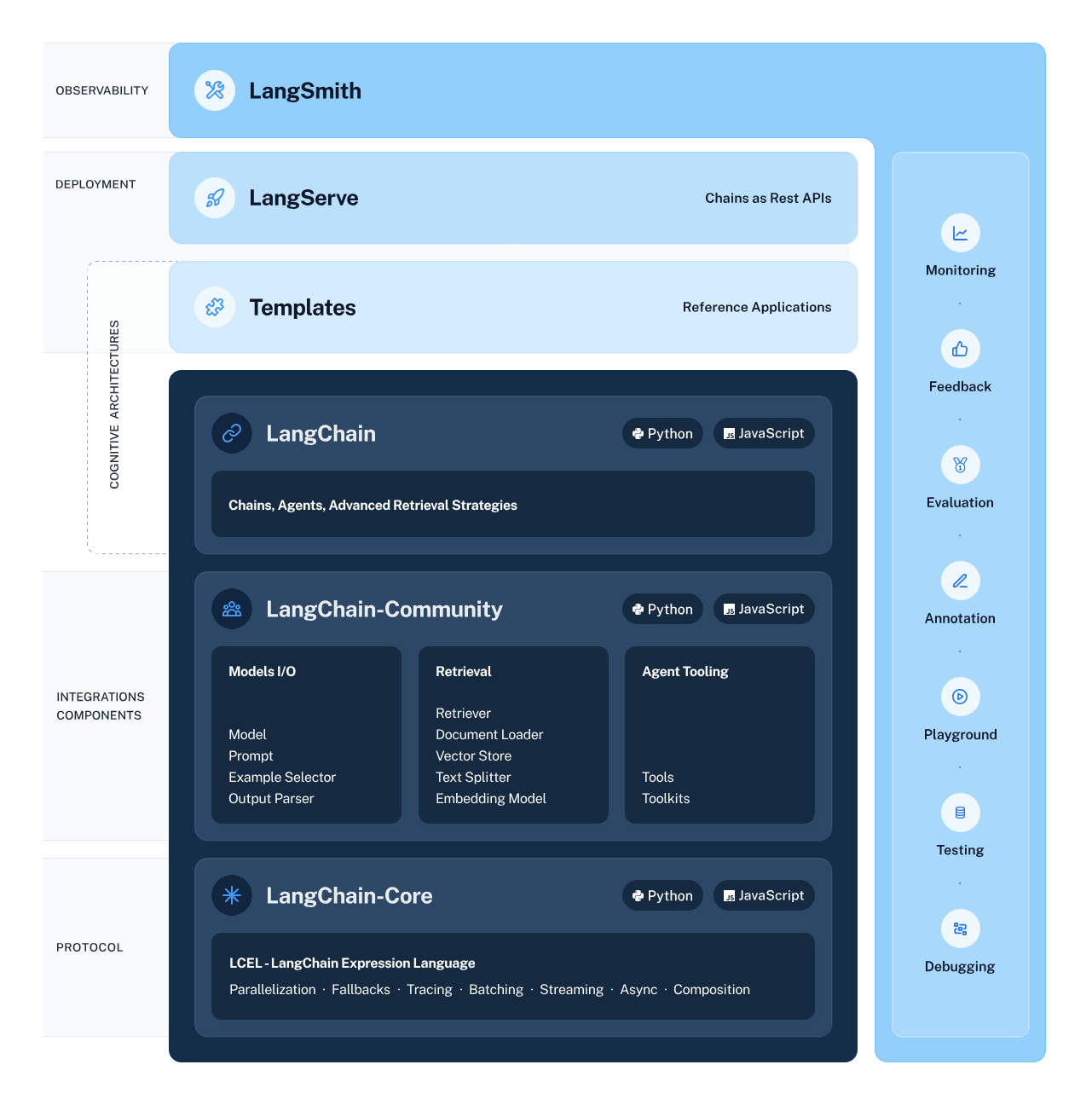

2. LangChain

LangChain es un marco versátil y potente para desarrollar aplicaciones basadas en modelos lingüísticos. Ofrece varios componentes que permiten a los desarrolladores crear, desplegar y supervisar aplicaciones basadas en el razonamiento y conscientes del contexto.

El marco consta de 4 componentes principales:

- Bibliotecas LangChain: Las bibliotecas Python y JavaScript ofrecen interfaces e integraciones que te permiten desarrollar aplicaciones de razonamiento conscientes del contexto.

- Plantillas LangChain: Esta colección de arquitecturas de referencia fácilmente desplegables cubre una amplia variedad de tareas, proporcionando a los desarrolladores soluciones preconstruidas.

- LangServe: Esta biblioteca permite a los desarrolladores desplegar cadenas LangChain como una API REST.

- LangSmith: Una plataforma que te permite depurar, probar, evaluar y supervisar cadenas construidas en cualquier marco LLM.

LangChain Ecosystem

Aprende a crear aplicaciones LLM con LangChain y explora el potencial sin explotar de los grandes modelos lingüísticos.

Herramientas de Seguimiento de Experimentos y Gestión de Metadatos de Modelos

Estas herramientas te permiten gestionar los metadatos de los modelos y te ayudan con el seguimiento de los experimentos:

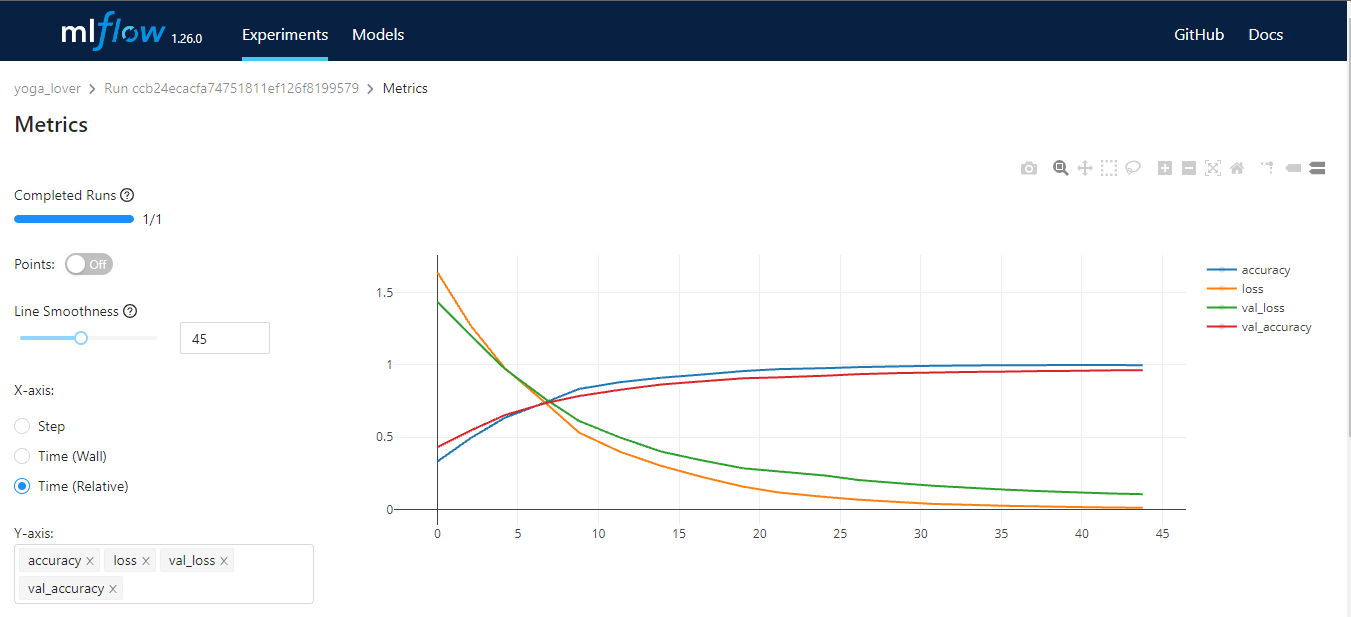

3. MLFlow

MLflow es una herramienta de código abierto que te ayuda a gestionar partes fundamentales del ciclo de vida del aprendizaje automático. Generalmente se utiliza para el seguimiento de experimentos, pero también puedes utilizarlo para la reproducibilidad, el despliegue y el registro de modelos. Puedes gestionar los experimentos de aprendizaje automático y los metadatos de los modelos mediante CLI, Python, R, Java y REST API.

MLflow tiene cuatro funciones básicas:

- Seguimiento de MLflow: almacenamiento y acceso al código, los datos, la configuración y los resultados.

- Proyectos MLflow: paquete fuente de ciencia de datos para la reproducibilidad.

- Modelos MLflow: despliegue y gestión de modelos de aprendizaje automático en diversos entornos de servicio.

- Registro de modelos MLflow: un almacén central de modelos que proporciona versionado, transiciones de etapas, anotaciones y gestión de modelos de aprendizaje automático.

Imagen del autor

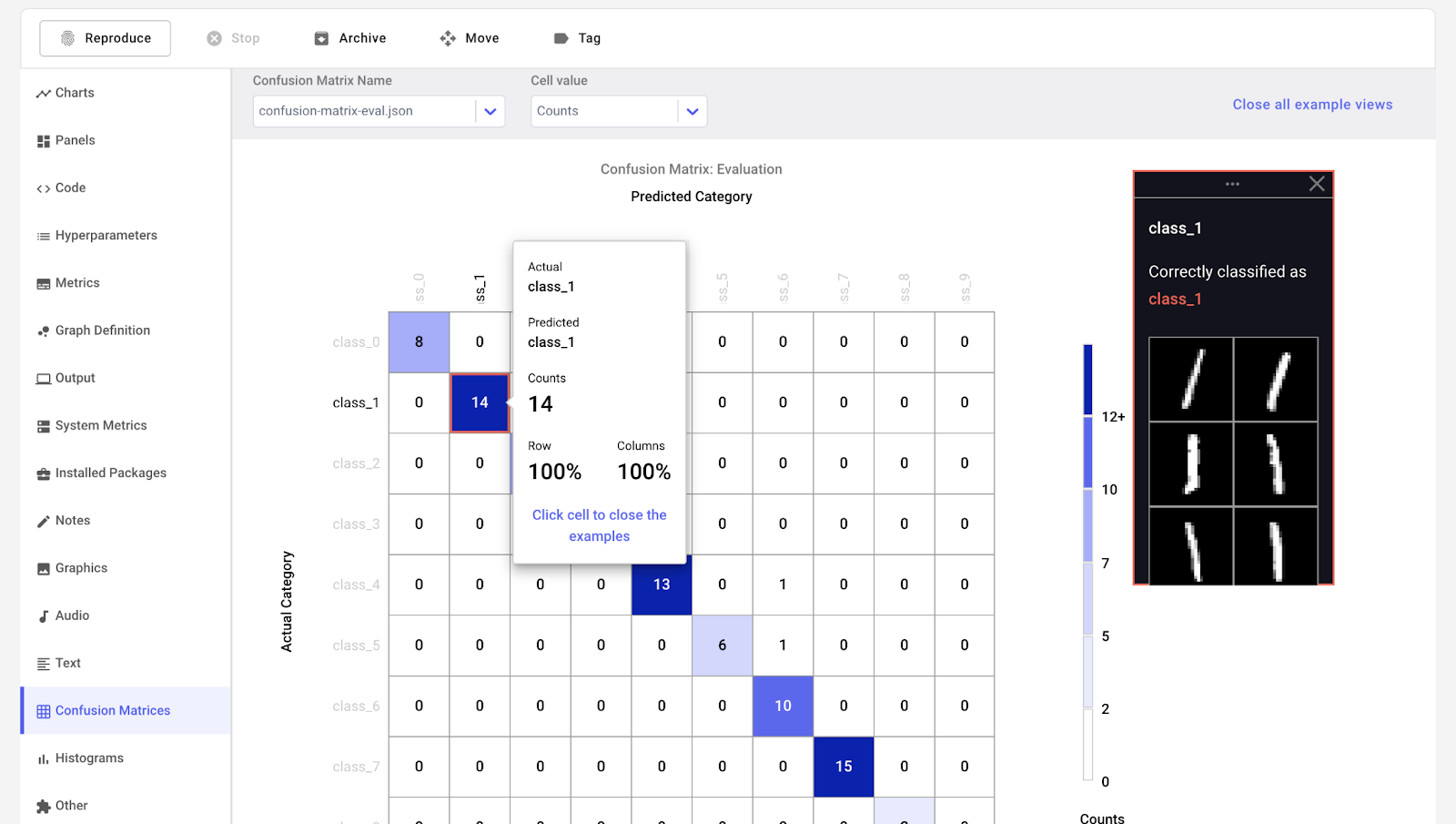

4. Cometa ML

Comet ML es una plataforma para rastrear, comparar, explicar y optimizar modelos y experimentos de aprendizaje automático. Puedes utilizarlo con cualquier biblioteca de aprendizaje automático, como Scikit-learn, Pytorch, TensorFlow y HuggingFace.

Comet ML es para particulares, equipos, empresas y académicos. Permite a cualquiera visualizar y comparar fácilmente los experimentos. Además, te permite visualizar muestras de imágenes, audio, texto y datos tabulares.

Imagen de Comet ML

5. Pesos y sesgos

Weights & Biases es una plataforma de ML para el seguimiento de experimentos, el versionado de datos y modelos, la optimización de hiperparámetros y la gestión de modelos. Además, puedes utilizarlo para registrar artefactos (conjuntos de datos, modelos, dependencias, canalizaciones y resultados) y visualizar los conjuntos de datos (audio, visual, texto y tabular).

Pesos y Sesgos dispone de un panel central de fácil manejo para los experimentos de aprendizaje automático. Al igual que Comet ML, puedes integrarla con otras bibliotecas de aprendizaje automático, como Fastai, Keras, PyTorch, Hugging face, Yolov5, Spacy y muchas más. Puedes consultar nuestra introducción a Pesos y BIases en otro artículo.

Gif de Pesos y prejuicios

Nota: También puedes utilizar TensorBoard, Pachyderm, DagsHub y DVC Studio para el seguimiento de experimentos y la gestión de metadatos de ML.

Orquestación y flujos de trabajo Herramientas MLOps

Estas herramientas te ayudan a crear proyectos de ciencia de datos y a gestionar flujos de trabajo de aprendizaje automático:

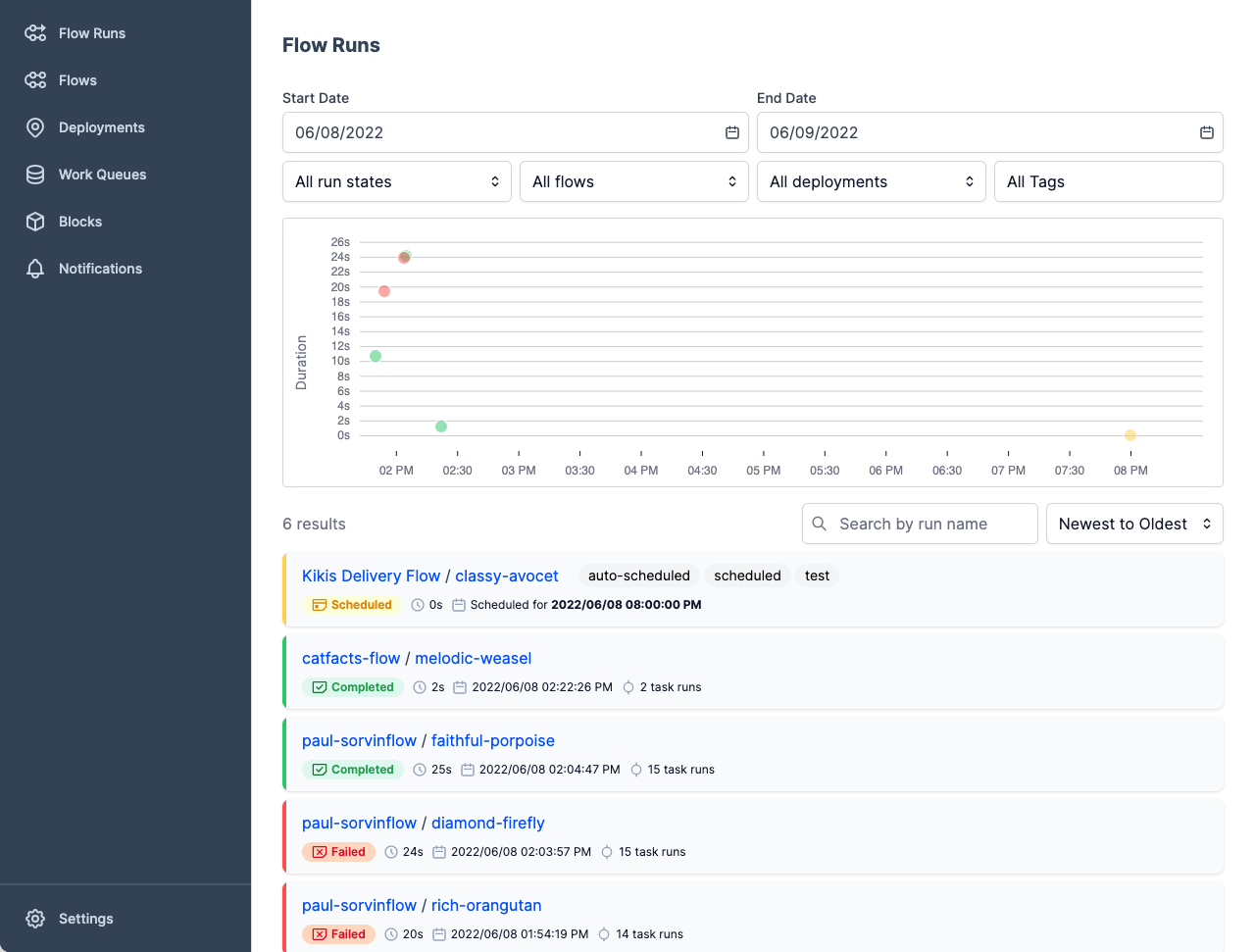

6. Prefecto

El Prefect es una moderna pila de datos para supervisar, coordinar y orquestar flujos de trabajo entre y a través de aplicaciones. Se trata de una herramienta ligera y de código abierto creada para canalizar el aprendizaje automático de extremo a extremo.

Puedes utilizar Prefect Orion UI o Prefect Cloud para las bases de datos.

- Prefect Orion UI es un motor de orquestación y servidor API de código abierto alojado localmente. Te proporciona información sobre la instancia local de Prefect Orion y los flujos de trabajo.

- Prefect Cloud es un servicio alojado para que visualices flujos, ejecuciones de flujos y despliegues. Además, puedes gestionar las cuentas, el espacio de trabajo y la colaboración en equipo.

Imagen de Prefect

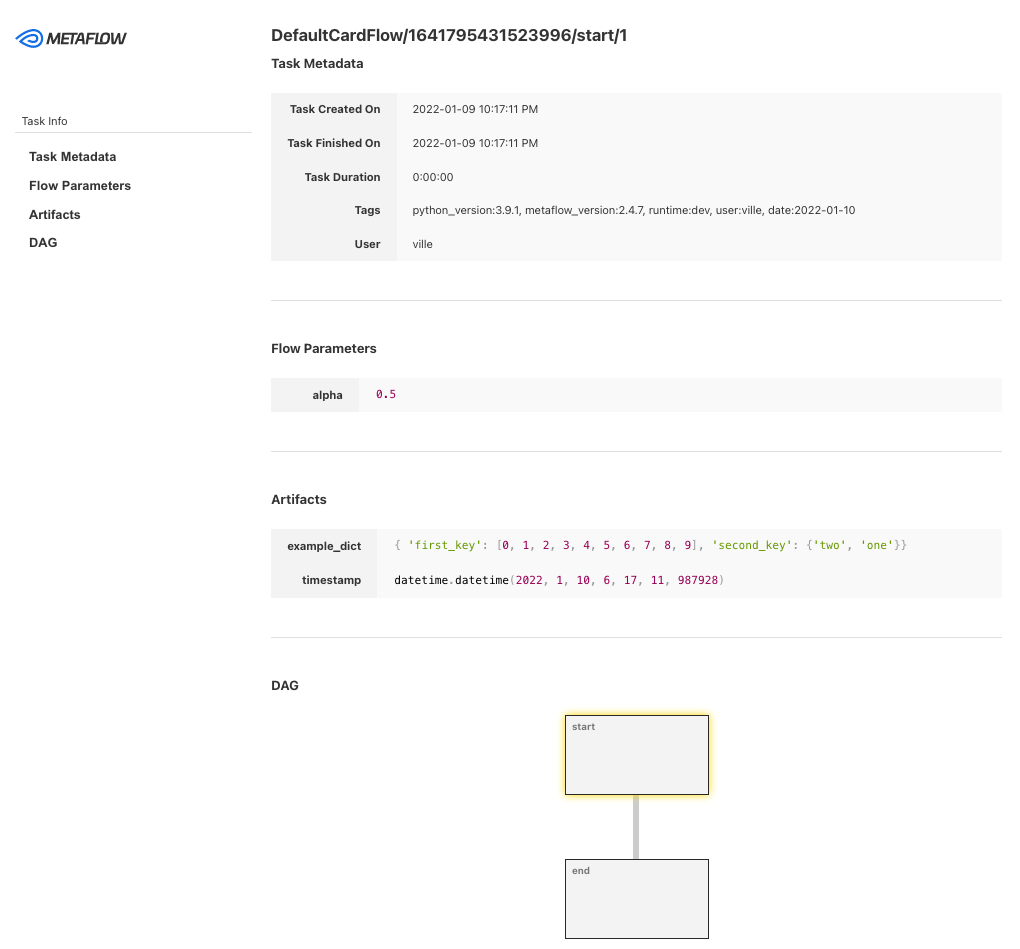

7. Metaflow

Metaflow es una potente herramienta de gestión de flujos de trabajo para proyectos de ciencia de datos y aprendizaje automático. Se ha creado para que los científicos de datos puedan centrarse en crear modelos en lugar de preocuparse por la ingeniería de MLOps.

Con Metaflow, puedes diseñar el flujo de trabajo, ejecutarlo a escala y desplegar el modelo en producción. Rastrea y versiona automáticamente los experimentos y datos de aprendizaje automático. Además, puedes visualizar los resultados en el cuaderno.

Metaflow funciona con múltiples nubes (incluidas AWS, GCP y Azure) y varios paquetes Python de aprendizaje automático (como Scikit-learn y Tensorflow), y la API también está disponible para el lenguaje R.

Imagen de Metaflow

8. Kedro

Kedro es una herramienta de orquestación de flujos de trabajo basada en Python. Puedes utilizarlo para crear proyectos de ciencia de datos reproducibles, mantenibles y modulares. Integra los conceptos de la ingeniería del software en el aprendizaje automático, como la modularidad, la separación de preocupaciones y el versionado.

Con Kedro, puedes:

- Establece las dependencias y la configuración.

- Establece los datos.

- Crea, visualiza y ejecuta las canalizaciones.

- Registro y seguimiento de experimentos.

- Despliegue en una máquina única o distribuida.

- Crear código de ciencia de datos mantenible.

- Crea código modular y reutilizable.

- Colabora con compañeros de equipo en proyectos.

Gif de Kedro

Nota: también puedes utilizar Kubeflow y DVC para la orquestación y las canalizaciones del flujo de trabajo.

Herramientas de control de versiones de datos y tuberías

Con estas herramientas de MLOps, puedes gestionar las tareas relacionadas con los datos y el versionado de las canalizaciones:

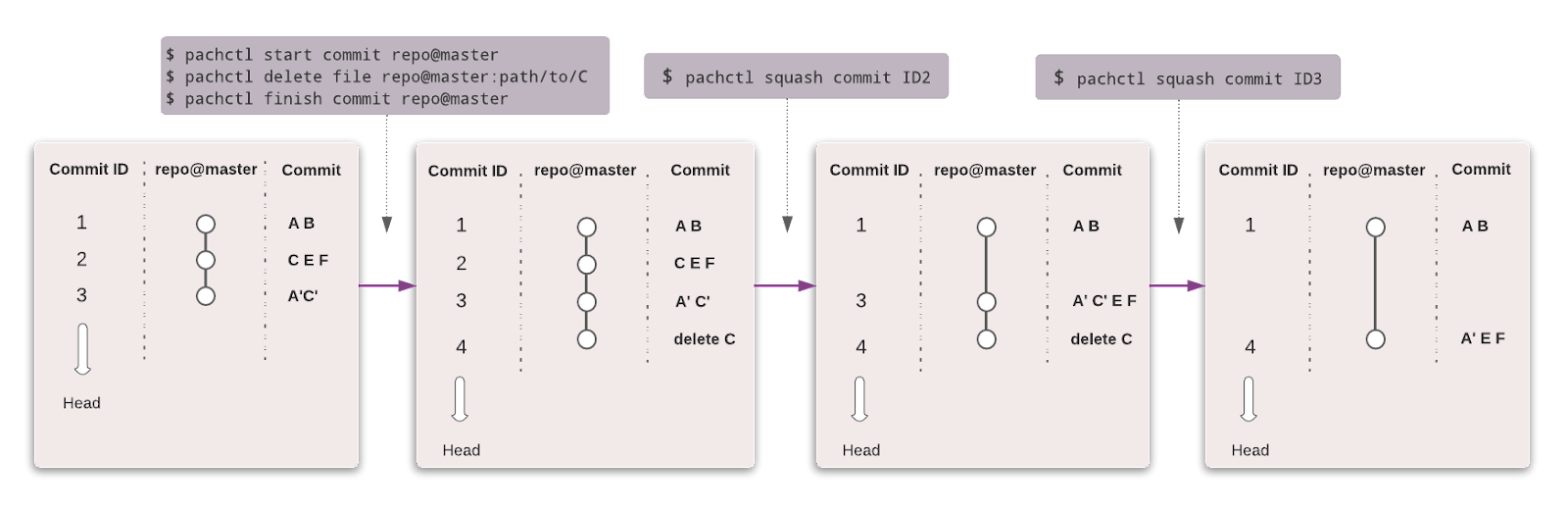

9. Paquidermo

Pachyderm automatiza la transformación de datos con versionado de datos, linaje y canalizaciones de extremo a extremo en Kubernetes. Puedes integrarte con cualquier dato (imágenes, registros, vídeo, CSV), cualquier lenguaje (Python, R, SQL, C/C++) y a cualquier escala (Petabytes de datos, miles de trabajos).

La edición comunitaria es de código abierto y para un equipo pequeño. Las organizaciones y equipos que deseen funciones avanzadas pueden optar por la edición Enterprise.

Al igual que Git, puedes versionar tus datos utilizando una sintaxis similar. En Pachyderm, el nivel más alto del objeto es Repositorio, y puedes utilizar Commit, Ramas, Archivo, Historial y Procedencia para rastrear y versionar el conjunto de datos.

Imagen de Pachyderm

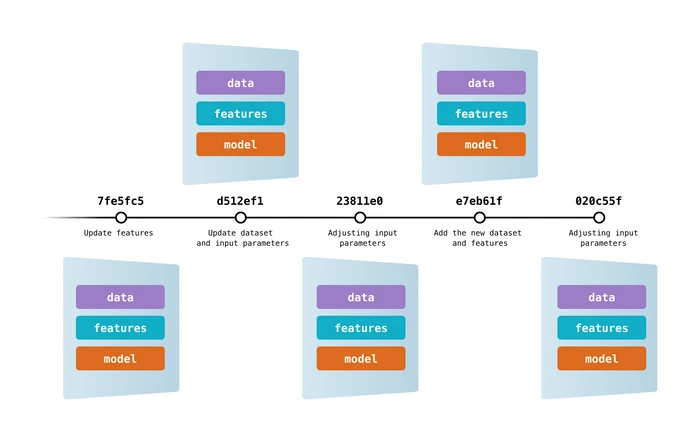

10. Control de versiones de datos (DVC)

El Control de Versiones de Datos es una herramienta popular y de código abierto para proyectos de aprendizaje automático. Funciona a la perfección con Git para proporcionarte versiones de código, datos, modelos, metadatos y canalizaciones.

DVC es algo más que una herramienta de seguimiento y versionado de datos.

Puedes utilizarlo para:

- Seguimiento de experimentos (métricas del modelo, parámetros, versionado).

- Crea, visualiza y ejecuta canalizaciones de aprendizaje automático.

- Flujo de trabajo para el despliegue y la colaboración.

- Reproducibilidad.

- Registro de datos y modelos.

- Integración y despliegue continuos para el aprendizaje automático mediante CML.

Imagen de DVC

Nota: DagsHub también puede utilizarse para versionar datos y tuberías.

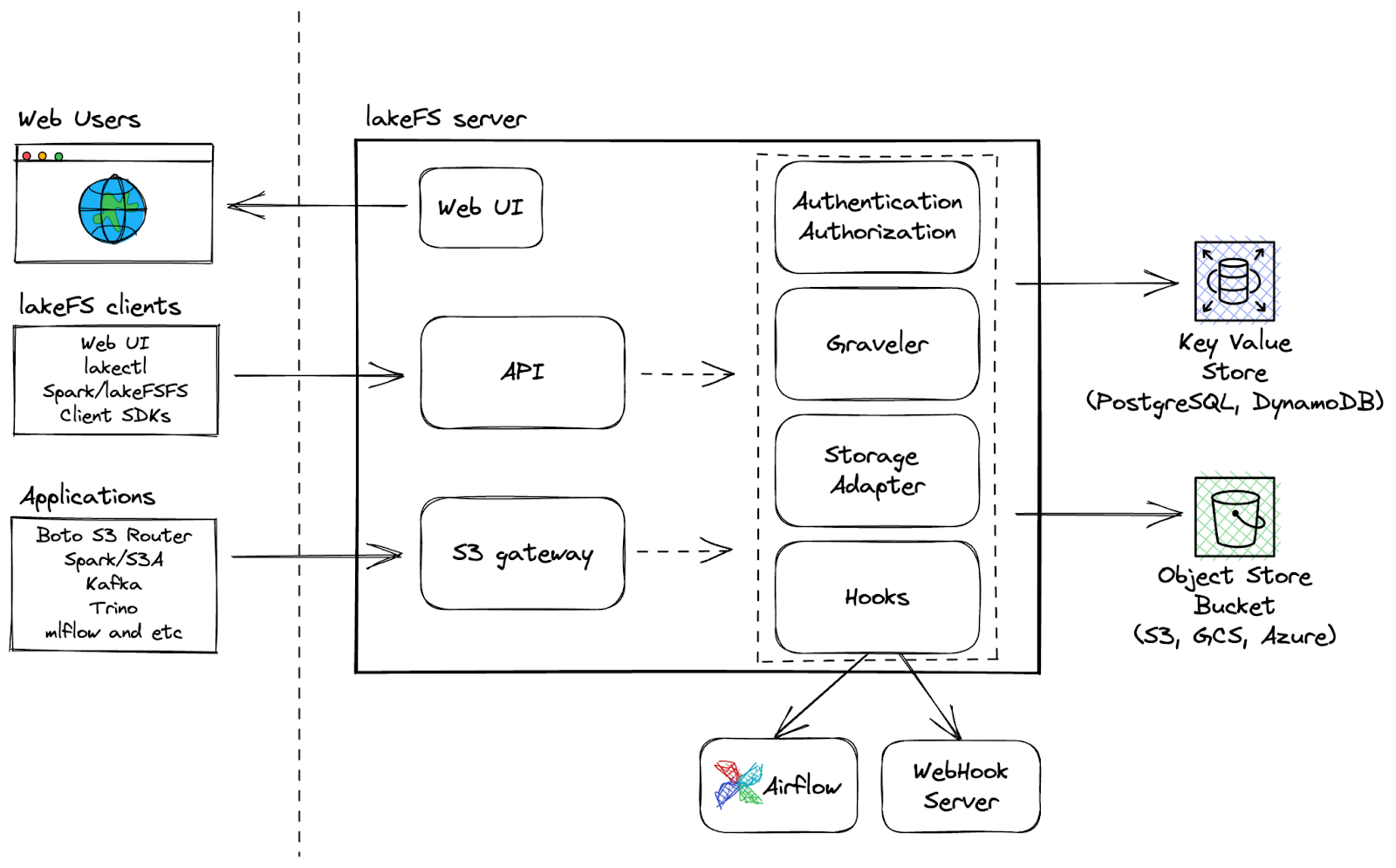

11. LakeFS

LakeFS es una herramienta de control de versiones de datos escalable y de código abierto que proporciona una interfaz de control de versiones similar a Git para el almacenamiento de objetos, permitiendo a los usuarios gestionar sus lagos de datos como lo harían con su código. Con LakeFS, los usuarios pueden controlar las versiones de los datos a escala de exabytes, lo que la convierte en una solución altamente escalable para gestionar grandes lagos de datos.

Capacidades adicionales:

- Realiza operaciones Git como bifurcar, confirmar y combinar en cualquier servicio de almacenamiento

- Desarrollo más rápido con bifurcación de copia cero para una experimentación sin fricciones y una colaboración sencilla.

- Utiliza ganchos pre-commit y merge para los flujos de trabajo CI/CD para garantizar flujos de trabajo limpios

- La plataforma resistente permite una recuperación más rápida de los problemas de datos con la capacidad de revertir.

LakeFS Architecture

Tiendas especializadas

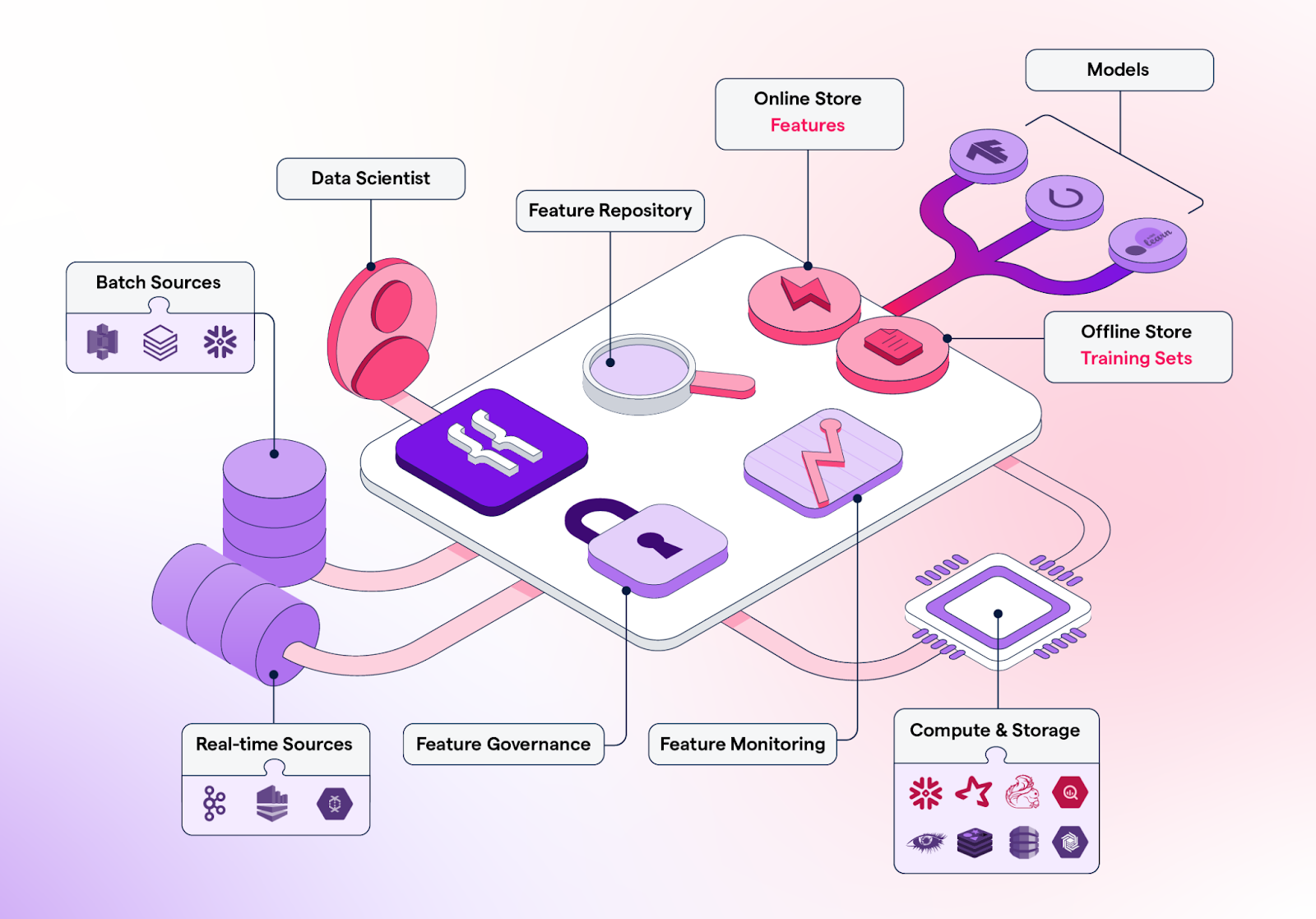

Los almacenes de características son depósitos centralizados para almacenar, versionar, gestionar y servir características (atributos de datos procesados utilizados para entrenar modelos de aprendizaje automático) para modelos de aprendizaje automático tanto en producción como con fines de entrenamiento.

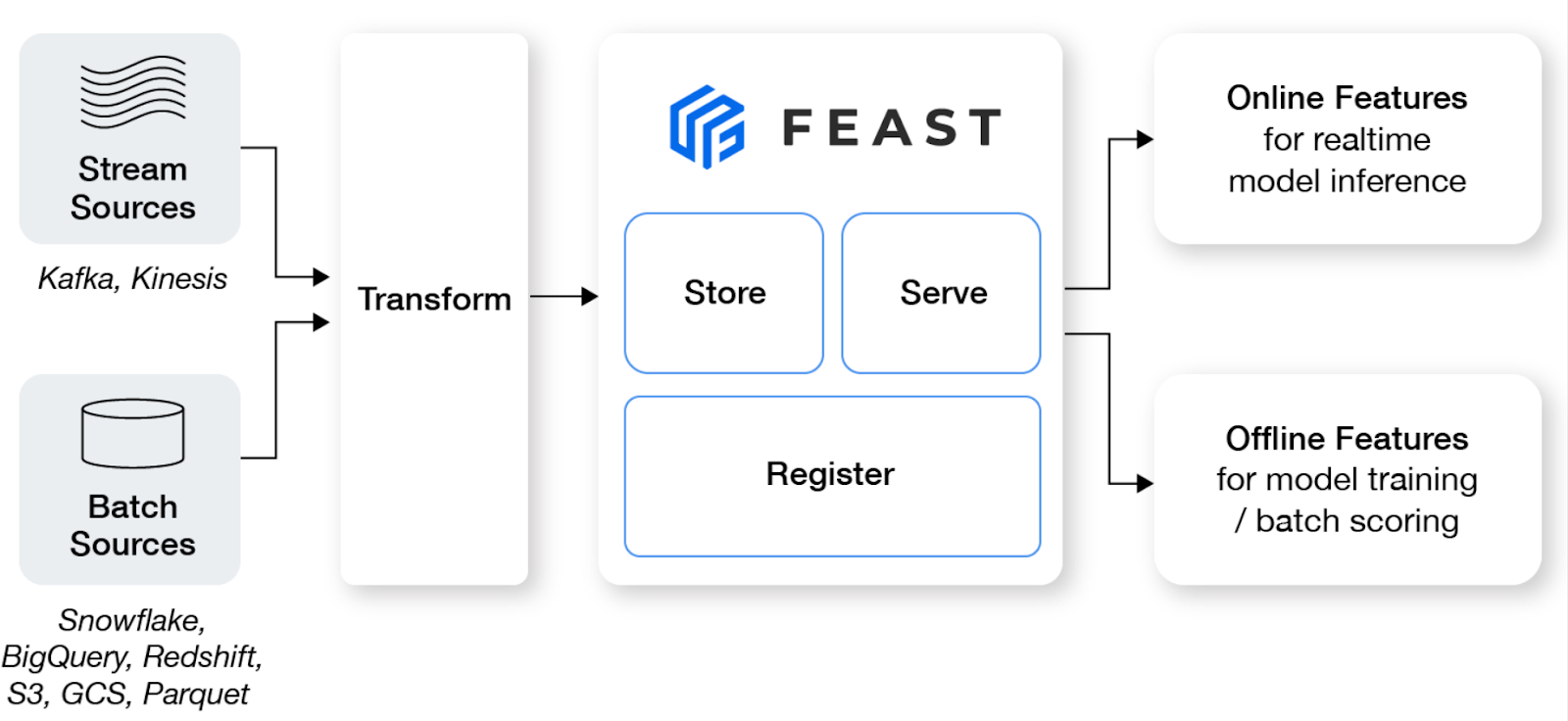

12. Fiesta

Feast es un almacén de funciones de código abierto que ayuda a los equipos de aprendizaje automático a producir modelos en tiempo real y a construir una plataforma de funciones que fomente la colaboración entre ingenieros y científicos de datos.

Características principales:

- Gestiona un almacén fuera de línea, un almacén en línea de baja latencia y un servidor de funciones para garantizar la disponibilidad constante de funciones tanto para la formación como para el servicio.

- Evita la fuga de datos creando conjuntos precisos de características puntuales, liberando a los científicos de datos de lidiar con la unión de conjuntos de datos propensos a errores.

- Desacopla el ML de la infraestructura de datos, teniendo una única capa de acceso.

Imagen de Fiesta

13. Featureform

Featureform es un almacén virtual de características que permite a los científicos de datos definir, gestionar y servir las características de su modelo ML. Puede ayudar a los equipos de ciencia de datos a mejorar la colaboración, organizar la experimentación, facilitar el despliegue, aumentar la fiabilidad y preservar el cumplimiento.

Características principales:

- Mejora la colaboración compartiendo, reutilizando y comprendiendo funciones en todo el equipo.

- Cuando tu función esté lista para desplegarse, Featureform orquestará tu infraestructura de datos para que esté lista para la producción.

- El sistema garantiza que no se modifiquen las características, las etiquetas ni los conjuntos de entrenamiento para aumentar la fiabilidad.

- Con el control de acceso integrado basado en roles, los registros de auditoría y las reglas de servicio dinámicas, Featureform puede aplicar directamente tu lógica de cumplimiento.

Imagen de Featureform

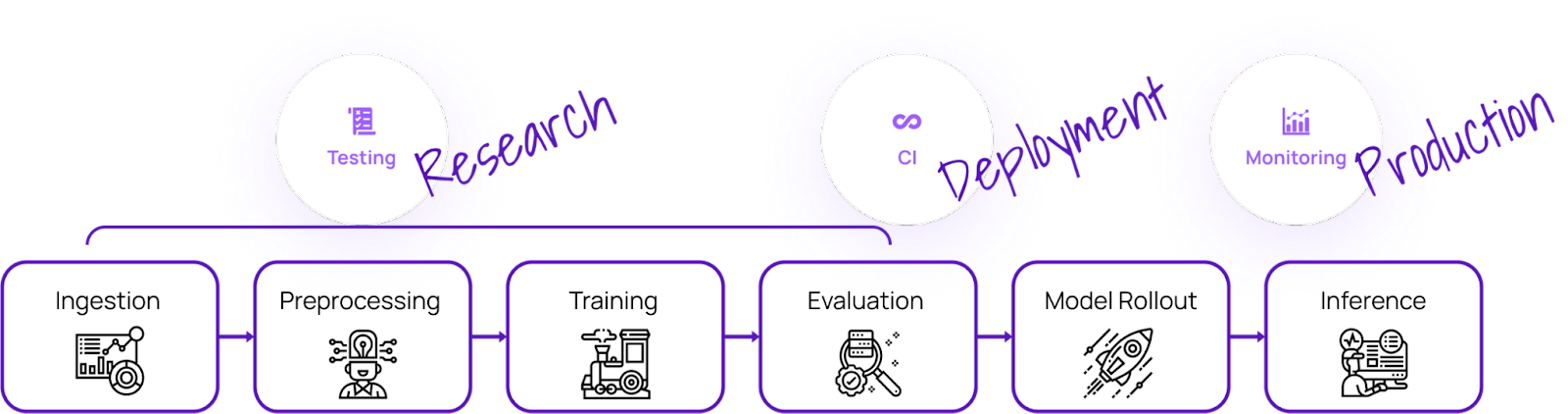

Prueba de modelos

Con estas herramientas de MLOps, puedes probar la calidad del modelo y garantizar la fiabilidad, solidez y precisión de los modelos de aprendizaje automático:

14. Pruebas de modelos ML Deepchecks

Deepchecks es una solución de código abierto que satisface todas tus necesidades de validación de ML, garantizando que tus datos y modelos se comprueban a fondo desde la investigación hasta la producción. Ofrece un enfoque holístico para validar tus datos y modelos a través de sus diversos componentes.

Imagen de Deepchecks

Las comprobaciones profundas constan de tres componentes:

- Pruebas Deepchecks: te permite crear comprobaciones y suites personalizadas para validación tabular, de procesamiento del lenguaje natural y de visión por ordenador.

- Gestión de pruebas y CI: proporciona gestión de pruebas y CI para ayudarte a colaborar con tu equipo y gestionar los resultados de las pruebas con eficacia.

- Supervisión de Deepchecks: rastrea y valida los modelos en producción.

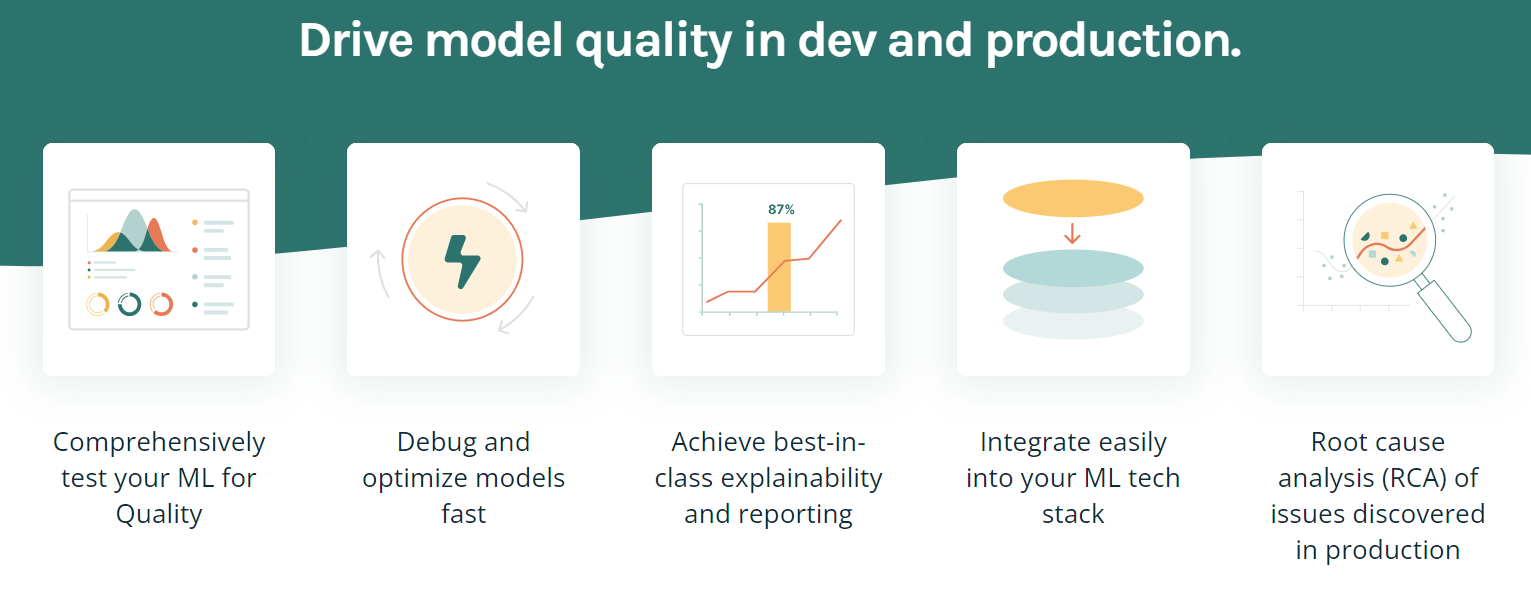

15. TruEra

TruEra es una plataforma avanzada diseñada para impulsar la calidad y el rendimiento de los modelos mediante pruebas automatizadas, capacidad de explicación y análisis de las causas raíz. Ofrece varias funciones para ayudar a optimizar y depurar modelos, lograr la mejor explicabilidad de su clase e integrarse fácilmente en tu pila tecnológica de ML.

Características principales:

- La función de comprobación y depuración de modelos te permite mejorar la calidad de los modelos durante el desarrollo y la producción.

- Puede realizar pruebas automatizadas y sistemáticas para garantizar el rendimiento, la estabilidad y la equidad.

- Comprende la evolución de las versiones de los modelos. Esto te permite extraer ideas que guíen un desarrollo de modelos más rápido y eficaz.

- Identificar y precisar qué características concretas contribuyen al sesgo del modelo.

- TruEra puede integrarse fácilmente en tu infraestructura y flujo de trabajo actuales sin ninguna complicación.

Imagen de TruEra

Herramientas de despliegue y servicio de modelos

A la hora de desplegar modelos, estas herramientas MLOps pueden ser de gran ayuda:

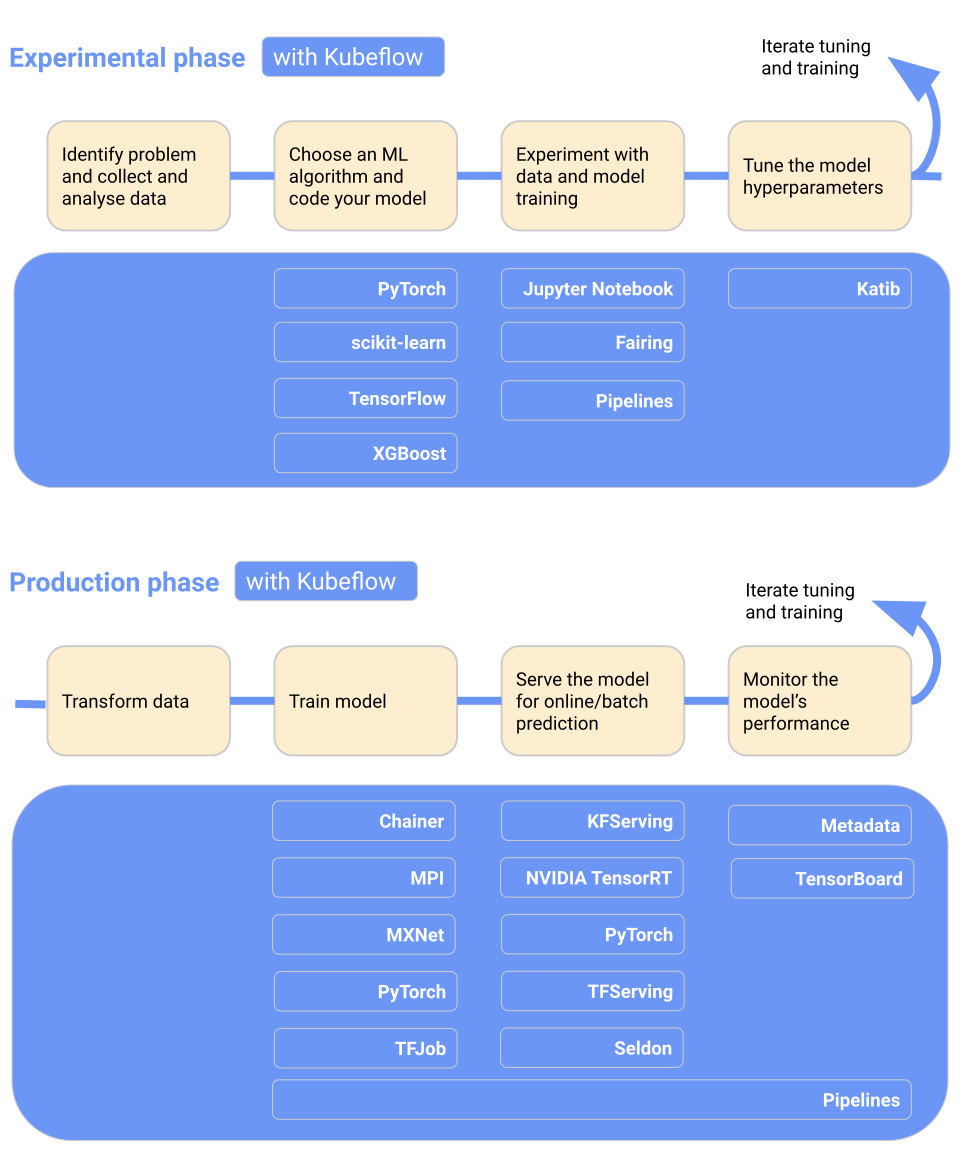

16. Kubeflow

Kubeflow hace que el despliegue de modelos de aprendizaje automático en Kubernetes sea sencillo, portátil y escalable. Puedes utilizarlo para preparar datos, entrenar modelos, optimizar modelos, servir predicciones y motorizar el rendimiento del modelo en producción. Puedes desplegar el flujo de trabajo de aprendizaje automático localmente, en las instalaciones o en la nube. En resumen, facilita Kubernetes a los equipos de ciencia de datos.

Características principales:

- Panel de control centralizado con interfaz de usuario interactiva.

- Pipelines de aprendizaje automático para la reproducibilidad y la racionalización.

- Proporciona soporte nativo para JupyterLab, RStudio y Visual Studio Code.

- Ajuste de hiperparámetros y búsqueda de arquitecturas neuronales.

- Trabajos de entrenamiento para Tensorflow, Pytorch, PaddlePaddle, MXNet y XGboost.

- Programación del trabajo.

- Proporciona a los administradores aislamiento multiusuario.

- Funciona con los principales proveedores de la nube.

Imagen de Kubeflow

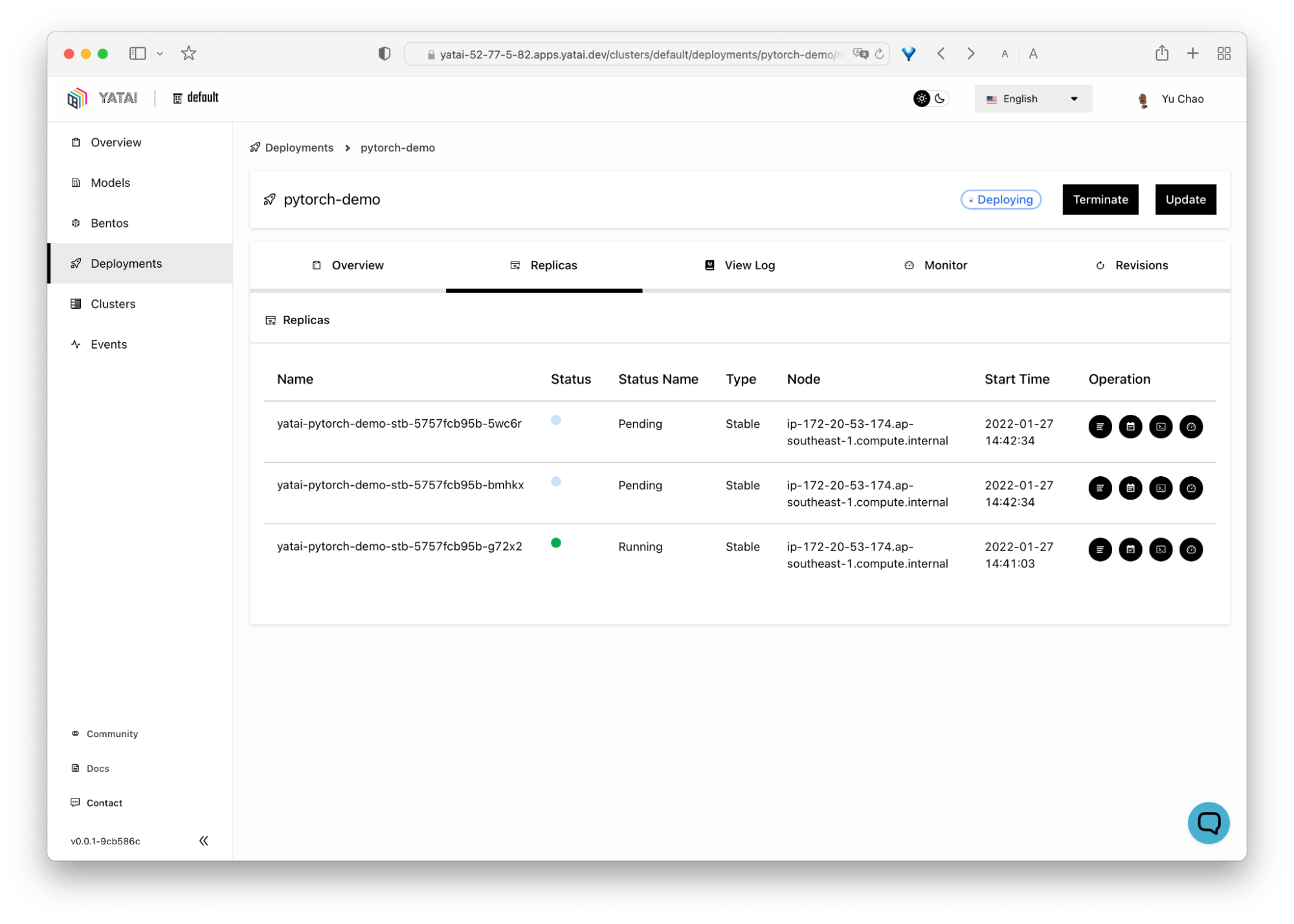

10. BentoML

BentoML facilita y agiliza la distribución de aplicaciones de aprendizaje automático. Es una herramienta basada en Python para desplegar y mantener APIs en producción. Se escala con potentes optimizaciones mediante la inferencia paralela y la dosificación adaptativa, y proporciona aceleración por hardware.

El panel de control centralizado e interactivo de BentoML facilita la organización y la supervisión al desplegar modelos de aprendizaje automático. Lo mejor es que funciona con todo tipo de marcos de aprendizaje automático, como Keras, ONNX, LightGBM, Pytorch y Scikit-learn. En resumen, BentoML proporciona una solución completa para el despliegue, el servicio y la supervisión de modelos.

Imagen de BentoML

18. Puntos Finales de la Inferencia de Caras Abrazadas

Hugging Face Inference Endpoints es un servicio basado en la nube ofrecido por Hugging Face, una plataforma de ML todo en uno que permite a los usuarios entrenar, alojar y compartir modelos, conjuntos de datos y demostraciones. Estos puntos finales están diseñados para ayudar a los usuarios a desplegar sus modelos de aprendizaje automático entrenados para la inferencia sin necesidad de configurar y gestionar la infraestructura necesaria.

Características principales:

- Mantén el coste tan bajo como 0,06 $ por núcleo de CPU/hora y 0,6 $ por GPU/hora, según tus necesidades.

- Fácil de desplegar en segundos.

- Totalmente gestionado y autoescalable.

- Forma parte del ecosistema Cara Abrazada.

- Seguridad de nivel empresarial.

Imagen de Cara de abrazo

Nota: También puedes utilizar MLflow y AWS sagemaker para desplegar y servir modelos.

Monitorización de modelos en herramientas de operaciones de ML de producción

Tanto si tu modelo ML está en desarrollo, validación o desplegado en producción, estas herramientas pueden ayudarte a controlar una serie de factores:

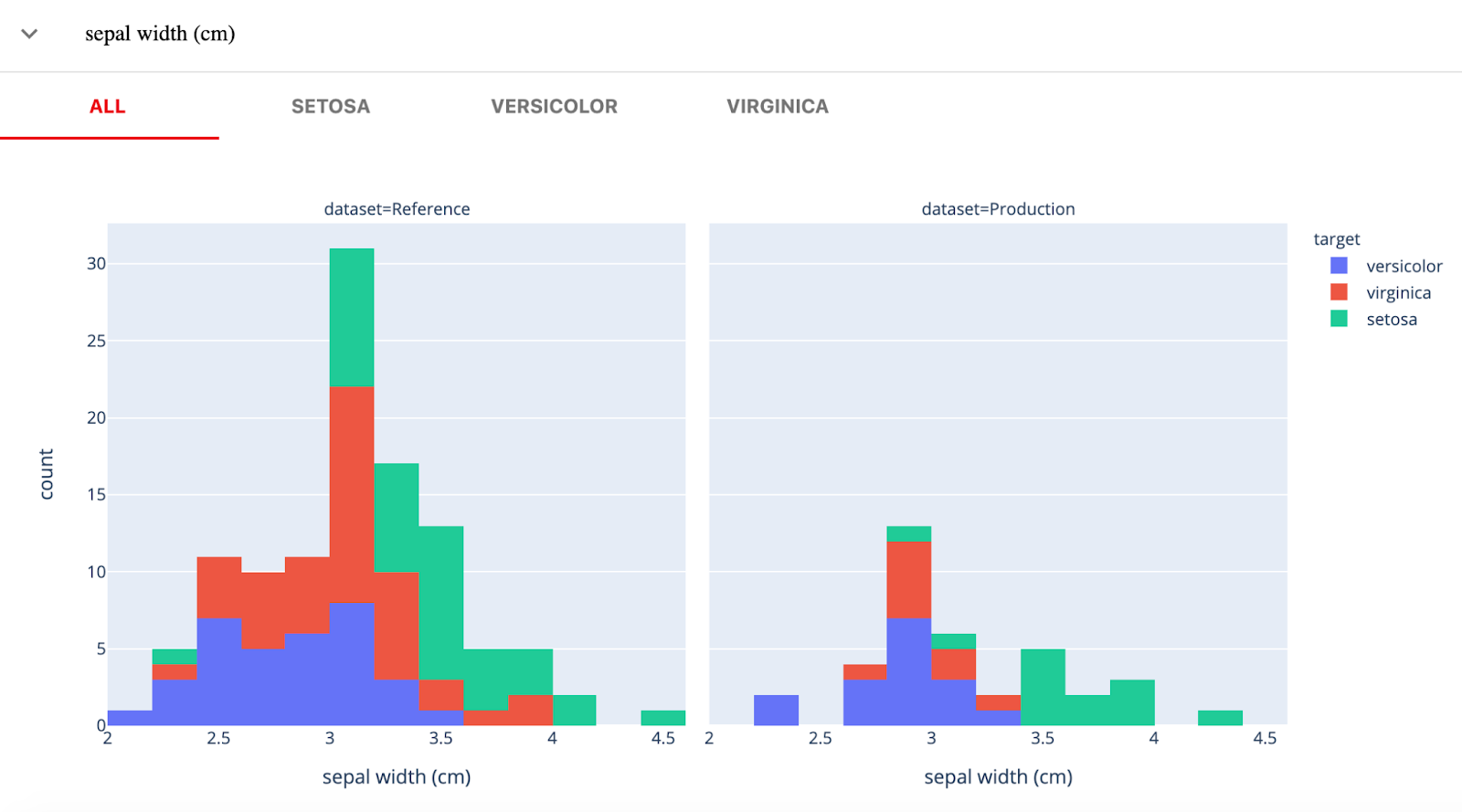

19. Evidentemente

Evidentemente, AI es una biblioteca Python de código abierto para monitorizar modelos ML durante el desarrollo, la validación y en producción. Comprueba la calidad de los datos y del modelo, la deriva de los datos, la deriva del objetivo y el rendimiento de la regresión y la clasificación.

Evidentemente tiene tres componentes principales:

- Pruebas (comprobaciones de modelo por lotes): para realizar comprobaciones de datos estructurados y de calidad del modelo.

- Informes (cuadros de mando interactivos): deriva interactiva de datos, rendimiento del modelo y virtualización del objetivo.

- Monitores (monitorización en tiempo real): monitoriza los datos y las métricas del modelo del servicio ML desplegado.

Imagen de Evidentemente

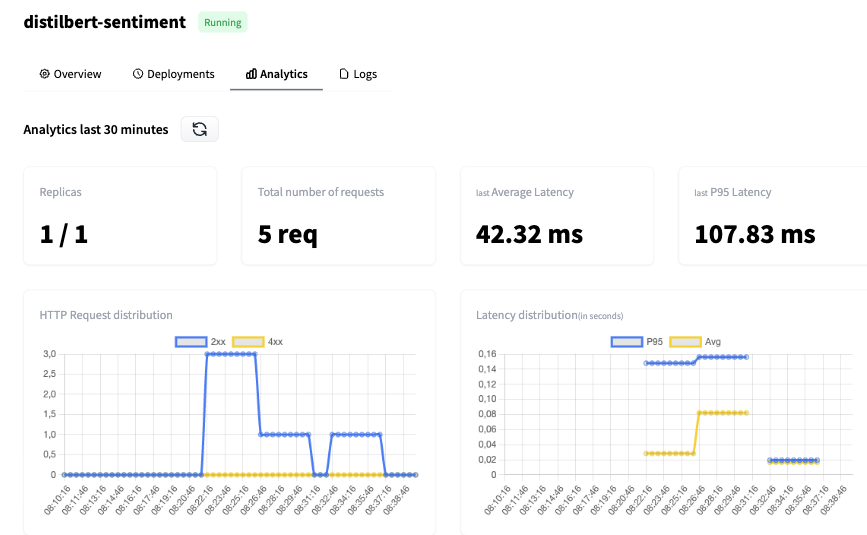

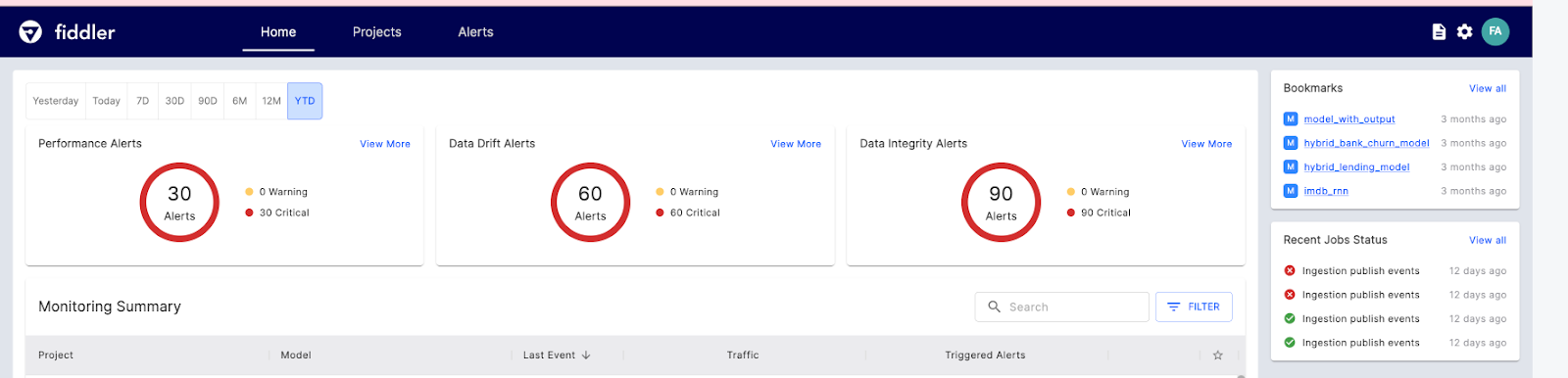

20. Violinista

Fiddler AI es una herramienta de monitorización de modelos ML con una interfaz de usuario clara y fácil de usar. Te permite explicar y depurar predicciones, analizar el comportamiento del modo para todo el conjunto de datos, desplegar modelos de aprendizaje automático a escala y supervisar el rendimiento del modelo.

Veamos las principales funciones de la IA de Fiddler para la monitorización ML:

- Supervisión del rendimiento: visualización en profundidad de la deriva de los datos, cuándo y cómo deriva.

- Integridad de los datos: evita introducir datos incorrectos para el entrenamiento del modelo.

- Seguimiento de valores atípicos: muestra los valores atípicos univariantes y multivariantes.

- Métricas del servicio: muestra información básica sobre las operaciones del servicio de ML.

- Alertas: configura alertas para un modelo o grupo de modelos para avisar de los problemas en producción.

Imagen de El violinista

Motores de tiempo de ejecución

El motor de ejecución se encarga de cargar el modelo, preprocesar los datos de entrada, ejecutar la inferencia y devolver los resultados a la aplicación cliente.

21. Ray

Ray es un marco versátil diseñado para escalar aplicaciones de IA y Python, facilitando a los desarrolladores la gestión y optimización de sus proyectos de aprendizaje automático.

La plataforma consta de dos componentes principales: un núcleo de tiempo de ejecución distribuido y un conjunto de bibliotecas de IA adaptadas para simplificar la computación ML.

Ray Core ofrece un conjunto limitado de elementos fundamentales que pueden utilizarse para construir y ampliar aplicaciones distribuidas.

- Las tareas son funciones que no tienen estado y se ejecutan dentro del clúster.

- Los actores son procesos de trabajo con estado que se crean dentro del clúster.

- Los objetos son valores inmutables a los que puede acceder cualquier componente del cluster.

Ray también proporciona bibliotecas de IA para conjuntos de datos escalables para ML, formación distribuida, ajuste de hiperparámetros, aprendizaje por refuerzo y servicio escalable y programable.

El siguiente ejemplo muestra el entrenamiento y el servicio de un modelo Clasificador de Impulso Gradiente.

import requests

from starlette.requests import Request

from typing import Dict

from sklearn.datasets import load_iris

from sklearn.ensemble import GradientBoostingClassifier

from ray import serve

# Train model.

iris_dataset = load_iris()

model = GradientBoostingClassifier()

model.fit(iris_dataset["data"], iris_dataset["target"])

@serve.deployment

class BoostingModel:

def __init__(self, model):

self.model = model

self.label_list = iris_dataset["target_names"].tolist()

async def __call__(self, request: Request) -> Dict:

payload = (await request.json())["vector"]

print(f"Received http request with data {payload}")

prediction = self.model.predict([payload])[0]

human_name = self.label_list[prediction]

return {"result": human_name}

# Deploy model.

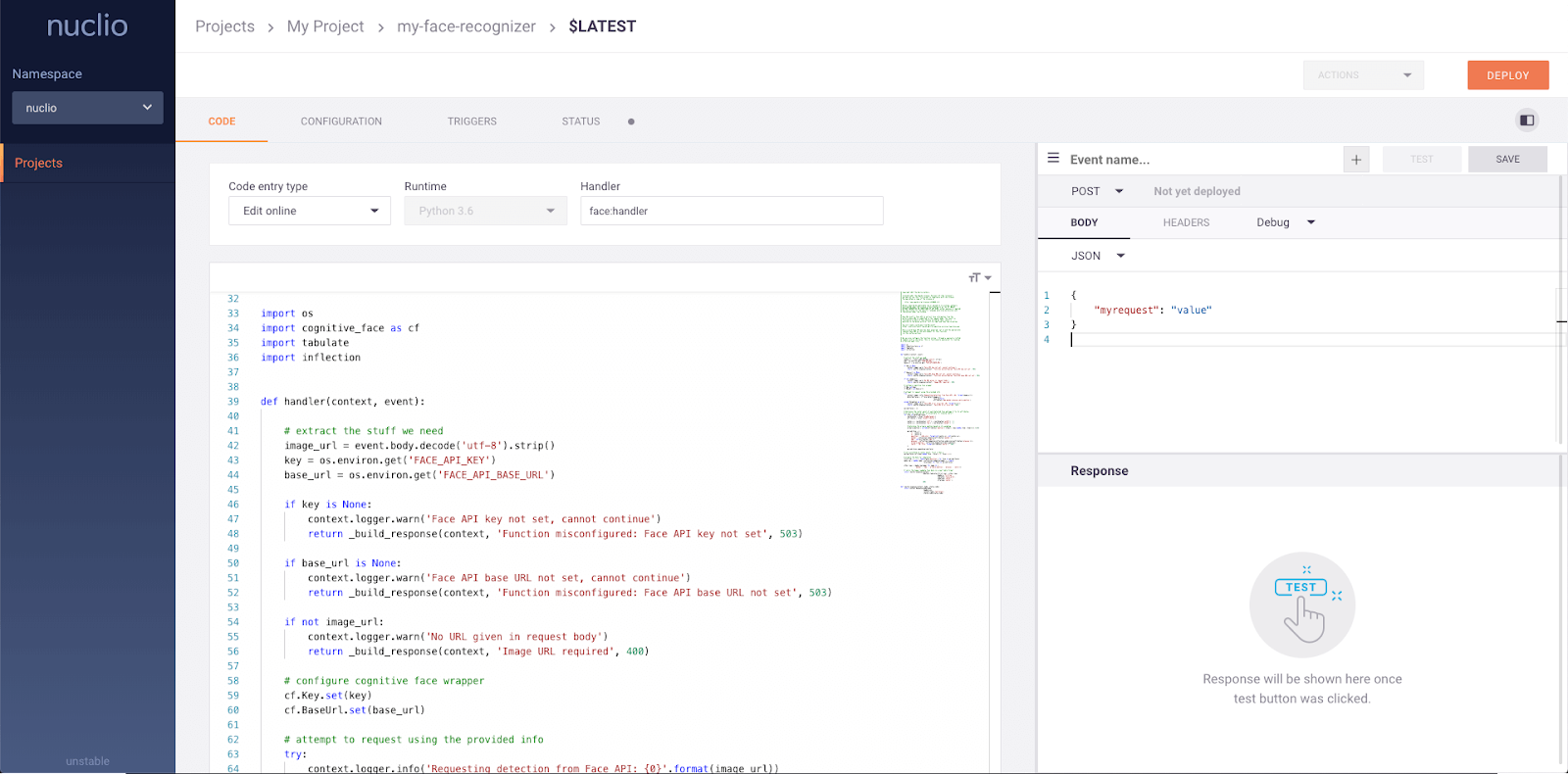

serve.run(BoostingModel.bind(model), route_prefix="/iris")22. Nuclio

Nuclio es un potente marco centrado en cargas de trabajo intensivas en datos, E/S y cálculo. Está diseñado para funcionar sin servidor, lo que significa que no tienes que preocuparte de gestionar servidores. Nuclio está bien integrado con herramientas populares de ciencia de datos, como Jupyter y Kubeflow. También admite una amplia variedad de fuentes de datos y streaming y puede ejecutarse en CPU y GPU.

Características principales:

- Requiere un mínimo de recursos de CPU/GPU y E/S para realizar el procesamiento en tiempo real maximizando el paralelismo.

- Se integra con una amplia gama de fuentes de datos y marcos de ML.

- Proporciona funciones de estado con aceleración de ruta de datos

- Portabilidad a través de todo tipo de dispositivos y plataformas en la nube, especialmente dispositivos de bajo consumo.

- Diseñado para la empresa.

Imagen de Nuclio

Plataformas MLOps integrales

Si buscas una herramienta MLOps completa que te ayude durante todo el proceso, aquí tienes algunas de las mejores:

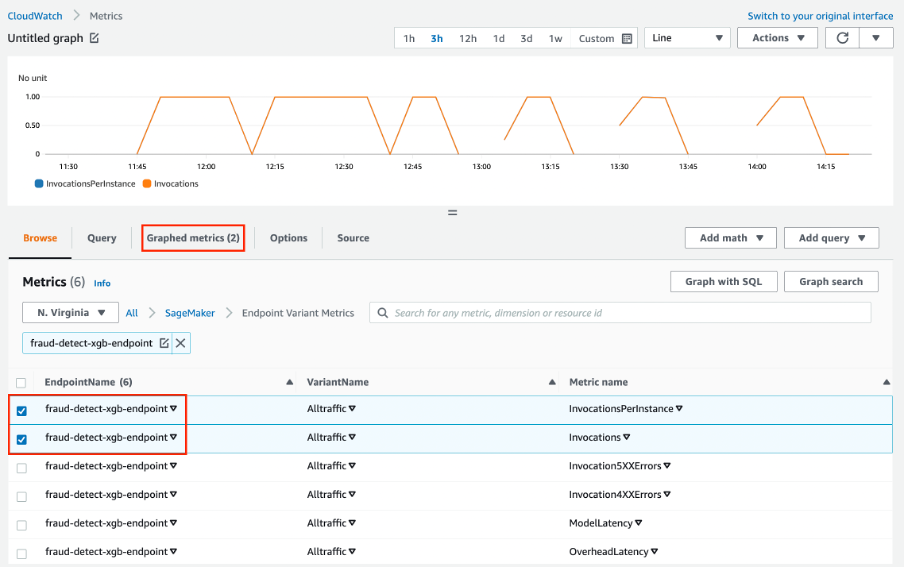

23. AWS SageMaker

Amazon Web Services SageMaker es una solución integral para MLOps. Puedes entrenar y acelerar el desarrollo de modelos, seguir y versionar experimentos, catalogar artefactos de ML, integrar conductos de CI/CD ML, y desplegar, servir y supervisar modelos en producción sin problemas.

Características principales:

- Un entorno colaborativo para equipos de ciencia de datos.

- Automatiza los flujos de trabajo de entrenamiento ML.

- Despliega y gestiona modelos en producción.

- Seguir y mantener las versiones de los modelos.

- CI/CD para integración y despliegue automáticos.

- Seguimiento continuo y modelos de retención para mantener la calidad.

- Optimiza el coste y el rendimiento.

Imagen de Amazon SageMaker

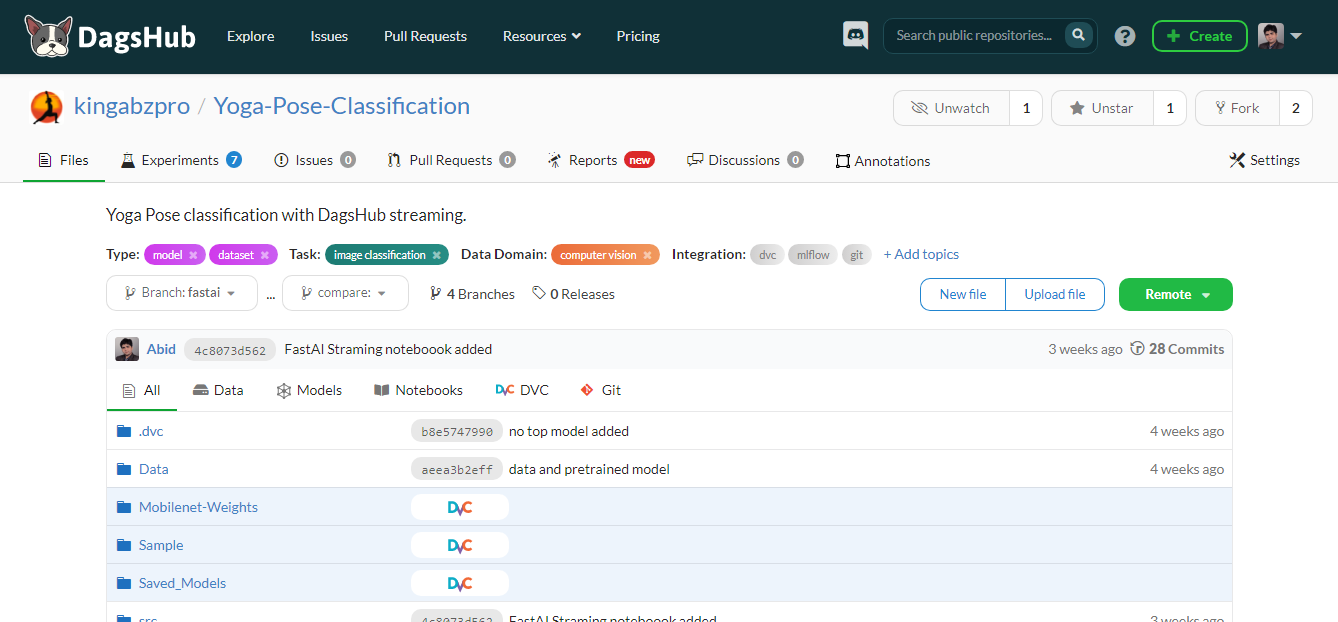

24. DagsHub

DagsHub es una plataforma hecha para que la comunidad del aprendizaje automático rastree y versione los datos, modelos, experimentos, tuberías de ML y código. Permite a tu equipo construir, revisar y compartir proyectos de aprendizaje automático.

En pocas palabras, es un GitHub para el aprendizaje automático, y dispones de varias herramientas para optimizar el proceso de aprendizaje automático de principio a fin.

Características principales:

- Repositorio Git y DVC para tus proyectos de ML.

- Registrador DagsHub e instancia MLflow para el seguimiento de experimentos.

- Anotación del conjunto de datos mediante la instancia de estudio de etiquetas.

- Diferencia los cuadernos Jupyter, el código, los conjuntos de datos y las imágenes.

- Posibilidad de comentar el archivo, la línea de código o el conjunto de datos.

- Crea un informe para el proyecto igual que la wiki de GitHub.

- Visualización de la tubería ML.

- Resultados reproducibles.

- Ejecutar CI/CD para la formación y el despliegue de modelos.

- Fusión de datos.

- Proporciona integración con GitHub, Google Colab, DVC, Jenkins, almacenamiento externo, webhooks y New Relic.

Imagen del autor

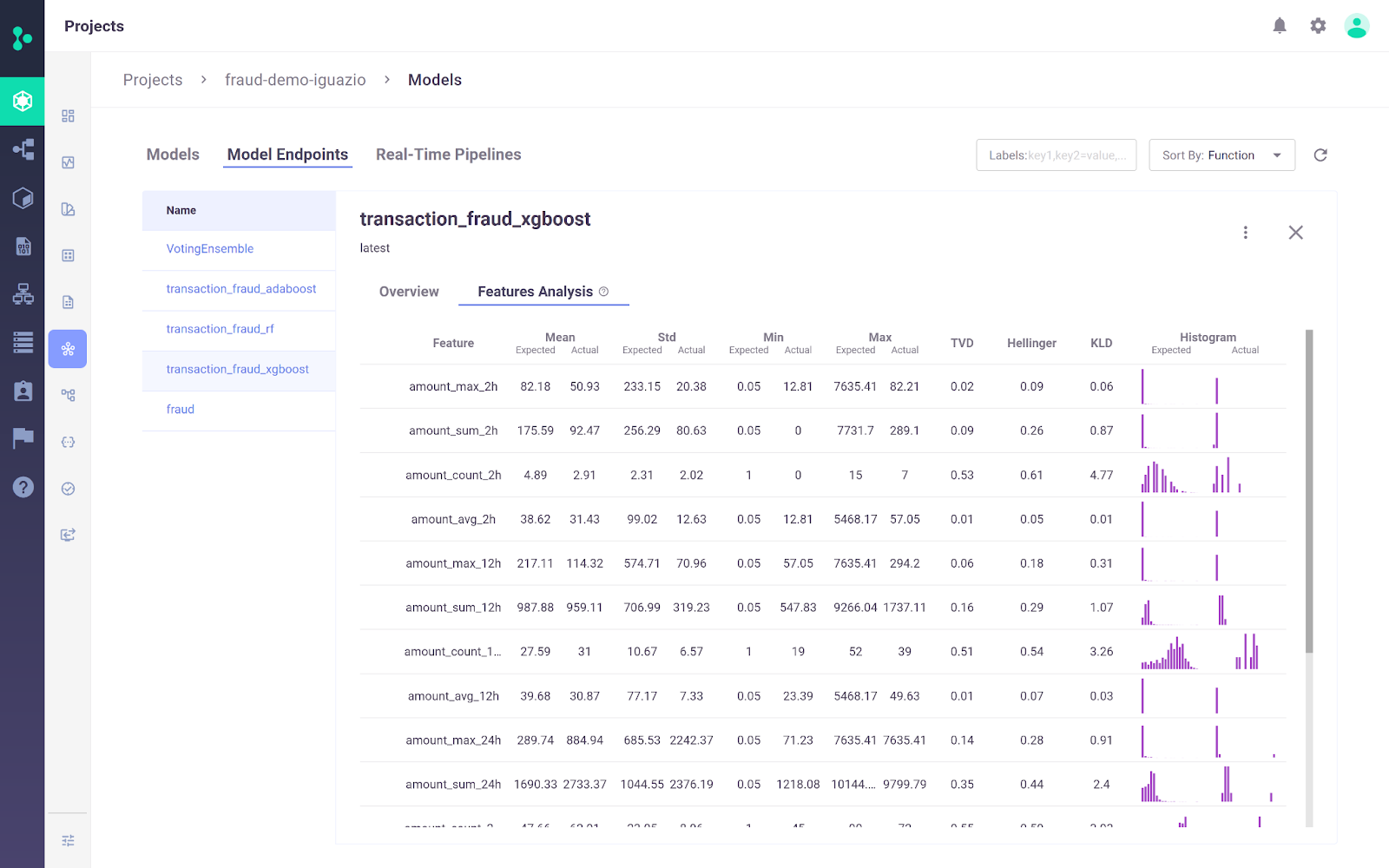

25. Plataforma MLOps de Iguazio

La Plataforma MLOps de Iguazio es una plataforma MLOps integral que permite a las organizaciones automatizar el proceso de aprendizaje automático, desde la recopilación y preparación de datos hasta la formación, despliegue y supervisión en producción. Proporciona una plataforma abierta(MLRun) y gestionada.

Un diferenciador clave de la Plataforma MLOps de Iguazio es su flexibilidad en las opciones de despliegue. Los usuarios pueden desplegar aplicaciones de IA en cualquier lugar, incluidos entornos en la nube, híbridos o locales. Esto es especialmente importante para sectores como la sanidad y las finanzas, en los que la privacidad de los datos puede hacer necesaria la implantación local.

Imagen de la Plataforma MLOps de Iguazio

Características principales:

- La plataforma permite a los usuarios introducir datos de cualquier fuente y crear funciones reutilizables en línea y fuera de línea utilizando el almacén de funciones integrado.

- Admite el entrenamiento continuo y la evaluación de modelos a escala utilizando un servidor escalable sin servidor con seguimiento automatizado, versionado de datos e integración y despliegue continuos.

- Facilita el despliegue de modelos en producción con sólo unos clics, supervisa continuamente el rendimiento de los modelos y mitiga su desviación.

- La plataforma viene con un sencillo panel de control para gestionar, gobernar y supervisar los modelos y la producción en tiempo real.

Visión general de las herramientas MLOps

Aquí tienes una tabla comparativa para que puedas evaluar estas herramientas una al lado de la otra y decidir cuáles son las mejores para tus proyectos:

| Herramienta | Funcionalidad principal | Marcos compatibles | Opciones de despliegue |

|---|---|---|---|

| Qdrant | Búsqueda de similitudes vectoriales y gestión de bases de datos | Python, varios idiomas | Nube nativa, escalable horizontalmente |

| LangChain | Desarrollar aplicaciones con modelos lingüísticos | Python, JavaScript | API REST, plantillas |

| MLFlow | Seguimiento de experimentos, registro de modelos, despliegue | Python, R, Java, API REST | Local, nube |

| Cometa ML | Seguimiento y optimización de experimentos | Scikit-learn, PyTorch, TensorFlow, HuggingFace | Local, nube |

| Pesos y sesgos | Seguimiento de experimentos, versionado de datos y modelos | Fastai, Keras, PyTorch, HuggingFace, Yolov5, Spacy | Local, nube |

| Prefecto | Orquestación y supervisión del flujo de trabajo | Python | Local (Orion UI), Nube |

| Metaflow | Gestión del flujo de trabajo para la ciencia de datos | Scikit-learn, TensorFlow, Python, R | AWS, GCP, Azure, local |

| Kedro | Orquestación del flujo de trabajo, reproducibilidad | Python | Local, distribuido |

| Paquidermo | Transformación, versionado y linaje de datos | Cualquier idioma | Kubernetes |

| DVC | Versionado de datos y canalizaciones | Git, Python | Local, nube |

| LakeFS | Control de versiones tipo Git para lagos de datos | Cualquier servicio de almacenamiento | Local, nube |

| Fiesta | Almacén centralizado de características para modelos ML | Python | Local, nube |

| Featureform | Almacén virtual de características para modelos ML | Python | Local, nube |

| Comprobaciones profundas | Prueba y validación del modelo ML | Python | Local, nube |

| TruEra | Pruebas de calidad y rendimiento del modelo | Python | Local, nube |

| Kubeflow | Despliegue y orquestación de modelos ML | TensorFlow, PyTorch, PaddlePaddle, MXNet, XGboost | Kubernetes, cloud |

| BentoML | Despliegue de modelos y gestión de API | Keras, ONNX, LightGBM, PyTorch, Scikit-learn | Local, nube |

| Cara de abrazo | Inferencia y despliegue del modelo | Cualquier modelo | Nube |

| Evidentemente | Supervisión de los modelos ML para la deriva de datos y objetivos | Python | Local, nube |

| Violinista | Supervisión y depuración de modelos ML | Python | Local, nube |

| Ray | Escalar aplicaciones de IA y Python | Python | Local, nube |

| Nuclio | Marco sin servidor para cargas de trabajo intensivas en datos y cálculo | Jupyter, Kubeflow | Nube, local |

| AWS SageMaker | Gestión integral del ciclo de vida del LD | Python, R, Java, TensorFlow, PyTorch | Nube AWS |

| DagsHub | Versionado y colaboración para proyectos de ML | Git, DVC, MLflow | Local, nube |

| Iguazio | Automatización de extremo a extremo de los procesos de ML | Python, MLRun | Nube, híbrido, local |

Conclusión

Nos encontramos en un momento de auge del sector de las MLOps. Cada semana se ven nuevos desarrollos, nuevas startups y nuevas herramientas que se lanzan para resolver el problema básico de convertir los portátiles en aplicaciones listas para la producción. Incluso las herramientas existentes están ampliando el horizonte e integrando nuevas funciones para convertirse en súper herramientas MLOps.

En este blog, hemos aprendido cuáles son las mejores herramientas de MLOps para los distintos pasos del proceso de MLOps. Estas herramientas te ayudarán durante las fases de experimentación, desarrollo, despliegue y supervisión.

Si eres nuevo en el aprendizaje automático y quieres dominar las habilidades esenciales para conseguir un trabajo como científico de aprendizaje automático, prueba a seguir nuestro itinerario profesional de Científico de Aprendizaje Automático con Python.

Si eres un profesional y quieres saber más sobre las Prácticas MLOps estándar, lee nuestro artículo sobre las Mejores Prácticas MLOps y Cómo Aplicarlas y consulta nuestra pista de habilidades Fundamentos MLOps .

Obtén una certificación superior en IA

Herramientas MLOps Preguntas frecuentes

¿Qué son las Herramientas MLOps?

Las herramientas MLOps ayudan a estandarizar, simplificar y racionalizar el ecosistema ML. Estas herramientas se utilizan para el seguimiento de experimentos, la gestión de metadatos de modelos, la orquestación, la optimización de modelos, el versionado de flujos de trabajo, el despliegue y servicio de modelos, y la supervisión de modelos en producción.

¿Qué habilidades necesita un Ingeniero MLOps?

- Capacidad para implantar soluciones en la nube.

- Experiencia con Docker y Kubernetes.

- Experiencia en el control de calidad mediante el seguimiento de experimentos y el control de versiones del flujo de trabajo.

- Capacidad para crear canalizaciones de MLOps.

- Familiarizado con el sistema operativo Linux.

- Experiencia con marcos ML como PyTorch, Tensorflow y TFX.

- Experiencia con DevOps y desarrollo de software.

- Experiencia en pruebas unitarias y de integración, validación de datos y modelos, y supervisión posterior a la implantación.

¿Qué nube es mejor para MLOps?

AWS, GCP y Azure proporcionan diversas herramientas para el ciclo de vida del aprendizaje automático. Todos ellos ofrecen soluciones integrales para MLOps. AWS toma la delantera en términos de popularidad y cuota de mercado. También proporciona soluciones sencillas para la formación, el servicio y la supervisión de modelos.

¿Es MLOps fácil de aprender?

Depende de tu experiencia previa. Para dominar los MLOps, tienes que aprender tanto el aprendizaje automático como los ciclos de vida del desarrollo de software. Además de un gran dominio de los lenguajes de programación, necesitas aprender varias herramientas MLOps. Es fácil para los ingenieros DevOps aprender MLOps, ya que la mayoría de las herramientas y estrategias están impulsadas por el desarrollo de software.

¿Es Kubeflow mejor que MLflow?

Depende del caso de uso. Kubeflow proporciona reproducibilidad a un nivel mayor que MLflow, ya que gestiona la orquestación.

- Kubeflow se utiliza generalmente para desplegar y gestionar sistemas ML complejos a escala.

- MLFlow se utiliza generalmente para el seguimiento de experimentos de ML y para almacenar y gestionar metadatos de modelos.

¿En qué se diferencia MLOps de DevOps?

Ambas son estrategias de desarrollo de software. DevOps se centra en desarrollar y gestionar sistemas de software a gran escala, mientras que MLOps se centra en desplegar y mantener modelos de aprendizaje automático en producción.

- DevOps: Integración Continua (IC) y Entrega Continua (CD).

- MLOps: Integración Continua, Entrega Continua, Formación Continua y Monitorización Continua.

¿Cómo se integran las herramientas MLOps con los flujos de trabajo existentes de Ciencia de Datos?

Las herramientas MLOps están diseñadas para integrarse perfectamente con los flujos de trabajo existentes de la ciencia de datos. Normalmente son compatibles con varias herramientas y plataformas de ciencia de datos, proporcionan API para la integración y ofrecen complementos o extensiones para entornos populares de ciencia de datos. Esta integración permite a los científicos de datos mantener sus flujos de trabajo actuales al tiempo que aprovechan las ventajas de MLOps para mejorar la escalabilidad, la reproducibilidad y la eficacia de la implantación.

¿Pueden las herramientas MLOps ayudar a la explicabilidad y equidad de los modelos?

Sí, muchas herramientas MLOps incluyen funciones para mejorar la explicabilidad y equidad del modelo. Ofrecen funcionalidades como la interpretación de modelos, la detección de sesgos y las métricas de equidad, que ayudan a comprender y mejorar cómo toman decisiones los modelos. Esto es crucial para desplegar una IA responsable y mantener el cumplimiento de las normas reguladoras.

¿Puedo obtener una certificación MLOps?

Las certificaciones específicas de MLOps aún están surgiendo, pero hay varias certificaciones centradas en el aprendizaje automático y la ciencia de datos que cubren las habilidades de MLOps. Lee nuestra guía de certificaciones MLOps para obtener un desglose.

Soy un científico de datos certificado que disfruta creando aplicaciones de aprendizaje automático y escribiendo blogs sobre ciencia de datos. Actualmente me centro en la creación de contenidos, la edición y el trabajo con grandes modelos lingüísticos.