Curso

Los grandes modelos lingüísticos (LLM) como el GPT-4 han aportado avances asombrosos, pero tienen sus limitaciones: conocimientos obsoletos, alucinaciones y respuestas genéricas. Ése es un problema que podemos resolver utilizando la Generación Aumentada de Recuperación (GRA).

En este blog, explicaré cómo funciona la GAR, por qué cambia las reglas del juego de las aplicaciones de IA y cómo la utilizan las empresas para crear sistemas más inteligentes y fiables.

¿Qué es el GAR?

La Generación Aumentada de Recuperación (GRA) es una técnica que mejora los LLM integrándolos con fuentes de datos externas. Al combinar las capacidades generativas de modelos como el GPT-4 con mecanismos precisos de recuperación de información, el GAR permite a los sistemas de IA producir respuestas más precisas y contextualmente relevantes.

Los LLM son potentes, pero tienen limitaciones inherentes:

- Conocimientos limitados: Los LLM sólo pueden generar respuestas basadas en sus datos de entrenamiento, que pueden estar desfasados o carecer de información específica del dominio.

- Alucinaciones: Estos modelos a veces generan información plausible pero incorrecta.

- Respuestas genéricas: Sin acceso a fuentes externas, los LLM pueden dar respuestas vagas o imprecisas.

RAG aborda estos problemas permitiendo que los modelos recuperen información actualizada y específica del dominio a partir de fuentes de datos estructuradas y no estructuradas, como bases de datos, documentación y API.

¿Por qué utilizar el GAR para mejorar los LLM? Un ejemplo

Para demostrar mejor qué es el GAR y cómo funciona la técnica, consideremos un escenario al que se enfrentan muchas empresas hoy en día.

Imagina que eres directivo de una empresa de electrónica que vende dispositivos como teléfonos inteligentes y ordenadores portátiles. Quieres crear un chatbot de atención al cliente para tu empresa que responda a las consultas de los usuarios relacionadas con las especificaciones de los productos, la resolución de problemas, la información sobre la garantía, etc.

Te gustaría utilizar las capacidades de LLMs como GPT-3 o GPT-4 para potenciar tu chatbot.

Sin embargo, los grandes modelos lingüísticos tienen las siguientes limitaciones, que conducen a una experiencia de cliente ineficaz:

Falta de información específica

Los modelos lingüísticos se limitan a dar respuestas genéricas basadas en sus datos de entrenamiento. Si los usuarios hicieran preguntas específicas sobre el software que vendes, o si tuvieran dudas sobre cómo solucionar problemas en profundidad, es posible que un LLM tradicional no pudiera dar respuestas precisas.

Esto se debe a que no han recibido formación sobre los datos específicos de tu organización. Además, los datos de entrenamiento de estos modelos tienen una fecha de corte, lo que limita su capacidad de proporcionar respuestas actualizadas.

Alucinaciones

Los LLM pueden "alucinar", lo que significa que tienden a generar con confianza respuestas falsas basadas en hechos imaginarios. Estos algoritmos también pueden dar respuestas fuera de tema si no tienen una respuesta precisa a la consulta del usuario, lo que conduce a una mala experiencia del cliente.

Respuestas genéricas

Los modelos lingüísticos suelen dar respuestas genéricas que no se adaptan a contextos específicos. Esto puede ser un gran inconveniente en un escenario de atención al cliente, ya que las preferencias individuales de los usuarios suelen ser necesarias para facilitar una experiencia personalizada al cliente.

RAG salva eficazmente estas lagunas proporcionándote una forma de integrar la base de conocimientos generales de los LLM con la capacidad de acceder a información específica, como los datos presentes en tu base de datos de productos y manuales de usuario. Esta metodología permite obtener respuestas muy precisas y fiables, adaptadas a las necesidades de tu organización.

¿Cómo funciona el GAR?

Ahora que ya sabes qué es el GAR, veamos los pasos que hay que dar para establecer este marco:

Paso 1: Recogida de datos

Primero debes reunir todos los datos necesarios para tu solicitud. En el caso de un chatbot de atención al cliente para una empresa de electrónica, esto puede incluir manuales de usuario, una base de datos de productos y una lista de preguntas frecuentes.

Paso 2: Agrupación de datos

La fragmentación de datos es el proceso de dividir tus datos en trozos más pequeños y manejables. Por ejemplo, si tienes un extenso manual de usuario de 100 páginas, podrías dividirlo en diferentes secciones, cada una de las cuales podría responder a diferentes preguntas de los clientes.

De este modo, cada trozo de datos se centra en un tema concreto. Cuando se recupera una información del conjunto de datos fuente, es más probable que sea directamente aplicable a la consulta del usuario, ya que evitamos incluir información irrelevante de documentos enteros.

Esto también mejora la eficacia, ya que el sistema puede obtener rápidamente las piezas de información más relevantes en lugar de procesar documentos enteros.

Paso 3: Incrustación de documentos

Ahora que los datos de origen se han descompuesto en partes más pequeñas, hay que convertirlos en una representación vectorial. Esto implica transformar los datos de texto en incrustaciones, que son representaciones numéricas que captan el significado semántico que hay detrás del texto.

En palabras sencillas, la incrustación de documentos permite al sistema entender las consultas de los usuarios y emparejarlas con la información relevante del conjunto de datos de origen basándose en el significado del texto, en lugar de una simple comparación palabra a palabra. Este método garantiza que las respuestas sean pertinentes y se ajusten a la consulta del usuario.

Si quieres saber más sobre cómo se convierten los datos de texto en representaciones vectoriales, te recomendamos que explores nuestro tutorial sobre incrustaciones de texto con la API OpenAI.

Paso 4: Gestión de las consultas de los usuarios

Cuando una consulta de usuario entra en el sistema, también debe convertirse en una representación incrustada o vectorial. Debe utilizarse el mismo modelo para la incrustación del documento y de la consulta, a fin de garantizar la uniformidad entre ambos.

Una vez convertida la consulta en una incrustación, el sistema compara la incrustación de la consulta con las incrustaciones del documento. Identifica y recupera los trozos cuyas incrustaciones son más similares a la incrustación de la consulta, utilizando medidas como la similitud del coseno y la distancia euclidiana.

Estos trozos se consideran los más relevantes para la consulta del usuario.

Paso 5: Generar respuestas con un LLM

Los trozos de texto recuperados, junto con la consulta inicial del usuario, se introducen en un modelo lingüístico. El algoritmo utilizará esta información para generar una respuesta coherente a las preguntas del usuario a través de una interfaz de chat.

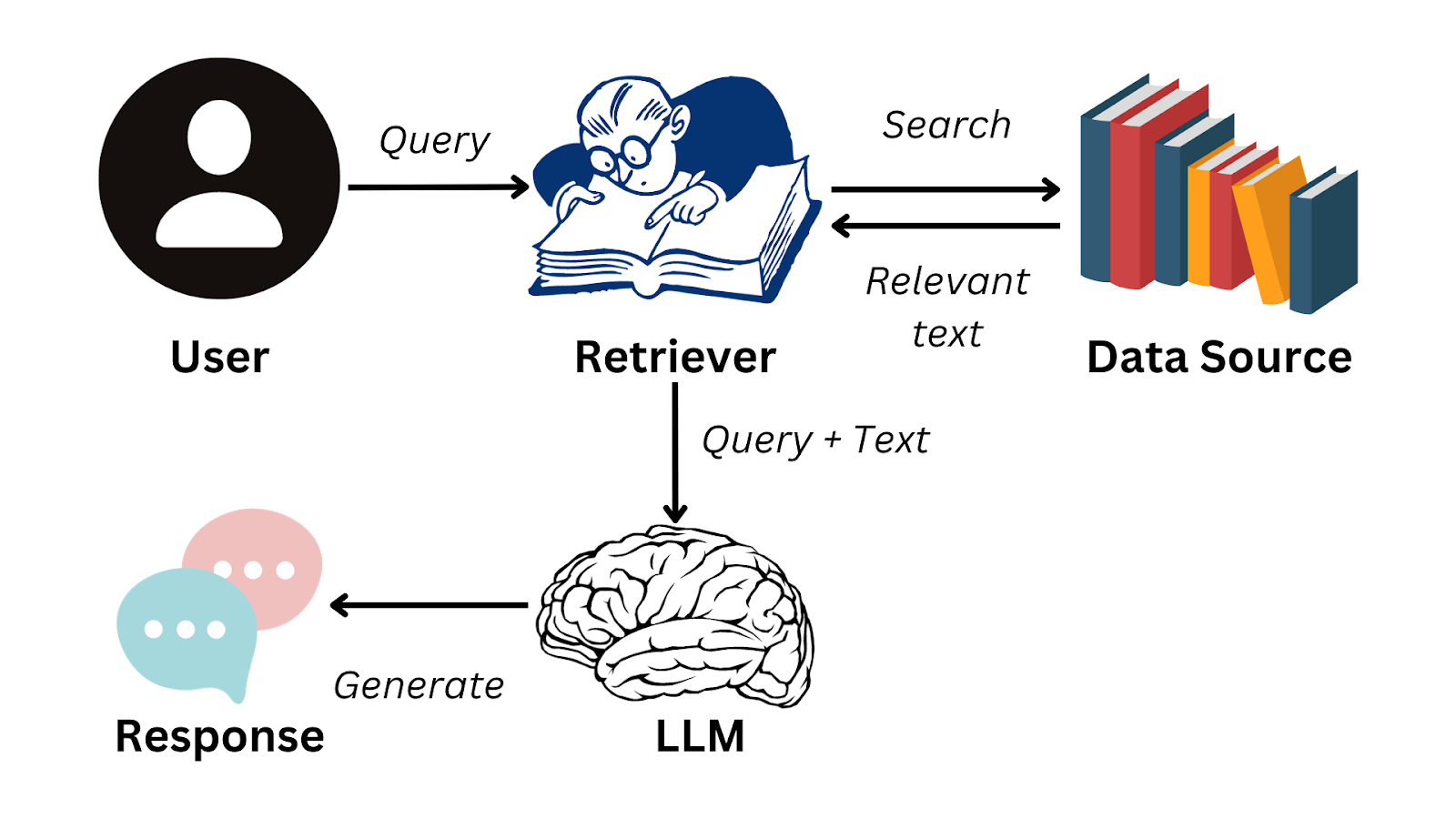

Aquí tienes un diagrama de flujo simplificado que resume cómo funciona el GAR:

Imagen del autor

Para realizar sin problemas los pasos necesarios para generar respuestas con LLMs, puedes utilizar un marco de datos como LlamaIndex.

Esta solución te permite desarrollar tus propias aplicaciones LLM gestionando eficazmente el flujo de información desde fuentes de datos externas a modelos lingüísticos como el GPT-3. Para saber más sobre este marco y cómo puedes utilizarlo para crear aplicaciones basadas en LLM, lee nuestro tutorial sobre LlamaIndex.

Aplicaciones prácticas del GAR

Ahora sabemos que el GAR permite a los LLM formar respuestas coherentes basándose en información ajena a sus datos de entrenamiento. Un sistema como éste tiene una variedad de casos de uso empresarial que mejorarán la eficacia organizativa y la experiencia del usuario. Aparte del ejemplo del chatbot de cliente que vimos antes en el artículo, he aquí algunas aplicaciones prácticas de la GAR:

Resumen de texto

El GAR puede utilizar contenidos de fuentes externas para elaborar resúmenes precisos, lo que supone un ahorro de tiempo considerable. Por ejemplo, los directivos y ejecutivos de alto nivel son personas ocupadas que no tienen tiempo de examinar informes exhaustivos.

Con una aplicación potenciada por RAG, pueden acceder rápidamente a los hallazgos más críticos de los datos textuales y tomar decisiones de forma más eficiente, en lugar de tener que leer largos documentos.

Recomendaciones personalizadas

Los sistemas RAG pueden utilizarse para analizar los datos de los clientes, como compras anteriores y opiniones, para generar recomendaciones de productos. Esto aumentará la experiencia general del usuario y, en última instancia, generará más ingresos para la organización.

Por ejemplo, las aplicaciones RAG pueden utilizarse para recomendar mejores películas en plataformas de streaming basándose en el historial de visionado y las valoraciones del usuario. También pueden utilizarse para analizar reseñas escritas en plataformas de comercio electrónico.

Dado que los LLM destacan en la comprensión de la semántica que subyace a los datos textuales, los sistemas RAG pueden proporcionar a los usuarios sugerencias personalizadas más matizadas que las de un sistema de recomendación tradicional.

Inteligencia empresarial

Las organizaciones suelen tomar decisiones empresariales vigilando el comportamiento de la competencia y analizando las tendencias del mercado. Esto se hace analizando meticulosamente los datos presentes en informes empresariales, estados financieros y documentos de investigación de mercado.

Con una aplicación RAG, las organizaciones ya no tienen que analizar manualmente e identificar tendencias en estos documentos. En cambio, se puede emplear un LLM para obtener de forma eficaz una visión significativa y mejorar el proceso de investigación de mercado.

Retos y buenas prácticas de la implantación de sistemas GAR

Aunque las aplicaciones RAG nos permiten tender un puente entre la recuperación de información y el procesamiento del lenguaje natural, su aplicación plantea algunos retos únicos. En esta sección, examinaremos las complejidades a las que se enfrenta la creación de aplicaciones GAR y debatiremos cómo se pueden mitigar.

Complejidad de la integración

Puede ser difícil integrar un sistema de recuperación con un LLM. Esta complejidad aumenta cuando hay múltiples fuentes de datos externas en distintos formatos. Los datos que se introducen en un sistema GAR deben ser coherentes, y las incrustaciones generadas deben ser uniformes en todas las fuentes de datos.

Para superar este reto, se pueden diseñar módulos separados para manejar distintas fuentes de datos de forma independiente. Los datos de cada módulo se pueden preprocesar para que sean uniformes, y se puede utilizar un modelo normalizado para garantizar que las incrustaciones tengan un formato coherente.

Escalabilidad

A medida que aumenta la cantidad de datos, resulta más difícil mantener la eficacia del sistema GAR. Hay que realizar muchas operaciones complejas, como generar incrustaciones, comparar el significado entre distintos fragmentos de texto y recuperar datos en tiempo real.

Estas tareas son computacionalmente intensivas y pueden ralentizar el sistema a medida que aumenta el tamaño de los datos de origen.

Para afrontar este reto, puedes distribuir la carga computacional entre distintos servidores e invertir en una infraestructura de hardware robusta. Para mejorar el tiempo de respuesta, también puede ser beneficioso almacenar en caché las consultas que se hacen con frecuencia.

La implementación de bases de datos vectoriales también puede mitigar el reto de la escalabilidad en los sistemas GAR. Estas bases de datos te permiten manejar incrustaciones con facilidad, y pueden recuperar rápidamente los vectores más alineados con cada consulta.

Si quieres saber más sobre la implementación de bases de datos vectoriales en una aplicación RAG, puedes ver nuestra sesión de código en directo, titulada Generación Aumentada de Recuperación con GPT y Milvus. Este tutorial ofrece una guía paso a paso para combinar Milvus, una base de datos vectorial de código abierto, con modelos GPT.

Calidad de los datos

La eficacia de un sistema GAR depende en gran medida de la calidad de los datos que se introducen en él. Si el contenido fuente al que accede la aplicación es deficiente, las respuestas generadas serán imprecisas.

Las organizaciones deben invertir en un proceso diligente de curación y ajuste de contenidos. Es necesario perfeccionar las fuentes de datos para mejorar su calidad. Para las aplicaciones comerciales, puede ser beneficioso implicar a un experto en la materia para que revise y rellene las lagunas de información antes de utilizar el conjunto de datos en un sistema GAR.

Reflexiones finales

La RAG es actualmente la técnica más conocida para aprovechar las capacidades lingüísticas de los LLM junto con una base de datos especializada. Estos sistemas abordan algunos de los retos más acuciantes que se plantean al trabajar con modelos lingüísticos, y presentan una solución innovadora en el campo del procesamiento del lenguaje natural.

Sin embargo, como cualquier otra tecnología, las aplicaciones GAR tienen sus limitaciones, sobre todo su dependencia de la calidad de los datos de entrada. Para sacar el máximo partido de los sistemas GAR, es crucial incluir la supervisión humana en el proceso.

La curación meticulosa de las fuentes de datos, junto con el conocimiento experto, es imprescindible para garantizar la fiabilidad de estas soluciones.

Si quieres profundizar en el mundo de la RAG y comprender cómo se puede utilizar para crear aplicaciones de IA eficaces, puedes ver nuestra formación en directo sobre la creación de aplicaciones de IA con LangChain. Este tutorial te proporcionará experiencia práctica con LangChain, una biblioteca diseñada para permitir la implementación de sistemas RAG en escenarios del mundo real.

Preguntas frecuentes

¿Qué tipos de datos puede recuperar el GAR?

RAG puede recuperar datos estructurados y no estructurados, como manuales de productos, documentos de atención al cliente, textos legales e información de la API en tiempo real.

¿Puede integrarse el GAR con cualquier LLM?

Sí, RAG puede implementarse con varios modelos de lenguaje, incluidos los modelos GPT de OpenAI, los modelos basados en BERT y otras arquitecturas de transformadores.

¿Se puede utilizar el GAR para aplicaciones en tiempo real?

Sí, la GAR puede utilizarse en aplicaciones en tiempo real como los chatbots de atención al cliente y los asistentes de IA, pero el rendimiento depende de una recuperación y generación de respuestas eficientes.

¿Cómo se compara la RAG con la puesta a punto de un LLM?

La RAG proporciona actualizaciones dinámicas sin reentrenar el modelo, lo que lo hace más adaptable a la nueva información, mientras que el ajuste fino requiere un reentrenamiento sobre datos específicos.

¿RAG requiere un tipo de base de datos específico para la recuperación?

No, RAG puede trabajar con varias soluciones de almacenamiento de datos, incluidas bases de datos SQL, bases de datos NoSQL y bases de datos vectoriales como FAISS y Milvus.

Natassha es una consultora de datos que trabaja en la intersección de la ciencia de datos y el marketing. Cree que los datos, cuando se utilizan sabiamente, pueden inspirar un enorme crecimiento para las personas y las organizaciones. Como profesional de datos autodidacta, a Natassha le encanta escribir artículos que ayuden a otros aspirantes a entrar en el sector de la ciencia de datos. Sus artículos en su blog personal, así como en publicaciones externas, acumulan una media de 200.000 visitas mensuales.

Preguntas frecuentes sobre la Generación Aumentada de Recuperación (GRA)

¿Qué es la Generación Aumentada de Recuperación (GRA)?

La RAG es una técnica que combina las capacidades de los grandes modelos lingüísticos (LLM) preentrenados con fuentes de datos externas, lo que permite obtener respuestas de IA más matizadas y precisas.

¿Por qué es importante el GAR para mejorar la funcionalidad de los LLM?

El GAR aborda limitaciones clave de los LLM, como su tendencia a dar respuestas genéricas, generar respuestas falsas (alucinaciones) y carecer de información específica. Al integrar los LLM con datos externos específicos, el GAR permite dar respuestas más precisas, fiables y adaptadas al contexto.

¿Cómo funciona el GAR? ¿Cuáles son los pasos necesarios para su aplicación?

La RAG consta de varios pasos: recogida de datos, agrupación de datos, incrustación de documentos, gestión de las consultas de los usuarios y generación de respuestas mediante un LLM. Este proceso garantiza que el sistema empareja con precisión las consultas de los usuarios con la información relevante de las fuentes de datos externas.

¿Cuáles son algunos de los retos de la aplicación de los sistemas GAR y cómo pueden abordarse?

Los retos incluyen la complejidad de la integración, la escalabilidad y la calidad de los datos. Las soluciones pasan por crear módulos separados para las distintas fuentes de datos, invertir en una infraestructura sólida y garantizar una diligente curación y puesta a punto de los contenidos.

¿Puede integrarse RAG con distintos tipos de modelos lingüísticos aparte de GPT-3 o GPT-4?

Sí, la GAR puede funcionar con varios modelos lingüísticos, siempre que sean capaces de comprender y generar un lenguaje sofisticado. La eficacia varía en función de los puntos fuertes específicos del modelo.

¿Qué diferencia al GAR de los buscadores o bases de datos tradicionales?

RAG combina la capacidad de recuperación de los motores de búsqueda con la comprensión matizada y la generación de respuestas de los modelos lingüísticos, proporcionando respuestas detalladas y conscientes del contexto en lugar de limitarse a obtener documentos.