programa

Wan2.1 de Qwen es un modelo de generación de vídeo de código abierto diseñado para ser a la vez potente y accesible, ya que puede ejecutarse en GPU de consumo.

Con su gran rendimiento, Wan2.1 compite con modelos de código abierto como HunyuanVideo y SkyReels y con soluciones comerciales como Sora y Pista.

En este artículo, exploraré qué es Wan2.1, sus características principales y cómo funciona. Además, te guiaré sobre cómo acceder a él y utilizarlo para generar vídeos a partir de varias indicaciones, mostrando sus capacidades en acción.

¿Qué es Wan 2.1?

Wan 2.1 es un modelo avanzado de generación de vídeo desarrollado por Qwen. Pertenece a una familia de modelos de base de vídeo a gran escala, lo que significa que puede crear vídeos de alta calidad a partir de distintos tipos de entradas, en este caso, descripciones de texto e imágenes.

Wan 2.1 combina una potente generación de vídeo con la accesibilidad. Puede funcionar con GPU de consumo, a diferencia de muchos otros modelos de vídeo de IA que requieren hardware caro, lo que lo hace más práctico. Además, es de código abierto.

Se basa en la tecnología del transformador de difusión, un enfoque que le permite generar vídeos suaves y realistas con una calidad de movimiento impresionante. Wan 2.1 también introduce un exclusivo Autocodificador Variacional de Vídeo (VAE), que ayuda a mantener la coherencia y el detalle del vídeo, incluso a resoluciones más altas como 1080p.

Éstas son sus principales características:

1. Rendimiento de vanguardia (SOTA)

Wan 2.1 supera a los modelos de vídeo de IA comerciales y de código abierto en múltiples pruebas comparativas, lo que significa que produce vídeos más realistas y de mayor calidad que muchas alternativas.

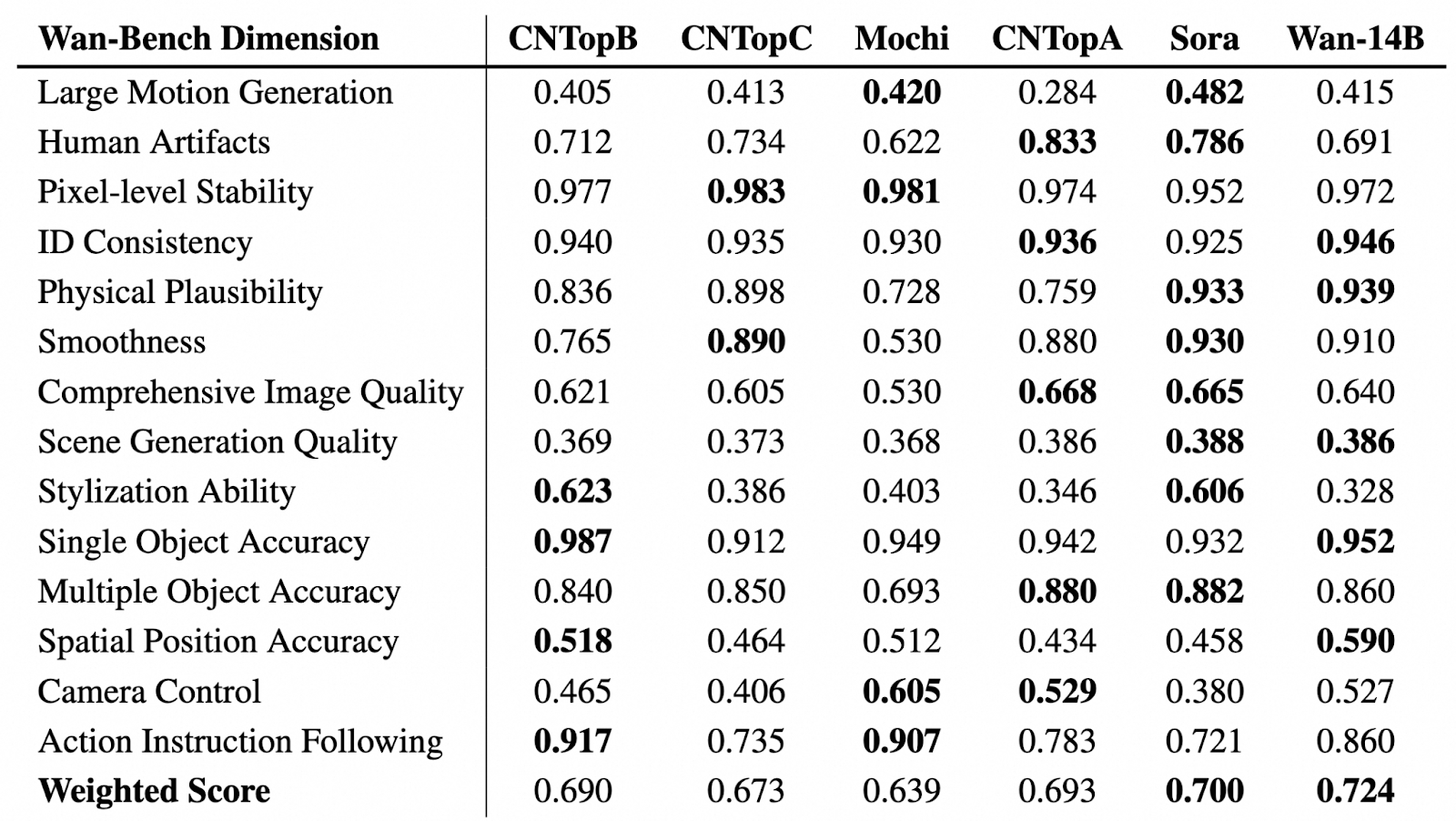

Fuente: GitHub (Wan-Video/Wan2.1)

En la tabla anterior, podemos ver una evaluación comparativa de los modelos de generación de vídeo en varias dimensiones de Wan-Bench, evaluando su rendimiento en aspectos clave como la generación de movimiento, la estabilidad visual, la precisión de los objetos y el seguimiento de instrucciones. El modelo con mejores resultados en cada categoría aparece resaltado en negrita.

El Wan-14B obtiene la puntuación ponderada global más alta (0,724), lo que demuestra su gran capacidad en múltiples puntos de referencia.

2. Funciona en GPU de consumo

En comparación con la mayoría de los modelos de vídeo de IA de gama alta que requieren hardware caro, el modelo T2V-1.3B de Wan 2.1 sólo necesita 8,19 GB de VRAM. Esto significa que puedes generar vídeos con una GPU normal, como una RTX 4090, en sólo unos minutos sin necesidad de un superordenador.

3. Admite diferentes tareas y funciones de generación de vídeo

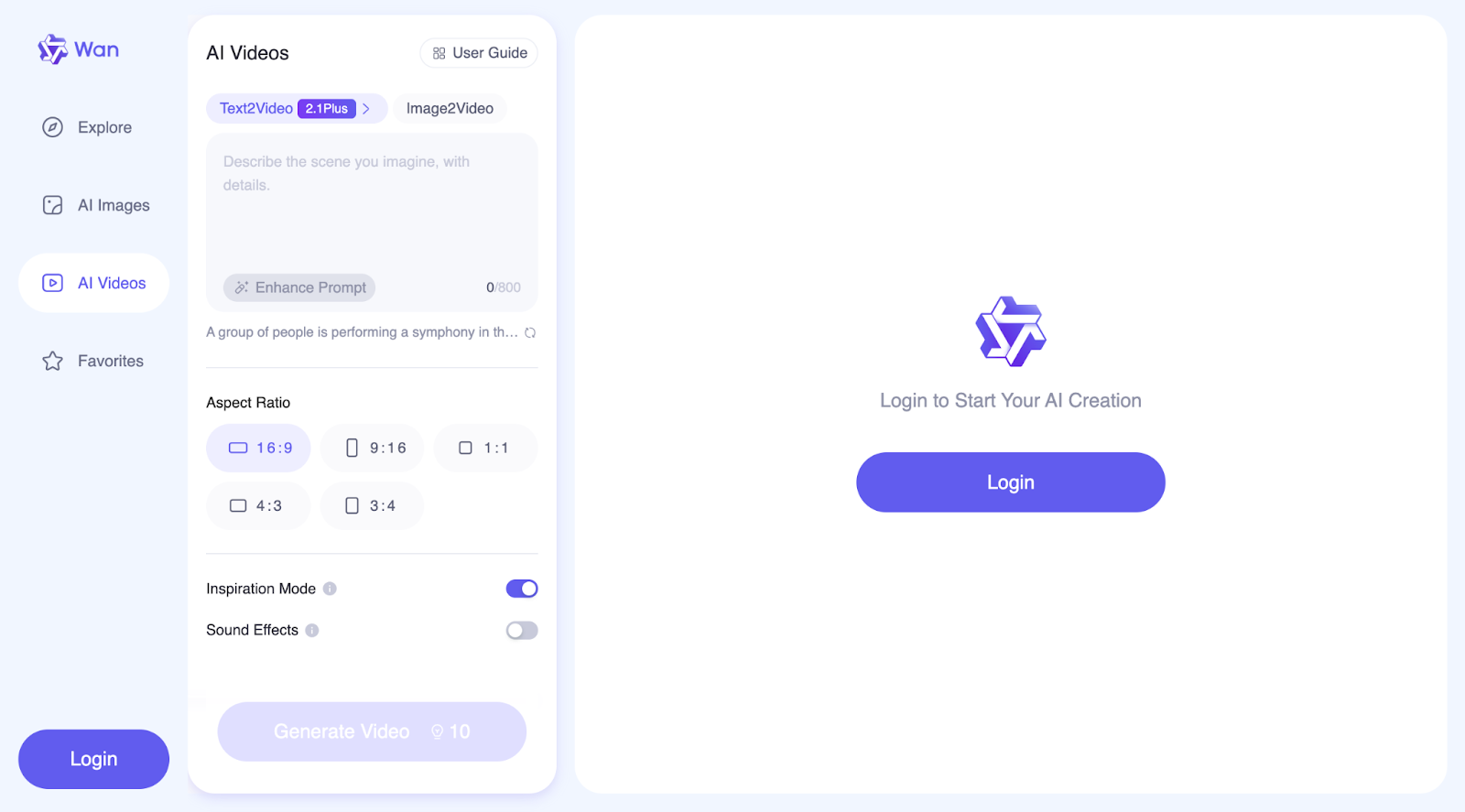

Con Wan, puedes hacer algo más que Texto a Vídeo (T2V). Ofrece funciones avanzadas para mejorar la generación y personalización de vídeos, como:

- Mejora inmediata: Si activas esta función, el modelo mejorará tus indicaciones para generar vídeos de mayor calidad y precisión.

- Control de la relación de aspecto: Puedes elegir la mejor relación de aspecto para tu salida: 16:9, 9:16, 1:1, 4:3 o 3:4.

- Modo inspiración: Esta función te ayuda a enriquecer los visuales y mejorar la expresividad. Los resultados pueden desviarse ligeramente de las indicaciones de entrada para darles un toque más artístico.

- Efectos de sonido: Puedes generar efectos de sonido adecuados para el vídeo o crear música de fondo.

Además, Wan soporta Imagen a Vídeo (I2V) para que puedas transformar imágenes fijas en vídeos animados. Puedes añadir indicaciones de texto opcionales para tener un mayor control sobre la generación del vídeo y definir el primer y el último fotograma para dar forma a la composición y el flujo del vídeo.

4. Generación de texto visual (inglés y chino)

Wan 2.1 es el primer modelo de vídeo de IA que puede generar texto legible dentro de los vídeos, tanto en inglés como en chino. Es ideal para crear subtítulos, texto animado y superposiciones gráficas dentro del contenido de vídeo.

5. Autoencodificador variacional de vídeo (VAE)

Wan 2.1 utiliza un avanzado Codificador Automático Variacional de Vídeo (Wan-VAE) que le permite:

- Codifica y descodifica vídeos 1080p de alta resolución de cualquier duración manteniendo un movimiento suave.

- Preserva los detalles y la coherencia temporal para que los objetos y personajes no parpadeen ni se distorsionen entre fotogramas.

- Comprime eficazmente los datos de vídeo.

¿Cómo acceder a Wan 2.1 Online?

Hay varias formas de empezar: puedes probarlo en línea o ejecutarlo localmente en tu ordenador.

Si quieres experimentar con Wan 2.1 sin instalar nada, puedes acceder a él a través de:

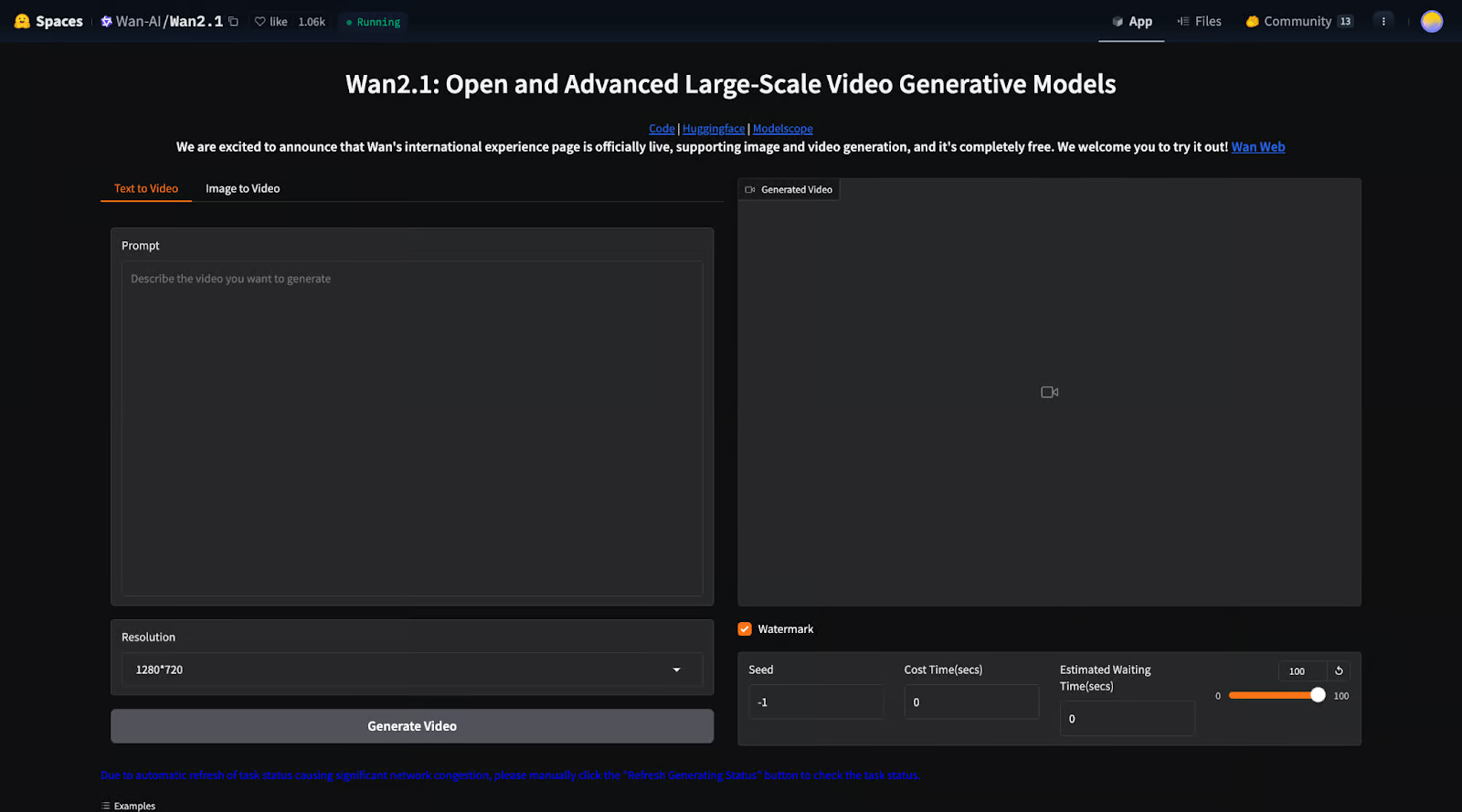

1. Espacio Cara Abrazada: Puedes ejecutar el modelo directamente en una interfaz web.

2. Sitio web de WanVideo: Aquí puedes hacer algo más que generar vídeos. El sitio web oficial también te permite crear imágenes y explorar una colección de vídeos e imágenes generados por otros usuarios, junto con las indicaciones que utilizaron.altInterfaz del sitio webalt

Estas opciones te permiten probar el modelo rápidamente sin preocuparte de la configuración ni del hardware.

Cómo configurar y ejecutar Wan 2.1 localmente

Si quieres control total y personalización, puedes instalar Wan 2.1 en tu propia máquina. Veamos paso a paso cómo hacerlo:

Configuración inicial

Paso 1: Clonar el repositorio

Primero, descarga el código Wan 2.1 de GitHub:

git clone https://github.com/Wan-Video/Wan2.1.git

cd Wan2.1Paso 2: Instalar dependencias

Asegúrate de que tienes instalados Python y PyTorch (versión 2.4.0 o posterior), y luego instala las bibliotecas necesarias:

pip install -r requirements.txtPaso 3: Descargar los pesos del modelo

Necesitas descargar los archivos del modelo preentrenado de Hugging Face (ver más información aquí) o ModelScope (más información aquí).Hay diferentes modelos que puedes descargar:

|

Modelos |

Enlace de descarga |

Notas |

|

T2V-14B |

Admite 480P y 720P |

|

|

I2V-14B-720P |

Admite 720P |

|

|

I2V-14B-480P |

Admite 480P |

|

|

T2V-1.3B |

Admite 480P |

El modelo 1.3B puede generar vídeos en resolución 720P, pero como ha tenido menos entrenamiento en esta calidad, los resultados pueden ser menos estables que en 480P. Para obtener el mejor rendimiento, se recomienda una resolución de 480P.

Ejecutar la generación de texto a vídeo con Wan 2.1

Wan 2.1 te permite generar vídeos a partir de descripciones de texto utilizando dos versiones del modelo:

- T2V-14B: Más grande, más potente, admite resolución 480p y 720p.

- T2V-1.3B: más pequeño, requiere menos energía, sólo admite 480p.

Si sólo quieres generar un vídeo rápidamente, puedes utilizar los siguientes comandos, en los que la mejora del aviso no está activada.

Para el modelo T2V-14B (modelo de mayor calidad y tamaño):

python generate.py --task t2v-14B --size 1280*720 --ckpt_dir ./Wan2.1-T2V-14B --prompt "A futuristic city with flying cars and neon lights."Para el modelo modelo T2V-1.3B (más pequeño, funciona con GPU de gama baja):

python generate.py --task t2v-1.3B --size 832*480 --ckpt_dir ./Wan2.1-T2V-1.3B --prompt "A futuristic city with flying cars and neon lights."Si tu ordenador se queda sin memoria (error OOM), puedes utilizar --offload_model True y --t5_cpu para reducir el uso de memoria.

Ejecutar texto a vídeo con Multi-GPU (para un procesamiento más rápido)

Si tienes varias GPU, puedes acelerar la generación de vídeo ejecutando este comando:

torchrun --nproc_per_node=8 generate.py --task t2v-14B --size 1280*720 --ckpt_dir ./Wan2.1-T2V-14B --dit_fsdp --t5_fsdp --ulysses_size 8 --prompt "A futuristic city with flying cars and neon lights.`Esto permite dividir la carga de trabajo entre varias GPU, lo que agiliza el proceso.

Utilizar la ampliación de avisos (para vídeos más detallados y realistas)

Wan 2.1 puede mejorar tus indicaciones automáticamente, para que el vídeo sea más detallado y visualmente atractivo.

Hay dos formas de ampliar el aviso:

- Utilizar la API de Dashscope (requiere una clave API).

- Utilizar un modelo local (se ejecuta en tu máquina sin Internet).

Para utilizar la API de Dashscope:

DASH_API_KEY=your_key python generate.py --task t2v-14B --size 1280*720 --ckpt_dir ./Wan2.1-T2V-14B --prompt "A futuristic city with flying cars and neon lights." --use_prompt_extend --prompt_extend_method 'dashscope'Para utilizar tu propio modelo local:

python generate.py --task t2v-14B --size 1280*720 --ckpt_dir ./Wan2.1-T2V-14B --prompt "A futuristic city with flying cars and neon lights." --use_prompt_extend --prompt_extend_method 'local_qwen'Ejecutar Wan 2.1 con difusores

Si quieres utilizar la biblioteca de difusores de Hugging Face en lugar de ejecutar scripts sin procesar, puedes generar un vídeo con Python:

import torch

from diffusers.utils import export_to_video

from diffusers import AutoencoderKLWan, WanPipeline

from diffusers.schedulers.scheduling_unipc_multistep import UniPCMultistepScheduler

# Available models: Wan-AI/Wan2.1-T2V-14B-Diffusers, Wan-AI/Wan2.1-T2V-1.3B-Diffusers

model_id = "Wan-AI/Wan2.1-T2V-14B-Diffusers"

# Load the autoencoder for video generation

vae = AutoencoderKLWan.from_pretrained(model_id, subfolder="vae", torch_dtype=torch.float32)

# Define the scheduler for controlling video motion flow

flow_shift = 5.0 # 5.0 for 720P, 3.0 for 480P

scheduler = UniPCMultistepScheduler(

prediction_type='flow_prediction',

use_flow_sigmas=True,

num_train_timesteps=1000,

flow_shift=flow_shift

)

# Load the video generation pipeline with the model

pipe = WanPipeline.from_pretrained(model_id, vae=vae, torch_dtype=torch.bfloat16)

pipe.scheduler = scheduler

pipe.to("cuda")

# New prompt

prompt = "A futuristic city at sunset, filled with flying cars and neon lights. The buildings have a sleek, cyberpunk design, and people walk on glowing sidewalks. The scene is full of vibrant colors, reflections, and dynamic movement."

# New negative prompt

negative_prompt = "Dull colors, grainy texture, washed-out details, static frames, incorrect lighting, unnatural shadows, distorted faces, artifacts, low-resolution elements, flickering, blurry motion, repetitive patterns, unrealistic reflections, overly simplistic backgrounds, three legged people, walking backwards."

# Generate the video frames

output = pipe(

prompt=prompt,

negative_prompt=negative_prompt,

height=720,

width=1280,

num_frames=81,

guidance_scale=5.0,

).frames[0]

# Export the generated frames as a video

export_to_video(output, "output.mp4", fps=16)El script comienza cargando el modelo Wan2.1-T2V-14B-Diffusers, que se utiliza para crear vídeos. También carga un VAE (Autoencoder), que ayuda a procesar y mejorar los fotogramas de vídeo. Para controlar la suavidad con la que aparece el movimiento en el vídeo, el script utiliza un programador (UniPCMultistepScheduler). La configuración flow_shift ajusta cómo se maneja el movimiento, siendo 5.0 mejor para una resolución más alta (720P) y 3.0 para una resolución más baja (480P).

A continuación, el script configura el canal de generación de vídeo (WanPipeline) y aplica el programador para garantizar transiciones más suaves entre fotogramas. La indicación describe una ciudad futurista con coches voladores y brillantes luces de neón, mientras que la indicación negativa ayuda a eliminar efectos no deseados, como detalles borrosos, colores desvaídos y fotogramas parpadeantes.

A continuación, el modelo crea 81 fotogramas, lo que da como resultado unos 5 segundos de vídeo a 16 fotogramas por segundo (FPS). El guidance_scale está ajustado a 5,0, lo que ayuda al modelo a seguir la indicación al tiempo que permite cierta creatividad. Una vez generado el vídeo, los fotogramas se combinan y se guardan como "output.mp4" a 16 FPS.

La indicación negativa desempeña un papel importante en la mejora del vídeo final, ya que indica al modelo lo que debe evitar. Ayuda a eliminar cosas como la mala calidad de la imagen, distorsiones extrañas o cualquier cosa que pueda hacer que el vídeo parezca poco realista. En este caso, garantiza que la escena futurista tenga un aspecto limpio, nítido y visualmente atractivo.

Ejecutar Wan 2.1 con una interfaz Gradio local

Si prefieres una interfaz web interactiva para generar vídeos en lugar de utilizar código, puedes ejecutar Wan 2.1 con Gradio:

Para la extensión Dashscope prompt:

DASH_API_KEY=your_key python t2v_14B_singleGPU.py --prompt_extend_method 'dashscope' --ckpt_dir ./Wan2.1-T2V-14BPara la extensión del aviso local:

python t2v_14B_singleGPU.py --prompt_extend_method 'local_qwen' --ckpt_dir ./Wan2.1-T2V-14BDe forma similar a la conversión de texto en vídeo, la conversión de imagen en vídeo también se divide en procesos con y sin el paso de ampliación del aviso. Para más detalles sobre la implementación, puedes visitar la página oficial de GitHub. También puedes unirte a su canal Discord para hablar de Wan2.1, compartir tus creaciones, recibir actualizaciones sobre nuevas funciones y desarrollos, y visitar el sitio web oficial para explorar ejemplos generados.

¿Cómo funciona Wan 2.1?

Wan 2.1 se ha creado utilizando técnicas avanzadas de IA para generar vídeos realistas de alta calidad. Sigue un enfoque basado en la difusión e integra transformadores para garantizar que los movimientos sean suaves, coherentes y detallados en todos los fotogramas.

Tecnología de transformadores de difusión

Wan 2.1 utiliza una técnica llamada modelos de difusión, que funcionan en dos pasos:

- Empieza con ruido: El modelo comienza con una imagen estática completamente aleatoria.

- Perfecciónalo gradualmente: A lo largo de muchos pasos, el modelo elimina el ruido y da forma al vídeo fotograma a fotograma, guiado por la indicación de entrada.

Es como revelar una foto en un cuarto oscuro: la imagen empieza borrosa y granulada, pero se va aclarando con cada paso del proceso.

Wan 2.1 mejora este enfoque utilizando un Transformador de Difusión (DiT), que ayuda a mantener los detalles nítidos y el movimiento suave mientras se generan múltiples fotogramas de vídeo.

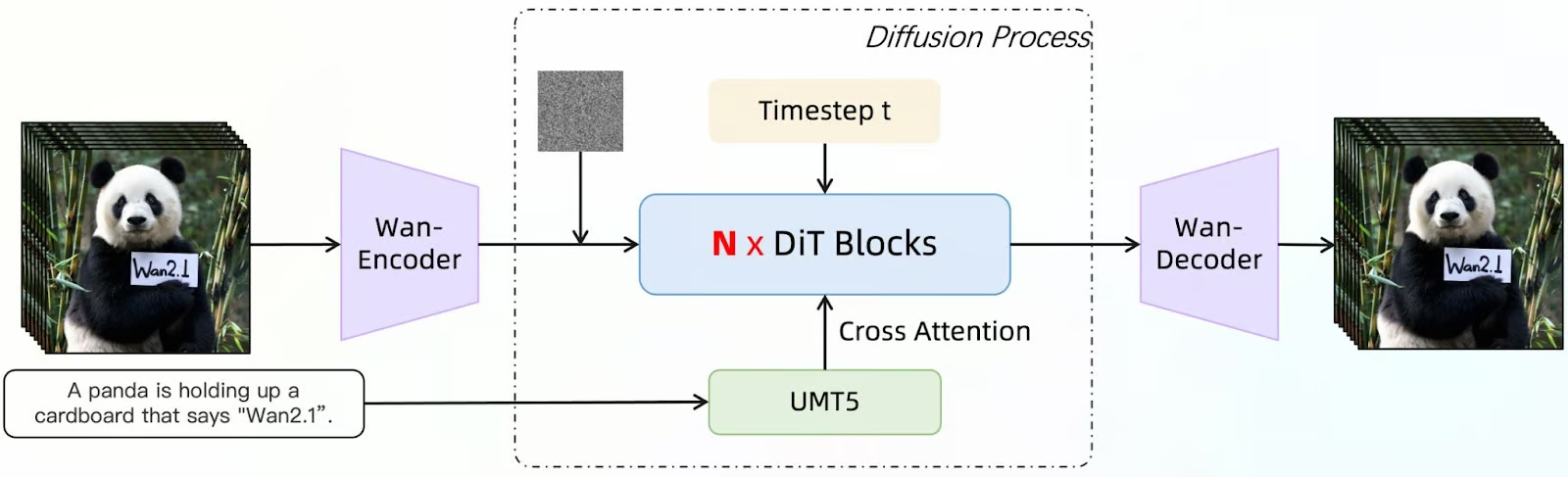

Fuente: GitHub (Wan-Video/Wan2.1)

Este diagrama muestra cómo la Wan 2.1 genera fotogramas de vídeo utilizando un modelo de difusión mejorado con un Transformador de Difusión (DiT). El proceso comienza con una descripción de entrada (por ejemplo, "Un panda sostiene una cartulina que dice 'Wan2.1'"). Este texto es procesado por el UMT5, un modelo lingüístico que ayuda al sistema a comprender y refinar la indicación.

Simultáneamente, se introduce una imagen inicial ruidosa como punto de partida. A continuación, el Wan-Encoder procesa estas entradas, codificándolas en una forma que el modelo pueda manipular. N x DiT Bloques refinan iterativamente la imagen.

El modelo de difusión elimina progresivamente el ruido de los fotogramas, utilizando la atención cruzada para alinear la salida con la indicación proporcionada. El paso de tiempo (t) indica los pasos progresivos en la eliminación de ruido, garantizando que el vídeo se desarrolle suavemente a lo largo del tiempo.

Tras múltiples pasos de refinamiento, el Wan-Decodificador reconstruye los fotogramas de vídeo finales a partir de los datos procesados. La salida es una serie de fotogramas que se alinean con la descripción de entrada original, manteniendo los detalles nítidos, el movimiento suave y la coherencia.

Autoencodificador Variacional de Vídeo (VAE) para vídeos de alta calidad

Wan 2.1 incorpora Wan-VAE, una potente herramienta de compresión que ayuda al modelo:

- Mantén la coherencia entre los fotogramas para que los objetos y las personas no cambien de forma aleatoriamente.

- Conserva los detalles finosincluso a altas resoluciones como 1080p.

- Procesa vídeos más largos sin perder la información pasada.

Es como cuando comprimes archivos de vídeo: Comprime y almacena los detalles clave, y luego los reconstruye con precisión al generar el vídeo.

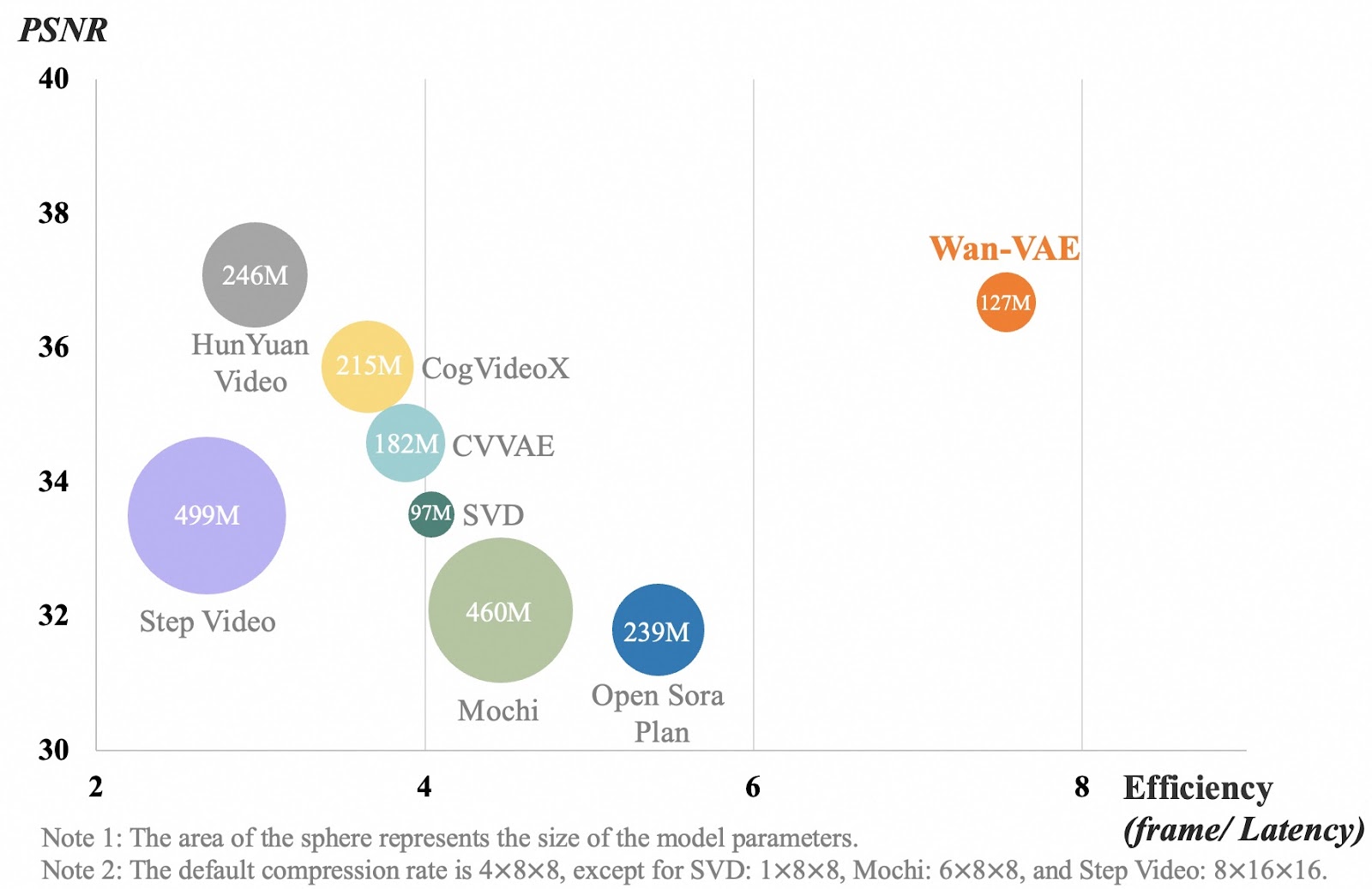

Fuente: GitHub (Wan-Video/Wan2.1)

El gráfico compara diferentes modelos de compresión de vídeo en función de la calidad de vídeo (PSNR) y la eficiencia (la rapidez con que procesan los fotogramas). Cada burbuja representa un modelo, y su tamaño muestra lo grande que es el modelo. El eje x mide la eficacia con la que un modelo procesa los fotogramas de vídeo. Un número más alto significa que el modelo funciona más rápido. El eje y muestra la calidad del vídeo, donde un número más alto significa vídeos más claros y detallados.

El Wan-VAE, mostrado en naranja, funciona mejor que otros modelos al equilibrar una alta calidad de vídeo con un procesamiento rápido, al tiempo que se mantiene relativamente pequeño (127M de parámetros). Otros modelos, como Step Video y Mochi, son mucho más grandes pero no procesan los fotogramas con tanta eficacia. Esto significa que Wan-VAE puede generar vídeos largos y de alta calidad, manteniendo los detalles nítidos y el movimiento suave, sin ralentizarse.

Casos prácticos de Wan 2.1

Wan 2.1 es un modelo de generación de vídeo de IA versátil que puede utilizarse en muchos sectores. En esta sección, voy a probar algunos ejemplos para distintos casos de uso.

Creación de contenidos y redes sociales

Wan 2.1 puede ayudarte a generar contenidos de vídeo únicos sin equipos caros ni largas horas de edición. Así pues, imaginemos que soy una influencer de estilo de vida y que quiero crear contenido sobre un día acogedor de mi vida.Voy a utilizar la siguiente instrucción para crear un clip para mi vídeo:

Una animación en time-lapse de una acogedora cafetería desde la mañana hasta la noche, mostrando a la gente entrando y saliendo, el café preparándose y la puesta de sol reflejándose en las ventanas.

Como quería que fuera lo más realista posible, también utilicé el modo inspiración. Este es el resultado que obtuve:

Cuando se generó el vídeo, a primera vista, me impresionó mucho. Pero después de mirarlo más de cerca, me di cuenta de un par de cosas. Primero, alguien desaparece en el fondo. Además, esto no es un lapso de tiempo, y no se está preparando café. Así que, aunque el vídeo parece bastante realista, no refleja con exactitud la indicación.

Juegos, mundos virtuales y animación

Ahora, imagina que eres desarrollador de juegos. Puedes utilizar Wan 2.1 para generar escenas realistas, animaciones de fondo o arte conceptual para tus proyectos. Por ejemplo, si ya tienes un concepto de personaje y el equipo creativo te ha proporcionado algunos diseños, podrías darle vida utilizando la función de Wan de imagen a vídeo.

Más allá de la animación de personajes, Wan 2.1 también puede ayudar a crear entornos dinámicos, como efectos meteorológicos cambiantes, bulliciosos paisajes urbanos o paisajes místicos, sin necesidad de animar manualmente cada fotograma.

Además, con el control de la relación de aspecto, puedes asegurarte de que tus animaciones encajan perfectamente en diferentes escenas de juego, como cinemáticas en pantalla panorámica (16:9), tomas verticales aptas para móviles (9:16) o composiciones cuadradas (1:1) para teasers en redes sociales.

Incluso puedes utilizar la función de efectos de sonido para generar un ambiente de fondo, como el susurro de las hojas, el zumbido de una ciudad futurista o paisajes sonoros de batalla.

¡Intentemos algo!He generado este esbozo de caballero medieval con DALL-E:

Usando Wan, introduje la siguiente consulta usando GPT-4o-mini:

Un caballero medieval adopta una postura heroica, empuñando una gran espada con ambas manos. Su capa fluye al viento mientras observa el campo de batalla. El caballero gira lentamente la cabeza, oteando el horizonte con expresión decidida. La animación tiene un estilo cinematográfico.Pero entonces, hice clic en Preguntar mejorado, y esto es lo que obtuve:

Caballero Medieval Cinematográfico: Un galante caballero se yergue resuelto, vestido con armadura de placas completa, empuñando con ambas manos una formidable espada ancha. Su casco con visera y sus hombreras brillan bajo el sol, mientras que un escudo nobiliario adorna su pechera. Un fajín le ciñe la cintura, asegurando su conjunto. Su capa carmesí ondea espectacularmente al soplo de la brisa, aumentando su imponente presencia. Con mirada acerada, gira la cabeza, observando el vasto y arenoso campo de batalla. La escena se desarrolla sobre papel con textura de pergamino, evocando una sensación de manuscrito antiguo. Se trata de un plano grandioso, de cuerpo entero, que capta al caballero en una pose triunfal, reminiscencia del cine épico medieval.

Desactivé el Modo Inspiración pero activé los Efectos Sonoros. He aquí el resultado:

No está mal. Aunque debo admitir que esperaba una versión más cinematográfica del borrador en lugar de una animación del propio borrador. Pero quizá podría haber sido más claro en el aviso. La música es interesante, ¡y supongo que va bien con la animación!

Publicidad y marketing

Si te dedicas al marketing, puedes utilizar Wan 2.1 para crear vídeos promocionales de marcas, productos y servicios, o incluso para animar logotipos.

Imagina que tienes un negocio de helados y quieres animar tu logotipo para ponerlo al final de tus anuncios o vídeos promocionales.Para probar esta idea, he vuelto a generar esta imagen con DALL-E:

Entonces, utilicé esta indicación: El oso polar se come el helado. Este es el resultado de la generación de imagen a vídeo:

Los dos primeros fotogramas son un poco extraños, en mi opinión, pero podrían recortarse, y los dos últimos segundos podrían utilizarse con fines publicitarios, al final de un anuncio, por ejemplo.

Educación y formación

Los vídeos generados por IA pueden simplificar temas complejos, haciendo que la educación sea más atractiva. Wan podría utilizarse para visualizar acontecimientos históricos, conceptos científicos o procesos técnicos.

Imagina que eres un profesor de escuela que explica cómo funciona el sistema solar. Wan 2.1 puede generar una simulación AI del proceso.

¡Vamos a probarlo!

Utilizando el siguiente indicador:

Sistema solar que muestra los planetas girando alrededor del sol. El vídeo debe mostrar las trayectorias orbitales de cada planeta sobre su eje. El sol debería tener llamaradas solares visibles.

Obtengo este resultado:

Vale, ¡esto no es bueno! Hay muchas cosas mal en este vídeo sobre el sistema solar: ¡definitivamente no debería utilizarse con fines educativos!

En primer lugar, el sol no está en el centro del sistema solar. Las órbitas se representan como estructuras gruesas en forma de anillo, que no representan con exactitud las órbitas planetarias reales. Los planetas no giran alrededor del Sol, y las propias órbitas son incorrectas. El tallaje también es incorrecto...

¡Siento que podría seguir y seguir hablando de todo lo que está mal! Al menos han acertado con las erupciones solares, ¡supongo!

Conclusión

Wan 2.1 es una herramienta de IA accesible y de código abierto que simplifica la creación de vídeos. Con su capacidad para manejar múltiples tareas, incluida la generación de texto a vídeo e imagen a vídeo, abre nuevas posibilidades para la creación de contenidos en las redes sociales, la publicidad, el entretenimiento, la educación y otros ámbitos.

En este tutorial, hemos explorado varios casos de uso y descubierto algunas de las limitaciones del modelo, dándote una comprensión más profunda de sus capacidades.

Para saber más sobre la generación de vídeo con IA, te recomiendo estos blogs:

Ana Rojo Echeburúa es especialista en IA y datos y doctora en Matemáticas Aplicadas. Le encanta convertir los datos en información práctica y tiene una amplia experiencia dirigiendo equipos técnicos. A Ana le gusta trabajar en estrecha colaboración con los clientes para resolver sus problemas empresariales y crear soluciones innovadoras de IA. Conocida por su capacidad para resolver problemas y su claridad de comunicación, es una apasionada de la IA, especialmente de la IA generativa. Ana se dedica al aprendizaje continuo y al desarrollo ético de la IA, así como a simplificar problemas complejos y explicar la tecnología de forma accesible.