Programa

O Wan2.1 da Qwen é um modelo de geração de vídeo de código aberto projetado para ser eficiente e acessível, pois pode ser executado em GPUs de nível de consumidor.

Com seu excelente desempenho, o Wan2.1 compete com modelos de código aberto, como HunyuanVideo e SkyReels, e soluções comerciais, como Sora e Runway.

Neste artigo, explorarei o que é o Wan2.1, seus principais recursos e como ele funciona. Além disso, orientarei você sobre como acessá-lo e usá-lo para gerar vídeos a partir de vários prompts, mostrando seus recursos em ação.

O que é o Wan 2.1?

O Wan 2.1 é um modelo avançado de geração de vídeo desenvolvido pela Qwen. Ele pertence a uma família de modelos de base de vídeo em grande escala, o que significa que pode criar vídeos de alta qualidade a partir de diferentes tipos de entradas, neste caso, descrições de texto e imagens.

O Wan 2.1 combina geração avançada de vídeo com acessibilidade. Ele pode ser executado em GPUs de nível de consumidor, ao contrário de muitos outros modelos de vídeo de IA que exigem hardware caro, o que o torna mais prático. Além disso, ele é de código aberto.

Ele foi desenvolvido com base na tecnologia de transformador de difusão, uma abordagem que permite gerar vídeos suaves e realistas com qualidade de movimento impressionante. O Wan 2.1 também apresenta um exclusivo Autoencoder Variacional de Vídeo (VAE), que ajuda a manter a consistência e os detalhes do vídeo, mesmo em resoluções mais altas, como 1080p.

Aqui estão seus principais recursos:

1. Desempenho de última geração (SOTA)

O Wan 2.1 supera os modelos de vídeo de IA comerciais e de código aberto em vários benchmarks, o que significa que ele produz vídeos mais realistas e de alta qualidade do que muitas alternativas.

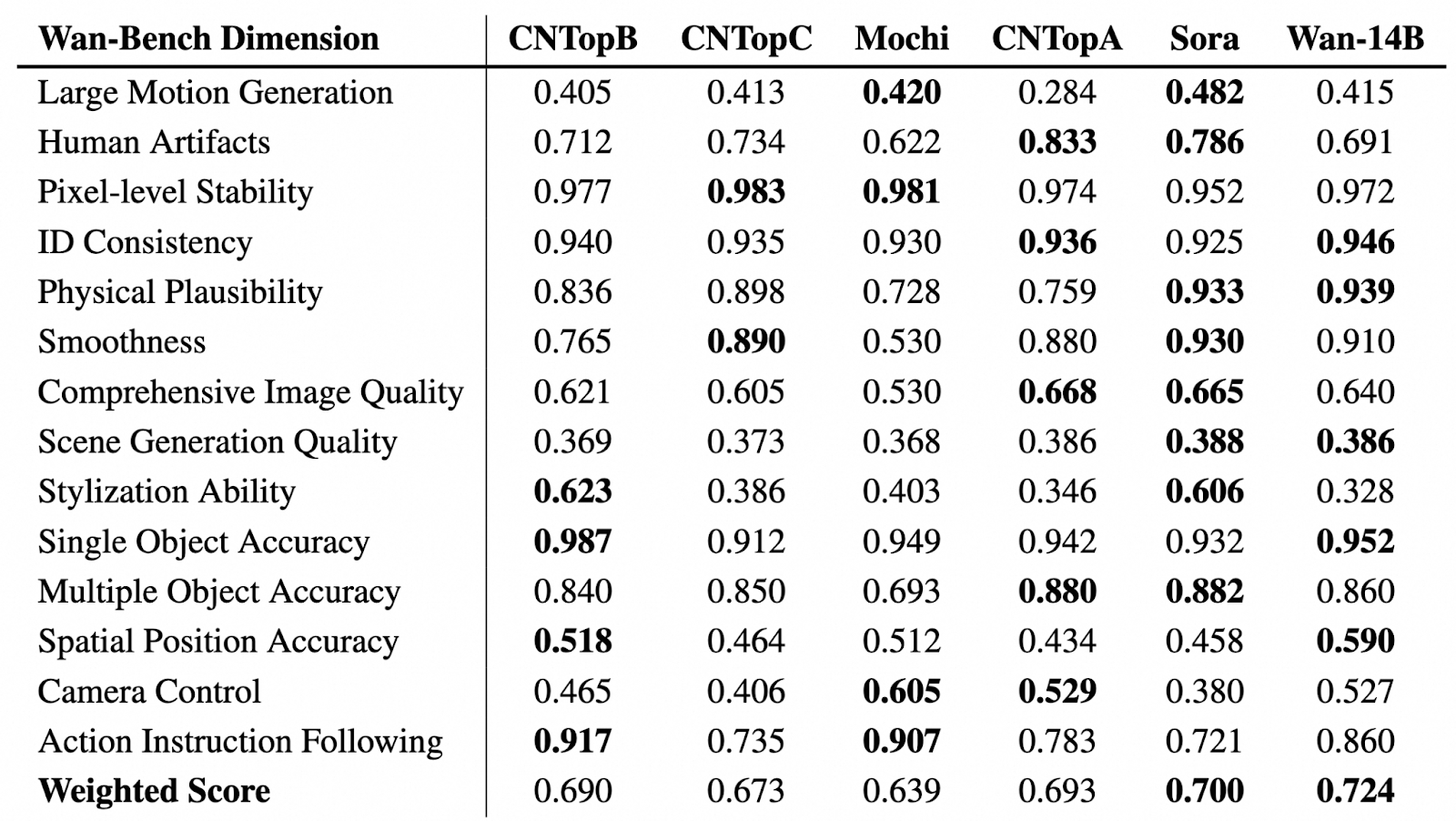

Fonte: GitHub (Wan-Video/Wan2.1)

Na tabela acima, podemos ver uma avaliação comparativa dos modelos de geração de vídeo em várias dimensões do Wan-Bench, avaliando seu desempenho em aspectos importantes, como geração de movimento, estabilidade visual, precisão do objeto e seguimento de instruções. O modelo com melhor desempenho em cada categoria está destacado em negrito.

O Wan-14B obteve a maior pontuação geral ponderada (0,724), demonstrando suas sólidas capacidades em vários benchmarks.

2. Funciona em GPUs de nível de consumidor

Em comparação com a maioria dos modelos de vídeo de IA de ponta que exigem hardware caro, o modelo T2V-1.3B do Wan 2.1 precisa apenas de 8,19 GB de VRAM. Isso significa que você pode gerar vídeos usando uma GPU comum, como uma RTX 4090, em apenas alguns minutos, sem precisar de um supercomputador.

3. Oferece suporte a diferentes tarefas e recursos de geração de vídeo

Com a Wan, você pode fazer mais do que apenas texto para vídeo (T2V). Ele oferece recursos avançados para aprimorar a geração e a personalização de vídeos, incluindo:

- Aprimoramento imediato: Se você ativar esse recurso, o modelo aprimorará os prompts para gerar vídeos mais precisos e de melhor qualidade.

- Controle de proporção de aspecto: Você pode escolher a melhor proporção de aspecto para sua saída: 16:9, 9:16, 1:1, 4:3 ou 3:4.

- Modo de inspiração: Esse recurso ajuda você a enriquecer os visuais e melhorar a expressividade. Os resultados podem divergir um pouco dos prompts de entrada para dar um toque mais artístico.

- Efeitos sonoros: Você pode gerar efeitos sonoros adequados para o vídeo ou criar música de fundo.

Além disso, o Wan oferece suporte a Image-to-Video (I2V) para que você possa transformar imagens estáticas em vídeos animados. Você pode adicionar prompts de texto opcionais para ter maior controle sobre a geração de vídeo e definir o primeiro e o último quadros para moldar a composição e o fluxo do vídeo.

4. Geração de texto visual (inglês e chinês)

O Wan 2.1 é o primeiro modelo de vídeo de IA que pode gerar texto legível dentro de vídeos em inglês e chinês. Isso é ótimo para criar legendas, texto animado e sobreposições gráficas em conteúdo de vídeo.

5. Autocodificador variacional de vídeo (VAE)

O Wan 2.1 usa um avançado codificador automático de variação de vídeo (Wan-VAE) que permite a você:

- Codifique e decodifique vídeos de alta resolução em 1080p de qualquer duração, mantendo a suavidade do movimento.

- Preserve os detalhes e a consistência temporal para que os objetos e personagens não tremam ou distorçam entre os quadros.

- Compactar dados de vídeo com eficiência.

Como acessar o Wan 2.1 on-line?

Há várias maneiras de começar - você pode experimentá-lo on-line ou executá-lo localmente em seu computador.

Se quiser experimentar o Wan 2.1 sem instalar nada, você pode acessá-lo por meio de:

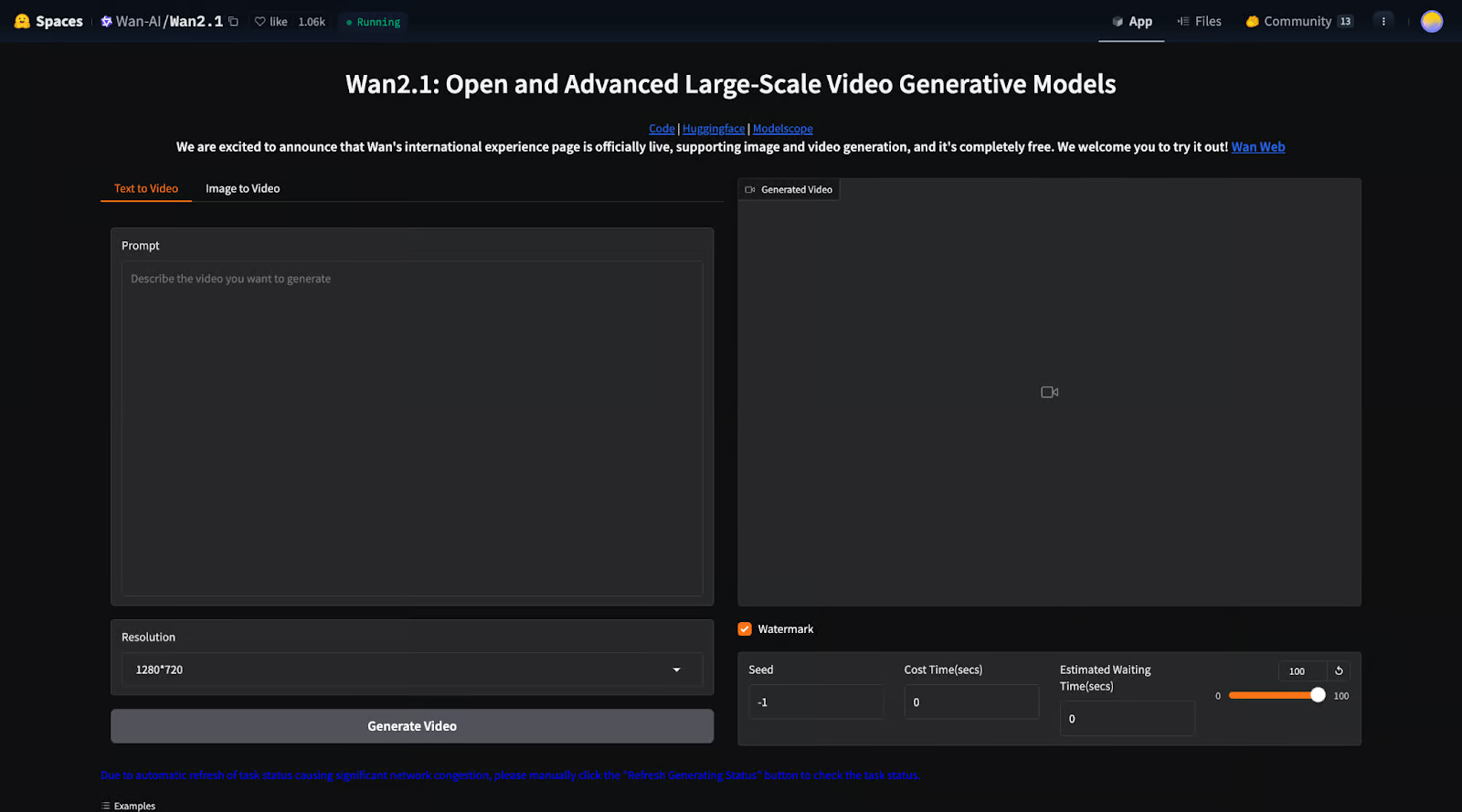

1. Espaço Hugging Face: Você pode executar o modelo diretamente em uma interface da Web.

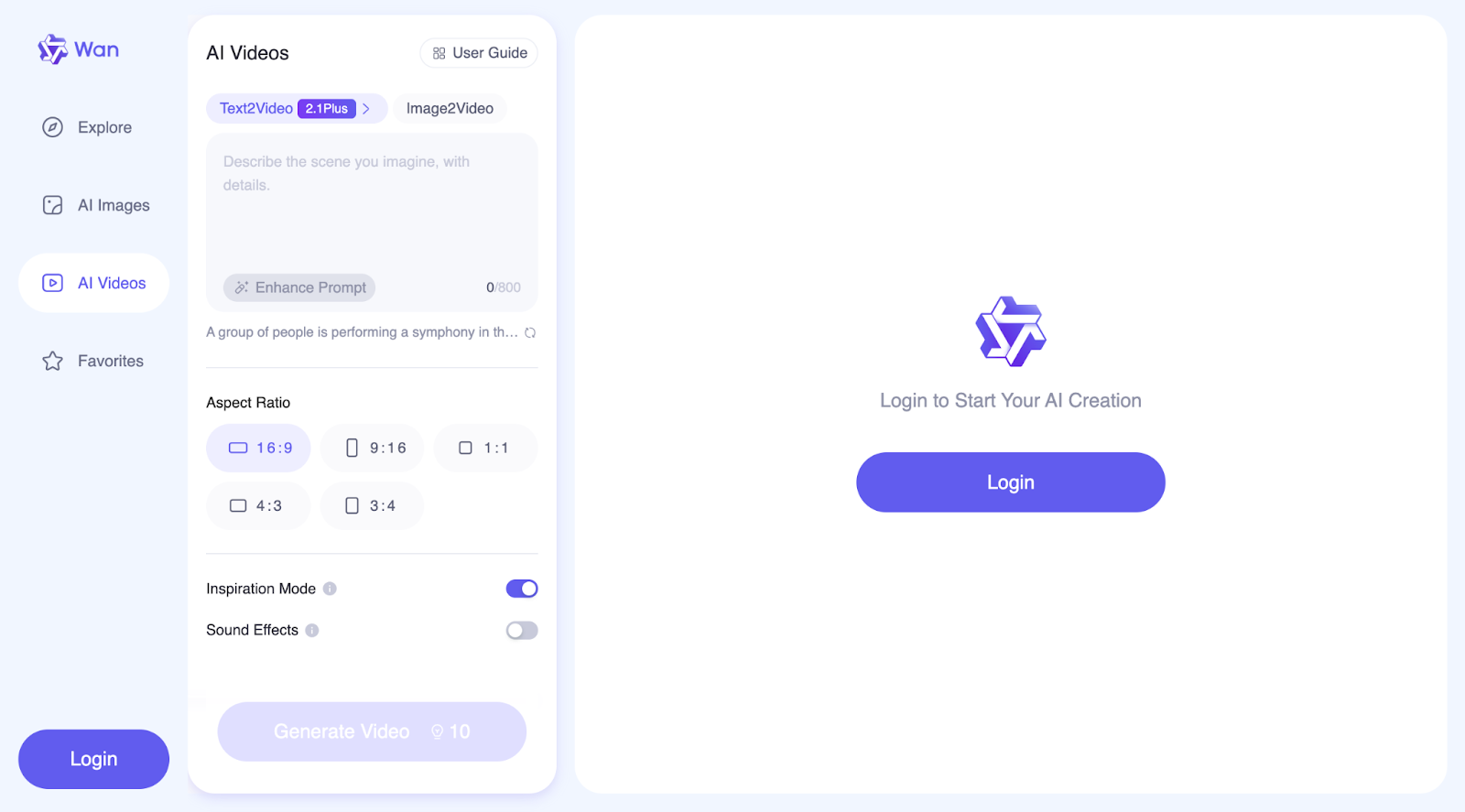

2. Site da WanVideo: Aqui, você pode fazer mais do que apenas gerar vídeos. O site oficial também permite que você crie imagens e explore uma coleção de vídeos e imagens gerados por outros usuários, juntamente com os prompts que eles usaram.

Essas opções permitem que você teste o modelo rapidamente sem se preocupar com a configuração ou o hardware.

Como configurar e executar o Wan 2.1 localmente

Se quiser ter controle total e personalização, você pode instalar o Wan 2.1 em seu próprio computador. Vamos ver passo a passo como você pode fazer isso:

Configuração inicial

Etapa 1: Clonar o repositório

Primeiro, baixe o código do Wan 2.1 do GitHub:

git clone https://github.com/Wan-Video/Wan2.1.git

cd Wan2.1Etapa 2: Instalar dependências

Certifique-se de que você tenha o Python e o PyTorch (versão 2.4.0 ou posterior) instalados e, em seguida, instale as bibliotecas necessárias:

pip install -r requirements.txtEtapa 3: Faça o download dos pesos do modelo

Você precisa fazer o download dos arquivos do modelo pré-treinado do Hugging Face (veja mais informações aqui) ou do ModelScope (veja mais informações aqui).Há diferentes modelos que você pode baixar:

|

Modelos |

Link para download |

Notas |

|

T2V-14B |

Suporta 480P e 720P |

|

|

I2V-14B-720P |

Suporta 720P |

|

|

I2V-14B-480P |

Suporta 480P |

|

|

T2V-1.3B |

Suporta 480P |

O modelo 1.3B pode gerar vídeos com resolução de 720P, mas como ele teve menos treinamento com essa qualidade, os resultados podem ser menos estáveis do que com 480P. Para obter o melhor desempenho, recomenda-se a resolução 480P.

Execução da geração de texto para vídeo com o Wan 2.1

O Wan 2.1 permite que você gere vídeos a partir de descrições de texto usando duas versões de modelo:

- T2V-14B: Maior, mais potente, suporta resolução de 480p e 720p.

- T2V-1.3BO T2V-1B é menor, requer menos energia e suporta apenas 480p.

Se quiser apenas gerar um vídeo rapidamente, você pode usar os seguintes comandos, nos quais o aprimoramento de prompt não está ativado.

Para o modelo modelo T2V-14B (qualidade superior, modelo maior):

python generate.py --task t2v-14B --size 1280*720 --ckpt_dir ./Wan2.1-T2V-14B --prompt "A futuristic city with flying cars and neon lights."Para o modelo modelo T2V-1.3B (menor, executado em GPUs de baixo custo):

python generate.py --task t2v-1.3B --size 832*480 --ckpt_dir ./Wan2.1-T2V-1.3B --prompt "A futuristic city with flying cars and neon lights."Se o computador ficar sem memória (erro OOM), você poderá usar --offload_model True e --t5_cpu para reduzir o uso da memória.

Execução de texto para vídeo com multi-GPU (para processamento mais rápido)

Se você tiver várias GPUs, poderá acelerar a geração de vídeo executando este comando:

torchrun --nproc_per_node=8 generate.py --task t2v-14B --size 1280*720 --ckpt_dir ./Wan2.1-T2V-14B --dit_fsdp --t5_fsdp --ulysses_size 8 --prompt "A futuristic city with flying cars and neon lights.`Isso permite que a carga de trabalho seja dividida em várias GPUs, tornando o processo mais rápido.

Usar a extensão do prompt (para vídeos mais detalhados e realistas)

O Wan 2.1 pode melhorar seu prompt automaticamente, para que você possa tornar o vídeo mais detalhado e visualmente atraente.

Há duas maneiras de estender o prompt:

- Usando a API do Dashscope (requer uma chave de API).

- Usando um modelo local (executado em sua máquina sem a Internet).

Para usar a API do Dashscope:

DASH_API_KEY=your_key python generate.py --task t2v-14B --size 1280*720 --ckpt_dir ./Wan2.1-T2V-14B --prompt "A futuristic city with flying cars and neon lights." --use_prompt_extend --prompt_extend_method 'dashscope'Para usar seu próprio modelo local:

python generate.py --task t2v-14B --size 1280*720 --ckpt_dir ./Wan2.1-T2V-14B --prompt "A futuristic city with flying cars and neon lights." --use_prompt_extend --prompt_extend_method 'local_qwen'Executando o Wan 2.1 com difusores

Se quiser usar a biblioteca Diffusers da Hugging Face em vez de executar scripts brutos, você pode gerar um vídeo com Python:

import torch

from diffusers.utils import export_to_video

from diffusers import AutoencoderKLWan, WanPipeline

from diffusers.schedulers.scheduling_unipc_multistep import UniPCMultistepScheduler

# Available models: Wan-AI/Wan2.1-T2V-14B-Diffusers, Wan-AI/Wan2.1-T2V-1.3B-Diffusers

model_id = "Wan-AI/Wan2.1-T2V-14B-Diffusers"

# Load the autoencoder for video generation

vae = AutoencoderKLWan.from_pretrained(model_id, subfolder="vae", torch_dtype=torch.float32)

# Define the scheduler for controlling video motion flow

flow_shift = 5.0 # 5.0 for 720P, 3.0 for 480P

scheduler = UniPCMultistepScheduler(

prediction_type='flow_prediction',

use_flow_sigmas=True,

num_train_timesteps=1000,

flow_shift=flow_shift

)

# Load the video generation pipeline with the model

pipe = WanPipeline.from_pretrained(model_id, vae=vae, torch_dtype=torch.bfloat16)

pipe.scheduler = scheduler

pipe.to("cuda")

# New prompt

prompt = "A futuristic city at sunset, filled with flying cars and neon lights. The buildings have a sleek, cyberpunk design, and people walk on glowing sidewalks. The scene is full of vibrant colors, reflections, and dynamic movement."

# New negative prompt

negative_prompt = "Dull colors, grainy texture, washed-out details, static frames, incorrect lighting, unnatural shadows, distorted faces, artifacts, low-resolution elements, flickering, blurry motion, repetitive patterns, unrealistic reflections, overly simplistic backgrounds, three legged people, walking backwards."

# Generate the video frames

output = pipe(

prompt=prompt,

negative_prompt=negative_prompt,

height=720,

width=1280,

num_frames=81,

guidance_scale=5.0,

).frames[0]

# Export the generated frames as a video

export_to_video(output, "output.mp4", fps=16)O script começa carregando o modelo Wan2.1-T2V-14B-Diffusers, que é usado para criar vídeos. Ele também carrega um VAE (Autoencoder), que ajuda a processar e melhorar os quadros de vídeo. Para controlar a suavidade com que o movimento aparece no vídeo, o script usa um agendador (UniPCMultistepScheduler). A configuração flow_shift ajusta como o movimento é tratado, sendo 5.0 melhor para resolução mais alta (720P) e 3.0 para resolução mais baixa (480P).

Em seguida, o script configura o pipeline de geração de vídeo (WanPipeline) e aplica o agendador para garantir transições mais suaves entre os quadros. O prompt descreve uma cidade futurista com carros voadores e luzes de neon brilhantes, enquanto o prompt negativo ajuda a remover efeitos indesejados, como detalhes borrados, cores desbotadas e quadros tremeluzentes.

Em seguida, o modelo cria 81 quadros, o que resulta em cerca de 5 segundos de vídeo a 16 quadros por segundo (FPS). O guidance_scale está definido como 5.0, o que ajuda o modelo a seguir o prompt e, ao mesmo tempo, permite alguma criatividade. Depois que o vídeo é gerado, os quadros são combinados e salvos como "output.mp4" a 16 FPS.

O prompt negativo desempenha um papel importante no aprimoramento do vídeo final, informando ao modelo o que deve ser evitado. Ele ajuda você a se livrar de coisas como baixa qualidade de imagem, distorções estranhas ou qualquer coisa que possa fazer com que o vídeo pareça irrealista. Nesse caso, ele garante que a cena futurista tenha uma aparência limpa, nítida e visualmente atraente.

Executando o Wan 2.1 com uma interface local do Gradio

Se preferir uma interface interativa da Web para gerar vídeos em vez de usar código, você pode executar o Wan 2.1 com o Gradio:

Para a extensão do prompt do Dashscope:

DASH_API_KEY=your_key python t2v_14B_singleGPU.py --prompt_extend_method 'dashscope' --ckpt_dir ./Wan2.1-T2V-14BPara a extensão do prompt local:

python t2v_14B_singleGPU.py --prompt_extend_method 'local_qwen' --ckpt_dir ./Wan2.1-T2V-14BAssim como o texto para vídeo, o processo de imagem para vídeo também é dividido em processos com e sem a etapa de extensão do prompt. Para obter mais detalhes sobre a implementação, você pode visitar o site oficial do GitHub oficial. Você também pode participar do canal do Discord para discutir o Wan2.1, compartilhar suas criações, receber atualizações sobre novos recursos e desenvolvimentos, e visitar o site oficial para você explorar os exemplos gerados.

Como o Wan 2.1 funciona?

O Wan 2.1 foi desenvolvido usando técnicas avançadas de IA para gerar vídeos realistas e de alta qualidade. Ele segue uma abordagem baseada em difusão e integra transformadores para garantir que os movimentos sejam suaves, consistentes e detalhados em todos os quadros.

Tecnologia de transformador de difusão

O Wan 2.1 usa uma técnica chamada modelos de difusão, que funcionam em duas etapas:

- Comece com o ruído: O modelo começa com uma imagem estática completamente aleatória.

- Gradualmente, você pode refiná-lo: Em várias etapas, o modelo remove o ruído e molda o vídeo quadro a quadro, orientado pelo prompt de entrada.

É como revelar uma foto em uma câmara escura - a imagem começa embaçada e granulada, mas fica mais clara a cada etapa do processamento.

O Wan 2.1 aprimora essa abordagem usando um transformador de difusão (DiT), que ajuda a manter detalhes nítidos e movimentos suaves ao gerar vários quadros de vídeo.

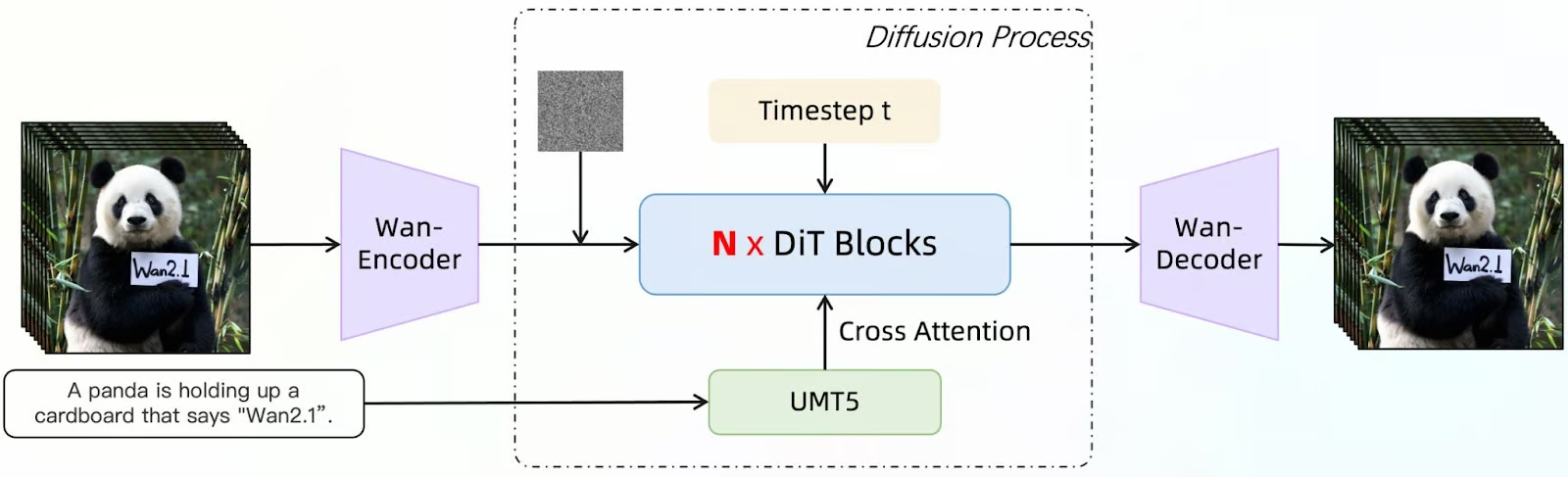

Fonte: GitHub (Wan-Video/Wan2.1)

Este diagrama mostra como o Wan 2.1 gera quadros de vídeo usando um modelo de difusão aprimorado com um transformador de difusão (DiT). O processo começa com uma descrição de entrada (por exemplo, "Um panda está segurando um cartão que diz 'Wan2.1'"). Esse texto é processado pelo UMT5, um modelo de linguagem que ajuda o sistema a entender e refinar o prompt.

Ao mesmo tempo, uma imagem inicial com ruído é introduzida como ponto de partida. Em seguida, o Wan-Encoder processa essas entradas, codificando-as em um formato que o modelo pode manipular. Os blocos N x DiT refinam a imagem iterativamente.

O modelo de difusão remove progressivamente o ruído dos quadros, usando a atenção cruzada para alinhar o resultado com o prompt fornecido. O intervalo de tempo (t) indica as etapas progressivas da redução de ruído, garantindo que o vídeo se desenvolva suavemente ao longo do tempo.

Após várias etapas de refinamento, o Wan-Decoder reconstrói os quadros de vídeo finais a partir dos dados processados. A saída é uma série de quadros que se alinham com a descrição da entrada original, mantendo detalhes nítidos, movimentos suaves e consistência.

Autoencodificador variacional de vídeo (VAE) para vídeos de alta qualidade

O Wan 2.1 apresenta o Wan-VAE, uma poderosa ferramenta de compactação que ajuda o modelo:

- Mantenha a consistência entre os quadros para que os objetos e as pessoas não mudem de forma aleatoriamente.

- Preserve os detalhes finosVocê pode usar o recurso de imagem de alta resolução, mesmo em altas resoluções, como 1080p.

- Processe vídeos mais longos sem perder informações anteriores.

É como quando você está compactando arquivos para vídeos: Ele comprime e armazena os principais detalhes e, em seguida, os reconstrói com precisão ao gerar o vídeo.

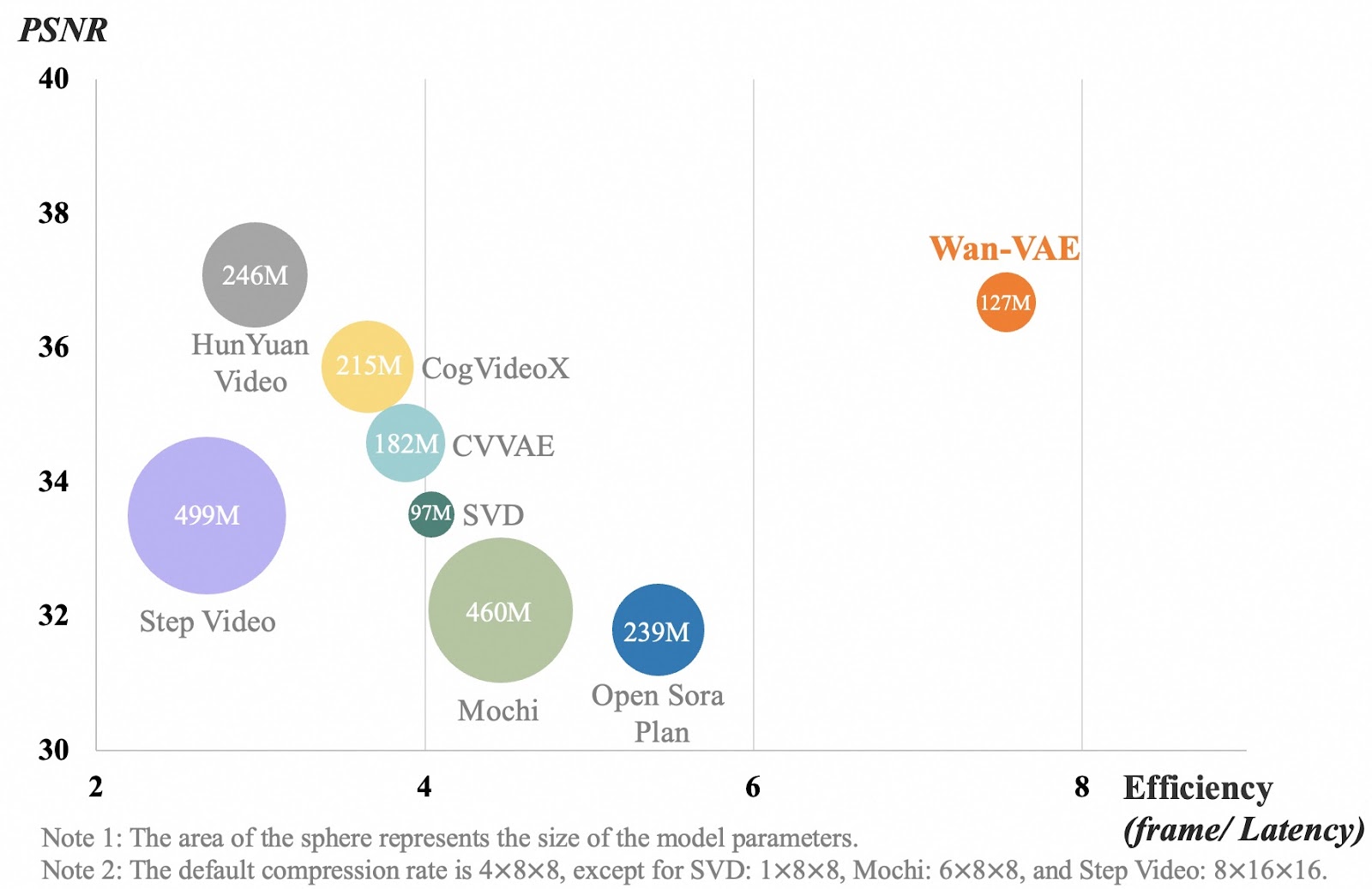

Fonte: GitHub (Wan-Video/Wan2.1)

O gráfico compara diferentes modelos de compactação de vídeo com base na qualidade do vídeo (PSNR) e na eficiência (a rapidez com que processam os quadros). Cada bolha representa um modelo, e seu tamanho mostra o tamanho do modelo. O eixo x mede a eficiência com que um modelo processa quadros de vídeo. Um número maior significa que o modelo funciona mais rápido. O eixo y mostra a qualidade do vídeo, em que um número maior significa vídeos mais claros e detalhados.

O Wan-VAE, mostrado em laranja, tem um desempenho melhor do que outros modelos, equilibrando alta qualidade de vídeo com processamento rápido e mantendo-se relativamente pequeno (parâmetros de 127M). Outros modelos, como o Step Video e o Mochi, são muito maiores, mas não processam quadros com a mesma eficiência. Isso significa que o Wan-VAE pode gerar vídeos longos e de alta qualidade, mantendo os detalhes nítidos e os movimentos suaves, sem diminuir a velocidade.

Casos de uso do Wan 2.1

O Wan 2.1 é um modelo versátil de geração de vídeo com IA que pode ser usado em muitos setores. Nesta seção, tentarei alguns exemplos para diferentes casos de uso.

Criação de conteúdo e mídia social

O Wan 2.1 pode ajudar você a gerar conteúdo de vídeo exclusivo sem equipamentos caros ou longas horas de edição. Então, vamos imaginar que eu seja um influenciador de estilo de vida e que queira criar algum conteúdo sobre um dia aconchegante em minha vida.Vou usar o seguinte prompt para criar um clipe para meu vídeo:

Uma animação em time-lapse de uma cafeteria aconchegante, da manhã à noite, mostrando as pessoas entrando e saindo, o café sendo preparado e o pôr do sol refletindo nas janelas.

Como eu queria que fosse o mais realista possível, também usei o modo de inspiração. Este é o resultado que obtive:

Quando o vídeo foi gerado, à primeira vista, fiquei muito impressionado. Mas depois de dar uma olhada mais de perto, percebi algumas coisas. Primeiro, alguém desaparece em segundo plano. Além disso, este não é um lapso de tempo e nenhum café está sendo preparado. Portanto, embora o vídeo pareça bastante realista, ele não reflete com precisão o prompt.

Jogos, mundos virtuais e animação

Agora, imagine que você é um desenvolvedor de jogos. Você pode usar o Wan 2.1 para gerar cenas realistas, animações de fundo ou arte conceitual para seus projetos. Por exemplo, se você já tiver um conceito de personagem e a equipe de criação tiver fornecido alguns designs, você poderá dar vida a ele usando o recurso de imagem para vídeo do Wan.

Além da animação de personagens, o Wan 2.1 também pode ajudar a criar ambientes dinâmicos, como efeitos climáticos variáveis, paisagens urbanas agitadas ou paisagens místicas, sem a necessidade de animar cada quadro manualmente.

Além disso, com o controle da proporção de aspecto, você pode garantir que suas animações se encaixem perfeitamente em diferentes cenas de jogos, como cinema em widescreen (16:9), fotos verticais compatíveis com dispositivos móveis (9:16) ou composições quadradas (1:1) para teasers de mídia social.

Você pode até usar o recurso de efeitos sonoros para gerar um ambiente de fundo, como o farfalhar das folhas, o zumbido de uma cidade futurista ou paisagens sonoras de batalha.

Vamos tentar algo!Eu criei este rascunho de um cavaleiro medieval com o DALL-E:

Usando o Wan, digitei o seguinte prompt usando o GPT-4o-mini:

Um cavaleiro medieval está em uma posição heroica, segurando uma grande espada com as duas mãos. Sua capa flui ao vento enquanto ele observa o campo de batalha. O cavaleiro vira lentamente a cabeça, examinando o horizonte com uma expressão determinada. A animação tem um estilo cinematográfico.Mas, em seguida, cliquei em Enhanced Prompt, e foi isso que recebi:

Cavaleiro medieval cinematográfico: Um cavaleiro galante permanece firme, vestindo uma armadura completa, segurando uma formidável espada larga com as duas mãos. Seu elmo com viseira e suas dragonas de ombro brilham sob o sol, enquanto um brasão nobre adorna seu peitoral. Uma faixa envolve sua cintura, prendendo o conjunto. Sua capa carmesim ondula dramaticamente com a brisa, aumentando sua presença imponente. Com um olhar de aço, ele gira a cabeça, examinando o vasto e arenoso campo de batalha. A cena se desenrola em um papel texturizado semelhante a um pergaminho, evocando uma sensação de manuscrito antigo. Essa é uma foto grandiosa, de corpo inteiro, capturando o cavaleiro em uma pose triunfante, que lembra o épico cinema medieval.

Desativei o Modo de inspiração, mas habilitei os Efeitos sonoros. Aqui está o resultado:

Nada mal! Embora eu deva admitir que estava esperando uma versão mais cinematográfica do rascunho, em vez de uma animação do próprio rascunho. Mas talvez eu pudesse ter sido mais claro na solicitação. A música é interessante, e acho que combina bem com a animação!

Publicidade e marketing

Se você for um profissional de marketing, poderá usar o Wan 2.1 para criar vídeos promocionais de marcas, produtos e serviços ou até mesmo para animar logotipos.

Imagine que você tem uma empresa de sorvetes e deseja animar seu logotipo para colocá-lo no final de seus anúncios ou vídeos promocionais.Para testar essa ideia, gerei mais uma vez essa imagem com o DALL-E. Você pode ver o logotipo do DALL-E:

Então, usei este prompt: O urso polar come o sorvete. Esse é o resultado da geração de imagem para vídeo:

Os primeiros quadros são um pouco estranhos, na minha opinião, mas podem ser cortados, e os últimos segundos podem ser usados para fins de propaganda, no final de um anúncio, por exemplo.

Educação e treinamento

Os vídeos gerados por IA podem simplificar tópicos complexos, tornando a educação mais envolvente. Wan pode ser usado para visualizar eventos históricos, conceitos científicos ou processos técnicos.

Imagine que você é um professor explicando como funciona o sistema solar. A Wan 2.1 pode gerar uma simulação de IA do processo.

Vamos experimentar!

Usando o prompt a seguir:

Sistema solar mostrando os planetas girando em torno do sol. O vídeo deve mostrar as trajetórias orbitais de cada planeta em seu eixo. O sol deve ter erupções solares visíveis.

Obtenho este resultado:

Ok, isso não é bom! Há muitas coisas erradas nesse vídeo sobre o sistema solar - ele definitivamente não deve ser usado para fins educacionais!

Primeiro, o sol não está no centro do sistema solar. As órbitas são representadas como estruturas grossas, semelhantes a anéis, que não representam com precisão as órbitas planetárias reais. Os planetas não estão girando em torno do Sol, e as órbitas em si estão incorretas. O tamanho também está incorreto...

Sinto que poderia continuar falando sobre tudo o que está errado! Pelo menos eles acertaram as explosões solares, eu acho!

Conclusão

O Wan 2.1 é uma ferramenta de IA de código aberto acessível que simplifica a criação de vídeos. Com sua capacidade de lidar com várias tarefas, incluindo a geração de texto para vídeo e imagem para vídeo, ele abre novas possibilidades para a criação de conteúdo em mídias sociais, publicidade, entretenimento, educação e muito mais.

Neste tutorial, exploramos vários casos de uso e descobrimos algumas das limitações do modelo, dando a você uma compreensão mais profunda de seus recursos.

Para saber mais sobre a geração de vídeos com IA, recomendo estes blogs:

Ana Rojo Echeburúa é especialista em IA e dados, com doutorado em Matemática Aplicada. Ela adora transformar dados em insights acionáveis e tem ampla experiência na liderança de equipes técnicas. Ana gosta de trabalhar em estreita colaboração com os clientes para resolver seus problemas de negócios e criar soluções inovadoras de IA. Conhecida por suas habilidades de resolução de problemas e comunicação clara, ela é apaixonada por IA, especialmente IA generativa. Ana se dedica ao aprendizado contínuo e ao desenvolvimento ético de IA, além de simplificar problemas complexos e explicar a tecnologia de forma acessível.