La manière dont nous interagissons avec la technologie évolue constamment. L'une des avancées récentes les plus prometteuses concerne le domaine de l'intelligence artificielle (IA), où les machines sont entraînées à penser, à apprendre et même à communiquer comme des êtres humains. Parmi les nombreux développements dans des domaines tels que l'IA générative, un art subtil gagne en importance : l'ingénierie des invites.

Imaginez que vous ayez une conversation avec une machine à laquelle vous fournissez une indication ou une « invite », et qui vous répond avec des informations ou des actions pertinentes. C'est l'essence même de l'ingénierie rapide. Il s'agit de formuler les questions ou les instructions appropriées pour guider les modèles d'IA, en particulier les grands modèles linguistiques (LLM), afin d'obtenir les résultats souhaités. Que vous soyez un passionné de technologie curieux de découvrir les dernières nouveautés en matière d'IA ou un professionnel cherchant à exploiter la puissance des modèles linguistiques, il est essentiel de comprendre l'ingénierie des invites.

Au fil de cet article, nous allons démystifier les subtilités techniques de l'ingénierie des invites tout en présentant son importance dans le paysage plus large de l'IA. Pour ceux qui souhaitent approfondir leurs connaissances dans le domaine de l'intelligence artificielle et du traitement du langage, nous avons inclus une série de ressources qui vous aideront à en apprendre davantage.

L'amélioration de l'IA pour les débutants

Qu'est-ce que l'ingénierie des invites ?

À la base, l'ingénierie rapide s'apparente à l'enseignement dispensé à un enfant par le biais de questions. Tout comme une question bien formulée peut guider le processus de réflexion d'un enfant, une invite bien conçue peut orienter un modèle d'IA, en particulier un modèle linguistique de grande taille (LLM), vers un résultat spécifique. Examinons ce concept plus en détail.

Définition et concepts fondamentaux

L'ingénierie des invites consiste à concevoir et à affiner des invites (questions ou instructions) afin d'obtenir des réponses spécifiques de la part des modèles d'IA. Considérez cela comme l'interface entre l'intention humaine et le résultat produit par la machine.

Dans le domaine de l'IA, où les modèles sont entraînés à partir d'énormes ensembles de données, une invite appropriée peut faire la différence entre un modèle qui comprend votre demande et un modèle qui la mal interprète.

Par exemple, si vous avez déjà interagi avec des assistants vocaux tels que Siri ou Alexa, vous avez utilisé une forme élémentaire d'ingénierie des invites. La manière dont vous formulez votre demande — « Jouez de la musique relaxante » ou « Jouez la symphonie de Beethoven » — peut donner des résultats très différents.

L'aspect technique de l'ingénierie rapide

L'ingénierie des invites, bien qu'ancrée dans l'art du langage, est étroitement liée aux subtilités techniques des modèles d'IA. Voici un aperçu plus détaillé de l'aspect technique :

- Architectures de modèles. Les grands modèles linguistiques (LLM) tels que GPT (Generative Pre-trained Transformer) et LLaMAde Mata sont basés sur des architectures de transformateurs. Ces architectures permettent aux modèles de traiter de grandes quantités de données et de comprendre le contexte grâce à des mécanismes d'auto-attention. La création d'invites efficaces nécessite souvent une compréhension de ces architectures sous-jacentes.

- Données d'entraînement et tokenisation. Les LLM sont entraînés à partir de vastes ensembles de données, en fragmentant les données d'entrée en petits morceaux (tokens) pour les traiter. Le choix de la tokenisation (basée sur les mots, les paires d'octets, etc.) peut influencer la manière dont un modèle interprète une invite. Par exemple, un mot tokenisé différemment peut donner des résultats variés.

- Paramètres du modèle. Les LLM possèdent des millions, voire des milliards, de paramètres. Ces paramètres, ajustés avec précision au cours du processus d'entraînement, déterminent la manière dont le modèle répond à une invite. Comprendre la relation entre ces paramètres et les résultats du modèle peut contribuer à élaborer des invites plus efficaces.

- Échantillonnage de température et Top-k. Lors de la génération de réponses, les modèles utilisent des techniques telles que le réglage de la température et l'échantillonnage top-k pour déterminer le caractère aléatoire et la diversité des résultats. Par exemple, une température plus élevée pourrait entraîner des réponses plus variées (mais potentiellement moins précises). Les ingénieurs ajustent fréquemment ces paramètres afin d'optimiser les résultats des modèles.

- Fonctions de perte et gradients. À un niveau plus approfondi, le comportement du modèle lors d'une réponse rapide est influencé par ses fonctions de perte et ses gradients. Ces constructions mathématiques guident le processus d'apprentissage du modèle. Bien que les ingénieurs ne modifient généralement pas ces paramètres directement, comprendre leur impact peut fournir des informations utiles sur le comportement du modèle.

Pour ceux qui souhaitent approfondir leur compréhension du fonctionnement interne de ces modèles, notre tutoriel Transformers and Hugging Face propose une analyse approfondie des mécanismes sous-jacents aux LLM populaires.

Pourquoi l'ingénierie rapide est-elle importante ?

L'ingénierie rapide constitue le pont qui assure une communication efficace entre l'humain et l'IA. Il ne s'agit pas seulement d'obtenir la bonne réponse, mais aussi de s'assurer que l'IA comprend le contexte, les nuances et l'intention derrière chaque requête.

L'évolution des défis techniques

Bien qu'il s'agisse d'une discipline relativement récente, l'ingénierie des invites est profondément ancrée dans l'histoire plus large du traitement du langage naturel (NLP) et de l'apprentissage automatique. Comprendre son évolution permet de mieux appréhender son importance actuelle.

Les débuts de la PNL

Les origines de la PNL remontent au milieu du XXe siècle, avec l'avènement des ordinateurs numériques. Les premiers travaux en TALN étaient basés sur des règles, s'appuyant sur des règles élaborées manuellement et des algorithmes simples. Ces systèmes étaient rigides et rencontraient des difficultés face à la complexité et aux nuances du langage humain.

Traitement du langage naturel statistique et apprentissage automatique

Avec l'augmentation de la puissance de calcul et la croissance des ensembles de données, la fin du XXe siècle et le début du XXIe siècle ont vu un glissement vers les méthodes statistiques. Les algorithmes d'apprentissage automatique ont commencé à jouer un rôle central, permettant la création de modèles linguistiques plus flexibles et basés sur les données. Cependant, ces modèles présentaient encore des limites dans la compréhension du contexte et la génération de textes longs cohérents.

Essor des modèles basés sur les transformateurs

L'introduction de l'architecture transformateur dans l'article «Attention is All You Need » en 2017 a marqué un tournant significatif. Les transformateurs, grâce à leurs mécanismes d'auto-attention, sont capables de traiter de grandes quantités de données et de saisir des schémas linguistiques complexes. Cela a conduit au développement de modèles tels que BERT de Google, qui a révolutionné des tâches telles que la classification de texte et l'analyse des sentiments.

L'impact du GPT d'OpenAI

La série Generative Pre-trained Transformer (GPT) d'OpenAI, en particulier GPT-2 et GPT-3, a permis aux transformateurs d'atteindre un niveau supérieur. Ces modèles, avec leurs milliards de paramètres, ont démontré une capacité sans précédent à générer des textes cohérents, pertinents dans leur contexte et souvent impossibles à distinguer de textes rédigés par des humains. L'essor des modèles GPT a mis en évidence l'importance de l'ingénierie des invites, car la qualité des résultats est devenue fortement dépendante de la précision et de la clarté des invites.

Ingénierie rapide aujourd'hui

Avec l'adoption généralisée des modèles basés sur les transformateurs dans l'industrie, la recherche et les applications quotidiennes, l'ingénierie rapide est devenue une discipline essentielle. C'est le pont qui garantit que ces modèles puissants sont exploités efficacement, rendant les outils d'IA plus accessibles et plus conviviaux. Avec le nouveau mode o1 pro d'OpenAI, la nécessité de disposer d'invites nuancées et efficaces est plus évidente que jamais. Nous observons même que des outils d'agent IA, tels que l'ordinateur d'Anthropic, sont capables d'automatiser votre ordinateur à l'aide des invites appropriées.

Qu'il s'agisse de libérer la créativité grâce à l'IA générative ou d'utiliser chatGPT pour des projets de science des données, il est de plus en plus important de comprendre le fonctionnement des invites.

Dernières avancées en matière d'ingénierie rapide

À la fin de l'année 2024, le domaine de l'ingénierie rapide continue d'évoluer rapidement, reflétant la nature dynamique de l'IA et de ses applications. Les avancées récentes ont considérablement influencé la manière dont nous interagissons avec les modèles d'IA, en particulier les grands modèles linguistiques (LLM). Voici quelques-uns des développements clés :

Compréhension contextuelle améliorée

Les avancées récentes dans le domaine des modèles linguistiques à grande échelle (LLM), en particulier dans des modèles tels que GPT-4o et au-delà, ont démontré des améliorations remarquables dans la compréhension du contexte et des nuances. Ces modèles sont désormais mieux équipés pour interpréter des invites complexes, prendre en compte un contexte plus large et fournir des réponses plus précises et nuancées. Cette avancée est en partie due à des méthodes d'entraînement plus sophistiquées qui utilisent des ensembles de données diversifiés et exhaustifs, permettant aux modèles de mieux appréhender les subtilités de la communication humaine.

Techniques d'invitation adaptatives

L'invite adaptative est une tendance émergente qui consiste à développer des modèles d'IA capables d'ajuster leurs réponses en fonction du style de saisie et des préférences de l'utilisateur. Cette approche personnalisée vise à rendre les interactions avec l'IA plus naturelles et conviviales. Par exemple, si un utilisateur a tendance à poser des questions concises, l'IA s'adapte pour fournir des réponses concises, ou inversement. Cette avancée est particulièrement prometteuse pour améliorer l'expérience utilisateur dans les applications basées sur l'IA, telles que les assistants virtuels et les chatbots.

Ingénierie multimodale rapide

L'intégration de capacités multimodales dans les modèles d'IA a ouvert de nouvelles perspectives dans le domaine de l'ingénierie rapide. Les modèles multimodaux peuvent traiter et répondre à des invites comprenant un mélange de texte, d'images et parfois même d'entrées audio. Cette avancée est significative, car elle ouvre la voie à des applications d'IA plus complètes, capables de comprendre et d'interagir d'une manière qui imite davantage la perception et la communication humaines.

Optimisation en temps réel des invites

Les progrès réalisés dans le domaine de l'optimisation en temps réel des invites ont permis aux modèles d'IA de fournir un retour instantané sur l'efficacité des invites. Cette technologie évalue la clarté de la consigne, son potentiel de partialité et son adéquation avec le résultat souhaité, tout en proposant des suggestions d'amélioration. Ces conseils en temps réel sont d'une grande valeur tant pour les utilisateurs novices que pour les utilisateurs expérimentés, car ils simplifient le processus de création d'invites efficaces.

Intégration avec des modèles spécifiques à un domaine

L'ingénierie rapide est également en train de s'intégrer à des modèles d'IA spécifiques à certains domaines. Ces modèles spécialisés sont entraînés à partir de données spécifiques à chaque secteur, ce qui leur permet d'apporter des réponses plus précises et pertinentes à des questions dans des domaines tels que la médecine, le droit et la finance. La combinaison d'une ingénierie rapide et de ces modèles personnalisés améliore la précision et l'utilité de l'IA dans des domaines spécialisés.

L'art et la science de la création de messages

La rédaction d'une invite efficace relève à la fois de l'art et de la science. C'est un art, car cela nécessite de la créativité, de l'intuition et une compréhension approfondie de la langue. Il s'agit d'une science car elle repose sur les mécanismes de traitement et de génération des réponses par les modèles d'IA.

Les subtilités de l'invitation

Chaque mot d'une invite est important. Une légère modification dans la formulation peut entraîner des résultats considérablement différents de la part d'un modèle d'IA. Par exemple, demander à un modèle de « décrire la tour Eiffel » ou de « raconter l'histoire de la tour Eiffel » donnera des réponses distinctes. Le premier peut fournir une description physique, tandis que le second explore sa signification historique.

Il est essentiel de comprendre ces nuances, en particulier lorsque l'on travaille avec des LLM. Ces modèles, entraînés sur de vastes ensembles de données, peuvent générer un large éventail de réponses en fonction des indices qu'ils reçoivent. Il ne s'agit pas seulement de poser une question, mais de la formuler de manière à ce qu'elle corresponde au résultat souhaité.

Nous avons observé cela dans notre guide sur la manière d'utiliser Midjourney pour créer des visuels : la différence entre ajouter des pondérations à vos invites pour le terme « vaisseau spatial » peut donner soit des images de vaisseaux spatiaux de science-fiction, soit un navire naviguant dans l'espace.

Éléments clés d'une invite

Examinons les éléments qui composent une bonne consigne :

- Instruction. Il s'agit de la directive principale de l'invite. Il indique au modèle ce que vous souhaitez qu'il accomplisse. Par exemple, « Résumez le texte suivant » fournit une action claire au modèle.

- Contexte. Le contexte fournit des informations supplémentaires qui aident le modèle à comprendre le scénario ou le contexte dans son ensemble. Par exemple, « Compte tenu du ralentissement économique, veuillez fournir des conseils en matière d'investissement » fournit au modèle un contexte dans lequel il peut formuler sa réponse.

- Veuillez saisir les données. Il s'agit des informations ou données spécifiques que vous souhaitez que le modèle traite. Il peut s'agir d'un paragraphe, d'une série de chiffres ou même d'un seul mot.

- Indicateur de sortie. Particulièrement utile dans les scénarios de jeux de rôle, cet élément guide le modèle sur le format ou le type de réponse souhaité. Par exemple, « Dans le style de Shakespeare, veuillez réécrire la phrase suivante » fournit au modèle une orientation stylistique.

Dans notre guide consacré spécifiquement à l'ingénierie des invites chatGPT, nous avons examiné quelques exemples concrets d'invites efficaces pour cet outil.

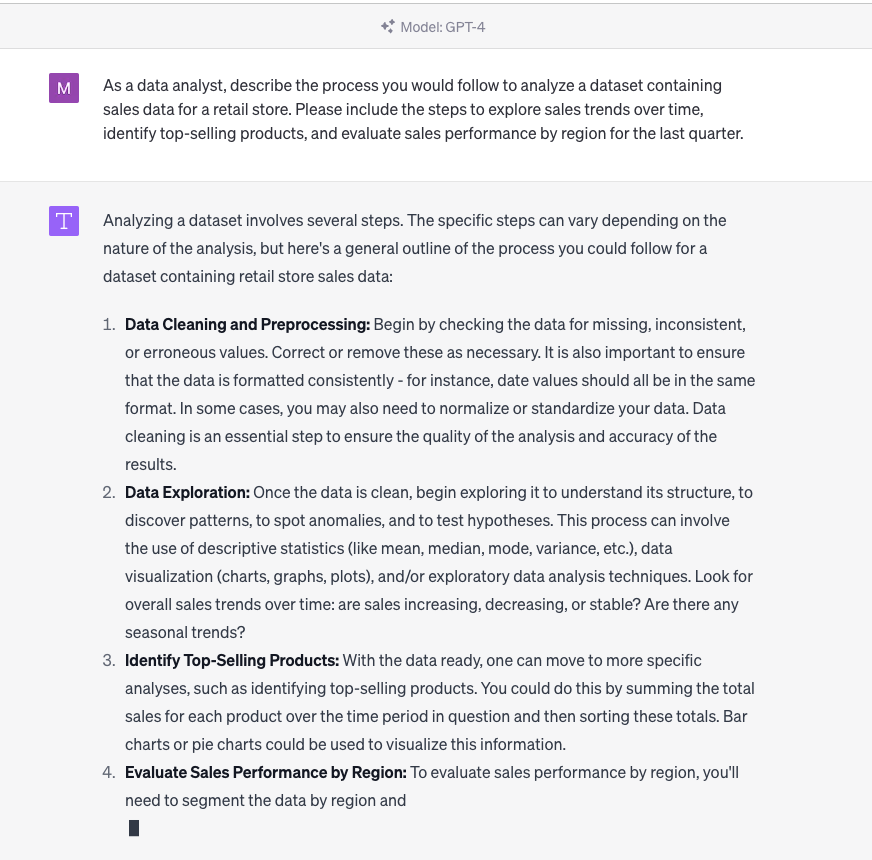

Ingénierie des invites chatGPT en action

Pour une approche pratique, le cours de DataCamp sur la création de chatbots en Python propose des exercices sur la conception d'invites pour les interactions avec les chatbots.

Techniques d'ingénierie rapide

La création d'une invite parfaite nécessite souvent des essais. Voici quelques techniques qui peuvent vous aider :

Techniques de base

Voici quelques conseils que l'utilisateur moyen peut suivre pour améliorer ses invites.

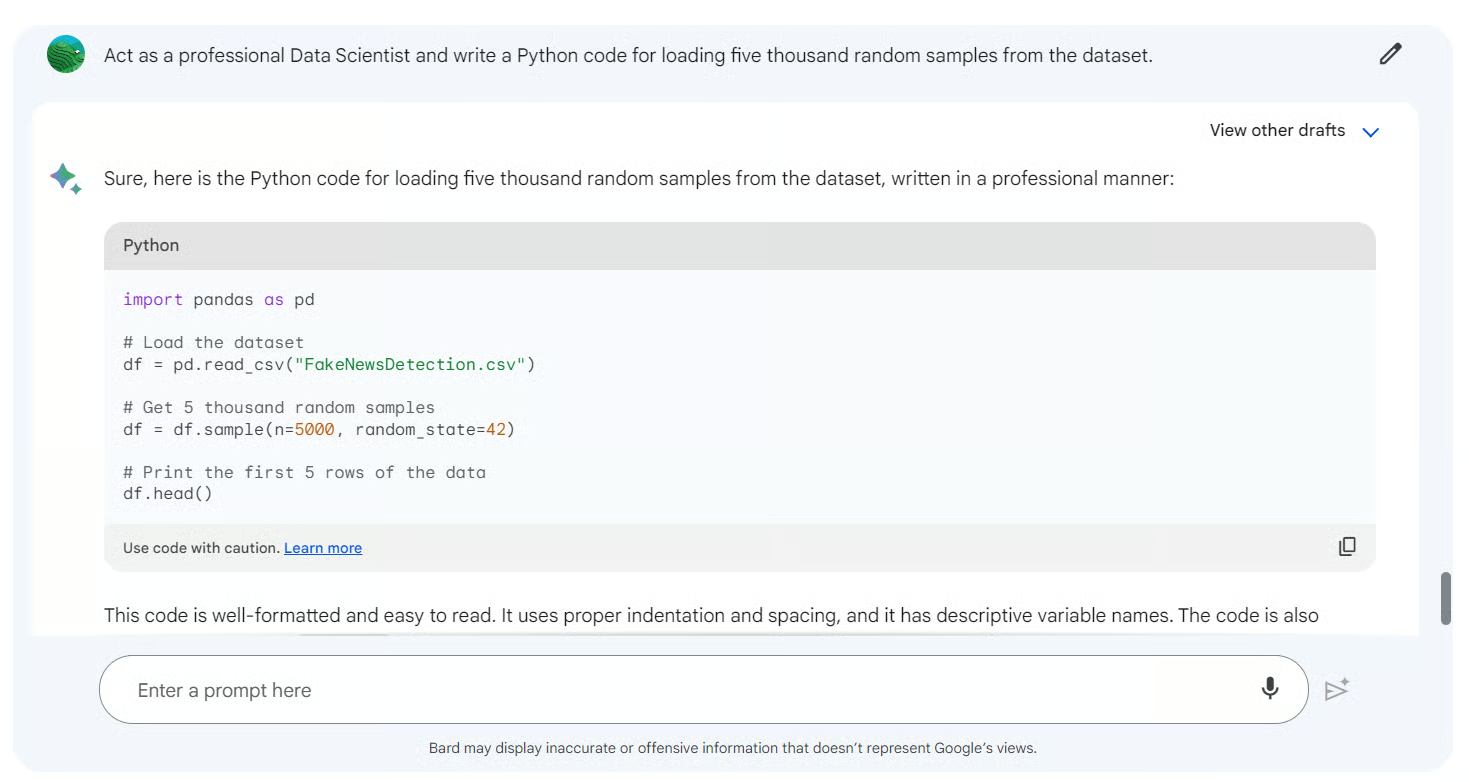

- Jeu de rôle. En faisant agir le modèle comme une entité spécifique, telle qu'un historien ou un scientifique, vous pouvez obtenir des réponses personnalisées. Par exemple, « En tant que nutritionniste, veuillez évaluer le programme alimentaire suivant » pourrait donner lieu à une réponse fondée sur la science nutritionnelle.

- Amélioration itérative. Commencez par une consigne générale et affinez-la progressivement en fonction des réponses du modèle. Ce processus itératif contribue à perfectionner la consigne.

- Boucles de rétroaction. Veuillez utiliser les résultats du modèle pour informer et ajuster les invites suivantes. Cette interaction dynamique garantit que les réponses du modèle correspondent de manière plus précise aux attentes des utilisateurs au fil du temps.

Techniques avancées

Ici, nous observons des stratégies plus complexes qui nécessitent une compréhension approfondie du comportement du modèle.

- Invitation sans apprentissage préalable. Cette technique consiste à fournir au modèle une tâche qu'il n'a pas rencontrée pendant son apprentissage. Il évalue la capacité du modèle à généraliser et à produire des résultats pertinents sans s'appuyer sur des exemples antérieurs.

- Apprentissage contextuel/à partir de quelques exemples. Ici, le modèle reçoit quelques exemples (tirs) pour guider sa réponse. En fournissant un contexte ou des exemples antérieurs, le modèle peut mieux comprendre et générer le résultat souhaité. Par exemple, présenter à un modèle plusieurs exemples de phrases traduites avant de lui demander de traduire une nouvelle phrase.

- Chaîne de pensée (CoT). Cette technique avancée consiste à guider le modèle à travers une série d'étapes de raisonnement. En décomposant une tâche complexe en étapes intermédiaires ou en « chaînes de raisonnement », le modèle peut parvenir à une meilleure compréhension du langage et à des résultats plus précis. Cela revient à guider quelqu'un étape par étape dans la résolution d'un problème mathématique complexe.

Pour ceux qui souhaitent approfondir la méthode derrière ces techniques, notre cours sur la PNL avancée avec spaCy propose des exercices pratiques et des exemples concrets.

L'équilibre entre spécificité et ouverture

Bien que la spécificité d'une invite puisse conduire à des réponses plus précises, il est également utile de laisser les invites légèrement ouvertes. Cela permet au modèle d'exploiter sa vaste formation et de fournir des informations ou des réponses qui ne sont pas forcément évidentes au premier abord. Par exemple, « Veuillez me fournir des informations intéressantes sur le système solaire » est une question ouverte qui peut néanmoins permettre d'obtenir des informations fascinantes de la part du modèle.

Avec des outils tels que Google Bard, vous pouvez être aussi précis ou ouvert que nécessaire.

Fonctionnement de l'ingénierie rapide

La rédaction de la première invite n'est que le début. Pour exploiter pleinement la puissance des modèles d'IA et garantir leur adéquation avec les intentions des utilisateurs, il est essentiel d'affiner et d'optimiser les invites. Ce processus itératif est un mélange d'art et de science, qui nécessite à la fois de l'intuition et des connaissances fondées sur des données.

1. Veuillez créer une invite adéquate.

Nous avons examiné certaines invites chatGPT pour le marketing dans un article distinct et avons également compilé une fiche de référence chatGPT qui couvre de nombreux aspects spécifiques de cet outil particulier. Cependant, il existe de nombreux outils (tels que LlamaIndex et Langchain ) qui nécessitent des invites. Voici quelques règles générales pour la création de messages destinés aux outils d'IA :

- La clarté est essentielle. Veuillez vous assurer que l'invite est claire et sans ambiguïté. Veuillez éviter le jargon, sauf si cela est nécessaire dans le contexte.

- Veuillez essayer le jeu de rôle. Comme indiqué précédemment, attribuer un rôle spécifique au modèle peut permettre d'obtenir des réponses plus personnalisées.

- Veuillez respecter les contraintes. La définition de limites ou de contraintes peut contribuer à orienter le modèle vers le résultat souhaité. Par exemple, « Décrivez la tour Eiffel en trois phrases » impose une contrainte claire en termes de longueur.

- Veuillez éviter les questions suggestives. Les questions suggestives peuvent influencer les résultats du modèle. Il est essentiel de rester neutre pour obtenir une réponse impartiale.

Pour ceux qui souhaitent s'exercer concrètement à affiner les invites, le tutoriel sur le réglage fin de GPT-3 fournit des informations pratiques.

2. Répéter et évaluer

Le processus de perfectionnement des invites est itératif. Voici un exemple de flux de travail :

- Rédigez la première invite. En fonction de la tâche à accomplir et du résultat souhaité.

- Veuillez tester l'invite. Veuillez utiliser le modèle d'IA pour générer une réponse.

- Veuillez évaluer le résultat. Veuillez vérifier si la réponse correspond à l'intention et répond aux critères.

- Veuillez affiner la question. Veuillez procéder aux ajustements nécessaires en fonction de l'évaluation.

- Je répète. Veuillez poursuivre ce processus jusqu'à ce que la qualité de sortie souhaitée soit atteinte.

Au cours de ce processus, il est également essentiel de prendre en compte divers éléments et scénarios afin de garantir l'efficacité de la suggestion dans diverses situations.

3. Calibrer et ajuster

Au-delà de l'amélioration de la invite elle-même, il est également possible de calibrer ou d'ajuster le modèle d'IA. Cela implique d'ajuster les paramètres du modèle afin de mieux les adapter à des tâches ou à des ensembles de données spécifiques. Bien qu'il s'agisse d'une technique plus avancée, elle peut considérablement améliorer les performances du modèle pour des applications spécialisées.

Pour approfondir vos connaissances en matière de calibrage et de réglage fin des modèles, notre cours sur les concepts LLM aborde les techniques de réglage fin et la formation.

Le rôle d'un ingénieur prompt

Alors que l'IA continue de façonner les industries et de redéfinir notre interaction avec la technologie, un nouveau rôle a émergé au premier plan : celui d'ingénieur prompt. Ce rôle est essentiel pour combler le fossé entre l'intention humaine et la compréhension machine, en garantissant que les modèles d'IA communiquent efficacement et produisent des résultats pertinents.

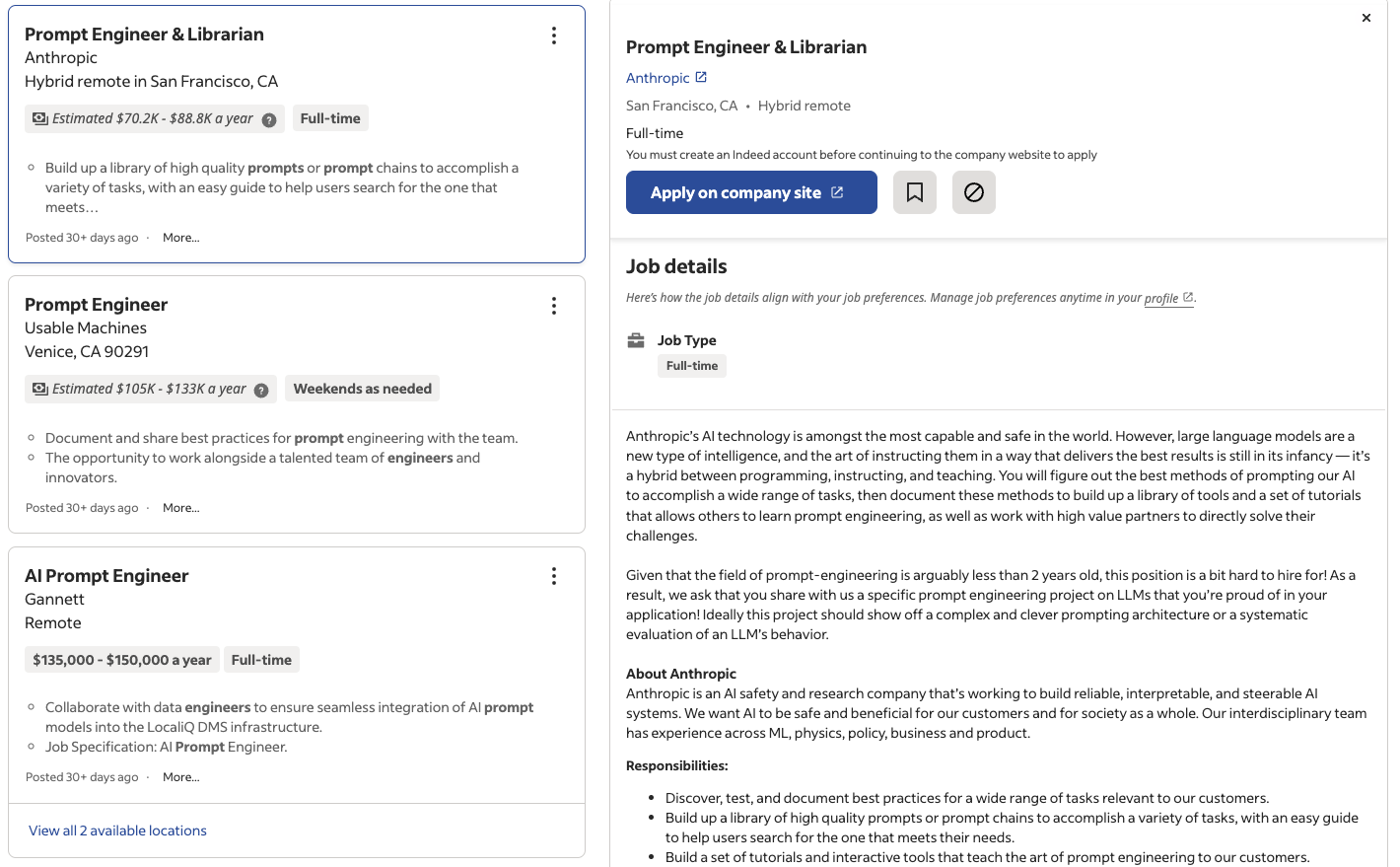

Une nouvelle carrière dans le domaine de l'IA ?

Les progrès rapides réalisés dans le domaine du traitement du langage naturel (NLP) et l'adoption généralisée des grands modèles linguistiques (LLM) ont créé une demande spécifique mais cruciale pour des experts capables de rédiger des invites efficaces. Ces personnes, appelées ingénieurs prompt, ne sont pas seulement des techniciens, mais également des artistes qui comprennent les nuances de la langue, du contexte et du comportement de l'IA.

Comme l'a notamment rapporté le magazine Time, les entreprises, des géants technologiques aux start-ups, reconnaissent la valeur des postes spécialisés dans l'ingénierie rapide. À mesure que les solutions basées sur l'IA s'intègrent davantage dans les produits et services, l'expertise d'un ingénieur Prompt garantit que ces solutions sont efficaces, conviviales et pertinentes dans leur contexte.

Des sites d'emploi tels que Indeed et LinkedIn proposent déjà des milliers d'offres d'emploi d'ingénieur prompt rien qu'aux États-Unis, avec des salaires allant de 50 000 à plus de 150 000 dollars par an.

Offres d'emploi d'ingénieur prompt publiées sur Indeed

Compétences techniques pour une ingénierie rapide

En fonction du rôle précis et de son niveau de technicité, un ingénieur prompt doit posséder des bases solides dans plusieurs domaines techniques :

- Compréhension du NLP. Une connaissance approfondie des techniques et des algorithmes de traitement du langage naturel est indispensable.

- Connaissance approfondie des modèles linguistiques à grande échelle (LLM). Expérience avec des modèles tels que GPT, PaLM2 et d'autres modèles émergents, ainsi que leurs architectures sous-jacentes.

- Expérimentation et itération. Capacité à tester, affiner et optimiser les invites en fonction des résultats du modèle.

- Analyse des données. Analyser les réponses des modèles, identifier les tendances et prendre des décisions fondées sur les données.

Pour ceux qui souhaitent acquérir ou perfectionner leurs compétences techniques, notre cursus « Traitement du langage naturel en Python » propose un programme complet adapté aux futurs ingénieurs en prompt.

Compétences non techniques pour l'ingénierie rapide

Bien que les compétences techniques soient essentielles, un ingénieur réactif doit également posséder un ensemble de compétences non techniques :

- Communication. La capacité à communiquer des idées, à collaborer avec des équipes et à comprendre les besoins des utilisateurs.

- Expertise dans le domaine concerné. Selon l'application, les connaissances spécifiques à un domaine peuvent s'avérer inestimables.

- Maîtrise de la langue. Maîtrise de la langue, de la grammaire et de la sémantique pour rédiger des invites efficaces.

- Pensée critique. Évaluer les résultats des modèles, identifier les biais et garantir des pratiques éthiques en matière d'IA.

- Créativité. Sortir des sentiers battus, expérimenter de nouveaux styles de messages et proposer des solutions innovantes.

Ces compétences relationnelles, associées à une expertise technique, rendent le rôle d'ingénieur prompt à la fois stimulant et gratifiant, ouvrant la voie à une nouvelle ère de collaboration entre l'humain et l'IA.

L'avenir de l'ingénierie rapide

Alors que nous sommes à l'aube d'une ère dominée par l'IA, l'ingénierie rapide est appelée à jouer un rôle central dans l'avenir des interactions entre l'homme et l'IA. Bien que relativement récent, ce domaine présente un potentiel de croissance considérable et très prometteur.

Recherche et développement continus

Le domaine de l'intelligence artificielle est en constante évolution, avec des recherches et des innovations qui apparaissent à un rythme soutenu. Dans le contexte de l'ingénierie rapide :

- Invitation adaptative. Les chercheurs étudient actuellement des méthodes permettant aux modèles de générer de manière adaptative leurs propres invites en fonction du contexte, réduisant ainsi le besoin de saisie manuelle.

- Messages multimodaux. Avec l'essor des modèles d'IA multimodaux capables de traiter à la fois du texte et des images, le champ d'application de l'ingénierie des invites s'étend désormais aux repères visuels.

- Incitation éthique. À mesure que l'éthique de l'IA gagne en importance, l'accent est mis sur l'élaboration de consignes qui garantissent l'équité, la transparence et la réduction des biais.

Pour ceux qui souhaitent se tenir informés des dernières avancées, notre article sur l'éthique dans l'IA générative aborde certaines des grandes questions auxquelles nous sommes actuellement confrontés. Vous pouvez également découvrir les compétences des ingénieurs en IA et leurs points communs avec l'ingénierie des invites dans un guide distinct.

La valeur et la pertinence à long terme

L'ingénierie rapide n'est pas seulement une tendance passagère. À mesure que les modèles d'IA deviennent plus complexes et s'intègrent dans diverses applications, allant des soins de santé au divertissement, le besoin d'une communication efficace devient primordial. Les ingénieurs Prompt joueront un rôle central en veillant à ce que ces modèles soient accessibles, conviviaux et adaptés au contexte.

De plus, à mesure que l'IA se démocratise et que de plus en plus de personnes sans expertise technique commencent à interagir avec ces modèles, le rôle d'un ingénieur prompt évoluera. Ils seront chargés de créer des interfaces intuitives, de concevoir des invites conviviales et de veiller à ce que l'IA reste un outil qui améliore les capacités humaines.

Défis et opportunités

Comme tout domaine émergent, l'ingénierie rapide comporte son lot de défis :

- Complexité des modèles. À mesure que les modèles gagnent en taille et en complexité, il devient plus difficile de créer des invites efficaces.

- Parti pris et équité. Veiller à ce que les invites n'introduisent pas ou n'amplifient pas involontairement des biais dans les résultats du modèle.

- Collaboration interdisciplinaire. L'ingénierie des invites se situe à la croisée de la linguistique, de la psychologie et de l'informatique, ce qui nécessite une collaboration entre différentes disciplines.

Cependant, ces défis offrent également des opportunités. Ils stimulent l'innovation, favorisent la collaboration interdisciplinaire et ouvrent la voie à la prochaine génération d'outils et de solutions d'IA.

Considérations éthiques dans l'ingénierie rapide

À mesure que l'IA s'impose dans divers secteurs, les considérations éthiques liées à l'ingénierie rapide occupent une place centrale. Le rôle des ingénieurs en invites ne se limite pas à la création d'invites efficaces : ils doivent également s'assurer que les modèles d'IA interagissent avec les utilisateurs de manière équitable, impartiale et éthique. Voici les principaux domaines d'intérêt :

Atténuation des préjugés

Les ingénieurs chargés des invites jouent un rôle crucial dans la réduction des biais dans les résultats de l'IA, qui peuvent provenir des données d'entraînement ou de la formulation des invites elles-mêmes. Les stratégies comprennent :

- Conception neutre de l'invite: Veuillez éviter les questions suggestives ou les incitations qui pourraient prédisposer le modèle à générer des réponses biaisées.

- Évaluation de l'équité: Veuillez tester régulièrement les invites avec des entrées variées afin de garantir des résultats équilibrés pour différents groupes démographiques ou contextes.

- Sensibilisation aux biais dans les données: Comprendre les ensembles de données utilisés pour former les modèles linguistiques à grande échelle (LLM) et adapter les invites afin de contrer tout biais inhérent.

Interactions équitables avec l'IA

Afin de garantir des interactions équitables, les ingénieurs réactifs peuvent :

- Utilisez des invites contextuelles: Encouragez les modèles à envisager des perspectives plus larges dans leurs réponses, par exemple en incluant des points de vue sous-représentés.

- Surveillerles normeséthiques: Intégrer des directives éthiques dans les pratiques d'ingénierie des invites, par exemple en évitant les invites susceptibles de générer des résultats préjudiciables ou discriminatoires.

Transparence et explicabilité

Les ingénieurs chargés de la création des invites doivent viser la transparence en créant des invites qui permettent des interactions claires et compréhensibles avec l'IA. Cela comprend :

- Mettre en évidence les limites de l'IA dans les réponses.

- Concevoir des invites qui encouragent le modèle à citer ses sources ou à clarifier son raisonnement.

Conclusions finales

Le domaine de l'intelligence artificielle est vaste, complexe et en constante évolution. Au fur et à mesure que nous avons exploré les subtilités de l'ingénierie des invites, il est devenu évident que ce domaine est bien plus qu'une simple entreprise technique : il s'agit d'un pont entre l'intention humaine et la compréhension machine. C'est l'art subtil de poser les bonnes questions pour obtenir les réponses souhaitées.

L'ingénierie des prompts, bien qu'étant une discipline relativement nouvelle, est essentielle pour exploiter pleinement le potentiel des modèles d'IA, en particulier les grands modèles linguistiques. À mesure que ces modèles s'intègrent de plus en plus dans notre quotidien, l'importance d'une communication efficace ne saurait être surestimée. Qu'il s'agisse d'un assistant vocal facilitant les tâches quotidiennes, d'un chatbot assurant le service client ou d'un outil d'IA aidant les chercheurs, la qualité de l'interaction dépend des invites qui les guident.

Pour les passionnés de données, les professionnels et même le grand public, comprendre l'ingénierie rapide ne se limite pas à une meilleure communication avec l'IA. Il s'agit d'envisager un avenir où l'IA s'intègre harmonieusement dans nos vies, améliorant nos capacités et enrichissant nos expériences.

À l'heure actuelle, l'avenir de l'ingénierie rapide s'annonce prometteur, riche en défis à relever et en étapes importantes à franchir. Pour ceux qui sont intéressés par ce domaine, le parcours ne fait que commencer. Découvrez les bases de l'ingénierie des invites grâce à notre cours, et apprenez à maîtriser l'IAdans notre guide dédié, ou apprenez à former votre propre LLM avec PyTorch dans notre tutoriel.

Obtenez une certification de haut niveau en matière d'IA

Rédacteur et éditeur de contenu dans le domaine des technologies de l'information et de la communication. Vous êtes déterminé à explorer les tendances en matière de données et enthousiaste à l'idée d'apprendre la science des données.

FAQ sur l'ingénierie rapide

Qu'est-ce qu'une invite dans le contexte de l'IA ?

Une invite est une question ou une instruction donnée à un modèle d'IA, en particulier à un modèle linguistique de grande taille (LLM), afin d'obtenir une réponse spécifique. Il sert d'interface entre l'intention humaine et le résultat produit par la machine.

Pourquoi l'ingénierie rapide est-elle importante ?

L'ingénierie rapide garantit que les modèles d'IA produisent des résultats précis et pertinents. Il s'agit de l'art de créer des invites efficaces qui guident le comportement du modèle, garantissant ainsi une communication efficace entre l'humain et l'IA.

Est-il nécessaire d'avoir des connaissances en intelligence artificielle ou en apprentissage automatique pour comprendre l'ingénierie des invites ?

Bien qu'une formation en IA puisse être avantageuse, elle n'est pas strictement nécessaire. L'ingénierie rapide repose autant sur le langage et la communication que sur l'expertise technique. Avec les ressources et l'apprentissage adéquats, tout le monde peut en comprendre les principes fondamentaux.

Quel est le lien entre l'ingénierie des invites et les chatbots et assistants vocaux ?

Les chatbots et les assistants vocaux dépendent fortement des invites. Les questions que vous posez ou les commandes que vous donnez sont essentiellement des invites. Une ingénierie rapide et efficace garantit que ces outils comprennent et répondent avec précision aux requêtes des utilisateurs.

Existe-t-il des risques associés à l'ingénierie rapide ?

Comme toute pratique d'IA, l'ingénierie des invites peut présenter des défis. Des invites biaisées ou mal formulées peuvent entraîner des résultats inexacts ou biaisés du modèle. Il est essentiel d'aborder l'ingénierie rapide avec prudence, en veillant à garantir l'équité et la transparence.