Cours

Si vous avez déjà travaillé avec des statistiques inférentielles, en particulier des tests d'hypothèses et des régressions, vous avez probablement déjà entendu parler de la valeur p. Et si vous avez déjà travaillé avec des valeurs p, vous savez probablement, ou du moins vous vous en doutez, que les valeurs p sont vulnérables et peuvent être manipulées, et vous avez raison.

En réalité, cette manipulation a même donné son nom à un terme. C'est ce qu'on appelle le « p-hacking ». Parfois, on parle également d', de « data dredging », de « data snooping », de « data fishing » et de « biais d'inflation ». C'est ce que nous allons examiner dans cet article.

Qu'est-ce qu'une valeur P ?

Tout d'abord, rappelons rapidement ce qu'est une valeur p. Le « p » dans « p-value » signifie « probabilité ». Plus précisément, la valeur p est la probabilité d'observer des résultats aussi extrêmes que ceux obtenus, en supposant que l'hypothèse nulle soit vraie. Ce rejet incorrect est également appelé « erreur de type I » ou « erreur de type faux positif ». En général, il est obtenu pour être comparé au niveau de signification (désigné par α), qui est la probabilité tolérée de rejeter l'hypothèse nulle lorsqu'elle est vraie.

Logiquement, il s'ensuit que si la valeur p est supérieure au niveau de signification, nous ne pouvons pas rejeter l'hypothèse nulle et nous nous en tenons à celle-ci. D'autre part, si la valeur p est inférieure ou égale au niveau de signification, nous pouvons rejeter l'hypothèse nulle en faveur de l'hypothèse alternative, et dans ce cas, nous disons que les résultats sont statistiquement significatifs.

Si l'un des éléments de ce bref rappel sur les valeurs p ne vous semble pas clair, ne vous inquiétez pas. Vous pouvez suivre notre cours théorique Introduction aux statistiques et acquérir rapidement les bases nécessaires .

Introduction au P-Hacking

Obtenir des résultats « statistiquement significatifs » semble être synonyme de réussite et est donc très attrayant. Dans le monde des affaires, cela signifierait que vous avez quelque chose de nouveau, d'intéressant ou de souhaitable à signaler. Dans le milieu universitaire, vous avez découvert quelque chose qui peut ensuite être publié dans des revues spécialisées.

Et comme il s'agit de la clé de ce monde passionnant, les professionnels des données et les chercheurs sont tentés de se concentrer excessivement sur les valeurs p de leurs études et de ne tenir compte d'aucun autre élément, pas même le niveau de signification. Et comme le niveau de signification le plus couramment considéré depuis des décennies est de 0,05, il est devenu facile de dire que si vous obtenez une valeur p inférieure à 0,05, vous pouvez retirer votre veste et célébrer immédiatement.

En conséquence, certains chercheurs commettent l'erreur du « p-hacking », parfois intentionnellement, mais généralement de manière involontaire, en appliquant des méthodes susceptibles de réduire la valeur p à un niveau statistiquement significatif, alors que des tests appropriés auraient donné des résultats différents.

Fonctionnement du P-hacking

Que ce soit intentionnel ou non, il existe de nombreuses façons de commettre des erreurs pouvant mener au p-hacking. Les méthodes qui conduisent au p-hacking peuvent être appelées p-hacks, et elles peuvent se produire à n'importe quelle phase des expériences.

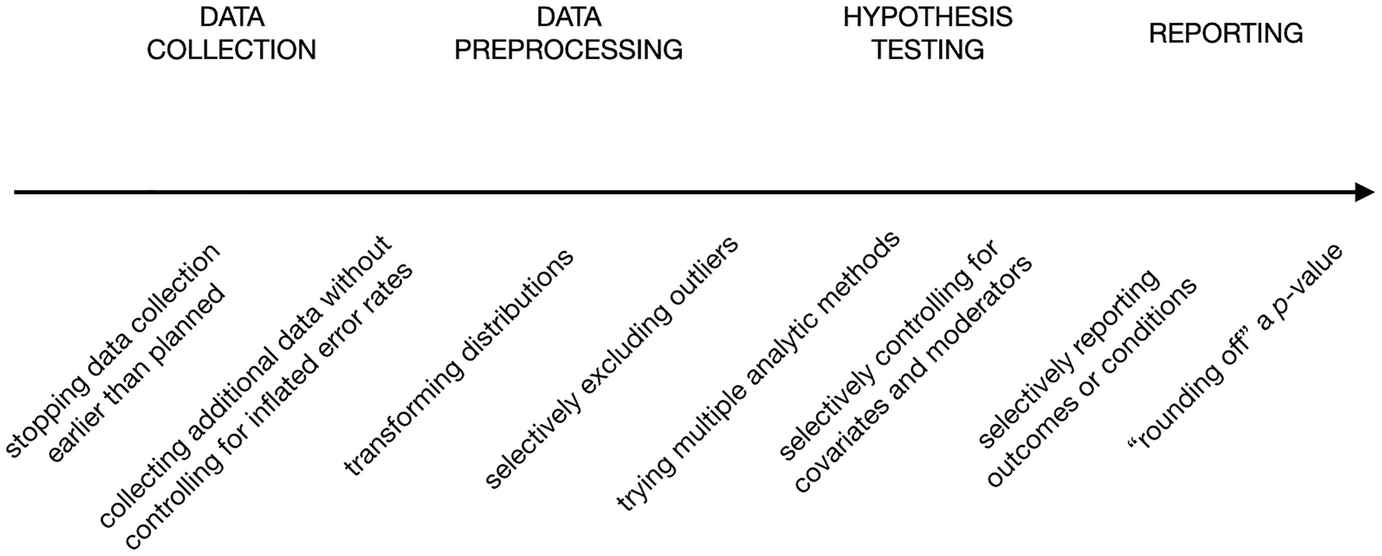

Dans leur chapitre intitulé « The Myriad Forms of p-Hacking » (Les multiples formes du p -hacking), Dorota Reis et Malte Friese fournissent une liste non exhaustive des p-hacks aux différentes étapes des expériences, de la collecte des données jusqu'à la présentation des résultats, représentée dans le graphique suivant.

Exemples de p-hacks. Source : Éviter les pratiques de recherche discutables en psychologie appliquée.

Voyons ce que signifie chaque élément, de gauche à droite :

- Arrêt facultatif : Cela signifie qu'il convient d'arrêter la collecte de données lorsque les individus étudiés donnent lieu à une valeur p significative, et non lorsque la taille de l'échantillon requis est atteinte.

- Collecte de données supplémentaires : Il s'agit d'une extension de la pratique précédente. La collecte de données supplémentaires peut parfois réduire la valeur p lorsqu'il n'y a pas d'effet sous-jacent réel.

- Transformer les distributions : La transformation peut être une étape nécessaire dans tout processus de préparation des données, mais lorsque plusieurs transformations sont essayées et que celle qui conduit à une valeur p significative est finalement choisie, il s'agit d'un p-hack.

- Exclure de manière sélective les valeurs aberrantes : Tout comme la transformation de la distribution, le traitement des valeurs aberrantes est une étape essentielle de la préparation des données. Il existe plusieurs méthodes pour détecter et exclure les valeurs aberrantes. Lorsque la méthode qui conduit les données à générer une signification statistique est sélectionnée de manière sélective, il s'agit d'un p-hack.

- Essayer plusieurs méthodes analytiques : Cela implique de réaliser différents types de tests d'hypothèses et de sélectionner celui qui aboutit à un résultat significatif.

- Modélisation multiple : Essayer différents modèles de variables et choisir celui qui conduit à une signification statistique, en ignorant le raisonnement théorique qui sous-tend ce choix, constitue également un p-hack.

- Remplacement a posteriori : Cela implique de remplacer ou d'ignorer un ensemble de points de données ou de conditions qui donnent lieu à une valeur p plus élevée, soit au cours des cycles de tests d'hypothèses, soit lors de la communication des résultats.

- Arrondir une valeur p: Il s'agit du p-hack le plus visible, car il repose sur l'arrondi de la valeur p lorsqu'elle est légèrement supérieure au niveau de signification. Par conséquent, il n'atteint même pas une valeur p statistiquement significative manipulée, mais il prétend le faire.

Veuillez noter que la plupart de ces p-hacks dépendent de la répétition de l'expérience, en modifiant à chaque fois ce qui devrait être une base prédéterminée pour l'expérience.

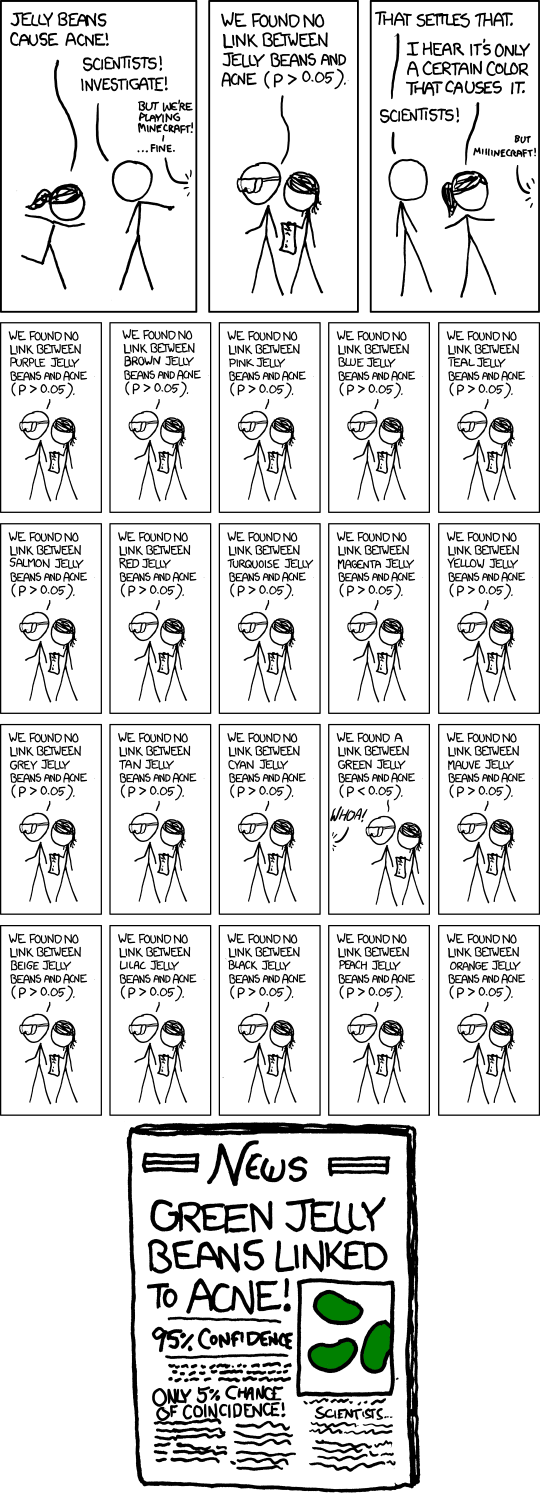

Cependant, même sans modification, le fait de répéter la même expérience et de ne communiquer les résultats que lorsqu'ils sont statistiquement significatifs peut constituer un p-hack, car il existe toujours une possibilité que, si une expérience est répétée suffisamment de fois, elle aboutisse à un moment donné à une valeur p faible. La bande dessinée ci-dessous, tirée du site, illustre cette idée.

Bande dessinée remarquable. Source : xkcd.

Exemples concrets de P-hacking

Le « P-hacking » est un phénomène très répandu. Au début des années 2010, de nombreuses études ont commencé à démontrer qu'un pourcentage important des recherches publiées dans des revues réputées dans divers domaines était susceptible d'avoir fait l'objet d'un « p-hacking », en particulier dans les domaines de la psychologie et de la médecine, mais également dans les sciences sociales et humaines.

Par exemple, en 2015, une étude menée par un chercheur de l'université de Virginie, qui a examiné 100 études en psychologie publiées dans des revues prestigieuses en 2008, a révélé que moins de la moitié de ces études étaient reproductibles. Le manque de reproductibilité signifie que les études, lorsqu'elles sont reproduites, ne conduisent pas aux mêmes résultats, parfois en raison du « p-hacking ».

Un autre projet qui s'est penché sur les études sur le cancer a révélé que seules 50 expériences sur 193 sont reproductibles. Plus tôt en 2009, une étude avait déjà relevé un nombre suspect d'expériences dans le domaine des neurosciences rapportant des corrélations inhabituellement élevées entre les émotions, la personnalité, la cognition sociale et l'activité cérébrale mesurée par IRMf. Après avoir interrogé les auteurs de ces expériences, il s'est avéré qu'ils s'appuyaient sur une stratégie consistant à sélectionner de manière sélective des sous-ensembles de données et à ne rendre compte que de ceux qui donnaient un résultat significatif, une technique similaire à ce que nous avons appelé le remplacement post hoc.

Les conclusions de ces études ont révélé comment le « p-hacking », associé à d'autres pratiques de recherche discutables, ébranle les fondements d'une recherche scientifique longtemps respectée et la rend lacunaire. Une crise qualifiée de « crise de la reproductibilité », qui sepoursuit actuellement et fait l'objet de nombreuses discussions et efforts pour trouver une issue.

Pourquoi le P-hacking est contraire à l'éthique

Alors, pourquoi le p-hacking est-il un problème après tout ?

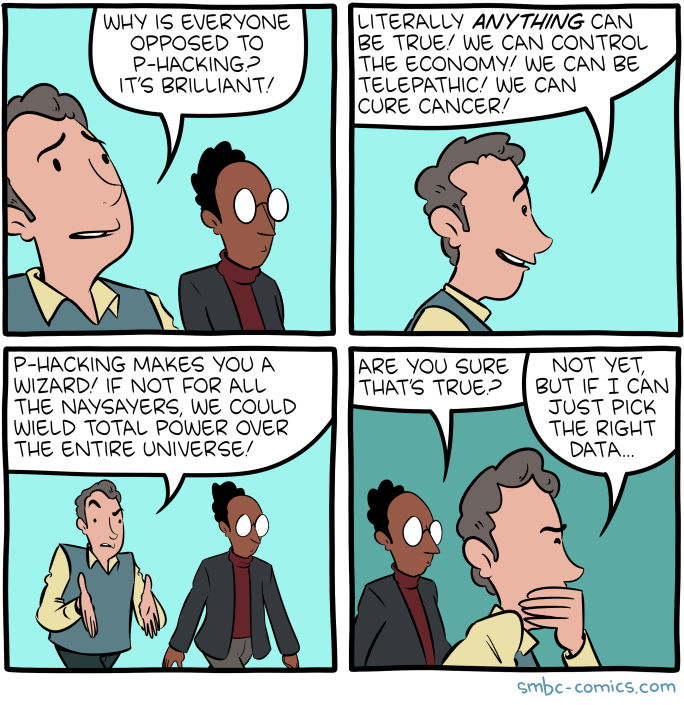

Le « P-hacking »vous transforme en expert. Source : SMBC Comics.

La question peut sembler trop évidente pour mériter une réponse, mais une analyse des raisons pour lesquelles le p-hacking est inapproprié et contraire à l'éthique peut également nous aider à mieux comprendre l'importance du problème de la signification falsifiée.

C'est tout simplement de la manipulation.

Le P-hacking n'est en substance rien d'autre que le résultat d'une manipulation de la méthodologie ou des résultats. Si cela est fait intentionnellement, cela reviendrait simplement à mentir sans autre raison que son propre intérêt (comme être publié ou reconnu). Si cela est fait de manière involontaire, cela reviendrait à emprunter la mauvaise voie et à n'aboutir finalement qu'à un mirage de faux positifs.

Cela peut entraîner des décisions erronées et des conséquences désastreuses.

Les expériences, qu'elles soient scientifiques ou commerciales, ont des conséquences. Ils sont réalisés afin de prendre des décisions ou d'approfondir les résultats obtenus. Si les résultats de l'expérience sont falsifiés, les décisions qui en dépendent seraient infondées, ce qui peut parfois avoir des conséquences désastreuses.

Par exemple, la recherche dans des domaines sensibles tels que l'oncologie et la neurologie peut contribuer collectivement au développement de traitements et de médicaments. Il serait regrettable que certaines des recherches initiales aient été manipulées.

Dans le monde des affaires, les mauvaises décisions peuvent avoir de nombreuses conséquences, telles que le lancement d'un produit défaillant, l'épuisement des ressources, le licenciement d'un employé ou la faillite. Une simple manipulation statistique peut créer un effet papillon.

Cela érode la confiance dans la méthode scientifique.

La crise de la reproductibilité a suscité un scepticisme généralisé à l'égard de la science dans son ensemble, qui s'exprime même dans le discours politique. Si l'esprit critique est toujours utile, même lorsqu'il s'agit d'accepter des conclusions scientifiques, rejeter toute conclusion empirique peut conduire à un sentiment de désespoir face à l'ignorance et à des décisions infondées.

Dans le monde des affaires, à plus petite échelle, le p-hacking et d'autres pratiques douteuses similaires peuvent conduire les dirigeants à renoncer à prendre des décisions fondées sur des données pour revenir à une approche reposant uniquement sur leur intuition, ce qui est exactement le contraire de ce que promet et peut réellement offrir le domaine de la science des données dans son ensemble.

Cela remet en question la nature cumulative de la connaissance.

La connaissance humaine repose entièrement sur sa nature cumulative. Chaque petite expérience est un élément constitutif qui contribue à l'élaboration d'une structure de connaissances plus vaste. Lorsque de plus en plus de ces éléments constitutifs deviennent fragiles en raison de pratiques discutables telles que le « p-hacking », le potentiel d'une telle accumulation devient compromis. Même la simple recherche de publications antérieures pour élaborer une nouvelle expérience peut s'avérer être une tâche complexe, comparable à la traversée d'un champ de mines.

Signaux d'alerte et comment détecter le P-hacking

Sur la base de ce que nous savons actuellement sur le p-hacking et ses méthodes, nous pouvons déduire certains signaux d'alerte qui peuvent nous aider à détecter les p-hacks. La plupart de ces signaux d'alerte nécessitent encore un esprit curieux, une réflexion critique et un regard introspectif pour être remarqués. Certaines nécessitent même des connaissances approfondies dans un domaine particulier.

Résultats excessivement sensationnels

Les résultats d'expériences sensationnels sont généralement trop suspects pour être pris au pied de la lettre. Généralement relayées par la presse et les réseaux sociaux, les études affirmant que « le chocolat peut favoriser la perte de poids » ne semblent pas tout à fait fiables.

Dans le monde des affaires, un test promettant une augmentation de 100 % des bénéfices grâce à l'introduction d'une petite fonctionnalité sur un site web peut être considéré comme tout aussi sensationnel.

Lorsque vous rencontrez une telle étude, si elle vous préoccupe, veuillez toujours vérifier la méthodologie et les résultats avant d'accepter les conclusions.

Manque de transparence dans la méthodologie

Veuillez vous méfier des expériences dont la méthodologie n'est pas claire ou qui ne mentionnent pas certains éléments de la méthodologie. Il est essentiel, pour garantir une procédure scientifique rigoureuse, de faire preuve de transparence quant aux hypothèses initiales, au niveau de signification, à la taille de l'échantillon, aux variables collectées, au type de test choisi et aux étapes de préparation des données. Toute imprécision concernant l'un de ces éléments constitue un signal d'alerte.

Transformation inutile des données

Si la préparation des données expérimentales comprend une transformation des variables, veuillez vérifier la raison de cette mesure, car elle doit être justifiée. Si ce n'est pas le cas, ou si cela n'est pas convaincant, cela peut être un indicateur direct de p-hacking.

Taille de l'échantillon trop petite et non justifiée

Un échantillon de petite taille réduit la puissance statistique de l'étude, augmentant ainsi le risque de faux négatifs. Cependant, lorsqu'elles sont associées à une sélection sélective des résultats ou au « p-hacking », les études à faible puissance peuvent également contribuer à un taux plus élevé de résultats faussement positifs dans la littérature publiée.

Dans certains domaines, les échantillons de petite taille sont acceptables et courants, comme dans la recherche clinique, les études environnementales, l'ingénierie et le contrôle qualité. Cependant, de manière générale, des échantillons plus importants permettent de meilleures inférences et réduisent donc le risque de faux positifs et de valeurs p significatives erronées.

Dans tous les cas, si la petite taille de l'échantillon n'est pas justifiée, cela peut indiquer un manque de puissance statistique, ce qui augmente le risque de résultats faussement positifs. Dans certains cas, je pense que cela peut également faire référence à l'arrêt prématuré, la pratique spécifique de p-hacking que j'ai mentionnée précédemment, où la collecte de données prend fin une fois que la significativité est atteinte plutôt que lorsque la taille de l'échantillon prévue est atteinte.

Ampleur de l'effet incertaine

La taille de l'effet mesure la force ou l'ampleur de la relation entre les variables, en contextualisant la signification statistique d'un résultat. Si une étude fait état d'une signification statistique mais ne fournit pas d'effet clair ou significatif, cela soulève des doutes.

Une valeur p peut indiquer que le résultat est peu probable en raison du hasard, mais sans ampleur de l'effet, il est difficile de déterminer la signification pratique des résultats. Dans les études p-hackées, le fait de ne pas préciser la taille de l'effet peut indiquer que les chercheurs se sont trop concentrés sur l'obtention d'une signification statistique, sans tenir compte d'autres considérations.

Incohérence entre l'hypothèse énoncée et le résultat

Lorsque les résultats d'une étude s'écartent considérablement de l'hypothèse initiale, cela devrait susciter des questions. Cela pourrait indiquer que les chercheurs ont modifié leur hypothèse ou leurs méthodes après avoir collecté les données afin de les adapter aux résultats, une pratique connue sous le nom de HARKing (HypothesizingAfter Results are Known, ou« émettre des hypothèses après connaître les résultats»).

Par exemple, si une expérience prétend avoir testé une hypothèse spécifique, mais que l'analyse finale semble se concentrer sur des variables ou des résultats non liés, cela peut suggérer un p-hacking. Veuillez toujours comparer l'hypothèse énoncée avec les résultats finaux afin de vous assurer qu'ils concordent.

Effet de taille exceptionnellement élevé

Une taille d'effet exceptionnellement élevée peut constituer un signal d'alerte indiquant un p-hacking. Dans de nombreux cas, les effets dans le monde réel sont faibles à modérés, en particulier dans des domaines tels que la psychologie, la médecine ou les sciences sociales. Tout comme pour déterminer la taille appropriée d'un échantillon, comprendre la plausibilité de la taille d'un effet nécessite une expertise approfondie dans le domaine concerné.

Si une étude fait état d'un effet inhabituellement important, cela pourrait indiquer que les données ont été manipulées de manière sélective ou que l'échantillon est biaisé d'une manière ou d'une autre. Les chercheurs peuvent, intentionnellement ou non, exclure des données qui réduiraient l'ampleur de l'effet afin de rendre leurs résultats plus impressionnants qu'ils ne le sont en réalité (le « p-hack » post hoc).

Une valeur p qui se situe juste en dessous du niveau de signification.

Lorsque la valeur p rapportée est juste en dessous du seuil de signification (par exemple, p = 0,049 dans une étude où p < 0,05 est le seuil de signification), cela peut indiquer que les chercheurs ont eu recours au p-hacking.

En effet, effectuer des tests à plusieurs reprises ou modifier des variables peut conduire à un résultat qui dépasse à peine le seuil de signification par hasard. Un ensemble de résultats qui se situent systématiquement juste en dessous du seuil de signification suggère que les chercheurs ont peut-être arrêté la collecte des données dès qu'ils ont obtenu le résultat souhaité (arrêt prématuré) ou qu'ils ont sélectionné certaines analyses pour les présenter (remplacement a posteriori).

Irréplicabilité

L'un des indicateurs les plus évidents du p-hacking est lorsque les résultats d'une étude ne sont pas reproductibles. Si des chercheurs indépendants ne parviennent pas à reproduire les résultats d'une étude en utilisant la même méthodologie, cela peut indiquer que les conclusions initiales étaient le résultat d'un p-hacking ou d'une communication sélective.

La reproductibilité est un pilier de l'intégrité scientifique, et les résultats qui ne peuvent être reproduits de manière cohérente suggèrent que l'analyse initiale a pu être erronée ou manipulée.

Drapeaux verts et comment éviter le « P-hacking »

En inversant les signaux d'alerte ci-dessus, nous pouvons également trouver des moyens de prévenir le p-hacking. Ces méthodes ont déjà fait leur apparition dans les débats de la communauté scientifique au cours de la dernière décennie, en réponse à la crise de la reproductibilité.

Connaissances statistiques

Une solide compréhension des principes statistiques est essentielle pour éviter le p-hacking. Lorsque les analystes disposent des connaissances nécessaires, ils sont mieux armés pour éviter les pièges courants, tels que la mauvaise interprétation des valeurs p ou le traitement inadéquat des comparaisons multiples.

Par exemple, dans le cadre d'un test A/B pour une fonctionnalité de site Web, un analyste bien informé comprendra que la valeur p n'est pas l'objectif final, car même si le test s'avère avoir une valeur p faible, il peut tout de même avoir un effet qui n'est pas suffisamment important et donc sans signification pratique. Comprendre la différence entre la signification statistique et la signification pratique peut aider les analystes à ne pas se concentrer excessivement sur la valeur p, ce qui pourrait conduire à des pratiques de « p-hacking » et donc réduire le risque de manipuler les résultats pour obtenir un résultat plus favorable.

Préinscription

La pré-enregistrement dans le domaine de la recherche scientifique consiste à définir les grandes lignes du projet de recherche ou d'expérimentation, y compris les hypothèses, les méthodes et les techniques d'analyse, avant de collecter des données. Ce processus empêche le « p-hacking » en verrouillant les décisions relatives à la manière dont l'analyse sera menée, ce qui rend plus difficile la modification a posteriori de l'analyse afin d'obtenir un résultat significatif.

Dans le monde des affaires, des pratiques similaires peuvent être mises en place, même au niveau des équipes chargées des données. Par exemple, avant de mener une expérience visant à mesurer l'impact d'un nouveau modèle tarifaire, l'équipe peut pré-documenter et déclarer en interne l'hypothèse, en précisant les variables qui seront testées (par exemple, le chiffre d'affaires, le taux d'acquisition de clients), le niveau de signification et la taille de l'échantillon. Cela garantit que l'équipe respecte le plan initial et ne modifie pas l'analyse après avoir pris connaissance des premiers résultats, évitant ainsi les pratiques consistant à remplacer a posteriori les données ou à ne retenir que celles qui présentent un résultat favorable.

Pratiques scientifiques ouvertes

La science ouverte consiste à mettre à la disposition de tous les données, méthodes et analyses afin qu'ils puissent les examiner et les reproduire. Dans le monde des affaires, bien que le terme « science ouverte » ne soit pas utilisé directement, des pratiques similaires en matière de transparence sont importantes pour garantir l'intégrité des analyses.

Par exemple, une entreprise qui réalise une analyse de marché peut partager ses données brutes et ses étapes d'analyse en interne avec d'autres équipes, des auditeurs ou des parties prenantes concernées, ou les documenter de manière systématique en vue d'une reproduction future. Cette transparence décourage le p-hacking, car tout le monde peut vérifier s'il existe des incohérences ou des failles dans la méthodologie. Dans une organisation, la transparence des méthodes et des résultats favorise la responsabilisation et contribue à garantir que les conclusions sont tirées à partir de données fiables et reproductibles.

Justifier les choix effectués lors de la préparation et de la transformation des données

Les étapes de préparation et de transformation des données doivent toujours être justifiées de manière claire. Sans justification claire, la suppression des valeurs aberrantes ou la transformation des variables peuvent être utilisées pour manipuler les résultats et créer un récit erroné.

Par exemple, lors de l'analyse des données d'achat des clients, un analyste peut exclure certains points de données (par exemple, les valeurs aberrantes extrêmes) qui ne semblent pas correspondre au modèle. Cependant, sans raison valable (par exemple, les identifier comme de véritables anomalies plutôt que comme faisant partie de la distribution normale), cela pourrait constituer une forme de « p-hacking ». Pour éviter cela, chaque étape de préparation des données (comme l'exclusion de certaines périodes ou l'application de transformations logarithmiques) doit être explicitement justifiée dans le rapport d'analyse, afin de garantir la transparence.

Déclaration et prise en compte de la taille de l'effet

Au-delà de la signification statistique, il est essentiel de rapporter et d'interpréter l'ampleur des effets. Cela garantit que les résultats sont significatifs sur le plan pratique et ne tirent pas uniquement parti de la signification statistique due à la taille importante des échantillons.

Dans le domaine des affaires, envisagez un test A/B dans lequel une nouvelle description de produit augmente les taux de conversion de 0,5 %, mais où la taille de l'échantillon est suffisamment importante pour que le résultat soit statistiquement significatif. Sans contexte, ce changement pourrait être interprété à tort comme significatif. Cependant, en se concentrant sur l'ampleur de l'effet et en se demandant si une augmentation de 0,5 % justifie le coût lié à la modification de toutes les descriptions de produits, les entreprises peuvent éviter de prendre des décisions basées uniquement sur les valeurs p.

Autorisation d'effectuer plusieurs essais, mais avec l'utilisation de méthodes de correction

Nous avons indiqué que l'exécution du même test (ou de tests différents) sur les mêmes données peut aboutir à un résultat significatif par hasard, et nous avons donc considéré cela comme un p-hack. Cependant, effectuer le même test plusieurs fois sur les mêmes données peut constituer une bonne mesure pour prévenir et éviter le p-hacking, à condition que cela soit associé à des méthodes de correction, qui sont des techniques statistiques permettant de tenir compte du fait que plusieurs comparaisons sont effectuées. Les deux types de méthodes de correction les plus courants sont la méthode de correction de Bonferroni et la procédure de Benjamini-Hochberg (BH).

La méthode Bonferroni consiste à ajuster le seuil de la valeur p (le niveau de signification) à la baisse, en le divisant par le nombre de tests effectués. Bien qu'il soit efficace pour réduire les risques de faux positifs, il peut être trop conservateur, ce qui augmente le risque de faux négatifs.

En revanche, la procédure BH est l'une des techniques de contrôle du taux de fausses découvertes (FDR) qui vise à trouver un équilibre entre la probabilité des deux types d'erreurs. En résumé, la procédure BH consiste à classer toutes les valeurs p issues de plusieurs tests par ordre croissant, de la plus petite à la plus grande. Chaque valeur p est ensuite comparée à un seuil qui augmente avec son rang. La plus grande valeur p qui reste inférieure à son seuil est identifiée, et toutes les valeurs p jusqu'à ce point sont considérées comme significatives.

Dans un contexte commercial, si une entreprise teste plusieurs versions d'une page d'accueil, il est tentant de réaliser de nombreux tests A/B et de s'arrêter lorsqu'une version semble nettement plus performante. Pour éviter cela, l'analyste peut appliquer des corrections afin de tenir compte des multiples tests effectués. Ce faisant, ils s'assurent que toute découverte importante n'est pas simplement le résultat de tests répétés.

Considérer les résultats non significatifs

Enfin, il est important de reconnaître et de signaler les résultats non significatifs plutôt que de les ignorer. La communauté scientifique a demandé que les expériences dont les résultats sont insignifiants puissent être publiées, à condition qu'elles suivent une méthodologie rigoureuse préenregistrée, car l'absence de résultats peut également constituer un résultat. Une sagesse similaire peut être appliquée dans le monde des affaires.

Par exemple, si une campagne marketing n'a pas d'impact significatif sur les ventes, une entreprise doit tout de même signaler et prendre en compte ce résultat. Il fournit des informations précieuses et évite les rapports biaisés qui pourraient conduire à des décisions commerciales injustifiées. Le fait d'être transparent sur les résultats non significatifs contribue à une analyse plus honnête et évite la tentation de manipuler les données dans le but de démontrer le succès.

Conclusion

Dans cet article, nous avons exploré en profondeur le domaine du p-hacking, où la valeur p peut être susceptible de manipulation. Nous avons examiné les différentes techniques de manipulation des données, comment elles peuvent être détectées et comment elles peuvent être évitées.

Comme vous pouvez le constater, et comme nous l'avons mentionné, une grande partie de la prise de conscience du p-hacking réside dans la possession de solides connaissances statistiques. Vous pouvez y parvenir grâce à nos différents cours sur les statistiques, tels que notre cours théorique « Introduction aux statistiques » ou nos cours pratiques « Introduction aux statistiques dans Google Sheets », « Introduction aux statistiques dans Python » et « Introduction aux statistiques dans R ».

Islam est consultant en données à l'Institut KPI. Issu d'une formation en journalisme, Islam s'intéresse à divers domaines, dont l'écriture, la philosophie, les médias, la technologie et la culture.