Curso

Si alguna vez has trabajado con estadística inferencial, especialmente con pruebas de hipótesis y regresión, probablemente hayas oído hablar del valor p. Y si alguna vez has trabajado con valores p, probablemente sabes, o al menos intuyes, que los valores p son vulnerables y pueden manipularse, y estarías en lo cierto.

De hecho, esta manipulación tiene un término que lleva su nombre. Eso es p-hacking. A veces, también se conoce como « » (extracción de datos), «data snooping» (espionaje de datos), «data fishing» (pesca de datos) y «inflation bias» (sesgo de inflación). Y esto es lo que se analiza en este artículo.

¿Qué es un valor P?

En primer lugar, refresquemos rápidamente la memoria sobre qué es un valor p. La «p» en «valor p» significa probabilidad. En concreto, el valor p es la probabilidad de observar resultados tan extremos como los obtenidos, suponiendo que la hipótesis nula es cierta. Este rechazo incorrecto también se conoce como error de tipo I o error falso positivo. Normalmente, se obtiene para compararlo con el nivel de significación (denominadoα ), que es la probabilidad tolerada de rechazar la hipótesis nula cuando es verdadera.

Lógicamente, se deduce que si el valor p es mayor que el nivel de significación, no rechazamos la hipótesis nula y nos atenemos a ella. Por otro lado, si el valor p es menor o igual que el nivel de significación, podemos rechazar la hipótesis nula en favor de la alternativa y, en este caso, decimos que los resultados son estadísticamente significativos.

Si alguna parte de este breve repaso sobre los valores p no te queda clara, ¡no te preocupes! Puedes realizar nuestro curso teórico Introducción a la estadística y adquirir rápidamente los fundamentos necesarios .

Introducción al P-Hacking

Alcanzar resultados «estadísticamente significativos» suena muy parecido al éxito y, por lo tanto, resulta tentador. En los negocios, significaría que tienes algo nuevo, interesante o deseable que comunicar. En el mundo académico, has descubierto algo y eso se puede publicar en revistas especializadas.

Y dado que es la clave de todo este apasionante mundo, los profesionales de los datos y los investigadores se ven tentados a centrarse excesivamente en los valores p de sus estudios y a no tener en cuenta nada más, ni siquiera el nivel de significación. Y dado que el nivel de significación más comúnmente considerado durante décadas ha sido 0,05, se ha convertido en una convención fácil decir que si alcanzas un valor p inferior a 0,05, debes quitarte el abrigo y celebrarlo inmediatamente.

Como resultado adicional, algunos investigadores caen en el error del p-hacking, a veces de forma intencionada, pero normalmente sin querer, al aplicar métodos que pueden reducir el valor p para que sea estadísticamente significativo, en casos en los que unas pruebas adecuadas habrían demostrado lo contrario.

Cómo funciona el P-Hacking

Ya sea de forma intencionada o no, hay muchas formas en las que las cosas pueden salir mal y dar lugar al p-hacking. Los métodos que conducen al p-hacking pueden denominarse p-hacks, y pueden producirse en cualquier fase de los experimentos.

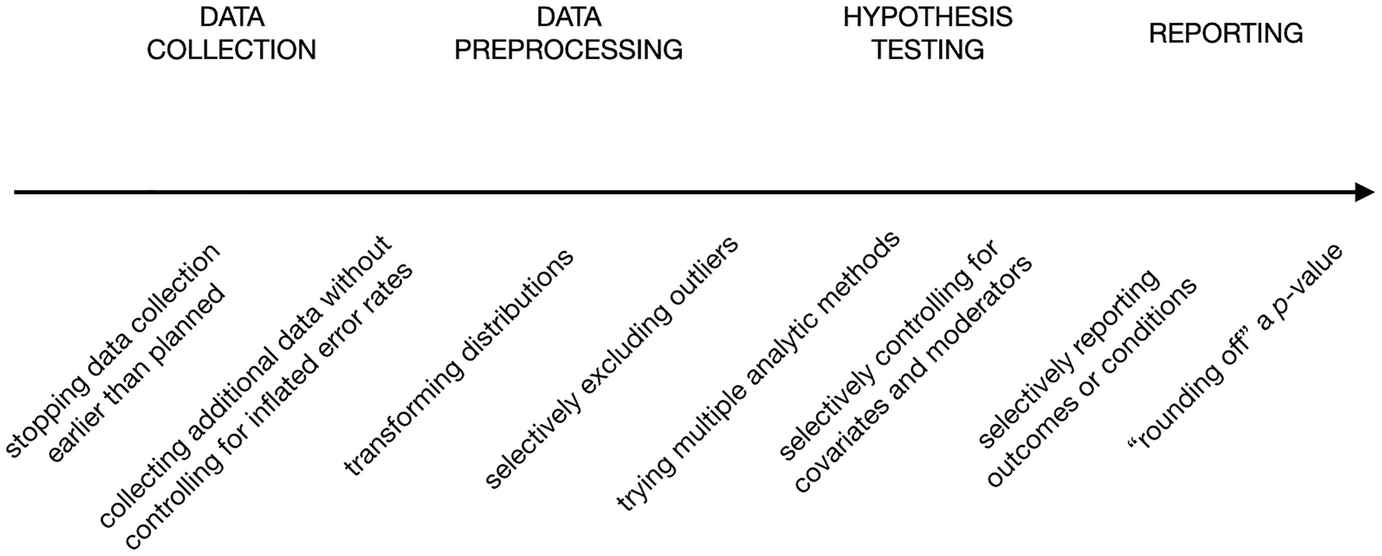

En su capítulo del libro The Myriad Forms of p-Hacking, Dorota Reis y Malte Friese proporcionan una lista no exhaustiva de p-hacks en las diferentes etapas de los experimentos, desde la recopilación de datos hasta la presentación de informes, representados en el siguiente gráfico.

Ejemplos de p-hacks. Fuente: Cómo evitar prácticas de investigación cuestionables en psicología aplicada.

Veamos qué significa cada uno de ellos, de izquierda a derecha:

- Parada opcional: Esto significa detener la recopilación de datos cuando los individuos recopilados dan como resultado un valor p significativo, no cuando se alcanza el tamaño de muestra requerido.

- Recopilación de datos adicionales: Esto es como una extensión de la práctica anterior. Recopilar más datos a veces puede reducir el valor p cuando no existe un efecto subyacente real.

- Transformando las distribuciones: La transformación puede ser una parte necesaria en cualquier proceso de preparación de datos, pero cuando se prueban múltiples transformaciones y finalmente se elige la que conduce a un valor p significativo, se trata de un p-hack.

- Excluir selectivamente los valores atípicos: Al igual que la transformación de la distribución, tratar los valores atípicos es un paso esencial en la preparación de datos, y existen varios métodos para detectarlos y excluirlos. Cuando se selecciona cuidadosamente el método que lleva a los datos a generar significación estadística, se trata de un p-hack.

- Probar varios métodos analíticos: Esto implica realizar diferentes tipos de pruebas hipotéticas y seleccionar la que dé un resultado significativo.

- Modelado múltiple: Probar diferentes modelos de variables y elegir el que conduce a la significación estadística, ignorando el razonamiento teórico básico que subyace a la elección, también es un p-hack.

- Sustitución posterior: Esto significa sustituir o ignorar un conjunto de puntos de datos o condiciones que dan lugar a un valor p mayor, ya sea a lo largo de varias rondas de pruebas de hipótesis o al comunicar los resultados.

- Redondeo de un valor p: Y este es el p-hack más expuesto, ya que depende del redondeo del valor p cuando está ligeramente por encima del nivel de significación y, por lo tanto, ni siquiera alcanza realmente un valor p manipulado estadísticamente significativo, pero pretende hacerlo.

Ten en cuenta que la mayoría de estos p-hacks dependen de repetir el experimento una y otra vez, ajustando cada vez lo que debería ser una base predeterminada para el experimento.

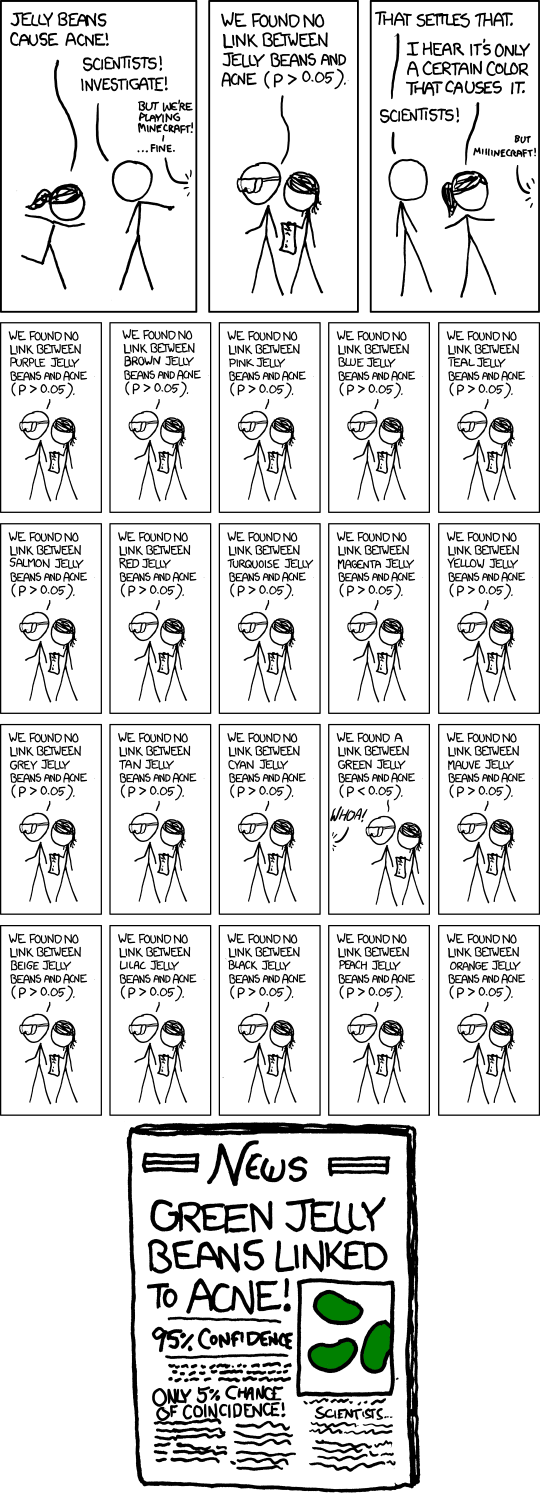

Pero incluso sin los ajustes, repetir el mismo experimento y publicar los resultados solo cuando son estadísticamente significativos puede ser un p-hack, porque siempre existe la posibilidad de que, si un experimento se repite suficientes veces, en algún momento se obtenga un valor p bajo. El cómic que aparece a continuación, titulado «» (El problema de la televisión), de xkcd, ilustra esta idea.

Cómic «significativo». Fuente: xkcd.

Ejemplos reales de P-Hacking

El p-hacking es un fenómeno muy extendido. A principios de la década de 2010, numerosos estudios de revisión comenzaron a descubrir que un gran porcentaje de las investigaciones publicadas en revistas respetadas de diversos campos probablemente eran víctimas del p-hacking, especialmente en los campos de la psicología y la medicina, pero también en las ciencias sociales y las humanidades.

Por ejemplo, en 2015, un estudio dirigido por un investigador de la Universidad de Virginia que revisó 100 estudios de psicología publicados en las principales revistas en 2008, descubrió que menos de la mitad de estos estudios eran replicables. La falta de reproducibilidad significa que los estudios, cuando se repiten, no dan el mismo resultado, a veces debido al p-hacking.

Otro proyecto que examinó estudios sobre el cáncer descubrió que solo 50 de 193 experimentos son replicables. Incluso antes, en 2009, un estudio señaló un número sospechoso de experimentos en el campo de la neurociencia que informaban de correlaciones inusualmente altas entre las emociones, la personalidad, la cognición social y la actividad del cerebro a través de la resonancia magnética funcional (fMRI). Tras encuestar a los autores de estos experimentos, se descubrió que se basaban en una estrategia consistente en seleccionar subconjuntos de datos y comunicar aquellos que daban lugar a un resultado significativo, un p-hack similar a lo que denominamos sustitución post hoc.

Los resultados de estos estudios de revisión revelaron cómo el p-hacking, además de otras prácticas de investigación cuestionables, está provocando que los fundamentos de la investigación científica, respetada durante mucho tiempo, se tambaleen y estén llenos de lagunas. Una crisis que se ha denominado «crisis de replicabilidad» y queaún continúa, en medio de numerosos debates y esfuerzos por encontrar una salida.

Por qué el P-hacking es poco ético

Entonces, ¿por qué es un problema el p-hacking?

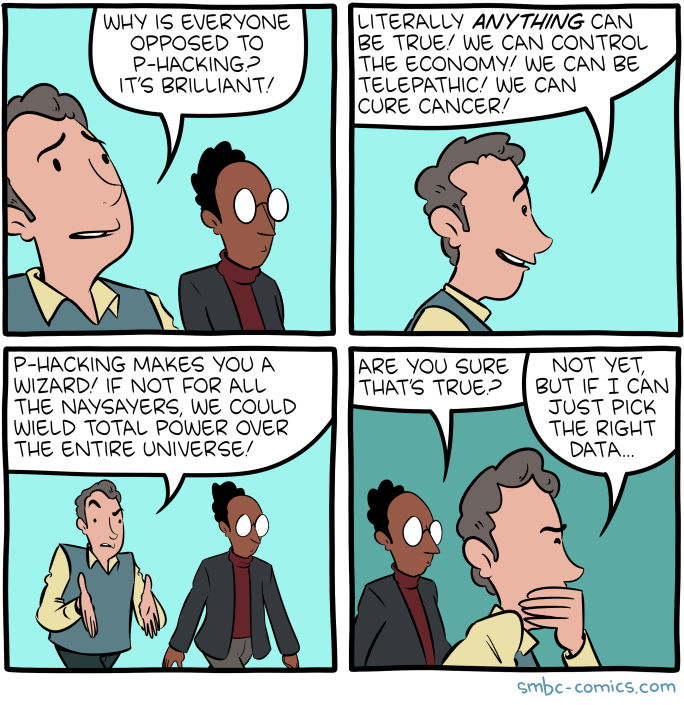

«El p-hackingte convierte en un mago». Fuente: SMBC Comics.

La pregunta puede parecer demasiado obvia, pero un análisis detallado de las razones por las que el p-hacking es incorrecto y poco ético también puede ayudarnos a comprender mejor la «importancia» del problema de la falsedad de la significación.

Simplemente, es manipulador.

En esencia, el p-hacking no es más que el resultado de manipular la metodología o los resultados. Si se hiciera intencionadamente, sería simplemente como mentir sin otra razón que el beneficio propio (como conseguir que se publique o se reconozca). Si se hace sin intención, sería como tomar el camino equivocado y acabar llegando a nada más que al espejismo de los falsos positivos.

Puede llevar a decisiones equivocadas y consecuencias desastrosas.

Los experimentos, ya sean en el ámbito científico o en el empresarial, tienen consecuencias. Se realizan para tomar decisiones o para seguir desarrollando los resultados obtenidos. Si los resultados del experimento son falsos, las decisiones que dependen de ellos carecerán de fundamento, lo que en ocasiones puede tener consecuencias desastrosas.

Por ejemplo, la investigación en ámbitos delicados como la oncología y la neurología puede contribuir colectivamente al desarrollo de tratamientos y medicamentos. Sería un desastre que se manipulase parte de la investigación fundacional.

En los negocios, las decisiones equivocadas pueden tener muchas consecuencias, desde lanzar un producto fallido hasta agotar los recursos, despedir a alguien o llevar a la empresa a la quiebra. Un simple truco p puede crear un efecto mariposa.

Erosiona la confianza en el método científico.

La crisis de la replicabilidad ha provocado un escepticismo generalizado he la ciencia en su conjunto, que se expresa incluso en el discurso político. Si bien el pensamiento crítico siempre puede ser útil, incluso cuando se reciben hallazgos científicos, descartar todos los hallazgos empíricos puede llevar a la desesperación por la ignorancia y a decisiones infundadas.

En los negocios, a menor escala, el p-hacking y otras prácticas cuestionables similares pueden llevar a los líderes empresariales a dejar de tomar decisiones basadas en datos y volver a depender únicamente de la intuición, que es exactamente lo contrario de lo que promete y puede cumplir el campo de la ciencia de datos en su conjunto.

Sacude la naturaleza acumulativa del conocimiento.

El conocimiento humano se basa en su naturaleza acumulativa. Cada pequeño experimento es un ladrillo que construye una estructura de conocimiento más grande. Cuando un número cada vez mayor de estos pilares se tambalea debido a prácticas cuestionables como el p-hacking, el potencial de dicha acumulación se ve abocado al fracaso. Incluso la simple tarea de buscar bibliografía previa para desarrollar un nuevo experimento se convierte en una misión complicada, como encontrar el camino en un campo minado.

Señales de alerta y cómo detectar el p-hacking

Basándonos en lo que sabemos ahora sobre el p-hacking y sus métodos, podemos deducir algunas señales de alerta que pueden ayudarnos a detectar los p-hacks. La mayoría de estas señales de alerta aún requieren una mente curiosa, un pensamiento crítico y una mirada introspectiva para poder detectarlas. Algunos incluso dependen de un amplio conocimiento del dominio.

Resultados excesivamente sensacionalistas

Los resultados sensacionales de los experimentos suelen ser demasiado sospechosos como para tomarlos al pie de la letra. Los estudios que afirman cosas como «el chocolate puede ayudar a perder peso», que suelen ser recogidos por la prensa y las redes sociales, simplemente no parecen lo suficientemente sólidos como para darles crédito.

En los negocios, una prueba que promete un aumento del 100 % en los beneficios gracias a la introducción de una pequeña función en un sitio web puede considerarse igualmente sensacional.

Cuando te encuentres con un estudio de este tipo, si te preocupa, comprueba siempre la metodología y los resultados antes de aceptar las conclusiones.

Falta de transparencia en la metodología

Ten cuidado con los experimentos cuya metodología no está clara o que no declaran algunos componentes de la metodología. Para garantizar un procedimiento científico sólido, es fundamental ser transparente en cuanto a las hipótesis iniciales, el nivel de significación, el tamaño de la muestra, las variables recopiladas, el tipo de prueba elegido y los pasos de preparación de los datos. No tener claro alguno de estos componentes es una señal de alerta.

Transformación innecesaria de datos

Si la preparación de los datos del experimento incluye la transformación de variables, comprueba dos veces el motivo de la medida, ya que debe declararse la justificación. Si no es así, o si no resulta convincente, esto puede ser un indicador directo de p-hacking.

Tamaño injustificado de la muestra pequeña

Un tamaño muestral reducido reduce la potencia estadística del estudio, lo que aumenta el riesgo de falsos negativos. Sin embargo, cuando se combinan con informes selectivos o p-hacking, los estudios de baja potencia también pueden contribuir a una mayor tasa de resultados falsos positivos en la literatura publicada.

En algunos ámbitos, los tamaños de muestra pequeños son aceptables y habituales, como en la investigación clínica, los estudios medioambientales, la ingeniería y el control de calidad. Pero, en términos generales, cuanto mayor es el tamaño de la muestra, mejor es la inferencia y, por lo tanto, menor es la probabilidad de obtener falsos positivos y valores p significativos falsos.

En cualquier caso, si no se justifica un tamaño muestral reducido, esto puede indicar una falta de potencia estadística, lo que aumenta el riesgo de obtener resultados falsos positivos. En algunos casos, creo que también puede insinuar una interrupción prematura, la práctica específica de p-hacking que mencioné anteriormente, en la que la recopilación de datos finaliza una vez que se alcanza la significación, en lugar de cuando se alcanza el tamaño de la muestra previsto.

Tamaño del efecto poco claro

El tamaño del efecto mide la fuerza o magnitud de la relación entre variables, lo que proporciona contexto a la significación estadística de un resultado. Si un estudio informa de significación estadística pero no proporciona un tamaño del efecto claro o significativo, esto levanta sospechas.

Un valor p puede indicar que el resultado es poco probable debido al azar, pero sin un tamaño del efecto, es difícil determinar la importancia práctica de los hallazgos. En los estudios p-hackeados, la falta de claridad sobre el tamaño del efecto puede indicar que los investigadores se centraron excesivamente en alcanzar la significación estadística, independientemente de otras consideraciones.

Incoherencia entre la hipótesis planteada y el resultado.

Cuando los resultados de un estudio se desvían significativamente de la hipótesis original, deben plantearse preguntas. Esto podría ser una señal de que los investigadores modificaron su hipótesis o sus métodos después de recopilar los datos para que coincidieran con los resultados, una práctica conocida como HARKing (formular hipótesisdespués de conocer los resultados).

Por ejemplo, si un experimento afirma haber probado una hipótesis específica, pero el análisis final parece centrarse en variables o resultados no relacionados, esto puede sugerir p-hacking. Compara siempre la hipótesis planteada con los resultados finales para asegurarte de que coinciden.

Efecto inusualmente elevado

Un tamaño del efecto inusualmente alto puede ser una señal de alerta de p-hacking. En muchos casos, los efectos en el mundo real son pequeños o moderados, especialmente en campos como la psicología, la medicina o las ciencias sociales. Al igual que juzgar el tamaño adecuado de una muestra, comprender cómo un tamaño del efecto es plausible requiere una gran experiencia en el campo.

Si un estudio informa de un tamaño del efecto inusualmente grande, podría indicar que los datos han sido manipulados selectivamente o que la muestra está sesgada de alguna manera. Los investigadores pueden excluir, de forma intencionada o no, datos que reducirían el tamaño del efecto para que sus hallazgos parezcan más impresionantes de lo que realmente son (el p-hack de sustitución post hoc).

Un valor p que está justo por debajo del nivel de significación.

Cuando el valor p reportado está justo por debajo del umbral de significación (por ejemplo, p = 0,049 en un estudio en el que p < 0,05 es el umbral de significación), puede indicar que los investigadores han recurrido al p-hacking.

Esto se debe a que realizar pruebas repetidamente o ajustar variables puede llevar a un resultado que apenas supere el umbral de significación por casualidad. Un patrón de resultados que se mantiene constantemente justo por debajo del nivel de significación sugiere que los investigadores pueden haber detenido la recopilación de datos una vez que alcanzaron el resultado deseado (interrupción prematura) o haber informado de forma selectiva sobre determinados análisis (sustitución post hoc).

Irreplicabilidad

Uno de los indicadores más claros del p-hacking es cuando los resultados de un estudio no son replicables. Si investigadores independientes no pueden replicar los resultados de un estudio utilizando la misma metodología, esto puede indicar que los hallazgos originales fueron el resultado de p-hacking o de informes selectivos.

La replicabilidad es una piedra angular de la integridad científica, y los resultados que no pueden reproducirse de manera consistente sugieren que el análisis original puede haber sido defectuoso o manipulado.

Banderas verdes y cómo prevenir el P-hacking

Al invertir las señales de alerta anteriores, también podemos encontrar formas de prevenir el p-hacking. Estas formas ya han surgido en el discurso de la comunidad científica durante la última década como respuesta a la crisis de la replicabilidad.

Conocimientos estadísticos

Es fundamental comprender bien los principios estadísticos para evitar el p-hacking. Cuando los analistas cuentan con los conocimientos necesarios, están mejor preparados para evitar errores comunes, como interpretar erróneamente los valores p o manejar incorrectamente las comparaciones múltiples.

Por ejemplo, en las pruebas A/B para una función de un sitio web, un analista bien informado comprenderá que el valor p no es el objetivo final, ya que, aunque la prueba arroje un valor p bajo, el tamaño del efecto puede no ser lo suficientemente grande y, por lo tanto, carecer de importancia práctica. Comprender la diferencia entre significación estadística y significación práctica puede ayudar a los analistas a no centrarse excesivamente en el valor p, lo que podría dar lugar a prácticas de p-hacking y, por lo tanto, reducir la probabilidad de manipular los resultados para obtener un resultado más favorable.

Preinscripción

La preinscripción en la investigación científica consiste en esbozar el plan de investigación o ensayo, incluyendo hipótesis, métodos y técnicas de análisis, antes de recopilar ningún dato. Este proceso evita el p-hacking al fijar las decisiones sobre cómo se llevará a cabo el análisis, lo que dificulta la alteración del análisis a posteriori para obtener un resultado significativo.

En los negocios, se pueden llevar a cabo prácticas similares incluso a nivel de los equipos de datos. Por ejemplo, antes de realizar un experimento para medir el impacto de un nuevo modelo de precios, el equipo puede documentar previamente y declarar internamente la hipótesis, especificando las variables que se van a probar (por ejemplo, ingresos, tasa de adquisición de clientes), el nivel de significación y el tamaño de la muestra. Esto garantiza que el equipo se ciña al plan original y no modifique el análisis tras ver los resultados iniciales, evitando prácticas como la sustitución a posteriori y la selección selectiva de los datos que muestran un resultado favorable.

Prácticas de ciencia abierta

La ciencia abierta se refiere a poner a disposición de otros los datos, los métodos y los análisis para que puedan revisarlos y reproducirlos. En el ámbito empresarial, aunque el término «ciencia abierta» no se utilice directamente, es importante aplicar prácticas de transparencia similares para garantizar la integridad de los análisis.

Por ejemplo, una empresa que realiza un análisis de mercado puede compartir sus datos brutos y los pasos del análisis internamente con otros equipos, auditores o partes interesadas, o documentarlos sistemáticamente para futuras réplicas. Esta transparencia desalienta el p-hacking, ya que cualquiera puede comprobar si hay discrepancias o fallos en la metodología. En una organización, ser transparente sobre los métodos y los resultados fomenta la responsabilidad y ayuda a garantizar que las conclusiones se extraigan a partir de datos sólidos y reproducibles.

Justificar las decisiones en la preparación y transformación de datos

Los pasos de preparación y transformación de los datos siempre deben estar bien justificados. Sin una justificación clara, eliminar valores atípicos o transformar variables puede utilizarse para manipular los resultados y crear una narrativa falsa.

Por ejemplo, al analizar los datos de compra de los clientes, un analista podría excluir ciertos puntos de datos (por ejemplo, valores atípicos extremos) que no parecen encajar en el modelo. Sin embargo, sin una razón válida —como identificarlos como verdaderas anomalías en lugar de parte de la distribución normal— esto podría ser una forma de p-hacking. Para evitarlo, cada paso de la preparación de los datos (como excluir determinados periodos de tiempo o aplicar transformaciones logarítmicas) debe justificarse explícitamente en el informe de análisis, garantizando así la transparencia.

Declaración y consideración del tamaño del efecto

Más allá de la significación estadística, es fundamental informar e interpretar el tamaño del efecto. Esto garantiza que los resultados sean significativos en términos prácticos y no se basen únicamente en la importancia estadística derivada del gran tamaño de la muestra.

En el ámbito empresarial, considera una prueba A/B en la que la descripción de un nuevo producto aumenta las tasas de conversión en un 0,5 %, pero el tamaño de la muestra es lo suficientemente grande como para que el resultado sea estadísticamente significativo. Sin contexto, este cambio podría malinterpretarse como significativo. Sin embargo, al centrarse en el tamaño del efecto y preguntarse si un aumento del 0,5 % justifica el coste de cambiar todas las descripciones de los productos, las empresas pueden evitar tomar decisiones basadas únicamente en los valores p.

La posibilidad de realizar múltiples ejecuciones del experimento, pero con el uso de métodos de corrección.

Dijimos que realizar la misma prueba (o pruebas diferentes) con los mismos datos puede dar lugar a resultados significativos por casualidad y, por lo tanto, lo consideramos un p-hack. Pero, en realidad, realizar la misma prueba con los mismos datos varias veces puede ser una buena medida para prevenir y evitar el p-hacking, siempre y cuando se combine con métodos de corrección, que son técnicas estadísticas que ajustan el hecho de que se están realizando múltiples comparaciones. Los dos tipos más comunes de métodos de corrección son el método de corrección de Bonferroni y el procedimiento de Benjamini-Hochberg (BH).

El método Bonferroni consiste en ajustar el umbral del valor p (el nivel de significación) a la baja, dividiéndolo por el número de pruebas realizadas. Aunque es eficaz para reducir las posibilidades de falsos positivos, puede resultar demasiado conservador, lo que aumenta la probabilidad de falsos negativos.

Por el contrario, el procedimiento BH es una de las técnicas de control de la tasa de descubrimientos falsos (FDR) que tiene como objetivo lograr un equilibrio entre la probabilidad de los dos tipos de errores. En pocas palabras, el procedimiento BH funciona clasificando primero todos los valores p de múltiples pruebas en orden de menor a mayor. A continuación, cada valor p se compara con un umbral que aumenta con su rango. Se identifica el valor p más grande que sigue estando por debajo de su umbral, y todos los valores p hasta ese punto se consideran significativos.

En un contexto empresarial, si una empresa está probando varias versiones de una página de destino, es tentador realizar muchas pruebas A/B y detenerse cuando una versión parece funcionar significativamente mejor. Para evitarlo, el analista puede aplicar correcciones que tengan en cuenta las múltiples pruebas que se están ejecutando. De este modo, se aseguran de que cualquier hallazgo significativo no sea solo el resultado de pruebas repetidas.

Considerando resultados insignificantes

Por último, es importante reconocer e informar los resultados no significativos en lugar de descartarlos. En la comunidad científica se ha pedido que se permita publicar experimentos con resultados insignificantes, siempre y cuando sigan una metodología rigurosa previamente registrada, ya que la ausencia de hallazgos también puede ser un hallazgo. Se puede aplicar una sabiduría similar en los negocios.

Por ejemplo, si una campaña de marketing no tiene un impacto significativo en las ventas, la empresa debe informar y tener en cuenta este resultado. Proporciona información valiosa y evita informes sesgados que podrían dar lugar a decisiones empresariales injustificadas. Ser sincero sobre los resultados no significativos contribuye a un análisis más honesto y evita la tentación de manipular los datos con el fin de mostrar el éxito.

Conclusión

En este artículo, hemos explorado en profundidad el mundo del p-hacking, donde el valor p puede ser vulnerable a la manipulación. Hemos analizado los distintos p-hacks, cómo se pueden detectar y cómo se pueden prevenir.

Como puedes ver, y como hemos mencionado, una parte importante de ser consciente del p-hacking es tener un sólido conocimiento estadístico. Puedes lograrlo a través de nuestros diversos cursos sobre estadística, como nuestro curso teórico-al Introducción a la Estadística, o nuestros cursos prácticos Introducción a la Estadística en Google Sheets, Introducción a la Estadística en Python e Introducción a la Estadística en R.

Islam es analista de datos, facilitador en el Instituto KPI y profesor en la Universidad de El Cairo. Con formación periodística, Islam tiene intereses diversos, como la escritura, la filosofía, los medios de comunicación, la tecnología y la cultura.