Kurs

Wenn du schon mal mit inferentieller Statistik gearbeitet hast, vor allem mit Hypothesentests und Regression, hast du bestimmt schon mal was vom p-Wert gehört. Und wenn du schon mal mit p-Werten gearbeitet hast, weißt du wahrscheinlich oder hast zumindest eine Vermutung, dass p-Werte anfällig sind und manipuliert werden können, und damit hast du auch recht.

Tatsächlich gibt es für diese Manipulation sogar einen eigenen Begriff. Das ist P-Hacking. Manchmal wird das auch als „ “ bezeichnet, also Datenauswertung, Datenschnüffeln, Datenfischen und Inflationsverzerrung. Und genau damit beschäftigt sich dieser Artikel.

Was ist ein P-Wert?

Lass uns erst mal kurz wiederholen, was ein p-Wert ist. Das „p“ in p-Wert steht für Wahrscheinlichkeit. Genauer gesagt ist der p-Wert die Wahrscheinlichkeit, dass man so extreme Ergebnisse wie die erzielten beobachtet, wenn man davon ausgeht, dass die Nullhypothese stimmt. Diese falsche Ablehnung wird auch als Typ-I-Fehler oder falsch positiver Fehler bezeichnet. Normalerweise wird es zum Vergleich mit dem Signifikanzniveau ( α) herangezogen, das die tolerierte Wahrscheinlichkeit angibt, dass die Nullhypothese zurückgewiesen wird, wenn sie wahr ist.

Logischerweise heißt das: Wenn der p-Wert größer als das Signifikanzniveau ist, können wir die Nullhypothese nicht ablehnen und bleiben dabei. Wenn der p-Wert kleiner oder gleich dem Signifikanzniveau ist, können wir die Nullhypothese zugunsten der Alternativhypothese ablehnen. In diesem Fall sagen wir, dass die Ergebnisse statistisch signifikant sind.

Wenn dir irgendwas in dieser kurzen Auffrischung zu p-Werten nicht klar ist, mach dir keine Sorgen! Mit unserem theoretischen Kurs „Einführung in die Statistik “ kannst du dir schnell die notwendigen Grundlagen aneignen .

Einführung in P-Hacking

„Statistisch signifikante“ Ergebnisse zu erzielen, klingt echt nach Erfolg und ist daher verlockend. Im Geschäftsleben würde das bedeuten, dass du was Neues, Interessantes oder Wünschenswertes zu berichten hast. In der Wissenschaft findest du etwas heraus, und das kannst du dann in Fachzeitschriften veröffentlichen.

Und weil sie der Schlüssel zu dieser spannenden Welt sind, neigen Datenprofis und Forscher dazu, sich zu sehr auf die p-Werte ihrer Studien zu konzentrieren und alles andere, sogar das Signifikanzniveau, zu ignorieren. Und weil das über Jahrzehnte am häufigsten verwendete Signifikanzniveau 0,05 war, war es einfach zu sagen, dass man, wenn man einen p-Wert unter 0,05 erreicht hat, sofort den Mantel ausziehen und feiern sollte.

Ein weiteres Problem ist, dass manche Forscher in die Falle des „p-Hackings“ tappen, manchmal absichtlich, meistens aber aus Versehen, indem sie Methoden anwenden, die den p-Wert senken, damit er statistisch signifikant ist, obwohl richtige Tests was anderes gezeigt hätten.

Wie P-Hacking funktioniert

Ob absichtlich oder nicht, es gibt viele Möglichkeiten, wie etwas schiefgehen und zu P-Hacking führen kann. Die Methoden, die zu P-Hacking führen, kann man als P-Hacks bezeichnen, und sie können in jeder Phase der Experimente auftreten.

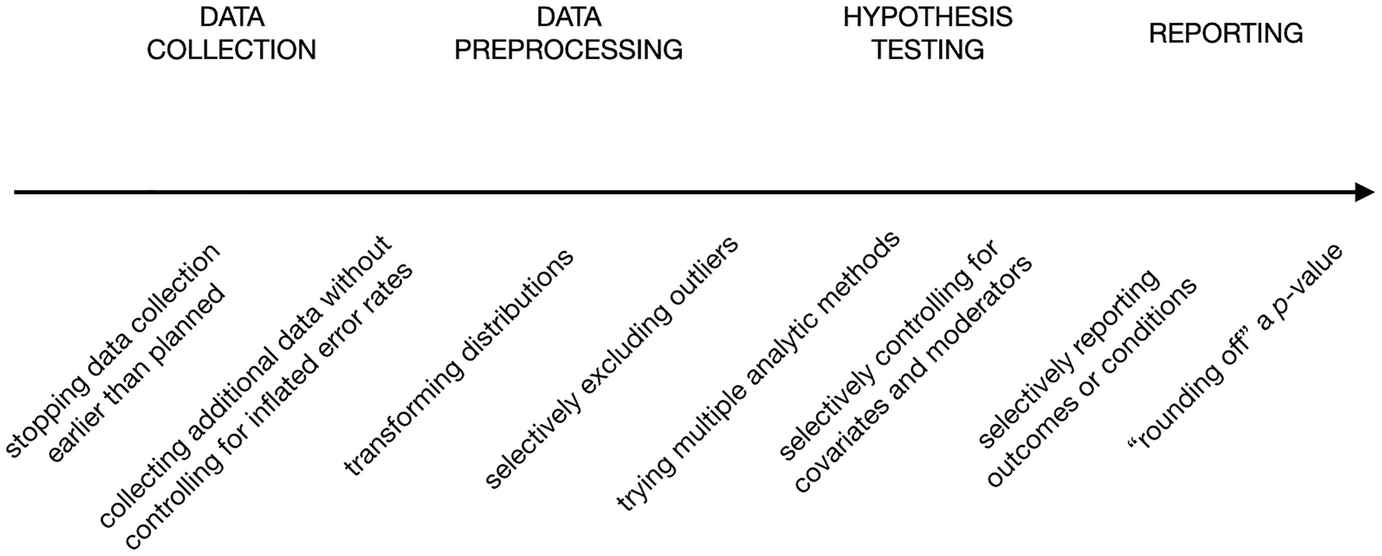

In ihrem Buchkapitel „The Myriad Forms of p-Hacking” zeigen Dorota Reis und Malte Friese eine Liste von p-Hacks in den verschiedenen Phasen von Experimenten, von der Datenerhebung bis zur Berichterstattung, die in der folgenden Grafik dargestellt ist.

Beispiele für p-Hacks. Quelle: Fragwürdige Forschungspraktiken in der angewandten Psychologie vermeiden.

Schauen wir mal, was die einzelnen Symbole von links nach rechts bedeuten:

- Optionaler Stopp: Das heißt, die Datenerfassung wird beendet, wenn die gesammelten Daten einen signifikanten p-Wert ergeben, nicht erst, wenn die erforderliche Stichprobengröße erreicht ist.

- Weitere Infos sammeln: Das ist so wie eine Fortsetzung von dem, was wir schon gemacht haben. Wenn man mehr Daten sammelt, kann das manchmal den p-Wert senken, auch wenn es keinen echten Effekt gibt.

- Verteilung umgestalten: Transformationen können ein wichtiger Teil der Datenaufbereitung sein, aber wenn mehrere Transformationen ausprobiert werden und dann diejenige mit dem besten p-Wert genommen wird, ist das ein p-Hack.

- Ausreißer gezielt rausnehmen: Genau wie die Verteilungstransformation ist auch der Umgang mit Ausreißern ein wichtiger Schritt bei der Datenaufbereitung. Es gibt verschiedene Methoden, um Ausreißer zu erkennen und rauszuschmeißen. Wenn die Methode, die die Daten zu statistischer Signifikanz führt, gezielt ausgewählt wird, handelt es sich um einen P-Hack.

- Verschiedene Analysemethoden ausprobieren: Das heißt, man macht verschiedene Hypothesentests und sucht sich den aus, der zu einem klaren Ergebnis führt.

- Mehrere Modelle: Verschiedene Variablenmodelle auszuprobieren und dann dasjenige zu nehmen, das statistisch signifikant ist, ohne auf die theoretischen Gründe dafür einzugehen, ist auch ein P-Hack.

- Ersatz nachträglich: Das heißt, dass man eine Reihe von Datenpunkten oder Bedingungen, die zu einem höheren p-Wert führen, entweder während der Hypothesentests oder bei der Berichterstattung über die Ergebnisse ersetzt oder einfach ignoriert.

- Abrunden eines p-Wert-: Und das ist der offensichtlichste p-Hack, weil er davon abhängt, dass der p-Wert ein bisschen über dem Signifikanzniveau gerundet wird. So kommt man nicht mal wirklich zu einem manipulierten statistisch signifikanten p-Wert, tut aber so, als ob.

Beachte, dass die meisten dieser p-Hacks davon abhängen, dass das Experiment immer wieder durchgeführt wird, wobei jedes Mal die eigentlich festgelegte Basis für das Experiment angepasst wird.

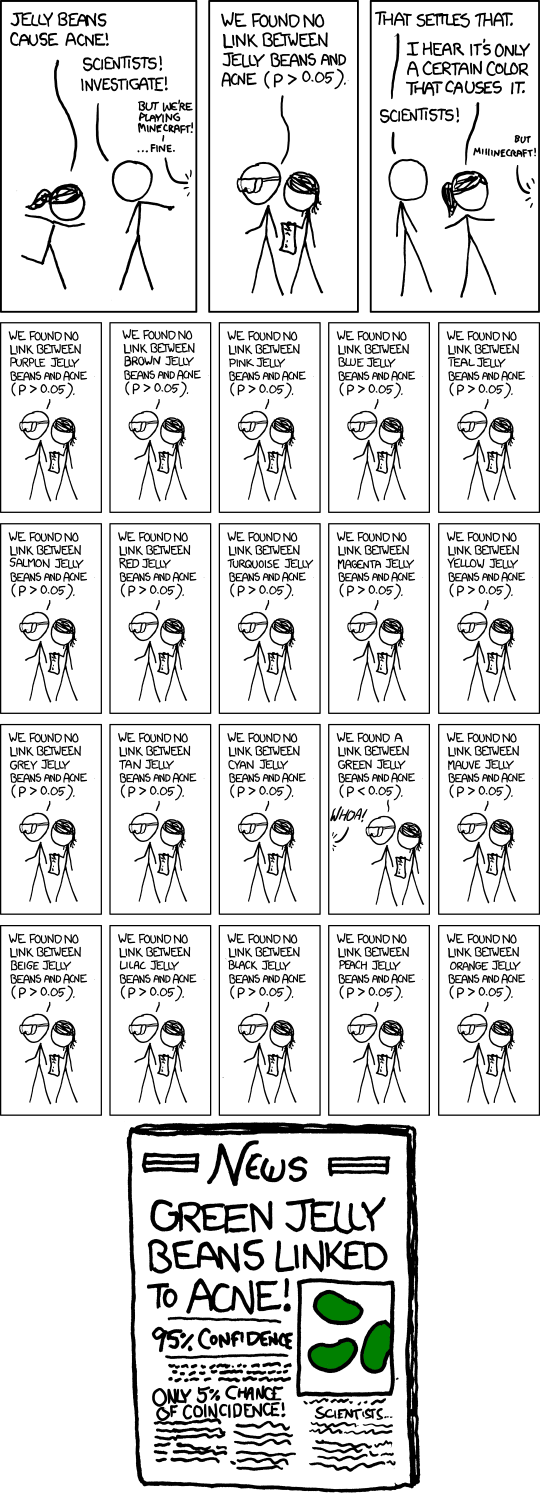

Aber auch ohne diese Optimierungen kann es schon ein P-Hack sein, wenn man dasselbe Experiment einfach wiederholt und das Ergebnis erst dann veröffentlicht, wenn es statistisch signifikant ist. Denn es besteht immer die Chance, dass ein Experiment, wenn es oft genug gemacht wird, irgendwann mal einen niedrigen p-Wert liefert. Der Comic „“ von xkcd zeigt das ganz gut.

Ein „bedeutender“ Comic. Quelle: xkcd.

Praktische Beispiele für P-Hacking

P-Hacking ist echt weit verbreitet. Anfang der 2010er Jahre haben viele Studien herausgefunden, dass ein großer Teil der in angesehenen Fachzeitschriften veröffentlichten Forschungsergebnisse wahrscheinlich p-gehackt ist, vor allem in der Psychologie und Medizin, aber auch in den Sozial- und Geisteswissenschaften.

Zum Beispiel hat eine Studie von einem Forscher an der University of Virginia im Jahr 2015, in der 100 Psychologie-Studien aus Top-Zeitschriften von 2008 angeschaut wurden, gezeigt, dass weniger als die Hälfte dieser Studien wiederholbar waren. Die mangelnde Reproduzierbarkeit bedeutet, dass die Studien bei einer Wiederholung nicht zum gleichen Ergebnis führen, manchmal aufgrund von P-Hacking.

Ein anderes Projekt, das sich mit Krebsstudien beschäftigt hat, hat herausgefunden, dass nur 50 von 193 Experimenten wiederholbar sind. Schon früher im Jahr 2009 hat eine Studie auf eine verdächtig hohe Anzahl von Experimenten im Bereich der Neurowissenschaften hingewiesen, die ungewöhnlich starke Zusammenhänge zwischen Emotionen, Persönlichkeit, sozialer Wahrnehmung und der Aktivität des Gehirns mittels fMRT festgestellt haben. Nachdem wir uns die Autoren dieser Experimente angesehen haben, haben wir festgestellt, dass sie eine Strategie verfolgt haben, bei der sie bestimmte Teile der Daten ausgewählt und nur über die berichtet haben, die zu einem signifikanten Ergebnis geführt haben – ein P-Hack, ähnlich dem, was wir als „Post-hoc-Ersetzung“ bezeichnet haben.

Die Ergebnisse dieser Studien zeigen, dass P-Hacking, zusammen mit anderen fragwürdigen Forschungspraktiken, die Grundlagen der lang angesehenen wissenschaftlichen Forschung ins Wanken bringt und mit Lücken füllt. Eine Krise, die als Reproduzierbarkeitskrise bezeichnet wird undimmer noch andauert, während viele Diskussionen und Bemühungen laufen, um einen Ausweg zu finden.

Warum P-Hacking unmoralisch ist

Also, warum ist P-Hacking eigentlich ein Problem?

„P-Hackingmacht dich zu einem Zauberer“. Quelle: SMBC Comics.

Die Frage mag zu offensichtlich sein, um sie zu beantworten, aber wenn wir uns mal genauer anschauen, warum P-Hacking falsch und unethisch ist, können wir auch besser verstehen, warum das Problem der gefälschten Signifikanz so wichtig ist.

Einfach gesagt, es ist manipulativ.

P-Hacking ist im Grunde nichts anderes als das Ergebnis von Manipulationen an der Methodik oder den Ergebnissen. Wenn das absichtlich gemacht wird, wäre das einfach wie lügen, ohne einen guten Grund außer dem eigenen Vorteil (wie veröffentlicht oder anerkannt zu werden). Wenn das aus Versehen passiert, ist das so, als würde man die falsche Straße nehmen und am Ende nur eine Fata Morgana von falschen Positiven sehen.

Das kann zu falschen Entscheidungen und echt schlimmen Folgen führen.

Experimente, egal ob in der Wissenschaft oder in der Wirtschaft, haben immer Konsequenzen. Sie werden gemacht, um Entscheidungen zu treffen oder um auf den Ergebnissen weiter aufzubauen. Wenn die Ergebnisse des Experiments gefälscht sind, sind die davon abhängigen Entscheidungen unbegründet, was manchmal zu katastrophalen Folgen führen kann.

Zum Beispiel kann die Forschung in heiklen Bereichen wie der Onkologie und Neurologie dazu beitragen, dass neue Behandlungen und Medikamente entwickelt werden. Es wäre echt schlimm, wenn einige der grundlegenden Forschungsergebnisse manipuliert worden wären.

Im Geschäftsleben können falsche Entscheidungen ganz schön schiefgehen, von der Einführung eines Flops über die Verschwendung von Ressourcen bis hin zur Entlassung von Mitarbeitern oder sogar zur Pleite. Ein einfacher p-Hack kann einen Schmetterlingseffekt auslösen.

Es untergräbt das Vertrauen in die wissenschaftliche Methode.

Die Krise der Reproduzierbarkeit hatzu einer weit verbreiteten Skepsis gegenüber der Wissenschaft als Ganzes geführt, die sogar in der Politik zu spüren ist. Kritisches Denken ist zwar immer gut, auch wenn man wissenschaftliche Ergebnisse hört, aber wenn man alle empirischen Erkenntnisse einfach abtut, kann das zu Verzweiflung und falschen Entscheidungen führen.

In der Wirtschaft können P-Hacking und ähnliche fragwürdige Praktiken dazu führen, dass Führungskräfte sich von datengestützten Entscheidungen wieder zurückziehen und sich nur noch auf ihr Bauchgefühl verlassen – genau das Gegenteil von dem, was die Datenwissenschaft als Ganzes verspricht und tatsächlich leisten kann.

Es erschüttert die kumulative Natur von Wissen.

Das Wissen der Menschen basiert komplett auf dem Prinzip, dass man Dinge sammelt. Jedes kleine Experiment ist ein Baustein, der den Weg für ein größeres Wissen ebnet. Wenn immer mehr dieser Bausteine durch fragwürdige Praktiken wie P-Hacking ins Wanken geraten, ist das Potenzial einer solchen Anhäufung zum Scheitern verurteilt. Selbst das einfache Suchen nach alter Literatur, um ein neues Experiment aufzubauen, wird zu einer kniffligen Aufgabe, wie wenn man einen Weg durch ein Minenfeld sucht.

Warnsignale und wie man P-Hacking erkennt

Basierend auf dem, was wir jetzt über P-Hacking und seine Methoden wissen, können wir einige Warnsignale erkennen, die uns helfen, P-Hacks zu entdecken. Die meisten dieser Warnsignale erfordern immer noch Neugier, kritisches Denken und einen genauen Blick, um sie zu erkennen. Manche brauchen sogar echt viel Fachwissen.

Zu reißerische Ergebnisse

Sensationelle Versuchsergebnisse sind meistens zu fragwürdig, um sie einfach so zu glauben. Studien, die behaupten, dass „Schokolade zum Abnehmen hilft“, werden oft von der Presse und den sozialen Medien aufgegriffen, aber man sollte sie nicht einfach so glauben.

Im Geschäftsleben kann ein Test, der durch die Einführung einer kleinen Funktion auf einer Website eine 100-prozentige Gewinnsteigerung verspricht, als ähnlich sensationell angesehen werden.

Wenn du auf so eine Studie stößt und sie dich interessiert, check immer erst die Methodik und die Ergebnisse, bevor du die Ergebnisse einfach so akzeptierst.

Es fehlt an Transparenz bei der Methodik.

Pass auf bei Experimenten, bei denen die Methodik nicht klar ist oder die einige Methodikkomponenten nicht offenlegen. Für eine solide wissenschaftliche Vorgehensweise ist es wichtig, dass man seine ersten Hypothesen, das Signifikanzniveau, die Stichprobengröße, die gesammelten Variablen, die gewählten Testarten und die Schritte zur Datenaufbereitung offenlegt. Wenn du dir über irgendwelche dieser Punkte nicht im Klaren bist, ist das ein Warnsignal.

Unnötige Datenumwandlung

Wenn du bei der Vorbereitung der Versuchsdaten Variablen umwandelst, überprüfe nochmal, warum du das machst, weil du das begründen musst. Wenn das nicht der Fall ist oder nicht überzeugend ist, kann das ein direkter Hinweis auf P-Hacking sein.

Unbegründete kleine Stichprobengröße

Eine kleine Stichprobengröße verringert die statistische Aussagekraft der Studie und erhöht das Risiko von falsch negativen Ergebnissen. Wenn man das aber mit selektiver Berichterstattung oder P-Hacking kombiniert, können Studien mit geringer Aussagekraft auch dazu führen, dass es in der veröffentlichten Literatur mehr falsche positive Ergebnisse gibt.

In manchen Bereichen sind kleine Stichproben okay und ganz normal, zum Beispiel in der klinischen Forschung, bei Umweltstudien, im Ingenieurwesen und in der Qualitätskontrolle. Aber im Allgemeinen gilt: Je größer die Stichprobe, desto besser die Schlussfolgerungen und desto geringer die Wahrscheinlichkeit von falschen positiven Ergebnissen und falschen signifikanten p-Werten.

Wenn eine kleine Stichprobe nicht gerechtfertigt ist, kann das auf eine zu geringe statistische Aussagekraft hindeuten, was das Risiko von falschen positiven Ergebnissen erhöht. In manchen Fällen könnte das auch auf ein vorzeitiges Beenden hindeuten, also auf die spezielle P-Hacking-Praxis, die ich vorhin erwähnt habe, bei der die Datenerhebung beendet wird, sobald eine Signifikanz erreicht ist, und nicht erst, wenn die geplante Stichprobengröße erreicht ist.

Unklare Effektgröße

Die Effektgröße zeigt, wie stark oder groß der Zusammenhang zwischen Variablen ist, und gibt so einen Kontext für die statistische Bedeutung eines Ergebnisses. Wenn eine Studie zwar statistische Signifikanz zeigt, aber keine klare oder aussagekräftige Effektgröße liefert, ist Vorsicht angesagt.

Ein p-Wert kann zeigen, dass das Ergebnis wahrscheinlich nicht nur Zufall ist, aber ohne eine Effektgröße ist es schwierig, die praktische Bedeutung der Ergebnisse zu bestimmen. In p-hacked Studien kann eine unklare Angabe der Effektgröße darauf hindeuten, dass die Forscher sich zu sehr auf das Erreichen statistischer Signifikanz konzentriert haben, ohne andere Aspekte zu berücksichtigen.

Widerspruch zwischen der Hypothese und dem Ergebnis

Wenn die Ergebnisse einer Studie ganz anders ausfallen als man erwartet hat, sollte man sich Gedanken machen. Das könnte bedeuten, dass die Forscher ihre Hypothese oder Methoden nach der Datenerhebung geändert haben, um sie an die Ergebnisse anzupassen – eine Praxis, die als HARKing (HypothesizingAfter Results are Known) bekannt ist.

Wenn zum Beispiel ein Experiment behauptet, eine bestimmte Hypothese getestet zu haben, die abschließende Analyse sich aber auf andere Variablen oder Ergebnisse zu konzentrieren scheint, könnte das auf P-Hacking hindeuten. Vergleich immer die aufgestellte Hypothese mit den Endergebnissen, um sicherzugehen, dass sie übereinstimmen.

Ungewöhnlich starker Effekt

Ein ungewöhnlich hoher Effekt kann ein Warnsignal für P-Hacking sein. In vielen Fällen sind die Auswirkungen in der Praxis eher gering bis moderat, vor allem in Bereichen wie Psychologie, Medizin oder Sozialwissenschaften. Genauso wie bei der Beurteilung der richtigen Stichprobengröße braucht man auch für die Beurteilung der Plausibilität einer Effektgröße intensive Fachkenntnisse.

Wenn eine Studie einen ungewöhnlich großen Effekt angibt, könnte das bedeuten, dass die Daten irgendwie manipuliert wurden oder die Stichprobe nicht ganz fair ist. Forscher könnten absichtlich oder aus Versehen Daten weglassen, die den Effekt verringern würden, damit ihre Ergebnisse beeindruckender aussehen, als sie eigentlich sind (der sogenannte „Post-hoc-Ersatz-P-Hack“).

Ein p-Wert, der knapp unter dem Signifikanzniveau liegt.

Wenn der gemeldete p-Wert knapp unter der Signifikanzschwelle liegt (z. B. p = 0,049 in einer Studie, in der p < 0,05 die Grenze für Signifikanz ist), könnte das darauf hindeuten, dass die Forscher p-Hacking betrieben haben.

Das liegt daran, dass das wiederholte Durchführen von Tests oder das Anpassen von Variablen dazu führen kann, dass ein Ergebnis zufällig knapp die Signifikanzschwelle überschreitet. Wenn die Ergebnisse immer knapp unter der Signifikanzschwelle liegen, könnte das bedeuten, dass die Forscher die Datenerhebung abgebrochen haben, sobald sie das gewünschte Ergebnis hatten (vorzeitiger Abbruch), oder dass sie bestimmte Analysen nur ausgewählt haben (nachträgliche Ersetzung).

Unwiederholbarkeit

Einer der besten Hinweise auf P-Hacking ist, wenn die Ergebnisse einer Studie nicht wiederholbar sind. Wenn unabhängige Forscher die Ergebnisse einer Studie mit derselben Methode nicht reproduzieren können, könnte das bedeuten, dass die ursprünglichen Ergebnisse durch P-Hacking oder selektive Berichterstattung entstanden sind.

Wiederholbarkeit ist ein wichtiger Teil von guter Wissenschaft, und wenn Ergebnisse nicht immer wieder genauso rauskommen, könnte das bedeuten, dass die ursprüngliche Analyse vielleicht nicht ganz in Ordnung war oder manipuliert wurde.

Grüne Flaggen und wie man P-Hacking vermeidet

Wenn wir die oben genannten Warnsignale umdrehen, können wir auch Wege finden, um P-Hacking zu vermeiden. Diese Ansätze sind in den letzten zehn Jahren in der wissenschaftlichen Diskussion als Antwort auf die Reproduzierbarkeitskrise aufgekommen.

Statistik-Know-how

Ein solides Verständnis statistischer Prinzipien ist wichtig, um P-Hacking zu vermeiden. Wenn Analysten das nötige Wissen haben, können sie besser gängige Fallen vermeiden, wie zum Beispiel die falsche Interpretation von p-Werten oder den unsachgemäßen Umgang mit Mehrfachvergleichen.

Bei A/B-Tests für eine Website-Funktion weiß ein guter Analyst zum Beispiel, dass der p-Wert nicht das Endziel ist, denn selbst wenn der Test einen niedrigen p-Wert ergibt, kann die Effektgröße immer noch zu gering sein und somit keine praktische Bedeutung haben. Wenn man den Unterschied zwischen statistischer und praktischer Signifikanz versteht, kann man sich als Analyst besser davon abhalten, sich zu sehr auf den p-Wert zu konzentrieren, was zu p-Hacking führen kann. So wird die Wahrscheinlichkeit geringer, dass Ergebnisse manipuliert werden, um ein besseres Ergebnis zu bekommen.

Voranmeldung

Bei der Vorregistrierung in der wissenschaftlichen Forschung wird der Forschungs- oder Testplan mit Hypothesen, Methoden und Analysetechniken festgelegt, bevor irgendwelche Daten gesammelt werden. Dieser Prozess verhindert „p-Hacking“, indem er Entscheidungen über die Durchführung der Analyse festlegt und es so schwieriger macht, die Analyse nachträglich zu ändern, um ein signifikantes Ergebnis zu erzielen.

In der Wirtschaft kann man so was sogar bei den Datenteams machen. Bevor zum Beispiel ein Experiment durchgeführt wird, um die Auswirkungen eines neuen Preismodells zu messen, kann das Team die Hypothese vorab dokumentieren und intern festlegen, wobei die zu testenden Variablen (z. B. Umsatz, Kundenakquisitionsrate), das Signifikanzniveau und die Stichprobengröße angegeben werden. So bleibt das Team beim ursprünglichen Plan und ändert die Analyse nicht, nachdem es die ersten Ergebnisse gesehen hat. Das verhindert, dass man nachträglich Daten austauscht oder nur die Daten herauspickt, die gut aussehen.

Offene Wissenschaftspraktiken

Offene Wissenschaft bedeutet, dass man Daten, Methoden und Analysen für andere zugänglich macht, damit sie diese überprüfen und wiederholen können. In der Wirtschaft wird der Begriff „offene Wissenschaft“ vielleicht nicht direkt benutzt, aber ähnliche Transparenzpraktiken sind wichtig, um die Integrität von Analysen sicherzustellen.

Ein Unternehmen, das zum Beispiel eine Marktanalyse macht, kann seine Rohdaten und Analyseschritte intern mit anderen Teams, Prüfern oder wichtigen Leuten teilen oder alles für spätere Wiederholungen ordentlich dokumentieren. Diese Transparenz hält Leute davon ab, mit den Zahlen rumzurechnen, weil jeder nachsehen kann, ob die Methodik stimmt. In einer Organisation fördert die Offenheit über Methoden und Ergebnisse die Verantwortlichkeit und hilft dabei, dass Schlussfolgerungen auf der Grundlage solider, reproduzierbarer Daten gezogen werden.

Entscheidungen bei der Datenaufbereitung und -umwandlung erklären

Die Schritte zur Datenaufbereitung und -umwandlung sollten immer gut begründet sein. Ohne einen klaren Grund kann das Entfernen von Ausreißern oder das Verändern von Variablen dazu führen, dass Ergebnisse manipuliert werden und ein falsches Bild entsteht.

Wenn man zum Beispiel Kundenkaufdaten anschaut, könnte ein Analyst bestimmte Datenpunkte (z. B. extreme Ausreißer) rausnehmen, die nicht so richtig ins Bild passen. Ohne einen guten Grund – wie zum Beispiel, dass es sich um echte Ausreißer und nicht um normale Werte handelt – könnte das aber als eine Art von p-Hacking durchgehen. Um das zu vermeiden, sollte jeder Schritt bei der Datenaufbereitung (wie das Rauschen bestimmter Zeiträume oder das Anwenden von Log-Transformationen) im Analysebericht klar erklärt werden, damit alles transparent bleibt.

Angabe und Berücksichtigung der Effektgröße

Abgesehen von der statistischen Signifikanz ist es echt wichtig, die Effektgrößen zu melden und zu erklären. So stellen wir sicher, dass die Ergebnisse in der Praxis echt was bringen und nicht nur wegen der großen Stichproben statistisch wichtig sind.

Denk mal an einen A/B-Test im Business, bei dem eine neue Produktbeschreibung die Conversion-Rate um 0,5 % steigert, aber die Stichprobe groß genug ist, um das Ergebnis statistisch relevant zu machen. Ohne Kontext könnte diese Änderung als wichtig missverstanden werden. Wenn man sich aber auf die Effektgröße konzentriert und fragt, ob ein Anstieg von 0,5 % die Kosten für die Änderung aller Produktbeschreibungen rechtfertigt, kann man vermeiden, Entscheidungen nur aufgrund von p-Werten zu treffen.

Die Erlaubnis, das Experiment mehrmals durchzuführen, aber mit Korrekturmethoden.

Wir haben gesagt, dass wenn man denselben Test (oder verschiedene Tests) mit denselben Daten macht, man zufällig ein signifikantes Ergebnis kriegen kann, und deshalb haben wir das als P-Hack angesehen. Aber eigentlich kann es eine gute Idee sein, denselben Test mit denselben Daten mehrmals zu machen, um P-Hacking zu vermeiden, aber nur, wenn man das mit Korrekturmethoden kombiniert, also mit statistischen Techniken, die berücksichtigen, dass mehrere Vergleiche gemacht werden. Die beiden gängigsten Korrekturmethoden sind die Bonferroni-Korrektur und das Benjamini-Hochberg-Verfahren (BH).

Bei der Bonferroni-Korrektur wird der p-Wert-Schwellenwert (das Signifikanzniveau) nach unten angepasst, indem er durch die Anzahl der durchgeführten Tests geteilt wird. Das verringert zwar die Wahrscheinlichkeit von falschen Positiven, kann aber zu konservativ sein und die Wahrscheinlichkeit von falschen Negativen erhöhen.

Im Gegensatz dazu ist das BH-Verfahren eine der Techniken zur Kontrolle der Falsch-Entdeckungsrate (FDR), die darauf abzielt, ein Gleichgewicht zwischen der Wahrscheinlichkeit der beiden Fehlerarten herzustellen. Kurz gesagt, beim BH-Verfahren werden erst mal alle p-Werte aus mehreren Tests sortiert, vom kleinsten bis zum größten. Jeder p-Wert wird dann mit einem Schwellenwert verglichen, der mit seinem Rang steigt. Der größte p-Wert, der noch unter dem Schwellenwert liegt, wird ermittelt, und alle p-Werte bis zu diesem Punkt werden als signifikant angesehen.

Wenn ein Unternehmen im Geschäftsleben mehrere Versionen einer Landing Page testet, ist es verlockend, viele A/B-Tests durchzuführen und aufzuhören, sobald eine Version deutlich besser abschneidet. Um das zu vermeiden, kann der Analyst Korrekturen vornehmen, um die vielen durchgeführten Tests zu berücksichtigen. Auf diese Weise stellen sie sicher, dass wichtige Ergebnisse nicht nur das Ergebnis wiederholter Tests sind.

Unbedeutende Ergebnisse berücksichtigen

Zu guter Letzt ist es wichtig, auch Ergebnisse, die nicht so wichtig sind, zu erwähnen und zu berichten, anstatt sie einfach wegzulassen. In der Wissenschaft gibt's Forderungen, dass man Experimente mit nicht so tollen Ergebnissen veröffentlichen darf, solange sie nach einer strengen, vorher festgelegten Methode gemacht wurden, weil auch das Nichtfinden ein Ergebnis sein kann! Ähnliche Weisheiten kann man auch im Geschäftsleben anwenden.

Wenn zum Beispiel eine Marketingkampagne keinen großen Einfluss auf den Umsatz hat, sollte ein Unternehmen das trotzdem melden und bedenken. Es liefert wichtige Infos und verhindert, dass Berichte verzerrt sind, was zu falschen Geschäftsentscheidungen führen könnte. Wenn man auch über nicht so wichtige Ergebnisse redet, wird die Analyse ehrlicher und man kommt nicht in Versuchung, Daten zu manipulieren, um Erfolge zu zeigen.

Fazit

In diesem Artikel haben wir uns intensiv mit dem Thema P-Hacking beschäftigt, bei dem der p-Wert leicht manipuliert werden kann. Wir haben uns die verschiedenen P-Hacks angesehen, wie man sie erkennen und verhindern kann.

Wie du sehen kannst und wie wir schon gesagt haben, ist es wichtig, sich mit Statistik gut auszukennen, um P-Hacking zu erkennen. Das kannst du in unseren verschiedenen Statistikkursen lernen, wie zum Beispiel in unserem theoretischen Kurs „Einführung in die Statistik“ oder unseren praktischen Kursen „Einführung in die Statistik in Google Sheets“, „Einführung in die Statistik in Python“ und „Einführung in die Statistik in R“.

Islam ist Datenanalyst, Moderator am KPI Institute und Dozent an der Universität Kairo. Mit einem journalistischen Hintergrund hat Islam vielfältige Interessen, darunter Schreiben, Philosophie, Medien, Technologie und Kultur.