Curso

A Meta introduziu recentemente um novo e empolgante avanço em IA: Modelo 2 de qualquer segmento (SAM 2).

Essa ferramenta elimina o incômodo da seleção de objetos na edição de imagens e vídeos, tornando o processo tão simples quanto um clique ou alguns toques. O SAM 2 pode isolar e rastrear objetos sem esforço com precisão excepcional.

Mas o SAM 2 é mais do que apenas uma ferramenta de design. Desenvolvido por Meta AIesse modelo avançado está pronto para impactar vários setores, desde a redefinição de imagens médicas até o aprimoramento dos recursos de veículos autônomos.

Neste artigo, exploraremos o que é o SAM 2, como ele difere de seu antecessor, o Segment Anything Model (SAM) original, e os principais recursos que o diferenciam. Também discutiremos suas possíveis aplicações em vários campos e forneceremos insights sobre como você pode começar a usá-lo.

Este vídeo demonstra a aplicação do SAM 2 para segmentação de vídeo, mostrando sua capacidade de rastrear e segmentar objetos com precisão em vários quadros. O SAM 2 mantém a consistência da segmentação, mesmo em cenários desafiadores com oclusões ou movimentos rápidos.

Vamos explorar como o SAM 2 está expandindo as possibilidades da visão computacional e definindo novos padrões de referência para o que é possível alcançar.

O que é SAM 2?

O SAM 2 (Segment Anything Model 2) é o mais recente avanço do Meta AI em tecnologia de visão computacional da Meta AI. Ele se baseia no fundamento estabelecido pelo SAM original, oferecendo recursos aprimorados para segmentação de imagens e vídeos.

Essencialmente, o SAM 2 pode gerar máscaras de segmentação precisas, que identificam e separam objetos em uma imagem ou vídeo.

Imagine que você tenha uma imagem complexa com vários objetos e precise selecionar um específico para edição posterior. Tradicionalmente, você teria que traçar cuidadosamente o contorno do objeto, pixel por pixel, o que pode ser demorado e frustrante. O SAM 2 simplifica esse processo, permitindo que você gere máscaras de segmentação precisas automaticamente, mesmo em cenas desordenadas.

Se você deseja editar um vídeo em que um personagem se movimenta e precisa mantê-lo em foco durante toda a cena, com o SAM 2, você pode rastrear facilmente os movimentos do personagem, mesmo que ele desapareça temporariamente ou mude de forma.

Outro exemplo da capacidade do SAM 2 de manter o foco e rastrear com precisão os movimentos de um personagem, mesmo quando ele desaparece ou muda de forma, demonstrando a robustez do modelo para lidar com cenários complexos de edição de vídeo.

SAM 2 vs. SAM

Embora o modelo SAM original fosse impressionante, o SAM 2 leva as coisas para o próximo nível com vários aprimoramentos importantes.

|

Recurso |

SAM |

SAM2 |

|

Capacidade de segmentação |

Somente imagens |

Imagens e vídeos |

|

Segmentação de vídeo |

Não suportado |

Segmentação de vídeo em tempo real com memória |

|

Precisão e velocidade |

Linha de base |

Maior precisão e 6x mais rapidez na segmentação de imagens |

|

Arquitetura |

Modelos separados para diferentes tarefas |

Modelo unificado para segmentação de imagens e vídeos |

|

Código aberto |

Sim |

Sim |

Segmentação de vídeo

O SAM 2 introduz a capacidade de segmentar objetos em vídeosum avanço significativo em relação ao seu antecessor.

Esse recurso é obtido por meio do módulo de memória por sessão, que mantém o controle do objeto-alvo em todos os quadros. Essa memória é armazenada no que é conhecido como "banco de memória", que retém mapas de características espaciais e informações semânticas sobre o objeto.

Esses mapas e informações são usados pelos mecanismos de atenção do modelo - especificamente, auto-atenção e atenção cruzada - para comparar os recursos do quadro atual com os dos quadros anteriores.

Desempenho aprimorado

O SAM 2 processa quadros de vídeo em tempo real a aproximadamente 44 quadros por segundo, o que o torna adequado para aplicativos de vídeo ao vivo e edição interativa. Isso representa uma melhoria substancial na velocidade e na precisão, o que permite que o SAM 2 lide com tarefas complexas com alta precisão.

Solicitação refinada

O SAM 2 oferece suporte a técnicas de solicitação mais avançadas técnicas de solicitação mais avançadasincluindo o uso de máscaras como avisos de entrada. Essa funcionalidade ampliada ajuda a definir áreas específicas de interesse com maior precisão, melhorando a capacidade do modelo de lidar com cenas complexas com vários objetos sobrepostos.

Segmentação interativa

Com o SAM 2, você pode ajustar os resultados da segmentação em tempo real, fornecendo avisos em qualquer quadro. Essa interatividade permite o refinamento iterativo, o que torna o SAM 2 particularmente vantajoso em fluxos de trabalho que exigem alta precisão, como na edição de vídeo de pós-produção.

Aplicativos do SAM 2

O SAM 2 não se destina apenas a edições básicas de fotos ou vídeos - seus recursos avançados podem ser usados em muitas áreas diferentes, como arte digital, saúde ou carros autônomos.

Setores criativos

O SAM 2 pode mudar a edição de imagens e vídeos, simplificando tarefas como remoção de objetos, substituição de plano de fundo e composição avançada.

Por exemplo, criar uma paisagem surreal combinando elementos de diferentes fontes torna-se um processo simples com o SAM 2, tornando as edições complexas quase sem esforço.

Além da edição tradicional, o SAM 2 também é excelente em IA generativafornecendo controle preciso sobre elementos em imagens e vídeos gerados. Esse recurso Spark novas ideias na criação de conteúdo, facilitando a produção de resultados exclusivos e personalizados.

Além disso, a integração do SAM 2 em plataformas de mídia social como o Instagram pode permitir o desenvolvimento de novos filtros ou efeitos que se adaptam a objetos e cenas em tempo real, melhorando o envolvimento e a criatividade do usuário.

Ciência e pesquisa

Na geração de imagens médicas, o SAM 2 pode ser crucial para identificar e separar com precisão diferentes partes do corpo em exames.

Os cientistas também podem usar o SAM 2 para monitorar de perto como um tumor muda de tamanho ao testar um novo medicamento, o que leva a resultados mais precisos e a uma melhor compreensão da eficácia do tratamento.

Mas o SAM 2 não é útil apenas na medicina. Ele também pode ajudar em outras áreas científicas, como estudos ambientais. Por exemplo, ele pode analisar com precisão imagens de satélite para rastrear o desmatamento, o derretimento de geleiras ou as mudanças nas cidades ao longo do tempo. Isso torna o SAM 2 uma ótima ferramenta para pesquisadores que precisam de dados visuais altamente precisos.

Sistemas autônomos

O setor automotivo tem a ganhar significativamente com a segmentação de objetos precisa e em tempo real do SAM 2. O SAM 2 pode ajudar na identificação e no rastreamento precisos de pedestres, outros veículos e obstáculos, o que é crucial para a navegação segura em ambientes de direção complexos, melhorando os sistemas de percepção dos veículos autônomos.

Imagine um carro autônomo navegando por uma cidade movimentada. A segmentação avançada do SAM 2 garante que o veículo possa detectar e responder com precisão a possíveis perigos, melhorando significativamente a segurança na estrada. Esse recurso melhora a confiabilidade dos veículos autônomos e contribui para a adoção mais ampla da tecnologia de direção autônoma.

Realidade aumentada

O SAM 2 tem grande potencial em realidade aumentada (AR). Com sua capacidade de rastrear objetos com precisão em tempo real, os elementos virtuais podem se misturar perfeitamente ao mundo real, criando experiências de AR mais imersivas. Essa tecnologia pode aprimorar muito os aplicativos de AR em jogos, educação e até mesmo em trabalho remoto, oferecendo aos usuários ferramentas mais interativas e responsivas.

Anotação de dados e treinamento de modelos de IA

Outro uso importante do SAM 2 é a criação de conjuntos de dados anotados (compostos de imagens e vídeos). O SAM 2 automatiza o processo de segmentação em grandes conjuntos de dados, reduzindo o tempo e o esforço necessários para o trabalho manual. Isso acelera o desenvolvimento da IA e melhora a qualidade dos dados de treinamento, resultando em modelos mais fortes e mais precisos.

SAM2: Como isso funciona?

Vamos dar uma olhada em como o SAM 2 funciona nos bastidores.

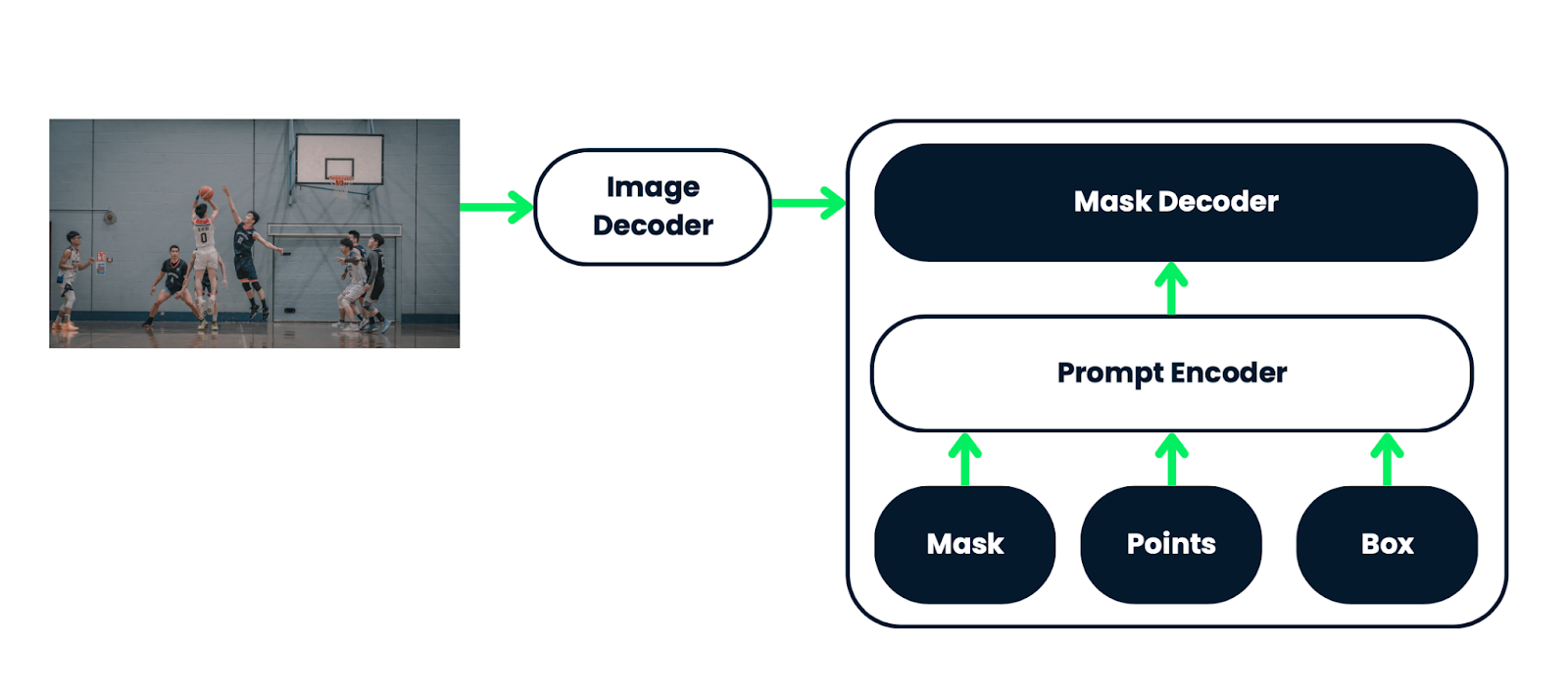

O SAM 2 foi desenvolvido com base em uma arquitetura sofisticada que inclui três componentes principais: um codificador de imagem, um codificador de prompt flexível e um decodificador de máscara rápido. Esses componentes trabalham juntos para processar com eficiência imagens e vídeos.

- Codificador de imagem: O codificador de imagem usa uma arquitetura hierárquica que permite capturar recursos em várias escalas de quadros de vídeo, reconhecendo tanto padrões amplos quanto detalhes finos.

- Codificador de prompt: O codificador de prompt usa uma combinação de mecanismos de autoatenção e de atenção cruzada para refinar a segmentação com base nas entradas do usuário, como cliques ou máscaras.

- Decodificador de máscara: O decodificador de máscara rápido processa rapidamente as informações dos codificadores para produzir máscaras de segmentação de alta qualidade em tempo real, mesmo em cenas complexas.

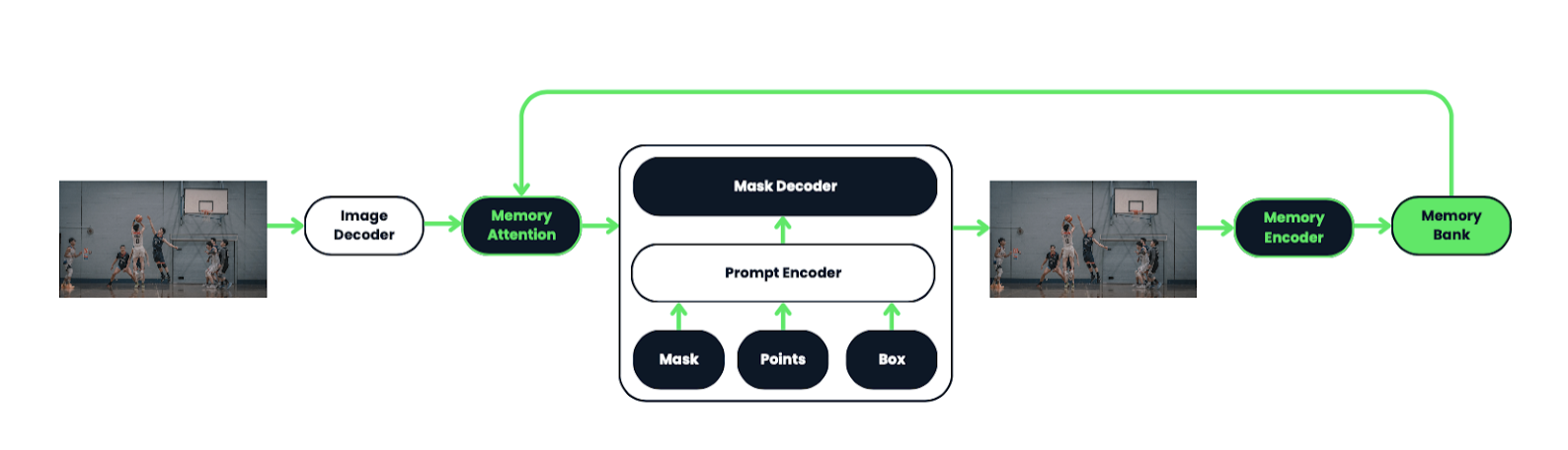

Atenção à memória e compreensão espaço-temporal

Um recurso de destaque do SAM 2 é o uso de um módulo de atenção à memória, que é essencial para a segmentação de vídeo. Esse módulo permite que o modelo lembre e use informações de quadros anteriores, aprimorando sua capacidade de rastrear objetos de forma consistente em um vídeo.

Para entender melhor isso, vamos examinar a arquitetura original do SAM:

O SAM 2 amplia a arquitetura do SAM de imagens para vídeos, permitindo que ele segmente objetos em quadros de vídeo. Ele usa vários prompts, como cliques ou caixas delimitadoras, para definir a extensão do objeto em um quadro. Um decodificador de máscara leve processa esses prompts e as incorporações de imagem para criar uma máscara de segmentação, que é então propagada em todos os quadros de vídeo para formar uma "máscara".

O sistema inclui um mecanismo de memória com um codificador de memória, um banco e um módulo de atenção, o que permite armazenar e usar informações sobre objetos e interações do usuário para melhorar as previsões de máscara em quadros subsequentes.

O codificador de memória atualiza o banco de memória com a previsão de máscara de cada quadro, permitindo que o SAM 2 refine suas previsões à medida que mais quadros são processados. A arquitetura foi projetada para lidar com o processamento de vídeo em tempo real e streaming de forma eficiente, tornando-a adequada para aplicativos como robótica e anotação de conjuntos de dados.

O SAM 2 também funciona com imagens, tratando-as como um vídeo de quadro único. Nesse modo, o mecanismo de memória é desativado. Ao processar imagens, o SAM 2 gera máscaras de segmentação sem utilizar os componentes de memória, lidando efetivamente com a tarefa como um caso simplificado em que apenas o quadro atual (imagem) é considerado.

Desempenho em tempo real

Graças à sua arquitetura otimizada e às técnicas de processamento eficientes, o SAM 2 pode operar a aproximadamente 44 quadros por segundo. Esse recurso em tempo real o torna adequado para uma ampla gama de aplicações, desde a edição de vídeo ao vivo até sistemas interativos de IA.

Dados de treinamento

O SAM 2 foi treinado em um conjunto de dados extenso e diversificado, incluindo o recém-introduzido conjunto de dados SA-V, que contém mais de 600.000 anotações de máscara em 51.000 vídeos. Esse conjunto de dados grande e variado permite que o SAM 2 seja generalizado em vários cenários, desde objetos do cotidiano até domínios altamente especializados.

Limitações do SAM 2

Embora o SAM 2 seja altamente avançado, ele não é isento de limitações.

O SAM 2, embora eficaz para segmentar objetos em imagens e vídeos curtos, tem limitações em cenários desafiadores. Você pode ter dificuldades para rastrear objetos em mudanças drásticas de ponto de vista, longas oclusões, cenas lotadas ou vídeos extensos. Para resolver isso, o modelo permite correções manuais por meio de prompts interativos.

Em cenas lotadas, o SAM 2 pode confundir objetos de aparência semelhante, especialmente se o objeto-alvo for especificado apenas em um quadro. No entanto, avisos adicionais nos quadros subsequentes podem ajudar a corrigir isso.

A eficiência do modelo diminui ao segmentar vários objetos simultaneamente, pois ele processa cada objeto separadamente sem comunicação entre objetos. Além disso, o SAM 2 pode perder detalhes finos em objetos que se movem rapidamente, e suas previsões podem ser instáveis entre os quadros devido à falta de suavidade temporal imposta.

Embora o SAM 2 tenha avançado na geração automática de máscaras, ainda são necessários anotadores humanos para tarefas como verificar a qualidade da máscara e identificar quadros que precisam de correção. São necessários mais aprimoramentos e automação, e os desenvolvedores incentivam a comunidade de IA a se basear no SAM 2 para avançar na pesquisa e criar novos aplicativos.

SAM2: Onde posso fazer download ou acessar o SAM 2?

Para fazer o download dos pesos e do código do modelo, visite o site do Meta AI. O SAM 2 é lançado sob a licença Apache 2.0, tornando-o de código aberto e acessível a desenvolvedores e pesquisadores. Você pode baixar o modelo e o código aqui.

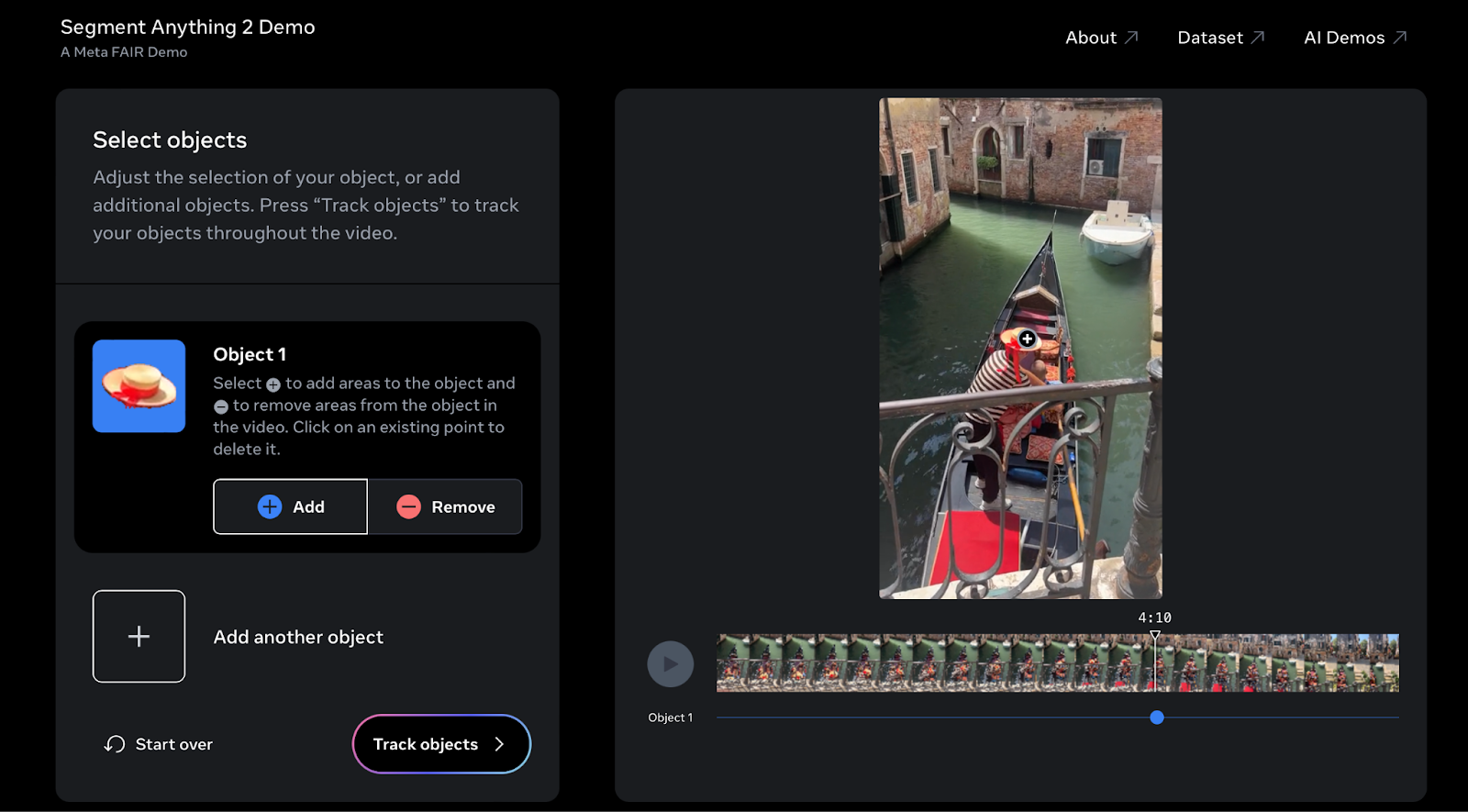

No entanto, se quiser experimentar o SAM2, você pode experimentar a demonstração interativa aqui.

Experimentei o SAM 2 em um vídeo das minhas últimas férias em Veneza. Você pode experimentá-lo com seus próprios vídeos para selecionar e rastrear facilmente objetos em toda a filmagem.

SAM 2: Recursos extras

Para obter uma compreensão mais profunda da arquitetura, do processo de treinamento e dos aplicativos do modelo, você pode acessar o documento oficial de pesquisa. O documento fornece informações detalhadas sobre as inovações por trás do SAM 2.

Se você quiser se aprofundar no SAM 2, há muitos recursos disponíveis para ajudá-lo. Você pode encontrar a documentação oficial, os tutoriais e muito mais no site do site da Meta AI. Ele contém tudo o que você precisa, desde detalhes sobre a arquitetura do modelo até guias de implementação passo a passo.

A comunidade também está ativamente envolvida no aprimoramento do SAM 2, contribuindo para seus projetos de código aberto. Se você ficar conectado com as atualizações mais recentes e fizer parte da comunidade, poderá ajudar a moldar o futuro do SAM 2 e aproveitar os novos recursos à medida que forem lançados.

Para ficar por dentro de todas essas atualizações, é uma boa ideia você acompanhar o blog do blog do Meta AI e verificar o repositório do GitHub regularmente. Essas plataformas fornecem notícias sobre novos recursos, aplicativos do mundo real e até mesmo uma prévia do que está por vir. Estar informado não apenas ajuda você a aproveitar ao máximo o SAM 2, mas também lhe dá a chance de contribuir para sua evolução.

SAM 2: Considerações éticas

Como acontece com qualquer tecnologia poderosa, precisamos pensar cuidadosamente sobre como usar o SAM 2. Como ele se baseia em grandes conjuntos de dados, há um risco de viés em suas previsõeso que é algo com que precisamos estar atentos, especialmente em áreas sensíveis como vigilância e veículos autônomos.

Há também preocupações com a privacidade que você deve considerar, principalmente no que se refere ao uso do SAM 2 para monitorar ou rastrear pessoas. Para garantir que o SAM 2 seja usado de forma responsável, é importante ter discussões abertas e definir diretrizes éticas claras. Isso ajudará a garantir que o SAM 2 seja usado de forma benéfica e justa para todos.

Também é importante lembrar que os modelos de IA, como o SAM 2, são tão bons quanto os dados em que são treinados. tão bons quanto os dados com os quais são treinados. Isso torna crucial o uso de conjuntos de dados diversos e equilibrados para treinar o SAM 2, minimizando o risco de resultados injustos.

A avaliação contínua e a transparência na forma como a SAM 2 é usada também serão fundamentais para manter a confiança do público e garantir que essa tecnologia seja aplicada de forma a respeitar os direitos das pessoas e melhorar o bem-estar da sociedade.

Conclusão

O Segment Anything Model 2 (SAM 2) está causando um impacto significativo no mundo da visão computacional, oferecendo recursos avançados de segmentação para imagens e vídeos.

Sua capacidade de rastrear objetos em tempo real, combinada com uma precisão aprimorada e técnicas de solicitação fáceis de usar, torna-o uma ferramenta valiosa em vários setores.

À medida que o SAM 2 continua a se desenvolver, ele abre novas oportunidades em design criativo, pesquisa científica e muito mais. Oferecendo uma demonstração interativa e acesso de código aberto ao modelo e seu extenso conjunto de dados de treinamento, o Meta AI incentiva a inovação e a colaboração na comunidade de IA, preparando o terreno para futuros avanços na compreensão visual e nos aplicativos interativos.

Perguntas frequentes

Como o SAM 2 lida com casos de segmentação ambígua em que vários objetos podem compartilhar limites semelhantes?

O SAM 2 prevê várias máscaras em cada etapa quando encontra ambiguidade, por exemplo, quando um objeto compartilha limites com outros objetos. Se outras solicitações não resolverem a ambiguidade, o modelo seleciona a máscara com a maior previsão de Intersecção sobre União (IoU) para propagação no vídeo, garantindo que a segmentação mais precisa seja mantida durante todo o processo.

Que mecanismos específicos de atenção o SAM 2 usa para melhorar a precisão da segmentação em vídeos?

O SAM 2 utiliza mecanismos de autoatenção e de atenção cruzada em seu módulo de atenção à memória. Esses mecanismos permitem que o modelo se concentre em quadros anteriores relevantes armazenados no banco de memória, melhorando a precisão da segmentação de objetos em sequências de vídeo complexas, especialmente quando os objetos passam por transformações ou oclusões.

Como o banco de memória no SAM 2 equilibra o contexto temporal e a eficiência computacional?

O banco de memória no SAM 2 foi projetado com uma fila FIFO (First In, First Out) para gerenciar o armazenamento de memórias de até N quadros recentes. Essa abordagem equilibra a necessidade de contexto temporal ao reter informações essenciais de quadros recentes e, ao mesmo tempo, manter a eficiência computacional, garantindo que o modelo não fique sobrecarregado com muitos dados.

Que tipo de codificação posicional o SAM 2 usa para manter a precisão espacial na segmentação de vídeo?

O SAM 2 emprega a incorporação posicional rotativa (RoPE) 2D em suas camadas de atenção à memória. Esse tipo de codificação ajuda a manter a precisão espacial entre os quadros, garantindo que as relações de posição entre os objetos e seus ambientes sejam representadas de forma consistente, mesmo quando os objetos se movem ou mudam de forma.

Como o SAM 2 garante a equidade entre diferentes grupos demográficos em tarefas de segmentação de vídeo?

A SAM 2 foi avaliada quanto à imparcialidade entre grupos demográficos usando o conjunto de dados Ego-Exo4D, que inclui informações demográficas autorreferidas. O modelo apresenta discrepâncias mínimas de desempenho entre os grupos de gênero e idade ao usar prompts de 3 cliques ou máscaras de verdade, garantindo um desempenho equitativo em diferentes populações.