Curso

Meta ha introducido recientemente un nuevo y emocionante avance en IA: Segmento Todo Modelo 2 (SAM 2).

Esta herramienta elimina las molestias de la selección de objetos en la edición de imágenes y vídeo, haciendo que el proceso sea tan sencillo como un clic o unos trazos. SAM 2 puede aislar y seguir objetos sin esfuerzo y con una precisión excepcional.

Pero SAM 2 es algo más que una herramienta de diseño. Desarrollado por Meta IAeste modelo avanzado está llamado a influir en varios sectores, desde la redefinición de las imágenes médicas hasta la mejora de las capacidades de los vehículos autónomos.

En este artículo exploraremos qué es SAM 2, en qué se diferencia de su predecesor, el Segment Anything Model (SAM) original, y las características clave que lo diferencian. También hablaremos de sus posibles aplicaciones en diversos campos y te explicaremos cómo puedes empezar a utilizarlo.

Este vídeo demuestra la aplicación de SAM 2 para la segmentación de vídeo, mostrando su capacidad para rastrear y segmentar objetos con precisión en varios fotogramas. SAM 2 mantiene la coherencia de la segmentación, incluso en escenarios difíciles con oclusiones o movimientos rápidos.

Exploremos cómo SAM 2 está ampliando las posibilidades de la visión por ordenador y estableciendo nuevas referencias de lo que se puede conseguir.

¿Qué es SAM 2?

SAM 2 (Segment Anything Model 2) es el último avance de Meta AI en visión por ordenador informática. Se basa en los cimientos establecidos por el SAM original, ofreciendo capacidades mejoradas para la segmentación de imágenes y vídeos.

Esencialmente, SAM 2 puede generar máscaras de segmentación precisas, que identifican y separan objetos dentro de una imagen o vídeo.

Imagina que tienes una imagen compleja con múltiples objetos, y necesitas seleccionar uno en concreto para editarlo posteriormente. Tradicionalmente, tendrías que trazar cuidadosamente el contorno del objeto, píxel a píxel, lo que puede llevar mucho tiempo y ser frustrante. SAM 2 simplifica este proceso permitiéndote generar automáticamente máscaras de segmentación precisas, incluso en escenas desordenadas.

Si quieres editar un vídeo en el que un personaje se mueve, y necesitas mantenerlo enfocado durante toda la escena, con SAM 2 puedes seguir fácilmente los movimientos del personaje, aunque desaparezca temporalmente o cambie de forma.

Otro ejemplo de la capacidad de SAM 2 para mantener el enfoque y seguir con precisión los movimientos de un personaje, incluso cuando desaparece o cambia de forma, mostrando la robustez del modelo para manejar escenarios complejos de edición de vídeo.

SAM 2 contra SAM

Aunque el modelo SAM original era impresionante, SAM 2 lleva las cosas al siguiente nivel con varias mejoras clave.

|

Función |

SAM |

SAM2 |

|

Capacidad de segmentación |

Sólo imágenes |

Imágenes y vídeos |

|

Segmentación de vídeo |

No se admite |

Segmentación de vídeo en tiempo real con memoria |

|

Precisión y velocidad |

Línea de base |

Mayor precisión y 6 veces más rapidez en la segmentación de imágenes |

|

Arquitectura |

Modelos separados para diferentes tareas |

Modelo unificado para la segmentación de imágenes y vídeos |

|

Código abierto |

Sí |

Sí |

Segmentación de vídeo

SAM 2 introduce la posibilidad de segmentar objetos en vídeosun avance significativo respecto a su predecesor.

Esta capacidad se consigue mediante el módulo de memoria por sesión, que realiza un seguimiento del objeto objetivo a través de los fotogramas. Esta memoria se almacena en lo que se conoce como "banco de memoria", que conserva mapas de características espaciales e información semántica sobre el objeto.

Estos mapas e información son utilizados por los mecanismos de atención del modelo -específicamente, autoatención y la atención cruzada- para comparar las características del fotograma actual con las de fotogramas anteriores.

Rendimiento mejorado

SAM 2 procesa fotogramas de vídeo en tiempo real a aproximadamente 44 fotogramas por segundo, lo que lo hace adecuado para aplicaciones de vídeo en directo y edición interactiva. Se trata de una mejora sustancial en velocidad y precisión, que permite a SAM 2 manejar tareas complejas con gran precisión.

Sugerencias refinadas

SAM 2 admite técnicas más avanzadas más avanzadasincluyendo el uso de máscaras como avisos de entrada. Esta funcionalidad ampliada ayuda a definir áreas específicas de interés con mayor precisión, mejorando la capacidad del modelo para manejar escenas complejas con múltiples objetos superpuestos.

Segmentación interactiva

Con SAM 2 puedes ajustar los resultados de la segmentación en tiempo real mediante avisos en cualquier fotograma. Esta interactividad permite un refinamiento iterativo, lo que hace que SAM 2 sea especialmente beneficioso en flujos de trabajo que exigen gran precisión, como en la edición de vídeo de postproducción.

Aplicaciones de SAM 2

SAM 2 no es sólo para la edición básica de fotos o vídeos: sus potentes funciones pueden utilizarse en muchas áreas diferentes, como el arte digital, la sanidad o los coches autoconducidos.

Industrias creativas

SAM 2 puede cambiar la edición de imagen y vídeo simplificando tareas como la eliminación de objetos, la sustitución del fondo y la composición avanzada.

Por ejemplo, crear un paisaje surrealista combinando elementos de distintas fuentes se convierte en un proceso sencillo con SAM 2, haciendo que las ediciones complejas se realicen casi sin esfuerzo.

Más allá de la edición tradicional, SAM 2 también es excelente en IA generativaproporcionando un control preciso sobre los elementos de las imágenes y vídeos generados. Esta función despierta nuevas ideas en la creación de contenidos, facilitando la producción de resultados únicos y personalizados.

Además, la integración de SAM 2 en plataformas de redes sociales como Instagram podría permitir el desarrollo de nuevos filtros o efectos que se adapten a objetos y escenas en tiempo real, mejorando la participación y la creatividad de los usuarios.

Ciencia e investigación

En la imagen médica, SAM 2 puede ser crucial para identificar y separar con precisión distintas partes del cuerpo en las exploraciones.

Los científicos también pueden utilizar SAM 2 para seguir de cerca cómo cambia el tamaño de un tumor al probar un nuevo fármaco, lo que permite obtener resultados más precisos y comprender mejor la eficacia del tratamiento.

Pero SAM 2 no sólo es útil en medicina. También puede ayudar en otras áreas científicas como los estudios medioambientales. Por ejemplo, puede analizar con precisión imágenes de satélite para rastrear la deforestación, el deshielo de los glaciares o los cambios en las ciudades a lo largo del tiempo. Esto convierte a SAM 2 en una gran herramienta para los investigadores que necesitan datos visuales de gran precisión.

Sistemas autónomos

La industria del automóvil puede beneficiarse considerablemente de la segmentación de objetos precisa y en tiempo real de SAM 2. SAM 2 puede ayudar a la identificación y seguimiento precisos de peatones, otros vehículos y obstáculos, lo que es crucial para una navegación segura en entornos de conducción complejos, mejorando los sistemas de percepción de los vehículos autónomos.

Imagina un coche autoconducido circulando por una ciudad bulliciosa. La segmentación avanzada de SAM 2 garantiza que el vehículo pueda detectar con precisión los peligros potenciales y responder a ellos, mejorando significativamente la seguridad en carretera. Esta capacidad mejora la fiabilidad de los vehículos autónomos y contribuye a una adopción más amplia de la tecnología de conducción autónoma.

Realidad aumentada

SAM 2 tiene un gran potencial en realidad aumentada (RA). Gracias a su capacidad para seguir con precisión los objetos en tiempo real, los elementos virtuales pueden mezclarse perfectamente con el mundo real, creando experiencias de RA más envolventes. Esta tecnología podría mejorar enormemente las aplicaciones de la RA en los juegos, la educación e incluso el trabajo a distancia, ofreciendo a los usuarios herramientas más interactivas y receptivas.

Anotación de datos y entrenamiento de modelos de IA

Otro uso clave de SAM 2 es la creación de conjuntos de datos anotados (compuestos por imágenes y vídeos). SAM 2 automatiza el proceso de segmentación en grandes conjuntos de datos, reduciendo el tiempo y el esfuerzo necesarios para el trabajo manual. Esto acelera el desarrollo de la IA y mejora la calidad de los datos de entrenamiento, lo que da lugar a modelos más sólidos y precisos.

SAM2: ¿Cómo funciona?

Veamos cómo funciona SAM 2 entre bastidores.

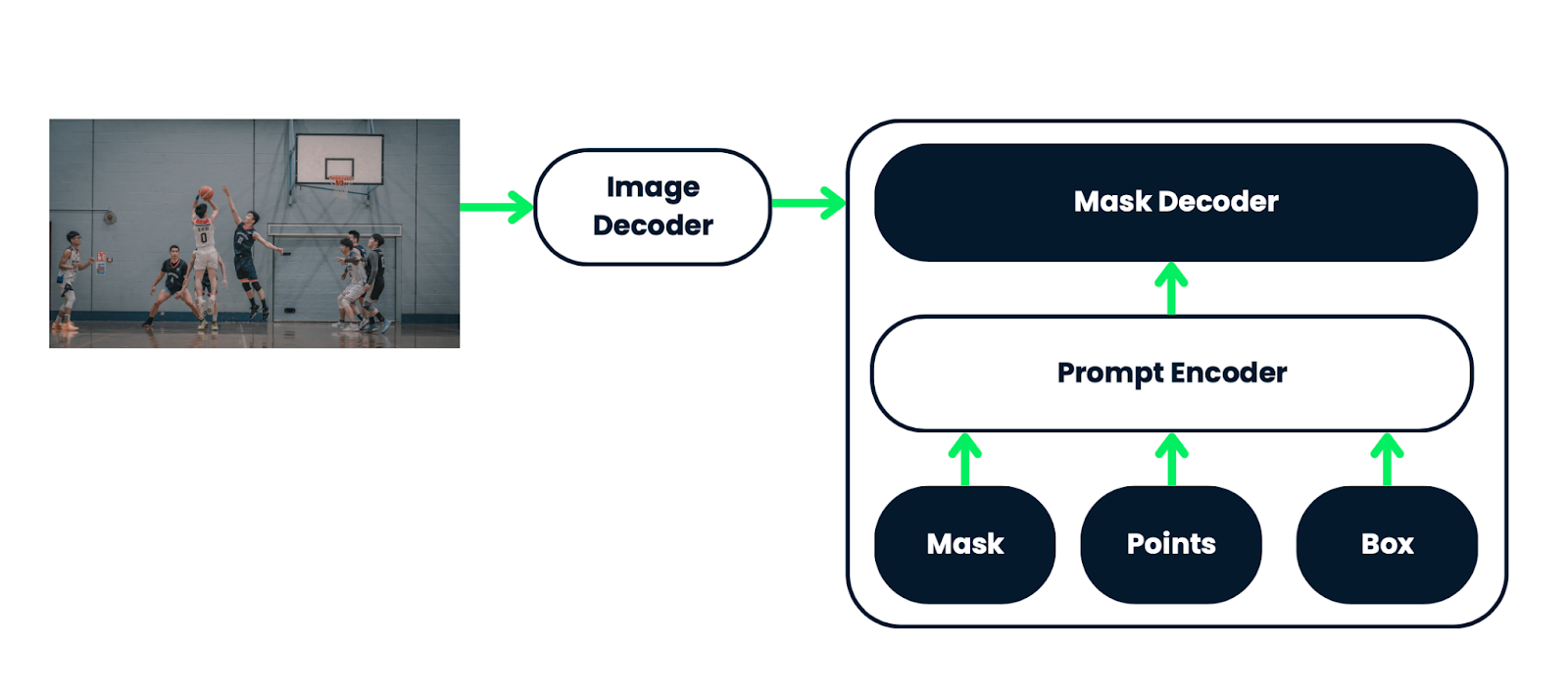

SAM 2 se basa en una arquitectura sofisticada que consta de tres componentes principales: un codificador de imágenes, un codificador de avisos flexible y un descodificador de máscaras rápido. Estos componentes trabajan juntos para procesar eficazmente tanto imágenes como vídeos.

- Codificador de imágenes: El codificador de imágenes utiliza una arquitectura jerárquica que le permite capturar características multiescala de los fotogramas de vídeo, reconociendo tanto patrones amplios como detalles finos.

- Pregunta al codificador: El codificador de avisos utiliza una combinación de mecanismos de autoatención y atención cruzada para refinar la segmentación basándose en las entradas del usuario, como clics o máscaras.

- Descodificador de máscaras: El rápido descodificador de máscaras procesa rápidamente la información de los codificadores para producir máscaras de segmentación de alta calidad en tiempo real, incluso para escenas complejas.

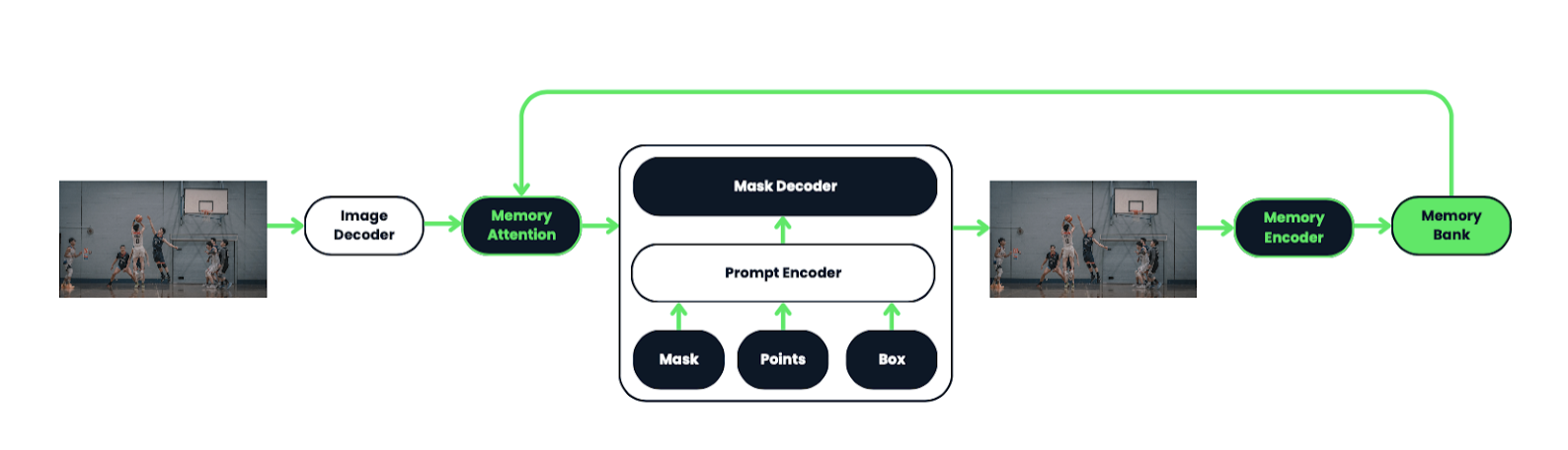

Memoria atención y comprensión espacio-temporal

Una característica destacada de SAM 2 es el uso de un módulo de atención a la memoria, que es crucial para la segmentación de vídeo. Este módulo permite al modelo recordar y utilizar información de fotogramas anteriores, mejorando su capacidad para seguir objetos de forma coherente a lo largo de un vídeo.

Para entenderlo mejor, examinemos la arquitectura original de SAM:

SAM 2 amplía la arquitectura SAM de imágenes a vídeos, permitiéndole segmentar objetos a través de fotogramas de vídeo. Utiliza varias indicaciones, como clics o cuadros delimitadores, para definir la extensión del objeto en un cuadro. Un descodificador de máscaras ligero procesa estas indicaciones e incrustaciones de imágenes para crear una máscara de segmentación, que luego se propaga por todos los fotogramas de vídeo para formar un "masklet".

El sistema incluye un mecanismo de memoria con un codificador de memoria, un banco y un módulo de atención, que le permite almacenar y utilizar información sobre los objetos y las interacciones del usuario para mejorar las predicciones de la máscara en fotogramas posteriores.

El codificador de memoria actualiza el banco de memoria con la predicción de máscara de cada fotograma, lo que permite a SAM 2 refinar sus predicciones a medida que se procesan más fotogramas. La arquitectura está diseñada para manejar con eficacia el procesamiento de vídeo en tiempo real y en streaming, lo que la hace adecuada para aplicaciones como la robótica y la anotación de conjuntos de datos.

SAM 2 también funciona con imágenes tratándolas como un vídeo de un solo fotograma. En este modo, el mecanismo de memoria está desactivado. Al procesar imágenes, SAM 2 genera máscaras de segmentación sin utilizar los componentes de memoria, manejando eficazmente la tarea como un caso simplificado en el que sólo se considera el fotograma (imagen) actual.

Rendimiento en tiempo real

Gracias a su arquitectura optimizada y a sus eficaces técnicas de procesamiento, SAM 2 puede funcionar a unos 44 fotogramas por segundo. Esta capacidad en tiempo real lo hace adecuado para una amplia gama de aplicaciones, desde la edición de vídeo en directo hasta los sistemas interactivos de IA.

Datos de entrenamiento

SAM 2 se entrenó en un conjunto de datos amplio y diverso, incluido el conjunto de datos SA-V, de reciente introducción, que contiene más de 600.000 anotaciones de máscaras en 51.000 vídeos. Este amplio y variado conjunto de datos permite a SAM 2 generalizar en diversos escenarios, desde objetos cotidianos hasta dominios altamente especializados.

Limitaciones de SAM 2

Aunque SAM 2 es muy avanzado, no está exento de limitaciones.

SAM 2, aunque es eficaz para segmentar objetos en imágenes y vídeos cortos, tiene limitaciones en escenarios difíciles. Puede tener problemas con el seguimiento de objetos a través de cambios drásticos de punto de vista, oclusiones prolongadas, escenas abarrotadas o vídeos extensos. Para solucionarlo, el modelo permite correcciones manuales mediante indicaciones interactivas.

En escenas abarrotadas, SAM 2 podría confundir objetos de aspecto similar, sobre todo si el objeto objetivo sólo se especifica en un fotograma. Sin embargo, las indicaciones adicionales en fotogramas posteriores pueden ayudar a corregirlo.

La eficacia del modelo disminuye al segmentar varios objetos simultáneamente, ya que procesa cada objeto por separado sin comunicación interobjetos. Además, SAM 2 puede pasar por alto detalles finos en objetos que se mueven rápidamente, y sus predicciones pueden ser inestables entre fotogramas debido a la falta de suavidad temporal forzada.

Aunque SAM 2 ha avanzado en la generación automática de máscaras, los anotadores humanos siguen siendo necesarios para tareas como verificar la calidad de las máscaras e identificar los fotogramas que necesitan corrección. Se necesitan más automatizaciones y mejoras, y los desarrolladores animan a la comunidad de IA a basarse en SAM 2 para avanzar en la investigación y crear nuevas aplicaciones.

SAM2: ¿Dónde puedo descargar o acceder a SAM 2?

Para descargar los pesos del modelo y el código, visita el sitio web de Meta AI. SAM 2 se publica bajo licencia Apache 2.0, por lo que es de código abierto y accesible para desarrolladores e investigadores. Puedes descargar el modelo y el código aquí.

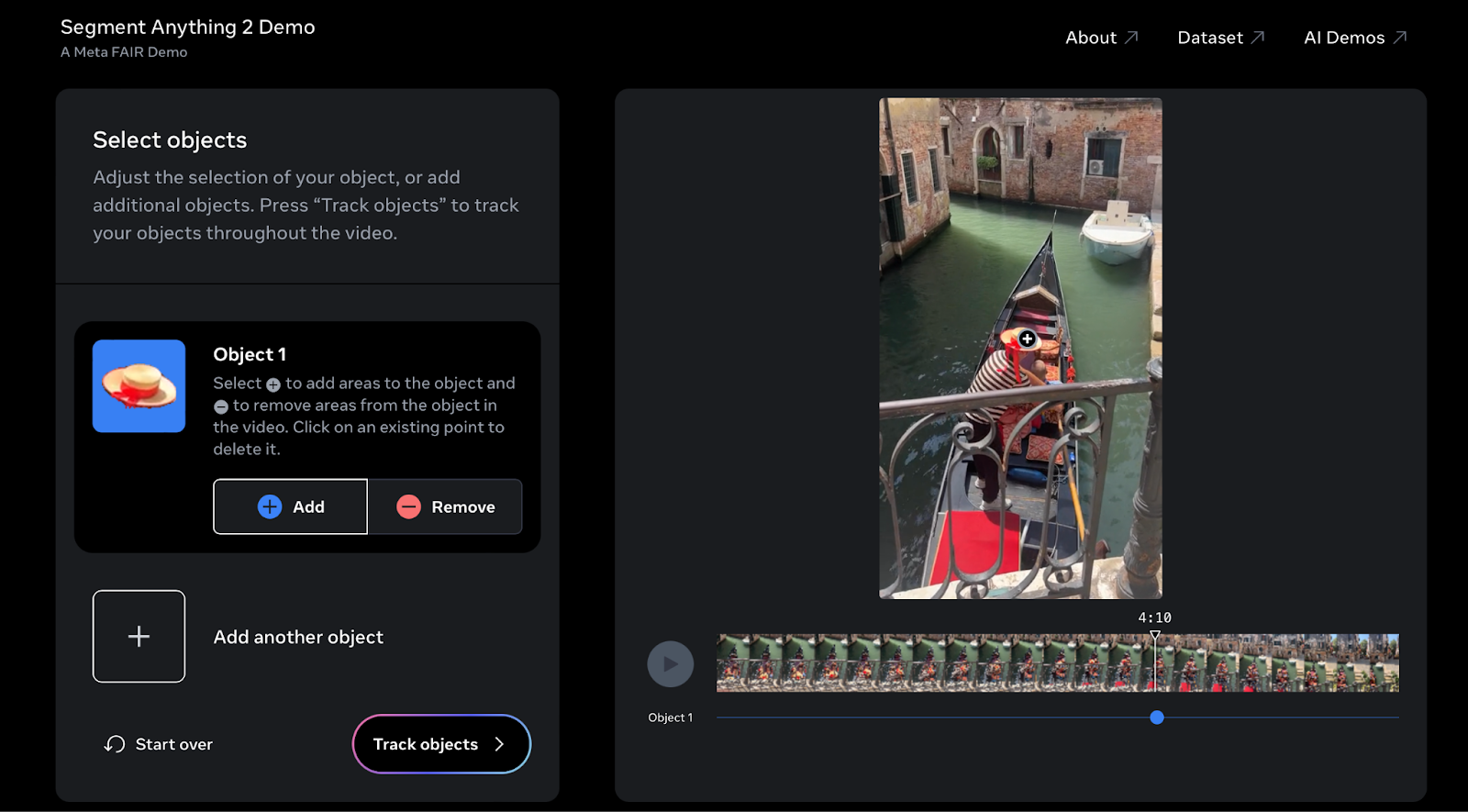

Sin embargo, si quieres probar SAM2, puedes probar la demo interactiva aquí.

Probé SAM 2 en un vídeo de mis últimas vacaciones en Venecia. Puedes probarlo con tus propios vídeos para seleccionar y seguir fácilmente objetos a lo largo de tus secuencias.

SAM 2: Recursos adicionales

Para una comprensión más profunda de la arquitectura, el proceso de entrenamiento y las aplicaciones del modelo, puedes acceder al documento oficial de investigación. El documento ofrece una visión detallada de las innovaciones que hay detrás de SAM 2.

Si quieres profundizar en SAM 2, hay muchos recursos disponibles para ayudarte. Puedes encontrar documentación oficial, tutoriales y mucho más en el sitio web de sitio web de Meta AI. Está repleto de todo lo que necesitas, desde detalles sobre la arquitectura del modelo hasta guías de aplicación paso a paso.

La comunidad también participa activamente en la mejora de SAM 2 contribuyendo a sus proyectos de código abierto. Mantenerse conectado con las últimas actualizaciones y formar parte de la comunidad puede ayudar a dar forma al futuro de SAM 2 y aprovechar sus nuevas funciones a medida que vayan apareciendo.

Para estar al tanto de todas estas actualizaciones, es una buena idea seguir el blog de Meta AI y consultar su repositorio repositorio GitHub con regularidad. Estas plataformas ofrecen noticias sobre nuevas funciones, aplicaciones en el mundo real e incluso adelantos de lo que está por venir. Estar informado no sólo te ayuda a sacar el máximo partido de SAM 2, sino que también te da la oportunidad de contribuir a su evolución.

SAM 2: Consideraciones éticas

Como con cualquier tecnología potente, tenemos que pensar cuidadosamente cómo utilizamos SAM 2. Como se basa en grandes conjuntos de datos, existe un riesgo de sesgo en sus prediccionesque es algo de lo que debemos cuidarnos, especialmente en áreas sensibles como la vigilancia y los vehículos autónomos.

También existen cuestiones de privacidad que hay que tener en cuenta, sobre todo en lo que respecta a cómo podría utilizarse SAM 2 para controlar o seguir a las personas. Para asegurarse de que SAM 2 se utiliza de forma responsable, es importante mantener debates abiertos y establecer directrices éticas claras. Esto ayudará a garantizar que SAM 2 se utiliza de forma beneficiosa y justa para todos.

También es importante recordar que los modelos de IA como SAM 2 sólo son tan buenos como los datos con los que se entrenan. Esto hace que sea crucial utilizar conjuntos de datos diversos y equilibrados para entrenar a SAM 2, minimizando el riesgo de resultados injustos.

La evaluación continua y la transparencia sobre cómo se utiliza SAM 2 también serán fundamentales para mantener la confianza pública y garantizar que esta tecnología se aplica de forma que respete los derechos de las personas y mejore el bienestar de la sociedad.

Conclusión

Segment Anything Model 2 (SAM 2) está causando un gran impacto en el mundo de la visión por ordenador, ya que ofrece funciones avanzadas de segmentación tanto para imágenes como para vídeos.

Su capacidad para rastrear objetos en tiempo real, combinada con una precisión mejorada y técnicas de aviso fáciles de usar, la convierten en una herramienta valiosa en diversas industrias.

A medida que SAM 2 sigue desarrollándose, abre nuevas oportunidades en el diseño creativo, la investigación científica y mucho más. Al ofrecer una demostración interactiva y acceso de código abierto al modelo y a su amplio conjunto de datos de entrenamiento, Meta AI fomenta la innovación y la colaboración dentro de la comunidad de la IA, sentando las bases para futuros avances en la comprensión visual y las aplicaciones interactivas.

Preguntas frecuentes

¿Cómo gestiona SAM 2 los casos de segmentación ambigua en los que varios objetos pueden compartir límites similares?

SAM 2 predice múltiples máscaras en cada paso cuando encuentra ambigüedad, como cuando un objeto comparte límites con otros objetos. Si las indicaciones adicionales no resuelven la ambigüedad, el modelo selecciona la máscara con la mayor Intersección sobre la Unión (IoU) prevista para su propagación en el vídeo, garantizando que se mantenga la segmentación más precisa en todo momento.

¿Qué mecanismos específicos de atención utiliza SAM 2 para mejorar la precisión de la segmentación en los vídeos?

SAM 2 utiliza mecanismos de autoatención y de atención cruzada en su módulo de atención a la memoria. Estos mecanismos permiten al modelo centrarse en los fotogramas pasados relevantes almacenados en el banco de memoria, mejorando la precisión de la segmentación de objetos en secuencias de vídeo complejas, sobre todo cuando los objetos sufren transformaciones u oclusiones.

¿Cómo equilibra el banco de memoria de SAM 2 el contexto temporal y la eficiencia computacional?

El banco de memoria de SAM 2 está diseñado con una cola FIFO (First In, First Out) para gestionar el almacenamiento de memorias de hasta N tramas recientes. Este planteamiento equilibra la necesidad de contexto temporal conservando la información esencial de los fotogramas recientes, al tiempo que mantiene la eficiencia computacional, asegurándose de que el modelo no se vea abrumado por demasiados datos.

¿Qué tipo de codificación posicional utiliza SAM 2 para mantener la precisión espacial en la segmentación de vídeo?

SAM 2 emplea la Incrustación Posicional Rotativa 2D (RoPE) en sus capas de atención a la memoria. Este tipo de codificación ayuda a mantener la precisión espacial a través de los fotogramas, garantizando que las relaciones posicionales entre los objetos y sus entornos se representen de forma coherente, aunque los objetos se muevan o cambien de forma.

¿Cómo garantiza SAM 2 la equidad entre distintos grupos demográficos en las tareas de segmentación de vídeo?

Se ha evaluado la equidad de la SAM 2 entre grupos demográficos utilizando el conjunto de datos Ego-Exo4D, que incluye información demográfica autodeclarada. El modelo muestra discrepancias mínimas de rendimiento entre los grupos de sexo y edad al utilizar indicaciones de 3 clics o máscaras de verdad, lo que garantiza un rendimiento equitativo en las distintas poblaciones.