Programa

Inteligência artificial generativa (também conhecida como IA generativa ou GenAI) é uma subcategoria da IA que se concentra na criação de novos conteúdos, como texto, imagem ou vídeo, usando várias tecnologias de IA.

À medida que a GenAI avança, ela se espalha por muitos outros campos da tecnologia, como o desenvolvimento de software. Um amplo conhecimento dos seus fundamentos continuará a ser cada vez mais relevante nessas áreas.

Para funções como cientistas de dadose profissionais de machine learninge engenheiros de IA, a IA generativa é um assunto super importante pra entender direito.

Aqui estão 30 perguntas sobre GenAI que podem te fazer numa entrevista.

Obtenha uma das melhores certificações de IA

Perguntas básicas para entrevistas sobre IA generativa

Vamos começar com algumas perguntas básicas sobre IA generativa para entrevistas. Isso vai testar o quanto você entendeu os conceitos e princípios básicos.

Quais são as principais diferenças entre modelos discriminativos e generativos?

Os modelos discriminativos aprendem a linha divisória entre as classes e os padrões que as diferenciam. Eles calculam a probabilidade P(y|x), que é a chance de um rótulo específico y, considerando os dados de entrada x. Esses modelos se concentram em distinguir entre diferentes categorias (por exemplo,“Este e-mail é spam?”).

Os modelos generativos aprendem a distribuição dos dados modelando a probabilidade conjunta P(x,y), que envolve a amostragem de pontos de dados dessa distribuição. Depois de ser treinado com milhares de imagens de dígitos, essa amostragem pode criar uma nova imagem de um dígito.

Leia mais neste blog em Modelos generativos vs. discriminativos: Diferenças e casos de uso.

O que são tokens e embeddings no contexto dos Modelos de Linguagem Grande (LLMs)?

Os tokens são as unidades básicas de texto que um LLM processa; podem ser palavras inteiras, sílabas ou até letras individuais (por exemplo, a palavra “generative” pode ser dividida em “gener”, “at”, “ive”).

Embeddings são representações numéricas vetoriais desses tokens que os colocam em um espaço multidimensional com base em seu significado. Essa conversão permite que o modelo capte o significado semântico e entenda as relações entre as palavras, por exemplo, reconhecendo que “rei” está próximo de “rainha”.

Você pode explicar os princípios básicos por trás das Redes Adversárias Generativas (GANs)?

As GANs são feitas de duas redes neurais que competem entre si (daí o nome Adversarial): um gerador e um discriminador.

O gerador cria amostras de dados falsos enquanto o discriminador os avalia em relação aos dados de treinamento reais. As duas redes são treinadas ao mesmo tempo:

- O gerador quer criar imagens tão parecidas com os dados reais que o discriminador não consegue perceber a diferença.

- O discriminador quer descobrir com precisão se uma imagem é real ou gerada.

Com esse aprendizado competitivo, o gerador fica craque em criar dados super realistas, parecidos com os dados de treinamento.

Quais são algumas das aplicações populares da IA generativa no mundo real?

- Geração de texto: Usado em chatbots, criação de conteúdo ou tradução (chatGPT, Claude, Gemini).

- Geração de imagens: Produzindo imagens realistas para arte ou design (por exemplo, chatGPT Images, Nano Banana Pro, Stable Diffusion).

- Agentes de codificação: Escrever módulos de código inteiros, usados na engenharia de software.

- Geração aumentada por recuperação (RAG): Recuperação de conhecimento empresarial, usada no atendimento ao cliente ou para wikis internos.

- Descoberta de medicamentos: Criando novas estruturas moleculares para medicamentos.

- Aumento de dados: Expandindo conjuntos de dados com poucos dados para machine learning.

Quais são alguns dos desafios associados ao treinamento e à avaliação de modelos de IA generativa?

- Custo computacional: Alto de computação e requisitos de hardware para treinar modelos mais complexos.

- Complexidade do treinamento: Treinar modelos generativos pode ser complicado e cheio de detalhes.

- Métricas de avaliação: É complicado avaliar quantitativamente a qualidade e a diversidade dos resultados do modelo.

- Requisitos de dados: Os modelos generativos geralmente precisam de um monte de dados de alta qualidade e diversidade. A coleta desses dados pode ser demorada e cara.

- Preconceito e justiça: Modelos não verificados podem aumentar os preconceitos presentes nos dados de treinamento, levando a resultados injustos.

Quais são algumas considerações éticas em torno do uso da IA generativa?

O uso generalizado da GenAI e seus casos de uso exigem uma avaliação cuidadosa do desempenho em termos de ética. Alguns exemplos incluem:

- Deepfakes: Criar mídia falsa, mas hiper-realista, pode espalhar desinformação ou difamar pessoas.

- Geração tendenciosa: Amplificando preconceitos históricos e sociais nos dados de treinamento.

- Propriedade intelectual: Uso não autorizado de material protegido por direitos autorais nos dados.

Como a IA generativa pode ser usada para aumentar ou melhorar a criatividade humana?

Embora as alucinações dos modelos de IA possam gerar resultados errados, esses modelos generativos são úteis em muitos aspectos e usos. Eles podem servir de inspiração criativa para especialistas em várias áreas:

- Arte e design: Oferecendo inspiração em arte e design.

- Ajuda com a redação: Sugerir títulos e escrever ideias ou completar textos.

- Música: Compondo batidas e harmonias.

- Programação: Otimizar o código que já existe ou dar dicas de como resolver um problema de implementação.

Qual é a diferença entre um modelo básico e um modelo ajustado?

Um modelo básico (como o GPT-5.2) é treinado com um monte de dados da internet pra aprender padrões gerais, raciocínio e estrutura da linguagem.

Um modelo ajustado pega essa base geral e treina ainda mais em um conjunto de dados menor e selecionado para dominar uma tarefa específica, como diagnóstico médico ou falar em uma linguagem de codificação específica. O aperfeiçoamento troca uma grande versatilidade por um conhecimento mais profundo em uma área específica.

Perguntas de entrevista sobre IA generativa intermediária

Agora que já falamos sobre o básico, vamos ver algumas perguntas intermediárias sobre IA generativa para entrevistas.

O que é “Mode Collapse” em GANs e como lidamos com isso?

Assim como um criador de conteúdo que descobre que um certo formato de vídeo gera mais alcance e interações, o modelo generativo de uma GAN pode acabar ficando preso a uma diversidade limitada de resultados que enganam o modelo discriminador. Isso faz com que o gerador produza um pequeno conjunto de resultados, prejudicando a diversidade e a flexibilidade dos dados gerados.

Algumas soluções possíveis pra isso podem ser focar em técnicas de treinamento, ajustando os hiperparâmetros e vários algoritmos de otimização, aplicando regularizações que promovam a diversidade ou combinando vários geradores pra cobrir diferentes modos de gerar dados.

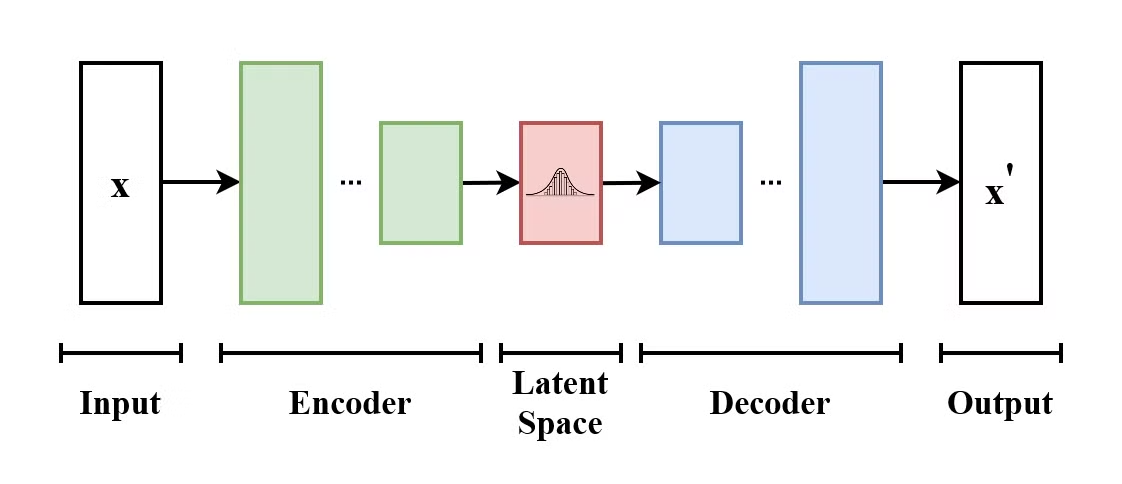

Como funciona um Autoencoder Variacional (VAE)?

Um Autoencoder Variacional (VAE) é um tipo de modelo generativo que aprende a codificar dados de entrada em um espaço latente e decodificá-los de volta para reconstruir os dados de entrada originais. VAEs são modelos codificadores-decodificadores:

- O codificador mapeia os dados de entrada para uma distribuição no espaço latente.

- O decodificador amostras dessa distribuição do espaço latente reconstruem os dados de entrada.

A estrutura de um Autoencoder Variacional. (Fonte: Wikimedia Commons)

O que faz os VAEs diferentes dos autoencoders tradicionais é que o VAE incentiva o espaço latente a seguir uma distribuição conhecida (como a gaussiana). Isso faz com que sejam mais úteis para gerar novos dados por meio da amostragem desse espaço latente.

Explique a diferença entre Retrieval-Augmented Generation (RAG) e ajuste fino. Quando você usaria um em vez do outro?

O RAG ( ) conecta um modelo a fontes de dados externas (como o wiki da sua empresa) para buscar informações atualizadas sem precisar treinar o modelo de novo. Os parâmetros do modelo continuam os mesmos; ele só tem acesso a dados adicionais.

O ajuste fino mexe nos pesos internos do modelo pra mudar como ele fala, age ou raciocina, mas não é legal pra adicionar novos conhecimentos factuais.

Use o RAG quando precisar de informações atualizadas (notícias, dados de empresas privadas) ou uma citação específica. Use o ajuste fino quando precisar que o modelo aprenda um novo “comportamento”, idioma ou formato de saída específico (por exemplo, falar em código SQL).

Como você avaliaria uma inscrição para um mestrado em Direito? Explique o que é “LLM como juiz”.

Avaliar as amostras geradas é uma tarefa complicada que depende do tipo de dados (imagem, texto, vídeo, etc.). Ttexto tradicional métricas, como a precisão, não são suficientes para tarefas criativas, porque só verificam a sobreposição de palavras, e não o significado.

Os benchmarks e rankings do LLM usam testes padronizados para medir o desempenho de um modelo em uma determinada tarefa. Eles são úteis para comparar modelos e para programar o progresso dentro ou entre modalidades.

LLM-as-a-Judge é uma estrutura de avaliação moderna em que um modelo “professor” super capaz (como o Gemini 3) avalia os resultados de um modelo menor com base em critérios específicos, incluindo fidelidade, utilidade e tom. Isso oferece uma maneira escalável de aproximar as preferências humanas sem a lentidão e o custo da revisão manual.

Quais são algumas técnicas para melhorar a estabilidade e a convergência do treinamento GAN?

Melhorar a estabilidade e a convergência do treinamento GAN é importante para evitar o colapso do modo, garantir um treinamento eficiente e alcançar bons resultados. Aqui estão algumas técnicas para melhorar a estabilidade e a convergência do treinamento GAN:

- GAN de Wasserstein (WGAN): Usa a distância de Wasserstein como função de perda, melhorando a estabilidade do treinamento e proporcionando gradientes mais suaves.

- Regra de atualização de duas escalas de tempo (TTUR): Usando taxas de aprendizagem separadas para o gerador e o discriminador.

- Suavização de etiquetas: Suaviza os rótulos para evitar excesso de confiança.

- Taxas de aprendizagem adaptativas: Usando otimizadores como o Adam para ajudar a gerenciar a taxa de aprendizagem de forma dinâmica.

- Penalidade de gradiente: Pune grandes gradientes no discriminador para garantir uma continuidadeLipschitz e e para um treinamento mais estável.

Como você pode controlar o estilo ou os atributos do conteúdo gerado usando modelos de IA generativa?

Tem várias técnicas comuns pra controlar o estilo das saídas da GenAI:

- Engenharia rápida: Especifique o estilo de saída desejado, fornecendo instruções detalhadas destacando o estilo ou o tom da geração de conteúdo. Esse é um jeito simples e eficaz tanto em modelos texto-texto quanto texto-imagem. É um método muito mais eficaz se você fizer isso de acordo com os requisitos específicos ou a documentação do modelo em questão.

- Controle de temperatura e amostragem: O parâmetro“ ” (Temperatura de aleatoriedade) do “ ” controla o quão aleatórias serão as saídas. Temperaturas mais baixas significam uma seleção de tokens mais conservadora e previsível, enquanto temperaturas mais altas permitem uma geração mais criativa. Outros parâmetros, como top-k e top-p, também podem controlar a criatividade com que o modelo seleciona os próximos tokens possíveis durante a geração.

- Resultados estruturados: Para a estrutura, os modelos modernos usam o “Modo JSON” ou “Saídas Estruturadas”, que fazem com que o modelo gere apenas esquemas JSON ou XML válidos, em vez de texto livre.

- Mensagens do sistema: As solicitações do sistema são enviadas junto com cada nova mensagem para o modelo. Eles podem ser usados para definirinstruções comportamentais persistentes de que substituem as entradas do usuário para manter personas ou regras específicas.

- Transferência de estilo (Imagens): Outra técnica que pode ser usada durante a inferência para os modelos compatíveis é aplicar o estilo de uma imagem (imagem de referência) a uma imagem de entrada.

- Ajustes finos: A gente pode usar um modelo pré-treinado e ajustá-lo em um conjunto de dados específico que tenha o estilo ou tom que a gente quer. Isso significa treinar o modelo ainda mais com dados adicionais para aprender estilos ou atributos específicos adicionais.

- Aprendizado por reforço: A gente pode orientar o modelo a preferir certos resultados e evitar outros, dando feedback. Esse feedback vai ser usado pra modificar o modelo por meio do aprendizado por reforço. Com o tempo, o modelo vai se ajustar às preferências dos usuários e/ou aos conjuntos de dados de preferências. Um exemplo disso, no contexto dos LLMs, é o aprendizado por reforço a partir do feedback humano (RLHF).

Quais são algumas maneiras de resolver o problema do viés nos modelos de IA generativa?

Garantir que o modelo seja imparcial e justo requer ajustes e monitoramento contínuos em cada fase.

Primeiro, é preciso evitar a contaminação dos dados, garantindo que nenhum dado de teste vaze para os dados de treinamento. Nesse caso, o modelo seria treinado para memorizar os dados, em vez de generalizá-los.

Além disso, temos que garantir que os dados de treinamento sejam o mais variados e inclusivos possível. Durante o treinamento, podemos orientar o modelo para uma geração mais justa, incorporando objetivos de justiça na função de perda.

Os resultados do modelo devem ser monitorados regularmente para verificar se há algum viés. Para ganhar a confiança do público, é legal deixar o processo de tomada de decisão do modelo, os detalhes do conjunto de dados e as etapas de pré-processamento o mais transparentes possível.

Você pode falar sobre o conceito de “Espaço Latente” nos modelos generativos e sua importância?

No contexto dos modelos generativos, o espaço latente é um espaço de dimensão inferior que capta as características essenciais dos dados de forma que entradas semelhantes sejam mapeadas mais próximas umas das outras. A amostragem desse espaço latente permite que os modelos criem novos dados e mexam em atributos ou características específicas (gerando variações de imagens).

Os espaços latentes são essenciais para gerar resultados que sejam controláveis, fiéis aos dados de treinamento e diversificados.

Qual é o papel do aprendizado auto-supervisionado no desenvolvimento de modelos de IA generativa?

A ideia principal por trás do aprendizado auto-supervisionado é usar um monte de dados sem rótulos para aprender representações úteis sem precisar rotular manualmente. Modelos como BERT e GPT são treinados por métodos auto-supervisionados, como previsão do próximo token e aprendizado da estrutura e da semântica das línguas. Isso reduz a dependência de dados rotulados, que são caros e demorados de se obter, permitindo essencialmente que os modelos aproveitem vastos conjuntos de dados não rotulados para treinamento.

O que é Adaptação de Baixo Rank (LoRA)?

Treinar de novo um modelo enorme com 70 bilhões de parâmetros é muito caro e demorado para a maioria das organizações. A Adaptação de Baixo Rank (LoRA) resolve isso congelando os pesos do modelo principal e treinando apenas uma pequena camada “adaptadora” (geralmente menos de 1% do total de parâmetros) que fica na parte superior. Isso permite que você ofereça várias versões “personalizadas” a partir de um único modelo básico, reduzindo bastante o custo computacional e as necessidades de armazenamento.

Perguntas avançadas sobre IA generativa para entrevistas

Pra quem tá procurando cargos mais seniores ou quer mostrar que entende bem de IA Generativa, vamos ver algumas perguntas avançadas pra entrevista.

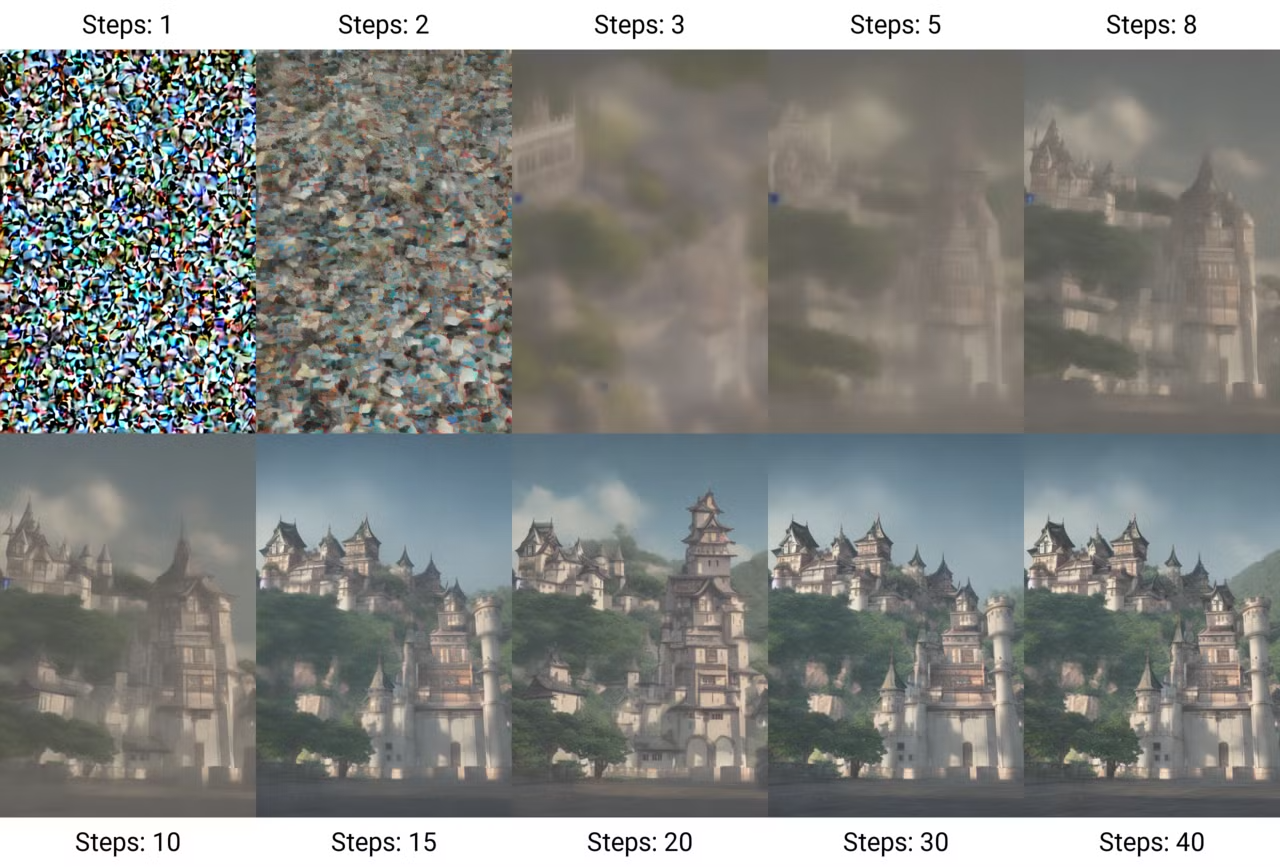

Explique o conceito de “Modelos de Difusão” e como eles são diferentes das arquiteturas mais antigas.

Os modelos de difusão funcionam principalmente adicionando ruído gradualmente a uma imagem até que só reste ruído — e, em seguida, aprendendo como reverter esse processo para gerar novas amostras a partir do ruído. Esse processo é chamado dedifusão e e. Esses modelos ficaram famosos por conseguirem imagens de alta qualidade e superdetalhadas.

Criação de uma imagem por meio de etapas de difusão. (Fonte: Wikimedia Commons)

O processo de treinamento desses modelos tem duas etapas:

- O processo de avanço (difusão): Pegando uma imagem de entrada e adicionando ruído aos poucos, em várias etapas, até que os dados se transformem em puro ruído.

- O processo inverso (remoção de ruído): Aprendendo a recuperar os dados originais a partir do ruído. Isso é feito treinando uma rede neural para prever o que é o ruído e, em seguida, removendo o ruído da imagem passo a passo até que os dados originais sejam recuperados do ruído.

Diferente das GANs mais antigas, que muitas vezes tinham problemas de instabilidade no treinamento, os modelos de difusão são mais estáveis e escaláveis, embora possam ser mais lentos por causa da sua natureza iterativa.

Variantes modernas, como a difusão latente, funcionam num “espaço latente” compactado para acelerar a geração, e as arquiteturas de correspondência de fluxo estão agora substituindo a difusão padrão para um desempenho ainda melhor.

Como funciona a arquitetura Transformer e qual é o seu principal gargalo?

A arquitetura do transformador apresentada no artigo “Attention is All You Need”, revolucionou o campo da IA generativa, especialmente no processamento de linguagem natural (NLP).

Diferente das redes neurais recorrentes (RNNs) tradicionais, que processam dados de forma sequencial, os transformadores usam o mecanismo de autoatenção para atribuir pesos a diferentes partes dos dados de entrada ao mesmo tempo. Isso permite que o modelo capte relações contextuais de forma eficaz e possibilita o processamento paralelo de sequências, o que acelera significativamente o treinamento.

O principal problema é que esse mecanismo de atenção cresce de forma quadrática com o comprimento da sequência — dobrar a janela de contexto exige quatro vezes mais computação. Isso torna o “contexto infinito” teoricamente possível, mas computacionalmente caro, levando a pesquisas sobre métodos de atenção mais eficientes.

O que é um “Modelo de Raciocínio” (pensamento do Sistema 2) e como ele é diferente de um LLM padrão?

Os LLMs padrão funcionam como pensadores do “Sistema 1”, prevendo a próxima palavra imediatamente com base em padrões superficiais.

Modelos de raciocínio (como Gemini 3 ou DeepSeek-R1) são treinados para criar uma “cadeia de pensamentos” escondida antes de dar uma resposta, o que permite que eles “pensem”, planejem e corrijam seus próprios erros. Isso faz com que eles sejam bem melhores em matemática complexa, programação e quebra-cabeças lógicos, embora sejam mais lentos e caros de operar.

Você pode falar sobre os desafios de criar conteúdo de alta resolução ou longo formato usando IA generativa?

À medida que você aumenta a complexidade da geração de IA, você também deve lidar com:

- Custo computacional: Saídas de alta resolução exigem redes maiores e mais poder computacional.

- Treinamento com várias GPUs: Modelos maiores podem não caber em uma única GPU, exigindo treinamento com várias GPUs. As plataformas online podem ajudar a simplificar a implementação desses sistemas.

- Estabilidade do treinamento: Redes maiores e arquiteturas mais complexas tornam mais difícil manter um procedimento de treinamento estável.

- Qualidade dos dados: Conteúdos com resolução mais alta e formato mais longo precisam de dados de melhor qualidade.

Quais são algumas das tendências e direções de pesquisa que estão surgindo no campo da IA generativa?

O campo da GenAI está evoluindo e se transformando rapidamente. Isso inclui:

- Modelos multimodais: Integrando vários formatos de dados, como texto, áudio e imagens.

- Modelos de linguagem pequenos (SLMs): Diferente dos grandes modelos de linguagem, os SLMs estão ficando mais populares por causa da eficiência e adaptabilidade deles. Esses modelos exigem menos recursos computacionais, o que os torna adequados para implantação em ambientes com recursos limitados — leia mais neste blog sobre IA de ponta.

- , especialista em IA ética: Desenvolvendo estruturas para garantir o desempenho alinhado dos modelos generativos.

- Modelos generativos para vídeo: Avanços na geração de vídeos super realistas e consistentes através da GenAI. Os exemplos mais recentes incluem Sora AI, Meta Movie Gene Runway Act-One.

Como você criaria um sistema pra usar IA generativa pra fazer conteúdo personalizado em um setor específico, tipo saúde?

Projetar um sistema que usa IA generativa para casos de uso específicos do setor é uma abordagem completa. As diretrizes gerais também podem ser ajustadas e modificadas em outros setores.

- Entendendo as necessidades do setor: O conhecimento do setor tem um efeito importante nas decisões que levam ao projeto desse tipo de sistema. O primeiro passo é aprender um pouco sobre o setor, os fundamentos, conceitos, objetivos e requisitos.

- Coleta e gerenciamento de dados: Identifique possíveis fornecedores de dados. Na área da saúde, isso significa coletar dados de profissionais de saúde sobre detalhes de tratamentos, informações de pacientes, diretrizes médicas, etc. As diretrizes específicas do setor dePrivacidade e Segurança de Dados Data Privacy and Security devem ser identificadas e respeitadas. Garanta que os dados sejam de alta qualidade, precisos, atualizados e também representativos dos diversos grupos.

- Seleção do modelo: Decida se você quer ajustar modelos pré-treinados ou criar suas arquiteturas do zero. Dependendo do tipo de projeto, os modelos de IA generativa ideais podem variar. Um modelo como o GPT-4o pode ser uma boa opção plug-and-play. Alguns domínios podem precisar de modelos hospedados localmente por motivos de privacidade. Nesse caso, os modelos de código aberto são a melhor opção. Pense em ajustar esses modelos com base nos dados específicos do setor que você coletou antes.

- Validação da saída: Implementar um processo de avaliação completo, onde os especialistas e profissionais validam o conteúdo gerado antes de ser colocado em prática.

- Escalabilidade: Crie uma infraestrutura baseada em nuvem escalável para lidar com as cargas necessárias sem prejudicar o desempenho.

- Considerações legais e éticas: Defina diretrizes éticas claras para o uso da IA e comunique as possíveis limitações do seu modelo de forma transparente. Respeite os direitos de propriedade intelectual e resolva qualquer problema relacionado a eles.

- Melhoria contínua: Dá uma olhada regularmente no desempenho do sistema e na avaliação dos especialistas sobre o conteúdo gerado. Reúna mais insights e dados para modificar o modelo para melhor.

Explique o conceito de “aprendizagem em contexto” no contexto dos LLMs.

A aprendizagem contextual refere-se à capacidade dos LLMs de modificar seu estilo e resultados com base no contexto fornecido, sem a necessidade de ajustes adicionais.

Também pode ser chamado de aprendizado com poucos exemplos ou engenharia de prompt. Isso pode ser feito especificando um ou vários exemplos da resposta desejada ou descrevendo claramente como o modelo deve se comportar.

A aprendizagem contextual também tem suas limitações. É de curto prazo e específico para cada tarefa, já que o modelo não retém nenhum conhecimento em outras sessões de uso dessa técnica.

Além disso, se o resultado esperado for complexo, o modelo pode precisar de um monte de exemplos. Se os exemplos fornecidos não forem claros o suficiente ou a tarefa for mais difícil do que o modelo consegue lidar, ele pode, às vezes, gerar resultados incorretos ou incoerentes.

Como as instruções podem ser estrategicamente projetadas para obter os comportamentos ou resultados desejados do modelo? Quais são algumas das melhores práticas para uma engenharia eficaz?

O prompt é importante para orientar os LLMs a responder a tarefas específicas. Prompts eficazes podem até diminuir a necessidade de ajustar modelos usando técnicas como aprendizado com poucos exemplos, decomposição de tarefas e modelos de prompts.

Algumas melhores práticas para uma engenharia eficaz e rápida incluem:

- Seja claro e direto: Dê instruções específicas para que o modelo saiba exatamente o que você quer que ele faça. Seja direto e vá direto ao ponto.

- Exemplos de uso: Para o aprendizado contextual, mostrar alguns pares de entrada-saída ajuda o modelo a entender a tarefa da maneira que você quer.

- Divida tarefas complexas em partes mais fáceis de lidar:: Se a tarefa for complicada, dividi-la em etapas menores pode melhorar a qualidade da resposta.

- Defina restrições ou formatos: Se você precisar de um estilo, formato ou comprimento específico para o resultado, deixe isso bem claro na solicitação.

Leia mais neste blog sobre Técnicas de otimização de prompt.

Quais são algumas técnicas para otimizar a velocidade de inferência dos modelos de IA generativa?

- Poda do modelo: Tirando pesos/camadas desnecessários pra diminuir o tamanho do modelo.

- Quantização: Reduzindo a precisão dos pesos do modelo para fp16/int8.

- Destilação de conhecimento: Treinar um modelo menor para imitar um maior.

- Aceleração por GPU: Usando hardware especializado.

Você pode explicar o conceito de “Geração Condicional” e como ele é aplicado em modelos como GANs Condicionais (cGANs)?

A geração condicional envolve o modelo gerando resultados com base em certas condições ou contextos. Isso permite um maior controle sobre o conteúdo gerado. Nas GANs condicionais (cGANs), tanto o gerador quanto o discriminador são condicionados por informações adicionais, como rótulos de classe. Funciona assim:

- Gerador: Recebe tanto ruído quanto informações condicionais (por exemplo, um rótulo de classe) para produzir dados que se alinham com a condição.

- Discriminador: Avalia a autenticidade dos dados gerados, considerando também as informações condicionais.

Você pode explicar a arquitetura Mixture of Experts (MoE)? Por que é preferível para modelos grandes?

A Mistura de Especialistas (MoE) substitui uma única rede neural densa por várias sub-redes “especializadas”. Para qualquer token, um roteador escolhe só os especialistas mais relevantes para processar os dados, ou seja, um modelo pode ter 100 bilhões de parâmetros, mas usar só 10 bilhões para inferência.

Essa arquitetura permite que os modelos sejam super inteligentes (alto número total de parâmetros), mas continuem rápidos e baratos de rodar (baixo número de parâmetros ativos).

Perguntas de entrevista sobre IA generativa para um engenheiro de IA

Se você estiver sendo entrevistado para uma vaga de engenheiro de IA com foco em IA generativa, espere perguntas que avaliem sua capacidade de projetar, implementar e implantar modelos generativos.

Qual é a diferença entre um fluxo de trabalho com agente e um chatbot padrão?

Um chatbot padrão é passivo: ele recebe uma pergunta e responde com um texto baseado no que aprendeu.

Um fluxo de trabalho agênico dá ao LLM acesso a ferramentas (como um navegador da web, interpretador de código ou API) e a autonomia para planejar um processo de várias etapas para resolver um objetivo. O agente pode planejar pesquisar na web, analisar os dados com código Python e, em seguida, escrever um relatório, repetindo o processo até que a tarefa seja concluída.

Como você garante a segurança e a robustez na implantação do LLM usando Guardrails?

Garantir a segurança e a robustez dos LLMs traz vários desafios. Um dos principais desafios é a possibilidade de gerar resultados prejudiciais ou tendenciosos, já que esses modelos são treinados com fontes de dados enormes ou até mesmo sem filtragem e podem produzir conteúdo tóxico ou enganoso.

Outro problema importante com o conteúdo gerado por LLM é o risco de alucinação, em que o modelo gera conteúdo que parece confiável, mas que, na verdade, contém informações incorretas. Outro desafio é a segurança contra prompts adversários que violam as medidas de segurança do modelo e produzem respostas prejudiciais ou antiéticas, como já foi comprovado várias vezes em relação a vários modelos.

Incorporar filtros de segurança e camadas de moderação pode ajudar a identificar e remover conteúdo prejudicial que está sendo gerado. A supervisão humana contínua melhora ainda mais a segurança do modelo.

Além disso, os engenheiros precisam implementar proteções explícitas (como NeMo Guardrails ou Llama Guard) que ficam entre o usuário e o modelo. Esses sistemas verificam as entradas para bloquear tentativas de injeção de prompt ou vazamento de PII (Informações de Identificação Pessoal) e verificam as saídas para detectar respostas tóxicas ou alucinatórias antes que elas cheguem ao usuário. Isso cria uma camada de segurança determinística que funciona de forma independente da natureza probabilística do modelo.

Conte sobre um projeto desafiador envolvendo IA generativa que você já enfrentou. Quais foram os principais desafios e como você os superou?

A resposta a essa pergunta depende muito dos seus projetos e experiências. Mas dá pra ter isso em mente quando responder perguntas assim:

- Escolha um projeto específico com desafios claros de IA, como viés, precisão do modelo ou alucinação.

- Explique o desafio e explique a dificuldade técnica ou operacional.

- Mostre sua abordagem mencionando as principais estratégias que você usou, como aumento de dados, ajuste de modelos ou colaboração com especialistas.

- Destaque os resultados e quantifique o impacto — maior precisão, melhor engajamento do usuário ou resolução de um problema de negócios.

Você pode falar sobre sua experiência com a implementação e implantação de modelos de IA generativa em ambientes de produção?

Assim como a pergunta acima, essa pergunta pode ser respondida com base na sua experiência, mas também tendo em mente que:

- Foco na implantação: Fala sobre infraestrutura (nuvem serviços, MLOps ) e as principais tarefas de implantação (escalonamento, otimização de baixa latência). Não precisa entrar em detalhes. Basta mostrar que você está no topo do jogo.

- Mencione um desafio: Vale a pena mencionar um ou dois desafios comuns que devem ser evitados, para mostrar sua experiência.

- : Inclua estratégias de monitoramento e manutenção para garantir um desempenho consistente.

- Endereço de segurança: Fale sobre as medidas tomadas para lidar com preconceitos ou segurança durante a implementação.

Como você lida com o fenômeno de “perda no meio” em janelas de texto longo?

Mesmo com janelas de contexto enormes (por exemplo, 1 milhão de tokens), os LLMs muitas vezes têm dificuldade em recuperar informações escondidas no meio do prompt, priorizando o início e o fim.

Os engenheiros resolvem isso usando algoritmos inteligentes de reclassificação que movem os trechos mais importantes para o começo ou o fim da janela de contexto. Outra estratégia é o algoritmo “map-reduce”, em que o modelo resume partes do documento longo de forma independente antes de juntá-las para chegar a uma resposta final.

Como você abordaria a tarefa de construir um sistema RAG completo?

Construir um sistema RAG precisa de uma abordagem sistemática. Aqui está como o pipeline poderia ser:

- Divisão eficaz em partes: Use estratégias semânticas ou recursivas para dividir documentos em partes que façam sentido (em vez de contar caracteres aleatoriamente) para garantir que o contexto seja mantido.

- Armazenamento vetorial: Incorpore esses trechos usando um modelo de incorporação de alto desempenho e guarde-os em um banco de dados vetorial, juntando metadados ricos (como datas ou autores) para pré-filtragem.

- Pesquisa híbrida: Implemente uma camada de recuperação que combine a pesquisa por palavra-chave (BM25) para correspondências exatas com a pesquisa vetorial (similaridade semântica) para capturar tanto termos específicos quanto conceitos mais amplos.

- Reclassificação: Use um modelo de codificador cruzado para reavaliar os principais resultados recuperados, filtrando agressivamente os pedaços de “ruído” irrelevantes antes que eles cheguem ao LLM.

- Citação e geração: Peça ao LLM para gerar respostas com base estritamente no contexto fornecido e exija que ele cite documentos de origem específicos para evitar alucinações.

Quais são algumas das questões ou áreas de pesquisa em aberto que você acha mais interessantes no campo da IA generativa?

A resposta depende também das suas preferências pessoais, mas aqui estão alguns tópicos que você pode mencionar:

- Melhorando a interpretabilidade do modelo: Tornando os modelos generativos mais transparentes e fáceis de entender.

- Estruturas éticas: Criando diretrizes para uma IA responsável.

- Geração multimodal: Criando conteúdo usando vários tipos de dados (imagem, texto, etc.).

- Robustez adversária: Tornando os modelos resistentes a ataques adversários.

- Capacidades de raciocínio: Aumentando a capacidade de raciocínio dos LLMs.

Conclusão

Como a IA generativa está encontrando maneiras de influenciar vários aspectos de nossas vidas e carreiras, é vital manter um olhar curioso sobre os tópicos essenciais. Embora as possíveis perguntas sobre IA genérica que podem ser feitas durante uma entrevista dependam da função e da empresa específicas, tentei selecionar 30 perguntas e respostas para ajudá-lo a começar a se preparar para a entrevista.

Pra ver mais perguntas de entrevista, recomendo esses blogs:

Estudante de mestrado em Inteligência Artificial e redatora técnica de IA. Compartilho insights sobre a mais recente tecnologia de IA, tornando a pesquisa de ML acessível e simplificando tópicos complexos de IA necessários para manter você na vanguarda.