Kurs

Automatisiertes maschinelles Lernen (AutoML) wird oft falsch verstanden.

Viele Leute in der Tech-Branche denken, dass AutoML-Tools nur für Geschäftsleute oder nicht-technische Teams gedacht sind, die nicht verstehen, , wie Machine-Learning-Modelle trainiert oder eingesetzt werden. Diese Annahme ist falsch.

In der Praxis nutzen Datenwissenschaftler und Machine-Learning-Ingenieure regelmäßig AutoML-Frameworks, um die Experimentierzeit zu verkürzen, die Modellleistung zu verbessern und sich wiederholende Phasen des Machine-Learning-Lebenszyklus zu automatisieren.

Diese AutoML-Tools helfen bei Sachen wie Feature Engineering, Modellauswahl, Hyperparameter-Optimierung und der Automatisierung der ganzen Pipeline, sodass sich die Teams auf wichtigere Aufgaben konzentrieren können.

In diesem Artikel schaue ich mir ein paar der besten AutoML-Frameworks an, die es gerade gibt und die für Leute mit unterschiedlichen Kenntnissen gemacht sind. Die Tools sind in drei übersichtliche Kategorien eingeteilt:

- Open-Source-Frameworks

- Keine Code- und Low-Code-Plattformen

- AutoML-Lösungen für Unternehmen

Für jedes Framework zeigen wir die wichtigsten Funktionen und geben Beispielcode, damit du sofort loslegen kannst.

Was sind AutoML-Frameworks?

AutoML sind Tools und Systeme, die den ganzen Prozess der Entwicklung von Machine-Learning-Modellen automatisieren, von den Rohdaten bis hin zu einem trainierten, einsatzbereiten Modell.

AutoML-Frameworks übernehmen viele der sich wiederholenden und technischen Aufgaben beim Erstellen von Machine-Learning-Modellen, sodass sowohl erfahrene Praktiker als auch weniger technisch versierte Nutzer effizienter arbeiten können.

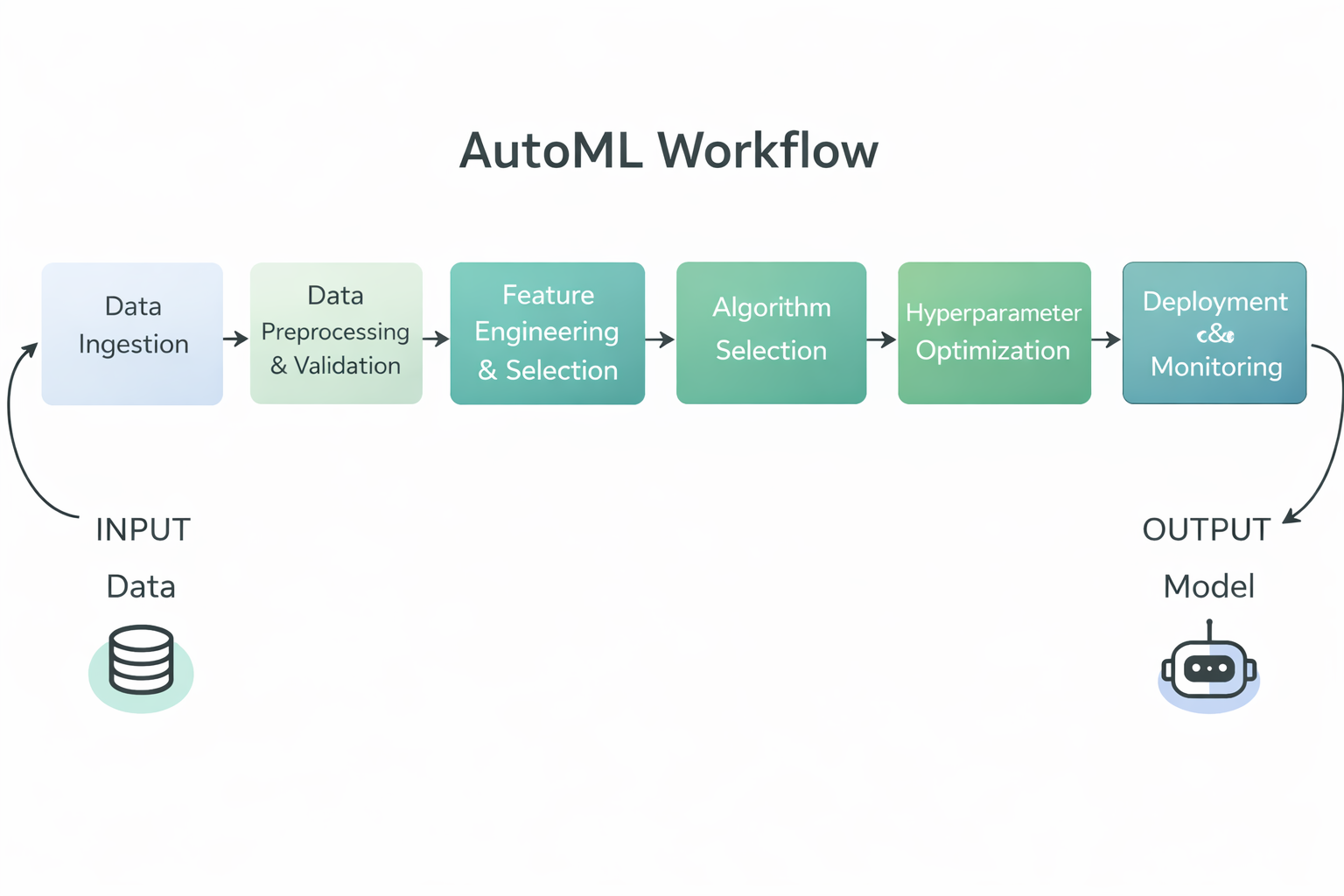

AutoML-Workflow-Diagramm

Genauer gesagt, automatisieren AutoML-Frameworks normalerweise die folgenden Schritte im Machine-Learning-Workflow:

- Datenvorbereitung und -validierung, einschließlich Bereinigung, Normalisierung und Formatierung der Rohdaten für das Training.

- Feature Engineering und Auswahl, bei dem automatisch aussagekräftige Eingabevariablen erstellt oder ausgewählt werden.

- Algorithmusauswahl, bei der mehrere Modelltypen getestet werden, um das für das Problem am besten geeignete zu finden.

- Hyperparameter-Optimierung, also das Einstellen von Modellparametern, um die Leistung zu verbessern, ohne dass man das manuell ausprobieren muss.

- Modellbewertung und -rangliste, bei dem trainierte Modelle anhand wichtiger Kennzahlen verglichen werden, um das leistungsstärkste Modell zu ermitteln.

- Unterstützung bei der Bereitstellung und Überwachung auf Unternehmensplattformen, damit Teams Modelle in großem Maßstab umsetzen können.

Durch die Automatisierung dieser Aufgaben sparen AutoML-Frameworks manuelle Arbeit, machen die Ergebnisse konsistenter und besser reproduzierbar und helfen sowohl Technikern als auch Nicht-Technikern, schnellere und hochwertigere Machine-Learning-Modelle zu entwickeln.

Open-Source-AutoML-Frameworks

Open-Source-AutoML-Frameworks bieten flexible, transparente und entwicklerfreundliche Tools, mit denen man die Modellerstellung automatisieren kann, während man die volle Kontrolle über Daten, Pipelines und Bereitstellungsabläufe behält.

1. TPOT

TPOT ist ein Open-Source-Python-AutoML-Framework, das genetische Programmierung nutzt, um komplette Machine-Learning-Pipelines automatisch zu finden und zu optimieren.

Es betrachtet das Pipeline-Design als ein evolutionäres Suchproblem und untersucht Kombinationen aus Vorverarbeitungsschritten, Modellen und Hyperparametern, um leistungsstarke Lösungen zu finden.

TPOT ist besonders gut für Aufgaben mit tabellarischen Daten, wo man schnell experimentieren und starke Basiswerte brauchen kann. Dabei kann man die resultierenden Pipelines trotzdem in den normalen scikit-learn-Workflows checken, exportieren und wiederverwenden.

Wichtigste Funktionen:

- Genetische Programmieroptimierung: TPOT nutzt evolutionäre Algorithmen, um einen großen Suchraum von Machine-Learning-Pipelines zu erkunden und diese im Laufe der Zeit immer weiter zu verbessern.

- Automatisierte Pipeline-Erstellung: Es kombiniert automatisch Vorverarbeitungsschritte, Methoden zur Merkmalsauswahl, Modelle und Hyperparameter zu durchgängigen Pipelines.

- Kompatibilität mit Scikit Learn: TPOT nutzt scikit-learn-Komponenten, was das Verständnis, die Erweiterung und die Bereitstellung der resultierenden Pipelines vereinfacht.

- Anpassbarer Suchbereich: Benutzer können festlegen, welche Algorithmen, Transformationen und Parameter TPOT verwenden darf.

- Exportierbarer Python-Code: Die Pipeline mit der besten Leistung kann als sauberer Python-Code exportiert werden, um sie genauer anzuschauen oder in der Produktion zu nutzen.

Code-Beispiel:

Dieses Beispiel zeigt, wie du TPOT mit minimalem Aufwand einrichten kannst. Die Datensatzmerkmale und Beschriftungen werden geladen, ein „ TPOTClassifier ” wird mit den Standardeinstellungen gestartet und die Anpassungsmethode löst den automatischen Suchprozess aus.

Während des Trainings checkt TPOT mehrere Pipeline-Kandidaten mit genetischer Programmierung und sucht sich ein leistungsstarkes Modell nach den vorgegebenen Bewertungskriterien aus.

import tpot

X, y = load_my_data()

est = tpot.TPOTClassifier()

est.fit(X, y)2. AutoGluon

AutoGluon ist ein Open-Source-Python-AutoML-Framework, das von AWS AI entwickelt wurde und Machine-Learning-Aufgaben automatisiert. Es legt Wert auf hohe Genauigkeit, minimalen Code und unterstützt Tabellen-, Text- und Bilddaten.

Es erstellt eine Vielzahl unterschiedlicher Modelle und nutzt automatisierte Modellauswahl, Hyperparameter-Optimierung und Ensemble-Lernen, um eine starke Vorhersageleistung für verschiedene Datentypen zu erzielen.

Wichtigste Funktionen:

- Multimodale Unterstützung: AutoGluon kann mit Tabellen, Texten, Bildern und mehr umgehen und bietet so viele verschiedene Anwendungsmöglichkeiten in einer einzigen Bibliothek.

- Automatisches Stapeln und Ensembles: Es kombiniert mehrere Modelle mithilfe von Stack Ensembling, um die Genauigkeit über die einzelnen Modelle hinaus zu steigern.

- Hyperparameter-Optimierung: AutoGluon optimiert automatisch die Hyperparameter des Modells, um die Leistung zu verbessern.

- Benutzerfreundlichkeit: Mit der High-Level-API kannst du mit nur ein paar Zeilen Code leistungsstarke Modelle trainieren.

- Robuste Vorverarbeitung: Es kümmert sich automatisch um die Datenvorverarbeitung und erkennt verschiedene Merkmalstypen, um die Daten für das Modelltraining vorzubereiten.

Code-Beispiel:

Dieser Code lädt die Trainings- und Testdatensätze als AutoGluon-Tabellendatensätze. Dann wird ein „ TabularPredictor “-Objekt erstellt, das das Ziel-Label angibt, und „fit “ aufgerufen , um AutoGluon anhand der tabellarischen Trainingsdaten zu trainieren. Nach dem Training nutzt es das trainierte Modell, um Vorhersagen für den Testsatz zu machen.

from autogluon.tabular import TabularDataset, TabularPredictor

label = "signature"

train_data = TabularDataset("train.csv")

predictor = TabularPredictor(label=label).fit(train_data)

test_data = TabularDataset("test.csv")

predictions = predictor.predict(test_data.drop(columns=[label]))3. FLAML

FLAML (Fast Lightweight AutoML) ist eine von Microsoft Research entwickelte Open-Source-Python-AutoML-Bibliothek, die darauf ausgelegt ist, automatisch und effizient hochwertige Machine-Learning-Modelle zu finden und dabei die Rechenkosten und den Ressourcenverbrauch zu minimieren. Damit eignet sie sich ideal für Umgebungen, in denen Geschwindigkeit und Effizienz am wichtigsten sind.

Wichtigste Funktionen:

- Budgetbewusste Optimierung: FLAML nutzt kostengünstige Suchstrategien, die zuerst günstigere Konfigurationen priorisieren und dann bei Bedarf komplexere Konfigurationen untersuchen, was eine starke Leistung mit begrenzten Ressourcen ermöglicht.

- Schnelle Hyperparameter-Optimierung: Es macht die Hyperparameter-Optimierung automatisch und konzentriert sich dabei mehr auf Geschwindigkeit und Recheneffizienz als auf eine umfassende Suche.

- Unterstützung für mehrere Aufgaben: FLAML kann gängige Aufgaben im Bereich des maschinellen Lernens wie Klassifizierung, Regression, Zeitreihenprognosen und mehr mit minimalem Einrichtungsaufwand bewältigen.

- Scikit-Learn-Stil-Schnittstelle: Es lässt sich in bekannte Schnittstellen wie scikit-learns„ “, „fit“ und „predict“ einbinden, was die Anwendung für Praktiker vereinfacht.

- Anpassbarer Suchbereich: Die Nutzer können die Schätzfunktionen und den Suchraum anpassen, um ein Gleichgewicht zwischen Genauigkeit und Ressourcenbeschränkungen zu finden.

Code-Beispiel:

Dieses Codebeispiel zeigt, wie man FLAMLs AutoML verwendet wird, um eine automatisierte Klassifizierungsaufgabe für den Iris-Datensatz durchzuführen, wobei vor dem Training ein Zeitbudget und eine Bewertungsmetrik festgelegt werden und anschließend das trainierte Modell verwendet wird, um Vorhersagewahrscheinlichkeiten zu erhalten.

from flaml import AutoML

from sklearn.datasets import load_iris

X_train, y_train = load_iris(return_X_y=True)

automl = AutoML()

automl_settings = {

"time_budget": 1,

"metric": "accuracy",

"task": "classification",

"log_file_name": "iris.log",

}

automl.fit(X_train=X_train, y_train=y_train, **automl_settings)

print(automl.predict_proba(X_train))4. AutoKeras

AutoKeras ist eine Open-Source-AutoML-Bibliothek, die auf dem Keras Deep-Learning-Framework basiert und automatisch hochwertige neuronale Netze für viele Aufgaben sucht und trainiert, wie strukturierte Daten, Bilder und Text, und das mit minimalem Programmieraufwand.

Es nutzt eine effiziente neuronale Architektursuche, um passende Modellarchitekturen und Hyperparameter zu finden, was Deep Learning sowohl für Anfänger als auch für erfahrene Anwender zugänglicher macht.

Wichtigste Funktionen:

- Suche nach neuronalen Architekturen: AutoKeras macht eine automatische Architektursuche, um die besten neuronalen Netzstrukturen für deine Aufgabe zu finden.

- Multimodale Unterstützung: Es unterstützt strukturierte tabellarische Daten, Bilddaten und Textdaten in einem einheitlichen Rahmen.

- Benutzerfreundlichkeit: Hochwertige APIs wie

StructuredDataClassifiermachen das Training komplexer Deep-Learning-Modelle mit nur wenigen Zeilen Code einfacher. - Flexibles Modellieren: Benutzer können Suchbeschränkungen anpassen und den Suchbereich für fortgeschrittene Anwendungsfälle erweitern.

- Integration von Keras und TensorFlow: Da AutoKeras auf Keras und TensorFlow basiert, lässt es sich super in diese weit verbreiteten Deep-Learning-Umgebungen einbinden.

Code-Beispiel:

Dieses Code-Beispiel holt die benötigten Bibliotheken rein und lädt Trainings- und Testdatensätze von den angegebenen URLs. Es trennt Features und Labels und erstellt dann ein „ ak.StructuredDataClassifier “-Objekt, das automatisch nach einem starken Deep-Learning-Modell sucht. Das Modell wird für eine bestimmte Anzahl von Versuchen und Epochen trainiert, und das endgültige Bewertungsergebnis für den Testsatz wird ausgegeben.

import keras

import pandas as pd

import autokeras as ak

TRAIN_DATA_URL = "https://storage.googleapis.com/tf-datasets/titanic/train.csv"

TEST_DATA_URL = "https://storage.googleapis.com/tf-datasets/titanic/eval.csv"

train_file_path = keras.utils.get_file("train.csv", TRAIN_DATA_URL)

test_file_path = keras.utils.get_file("eval.csv", TEST_DATA_URL)

train_df = pd.read_csv(train_file_path)

test_df = pd.read_csv(test_file_path)

y_train = train_df["survived"].values

x_train = train_df.drop("survived", axis=1).values

y_test = test_df["survived"].values

x_test = test_df.drop("survived", axis=1).values

clf = ak.StructuredDataClassifier(overwrite=True, max_trials=3)

clf.fit(x_train, y_train, epochs=10)

print(clf.evaluate(x_test, y_test))No-Code- und Low-Code-AutoML-Plattformen

No-Code- und Low-Code-AutoML-Plattformen machen die Modellentwicklung einfacher, indem sie komplizierte Abläufe vereinfachen und so schnelles Testen und Bereitstellen für technische Teams und Geschäftsanwender ermöglichen.

5. PyCaret

PyCaret ist eine Open-Source-Bibliothek für maschinelles Lernen in Python, die den kompletten Workflow für Aufgaben wie Klassifizierung, Regression, Clustering, Anomalieerkennung und Zeitreihenprognosen automatisiert. Damit kann man mit nur wenigen Zeilen Code schnell Prototypen erstellen und es gibt auch eine grafische Benutzeroberfläche für alle, die Low-Code- oder Click-Through-Erfahrungen bevorzugen.

Wichtigste Funktionen:

- Low-Code-Automatisierung: PyCaret macht das Schreiben von Code viel einfacher, indem es die üblichen Schritte beim maschinellen Lernen wie Datenvorbereitung, Modelltraining, Bewertung und Auswahl automatisch erledigt.

- Unterstützung für mehrere ML-Aufgaben: Es hat eingebaute Unterstützung für viele Aufgaben im Bereich maschinelles Lernen, wie Klassifizierung, Regression, Clustering, Anomalieerkennung, Verarbeitung natürlicher Sprache und Zeitreihenanalyse.

- Integrierte Vorverarbeitung: PyCaret macht automatisch die üblichen Schritte zur Datenvorverarbeitung, wie zum Beispiel das Behandeln fehlender Werte, das Kodieren kategorialer Merkmale und das Skalieren für Modelle.

- Modellvergleich und -auswahl: Die Funktion „

compare_models” trainiert und bewertet viele Modelle mithilfe von Kreuzvalidierung und stellt eine Rangliste der Leistung bereit, um bei der Auswahl des besten Modells zu helfen. - Erweiterbar und integrierbar: Es nutzt bekannte Bibliotheken (scikit-learn, XGBoost, LightGBM, CatBoost usw.) und lässt sich in BI-Tools wie Power BI, Tableau und andere einbinden.

Code-Beispiel:

Dieser Codeausschnitt zeigt, wie man einen integrierten Datensatz lädt, das PyCaret-Regressionsmodul mit „ setup ” initialisiert (was die Daten vorverarbeitet und die ML-Umgebung initialisiert) und dann mit „compare_models” automatisch verschiedene Regressionsmodelle trainiert, bewertet und einstuft, um dann das Modell mit der besten Leistung zurückzugeben.

from pycaret.datasets import get_data

from pycaret.regression import *

data = get_data("insurance")

s = setup(data, target="charges", session_id=123)

best_model = compare_models()6. MLJAR Studio

MLJAR Studio ist eine No-Code- und Low-Code-AutoML-Umgebung, mit der du Machine-Learning-Modelle über eine geführte Oberfläche trainieren und vergleichen kannst. Außerdem gibt's einen optionalen Python-Workflow über das Open-Source-Projekt mljar-supervised .

Wichtigste Funktionen:

- AutoML-Workflow ohne Programmierung: Du kannst einen Datensatz laden, Features und ein Ziel auswählen, mit dem Training anfangen und die Ergebnisse anschauen, ohne Code schreiben zu müssen.

- Transparente Modelle und Berichte: MLJAR betont, dass es keine Black Box ist und detaillierte Berichte erstellt, die erklären, wie die Modelle aufgebaut sind und wie sie funktionieren.

- Automatisches Training und Optimierung: Die AutoML-Engine kümmert sich um die Vorverarbeitung, das Modelltraining und die Hyperparameteroptimierung, um starke Modelle zu finden.

- Modellvergleich mit klaren Ergebnissen: Es trainiert mehrere Modelle und hilft dir, sie mithilfe von generierten Zusammenfassungen und Leistungsansichten zu vergleichen.

- Code optional über mljar-supervised: Wenn du mehr Kontrolle haben willst, kannst du die gleichen AutoML-Funktionen über das Python-Paket„ mljar-supervised“ nutzen.

Code-Beispiel:

Du brauchst keinen Code, um MLJAR Studio zu nutzen, weil du AutoML über die Benutzeroberfläche ausführen kannst. Der Code unten zeigt aber den optionalen programmatischen Ansatz mit der Bibliothek „ mljar-supervised “. Es lädt einen Datensatz, teilt ihn in Merkmale und Ziele auf, führt das AutoML-Training durch und erstellt dann Vorhersagen mit dem trainierten Modell.

import pandas as pd

from supervised.automl import AutoML

df = pd.read_csv(

"https://raw.githubusercontent.com/pplonski/datasets-for-start/master/adult/data.csv",

skipinitialspace=True,

)

X = df[df.columns[:-1]]

y = df["income"]

automl = AutoML(results_path="mljar_results")

automl.fit(X, y)

predictions = automl.predict(X)7. H2O AutoML

H2O AutoML ist eine Open-Source-AutoML-Funktion innerhalb der H2O-Plattform, die skalierbares, automatisiertes maschinelles Lernen mit Unterstützung für Python, R und einer no-code-Grafikschnittstelle namens H2O Flow bietet , sodass sowohl technische als auch nicht-technische Benutzer mit minimalem Programmieraufwand Modelle erstellen, bewerten und auswählen können. Benutzer können über die webbasierte Flow-Oberfläche Daten importieren, AutoML-Experimente durchführen, Ergebnisse auswerten und Modelle exportieren, ohne Code schreiben zu müssen.

Wichtigste Funktionen:

- Automatisiertes Modelltraining und -optimierung: H2O AutoML macht automatisch mehrere Algorithmen, passt Hyperparameter an und erstellt eine Rangliste der besten Modelle, ohne dass man manuell welche auswählen muss.

- Webschnittstelle ohne Programmierung: Mit der grafischen Benutzeroberfläche von H2O Flow kannst du über einen Browser mit H2O interagieren, Machine-Learning-Aufgaben erledigen und Ergebnisse anschauen, ohne Code schreiben zu müssen.

- Unterstützung für mehrere Schnittstellen: Neben der Web-Benutzeroberfläche kann man auf H2O AutoML auch über Python- und R-APIs zugreifen, was Flexibilität für Low-Code- und No-Code-Workflows bietet.

- Automatische Vorverarbeitung: H2O AutoML macht die üblichen Vorbereitungsaufgaben wie das Behandeln fehlender Werte, das Kodieren kategorialer Variablen und das automatische Skalieren.

- Tools zur Erklärbarkeit von Modellen: H2O hat Funktionen, die dir helfen, das Verhalten und die Leistung von Modellen zu verstehen, damit du den Ergebnissen der Modelle vertrauen kannst.

Code-Beispiel:

Dieses Beispiel zeigt, wie man H2O AutoML mit Python benutzt. Es macht die H2O-Umgebung startklar, holt Trainings- und Testdatensätze rein, legt Feature- und Zielspalten fest, startet einen AutoML-Lauf mit einer Begrenzung der Anzahl der Modelle und zeigt dann eine Rangliste mit den leistungsstärksten Modellen an.

Anmerkung: Das ist zwar der programmatische Ansatz, aber die gleichen Aufgaben kannst du auch über die H2O Flow-Weboberfläche erledigen, ohne Code schreiben zu müssen.

import h2o

from h2o.automl import H2OAutoML

h2o.init()

train = h2o.import_file(

"https://s3.amazonaws.com/h2o-public-test-data/smalldata/higgs/higgs_train_10k.csv"

)

test = h2o.import_file(

"https://s3.amazonaws.com/h2o-public-test-data/smalldata/higgs/higgs_test_5k.csv"

)

x = train.columns

y = "response"

x.remove(y)

train[y] = train[y].asfactor()

test[y] = test[y].asfactor()

aml = H2OAutoML(max_models=20, seed=1)

aml.train(x=x, y=y, training_frame=train)

aml.leaderboardAutoML-Lösungen für Unternehmen

AutoML-Lösungen für Unternehmen bieten skalierbare, sichere und kontrollierte Machine-Learning-Plattformen, die für den Einsatz in der Produktion, die Einhaltung von Vorschriften und den großflächigen operativen Einsatz entwickelt wurden.

8. DataRobot

DataRobot ist eine AutoML-Plattform für Unternehmen, die ohne oder mit wenig Programmieraufwand auskommt. Damit können Geschäftsleute, Analysten und Datenteams Machine-Learning-Modelle erstellen, einsetzen und verwalten, ohne viel programmieren zu müssen.

Die Plattform macht den ganzen Machine-Learning-Lebenszyklus automatisch, von der Datenerfassung und Feature Engineering bis hin zum Modelltraining, der Bereitstellung und Überwachung. Dabei bietet sie die starke Governance, Erklärbarkeit und Betriebskontrollen, die in regulierten Umgebungen gebraucht werden.

Wichtigste Funktionen:

- Entwicklung ohne Programmierung: Benutzer können Datensätze hochladen, Modellierungsaufgaben einrichten, Modelle trainieren und Vorhersagen komplett über die grafische Benutzeroberfläche machen, ohne Code schreiben zu müssen.

- Automatisiertes maschinelles Lernen: DataRobot checkt automatisch Algorithmen, macht Feature Engineering, optimiert Hyperparameter und ordnet Modelle nach Leistung und Geschäftsmetriken.

- Eingebaute Erklärbarkeit: Die Plattform bietet globale und lokale Tools zur Erklärbarkeit von Modellen, darunter Feature-Auswirkungen, Vorhersageerklärungen und Compliance-konforme Berichte.

- End-to-End-MLOps: DataRobot unterstützt die Bereitstellung von Modellen, die Überwachung, die Erkennung von Abweichungen, die Leistungsüberwachung und die Nachschulung von Arbeitsabläufen auf derselben Plattform.

- Unternehmensführung und Sicherheit: Die Plattform hat rollenbasierte Zugriffskontrolle, Genehmigungsabläufe, Audit-Protokolle und Compliance-Berichte, die für regulierte Branchen gemacht sind.

Code-Beispiel:

Obwohl DataRobot hauptsächlich über seine No-Code-Oberfläche genutzt wird, gibt's auch eine Python-API für die programmatische Steuerung und Automatisierung. Das folgende Beispiel zeigt, wie du dich bei DataRobot anmeldest, ein Projekt aus einem Datensatz erstellst und AutoPilot ausführst, um Modelle automatisch zu trainieren und zu bewerten.

import datarobot as dr

dr.Client(config_path="./drconfig.yaml")

dataset = dr.Dataset.create_from_file("auto-mpg.csv")

project = dr.Project.create_from_dataset(

dataset.id,

project_name="Auto MPG Project"

)

from datarobot import AUTOPILOT_MODE

project.analyze_and_model(

target="mpg",

mode=AUTOPILOT_MODE.QUICK

)

project.wait_for_autopilot()9. Amazon SageMaker Autopilot

Amazon SageMaker Autopilot ist eine komplett verwaltete AutoML-Lösung von AWS, mit der man den kompletten Machine-Learning-Workflow ohne ohne oder mit nur wenig Programmierung, vor allem über eine Webschnittstelle in Amazon SageMaker Canvas oder SageMaker Studio.

Benutzer können mit wenigen Klicks in der Konsole Daten importieren, die Zielvariable konfigurieren, Kandidatenmodelle bewerten und Modelle bereitstellen, während das Python SDK und die APIs weiterhin als optionale Möglichkeit zur Verfügung stehen, um Experimente reproduzierbar zu machen oder in andere Systeme zu integrieren.

Wichtigste Funktionen:

- Webbasierter Workflow ohne Programmierung: Die meisten Aufgaben, wie zum Beispiel das Hochladen von Datensätzen, das Einrichten von Experimenten, das Trainieren von Modellen, die Auswertung und die Bereitstellung, kannst du über die Weboberfläche in SageMaker Canvas oder SageMaker Studio erledigen, ohne Code schreiben zu müssen.

- Automatisierte Datenanalyse und -vorverarbeitung: Der Autopilot schaut sich den Datensatz an, um zu sehen, um was für ein Problem es geht, bereinigt und bereitet ihn vor und entwickelt Features, um alles für das Modelltraining fertig zu machen.

- Modellauswahl und Optimierung: Der Autopilot checkt verschiedene Algorithmen für maschinelles Lernen und passt Hyperparameter an, um leistungsstarke Modelle zu finden. Dann sortiert er sie in einer Rangliste.

- Erklärbarkeit und Erkenntnisse: Die Plattform gibt einen Einblick in die Modelle, die sie erstellt, zum Beispiel wie bestimmte Merkmale die Vorhersagen beeinflussen und wie die Leistung im Vergleich ist.

- Produktionsbereitstellung: Benutzer können das ausgewählte Modell direkt über die Benutzeroberfläche mit wenigen Schritten bereitstellen und Endpunkte für die Inferenz generieren.

Code-Beispiel:

Der Code unten zeigt, wie man Amazon SageMaker Autopilot mit dem Python SDK programmiert ausführt. Dieser Ansatz ist optional und kann verwendet werden, um Ergebnisse zu reproduzieren oder in automatisierte Pipelines zu integrieren.

from sagemaker import AutoML, AutoMLInput

automl = AutoML(

role=execution_role,

target_attribute_name=target_attribute_name,

sagemaker_session=pipeline_session,

total_job_runtime_in_seconds=3600,

mode="ENSEMBLING",

)

automl.fit(

inputs=[

AutoMLInput(

inputs=s3_train_val,

target_attribute_name=target_attribute_name,

channel_type="training",

)

]

)10. Google Cloud AutoML

Google Cloud AutoML ist Teil von Vertex AI, der einheitlichen Machine-Learning-Plattform von Google Cloud, mit der Nutzer hochwertige Modelle mithilfe einer vollständig verwalteten Infrastruktur erstellen, trainieren, bewerten und bereitstellen können.

Vertex AI AutoML kann mit tabellarischen Daten, natürlicher Sprachverarbeitung, Computer Vision und Videoaufgaben umgehen und ist so gemacht, dass man es über eine Web-Oberfläche ohne Programmierung in der Google Cloud Console nutzen kann.

Alle wichtigen Schritte, wie zum Beispiel das Erstellen von Datensätzen, die Auswahl von Aufgaben, das Training, die Bewertung und die Bereitstellung, kannst du über die Benutzeroberfläche erledigen, ohne Code schreiben zu müssen.

Wichtigste Funktionen:

- Webschnittstelle ohne Programmierung: Du kannst Datensätze hochladen, AutoML-Aufgaben einrichten, Modelle trainieren, Metriken checken und Modelle komplett über die Vertex AI-Konsole bereitstellen.

- Unterstützung für mehrere Datenmodalitäten: AutoML kann tabellarische Klassifizierung und Regression, Bildklassifizierung und -erkennung, Textklassifizierung und -extraktion sowie Videoanalyse.

- Automatisiertes End-to-End-Training: Vertex AI AutoML kümmert sich automatisch um die Vorverarbeitung, das Feature Engineering, die Auswahl der Modellarchitektur und die Hyperparameteroptimierung.

- Verwaltete Infrastruktur: Das ganze Training und die Bereitstellung laufen auf einer von Google verwalteten Infrastruktur mit integrierter Skalierung und Ressourcenverwaltung.

- Bereit für die Produktion: Trainierte Modelle können direkt über die Benutzeroberfläche als Endpunkte für Online- oder Batch-Vorhersagen eingesetzt werden.

Code-Beispiel:

Obwohl Vertex AI AutoML eigentlich für No-Code-Workflows gedacht ist, kann man das Python SDK nutzen, um Experimente reproduzierbar zu machen oder das AutoML-Training in automatisierte Pipelines einzubauen.

Der folgende kurze Code-Ausschnitt startet ein Vertex AI-Projekt, macht einen Bilddatensatz aus einem CSV-Index, der in Cloud Storage gespeichert ist, und startet einen AutoML-Bildtrainingsjob.

from google.cloud import aiplatform

aiplatform.init(

project="YOUR_PROJECT_ID",

location="us-central1",

staging_bucket="gs://YOUR_BUCKET",

)

dataset = aiplatform.ImageDataset.create(

display_name="flowers",

gcs_source=["gs://cloud-samples-data/ai-platform/flowers/flowers.csv"],

import_schema_uri=aiplatform.schema.dataset.ioformat.image.single_label_classification,

)

training_job = aiplatform.AutoMLImageTrainingJob(

display_name="flowers_automl",

prediction_type="classification",

)

model = training_job.run(

dataset=dataset,

model_display_name="flowers_model",

budget_milli_node_hours=8000,

)AutoML-Framework-Vergleichstabelle

Diese Tabelle vergleicht beliebte AutoML-Frameworks nach ihrem Automatisierungsgrad, ihrem Schnittstellenstil und ihrer Eignung für Open-Source-Experimente, Low-Code-Workflows und den Einsatz in Unternehmen.

|

Rahmen |

Kategorie |

Code-Ebene |

Schnittstellenoptionen |

Hauptanwendungsfall |

|

TPOT |

Open Source |

Hoch |

Python API |

Automatische Erkennung und Optimierung von Pipelines für tabellarische Daten |

|

AutoGluon |

Open Source |

Niedrig |

Python API |

Schnelle, supergenaue Modelle für die Produktion, die für alle Modalitäten geeignet sind |

|

FLAML |

Open Source |

Niedrig |

Python API |

Kosteneffiziente und ressourcenbewusste Modelloptimierung |

|

AutoKeras |

Open Source |

Mittel |

Python API |

Suche nach neuronalen Architekturen und Automatisierung des Deep Learning |

|

PyCaret |

Low Code |

Sehr niedrig |

Python-API, optionale GUI-Tools |

Schnelle Experimente und datengesteuerte Arbeitsabläufe |

|

MLJAR Studio |

Kein Code |

Keiner |

Web-Benutzeroberfläche, Python optional |

Einfaches Experimentieren mit AutoML und Modellvergleich für Unternehmen |

|

H2O AutoML |

Hybrid |

Niedrig |

Web-Benutzeroberfläche (H2O Flow), Python, R |

Skalierbares AutoML für große Datensätze und den Einsatz in Unternehmen |

|

DataRobot |

Unternehmen |

Keine bis gering |

Web-Benutzeroberfläche, Python-API |

Enterprise ML mit Governance, Erklärbarkeit und MLOps |

|

SageMaker Autopilot |

Unternehmen |

Keine bis gering |

AWS-Konsole, Python SDK |

AWS-eigene AutoML, eingebaut in Produktionspipelines |

|

Google Cloud AutoML |

Unternehmen |

Keiner |

Vertex AI-Konsole, optionales SDK |

Vision, NLP und tabellarisches AutoML auf verwalteter GCP-Infrastruktur |

Abschließende Gedanken

AutoML-Frameworks sind mittlerweile ausgereifte Tools, die Teams während des gesamten Machine-Learning-Lebenszyklus unterstützen. In der Praxis sind sie nicht nur auf Experimente oder Prototypen beschränkt.

Ich habe AutoML-Frameworks benutzt, um bei Kaggle-Wettbewerben mitzumachen, komplette End-to-End-Pipelines für maschinelles Lernen für echte Projekte zu bauen und mich sogar auf technische Vorstellungsgespräche vorzubereiten und diese erfolgreich zu meistern.

Aus der Sicht eines Datenwissenschaftlers ist AutoML eine super Möglichkeit, um mit wenig Aufwand ein starkes und unvoreingenommenes Basismodell zu erstellen.

Man muss nur die Daten bereitstellen, und diese Frameworks kümmern sich um Feature Engineering, Modellauswahl, Hyperparameter-Tuning und Auswertung. So können sich die Leute darauf konzentrieren, das Problem zu verstehen, Annahmen zu überprüfen und die Ergebnisse zu verbessern, anstatt viel Zeit damit zu verbringen, Modelle von Grund auf neu zu erforschen und zu testen.

AutoML ersetzt nicht das Fachwissen. Stattdessen macht es den Arbeitsablauf schneller, indem es einen zuverlässigen Ausgangspunkt bietet, der immer weiter verbessert werden kann.

Das Modell zu bauen ist nur der erste Schritt. Lerne im Kurs „MLOps-Konzepte“, wie du deine AutoML-Modelle in der Produktion einsetzt und überwachst. Kurs „MLOps-Konzepte“.

AutoML FAQs

Wird AutoML die Datenwissenschaftler ersetzen?

Nein. AutoML macht sich wiederholende Aufgaben wie die Modellauswahl und die Hyperparameteroptimierung automatisch, kann aber menschliches Urteilsvermögen nicht ersetzen. Datenwissenschaftler sind immer noch super wichtig, um geschäftliche Probleme zu definieren, Ergebnisse zu verstehen, ethische KI-Praktiken sicherzustellen und komplexes Feature Engineering zu machen, das echt tiefes Fachwissen braucht.

Ist AutoML nur für Leute ohne Technik-Hintergrund gedacht?

Überhaupt nicht. Während „No-Code“-Plattformen Business-Analysten unterstützen, sind viele AutoML-Frameworks (wie TPOT, AutoGluon und FLAML) Code-First-Tools, die speziell für Datenwissenschaftler entwickelt wurden. Experten nutzen sie, um schnell Basismodelle zu erstellen, was ihnen stundenlanges manuelles Ausprobieren erspart, sodass sie sich auf die Optimierung auf höherer Ebene konzentrieren können.

Wann sollte ich traditionelles maschinelles Lernen statt AutoML nehmen?

Entscheide dich für traditionelles (manuelles) maschinelles Lernen, wenn du die volle Kontrolle über die Modellarchitektur brauchst, wenn du mit sehr unstrukturierten oder einzigartigen Datentypen arbeitest, die AutoML nur schwer verarbeiten kann, oder wenn „Erklärbarkeit” wichtig ist und du genau wissen musst, warum ein Modell eine bestimmte Vorhersage trifft (um das „Black-Box”-Problem zu vermeiden).

Ist AutoML teuer in der Nutzung?

Das kommt drauf an. Unternehmensplattformen (wie Vertex AI oder DataRobot) berechnen ihre Preise oft nach Rechenzeit oder Abonnementstufen, was bei großen Datensätzen ziemlich teuer werden kann. Open-Source-Bibliotheken (wie TPOT oder H2O) kann man aber kostenlos nutzen, also zahlst du nur für die Infrastruktur (Laptop oder Cloud-Server), auf der du sie laufen lässt.

Kann AutoML mit unordentlichen oder Rohdaten umgehen?

Bis zu einem gewissen Grad. Die meisten AutoML-Tools können einfache Bereinigungen machen, wie zum Beispiel fehlende Werte ergänzen oder Merkmale skalieren. Allerdings können sie meistens grundlegende Probleme mit der Datenqualität (wie falsche Beschriftungen oder verzerrte Stichproben) nicht beheben oder komplexes, fachspezifisches Feature Engineering durchführen. „Garbage in, garbage out“ gilt immer noch.

Als zertifizierter Data Scientist ist es meine Leidenschaft, modernste Technologien zu nutzen, um innovative Machine Learning-Anwendungen zu entwickeln. Mit meinem fundierten Hintergrund in den Bereichen Spracherkennung, Datenanalyse und Reporting, MLOps, KI und NLP habe ich meine Fähigkeiten bei der Entwicklung intelligenter Systeme verfeinert, die wirklich etwas bewirken können. Neben meinem technischen Fachwissen bin ich auch ein geschickter Kommunikator mit dem Talent, komplexe Konzepte in eine klare und prägnante Sprache zu fassen. Das hat dazu geführt, dass ich ein gefragter Blogger zum Thema Datenwissenschaft geworden bin und meine Erkenntnisse und Erfahrungen mit einer wachsenden Gemeinschaft von Datenexperten teile. Zurzeit konzentriere ich mich auf die Erstellung und Bearbeitung von Inhalten und arbeite mit großen Sprachmodellen, um aussagekräftige und ansprechende Inhalte zu entwickeln, die sowohl Unternehmen als auch Privatpersonen helfen, das Beste aus ihren Daten zu machen.