Ja. GPT-Image-1.5 ist in der OpenAI-API verfügbar und hat die gleichen Verbesserungen wie ChatGPT Images. Die Bild-Inputs und -Outputs sind ungefähr 20 % günstiger als bei GPT Image 1, was es super für Anwendungen wie Marketing, E-Commerce und Design-Workflows macht.

Der Wettlauf um die besten Tools zur Bildbearbeitung hat wieder eine neue Phase erreicht: Nicht mal einen Monat, nachdem Google Nano Banana Pro, hat OpenAI seine Antwort, chatGPT Images, rausgebracht .

Die Veröffentlichung kombiniert einen neuen Arbeitsbereich „Bilder“ in chatGPT mit einem neuen Generierungsmodell, GPT-Image-1.5. Das zeigt, dass chatGPT die Bilderzeugung nicht mehr nur als Zusatzfunktion sieht, sondern als eine Kernfunktion, die voll in die Benutzererfahrung eingebaut ist. Das Modell verspricht unter anderem eine gute Detailerhaltung und eine schnellere Generierung.

In diesem Artikel zeig ich dir alle wichtigen Funktionen, die OpenAI angekündigt hat, wie chatGPT Images im Vergleich zu seinen Mitbewerbern abschneidet, und gebe dir praktische Beispiele, um dir die Möglichkeiten des neuen Modells zu zeigen.

Willst du mit generativer KI beginnen?

Lerne, wie du mit LLMs in Python direkt in deinem Browser arbeiten kannst

Was ist chatGPT Images?

Der neue Reiter „Bilder“ von chatGPT ist sozusagen die kreative Zentrale für alles Visuelle in der chatGPT-Benutzeroberfläche und ersetzt die persönliche Bildbibliothek. Die auffälligste Änderung ist, dass man jetzt direkt bearbeiten kann, sodass man bestimmte Details im Bild anpassen kann, ohne die anderen Details zu verändern.

chatGPT Images läuft mit GPT-Image-1.5, dem neuesten und fortschrittlichsten Text-zu-Bild-KI-Modell von OpenAI. Es baut auf der Veröffentlichung von GPT-Image-1-Modells Modells im März 2025 auf, das mit über 700 Millionen generierten Bildern in der ersten Woche ein großer Erfolg war.

Es bietet Detailtreue und eine verbesserte Textdarstellung und soll „bis zu viermal“ schneller sein als sein Vorgänger.

Die neuen Funktionen sind jetzt für alle Nutzer da, egal ob kostenlos oder kostenpflichtig, im Web, in der mobilen Benutzeroberfläche und in der API. Nur Business- und Enterprise-Konten müssen noch auf den Zugang warten.

Die wichtigsten Features von chatGPT Bilder

Also, was hat chatGPT Images im Vergleich zum Vorgängermodell und zur Konkurrenz zu bieten? OpenAI setzt sich besonders für „präzise Bearbeitungen ein, die das Wesentliche bewahren“. Schauen wir uns mal die neuen Funktionen an, um zu sehen, was sie bedeuten.

Spezieller kreativer Arbeitsbereich

Die Registerkarte „Bilder“ wurde als visueller Kreativbereich in der chatGPT-Benutzeroberfläche eingeführt. Die Idee dahinter ist, das Erstellen und Bearbeiten von Bildern von normalen Chat-Interaktionen zu trennen.

Die alte Bibliotheksfunktion hat zwar auch alle erstellten Bilder gespeichert, aber man konnte nur zu dem Gespräch zurückgehen, in dem sie erstellt wurden. Es hat den Kontext aus dem ganzen Gesprächsverlauf genutzt, um ein neues Bild von Grund auf zu erstellen, was oft zu Halluzinationen in längeren Threads.

Der neue Ansatz ist aber mehr auf das Bild ausgerichtet: Jede Bearbeitung geht von einem Bild aus und ändert nur bestimmte Teile davon, anstatt ein komplett neues Bild zu erstellen.

Bilder sind bleibende Sachen, die nicht in einem Gesprächsverlauf verschwinden. Das macht schnellere Feedback-Schleifen mit neuen Varianten möglich und fördert das Experimentieren, wodurch die Erfahrung von einem Chat-Thread zu einer Art Leinwand wird.

Um diesen kreativen Fluss zu fördern, gibt's im Arbeitsbereich neue Tools, die helfen, die Lücke zwischen Idee und Umsetzung zu schließen. Man kann vorgefertigte Stile (wie „Skizze“ oder „Dramatisch“) nehmen oder nach angesagten Looks stöbern, um den nächsten „Studio Ghibli“ zu entdecken. Für Leute, die noch nicht so viel Erfahrung haben, gibt's in der Benutzeroberfläche kreative Vorschläge und proaktive Hilfe, um die Ergebnisse zu verbessern.

Detailtreue und präzise Bearbeitung

Die wohl wichtigste neue Funktion des Updates ist, dass man bestimmte Teile eines Bildes auswählen und direkt bearbeiten kann, ohne den Rest der Komposition zu verändern. Das Modell ist kontextabhängig, das heißt, es weiß, was geändert werden muss, während die umliegenden Elemente gleich bleiben.

Solche präzisen Bearbeitungen sind dank der verbesserten Detailerhaltung des neuen Modells möglich.

Es kann Objekte, Beleuchtung, Bildaufbau und das Aussehen von Leuten über alle Ausgaben und spätere Bearbeitungen hinweg gleich halten. Außerdem hilft eine verbesserte Befolgung von Anweisungen dabei, die Beziehungen zwischen Elementen besser zu bewahren, was zu einer höheren Präzision führt.

Präzise Bearbeitung ist super, um kleine Probleme zu beheben und mit bestimmten Details rumzuexperimentieren, wenn man nicht gleich eine komplette neue Version machen muss. Es ermöglicht auch coole Veränderungen, wie zum Beispiel ein Element aus einem Bild in die Szene eines anderen Bildes zu bringen.

Allerdings muss man sagen, dass das Modell Probleme hat, die genaue Identität jeder Person zu erkennen, wenn viele Leute auf einem Bild sind.

Bessere Textdarstellung und mehr Realismus

Eines der wichtigsten Features des Vorgängermodells GPT-Image-1 war, dass es längere Texte und zusammenhängende Sätze verarbeiten konnte. Die neue Version baut auf dieser Grundlage auf und kann jetzt noch dichteren und kleineren Text verarbeiten als vorher.

Das ist besonders praktisch für Infografiken, wo die ersten Ergebnisse echt beeindruckend sind, und eröffnet neue Möglichkeiten wie das Markdown von Text in einem Bild, z. B. in einer Zeitung. Wir werden später einen Test mit Infografiken machen.

Laut der Pressemitteilung von OpenAI scheinen die Einschränkungen bei bestimmten Sprachen wie Chinesisch, Arabisch und Hebräisch aber noch zu bestehen.

Auch wenn das nicht der Hauptfokus des Updates war, ist der Realismus der Ausgabe im Vergleich zum Vorgängermodell echt besser geworden. Zwei Fälle, in denen das gut zu sehen ist, sind Reflexionen, wie zum Beispiel der Glanz auf einem Foto, und viele kleine Gesichter in großen Menschenmengen.

Wie so oft bringen große Upgrades in bestimmten Bereichen auch ein paar Nachteile mit sich. In diesem Fall hat sich die Fähigkeit, bestimmte Kunststile zu machen, verschlechtert. OpenAI sagt, man soll die voreingestellten Filter auf der Registerkarte „Bilder“ nutzen oder auf das alte Modell „ “ zurückgreifen, das immer noch als benutzerdefiniertes GPT verfügbar ist.

Schnellere Leistung

Die gezielten Bearbeitungsfunktionen sind auch der Grund, warum die Generierungsgeschwindigkeit so viel schneller geworden ist. Die vollständige Bilderzeugung ist zwar deutlich schneller, erreicht aber nicht die in den Versionshinweisen von OpenAI gemachten Angaben. GPT-Images-1.5 ist „bis zu 4x schneller“, weil es nur das neu generiert, was sich bei der Bearbeitung ändert.

Genauso kommen die um etwa 20 % niedrigeren API-Kosten hauptsächlich von der teilweisen Bildregeneration während der Bearbeitung, mit zusätzlichen Vorteilen durch effizientere Inferenz statt durch billigere vollständige Generierungen.

Insgesamt sorgen die neuen Funktionen für eine effizientere und zuverlässigere Nutzung, vor allem bei API-Workflows.

chatGPT-Bilder Beispiele

Die angekündigten Features klingen echt spannend. Ich hab sie mit ein paar einfachen Eingabeaufforderungen zusammen mit dem neuen Auswahlwerkzeug getestet.

Testen der Bearbeitungsgenauigkeit

Das Ziel meines ersten Tests war es, zu sehen, wie gut das Modell mit wiederholten Änderungen klarkommt, ohne dass die Qualität darunter leidet. Zuerst hab ich es gebeten, ein Bild von einem Braunbären zu machen, der bei Mitternachtssonne durch einen finnischen Wald läuft.

Prompt: „Ein Braunbär, der bei Mitternachtssonne durch einen dichten finnischen Wald läuft.“

Ich finde, dass die Qualität des ersten Outputs echt super ist. Der Bär sieht echt aus, die Bäume und Büsche passen super zu finnischen Wäldern (ich weiß, wovon ich rede!), und die tief stehende Sonne passt genau zu dem, was man in Nordfinnland während der Mitternachtssonne erwarten kann.

Außerdem sehen die Beleuchtung und die Schatten auf dem Fell des Bären sowie im Hintergrund ziemlich echt aus. Irgendwie merkt man trotzdem, dass es KI ist, auch wenn die Details echt gut gemacht sind.

Lass uns mal versuchen, den Bären in einen Eisbären zu verwandeln und schauen, was passiert. In Finnland gibt's keine Eisbären, aber wenn alles so läuft, wie es soll, sollte der Hintergrund gleich bleiben.

Prompt: Mach aus dem Bären einen Eisbären.

Wie wir sehen können, ist der Hintergrund komplett intakt geblieben, genau wie es geplant war.

Für meine nächste Bearbeitung hab ich den Kopf und die Augen des Eisbären ausgewählt und ihm eine Vintage-Sonnenbrille verpasst.

Prompt: „Setz dem Bären eine Vintage-Sonnenbrille auf.“ (Kopf ausgewählt)

Sieht so aus, als hätten wir rausgefunden, was passiert, wenn man einen zu großen Bereich auswählt. Während der Bildhintergrund und der Körper des Bären gleich geblieben sind, wurde sein Kopf zu einer riesigen Sonnenbrille. Lass es uns nochmal versuchen und nur seine Augen auswählen.

Prompt: „Setz dem Bären eine Vintage-Sonnenbrille auf.“ (Augen ausgewählt)

Super cool und echt viel besser! In diesem ersten Test konnten wir sehen, wie stark die Funktion zur Detailerhaltung wirklich ist: Wir mussten wichtige Details zur Kulisse nur einmal angeben und konnten uns ganz auf unsere Hauptfigur konzentrieren, ohne uns um den Hintergrund kümmern zu müssen. Eine weitere wichtige Erkenntnis aus dem Test ist, dass die Größe des Auswahlfensters eine Rolle spielt.

Prüfung der Konsistenz der Transformation

Als Nächstes habe ich die Objektpermanenz in verschiedenen Szenarien und die Grenzen des Modells bei großen Menschenmengen getestet. Dafür hab ich unseren Eisbären ein bisschen rumreisen lassen und versucht, ihn in eine belebte U-Bahn-Szene in Tokio zu setzen.

Prompt: Stell dir diesen Bären in einer super belebten U-Bahn-Szene in Tokio vor.

Zuerst mal ist die Konsistenz der Figur echt beeindruckend: Das Modell hat die genaue Haltung und Identität des Bären perfekt eingefangen und die Sonnenreflexe aus seinem Fell entfernt.

Diese starre Erhaltung hat aber zu einer optischen Diskrepanz geführt, die als „Aufkleber-Effekt” bekannt ist. Weil das Modell den Beleuchtungskontext nicht aktualisiert hat (die gerichteten Schatten und Waldreflexionen in der Sonnenbrille sind geblieben), sieht der Bär eher aus wie ein 2D-Ausschnitt, der in die Szene eingefügt wurde, statt wie ein 3D-Objekt, das sich darin befindet.

Die Perspektive macht die Illusion noch mehr kaputt: Der Bär schwebt vor einem Zuschauer, der näher an der Kamera ist.

Das zweite Problem zu lösen, war echt nervig. Ich hab den Bereich mit dem Zuschauer und seiner Begegnung mit dem Bären ausgewählt und chatGPT gebeten, die Perspektive zu korrigieren. Für jede Variante hat das Modell eine neue Person in die Nähe der Kamera gesetzt, so wie hier:

Prompt: Die Perspektive korrigieren: Der Rücken des ausgewählten Zuschauers ist im Vordergrund und sollte den Bären teilweise verdecken. Der Bär steht hinter dem Rücken der Person.

Es sieht so aus, als hätte das Modell die Person nicht erkannt, obwohl sie ausgewählt wurde, und deshalb musste der neue Charakter den Befehl in der Eingabeaufforderung befolgen.

Die Schatten und die Reflexionen der Sonnenbrille zu korrigieren, hat besser geklappt. Ich hab die folgenden Iterationen benutzt:

- Schatten: Wähl den Boden um die Füße des Bären aus und sag: „Statt des aktuellen Schattens soll ein weicher, diffuser Schatten auf den U-Bahn-Fliesenboden geworfen werden, der zur Deckenbeleuchtung passt.“

- Sonnenbrillen: Such dir die Sonnenbrille aus und sag: „Passe die Reflexionen der Sonnenbrille an die U-Bahn-Umgebung an.“

Unser Eisbär in der Tokioter U-Bahn, nachdem wir die Schatten und Sonnenbrillenreflexionen weggemacht haben

Schon viel besser, aber noch nicht perfekt.

Insgesamt war der zweite Test nicht so gut wie der erste. Während die Konsistenz der Elemente in verschiedenen Bildern gut zu funktionieren scheint, stößt die Zeichenerkennung in überfüllten Umgebungen anscheinend an ihre Grenzen.

Textdarstellung testen

Schließlich wollte ich die neuen Funktionen zur Textdarstellung testen, vor allem bei dichten Texten und Bearbeitungen. Verbesserungen bei der Textdarstellung wären echt super, weil es bisher so war, dass Sichtmodelle besser mit Objekten, Texturen und Szenen klarkamen, nicht aber mit Symbolen.

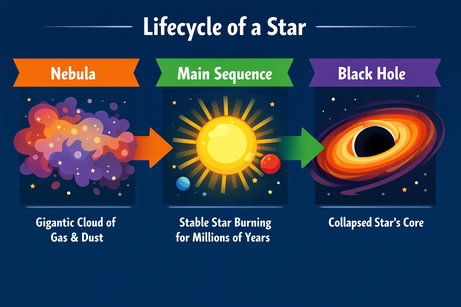

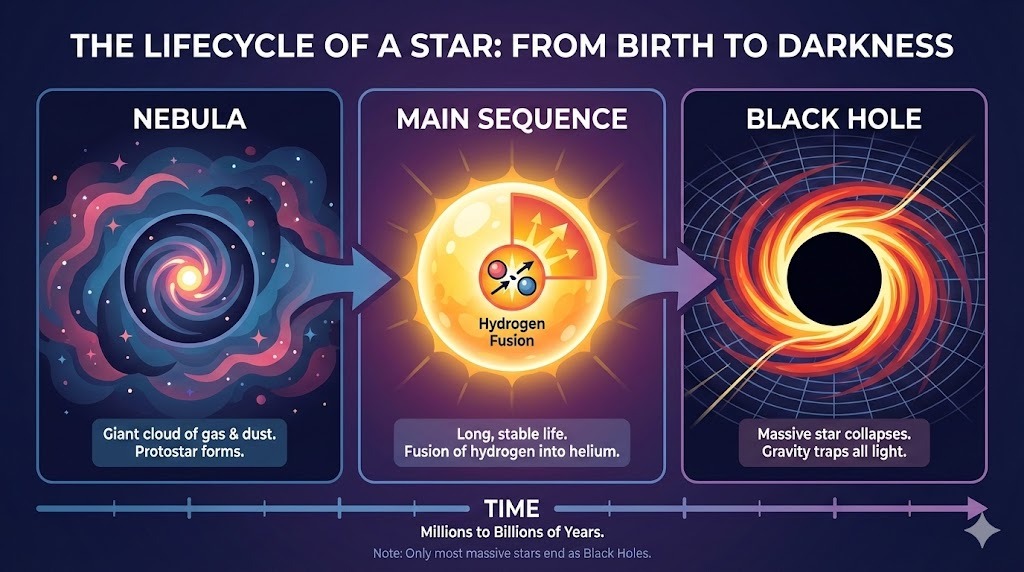

Ich hab chatGPT um ein kompliziertes Layout für eine Infografik zum Lebenszyklus eines Sterns gebeten:

Prompt: Eine Infografik, die den „Lebenszyklus eines Sterns” erklärt. Drei Abschnitte: Nebel, Hauptreihe, Schwarzes Loch. Verwende den flachen Vektorstil.

Die Ausgabe macht genau das, was du gesagt hast, und zeigt den Text ohne Probleme an. Der Stil ist in der ganzen Infografik einheitlich und genau.

Die Multimodalität der chatGPT-Ausgabe zwingt uns dazu, beim Einfügen von Text genau zu sein. Als ich aufgefordert wurde, „hier“ (an einer ausgewählten Stelle im Bild) einen Aufzählungspunkt hinzuzufügen, wurde der Aufzählungspunkt einfach als Text ausgegeben. Die Klarstellung „zum Bild“ hat geholfen:

Prompt: Füge hier einen Aufzählungspunkt zum Bild hinzu, der lautet: „Hält Milliarden von Jahren.“

Nach der Erklärung wurde der Punkt an der richtigen Stelle eingefügt. Schriftart, Größe und Farbe passen zum Stil der Grafik.

Wie kann ich auf chatGPT-Bilder zugreifen?

chatGPT Images ist jetzt für fast alle Leute auf mehreren Plattformen verfügbar. Nur die Unterstützung für Nutzer der Business- und Enterprise-Stufen fehlt noch und kommt später dazu.

In der Benutzeroberfläche kannst du über den Reiter „Bilder“ direkt auf die Funktionen in der Web-Benutzeroberfläche oder der mobilen App von chatGPT zugreifen. Auch wenn die genauen Zahlen nicht bekannt sind, gibt's strenge tägliche Limits für Free-Accounts und immer höhere, stabilere Kontingente für Plus- und Pro-Pläne.

Entwickler können das neue Modell GPT-Image-1.5 über die OpenAI-API und den Azure OpenAI-Dienst nutzen, wo es für die Bilderzeugung und -bearbeitung zur Verfügung steht. Wir rechnen damit, dass das Modell bald in die großen Kreativsuiten von Drittanbietern integriert wird, aber Entwickler können schon jetzt Bearbeitungsworkflows direkt in ihre eigenen Anwendungen einbauen, indem sie die Endpunkte v1/images/generations und v1/images/edits nutzen.

Im Gegensatz zu seinem Vorgänger zeigt GPT-Image-1.5 die Bildausgabe als separat berechnete Tokens an und nutzt dafür bildspezifische API-Endpunkte anstelle des einheitlichen /v1/responses. Du bezahlst nur für die Token, die du brauchst, um die Änderungen zu machen, und nicht jedes Mal für ein komplett neues Bild.

Deshalb soll das neue Modell etwa 20 % günstiger sein als das alte, obwohl die Preise pro Token im Vergleich zu GPT-Image-1 nicht geändert haben.

Wie gut sind chatGPT-Bilder?

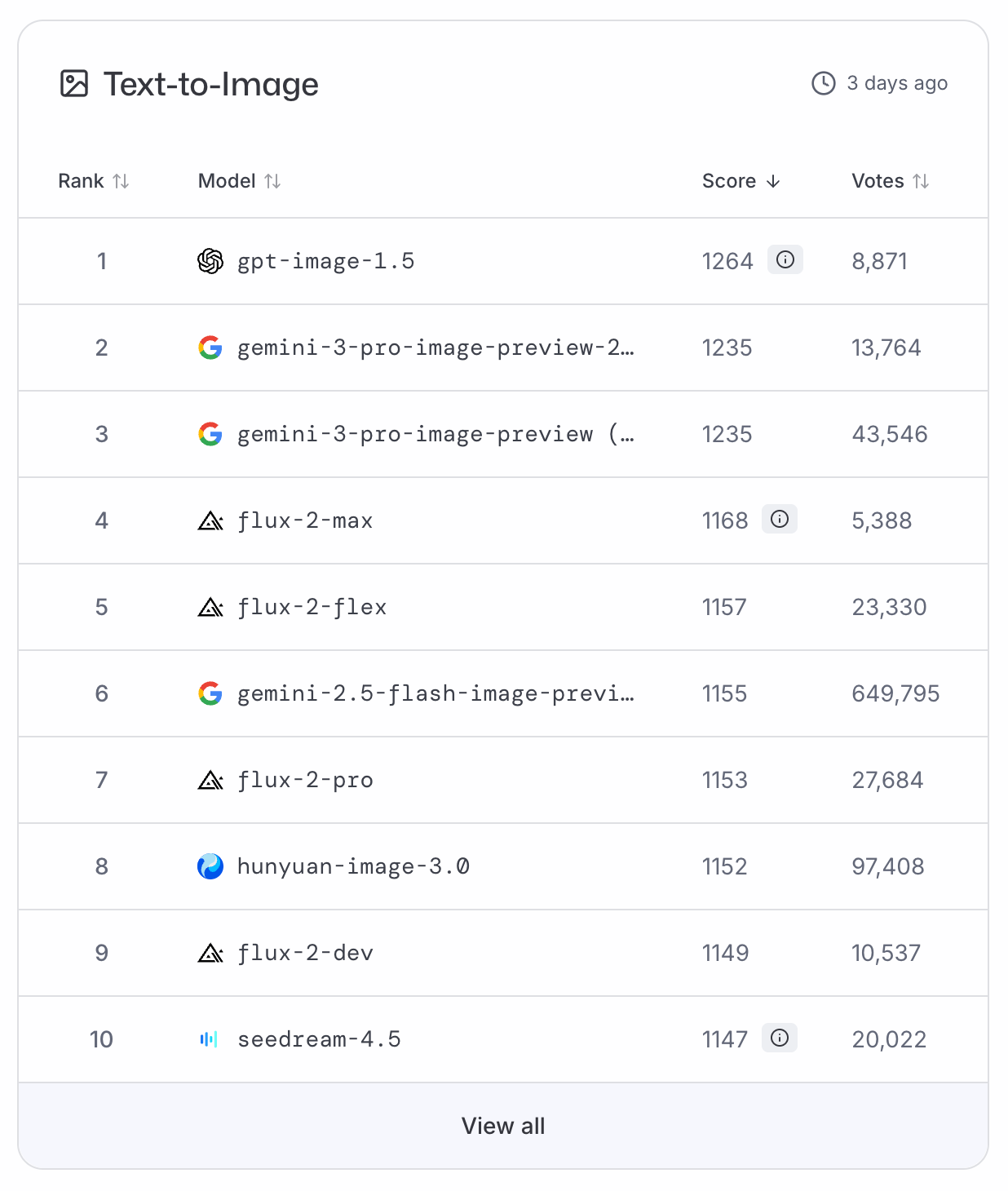

GPT-Image-1.5 hat sich sofort an die Spitze der LMArena und ArtificialAnalysis Text-zu-Bild-Ranglisten und hat Nano Banana Pro auf den zweiten Platz verdrängt. Da es im Moment keine Vergleichsdaten gibt, müssen wir uns auf diese Abstimmungsrankings verlassen, um eine objektive Einstufung zu bekommen.

Um einen bekannten Astronauten zu zitieren: GPT-Image-1.5 ist ein kleiner Schritt für die Branche, aber ein riesiger Sprung für OpenAI.

Auch wenn die präzise Bearbeitung nicht ganz neu ist, ist die native Integration in chatGPT die größte Neuerung in dieser Version. Aber Vorsicht, es kommt auf die Genauigkeit an: Denk dran, nur die notwendigen Bereiche auszuwählen, um Probleme wie den „kopflosen Eisbären” zu vermeiden, der beim Testen aufgetaucht ist.

Ich finde, das Update bringt echt einen großen Qualitätssprung, was man auch in den Ranglisten sehen kann. Standardbilder wirken lebendiger und Infografiken sehen viel weniger vereinfacht aus als früher.

Die Nutzer haben jetzt viel mehr Kontrolle über jede Ausgabe und müssen nicht mehr wie früher komplizierte Folgeaufforderungen erstellen und auf das Beste hoffen. Das liegt vor allem daran, dass die Detailerhaltung echt gut funktioniert. Bei unseren Tests hat es die Elemente komplett intakt gehalten.

Die Konsistenz der Charaktere ist stark, aber man sollte auf den „Sticker-Effekt“ und Probleme mit der logischen Perspektive achten. Gezielte Bearbeitungen machen die Korrektur zwar einfacher, aber in Szenen mit vielen Leuten gibt's immer noch Einschränkungen.

chatGPT-Bilder vs. Nano Banana Pro

Der aktuelle Spitzenreiter, den chatGPT Images schlagen muss, ist ganz klar Googles Nano Banana Pro. Die folgende Tabelle zeigt, wie die beiden Modelle im Vergleich abschneiden:

|

ChatGPT Images |

Nano Banana Pro |

|

|

Bearbeitungsmodell |

Genauigkeit: Bereichsauswahl & Bearbeitung an Ort und Stelle |

Begründung: Konversationsbasierte und intelligente Maskierung |

|

Workflow |

Spezieller kreativer Arbeitsbereich |

Eingebaute Chat-Funktion |

|

Iteration |

Effizient: Teilweise Regeneration |

Explorativ: Remixen |

|

Konsistenz |

Hohe Layout- und Detailtreue |

Hohe Layout- und Detailtreue |

|

Ecosystem |

OpenAI & Azure |

Google / Gemini Stack |

GPT-Image-1.5 und Nano Banana Pro liefern beide super Ergebnisse, aber sie haben unterschiedliche Herangehensweisen beim Bearbeiten, unterschiedliche Arbeitsabläufe und unterschiedliche Kundenfokussierungen.

chatGPT Images setzt auf pixelgenaue Isolierung, die ihre Stärke in der manuellen Steuerung hat: Du kannst einen bestimmten Bereich auswählen, und dieser wird dann wie eine Leinwand zum Ausmalen behandelt, während der Rest des Bildes gesperrt bleibt. Nano Banana Pro hingegen versucht zu verstehen, was du vorhast, um die richtigen Änderungen vorzunehmen.

Was den Arbeitsablauf angeht, haben sich beide Firmen auch für unterschiedliche Wege entschieden: Der Reiter „Bilder“ in chatGPT wirkt wie ein kreatives Studio, das von den Unterhaltungen getrennt ist, während Nano Banana Pro komplett in den Chat-Stream eingebaut ist.

Wann sollte man chatGPT Images verwenden? Nano Banana Pro

Ich würde dir empfehlen, chatGPT Images zu nutzen, wenn du Layouts anpassen, Text bearbeiten oder präzise Änderungen an einem bestehenden Bild vornehmen musst, ohne den Stil zu verändern. Nimm Nano Banana Pro, wenn du datenintensive Visualisierungen erstellen, mehrere Bilder mischen oder lieber einen smarten Assistenten deine Absicht erraten lassen möchtest, anstatt alles manuell zu steuern.

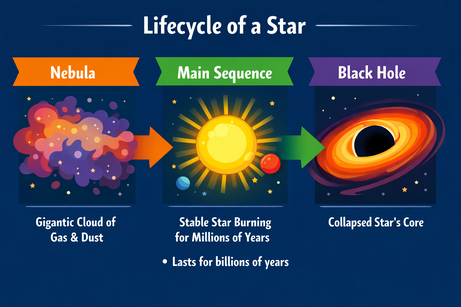

Mit denselben Eingabeaufforderungen wie oben habe ich die Testbilder neu erstellt. Ich persönlich fand die Infografiken von Nano Banana Pro besser, während die Bärenbilder für mich gleichwertig waren.

Prompt: Eine Infografik, die den „Lebenszyklus eines Sterns” erklärt. Drei Abschnitte: Nebel, Hauptreihe, Schwarzes Loch. Verwende einen flachen Vektorstil. (Nano Banana Pro)

Anwendungsfälle für chatGPT-Bilder

Nach unseren praktischen Tests und den besonderen Stärken von GPT-Image-1.5 ist das Modell echt gut bei wiederholten Prozessen und beim Bearbeiten von Texten. Hier sind ein paar der besten Anwendungsfälle:

- Marketing-Workflow: Erstellen von Social-Media-Anzeigen oder Produktfotos, bei denen bestimmte Details geändert werden können (z. B. „Den Pullover von rot auf blau ändern“).

- Infografiken für die Bildung: Diagramme für Lehrbücher, Präsentationen oder Blogs erstellen, wie unser Beispiel „Lebenszyklus eines Sterns“

- Storyboard erstellen: Stell dir ein Drehbuch oder einen Comic vor, in dem dieselbe Figur an verschiedenen Orten auftauchen muss.

- Mode: Mit hybrider Inhaltserstellung Outfit-Kombinationen visuell erkunden, wie in diesem FLUX.2-Tutorial zum Visualisieren von Garderoben

- Innenarchitektur: Kombiniere eine grobe Skizze oder ein Foto mit Tipps, um Räume in einem bestimmten Stil neu zu dekorieren.

- UI/UX-Modelle: Schnell sehen, wie die Startseite einer Website oder die Verpackung für ein neues Produkt aussehen könnte

Abschließende Gedanken

Seit der Veröffentlichung von Nano Banana Pro steht OpenAI unter großem Druck, mithalten zu können. Mit diesem vielversprechenden Update sind sie wieder im Rennen um das leistungsfähigste Text-zu-Bild-KI-Modell. Es ist nicht perfekt, aber wenn du dich auf das Wesentliche konzentrierst, wie klare Typografie und präzise Bearbeitung, kannst du gute Ergebnisse erzielen. Probier die Funktion doch mal in deiner chatGPT-Benutzeroberfläche oder im OpenAI Playgroundaus. Wenn du Inspiration suchst, kannst du dir die Galerie und den Leitfaden anschauen.

Wenn du mit der Entwicklung von Tools mit GPT-Modellen loslegen willst, schau dir unsere OpenAI-Grundlagen Skill-Lernpfad genau das Richtige für dich.

FAQs

Welche Arten von Bildbearbeitungen kann chatGPT Images machen?

chatGPT Images kann präzise Bearbeitungen machen, wie zum Beispiel Elemente hinzufügen, entfernen, kombinieren, mischen und umwandeln. Es ist so gemacht, dass es nur das ändert, was du willst, und dabei wichtige Details wie Beleuchtung, Bildaufbau, Gesichtsähnlichkeit und die allgemeine Konsistenz der Szene beibehält.

Inwiefern ist GPT-Image-1.5 besser als das vorherige Bildmodell?

Im Vergleich zu GPT Image 1.0 macht GPT-Image-1.5 Anweisungen zuverlässiger, behält wichtige visuelle Details auch nach mehreren Bearbeitungen bei, rendert dichten und kleinen Text genauer und erzeugt natürlichere Bilder. Es ist auch schneller und kostengünstiger in der API.

Ist chatGPT Images für alle zugänglich?

Das neue chatGPT-Bildermodell wird weltweit für alle chatGPT-Nutzer und API-Nutzer eingeführt. Der neue Bereich zum Erstellen von Bildern in chatGPT ist jetzt für die meisten Leute verfügbar, der Zugang für Business- und Enterprise-Kunden kommt später.

Können Entwickler das neue Bildmodell über die API nutzen?

Datenwissenschaftsredakteur bei DataCamp | Prognosen erstellen und mit APIs arbeiten ist genau mein Ding.