Kurs

Gleich nach dem beeindruckenden Gemini 3 von Google hat Anthropic kürzlich Claude Opus 4.5 angekündigt und es als das „beste Modell der Welt für Programmierung, Agenten und Computernutzung” gepriesen.

Trotz der echt beeindruckenden Benchmarks von Gemini 3 lag es beim SWE-Benchmark, einem Test für Software-Engineering-Fähigkeiten, immer noch hinter Claude Sonnet 4.5. Mit Claude Opus 4.5 hat Anthropic seine eigene Punktzahl beim SWE-Benchmark und anderen Tests übertroffen.

Claude Opus 4.5 ist Anthropics dritte große Modellvorstellung in nur zwei Monaten. Nach Sonnet 4.5 und Haiku 4.5. Und jetzt, wo Anthropic einen Wert von über 350 Milliarden Dollar hat, wissen wir, dass sie die Mittel haben, um in diesem Tempo weiterzumachen.

In diesem Artikel zeig ich dir alles Neue in Claude Opus 4.5, schau mir die Benchmarks und neuen Funktionen an und teste die Möglichkeiten in der Praxis.

Was ist Claude Opus 4.5?

Claude Opus 4.5 ist das neueste große Sprachmodell von Anthropic. Nach Opus 4 ist es das fortschrittlichste Modell von Anthropic, das sich auf Codierung, Schlussfolgerungen und lang andauernde Aufgaben konzentriert. Das Modell hat beim SWE-Bench 80,9 % und beim Terminal-Bench 59,3 % erreicht.

Claude Opus 4.5 ist jetzt in den Apps von Anthropic, der API und den wichtigsten Cloud-Plattformen verfügbar.

Was gibt's Neues bei Claude Opus 4.5?

Aus der Ankündigung sind mir folgende Sachen aufgefallen:

- Agentische Kodierung: Opus 4.5 ist auf dem neuesten Stand der Technik auf SWE-bench Verified und schlägt Googles Gemini 3 Pro und OpenAIs GPT-5.1. Anthropic hat das Modell auch bei einer kniffligen Hausarbeit getestet, die sie angehende Performance-Ingenieure machen müssen. Es hat besser abgeschnitten als jeder menschliche Kandidat jemals zuvor.

- Computer-Nutzung: Anthropic sagt, Opus 4.5 sei „das beste Modell der Welt für die Computernutzung”, was bedeutet, dass es mit Software-Schnittstellen interagieren, auf Schaltflächen klicken, Formulare ausfüllen und auf Websites navigieren kann, genau wie ein Mensch.

- Alltägliche Aufgaben: Laut Anthropic ist das Modell „deutlich besser“ im Umgang mit Tabellenkalkulationen und Folien sowie bei der Durchführung tiefgreifender Recherchen.

Zusammen mit der Vorstellung des Modells hat Anthropic ein paar Produkt-Updates angekündigt, auf die ich weiter unten genauer eingehen werde. Dazu gehören Claude für Chrome, die Browser-Erweiterung, mit der Claude über verschiedene Tabs hinweg aktiv werden kann, und Claude for Excel.

Claude Opus 4.5 testen

Ein Bericht wäre nicht komplett, ohne das neue Modell ein oder zwei Tests zu unterziehen. Schauen wir mal, wie die neuen Verbesserungen bei verschiedenen Aufgaben abschneiden:

Opus 4.5 mit einer Wirtschafts-Frage testen

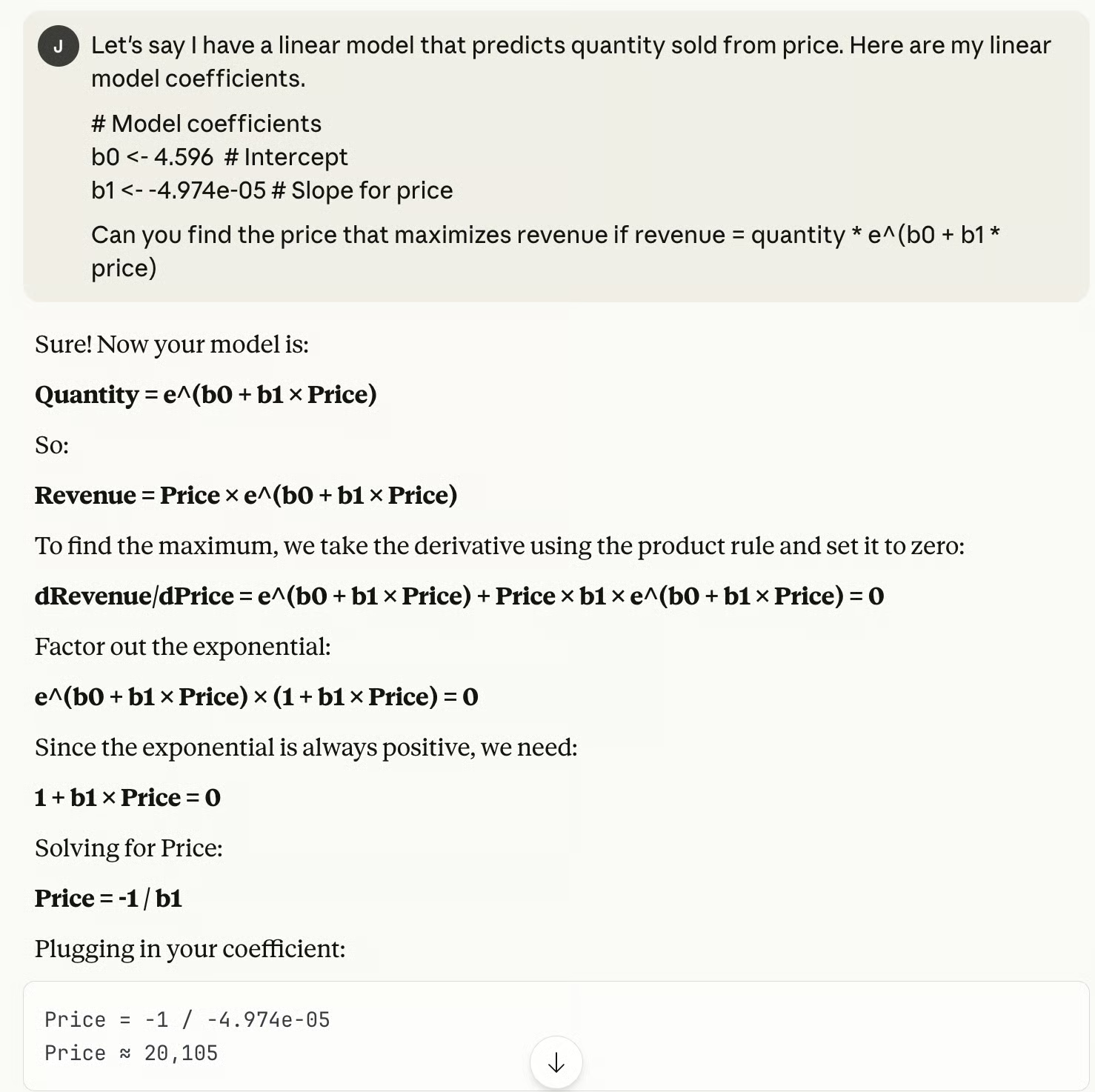

Zuerst wollte ich mal sehen, wie Opus 4.5 mit einem klassischen Problem aus der Wirtschaftsoptimierung klarkommt. Ich stelle mir ein loglineares Nachfragemodell vor, das die verkaufte Menge anhand des Preises vorhersagt. Das ist so was, was man in einem Ökonometriekurs sehen würde, aber es ist auch echt nützlich. Wenn du deine Nachfragekurve und deine Kosten kennst, kannst du den Preis berechnen, der den Gewinn maximiert.

Opus 4.5 hat mir die richtige Antwort gegeben, ohne dass ich groß nachdenken musste, und das alles auf einen Schlag.

Das hat mich beeindruckt, weil so ziemlich jedes Unternehmen, das irgendwas verkauft, eine Vorstellung von der verkauften Menge und dem Preis hat, aber nicht jedes Unternehmen die Ressourcen hat, um Antworten auf grundlegende Optimierungsprobleme zu finden.

Aber hier kannst du mit einer gut gemachten Eingabeaufforderung deine Antwort ganz einfach finden. Natürlich muss der Analyst immer noch entscheiden, ob die Einschränkungen wirklich richtig modelliert wurden.

Das hat mir auch gefallen: Opus 4.5 hat seine Arbeit gezeigt. Ich hab nicht nur 'ne Nummer bekommen. Es ging um Ableitungen, Factoring und Algebra. Wenn es einen Fehler gemacht hätte, hätte ich sehen können, wo.

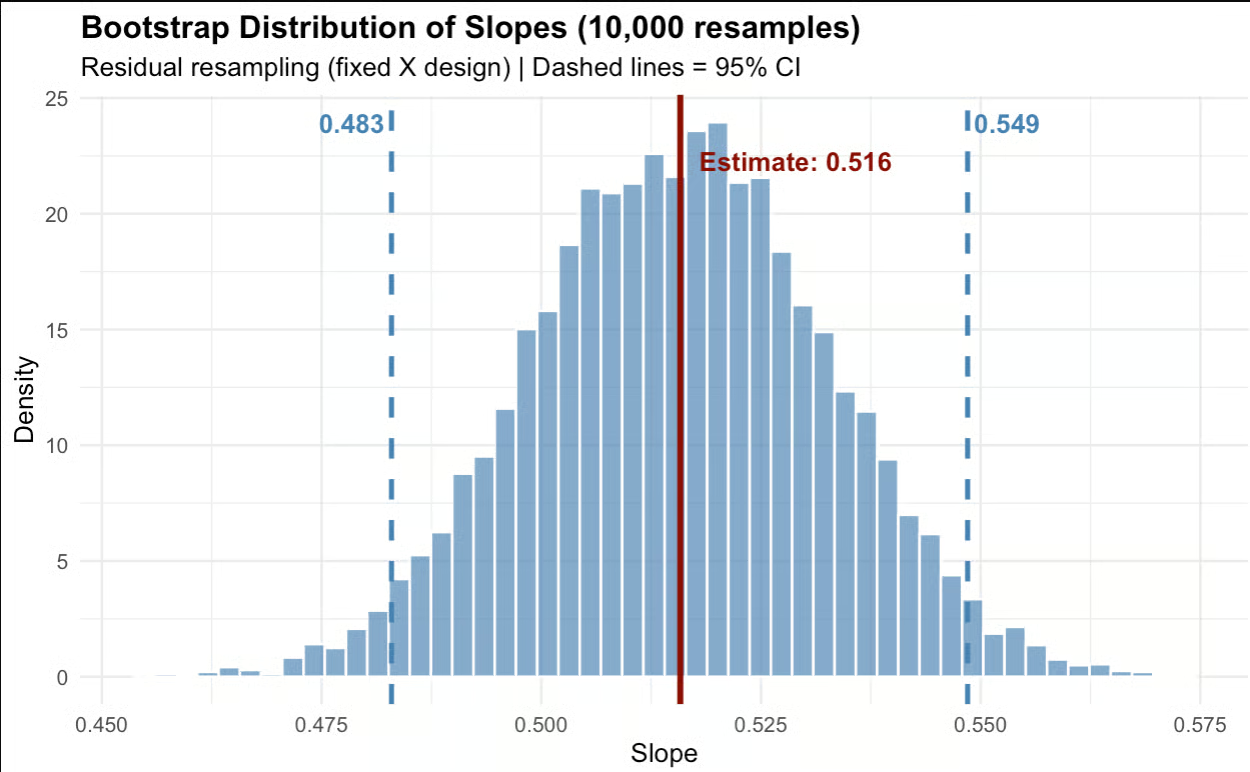

Opus 4.5 mit einer Statistikfrage testen

Als Nächstes wollte ich Opus 4.5 bei einer Statistikfrage testen. Ich hab einen Datensatz erstellt, bei dem „ yield “ eine Funktion von „ temperature “ mit hinzugefügtem Rauschen war.

library(tidyverse)

set.seed(1024)

# Generate data

n <- 100

df <- data.frame(

temperature = seq(0, 100, length.out = n)

) %>%

mutate(yield = 0.5 * temperature + 10 + rnorm(n, 0, 5))Dann hab ich Claude diese Eingabe gegeben.

Claude hat mir die folgenden Daten geschickt, mit denen ich unten ein Histogramm erstellt habe.

# Fit model

fit <- lm(yield ~ temperature, data = df)

fitted_vals <- fitted(fit)

resids <- residuals(fit)

original_slope <- coef(fit)[2]

# Residual bootstrap

set.seed(123)

n_boot <- 1000

boot_slopes <- numeric(n_boot)

for (i in 1:n_boot) {

new_y <- fitted_vals + sample(resids, replace = TRUE)

boot_fit <- lm(new_y ~ df$temperature)

boot_slopes[i] <- coef(boot_fit)[2]

}

# Confidence intervals

ci_lower <- quantile(boot_slopes, 0.025)

ci_upper <- quantile(boot_slopes, 0.975)

# Plot

ggplot(data.frame(slope = boot_slopes), aes(x = slope)) +

geom_histogram(bins = 40, fill = "gray70", color = "white") +

geom_vline(xintercept = original_slope, color = "red", linewidth = 1) +

geom_vline(xintercept = ci_lower, color = "steelblue", linetype = "dashed", linewidth = 1) +

geom_vline(xintercept = ci_upper, color = "steelblue", linetype = "dashed", linewidth = 1) +

labs(

title = "Bootstrap Estimate: Effect of Temperature on Yield",

subtitle = paste0("Estimate: ", round(original_slope, 3),

" | 95% CI: [", round(ci_lower, 3), ", ", round(ci_upper, 3), "]"),

x = "Slope (yield per °C)",

y = "Count"

) +

theme_minimal()

Ich muss sagen, dass mir das Ergebnis gefällt. Opus 4.5 hat ein Konfidenzintervall für die Steigung gefunden, was genau das ist, was ich eigentlich wollte.

Es hat eine Bootstrap-Methodeverwendet, die eine gute Technik ist, um Konfidenzintervalle bei Heteroskedastizität vorhanden ist. Außerdem wurde speziell ein Bootstrap-Verfahren für die Residuen verwendet, statt einer anderen Bootstrap-Methode, die (X,Y)-Paare neu auswählt, was einen Fehler im X-Term angenommen hätte.

Das ist ein kleiner, aber wahrscheinlich wichtiger Punkt für Leute, die so was machen: Ein Residual-Bootstrap wäre besser, wenn X wie in meiner Eingabe festgelegt ist und du daher eine Inferenz in Abhängigkeit von genau diesen X-Werten wünschst, wie beispielsweise bei einer wissenschaftlichen Studie. Was ich sagen will, ist, dass Opus 4.5 auf die Feinheiten in der Eingabe geachtet hat.

Opus 4.5 mit einer Matheaufgabe testen

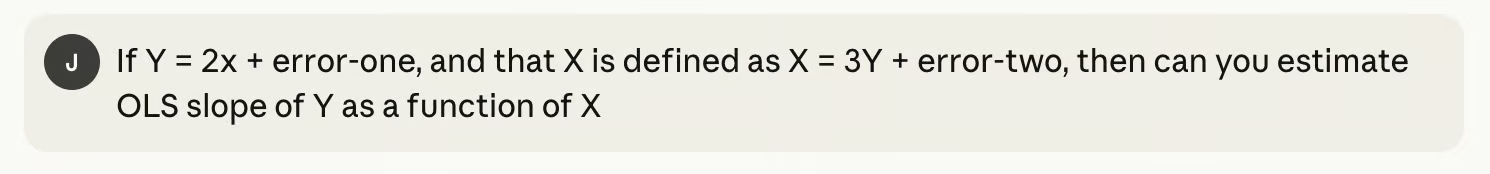

Als Nächstes wollte ich schauen, ob ich Opus 4.5 irgendwie zum Absturz bringen kann.

In diesem Fall war das Modell mir weit voraus. Opus 4.5 hat gemerkt, dass meine Frage irgendwie im Kreis lief – ich habe X durch Y definiert und umgekehrt, also konnten wir mit den Daten, die wir hatten, keine vernünftige Schätzung für die Steigung einer Regressionsgeraden machen.

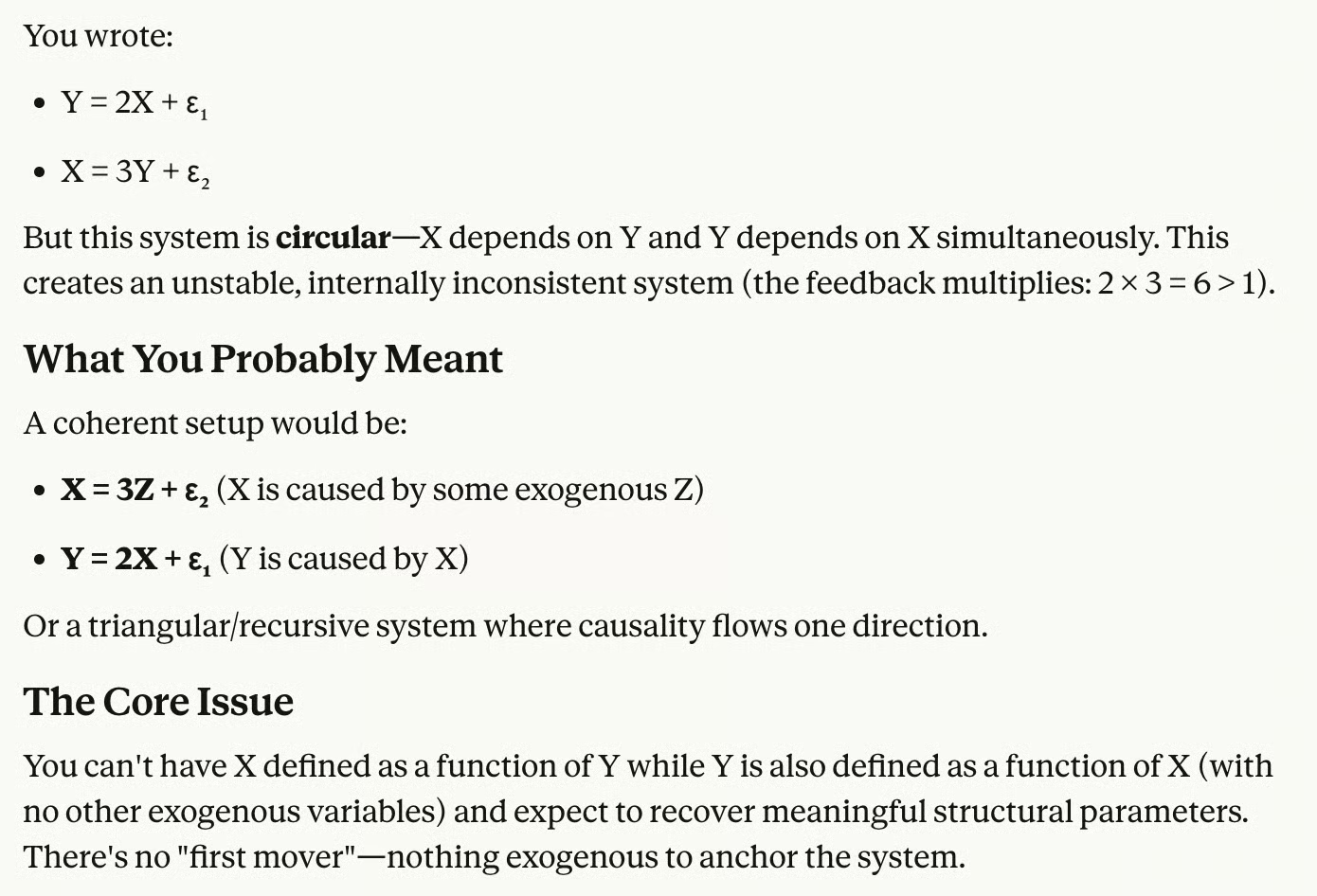

Opus 4.5 für die SQL-Optimierung testen

Schließlich dachte ich, es könnte Spaß machen, Opus 4.5 bei einer SQL-Frage zu testen. Ich hab 'ne funktionierende, aber echt ineffiziente SQL-Abfrage geschickt.

-- Find customers who placed orders above their average order value in 2024

SELECT

c.customer_id,

c.customer_name,

o.order_id,

o.order_date,

o.order_total

FROM customers c

JOIN orders o ON c.customer_id = o.customer_id

WHERE o.order_date >= '2024-01-01'

AND o.order_date < '2025-01-01'

AND o.order_total > (

SELECT AVG(o2.order_total)

FROM orders o2

WHERE o2.customer_id = c.customer_id

)

AND c.customer_id IN (

SELECT DISTINCT o3.customer_id

FROM orders o3

WHERE o3.order_date >= '2024-01-01'

)

AND EXISTS (

SELECT 1

FROM customer_preferences cp

WHERE cp.customer_id = c.customer_id

AND cp.email_opt_in = 1

)

ORDER BY (

SELECT COUNT(*)

FROM orders o4

WHERE o4.customer_id = c.customer_id

) DESC;Ich hab Opus 4.5 gebeten, die Abfrage zu verbessern. Es hat mir in etwa einer Sekunde eine Antwort gegeben.

-- Find customers who placed orders above their average order value in 2024

WITH customer_avg AS (

SELECT

customer_id,

AVG(order_total) AS avg_order_total,

COUNT(*) AS order_count

FROM orders

GROUP BY customer_id

)

SELECT

c.customer_id,

c.customer_name,

o.order_id,

o.order_date,

o.order_total

FROM customers c

JOIN orders o ON c.customer_id = o.customer_id

JOIN customer_avg ca ON c.customer_id = ca.customer_id

JOIN customer_preferences cp ON c.customer_id = cp.customer_id

WHERE o.order_date >= '2024-01-01'

AND o.order_date < '2025-01-01'

AND o.order_total > ca.avg_order_total

AND cp.email_opt_in = 1

ORDER BY ca.order_count DESC;Unter anderem hat Opus 4.5 die korrelierte Unterabfrage für „ AVG “ durch eine CTE ersetzt. (Die ursprüngliche Abfrage hat „ AVG(order_total) “ für jede einzelne Zeile neu berechnet, aber die CTE berechnet jetzt den Durchschnitt jedes Kunden im Voraus.) Opus 4.5 hat auch die unnötige Klausel „ IN (SELECT DISTINCT ...) “ rausgeschmissen, die nur unnötige Arbeit gemacht hat. Und es hat die Unterabfrage „ EXISTS “ in „ JOIN “ umgewandelt, was besser ist.

Claude Opus 4.5 Agenten und agentische Fähigkeiten

Es gab noch mehr coole Sachen in der neuesten Version von Anthropic. Schauen wir uns das genauer an:

Funktionen der Entwicklerplattform

Anthropic hat ein paar neue Bausteine für Entwickler hinzugefügt. Das Wichtigste ist derParameter „ “ (Anstrengung), mit dem du einstellen kannst, wie viel das Modell nachdenkt, bevor es antwortet. Stell es niedrig ein, wenn du schnelle, leichte Aufgaben erledigen willst; stell es höher, wenn das Modell etwas zu knacken hat.

Laut Anthropic erreicht Opus 4.5 bei mittlerem Aufwand die beste SWE-Benchmark-Punktzahl von Sonnet 4.5, verbraucht dabei aber 76 % weniger Output-Tokens. Bei hoher Auslastung ist es um mehr als 4 % schneller als Sonnet – und braucht trotzdem fast nur halb so viele Tokens.

Es gibt auch ein besseres Kontextmanagement und Speicher. Bei lang laufenden Agenten kann Claude jetzt automatisch den früheren Kontext zusammenfassen, damit es nicht mitten in der Aufgabe hängen bleibt. Das geht einher mit der Kontextverdichtung, die dafür sorgt, dass Agenten länger laufen, ohne dass man viel eingreifen muss.

Schließlich ist Opus 4.5 anscheinend ziemlich gut darin, mehrere Agenten zu koordinieren, was heißt, dass es ein Team von Unteragenten leiten könnte.

Claude Opus 4.5 Tiefgehende Forschung

Anscheinend hat sich die Leistung von Opus 4.5 bei einer eingehenden Forschungsbewertung um ungefähr 15 % verbessert.

Ich hab die tiefgehende Recherchefunktion selbst ausprobiert. Ich hab's gebeten, mir einen Bericht über alte englische Wörter zu machen, die es heute noch gibt, aber nicht mehr so oft benutzt werden, und wie sich diese Wörter im Laufe der Zeit verändert haben. Der Bericht war in sieben Minuten fertig:

Ich war echt beeindruckt von der Qualität des Berichts, was die Spannung, den Schreibstil, die Struktur und die Recherche angeht.

Es war kein total trockenes Dokument, das voll mit alten oder veralteten Wörtern war. Ich gebe zu, dass manche Abschnitte besser hätten voneinander abgegrenzt werden können. Der mittlere Teil des Berichts war ein bisschen langweiliger als der Rest. Aber – und das ist der springende Punkt – es war echt gut recherchiert. Schau dir einfach mal diese Zitate an:

Außerdem hab ich ein echt cooles neues Wort gelernt: „Apricity“, das heißt die Wärme der Sonne im Winter.

Claude Code

Anthropic hat zwei Upgrades für Claude Codeherausgebracht.

Der sogenannte Planmodus erstellt jetzt genauere Pläne, bevor er loslegt. In der Praxis heißt das, dass Claude zuerst ein paar klärende Fragen stellt und dann eine bearbeitbare „ plan.md “-Datei erstellt, die du checken und anpassen kannst, bevor sie loslegt. Die Idee dahinter ist, dir einen Fehlstart zu ersparen.

Die Integration von Desktop-Apps ist das andere große Thema. Claude Code ist jetzt in der Desktop-App verfügbar, was heißt, dass du mehrere lokale und Remote-Sitzungen gleichzeitig laufen lassen kannst. Um das Beispiel von Anthropic zu nehmen: Einer der Agenten behebt Fehler, ein anderer recherchiert GitHub-Probleme und ein dritter aktualisiert die Dokumentation.

Agenten für Verbraucher-Apps

Ein paar neue Funktionen sind jetzt in den Claude-Apps für Verbraucher da:

Mit Claude für Chrome kannst du Claude Aufgaben über deine Browser-Tabs hinweg erledigen lassen. Jetzt ist es für alle Max-Nutzer verfügbar. Stell dir das wie einen Browser-Agenten vor, der auf mehreren Websites navigieren, klicken, Formulare ausfüllen und Infos abrufen kann.

Claude für Excel macht Tabellenkalkulationen in Claude automatisch. Das wurde schon mal angekündigt, aber Anthropic hat jetzt den Beta-Zugang auf alle Max-, Team- und Enterprise-Nutzer ausgeweitet, sodass es immer realer wird.

Die Überarbeitung der langen Konversationsabwicklung behebt eine nervige Einschränkung. Früher wurden lange Chats nach einer bestimmten Zeichenanzahl einfach abgebrochen, sodass man eine neue Unterhaltung starten musste. Jetzt fasst Claude automatisch frühere Teile der Unterhaltung im Hintergrund zusammen, was Speicherplatz freimacht, sodass du nicht an deine Grenzen stößt.

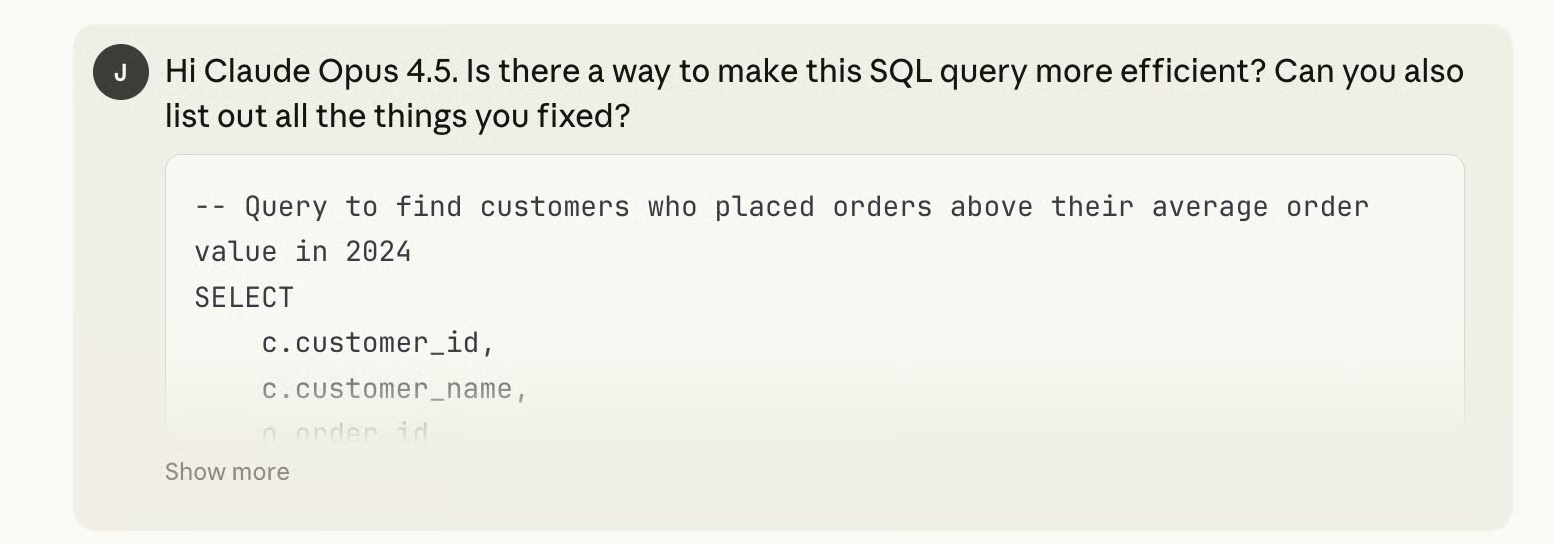

Claude Opus 4.5 Benchmark-Ergebnisse

Opus 4.5 wurde, wie die früheren Claude-Modelle, mit den üblichen Benchmarks in den Bereichen agentenbasierte Codierung, Werkzeuggebrauch, Computernutzung und Problemlösung getestet. Hier sind die wichtigsten Ergebnisse für Opus 4.5.

Opus 4.5 hat bei vielen wichtigen Tests die Bestnote bekommen. Alles, was mit praktischen Tätigkeiten zu tun hat, wie zum Beispiel das Schreiben von Code, der Tests besteht (SWE-Bench), die Verwendung von Tools in mehrstufigen Arbeitsabläufen (τ2-Bench, MCP Atlas) und die Bedienung eines Computers (OSWorld). Opus 4.5 liegt oft weit vorne.

Die Lücke beim Einsatz von skalierten Werkzeugen ist echt riesig: 62,3 % gegenüber 43,8 % für den Zweitplatzierten, der auch Claude heißt! Das zeigt aber, wie viel Anthropic in die Verbesserung seiner Leistung investiert, vor allem bei agentenbasierten Aufgaben. Auch wenn ihr älteres Modell im Moment in einigen Bereichen vorne liegt, halten sie sich nicht zurück.

Es sieht so aus, als hätte Gemini 3 Pro bei einigen der wissensintensiven Benchmarks, wie zum Beispiel dem logischen Denken auf Hochschulniveau (GPQA Diamond) und mehrsprachigen Fragen und Antworten (MMMLU), die Nase vorn. Diese Benchmarks belohnen wahrscheinlich eher umfangreiche Trainingsdaten und sorgfältiges Denken als auswendig gelernte Fakten, und Google hat natürlich jede Menge Ressourcen.

Fortschritte bei Sicherheit und Ausrichtung

Die Verbesserungen von Anthropic betreffen nicht nur die Bereiche Programmierung, Forschung und Computernutzung. Es wird echt viel Wert auf Sicherheit gelegt, und es wird gesagt, dass dieses Modell das sicherste und „robusteste Modell“ ist, das sie bisher rausgebracht haben.

Diese Behauptung wird durch eine Verringerung des sogenannten „besorgniserregenden Verhaltenswerts” gestützt, der niedriger ist als bei den anderen 4.5-Modellen sowie bei GPT-5.1 und Gemini 3 Pro. Anthropic hat Opus 4.5 auch robuster gegen Prompt-Injection-Angriffe gemacht, die das Modell zu schädlichem Verhalten verleiten können.

Claude 4.5 Opus – Preise und Verfügbarkeit

Claude Opus 4.5 ist ab heute für die ganze Produktpalette von Anthropic verfügbar, also für die Claude-App, die API und alle drei großen Cloud-Plattformen. Entwickler können direkt über die Modell-ID drauf zugreifen: claude-opus-4-5-20251101.

Auch die Preise sind deutlich gesunken. Mit 5 Dollar pro Million Input-Token und 25 Dollar pro Million Output-Token macht Opus 4.5 die Top-Funktionen von Anthropic viel zugänglicher.

Für Firmenkunden könnte die Preisänderung echt wichtig sein. Die Kombination aus niedrigeren Kosten, erweitertem API-Zugriff und größerer Verfügbarkeit bei verschiedenen Cloud-Anbietern macht Opus 4.5 zu einer coolen Option.

Fazit

Claude Opus 4.5 ist Anthropics bisher deutlichste Aussage dazu, wo sie sich im KI-Wettlauf sehen. Während Google multimodales Verständnis und geräteinterne Modelle vorantreibt, setzt Anthropic stark auf Aktionen: agentenbasierte Programmierung, Werkzeugnutzung und Computerinteraktion.

Die Benchmark-Ergebnisse sprechen echt für sich: Opus 4.5 hat die besten Ergebnisse erzielt, die je bei Software-Engineering-Benchmarks gemessen wurden, und kann ohne viel Anleitung das Debugging mehrerer Systeme hinkriegen.

Meine Tests zeigen, was die Benchmarks schon andeuten: Opus 4.5 kann echt gut mit mehrstufigen Aufgaben umgehen. Egal, ob es um Bootstrap-Simulationen oder die Zusammenfassung von Forschungsergebnissen aus verschiedenen Artikeln ging – das Modell hat Probleme so angegangen, wie es ein Denker tun würde: flexibel und mit klaren Argumenten. Ich denke, wenn du deine Arbeitsabläufe verbessern willst, ist das das Wichtigste.

Wenn du mehr über Claude-Modelle erfahren möchtest, empfehle ich dir den Kurs „Einführung in Claude-Modelle“.

Claude Opus 4.5 – Häufig gestellte Fragen

Was ist der Unterschied zwischen Claude Opus 4.5 und Sonnet 4.5 sowie Haiku 4.5?

Opus 4.5 ist das leistungsstärkste Modell, das für komplexe Denkprozesse, Codierung und lang andauernde Aufgaben entwickelt wurde. Sonnet 4.5 bringt Leistung und Kosten unter einen Hut, während Haiku 4.5 auf Geschwindigkeit und Effizienz ausgelegt ist.

Wo kann ich Claude Opus 4.5 finden?

Es ist über die Claude-Web- und Mobil-Apps, die Claude-API und alle großen Cloud-Plattformen verfügbar, sodass es sich leicht in verschiedene Arbeitsabläufe einbinden lässt.

Hat Anthropic Claudes Kontext- oder Speicherfähigkeiten verbessert?

Ja. Opus 4.5 hat jetzt ein besseres Kontextmanagement, kann längere Unterhaltungen besser verarbeiten und bietet eine verbesserte Zusammenfassung, um komplexere Schlussfolgerungen und mehrstufige Aufgaben zu unterstützen.

Welche Sicherheitsstandards hat Opus 4.5?

Es erfüllt die höchsten Sicherheitsstandards von Anthropic, mit großen Verbesserungen bei der Ausrichtung, reduzierten Werten für „besorgniserregendes Verhalten“ und einer höheren Widerstandsfähigkeit gegen Prompt-Injection-Angriffe.

Welche Anwendungsfälle profitieren am meisten von Opus 4.5?

Opus 4.5 ist super für komplizierte, mehrstufige Denkprozesse wie Debugging, Forschung und Multi-Agenten-Orchestrierung. Für einfachere oder schnellere Aufgaben sind Sonnet oder Haiku vielleicht günstiger.

Autorin und Redakteurin im Bereich der Bildungstechnologie. Engagiert bei der Erforschung von Datentrends und begeistert davon, Data Science zu lernen.