Curso

El uso de modelos lingüísticos de gran tamaño conlleva costes reales. Pagas por cada token procesado, cada ciclo de GPU utilizado y cada capa de complejidad añadida a un modelo. Aunque los precios han bajado, la factura sigue aumentando rápidamente cuando trabajas con aplicaciones grandes, comandos largos o actualizaciones frecuentes.

He visto lo rápido que esto se convierte en un problema. Los equipos asumen que los costes seguirán siendo manejables, solo para darse cuenta de que están gastando el presupuesto en modelos sobredimensionados, indicaciones ineficaces o hardware inactivo.

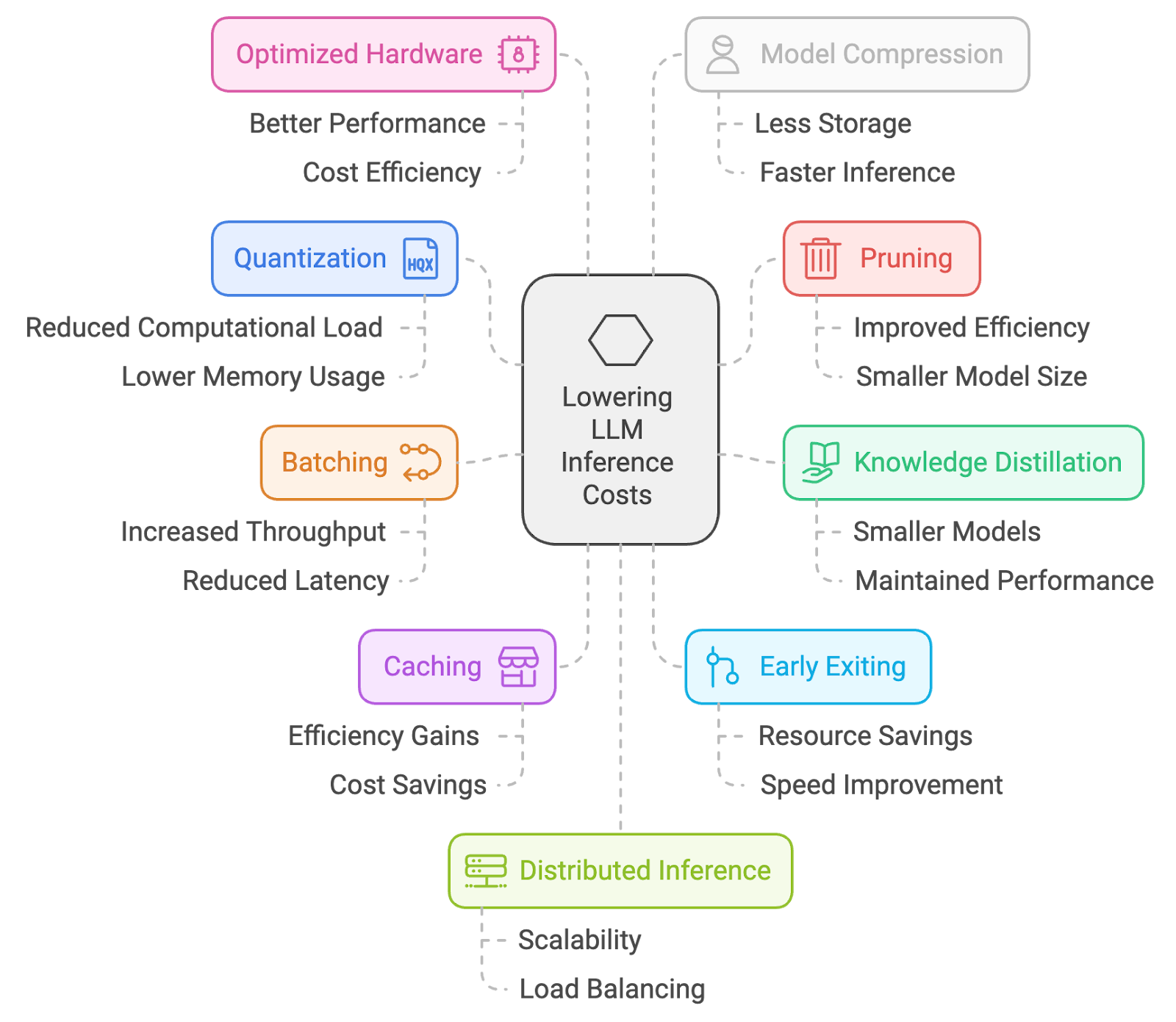

Por eso he recopilado 10 formas prácticas de reducir los costes de inferencia. Desde la cuantificación y la poda hasta el procesamiento por lotes, el almacenamiento en caché y la ingeniería de prompts, estos son los enfoques que utilizo para mantener los LLM asequibles sin sacrificar demasiado rendimiento.

1. Cuantización

La cuantificación es un proceso de reducción de la precisión de los pesos y activaciones del modelo, normalmente de números de coma flotante de 32 bits a representaciones de menos bits (por ejemplo, 16 bits o incluso 8 bits). Esto reduce el consumo de memoria y los requisitos computacionales, lo que permite una inferencia más rápida en dispositivos con recursos limitados.

Cómo se hace:

- Cuantificación posterior al entrenamiento (PTQ): Convierte los pesos del modelo preentrenado a una precisión inferior (por ejemplo, enteros de 8 bits) sin necesidad de volver a entrenarlo. Esto es relativamente sencillo, pero puede provocar cierta pérdida de precisión.

- Entrenamiento consciente de la cuantificación (QAT): Ajusta el modelo con técnicas de cuantificación durante el entrenamiento, lo que da como resultado una mejor conservación de la precisión.

Cómo ayuda:

- Modelo de tamaño más pequeño: Esto se traduce en tiempos de carga más rápidos y un menor uso de memoria, lo que puede reducir significativamente los costes, especialmente en entornos de nube, donde se paga por los recursos utilizados.

- Inferencia más rápida: Con números más pequeños, los cálculos se vuelven más rápidos, lo que se traduce en tiempos de respuesta más rápidos.

La principal desventaja es una posible pérdida de precisión. Aunque las técnicas modernas de cuantificación son bastante buenas, siempre existe la posibilidad de que se produzca una ligera disminución en la precisión del modelo.

2. Poda

La poda es una técnica que consiste en eliminar pesos menos importantes o redundantes de una red neuronal. Al eliminar las conexiones que tienen un impacto mínimo en el rendimiento del modelo, la poda reduce el tamaño y la complejidad computacional del modelo, lo que se traduce en una inferencia más rápida.

Cómo se hace:

- Poda no estructurada: Elimina pesos individuales en función de su magnitud o importancia.

- Poda estructurada: Elimina canales o filtros completos, lo que da lugar a estructuras de modelos más regulares que pueden ejecutarse de manera eficiente en el hardware.

Cómo ayuda:

- Tamaño del modelo más pequeño: Al igual que la cuantificación, la poda da como resultado un modelo más pequeño y rápido de cargar.

- Cálculos reducidos: Menos conexiones significan menos cálculos durante la inferencia, lo que se traduce en tiempos de respuesta más rápidos.

Al igual que con la cuantificación, la principal desventaja es una posible pérdida de precisión. Una poda agresiva puede provocar una notable disminución del rendimiento. Es fundamental encontrar el equilibrio adecuado.

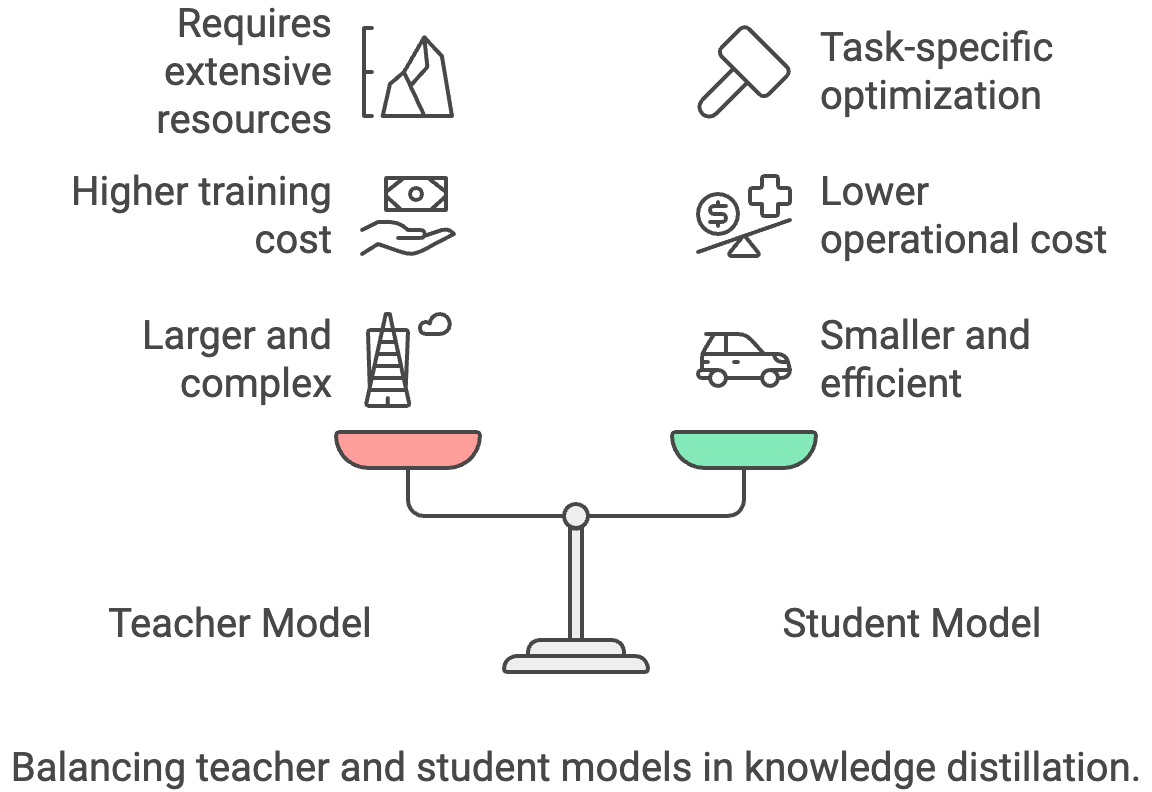

3. Destilación del conocimiento

La destilación del conocimiento es un proceso de transferencia de conocimientos desde un modelo «profesor» grande y complejo a un modelo «alumno» más pequeño y eficiente. El modelo del alumno aprende a imitar el comportamiento del profesor, lo que te permite alcanzar un rendimiento comparable con un tamaño más reducido y una inferencia más rápida.

Cómo se hace:

- Entrena un modelo de estudiante más pequeño: Utiliza los resultados del modelo del profesor más grande (logits o etiquetas suaves) como señales de entrenamiento adicionales para el modelo del alumno.

- Escala de temperatura: Ajusta el parámetro de temperatura durante la destilación para controlar la suavidad de la distribución de salida del profesor.

Cómo ayuda:

- Modelo considerablemente más pequeño: Los modelos de los estudiantes pueden ser considerablemente más pequeños y rápidos que los de sus profesores, lo que se traduce en un importante ahorro de costes.

- Optimización específica para cada tarea: Puedes ajustar el modelo de estudiante para una tarea concreta, haciéndolo aún más eficiente.

La principal desventaja es que necesitas tener acceso a un modelo de enseñanza potente, cuya formación o uso puede resultar caro.

4. Procesamiento por lotes

El procesamiento por lotes implica procesar varias muestras de entrada simultáneamente en un lote durante la inferencia. Esto mejora la eficiencia al utilizar las capacidades de procesamiento paralelo del hardware, lo que se traduce en una inferencia global más rápida.

Cómo se hace:

- Acumular solicitudes: Recopilar varias solicitudes de inferencia y procesarlas juntas como un lote.

- Procesamiento por lotes dinámico: Ajusta el tamaño del lote de forma dinámica en función de las tasas de solicitudes entrantes para equilibrar la latencia y el rendimiento.

Cómo ayuda:

- Mayor rendimiento: El procesamiento por lotes puede aumentar significativamente el número de solicitudes procesadas por segundo, lo que hace que tu aplicación sea más eficiente.

- Mejor aprovechamiento del hardware: Las GPU están diseñadas para el procesamiento paralelo, y el procesamiento por lotes te ayuda a aprovechar al máximo sus capacidades.

Sin embargo, el procesamiento por lotes puede introducir una latencia adicional para las solicitudes individuales, ya que el sistema puede esperar a acumular suficientes entradas antes de procesarlas. En aplicaciones en tiempo real o de baja latencia, este retraso adicional puede degradar la experiencia del usuario si no se ajusta cuidadosamente. El procesamiento por lotes dinámico ayuda a mitigar el problema, pero añade complejidad al sistema. También existe el riesgo de que el procesamiento por lotes sea ineficiente cuando el tráfico es desigual, lo que puede reducir el ahorro de costes previsto.

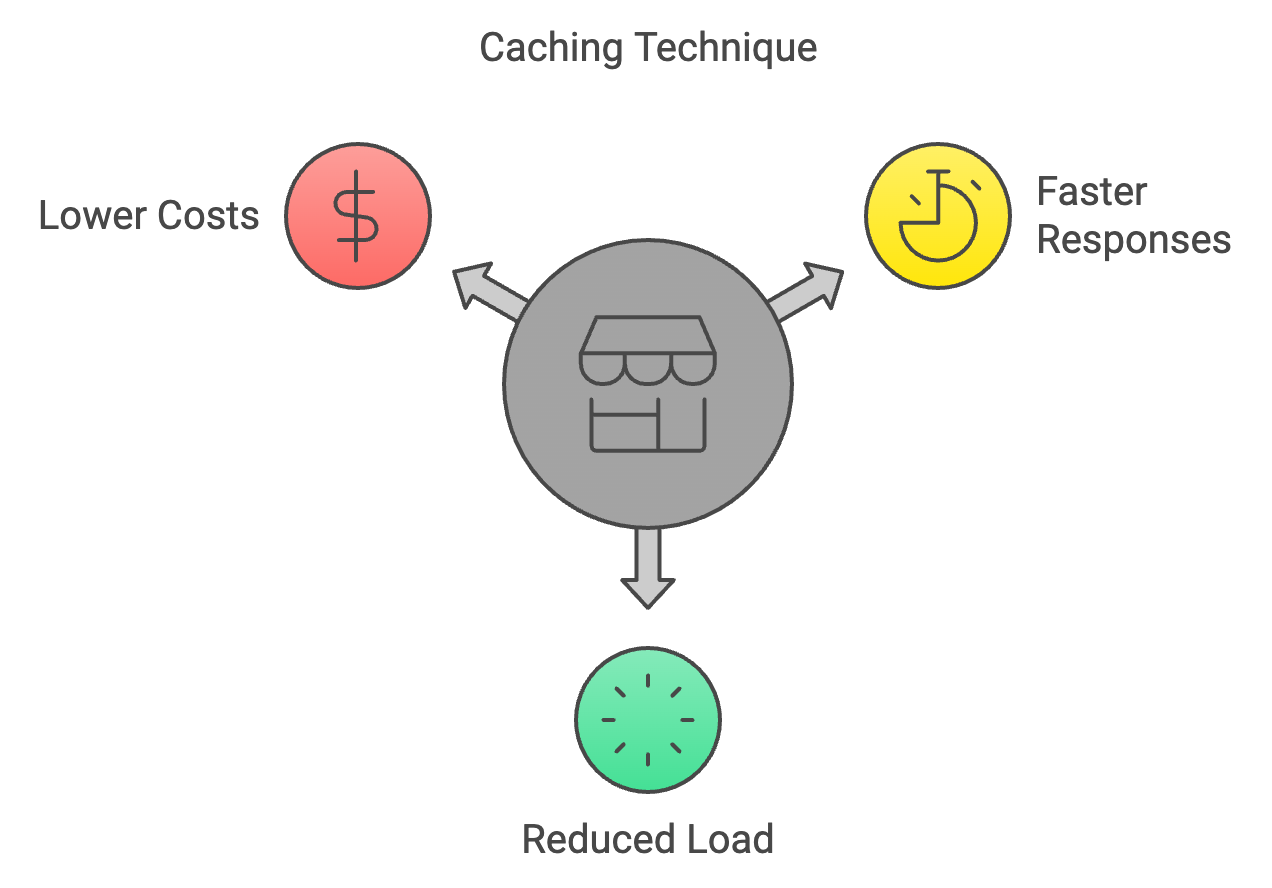

5. Almacenamiento en caché

El almacenamiento en caché es una técnica que consiste en guardar los resultados de cálculos anteriores y reutilizarlos cuando se encuentran las mismas entradas de nuevo durante la inferencia. Esto evita cálculos redundantes, lo que acelera el proceso de inferencia.

Cómo se hace:

- Almacenar cálculos anteriores: Mantener una caché de las entradas anteriores y sus salidas correspondientes.

- Políticas de expulsión de la caché: Implementa estrategias para eliminar los elementos menos utilizados de la caché cuando alcancen su capacidad máxima.

Cómo ayuda:

- Respuestas más rápidas para solicitudes repetidas: El almacenamiento en caché es increíblemente eficaz para aplicaciones en las que se realizan con frecuencia solicitudes iguales o similares.

- Reducción de la carga computacional: Menos cálculos significan menores costes.

Sin embargo, el almacenamiento en caché solo es útil cuando las entradas se repiten o se superponen. En cargas de trabajo muy variables, las tasas de acierto pueden ser bajas y los gastos generales de mantenimiento de una caché pueden superar los beneficios. Los resultados obsoletos o desactualizados también pueden crear problemas de coherencia si los resultados almacenados en caché ya no reflejan los datos más relevantes. Además, implementar y ajustar estrategias de expulsión de caché añade complejidad técnica, especialmente en sistemas distribuidos, donde la sincronización de la caché se convierte en un reto.

6. Salida anticipada

La salida anticipada consiste en detener el cálculo antes de tiempo durante la inferencia si el modelo tiene suficiente confianza en su predicción. Esto ahorra recursos computacionales y acelera la inferencia en casos más sencillos en los que no es necesario realizar una pasada completa hacia adelante.

Cómo se hace:

- Umbral de confianza: Establece un umbral para la confianza del modelo en su predicción. Si la confianza supera el umbral en una capa intermedia, detén el cálculo y devuelve el resultado actual.

- Salida anticipada adaptativa: Ajusta dinámicamente el umbral en función de la entrada o la capa del modelo para equilibrar la velocidad y la precisión.

Cómo ayuda:

- Inferencia más rápida para casos sencillos: Si el modelo puede predecir con seguridad el resultado desde el principio, se ahorra tiempo y computación.

- Reducción de costes: Menos cálculos significan menores costes.

La desventaja es que salir antes de tiempo puede reducir ligeramente la precisión en algunos casos, especialmente con entradas complejas.

7. Hardware optimizado

Esta técnica implica el uso de arquitecturas de hardware y aceleradores especializados diseñados para realizar cálculos de IA de manera eficiente. Entre ellos se incluyen GPU, TPU y otros chips dedicados a la IA que ofrecen mejoras significativas en el rendimiento en comparación con las CPU de uso general para tareas de inferencia.

Cómo se hace:

- GPUs: Aprovecha las capacidades de procesamiento paralelo de las GPU para operaciones matriciales y cálculos de redes neuronales.

- TPUs: Utiliza unidades de procesamiento tensorial especializadas diseñadas específicamente para cargas de trabajo de IA.

- Otros aceleradores de IA: Explora las opciones de hardware emergentes, como los FPGA o los chips dedicados a la IA.

Cómo ayuda:

- Inferencia significativamente más rápida: Las GPU y los chips especializados son mucho más rápidos que las CPU para el tipo de cálculos que necesitan los LLM.

- Mayor eficiencia energética: Esto se traduce en menores costos de energía a largo plazo.

Sin embargo, el hardware especializado suele requerir una inversión inicial considerable y puede limitarte a un ecosistema de proveedores concreto. Las GPU, TPU o aceleradores personalizados también pueden ser más difíciles de aprovisionar de manera consistente en la nube, especialmente durante los picos de demanda. Las implementaciones locales plantean retos de mantenimiento y escalabilidad, mientras que las opciones en la nube pueden conllevar mayores costes de alquiler continuos. Por último, adaptar el software para aprovechar al máximo el hardware especializado puede añadir complejidad técnica y requerir una optimización continua.

8. Compresión del modelo

La compresión de modelos se refiere al uso de más de una técnica para reducir el tamaño y la complejidad de un modelo sin comprometer significativamente su rendimiento. Esto puede implicar la poda, la cuantificación, la destilación de conocimientos u otros métodos destinados a crear un modelo más compacto y eficiente para una inferencia más rápida.

Cómo se hace:

- Combina varias técnicas: Aplica una combinación de cuantificación, poda, destilación de conocimientos y otros métodos para lograr una reducción óptima del tamaño del modelo.

- Descomposición tensorial: Descomponer matrices de peso grande en representaciones más pequeñas y eficientes.

Cómo ayuda:

- Tamaño del modelo más pequeño: Esto se traduce en una carga más rápida, un menor uso de memoria y, potencialmente, menores costes.

La compresión del modelo puede provocar una pérdida de precisión si las técnicas se aplican de forma demasiado agresiva o sin un ajuste cuidadoso. La combinación de métodos como la poda, la cuantificación y la destilación aumenta la complejidad del sistema y puede requerir ciclos adicionales de reentrenamiento o ajuste. Los modelos comprimidos también pueden ser menos flexibles para transferirlos a nuevas tareas, ya que las optimizaciones suelen reducir el abanico de escenarios en los que el modelo funciona bien. En algunos casos, el tiempo de ingeniería y la sobrecarga computacional dedicados a la compresión pueden contrarrestar el ahorro de costes a corto plazo.

9. Inferencia distribuida

La inferencia distribuida es un enfoque para dividir la carga de trabajo de inferencia entre varias máquinas o dispositivos. Esto permite el procesamiento paralelo de tareas de inferencia a gran escala, lo que reduce la latencia y mejora el rendimiento.

Cómo se hace:

- Partición del modelo: Divide el modelo entre varias máquinas, cada una de las cuales se encargará de una parte del cálculo.

- Equilibrio de carga: Distribuir las solicitudes entrantes entre las máquinas disponibles para garantizar un uso eficiente de los recursos.

Cómo ayuda:

- Admite modelos más grandes y mayor tráfico: La inferencia distribuida te permite dividir tareas grandes entre varias máquinas, lo que permite gestionar modelos más grandes y más solicitudes simultáneamente. Esto hace que el hardware sea más eficiente y permite un escalado flexible en la nube, lo que se traduce en un ahorro de costes.

La inferencia distribuida introduce una complejidad significativa en el sistema, ya que coordinar los cálculos entre múltiples máquinas requiere una sólida organización, sincronización y tolerancia a fallos. La latencia de la red y las limitaciones de ancho de banda pueden contrarrestar las mejoras de rendimiento, especialmente cuando es necesario intercambiar grandes cantidades de datos intermedios. También aumenta los costes de infraestructura, ya que hay que adquirir y mantener hardware adicional y mecanismos de equilibrio de carga. La depuración y supervisión de sistemas distribuidos puede resultar más difícil, lo que hace que la fiabilidad sea un reto en comparación con las configuraciones de un solo nodo.

10. Ingeniería rápida

La ingeniería de prompts es un proceso que consiste en elaborar cuidadosamente indicaciones de entrada para guiar a los modelos de lenguaje grandes (LLM) hacia la generación de los resultados deseados. Al formular indicaciones claras, concisas y específicas, los usuarios pueden mejorar la calidad y la capacidad de control de las respuestas del LLM, haciéndolas más relevantes y útiles para tareas específicas.

Cómo se hace:

- Sé claro y conciso: Utiliza un lenguaje específico y sin ambigüedades en tus indicaciones.

- Proporciona contexto: Incluye información contextual relevante o ejemplos para orientar al LLM.

- Experimenta y repite: Prueba diferentes formulaciones de indicaciones y evalúa los resultados para encontrar las más eficaces.

Cómo ayuda:

- Resultados más relevantes y concisos: Una buena ingeniería de prompts puede reducir el número de tokens que el modelo necesita generar, lo que se traduce en una inferencia más rápida y potencialmente más económica.

- Mayor precisión: Las indicaciones claras pueden ayudar al modelo a evitar malentendidos y generar respuestas más precisas.

La ingeniería rápida requiere experimentación e iteración continuas, lo que puede llevar mucho tiempo y resultar inconsistente en los distintos casos de uso. Las indicaciones bien elaboradas pueden no ser generalizables, lo que te obliga a rediseñarlas cuando cambian las tareas o los modelos. Las mejoras en el diseño de las preguntas también pueden ser frágiles: pequeños cambios en la redacción o actualizaciones del modelo pueden alterar los resultados de forma impredecible. Por último, depender en exceso de la ingeniería rápida sin técnicas complementarias como la gestión del contexto o el ajuste fino puede limitar la escalabilidad y el ahorro de costes a largo plazo.

Bonificación: Ingeniería de contexto

La ingeniería de contexto es la práctica de diseñar sistemas que controlan la información que ve un LLM antes de generar una respuesta. En lugar de abarrotar todo en la ventana de contexto, seleccionas y organizas solo los detalles más relevantes, como el historial del usuario, los documentos recuperados o los resultados de las herramientas, para que el modelo pueda razonar de manera más eficiente.

Cómo se hace:

- Resumen del contexto: Comprime el historial de conversaciones o documentos acumulados en resúmenes más breves para conservar el significado y reducir al mismo tiempo los tokens.

- Gestión de la carga de herramientas: Utiliza sistemas de recuperación para seleccionar solo las herramientas o descripciones más relevantes, en lugar de pasar todas las opciones disponibles.

- Poda contextual: Elimina la información obsoleta o redundante a medida que lleguen nuevos datos, manteniendo el contexto activo ágil y útil.

- Validación del contexto y cuarentena: Detecta y aísla las alucinaciones o los errores antes de que contaminen la memoria a largo plazo.

Cómo ayuda:

- Menor uso de tokens: Los contextos más cortos y específicos reducen el número de tokens procesados, lo que se traduce en una reducción directa de los costes.

- Mayor precisión: Un contexto más limpio significa que el modelo es menos propenso a distraerse o confundirse por detalles irrelevantes o contradictorios.

- Inferencia más rápida: Con menos tokens y una caché KV más estable, las solicitudes se completan más rápidamente, lo que ahorra recursos informáticos.

La contrapartida es que la creación de sistemas contextuales eficaces requiere un esfuerzo inicial de ingeniería. Necesitas contar con procesos de recuperación, resumen y validación, y un diseño deficiente puede provocar lagunas contextuales que perjudican el rendimiento. Pero cuando se hace bien, la ingeniería de contexto hace que las aplicaciones grandes sean más fiables y asequibles.

Conclusión

Reducir los costes de inferencia del LLM no es cuestión de un solo truco. Se trata de combinar enfoques que tengan sentido para tu carga de trabajo. Técnicas como la cuantificación, la poda y la destilación de conocimientos reducen el tamaño del modelo. El procesamiento por lotes, el almacenamiento en caché y la inferencia distribuida mejoran la forma en que se procesan las solicitudes. Las opciones de hardware y la compresión de modelos aumentan aún más la eficiencia, mientras que la ingeniería de contexto y de respuestas rápidas reduce el uso innecesario de tokens en el origen.

Las desventajas son reales: cada método conlleva complejidad, posible pérdida de precisión o sobrecarga de infraestructura. Pero las ganancias se acumulan. Con solo aplicar algunas de estas técnicas, podrás mantener los modelos asequibles, ampliar el uso sin que los costes se disparen y crear sistemas que sigan siendo sostenibles a medida que los modelos y las aplicaciones crecen.

Ingeniero Senior de GenAI y creador de contenidos que ha conseguido 20 millones de visitas compartiendo conocimientos sobre GenAI y ciencia de datos.