Curso

Executar modelos de linguagem grandes tem custos reais. Você paga por cada token processado, cada ciclo de GPU usado e cada camada de complexidade adicionada a um modelo. Mesmo com a queda nos preços, a conta ainda fica alta quando você está lidando com aplicativos grandes, prompts longos ou atualizações frequentes.

Já vi como isso vira um problema rapidinho. As equipes acham que os custos vão continuar sob controle, mas depois percebem que estão gastando muito com modelos grandes demais, avisos ineficientes ou equipamentos parados.

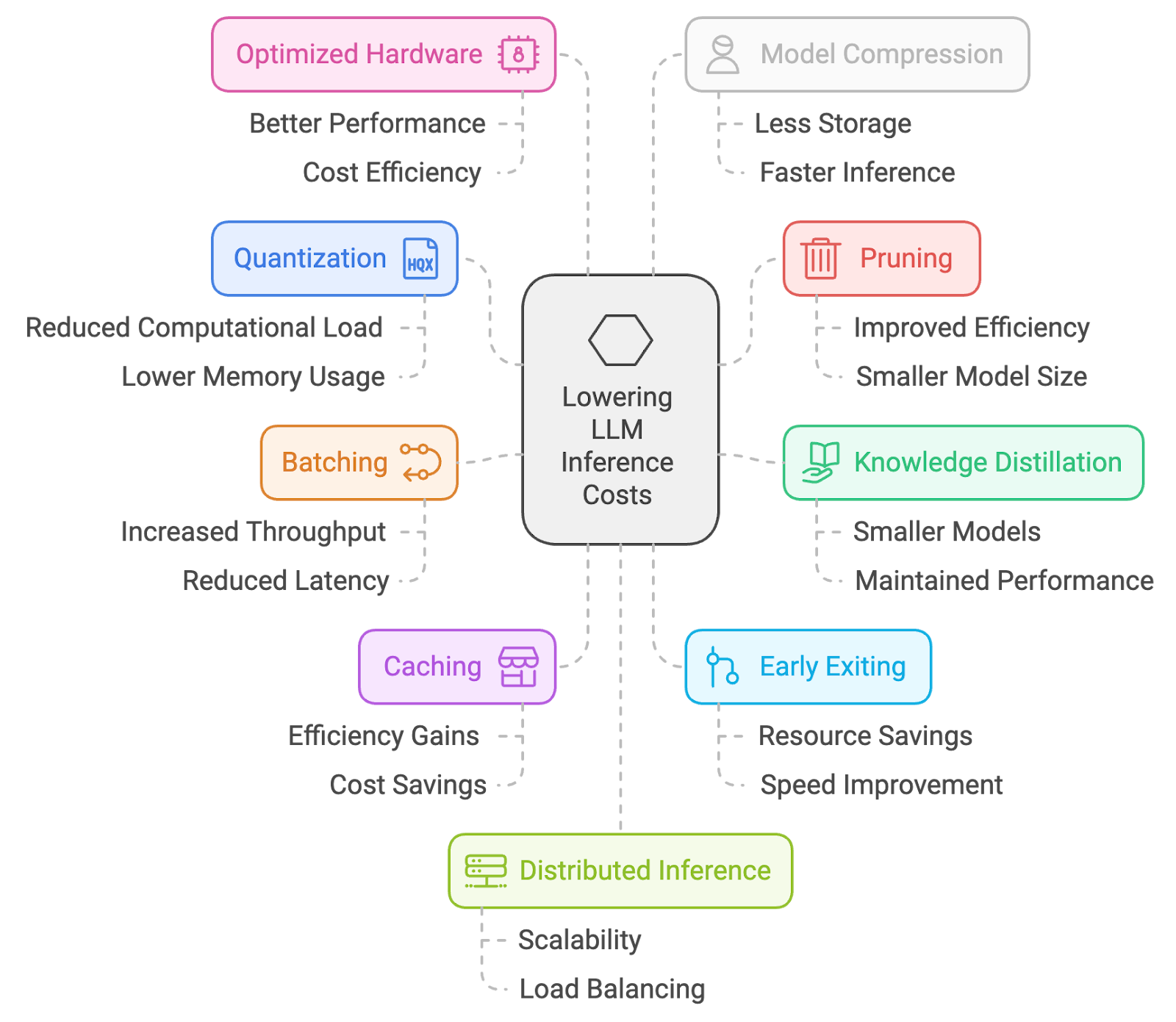

É por isso que reuni 10 maneiras práticas de reduzir os custos de inferência. Da quantização e poda ao processamento em lote, cache e engenharia de prompts, essas são abordagens que eu realmente uso para manter os LLMs acessíveis sem comprometer muito o desempenho.

1. Quantização

Quantização é um processo de redução da precisão dos pesos e ativações do modelo, normalmente de números de ponto flutuante de 32 bits para representações de bits mais baixos (por exemplo, 16 bits ou até 8 bits). Isso reduz o consumo de memória e os requisitos computacionais, permitindo uma inferência mais rápida em dispositivos com recursos limitados.

Como é feito:

- Quantização pós-treinamento (PTQ): Converta os pesos do modelo pré-treinado para uma precisão menor (por exemplo, inteiros de 8 bits) sem precisar treinar de novo. Isso é relativamente simples, mas pode causar alguma perda de precisão.

- Treinamento com consciência de quantização (QAT): Ajustar o modelo com técnicas de quantização durante o treinamento, resultando em uma melhor preservação da precisão.

Como isso ajuda:

- Modelo menor: Isso significa tempos de carregamento mais rápidos e menos uso de memória, o que pode reduzir bastante os custos, principalmente em ambientes de nuvem, onde você paga pelos recursos que usa.

- Inferência mais rápida: Com números menores, os cálculos ficam mais rápidos, o que leva a tempos de resposta mais rápidos.

A principal desvantagem é uma possível perda de precisão. Embora as técnicas modernas de quantização sejam muito boas, sempre existe a chance de uma pequena queda na precisão do modelo.

2. Poda

A poda é uma técnica pra tirar pesos menos importantes ou que já não servem mais de uma rede neural. Ao eliminar conexões que têm um impacto mínimo no desempenho do modelo, a poda reduz o tamanho e a complexidade computacional do modelo, levando a uma inferência mais rápida.

Como é feito:

- Poda não estruturada: Tira pesos individuais com base na magnitude ou importância deles.

- Poda estruturada: Remove canais ou filtros inteiros, levando a estruturas de modelo mais regulares que podem ser executadas de forma eficiente no hardware.

Como isso ajuda:

- Modelo menor: Parecido com a quantização, a poda deixa o modelo menor e mais rápido de carregar.

- Cálculos reduzidos: Menos conexões significam menos cálculos durante a inferência, o que leva a tempos de resposta mais rápidos.

Parecido com a quantização, a principal desvantagem é uma possível perda de precisão. Uma poda agressiva pode fazer com que o desempenho caia bastante. É super importante achar o equilíbrio certo.

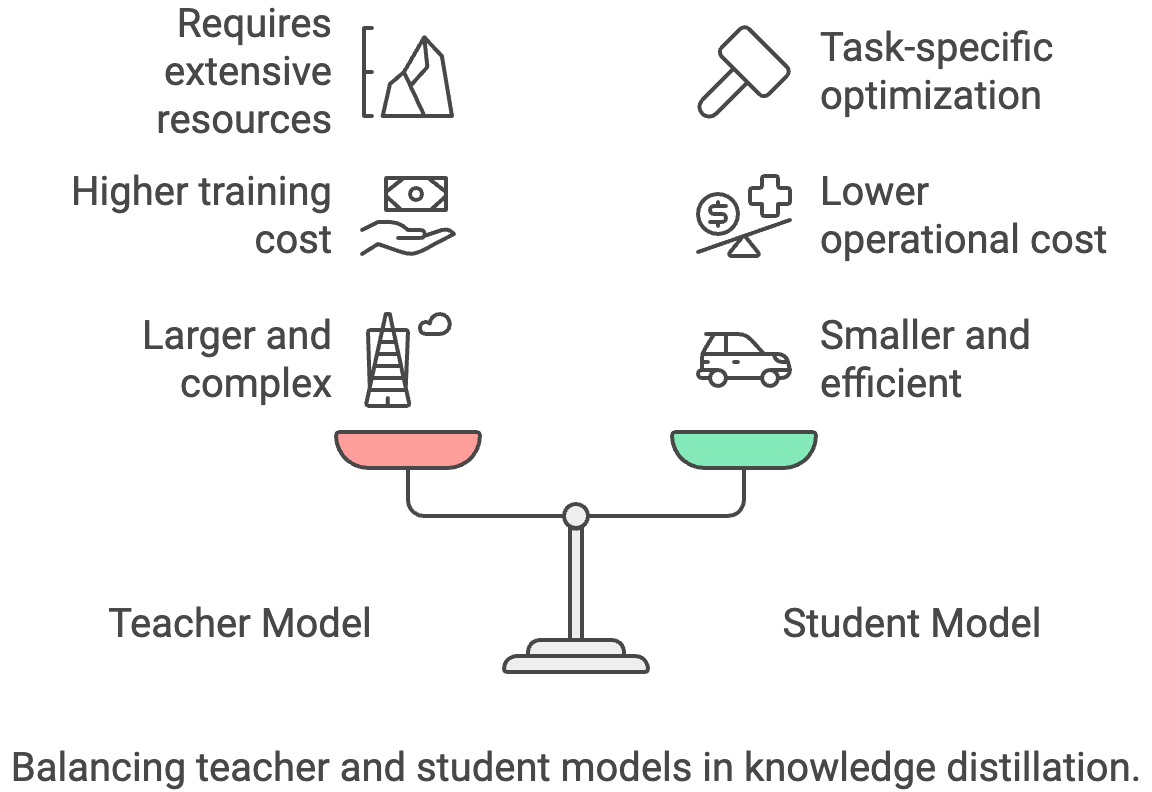

3. Destilação de conhecimento

A destilação de conhecimento é o processo de passar conhecimento de um modelo “professor” grande e complexo para um modelo “aluno” menor e mais eficiente. O modelo do aluno aprende a imitar o comportamento do professor, o que permite um desempenho parecido com um tamanho menor e uma inferência mais rápida.

Como é feito:

- Treine um modelo de aluno menor: Use os resultados maiores do modelo do professor (logits ou rótulos suaves) como sinais de treinamento adicionais para o modelo do aluno.

- Escala de temperatura: Ajuste o parâmetro de temperatura durante a destilação para controlar a suavidade da distribuição de saída do professor.

Como isso ajuda:

- Modelo bem menor: Os modelos dos alunos podem ser bem menores e mais rápidos que os dos professores, o que ajuda a economizar bastante.

- Otimização específica para tarefas: Você pode ajustar o modelo do aluno para uma tarefa específica, tornando-o ainda mais eficiente.

A principal desvantagem é que você precisa de um modelo de professor eficiente, que pode ser caro para treinar ou usar.

4. Processamento em lote

O processamento em lote envolve processar várias amostras de entrada ao mesmo tempo em um lote durante a inferência. Isso melhora a eficiência usando os recursos de processamento paralelo do hardware, levando a uma inferência geral mais rápida.

Como é feito:

- Acumular pedidos: Reúna várias solicitações de inferência e processe-as juntas como um lote.

- Agrupamento dinâmico: Ajuste o tamanho do lote de forma dinâmica com base nas taxas de solicitações recebidas para equilibrar a latência e a taxa de transferência.

Como isso ajuda:

- Maior rendimento: O processamento em lote pode aumentar bastante o número de solicitações processadas por segundo, deixando seu aplicativo mais eficiente.

- Melhor aproveitamento do hardware: As GPUs são feitas pra processamento paralelo, e o processamento em lote te ajuda a aproveitar ao máximo o que elas podem fazer.

Mas, o agrupamento pode trazer um atraso extra para pedidos individuais, já que o sistema pode esperar para juntar entradas suficientes antes de processar. Para aplicações em tempo real ou de baixa latência, esse atraso adicional pode prejudicar a experiência do usuário se não for cuidadosamente ajustado. O agrupamento dinâmico ajuda a resolver o problema, mas deixa o sistema mais complicado. Também existe o risco de um agrupamento ineficiente quando o tráfego é irregular, o que pode reduzir a economia de custos esperada.

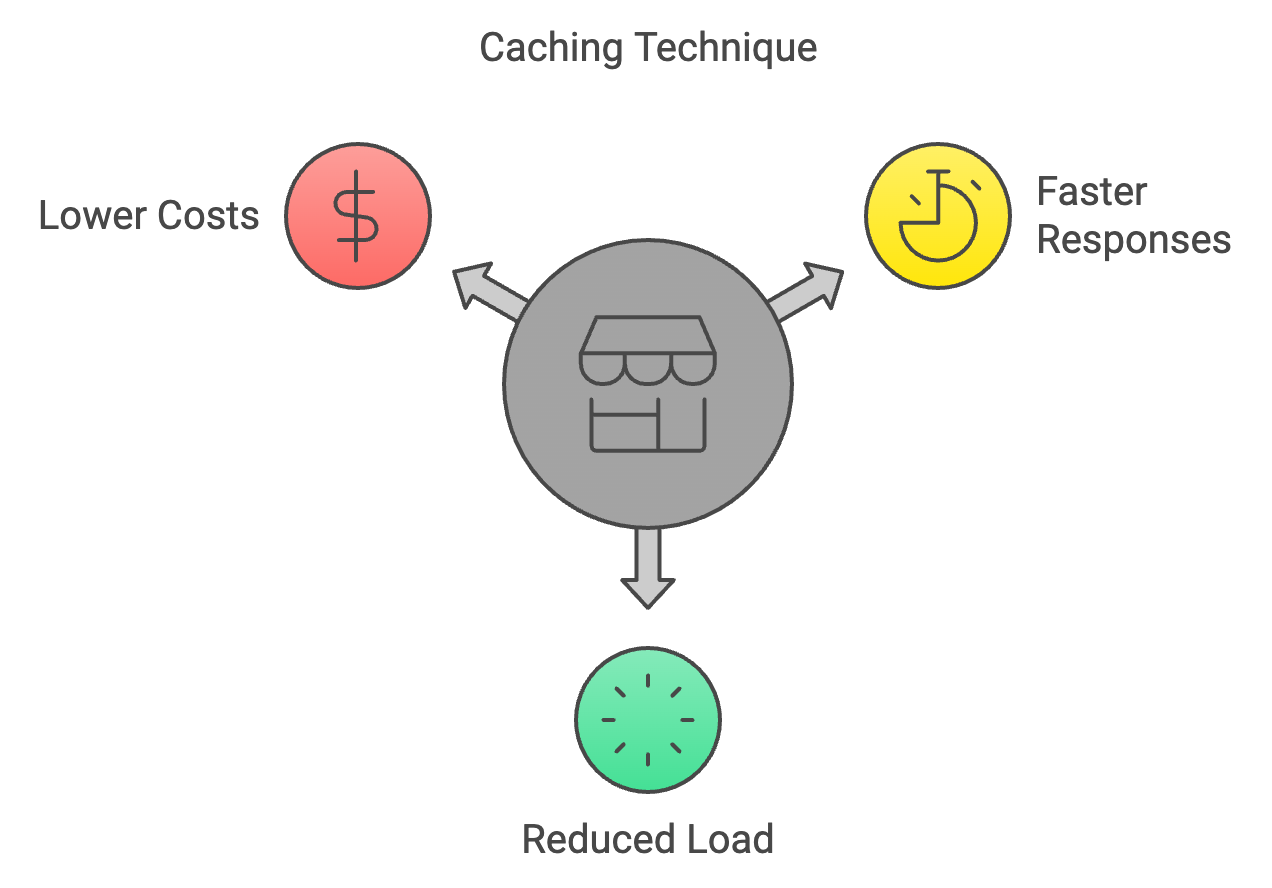

5. Armazenamento em cache

O cache é uma técnica pra guardar os resultados de cálculos anteriores e reutilizá-los quando os mesmos dados aparecem de novo durante a inferência. Isso evita cálculos desnecessários, acelerando o processo de inferência.

Como é feito:

- Armazene cálculos anteriores: Mantenha um cache das entradas anteriores e suas saídas correspondentes.

- Políticas de expulsão do cache: Implemente estratégias para remover itens menos usados do cache quando ele atingir a capacidade máxima.

Como isso ajuda:

- Respostas mais rápidas para pedidos repetidos: O cache é super eficiente pra aplicativos onde as mesmas solicitações ou semelhantes são feitas com frequência.

- Carga computacional reduzida: Menos cálculos significam custos mais baixos.

Mas, o cache só é útil quando as entradas se repetem ou se sobrepõem. Em cargas de trabalho super variáveis, as taxas de acerto podem ser baixas, e o custo de manter um cache pode ser maior do que os benefícios. Resultados obsoletos ou desatualizados também podem criar problemas de consistência se as saídas armazenadas em cache não refletirem mais os dados mais relevantes. Além disso, implementar e ajustar estratégias de evicção de cache adiciona complexidade de engenharia, especialmente em sistemas distribuídos, onde a sincronização do cache se torna um desafio.

6. Saída antecipada

A saída antecipada envolve interromper o cálculo durante a inferência se o modelo estiver confiante o suficiente em sua previsão. Isso economiza recursos computacionais e acelera a inferência para casos mais simples, nos quais não é necessário realizar uma passagem completa.

Como é feito:

- Limite de confiança: Defina um limite para a confiança do modelo em sua previsão. Se a confiança passar do limite em uma camada intermediária, pare o cálculo e mostre o resultado atual.

- Saída antecipada adaptativa: Ajuste o limite de forma dinâmica com base na entrada ou na camada do modelo para equilibrar velocidade e precisão.

Como isso ajuda:

- Inferência mais rápida para casos fáceis: Se o modelo conseguir prever o resultado com segurança logo no início, isso economiza tempo e computação.

- Custos reduzidos: Menos cálculos significam custos mais baixos.

A desvantagem é que sair mais cedo pode fazer com que a precisão seja um pouco menor em alguns casos, principalmente para entradas complexas.

7. Hardware otimizado

Essa técnica envolve o uso de arquiteturas de hardware e aceleradores especializados, feitos para fazer cálculos de IA de forma eficiente. Isso inclui GPUs, TPUs e outros chips de IA dedicados que oferecem melhorias significativas de desempenho em comparação com CPUs de uso geral para tarefas de inferência.

Como é feito:

- GPUs: Aproveite os recursos de processamento paralelo das GPUs para operações matriciais e cálculos de redes neurais.

- TPUs: Use unidades de processamento tensor especializadas, feitas especialmente para cargas de trabalho de IA.

- Outros aceleradores de IA: Dá uma olhada nas novas opções de hardware, tipo FPGAs ou chips dedicados para IA.

Como isso ajuda:

- Inferência significativamente mais rápida: As GPUs e os chips especializados são muito mais rápidos do que as CPUs para o tipo de cálculos que os LLMs precisam.

- Melhor eficiência energética: Isso significa menos gastos com energia no longo prazo.

Mas, hardware especializado geralmente exige um investimento inicial grande e pode te prender a um sistema específico de um fornecedor. GPUs, TPUs ou aceleradores personalizados também podem ser mais difíceis de provisionar de forma consistente na nuvem, especialmente durante picos de demanda. As implementações locais trazem desafios de manutenção e dimensionamento, enquanto as opções na nuvem podem acarretar custos de aluguel mais elevados. Por fim, adaptar o software para aproveitar ao máximo o hardware especializado pode aumentar a complexidade da engenharia e exigir otimização contínua.

8. Compressão do modelo

A compressão de modelos é quando a gente usa mais de uma técnica pra diminuir o tamanho e a complexidade de um modelo sem prejudicar muito o desempenho dele. Isso pode envolver poda, quantização, destilação de conhecimento ou outros métodos que buscam criar um modelo mais compacto e eficiente para uma inferência mais rápida.

Como é feito:

- Junte várias técnicas: Use uma combinação de quantização, poda, destilação de conhecimento e outros métodos para conseguir uma redução ideal do tamanho do modelo.

- Decomposição tensorial: Divida grandes matrizes de peso em representações menores e mais eficientes.

Como isso ajuda:

- Modelo menor: Isso significa carregamento mais rápido, menos uso de memória e custos potencialmente mais baixos.

A compressão do modelo pode prejudicar a precisão se as técnicas forem aplicadas de forma muito agressiva ou sem um ajuste cuidadoso. Combinar métodos como poda, quantização e destilação aumenta a complexidade do sistema e pode exigir mais ciclos de retreinamento ou ajuste fino. Os modelos compactados também podem ser menos flexíveis para transferência para novas tarefas, já que as otimizações muitas vezes limitam a variedade de cenários em que o modelo tem um bom desempenho. Em alguns casos, o tempo de engenharia e a sobrecarga computacional gastos na compressão podem compensar a economia de custos a curto prazo.

9. Inferência Distribuída

A inferência distribuída é uma forma de dividir a carga de trabalho de inferência entre várias máquinas ou dispositivos. Isso permite o processamento paralelo de tarefas de inferência em grande escala, reduzindo a latência e melhorando o rendimento.

Como é feito:

- Particionamento do modelo: Divida o modelo entre várias máquinas, cada uma cuidando de uma parte do cálculo.

- Equilíbrio de carga: Distribua as solicitações recebidas pelas máquinas disponíveis para garantir uma utilização eficiente dos recursos.

Como isso ajuda:

- Lida com modelos maiores e tráfego mais intenso: A inferência distribuída permite dividir tarefas grandes entre várias máquinas, lidando com modelos maiores e mais solicitações ao mesmo tempo. Isso torna o hardware mais eficiente e permite um dimensionamento flexível na nuvem, o que leva a uma redução de custos.

A inferência distribuída deixa o sistema bem complexo, porque coordenar a computação em várias máquinas exige uma orquestração robusta, sincronização e tolerância a falhas. A latência da rede e as limitações de largura de banda podem prejudicar o aumento de desempenho, principalmente quando é preciso trocar um monte de dados intermediários. Isso também aumenta os custos de infraestrutura, já que é preciso providenciar e manter hardware adicional e mecanismos de balanceamento de carga. Depurar e monitorar sistemas distribuídos pode ser mais complicado, o que torna a confiabilidade um desafio em comparação com configurações de nó único.

10. Engenharia de Prompt

Engenharia de prompts é um processo de elaboração cuidadosa de prompts de entrada para orientar grandes modelos de linguagem (LLMs) na geração dos resultados desejados. Ao criar perguntas claras, curtas e específicas, os usuários podem melhorar a qualidade e o controle das respostas do LLM, tornando-as mais relevantes e úteis para tarefas específicas.

Como é feito:

- Seja claro e direto: Use uma linguagem específica e sem ambiguidades nas suas instruções.

- Forneça contexto: Inclua informações relevantes ou exemplos para ajudar o LLM.

- Experimente e repita: Teste diferentes formulações de prompts e veja os resultados pra descobrir quais são os mais eficazes.

Como isso ajuda:

- Resultados mais relevantes e diretos: Uma boa engenharia de prompt pode reduzir o número de tokens que o modelo precisa gerar, levando a uma inferência mais rápida e potencialmente mais barata.

- Maior precisão: Instruções claras podem ajudar o modelo a evitar mal-entendidos e gerar respostas mais precisas.

A engenharia de prompts precisa de experimentação e iteração contínuas, o que pode ser demorado e inconsistente entre os casos de uso. Prompts bem elaborados podem não ser generalizáveis, obrigando você a redesenhá-los quando as tarefas ou modelos mudarem. Melhorias no design do prompt também podem ser frágeis — pequenas alterações na redação ou atualizações do modelo podem alterar os resultados de forma imprevisível. Por fim, confiar demais na engenharia de prompt sem técnicas complementares, como gerenciamento de contexto ou ajuste fino, pode limitar a escalabilidade e a economia de custos a longo prazo.

Bônus: Engenharia de Contexto

Engenharia de contexto é a prática de projetar sistemas que controlam quais informações um LLM vê antes de gerar uma resposta. Em vez de enfiar tudo na janela de contexto, você escolhe e organiza só os detalhes mais importantes — tipo histórico do usuário, documentos recuperados ou resultados de ferramentas — pra que o modelo possa raciocinar de forma mais eficiente.

Como é feito:

- Resumo do contexto: Compacta o histórico de conversas ou documentos em resumos mais curtos pra manter o significado e reduzir os tokens.

- Gerenciamento de carga de ferramentas: Use sistemas de recuperação pra escolher só as ferramentas ou descrições mais relevantes, em vez de passar todas as opções disponíveis.

- Poda de contexto: Tira as informações desatualizadas ou que não servem mais quando chegarem novos dados, mantendo o contexto ativo simples e útil.

- Validação de contexto e quarentena: Detecte e isole alucinações ou erros antes que eles afetem a memória de longo prazo.

Como isso ajuda:

- Menos uso de tokens: Contextos mais curtos e focados diminuem o número de tokens processados, reduzindo diretamente os custos.

- Maior precisão: Um contexto mais claro significa que o modelo tem menos chances de se distrair ou ficar confuso com detalhes irrelevantes ou contraditórios.

- Inferência mais rápida: Com menos tokens e um cache KV mais estável, as solicitações são concluídas mais rapidamente, o que economiza recursos de computação.

A desvantagem é que criar sistemas de contexto eficazes exige um esforço inicial de engenharia. Você precisa de pipelines de recuperação, resumo e validação, e um design ruim pode causar lacunas de contexto que prejudicam o desempenho. Mas, quando bem feita, a engenharia de contexto torna os grandes aplicativos mais confiáveis e acessíveis.

Conclusão

Reduzir os custos de inferência do LLM não é só um truque. É sobre juntar abordagens que fazem sentido para a sua carga de trabalho. Técnicas como quantização, poda e destilação de conhecimento reduzem o tamanho do modelo. O agrupamento, o armazenamento em cache e a inferência distribuída melhoram a forma como as solicitações são processadas. As escolhas de hardware e a compactação de modelos aumentam ainda mais a eficiência, enquanto a engenharia de prompt e contexto reduzem o uso desnecessário de tokens na fonte.

As desvantagens são reais: cada método traz complexidade, perda potencial de precisão ou sobrecarga de infraestrutura. Mas os ganhos se acumulam. Ao aplicar apenas algumas dessas técnicas, você pode manter os modelos acessíveis, dimensionar o uso sem custos descontrolados e criar sistemas que permaneçam sustentáveis à medida que os modelos e aplicativos crescem.

Engenheiro sênior de GenAI e criador de conteúdo que obteve 20 milhões de visualizações ao compartilhar conhecimento sobre GenAI e ciência de dados.