Curso

Los grandes modelos lingüísticos (LLM) siguen creciendo en complejidad y tamaño, y su despliegue plantea importantes retos.

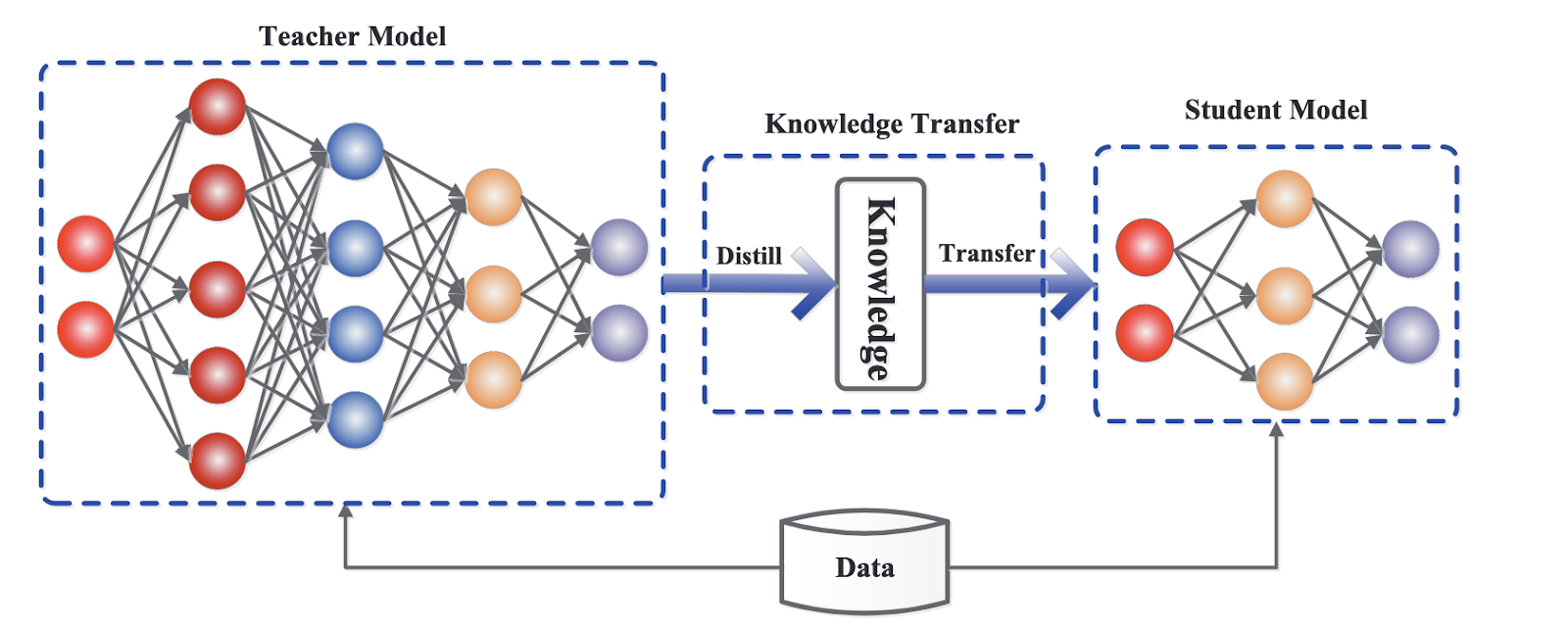

La destilación LLM surge como una potente solución a este problema, ya que permite transferir conocimientos de un modelo lingüístico más grande y complejo (el "maestro") a una versión más pequeña y eficaz (el "alumno").

Un ejemplo reciente en el mundo de la IA es la destilación de GPT-4o mini (estudiante) de GPT-4o (profesor).

Este proceso puede compararse al de un profesor que imparte sabiduría a un alumno, en el que el objetivo es destilar el conocimiento esencial sin el engorroso bagaje de la complejidad del modelo más amplio. ¡Averigüemos más!

¿Qué es la destilación LLM?

La destilación de LLM es una técnica que pretende replicar el rendimiento de un modelo lingüístico de gran tamaño, reduciendo al mismo tiempo su tamaño y sus exigencias computacionales.

Imagina a un profesor experimentado compartiendo su experiencia con un nuevo alumno. El profesor, que representa el modelo de maestro, transmite conceptos y conocimientos complejos, mientras que el modelo de alumno aprende a imitar estas enseñanzas de forma más simplificada y eficaz.

Este proceso no sólo conserva las competencias básicas del profesor, sino que también optimiza al alumno para aplicaciones más rápidas y versátiles.

¿Por qué es importante la destilación del LLM?

El creciente tamaño y requisitos informáticos de los grandes modelos lingüísticos impiden su adopción y despliegue generalizados. El hardware de alto rendimiento y el creciente consumo de energía a menudo limitan la accesibilidad de estos modelos, sobre todo en entornos con recursos limitados, como los dispositivos móviles o las plataformas informáticas periféricas.

La destilación LLM aborda estos retos produciendo modelos más pequeños y rápidos, lo que los hace ideales para su integración en una gama más amplia de dispositivos y plataformas.

Esta innovación no sólo democratiza el acceso a la IA avanzada, sino que también es compatible con aplicaciones en tiempo real en las que se valoran mucho la velocidad y la eficacia. Al permitir soluciones de IA más accesibles y escalables, la destilación LLM ayuda a avanzar en la aplicación práctica de las tecnologías de IA.

Cómo funciona la destilación LLM: El proceso de transferencia de conocimientos

El proceso de destilación del LLM implica varias técnicas que garantizan que el modelo del alumno retenga la información clave a la vez que funciona con mayor eficacia. Aquí exploramos los mecanismos clave que hacen que esta transferencia de conocimientos sea eficaz.

Paradigma profesor-alumno

El paradigma profesor-alumno está en el centro de la destilación del LLM, un concepto fundacional que impulsa el proceso de transferencia de conocimientos. En esta configuración, un modelo más grande y avanzado imparte sus conocimientos a un modelo más pequeño y ligero.

El modelo del profesor, a menudo un modelo lingüístico de última generación con un amplio entrenamiento y recursos computacionales, sirve como una rica fuente de información. Por otra parte, el alumno está diseñado para aprender del profesor imitando su comportamiento e interiorizando sus conocimientos.

La tarea principal del modelo del alumno es replicar los resultados del profesor manteniendo un tamaño mucho menor y unos requisitos computacionales reducidos. Este proceso implica que el alumno observe y aprenda de las predicciones, ajustes y respuestas del profesor a diversas entradas.

De este modo, el alumno puede alcanzar un nivel comparable de rendimiento y comprensión, lo que lo hace adecuado para su despliegue en entornos con recursos limitados.

Técnicas de destilación

Se emplean diversas técnicas de destilación para transferir conocimientos del profesor al alumno. Estos métodos garantizan que el modelo de alumno no sólo aprenda eficazmente, sino que también retenga los conocimientos y capacidades esenciales del modelo de profesor. He aquí algunas de las técnicas más destacadas utilizadas en la destilación LLM.

Destilación de conocimientos (DC)

Una de las técnicas más destacadas en la destilación de LLM es la destilación de conocimientos (DC). En KD, el modelo del alumno se entrena utilizando las probabilidades de salida del modelo del profesor, conocidas comoobjetivos blandos , junto con las etiquetas de la verdad sobre el terreno, denominadas objetivos duros.

Los objetivos blandos proporcionan una visión matizada de las predicciones del profesor, ofreciendo una distribución de probabilidades sobre los posibles resultados en lugar de una única respuesta correcta. Esta información adicional ayuda al alumno modelo a captar los sutiles patrones y los intrincados conocimientos codificados en las respuestas del profesor.

Al utilizar objetivos blandos, el modelo de alumno puede comprender mejor el proceso de toma de decisiones del profesor, lo que conduce a un rendimiento más preciso y fiable. Este enfoque no sólo conserva los conocimientos críticos del profesor, sino que también permite un proceso de formación más fluido y eficaz para el alumno.

Marco genérico para la destilación de conocimientos. Fuente

Otras técnicas de destilación

Además de la KD, hay otras técnicas que pueden mejorar el proceso de destilación LLM:

- Aumento de datos: Esto implica generar datos de entrenamiento adicionales utilizando el modelo del profesor. Al crear un conjunto de datos más amplio e inclusivo, el alumno puede estar expuesto a una gama más amplia de escenarios y ejemplos, lo que mejora su rendimiento de generalización.

- Destilación en capa intermedia: En lugar de centrarse únicamente en los resultados finales, este método transfiere conocimientos de las capas intermedias del modelo del profesor al alumno. Aprendiendo a partir de estas representaciones intermedias, el alumno puede captar información más detallada y estructurada, lo que conduce a un mejor rendimiento general.

- Destilación multiprofesional: Un modelo de alumno puede beneficiarse del aprendizaje de varios modelos de profesor. Al agregar conocimientos de varios profesores, el alumno puede lograr una comprensión más completa y una mayor solidez, ya que integra diferentes perspectivas y puntos de vista.

Ventajas de la destilación LLM

La destilación de LLM ofrece una serie de ventajas considerables que desarrollan la usabilidad y eficacia de los modelos lingüísticos, haciéndolos más prácticos para diversas aplicaciones.

Aquí exploramos algunas de sus principales ventajas.

Tamaño reducido del modelo

Una de las principales ventajas de la destilación LLM es la creación de modelos notablemente más pequeños. Al transferir conocimientos de un modelo de profesor grande a un modelo de alumno más pequeño, el alumno resultante conserva gran parte de las capacidades del profesor siendo una fracción de su tamaño.

Esta reducción del tamaño del modelo conduce a:

- Inferencia más rápida: Los modelos más pequeños procesan los datos con mayor rapidez, lo que se traduce en tiempos de respuesta más rápidos.

- Reducción de las necesidades de almacenamiento: Los modelos más pequeños ocupan menos espacio, lo que facilita su almacenamiento y gestión, sobre todo en entornos con capacidad de almacenamiento limitada.

Velocidad de inferencia mejorada

El menor tamaño de los modelos destilados se traduce directamente en una mayor velocidad de inferencia. Esto es especialmente importante para las aplicaciones que requieren procesamiento en tiempo real y respuestas rápidas.

He aquí cómo se manifiesta este beneficio:

- Aplicaciones en tiempo real: Las velocidades de inferencia más rápidas hacen factible desplegar modelos destilados en aplicaciones en tiempo real, como chatbots, asistentes virtuales y sistemas interactivos en los que la latencia es un factor vital.

- Dispositivos con recursos limitados: Los modelos destilados pueden desplegarse en dispositivos con recursos computacionales limitados, como smartphones, tabletas y dispositivos periféricossin comprometer el rendimiento.

Menores costes computacionales

Otra ventaja destacable de la destilación LLM es la reducción de los costes computacionales. Los modelos más pequeños requieren menos potencia de cálculo para funcionar, lo que supone un ahorro de costes en varias áreas:

- Entornos en nube: Ejecutar modelos más pequeños en entornos en la nube reduce la necesidad de hardware caro y de alto rendimiento y disminuye el consumo de energía.

- Implantaciones in situ: Los modelos más pequeños suponen menores costes de infraestructura y gastos de mantenimiento para las organizaciones que prefieren las implantaciones locales.

Mayor accesibilidad y despliegue

Los LLM destilados son más versátiles y accesibles, lo que permite su despliegue en distintas plataformas. Este alcance ampliado tiene varias implicaciones:

- Dispositivos móviles: Los modelos destilados pueden desplegarse en dispositivos móviles, permitiendo funciones avanzadas de IA en formatos portátiles y fáciles de usar.

- Dispositivos de borde: La capacidad de funcionar en dispositivos periféricos acerca las capacidades de IA al lugar donde se generan los datos, reduciendo la necesidad de conectividad constante y mejorando la privacidad de los datos.

- Aplicaciones más amplias: Desde la sanidad a las finanzas, pasando por la educación, los modelos destilados pueden integrarse en multitud de aplicaciones, haciendo que la IA avanzada sea accesible a más sectores y usuarios.

Aplicaciones de los LLM Destilados

Las ventajas de la destilación LLM van mucho más allá de la eficiencia del modelo y el ahorro de costes. Los modelos lingüísticos destilados pueden aplicarse a una amplia gama de procesamiento del lenguaje natural (PLN) y casos de uso específicos de la industria, haciendo que las soluciones de IA sean accesibles en diversos campos.

Tareas PNL eficientes

Los LLM destilados destacan en muchas tareas de procesamiento del lenguaje natural. Su tamaño reducido y su mayor rendimiento los hacen ideales para tareas que requieren procesamiento en tiempo real y menor potencia de cálculo.

Chatbots

Los LLM destilados permiten desarrollar chatbots más pequeños y rápidos chatbots que pueden gestionar sin problemas las tareas de atención al cliente y soporte. Estos chatbots pueden entender y responder a las consultas de los usuarios en tiempo real, proporcionando una experiencia de cliente sin fisuras y sin necesidad de una gran informática.

Resumen de texto

Las herramientas de resumen basadas en LLM destilados pueden condensar artículos de noticias, documentos o fuentes de redes sociales en resúmenes concisos. Esto ayuda a los usuarios a captar rápidamente los puntos clave sin tener que leer largos textos.

Traducción automática

Los modelos destilados hacen que los servicios de traducción sean más rápidos y accesibles en todos los dispositivos. Pueden desplegarse en teléfonos móviles, tabletas e incluso aplicaciones offline, proporcionando traducción en tiempo real con una latencia y una sobrecarga computacional reducidas.

Otras tareas

Los LLM destilados no sólo son valiosos para las tareas habituales de la PNL, sino que también destacan en áreas especializadas que requieren un procesamiento rápido y resultados precisos.

- Análisis del sentimiento: Analizar el sentimiento de los textoscomo reseñas o publicaciones en redes sociales, resulta más fácil y rápido con los modelos destilados, lo que permite a las empresas calibrar rápidamente la opinión pública y los comentarios de los clientes.

- Respuesta a las preguntas: Los modelos destilados pueden alimentar sistemas que respondan a las preguntas de los usuarios con precisión y prontitud, ampliando la experiencia del usuario en aplicaciones como asistentes virtuales y herramientas educativas.

- Generación de texto: La creación de textos coherentes y contextualmente relevantes, ya sea para la creación de contenidos, la narración de historias o la generación automatizada de informes, se agiliza con los LLM destilados.

Casos de uso en la industria

Los LLM destilados no se limitan a tareas generales de PNL. También pueden influir en muchas industrias mejorando los procesos y las experiencias de los usuarios, e impulsando la innovación.

Sanidad

En el industria sanitarialos LLM destilados pueden procesar los historiales de los pacientes y los datos de diagnóstico con mayor eficacia, lo que permite diagnósticos más rápidos y precisos. Estos modelos pueden implantarse en dispositivos médicos, ayudando a los médicos y profesionales sanitarios con el análisis de datos en tiempo real y la toma de decisiones.

Finanzas

La página sector financiero se beneficia de modelos destilados a través de sistemas de detección del fraude y modelos de interacción con el cliente. Al descifrar rápidamente los patrones de las transacciones y las consultas de los clientes, los LLM destilados ayudan a prevenir las actividades fraudulentas y proporcionan asesoramiento y apoyo financiero personalizados.

Educación

En educaciónlos LLM destilados facilitan la creación de sistemas de aprendizaje adaptativo y plataformas de tutoría personalizada. Estos sistemas pueden analizar el rendimiento de los alumnos y ofrecer contenidos educativos a medida, mejorando los resultados del aprendizaje y haciendo que la educación sea más accesible e impactante.

Implementación de la destilación LLM

Implementar la destilación LLM implica una serie de pasos y el uso de marcos y bibliotecas especializados diseñados para facilitar el proceso. Aquí exploramos las herramientas y los pasos necesarios para destilar un gran modelo lingüístico.

Marcos y bibliotecas

Para agilizar el proceso de destilación, existen algunos marcos y bibliotecas, cada uno de los cuales ofrece características únicas para apoyar la destilación LLM.

Transformadores Cara Abrazada

La Biblioteca de transformadores Cara Abrazada es una herramienta popular para aplicar la destilación LLM. Incluye una clase Distiller que simplifica el proceso de transferencia de conocimientos de un modelo de profesor a un modelo de alumno .

Utilizando la clase Distiller, los profesionales pueden aprovechar modelos preentrenados, afinarlos en conjuntos de datos específicos y emplear técnicas de destilación para lograr resultados óptimos.

Otras bibliotecas

Aparte de los Transformadores de Cara Abrazada, muchas otras bibliotecas admiten la destilación LLM:

- Optimización del modelo TensorFlow: Esta biblioteca proporciona herramientas para la poda, cuantificación y destilación de modelos, lo que la convierte en una opción versátil para crear modelos.

- PyTorch destilador: PyTorch

Distillerestá diseñado para comprimir modelos de aprendizaje profundo, incluyendo soporte para técnicas de destilación. Ofrece una serie de utilidades para gestionar el proceso de destilación y mejorar la eficacia del modelo. - DeepSpeed: Desarrollada por Microsoft, DeepSpeed es una biblioteca de optimización del aprendizaje profundo que incluye funciones para la destilación de modelos, lo que permite entrenar y desplegar modelos de gran tamaño.

Pasos a seguir

Poner en práctica la destilación LLM requiere una planificación y ejecución cuidadosas. He aquí los pasos clave del proceso.

Preparación de datos

El primer paso en el proceso de destilación es preparar un conjunto de datos adecuado para entrenar el modelo del alumno. El conjunto de datos debe ser representativo de las tareas que realizará el modelo, para garantizar que el modelo del alumno aprenda a generalizar bien.

Las técnicas de aumento de datos también pueden mejorar el conjunto de datos, proporcionando al modelo del alumno una gama más amplia de ejemplos de los que aprender.

Selección del modelo de profesor

Seleccionar un modelo de profesor adecuado es necesario para que la destilación tenga éxito. El modelo maestro debe ser un modelo preentrenado de buen rendimiento con un alto nivel de precisión en las tareas objetivo. La calidad y los atributos del modelo del profesor influyen directamente en el rendimiento del modelo del alumno.

Proceso de destilación

El proceso de destilación implica los siguientes pasos:

- Configuración de la formación: Inicializa el modelo del alumno y configura el entorno de entrenamiento, incluyendo hiperparámetros como la tasa de aprendizaje y el tamaño del lote.

- Transferencia de conocimientos: Utiliza el modelo del profesor para generar objetivos blandos (distribuciones de probabilidad) para los datos de entrenamiento. Estos objetivos blandos, junto con los objetivos duros (etiquetas de la verdad sobre el terreno), se utilizan para entrenar el modelo del alumno.

- Bucle de entrenamiento: Entrena el modelo de alumno utilizando una combinación de objetivos blandos y objetivos duros. El objetivo es minimizar la función de pérdida, que mide la diferencia entre las predicciones del modelo del alumno y los objetivos blandos proporcionados por el modelo del profesor.

Métricas de evaluación

Evaluar el rendimiento del modelo destilado es esencial para garantizar que cumple los criterios deseados. Las métricas de evaluación habituales incluyen:

- Precisión: Medida del porcentaje de predicciones correctas realizadas por el modelo del alumno en comparación con la verdad del terreno.

- Velocidad de inferencia: Evalúa el tiempo que tarda el modelo del alumno en procesar las entradas y generar las salidas.

- Talla del modelo: Evalúa la reducción del tamaño del modelo y los beneficios asociados en términos de almacenamiento y eficiencia computacional.

- Utilización de los recursos: Supervisa los recursos informáticos que necesita el modelo del alumno durante la inferencia, confirmando si cumple las restricciones del entorno de despliegue.

Cubro la evaluación LLM más a fondo en este artículo sobre LLM Evaluation: Métricas, metodologías, buenas prácticas.

Destilación LLM: Retos y buenas prácticas

Aunque la destilación LLM ofrece numerosas ventajas, también presenta varios retos que deben abordarse para garantizar el éxito de su aplicación.

Pérdida de conocimientos

Uno de los principales obstáculos en la destilación del LLM es la posible pérdida de conocimientos. Durante el proceso de destilación, es posible que parte de la información matizada y de las características del modelo del profesor deban ser captadas en su totalidad por el modelo del alumno, lo que provocaría una disminución del rendimiento. Este problema puede ser especialmente pronunciado en tareas que requieren una comprensión profunda o conocimientos especializados.

He aquí algunas estrategias que podemos aplicar para mitigar la pérdida de conocimientos:

- Destilación en capa intermedia: Transferir conocimientos de capas intermedias del modelo del profesor puede ayudar al modelo del alumno a captar información más detallada y estructurada.

- Aumento de datos: Utilizar datos aumentados generados por el modelo maestro puede proporcionar al modelo alumno una gama más amplia de ejemplos de entrenamiento, ayudando a su proceso de aprendizaje.

- Destilación iterativa: Perfeccionar el modelo del alumno mediante múltiples rondas de destilación puede llevar a que capte progresivamente más conocimientos del profesor.

Ajuste de hiperparámetros

El ajuste cuidadoso de los hiperparámetros es vital para el éxito del proceso de destilación. Los hiperparámetros clave, como la temperatura y la velocidad de aprendizaje, influyen significativamente en la capacidad del modelo alumno para aprender del maestro:

- Temperatura: Este parámetro controla la suavidad de la distribución de probabilidad generada por el modelo del profesor. Las temperaturas más altas producen distribuciones de probabilidad más suaves, lo que puede ayudar al modelo de alumno a aprender más a fondo de las predicciones del profesor.

- Tasa de aprendizaje: Ajustar el ritmo de aprendizaje es esencial para equilibrar la velocidad y la estabilidad del proceso de entrenamiento. Una tasa de aprendizaje adecuada garantiza que el modelo del alumno converja a una solución óptima sin sobreajustarse ni desajustarse.

Evaluar la eficacia

Evaluar la eficacia del modelo destilado es un paso indispensable para garantizar que cumple los criterios de rendimiento deseados, sobre todo con sus predecesores y alternativas. Esto implica comparar el rendimiento del alumno con el del profesor y otras líneas de base para comprender hasta qué punto el proceso de destilación ha conservado o avanzado la funcionalidad del modelo.

Para medir la eficacia del modelo destilado, es importante centrarse en las siguientes métricas:

- Precisión: Mide cómo se compara la precisión del modelo del alumno con el modelo del profesor y otras líneas de base, proporcionando información sobre cualquier pérdida o retención de precisión.

- Velocidad de inferencia: Compara la velocidad de inferencia del modelo del alumno con la del modelo del profesor, destacando las mejoras en el tiempo de procesamiento.

- Talla del modelo: Evalúa las diferencias en el tamaño del modelo entre los modelos del alumno y del profesor, así como otras líneas de base, para evaluar las ganancias de eficiencia de la destilación.

- Utilización de los recursos: Analiza cómo se compara el uso de recursos del modelo de alumno con el del modelo de profesor, asegurándote de que el modelo de alumno ofrece una alternativa más económica sin comprometer el rendimiento.

Buenas prácticas

Seguir las mejores prácticas puede aumentar la eficacia de la destilación LLM. Estas directrices hacen hincapié en la experimentación, la evaluación continua y la aplicación estratégica.

- Experimentación: Experimenta regularmente con diferentes técnicas de destilación y ajustes de hiperparámetros para identificar las mejores configuraciones para tu caso de uso específico.

- Evaluación continua: Evalúa continuamente el rendimiento del modelo del alumno utilizando puntos de referencia y conjuntos de datos relevantes. Las pruebas iterativas y el perfeccionamiento son fundamentales para lograr resultados óptimos.

- Formación equilibrada: Verifica que se está aplicando un proceso de entrenamiento equilibrado, combinando objetivos blandos del modelo de profesor con objetivos duros. Este enfoque ayuda al alumno modelo a captar conocimientos matizados manteniendo la precisión.

- Actualizaciones periódicas: Mantente informado sobre los últimos avances en la investigación de la destilación LLM e incorpora nuevas técnicas y descubrimientos a tu proceso de destilación.

Investigación y orientaciones futuras

El campo de la destilación LLM está evolucionando rápidamente. Esta sección explora las últimas tendencias, los retos actuales de la investigación y las técnicas emergentes en la destilación LLM.

Últimas investigaciones y avances

La investigación reciente en destilación LLM se ha centrado en el desarrollo de técnicas y arquitecturas novedosas para mejorar la eficiencia y eficacia del proceso de destilación. Algunos avances notables son:

- Destilación progresiva: Esto implica destilar el conocimiento por etapas, donde los modelos intermedios del alumno se destilan progresivamente a partir del modelo del profesor. Esta técnica ha demostrado ser prometedora para mejorar el rendimiento y la estabilidad del modelo final del alumno.

- Destilación diagnóstica de tareas: Los investigadores están explorando métodos para destilar el conocimiento de una manera independiente de la tarea, permitiendo que el modelo del estudiante se generalice a través de diferentes tareas sin requerir un ajuste fino específico de la tarea. específica de la tarea. Este enfoque puede reducir en gran medida el tiempo de entrenamiento y los recursos informáticos necesarios para las nuevas aplicaciones.

- Destilación intermodal: Otra área emergente es la destilación de conocimientos a través de diferentes modalidades, como texto, imágenes y audio. La destilación intermodal pretende crear modelos de alumnos versátiles que puedan manejar múltiples tipos de datos de entrada, ampliando la aplicabilidad de los modelos destilados.

Problemas abiertos y orientaciones futuras

A pesar de los importantes avances, aún quedan varios retos y cuestiones de investigación abiertas en el campo de la destilación LLM:

- Potenciar la generalización: Uno de los principales retos es mejorar la capacidad de generalización de los modelos destilados. Garantizar que los modelos de los estudiantes funcionen bien en una variedad de tareas y conjuntos de datos sigue siendo un área de investigación en curso.

- Transferencia de conocimientos entre dominios: La transferencia eficaz de conocimientos entre distintos ámbitos es otra área crítica. Desarrollar métodos para destilar conocimientos que puedan aplicarse a dominios nuevos y distintos sin una pérdida significativa de rendimiento es un objetivo importante.

- Escalabilidad: Escalar las técnicas de destilación para manejar eficientemente modelos y conjuntos de datos cada vez mayores es un reto persistente. La investigación se centra en optimizar el proceso de destilación para hacerlo más escalable.

Técnicas emergentes

Se están desarrollando continuamente nuevas técnicas e innovaciones para afrontar estos retos e impulsar este campo. Algunos enfoques prometedores son:

- Adaptaciones de aprendizaje de cero disparos y pocos disparos: Integrar las capacidades de aprendizaje de cero disparos y pocos disparos en modelos destilados es un área de investigación floreciente. Estas técnicas permiten a los modelos realizar tareas con pocos o ningún dato de entrenamiento específico de la tarea, lo que aumenta su versatilidad y practicidad.

- Autodestilación: En la autodestilación, el modelo del alumno se entrena utilizando sus predicciones como objetivos blandos. Este enfoque puede mejorar el rendimiento y la robustez del modelo utilizando iterativamente sus conocimientos aprendidos.

- Destilación adversarial: Combinar la formación contradictoria con técnicas de destilación es otro enfoque innovador. La destilación adversarial implica entrenar el modelo del alumno no sólo para que imite al maestro, sino también para que sea robusto contra ataques adversariosmejorando su seguridad y fiabilidad.

Conclusión

La destilación LLM es una técnica fundamental para hacer más prácticos y eficaces los modelos lingüísticos de gran tamaño. Al transferir los conocimientos esenciales de un modelo de profesor complejo a un modelo de alumno más pequeño, la destilación conserva el rendimiento al tiempo que reduce el tamaño y las exigencias computacionales.

Este proceso permite aplicaciones de IA más rápidas y accesibles en diversos sectores, desde tareas de PNL en tiempo real hasta casos de uso especializado en sanidad y finanzas. Poner en práctica la destilación LLM requiere una planificación cuidadosa y las herramientas adecuadas, pero las ventajas -como la reducción de costes y un despliegue más amplio- son sustanciales.

A medida que la investigación siga avanzando, la destilación LLM desempeñará un papel cada vez más importante en la democratización de la IA, haciendo que los modelos potentes sean más accesibles y utilizables en diversos contextos.