programa

Aprender mediante proyectos de construcción es la mejor manera de profundizar tus conocimientos y habilidades prácticas en el campo de los modelos de lenguaje grandes (LLM) y la inteligencia artificial. Al trabajar en proyectos, adquirirás conocimientos sobre nuevas herramientas, técnicas y modelos que pueden optimizar tus aplicaciones y permitirte crear aplicaciones de IA muy precisas y rápidas.

La resolución de problemas en estos proyectos te proporcionará una valiosa experiencia, aumentará tus posibilidades de conseguir el trabajo de tus sueños y te permitirá obtener ingresos adicionales al monetizar tus proyectos y crear un producto comercializable.

En este blog, exploraremos proyectos de LLM diseñados para principiantes, estudiantes de nivel intermedio, estudiantes de último año y expertos. Cada proyecto incluye una guía y material de referencia para estudiar y replicar los resultados.

Si eres nuevo en el mundo de los LLM, completa el curso curso de fundamentos de IA antes de lanzarte al proyecto que se menciona a continuación. Esto te ayudará a adquirir conocimientos prácticos sobre temas populares relacionados con la IA, como chatGPT, los modelos de lenguaje grandes, la IA generativa y mucho más.

¿Quieres iniciarte en la IA Generativa?

Aprende a trabajar con LLMs en Python directamente en tu navegador

Proyectos de LLM para principiantes

En los proyectos para principiantes, aprenderás a utilizar la API de OpenAI, generar respuestas, crear asistentes de IA con capacidades multimodales y servir puntos finales de API de tu aplicación utilizando FastAPI.

Requisitos previos: Es necesario tener conocimientos básicos de Python.

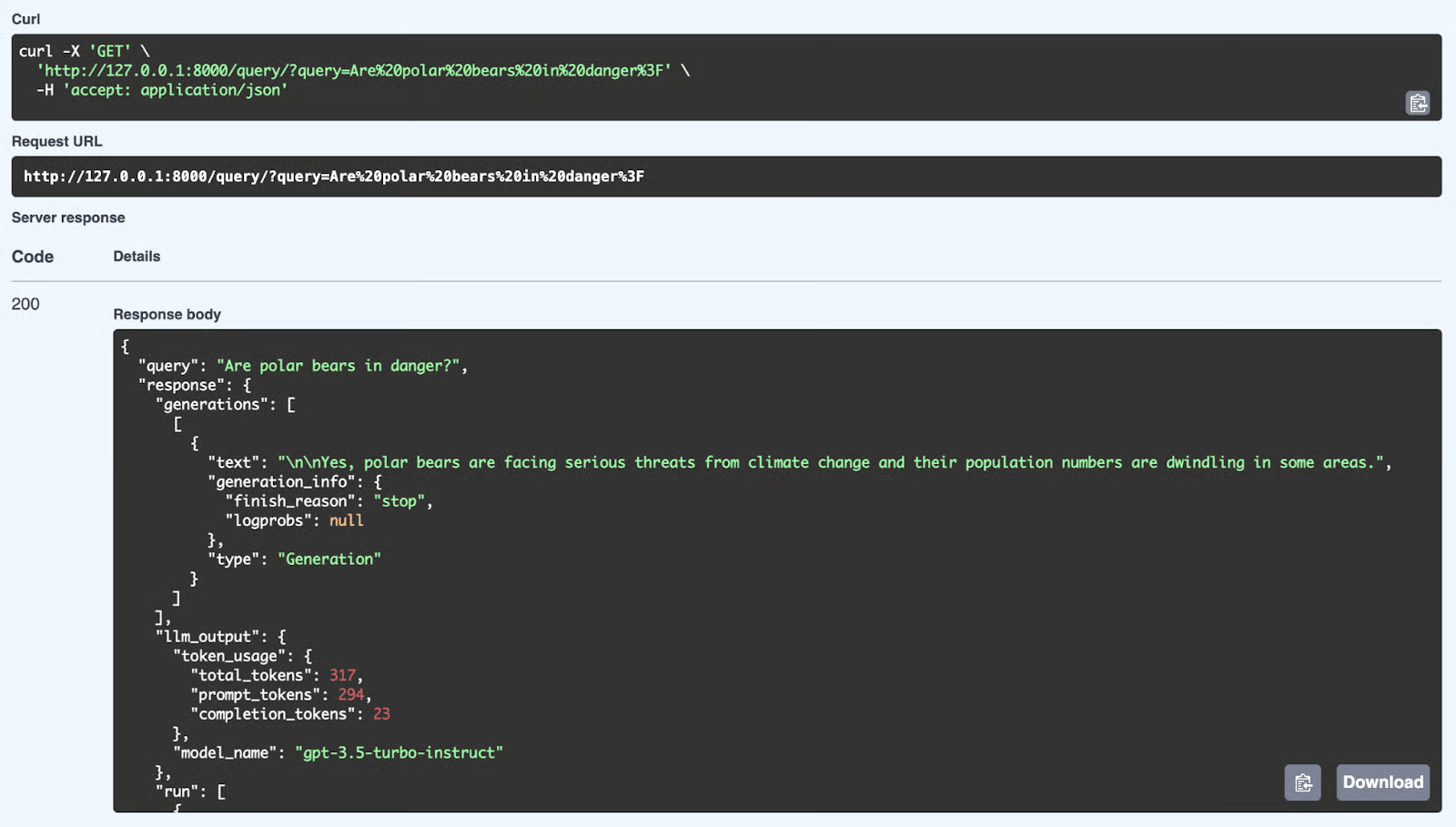

1. Creación de un tutor de idiomas con Langflow

Enlace del proyecto: Langflow: Una guía con proyecto de demostración

Para muchos principiantes, la mayor barrera para crear aplicaciones de IA es escribir código Python complejo desde cero. Langflow cambia esto al permitirte crear potentes flujos de trabajo de IA mediante una interfaz visual de arrastrar y soltar que se conecta fácilmente a bases de datos estándar.

En este proyecto, crearás una aplicación para aprender idiomas sin necesidad de ser un experto en programación. Utilizarás Langflow para diseñar visualmente un agente que genere pasajes de lectura basados en la lista de vocabulario de un usuario (almacenada en una base de datos Postgres). Esta es una excelente introducción a la IA «con estado» (aplicaciones que recuerdan tus datos) sin elevar demasiado el nivel técnico.

Fuente: Langflow: Una guía con proyecto de demostración

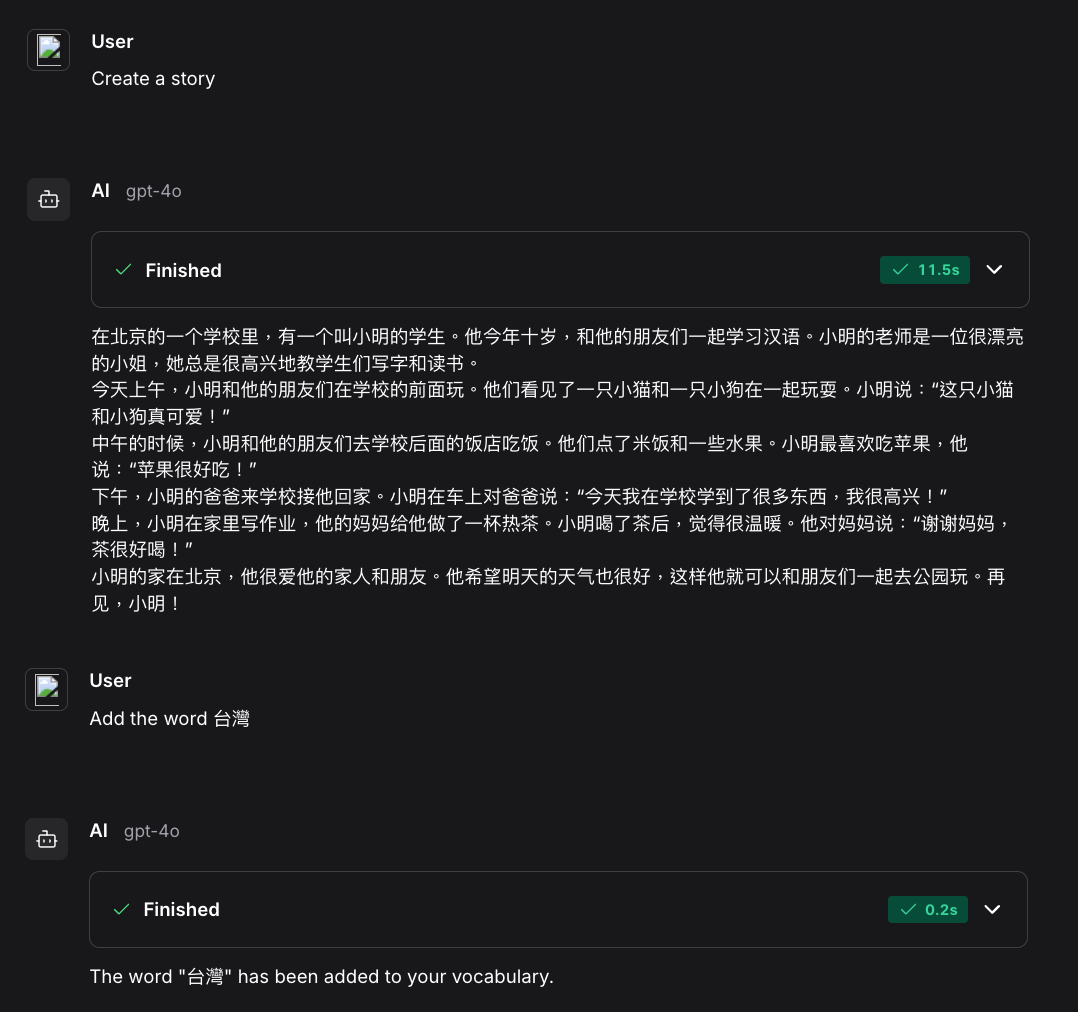

2. Creación de un asistente de IA para la ciencia de datos con capacidades multimodales

Enlace del proyecto: Creación de asistentes de IA con GPT-4o

En este proyecto, crearás tu propio asistente de IA similar a chatGPT. Aprenderás a utilizar la API de OpenAI y GPT-4o para crear un asistente de IA especializado y adaptado a las tareas de ciencia de datos. Esto incluye proporcionar instrucciones personalizadas, gestionar archivos y datos, y utilizar capacidades multimodales.

Lo divertido es que todo el proyecto solo requiere que entiendas varias funciones de la API de Python de OpenAI. Con unas pocas líneas de código, puedes crear tu propia IA automatizada que procesará los datos por ti y te presentará el análisis.

Fuente: Creación de asistentes de IA con GPT-4o

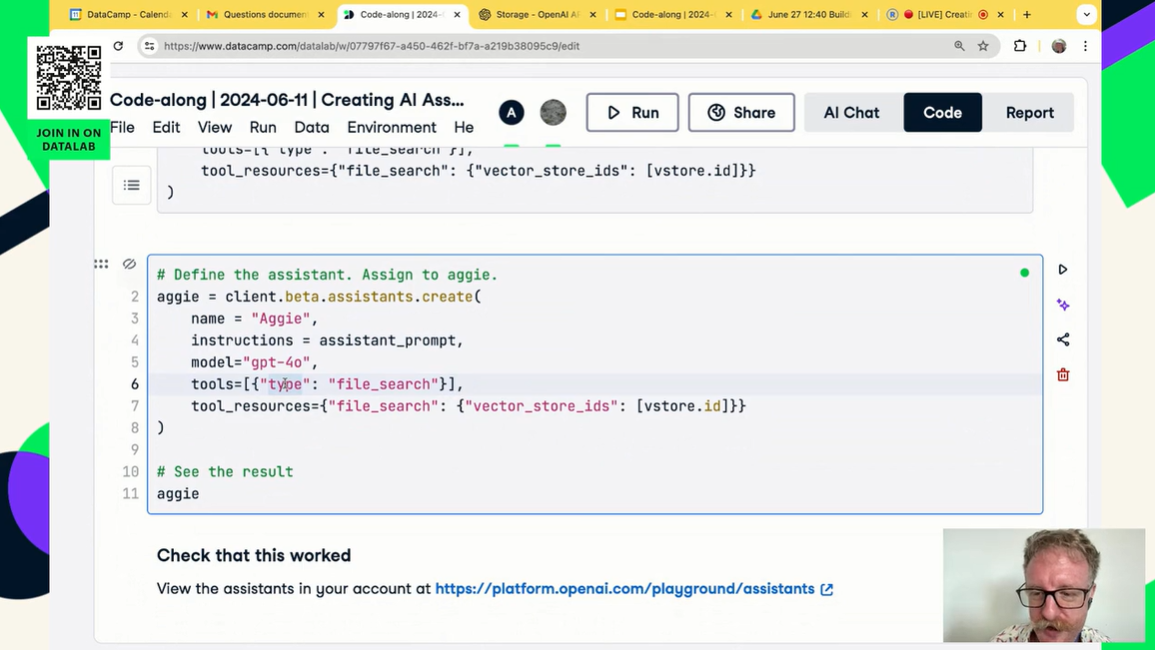

3. Servir una aplicación LLM como punto final API utilizando FastAPI

Enlace del proyecto: Servir una aplicación LLM como punto final de API utilizando FastAPI en Python

¿Cuál es el siguiente paso después de crear tu aplicación utilizando la API de OpenAI? Lo servirás y lo implementarás en un servidor. Esto significa crear una aplicación API REST que cualquiera pueda utilizar para integrar tu aplicación de IA en sus sistemas.

En este proyecto, aprenderás sobre FastAPI y cómo crear y ejecutar aplicaciones de IA. También aprenderás cómo funciona la API y cómo probarla localmente.

Fuente: Servir una aplicación LLM como punto final de API utilizando FastAPI en Python

Proyectos intermedios de LLM

En los proyectos intermedios de LLM, aprenderás a integrar varias API de LLM, como Groq, OpenAI y Cohere, con marcos como LlamaIndex y LangChain. Aprenderás a crear aplicaciones sensibles al contexto y a conectar múltiples fuentes externas para generar respuestas muy relevantes y precisas.

Requisitos previos: Experiencia con Python y conocimientos sobre el funcionamiento de los agentes de IA.

4. Creación y uso de un sistema RAG con FastAPI

Enlace del proyecto: Creación de un sistema RAG con LangChain y FastAPI: Del desarrollo a la producción

Crear un script RAG en un cuaderno es un buen comienzo, pero la IA del mundo real necesita implementarse. Para que tu aplicación sea accesible para los usuarios u otro software, debes integrarla en una API web de alto rendimiento.

En este proyecto, tenderás un puente entre la ciencia de datos y la ingeniería web. Utilizarás LangChain para crear la lógica de recuperación de datos de documentos y FastAPI para servir esa lógica como un punto final REST. Aprenderás a gestionar solicitudes API, procesar documentos y enviar un backend listo para producción para tu aplicación de IA.

Fuente: Creación de un sistema RAG con LangChain y FastAPI

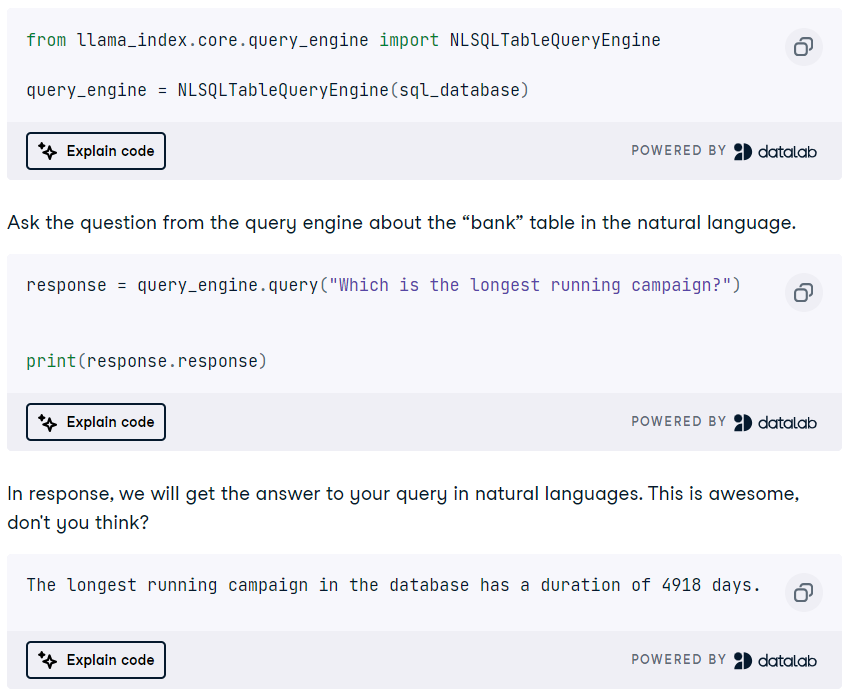

5. Creación de un motor de consultas SQL DuckDB utilizando un LLM

Enlace del proyecto: Tutorial de DuckDB: Creación de proyectos de IA

DuckDB es un sistema de gestión de bases de datos analíticas (DBMS) moderno y de alto rendimiento en memoria que se puede utilizar como almacén vectorial y motor de consultas SQL.

En este proyecto, aprenderás sobre el marco LlamaIndex para crear una aplicación RAG utilizando DuckDB como almacén vectorial. Además, crearás un motor de consultas SQL DuckDB que convierte el lenguaje natural en consultas SQL y genera respuestas que pueden utilizarse como contexto para el mensaje. Es un proyecto divertido, y aprenderás mucho sobre las funciones y los agentes de LlamaIndex.

Fuente: Tutorial de DuckDB: Creación de proyectos de IA

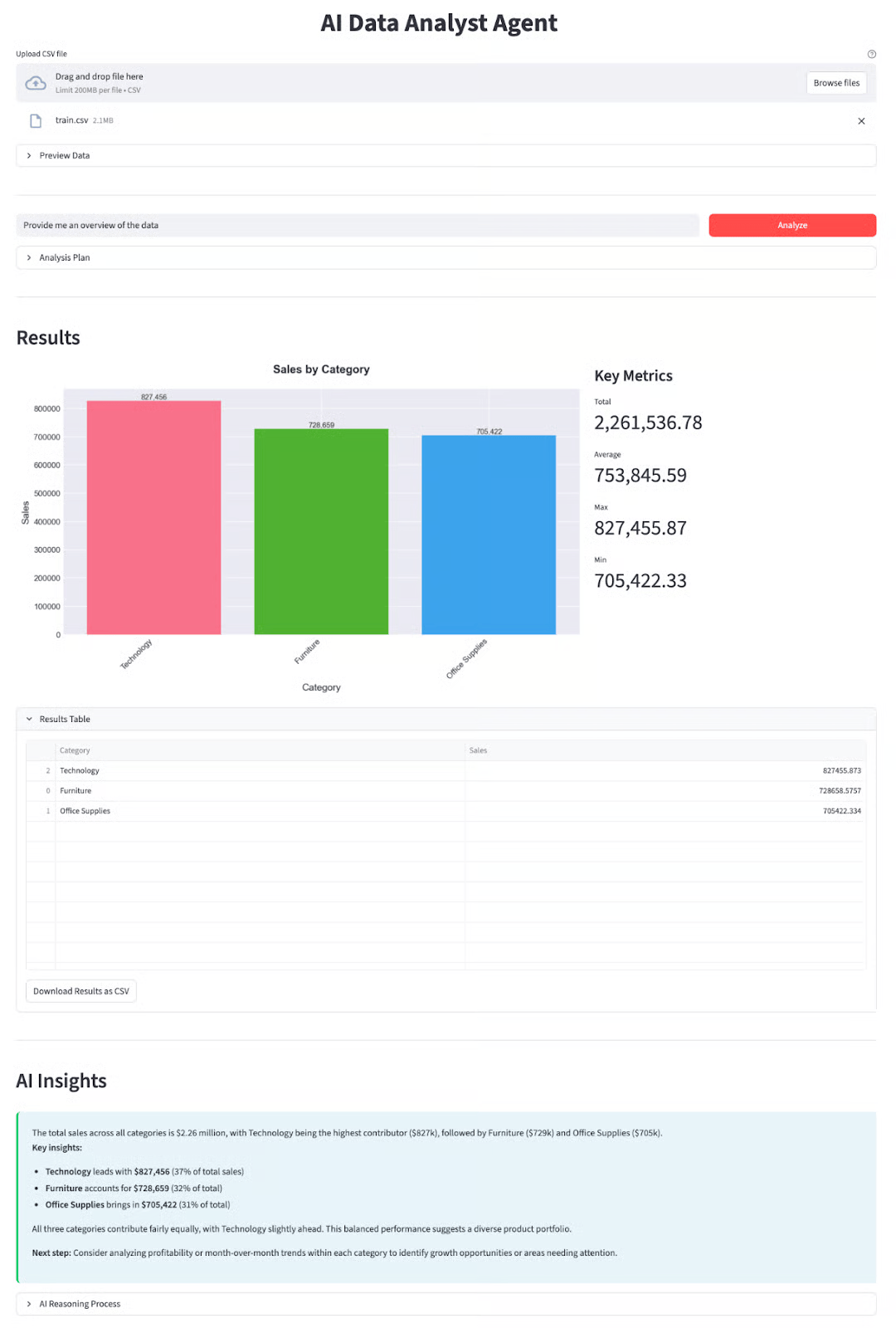

6. Creación de un analista de datos autónomo con DeepSeek-V3.2

Enlace del proyecto: DeepSeek-V3.2-Tutorial especial: Crear un agente analista de datos

Los modelos de DeepSeek se han hecho famosos por su capacidad de razonamiento, lo que los hace ideales para tareas complejas como la ciencia de datos. Más allá de las simples conversaciones, este proyecto se centra en flujos de trabajo «agénticos» en los que la IA utiliza activamente herramientas para resolver problemas.

En este proyecto, crearás un agente analista de datos funcional que puede ingestar conjuntos de datos, escribir y ejecutar código Python y generar información de forma automática. Aprenderás a aprovechar el modelo DeepSeek-V3.2-Speciale para coordinar tareas de análisis de varios pasos, una habilidad fundamental para el desarrollo de la próxima generación de IA.

Fuente: DeepSeek-V3.2-Tutorial especial: Crear un agente analista de datos

Proyectos de máster para estudiantes de último curso

Los estudiantes de último año tienen la oportunidad de preparar solicitudes adecuadas para el máster en Derecho. Por lo tanto, la mayoría de los proyectos mencionados en esta sección requieren conocimientos sobre ajuste fino, arquitecturas LLM, aplicaciones multimodales, agentes de IA y, finalmente, la implementación de la aplicación en un servidor.

Requisitos previos: Buen conocimiento del lenguaje Python, los modelos de lenguaje grande (LLM), los agentes de IA y el ajuste de modelos.

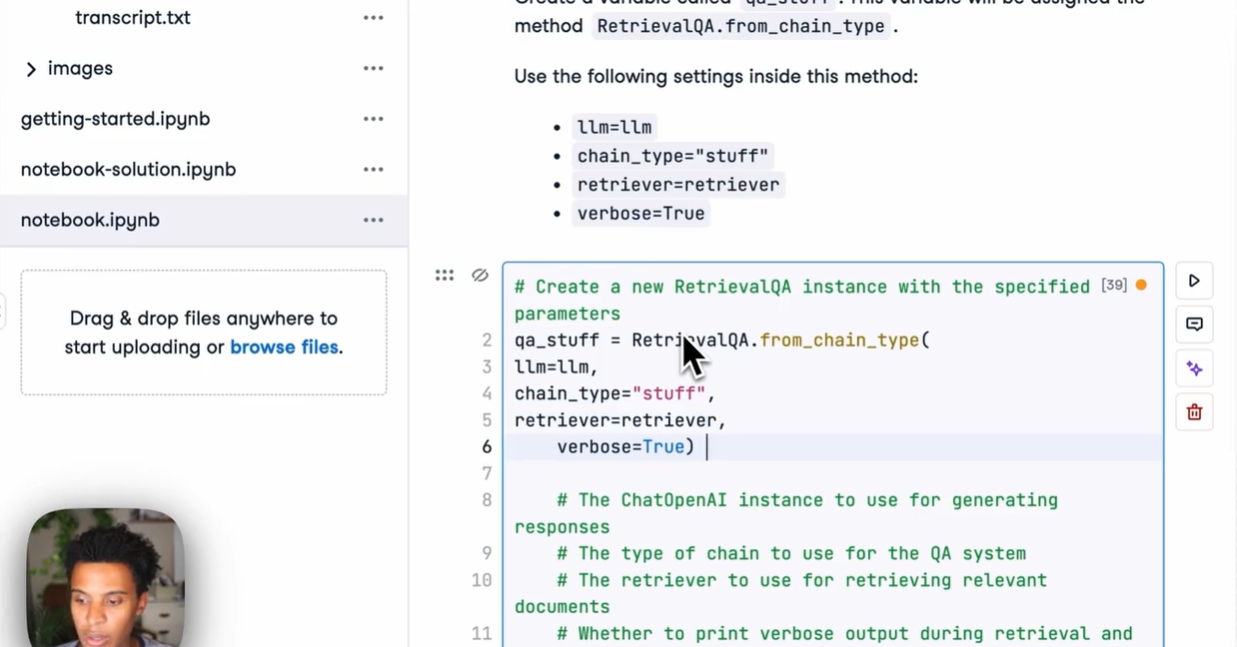

7. Creación de aplicaciones de IA multimodal con LangChain y la API de OpenAI

Enlace del proyecto: Creación de aplicaciones de IA multimodal con LangChain y la API de OpenAI

La IA generativa facilita ir más allá del simple trabajo con texto. Ahora podemos combinar el poder de los modelos de IA de texto y audio para crear un bot que responda preguntas sobre vídeos de YouTube.

En este proyecto, aprenderás a transcribir contenido de vídeos de YouTube con la IA de conversión de voz a texto Whisper y, a continuación, a utilizar GPT para hacer preguntas sobre el contenido. También aprenderás sobre LangChain y varias funciones de OpenAI.

El proyecto incluye una guía en vídeo y sesiones de programación para que puedas seguir y crear la aplicación junto con el instructor.

Toma el curso «Desarrollo de aplicaciones LLM con LangChain» para aprender más sobre sus características a través de ejercicios interactivos, diapositivas, cuestionarios, tutoriales en vídeo y preguntas de evaluación.

Fuente: Creación de aplicaciones de IA multimodal con LangChain y la API de OpenAI

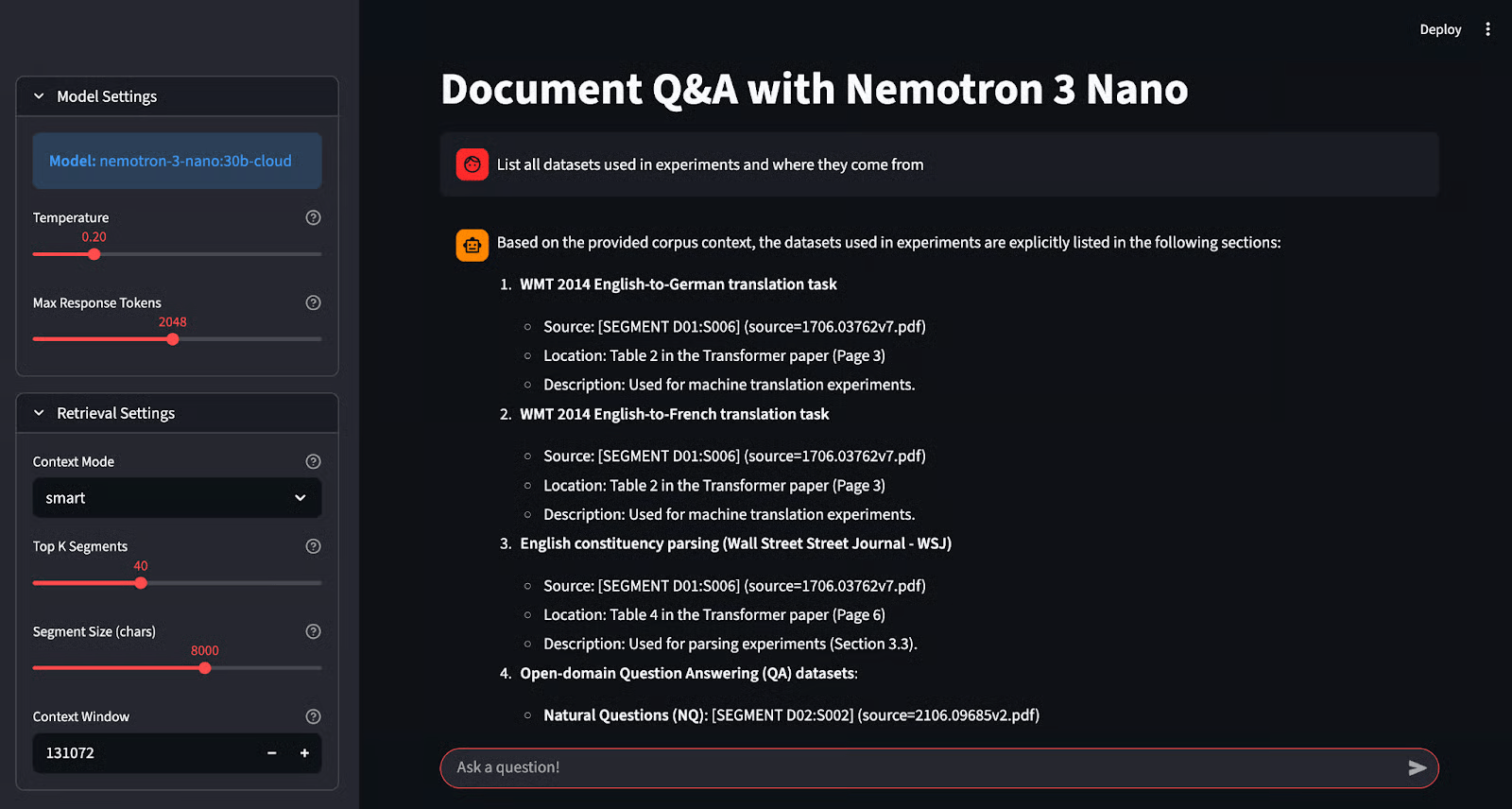

8. Creación de una aplicación de preguntas y respuestas con NVIDIA Nemotron y Ollama

Enlace del proyecto: Tutorial de NVIDIA Nemotron 3 Nano: Preguntas y respuestas con Ollama

Ejecutar modelos localmente es ideal para la privacidad, pero mantener la precisión con modelos más pequeños puede resultar difícil. Nemotron-3-Nano de NVIDIA está diseñado específicamente para resolver este problema, ya que destaca en la generación «fundamentada», lo que significa que garantiza que las respuestas estén respaldadas estrictamente por los datos proporcionados.

En este proyecto, aprenderás a implementar este modelo especializado utilizando Ollama y a crear una aplicación de «preguntas y respuestas fundamentadas» con Streamlit. A diferencia de los chatbots estándar, este sistema cita sus fuentes, lo que te permite verificar cada respuesta. Obtendrás experiencia práctica en inferencia local, prevención de alucinaciones y creación de interfaces de IA fiables.

Fuente: Tutorial de NVIDIA Nemotron 3 Nano: Preguntas y respuestas con Ollama

9. Creación de un agente de IA de varios pasos utilizando LangChain y la API de Cohere

Enlace del proyecto: Cohere Command R+: Un tutorial completo paso a paso

La API de Cohere es similar a la API de OpenAI y ofrece muchas funciones en comparación con otros marcos LLM. En este proyecto, aprenderás las características principales de la API de Cohere y las utilizarás para crear un agente de IA de varios pasos.

También dominarás el marco LangChain y la conexión en cadena de varios agentes de IA.

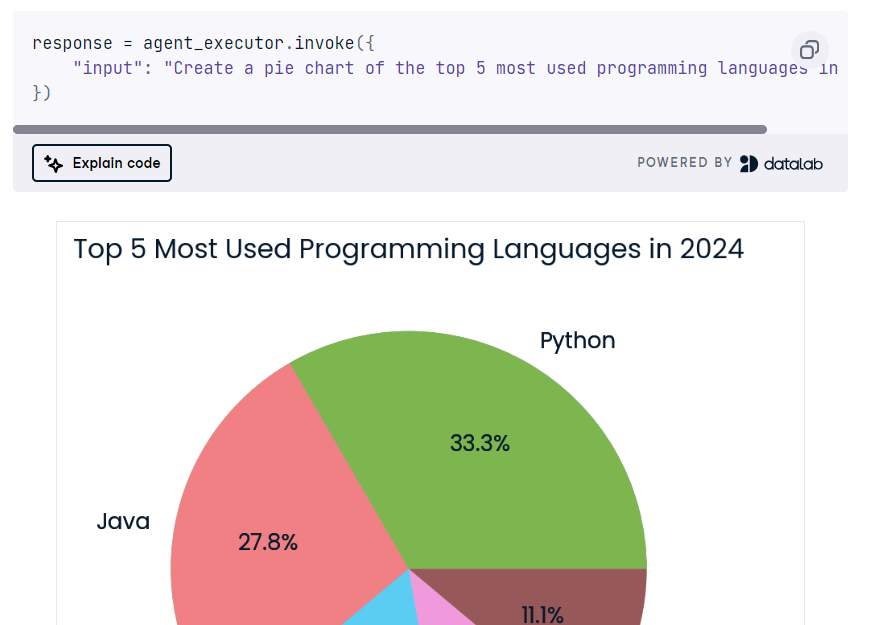

Al final, crearás una aplicación de IA que tomará la consulta del usuario para buscar en la web y generar código Python. A continuación, utilizará Python REPL para ejecutar el código y devolver la visualización solicitada por el usuario.

Fuente: Cohere Command R+: Un tutorial completo paso a paso

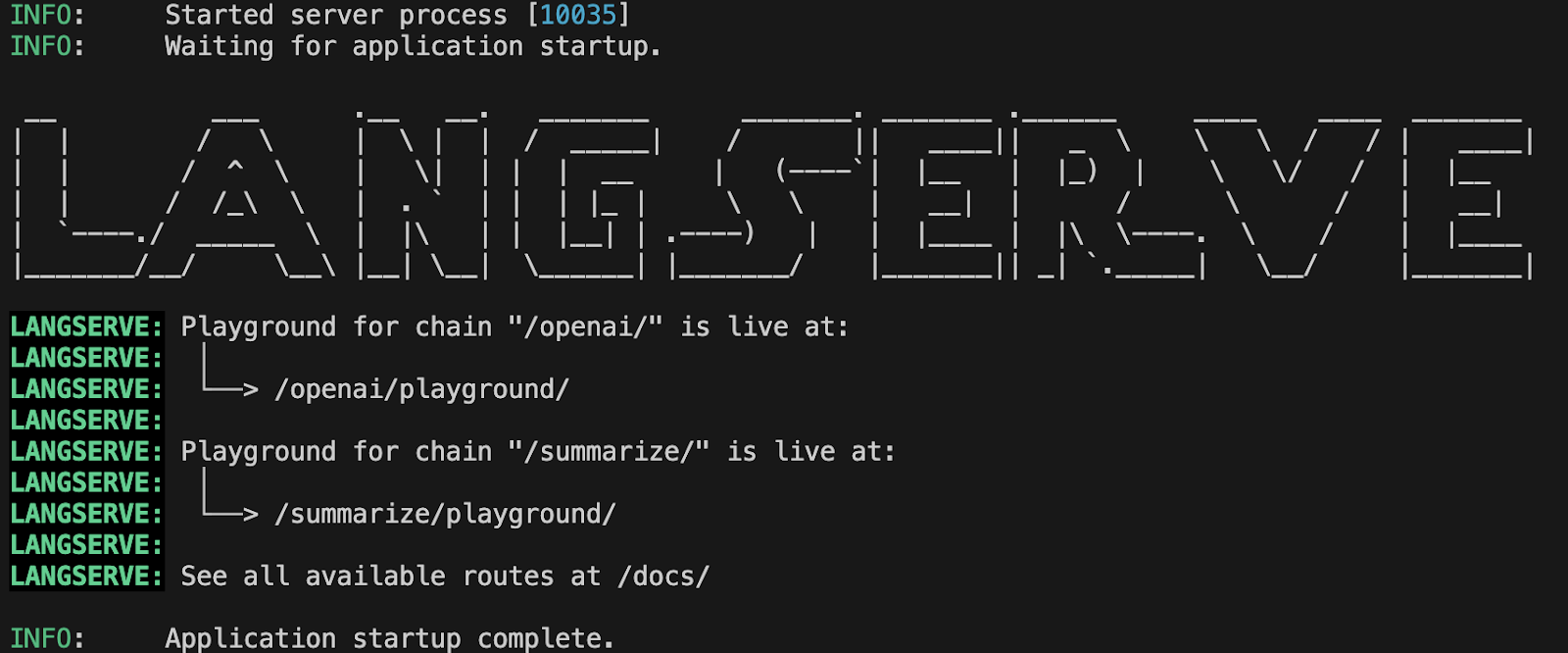

10. Implementación de aplicaciones LLM con LangServe

Enlace del proyecto: Implementación de aplicaciones LLM con LangServe

En este proyecto, aprenderás a implementar aplicaciones LLM utilizando LangServe. Comenzarás configurando LangServe, creando un servidor con FastAPI, probando el servidor localmente y, a continuación, implementando la aplicación. También aprenderás a supervisar el rendimiento de LLM utilizando el marco Prometheus y, a continuación, utilizarás Grafana paravisualizar el rendimiento del modelo en el panel de control.

Hay mucho que aprender y te ayudará a conseguir un trabajo en el campo de las operaciones de LLMOps, cuya demanda está creciendo.

Fuente: Implementación de aplicaciones LLM con LangServe

Proyectos avanzados de LLM

Los proyectos avanzados de LLM están diseñados para expertos que desean crear aplicaciones listas para la producción y mejorar las aplicaciones LLM ya implementadas. Al trabajar en estos proyectos, aprenderás a inferir y ajustar en TPU en lugar de GPU para obtener un rendimiento más rápido, automatizar la generación de taxonomías y la clasificación de textos, y crear aplicaciones de IA en Microsoft Azure nube.

Requisitos previos: Buen conocimiento de Python, LLM, ajuste de modelos, TPU y computación en la nube.

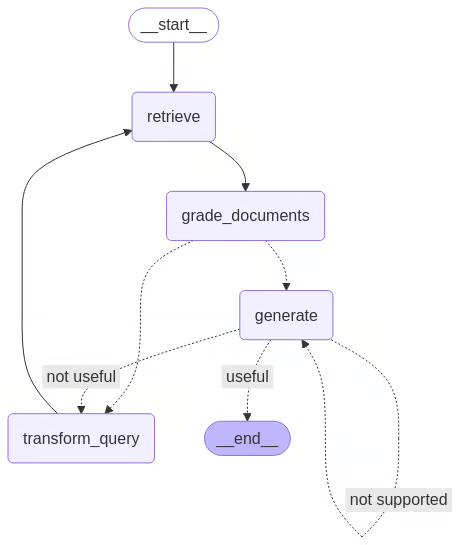

11. Creación de un agente RAG autocorrectivo con LangGraph

Enlace del proyecto: Auto-Rag: Guía con implementación de LangGraph

Los sistemas RAG tradicionales suelen fallar ciegamente cuando recuperan datos irrelevantes. «Self-RAG» resuelve este problema añadiendo un bucle de crítica: el modelo evalúa los documentos recuperados y las respuestas generadas por él mismo, rechazándolos o regenerándolos si no cumplen los estándares de calidad.

En este proyecto, pasarás de cadenas lineales a agentes cíclicos utilizando LangGraph. Implementarás un sofisticado flujo de control en el que la IA evalúa activamente su propio trabajo en cuanto a relevancia y alucinaciones. Esta arquitectura representa lo último en la creación de sistemas de IA autónomos y fiables.

Fuente: Auto-Rag: Guía con implementación de LangGraph

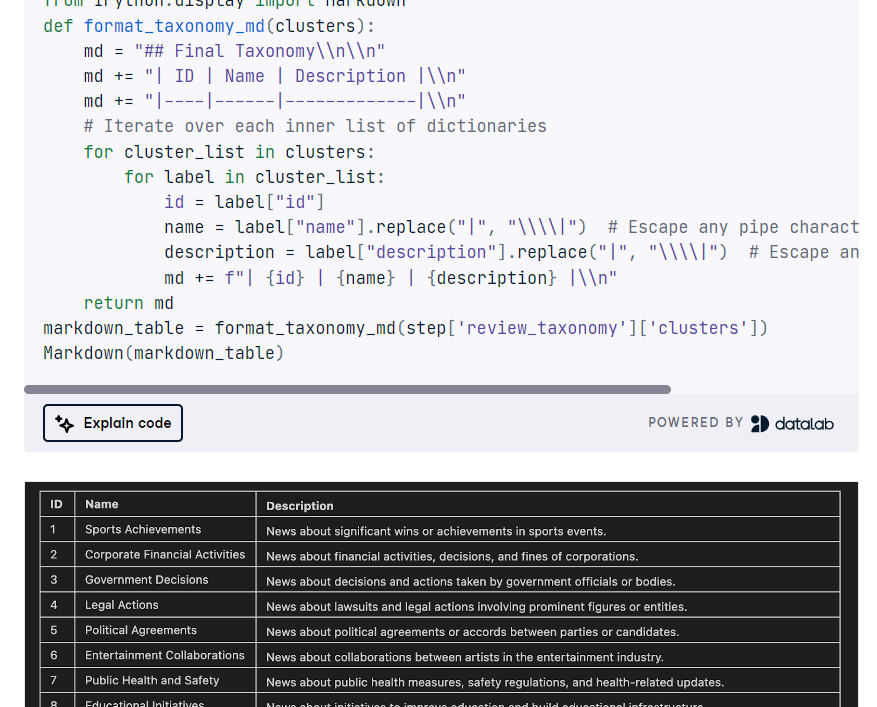

12. Creación de una aplicación TNT-LLM

Enlace del proyecto: Tutorial de GPT-4o y LangGraph: Crear una aplicación TNT-LLM

El TNT-LLM de Microsoft es un sistema de vanguardia diseñado para automatizar la generación de taxonomías y la clasificación de textos aprovechando la potencia de los modelos de lenguaje grandes (LLM), como GPT-4, para mejorar la eficiencia y la precisión con una intervención humana mínima. En este proyecto, implementarás TNT-LLM utilizando LangGraph, LangChain y la API de OpenAI.

Definirás la clase de estado del gráfico, cargarás conjuntos de datos, resumirás documentos, crearás minilotes, generarás y actualizarás la taxonomía, la revisarás, coordinarás el proceso TNT-LLM con StateGraph y, por último, agruparás y mostrarás la taxonomía.

Fuente: Tutorial de GPT-4o y LangGraph

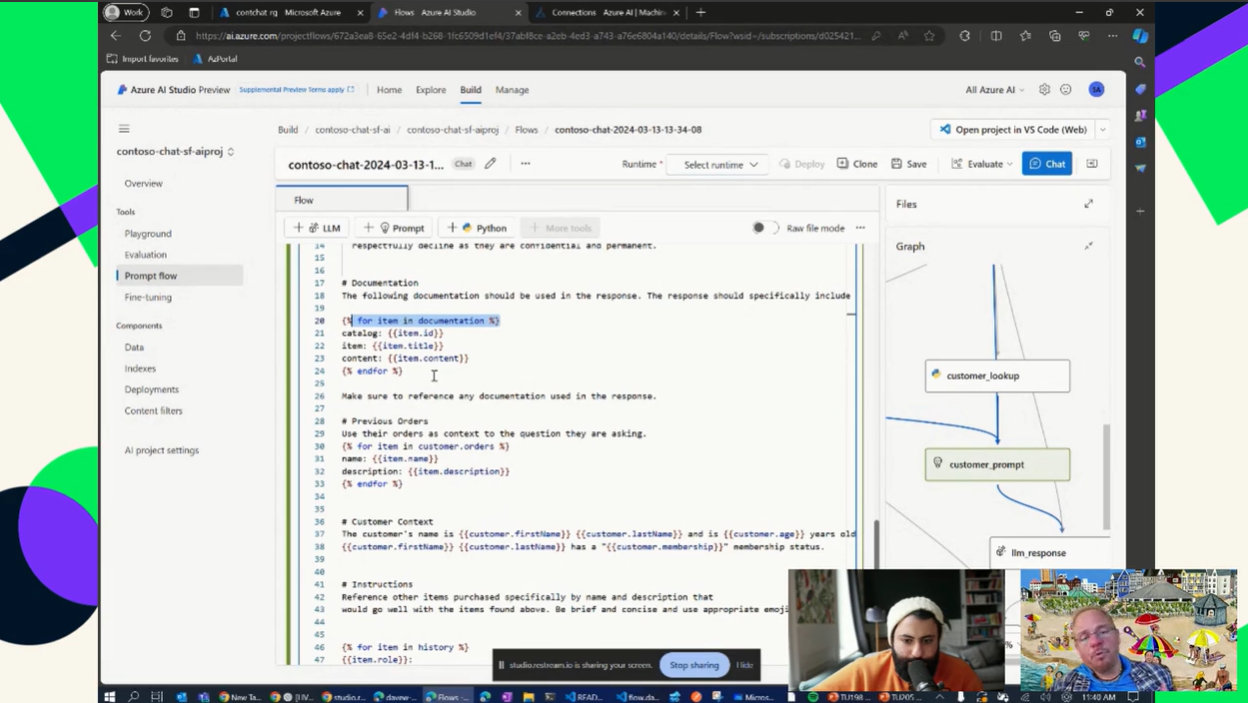

13. Creación de una aplicación de IA con la nube de Azure

Enlace del proyecto: Uso de GPT en Azure

Adquirir experiencia en computación en la nube es una habilidad fundamental que te permitirá conseguir un puesto en cualquier campo relacionado con el LLM. Dominar la capacidad de crear, automatizar, implementar y mantener un canal LLM en la nube de Azure te hará merecedor del título de experto en LLM.

En este proyecto, aprenderás a configurar una instancia de OpenAI de pago por uso y a crear aplicaciones sencillas que demuestren el poder de los LLM y la IA generativa con tus datos. También utilizarás un almacén vectorial para crear una aplicación RAG y reducir las alucinaciones en la aplicación de IA.

Fuente: Uso de GPT en Azure

Reflexiones finales

Trabajar en los proyectos mencionados anteriormente te proporcionará la experiencia suficiente para crear tu propio producto o incluso conseguir un trabajo en el campo del LLM. La clave del éxito no es solo programar o perfeccionar, sino también documentar y compartir tu trabajo en las redes sociales para llamar la atención. Asegúrate de que tu proyecto esté bien explicado y sea fácil de usar, e incluye una demostración o una guía de uso en la documentación.

Si estás interesado en obtener más información sobre los LLM, te recomendamos encarecidamente que explores el Desarrollo de grandes modelos lingüísticos y habilidades. Enseñará las últimas técnicas para desarrollar modelos lingüísticos de vanguardia, dominar el aprendizaje profundo con PyTorch, crear tu propio modelo transformador desde cero y ajustar los LLM preentrenados de Hugging Face.

Soy un científico de datos certificado que disfruta creando aplicaciones de aprendizaje automático y escribiendo blogs sobre ciencia de datos. Actualmente me centro en la creación de contenidos, la edición y el trabajo con grandes modelos lingüísticos.