programa

La IA está cambiando nuestro mundo más rápido que nunca: desde los avances en sanidad hasta los coches autoconducidos, su potencial para remodelar las industrias es enorme. Pero este poder conlleva riesgos como la parcialidad, los problemas de privacidad y el desplazamiento laboral. Sin las barandillas adecuadas, estos riesgos podrían provocar graves problemas sociales, económicos y éticos.

Los países están abordando la regulación de la IA de formas muy diferentes. La UE está tomando la iniciativa con leyes detalladas como la Ley de IA de la UE, que clasifica la IA por riesgos. EE.UU. se mantiene más al margen, dejando que la industria se autorregule. China, por su parte, persigue una rápida innovación en IA, al tiempo que mantiene un estricto control estatal, especialmente en áreas sensibles como la vigilancia.

Estos distintos enfoques demuestran lo difícil que es regular una tecnología que traspasa fronteras e industrias. En este artículo, exploraremos por qué es esencial crear normativas eficaces y equilibradas sobre IA para garantizar que la IA beneficie a la sociedad al tiempo que se minimizan los daños.

Prepara a tu equipo para la Ley de IA de la UE

Garantiza el cumplimiento y fomenta la innovación dotando a tu equipo de los conocimientos de IA que necesitan. Empieza hoy mismo a crear tu programa de formación en IA con DataCamp para empresas.

¿Qué es la regulación de la IA?

La regulación de la IA se refiere a las leyes, políticas y directrices diseñadas para supervisar el desarrollo, despliegue y uso de los sistemas de IA. El objetivo de la regulación de la IA es garantizar que las tecnologías de IA se utilicen de forma ética, segura y responsable, minimizando los riesgos potenciales, como la parcialidad, la violación de la intimidad y el daño a las personas o a la sociedad.

La ética de la IA es el campo que estudia cómo desarrollar y utilizar la IA de forma justa, responsable, transparente y respetuosa con los valores humanos. Lee nuestra página Ética de la IA: Blog de introducción para comprender los riesgos a corto y largo plazo de la IA .

La regulación de la IA abarca una amplia gama de cuestiones, entre las que se incluyen:

- Privacidad de los datos: Garantizar que los sistemas de IA manejen los datos personales de acuerdo con las leyes de privacidad.

- Prejuicios e imparcialidad: Evitar que la IA perpetúe o amplifique la discriminación y los prejuicios.

- Transparencia: Hacer que los sistemas de IA sean explicables y comprensibles, para que sus decisiones sean claras y responsables.

- Seguridad: Garantizar que las tecnologías de IA no causen daños, especialmente en sectores críticos como la sanidad, las finanzas y los sistemas autónomos.

- Responsabilidad: Establecer una responsabilidad clara por las decisiones tomadas por los sistemas de IA, incluidos los marcos jurídicos de responsabilidad.

- Impactos económicos, medioambientales y sociales: Abordar el posible desplazamiento de puestos de trabajo, las desigualdades económicas, medioambientales y sociales derivados de la IA.

Sigue el tema Fundamentos de la IA para descubrir los fundamentos de la IA, sumergirte en modelos como ChatGPT y descifrar los secretos de la IA generativa para navegar por el dinámico panorama de la IA.

¿Por qué es necesaria la regulación de la IA?

El potencial de la IA conlleva riesgos significativos, por lo que la regulación es una necesidad. Una de las preocupaciones más acuciantes es la posibilidad de resultados perjudiciales. Por ejemplo, los sistemas de IA utilizados en la justicia penal han mostrado sesgos afectando desproporcionadamente a las comunidades marginadas. Si no se gestiona adecuadamente, la IA podría exacerbar las desigualdades sociales existentes.

Además, el problema de la "caja negra" es un reto exclusivo de la IA. Muchos sistemas de IA funcionan de formas que ni siquiera sus creadores pueden explicar completamente. Sin transparencia, es difícil entender cómo toman decisiones estos sistemas, lo que plantea dudas sobre la responsabilidad.

La parcialidad es otra cuestión crítica. Los sistemas de IA son tan buenos como los datos con los que se entrenan, y si esos datos reflejan sesgos sociales, la IA también lo hará. Esto puede dar lugar a resultados injustos en ámbitos como la contratación, los préstamos y la aplicación de la ley.

En 2023, Forbes informó sobre una demanda colectiva contra UnitedHealthcare (el mayor proveedor de seguros médicos de EE.UU.), en la que se alegaba la denegación indebida de solicitudes de cuidados prolongados para pacientes ancianos mediante el uso de un algoritmo de IA.

Sin un marco regulador, la sociedad podría no estar preparada para estos cambios económicos, lo que provocaría desigualdad e inestabilidad. No dejes de consultar nuestro artículo, AI in Healthcare: Enhancing Diagnostics, Personalizing Treatment, and Streamlining Operations; explora cómo la IA está influyendo en el futuro de la asistencia sanitaria y cómo las empresas pueden mantenerse a flote con las nuevas habilidades y tecnologías de la IA .

Por último, la IA podría alterar el mercado laboral, desplazando a los trabajadores a medida que la automatización se generalice. McKinsey informa que la actual Generativa y otras tecnologías de IA tienen potencial para automatizar actividades laborales que hoy absorben hasta el 70% del tiempo de los empleados.

Estos cambios supondrán que hasta 12 millones de trabajadores en Europa y Estados Unidos tendrán que cambiar de trabajo. Algunos trabajadores pueden necesitar ayuda para recualificación y mejora de las cualificaciones para ser competitivos en el nuevo mercado.

El estado actual de la regulación de la IA

Echemos un vistazo a la legislación y normativa vigentes para garantizar el uso justo de las herramientas de IA:

El reglamento sobre IA de la Unión Europea

La Ley de la Unión Europea sobre la IA, propuesta en abril de 2021, representa el primer marco jurídico completo destinado a regular la IA en la Unión Europea (UE). La Ley de IA de la UE es una iniciativa innovadora elaborada por la Oficina de IA de la UE para regular el futuro de la IA en Europa. Su objetivo es mitigar los riesgos potenciales que plantean los sistemas de IA, fomentando al mismo tiempo la innovación y la competitividad en el mercado europeo de la IA.

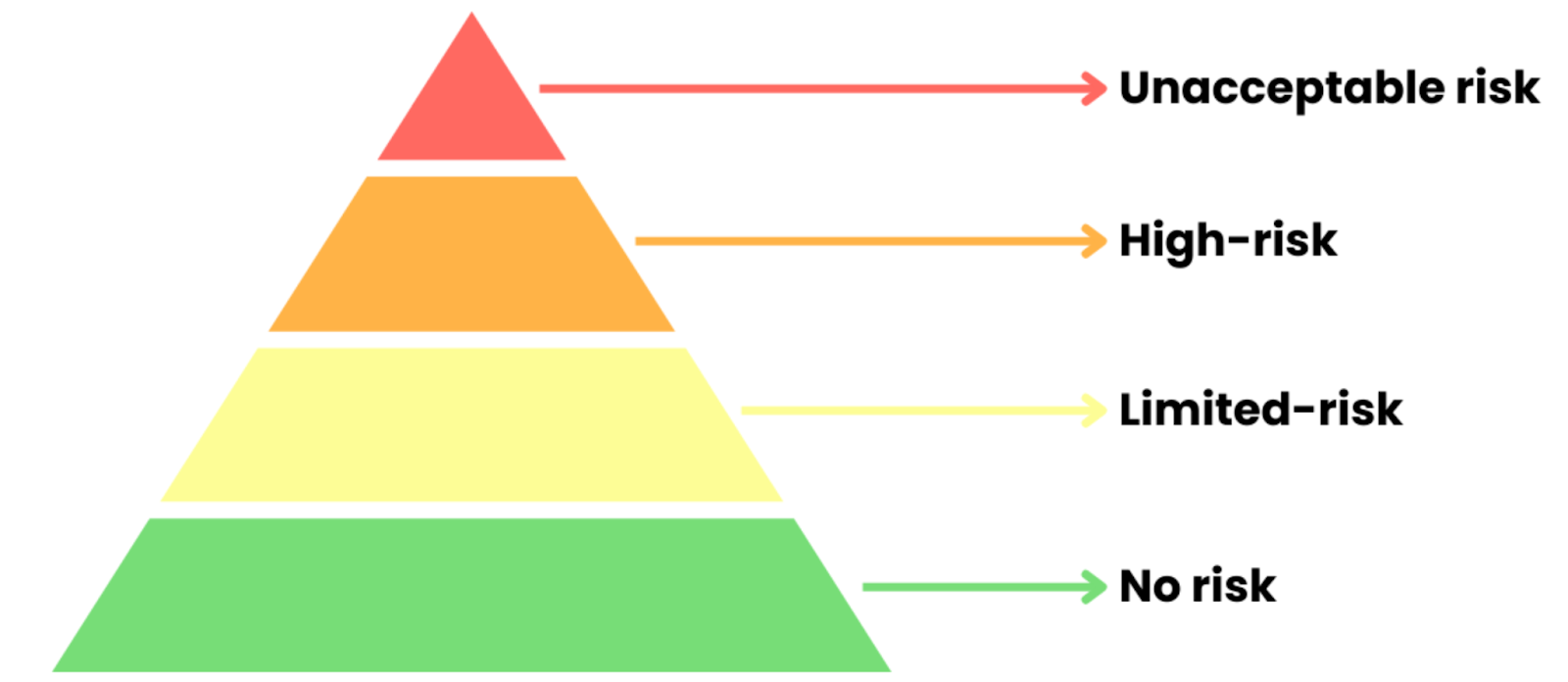

La Ley de IA de la UE está estructurada en torno a un enfoque de la regulación basado en el riesgo, que clasifica los sistemas de IA en función del nivel de riesgo que suponen para las personas y la sociedad. La Ley divide los sistemas de IA en cuatro categorías de riesgo distintas:

Fuente: Curso Datacamp 'Entender la Ley de IA de la UE'

- Riesgo inaceptable: Se prohíben los sistemas de IA que amenacen la seguridad, los derechos o los valores democráticos (por ejemplo, la puntuación social, la manipulación perjudicial).

- IA de alto riesgo: IA en áreas críticas como la sanidad o la aplicación de la ley. Requiere pruebas estrictas, transparencia y supervisión humana para cumplir las normas de la UE antes de su uso.

- Riesgo limitado AI: Incluye chatbots y asistentes virtuales. Los usuarios deben estar informados cuando interactúen con la IA, pero con menos normas.

- AI de riesgo mínimo: Aplicaciones de bajo riesgo, como filtros de spam o IA de juegos. En gran medida exentos de regulación.

Asegúrate de seguir nuestros Fundamentos de la Ley de IA de la UE para dominar la Ley de IA de la UE y los fundamentos de la IA. En el curso aprenderás a sortear las normativas y a fomentar la confianza con la IA Responsable.

La Ley de IA de la UE hace especial hincapié en la transparencia, sobre todo para los sistemas de IA Generativa como ChatGPT, que crean contenidos y se relacionan directamente con los usuarios. En función de cómo se utilicen, estos sistemas podrían clasificarse como de alto riesgo o de riesgo limitado según la Ley. Un requisito clave es que los usuarios deben estar claramente informados cuando interactúan con una IA. Para los modelos generativos, esto significa

- Divulgación de la IA: Los desarrolladores deben indicar claramente cuándo el contenido es generado por IA. Esto ayuda a los usuarios a entender que se están comunicando con una máquina, no con una persona.

- Explicabilidad: Aunque los sistemas de IA generativa pueden ser complejos, la Ley de IA de la UE exige un cierto nivel de claridad. Los que proporcionan modelos de IA tienen que proporcionar suficiente información para que los usuarios y los reguladores puedan comprender cómo funciona el sistema y toma decisiones. Esto incluye compartir detalles sobre los algoritmos subyacentes y los datos de entrenamiento cuando sea necesario.

Para hacer cumplir estas normas, la UE está creando organismos de supervisión tanto a nivel nacional como de la UE para controlar su cumplimiento. Estos organismos pueden auditar los sistemas de IA, investigar las infracciones e imponer sanciones de hasta 30 millones de euros o el 6% de los ingresos globales, lo que sea mayor.

Para saber más sobre la Ley de la IA de la UE, no dejes de seguir nuestro curso Curso sobre la Ley de IA de la UEdonde conocerás las categorías de riesgo de la IA y su cumplimiento, con ejemplos de IA biométrica, educación y modelos de uso general.

Regulación de la IA en Estados Unidos

Estados Unidos adopta un enfoque sectorial más flexible de la regulación de la IA. Aunque no existe una ley federal integral sobre IA, varias leyes existentes, proyectos de ley y directrices tanto a nivel federal como estatal están dando forma a la gobernanza de los sistemas de IA.

Leyes y reglamentos federales existentes

Éstas son las leyes y normativas vigentes en EEUU:

Ley de la Comisión Federal de Comercio (FTC)

La FTC tiene amplia autoridad para proteger a los consumidores de prácticas desleales o engañosas. Esto incluye regular los sistemas de IA que podrían dar lugar a prácticas discriminatorias o resultados engañosos, especialmente en la publicidad y el uso de datos de los consumidores.

Leyes de derechos civiles

Varias leyes de derechos civiles prohíben la discriminación en el empleo, la vivienda y los préstamos. Estas leyes son relevantes para las aplicaciones de IA que podrían perpetuar inadvertidamente los prejuicios, como los algoritmos utilizados para la contratación o la puntuación crediticia. Organismos como la Comisión para la Igualdad de Oportunidades en el Empleo (EEOC) examinan cada vez más los sistemas de IA para comprobar si cumplen estas leyes.

Ley de Portabilidad y Responsabilidad de los Seguros Sanitarios (HIPAA)

En sanidad, las aplicaciones de IA deben cumplir la normativa HIPAA sobre privacidad y seguridad de la información sanitaria. Esto incluye garantizar que cualquier IA utilizada en la atención al paciente respete la confidencialidad y los derechos del paciente.

Legislación federal propuesta

También hay legislación que se ha propuesto y está a la espera de ser validada:

Ley de Responsabilidad Algorítmica

Propuesta en 2022, este proyecto de ley pretende exigir a las empresas que evalúen el impacto de los sistemas automatizados de toma de decisiones en los consumidores. Obliga a realizar auditorías de los algoritmos utilizados en áreas de alto riesgo para identificar y mitigar los sesgos.

Declaración de derechos de la IA

A finales de 2022, el gobierno de Biden publicó un proyecto de 'Declaración de Derechos de la IAen el que se esbozan principios para el uso responsable de la IA, como la imparcialidad, la transparencia y el derecho a recurrir las decisiones automatizadas.

Normativa estatal

A nivel estatal, varias jurisdicciones han tomado la iniciativa de aplicar sus propias normativas sobre IA, a menudo centradas en la privacidad de los datos y la mitigación de los prejuicios:

Ley de Privacidad del Consumidor de California (CCPA)

Esta legislación histórica otorga a los consumidores el derecho a saber cómo se recopila, utiliza y comparte su información personal. Afecta directamente a los sistemas de IA que utilizan datos personales, exigiendo transparencia y el consentimiento del consumidor.

Ley de Herramientas de Decisión Laboral Automatizadas de Nueva York

En vigor en 2023, esta ley obliga a las empresas que utilicen herramientas automatizadas para la contratación a realizar auditorías anuales de sesgo para evaluar el impacto de sus sistemas de IA en distintos grupos demográficos.

Normativa sectorial

Además de las normativas federales y estatales, también existen algunas normativas específicas del sector de la IA:

Vehículos autónomos

EE.UU. El Departamento de Transporte ha publicado directrices para las pruebas y el despliegue de vehículos autónomoshaciendo hincapié en la seguridad y la responsabilidad. Estas directrices exigen a las empresas que demuestren que sus tecnologías de autoconducción cumplen las normas de seguridad antes de que puedan desplegarse en las vías públicas.

Sanidad

Las aplicaciones de la IA en la asistencia sanitaria, como las herramientas de diagnóstico y las recomendaciones de tratamiento, están sujetas al escrutinio de la Administración de Alimentos y Medicamentos (FDA), que está trabajando para establecer vías de regulación de las tecnologías de IA para garantizar que sean seguras y eficaces.

El enfoque chino de la regulación de la IA

El enfoque chino de la gobernanza de la IA está dirigido por el Estado, equilibrando la rápida innovación con una regulación estricta. Se trata de mantener un fuerte control gubernamental al tiempo que se garantiza la seguridad y se fomenta el uso ético.

El marco incluye una serie de políticas y directrices que determinan cómo se desarrolla y utiliza la IA. Las características principales son:

Gobernanza centralizada

El gobierno chino, a través de varios ministerios como el de Ciencia y Tecnología, desempeña un papel crucial en la regulación de la IA. Este control centralizado permite una aplicación coherente de la normativa en distintos sectores y regiones.

Legislación y directrices

Leyes importantes como la Ley de Seguridad de Datos y la Ley de Protección de Datos Personales establecen normas claras para el tratamiento de datos en las aplicaciones de IA. Además, las Directrices Éticas de la IA esbozan los principios que deben cumplir los sistemas de IA, haciendo hincapié en los derechos humanos, la privacidad y la seguridad.

Centrarse en la seguridad nacional

El panorama normativo hace mucho hincapié en la seguridad nacional, y las aplicaciones de IA se someten a evaluaciones rigurosas para garantizar que no amenazan el orden público ni la seguridad del Estado. Esta supervisión es especialmente relevante para las tecnologías que podrían afectar a la estabilidad o la gobernanza de la sociedad.

El modelo de gobierno centralizado plantea problemas de transparencia y responsabilidad, ya que un escrutinio público limitado podría permitir un poder gubernamental sin control en el espacio de la IA.

En 2023, China introdujo el Reglamento sobre la Administración de los Servicios de Inteligencia Artificial Generativaque establece un marco para el desarrollo, despliegue y uso de las tecnologías de IA generativa. Algunas de sus características más destacadas son:

- Controles de seguridad obligatorios: Las empresas necesitan la aprobación del gobierno antes de lanzar IA generadora de contenidos, asegurándose de que los sistemas no supongan riesgos para los intereses o la estabilidad nacionales.

- Control estricto del contenido: Los resultados de la IA generativa están estrechamente regulados para evitar la desinformación o los contenidos que perturben la armonía social, utilizando la censura cuando sea necesario.

- Altas normas de cumplimiento: Las empresas deben ser transparentes sobre sus algoritmos, fuentes de datos y procesos para cumplir las estrictas normativas, mejorando la responsabilidad y evitando el uso indebido.

A medida que la IA transforma las industrias, es fundamental comprender sus riesgos éticos y empresariales. Las empresas no sólo deben aprovechar el potencial de la IA, sino también asegurarse de que se utiliza de forma responsable y transparente.

En nuestro seminario web, "Comprender la normativa sobre IA en EE.UU., la UE y el resto del mundo Shalini Kurapati (directora general de Clearbox AI) y Nick Reiners (analista principal de Eurasia Group) abordan las principales políticas, tendencias normativas y estrategias de cumplimiento en materia de IA. Aprenderás cómo afectan las nuevas normativas a las empresas y obtendrás consejos prácticos para navegar por la gobernanza de la IA, con especial atención a EE.UU., la UE y los marcos globales.

El futuro de la regulación de la IA

Ahora que conocemos el panorama actual de las normativas que rodean a la IA, es hora de analizar lo que vendrá después. A medida que estas herramientas siguen desarrollándose, también deben evolucionar al mismo tiempo nuestras leyes y reglamentos.

La necesidad de cooperación internacional y de un marco regulador mundial

La IA es una tecnología global, y una regulación eficaz requiere cooperación internacional. Los sistemas de IA suelen cruzar fronteras, lo que dificulta que un solo país los regule de forma exhaustiva.

Las aplicaciones de la IA en ámbitos como los vehículos autónomos, la asistencia sanitaria, las finanzas y la seguridad a menudo implican flujos de datos transfronterizos, lo que suscita preocupación por la privacidad, la protección de datos y las normas éticas. Esta naturaleza global requiere un enfoque coordinado de la gobernanza de la IA. Los objetivos de la cooperación internacional son:

- Alineación estándar: Establecer principios compartidos como la transparencia, la responsabilidad y la equidad para crear directrices globales coherentes para el uso de la IA.

- Privacidad y protección de datos: Establecer normas comunes para el intercambio transfronterizo de datos con el fin de proteger la privacidad y garantizar aplicaciones éticas de la IA, respetando al mismo tiempo las leyes nacionales.

- Abordar el sesgo de la IA: Colaborar a nivel mundial para compartir las mejores prácticas, detectar los prejuicios y desarrollar estrategias para unos sistemas de IA más justos y unos resultados equitativos.

Consulta nuestro curso, Gestión responsable de datos de IAdonde podrás aprender los fundamentos de las prácticas de datos responsables, incluida la adquisición de datos, las normativas clave y las estrategias de validación de datos y mitigación de sesgos. Y

sted puede aplicar estas habilidades para utilizar el pensamiento crítico en cualquier proyecto de datos, asegurándose de que tiene un proyecto exitoso, responsable y conforme de principio a fin.

Retos para un marco regulador global de la IA

A pesar de la necesidad de cooperación internacional, la creación de un marco global unificado para la regulación de la IA se enfrenta a varios retos:

- Prioridades nacionales divergentes: Los distintos países dan prioridad a diferentes aspectos de la regulación de la IA -por ejemplo, EE.UU. se centra en la innovación, la UE en la privacidad y China en el control estatal-, lo que dificulta un enfoque global unificado.

- Tensiones geopolíticas: Las rivalidades entre los principales actores de la IA, como EE.UU. y China, dan lugar a marcos opuestos y a preocupaciones sobre la transferencia de tecnología y la seguridad nacional, lo que complica la cooperación.

- Diferencias éticas y culturales: La diversidad de opiniones sobre la vigilancia, la privacidad de los datos y los derechos humanos dificulta la creación de normas éticas universales para la regulación de la IA.

Esfuerzos hacia un marco global de IA

A pesar de los retos, se están realizando esfuerzos para promover la cooperación internacional en la gobernanza de la IA:

Naciones Unidas y AI para el Bien

Las Naciones Unidas han iniciado debates sobre la regulación mundial de la IA a través de foros como IA para el Bienque reúne a expertos, responsables políticos y líderes del sector para explorar los posibles beneficios y riesgos de la IA. Estos debates pretenden dar forma a las normas internacionales para el desarrollo de la IA, especialmente en áreas como la sostenibilidad y los derechos humanos.

Asociaciones Globales sobre IA (GPAI)

Lanzamiento en 2020, GPAI es una iniciativa internacional que promueve el desarrollo responsable de la IA mediante la cooperación transfronteriza. Incluye a países líderes en IA, como Canadá, Francia, Japón e India, entre otros, con el objetivo de fomentar las mejores prácticas, compartir datos y alentar la innovación, respetando al mismo tiempo las normas éticas.

Cumbre de Seguridad de la IA

El Reino Unido acogió la primera Cumbre de Seguridad de la IA en noviembre de 2023. Reunió a líderes mundiales, expertos en tecnología y responsables políticos para abordar los retos críticos de garantizar el desarrollo seguro y ético de la IA. El acto subrayó la importancia de crear marcos para la seguridad de la IA, con especial atención a alinear el desarrollo de la IA con las normas éticas y de seguridad mundiales, sin dejar de fomentar la innovación.

Sin presión pública para que se refuercen las normas éticas y la transparencia, las empresas pueden anteponer los beneficios a la seguridad, y los gobiernos pueden evitar la regulación hasta que el daño sea evidente. Pero cuando la gente exige responsabilidad, empuja a los legisladores a actuar y crear políticas que garanticen que la IA beneficia a la sociedad en lugar de socavar la privacidad o la justicia.

Como dice Bruce Schneier en nuestro episodio de DataFramed sobre Confianza y Regulación en la IA:

Nada cambiará a menos que el gobierno lo fuerce, y el gobierno no lo forzará a menos que nosotros, el pueblo, lo exijamos.

Bruce Schneier, Security Technologist

La necesidad de mejorar y reciclar las cualificaciones

No sólo hay que actualizar la legislación a raíz de la IA; la mano de obra también debe adaptarse. A medida que la automatización y los sistemas inteligentes se hacen cargo de las tareas rutinarias, se hacen imprescindibles nuevos conjuntos de habilidades.

Como destacamos en el Informe sobre el Estado de la Alfabetización en Datos e IAesta transición hace cada vez más hincapié en dotar a la mano de obra de conocimientos sobre IA, competencia técnica y fluidez de datos para prosperar en el cambiante panorama laboral.

Dado que el 62% de los líderes creen que la alfabetización en IA es ahora importante para las tareas cotidianas de sus equipos, para las organizaciones el reto no es sólo mantenerse al día con el cambio tecnológico, sino también asegurarse de que sus equipos están equipados para aprovechar estas herramientas de forma responsable y estratégica.

Esto requiere un enfoque estructurado del aprendizaje, que abarque conceptos básicos de IA, consideraciones éticas y formación técnica avanzada.

Las organizaciones que invierten en mejora y reciclaje de las cualificaciones están mejor posicionadas para mitigar el desplazamiento de puestos de trabajo, fomentar la innovación y seguir siendo competitivas. Los programas integrales de aprendizaje que abordan estas necesidades pueden salvar las distancias, preparando a los equipos técnicos y no técnicos para comprender, desplegar y gobernar los sistemas de IA con eficacia.

DataCamp para empresas puede ayudar a tus equipos a perfeccionarse en IA, sea cual sea la escala de tu organización. Con rutas de aprendizaje personalizadas, informes detallados y un equipo dedicado al éxito, podrás alcanzar tus objetivos de IA en muy poco tiempo.

Mejora las habilidades de tu equipo en IA

Transforma tu empresa dotando a tu equipo de conocimientos avanzados de IA a través de DataCamp for Business. Consigue mejores conocimientos y eficacia.

Conclusión

Regular la IA es clave para garantizar que beneficia a la sociedad al tiempo que se gestionan sus riesgos. Con la IA evolucionando tan rápidamente en todos los sectores, las normativas existentes a menudo no pueden seguir el ritmo.

A medida que la IA avanza en áreas como los modelos generativos, la toma de decisiones autónoma y el aprendizaje profundo, puede que las viejas reglas ya no sean suficientes. El verdadero reto es crear normativas adaptables que puedan evolucionar con la tecnología, equilibrando la innovación con una supervisión responsable.

Si quieres profundizar en el conocimiento de la IA y su impacto, echa un vistazo a nuestros Fundamentos de la IA para ampliar tus conocimientos y mantenerte a la vanguardia.

Llevo varios sombreros: Desarrollador de Software, Programador, Científico de Datos, Desarrollador de Inteligencia de Negocio, Propietario de Producto