Cursus

L'IA change notre monde plus rapidement que jamais - des percées dans le domaine des soins de santé aux voitures autonomes, son potentiel de remodelage des industries est énorme. Mais ce pouvoir s'accompagne de risques tels que les préjugés, les problèmes de protection de la vie privée et le déplacement d'emplois. En l'absence de garde-fous, ces risques peuvent entraîner de graves problèmes sociaux, économiques et éthiques.

Les pays abordent la réglementation de l'IA de manières très différentes. L'UE prend les devants en adoptant des lois détaillées telles que la loi européenne sur l'IA, qui classe l'IA en fonction des risques. Les États-Unis sont plus discrets et laissent l'industrie s'autoréguler. La Chine, quant à elle, poursuit l'innovation rapide en matière d'IA tout en maintenant un contrôle étatique strict, en particulier dans des domaines sensibles tels que la surveillance.

Ces différentes approches montrent à quel point il est difficile de réglementer une technologie qui dépasse les frontières et les secteurs d'activité. Dans cet article, nous verrons pourquoi il est essentiel d'élaborer des réglementations efficaces et équilibrées en matière d'IA pour garantir que l'IA profite à la société tout en minimisant les dommages.

Découvrez les réglementations en matière d'IA sur les différents marchés grâce à notre webinaire intitulé " Comprendre les réglementations en matière d'IA aux États-Unis, dans l'UE et dans le reste du monde".

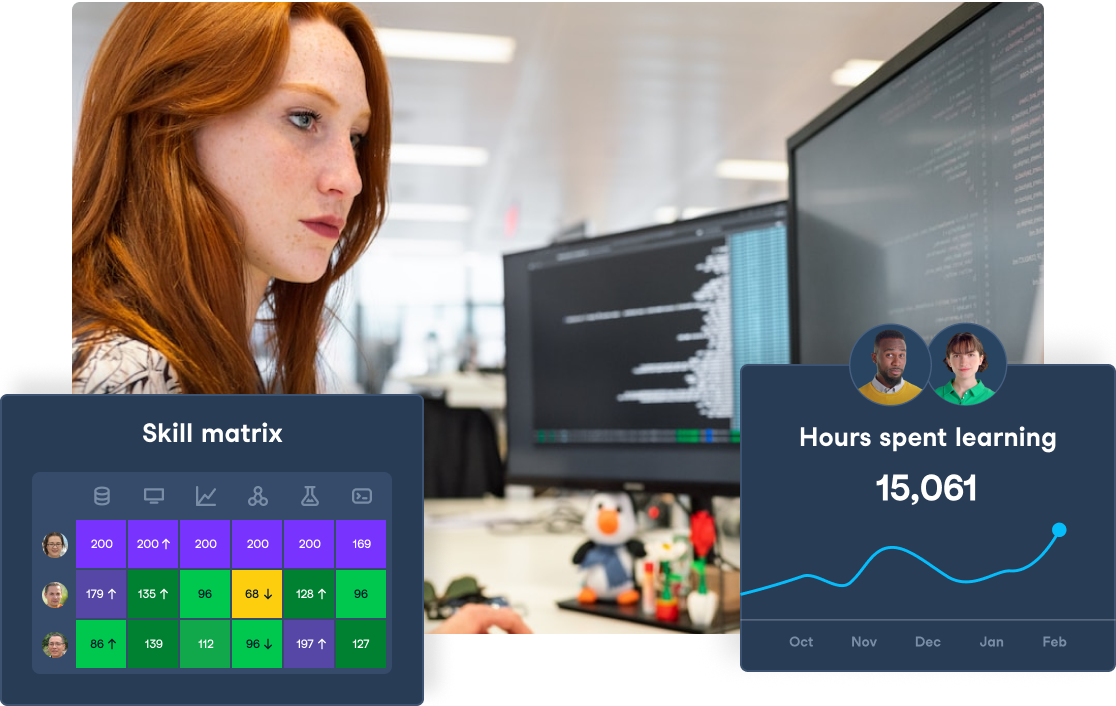

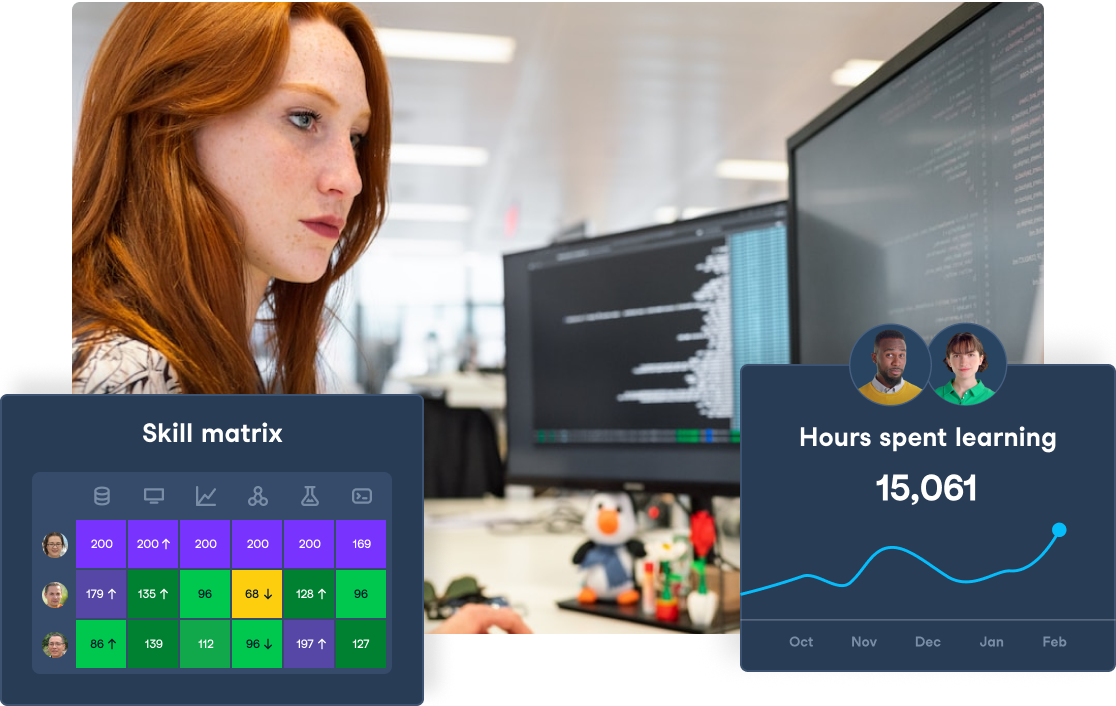

Préparez votre équipe à la loi européenne sur l'IA

Garantissez la conformité et favorisez l'innovation en dotant votre équipe des compétences en matière de maîtrise de l'IA dont elle a besoin. Commencez dès aujourd'hui à créer votre programme de formation à l'IA avec DataCamp for Business.

Qu'est-ce que la réglementation de l'IA ?

La réglementation de l'IA fait référence aux lois, politiques et lignes directrices conçues pour superviser le développement, le déploiement et l'utilisation des systèmes d'IA. L'objectif de la réglementation de l'IA est de garantir que les technologies de l'IA sont utilisées de manière éthique, sûre et responsable, tout en minimisant les risques potentiels tels que les préjugés, les violations de la vie privée et les préjudices causés aux individus ou à la société.

L'éthique de l'IA est le domaine qui étudie comment développer et utiliser l'IA de manière équitable, responsable, transparente et respectueuse des valeurs humaines. Consultez notre site Éthique de l'IA : Une introduction blog pour comprendre les risques à court et à long terme de l'IA.

La réglementation de l'IA englobe un large éventail de questions, notamment

- Confidentialité des données: Veiller à ce que les systèmes d'IA traitent les données personnelles dans le respect des lois sur la protection de la vie privée.

- Biais et équité: Empêcher l'IA de perpétuer ou d'amplifier les discriminations et les préjugés.

- Transparence: Rendre les systèmes d'IA explicables et compréhensibles, afin que leurs décisions soient claires et responsables.

- Sécurité: Veiller à ce que les technologies d'IA ne causent pas de dommages, en particulier dans des secteurs critiques tels que les soins de santé, la finance et les systèmes autonomes.

- Responsabilité: Établir une responsabilité claire pour les décisions prises par les systèmes d'IA, y compris des cadres juridiques pour la responsabilité.

- Impacts économiques, environnementaux et sociaux: Prise en compte du risque de déplacement d'emplois et des inégalités économiques, environnementaux environnementaux et sociétaux résultant de l'IA.

Suivez les cours de DataCamp sur les le cursus AI Fundamentals de Datacamp pour découvrir les fondamentaux de l'IA, plonger dans des modèles comme ChatGPT, et décoder les secrets de l'IA générative pour naviguer dans le paysage dynamique de l'IA.

Pourquoi la réglementation de l'IA est-elle nécessaire ?

Le potentiel de l'IA s'accompagne de risques importants, d'où la nécessité d'une réglementation. L'une des préoccupations les plus pressantes est la possibilité de résultats néfastes. Par exemple, les systèmes d'IA utilisés dans la justice pénale ont fait preuve de partialité, les systèmes d'IA utilisés dans la justice pénale ont fait preuve de partialité, affectant de manière disproportionnée les communautés marginalisées. Si elle n'est pas correctement gérée, l'IA pourrait exacerber les inégalités sociales existantes.

En outre, le problème de la "boîte noire" est un défi propre à l'IA. De nombreux systèmes d'IA fonctionnent d'une manière que même leurs créateurs ne peuvent expliquer entièrement. En l'absence de transparence, il est difficile de comprendre comment ces systèmes prennent leurs décisions, ce qui soulève des questions quant à la responsabilité.

La partialité est un autre problème critique. La qualité des systèmes d'IA dépend des données sur lesquelles ils sont formés, et si ces données reflètent les préjugés de la société, l'IA en fera de même. Cela peut conduire à des résultats injustes dans des domaines tels que l'embauche, les prêts et l'application de la loi.

En 2023, Forbes a fait état d'une recours collectif contre UnitedHealthcare (le plus grand fournisseur d'assurance maladie des États-Unis), alléguant le refus injustifié de demandes de prise en charge de soins prolongés pour des patients âgés par l'utilisation d'un algorithme d'IA.

Sans cadre réglementaire, la société pourrait ne pas être préparée à ces changements économiques, ce qui entraînerait des inégalités et de l'instabilité. N'oubliez pas de consulter notre article, AI in Healthcare : Enhancing Diagnostics, Personalizing Treatment, and Streamlining Operations; il explore la façon dont l'IA influence l'avenir des soins de santé et comment les entreprises peuvent rester à flot grâce aux nouvelles compétences et technologies de l'IA.

Enfin, l'IA pourrait perturber le marché de l'emploi, en déplaçant les travailleurs à mesure que l'automatisation se répand. McKinsey rapporte que l'actuelle approche générative et d'autres technologies d'IA ont le potentiel d'automatiser les activités professionnelles qui absorbent aujourd'hui jusqu'à 70 % du temps des employés.

Ces changements impliqueront que jusqu'à 12 millions de travailleurs en Europe et aux États-Unis devront changer d'emploi. Certains travailleurs peuvent avoir besoin d'aide pour de requalification et d'amélioration des compétences pour être compétitifs sur le nouveau marché.

L'état actuel de la réglementation de l'IA

Examinons la législation et la réglementation en vigueur pour garantir une utilisation équitable des outils d'IA :

Le règlement de l'Union européenne sur l'IA

La loi de l'Union européenne sur l'IA, proposée en avril 2021, représente le premier cadre juridique complet visant à réglementer l'IA au sein de l'Union européenne (UE). La loi européenne sur l'IA est une initiative novatrice élaborée par l'Office européen de l'IA pour réglementer l'avenir de l'IA en Europe. Son objectif est d'atténuer les risques potentiels posés par les systèmes d'IA tout en encourageant l'innovation et la compétitivité sur le marché européen de l'IA.

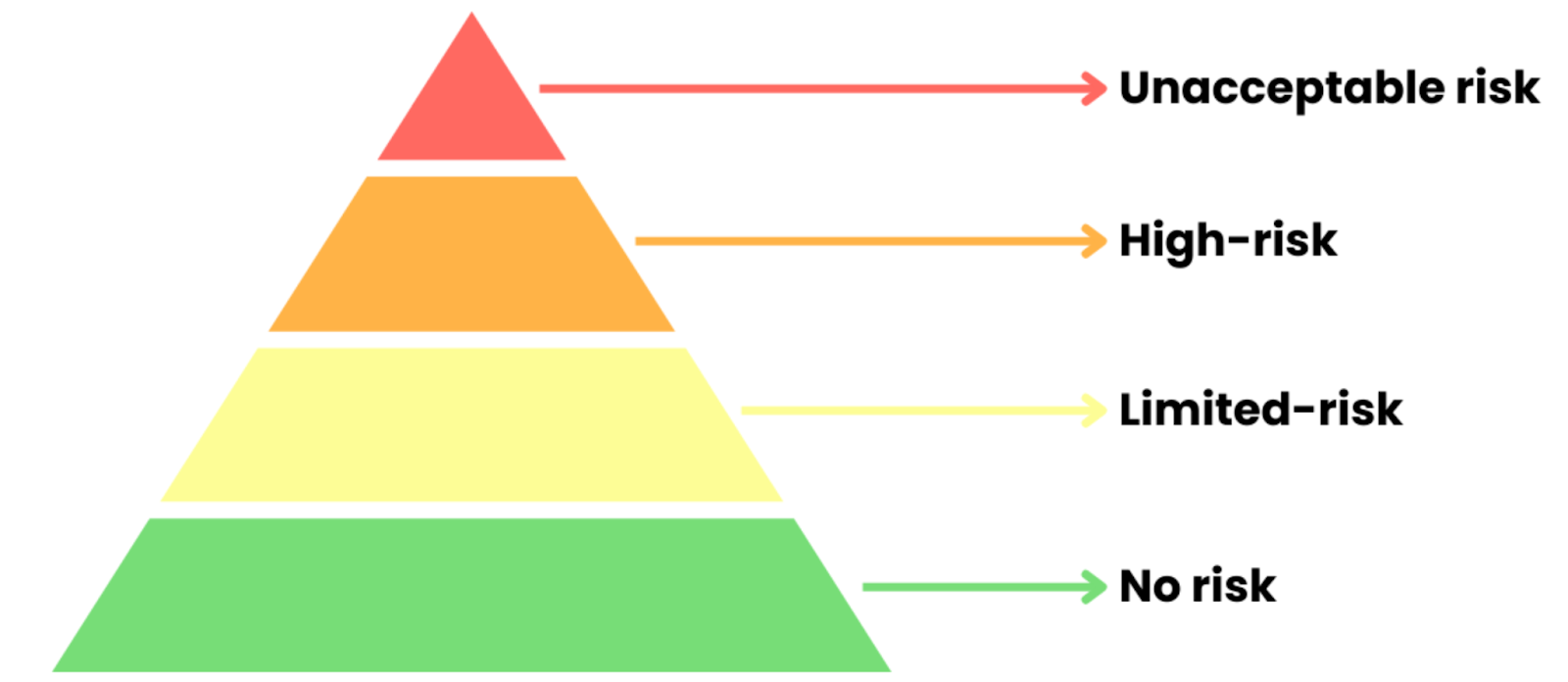

La loi européenne sur l'IA s'articule autour d'une approche réglementaire fondée sur le risque, qui classe les systèmes d'IA en fonction du niveau de risque qu'ils représentent pour les individus et la société. La loi répartit les systèmes d'IA en quatre catégories de risques distinctes :

Source : Cours DataCamp "Comprendre la loi européenne sur l'intelligence artificielle".

- Risque inacceptable : Les systèmes d'IA qui menacent la sécurité, les droits ou les valeurs démocratiques sont interdits (par exemple, la notation sociale, la manipulation nuisible).

- IA à haut risque: L'IA dans des domaines critiques tels que les soins de santé ou l'application de la loi. L'utilisation de ce produit nécessite des tests stricts, de la transparence et une surveillance humaine afin de répondre aux normes de l'UE.

- Risque limité AI: Inclut les chatbots et les assistants virtuels. Les utilisateurs doivent être informés lorsqu'ils interagissent avec l'IA, mais les réglementations sont moins nombreuses.

- Risque minimal AI: Applications à faible risque telles que les filtres anti-spam ou les jeux d'intelligence artificielle. Largement exempté de réglementation.

Assurez-vous de suivre nos Principes fondamentaux de la loi sur l'IA de l'UE pour maîtriser la loi européenne sur l'IA et les principes fondamentaux de l'IA. Dans ce cours, vous apprendrez à naviguer dans les réglementations et à favoriser la confiance avec l'IA responsable.

La loi européenne sur l'IA met fortement l'accent sur la transparence, en particulier pour les systèmes d'IA générative comme ChatGPT qui créent du contenu et s'engagent directement avec les utilisateurs. En fonction de leur utilisation, ces systèmes pourraient être classés comme étant à risque élevé ou à risque limité en vertu de la loi. L'une des principales exigences est que les utilisateurs soient clairement informés lorsqu'ils interagissent avec une IA. Pour les modèles génératifs, cela signifie :

- Divulgation de l'IA: Les développeurs doivent clairement indiquer quand le contenu est généré par l'IA. Cela permet aux utilisateurs de comprendre qu'ils communiquent avec une machine et non avec une personne.

- Explicabilité: Bien que les systèmes d'IA générative puissent être complexes, la loi européenne sur l'IA exige un certain niveau de clarté. Les fournisseurs de modèles d'IA doivent fournir suffisamment d'informations pour que les utilisateurs et les régulateurs puissent comprendre comment le système fonctionne et prend des décisions. Il s'agit notamment de partager des détails sur les algorithmes sous-jacents et les données d'entraînement, le cas échéant.

Pour faire respecter ces règles, l'UE met en place des organismes de surveillance au niveau national et européen afin de contrôler le respect des règles. Ces organismes peuvent contrôler les systèmes d'IA, enquêter sur les infractions et imposer des sanctions pouvant aller jusqu'à 30 millions d'euros ou 6 % du chiffre d'affaires mondial, le montant le plus élevé étant retenu.

Pour en savoir plus sur la loi européenne sur l'IA, suivez notre cours intitulé Comprendre la loi européenne sur l'IAqui vous permettra de comprendre les catégories de risques liés à l'IA et la conformité, avec des exemples d'IA biométrique, d'éducation et de modèles à usage général.

Réglementation de l'IA aux États-Unis

Les États-Unis adoptent une approche sectorielle plus souple en matière de réglementation de l'IA. Bien qu'il n'existe pas de loi fédérale globale sur l'IA, plusieurs lois existantes, propositions de loi et lignes directrices, tant au niveau fédéral qu'au niveau des États, façonnent la gouvernance des systèmes d'IA.

Lois et règlements fédéraux en vigueur

Voici les lois et règlements actuellement en vigueur aux États-Unis :

Loi sur la Commission fédérale du commerce (FTC)

La FTC dispose d'une large autorité pour protéger les consommateurs contre les pratiques déloyales ou trompeuses. Il s'agit notamment de réglementer les systèmes d'IA qui pourraient potentiellement conduire à des pratiques discriminatoires ou à des résultats trompeurs, en particulier dans le domaine de la publicité et de l'utilisation des données des consommateurs.

Lois sur les droits civils

Diverses lois sur les droits civils interdisent la discrimination en matière d'emploi, de logement et de prêt. Ces lois s'appliquent aux applications de l'IA susceptibles de perpétuer involontairement des préjugés, comme les algorithmes utilisés pour l'embauche ou l'évaluation de la solvabilité. Des agences telles que l'Equal Employment Opportunity Commission (EEOC) examinent de plus en plus attentivement les systèmes d'IA pour s'assurer qu'ils sont conformes à ces lois.

Loi sur la portabilité et la responsabilité en matière d'assurance maladie (HIPAA)

Dans le domaine de la santé, les applications d'IA doivent être conformes à la réglementation HIPAA relative à la confidentialité et à la sécurité des informations médicales. Il s'agit notamment de veiller à ce que toute IA utilisée dans le cadre des soins aux patients respecte la confidentialité et les droits des patients.

Proposition de législation fédérale

Il existe également une législation qui a été proposée et qui attend d'être validée :

Loi sur la responsabilité des algorithmes

Proposé en 2022, ce projet de loi vise à obliger les entreprises à évaluer l'impact des systèmes de prise de décision automatisée sur les consommateurs. Elle rend obligatoire l'audit des algorithmes utilisés dans les domaines à forts enjeux afin d'identifier et d'atténuer les biais.

Charte des droits de l'IA

Fin 2022, l'administration Biden a publié un projet de "Charte des droits de l'IA".Charte des droits de l'IAqui énonce les principes d'une utilisation responsable de l'IA, notamment l'équité, la transparence et le droit de faire appel des décisions automatisées.

Réglementation au niveau de l'État

Au niveau des États, plusieurs juridictions ont pris l'initiative de mettre en œuvre leurs propres réglementations en matière d'IA, souvent axées sur la confidentialité des données et l'atténuation des préjugés :

Loi californienne sur la protection de la vie privée des consommateurs (CCPA)

Cette législation historique donne aux consommateurs le droit de savoir comment leurs informations personnelles sont collectées, utilisées et partagées. Elle a un impact direct sur les systèmes d'IA qui utilisent des données personnelles, en exigeant la transparence et le consentement des consommateurs.

Loi sur les outils de décision automatisée en matière d'emploi de la ville de New York

Entrée en vigueur en 2023, cette loi impose aux entreprises qui utilisent des outils automatisés pour le recrutement de procéder à des audits annuels sur les préjugés afin d'évaluer l'impact de leurs systèmes d'IA sur différents groupes démographiques.

Réglementations sectorielles

Outre les réglementations fédérales et nationales, il existe également des réglementations spécifiques au secteur de l'IA :

Véhicules autonomes

Les États-Unis Le ministère des transports a publié des des lignes directrices pour les essais et le déploiement des véhicules autonomesqui mettent l'accent sur la sécurité et la responsabilité. Ces lignes directrices exigent des entreprises qu'elles démontrent que leurs technologies de conduite autonome répondent aux normes de sécurité avant de pouvoir être déployées sur les routes publiques.

Soins de santé

Les applications de l'IA dans le domaine de la santé, telles que les outils de diagnostic et les recommandations de traitement, font l'objet d'un examen minutieux de la part de la Food and Drug Administration (FDA), qui s'efforce d'établir des voies réglementaires pour les technologies de l'IA afin de s'assurer qu'elles sont sûres et efficaces.

L'approche de la Chine en matière de réglementation de l'IA

L'approche de la Chine en matière de gouvernance de l'IA est pilotée par l'État, équilibrant l'innovation rapide avec une réglementation stricte. Il s'agit de maintenir un contrôle gouvernemental fort tout en garantissant la sécurité et en promouvant une utilisation éthique.

Ce cadre comprend une série de politiques et de lignes directrices qui déterminent la manière dont l'IA est développée et utilisée. Les principales caractéristiques sont les suivantes :

Gouvernance centralisée

Le gouvernement chinois, par l'intermédiaire de différents ministères tels que le ministère de la science et de la technologie, joue un rôle crucial dans la réglementation de l'IA. Ce contrôle centralisé permet une application cohérente des réglementations dans les différents secteurs et régions.

Législation et lignes directrices

Des lois importantes telles que la Loi sur la sécurité des données et la loi sur la protection des informations personnelles fixent des normes claires pour le traitement des données dans les applications d'IA. En outre, les Lignes directrices éthiques de l'IA décrivent les principes auxquels les systèmes d'IA doivent adhérer, en mettant l'accent sur les droits de l'homme, la protection de la vie privée et la sécurité.

Priorité à la sécurité nationale

Le paysage réglementaire met fortement l'accent sur la sécurité nationale, les applications d'IA étant soumises à des évaluations rigoureuses pour s'assurer qu'elles ne menacent pas l'ordre public ou la sécurité de l'État. Cette surveillance est particulièrement importante pour les technologies qui pourraient avoir un impact sur la stabilité ou la gouvernance de la société.

Le modèle de gouvernance centralisée soulève des inquiétudes quant à la transparence et à la responsabilité, car un contrôle public limité pourrait permettre au gouvernement d'exercer un pouvoir incontrôlé dans le domaine de l'IA.

En 2023, la Chine a introduit le Règlement sur l'administration des services d'intelligence artificielle générativequi définit un cadre pour le développement, le déploiement et l'utilisation des technologies d'intelligence artificielle générative. Voici quelques-unes de ses principales caractéristiques :

- Contrôles de sécurité obligatoires : Les entreprises doivent obtenir l'approbation du gouvernement avant de lancer une IA génératrice de contenu, afin de s'assurer que les systèmes ne présentent pas de risques pour les intérêts nationaux ou la stabilité.

- Contrôle strict du contenu : Les résultats de l'IA générative sont étroitement réglementés afin d'éviter la désinformation ou les contenus qui perturbent l'harmonie sociale, en recourant à la censure si nécessaire.

- Des normes de conformité élevées : Les entreprises doivent être transparentes sur leurs algorithmes, leurs sources de données et leurs processus afin de respecter des réglementations strictes, de renforcer la responsabilité et de prévenir les abus.

Alors que l'IA transforme les industries, il est essentiel de comprendre ses risques éthiques et commerciaux. Les entreprises doivent non seulement exploiter le potentiel de l'IA, mais aussi veiller à ce qu'elle soit utilisée de manière responsable et transparente.

Dans notre webinaire, "Comprendre les réglementations relatives à l'IA aux États-Unis, dans l'UE et dans le monde entier Shalini Kurapati (CEO, Clearbox AI) et Nick Reiners (Senior Analyst, Eurasia Group) abordent les principales politiques en matière d'IA, les tendances réglementaires et les stratégies de conformité. Vous découvrirez l'impact des nouvelles réglementations sur les entreprises et obtiendrez des conseils pratiques pour naviguer dans la gouvernance de l'IA, en mettant l'accent sur les États-Unis, l'UE et les cadres mondiaux.

L'avenir de la réglementation de l'IA

Maintenant que nous comprenons le paysage actuel des réglementations relatives à l'IA, il est temps d'envisager l'avenir. Alors que ces outils continuent de se développer, nos lois et règlements doivent eux aussi évoluer en même temps.

La nécessité d'une coopération internationale et d'un cadre réglementaire mondial

L'IA est une technologie mondiale, et une réglementation efficace nécessite une coopération internationale. Les systèmes d'IA dépassent souvent les frontières, ce qui fait qu'il est difficile pour un seul pays de les réglementer de manière exhaustive.

Les applications de l'IA dans des domaines tels que les véhicules autonomes, les soins de santé, la finance et la sécurité impliquent souvent des flux de données transfrontaliers, ce qui soulève des préoccupations en matière de confidentialité, de protection des données et de normes éthiques. Ce caractère mondial nécessite une approche coordonnée de la gouvernance de l'IA. Les objectifs de la coopération internationale sont les suivants :

- Alignement standard : Établir des principes communs tels que la transparence, la responsabilité et l'équité afin de créer des lignes directrices mondiales cohérentes pour l'utilisation de l'IA.

- Confidentialité et protection des données : Établir des règles communes pour le partage transfrontalier des données afin de protéger la vie privée et de garantir des applications éthiques de l'IA tout en respectant les lois nationales.

- S'attaquer aux biais de l'IA : Collaborer à l'échelle mondiale pour partager les meilleures pratiques, détecter les préjugés et élaborer des stratégies pour des systèmes d'IA plus justes et des résultats équitables.

Consultez notre cours, Gestion responsable des données d'IAoù vous apprendrez les principes fondamentaux des pratiques responsables en matière de données, y compris l'acquisition de données, les principales réglementations, la validation des données et les stratégies d'atténuation des biais. Y

ous pouvez appliquer ces compétences à la réflexion critique dans le cadre de n'importe quel projet de données, afin de garantir la réussite, la responsabilité et la conformité du projet du début à la fin.

Les défis d'un cadre réglementaire mondial en matière d'IA

Malgré la nécessité d'une coopération internationale, la création d'un cadre mondial unifié pour la réglementation de l'IA se heurte à plusieurs difficultés :

- Des priorités nationales divergentes : Différents pays donnent la priorité à différents aspects de la réglementation de l'IA - par exemple, les États-Unis se concentrent sur l'innovation, l'UE sur la protection de la vie privée et la Chine sur le contrôle de l'État -, ce qui rend difficile une approche mondiale unifiée.

- Tensions géopolitiques : Les rivalités entre les principaux acteurs de l'IA, comme les États-Unis et la Chine, conduisent à des cadres concurrents et à des préoccupations concernant le transfert de technologie et la sécurité nationale, ce qui complique la coopération.

- Différences éthiques et culturelles : La diversité des points de vue sur la surveillance, la confidentialité des données et les droits de l'homme rend difficile l'élaboration de normes éthiques universelles pour la réglementation de l'IA.

Efforts en vue d'un cadre mondial pour l'IA

Malgré les difficultés, des efforts sont actuellement déployés pour promouvoir la coopération internationale en matière de gouvernance de l'IA :

Les Nations unies et AI for Good

Les Nations unies ont entamé des discussions sur la réglementation mondiale de l'IA dans le cadre de forums tels que AI for Goodqui réunit des experts, des décideurs politiques et des chefs d'entreprise pour étudier les avantages et les risques potentiels de l'IA. Ces discussions visent à définir des normes internationales pour le développement de l'IA, en particulier dans des domaines tels que la durabilité et les droits de l'homme.

Partenariats mondiaux sur l'IA (GPAI)

Lancement en 2020, GPAI est une initiative internationale qui promeut le développement responsable de l'IA par le biais de la coopération transfrontalière. Il comprend des pays leaders en matière d'IA tels que le Canada, la France, le Japon et l'Inde, entre autres, et vise à favoriser les meilleures pratiques, à partager les données et à encourager l'innovation tout en respectant des normes éthiques.

Sommet sur la sécurité de l'IA

Le Royaume-Uni a accueilli le premier sommet mondial sur la sécurité de l Sommet sur la sécurité de l'IA en novembre 2023. Elle a réuni des dirigeants mondiaux, des experts en technologie et des décideurs politiques afin de relever les défis cruciaux que pose le développement sûr et éthique de l'IA. L'événement a souligné l'importance de créer des cadres pour la sécurité de l'IA, en mettant l'accent sur l'alignement du développement de l'IA sur les normes mondiales de sécurité et d'éthique, tout en encourageant l'innovation.

En l'absence de pression publique en faveur de normes éthiques plus strictes et d'une plus grande transparence, les entreprises risquent de faire passer leurs profits avant la sécurité, et les gouvernements risquent d'éviter toute réglementation jusqu'à ce que le préjudice soit évident. Mais lorsque les citoyens demandent des comptes, cela pousse les législateurs à agir et à élaborer des politiques qui garantissent que l'IA profite à la société plutôt que de porter atteinte à la vie privée ou à l'équité.

Comme le dit Bruce Schneier dans notre épisode de DataFrame sur . La confiance et la régulation dans l'IA :

Rien ne changera si le gouvernement ne l'impose pas, et le gouvernement ne l'imposera pas si nous, le peuple, ne l'exigeons pas.

Bruce Schneier, Security Technologist

La nécessité d'améliorer les compétences et de les renouveler

La législation n'est pas la seule à devoir être mise à jour dans le sillage de l'IA ; le personnel doit également s'adapter. À mesure que l'automatisation et les systèmes intelligents prennent en charge les tâches routinières, de nouvelles compétences deviennent essentielles.

Comme nous le soulignons dans le Rapport sur l'état de la maîtrise des données et de l'IAcette transition met de plus en plus l'accent sur la nécessité de doter la main-d'œuvre d'une culture de l'IA, de compétences techniques et d'une maîtrise des données afin qu'elle puisse s'épanouir dans un paysage professionnel en constante évolution.

Avec 62 % des dirigeants estimant que la maîtrise de l'IA est désormais importante pour les tâches quotidiennes de leurs équipes, pour les organisations, le défi consiste non seulement à suivre l'évolution technologique, mais aussi à s'assurer que leurs équipes sont équipées pour tirer parti de ces outils de manière responsable et stratégique.

Cela nécessite une approche structurée de l'apprentissage, qui englobe les concepts de base de l'IA, les considérations éthiques et la formation technique avancée.

Les organisations qui investissent dans l'amélioration et la requalification des compétences sont mieux placées pour atténuer les déplacements d'emplois, favoriser l'innovation et rester compétitives. Des programmes d'apprentissage complets qui répondent à ces besoins peuvent combler le fossé, en préparant les équipes techniques et non techniques à comprendre, déployer et gérer efficacement les systèmes d'IA.

DataCamp for Business peut aider vos équipes à se perfectionner en IA, quelle que soit la taille de votre organisation. Avec des parcours d'apprentissage personnalisés, des rapports détaillés et une équipe dédiée à la réussite, vous pouvez atteindre vos objectifs en matière d'IA en un rien de temps.

Améliorez les compétences de votre équipe en matière d'IA

Transformez votre entreprise en dotant votre équipe de compétences avancées en matière d'IA grâce à DataCamp for Business. Améliorez vos connaissances et votre efficacité.

Conclusion

La réglementation de l'IA est essentielle pour s'assurer qu'elle profite à la société tout en gérant ses risques. L'IA évoluant très rapidement dans tous les secteurs, les réglementations existantes ne parviennent souvent pas à suivre.

À mesure que l'IA progresse dans des domaines tels que les modèles génératifs, la prise de décision autonome et l'apprentissage profond, les anciennes règles risquent de ne plus suffire. Le véritable défi consiste à créer des réglementations adaptables qui peuvent évoluer avec la technologie - en équilibrant l'innovation avec une surveillance responsable.

Si vous souhaitez approfondir votre connaissance de l'IA et de son impact, consultez nos Principes fondamentaux de l'IA pour approfondir vos connaissances et garder une longueur d'avance.

J'ai travaillé dans différents secteurs d'activité et j'ai porté plusieurs casquettes : développeur de logiciels, chercheur en apprentissage automatique, scientifique des données, chef de produit. Mais au fond, je suis un programmeur qui aime apprendre et partager ses connaissances !