Programa

A IA está mudando nosso mundo mais rápido do que nunca - desde os avanços na área da saúde até os carros autônomos, seu potencial para remodelar os setores é enorme. No entanto, esse poder traz riscos como preconceito, problemas de privacidade e deslocamento do emprego. Sem as proteções corretas, esses riscos podem levar a sérios problemas sociais, econômicos e éticos.

Os países estão lidando com a regulamentação da IA de maneiras muito diferentes. A UE está assumindo a liderança com leis detalhadas, como a Lei de IA da UE, que classifica a IA por risco. Os Estados Unidos são mais discretos, deixando o setor se autorregular. A China, por outro lado, está buscando uma rápida inovação em IA e, ao mesmo tempo, mantendo um controle estatal rigoroso, especialmente em áreas sensíveis como a vigilância.

Essas abordagens variadas mostram como é difícil regulamentar uma tecnologia que ultrapassa fronteiras e setores. Neste artigo, exploraremos por que a criação de regulamentações de IA eficazes e equilibradas é essencial para garantir que a IA beneficie a sociedade e, ao mesmo tempo, minimize os danos.

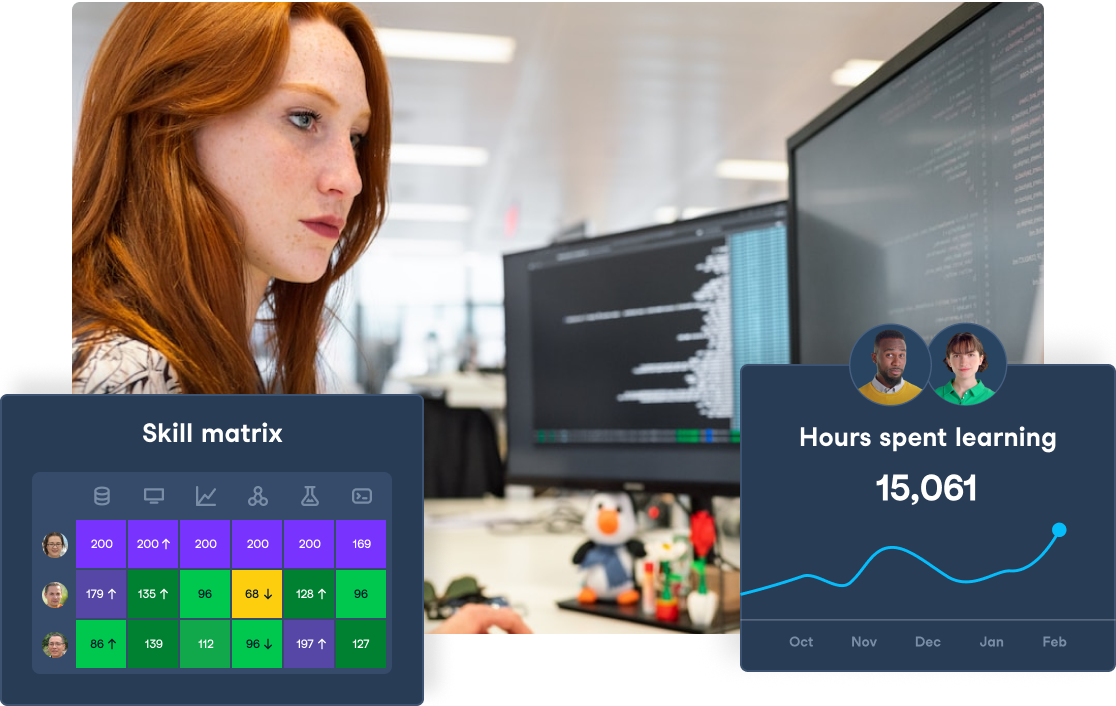

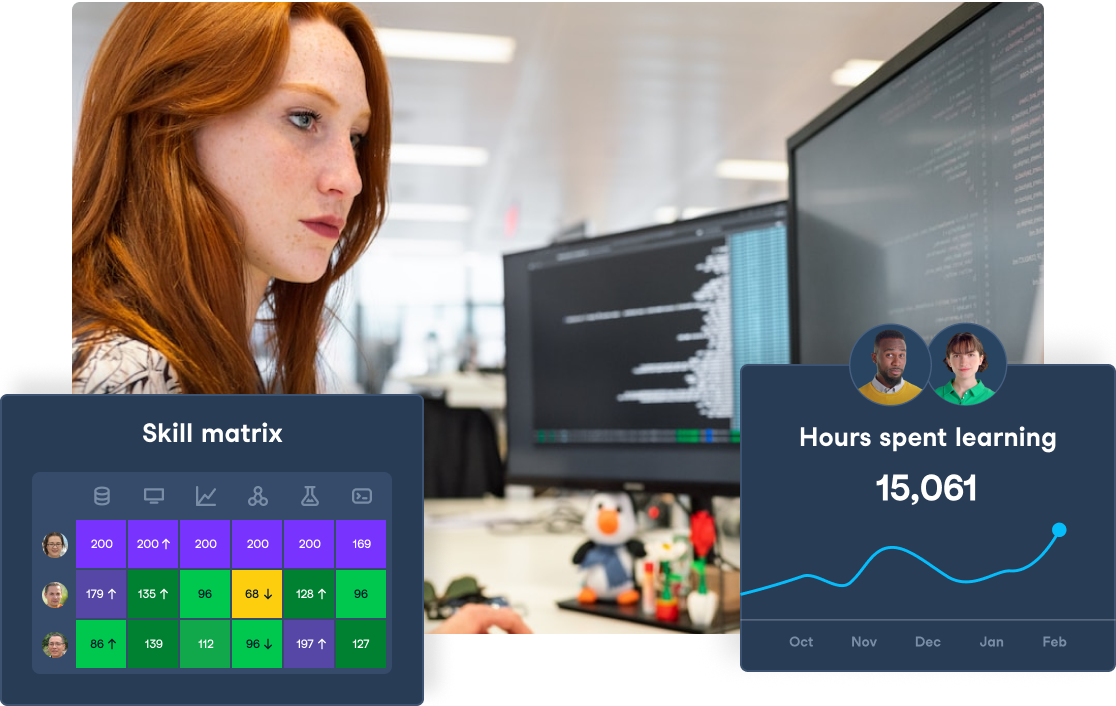

Prepare sua equipe para a Lei de IA da UE

Garanta a conformidade e promova a inovação equipando sua equipe com as habilidades de alfabetização em IA necessárias. Comece hoje mesmo a criar seu programa de treinamento em IA com o DataCamp for Business.

O que é regulamentação de IA?

A regulamentação de IA refere-se às leis, políticas e diretrizes criadas para supervisionar o desenvolvimento, a implantação e o uso de sistemas de IA. O objetivo da regulamentação da IA é garantir que as tecnologias de IA sejam usadas de forma ética, segura e responsável, minimizando os possíveis riscos, como preconceitos, violações de privacidade e danos a indivíduos ou à sociedade.

A ética da IA é o campo que estuda como desenvolver e usar a IA de forma justa, responsável, transparente e que respeite os valores humanos. Leia nosso site AI Ethics: An Introduction blog para você entender os riscos de curto e longo prazo da IA .

A regulamentação da IA abrange uma ampla gama de questões, incluindo:

- Privacidade dos dados: Garantir que os sistemas de IA manipulem dados pessoais em conformidade com as leis de privacidade.

- Preconceito e justiça: Evitar que a IA perpetue ou amplie a discriminação e os preconceitos.

- Transparência: Tornar os sistemas de IA explicáveis e compreensíveis, para que suas decisões sejam claras e responsáveis.

- Segurança: Garantir que as tecnologias de IA não causem danos, especialmente em setores críticos como saúde, finanças e sistemas autônomos.

- Prestação de contas: Estabelecer uma responsabilidade clara pelas decisões tomadas pelos sistemas de IA, incluindo estruturas legais para responsabilidade.

- Impactos econômicos, ambientais e sociais: Abordar o possível deslocamento de empregos e as desigualdades econômicas, ambientais e mudanças sociais resultantes da IA.

Acompanhe a trilha de Fundamentos de IA do Datacamp para você descobrir os fundamentos da IA, mergulhar em modelos como o ChatGPT e decodificar os segredos da IA generativa para navegar no cenário dinâmico da IA.

Por que a regulamentação da IA é necessária?

O potencial da IA vem acompanhado de riscos significativos, o que torna a regulamentação uma necessidade. Uma das preocupações mais urgentes é a possibilidade de resultados prejudiciais. Por exemplo, Os sistemas de IA usados na justiça criminal têm demonstrado parcialidade, afetando desproporcionalmente as comunidades marginalizadas. Se não for gerenciada adequadamente, a IA poderá exacerbar as desigualdades sociais existentes.

Além disso, o problema da "caixa preta" é um desafio exclusivo da IA. Muitos sistemas de IA operam de maneiras que nem mesmo seus criadores conseguem explicar completamente. Sem transparência, é difícil entender como esses sistemas tomam decisões, o que gera preocupações quanto à responsabilidade.

O preconceito é outro problema crítico. Os sistemas de IA são tão bons quanto os dados com os quais são treinados e, se esses dados refletirem preconceitos sociais, a IA também o fará. Isso pode levar a resultados injustos em áreas como contratação, empréstimos e aplicação da lei.

Em 2023, a Forbes informou sobre uma ação coletiva contra a UnitedHealthcare (o maior provedor de seguros de saúde dos EUA), alegando a negação indevida de pedidos de cuidados prolongados para pacientes idosos por meio do uso de um algoritmo de IA.

Sem uma estrutura regulatória, a sociedade pode não estar preparada para essas mudanças econômicas, levando à desigualdade e à instabilidade. Não deixe de conferir nosso artigo, AI in Healthcare: Enhancing Diagnostics, Personalizing Treatment, and Streamlining Operations; ele explora como a IA está influenciando o futuro do setor de saúde e como as empresas podem se manter à tona com novas habilidades e tecnologias de IA .

Por fim, a IA pode desestabilizar o mercado de trabalho, deslocando trabalhadores à medida que a automação se torna mais predominante. A McKinsey informa que os atuais Generativa e outras tecnologias de IA têm o potencial de automatizar as atividades de trabalho que hoje absorvem até 70% do tempo dos funcionários.

Essas mudanças significarão que até 12 milhões de trabalhadores na Europa e nos Estados Unidos precisarão mudar de emprego. Alguns trabalhadores podem precisar de apoio para requalificação e aprimoramento de habilidades para serem competitivos no novo mercado.

O estado atual da regulamentação da IA

Vamos dar uma olhada na legislação e nos regulamentos atuais para garantir o uso justo das ferramentas de IA:

A regulamentação de IA da União Europeia

A Lei de IA da União Europeia, proposta em abril de 2021, representa a primeira estrutura jurídica abrangente destinada a regulamentar a IA na União Europeia (UE). A Lei de IA da UE é uma iniciativa inovadora elaborada pelo Escritório de IA da UE para regulamentar o futuro da IA na Europa. Seu objetivo é mitigar os possíveis riscos apresentados pelos sistemas de IA e, ao mesmo tempo, promover a inovação e a competitividade no mercado europeu de IA.

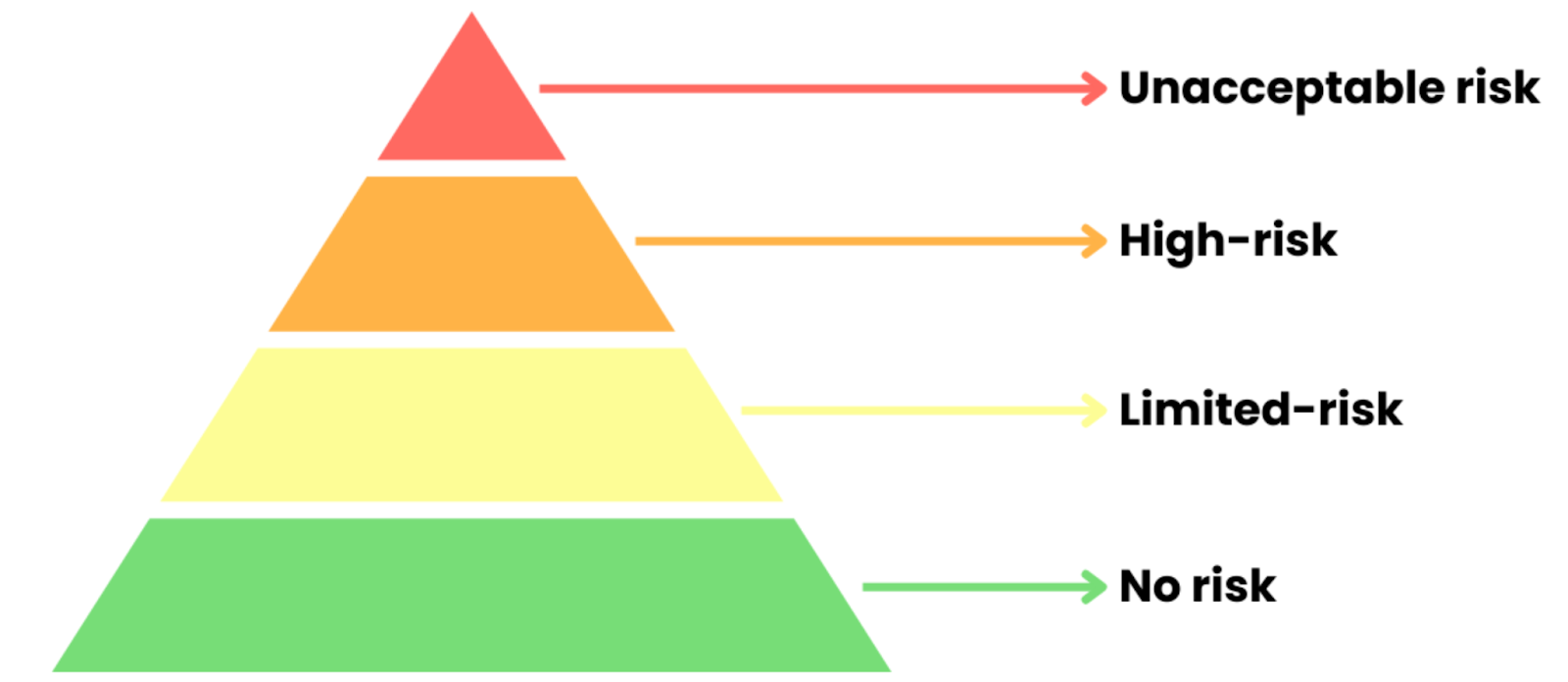

A Lei de IA da UE está estruturada em torno de uma abordagem de regulamentação baseada em riscos, que categoriza os sistemas de IA com base no nível de risco que eles representam para os indivíduos e a sociedade. A lei divide os sistemas de IA em quatro categorias de risco distintas:

Fonte: Curso Datacamp 'Entendendo a Lei de IA da UE'

- Risco inaceitável: Os sistemas de IA que ameaçam a segurança, os direitos ou os valores democráticos são proibidos (por exemplo, pontuação social, manipulação prejudicial).

- IA de alto risco: IA em áreas críticas, como saúde ou aplicação da lei. Requer testes rigorosos, transparência e supervisão humana para atender aos padrões da UE antes do uso.

- IA de risco limitado: Inclui chatbots e assistentes virtuais. Os usuários devem ser informados ao interagir com a IA, mas com menos regulamentações.

- IA de risco mínimo: Aplicativos de baixo risco, como filtros de spam ou IA para jogos. Em grande parte isento de regulamentação.

Certifique-se de seguir nossos Fundamentos da Lei de IA da UE para que você domine a Lei de IA da UE e os fundamentos da IA. No curso, você aprenderá a navegar pelas regulamentações e a promover a confiança com a IA responsável.

A Lei de IA da UE dá grande ênfase à transparência, especialmente para sistemas de IA generativa, como o ChatGPT, que criam conteúdo e se envolvem diretamente com os usuários. Dependendo de como são usados, esses sistemas podem ser classificados como de alto risco ou de risco limitado de acordo com a lei. Um requisito fundamental é que os usuários sejam claramente informados quando estiverem interagindo com uma IA. Para modelos generativos, isso significa:

- Divulgação da IA: Os desenvolvedores devem declarar claramente quando o conteúdo é gerado por IA. Isso ajuda os usuários a entender que estão se comunicando com uma máquina, não com uma pessoa.

- Explicabilidade: Embora os sistemas de IA generativa possam ser complexos, a Lei de IA da UE exige um certo nível de clareza. Aqueles que fornecem modelos de IA precisam fornecer informações suficientes para que os usuários e os reguladores possam entender como o sistema funciona e toma decisões. Isso inclui o compartilhamento de detalhes sobre os algoritmos subjacentes e os dados de treinamento, quando necessário.

Para fazer cumprir essas regras, a UE está criando órgãos de supervisão em nível nacional e da UE para monitorar a conformidade. Esses órgãos podem auditar sistemas de IA, investigar violações e impor penalidades de até 30 milhões de euros ou 6% da receita global, o que for maior.

Para saber mais sobre a Lei de IA da UE, não deixe de acompanhar nosso Curso sobre a Lei de IA da UEno qual você entenderá as categorias de risco e a conformidade da IA, com exemplos de IA biométrica, educação e modelos de uso geral.

Regulamentação de IA nos Estados Unidos

Os Estados Unidos adotam uma abordagem mais flexível e setorial para a regulamentação da IA. Embora não exista uma lei federal abrangente sobre IA, várias leis existentes, projetos de lei propostos e diretrizes nos níveis federal e estadual estão moldando a governança dos sistemas de IA.

Leis e regulamentos federais existentes

Aqui estão as leis e os regulamentos que estão atualmente em vigor nos EUA:

Lei da Comissão Federal de Comércio (FTC)

A FTC tem ampla autoridade para proteger os consumidores contra práticas desleais ou enganosas. Isso inclui a regulamentação de sistemas de IA que poderiam levar a práticas discriminatórias ou resultados enganosos, especialmente em publicidade e uso de dados do consumidor.

Leis de direitos civis

Várias leis de direitos civis proíbem a discriminação no emprego, na moradia e em empréstimos. Essas leis são relevantes para aplicativos de IA que podem inadvertidamente perpetuar preconceitos, como algoritmos usados para contratação ou pontuação de crédito. Órgãos como a Comissão de Oportunidades Iguais de Emprego (EEOC) estão examinando cada vez mais os sistemas de IA para verificar a conformidade com essas leis.

Lei de Portabilidade e Responsabilidade de Seguros de Saúde (HIPAA)

No setor de saúde, os aplicativos de IA devem estar em conformidade com os regulamentos da HIPAA relativos à privacidade e à segurança das informações de saúde. Isso inclui garantir que qualquer IA usada no atendimento ao paciente respeite a confidencialidade e os direitos do paciente.

Legislação federal proposta

Há também uma legislação que foi proposta e está aguardando validação:

Lei de Responsabilidade Algorítmica

Proposta em 2022, esse projeto de lei busca exigir que as empresas avaliem o impacto dos sistemas automatizados de tomada de decisão sobre os consumidores. Ela exige auditorias de algoritmos usados em áreas de alto risco para identificar e atenuar a parcialidade.

Declaração de direitos de IA

No final de 2022, o governo Biden divulgou um projeto para uma 'Declaração de direitos de IA', delineando princípios para o uso responsável da IA, incluindo justiça, transparência e o direito de recorrer de decisões automatizadas.

Regulamentações em nível estadual

Em nível estadual, várias jurisdições tomaram a iniciativa de implementar suas próprias regulamentações de IA, geralmente com foco em privacidade de dados e mitigação de preconceitos:

Lei de Privacidade do Consumidor da Califórnia (CCPA)

Essa legislação histórica dá aos consumidores o direito de saber como suas informações pessoais são coletadas, usadas e compartilhadas. Ela afeta diretamente os sistemas de IA que utilizam dados pessoais, exigindo transparência e consentimento do consumidor.

Lei de ferramentas automatizadas de decisão de emprego da cidade de Nova York

Em vigor em 2023, essa lei determina que as empresas que usam ferramentas automatizadas para contratação devem realizar auditorias anuais de preconceito para avaliar o impacto de seus sistemas de IA em diferentes grupos demográficos.

Regulamentações específicas do setor

Além das regulamentações federais e estaduais, há também algumas regulamentações de IA específicas do setor em vigor:

Veículos autônomos

Os EUA O Departamento de Transportes emitiu diretrizes para o teste e a implantação de veículos autônomosenfatizando a segurança e a responsabilidade. Essas diretrizes exigem que as empresas demonstrem que suas tecnologias de direção autônoma atendem aos padrões de segurança antes de poderem ser implantadas em vias públicas.

Cuidados com a saúde

As aplicações de IA na área da saúde, como ferramentas de diagnóstico e recomendações de tratamento, estão sujeitas ao escrutínio da Food and Drug Administration (FDA), que está trabalhando para estabelecer caminhos regulatórios para as tecnologias de IA a fim de garantir que sejam seguras e eficazes.

Abordagem da China para a regulamentação da IA

A abordagem da China para a governança de IA é liderada pelo Estado, equilibrando a inovação rápida com uma regulamentação rígida. Trata-se de manter um forte controle governamental e, ao mesmo tempo, garantir a segurança e promover o uso ético.

A estrutura inclui uma série de políticas e diretrizes que definem como a IA é desenvolvida e usada. Os principais recursos incluem:

Governança centralizada

O governo chinês, por meio de vários ministérios, como o Ministério da Ciência e Tecnologia, desempenha um papel fundamental na regulamentação da IA. Esse controle centralizado permite a aplicação consistente de regulamentações em diferentes setores e regiões.

Legislação e diretrizes

Leis importantes, como a Lei de Segurança de Dados e a Lei de Proteção de Informações Pessoais definem padrões claros para o tratamento de dados em aplicativos de IA. Além disso, as Diretrizes Éticas de IA descrevem os princípios aos quais os sistemas de IA devem aderir, enfatizando os direitos humanos, a privacidade e a segurança.

Foco na segurança nacional

O cenário regulatório enfatiza fortemente a segurança nacional, com aplicativos de IA sujeitos a avaliações rigorosas para garantir que não ameacem a ordem pública ou a segurança do Estado. Essa supervisão é particularmente relevante para as tecnologias que podem afetar a estabilidade ou a governança da sociedade.

O modelo de governança centralizada levanta preocupações quanto à transparência e à responsabilidade, com o escrutínio público limitado, o que pode permitir um poder governamental sem controle no espaço da IA.

Em 2023, a China introduziu as Regulamentações sobre a Administração de Serviços de Inteligência Artificial Generativaque estabelecem uma estrutura para o desenvolvimento, a implantação e o uso de tecnologias de IA generativas. Alguns de seus recursos de destaque são:

- Verificações de segurança obrigatórias: As empresas precisam da aprovação do governo antes de lançar a IA geradora de conteúdo, garantindo que os sistemas não representem riscos aos interesses nacionais ou à estabilidade.

- Monitoramento rigoroso do conteúdo: Os resultados da IA geradora são rigorosamente regulamentados para evitar desinformação ou conteúdo que perturbe a harmonia social, usando censura quando necessário.

- Altos padrões de conformidade: As empresas precisam ser transparentes em relação a seus algoritmos, fontes de dados e processos para atender a regulamentações rigorosas, aumentando a responsabilidade e evitando o uso indevido.

À medida que a IA transforma os setores, é fundamental entender seus riscos éticos e comerciais. As empresas devem não apenas aproveitar o potencial da IA, mas também garantir que ela seja usada de forma responsável e transparente.

Em nosso webinar, "Entendendo as regulamentações para IA nos EUA, na UE e em todo o mundo", Shalini Kurapati (CEO, Clearbox AI) e Nick Reiners (analista sênior, Eurasia Group) abordam as principais políticas de IA, tendências regulatórias e estratégias de conformidade. Você saberá como as novas regulamentações afetam as empresas e obterá dicas práticas para navegar na governança de IA, com foco nos EUA, na UE e em estruturas globais.

O futuro da regulamentação da IA

Agora que entendemos o cenário atual das regulamentações relacionadas à IA, é hora de ver o que está por vir. Como essas ferramentas continuam a se desenvolver, nossas leis e regulamentações também precisam evoluir ao mesmo tempo.

A necessidade de cooperação internacional e de uma estrutura regulatória global

A IA é uma tecnologia global, e uma regulamentação eficaz exige cooperação internacional. Os sistemas de IA frequentemente cruzam fronteiras, o que dificulta a regulamentação abrangente por parte de um único país.

Os aplicativos de IA em áreas como veículos autônomos, saúde, finanças e segurança geralmente envolvem fluxos de dados internacionais, o que gera preocupações sobre privacidade, proteção de dados e padrões éticos. Essa natureza global exige uma abordagem coordenada para a governança da IA. Os objetivos da cooperação internacional são:

- Alinhamento padrão: Estabelecer princípios compartilhados como transparência, responsabilidade e justiça para criar diretrizes globais consistentes para o uso da IA.

- Privacidade e proteção de dados: Defina regras comuns para o compartilhamento de dados entre fronteiras para proteger a privacidade e garantir aplicativos de IA éticos, respeitando as leis nacionais.

- Combatendo o viés da IA: Colaborar globalmente para compartilhar práticas recomendadas, detectar preconceitos e desenvolver estratégias para sistemas de IA mais justos e resultados equitativos.

Confira nosso curso, Gerenciamento responsável de dados de IAonde você pode aprender os fundamentos das práticas de dados responsáveis, incluindo aquisição de dados, principais regulamentações e validação de dados e estratégias de mitigação de viés. Y

Você pode aplicar essas habilidades para usar o pensamento crítico em qualquer projeto de dados, garantindo que você tenha um projeto bem-sucedido, responsável e em conformidade do início ao fim.

Desafios para uma estrutura regulatória global de IA

Apesar da necessidade de cooperação internacional, a criação de uma estrutura global unificada para a regulamentação da IA enfrenta vários desafios:

- Prioridades nacionais divergentes: Diferentes países priorizam diferentes aspectos da regulamentação da IA - por exemplo, os EUA se concentram na inovação, a UE na privacidade e a China no controle estatal - dificultando uma abordagem global unificada.

- Tensões geopolíticas: As rivalidades entre os principais participantes da IA, como os EUA e a China, levam a estruturas concorrentes e preocupações com a transferência de tecnologia e a segurança nacional, complicando a cooperação.

- Diferenças éticas e culturais: Visões variadas sobre vigilância, privacidade de dados e direitos humanos tornam desafiadora a criação de padrões éticos universais para a regulamentação da IA.

Esforços em direção a uma estrutura global de IA

Apesar dos desafios, há esforços contínuos para promover a cooperação internacional na governança da IA:

Nações Unidas e AI for Good

As Nações Unidas iniciaram discussões sobre a regulamentação global da IA por meio de fóruns como AI for Goodque reúne especialistas, formuladores de políticas e líderes do setor para explorar os possíveis benefícios e riscos da IA. Essas discussões têm o objetivo de moldar as normas internacionais para o desenvolvimento da IA, especialmente em áreas como sustentabilidade e direitos humanos.

Parcerias globais em IA (GPAI)

Lançado em 2020, GPAI é uma iniciativa internacional que promove o desenvolvimento responsável da IA por meio da cooperação transfronteiriça. Ele inclui países líderes em IA, como Canadá, França, Japão e Índia, entre outros, com o objetivo de promover práticas recomendadas, compartilhar dados e incentivar a inovação, ao mesmo tempo em que mantém padrões éticos.

Cúpula de Segurança de IA

O Reino Unido sediou a primeira Cúpula de Segurança de IA em novembro de 2023. Ele reuniu líderes globais, especialistas em tecnologia e formuladores de políticas para abordar os desafios críticos de garantir o desenvolvimento seguro e ético da IA. O evento ressaltou a importância da criação de estruturas para a segurança da IA, com foco especial no alinhamento do desenvolvimento da IA com os padrões globais de segurança e ética, ao mesmo tempo em que promove a inovação.

Sem a pressão pública por padrões éticos e transparência mais fortes, as empresas podem colocar os lucros acima da segurança, e os governos podem evitar a regulamentação até que o dano seja evidente. Porém, quando as pessoas exigem responsabilidade, isso pressiona os legisladores a agir e criar políticas que garantam que a IA beneficie a sociedade em vez de prejudicar a privacidade ou a justiça.

Como diz Bruce Schneier em nosso episódio do DataFramed sobre Confiança e regulamentação em IA:

Nada mudará a menos que o governo force, e o governo não forçará a menos que nós, o povo, exijamos.

Bruce Schneier, Security Technologist

A necessidade de aprimoramento e requalificação

Não é apenas a legislação que precisa ser atualizada na esteira da IA; a força de trabalho também deve se adaptar. À medida que a automação e os sistemas inteligentes assumem as tarefas de rotina, novos conjuntos de habilidades estão se tornando essenciais.

Como destacamos no Relatório sobre o estado da alfabetização em dados e IAessa transição coloca uma ênfase cada vez maior em equipar a força de trabalho com alfabetização em IA, proficiência técnica e fluência em dados para prosperar no cenário de trabalho em evolução.

Com 62% dos líderes acreditando que a alfabetização em IA agora é importante para as tarefas diárias de suas equipes, para as organizações, o desafio não é apenas acompanhar as mudanças tecnológicas, mas também garantir que suas equipes estejam equipadas para aproveitar essas ferramentas de forma responsável e estratégica.

Isso requer uma abordagem estruturada para o aprendizado, que abranja conceitos básicos de IA, considerações éticas e treinamento técnico avançado.

Organizações que investem em aprimoramento e requalificação estão mais bem posicionadas para reduzir o deslocamento de empregos, promover a inovação e permanecer competitivas. Programas abrangentes de aprendizagem que atendam a essas necessidades podem preencher a lacuna, preparando equipes técnicas e não técnicas para entender, implantar e administrar sistemas de IA de forma eficaz.

DataCamp para empresas pode ajudar suas equipes a melhorar suas habilidades em IA, independentemente da escala da sua organização. Com caminhos de aprendizagem personalizados, relatórios detalhados e uma equipe de sucesso dedicada, você pode atingir suas metas de IA em pouco tempo.

Melhore as habilidades de IA da sua equipe

Transforme seus negócios capacitando sua equipe com habilidades avançadas de IA por meio do DataCamp for Business. Obtenha melhores insights e eficiência.

Conclusão

A regulamentação da IA é fundamental para garantir que ela beneficie a sociedade e, ao mesmo tempo, gerencie seus riscos. Com a IA evoluindo tão rapidamente em todos os setores, as regulamentações existentes muitas vezes não conseguem acompanhar.

À medida que a IA avança em áreas como modelos generativos, tomada de decisão autônoma e aprendizagem profunda, as regras antigas podem não ser mais suficientes. O verdadeiro desafio é criar regulamentações adaptáveis que possam evoluir com a tecnologia, equilibrando a inovação com a supervisão responsável.

Se você deseja obter uma compreensão mais profunda da IA e de seu impacto, confira nossos Fundamentos de IA para que você desenvolva seu conhecimento e fique à frente da curva.

Eu uso vários chapéus: Desenvolvedor de software, programador, cientista de dados, desenvolvedor de business intelligence, proprietário de produto