Curso

La IA está evolucionando tan rápidamente que mantenerse al día con sus retosde seguridad es como intentar reparar un avión mientras está en el aire. A medida que los sistemas se vuelven más inteligentes y se integran más profundamente en los procesos empresariales cotidianos, también se vuelven más vulnerables a nuevos tipos de amenazas.

Lo he visto de cerca en mi trabajo. En numerosas ocasiones he detectado fallos de seguridad en procesos empresariales que podrían haber permitido a alguien acceder a información confidencial a la que no debería haber tenido acceso, especialmente cuando las soluciones de IA se implementaban de forma precipitada sin contar con las medidas de seguridad adecuadas.

De eso trata este artículo: comprender los riesgos, los retos y las mejores prácticas para mantener la seguridad de la IA. La IA está creciendo muy rápido y, si no nos adelantamos a las vulnerabilidades, corremos el riesgo de perder la confianza y los beneficios que aporta.

Si deseas obtener más información sobre este tema, te recomiendo que consultes la sección curso de Seguridad y gestión de riesgos de la IA .

Nuevos retos de seguridad para la IA

La IA funciona con datos. Y cuantos más datos utilice tu IA, mayor será el objetivo. Los hackers lo saben. Imagina un hospital que utiliza la inteligencia artificial para predecir los riesgos para la salud de los pacientes. Suena genial, hasta que alguien piratea el sistema. De repente, los historiales médicos privados están a la venta en la web oscura o, lo que es peor, los datos médicos se alteran, lo que puede dar lugar a decisiones perjudiciales. Cifrar los datos confidenciales y realizar copias de seguridad es fundamental, pero muchas empresas están tan centradas en la innovación que pasan por alto estos aspectos básicos.

Y, por cierto, los hackers no solo roban datos. Pueden alterar los modelos de IA por vos mismos. Por ejemplo, un coche autónomo al que se le hace creer que una señal de stop es una señal de límite de velocidad. Este tipo de ataque se denomina ataque de envenenamiento de datos, en el que los piratas informáticos introducen datos erróneos en el sistema para corromper su toma de decisiones. Analizaremos esto con más detalle en la siguiente sección.

Los ataques de inyección rápida son otro tipo de ataque. Se trata de manipulaciones sutiles que engañan a una IA para que diga o haga algo que no debería. Tenemos un artículo fantástico sobre inyección de comandos, por lo que no entraremos en muchos detalles en este artículo, pero sin duda merece la pena leerlo.

Irónicamente, los hackers también están utilizando la IA para hackear. Aquí es donde la ciberseguridad se convierte en una carrera contra el tiempo: los piratas informáticos innovan y los equipos de seguridad tienen que responder con la misma rapidez. Herramientas como la detección de anomalías pueden ayudar, pero no son infalibles.

¿Alguna vez has oído el dicho «una cadena es tan fuerte como su eslabón más débil»? Esto se aplica totalmente a la IA. Las empresas suelen integrar herramientas de IA preconfiguradas en sus sistemas. Pero, ¿qué pasa si una de esas herramientas se ve comprometida? Imagina que un chatbot muy popular utilizado por cientos de empresas es pirateado. Son cientos de empresas, y todos los datos de sus clientes, los que están en peligro. Es un efecto dominó digital.

Por último, está la brecha de conocimientos especializados. La adopción de la IA está aumentando, pero la ciberseguridad para la IA todavía está tratando de ponerse al día.

Amenazas a la seguridad de la IA

Los sistemas de IA se enfrentan a graves amenazas de seguridad que pueden comprometer su buen funcionamiento y fiabilidad. Veamos cuáles son las principales amenazas.

Ataques adversarios

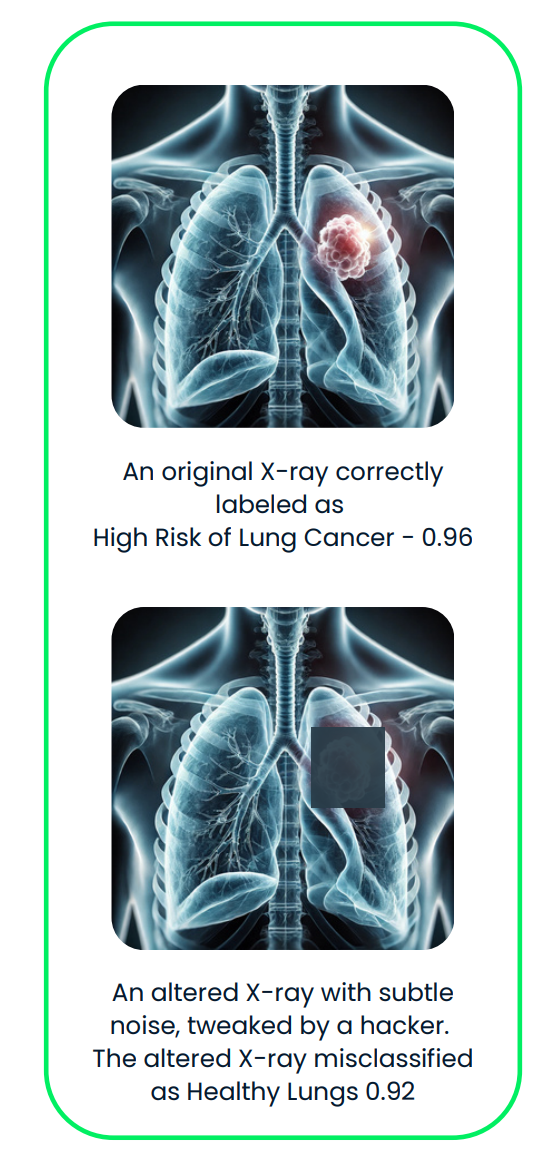

Los ataques adversarios engañan a los sistemas de IA realizando pequeños y sutiles cambios en los datos que procesan. Estos cambios son tan sutiles que los seres humanos normalmente no los notan, pero pueden confundir por completo a la IA y hacer que tome una decisión equivocada.

Por ejemplo:

- Cambiar pequeños detalles en una imagen, como alterar solo unos pocos píxeles, para que la IA la identifique erróneamente.

- Añadir un ligero ruido a un archivo de audio, haciendo que suene igual para nosotros, pero provocando que la IA lo malinterprete.

- Modificar la redacción de una frase para confundir la comprensión de la IA.

Estos ataques no requieren que el atacante conozca el funcionamiento interno de la IA, lo que constituye otra razón por la que resultan muy difíciles de detectar y detener.

Veamos ahora algunos ejemplos reales.

- Algoritmo DeepFool: DeepFool es un método diseñado para realizar cambios minúsculos, casi invisibles, en una entrada, como una imagen, con el fin de engañar a la IA para que la clasifique erróneamente. Funciona ajustando gradualmente la entrada hasta que la IA se equivoca. Estos cambios son tan pequeños que los seres humanos ni siquiera los notarían.

- Ataques acústicos selectivos: En este artículo, los atacantes crearon un audio que suena casi idéntico al original, pero que hace que un sistema de reconocimiento de voz escuche palabras completamente diferentes. Este método se utilizó para engañar al sistema DeepSpeech de Mozilla con una tasa de éxito del 100 %.

- Manipulación del piloto automático de Tesla: Keen Labs engañó al sistema de piloto automático de Tesla colocando estratégicamente tres pegatinas discretas en la carretera, lo que provocó que interpretara erróneamente las marcas de los carriles y pudiera desviarse hacia el carril equivocado. Lee más aquí.

Este diagrama ilustra un ataque adversario contra un sistema de IA para imágenes médicas. La radiografía original, clasificada correctamente como «alto riesgo de cáncer de pulmón», se altera sutilmente con ruido adversario, lo que da lugar a una clasificación errónea de «pulmones sanos».

Una lectura muy interesante es Adversarial Machine Learning, un campo que estudia los ataques que explotan las vulnerabilidades de los modelos de machine learning y desarrolla defensas para protegerte contra estas amenazas.

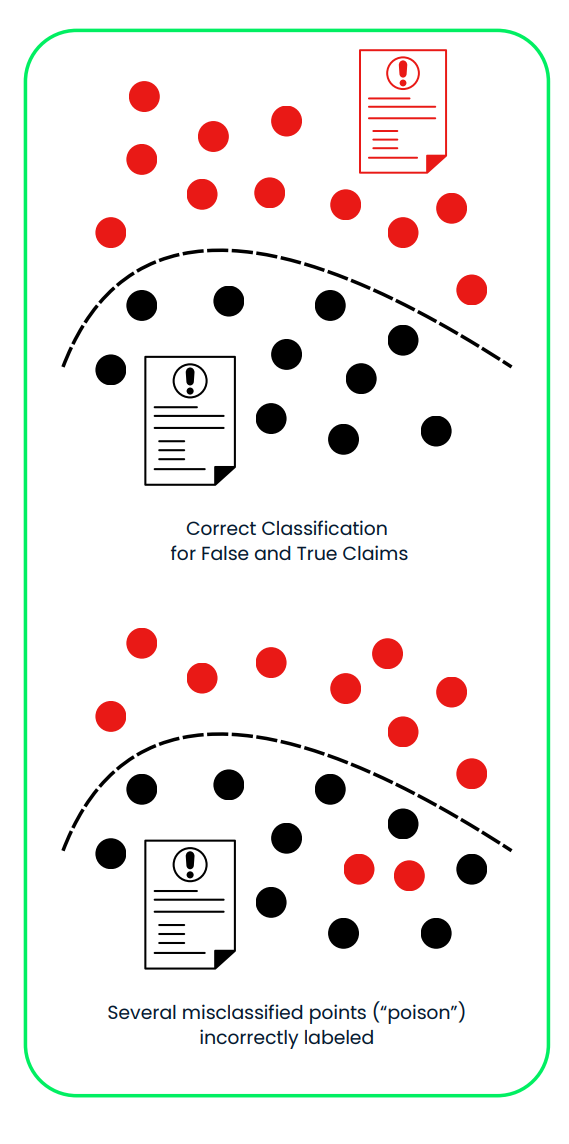

Ataques con veneno

Los ataques de envenenamiento se dirigen a la fase de entrenamiento de los sistemas de IA, en la que el modelo aprende a tomar decisiones. Los atacantes introducen datos corruptos o engañosos en el conjunto de entrenamiento para manipular la IA y que esta se comporte de forma incorrecta o favorezca resultados sesgados. Estos ataques funcionan porque alteran los cimientos del proceso de aprendizaje de la IA, a menudo sin dejar señales evidentes de que algo va mal.

Esto puede implicar:

- Cambiar las etiquetas de ciertos ejemplos de entrenamiento, como etiquetar una imagen de un perro como un gato, por ejemplo.

- Añadir puntos de datos falsos diseñados para influir en las decisiones de la IA de maneras específicas.

Estos sutiles cambios pueden provocar que la IA falle en determinadas condiciones o actúe de forma que beneficie al atacante. Dado que el ataque se produce durante el entrenamiento, es difícil detectarlo una vez que se implementa el modelo.

Veamos algunos ejemplos reales:

- Ataques por la puerta trasera: Un estudio titulado« » (Eludir los algoritmos de detección de puertas traseras en el aprendizaje profundo» (Eludir los algoritmos de detección de puertas traseras en el aprendizaje profundo) mostró cómo los atacantes pueden ocultar «puertas traseras» maliciosas en los modelos de IA. Estas puertas traseras solo se activan en condiciones específicas, como mostrar un patrón determinado en una imagen. El estudio demostró que los atacantes pueden utilizar técnicas avanzadas para hacer que los datos infectados parezcan idénticos a los datos limpios, evadiendo así su detección.

- Contaminación de conjuntos de datos a escala web: En el artículo« » (El envenenamiento de conjuntos de datos de entrenamiento a escala web es práctico», los investigadores describieron cómo se pueden contaminar los grandes conjuntos de datos recopilados en Internet:

- Envenenamiento de datos con vista dividida: Corromper los datos después de recopilarlos, pero antes de utilizarlos para el entrenamiento.

- Contaminación de datos por adelantado: Manipular los datos justo antes de añadirlos al conjunto de datos.

- El chatbot Tay de Microsoft: En 2016, Microsoft lanzó un chatbot llamado Tay en Twitter. Los usuarios manipularon rápidamente a Tay bombardeándola con contenido ofensivo, lo que provocó que publicara tuits racistas e inapropiados. Microsoft tuvo que cerrar Tay poco después de su lanzamiento. Lee más aquí.

Este diagrama muestra un ataque de envenenamiento a un sistema de IA utilizado para clasificar reclamaciones de seguros falsas y verdaderas. En el primer panel, el sistema separa correctamente las afirmaciones falsas (rojas) y verdaderas (negras) utilizando un conjunto de datos de entrenamiento limpio. En el segundo panel, los datos maliciosamente etiquetados de forma errónea («veneno») alteran el límite de decisión, lo que lleva a una clasificación errónea de las afirmaciones falsas como verdaderas, comprometiendo la fiabilidad y la seguridad del sistema.

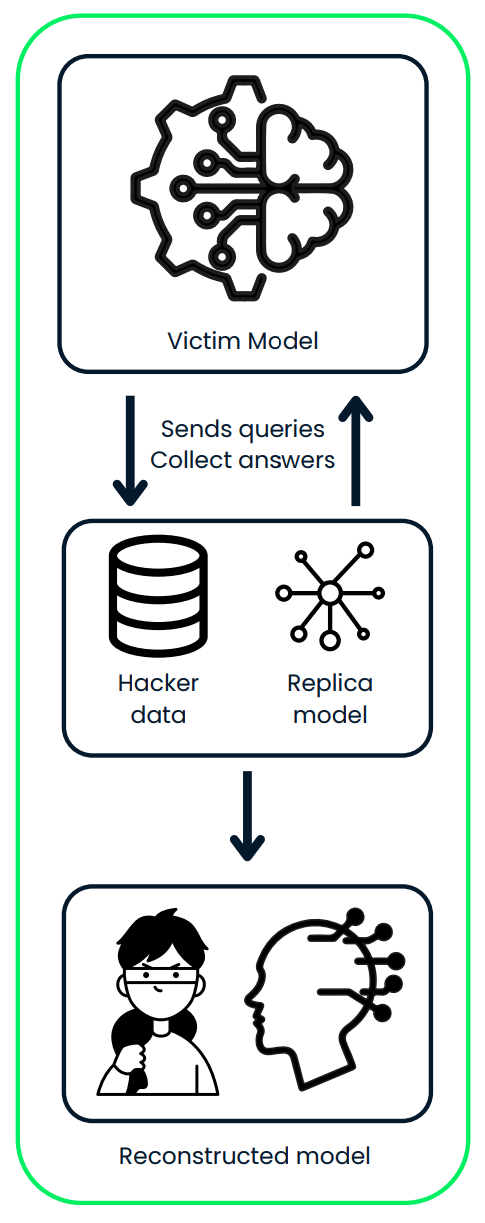

Ataques de extracción de modelos

En un ataque de extracción de modelos, un atacante descubre cómo funciona un modelo de IA mediante ingeniería inversa. Utilizan las entradas y salidas que recopilan para copiar el diseño y el comportamiento del sistema.

Una vez que hayas construido una réplica del modelo, podrás:

- Úsalo para hacer predicciones, que pueden incluir datos confidenciales o privados.

- Robar información confidencial del modelo original.

- Modifican y reentrenan el modelo para adaptarlo a sus propias necesidades, a menudo con fines perjudiciales.

Por ejemplo, si el modelo robado se entrenó con datos privados de clientes, el atacante podría predecir datos personales sobre esos clientes o crear una versión personalizada del modelo para su propio uso.

Veamos algunos ejemplos reales:

- Una herramienta llamada DeepSniffer muestra cómo puede funcionar este tipo de ataque. DeepSniffer no necesita saber nada sobre el modelo original por adelantado. En su lugar, recopila pistas sobre cómo el modelo procesa los datos, como el programa de las operaciones de memoria durante su tiempo de ejecución. Reúne estas pistas para poder averiguar la estructura del modelo, incluso si el sistema intenta optimizar u ocultar sus procesos.

- Mindgard demostró cómo se pueden extraer los componentes críticos de un modelo de lenguaje de caja negra, como chatGPT 3.5 Turbo de OpenAI, mediante un proceso de bajo coste. Con solo 50 dólares en gastos de API, el equipo creó con éxito un modelo más pequeño, aproximadamente 100 veces más pequeño que el original, que superó a chatGPT en una tarea específica. Este modelo extraído se utilizó posteriormente para mejorar otro ataque, que se desplegó posteriormente contra el propio chatGPT. El ataque mejorado logró una mayor tasa de éxito, aumentando hasta el 11 %.

Este diagrama ilustra un ataque de extracción de modelos, en el que un atacante interactúa con el modelo de IA de la víctima enviando consultas y recopilando sus predicciones. El atacante utiliza los datos recopilados para entrenar un modelo réplica, reconstruyendo finalmente una versión robada del sistema original.

Defensas de seguridad con IA

En secciones anteriores hemos mencionado que, a medida que la IA se vuelve más común, es importante implementar medidas de seguridad sólidas para protegerte contra los ataques. Hablemos de algunas formas eficaces de hacer que la IA sea más segura.

Entrenamiento adversarial

Este método consiste en enseñar a los modelos a reconocer y manejar entradas difíciles y manipuladas (denominadas ejemplos adversarios). Cuando entrenas tu modelo con estos ejemplos, este mejora su capacidad para resistir ciertos tipos de ataques.

- Cómo funciona: Crea ejemplos de datos manipulados e inclúyelos en el entrenamiento de la IA.

- Por qué ayuda: Hace que los sistemas de IA sean más resistentes frente a los ataques que intentan engañarlos.

- Inconveniente: Podría reducir ligeramente la precisión de la IA en datos normales (limpios).

- Ejemplos del mundo real:

- La API de nube Vision de Google utiliza el entrenamiento adversarial para mejorar la resistencia de sus modelos de reconocimiento de imágenes frente a entradas manipuladas.

- Los modelos de OpenAI incorporan ejemplos adversarios en su proceso de entrenamiento para mejorar la robustez frente a ataques basados en texto.

Destilación defensiva

La destilación LLM implica entrenar un modelo secundario para imitar el comportamiento del modelo original con el objetivo de dificultar su manipulación por parte de los atacantes.

- Cómo funciona: Entrena el primer modelo y, a continuación, utiliza sus resultados para entrenar otro modelo de forma que se optimice su proceso de toma de decisiones.

- Por qué ayuda: Hace que sea más difícil para los atacantes aprovechar las debilidades.

- Inconveniente: Este enfoque puede requerir una gran potencia de cálculo, especialmente en el caso de modelos de gran tamaño.

- Ejemplos del mundo real:

- Investigadores de la Universidad de California, Berkeley, aplicaron la destilación defensiva para mejorar la solidez de las redes neuronales profundas utilizadas en los vehículos autónomos.

- La plataforma de inteligencia artificial Watson de IBM emplea técnicas de destilación defensiva para proteger sus modelos de procesamiento del lenguaje natural frente a ataques adversarios.

Validación y desinfección de entradas

Garantizar que los datos que se introducen en un sistema de IA sean limpios y seguros es fundamental para protegerlo de entradas maliciosas.

- Cómo funciona: Comprueba que las entradas tengan el formato correcto, estén dentro de los rangos esperados y no contengan elementos dañinos.

- Por qué ayuda: Evita ataques como el envenenamiento de datos y mantiene el buen funcionamiento del sistema de IA.

- Mejores prácticas: Valida los datos en múltiples etapas: en el extremo del usuario, en el lado del servidor y dentro del propio sistema de IA.

- Ejemplos del mundo real:

- Los servicios Azure AI de Microsoft implementan una estricta validación de entradas para evitar ataques de inyección SQL en sus modelos de machine learning.

- El sistema de reconocimiento facial Rekognition de Amazon utiliza la desinfección de entradas para filtrar las entradas de imágenes potencialmente maliciosas.

Métodos de conjunto

El uso conjunto de varios modelos de IA diferentes (un conjunto) puede hacer que los sistemas sean más seguros. Aunque un modelo sea atacado, los demás pueden proporcionar respaldo.

- Cómo funciona: Combina las predicciones de varios modelos para tomar decisiones.

- Por qué ayuda: A los atacantes les resulta más difícil comprometer todos los modelos a la vez.

- Inconveniente: Requiere más recursos informáticos para gestionar múltiples modelos.

- Ejemplos del mundo real:

- El sistema de recomendaciones de Netflix utiliza un conjunto de múltiples modelos de IA para mejorar la precisión y la resistencia frente a los intentos de manipulación.

- Los métodos conjuntos no son exclusivos de la seguridad en la IA, sino que se utilizan en general para crear modelos predictivos más robustos y precisos.

IA explicable (XAI)

Hacer que los sistemas de IA sean explicables ayuda a las personas a comprender cómo funcionan y a detectar cualquier vulnerabilidad o comportamiento inusual. Puedes explorar este tema con más detalle en la curso «Explainable AI in Python».

- Cómo funciona: Utiliza herramientas como LIME, SHAP o mecanismos de atención para explicar las decisiones de la IA.

- Por qué ayuda: Aumenta la confianza en los sistemas de IA y facilita la detección y resolución de problemas como los sesgos.

- Reto: Los modelos más sencillos y fáciles de explicar pueden no ser tan potentes como los complejos.

- Ejemplo real:

- El programa Explainable AI (XAI) de DARPA tiene como objetivo desarrollar sistemas de IA más transparentes para aplicaciones militares.

- El kit de herramientas AI Explainability 360 de IBM proporciona recursos de código abierto para implementar técnicas de IA explicables en diversos sectores.

Auditorías de seguridad periódicas

Comprobar periódicamente los sistemas de IA en busca de puntos débiles puede ayudar a detectar problemas de forma temprana y garantizar su seguridad a lo largo del tiempo.

- En qué consiste: Realizar evaluaciones de vulnerabilidad, pruebas de penetración y revisiones de código.

- Con qué frecuencia: Realiza auditorías periódicamente y después de realizar cambios significativos en el sistema.

- Por qué ayuda: Identifica posibles brechas de seguridad y garantiza el cumplimiento de las normativas.

- Ejemplos del mundo real:

- Facebook realiza auditorías de seguridad periódicas de sus sistemas de moderación de contenido basados en inteligencia artificial para identificar y abordar posibles vulnerabilidades.

- La Ley de IA de la Unión Europea propone auditorías de seguridad obligatorias para los sistemas de IA de alto riesgo utilizados en sectores críticos.

El uso de estas estrategias puede hacer que los sistemas de IA sean más seguros y estén mejor protegidos contra los ataques. Pero aquí está la cuestión: la seguridad de la IA no es algo que se pueda «configurar y olvidar». Es un proceso continuo.

A medida que surgen nuevas amenazas —y créanme, siempre lo hacen—, las empresas deben mantenerse alerta. Esto implica supervisar constantemente las vulnerabilidades, actualizar los sistemas y mejorar las defensas.

|

Método |

Cómo funciona |

Por qué ayuda |

Inconvenientes |

|

Entrenamiento adversarial |

Crea ejemplos de datos manipulados e inclúyelos en el entrenamiento de la IA. |

Mejora la robustez frente a ataques adversarios que intentan engañar al sistema. |

Puede reducir ligeramente la precisión de la IA en datos normales (limpios). |

|

Destilación defensiva |

Entrena un modelo secundario para imitar el comportamiento del modelo original, suavizando tu proceso de toma de decisiones. |

Dificulta que los atacantes aprovechen las debilidades del modelo. |

Requiere mucha potencia de cálculo, especialmente para modelos grandes. |

|

Validación y desinfección de entradas |

Valida que las entradas tengan el formato correcto, estén dentro de los rangos esperados y no contengan elementos dañinos. |

Evita el envenenamiento de datos y garantiza el buen funcionamiento del sistema de IA. |

Requiere una implementación cuidadosa en múltiples etapas. |

|

Métodos de conjunto |

Combina las predicciones de varios modelos para tomar decisiones. |

Es más difícil para los atacantes comprometer todos los modelos simultáneamente. |

Requiere más recursos informáticos para gestionar y mantener múltiples modelos. |

|

IA explicable (XAI) |

Utiliza herramientas como LIME, SHAP o mecanismos de atención para explicar las decisiones de la IA. |

Aumenta la confianza y facilita la identificación y resolución de problemas como sesgos o comportamientos inusuales. |

Los modelos más sencillos y fáciles de explicar pueden no funcionar tan bien como los complejos. |

|

Auditorías de seguridad periódicas |

Realizar evaluaciones de vulnerabilidad, pruebas de penetración y revisiones de código para identificar puntos débiles. |

Identifica posibles brechas de seguridad y garantiza el cumplimiento de las normativas. |

Puede requerir muchos recursos, dependiendo de la complejidad del sistema. |

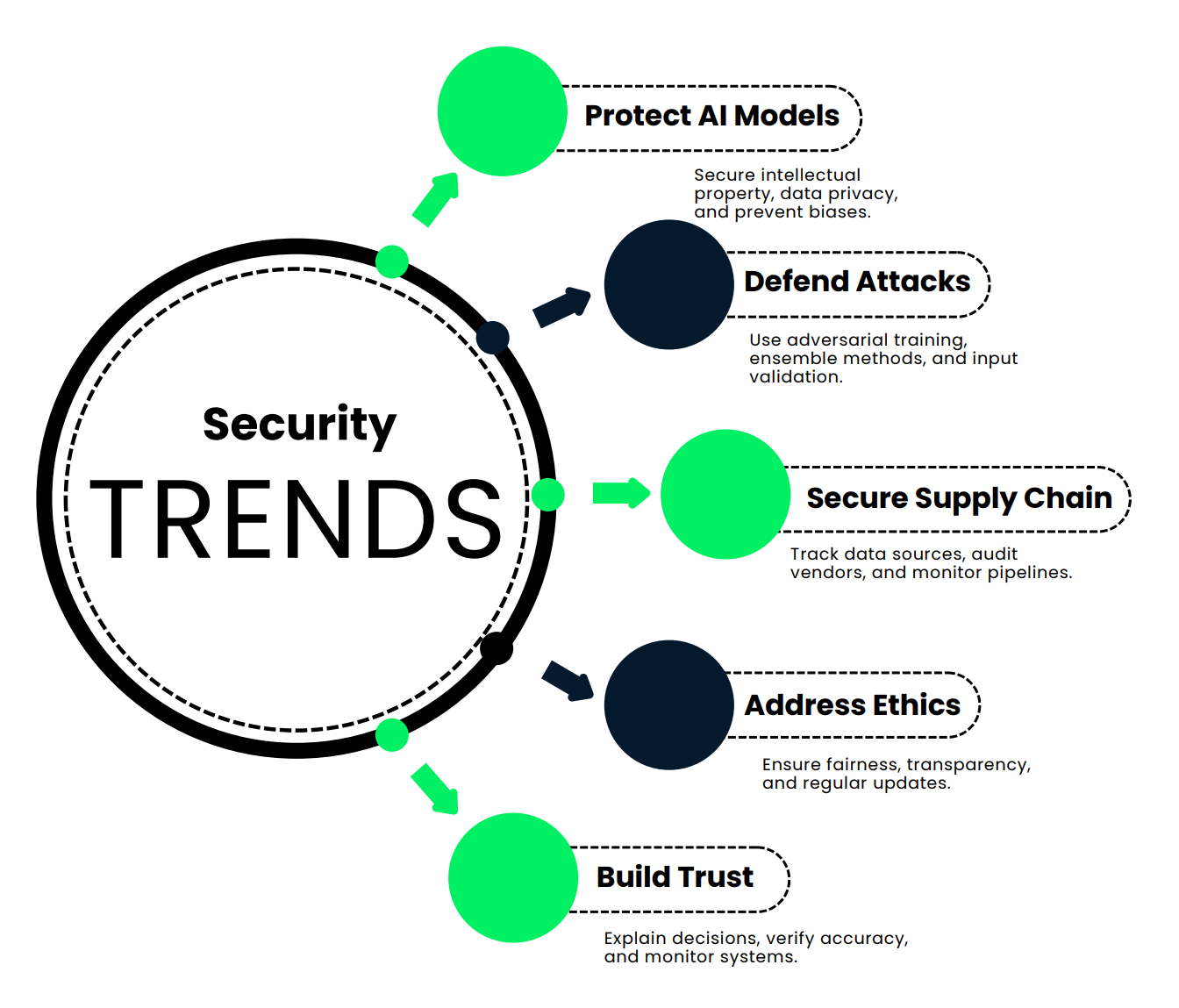

Nuevas tendencias en seguridad de la IA

En esta sección, analizamos las nuevas tendencias que mantienen los sistemas de IA seguros, precisos y fiables.

Protección de los modelos de IA y la integridad de los datos

En primer lugar, hablemos de por qué es tan importante proteger los modelos y los datos de IA.

- Protección de la propiedad intelectual: Piensa en el tiempo, el dinero y la capacidad intelectual que se invierten en crear un modelo de IA. No se trata solo de algoritmos, sino de inversiones masivas. Mantenerlos seguros evita que la competencia se apropie de ese arduo trabajo.

- Mantener la ventaja competitiva: Si alguien obtiene acceso no autorizado a tu modelo de IA, podría copiarlo y obtener los mismos resultados, sin gastar ni un céntimo en desarrollo.

- Privacidad y cumplimiento de los datos: La IA suele procesar datos confidenciales: información financiera, historiales médicos, etc. Si estos datos se filtran, te enfrentarás a cuantiosas multas y a una grave pérdida de confianza por parte del público. Más información en esta Introducción a la privacidad de datos.

- Prevención del envenenamiento de datos: Los hackers podrían manipular tus datos de entrenamiento y enseñar a tu IA a tomar decisiones erróneas, como pasar por alto fraudes o señalar acciones inocentes como amenazas.

- Mitigación de los ataques de inversión de modelos: Imagina que los atacantes pudieran averiguar los datos privados de los clientes con solo estudiar los resultados de tu IA. ¡Eso no sería bueno!

- Evitar resultados sesgados o poco éticos: Un modelo comprometido puede dar lugar a decisiones injustas o incluso perjudiciales, lo que podría dañar tu reputación.

- Protección de infraestructuras críticas: Dado que la IA se utiliza en los ámbitos de la sanidad, las finanzas e incluso la seguridad nacional, su protección no es solo una cuestión empresarial, sino también de seguridad pública.

Entonces, ¿cómo puedes mantener tu IA segura? A continuación, te presentamos algunas estrategias clave:

- Utilizar el cifrado y la anonimización de datos para proteger la información confidencial.

- Implementar políticas estrictas de retención de datos para controlar el tiempo que se almacena la información.

- Realizar auditorías de seguridad y supervisiones periódicas para detectar vulnerabilidades de forma temprana.

- Diseñar sistemas con privacidad desde el diseño , incorporando la seguridad en cada paso.

- Utiliza técnicas avanzadas como aprendizaje federado para proteger el modelo y sus datos sin mover información confidencial.

Veamos un ejemplo real para ilustrarlo. Imagina un gran banco internacional que ha desarrollado un modelo de IA para detectar transacciones fraudulentas. Este sistema gestiona millones de transacciones diarias, detectando patrones sospechosos y señalando los fraudes.

El banco gastó 50 millones de dólares y tardó tres años en crear este sistema. Si te lo roban, la competencia podría utilizarlo sin invertir ni un céntimo, lo que le costaría al banco su ventaja competitiva.

Este modelo procesa datos financieros confidenciales de millones de clientes. Una violación podría exponer esta información, lo que daría lugar a multas cuantiosas en virtud de leyes como el RGPD.

Si los hackers inyectaran datos falsos durante el entrenamiento, podrían enseñar a la IA a pasar por alto ciertos patrones de fraude, dejando al banco en una situación vulnerable.

Los atacantes más sofisticados podrían incluso extraer datos privados de los clientes a partir de los resultados del modelo.

¿Cómo lo protege el banco?

- Utilizan cifrado de extremo a extremo para proteger los datos.

- El acceso al modelo requiere autenticación multifactorial y está limitado por controles basados en roles.

- Realizan auditorías y pruebas de penetración periódicas para detectar puntos débiles.

- Los datos de los clientes utilizados para la formación son totalmente anónimos.

- El banco supervisa constantemente el rendimiento del modelo para detectar cualquier anomalía.

Esto da como resultado un sistema de IA más seguro y fiable que mantiene a salvo los datos de los clientes y cumple su promesa de detectar el fraude de forma eficaz. Es una ventaja tanto para el banco como para sus clientes.

Defensa contra ataques de evasión y envenenamiento

Imagina que gestionas una instalación de alta seguridad que utiliza el reconocimiento facial para garantizar la seguridad. Sin embargo, hemos aprendido que los sistemas de IA son vulnerables a ataques, como entradas adversas o datos de entrenamiento contaminados. Los hackers pueden manipular el sistema para poder entrar.

Analicemos las cuatro defensas clave que pueden detener a los atacantes en seco:

- Entrenamiento adversarial: Es como enseñarle a tu modelo algunos movimientos de defensa personal. Incluyes ejemplos de entradas manipuladas (imágenes con pequeños retoques diseñados para engañar a la IA) y la entrenas para que las reconozca. Imagina un sistema de reconocimiento facial que no solo detecta tu rostro, sino también aquellas alteraciones perfectas al píxel que los atacantes intentan introducir sigilosamente. Tu IA se vuelve más inteligente frente a estos ataques, aprendiendo de estos ejemplos para que no te engañen en la vida real.

- Métodos de conjunto: Ya hemos hablado de esto antes. En lugar de depender de un solo sistema, utilizas un conjunto de modelos. Cada modelo procesa la entrada de forma independiente y sus resultados se combinan mediante un mecanismo de votación. Los atacantes no pueden engañar solo a un modelo, tienen que engañar a todo el equipo. Buena suerte con eso.

- Comprobaciones periódicas de datos: A nadie le gusta limpiar, pero es un mantenimiento esencial para tu IA. Las auditorías semanales garantizan que tus datos de formación estén libres de duplicados, entradas mal etiquetadas o entradas maliciosas ocultas. Mantener el conjunto de datos actualizado con imágenes verificadas ayuda a que tu sistema se mantenga preciso.

- Validación de entradasAntes de que una imagen llegue a tu IA, pasa por un control de seguridad. Esto es lo que sucede:

- Se comprueban el formato y el tamaño.

- Los metadatos se analizan en busca de signos de manipulación.

- Se marcan los patrones adversarios conocidos.

- La detección de anomalías sirve para detectar cualquier cosa inusual.

El sistema no solo es inteligente, sino también prudente. Cada entrada debe demostrar su legitimidad antes de continuar.

Proteger las cadenas de suministro de IA

Garantizar la seguridad de la IA consiste en gestionar la integridad de los datos, proteger los modelos patentados y asegurarse de que todo funcione correctamente con tu configuración de ciberseguridad existente. Añádase a eso la necesidad de abordar las amenazas en constante evolución, el cumplimiento normativo, la ética y las vulnerabilidades de la cadena de suministro. A continuación, se presentan algunas estrategias para garantizar el ciclo de vida de la IA:

- Realiza un programa de tus fuentes: Cada dato y cada modelo de tu sistema de IA deben tener un origen claro. Documenta su procedencia, ya sea un hospital de confianza, una institución de investigación o un proveedor especializadoo. ¿Por qué? Porque conocer la fuente es el primer paso para saber si puedes confiar en ella.

- Audita a tus proveedores: Los proveedores externos son fundamentales, pero también pueden ser puntos débiles. Realiza auditorías periódicas para garantizar que cumplen con tus estándares de seguridad, ya sea el cumplimiento de la HIPAA, los protocolos de anonimización de datos o las certificaciones ISO.

- Utiliza herramientas de seguimiento de datos: Tus datos no son estáticos. Con el tiempo, evoluciona y, a veces, esa evolución incluye errores o cambios maliciosos. Herramientas como la supervisión automatizada de datos pueden realizar un seguimiento de los cambios y señalar los cambios inesperados, manteniendo tus conjuntos de datos limpios y precisos.

- Supervisar los flujos de datos: Los datos fluyen desde la fuente hasta el modelo a través de complejos procesos, y cualquier contratiempo en el camino puede suponer un problema. Los paneles de control en tiempo real pueden ayudarte a detectar irregularidades, como caídas repentinas en el volumen de datos o cambios inesperados en las funciones.

Aquí tienes un ejemplo real. Tomemos como ejemplo una empresa sanitaria que desarrolla una herramienta de diagnóstico basada en inteligencia artificial. Tu cadena de suministro incluye:

- Datos de pacientes de hospitales asociados.

- Conjuntos de datos de imágenes médicas procedentes de una institución de investigación de primer nivel.

- Modelos preentrenados de un proveedor especializado en IA.

¿Cómo se asegura este oleoducto?

- Fuentes de programa: Cada conjunto de datos y cada modelo se documentan meticulosamente para garantizar su trazabilidad.

- Auditorías de proveedores: Realizan comprobaciones trimestrales del cumplimiento de la HIPAA y garantizan el anonimato de los datos. Los proveedores se someten a evaluaciones de seguridad anuales para mantener sus certificaciones.

- Herramientas de linaje de datos: Utilizan herramientas como Anomalo para detectar cambios inesperados en los datos demográficos de los pacientes o en los datos de imagenología.

- : Los paneles de control en tiempo real de Looker supervisan el flujo de datos y señalan al instante cualquier irregularidad.

De esta manera, cuentan con una cadena de suministro de IA segura que garantiza que tu herramienta de diagnóstico sea precisa, fiable y cumpla con los estándares del sector.

Abordar los riesgos éticos

La IA es poderosa, pero ese poder puede ser peligroso en las manos equivocadas. Si un sistema de IA es pirateado o está mal diseñado, puede dar lugar a decisiones sesgadas, resultados poco éticos o incluso a un uso indebido. Eso es muy importante, especialmente cuando la IA toma decisiones que afectan a vidas reales, como la contratación, los préstamos o la asistencia sanitaria.

Entonces, ¿cómo podemos hacer que los sistemas de IA sean más éticos y resilientes? Vamos a dividirlo en cuatro pasos clave:

- Desarrollar normas y marcos claros: Empieza por crear una base sólida. Esto significa redactar políticas que definan qué es la equidad y la ética en tu sistema.

- Formar a los equipos de IA en materia de ética: No se puede esperar que la IA actúe de forma ética si las personas que la crean no están preparadas para pensar de forma crítica sobre estas cuestiones. La formación en ética ayuda a los equipos a reconocer y abordar los prejuicios inconscientes, comprender la equidad y lidiar con el impacto social de su trabajo.

- Haz que las decisiones de IA sean transparentes: La transparencia significa diseñar sistemas que puedan explicar sus decisiones: qué factores se tuvieron en cuenta, cómo se compararon los candidatos y dónde podrían existir posibles motivos de preocupación. La transparencia genera confianza y responsabilidad.

- Actualizar periódicamente los sistemas de IA: La IA no es algo que se configura una vez y ya está. Las auditorías periódicas ayudan a identificar y reducir los sesgos, garantizar la equidad y mantener el sistema en conformidad con las últimas normas del sector y los requisitos legales. La equidad no es algo estático, sino un proceso continuo.

Aquí tienes un ejemplo real. Hablemos de una gran empresa tecnológica que utiliza un sistema de contratación basado en inteligencia artificial. ¿Cómo se mantiene la ética?

- Establece reglas claras: Crean una Política de Ética de IA que describe los principios para una contratación imparcial, cubriendo todo, desde la recopilación de datos hasta la toma de decisiones. Una Junta de Ética de IA supervisa estas políticas para garantizar la rendición de cuentas.

- Entrenar a los equipos: La formación en materia de ética pasa a ser obligatoria para todos los empleados que trabajáis en el sistema. Cursan asignaturas sobre sesgos inconscientes y equidad en machine learning y participan en talleres que abordan dilemas del mundo real.

- Transparencia: El sistema de contratación incluye herramientas de explicabilidad. Para cada recomendación, proporciona un desglose de los factores que influyen en la decisión, como las cualificaciones clave o cómo se compara un candidato con los demás. Esto facilita a los responsables de RR. HH. la revisión de las decisiones.

- Actualizaciones periódicas: Las auditorías trimestrales analizan las decisiones de contratación en busca de sesgos y aplican técnicas como la eliminación de sesgos contradictorios para mejorar continuamente la equidad. También actualizan el sistema con las últimas leyes sobre igualdad en el empleo y las mejores prácticas del sector.

Se trata de un sistema de contratación ético, justo y transparente, incluso ante posibles compromisos.

Retos en materia de explicabilidad y confianza

Los sistemas de IA suelen considerarse «cajas negras», lo que significa que su proceso de toma de decisiones no es fácil de entender. Esto puede dificultar la detección de problemas o el establecimiento de una relación de confianza. Si eres un médico que confía en una herramienta de IA o un paciente afectado por su decisión, quieres respuestas, no interrogantes. La solución es la explicabilidad. Aquí hay cuatro estrategias para hacer que los sistemas de IA sean más transparentes y fáciles de confiar:

- Utiliza herramientas de IA explicable (XAI): Estas herramientas ayudan a desmitificar cómo la IA llega a sus conclusiones. Por ejemplo, técnicas como LIME o SHAP pueden mostrar qué factores influyeron en una decisión específica, lo que hace que el razonamiento del sistema sea más accesible.

- Programar y documentar los cambios en los datos: Cuando documentas cada cambio, como qué datos se han añadido, eliminado o modificado, puedes rastrear cómo estas actualizaciones afectan al rendimiento del modelo.

- Verifica la precisión con regularidad: No puedes tomarte la IA al pie de la letra. Compara tus resultados con los datos originales y, cuando sea posible, pide la opinión de expertos humanos. Las auditorías periódicas garantizan que el sistema se mantenga preciso e imparcial. Confía, pero verifica.

- Prueba y supervisa continuamente: La IA no es una herramienta que se pueda «configurar y olvidar». Las pruebas frecuentes con diversos datos de entrada ayudan a detectar errores de forma temprana, y la supervisión en tiempo real garantiza que el sistema funcione de forma coherente en diferentes escenarios.

Veamos cómo un hospital genera confianza en una herramienta de diagnóstico dermatológico basada en IA, un sistema que utiliza el reconocimiento de imágenes para identificar posibles afecciones cutáneas.

- Herramientas XAI: El hospital utiliza LIME, una herramienta que destaca qué partes de una imagen de la piel fueron más influyentes en el diagnóstico de la IA, para que los médicos puedan comprender y confiar en el razonamiento de la IA.

- Seguimiento de los cambios en los datos: Un herramienta de linaje de datos registra todas las actualizaciones del conjunto de datos de entrenamiento, como las imágenes recién añadidas o eliminadas. Esto permite al hospital realizar un seguimiento de cómo estos cambios afectan a la precisión de la IA a lo largo del tiempo.

- Verificación de la precisión: Cada mes, los dermatólogos revisan una muestra aleatoria de diagnósticos de IA y los comparan con los datos originales de los pacientes y sus propias opiniones expertas. El objetivo es garantizar que el sistema mantenga unos altos niveles de precisión y equidad.

- Pruebas y supervisión periódicas: El equipo de TI realiza pruebas semanales con diversas imágenes, comprobando el rendimiento de la IA en diferentes tipos y condiciones de piel. También supervisan patrones inusuales en tiempo real, para poder solucionar los problemas antes de que se agraven.

Esta herramienta de IA no solo es inteligente, sino también comprensible y fiable. Los médicos comprenden sus decisiones, los pacientes se sienten seguros con la atención que reciben y el hospital se asegura de que la tecnología funcione de manera justa y precisa.

Conclusión

A medida que la IA se convierte en una parte cada vez más importante de nuestras vidas, mantenerla segura es más importante que nunca. ¿Por qué? Porque el mismo poder que impulsa las capacidades de la IA también la convierte en blanco de ataques. Amenazas como los ataques adversarios, el envenenamiento de datos y el robo de modelos pueden perturbar gravemente el funcionamiento de la IA.

Entonces, ¿cómo defendemos la IA? Hemos aprendido que no existe una solución única para todos. Técnicas como el entrenamiento adversarial, las auditorías periódicas y las medidas de seguridad por capas pueden reducir los riesgos y hacer que tus sistemas sean más robustos.

Luego está la IA generativa. Los modelos lingüísticos de gran tamaño ofrecen oportunidades increíbles, pero también introducen nuevas vulnerabilidades. Desde la producción de contenidos engañosos hasta la manipulación para obtener resultados perjudiciales, estas herramientas requieren una supervisión cuidadosa. En el artículo Cómo construir barreras de protección para los grandes modelos lingüísticos, se exploran las medidas de seguridad para garantizar que los LLM se comporten como deben.

La ética y la transparencia no son negociables. Los sistemas de IA deben ser justos, explicables y fiables. Los prejuicios y el mal uso pueden minar la confianza, y la confianza lo es todo en el mundo actual, impulsado por la tecnología. La gente no utiliza lo que no te fía.

Por último, es fundamental mantenerse a la vanguardia. Las amenazas de la IA están en constante evolución. Las empresas deben actualizar periódicamente sus estrategias de seguridad, adaptándose a los nuevos riesgos para mantener su protección.La clave es ser proactivo, estar alerta y comprometerse con la ética y la transparencia. De esta manera, las empresas pueden generar confianza y aprovechar al máximo las ventajas de la IA.

Ana Rojo Echeburúa es especialista en IA y datos y doctora en Matemáticas Aplicadas. Le encanta convertir los datos en información práctica y tiene una amplia experiencia dirigiendo equipos técnicos. A Ana le gusta trabajar en estrecha colaboración con los clientes para resolver sus problemas empresariales y crear soluciones innovadoras de IA. Conocida por su capacidad para resolver problemas y su claridad de comunicación, es una apasionada de la IA, especialmente de la IA generativa. Ana se dedica al aprendizaje continuo y al desarrollo ético de la IA, así como a simplificar problemas complejos y explicar la tecnología de forma accesible.