Curso

A IA tá evoluindo tão rápido que acompanhar os desafiosde segurança parece tentar consertar um avião enquanto ele tá no ar. À medida que os sistemas ficam mais inteligentes e mais integrados nos processos diários de negócios, eles também ficam mais vulneráveis a novos tipos de ameaças.

Eu já vi isso de perto no meu trabalho. Já descobri várias vezes falhas de segurança em processos de negócios que poderiam permitir que alguém acessasse informações confidenciais sem autorização, principalmente quando as soluções de IA eram implementadas às pressas, sem as medidas de segurança adequadas.

É disso que trata este artigo: entender os riscos, desafios e melhores práticas para manter a IA segura. A IA tá crescendo muito rápido e, se a gente não ficar ligado nas vulnerabilidades, corre o risco de perder a confiança e os benefícios que ela traz.

Se você quiser saber mais sobre esse assunto, recomendo dar uma olhada no curso de Segurança e Gestão de Riscos em IA .

Novos desafios de segurança da IA

A IA funciona com base em dados. E quanto mais dados sua IA usar, maior será o alvo. Os hackers sabem disso. Imagina um hospital usando IA para prever os riscos à saúde dos pacientes. Parece ótimo, até alguém hackear o sistema. De repente, os registros médicos particulares ficam disponíveis na dark web ou, pior ainda, os dados médicos são alterados, o que pode levar a decisões prejudiciais. Criptografar dados confidenciais e fazer backups são essenciais, mas muitas empresas estão tão focadas na inovação que acabam esquecendo essas coisas básicas.

E os hackers não roubam só dados, aliás. Eles podem mexer nos próprios modelos de IA. Por exemplo, um carro autônomo sendo enganado e pensando que um sinal de parada é um sinal de limite de velocidade. Esse tipo de ataque é chamado de ataque de contaminação de dados, em que os hackers colocam dados ruins no sistema para atrapalhar a tomada de decisões. Vamos ver isso com mais detalhes na próxima seção.

Os ataques de injeção imediata também são outro tipo de ataque. São manipulações sutis que fazem uma IA dizer ou fazer algo que não deveria. Temos um artigo incrível sobre injeção de prompt, então não vamos entrar em muitos detalhes neste artigo, mas vale a pena dar uma olhada.

Curiosamente, os hackers também estão usando IA para hackear. É aqui que entra a a segurança cibernética se torna uma corrida contra o tempo — os hackers inovam e as equipes de segurança precisam responder com a mesma rapidez. Ferramentas como a detecção de anomalias podem ajudar, mas não são infalíveis.

Já ouviu falar que “uma corrente é tão forte quanto seu elo mais fraco”? Isso se aplica totalmente à IA. As empresas costumam integrar ferramentas de IA pré-construídas em seus sistemas. Mas e se uma dessas ferramentas for comprometida? Imagina um chatbot popular, usado por centenas de empresas, sendo hackeado. São centenas de empresas — e todos os dados de seus clientes — em risco. É tipo um efeito dominó digital.

Por fim, tem a falta de conhecimento especializado. A adoção da IA está aumentando, mas a segurança cibernética para IA ainda está tentando acompanhar.

Ameaças à segurança da IA

Os sistemas de IA enfrentam sérias ameaças à segurança que podem comprometer o seu bom funcionamento e confiabilidade. Vamos ver as principais ameaças.

Ataques adversários

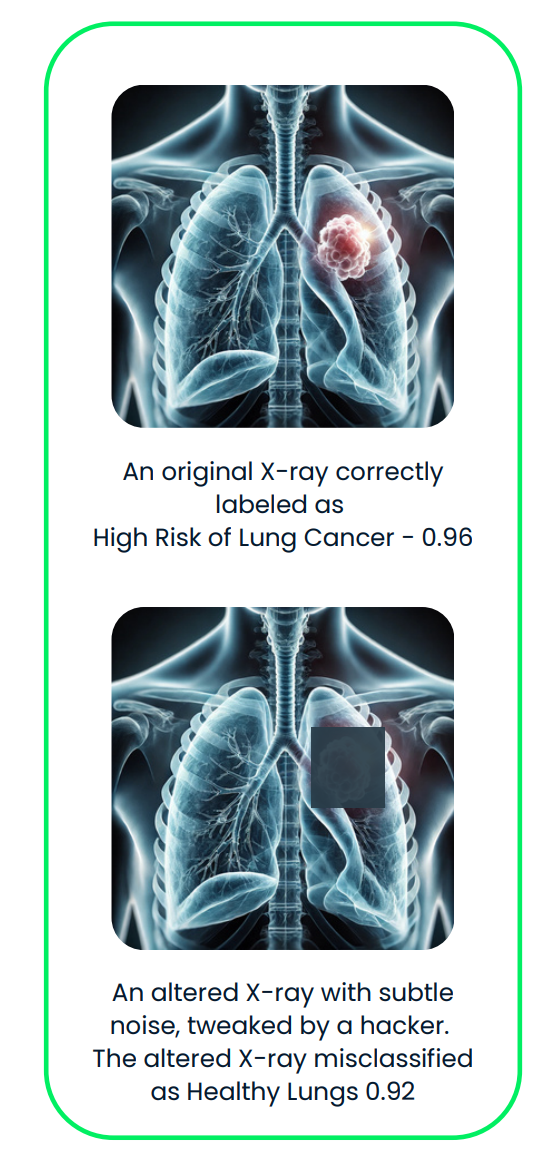

Os ataques adversários enganam os sistemas de IA fazendo pequenas alterações sorrateiras nas entradas que a IA processa. Essas mudanças são tão sutis que os humanos geralmente não conseguem percebê-las, mas podem confundir completamente a IA, levando-a a tomar a decisão errada.

Por exemplo:

- Mudar pequenos detalhes numa imagem, tipo alterar só alguns pixels, pra que a IA identifique errado.

- Adicionar um leve ruído a um arquivo de áudio, fazendo com que soe igual para nós, mas fazendo com que a IA interprete mal.

- Mexer no jeito que uma frase é escrita pra confundir o entendimento da IA.

Esses ataques não exigem que o invasor saiba como a IA funciona internamente, o que é outra razão pela qual eles são muito difíceis de detectar e impedir.

Vamos ver agora alguns exemplos reais.

- Algoritmo DeepFool: DeepFool é um método feito pra fazer pequenas mudanças, quase invisíveis, numa entrada, tipo uma imagem, pra enganar a IA e fazê-la classificar errado. Funciona ajustando gradualmente a entrada até que a IA erre. Essas mudanças são tão pequenas que a gente nem percebe.

- Ataques de áudio direcionados: Neste artigo, os invasores criaram um áudio que soa quase idêntico ao original, mas faz com que um sistema de reconhecimento de voz ouça palavras completamente diferentes. Esse método foi usado pra enganar o sistema DeepSpeech da Mozilla com uma taxa de sucesso de 100%.

- Manipulação do piloto automático da Tesla: A Keen Labs enganou o sistema de piloto automático da Tesla colocando três adesivos discretos na estrada, fazendo com que ele interpretasse mal as marcações da pista e pudesse acabar indo para a pista errada. Leia mais aqui.

Esse diagrama mostra um ataque adversário a um sistema de IA de imagens médicas. A radiografia original, corretamente classificada como “Alto risco de câncer de pulmão”, é sutilmente alterada com ruído adverso, resultando em uma classificação incorreta de “Pulmões saudáveis”.

Uma ótima leitura é Aprendizaje de machine learning adversarial, uma área que estuda ataques que exploram vulnerabilidades em modelos de machine learning e desenvolve defesas para proteger contra essas ameaças.

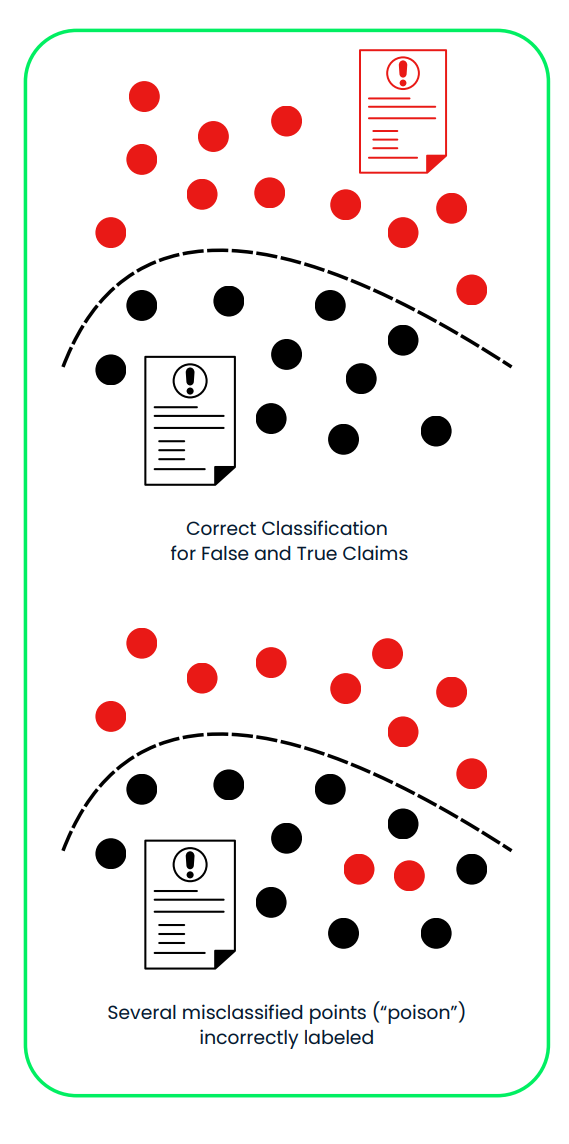

Ataques com veneno

Os ataques de envenenamento miram a fase de treinamento dos sistemas de IA, onde o modelo aprende a tomar decisões. Os invasores colocam dados corrompidos ou enganosos no conjunto de treinamento para que possam manipular a IA para que ela se comporte de forma incorreta ou favoreça resultados tendenciosos. Esses ataques funcionam porque mexem com a base do processo de aprendizagem da IA, muitas vezes sem deixar sinais óbvios de que algo está errado.

Isso pode envolver:

- Mudar os rótulos de alguns exemplos de treinamento, tipo rotular uma foto de um cachorro como gato, por exemplo.

- Adicionar dados falsos pra influenciar as decisões da IA de maneiras específicas.

Essas mudanças sutis podem fazer com que a IA falhe em certas situações ou aja de forma que beneficie o invasor. Como o ataque rola durante o treinamento, é difícil perceber quando o modelo é implementado.

Vamos ver alguns exemplos reais:

- Ataques por porta dos fundos: Um estudo chamado“ ”Contornando algoritmos de detecção de backdoors em deep learning” (Contornando algoritmos de detecção de backdoors em deep learning) mostrou como os invasores podem esconder “backdoors” maliciosas em modelos de IA. Essas backdoors só são ativadas em condições específicas, tipo mostrar um certo padrão numa imagem. O estudo mostrou que os invasores podem usar técnicas avançadas para fazer com que dados contaminados pareçam iguais aos dados limpos, evitando a detecção.

- Contaminação de conjuntos de dados em escala web: No artigo“ ” (Invenção de conjuntos de dados de treinamento em escala web),Envenenar conjuntos de dados de treinamento em escala web é prático”, os pesquisadores falaram sobre como grandes conjuntos de dados coletados na internet podem ser contaminados:

- Contaminação de dados em visualização dividida: Corromper os dados depois que eles são coletados, mas antes de serem usados para treinamento.

- Contaminação de dados por frontrunning: Manipular os dados logo antes de adicioná-los ao conjunto de dados.

- Chatbot Tay da Microsoft: Em 2016, a Microsoft lançou um chatbot chamado Tay no Twitter. Os usuários rapidamente manipularam a Tay, enchendo-a de conteúdo ofensivo, fazendo com que ela postasse tweets racistas e inapropriados. A Microsoft teve que desligar a Tay logo depois do lançamento. Leia mais aqui.

Esse diagrama mostra um ataque de envenenamento em um sistema de IA usado para classificar reclamações de seguro falsas e verdadeiras. No primeiro painel, o sistema separa corretamente as alegações falsas (vermelho) e verdadeiras (preto) usando um conjunto de dados de treinamento limpo. No segundo painel, dados maliciosamente rotulados de forma errada (“veneno”) mudam o limite da decisão, levando à classificação errada de alegações falsas como verdadeiras, comprometendo a confiabilidade e a segurança do sistema.

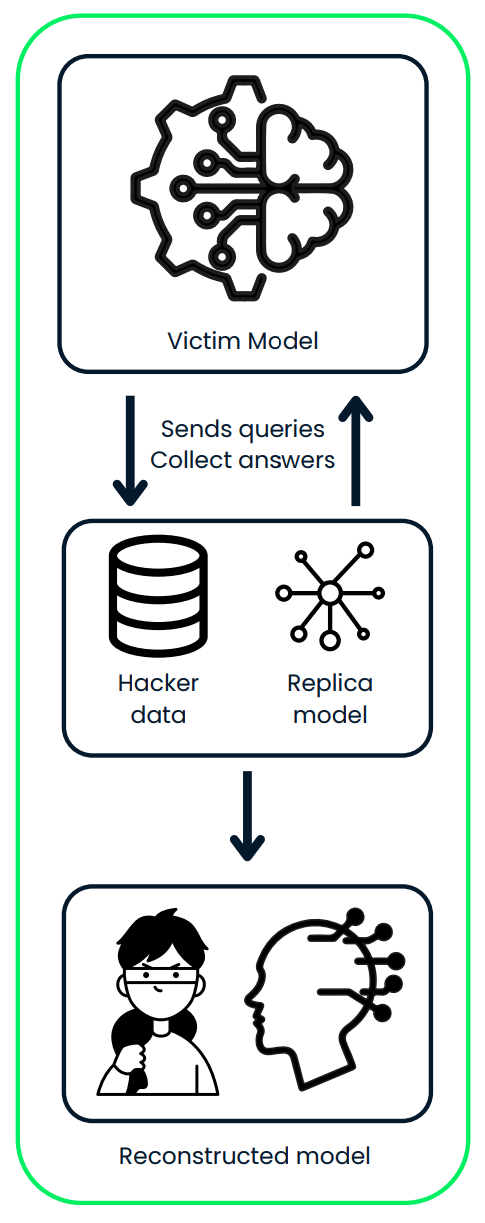

Ataques de extração de modelos

Em um ataque de extração de modelo, um invasor descobre como um modelo de IA funciona fazendo engenharia reversa nele. Eles usam as entradas e saídas que coletam para copiar o design e o comportamento do sistema.

Depois de fazerem uma réplica do modelo, eles podem:

- Use-o para fazer previsões, possivelmente envolvendo dados confidenciais ou privados.

- Roubar informações confidenciais do modelo original.

- Modificar e retreinar o modelo para atender às suas próprias necessidades, muitas vezes com fins prejudiciais.

Por exemplo, se o modelo roubado foi treinado com dados privados de clientes, o invasor poderia prever detalhes pessoais sobre esses clientes ou criar uma versão personalizada do modelo para seu próprio uso.

Vamos ver alguns exemplos reais:

- Uma ferramenta chamada DeepSniffer mostra como esse tipo de ataque pode funcionar. O DeepSniffer não precisa saber nada sobre o modelo original antes. Ele pega dicas de como o modelo processa os dados, tipo, programando as operações de memória durante o tempo de execução. Ele junta essas pistas para descobrir a estrutura do modelo, mesmo que o sistema tente otimizar ou esconder seus processos.

- Mindgard mostrou como os componentes críticos de um modelo de linguagem de caixa preta, como o chatGPT 3.5 Turbo da OpenAI, podem ser extraídos por meio de um processo de baixo custo. Com apenas US$ 50 em despesas com API, a equipe conseguiu criar um modelo menor — cerca de 100 vezes menor que o original — que superou o chatGPT em uma tarefa específica. Esse modelo extraído foi então usado para aprimorar outro ataque, que foi posteriormente implantado contra o próprio chatGPT. O ataque melhorado conseguiu uma taxa de sucesso maior, subindo para 11%.

Esse diagrama mostra um ataque de extração de modelo, onde um invasor interage com o modelo de IA da vítima enviando consultas e coletando suas previsões. O invasor usa os dados coletados para treinar um modelo réplica, reconstruindo, por fim, uma versão roubada do sistema original.

Defesas de segurança com IA

Já falamos nas seções anteriores que, à medida que a IA se torna mais comum, é importante implementar medidas de segurança robustas para se proteger contra ataques. Vamos falar sobre algumas maneiras eficazes de tornar a IA mais segura.

Treinamento adversarial

Esse método envolve ensinar modelos a reconhecer e lidar com entradas complicadas e manipuladas (chamadas de exemplos adversários). Quando você treina seu modelo com esses exemplos, ele fica mais resistente a certos tipos de ataques.

- Como funciona: Crie exemplos de dados manipulados e inclua-os no treinamento da IA.

- Por que isso ajuda: Isso deixa os sistemas de IA mais resistentes contra ataques que tentam enganá-los.

- Desvantagem: Isso pode diminuir um pouco a precisão da IA em dados normais (limpos).

- Exemplos reais:

- A API Cloud Vision do Google usa treinamento adversário para melhorar a resistência dos seus modelos de reconhecimento de imagem contra entradas manipuladas.

- Os modelos da OpenAI usam exemplos adversários no treinamento para ficar mais resistentes contra ataques baseados em texto.

Destilação defensiva

A destilação LLM é quando a gente treina um modelo secundário pra imitar o comportamento do modelo original, com o objetivo de dificultar a manipulação por parte de invasores.

- Como funciona: Treine o primeiro modelo e, em seguida, use sua saída para treinar outro modelo de forma a suavizar seu processo de tomada de decisão.

- Por que isso ajuda: Isso torna mais difícil para os invasores explorarem as vulnerabilidades.

- Desvantagem: Essa abordagem pode exigir bastante poder de computação, principalmente para modelos grandes.

- Exemplos reais:

- Pesquisadores da Universidade da Califórnia, em Berkeley, usaram a destilação defensiva para melhorar a robustez das redes neurais profundas usadas em veículos autônomos.

- A plataforma de IA Watson da IBM usa técnicas de destilação defensiva para proteger seus modelos de processamento de linguagem natural contra ataques adversários.

Validação e higienização de entradas

Garantir que os dados que entram num sistema de IA estejam limpos e seguros é essencial para protegê-lo contra entradas maliciosas.

- Como funciona: Verifique se as entradas estão no formato correto, se estão dentro dos intervalos esperados e se não contêm elementos prejudiciais.

- Por que isso ajuda: Evita ataques como o envenenamento de dados e mantém o sistema de IA funcionando sem problemas.

- Melhores práticas: Valide os dados em várias etapas — do lado do usuário, do servidor e dentro do próprio sistema de IA.

- Exemplos reais:

- Os serviços de IA do Azure da Microsoft fazem uma validação rigorosa das entradas para evitar ataques de injeção de SQL nos seus modelos de machine learning.

- O sistema de reconhecimento facial Rekognition da Amazon usa a sanitização de entradas para filtrar imagens que podem ser maliciosas.

Métodos de conjunto

Usar vários modelos diferentes de IA juntos (um conjunto) pode tornar os sistemas mais seguros. Mesmo que um modelo seja atacado, os outros podem dar uma força.

- Como funciona: Junte as previsões de vários modelos para tomar decisões.

- Por que isso ajuda: É mais difícil para os invasores comprometerem todos os modelos de uma só vez.

- Desvantagem: Precisa de mais recursos de computação pra gerenciar vários modelos.

- Exemplos reais:

- O sistema de recomendações da Netflix usa um conjunto de vários modelos de IA para melhorar a precisão e a resistência contra tentativas de manipulação.

- Os métodos de conjunto não são exclusivos da segurança em IA, eles são usados em geral para criar modelos preditivos mais robustos e precisos.

IA explicável (XAI)

Tornar os sistemas de IA explicáveis ajuda as pessoas a entender como eles funcionam e a detectar quaisquer vulnerabilidades ou comportamentos incomuns. Você pode ver mais sobre esse assunto em detalhes no IA explicável em Python.

- Como funciona: Use ferramentas como LIME, SHAP ou mecanismos de atenção para explicar as decisões da IA.

- Por que isso ajuda: Aumenta a confiança nos sistemas de IA e facilita a identificação e correção de problemas como preconceitos.

- Desafio: Modelos mais simples e fáceis de entender podem não ser tão poderosos quanto os complexos.

- Exemplo real:

- O programa Explainable AI (XAI) da DARPA quer criar sistemas de IA mais transparentes para aplicações militares.

- O kit de ferramentas AI Explainability 360 da IBM oferece recursos de código aberto para implementar técnicas de IA explicáveis em vários setores.

Auditorias de segurança regulares

Verificar regularmente se os sistemas de IA têm pontos fracos pode ajudar a detectar problemas logo no início e garantir que eles continuem seguros ao longo do tempo.

- O que isso envolve: Faça avaliações de vulnerabilidade, testes de penetração e revisões de código.

- Com que frequência: Faça auditorias regularmente e depois de fazer mudanças significativas no sistema.

- Por que isso ajuda: Identifica possíveis falhas de segurança e garante que as regras sejam seguidas.

- Exemplos reais:

- O Facebook faz auditorias de segurança regulares nos seus sistemas de moderação de conteúdo com inteligência artificial para identificar e resolver possíveis vulnerabilidades.

- A Lei de IA da União Europeia propõe auditorias de segurança obrigatórias para sistemas de IA de alto risco usados em setores críticos.

Usar essas estratégias pode tornar os sistemas de IA mais seguros e melhor protegidos contra ataques. Mas é o seguinte: a segurança da IA não é algo que você configura e esquece. É um processo contínuo.

À medida que novas ameaças aparecem — e acredite, elas sempre aparecem —, as empresas precisam estar sempre atentas. Isso significa monitorar constantemente as vulnerabilidades, atualizar os sistemas e melhorar as defesasnses.

|

Método |

Como funciona |

Por que isso ajuda |

Drawbacks |

|

Treinamento Adversarial |

Crie exemplos de dados manipulados e inclua-os no treinamento da IA. |

Melhora a resistência contra ataques adversários que tentam enganar o sistema. |

Pode diminuir um pouco a precisão da IA em dados normais (limpos). |

|

Destilação defensiva |

Treine um modelo secundário para imitar o comportamento do modelo original, suavizando seu processo de tomada de decisão. |

Torna mais difícil para os invasores explorarem as fraquezas do modelo. |

Precisa de bastante poder de computação, principalmente para modelos grandes. |

|

Validação e higienização de entradas |

Confira se as entradas estão no formato certo, dentro dos limites esperados e não têm nada que possa causar problemas. |

Evita a contaminação de dados e garante o bom funcionamento do sistema de IA. |

Precisa ser implementado com cuidado em várias etapas. |

|

Métodos de Conjunto |

Junte as previsões de vários modelos para tomar decisões. |

É mais difícil para os invasores comprometerem todos os modelos ao mesmo tempo. |

Precisa de mais recursos de computação para gerenciar e manter vários modelos. |

|

IA explicável (XAI) |

Use ferramentas como LIME, SHAP ou mecanismos de atenção para explicar as decisões da IA. |

Aumenta a confiança e facilita a identificação e correção de problemas, como preconceitos ou comportamentos incomuns. |

Modelos mais simples e fáceis de entender podem não funcionar tão bem quanto os mais complexos. |

|

Auditorias de segurança regulares |

Faça avaliações de vulnerabilidade, testes de penetração e revisões de código para identificar pontos fracos. |

Identifica possíveis falhas de segurança e garante que as regras sejam seguidas. |

Pode exigir muitos recursos, dependendo da complexidade do sistema. |

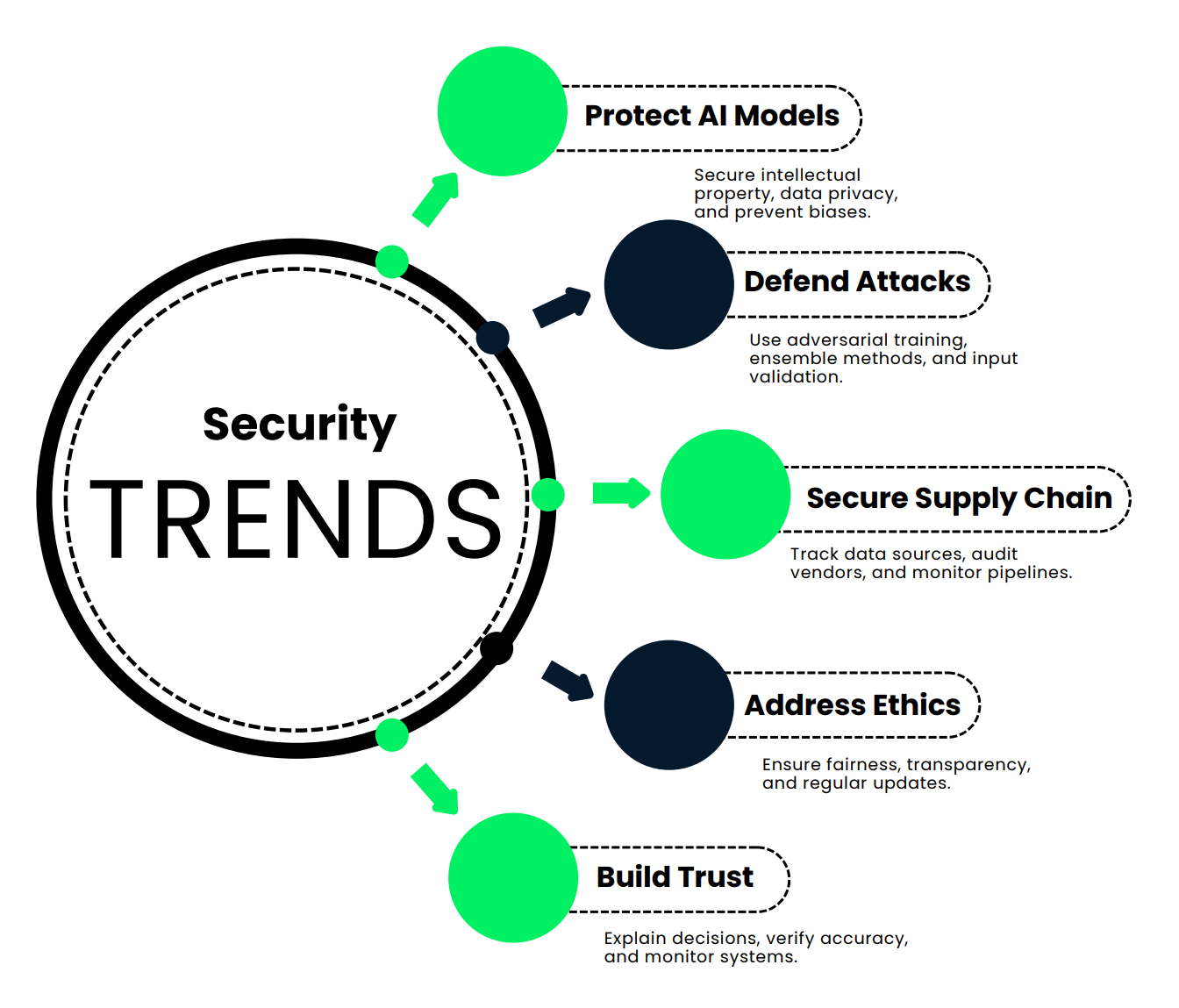

Novas tendências em segurança de IA

Nesta seção, vamos dar uma olhada nas novas tendências que estão mantendo os sistemas de IA seguros, precisos e confiáveis.

Protegendo modelos de IA e a integridade dos dados

Primeiro, vamos falar sobre por que proteger modelos e dados de IA é tão importante.

- Protegendo a propriedade intelectual: Pense no tempo, dinheiro e inteligência necessários para criar um modelo de IA. Não se trata apenas de algoritmos; são investimentos enormes. Manter tudo seguro evita que os concorrentes roubem esse trabalho árduo.

- Manter a vantagem competitiva: Se alguém conseguir acesso não autorizado ao seu modelo de IA, poderá copiá-lo e obter os mesmos resultados, sem gastar um centavo em desenvolvimento.

- Privacidade e conformidade dos dados: A IA costuma lidar com dados confidenciais — informações financeiras, registros médicos, o que você quiser. Se esses dados forem expostos, você vai ter que lidar com multas pesadas e uma grande queda na confiança do público. Saiba mais nesta Introdução à Privacidade de Dados.

- Prevenindo a contaminação de dados: Os hackers podem mexer nos seus dados de treinamento, ensinando sua IA a tomar decisões erradas, como deixar fraudes passarem ou sinalizar ações inocentes como ameaças.

- Como diminuir os ataques de inversão de modelo: Imagina se os invasores pudessem descobrir detalhes privados dos clientes só de analisar os resultados da sua IA. Isso não seria legal!

- Evitar resultados tendenciosos ou antiéticos: Um modelo comprometido pode levar a decisões injustas ou até prejudiciais, o que pode manchar sua reputação.

- Protegendo infraestruturas importantes: Como a IA está sendo usada na área da saúde, finanças e até mesmo na segurança nacional, sua proteção não é só uma preocupação comercial — é uma questão de segurança pública.

Então, como você pode realmente manter sua IA segura? Aqui estão algumas estratégias importantes:

- Use criptografia e anonimização de dados para proteger informações confidenciais.

- Implementar políticas rígidas de retenção de dados para controlar por quanto tempo as informações são armazenadas.

- Fazer auditorias de segurança regulares e monitoramento para detectar vulnerabilidades logo no início.

- Sistemas de design com privacidade desde a concepção , incorporando segurança em cada etapa.

- Use técnicas avançadas como aprendizado federado para proteger o modelo e seus dados sem precisar mover informações confidenciais.

Vamos dar vida a isso com um cenário do mundo real. Imagina um grande banco internacional que desenvolveu um modelo de IA para detectar transações fraudulentas. Esse sistema lida com milhões de transações por dia, identificando padrões suspeitos e sinalizando fraudes.

O banco gastou US$ 50 milhões e levou três anos para construir esse sistema. Se for roubado, os concorrentes podem usá-lo sem investir um centavo, fazendo com que o banco perca sua vantagem.

Esse modelo processa dados financeiros confidenciais de milhões de clientes. Uma violação pode expor essas informações, levando a multas pesadas de acordo com leis como o GDPR.

Se os hackers colocassem dados falsos durante o treinamento, eles poderiam ensinar a IA a ignorar certos padrões de fraude, deixando o banco vulnerável.

Atacantes mais espertos podem até conseguir pegar detalhes privados dos clientes a partir dos resultados do modelo.

Como o banco protege isso?

- Eles usam criptografia de ponta a ponta para proteger os dados.

- O acesso ao modelo precisa de autenticação multifatorial. autenticação multifatorial e é limitado por controles baseados em funções.

- Eles fazem auditorias e testes de penetração para encontrar pontos fracos.

- Os dados dos clientes usados para treinamento são totalmente anônimos.

- O banco fica de olho no desempenho do modelo o tempo todo pra perceber qualquer coisa fora do normal.

Isso resulta em um sistema de IA mais seguro e confiável, que mantém os dados dos clientes protegidos e cumpre sua promessa de detectar fraudes de forma eficaz. É uma vitória tanto para o banco quanto para seus clientes.

Defesa contra ataques de evasão e envenenamento

Imagina que você está cuidando de uma instalação de alta segurança que usa reconhecimento facial para manter tudo protegido. Mas a gente aprendeu que os sistemas de IA são vulneráveis a ataques, tipo entradas adversárias ou dados de treinamento corrompidos. Os hackers podem mexer no sistema pra conseguir entrar.

Vamos analisar as quatro principais defesas que podem impedir os invasores de avançar:

- Treinamento adversarial: É como ensinar ao seu modelo alguns movimentos de autodefesa. Você inclui exemplos de entradas manipuladas — imagens com ajustes sutis que são projetadas para enganar a IA — e a treina para reconhecê-las. Imagina um sistema de reconhecimento facial que não só reconhece o teu rosto, mas também detecta aquelas alterações perfeitas que os invasores tentam fazer. Sua IA fica mais esperta contra esses ataques, aprendendo com esses exemplos para não cair em armadilhas na vida real.

- Métodos de conjunto: Já falamos sobre isso antes. Em vez de depender de um único sistema, você usa um conjunto de modelos. Cada modelo processa a entrada de forma independente, e os resultados são combinados usando um mecanismo de votação. Os invasores não podem enganar só um modelo — eles precisam enganar todo o time. Boa sorte com isso.

- Verificações regulares de dados: Ninguém gosta de limpar, mas isso é essencial para a manutenção da sua IA. Auditorias semanais garantem que seus dados de treinamento estejam livres de duplicatas, entradas com rótulos errados ou entradas maliciosas dissimuladas. E manter o conjunto de dados atualizado com imagens verificadas ajuda seu sistema a permanecer eficiente.

- Validação de entradaAntes mesmo de uma imagem chegar perto da sua IA, ela passa por uma verificação de segurança. Eis o que rola:

- O formato e o tamanho são verificados.

- Os metadados são analisados para ver se tem algum sinal de adulteração.

- Os padrões adversários conhecidos são sinalizados.

- A detecção de anomalias funciona para identificar qualquer coisa fora do normal.

O sistema não é só inteligente; ele é cuidadoso. Cada entrada precisa provar que é legítima antes de seguir em frente.

Protegendo as cadeias de suprimentos de IA

Proteger a IA é cuidar da integridade dos dados, proteger modelos exclusivos e garantir que tudo funcione bem com a sua configuração de segurança cibernética atual. Acrescente a isso a necessidade de lidar com ameaças em constante evolução, conformidade regulatória, ética e vulnerabilidades na cadeia de suprimentos. Aqui estão algumas estratégias para garantir o ciclo de vida da IA:

- Programa suas fontes: Cada dado e cada modelo no seu sistema de IA deve ter uma história de origem clara. Documente de onde veio, seja de um hospital de confiança, uma instituição de pesquisa ou um fornecedor especializadoou. Por quê? Porque saber de onde vem a informação é o primeiro passo para saber se dá pra confiar nela.

- Faça uma auditoria nos seus fornecedores: Os fornecedores terceirizados são essenciais, mas também podem ser pontos fracos. Faça auditorias regulares para garantir que eles cumpram seus padrões de segurança, seja conformidade com a HIPAA, protocolos de anonimização de dados ou certificações ISO.

- Use ferramentas de rastreamento de dados: Seus dados não são estáticos. Com o tempo, ele vai mudando, e às vezes essas mudanças podem incluir erros ou alterações maliciosas. Ferramentas como o monitoramento automatizado de dados podem acompanhar as mudanças e sinalizar alterações inesperadas, mantendo seus conjuntos de dados limpos e precisos.

- Monitorar os fluxos de dados: Os dados fluem da fonte para o modelo por meio de pipelines complexos, e qualquer problema no caminho pode significar complicações. Os painéis em tempo real podem te ajudar a detectar irregularidades, como quedas repentinas no volume de dados ou alterações inesperadas nos recursos.

Aqui vai um exemplo da vida real. Vamos pegar como exemplo uma empresa de saúde que está desenvolvendo uma ferramenta de diagnóstico com inteligência artificial. A cadeia de suprimentos deles inclui:

- Dados dos pacientes dos hospitais parceiros.

- Conjuntos de dados de imagens médicas de uma instituição de pesquisa de ponta.

- Modelos pré-treinados de um fornecedor especializado em IA.

Como eles protegem esse oleoduto?

- Fontes de programa: Cada conjunto de dados e modelo é documentado com cuidado para garantir a rastreabilidade.

- Auditorias de fornecedores: Eles fazem verificações trimestrais para ver se estão seguindo a HIPAA e garantem que os dados fiquem anônimos. Os fornecedores passam por avaliações de segurança anuais para manter as certificações.

- Ferramentas de linhagem de dados: Eles usam ferramentas como o Anomalo para detectar mudanças inesperadas nos dados demográficos dos pacientes ou nos dados de imagem.

- Monitoramento de dutos: Os painéis em tempo real no Looker ficam de olho no fluxo de dados, sinalizando na hora qualquer irregularidade.

Assim, eles têm uma cadeia de suprimentos de IA segura que garante que sua ferramenta de diagnóstico seja precisa, confiável e esteja de acordo com os padrões do setor.

Lidando com riscos éticos

A IA é poderosa, mas esse poder pode ser perigoso nas mãos erradas. Se um sistema de IA for hackeado ou for mal projetado, isso pode levar a decisões tendenciosas, resultados antiéticos ou até mesmo uso indevido. Isso é muito importante, principalmente quando a IA toma decisões que afetam vidas reais, como contratações, empréstimos ou cuidados de saúde.

Então, como podemos tornar os sistemas de IA mais éticos e resilientes? Vamos dividir isso em quatro etapas principais:

- Crie regras e estruturas claras: Comece criando uma base sólida. Isso significa elaborar políticas que definam o que é justiça e ética para o seu sistema.

- Treine equipes de IA em ética: Não dá pra esperar que a IA aja de forma ética se as pessoas que a criam não estão preparadas pra pensar criticamente sobre essas questões. O treinamento em ética ajuda as equipes a reconhecer e lidar com preconceitos inconscientes, entender o que é justiça e encarar o impacto social do seu trabalho.

- Torne as decisões da IA transparentes: Transparência é criar sistemas que possam explicar suas decisões — quais fatores foram considerados, como os candidatos foram comparados e onde podem estar as possíveis preocupações. A transparência gera confiança e responsabilidade.

- Atualize os sistemas de IA com frequência: A IA não é algo que se configura e se esquece. Auditorias regulares ajudam a identificar e reduzir preconceitos, garantir a imparcialidade e manter o sistema em conformidade com os mais recentes padrões do setor e requisitos legais. A justiça não é algo fixo; é um processo que nunca para.

Aqui vai um exemplo da vida real. Vamos falar sobre uma grande empresa de tecnologia que usa um sistema de contratação baseado em inteligência artificial. Como eles mantêm a ética?

- Crie regras claras: Eles criam uma Política de Ética em IA que define os princípios para contratações imparciais, cobrindo tudo, desde a coleta de dados até a tomada de decisões. Um Conselho de Ética em IA fica de olho nessas políticas pra garantir a responsabilidade.

- Treinar as equipes: O treinamento em ética passa a ser obrigatório para todos os funcionários que trabalham no sistema. Eles fazem cursos sobre preconceitos inconscientes e justiça no machine learning e participam de workshops que abordam dilemas do mundo real.

- Transparência: O sistema de contratação inclui ferramentas de explicabilidade. Para cada recomendação, ele mostra os fatores que influenciam a decisão, tipo as principais qualificações ou como um candidato se compara aos outros. Isso facilita a revisão das decisões pelos gerentes de RH.

- Atualizações regulares: Auditorias trimestrais analisam as decisões de contratação em busca de preconceitos e aplicam técnicas como o debiasing adversarial para melhorar continuamente a imparcialidade. Eles também atualizam o sistema com as leis mais recentes sobre igualdade no emprego e as melhores práticas do setor.

Esse é um sistema de contratação ético, justo e transparente, mesmo quando tem possíveis desafios.

Desafios em termos de explicabilidade e confiança

Os sistemas de IA são frequentemente vistos como “caixas pretas”, o que significa que seu processo de tomada de decisão não é fácil de entender. Isso pode dificultar a identificação de problemas ou a construção de confiança. Se você é um médico que usa uma ferramenta de IA ou um paciente afetado pela decisão dela, você quer respostas, não perguntas. A solução é a explicabilidade. Aqui estão quatro estratégias para tornar os sistemas de IA mais transparentes e fáceis de confiar:

- Use ferramentas de IA explicável (XAI): Essas ferramentas ajudam a desmistificar como a IA chega às suas conclusões. Por exemplo, técnicas como LIME ou SHAP podem mostrar quais fatores influenciaram uma decisão específica, o que torna o raciocínio do sistema mais acessível.

- Programe e documente as alterações nos dados: Quando você documenta todas as mudanças — tipo quais dados foram adicionados, removidos ou modificados —, dá pra acompanhar como essas atualizações afetam o desempenho do modelo.

- Verifique a precisão regularmente: Não dá pra acreditar em tudo que a IA diz. Compare os resultados com os dados originais e, se der, peça a opinião de especialistas. Auditorias regulares garantem que o sistema continue eficiente e imparcial. Confie, mas verifique.

- Teste e monitore sempre: A IA não é uma ferramenta do tipo “configure e esqueça”. Testes frequentes com diversas entradas ajudam a detectar erros logo no início, e o monitoramento em tempo real garante que o sistema funcione de maneira consistente em diferentes cenários.

Vamos ver como um hospital cria confiança em uma ferramenta de diagnóstico dermatológico com IA — um sistema que usa reconhecimento de imagem para identificar possíveis doenças de pele.

- Ferramentas XAI: O hospital usa o LIME, uma ferramenta que destaca quais partes de uma imagem da pele foram mais influentes no diagnóstico da IA, para que os médicos possam entender e confiar no raciocínio da IA.

- Acompanhando as mudanças nos dados: A linhagem de dados registra todas as atualizações no conjunto de dados de treinamento, como imagens recém-adicionadas ou removidas. Isso permite que o hospital programe como essas mudanças afetam a precisão da IA ao longo do tempo.

- Verificando a precisão: Todo mês, os dermatologistas analisam uma amostra aleatória de diagnósticos da IA, comparando-os com os dados originais dos pacientes e suas próprias opiniões especializadas. O objetivo aqui é garantir que o sistema mantenha altos padrões de precisão e justiça.

- Testes e monitoramento regulares: A equipe de TI faz testes toda semana com várias imagens, conferindo como a IA se sai em diferentes tipos e condições de pele. Eles também ficam de olho em padrões estranhos em tempo real, pra poder resolver os problemas antes que eles piorem.

Essa ferramenta de IA não é só inteligente, mas também fácil de entender e confiável. Os médicos entendem suas decisões, os pacientes se sentem confiantes nos cuidados recebidos e o hospital garante que a tecnologia funcione de forma justa e precisa.

Conclusão

À medida que a IA se torna uma parte cada vez mais importante das nossas vidas, mantê-la segura é mais importante do que nunca. Por quê? Porque o mesmo poder que impulsiona as capacidades da IA também a torna alvo de ataques. Ameaças como ataques adversários, contaminação de dados e roubo de modelos podem atrapalhar bastante o funcionamento da IA.

Então, como defendemos a IA? A gente aprendeu que não existe uma solução única que sirva para todos. Técnicas como treinamento adversário, auditorias regulares e proteções em camadas podem reduzir os riscos e tornar seus sistemas mais robustos.

Depois, tem a IA generativa. Modelos de linguagem grandes trazem oportunidades incríveis, mas também trazem novas vulnerabilidades. Desde a produção de conteúdo enganoso até a manipulação para gerar resultados prejudiciais, essas ferramentas exigem uma supervisão cuidadosa. No artigo Como criar proteções para grandes modelos de linguagem, são exploradas medidas de segurança para garantir que os LLMs se comportem da maneira que deveriam.

Ética e transparência não são negociáveis. Os sistemas de IA precisam ser justos, compreensíveis e confiáveis. Preconceitos e uso indevido podem minar a confiança — e a confiança é tudo no mundo atual, impulsionado pela tecnologia. As pessoas não usam o que não confiam.

Por fim, manter-se à frente é fundamental. As ameaças da IA estão sempre mudando. As empresas precisam atualizar regularmente suas estratégias de segurança, acompanhando os novos riscos para se manterem protegidas.O segredo é ser proativo, estar atento e comprometido com a ética e a transparência. Assim, as empresas podem construir confiança e aproveitar ao máximo os benefícios da IA.

Ana Rojo Echeburúa é especialista em IA e dados, com doutorado em Matemática Aplicada. Ela adora transformar dados em insights acionáveis e tem ampla experiência na liderança de equipes técnicas. Ana gosta de trabalhar em estreita colaboração com os clientes para resolver seus problemas de negócios e criar soluções inovadoras de IA. Conhecida por suas habilidades de resolução de problemas e comunicação clara, ela é apaixonada por IA, especialmente IA generativa. Ana se dedica ao aprendizado contínuo e ao desenvolvimento ético de IA, além de simplificar problemas complexos e explicar a tecnologia de forma acessível.