Kurs

Die KI entwickelt sich so schnell, dass es sich anfühlt, als würde man versuchen, ein Flugzeug während des Fluges zu reparieren, wenn man mit den Herausforderungender Sicherheits en Schritt halten will . Je intelligenter Systeme werden und je tiefer sie in alltägliche Geschäftsprozesse eingebunden sind, desto anfälliger werden sie auch für neue Arten von Bedrohungen.

Ich hab das in meiner Arbeit aus nächster Nähe mitgemacht. Ich habe schon oft Sicherheitslücken in Geschäftsprozessen entdeckt, die es jemandem ermöglicht hätten, auf sensible Informationen zuzugreifen, auf die er keinen Zugriff haben sollte, vor allem wenn KI-Lösungen überstürzt und ohne angemessene Sicherheitsmaßnahmen implementiert wurden.

Darum geht's in diesem Artikel: die Risiken, Herausforderungen und bewährten Methoden für die Sicherheit von KI verstehen. KI entwickelt sich so schnell, und wenn wir den Schwachstellen nicht immer einen Schritt voraus sind, riskieren wir, das Vertrauen und die Vorteile zu verlieren, die sie mit sich bringt.

Wenn du mehr über dieses Thema erfahren möchtest, empfehle ich dir, dir die Kurs „KI-Sicherheit und Risikomanagement” anzuschauen.

Neue Herausforderungen für die KI-Sicherheit

KI braucht Daten, um zu funktionieren. Und je mehr Daten deine KI nutzt, desto größer ist das Ziel. Hacker wissen das. Stell dir vor, ein Krankenhaus nutzt KI, um Gesundheitsrisiken von Patienten vorherzusagen. Klingt super, bis jemand das System hackt. Plötzlich sind private Patientenakten im Dark Web frei zugänglich oder, noch schlimmer, medizinische Daten werden verändert, was zu schädlichen Entscheidungen führen kann. Die Verschlüsselung sensibler Daten und das Erstellen von Backups sind super wichtig, aber viele Firmen sind so auf Innovation fixiert, dass sie diese grundlegenden Dinge vergessen.

Und Hacker klauen übrigens nicht nur Daten. Sie können selbst mit KI-Modellen herumspielen. Zum Beispiel könnte ein selbstfahrendes Auto denken, dass ein Stoppschild ein Tempolimit-Schild ist. Diese Art von Angriff wird als Datenvergiftungsangriff, bei der Hacker falsche Daten ins System schicken, um die Entscheidungen zu beeinflussen. Wir werden uns das im nächsten Abschnitt genauer anschauen.

Prompt-Injection-Angriffe sind auch eine Art von Angriff. Das sind raffinierte Tricks, die eine KI dazu bringen, was zu sagen oder zu tun, was sie eigentlich nicht tun sollte. Wir haben einen super Artikel über Prompt-Injection, deshalb gehen wir in diesem Artikel nicht so sehr ins Detail, aber er ist echt lesenswert.

Ironischerweise nutzen Hacker auch KI, um zu hacken. Hier geht's um Cybersicherheit zu einem Wettlauf gegen die Zeit – Hacker entwickeln sich weiter, und Sicherheitsteams müssen genauso schnell reagieren. Tools wie die Anomalieerkennung können helfen, sind aber nicht immer zuverlässig.

Hast du schon mal das Sprichwort gehört: „Eine Kette ist nur so stark wie ihr schwächstes Glied“? Das trifft voll und ganz auf KI zu. Firmen bauen oft vorgefertigte KI-Tools in ihre Systeme ein. Aber was passiert, wenn eines dieser Tools kaputt geht? Stell dir vor, ein beliebter Chatbot, den hunderte von Unternehmen nutzen, wird gehackt. Das sind Hunderte von Unternehmen – und all ihre Kundendaten –, die gefährdet sind. Das ist ein digitaler Dominoeffekt.

Und dann ist da noch die Lücke beim Fachwissen. Die KI-Nutzung nimmt zu, aber die Cybersicherheit für KI hinkt noch hinterher.

Sicherheitsrisiken durch KI

KI-Systeme haben mit echten Sicherheitsrisiken zu kämpfen, die ihre Leistung und Zuverlässigkeit beeinträchtigen können. Schauen wir uns mal die größten Risiken an.

Angriffe mit böswilliger Absicht

Adversarial Attacks tricksen KI-Systeme aus, indem sie kleine, heimtückische Änderungen an den Eingaben vornehmen, die die KI verarbeitet. Diese Änderungen sind so subtil, dass Menschen sie normalerweise nicht bemerken, aber sie können die KI total verwirren und dazu bringen, die falsche Entscheidung zu treffen.

Zum Beispiel:

- Kleine Details in einem Bild ändern, wie zum Beispiel ein paar Pixel, damit die KI es falsch erkennt.

- Man fügt einer Audiodatei ein bisschen Rauschen hinzu, sodass sie für uns gleich klingt, die KI sie aber falsch versteht.

- Den Wortlaut eines Satzes so anpassen, dass die KI ihn nicht richtig versteht.

Für diese Angriffe muss der Angreifer nicht wissen, wie die KI intern funktioniert, was ein weiterer Grund dafür ist, dass diese Angriffe echt schwer zu erkennen und zu stoppen sind.

Schauen wir uns jetzt ein paar Beispiele aus der Praxis an.

- DeepFool-Algorithmus: DeepFool ist eine Methode, die winzige, fast unsichtbare Änderungen an einer Eingabe, wie z. B. einem Bild, vornimmt, um die KI dazu zu bringen, es falsch zu klassifizieren. Es funktioniert, indem es die Eingabe nach und nach anpasst, bis die KI einen Fehler macht. Diese Änderungen sind so klein, dass man sie gar nicht bemerken würde.

- Gezielte Audio-Angriffe: In diesem Artikelhaben Angreifer Audioaufnahmen erstellt, die fast wie das Original klingen, aber ein Spracherkennungssystem dazu bringen, ganz andere Wörter zu hören. Mit dieser Methode konnte Mozillas DeepSpeech-System mit einer Erfolgsquote von 100 % ausgetrickst werden.

- Manipulation des Tesla-Autopiloten: Keen Labs hat das Autopilot-System von Tesla ausgetrickst, indem sie drei unauffällige Aufkleber strategisch auf der Straße platziert haben, sodass das System die Fahrbahnmarkierungen falsch interpretiert hat und möglicherweise auf die falsche Spur gelenkt hätte. Mehr dazu hier.

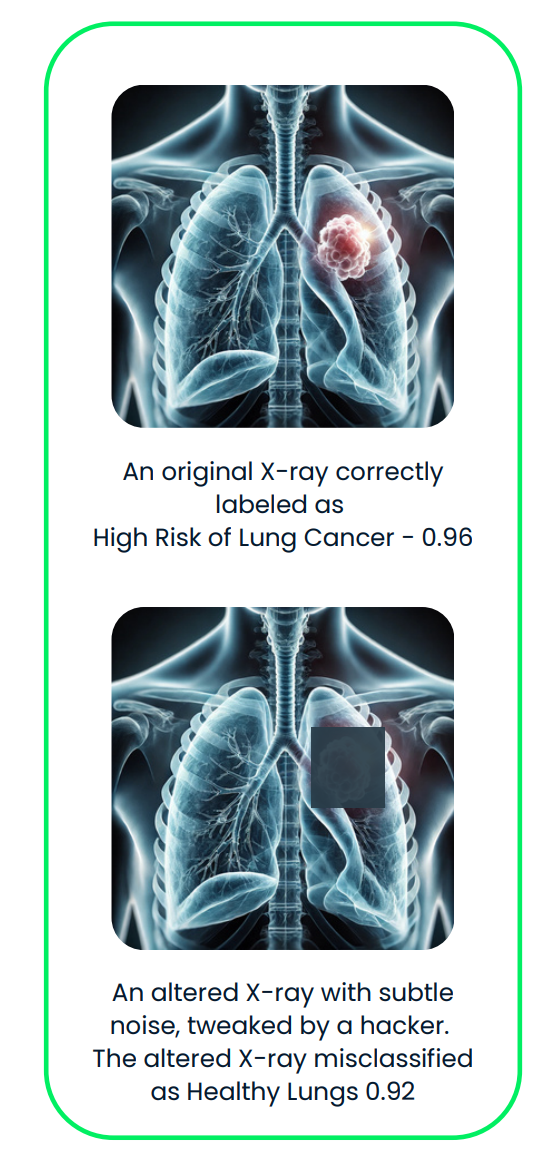

Dieses Diagramm zeigt einen gegnerischen Angriff auf ein KI-System für medizinische Bildgebung. Das Original-Röntgenbild, das richtig als „hohes Lungenkrebsrisiko“ eingestuft wurde, wird mit gegensätzlichem Rauschen leicht verändert, was zu einer falschen Einstufung als „gesunde Lunge“ führt.

Eine super Lektüre ist Adversarial Machine Learning, ein Bereich, der sich mit Angriffen beschäftigt, die Schwachstellen in Machine-Learning-Modellen ausnutzen, und Abwehrmaßnahmen entwickelt, um vor diesen Bedrohungen zu schützen.

Vergiftungsangriffe

Vergiftungsangriffe zielen auf die Trainingsphase von KI-Systemen ab, in der das Modell lernt, wie man Entscheidungen trifft. Angreifer schmuggeln kaputte oder irreführende Daten in den Trainingssatz, um die KI dazu zu bringen, sich falsch zu verhalten oder voreingenommene Ergebnisse zu bevorzugen. Diese Angriffe funktionieren, weil sie die Grundlage des Lernprozesses der KI manipulieren, oft ohne offensichtliche Anzeichen dafür zu hinterlassen, dass etwas nicht stimmt.

Das kann Folgendes beinhalten:

- Ändere die Beschriftungen von bestimmten Trainingsbeispielen, wie zum Beispiel ein Bild von einem Hund als Katze zu beschriften.

- Falsche Datenpunkte hinzufügen, um die Entscheidungen der KI auf bestimmte Weise zu beeinflussen.

Diese kleinen Änderungen können dazu führen, dass die KI unter bestimmten Bedingungen versagt oder so reagiert, dass es dem Angreifer hilft. Da der Angriff während des Trainings passiert, ist er schwer zu erkennen, wenn das Modell mal eingesetzt wird.

Schauen wir uns ein paar Beispiele aus der Praxis an:

- Backdoor-Angriffe: Eine Studie mit dem Titel„ “ („Umgehung von Backdoor-ErkennungsalgorithmenUmgehung von Backdoor-Erkennungsalgorithmen im Deep Learning” ( ) hat gezeigt, wie Angreifer bösartige „Hintertüren” in KI-Modellen verstecken können. Diese Hintertüren werden nur unter bestimmten Bedingungen aktiviert, zum Beispiel wenn ein bestimmtes Muster in einem Bild angezeigt wird. Die Studie hat gezeigt, dass Angreifer mit ausgeklügelten Techniken vergiftete Daten so aussehen lassen können wie saubere Daten und so der Erkennung entgehen.

- Verfälschung von Datensätzen im Web: In dem Artikel„ “ („Vergiftung von Web-Scale-Trainingsdatensätzen ist praktikPoisoning Web-Scale Training Datasets is Practical” haben Forscher beschrieben, wie große Datensätze, die aus dem Internet gesammelt wurden, manipuliert werden können:

- Datenvergiftung durch geteilte Ansicht: Daten nach der Erfassung, aber vor der Verwendung für Trainingszwecke verfälschen.

- Frontrunning-Datenvergiftung: Datenbearbeitung, bevor sie zum Datensatz hinzugefügt werden.

- Microsofts Chatbot Tay: 2016 hat Microsoft einen Chatbot namens Tay auf Twitter gestartet. Die Leute haben Tay schnell manipuliert, indem sie es mit beleidigenden Inhalten zugeschüttet haben, sodass es rassistische und unpassende Tweets gepostet hat. Microsoft musste Tay kurz nach dem Start wieder abschalten. Mehr dazu hier.

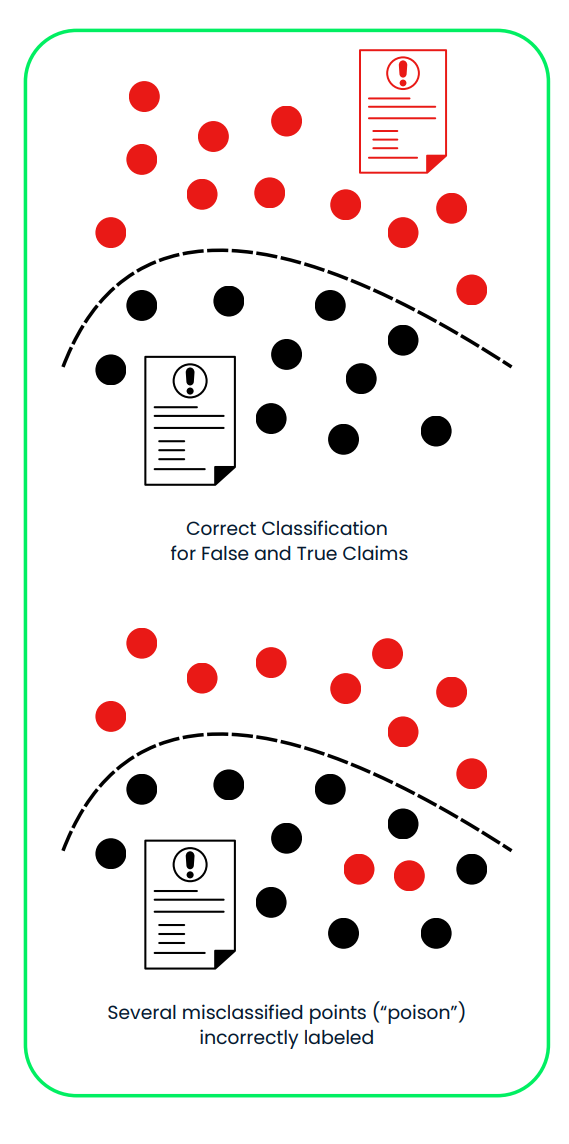

Dieses Diagramm zeigt einen Poisoning-Angriff auf ein KI-System, das falsche und echte Versicherungsansprüche sortiert. Im ersten Panel trennt das System falsche (rote) und echte (schwarze) Behauptungen mithilfe eines sauberen Trainingsdatensatzes richtig voneinander. Im zweiten Panel verschiebt böswillig falsch beschriftete Daten („Poison“) die Entscheidungsgrenze, was dazu führt, dass falsche Behauptungen fälschlicherweise als wahr eingestuft werden, was die Zuverlässigkeit und Sicherheit des Systems gefährdet.

Modell-Extraktionsangriffe

Bei einem Modell-Extraktionsangriff findet ein Angreifer durch Reverse Engineering heraus, wie ein KI-Modell funktioniert. Sie nutzen die gesammelten Eingaben und Ausgaben, um das Design und Verhalten des Systems nachzumachen.

Sobald sie eine Nachbildung des Modells gebaut haben, können sie:

- Benutz es, um Vorhersagen zu treffen, die möglicherweise sensible oder private Daten beinhalten.

- Klaue vertrauliche Infos vom Originalmodell.

- Das Modell an ihre eigenen Bedürfnisse anpassen und neu trainieren, oft für schädliche Zwecke.

Wenn das geklaute Modell zum Beispiel mit privaten Kundendaten trainiert wurde, könnte der Angreifer persönliche Details über diese Kunden erraten oder eine angepasste Version des Modells für sich selbst basteln.

Schauen wir uns ein paar Beispiele aus der Praxis an:

- Ein Tool namens DeepSniffer zeigt, wie so ein Angriff funktionieren kann. DeepSniffer muss vorher nichts über das ursprüngliche Modell wissen. Stattdessen sammelt es Hinweise aus der Art und Weise, wie das Modell Daten verarbeitet, beispielsweise durch die Verfolgung von Speicheroperationen während seiner Laufzeit. Es setzt diese Hinweise zusammen, um die Struktur des Modells zu ermitteln, selbst wenn das System versucht, seine Prozesse zu optimieren oder zu verbergen.

- Mindgard hat gezeigt, wie man wichtige Teile von einem Black-Box-Sprachmodell, wie zum Beispiel OpenAI's chatGPT 3.5 Turbo, mit einem kostengünstigen Verfahren herausziehen kann. Mit nur 50 Dollar für API-Kosten hat das Team ein kleineres Modell entwickelt – ungefähr 100 Mal kleiner als das Original –, das chatGPT bei einer bestimmten Aufgabe übertroffen hat. Dieses extrahierte Modell wurde dann benutzt, um einen anderen Angriff zu verbessern, der später gegen chatGPT selbst eingesetzt wurde. Der verbesserte Angriff hatte eine höhere Erfolgsquote und stieg auf 11 %.

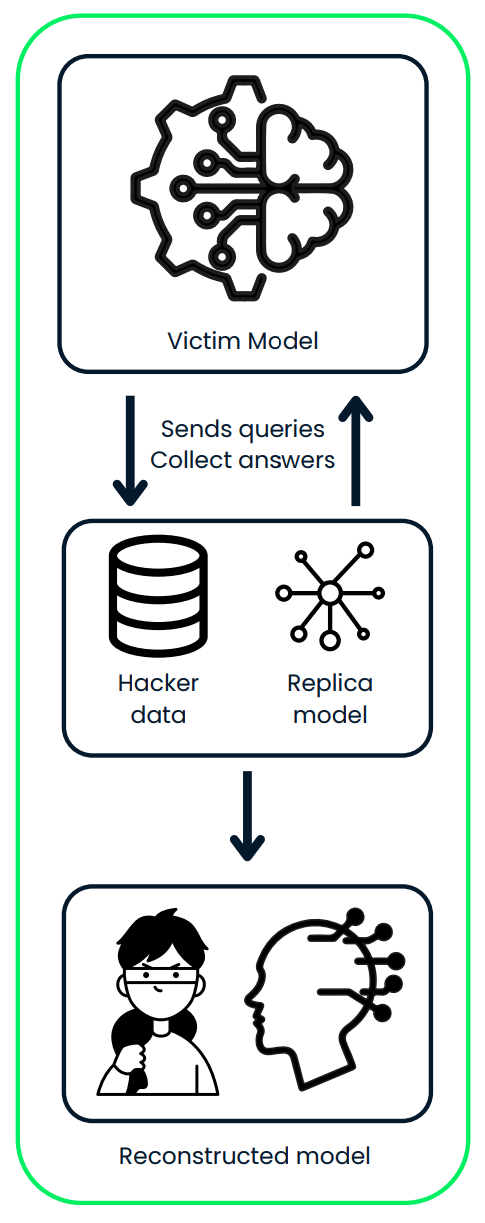

Dieses Diagramm zeigt einen Modell-Extraktionsangriff, bei dem ein Angreifer mit einem KI-Modell interagiert, indem er Anfragen sendet und dessen Vorhersagen sammelt. Der Angreifer nutzt die gesammelten Daten, um ein Replikatmodell zu trainieren und so eine geklaute Version des Originalsystems zu bauen.

KI-Sicherheitsmaßnahmen

Wir haben schon in den vorherigen Abschnitten gesagt, dass es wichtig ist, starke Sicherheitsmaßnahmen zu haben, um sich vor Angriffen zu schützen, wenn KI immer mehr zum Alltag wird. Lass uns über ein paar coole Möglichkeiten reden, wie man KI sicherer machen kann.

Adversariales Training

Bei dieser Methode lernen Modelle, knifflige, manipulierte Eingaben (sogenannte Adversarial Examples) zu erkennen und damit umzugehen. Wenn du dein Modell mit diesen Beispielen trainierst, wird es besser darin, bestimmten Arten von Angriffen zu widerstehen.

- So geht's: Mach ein paar Beispiele für manipulierte Daten und pack sie ins Training der KI rein.

- Warum das hilft: Das macht KI-Systeme widerstandsfähiger gegen Angriffe, die versuchen, sie auszutricksen.

- Nachteil: Das könnte die Genauigkeit der KI bei normalen (sauberen) Daten ein bisschen verringern.

- Beispiele aus der Praxis:

- Die Cloud Vision API von Google nutzt Adversarial Training, um die Widerstandsfähigkeit ihrer Bilderkennungsmodelle gegen manipulierte Eingaben zu verbessern.

- Die Modelle von OpenAI nutzen gegnerische Beispiele beim Training, um die Robustheit gegen Textangriffe zu verbessern.

Defensive Destillation

LLM-Destillation bedeutet, dass ein zweites Modell trainiert wird, um das Verhalten des ursprünglichen Modells nachzuahmen, damit es für Angreifer schwieriger wird, es zu manipulieren.

- So geht's: Trainiere das erste Modell und nutze dann seine Ergebnisse, um ein anderes Modell zu trainieren, sodass dessen Entscheidungsprozess optimiert wird.

- Warum das hilft: Es macht es Angreifern schwerer, Schwachstellen auszunutzen.

- Nachteil: Dieser Ansatz kann echt viel Rechenleistung brauchen, vor allem bei großen Modellen.

- Beispiele aus der Praxis:

- Forscher von der University of California in Berkeley haben defensive Destillation genutzt, um die Robustheit von tiefen neuronalen Netzen zu verbessern, die in autonomen Fahrzeugen verwendet werden.

- Die Watson-KI-Plattform von IBM nutzt defensive Destillationstechniken, um ihre Modelle zur Verarbeitung natürlicher Sprache vor Angriffen zu schützen.

Eingabevalidierung und -bereinigung

Es ist super wichtig, dass die Daten, die in ein KI-System reinkommen, sauber und sicher sind, um es vor böswilligen Eingaben zu schützen.

- So geht's: Überprüfe, ob die Eingaben das richtige Format haben, in den erwarteten Bereichen liegen und keine schädlichen Elemente enthalten.

- Warum das hilft: Verhindert Angriffe wie Datenvergiftung und sorgt dafür, dass das KI-System reibungslos läuft.

- Bewährte Vorgehensweise: Überprüfe die Daten in mehreren Schritten – beim Nutzer, auf dem Server und im KI-System selbst.

- Beispiele aus der Praxis:

- Die Azure-KI-Dienste von Microsoft machen strenge Eingabevalidierungen, um SQL-Injection-Angriffe auf ihre Modelle für maschinelles Lernen zu verhindern.

- Das Gesichtserkennungssystem „Rekognition“ von Amazon filtert potenziell bösartige Bilddaten raus, indem es die Eingaben bereinigt.

Ensemble-Methoden

Wenn man mehrere verschiedene KI-Modelle zusammen benutzt (ein Ensemble), kann das die Systeme sicherer machen. Selbst wenn ein Modell angegriffen wird, können die anderen einspringen.

- So geht's: Kombiniere die Vorhersagen mehrerer Modelle, um Entscheidungen zu treffen.

- Warum das hilft: Es ist schwieriger für Angreifer, alle Modelle gleichzeitig zu kompromittieren.

- Nachteil: Man braucht mehr Rechenleistung, um mehrere Modelle zu verwalten.

- Beispiele aus der Praxis:

- Das Empfehlungssystem von Netflix nutzt mehrere KI-Modelle, um genauer zu sein und Manipulationsversuchen besser standzuhalten.

- Ensemble-Methoden sind nicht nur für die Sicherheit in der KI wichtig, sondern werden generell genutzt, um robustere und genauere Vorhersagemodelle zu erstellen.

Erklärbare KI (XAI)

Wenn man KI-Systeme verständlich macht, können Leute besser nachvollziehen, wie sie funktionieren, und Schwachstellen oder ungewöhnliches Verhalten erkennen. Mehr zu diesem Thema findest du im Kurs „Explainable AI in Python”.

- So geht's: Benutz Tools wie LIME, SHAP oder Aufmerksamkeitsmechanismen, um KI-Entscheidungen zu erklären.

- Warum das hilft: Steigert das Vertrauen in KI-Systeme und macht es einfacher, Probleme wie Verzerrungen zu erkennen und zu beheben.

- Herausforderung: Einfachere, verständliche Modelle sind vielleicht nicht so leistungsstark wie komplizierte.

- Beispiel aus der Praxis:

- Das Programm „Explainable AI (XAI)” von DARPA will transparentere KI-Systeme für militärische Anwendungen entwickeln.

- Das Toolkit „AI Explainability 360” von IBM bietet Open-Source-Ressourcen für die Umsetzung erklärbarer KI-Techniken in verschiedenen Branchen.

Regelmäßige Sicherheitsüberprüfungen

Wenn man KI-Systeme regelmäßig auf Schwachstellen checkt, kann man Probleme frühzeitig erkennen und dafür sorgen, dass sie langfristig sicher bleiben.

- Was das beinhaltet: Mach Schwachstellenanalysen, Penetrationstests und Code-Reviews.

- Wie oft: Mach regelmäßig Audits und auch, wenn du wichtige Änderungen am System vornimmst.

- Warum das hilft: Findet mögliche Sicherheitslücken und sorgt dafür, dass die Vorschriften eingehalten werden.

- Beispiele aus der Praxis:

- Facebook macht regelmäßig Sicherheitschecks bei seinen KI-basierten Systemen zur Moderation von Inhalten, um mögliche Schwachstellen zu finden und zu beheben.

- Das KI-Gesetz der EU schlägt vor, dass für risikoreiche KI-Systeme, die in wichtigen Bereichen eingesetzt werden, obligatorische Sicherheitsprüfungen gemacht werden müssen.

Mit diesen Strategien kann man KI-Systeme sicherer machen und besser vor Angriffen schützen. Aber hier ist die Sache: KI-Sicherheit ist keine Sache, die man einmal einrichtet und dann vergessen kann. Es ist ein fortlaufender Prozess.

Wenn neue Bedrohungen auftauchen – und glaub mir, das passiert immer wieder –, müssen Unternehmen auf der Hut sein. Das heißt, man muss ständig nach Schwachstellen Ausschau halten, Systeme aktualisieren und die Abwehrmaßnahmen verbessern.

|

Methode |

Wie es funktioniert |

Warum es hilft |

Nachteile |

|

Adversariales Training |

Mach ein paar Beispiele für manipulierte Daten und pack sie ins Training der KI rein. |

Macht das System widerstandsfähiger gegen Angriffe, die versuchen, es auszutricksen. |

Kann die Genauigkeit der KI bei normalen (sauberen) Daten leicht verringern. |

|

Defensive Destillation |

Trainiere ein zweites Modell, das das Verhalten des ersten Modells nachmacht und seinen Entscheidungsprozess glättet. |

Macht es Angreifern schwerer, Schwachstellen im Modell auszunutzen. |

Braucht echt viel Rechenleistung, vor allem bei großen Modellen. |

|

Eingabevalidierung und -bereinigung |

Stell sicher, dass die Eingaben das richtige Format haben, in den erwarteten Bereichen liegen und keine schädlichen Elemente enthalten. |

Verhindert Datenverfälschungen und sorgt dafür, dass das KI-System reibungslos läuft. |

Muss in mehreren Schritten sorgfältig umgesetzt werden. |

|

Ensemble-Methoden |

Kombiniere Vorhersagen aus mehreren Modellen, um Entscheidungen zu treffen. |

Es ist für Angreifer schwieriger, alle Modelle gleichzeitig zu kompromittieren. |

Man braucht mehr Computer-Power, um mehrere Modelle zu verwalten und zu pflegen. |

|

Erklärbare KI (XAI) |

Benutz Tools wie LIME, SHAP oder Aufmerksamkeitsmechanismen, um KI-Entscheidungen zu erklären. |

Steigert das Vertrauen und macht es einfacher, Probleme wie Voreingenommenheit oder ungewöhnliches Verhalten zu erkennen und zu beheben. |

Einfachere, erklärbare Modelle funktionieren vielleicht nicht so gut wie die komplizierten. |

|

Regelmäßige Sicherheitsüberprüfungen |

Mach Schwachstellenanalysen, Penetrationstests und Codeüberprüfungen, um Schwachstellen zu finden. |

Findet mögliche Sicherheitslücken und sorgt dafür, dass die Vorschriften eingehalten werden. |

Kann je nach Komplexität des Systems ziemlich ressourcenintensiv sein. |

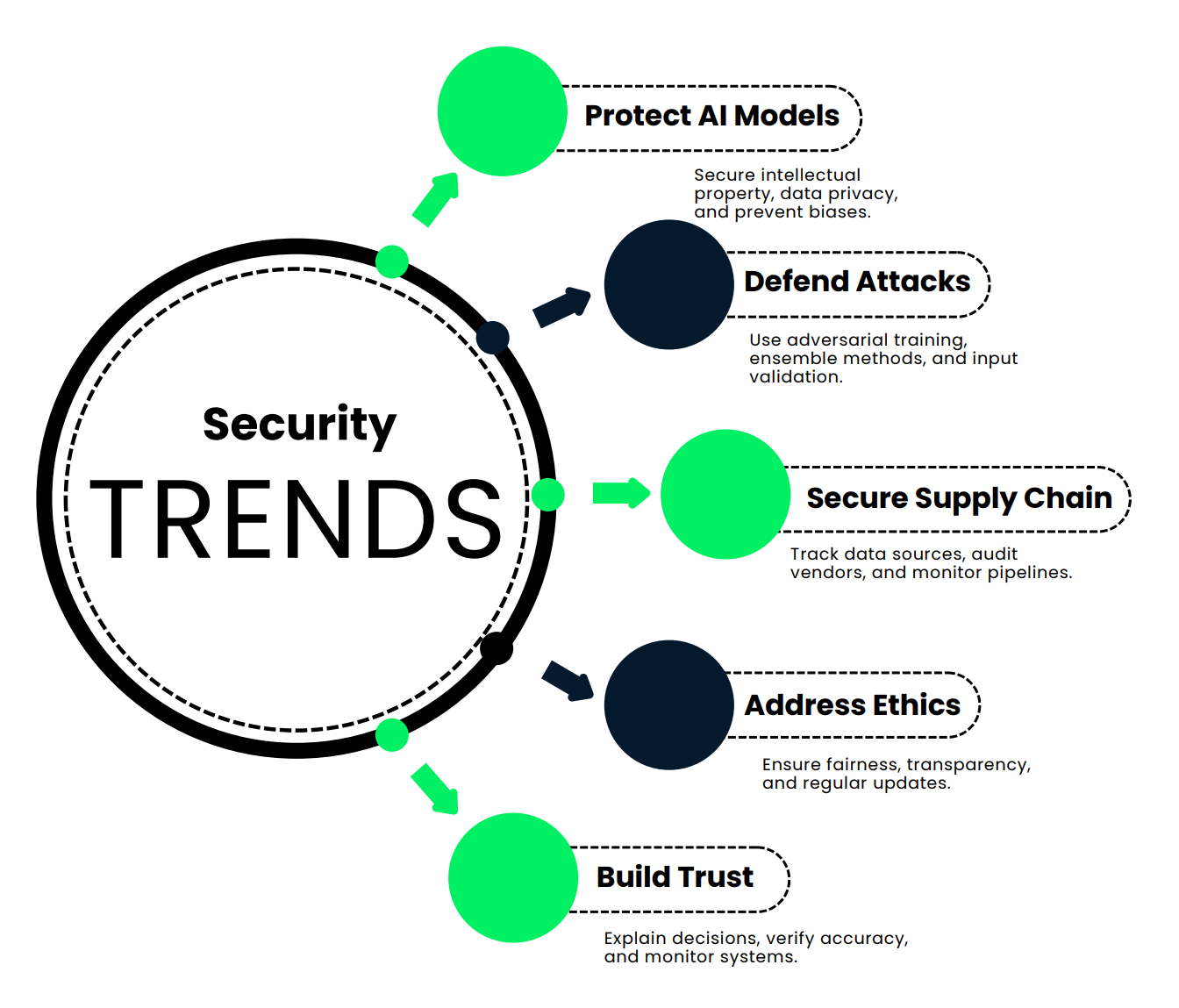

Neue Trends in der KI-Sicherheit

In diesem Abschnitt schauen wir uns neue Trends an, die dafür sorgen, dass KI-Systeme sicher, genau und vertrauenswürdig bleiben.

Schutz von KI-Modellen und Datenintegrität

Zuerst mal, lass uns darüber reden, warum es so wichtig ist, KI-Modelle und Daten zu schützen.

- Schutz von geistigem Eigentum: Denk mal darüber nach, wie viel Zeit, Geld und Intelligenz man braucht, um ein KI-Modell zu entwickeln. Das sind nicht nur Algorithmen, sondern riesige Investitionen. Wenn du sie sicher hältst, kannst du verhindern, dass Konkurrenten deine harte Arbeit klauen.

- Wettbewerbsvorteile behalten: Wenn jemand ohne Erlaubnis auf dein KI-Modell zugreifen kann, könnte er es kopieren und die gleichen Ergebnisse erzielen – ohne einen Cent für die Entwicklung auszugeben.

- Datenschutz und Compliance: KI verarbeitet oft sensible Daten – Finanzinfos, Krankenakten, was auch immer. Wenn diese Daten offengelegt werden, drohen dir hohe Geldstrafen und ein erheblicher Vertrauensverlust in der Öffentlichkeit. Mehr dazu erfährst du in dieser Einführung in den Datenschutz.

- Verhindern von Datenvergiftung: Hacker könnten deine Trainingsdaten manipulieren und deiner KI beibringen, falsche Entscheidungen zu treffen – zum Beispiel Betrug durchgehen zu lassen oder harmlose Aktionen als Bedrohungen zu markieren.

- Angriffe auf Modellinversionen abmildern: Stell dir vor, Angreifer könnten private Kundendaten herausfinden, indem sie einfach die Ergebnisse deiner KI analysieren. Das wäre nicht gut!

- Vermeidung von voreingenommenen oder unethischen Ergebnissen: Ein fehlerhaftes Modell kann zu unfairen oder sogar schädlichen Entscheidungen führen, die deinem Ruf schaden könnten.

- Schutz kritischer Infrastruktur: Da KI im Gesundheitswesen, im Finanzwesen und sogar in der nationalen Sicherheit eingesetzt wird, ist ihr Schutz nicht nur ein geschäftliches Anliegen, sondern auch eine Frage der öffentlichen Sicherheit.

Also, wie kannst du deine KI eigentlich sicher halten? Hier sind ein paar wichtige Strategien:

- Verwende Datenverschlüsselung und Anonymisierung , um sensible Infos zu schützen.

- Strenge Richtlinien zur Datenaufbewahrung strenge Richtlinien zur Datenaufbewahrung , um zu regeln, wie lange Infos gespeichert werden.

- Mach regelmäßige Sicherheitsüberprüfungen und -überwachungen , um Schwachstellen frühzeitig zu erkennen.

- Entwickle Systeme mit eingebauten Datenschutz und bauen Sicherheit in jeden Schritt ein.

- Nutze moderne Techniken wie föderiertes Lernen , um das Modell und seine Daten zu schützen, ohne sensible Informationen zu verschieben.

Lass uns das mal mit einem Beispiel aus dem echten Leben anschauen. Stell dir eine große internationale Bank vor, die ein KI-Modell entwickelt hat, um betrügerische Transaktionen zu erkennen. Dieses System checkt jeden Tag Millionen von Transaktionen, findet verdächtige Muster und meldet Betrugsfälle.

Die Bank hat 50 Millionen Dollar und drei Jahre gebraucht, um dieses System aufzubauen. Wenn es geklaut wird, könnten Konkurrenten es nutzen, ohne einen Cent zu investieren, was die Bank ihren Vorsprung kosten würde.

Dieses Modell verarbeitet sensible Finanzdaten von Millionen von Kunden. Ein Verstoß könnte diese Infos offenlegen und zu hohen Strafen nach Gesetzen wie der DSGVO führen.

Wenn Hacker während des Trainings gefälschte Daten einspeisen, könnten sie der KI beibringen, bestimmte Betrugsmuster zu übersehen, wodurch die Bank angreifbar würde.

Erfahrene Angreifer könnten sogar private Kundendaten aus den Ergebnissen des Modells herausziehen.

Wie schützt die Bank das?

- Sie nutzen End-to-End-Verschlüsselung , um die Daten zu schützen.

- Um auf das Modell zugreifen zu können, brauchst du eine Multi-Faktor-Authentifizierung und ist durch rollenbasierte Kontrollen eingeschränkt.

- Sie machen regelmäßige Audits und Penetrationstests , um Schwachstellen zu finden.

- Die Kundendaten, die fürs Training benutzt werden, sind komplett anonymisiert.

- Die Bank checkt ständig, wie das Modell läuft, um irgendwas Ungewöhnliches zu erkennen.

Das Ergebnis ist ein sichereres, zuverlässigeres KI-System, das Kundendaten schützt und sein Versprechen einhält, Betrug effektiv zu erkennen. Das ist ein Gewinn für die Bank und ihre Kunden.

Schutz vor Umgehungs- und Vergiftungsangriffen

Stell dir vor, du leitest eine Hochsicherheitsanlage, die auf Gesichtserkennung setzt, um alles sicher zu halten. Wir haben aber gelernt, dass KI-Systeme anfällig für Angriffe sind, wie zum Beispiel gegnerische Eingaben oder manipulierte Trainingsdaten. Hacker können das System manipulieren, um sich Zugang zu verschaffen.

Schauen wir uns mal die vier wichtigsten Abwehrmechanismen an, die Angreifer stoppen können:

- Adversariales Training: Das ist so, als würdest du deinem Modell ein paar Selbstverteidigungstechniken beibringen. Du fügst Beispiele für manipulierte Eingaben hinzu – Bilder mit subtilen Änderungen, die die KI austricksen sollen – und trainierst sie, diese zu erkennen. Stell dir ein Gesichtserkennungssystem vor, das nicht nur dein Gesicht erkennt, sondern auch die pixelgenauen Veränderungen, die Angreifer heimlich einbauen wollen. Deine KI wird durch diese Angriffe schlauer, weil sie aus diesen Beispielen lernt, sodass sie im echten Leben nicht reingelegt wird.

- Ensemble-Methoden: Wir haben schon mal darüber geredet. Statt dich auf ein System zu verlassen, nutzt du eine ganze Reihe von Modellen. Jedes Modell verarbeitet die Eingabe für sich, und die Ergebnisse werden dann über einen Abstimmungsmechanismus zusammengefasst. Angreifer können nicht nur ein Modell austricksen – sie müssen die ganze Truppe überlisten. Viel Glück dabei.

- Regelmäßige Datenüberprüfungen: Niemand putzt gerne, aber das ist echt wichtig für deine KI. Wöchentliche Prüfungen sorgen dafür, dass deine Trainingsdaten keine Duplikate, falsch beschrifteten Einträge oder versteckten böswilligen Eingaben haben. Und wenn du den Datensatz mit geprüften Bildern auf dem neuesten Stand hältst, bleibt dein System auf dem Laufenden.

- EingabevalidierungsBevor ein Bild überhaupt in die Nähe deiner KI kommt, durchläuft es eine Sicherheitsüberprüfung. Das passiert:

- Format und Größe sind überprüft.

- Metadaten werden auf Anzeichen von Manipulation überprüft.

- Bekannte feindliche Muster werden markiert.

- Die Anomalieerkennung findet alles, was irgendwie komisch ist.

Das System ist nicht nur clever, sondern auch vorsichtig. Jede Eingabe muss erst mal echt sein, bevor es weitergeht.

Sicherheit in KI-Lieferketten

Bei der Sicherung von KI geht's darum, die Datenintegrität zu verwalten, proprietäre Modelle zu schützen und sicherzustellen, dass alles mit deiner bestehenden Cybersicherheits-Konfiguration gut zusammenarbeitet. Dazu kommen noch die Herausforderungen durch neue Bedrohungen, die Einhaltung von Vorschriften, ethische Fragen und Schwachstellen in der Lieferkette. Hier sind ein paar Strategien, um den KI-Lebenszyklus sicher zu machen:

- Verfolge deine Quellen: Jeder Datensatz und jedes Modell in deinem KI-System sollte eine klare Herkunftsgeschichte haben. Schreib auf, woher das Ding kommt, egal ob von einem vertrauenswürdigen Krankenhaus, einer Forschungseinrichtung oder einem spezialisierten Anbieteroder. Warum? Weil du erst mal wissen musst, woher die Info kommt, um ihr vertrauen zu können.

- Überprüfe deine Lieferanten: Drittanbieter sind super wichtig, aber sie können auch Schwachstellen sein. Mach regelmäßig Audits, um sicherzustellen, dass sie deinen Sicherheitsstandards entsprechen, egal ob es um HIPAA-Konformität, Protokolle zur Datenanonymisierung oder ISO-Zertifizierungen geht.

- Nutze Tools zur Datenverfolgung: Deine Daten sind nicht statisch. Mit der Zeit entwickelt es sich weiter, und manchmal passieren dabei Fehler oder es gibt böswillige Änderungen. Tools wie die automatische Datenüberwachung können Änderungen verfolgen und unerwartete Verschiebungen melden, sodass deine Datensätze sauber und genau bleiben.

- Datenpipelines überwachen: Die Daten fließen von der Quelle zum Modell durch komplizierte Pipelines, und jede kleine Panne unterwegs kann Probleme verursachen. Mit Echtzeit-Dashboards kannst du Unregelmäßigkeiten wie plötzliche Einbrüche beim Datenvolumen oder unerwartete Funktionsänderungen erkennen.

Hier ist ein Beispiel aus der Praxis. Nehmen wir mal ein Gesundheitsunternehmen, das ein KI-gestütztes Diagnosetool entwickelt. Ihre Lieferkette umfasst:

- Patientendaten von Partnerkrankenhäusern.

- Medizinische Bilddaten von einer superforschungsinstitution.

- Vortrainierte Modelle von einem spezialisierten KI-Anbieter.

Wie sichern sie diese Pipeline?

- Quellenverfolgung: Jeder Datensatz und jedes Modell wird genau dokumentiert, damit man alles nachverfolgen kann.

- Lieferantenaudits: Sie machen vierteljährliche Checks, ob die HIPAA-Vorschriften eingehalten werden, und sorgen dafür, dass die Daten anonymisiert werden. Anbieter müssen jedes Jahr Sicherheitsbewertungen machen, um ihre Zertifizierungen zu behalten.

- Tools zur Datenherkunft: Sie nutzen Tools wie Anomalo, um unerwartete Veränderungen in der Patientendemografie oder in Bildgebungsdaten zu erkennen.

- Pipeline-Überwachungs: Die Echtzeit-Dashboards in Looker behalten den Datenfluss im Auge und zeigen sofort an, wenn was nicht stimmt.

So haben sie eine sichere KI-Lieferkette, die dafür sorgt, dass ihr Diagnosetool genau, zuverlässig und mit den Branchenstandards kompatibel ist.

Ethische Risiken angehen

KI ist echt stark, aber diese Stärke kann in den falschen Händen gefährlich sein. Wenn ein KI-System gehackt wird oder schlecht gemacht ist, kann das zu voreingenommenen Entscheidungen, unethischen Ergebnissen oder sogar Missbrauch führen. Das ist echt wichtig, vor allem wenn KI Entscheidungen trifft, die echtes Leben beeinflussen – wie zum Beispiel bei Einstellungen, Krediten oder im Gesundheitswesen.

Also, wie können wir KI-Systeme ethischer und widerstandsfähiger machen? Lass uns das in vier wichtige Schritte aufteilen:

- Klare Regeln und Rahmenbedingungen entwickeln: Fang damit an, ein solides Fundament zu schaffen. Das heißt, du musst Richtlinien erstellen, die festlegen, was Fairness und Ethik in deinem System bedeuten.

- KI-Teams in Ethik schulen: Man kann nicht erwarten, dass KI ethisch handelt, wenn die Leute, die sie entwickeln, nicht in der Lage sind, kritisch über diese Themen nachzudenken. Ethik-Schulungen helfen Teams dabei, unbewusste Vorurteile zu erkennen und anzugehen, Fairness zu verstehen und sich mit den gesellschaftlichen Auswirkungen ihrer Arbeit auseinanderzusetzen.

- Mach KI-Entscheidungen transparent: Transparenz heißt, Systeme zu entwickeln, die ihre Entscheidungen erklären können – welche Faktoren berücksichtigt wurden, wie die Kandidaten verglichen wurden und wo mögliche Probleme liegen könnten. Transparenz schafft Vertrauen und Verantwortungsbewusstsein.

- Aktualisier regelmäßig die KI-Systeme: KI ist nichts, was man einfach einrichtet und dann vergisst. Regelmäßige Audits helfen dabei, Verzerrungen zu erkennen und zu reduzieren, Fairness zu gewährleisten und sicherzustellen, dass das System den neuesten Branchenstandards und gesetzlichen Anforderungen entspricht. Fairness ist nichts Statisches, sondern ein ständiger Prozess.

Hier ist ein Beispiel aus der Praxis. Reden wir mal über ein großes Tech-Unternehmen, das ein KI-gestütztes Einstellungssystem nutzt. Wie halten sie es ethisch?

- Klare Regeln aufstellen: Sie machen eine KI-Ethikrichtlinie, die Grundsätze für eine faire Einstellung festlegt und alles von der Datenerfassung bis zur Entscheidungsfindung abdeckt. Ein KI-Ethikrat checkt diese Richtlinien, um sicherzustellen, dass alles fair läuft.

- Die Teams trainieren: Ethikschulungen sind jetzt Pflicht für alle Mitarbeiter, die mit dem System arbeiten. Sie machen Kurse über unbewusste Vorurteile und Fairness beim maschinellen Lernen und sind bei Workshops dabei, die sich mit echten Problemen beschäftigen.

- Transparenz: Das Einstellungssystem hat Tools, die die Entscheidungen erklären können. Für jede Empfehlung gibt's eine Aufschlüsselung der Faktoren, die die Entscheidung beeinflussen – wie wichtige Qualifikationen oder wie ein Kandidat im Vergleich zu anderen abschneidet. Das macht es für Personalchefs einfacher, Entscheidungen zu überprüfen.

- Regelmäßige Updates: Vierteljährliche Audits checken Einstellungsentscheidungen auf Voreingenommenheit und nutzen Techniken wie Adversarial Debiasing, um die Fairness immer weiter zu verbessern. Außerdem halten sie das System mit den neuesten Gesetzen zur Gleichstellung am Arbeitsplatz und den besten Praktiken der Branche auf dem neuesten Stand.

Das ist ein Einstellungssystem, das ethisch, fair und transparent ist – auch wenn es zu Kompromissen kommen könnte.

Herausforderungen in Sachen Erklärbarkeit und Vertrauen

KI-Systeme werden oft als „Black Boxes“ gesehen, was bedeutet, dass ihr Entscheidungsprozess nicht leicht zu verstehen ist. Das kann es schwierig machen, Probleme zu erkennen oder Vertrauen aufzubauen. Wenn du ein Arzt bist, der sich auf ein KI-Tool verlässt, oder ein Patient, der von dessen Entscheidung betroffen ist, willst du Antworten und keine Fragezeichen. Die Lösung ist Erklärbarkeit. Hier sind vier Strategien, um KI-Systeme transparenter und vertrauenswürdiger zu machen:

- Benutze Tools für erklärbare KI (XAI): Diese Tools helfen dabei, zu verstehen, wie KI zu ihren Schlussfolgerungen kommt. Techniken wie LIME oder SHAP können zum Beispiel zeigen, welche Faktoren eine bestimmte Entscheidung beeinflusst haben, was die Argumentation des Systems verständlicher macht.

- Lernpfad und dokumentiere Datenänderungen: Wenn du jede Änderung dokumentierst – also welche Daten hinzugefügt, entfernt oder geändert wurden – kannst du nachverfolgen, wie sich diese Aktualisierungen auf die Leistung des Modells auswirken.

- Überprüfe regelmäßig die Genauigkeit: Du kannst KI nicht einfach so nehmen, wie sie ist. Vergleich die Ergebnisse mit den Originaldaten und hol, wenn möglich, die Meinung von Experten dazu ein. Regelmäßige Audits sorgen dafür, dass das System immer auf dem neuesten Stand und unvoreingenommen bleibt. Vertraue, aber überprüfe.

- Test und Überwachung rund um die Uhr: KI ist kein Tool, das man einfach einrichtet und dann vergisst. Regelmäßige Tests mit verschiedenen Eingaben helfen dabei, Fehler frühzeitig zu erkennen, und die Echtzeitüberwachung stellt sicher, dass das System in verschiedenen Szenarien konsistent funktioniert.

Schauen wir mal, wie ein Krankenhaus Vertrauen in ein KI-basiertes Dermatologie-Diagnosetool aufbaut – ein System, das Bilderkennung nutzt, um mögliche Hauterkrankungen zu erkennen.

- XAI-Tools: Das Krankenhaus nutzt LIME, ein Tool, das zeigt, welche Teile eines Hautbildes für die Diagnose der KI am wichtigsten waren, damit die Ärzte die Argumentation der KI verstehen und ihr vertrauen können.

- Verfolgen von Datenänderungen: Eine Datenherkunft Tool protokolliert alle Änderungen am Trainingsdatensatz, wie zum Beispiel neu hinzugefügte oder entfernte Bilder. So kann das Krankenhaus verfolgen, wie sich diese Änderungen im Laufe der Zeit auf die Genauigkeit der KI auswirken.

- Überprüfen der Genauigkeit: Jeden Monat schauen sich Dermatologen eine zufällige Auswahl von KI-Diagnosen an und vergleichen sie mit den Originaldaten der Patienten und ihren eigenen Expertenmeinungen. Das Ziel ist, dass das System immer super genau und fair bleibt.

- Regelmäßige Tests und Überwachung: Das IT-Team macht jede Woche Tests mit verschiedenen Bildern und schaut dabei, wie gut die KI bei unterschiedlichen Hauttypen und -zuständen funktioniert. Sie checken auch in Echtzeit, ob irgendwas komisch läuft, damit sie Probleme beheben können, bevor sie größer werden.

Dieses KI-Tool ist nicht nur clever, sondern auch nachvollziehbar und zuverlässig. Die Ärzte verstehen die Entscheidungen, die Patienten fühlen sich gut aufgehoben und das Krankenhaus sorgt dafür, dass die Technologie fair und genau funktioniert.

Fazit

Da KI immer mehr Teil unseres Alltags wird, ist es wichtiger denn je, dass sie sicher bleibt. Warum? Weil genau die Kraft, die die Fähigkeiten der KI antreibt, sie auch zu einem Ziel für Angriffe macht. Bedrohungen wie Angriffe, Datenmanipulation und Modelldiebstahl können die Funktionsweise von KI echt durcheinanderbringen.

Also, wie schützen wir KI? Wir haben gelernt, dass es keine Lösung gibt, die für alle passt. Techniken wie Adversarial Training, regelmäßige Audits und mehrschichtige Sicherheitsvorkehrungen können Risiken reduzieren und deine Systeme robuster machen.

Dann gibt's noch generative KI. Große Sprachmodelle bieten echt tolle Möglichkeiten, bringen aber auch neue Schwachstellen mit sich. Von der Erstellung irreführender Inhalte bis hin zur Manipulation, um schädliche Ergebnisse zu liefern – diese Tools müssen genau im Auge behalten werden. In dem Artikel Wie man Leitplanken für große Sprachmodelle bautwerden Sicherheitsmaßnahmen besprochen, die dafür sorgen sollen, dass LLMs sich so verhalten, wie sie sollen.

Ethik und Transparenz sind einfach super wichtig. KI-Systeme müssen fair, nachvollziehbar und vertrauenswürdig sein. Voreingenommenheit und Missbrauch können das Vertrauen zerstören – und Vertrauen ist in der heutigen, von Technologie geprägten Welt das Wichtigste. Leute nutzen nichts, dem sie nicht vertrauen.

Letztendlich ist es wichtig, immer einen Schritt voraus zu sein. KI-Bedrohungen entwickeln sich ständig weiter. Unternehmen müssen ihre Sicherheitsstrategien regelmäßig anpassen, um mit neuen Risiken Schritt zu halten und geschützt zu bleiben.Der Schlüssel liegt darin, proaktiv und wachsam zu sein und sich für Ethik und Transparenz einzusetzen. So können Unternehmen Vertrauen aufbauen und die Vorteile der KI optimal nutzen.

Ana Rojo Echeburúa ist KI- und Datenspezialistin und hat einen Doktortitel in angewandter Mathematik. Sie liebt es, Daten in verwertbare Erkenntnisse umzuwandeln und hat umfangreiche Erfahrung in der Leitung technischer Teams. Ana arbeitet gerne eng mit ihren Kunden zusammen, um deren Geschäftsprobleme zu lösen und innovative KI-Lösungen zu entwickeln. Sie ist für ihre Problemlösungsfähigkeiten und ihre klare Kommunikation bekannt und hat eine Leidenschaft für KI, insbesondere für generative KI. Ana widmet sich dem kontinuierlichen Lernen und der ethischen KI-Entwicklung sowie der Vereinfachung komplexer Probleme und der Erklärung von Technologien auf verständliche Weise.