programa

Se predijo que este año sería el año de la IA agéntica, pero a mí me parece más bien el año de los modelos de razonamiento. Google acaba de presentar Gemini 2.0 Flash Thinking Experimental a los usuarios de la aplicación Gemini, ampliando el acceso más allá de su disponibilidad anterior en Google AI Studio, la API Gemini y Vertex AI.

El modelo Flash Thinking 2.0 está diseñado para competir con otros modelos de razonamiento de la serie o de OpenAI y serie R de DeepSeek.

En lugar de limitarse a dar respuestas, Flash Thinking se centra en mostrar su proceso de pensamiento, desglosando pasos, evaluando alternativas y haciendo más transparente el razonamiento. Mi primera impresión es que la versión basada en chat de Gemini 2.0 Flash Thinking es notablemente más rápida que sus homólogas OpenAI y DeepSeek.

En este blog, trataré qué es Gemini 2.0 Flash Thinking Experimental, cómo puedes utilizarlo, sus puntos de referencia y cómo y por qué utilizarlo junto con herramientas como Búsqueda, Mapas y YouTube.

Perfeccionamiento en IA para principiantes

¿Qué es Gemini 2.0 Flash Thinking Experimental?

Google ha presentado Gemini 2.0 Flash Thinking Experimental como un nuevo modelo de IA diseñado para el razonamiento avanzado. Inicialmente disponible a través de Google AI Studio, la API Géminis y Vertex AI, ahora se ha extendido también a los usuarios de la aplicación Géminis.

A diferencia de los modelos lingüísticos estándar que dan prioridad a la generación de respuestas fluidas, Flash Thinking pretende desglosar su proceso de pensamiento, mostrando un razonamiento paso a paso, evaluando múltiples opciones y explicando sus conclusiones de forma más estructurada.

Gemini 2.0 Flash Thinking Experimental es una IA multimodal multimodal, lo que significa que puede procesar tanto texto como imágenes. Esto significa que podemos utilizarlo para tareas que requieren un contexto visual, como interpretar diagramas, analizar gráficos o extraer ideas de documentos complejos.

Sin embargo, a diferencia de otros modelos multimodales, Flash Thinking sólo produce resultados basados en texto, lo que significa que no generará imágenes ni datos visuales como respuesta.

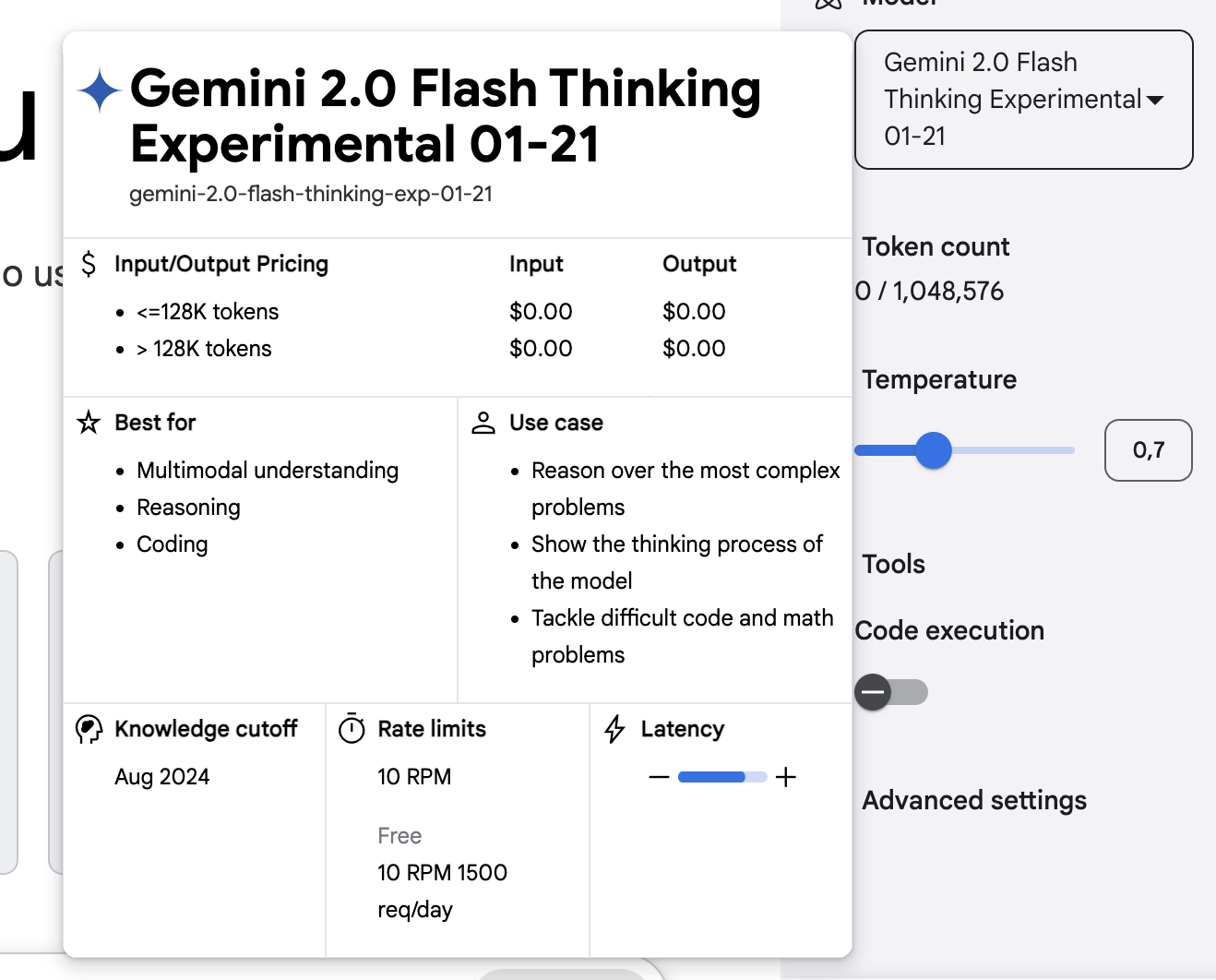

Una de sus características más destacadas es su enorme ventana contextual, que admite hasta 1 millón de tokens de entrada y genera respuestas de hasta 64.000 tokens. Esto la convierte en uno de los modelos de IA más amplios disponibles para el razonamiento de larga duración, lo que le permite analizar libros enteros, trabajos de investigación o conversaciones extensas manteniendo la coherencia.

El límite de fichas grandes garantiza que el modelo pueda seguir argumentos complejos a lo largo de interacciones prolongadas, reduciendo la necesidad de que los usuarios vuelvan a introducir el contexto repetidamente.

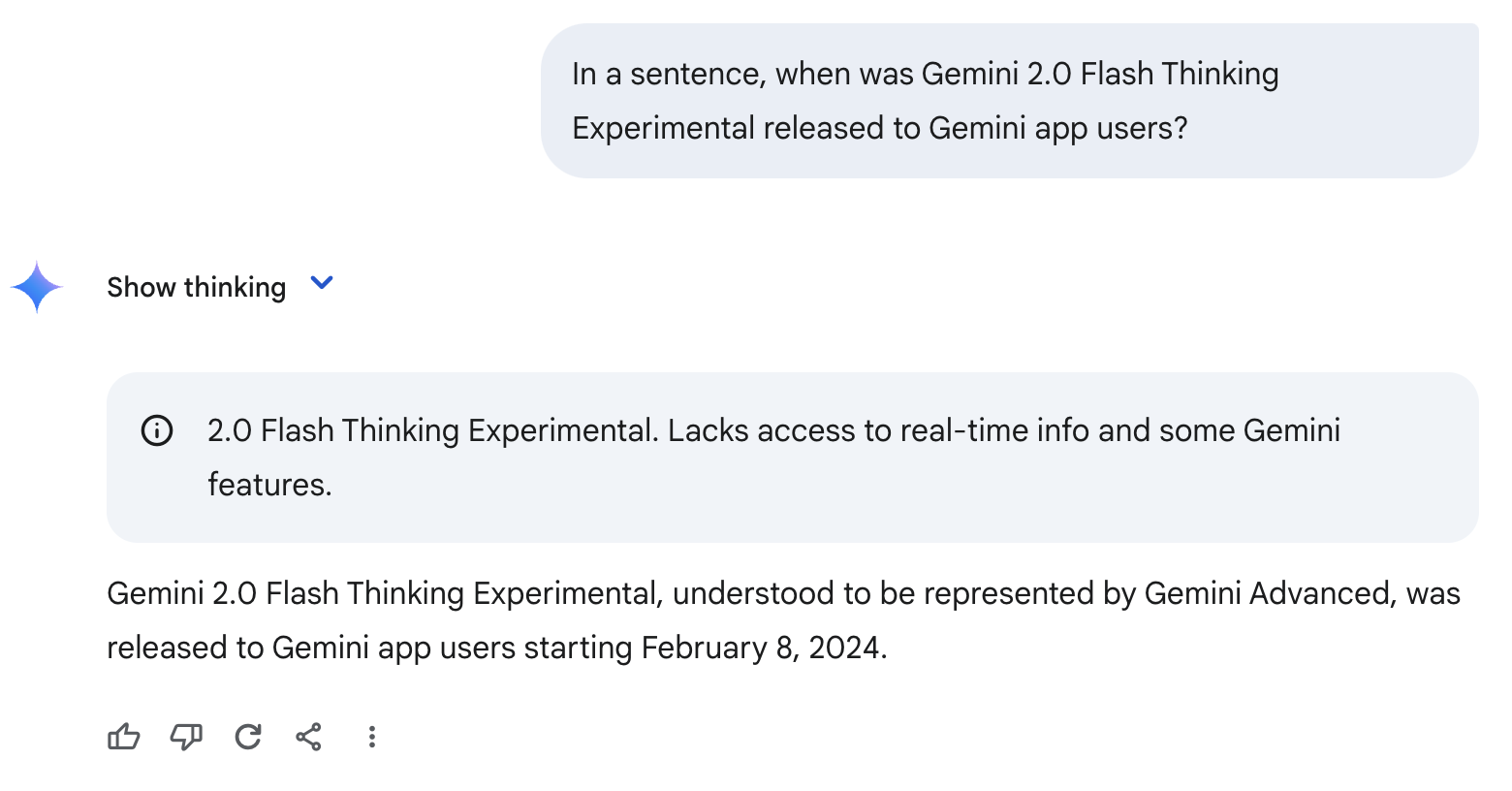

Una limitación clave a tener en cuenta es que Flash Thinking tiene una fecha límite de conocimiento de junio de 2024. Esto significa que no tiene conocimiento incorporado de los acontecimientos más allá de ese punto.

Por esta razón, puede alucinar o hacer suposiciones erróneas, como en el ejemplo siguiente. Como nunca ha oído hablar de Gemini 2.0 Flash Thinking Experimental, supone erróneamente que este modelo es equivalente a Gemini Advanced y emite una fecha equivocada.

Gemini 2.0 Flash Pensamiento Experimental Con Aplicaciones

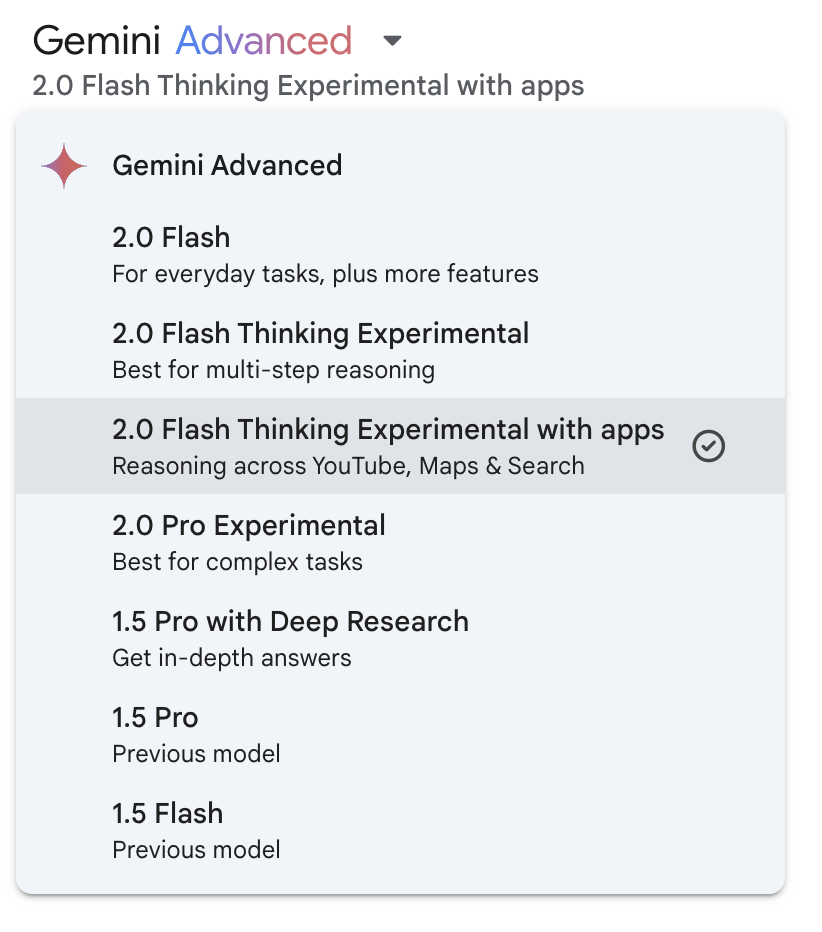

Para hacer frente al corte de conocimientos mencionado anteriormente, Google ha integrado las funciones de YouTube, Mapas y Búsqueda en Gemini 2.0 Flash Thinking Experimental. Puedes activar esta funcionalidad desde el menú desplegable del modelo:

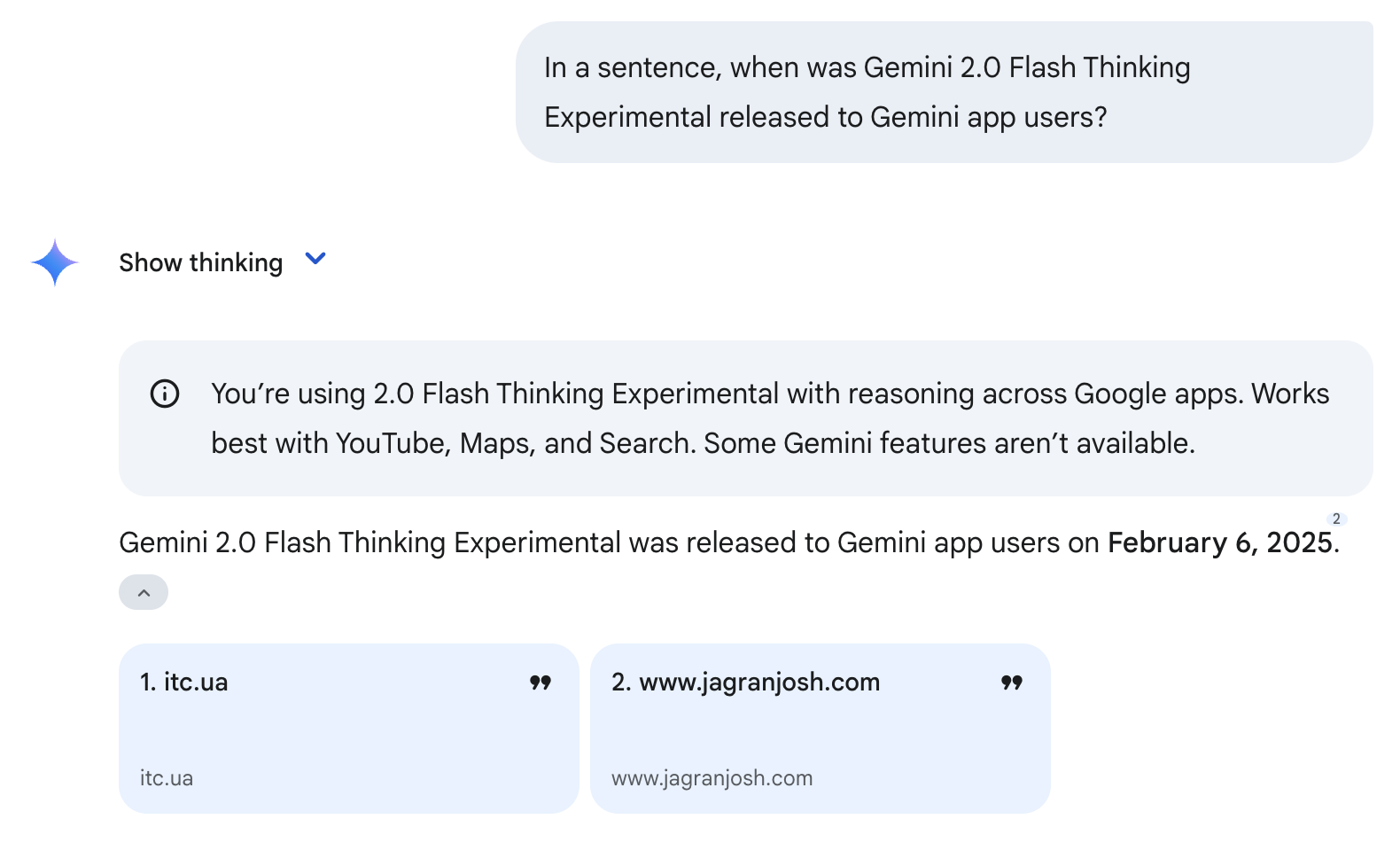

Ten en cuenta que el uso de estas herramientas no garantiza una respuesta correcta. Por ejemplo, seguía equivocándose en la fecha de lanzamiento, pero esta vez estaba mucho más cerca: la fecha de lanzamiento correcta es el 5 de febrero de 2025 (ver ejemplo más abajo). Esto ocurrió porque el modelo utilizó la herramienta de Búsqueda y obtuvo su información de dos sitios web citados. Como estos sitios se publicaron el 6 de febrero de 2025, el modelo dedujo erróneamente que ésa era la fecha de lanzamiento de Gemini 2.0 Flash Thinking Experimental.

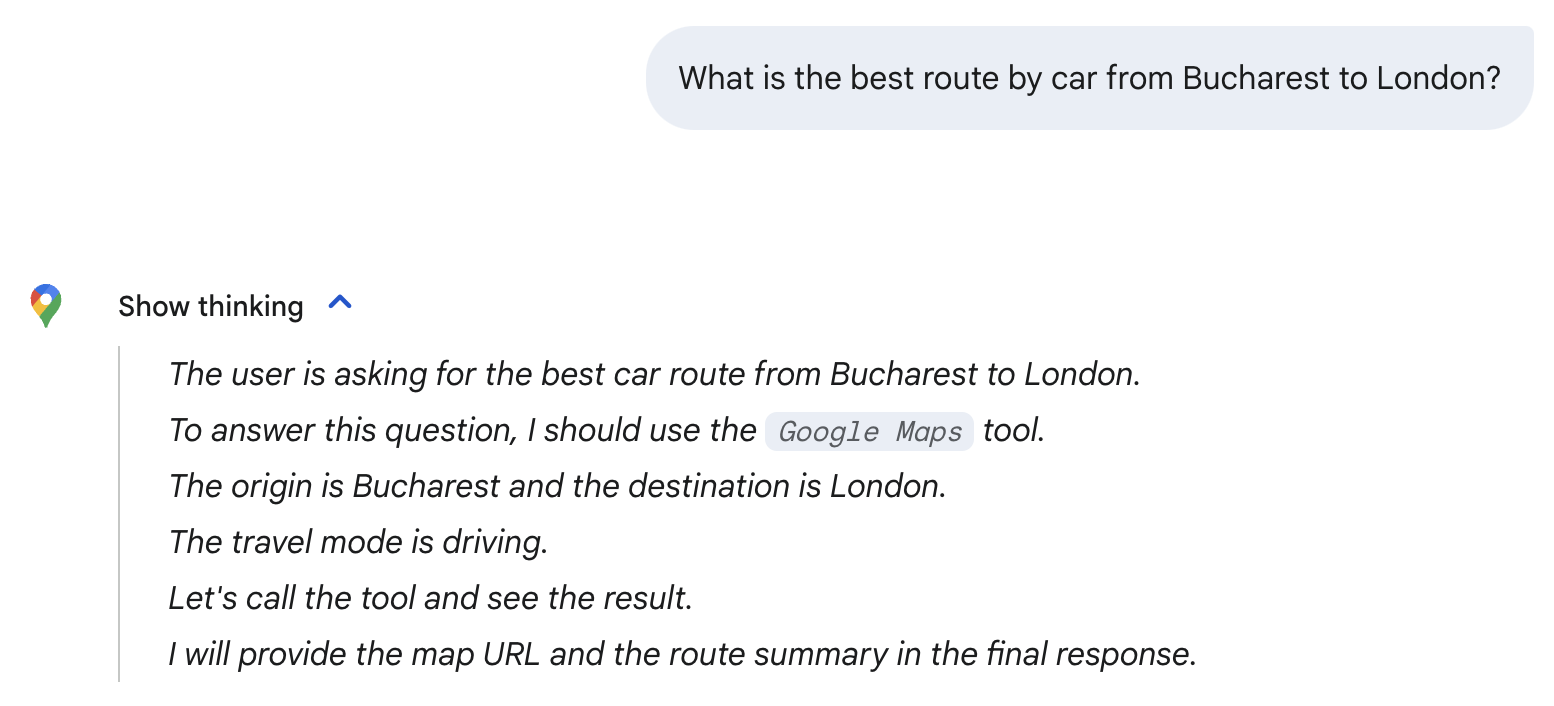

El modelo selecciona automáticamente las herramientas que necesita en función de la indicación. Por ejemplo, cuando pregunté por la mejor ruta en coche de Bucarest a Londres, el modelo eligió automáticamente la herramienta Google Maps. Fíjate en el icono de Google Maps que aparece a continuación y en la mención de la herramienta Google Maps en su proceso de razonamiento.

Ten en cuenta que sólo estoy utilizando estas preguntas triviales para explorar el modelo: para la pregunta anterior, basta con el simple modelo 2.0 Flash. Como veremos en la sección siguiente, Gemini 2.0 Flash Thinking Experimental se utiliza mejor para matemáticas avanzadas, ciencias y razonamiento multimodal.

Puntos de referencia: Gemini 2.0 Flash Pensamiento Experimental

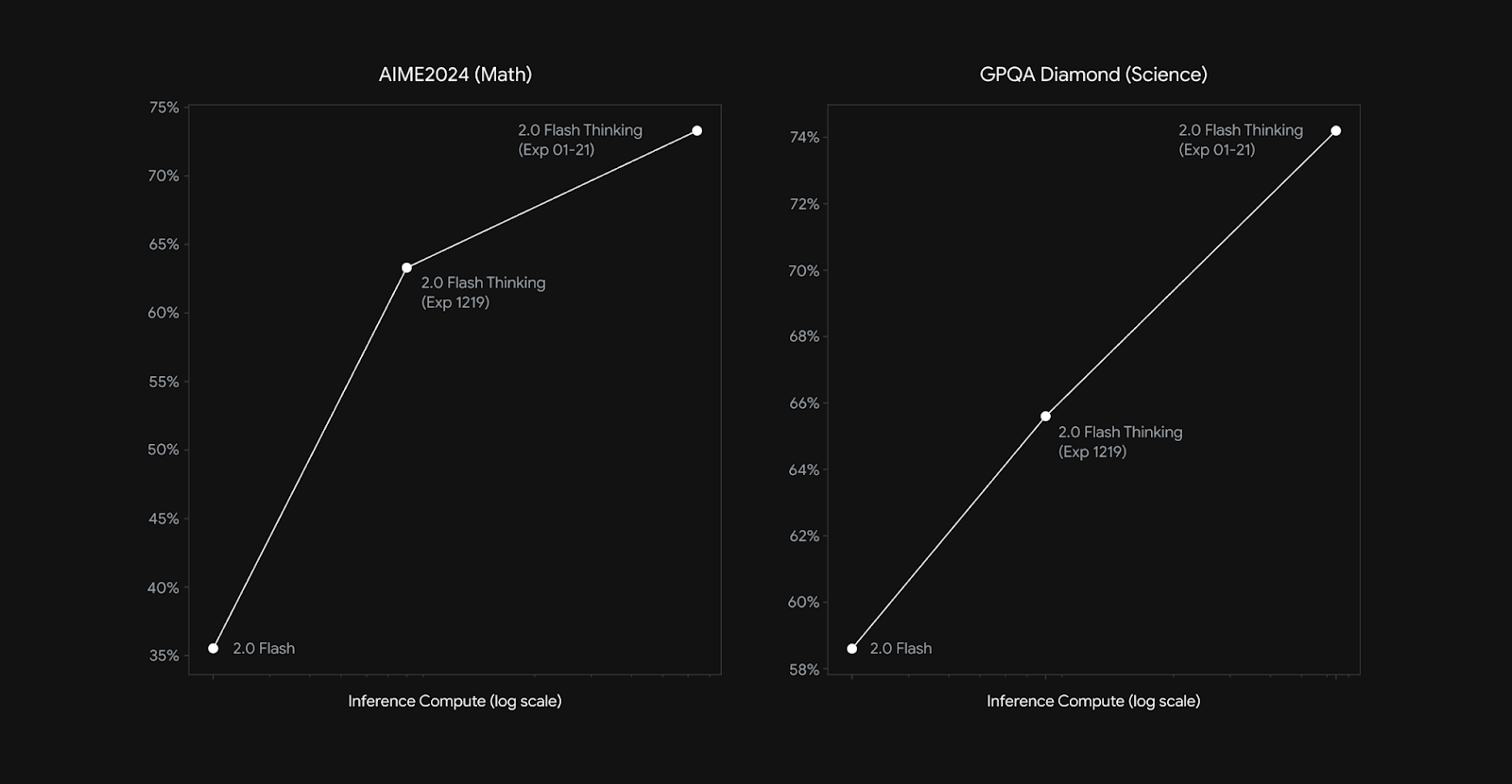

El Experimento de Pensamiento Flash Gemini 2.0 de Google ha mostrado mejoras significativas en tareas basadas en el razonamiento, superando a sus predecesores en múltiples puntos de referencia clave (con especial atención a las matemáticas, las ciencias y el razonamiento multimodal).

|

Punto de referencia |

Géminis 1.5 Pro 002 |

Flash Géminis 2.0 Exp |

Flash Géminis 2.0 Pensar Exp 01-21 |

|

AIME2024 (Matemáticas) |

19.3% |

35.5% |

73.3% |

|

GPQA Diamante (Ciencia) |

57.6% |

58.6% |

74.2% |

|

MMMU (Razonamiento Multimodal) |

64.9% |

70.7% |

75.4% |

Source: Google

En la prueba de referencia AIME2024 (matemáticas), Gemini 2.0 Flash Thinking Experimental obtuvo un 73,3%, un gran aumento respecto a la puntuación del 35,5% de Gemini 2.0 Flash Experimental y del 19,3% de Gemini 1.5 Pro. Para comparar, o3-mini (alto) de OpenAI obtuvo un 87,3% en esta prueba.

Del mismo modo, para el GPQA Diamante (ciencia), el modelo alcanzó el 74,2%, mejorando respecto al 58,6% de la versión anterior. A modo de comparación, DeepSeek-R1 obtuvo un 71,5% (pass@1-en la primera pasada) en esta prueba, mientras que o1 de OpenAI obtuvo un 75,7 (pass@1), y o3-mini (high) un 79,7%.

En MMMU (razonamiento multimodal), que evalúa la capacidad del modelo para integrar e interpretar información a través de múltiples modalidades, Gemini 2.0 Flash Thinking Experimental obtuvo una puntuación del 75,4%, superando de nuevo a sus iteraciones anteriores.

Al igual que hemos visto con otros modelos de razonamiento, las capacidades de razonamiento de Flash Thinking 2.0 escalan con el aumento del cómputo de inferencia (véase el gráfico siguiente). El cómputo de la inferencia se refiere a la cantidad de potencia de cálculo utilizada después de dar tu indicación al modelo.

Fuente: Google

Cómo acceder a Gemini 2.0 Flash Pensamiento Experimental

Google ha hecho que Gemini 2.0 Flash Thinking Experimental esté disponible a través de múltiples plataformas, incluido el acceso directo para los usuarios de Gemini.

Gemini Chat (Gemini App & Web)

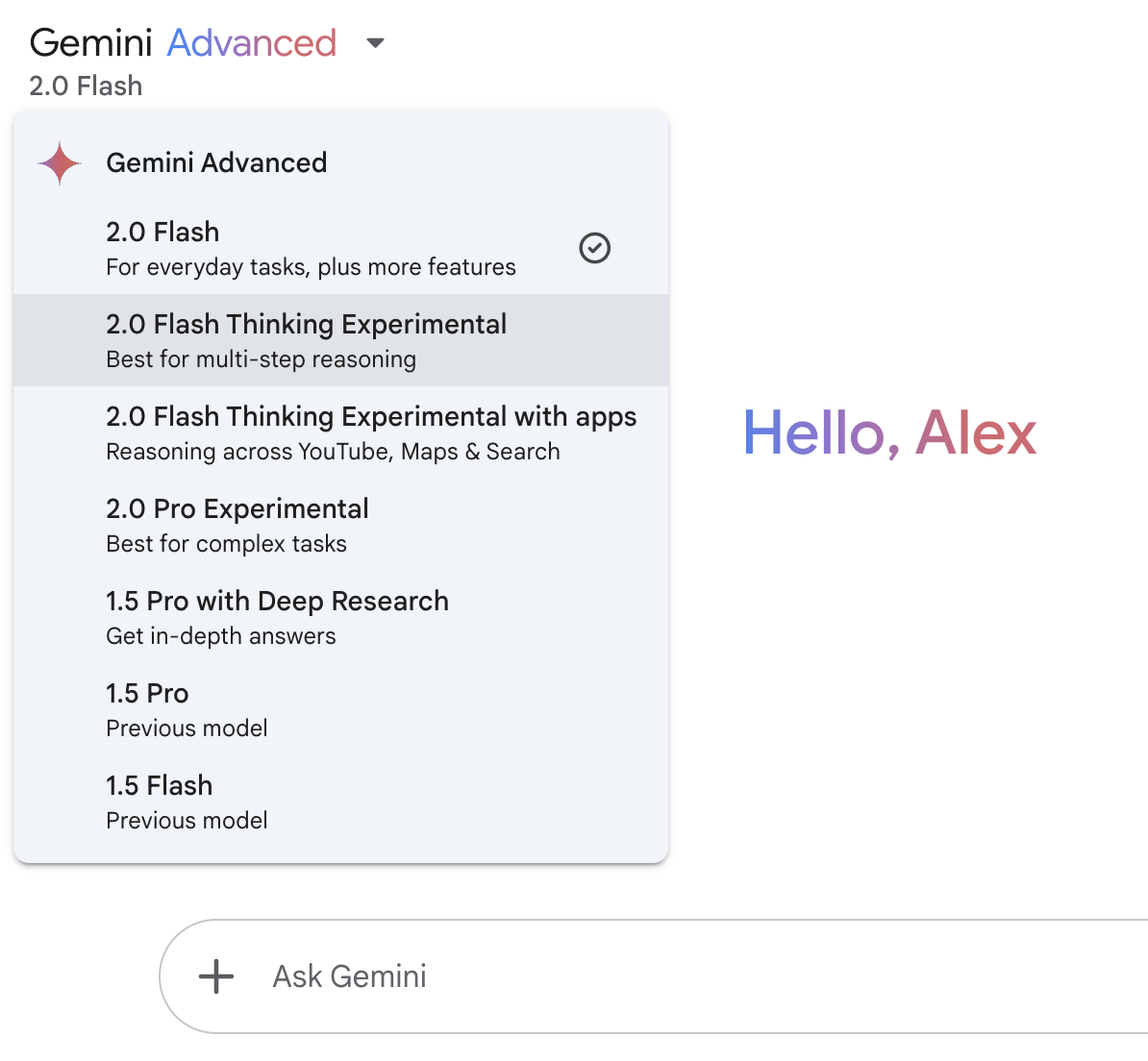

La forma más fácil de acceder a Gemini 2.0 Flash Thinking es a través de Gemini de Google de Google, disponible tanto en la aplicación web Gemini como en la aplicación móvil Gemini.

En el momento de publicar este artículo, el acceso a Flash Thinking 2.0 está disponible gratuitamente para todos los usuarios.

Utiliza el menú desplegable de la parte superior izquierda para acceder al modelo:

Google AI Studio

Google AI Studio es otra forma de utilizar Flash Thinking. Esta plataforma web está dirigida a usuarios más avanzados, y te permite experimentar con las capacidades de razonamiento del modelo, controlar parámetros como la temperatura, probar consultas complejas, explorar respuestas estructuradas, etc.

API Géminis

Para los desarrolladores que deseen integrar Flash Thinking en sus aplicaciones, Gemini 2.0 Flash Thinking está disponible a través de la API de Gemini.

Conclusión

Gemini 2.0 Flash Thinking Experimental amplía el impulso de Google hacia el razonamiento de IA, ahora disponible para los usuarios de la app Gemini. Destaca por explicar su proceso de pensamiento, estructurar las respuestas paso a paso y utilizar herramientas como la Búsqueda, YouTube y Mapas.

Aunque prometedor, Flash Thinking sigue enfrentándose a retos como las imprecisiones ocasionales y la excesiva dependencia de las fuentes. Con OpenAI y DeepSeek avanzando también en modelos de razonamiento, será interesante ver cómo evoluciona la competencia en este espacio.

Preguntas frecuentes

¿Puedo ajustar el Pensamiento Flash Gemini 2.0 a mi propio caso de uso?

No, Google aún no ha proporcionado opciones de ajuste para Flash Thinking.

¿Puede Gemini 2.0 Flash Thinking generar imágenes?

No, aunque el modelo procesa texto e imágenes como entradas, sólo genera respuestas basadas en texto. No produce contenidos visuales como imágenes o diagramas.

¿Para qué tipo de preguntas debería utilizar Flash Thinking?

Sobresale en tareas de razonamiento complejas, como la resolución de problemas matemáticos, el análisis científico y la interpretación multimodal de datos. Es posible que las consultas cotidianas no requieran Flash Thinking y puedan ser gestionadas por los modelos Gemini estándar.