Programa

A previsão era de que este ano seria o ano da IA agêntica, mas, para mim, parece mais o ano dos modelos de raciocínio. O Google acaba de apresentaro Gemini 2.0 Flash Thinking Experimental aos usuários do aplicativo Gemini, expandindo o acesso além da disponibilidade anterior no Google AI Studio, na API Gemini e no Vertex AI.

O modelo Flash Thinking 2.0 foi projetado para competir com outros modelos de raciocínio da série o da OpenAI e DeepSeek's R-series.

Em vez de apenas fornecer respostas, o Flash Thinking se concentra em mostrar seu processo de raciocínio, detalhando etapas, avaliando alternativas e tornando o raciocínio mais transparente. Minha primeira impressão é que a versão baseada em bate-papo do Gemini 2.0 Flash Thinking é visivelmente mais rápida do que suas contrapartes OpenAI e DeepSeek.

Neste blog, falarei sobre o que é o Gemini 2.0 Flash Thinking Experimental, como você pode usá-lo, seus benchmarks e como e por que usá-lo juntamente com ferramentas como Search, Maps e YouTube.

Aprimoramento de IA para iniciantes

O que é o Gemini 2.0 Flash Thinking Experimental?

O Google apresentou o Gemini 2.0 Flash Thinking Experimental como um novo modelo de IA projetado para raciocínio avançado. Inicialmente disponível por meio do Google AI Studio, da API Gemini e do Vertex AI, ele também foi implementado para os usuários do aplicativo Gemini.

Diferentemente dos modelos de linguagem padrão, que priorizam a geração de respostas fluentes, o Flash Thinking tem como objetivo detalhar seu processo de pensamento, mostrando o raciocínio passo a passo, avaliando várias opções e explicando suas conclusões de forma mais estruturada.

O Gemini 2.0 Flash Thinking Experimental é uma IA multimodal multimodal, o que significa que ele pode processar texto e imagens como entrada. Isso significa que podemos usá-lo para tarefas que exigem contexto visual, como interpretar diagramas, analisar gráficos ou extrair insights de documentos complexos.

No entanto, ao contrário de outros modelos multimodais, o Flash Thinking produz apenas resultados baseados em texto, o que significa que ele não gera imagens ou dados visuais como resposta.

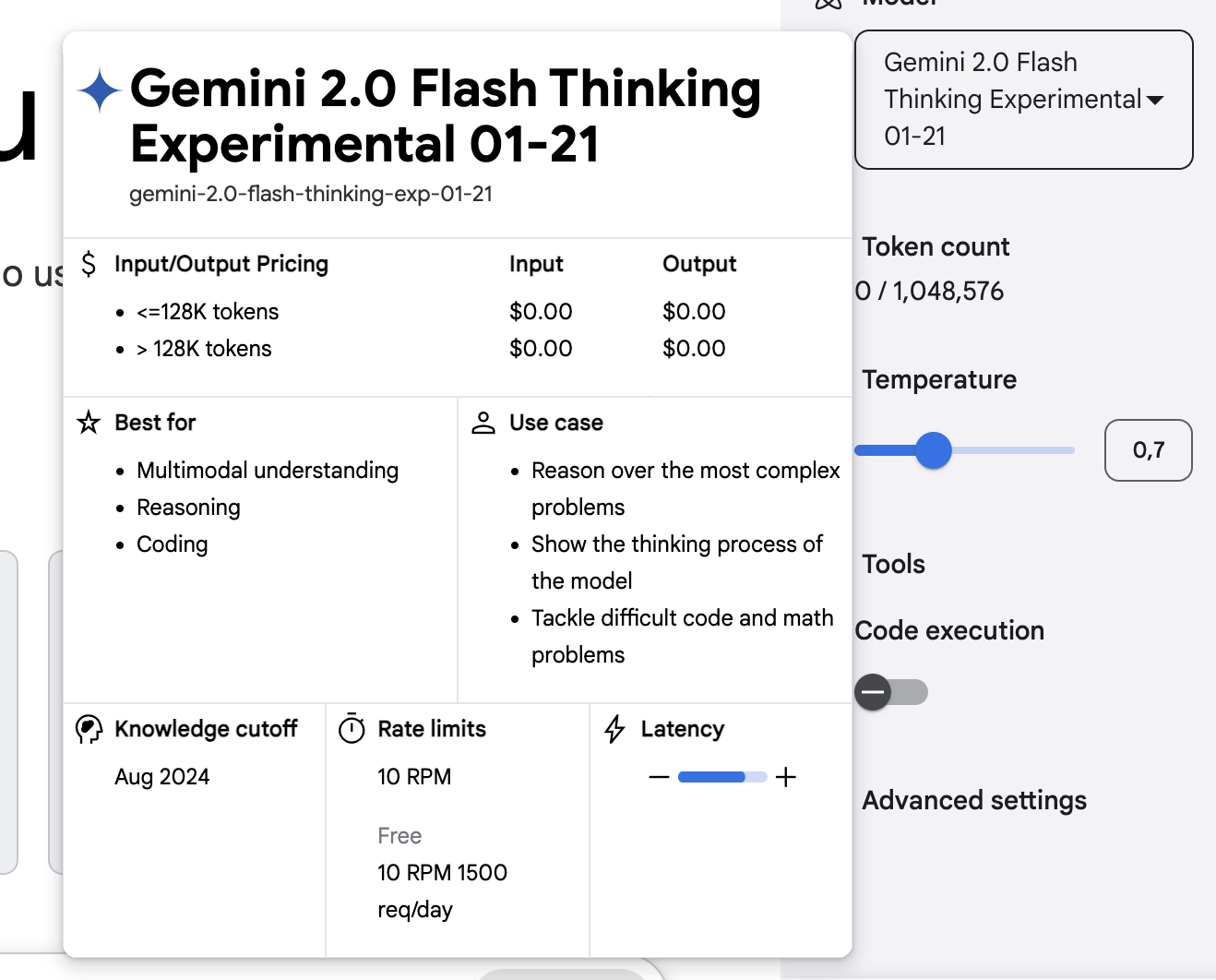

Um de seus recursos de destaque é a enorme janela de contexto, que suporta até 1 milhão de tokens para entrada e gera respostas de até 64.000 tokens. Isso o torna um dos modelos de IA mais abrangentes disponíveis para raciocínio de formato longo, permitindo que ele analise livros inteiros, documentos de pesquisa ou conversas extensas, mantendo a coerência.

O grande limite de tokens garante que o modelo possa rastrear argumentos complexos em interações prolongadas, reduzindo a necessidade de os usuários reintroduzirem repetidamente o contexto.

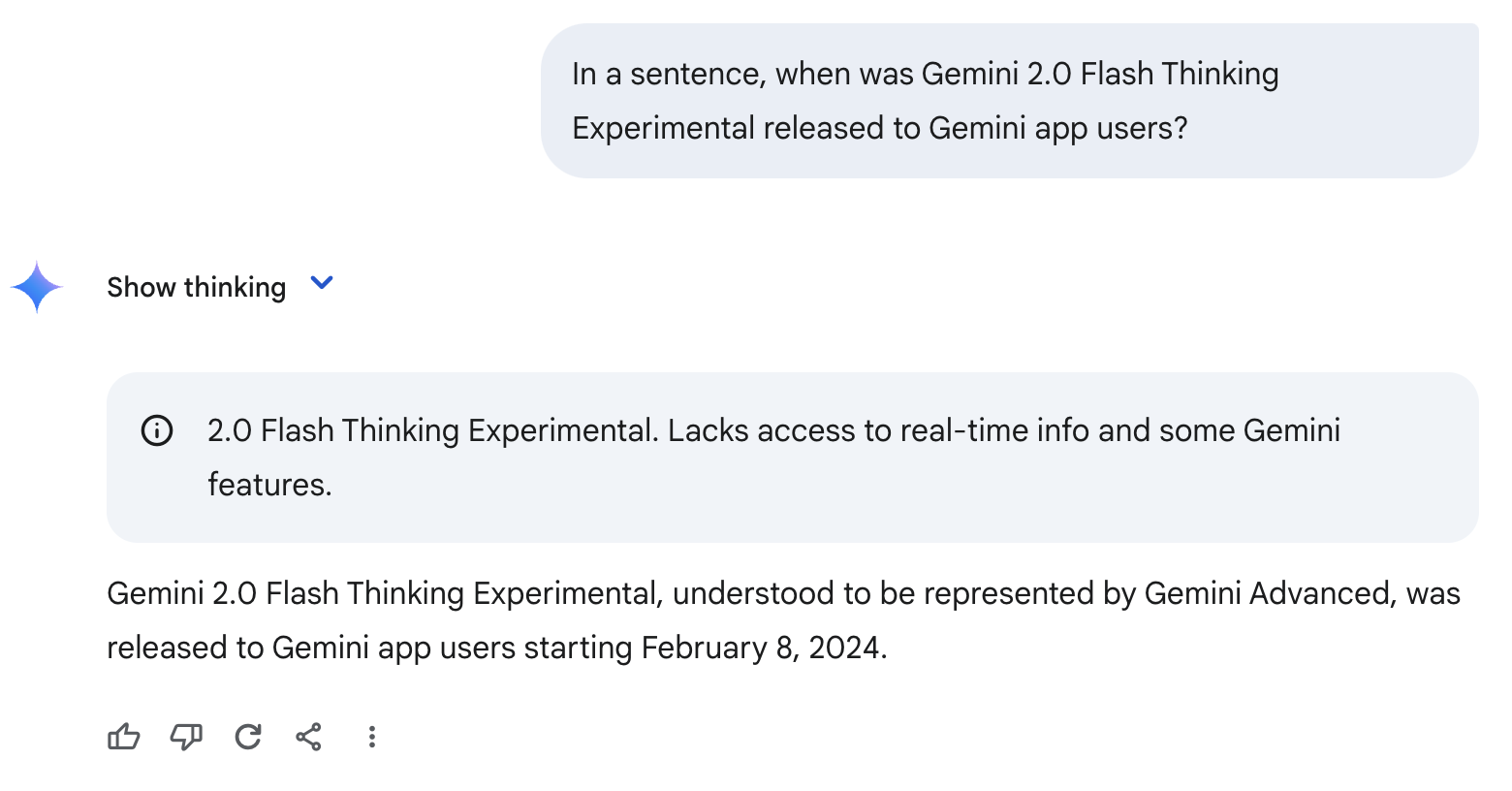

Uma limitação importante que você deve ter em mente é que o Flash Thinking tem um limite de conhecimento em junho de 2024. Isso significa que ele não tem conhecimento integrado de eventos além desse ponto.

Por esse motivo, você pode alucinar ou fazer suposições erradas, como no exemplo abaixo. Como você nunca ouviu falar sobre o Gemini 2.0 Flash Thinking Experimental, ele supõe erroneamente que esse modelo é equivalente ao Gemini Advanced e gera uma data errada.

Gemini 2.0 Flash Thinking Experimental com aplicativos

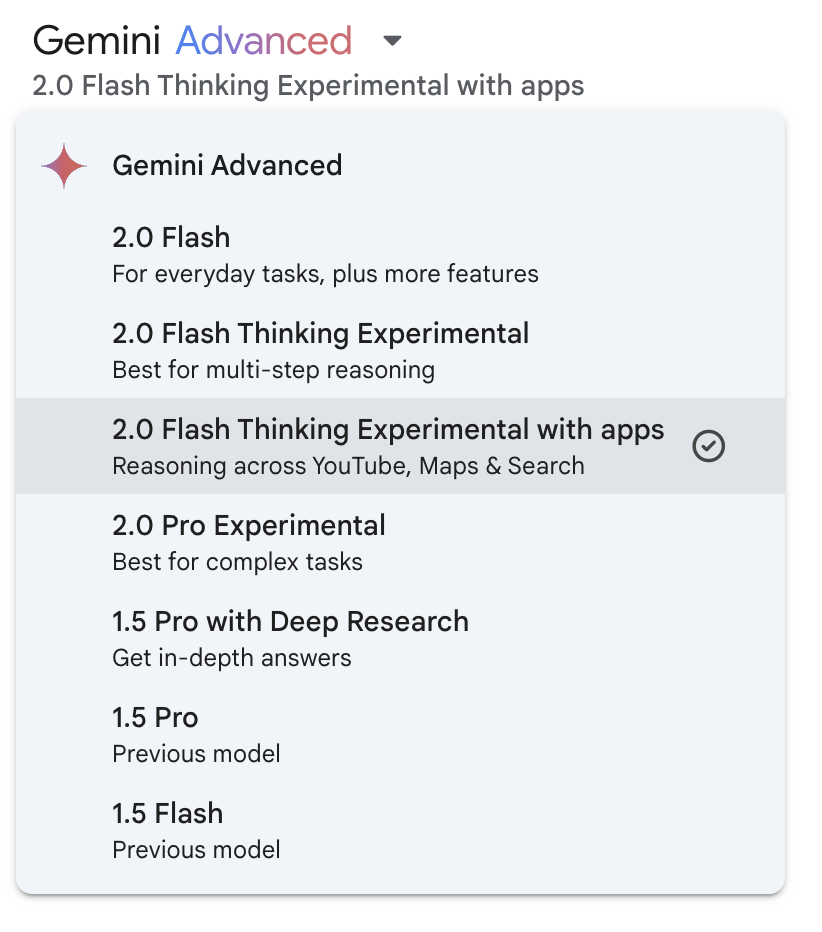

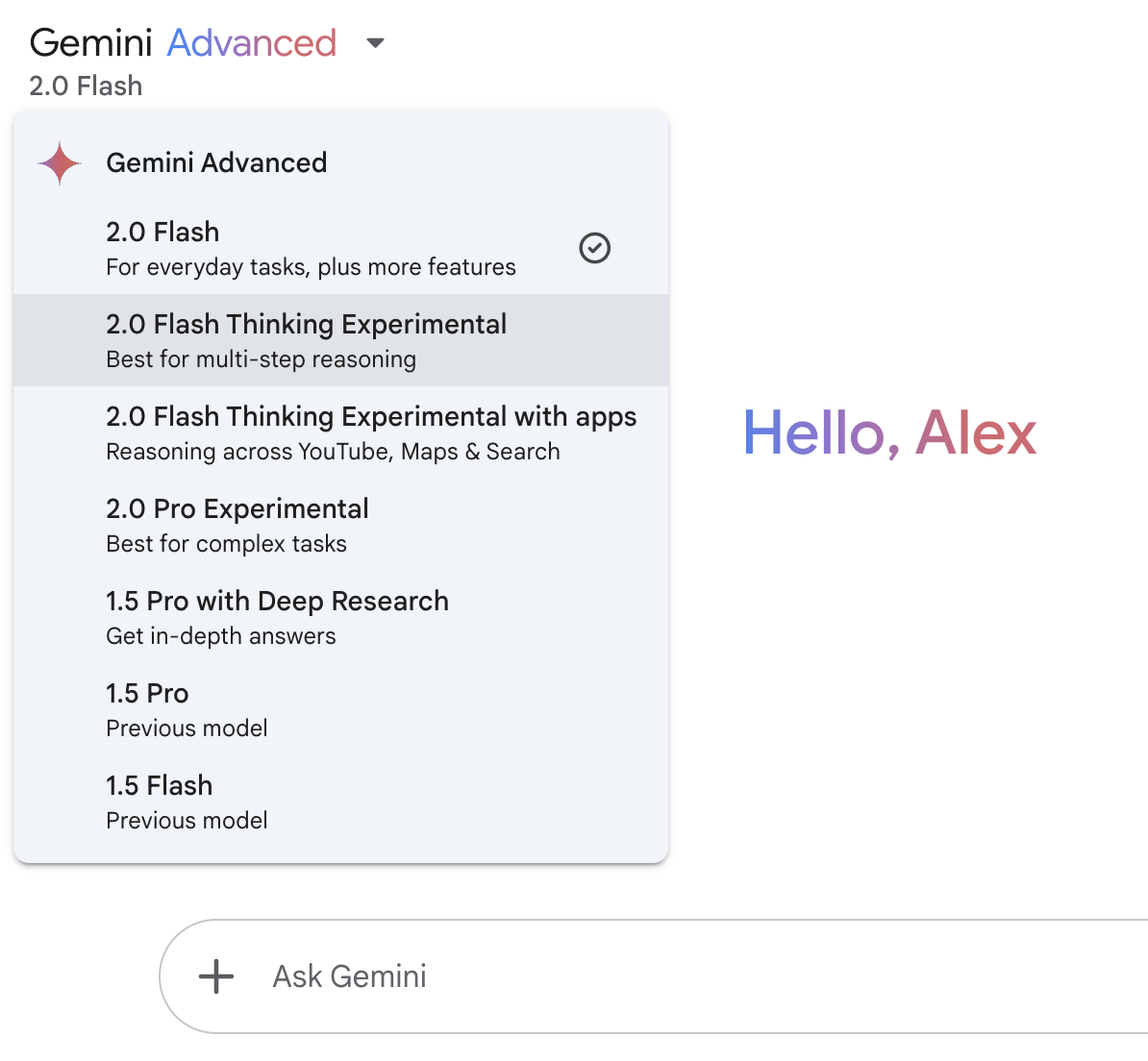

Para resolver o problema do limite de conhecimento mencionado acima, o Google integrou o YouTube, o Maps e a funcionalidade de pesquisa ao Gemini 2.0 Flash Thinking Experimental. Você pode ativar essa funcionalidade no menu suspenso do modelo:

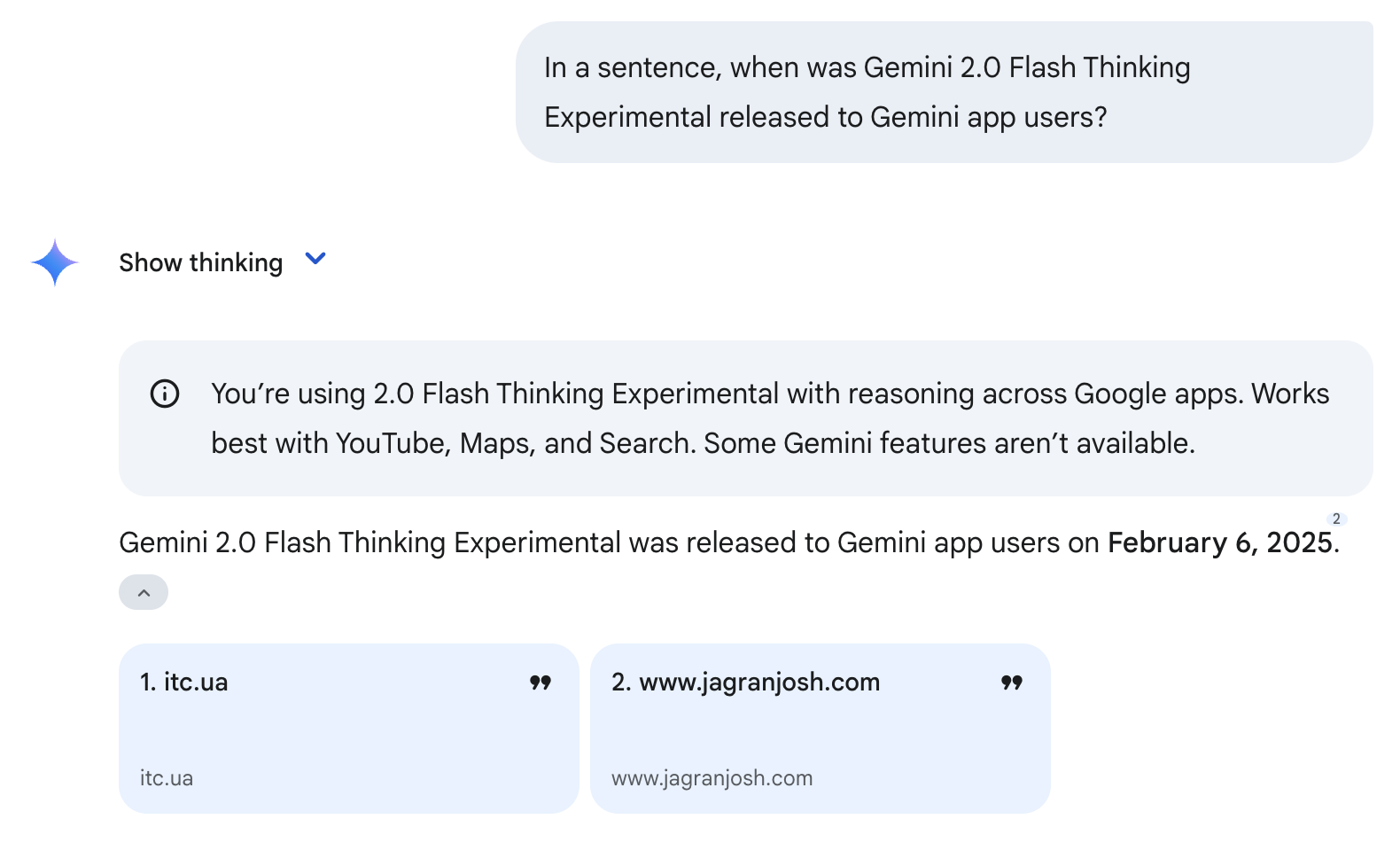

Observe que o uso dessas ferramentas não garante uma resposta correta. Por exemplo, ele ainda errou a data de lançamento, mas dessa vez ficou muito mais próximo - a data de lançamento correta é 5 de fevereiro de 2025 (veja o exemplo abaixo). Isso aconteceu porque o modelo usou a ferramenta Search e obteve suas informações de dois sites citados. Como esses sites foram publicados em 6 de fevereiro de 2025, o modelo inferiu erroneamente que essa era a data de lançamento do Gemini 2.0 Flash Thinking Experimental.

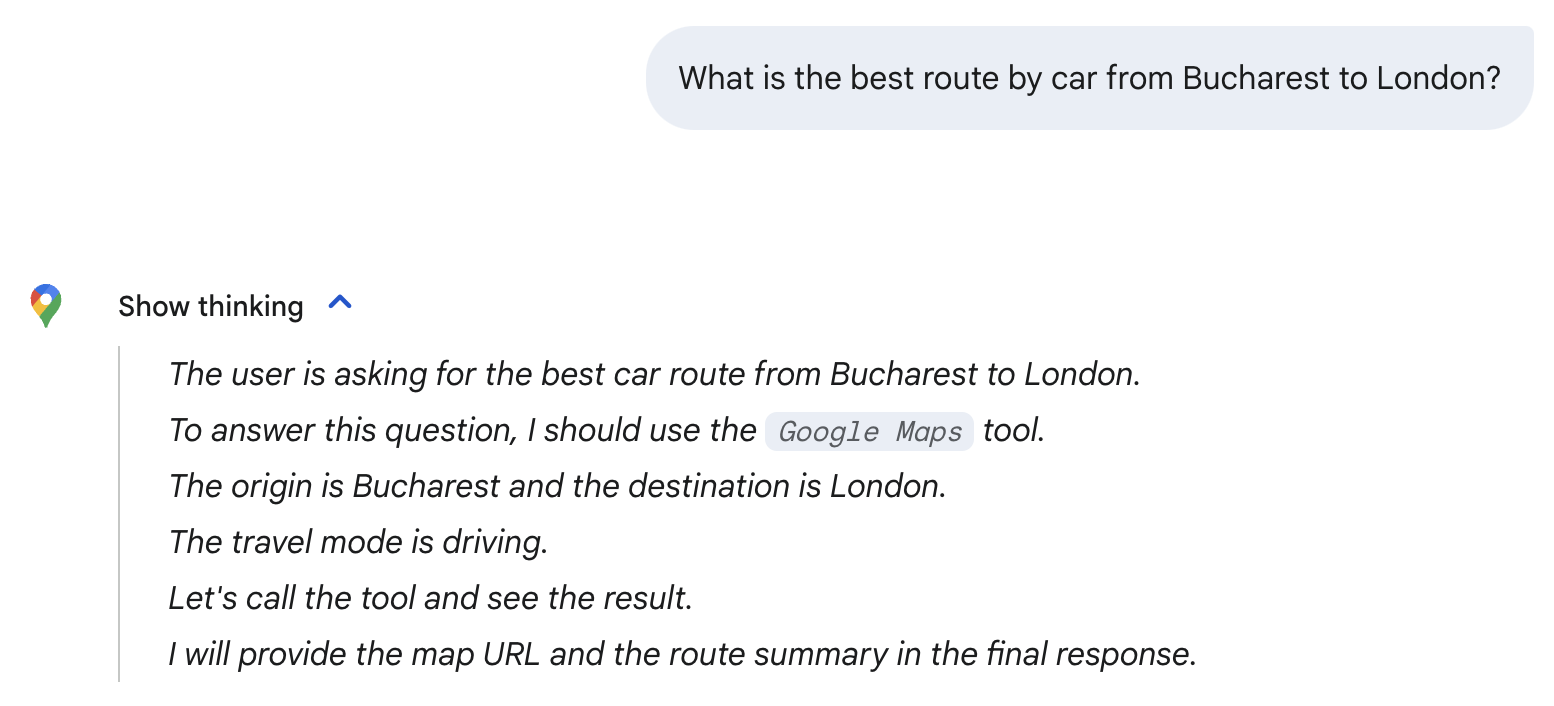

O modelo seleciona automaticamente as ferramentas necessárias com base no prompt. Por exemplo, quando perguntei qual era a melhor rota de carro de Bucareste a Londres, o modelo escolheu automaticamente a ferramenta Google Maps. Observe o ícone do Google Maps abaixo e a menção da ferramenta do Google Maps em seu processo de raciocínio.

Observe que estou usando apenas essas perguntas triviais para explorar o modelo - para a pergunta acima, o modelo simples do Flash 2.0 é suficiente. Como veremos na seção a seguir, o Gemini 2.0 Flash Thinking Experimental é melhor utilizado para matemática avançada, ciências e raciocínio multimodal.

Benchmarks: Gemini 2.0 Flash Thinking Experimental

O Gemini 2.0 Flash Thinking Experimental do Google apresentou melhorias significativas em tarefas baseadas em raciocínio, superando seus antecessores em vários benchmarks importantes (com foco em matemática, ciências e raciocínio multimodal).

|

Benchmark |

Gemini 1.5 Pro 002 |

Flash Gemini 2.0 Exp |

Flash Gemini 2.0 Pensamento Exp 01-21 |

|

AIME2024 (Matemática) |

19.3% |

35.5% |

73.3% |

|

GPQA Diamante (Ciências) |

57.6% |

58.6% |

74.2% |

|

MMMU (raciocínio multimodal) |

64.9% |

70.7% |

75.4% |

Source: Google

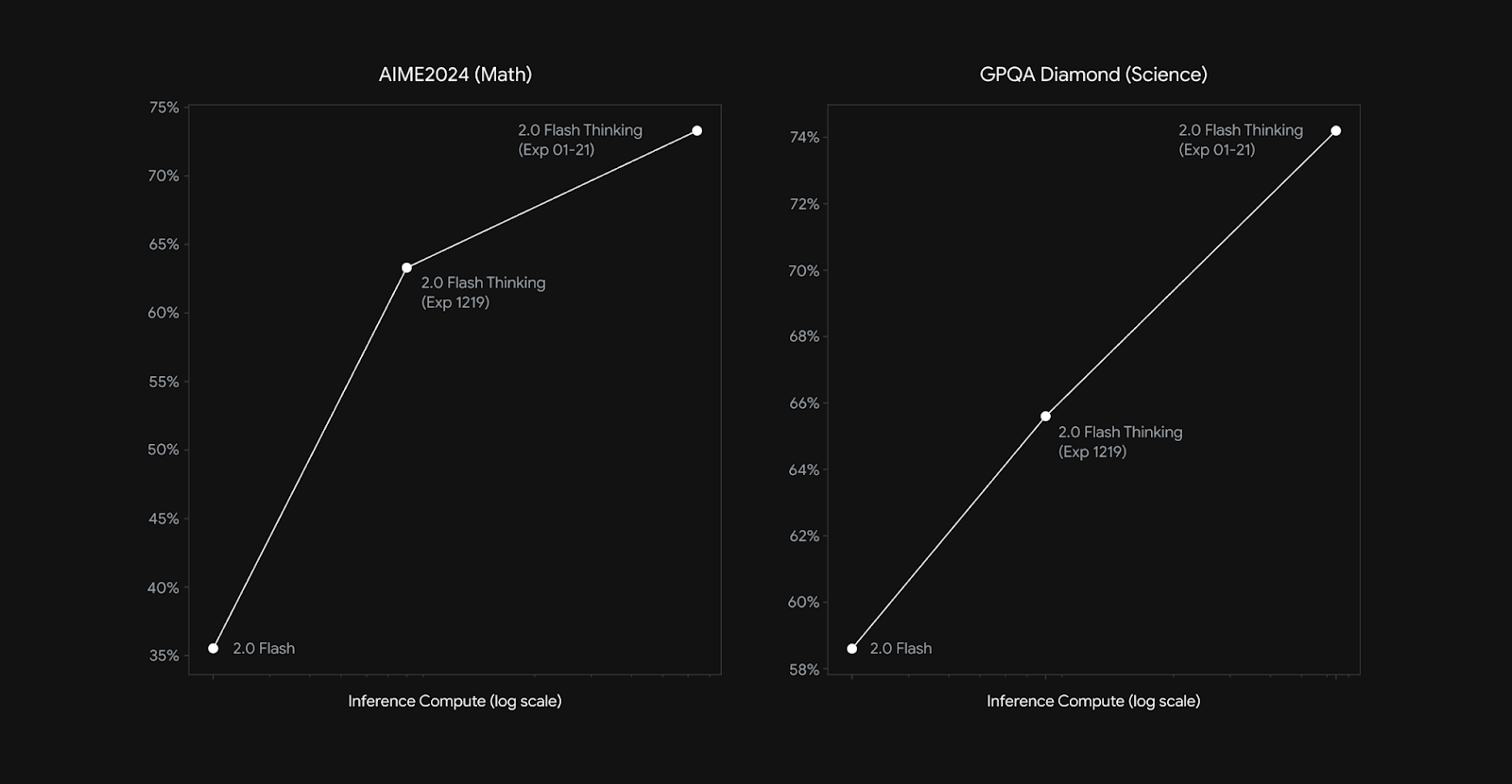

No benchmark AIME2024 (matemática), o Gemini 2.0 Flash Thinking Experimental atingiu 73,3%, um grande aumento em relação à pontuação de 35,5% do Gemini 2.0 Flash Experimental e de 19,3% do Gemini 1.5 Pro. Para comparação, o3-mini (high) da OpenAI da OpenAI obteve 87,3% de pontuação nesse benchmark.

Da mesma forma, para o GPQA Diamond (ciência), o modelo atingiu 74,2%, melhorando em relação aos 58,6% da versão anterior. Para fins de comparação, o DeepSeek-R1 obteve 71,5% (pass@1 - na primeira passagem) nesse benchmark, enquanto o o1 da OpenAI obteve 75,7 (pass@1) e o o3-mini (high) obteve 79,7%.

No MMMU (raciocínio multimodal), que avalia a capacidade do modelo de integrar e interpretar informações em várias modalidades, o Gemini 2.0 Flash Thinking Experimental obteve 75,4%, superando novamente suas iterações anteriores.

Assim como vimos em outros modelos de raciocínio, os recursos de raciocínio do Flash Thinking 2.0 são dimensionados com o aumento da computação de inferência (veja o gráfico abaixo). A computação de inferência refere-se à quantidade de potência computacional usada depois que você dá seu prompt ao modelo.

Fonte: Google

Como acessar o Gemini 2.0 Flash Thinking Experimental

O Google disponibilizou o Gemini 2.0 Flash Thinking Experimental por meio de várias plataformas, incluindo o acesso direto para os usuários do Gemini.

Gemini Chat (Gemini App e Web)

A maneira mais fácil de acessar o Gemini 2.0 Flash Thinking é por meio do Gemini do Google do Google, disponível no aplicativo web Gemini e no aplicativo móvel Gemini.

No momento da publicação deste artigo, o acesso ao Flash Thinking 2.0 está disponível gratuitamente para todos os usuários.

Use o menu suspenso no canto superior esquerdo para acessar o modelo:

Google AI Studio

Google AI Studio é outra maneira de usar o Flash Thinking. Essa plataforma baseada na Web é voltada para usuários mais avançados e permite que você experimente os recursos de raciocínio do modelo, controle parâmetros como temperatura, teste consultas complexas, explore respostas estruturadas etc.

API Gemini

Para os desenvolvedores que desejam integrar o Flash Thinking em seus aplicativos, o Gemini 2.0 Flash Thinking está disponível por meio da API do Gemini.

Conclusão

O Gemini 2.0 Flash Thinking Experimental expande o impulso do Google para o raciocínio de IA, agora disponível para os usuários do aplicativo Gemini. Ele se destaca por explicar seu processo de pensamento, estruturar as respostas passo a passo e usar ferramentas como Search, YouTube e Maps.

Embora promissor, o Flash Thinking ainda enfrenta desafios como imprecisões ocasionais e dependência excessiva de fontes. Com a OpenAI e a DeepSeek também avançando nos modelos de raciocínio, será interessante ver como a concorrência nesse espaço evolui.

Perguntas frequentes

Posso ajustar o Gemini 2.0 Flash Thinking para o meu próprio caso de uso?

Não, o Google ainda não forneceu opções de ajuste fino para o Flash Thinking.

O Gemini 2.0 Flash Thinking pode gerar imagens?

Não, embora o modelo processe texto e imagens como entradas, ele gera apenas respostas baseadas em texto. Ele não produz conteúdo visual, como imagens ou diagramas.

Para que tipo de perguntas devo usar o Flash Thinking?

Ele se destaca em tarefas de raciocínio complexas, como resolução de problemas matemáticos, análise científica e interpretação de dados multimodais. As consultas do dia a dia podem não exigir o Flash Thinking e podem ser tratadas por modelos Gemini padrão.