Cursus

Cette année était annoncée comme l'année de l'IA agentique, mais pour moi, elle ressemble davantage à l'année des modèles de raisonnement. Google vient d'introduire Gemini 2.0 Flash Thinking Experimental pour les utilisateurs de l'application Gemini, élargissant ainsi son accès au-delà de sa disponibilité précédente dans Google AI Studio, l'API Gemini et Vertex AI.

Le modèle 2.0 Flash Thinking est conçu pour rivaliser avec d'autres modèles de raisonnement de la série o d'OpenAI. série o d'OpenAI d'OpenAI et série R de DeepSeek.

Plutôt que de fournir des réponses, Flash Thinking s'attache à montrer le processus de réflexion, en décomposant les étapes, en évaluant les alternatives et en rendant le raisonnement plus transparent. Ma première impression est que la version de Gemini 2.0 Flash Thinking basée sur le chat est nettement plus rapide que ses homologues OpenAI et DeepSeek.

Dans ce blog, j'expliquerai ce qu'est Gemini 2.0 Flash Thinking Experimental, comment vous pouvez l'utiliser, ses points de référence, et comment et pourquoi l'utiliser avec des outils tels que Search, Maps et YouTube.

L'amélioration de l'IA pour les débutants

Qu'est-ce que Gemini 2.0 Flash Thinking Experimental ?

Google a présenté Gemini 2.0 Flash Thinking Experimental, un nouveau modèle d'IA conçu pour le raisonnement avancé. Initialement disponible via Google AI Studio, l'API Gemini et Vertex AI, elle a été étendue aux utilisateurs de l'application Gemini.

Contrairement aux modèles linguistiques standard qui privilégient la production de réponses fluides, la pensée éclair vise à décomposer le processus de réflexion, en montrant un raisonnement étape par étape, en évaluant plusieurs options et en expliquant ses conclusions d'une manière plus structurée.

Gemini 2.0 Flash Thinking Experimental est un outil d'IA multimodale. modèle d'IA multimodale multimodale, ce qui signifie qu'il peut traiter à la fois du texte et des images en entrée. Cela signifie que nous pouvons l'utiliser pour des tâches qui nécessitent un contexte visuel, telles que l'interprétation de diagrammes, l'analyse de graphiques ou l'extraction d'informations à partir de documents complexes.

Cependant, contrairement à d'autres modèles multimodaux, Flash Thinking ne produit que des sorties textuelles, ce qui signifie qu'il ne génère pas d'images ou de données visuelles en réponse.

L'une de ses caractéristiques les plus remarquables est sa fenêtre contextuelle massive, qui prend en charge jusqu'à 1 million de tokens en entrée et génère des réponses pouvant aller jusqu'à 64 000 tokens. Cela en fait l'un des modèles d'IA les plus étendus disponibles pour le raisonnement à long terme, lui permettant d'analyser des livres entiers, des documents de recherche ou des conversations prolongées tout en maintenant la cohérence.

La limite importante de jetons garantit que le modèle peut suivre des arguments complexes au cours d'interactions prolongées, réduisant ainsi la nécessité pour les utilisateurs de réintroduire le contexte de manière répétée.

Il convient de garder à l'esprit une limitation essentielle : la date limite de connaissance de Flash Thinking est fixée à juin 2024. Cela signifie qu'il ne dispose pas d'une connaissance intégrée des événements au-delà de ce point.

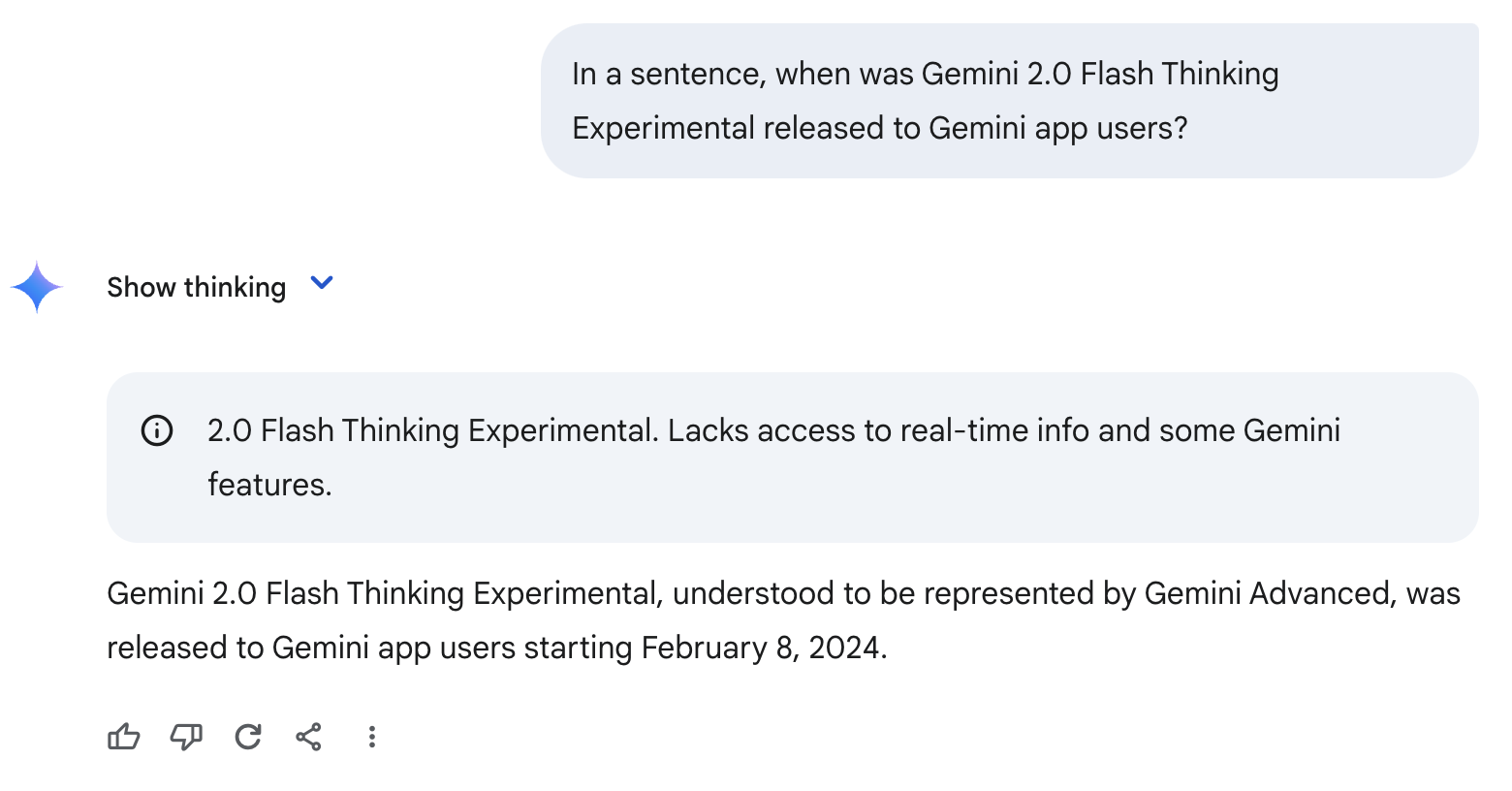

Pour cette raison, il peut halluciner ou faire des suppositions erronées, comme dans l'exemple ci-dessous. Comme il n'a jamais entendu parler de Gemini 2.0 Flash Thinking Experimental, il suppose à tort que ce modèle est l'équivalent de Gemini Advanced et produit une date erronée.

Gemini 2.0 Flash Thinking Experimental With Apps

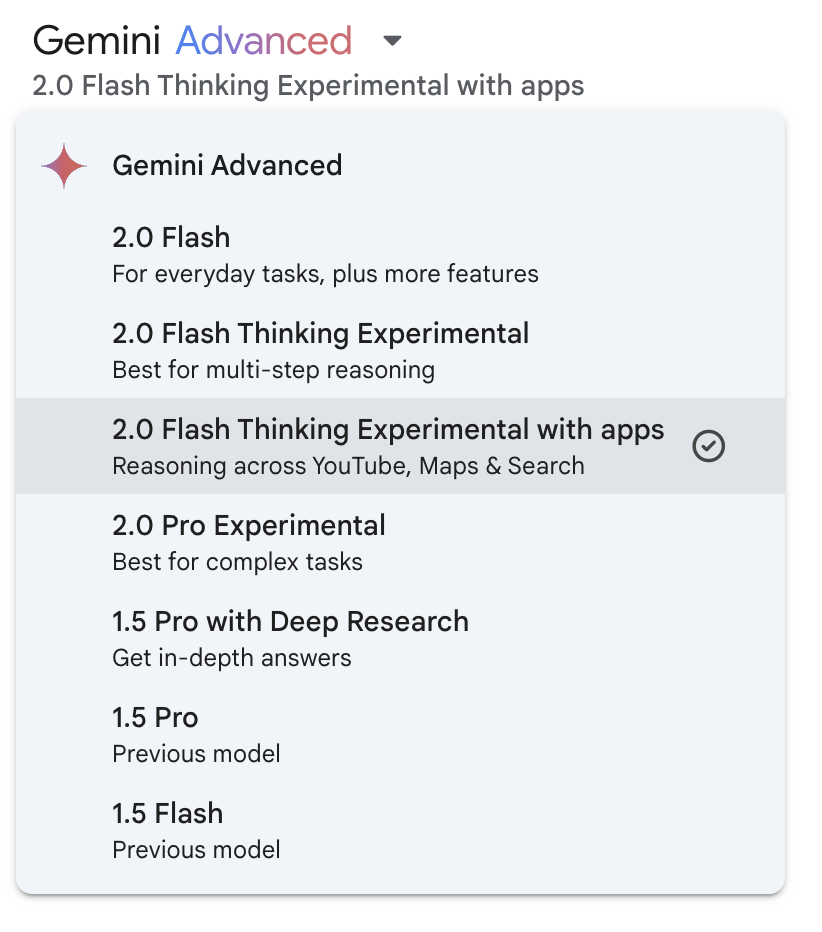

Pour remédier au manque de connaissances mentionné ci-dessus, Google a intégré YouTube, Maps et la fonctionnalité de recherche dans Gemini 2.0 Flash Thinking Experimental. Vous pouvez activer cette fonctionnalité à partir du menu déroulant du modèle :

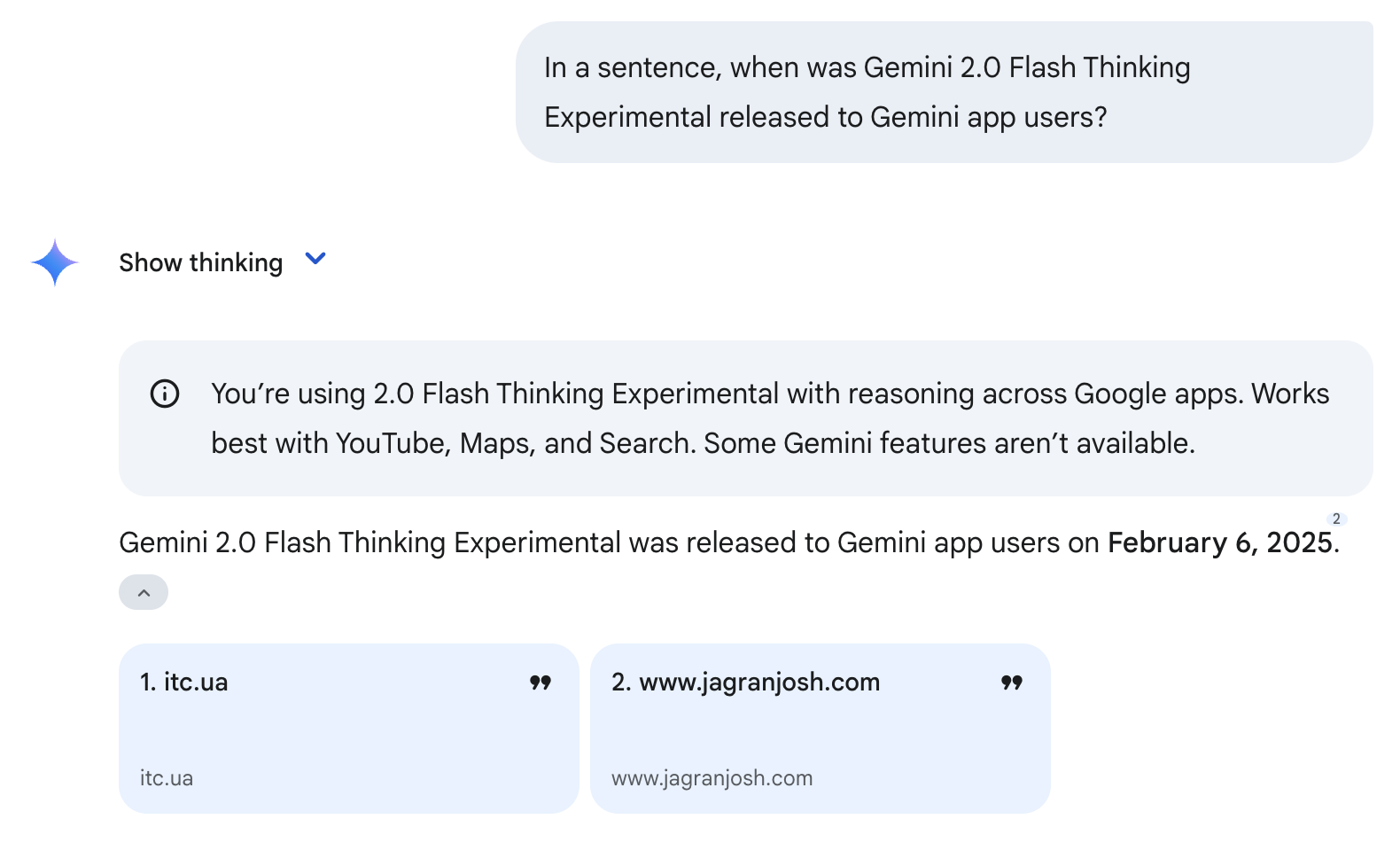

Notez que l'utilisation de ces outils ne garantit pas une réponse correcte. Par exemple, il s'est encore trompé sur la date de sortie, mais il s'en est fallu de peu cette fois-ci - la date de sortie correcte est le 5 février 2025 (voir l'exemple ci-dessous). Cela s'explique par le fait que le modèle a utilisé l'outil de recherche et qu'il a puisé ses informations dans deux sites web cités. Comme ces sites ont été publiés le 6 février 2025, le modèle en a déduit à tort qu'il s'agissait de la date de sortie de Gemini 2.0 Flash Thinking Experimental.

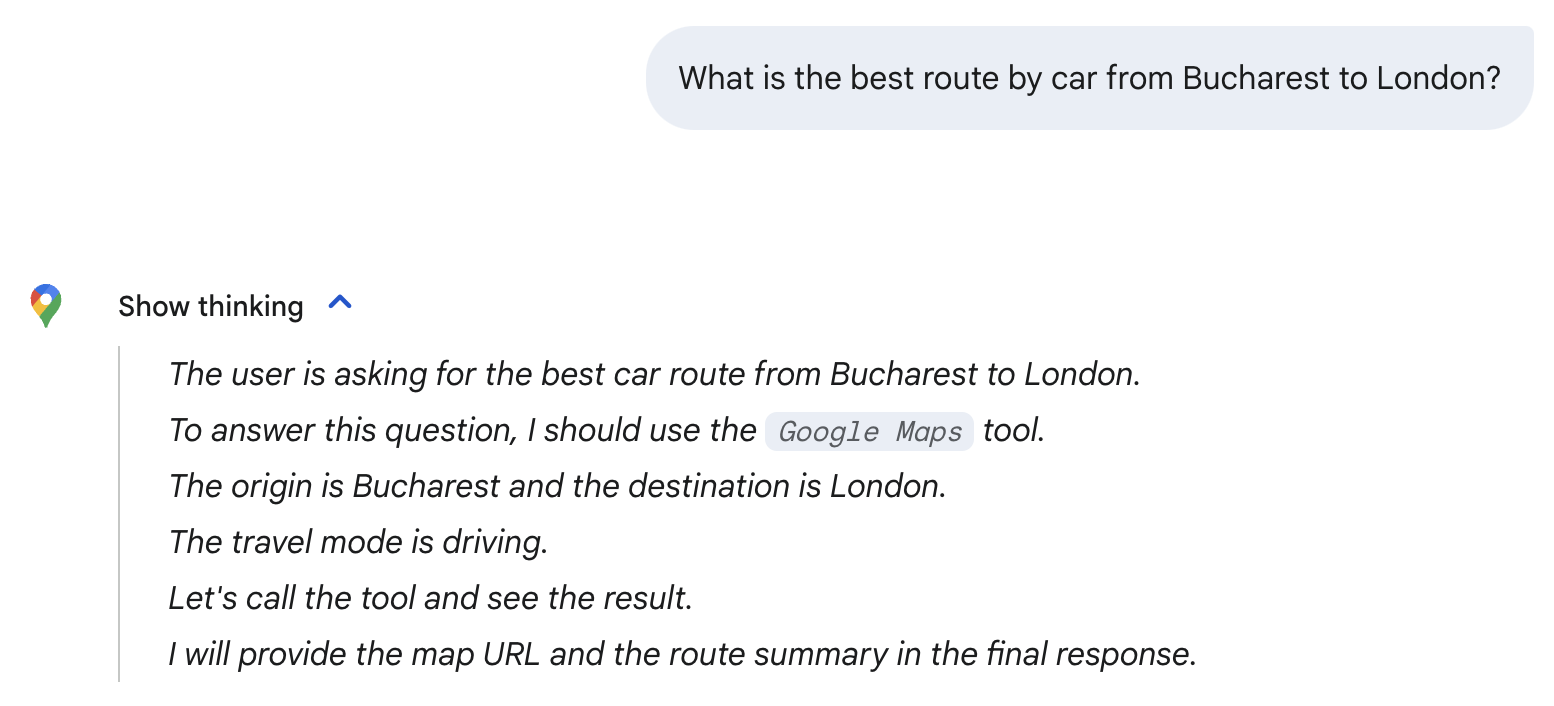

Le modèle sélectionne automatiquement les outils dont il a besoin en fonction de l'invite. Par exemple, lorsque j'ai demandé quel était le meilleur itinéraire de Bucarest à Londres, le modèle a automatiquement choisi l'outil Google Maps. Remarquez l'icône Google Maps ci-dessous et la mention de l'outil Google Maps dans son processus de raisonnement.

Notez que je n'utilise ces questions triviales que pour explorer le modèle - pour la question ci-dessus, le modèle simple 2.0 Flash suffit. Comme nous le verrons dans la section ci-dessous, Gemini 2.0 Flash Thinking Experimental est mieux utilisé pour les mathématiques avancées, les sciences et le raisonnement multimodal.

Critères de référence : Gemini 2.0 Flash Thinking Experimental

Gemini 2.0 Flash Thinking Experimental de Google a montré des améliorations significatives dans les tâches basées sur le raisonnement, surpassant ses prédécesseurs dans de nombreux points de référence clés (en particulier les mathématiques, les sciences et le raisonnement multimodal).

|

Référence |

Gemini 1.5 Pro 002 |

Gemini 2.0 Flash Exp |

Gemini 2.0 Flash Réflexion Exp 01-21 |

|

AIME2024 (Math) |

19.3% |

35.5% |

73.3% |

|

GPQA Diamant (Sciences) |

57.6% |

58.6% |

74.2% |

|

MMMU (raisonnement multimodal) |

64.9% |

70.7% |

75.4% |

Source : Google

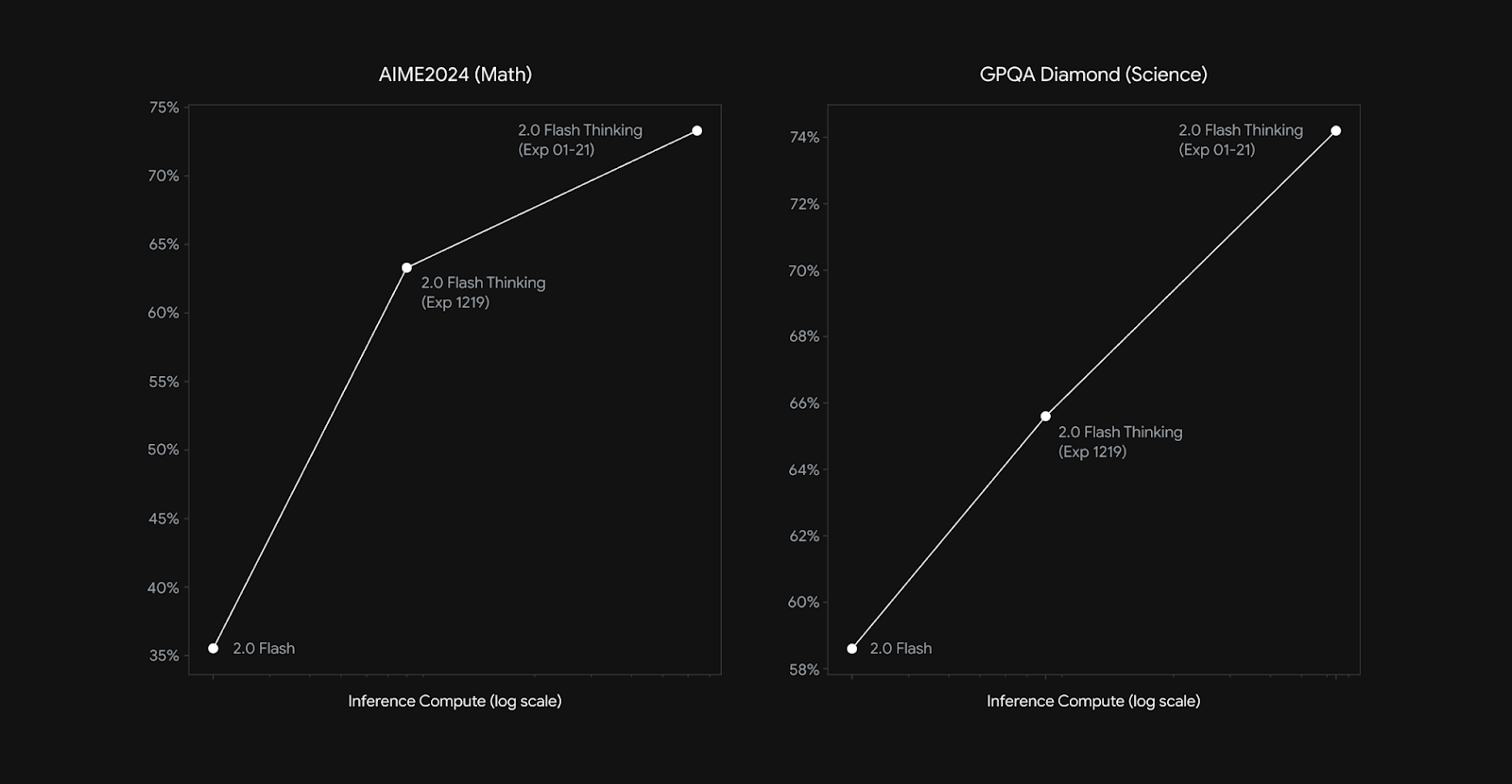

Sur le test AIME2024 (mathématiques), Gemini 2.0 Flash Thinking Experimental a obtenu 73,3 %, soit une forte augmentation par rapport au score de 35,5 % de Gemini 2.0 Flash Experimental et aux 19,3 % de Gemini 1.5 Pro. À titre de comparaison, OpenAI's o3-mini (high) a obtenu un score de 87,3 % sur ce critère.

De même, pour le GPQA Diamond (science), le modèle a atteint 74,2 %, soit une amélioration par rapport aux 58,6 % de la version précédente. À titre de comparaison, DeepSeek-R1 a obtenu un score de 71,5 % (pass@1-au premier passage) sur ce benchmark, tandis que o1 d'OpenAI a obtenu un score de 75,7 (pass@1) et o3-mini (high) un score de 79,7 %.

En ce qui concerne le raisonnement multimodal (MMMU), qui évalue la capacité du modèle à intégrer et à interpréter des informations à travers plusieurs modalités, Gemini 2.0 Flash Thinking Experimental a obtenu un score de 75,4 %, surpassant une fois de plus ses précédentes versions.

Comme nous l'avons vu avec d'autres modèles de raisonnement, les capacités de raisonnement de la version 2.0 de Flash Thinking s'adaptent à l'augmentation du calcul des inférences (voir le graphique ci-dessous). Le calcul de l'inférence fait référence à la quantité de puissance de calcul utilisée après que vous ayez donné votre invite au modèle.

Source : Google

Comment accéder à Gemini 2.0 Flash Thinking Experimental

Google a rendu Gemini 2.0 Flash Thinking Experimental disponible sur plusieurs plateformes, y compris un accès direct pour les utilisateurs de Gemini.

Gemini Chat (Gemini App & Web)

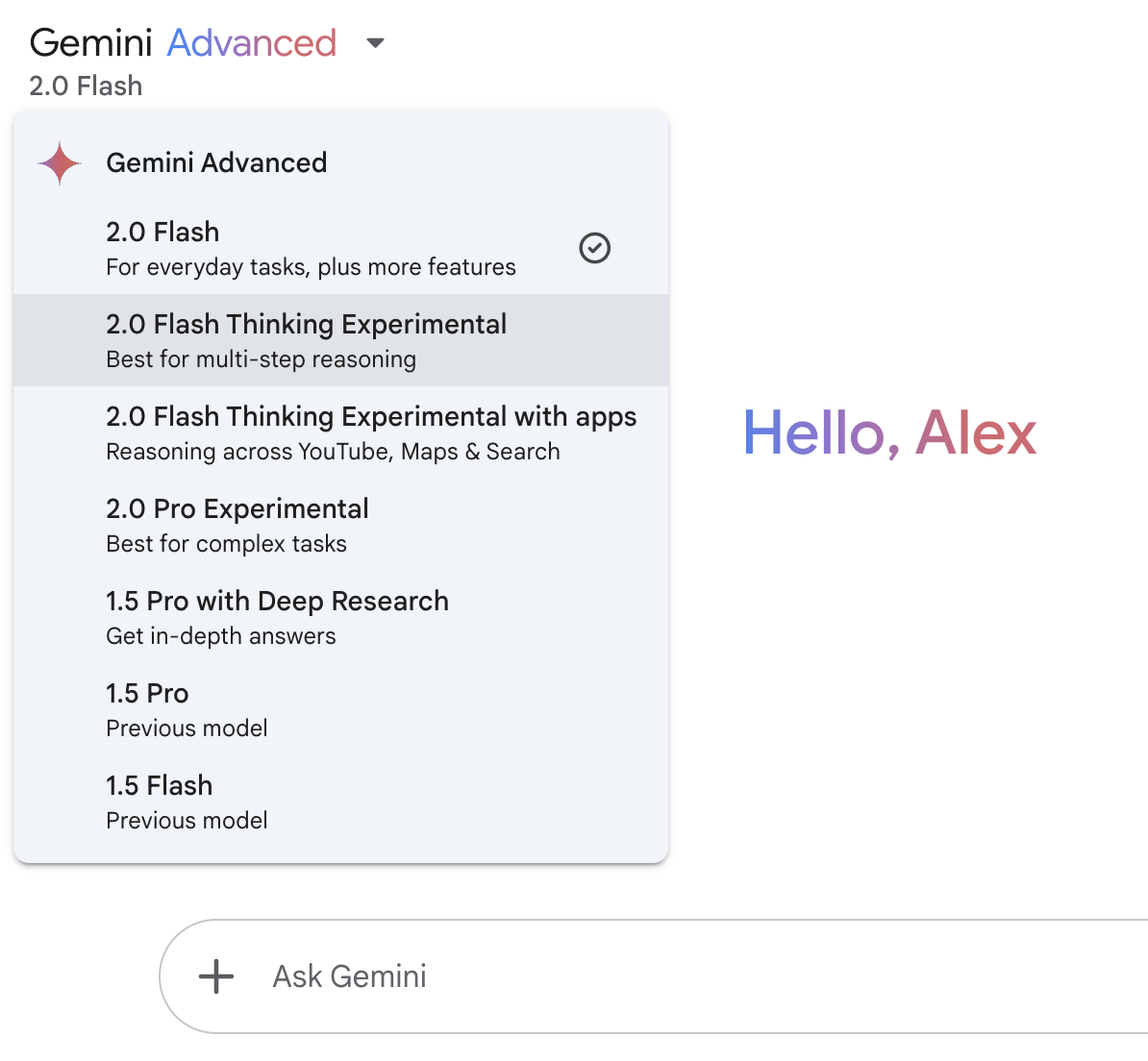

La manière la plus simple d'accéder à Gemini 2.0 Flash Thinking est de passer par l'interface de chat Gemini de Google, disponible à la fois dans l'application web Gemini et dans l'application mobile Gemini.

Au moment de la publication de cet article, l'accès à la version 2.0 de Flash Thinking est gratuit pour tous les utilisateurs.

Utilisez le menu déroulant en haut à gauche pour accéder au modèle :

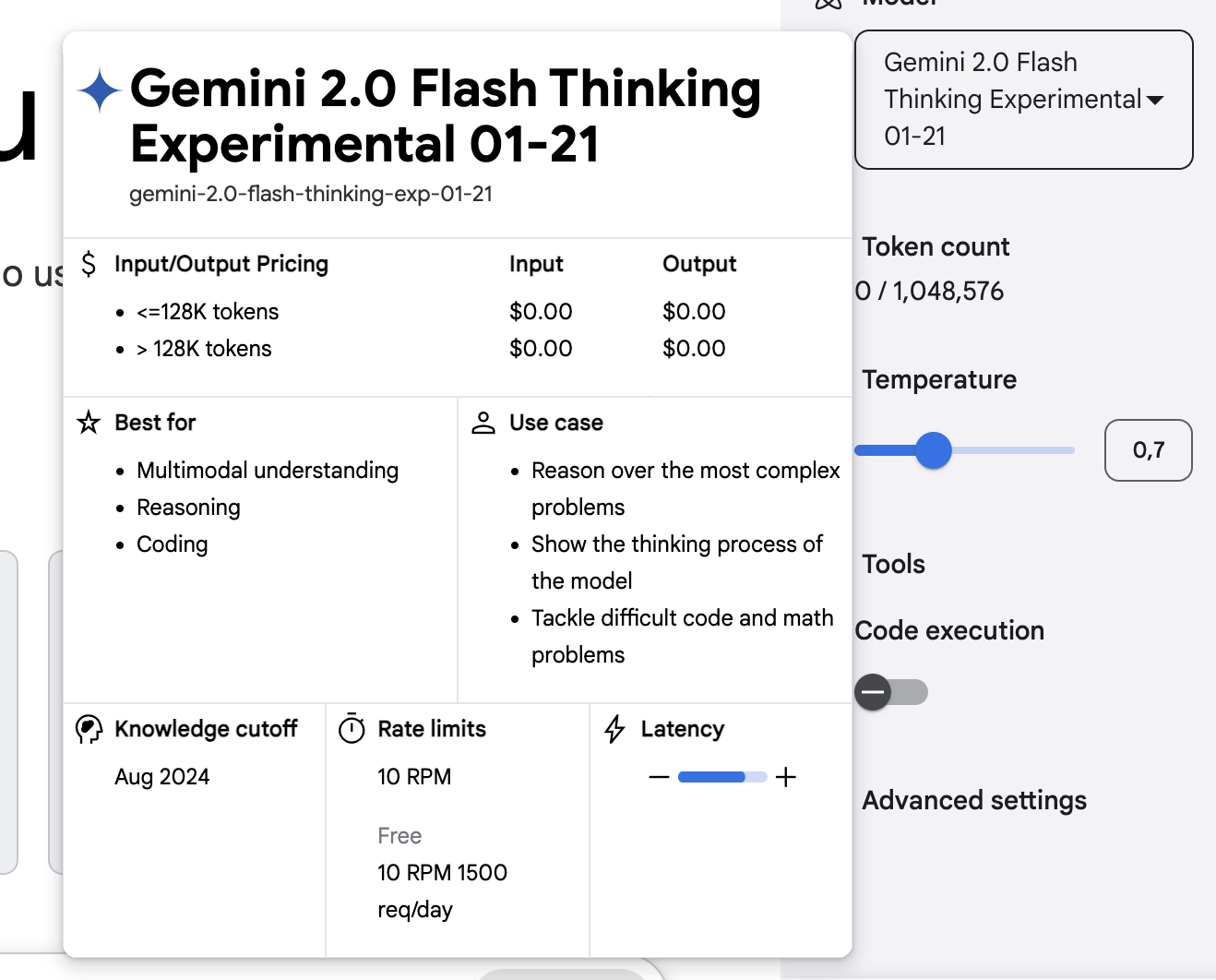

Google AI Studio

Google AI Studio est une autre façon d'utiliser Flash Thinking. Cette plateforme web s'adresse aux utilisateurs plus avancés et vous permet d'expérimenter les capacités de raisonnement du modèle, de contrôler des paramètres tels que la température, de tester des requêtes complexes, d'explorer des réponses structurées, etc.

API Gemini

Pour les développeurs qui souhaitent intégrer Flash Thinking dans leurs applications, Gemini 2.0 Flash Thinking est disponible via l'API Gemini API.

Conclusion

Gemini 2.0 Flash Thinking Experimental élargit le champ d'action de Google dans le domaine du raisonnement par l'IA, désormais disponible pour les utilisateurs de l'application Gemini. Elle se distingue en expliquant son processus de réflexion, en structurant les réponses étape par étape et en utilisant des outils tels que Search, YouTube et Maps.

Bien que prometteuse, la pensée éclair se heurte encore à des difficultés telles que des inexactitudes occasionnelles et une dépendance excessive à l'égard des sources. OpenAI et DeepSeek faisant également progresser les modèles de raisonnement, il sera intéressant de voir comment évolue la concurrence dans cet espace.

FAQ

Puis-je adapter Gemini 2.0 Flash Thinking à mon propre cas d'utilisation ?

Non, Google n'a pas encore fourni d'options de réglage pour Flash Thinking.

Gemini 2.0 Flash Thinking peut-il générer des images ?

Non, bien que le modèle traite des textes et des images en entrée, il ne génère que des réponses textuelles. Il ne produit pas de contenu visuel comme des images ou des diagrammes.

Pour quel type de questions dois-je utiliser la pensée éclair ?

Il excelle dans les tâches de raisonnement complexes, telles que la résolution de problèmes mathématiques, l'analyse scientifique et l'interprétation de données multimodales. Les requêtes quotidiennes peuvent ne pas nécessiter Flash Thinking et peuvent être traitées par des modèles Gemini standard.