Lernpfad

Dieses Jahr wurde als das Jahr der agentenbasierten KI vorausgesagt, aber für mich fühlt es sich eher wie das Jahr der Denkmodelle an. Google hat soeben Gemini 2.0 Flash Thinking Experimental für Gemini-App-Nutzer eingeführt und damit den Zugang über die bisherige Verfügbarkeit in Google AI Studio, der Gemini API und Vertex AI hinaus erweitert.

Das 2.0 Flash Thinking Modell ist so konzipiert, dass es mit anderen Denkmodellen aus der OpenAI's o-series und DeepSeek's R-Serie.

Anstatt nur Antworten zu geben, konzentriert sich Flash Thinking darauf, seinen Denkprozess zu zeigen - Schritte aufzuschlüsseln, Alternativen zu bewerten und die Argumentation transparenter zu machen. Mein erster Eindruck ist, dass die Chat-basierte Version von Gemini 2.0 Flash Thinking merklich schneller ist als die OpenAI- und DeepSeek-Versionen.

In diesem Blog erfährst du, was Gemini 2.0 Flash Thinking Experimental ist, wie du es nutzen kannst, was die Benchmarks sind und wie und warum du es zusammen mit Tools wie Search, Maps und YouTube nutzen solltest.

KI-Upskilling für Einsteiger

Was ist Gemini 2.0 Flash Thinking Experimentell?

Google hat mit Gemini 2.0 Flash Thinking Experimental ein neues KI-Modell vorgestellt, das für fortgeschrittenes logisches Denken entwickelt wurde. Ursprünglich war sie über Google AI Studio, die Gemini API und Vertex AI verfügbar, aber jetzt wurde sie auch für Nutzer der Gemini-App eingeführt.

Im Gegensatz zu Standard-Sprachmodellen, bei denen das Erzeugen von flüssigen Antworten im Vordergrund steht, zielt Flash Thinking darauf ab, den Denkprozess aufzuschlüsseln, Schritt für Schritt zu argumentieren, mehrere Optionen zu bewerten und die Schlussfolgerungen auf strukturiertere Weise zu erklären.

Gemini 2.0 Flash Thinking Experimental ist eine multimodale KI Modell, das heißt, es kann sowohl Text als auch Bilder als Eingabe verarbeiten. Das bedeutet, dass wir sie für Aufgaben nutzen können, die einen visuellen Kontext erfordern, wie z. B. die Interpretation von Diagrammen, die Analyse von Tabellen oder die Gewinnung von Erkenntnissen aus komplexen Dokumenten.

Im Gegensatz zu einigen anderen multimodalen Modellen erzeugt Flash Thinking jedoch nur textbasierte Ausgaben, d.h. es erzeugt keine Bilder oder visuellen Daten als Antwort.

Eines der herausragenden Merkmale ist das riesige Kontextfenster, das bis zu 1 Million Token für die Eingabe unterstützt und Antworten mit bis zu 64.000 Token erzeugt. Das macht sie zu einem der umfangreichsten KI-Modelle, die es für das Denken in langen Formen gibt. So kann sie ganze Bücher, Forschungsarbeiten oder längere Gespräche analysieren und dabei die Kohärenz wahren.

Die große Token-Grenze stellt sicher, dass das Modell komplexe Argumente über längere Interaktionen hinweg verfolgen kann, so dass die Nutzer/innen den Kontext nicht immer wieder neu einbringen müssen.

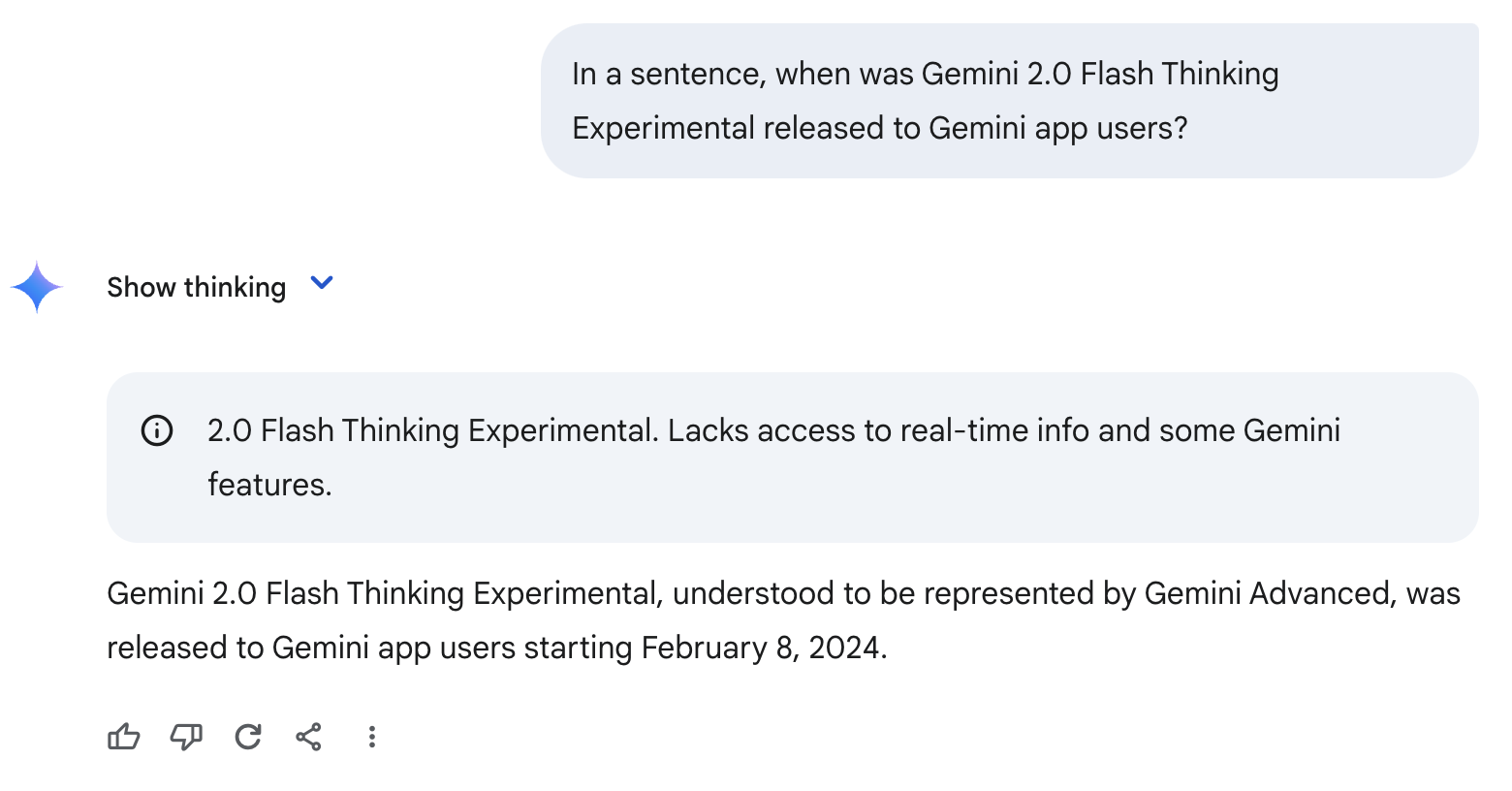

Eine wichtige Einschränkung, die du beachten musst, ist, dass Flash Thinking einen Wissensstopp im Juni 2024 hat. Das bedeutet, dass es kein eingebautes Wissen über Ereignisse jenseits dieses Punktes hat.

Aus diesem Grund kann es halluzinieren oder falsche Annahmen treffen, wie in dem Beispiel unten. Weil es noch nie von Gemini 2.0 Flash Thinking Experimental gehört hat, nimmt es fälschlicherweise an, dass dieses Modell das Äquivalent zu Gemini Advanced ist und gibt ein falsches Datum aus.

Gemini 2.0 Flash Thinking Experimentell mit Apps

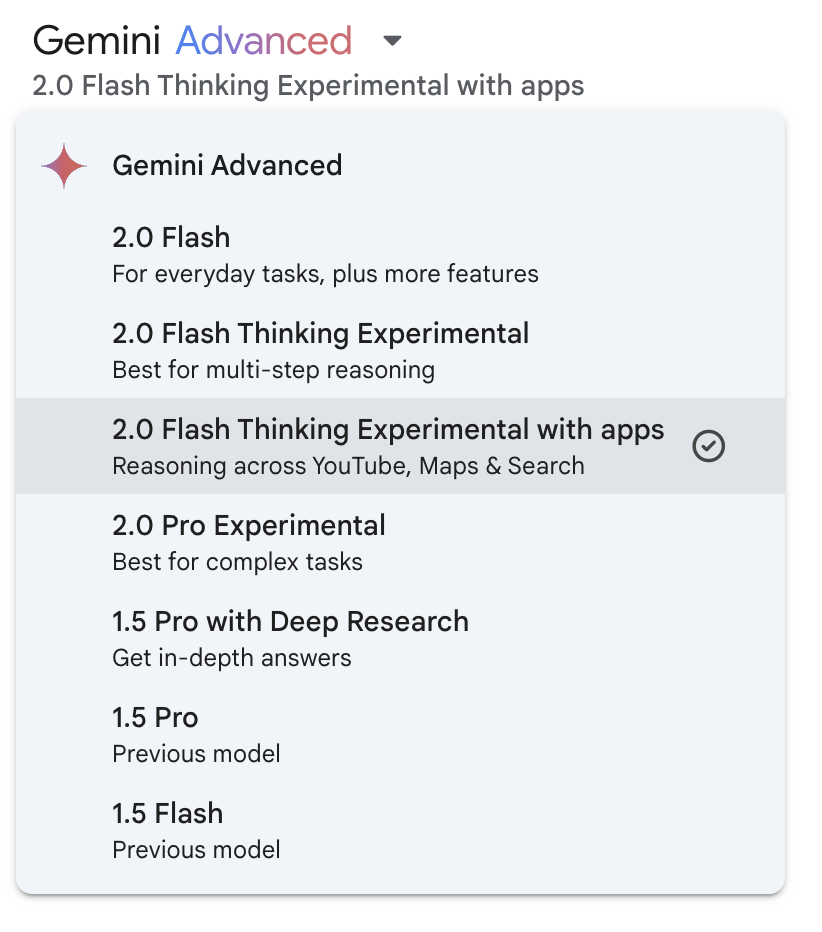

Um die oben erwähnte Wissenslücke zu schließen, hat Google YouTube, Maps und die Suchfunktion in Gemini 2.0 Flash Thinking Experimental integriert. Du kannst diese Funktion über das Dropdown-Menü des Modells aktivieren:

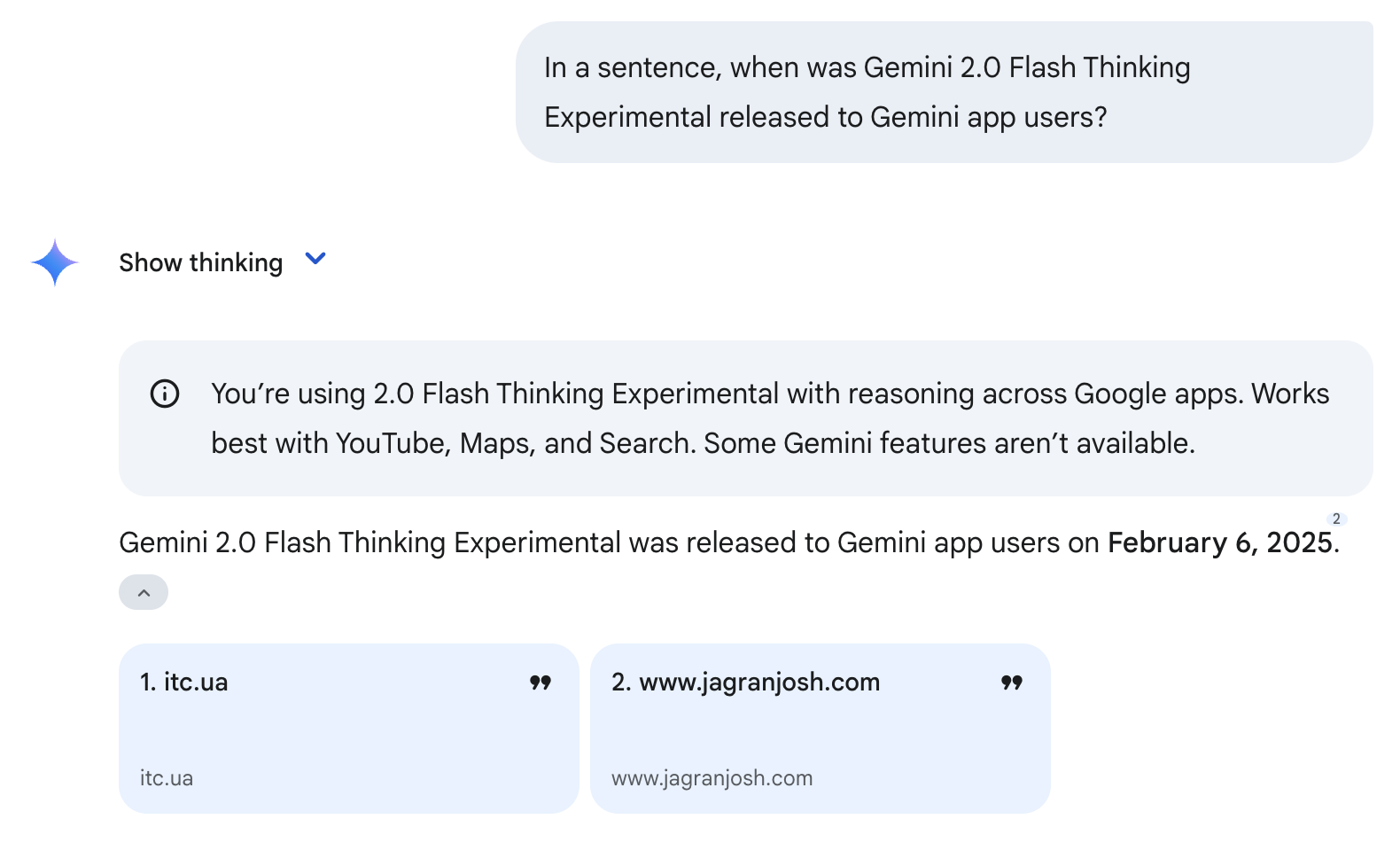

Beachte, dass die Verwendung dieser Tools keine Garantie für eine richtige Antwort ist. Zum Beispiel ist das Veröffentlichungsdatum immer noch falsch, aber dieses Mal viel näher dran - das richtige Datum ist der 5. Februar 2025 (siehe Beispiel unten). Dies geschah, weil das Modell die Suchfunktion verwendete und seine Informationen von zwei zitierten Websites bezog. Da diese Seiten am 6. Februar 2025 veröffentlicht wurden, hat das Modell fälschlicherweise angenommen, dass dies das Veröffentlichungsdatum von Gemini 2.0 Flash Thinking Experimental war.

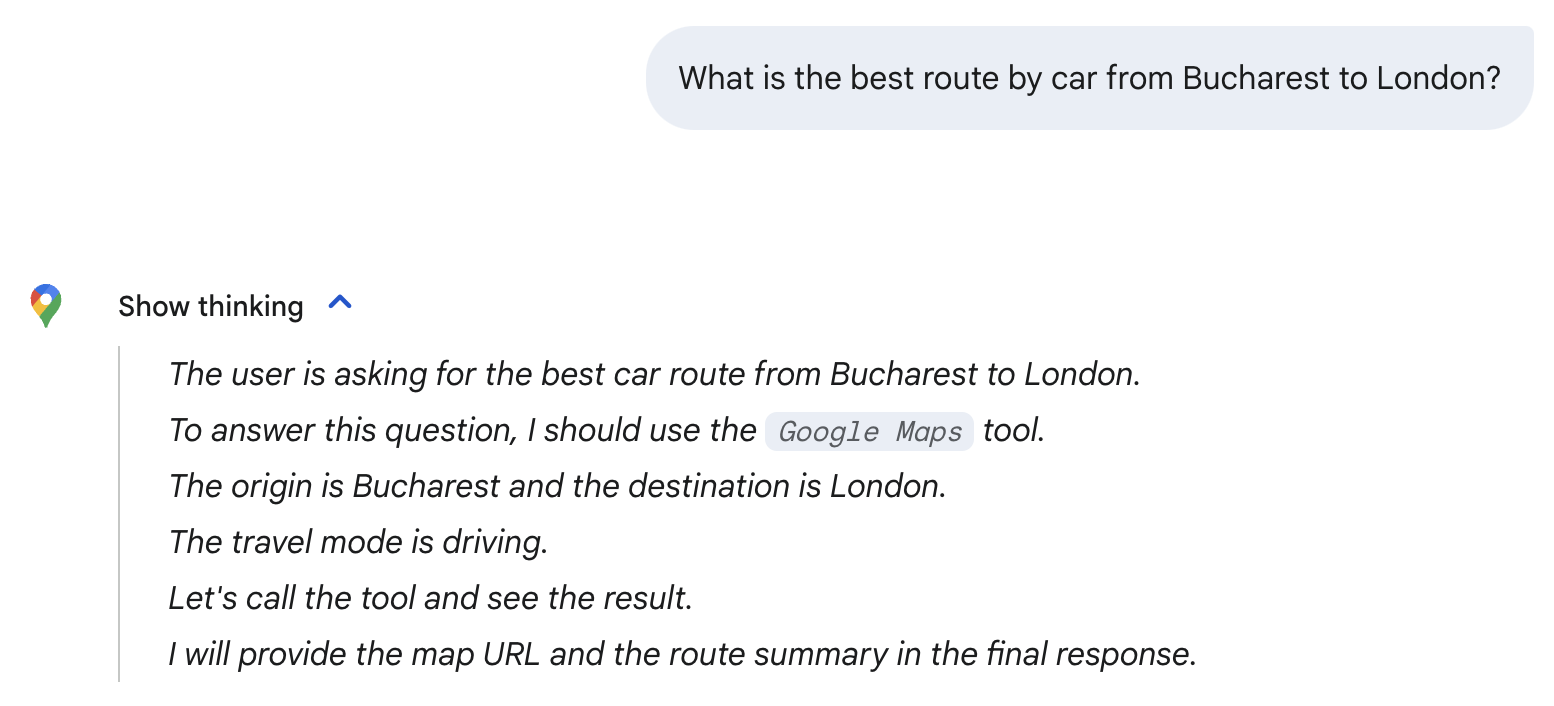

Das Modell wählt automatisch die Werkzeuge aus, die es braucht, je nach Aufforderung. Als ich zum Beispiel nach der besten Fahrtroute von Bukarest nach London fragte, wählte das Modell automatisch das Tool Google Maps. Beachte das Google Maps-Symbol unten und die Erwähnung des Google Maps-Tools in der Argumentation.

Beachte, dass ich diese trivialen Fragen nur benutze, um das Modell zu erkunden - für die obige Frage reicht das einfache 2.0 Flash-Modell aus. Wie wir im folgenden Abschnitt sehen werden, eignet sich Gemini 2.0 Flash Thinking Experimental am besten für fortgeschrittene Mathematik, Naturwissenschaften und multimodales Denken.

Benchmarks: Gemini 2.0 Flash Thinking Experimentell

Googles Gemini 2.0 Flash Thinking Experimental hat deutliche Verbesserungen bei schlussfolgernden Aufgaben gezeigt und seine Vorgänger in mehreren wichtigen Benchmarks (mit Schwerpunkt auf Mathematik, Naturwissenschaften und multimodalem Denken) übertroffen.

|

Benchmark |

Zwilling 1.5 Pro 002 |

Gemini 2.0 Flash Exp |

Gemini 2.0 Flash Nachdenken Exp 01-21 |

|

AIME2024 (Mathematik) |

19.3% |

35.5% |

73.3% |

|

GPQA Diamant (Wissenschaft) |

57.6% |

58.6% |

74.2% |

|

MMMU (Multimodale Argumentation) |

64.9% |

70.7% |

75.4% |

Source: Google

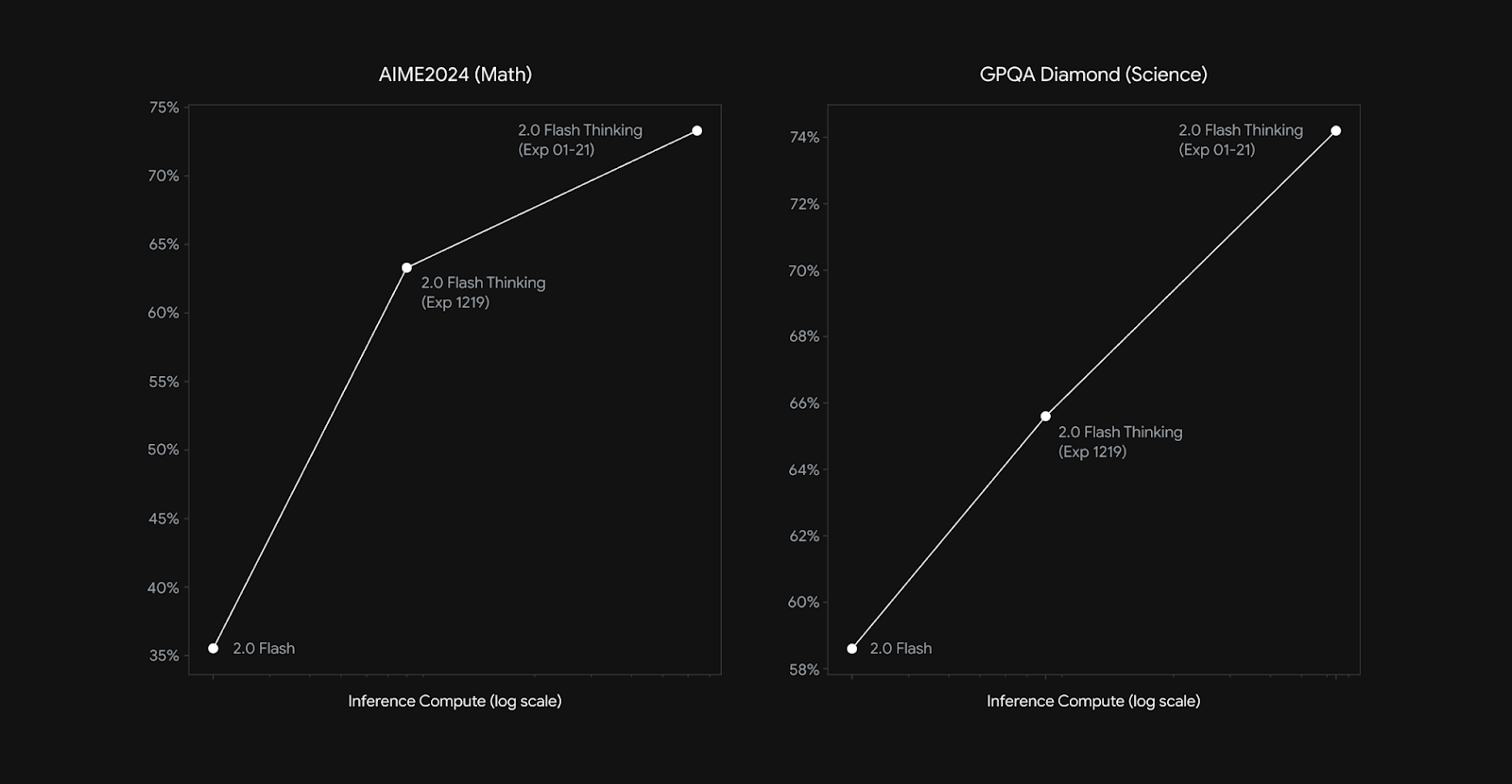

Beim AIME2024 (Mathe) Benchmark erreichte Gemini 2.0 Flash Thinking Experimental 73,3 %, eine große Steigerung gegenüber den 35,5 % von Gemini 2.0 Flash Experimental und den 19,3 % von Gemini 1.5 Pro. Zum Vergleich, OpenAIs o3-mini (hoch) hat bei diesem Benchmark 87,3 % erreicht.

Auch bei GPQA Diamond (Wissenschaft) erreichte das Modell 74,2 % und verbesserte sich damit gegenüber den 58,6 % der Vorgängerversion. Zum Vergleich: DeepSeek-R1 erreichte bei diesem Benchmark 71,5 % (pass@1-im ersten Durchgang), während OpenAIs o1 75,7 (pass@1) und o3-mini (hoch) 79,7 % erreichten.

Im MMMU-Test (Multimodal Reasoning), der die Fähigkeit des Modells bewertet, Informationen über mehrere Modalitäten hinweg zu integrieren und zu interpretieren, erreichte Gemini 2.0 Flash Thinking Experimental 75,4 % und übertraf damit erneut seine früheren Versionen.

Genau wie bei anderen Argumentationsmodellen skalieren auch die Argumentationsfähigkeiten von Flash Thinking 2.0 mit zunehmender Anzahl von Schlussfolgerungen (siehe Grafik unten). Inferenzberechnung bezieht sich auf die Menge an Rechenleistung, die verwendet wird, nachdem du deine Eingabeaufforderung an das Modell gegeben hast.

Quelle: Google

Wie man auf Gemini 2.0 Flash Thinking Experimental zugreift

Google hat Gemini 2.0 Flash Thinking Experimental über mehrere Plattformen verfügbar gemacht, einschließlich des direkten Zugangs für Gemini-Nutzer.

Gemini Chat (Gemini App & Web)

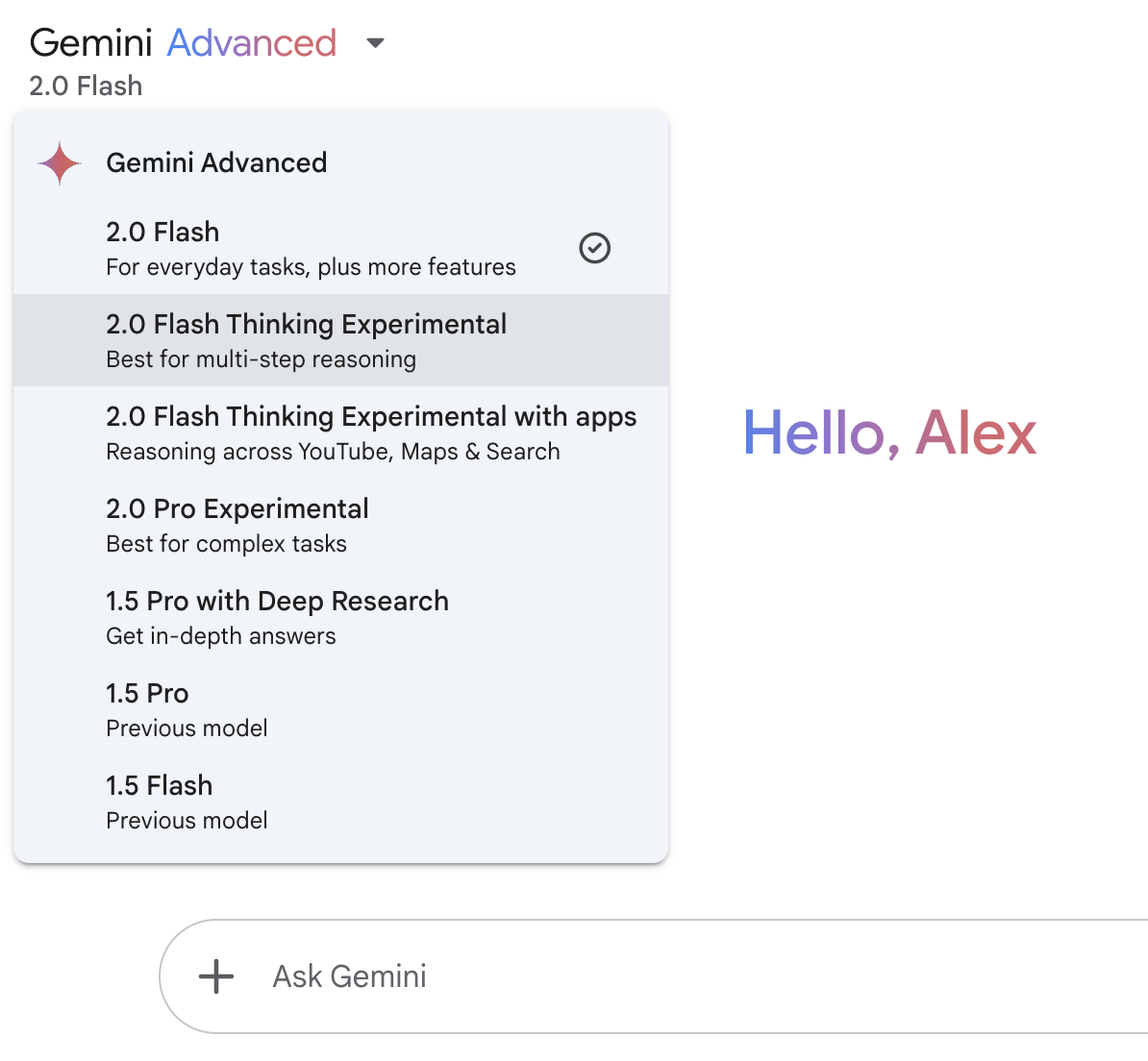

Der einfachste Weg, auf Gemini 2.0 Flash Thinking zuzugreifen, ist über Googles Gemini Chat-Schnittstelle, die sowohl in der Gemini Web App als auch in der Gemini Mobile App verfügbar ist.

Zum Zeitpunkt der Veröffentlichung dieses Artikels ist der Zugang zu 2.0 Flash Thinking für alle Nutzer kostenlos.

Verwende das Dropdown-Menü oben links, um das Modell aufzurufen:

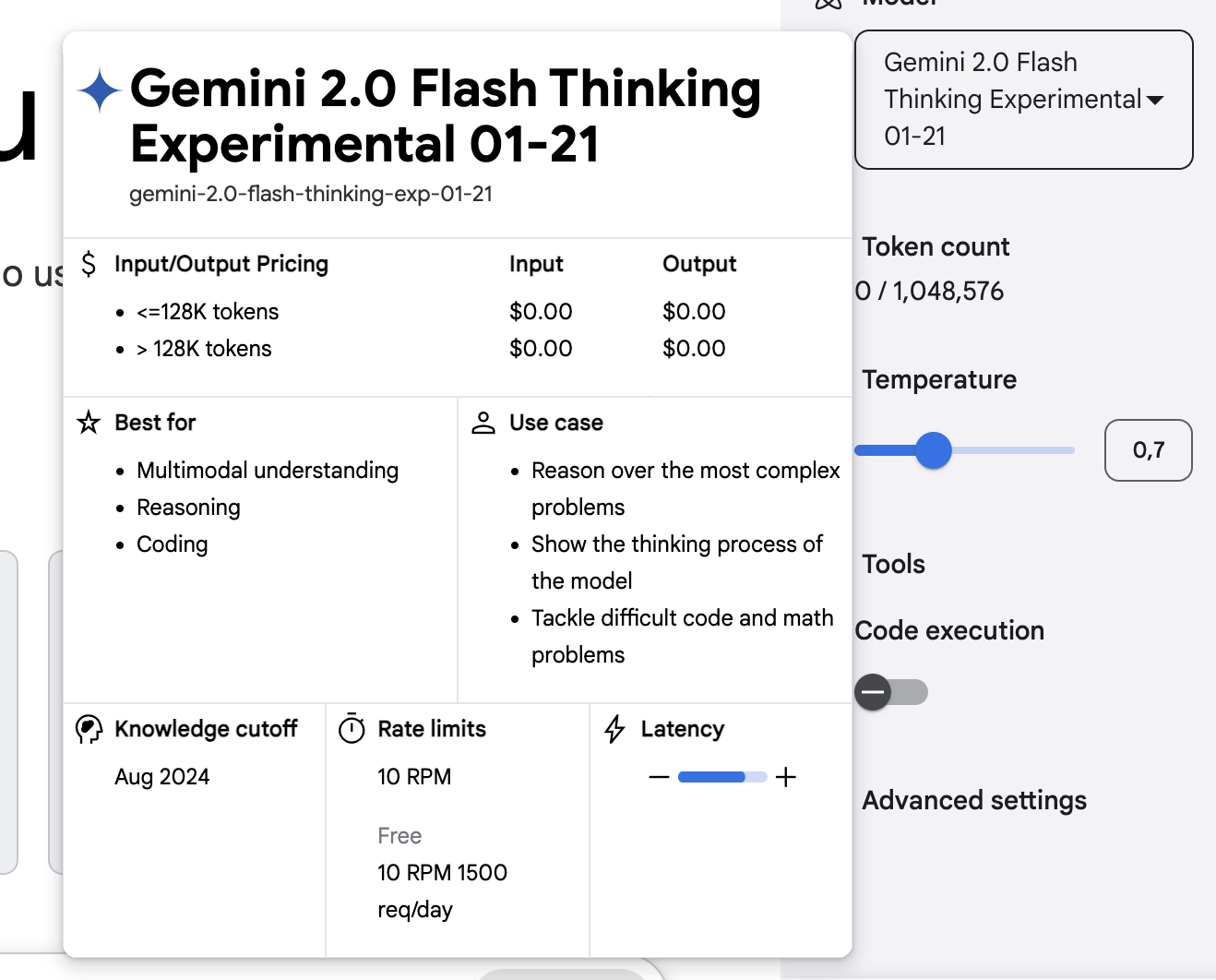

Google AI Studio

Google AI Studio ist eine weitere Möglichkeit, Flash Thinking zu nutzen. Diese webbasierte Plattform richtet sich an fortgeschrittene Nutzer/innen und ermöglicht es dir, mit den Argumentationsfähigkeiten des Modells zu experimentieren, Parameter wie die Temperatur zu kontrollieren, komplexe Abfragen zu testen, strukturierte Antworten zu untersuchen usw.

Gemini API

Für Entwickler, die Flash Thinking in ihre Anwendungen integrieren möchten, ist Gemini 2.0 Flash Thinking über die Gemini API.

Fazit

Gemini 2.0 Flash Thinking Experimental erweitert Googles Vorstoß in die KI und ist jetzt für Nutzer der Gemini-App verfügbar. Es zeichnet sich dadurch aus, dass es seinen Gedankengang erklärt, Antworten Schritt für Schritt strukturiert und Tools wie Suche, YouTube und Karten verwendet.

Flash Thinking ist zwar vielversprechend, hat aber auch mit Problemen zu kämpfen, wie z. B. gelegentlichen Ungenauigkeiten und einer zu starken Abhängigkeit von Quellen. Da OpenAI und DeepSeek ebenfalls Denkmodelle entwickeln, wird es interessant zu sehen sein, wie sich der Wettbewerb in diesem Bereich entwickelt.

FAQs

Kann ich das Gemini 2.0 Flash Thinking für meinen eigenen Anwendungsfall feinabstimmen?

Nein, Google hat noch keine Feinabstimmungsoptionen für Flash Thinking bereitgestellt.

Kann Gemini 2.0 Flash Thinking Bilder erzeugen?

Nein, das Modell verarbeitet zwar Text und Bilder als Eingaben, aber es erzeugt nur textbasierte Antworten. Sie produziert keine visuellen Inhalte wie Bilder oder Diagramme.

Für welche Art von Fragen sollte ich Flash Thinking verwenden?

Er zeichnet sich durch komplexe Denkaufgaben aus, wie z.B. mathematisches Problemlösen, wissenschaftliche Analysen und multimodale Dateninterpretation. Alltägliche Abfragen erfordern kein Flash Thinking und können mit den Standard-Gemini-Modellen bearbeitet werden.