Curso

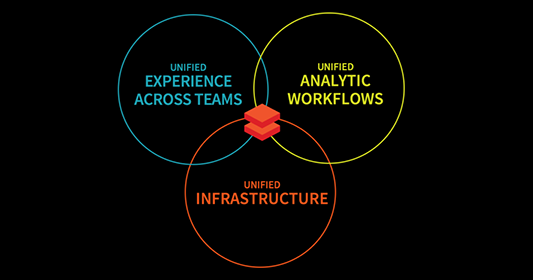

Databricks es una plataforma analítica abierta para construir, desplegar y mantener soluciones de datos, análisis e IA a escala. Está basado en Apache Spark y se integra con cualquiera de los tres principales proveedores de la nube (AWS, Azure o GCP), lo que nos permite gestionar y desplegar la infraestructura de la nube en nuestro nombre, a la vez que ofrecemos cualquier aplicación de ciencia de datos que puedas imaginar.

Hoy quiero guiarte a través de una completa introducción a Databricks, cubriendo sus características principales, aplicaciones prácticas y rutas de aprendizaje estructuradas para que puedas empezar. Desde la configuración de tu entorno hasta el dominio del procesamiento de datos, la orquestación y la visualización, encontrarás todo lo que necesitas para empezar con Databricks.

¿Por qué aprender Databricks?

Aprender Databricks y tener unas bases sólidas en él puede tener varias ventajas positivas principales para ti:

Databricks tiene muchas aplicaciones

Databricks tiene amplias aplicaciones que permiten a las empresas transformar datos, limpiar, procesar y optimizar grandes conjuntos de datos para obtener información. Permite la analítica avanzada para una mejor toma de decisiones mediante la exploración y visualización de datos; apoya el desarrollo y despliegue de modelos predictivos y soluciones de IA.

Databricks te dará ventaja

Databricks ofrece una ventaja competitiva gracias a su compatibilidad con la nube. Construido sobre Apache Spark, se integra con las mejores herramientas de datos como AWS, Azure y Google Cloud... El dominio de Databricks te posiciona como líder en cualquier industria que se preocupe por los datos.

Características principales de Databricks

Databricks es una plataforma integral para la ingeniería de datos, la analítica y el aprendizaje automático, que combina cinco características principales que mejoran la escalabilidad, la colaboración y la eficacia del flujo de trabajo.

Características principales de Databricks. Imagen del autor.

Plataforma de datos unificada

Databricks combina los tres flujos de trabajo de ingeniería de datos, ciencia de datos y aprendizaje automático en una única plataforma. Esto simplifica aún más el procesamiento de datos, la formación de modelos y la implantación. Al unificar estos dominios, Databricks acelera las iniciativas de IA, ayudando a las empresas a transformar los datos aislados en información práctica, al tiempo que fomenta la colaboración.

Integración con Apache Spark

Apache Spark, el principal marco de computación distribuida, está profundamente integrado con Databricks. Esto permite a Databricks gestionar la configuración de Spark automáticamente. Por tanto, los usuarios pueden centrarse en crear soluciones de datos sin preocuparse de la configuración.

Además, la potencia de procesamiento distribuido de Spark es ideal para tareas de big data, y Databricks la mejora con seguridad, escalabilidad y optimización de nivel empresarial.

Delta Lake

Delta Lake es la columna vertebral de la arquitectura Lakehouse de Databricks, que añade funciones como transacciones ACID, aplicación de esquemas y coherencia de datos en tiempo real. Esto garantiza la fiabilidad y precisión de los datos, lo que convierte a Delta Lake en una herramienta fundamental para gestionar tanto datos por lotes como datos en flujo.

MLflow

MLflow es una plataforma de código abierto para gestionar todo el ciclo de vida del aprendizaje automático. Desde el seguimiento de experimentos hasta la gestión del despliegue de modelos, MLflow simplifica el proceso de creación y puesta en funcionamiento de modelos de ML.

Además, con las últimas integraciones para herramientas de IA generativa como OpenAI y Hugging Face, MLflow amplía sus capacidades para incluir aplicaciones de vanguardia como chatbots, resumen de documentos y análisis de sentimientos.

Herramientas de colaboración

Databricks fomenta la colaboración mediante:

- Cuadernos interactivos: Combina código, markdown y elementos visuales para documentar flujos de trabajo y compartir información sin problemas.

- Compartir en tiempo real: Colabora en directo en cuadernos para obtener comentarios instantáneos y agilizar el trabajo en equipo.

- Funciones de control de versiones: Realiza un seguimiento de los cambios e intégralo con Git para una gestión de proyectos segura y eficaz.

Cómo empezar a aprender Databricks

Empezar a utilizar Databricks puede ser tan emocionante como abrumador. Por eso, el primer paso en el aprendizaje de cualquier tecnología nueva es tener claros tus objetivos: por qué quieres aprenderla y cómo piensas utilizarla.

Establece objetivos claros

Antes de sumergirte, define lo que quieres conseguir con Databricks.

¿Buscas agilizar el procesamiento de big data como ingeniero de datos? ¿O estás centrado en aprovechar sus capacidades ML para construir y desplegar modelos predictivos?

Al definir tus objetivos principales, puedes crear un plan de aprendizaje enfocado en consecuencia. Aquí tienes algunos consejos en función de tu principal aspiración:

- Si tu enfoque es la ingeniería de datos prioriza conocer las herramientas de Databricks para la ingestión, transformación y gestión de datos, así como su perfecta integración con Apache Spark y Delta Lake.

- Si tu enfoque es el aprendizaje automático céntrate en comprender MLflow para el seguimiento de experimentos, la gestión de modelos y el despliegue, así como en aprovechar la compatibilidad integrada de la plataforma con bibliotecas como TensorFlow y PyTorch.

Empieza por lo básico:

Empezar a utilizar Databricks puede ser más fácil de lo que crees. Para ello, te guiaré paso a paso, para que puedas familiarizarte fácilmente con lo esencial de la plataforma.

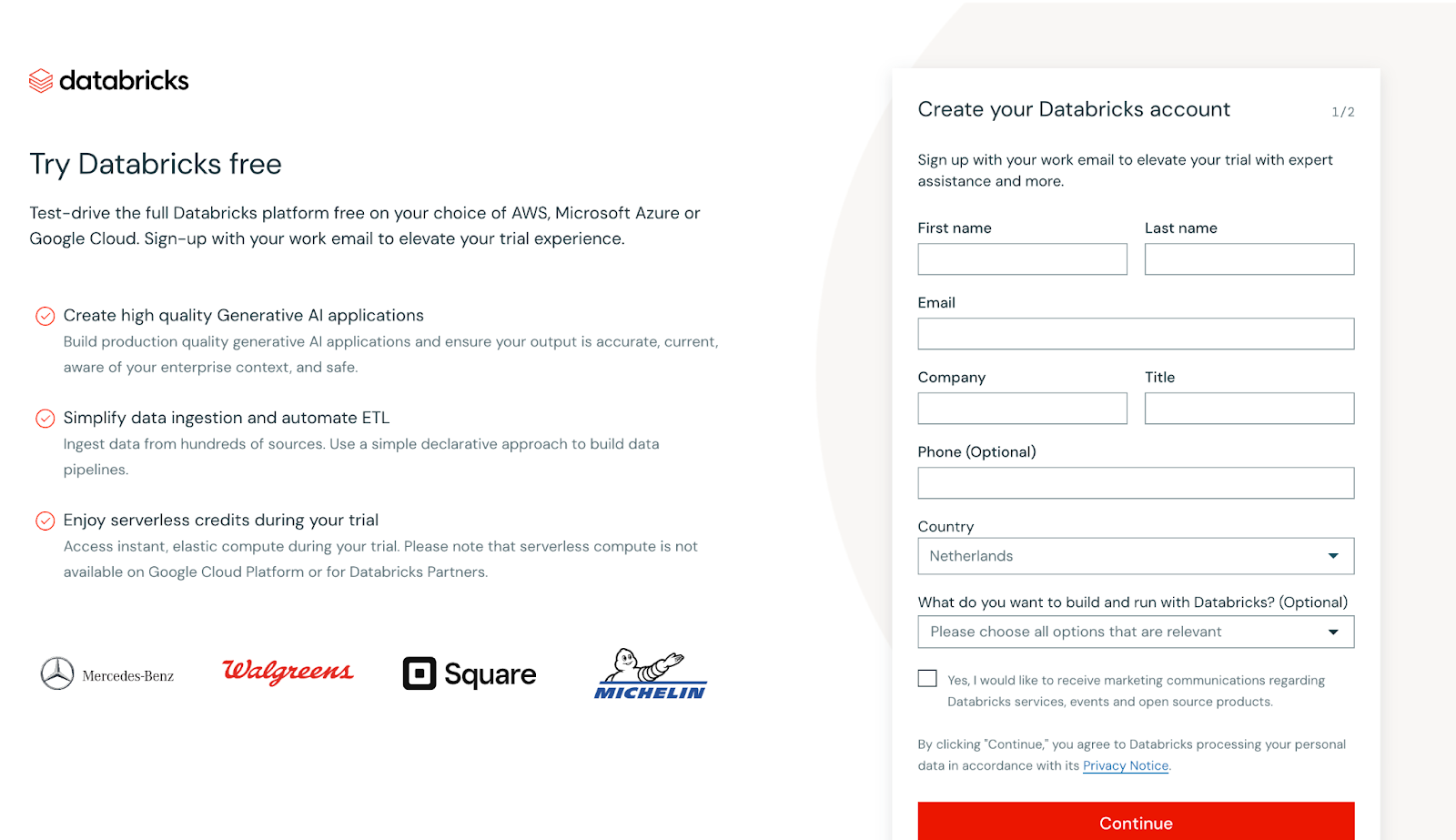

Regístrate gratis

Empieza por crear una cuenta gratuita en Databricks Edición Comunidadque proporciona acceso a las funciones básicas de la plataforma sin coste alguno. Esta edición es perfecta para la exploración práctica, ya que te permite experimentar con Espacios de trabajo, Clusters y Cuadernos sin necesidad de una suscripción de pago.

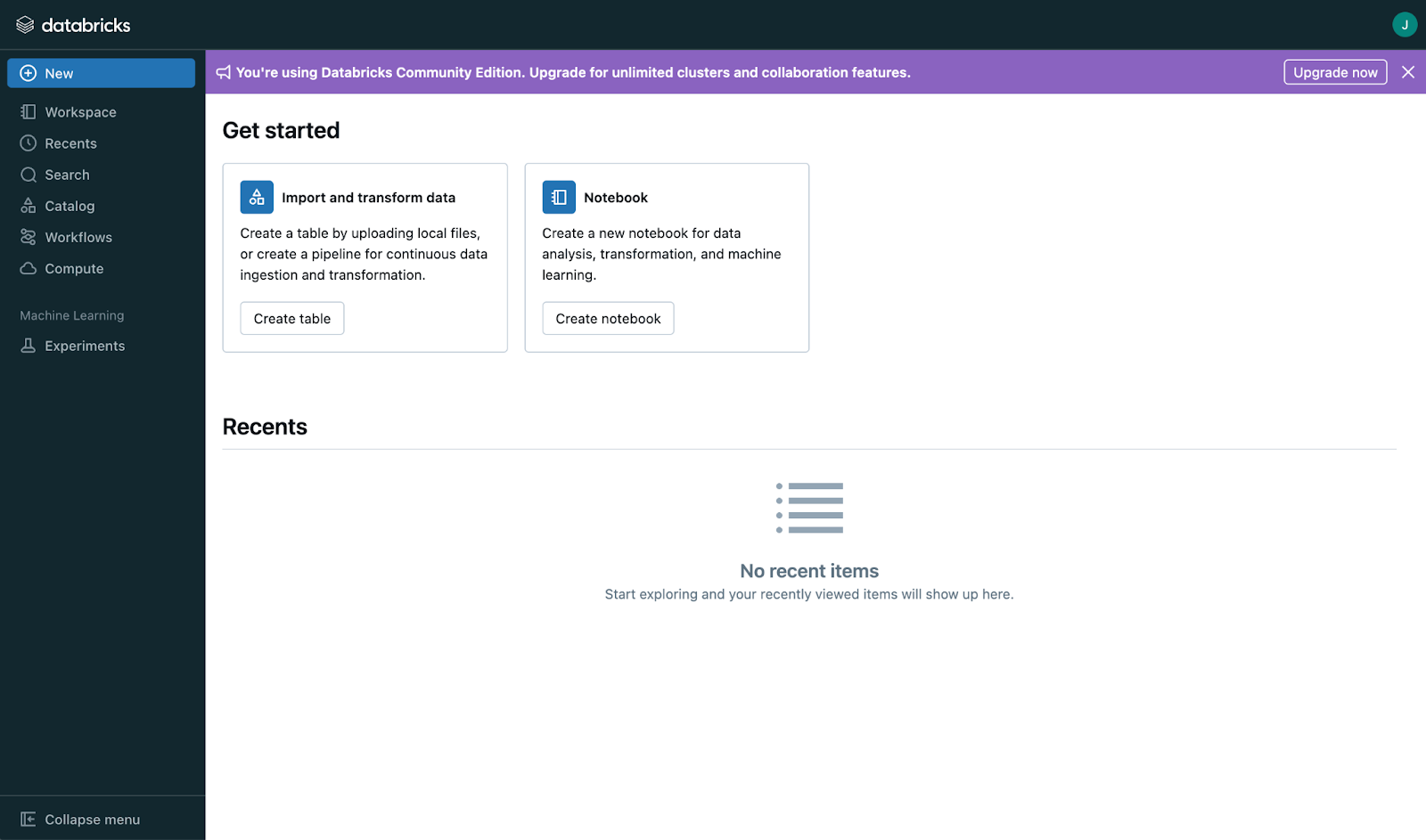

Captura de pantalla de la vista principal del registro en Databricks. Imagen del autor

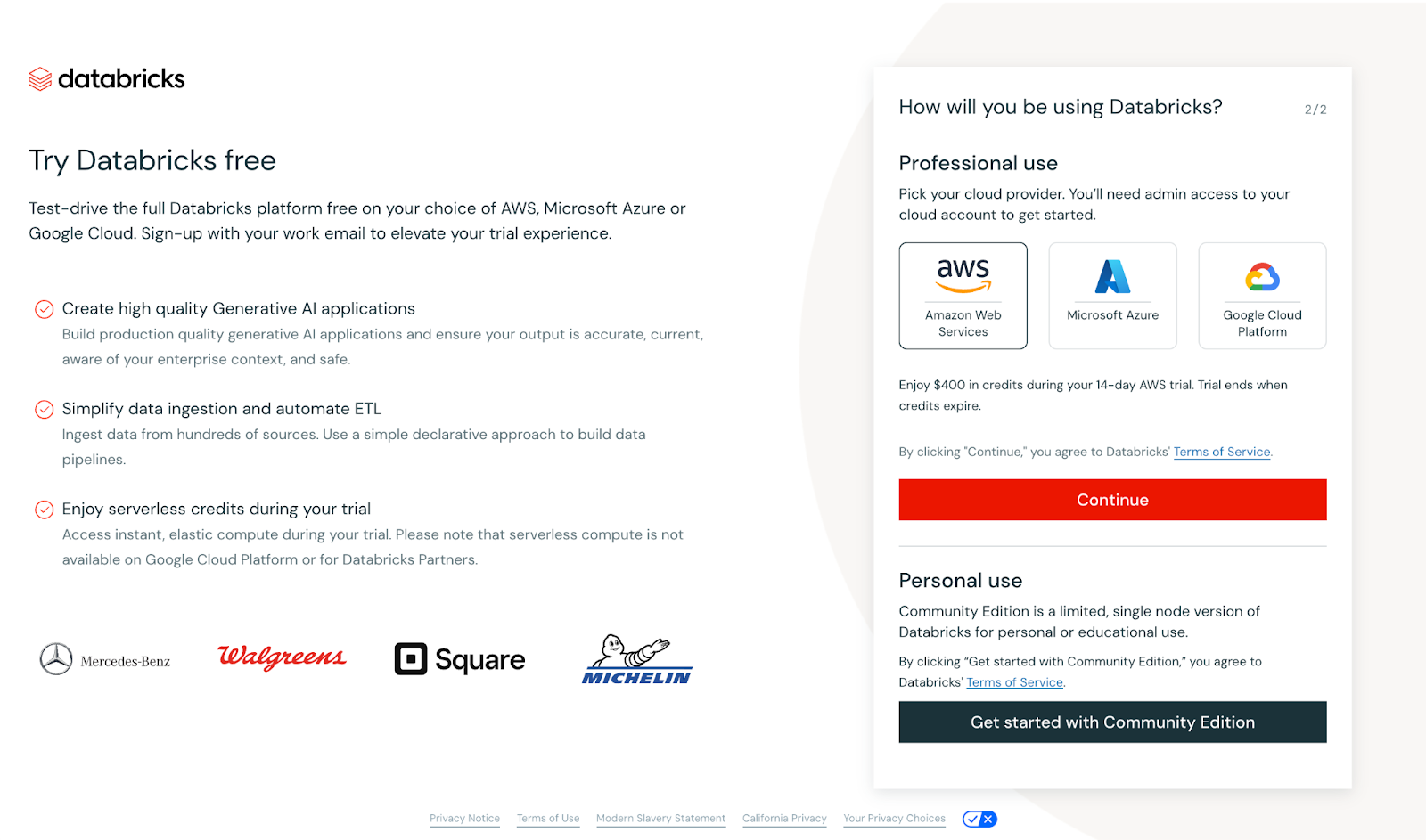

Una vez que des tus datos, aparecerá la siguiente vista.

Captura de pantalla de la vista principal del registro en Databricks. Imagen del autor

En este caso, se te pedirá que configures un proveedor de la nube o que continúes con la Edición Comunidad. Para mantener las cosas accesibles, utilizaremos la Edición Comunidad. Aunque ofrece menos funciones que la versión Enterprise, es ideal para casos de uso más reducidos, como los tutoriales, y no requiere la configuración de un proveedor en la nube.

Tras seleccionar la Edición Comunidad, verifica tu dirección de correo electrónico. Una vez verificado, te aparecerá un panel principal con el siguiente aspecto:

Captura de pantalla de la página principal de Databricks. Imagen del autor

Empieza por la interfaz

Una vez conectado, tómate tu tiempo para entender el diseño. A primera vista, la interfaz puede parecer básica, pero una vez que explores más a fondo o actualices tu cuenta, descubrirás un montón de funciones estupendas:

- Espacios de trabajo: Aquí es donde organizas tus proyectos, cuadernos y archivos. Piensa que es el centro de todo tu trabajo.

- Cuadernos: Escribe y ejecuta código en varios lenguajes de programación dentro del mismo cuaderno.

- Gestión del clúster: Son grupos de máquinas virtuales que se encargan del procesamiento de datos. Proporcionan la potencia de cálculo que necesitarás para tareas como las transformaciones de datos y el aprendizaje automático.

- Gestión de la mesa: Organiza y analiza datos estructurados con eficacia.

- Creación de cuadros de mando: Construye cuadros de mando interactivos directamente en el espacio de trabajo para visualizar la información.

- Edición colaborativa: Trabaja en cuadernos en tiempo real con compañeros de equipo para una colaboración fluida.

- Control de versiones: Haz un seguimiento de los cambios en los cuadernos y gestiona las versiones sin esfuerzo.

- Programación de trabajos: Automatiza la ejecución de cuadernos y scripts a intervalos especificados para agilizar los flujos de trabajo.

Aprender conceptos básicos

Databricks tiene tres conceptos básicos que seguirán siendo básicos para cualquier profesional dispuesto a dominarlo:

- Agrupaciones: La columna vertebral de Databricks, los clusters son entornos informáticos que ejecutan tu código. Aprende a crearlos, configurarlos y gestionarlos para adaptarlos a tus necesidades de procesamiento.

- Empleos: Automatiza las tareas repetitivas creando trabajos que ejecuten tus cuadernos o guiones según un calendario, agilizando los flujos de trabajo.

- Cuadernos: Se trata de documentos interactivos en los que escribes y ejecutas código, visualizas los resultados y documentas las conclusiones. Los cuadernos admiten múltiples lenguajes como Python, SQL y Scala, lo que los hace versátiles para diversas tareas.

Plan de Aprendizaje Databricks

Ésta es mi idea de un plan de aprendizaje en tres pasos.

Paso 1: Domina los fundamentos de Databricks

Comienza tu viaje construyendo una base sólida en Databricks Essentials.

Gestión de datos

Gestionar los datos con eficacia es el núcleo de cualquier plataforma de datos, y Databricks simplifica este proceso con herramientas robustas para cargar, transformar y organizar datos a escala. Aquí tienes un resumen de los aspectos clave de la gestión de datos en Databricks:

Carga de datos

Databricks admite diversas fuentes de datos, lo que facilita la ingesta de datos procedentes de formatos estructurados, semiestructurados y no estructurados.

- Formatos de datos admitidos: CSV, JSON, Parquet, ORC, Avro y más.

- Fuentes de datos: Sistemas de almacenamiento en la nube como AWS S3, Azure Data Lake y Google Cloud Storage, así como bases de datos relacionales y API.

- Cargador automático: Una función de Databricks que simplifica la carga de datos desde el almacenamiento en la nube de forma escalable e incremental, perfecta para manejar conjuntos de datos en continuo crecimiento.

Transformación de datos

Una vez ingestados tus datos, Databricks proporciona potentes herramientas para limpiarlos y transformarlos, a fin de prepararlos para el análisis o los flujos de trabajo de aprendizaje automático.

- Marcos de datos: Proporcionan una forma intuitiva de realizar transformaciones, similar a SQL o pandas en Python. Puedes filtrar, agregar y unir conjuntos de datos con facilidad.

- SparkSQL: Para quienes estén familiarizados con SQL, Databricks te permite consultar y manipular tus datos directamente mediante comandos SQL.

- Lago Delta: Mejora las transformaciones de datos con la compatibilidad de Delta Lake con la aplicación de esquemas, la creación de versiones y la coherencia en tiempo real.

Gestión de datos

Databricks permite una gestión fluida de tus datos en las distintas fases del flujo de trabajo.

- Data Lakehouse: Databricks combina lo mejor de los lagos de datos y los almacenes de datos, proporcionando una única plataforma para todas las necesidades de datos.

- Partición: Optimiza el rendimiento y el almacenamiento particionando tus conjuntos de datos para acelerar las consultas y el procesamiento.

- Manejo de metadatos: Databricks rastrea y actualiza automáticamente los metadatos de tus conjuntos de datos, simplificando la gobernanza de los datos y la optimización de las consultas.

Conceptos básicos de Apache Spark

Familiarízate con los conceptos básicos de Spark, incluidos:

- RDDs (Conjuntos de Datos Distribuidos Resistentes): La estructura de datos fundamental para la informática distribuida.

- Marcos de datos: Abstracciones de alto nivel para datos estructurados, que permiten un tratamiento y análisis eficaces.

- SparkSQL: Una interfaz SQL para consultar y manipular datos en Spark.

Recursos sugeridos

- Academia Databricks: Empieza con su ruta de aprendizaje Fundamentos para lecciones guiadas.

- Sigue el curso DataCamp Introducción a DataBricks para iniciarte y comprender los fundamentos de esta plataforma.

- También puedes utilizar la documentación habitual de Cloud-Provider para empezar a utilizar Databricks. Por ejemplo, Azure tiene un buen contenido introductorio a Databricks.

Paso 2: Ponte manos a la obra con Databricks

La mejor forma de aprender cualquier herramienta nueva, incluida Databricks, es mediante la práctica. Al aplicar los conceptos que has aprendido a situaciones reales, no sólo ganarás confianza, sino que también profundizarás en el conocimiento de las potentes capacidades de la plataforma.

Participa en miniproyectos

Los proyectos prácticos son una forma excelente de explorar las funciones de Databricks al tiempo que se desarrollan habilidades clave. Aquí tienes algunos proyectos iniciales que puedes considerar:

- Construir un proyecto de ingeniería de datos de principio a fin

- Sigue un flujo de trabajo completo de ingeniería de datos implementando un proceso ETL en Databricks.

- Extrae datos de un servicio de almacenamiento en la nube, como AWS S3 o Azure Blob Storage.

- Transforma los datos utilizando Spark para tareas como limpieza, deduplicación y agregaciones.

- Carga los datos procesados en una tabla Delta para una consulta y almacenamiento eficaces.

- Añade valor creando un panel o informe que visualice las percepciones de los datos procesados.

- Referencia: Sigue este proyecto aquí.

Puedes encontrar muchos otros proyectos (de intermedio a avanzado) en la siguiente página web sobre aprendizaje basado en proyectos. Estos proyectos no sólo ayudan a reforzar los conceptos básicos, sino que también te preparan para flujos de trabajo más complejos en ingeniería de datos y aprendizaje automático.

Utiliza los laboratorios de la Edición Comunidad de Databricks

La Edición Comunitaria de Databricks proporciona un entorno gratuito, basado en la nube, perfecto para la experimentación. Utilízalo para acceder:

- Laboratorios preconstruidos: Laboratorios prácticos diseñados para enseñarte habilidades clave como trabajar con clusters, notebooks y Delta Lake.

- Cuadernos interactivos: Practica la codificación directamente en los cuadernos Databricks, compatibles con Python, SQL, Scala y R.

- Características de colaboración: Experimenta con herramientas de colaboración en tiempo real para simular proyectos en equipo.

Muestra tus habilidades

Crear una cartera diversa es una forma excelente de mostrar tu experiencia. Documentar y presentar tus proyectos es tan importante como construirlos. Utiliza GitHub o un sitio web personal para:

- Proporciona descripciones detalladas de cada proyecto, incluyendo objetivos, herramientas utilizadas y resultados.

- Comparte repositorios de código con documentación clara para hacerlos accesibles a los demás.

- Incluye elementos visuales como capturas de pantalla, diagramas o cuadros de mando para ilustrar los resultados.

- Escribe una entrada de blog o un resumen del proyecto para destacar los retos, las soluciones y los aprendizajes clave.

Combinando la experiencia práctica con una cartera pulida, demostrarás eficazmente tus conocimientos y destacarás en el competitivo ecosistema de Azure.

Paso 3: Profundiza tus conocimientos en áreas especializadas

- Ingeniería de datos: Recomiendan centrarse en el tratamiento del lago Delta y de los arroyos.

- Aprendizaje automático: Sugiere estudiar MLflow para el seguimiento y despliegue de modelos.

- Certificaciones: Enumera certificaciones como Desarrollador Asociado Certificado Databricks para Apache Spark y Científico de Datos Profesional Certificado Databricks.

Una vez que domines los fundamentos de Databricks y hayas adquirido experiencia práctica, el siguiente paso es centrarte en áreas especializadas que se alineen con tus objetivos profesionales. Tanto si te interesa la ingeniería de datos, el aprendizaje automático o la obtención de certificaciones para validar tus conocimientos, este paso te ayudará a adquirir una experiencia avanzada.

Ingeniería de datos

La ingeniería de datos está en el corazón de la construcción de canalizaciones de datos escalables, y Databricks ofrece potentes herramientas para apoyar este trabajo. Para mejorar tus competencias en este ámbito:

| Área de interés | Actividades clave y objetivos de aprendizaje |

|---|---|

| Aprende Delta Lake | Comprende el papel de Delta Lake a la hora de garantizar la fiabilidad y coherencia de los datos con funciones como las transacciones ACID y la aplicación de esquemas Explora cómo Delta Lake facilita el procesamiento de datos por lotes y en flujo en una plataforma unificada Practica la creación, consulta y optimización de tablas Delta para análisis de alto rendimiento |

| Sumérgete en el procesamiento de flujos | Estudia Spark Structured Streaming para construir pipelines de datos en tiempo real Experimenta con casos de uso como el procesamiento de flujos de eventos, análisis de registros y cuadros de mando en tiempo real Aprende a integrar los datos en streaming con Delta Lake para una gestión continua del flujo de datos |

Aprendizaje automático

El ecosistema de aprendizaje automático de Databricks acelera el desarrollo y la implantación de modelos. Especializarse en esta área:

| Área de interés | Actividades clave y objetivos de aprendizaje |

|---|---|

| Maestro MLflow | Utiliza MLflow para rastrear experimentos, registrar parámetros y evaluar métricas de tus modelos Conoce el Registro de Modelos MLflow para gestionar modelos a lo largo de su ciclo de vida, desde el desarrollo hasta la producción Explora funciones avanzadas como la compatibilidad con GenAI para crear aplicaciones como chatbots y resumen de documentos |

| Centrarse en el despliegue | Practica el despliegue de modelos de aprendizaje automático como API REST o utilizando marcos como Azure ML y Amazon SageMaker Experimenta con Databricks Model Serving para escalar los despliegues de forma eficiente |

| Incorporar bibliotecas avanzadas | Utiliza TensorFlow, PyTorch o Transformadores de Cara Abrazada para construir modelos sofisticados dentro de Databricks. |

Certifícate

Las certificaciones validan tu experiencia y te hacen destacar en el mercado laboral. Databricks ofrece varias certificaciones adaptadas a diferentes funciones y niveles de cualificación:

| Certificación | Descripción |

|---|---|

| Desarrollador Asociado Certificado de Databricks para Apache Spark | Diseñada para desarrolladores, esta certificación se centra en los conceptos de programación de Spark, las API de DataFrame y Spark SQL. |

| Ingeniero de Datos Certificado Asociado de Databricks | Abarca conocimientos clave como la creación de canalizaciones de datos fiables mediante Delta Lake y la optimización del almacenamiento de datos para el análisis. |

| Científico de Datos Profesional Certificado Databricks | Para los profesionales avanzados, esta certificación pone a prueba tu capacidad para construir, desplegar y supervisar modelos de aprendizaje automático utilizando las herramientas de Databricks. |

Recursos de aprendizaje de Databricks

Cursos y tutoriales

- Academia Databricks: Ofrece rutas de formación oficiales que cubren temas básicos como la ingeniería de datos, el aprendizaje automático y Databricks SQL. Perfecto para obtener certificaciones y dominar las herramientas Databricks.

- DataCamp: Proporciona introducciones a Databricks para principiantes y guías avanzadas centradas en la obtención de certificaciones.

- Coursera y edX: Incluye cursos de las principales instituciones y expertos del sector centrados en los flujos de trabajo de Databricks y la programación de Spark.

- Udemy: Ofrece cursos rentables sobre temas como canalizaciones ETL, Delta Lake y fundamentos de Databricks.

- Recursos comunitarios: Explora blogs, canales de YouTube (como Databricks o TheSeattleGuy) y tutoriales de usuarios experimentados para un aprendizaje práctico.

Documentación y apoyo comunitario

- Documentación de Databricks: Un recurso completo para comprender las características de la plataforma, las API y las mejores prácticas. Incluye tutoriales, preguntas frecuentes y guías para ayudar tanto a principiantes como a usuarios avanzados.

- Databricks Edición Comunidad: Un entorno gratuito para probar y aprender Databricks sin necesidad de tener una cuenta en la nube.

- Foros de usuarios: Únete a los foros de la comunidad de Databricks o participa en debates en plataformas como Stack Overflow para solucionar problemas y compartir conocimientos.

- Repositorios de GitHub: Accede a proyectos de código abierto, cuadernos de ejemplo y fragmentos de código compartidos por los ingenieros de Databricks y la comunidad como el reto de los 30 días de Databricks.

Fichas y guías de referencia

- Hojas de trucos de comandos Spark: Utiliza la hoja de trucos de los comandos Spark de Standford para mejorar tu experiencia de aprendizaje.

- Inicio rápido en el Lago Delta: Guías descargables para configurar Delta Lake para un almacenamiento de datos y unas transacciones eficientes.

- Guías CLI y API de Databricks: Utilízalos para gestionar tu entorno Databricks mediante programación.

Para dominar Databricks con eficacia, es esencial aprovechar una mezcla de cursos estructurados, documentación oficial y materiales de referencia rápida. A continuación encontrarás recursos clave que pueden guiar tu viaje de aprendizaje y apoyarte a medida que adquieres experiencia.

Mantente al día con Databricks

Aprendizaje continuo

Mantenerse al día con Databricks es esencial, ya que la plataforma evoluciona frecuentemente con nuevas funciones y mejoras.

- Refresca tus habilidades: Revisa regularmente conceptos fundamentales como Spark, Delta Lake y MLflow, y explora las actualizaciones para mantenerte a la vanguardia.

- Experimenta con nuevas funciones: Utiliza la Edición Comunidad gratuita o los entornos sandbox para probar las herramientas y capacidades introducidas recientemente.

- Explora las opciones de certificación: Databricks ofrece programas de certificación que validan tus conocimientos y te ayudan a mantenerte alineado con las últimas prácticas del sector.

Seguir blogs y noticias

- Blog oficial de Databricks: Mantente informado sobre anuncios de productos, mejores prácticas e historias de éxitocess en el blog oficial de Databricks.

- Plataformas de noticias tecnológicas: Sigue fuentes como TechCrunch, InfoWorld y Medium para saber cómo Databricks impulsa la innovación en todos los sectores.

Comprometerse con la comunidad

- Únete a Grupos de Usuarios: Participa en grupos centrados en Databricks en Meetup, LinkedIn o Discord para compartir conocimientos y aprender de forma colaborativa.

- Asistir a conferencias: Eventos como la Cumbre Databricks son excelentes para establecer contactos y explorar casos de uso de vanguardia.

- Participa en los foros: Participa en debates en plataformas como Stack Overflow, los foros de la comunidad Databricks y los subreddits de ingeniería de datos de Reddit.

Suscribirse a DataFramed

Suscríbete al podcast de DataFramed para conocer las últimas tendencias y escuchar entrevistas a expertos. En un gran episodio relacionado con Databricks que recomiendo aparece incluso el CTO de Databricks: [ AI and the Modern Data Stack] Cómo Databricks está transformando el almacenamiento de datos y la IA con Ari Kaplan, Evangelista Jefe y Robin Sutara, CTO de Databricks.

Suscríbete a DataFramed

Suscríbete a DataFramed dondequiera que recibas tus podcasts.

Conclusión

Databricks capacita a los profesionales para resolver retos y desbloquear oportunidades profesionales. Me alegro de haber aprendido Databricks, y te animo a que sigas estudiando. Recuérdalo:

-

Define tus objetivos: Alinea tu itinerario de aprendizaje con objetivos específicos, ya sea en ingeniería de datos, IA o analítica.

-

Utiliza los recursos: Aprovecha los cursos estructurados, las ediciones comunitarias y los proyectos prácticos para adquirir experiencia.

-

Mantente comprometido: Sigue las actualizaciones, participa en la comunidad Databricks y adopta el aprendizaje continuo para mantenerte a la vanguardia.

Josep es Científico de Datos y Gestor de Proyectos en la Agencia Catalana de Turismo, utilizando datos para mejorar la experiencia de los turistas en Cataluña. Su experiencia incluye la gestión del almacenamiento y procesamiento de datos, junto con la analítica avanzada y la comunicación eficaz de las perspectivas de los datos.

También es un dedicado educador, que imparte clases en el Máster de Big Data de la Universidad de Navarra, y contribuye regularmente con artículos perspicaces sobre ciencia de datos en Medium y KDNuggets.

Es Licenciado en Ingeniería Física por la Universidad Politécnica de Cataluña y Máster en Sistemas Interactivos Inteligentes por la Universidad Pompeu Fabra.

En la actualidad, se dedica con pasión a hacer que las tecnologías relacionadas con los datos sean más accesibles a un público más amplio a través de la publicación de Medium ForCode'Sake.

Preguntas frecuentes al aprender Databricks

¿Qué es Databricks y por qué es importante para los profesionales de los datos?

Databricks es una plataforma analítica abierta para construir, desplegar y mantener soluciones de datos, análisis e IA a escala. Su integración con los principales proveedores de la nube (AWS, Azure, GCP) y sus sólidas herramientas hacen que cambie las reglas del juego para los profesionales de los datos, al agilizar el procesamiento de big data y permitir el análisis avanzado y el aprendizaje automático.

¿Cuáles son las tres principales ventajas de aprender Databricks?

Crecimiento profesional: Gran demanda y escasez de profesionales cualificados; 2) Aplicaciones amplias: Permite la transformación de datos, la analítica avanzada y el aprendizaje automático; 3) Ventaja competitiva: Ofrece compatibilidad con AWS, Azure, GCP, y se integra perfectamente con Apache Spark.

¿Qué características clave hacen de Databricks una plataforma completa?

Entre sus principales características se incluyen una plataforma de datos unificada que combina ingeniería de datos, analítica y aprendizaje automático, integración con Apache Spark para el procesamiento distribuido, Delta Lake para la coherencia de los datos, MLflow para gestionar los ciclos de vida del aprendizaje automático y herramientas de colaboración como los cuadernos interactivos.

¿Cómo pueden empezar los principiantes con Databricks?

Los principiantes pueden empezar definiendo sus objetivos de aprendizaje, suscribiéndose a la edición gratuita Databricks Community Edition, explorando la interfaz (espacios de trabajo, clusters, cuadernos) y trabajando en proyectos prácticos como la construcción de ETL pipelines o experimentando con MLflow.

¿Cómo pueden los profesionales mantenerse al día con Databricks?

Mantente al día revisando regularmente conceptos básicos como Delta Lake y MLflow, experimentando con las nuevas funciones de la Edición Comunidad, siguiendo el Blog Oficial de Databricks y participando en la comunidad Databricks a través de foros, conferencias y grupos de usuarios.