Curso

A Databricks é uma plataforma de análise aberta para criar, implementar e manter soluções de dados, análise e IA em escala. Ele foi desenvolvido com base no Apache Spark e se integra a qualquer um dos três principais provedores de nuvem (AWS, Azure ou GCP), o que nos permite gerenciar e implantar a infraestrutura de nuvem em nosso nome e, ao mesmo tempo, oferecer qualquer aplicativo de ciência de dados que você possa imaginar.

Hoje, quero apresentar a você uma introdução abrangente ao Databricks, abordando seus principais recursos, aplicativos práticos e caminhos de aprendizado estruturados para que você possa começar. Desde a configuração do ambiente até o domínio do processamento, da orquestração e da visualização de dados, você encontrará tudo o que precisa para começar a usar o Databricks.

Por que aprender Databricks?

Aprender o Databricks e ter bases sólidas sobre ele pode ter várias vantagens positivas para você:

O Databricks tem muitos aplicativos

A Databricks tem amplos aplicativos que permitem que as empresas transformem dados, limpem, processem e otimizem grandes conjuntos de dados para obter insights. Ele permite análises avançadas para uma melhor tomada de decisões por meio da exploração e visualização de dados; ele oferece suporte ao desenvolvimento e à implantação de modelos preditivos e soluções de IA.

O Databricks dará a você uma vantagem

A Databricks oferece uma vantagem competitiva com sua compatibilidade com a nuvem. Criado com base no Apache Spark, ele se integra às principais ferramentas de dados, como AWS, Azure e Google Cloud. O domínio do Databricks posiciona você como líder em qualquer setor que se preocupe com dados.

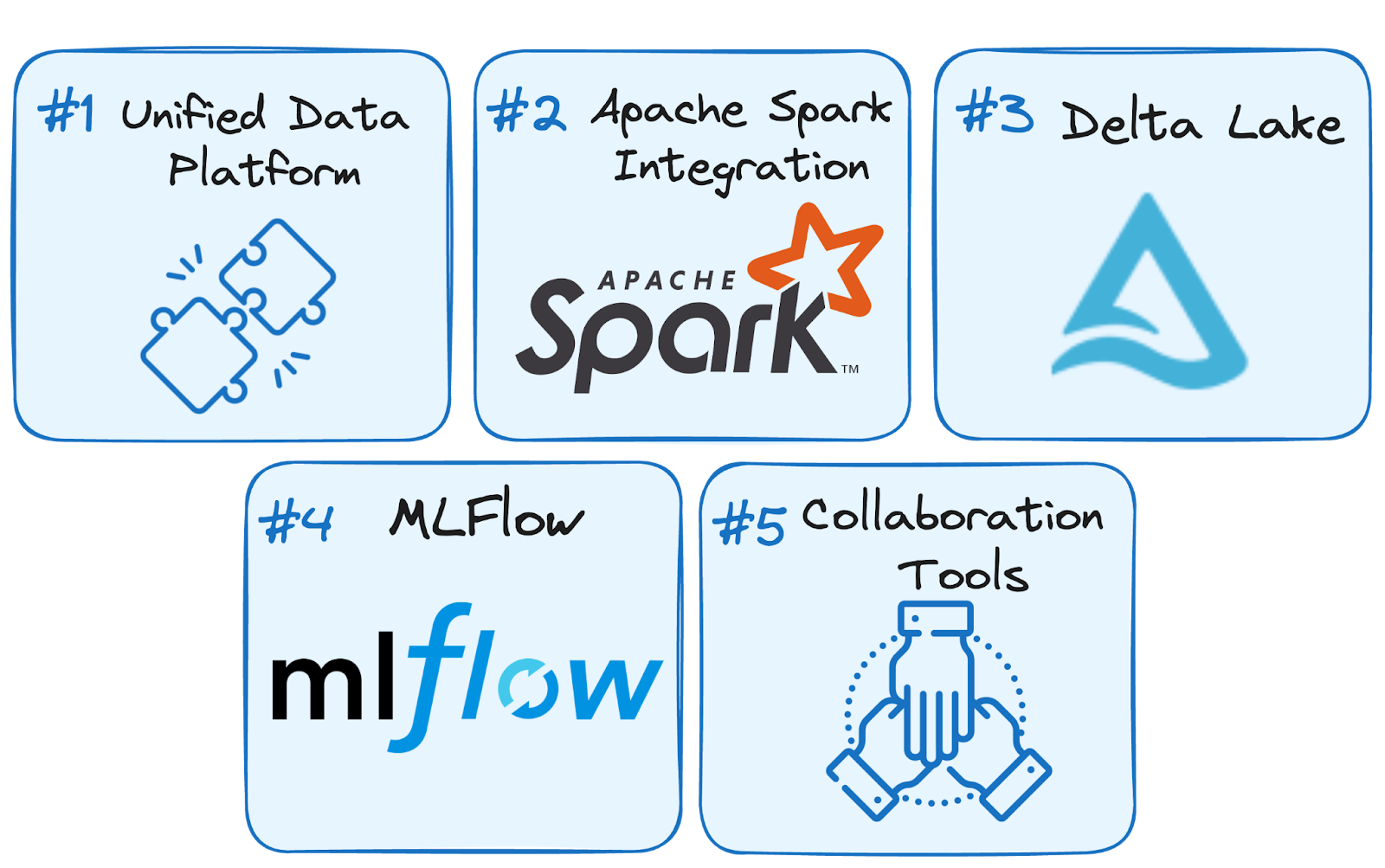

Principais recursos do Databricks

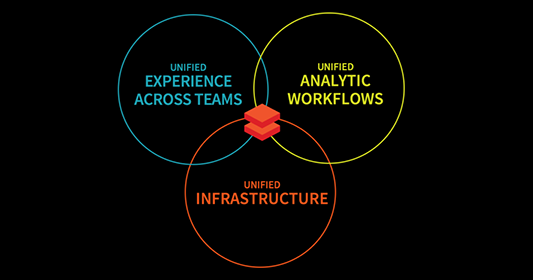

O Databricks é uma plataforma abrangente para engenharia de dados, análise e aprendizado de máquina, combinando cinco recursos principais que aumentam a escalabilidade, a colaboração e a eficiência do fluxo de trabalho.

Principais recursos do Databricks. Imagem do autor.

Plataforma de dados unificada

A Databricks combina todos os três fluxos de trabalho de engenharia de dados, ciência de dados e aprendizado de máquina em uma única plataforma. Isso simplifica ainda mais o processamento de dados, o treinamento de modelos e a implantação. Ao unificar esses domínios, a Databricks acelera as iniciativas de IA, ajudando as empresas a transformar dados isolados em insights acionáveis e, ao mesmo tempo, promovendo a colaboração.

Integração com o Apache Spark

O Apache Spark, a principal estrutura de computação distribuída, está profundamente integrado ao Databricks. Isso permite que o Databricks lide com a configuração do Spark automaticamente. Portanto, os usuários podem se concentrar na criação de soluções de dados sem se preocupar com a configuração.

Além disso, o poder de processamento distribuído do Spark é ideal para tarefas de big data, e a Databricks o aprimora com segurança, escalabilidade e otimização de nível empresarial.

Delta Lake

O Delta Lake é a espinha dorsal da arquitetura Lakehouse da Databricks, que acrescenta recursos como transações ACID, aplicação de esquemas e consistência de dados em tempo real no site. Isso garante a confiabilidade e a precisão dos dados, tornando o Delta Lake uma ferramenta essencial para o gerenciamento de dados em lote e de fluxo contínuo.

MLflow

O MLflow é uma plataforma de código aberto para gerenciar todo o ciclo de vida do aprendizado de máquina. Desde o rastreamento de experimentos até o gerenciamento da implantação de modelos, o MLflow simplifica o processo de criação e operacionalização de modelos de ML.

Além disso, com as integrações mais recentes para ferramentas de IA generativa, como OpenAI e Hugging Face, o MLflow amplia seus recursos para incluir aplicativos de ponta, como chatbots, resumo de documentos e análise de sentimentos.

Ferramentas de colaboração

A Databricks promove a colaboração por meio de:

- Cadernos interativos: Combine código, markdown e recursos visuais para documentar fluxos de trabalho e compartilhar insights com perfeição.

- Compartilhamento em tempo real: Colabore ao vivo em notebooks para obter feedback instantâneo e simplificar o trabalho em equipe.

- Recursos de controle de versão: Acompanhe as alterações e integre-as ao Git para um gerenciamento de projetos seguro e eficiente.

Como começar a aprender Databricks

Começar a trabalhar com a Databricks pode ser empolgante e ao mesmo tempo assustador. É por isso que o primeiro passo para aprender qualquer nova tecnologia é ter uma compreensão clara de seus objetivos - por que você quer aprendê-la e como planeja usá-la.

Defina metas claras

Antes de começar, defina o que você deseja alcançar com o Databricks.

Você está procurando otimizar o processamento de big data como engenheiro de dados? Ou você está concentrado em aproveitar seus recursos de ML para criar e implantar modelos preditivos?

Ao definir seus principais objetivos, você pode criar um plano de aprendizado focado de acordo com eles. Aqui estão algumas dicas, dependendo de sua principal aspiração:

- Se você se concentra em engenharia de dados, priorize o aprendizado sobre as ferramentas da Databricks para ingestão, transformação e gerenciamento de dados, bem como sua integração perfeita com o Apache Spark e o Delta Lake.

- Se você se concentra no aprendizado de máquina, concentre-se em entender o MLflow para rastreamento de experimentos, gerenciamento de modelos e implantação, além de aproveitar o suporte integrado da plataforma para bibliotecas como TensorFlow e PyTorch.

Comece com o básico:

Começar a usar o Databricks pode ser mais fácil do que você imagina. Para isso, vou orientá-lo em uma abordagem passo a passo, para que você possa se familiarizar facilmente com os elementos essenciais da plataforma.

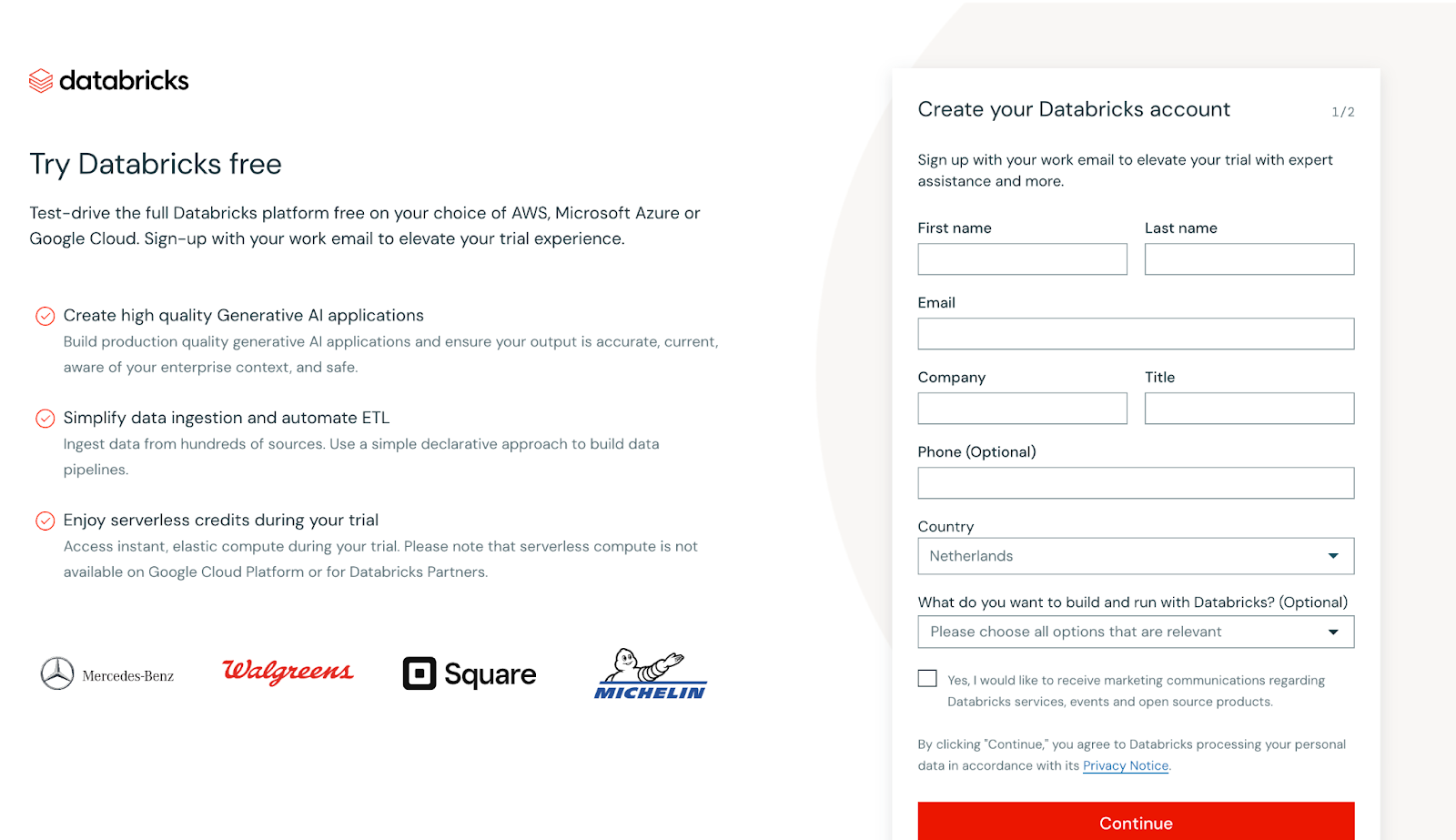

Inscreva-se gratuitamente

Comece criando uma conta gratuita no Databricks Community Editionque fornece acesso aos principais recursos da plataforma sem nenhum custo. Esta edição é perfeita para a exploração prática, permitindo que você faça experiências com Workspaces, Clusters e Notebooks sem precisar de uma assinatura paga.

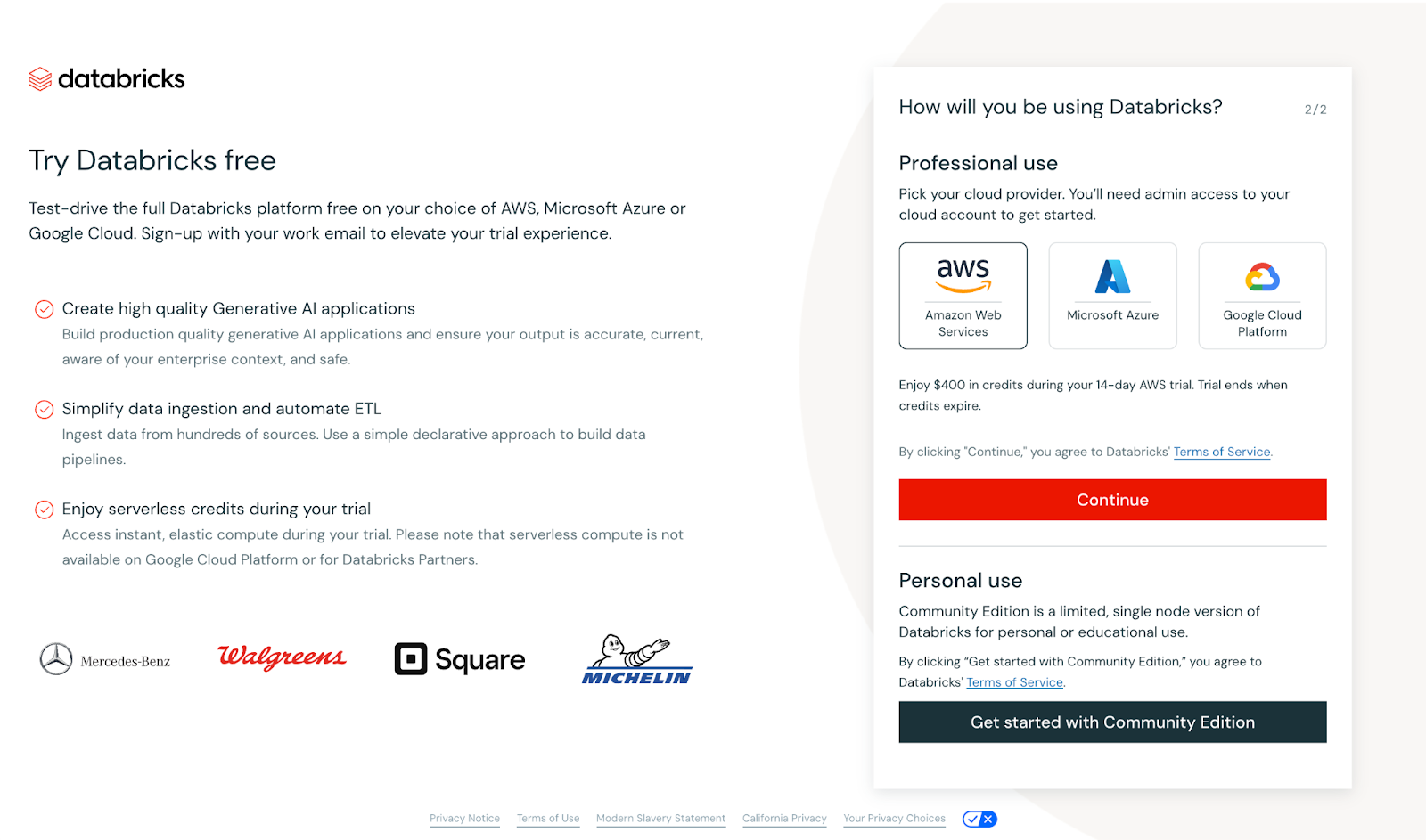

Captura de tela da visualização principal da inscrição no Databricks. Imagem do autor

Depois que você fornecer seus detalhes, a seguinte exibição será exibida.

Captura de tela da visualização principal da inscrição no Databricks. Imagem do autor

Nesse caso, você será solicitado a configurar um provedor de nuvem ou prosseguir com o Community Edition. Para manter as coisas acessíveis, usaremos a Community Edition. Embora ofereça menos recursos do que a versão Enterprise, ela é ideal para casos de uso menores, como tutoriais, e não exige a configuração de um provedor de nuvem.

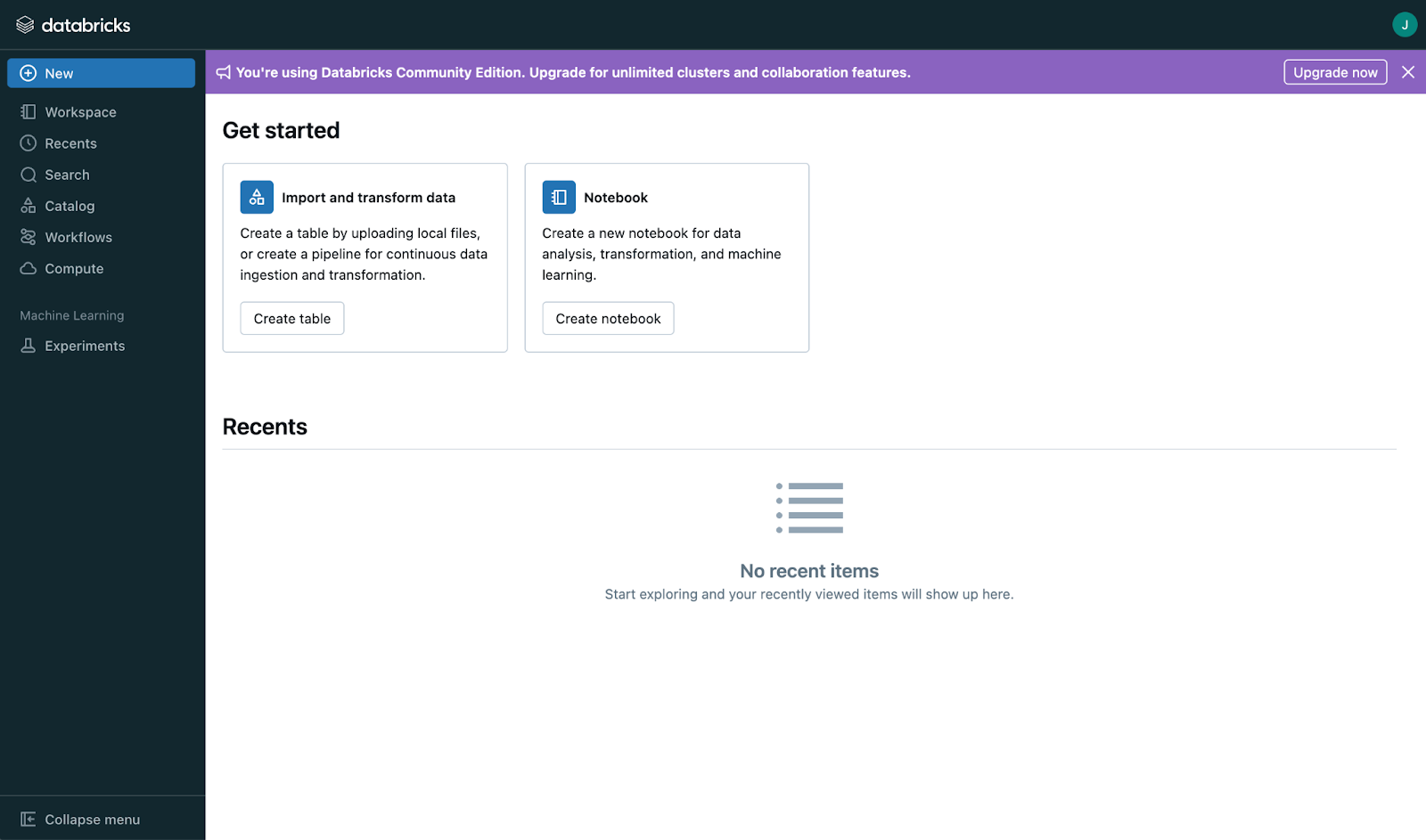

Depois de selecionar a Community Edition, verifique seu endereço de e-mail. Depois de verificado, você verá um painel principal com a seguinte aparência:

Captura de tela da página principal da Databricks. Imagem do autor

Comece com a interface

Depois de fazer login, reserve um tempo para entender o layout. À primeira vista, a interface pode parecer básica, mas quando você explorar mais ou atualizar sua conta, descobrirá muitos recursos excelentes:

- Espaços de trabalho: É aqui que você organiza seus projetos, cadernos e arquivos. Pense nele como o centro de todo o seu trabalho.

- Notebooks: Escreva e execute códigos em várias linguagens de programação no mesmo notebook.

- Gerenciamento de cluster: Esses são grupos de máquinas virtuais que lidam com o processamento de dados. Eles fornecem a capacidade de computação de que você precisa para tarefas como transformações de dados e aprendizado de máquina.

- Gerenciamento de tabelas: Organize e analise dados estruturados com eficiência.

- Criação do painel: Crie painéis interativos diretamente no espaço de trabalho para visualizar insights.

- Edição colaborativa: Trabalhe em notebooks em tempo real com colegas de equipe para uma colaboração perfeita.

- Controle de versão: Acompanhe as alterações no notebook e gerencie as versões sem esforço.

- Programação de trabalhos: Automatize a execução de notebooks e scripts em intervalos específicos para simplificar os fluxos de trabalho.

Aprenda os principais conceitos

O Databricks tem três conceitos principais que continuarão sendo básicos para qualquer profissional que queira dominá-lo:

- Agrupamentos: A espinha dorsal dos Databricks, os clusters são ambientes de computação que executam seu código. Saiba como criar, configurar e gerenciá-los para atender às suas necessidades de processamento.

- Empregos: Automatize tarefas repetitivas criando trabalhos que executam seus notebooks ou scripts em uma programação, simplificando os fluxos de trabalho.

- Notebooks: Esses são documentos interativos em que você escreve e executa códigos, visualiza resultados e documenta descobertas. Os notebooks suportam várias linguagens, como Python, SQL e Scala, o que os torna versáteis para várias tarefas.

Plano de aprendizado da Databricks

Aqui está minha ideia de um plano de aprendizado em três etapas.

Etapa 1: Dominar os fundamentos do Databricks

Comece sua jornada criando uma base sólida no Databricks Essentials.

Gerenciamento de dados

O gerenciamento eficaz de dados está no centro de qualquer plataforma de dados, e a Databricks simplifica esse processo com ferramentas robustas para carregar, transformar e organizar dados em escala. Aqui está uma visão geral dos principais aspectos do gerenciamento de dados no Databricks:

Carregando dados

A Databricks oferece suporte a uma variedade de fontes de dados, facilitando a ingestão de dados de formatos estruturados, semiestruturados e não estruturados.

- Formatos de dados compatíveis: CSV, JSON, Parquet, ORC, Avro e muito mais.

- Fontes de dados: Sistemas de armazenamento em nuvem, como AWS S3, Azure Data Lake e Google Cloud Storage, bem como bancos de dados relacionais e APIs.

- Auto Loader: Um recurso do Databricks que simplifica o carregamento de dados do armazenamento em nuvem de forma escalonável e incremental, perfeito para lidar com conjuntos de dados em crescimento contínuo.

Transformação de dados

Depois que os dados são ingeridos, a Databricks fornece ferramentas avançadas para limpá-los e transformá-los, preparando-os para análise ou fluxos de trabalho de aprendizado de máquina.

- DataFrames: Eles oferecem uma maneira intuitiva de realizar transformações, semelhante ao SQL ou pandas em Python. Você pode filtrar, agregar e unir conjuntos de dados com facilidade.

- SparkSQL: Para quem está familiarizado com SQL, o Databricks permite que você consulte e manipule seus dados diretamente usando comandos SQL.

- Delta Lake: Aprimore as transformações de dados com o suporte do Delta Lake para aplicação de esquema, controle de versão e consistência em tempo real.

Gerenciamento de dados

O Databricks permite o gerenciamento contínuo dos seus dados em diferentes estágios do fluxo de trabalho.

- Data Lakehouse: A Databricks combina o melhor dos data lakes e data warehouses, fornecendo uma plataforma única para todas as necessidades de dados.

- Particionamento: Otimize o desempenho e o armazenamento particionando seus conjuntos de dados para consultas e processamento mais rápidos.

- Manuseio de metadados: O Databricks rastreia e atualiza automaticamente os metadados de seus conjuntos de dados, simplificando a governança de dados e a otimização de consultas.

Noções básicas do Apache Spark

Familiarize-se com os principais conceitos do Spark, incluindo:

- RDDs (Resilient Distributed Datasets, conjuntos de dados distribuídos resilientes): A estrutura de dados fundamental para a computação distribuída.

- DataFrames: Abstrações de alto nível para dados estruturados, permitindo processamento e análise eficientes.

- SparkSQL: Uma interface SQL para consulta e manipulação de dados no Spark.

Recursos sugeridos

- Databricks Academy: Comece com o caminho de aprendizado Fundamentals para obter lições guiadas.

- Siga o curso DataCamp Introduction to DataBricks para começar e entender os fundamentos dessa plataforma.

- Você também pode usar a documentação usual do Cloud-Provider para começar a usar o Databricks. Por exemplo, o Azure tem um bom conteúdo introdutório para o Databricks.

Etapa 2: Você pode usar o Databricks de forma prática

A melhor maneira de aprender qualquer nova ferramenta, inclusive o Databricks, é por meio da prática. Ao aplicar os conceitos que aprendeu em cenários reais, você não apenas ganhará confiança, mas também aprofundará sua compreensão dos recursos avançados da plataforma.

Envolver-se em miniprojetos

Os projetos práticos são uma excelente maneira de explorar os recursos do Databricks e, ao mesmo tempo, desenvolver habilidades importantes. Aqui estão alguns projetos iniciais que você pode considerar:

- Crie um projeto de engenharia de dados de ponta a ponta

- Siga um fluxo de trabalho completo de engenharia de dados implementando um processo ETL no Databricks.

- Extraia dados de um serviço de armazenamento em nuvem, como o AWS S3 ou o Azure Blob Storage.

- Transforme os dados usando o Spark para tarefas como limpeza, deduplicação e agregações.

- Carregue os dados processados em uma tabela Delta para que você possa fazer consultas e armazená-los com eficiência.

- Agregue valor criando um painel ou relatório que visualize os insights dos dados processados.

- Referência: Acompanhe esse projeto aqui.

Você pode encontrar muitos outros projetos (do intermediário ao avançado) no seguinte site sobre aprendizado baseado em projetos. Esses projetos não apenas ajudam a reforçar os conceitos básicos, mas também preparam você para fluxos de trabalho mais complexos em engenharia de dados e aprendizado de máquina.

Use os laboratórios do Databricks Community Edition

O Databricks Community Edition oferece um ambiente gratuito baseado em nuvem, perfeito para experimentação. Use-o para acessar:

- Laboratórios pré-construídos: Laboratórios práticos projetados para ensinar a você as principais habilidades, como trabalhar com clusters, notebooks e Delta Lake.

- Cadernos interativos: Pratique a codificação diretamente nos notebooks do Databricks, que são compatíveis com Python, SQL, Scala e R.

- Recursos de colaboração: Experimente ferramentas de colaboração em tempo real para simular projetos em equipe.

Mostre suas habilidades

Criar um portfólio diversificado é uma excelente maneira de mostrar sua experiência. Documentar e apresentar seus projetos é tão importante quanto criá-los. Use o GitHub ou um site pessoal para:

- Forneça descrições detalhadas de cada projeto, incluindo objetivos, ferramentas usadas e resultados.

- Compartilhe repositórios de código com documentação clara para torná-los acessíveis a outras pessoas.

- Inclua recursos visuais, como capturas de tela, diagramas ou painéis para ilustrar os resultados.

- Escreva uma publicação no blog ou um resumo do projeto para destacar os desafios, as soluções e os principais aprendizados.

Combinando a experiência prática com um portfólio bem elaborado, você demonstrará efetivamente sua experiência e se destacará no competitivo ecossistema do Azure.

Etapa 3: Aprofundar suas habilidades em áreas especializadas

- Data Engineering: Recomendamos que você se concentre no processamento do Delta Lake e dos riachos.

- Aprendizado de máquina: Sugerimos que você estude o MLflow para rastreamento e implantação de modelos.

- Certificações: Liste certificações como Databricks Certified Associate Developer for Apache Spark e Databricks Certified Professional Data Scientist.

Depois que você dominar os fundamentos do Databricks e adquirir experiência prática, a próxima etapa é concentrar-se em áreas especializadas que se alinham às suas metas de carreira. Se você estiver interessado em engenharia de dados, aprendizado de máquina ou em obter certificações para validar suas habilidades, esta etapa o ajudará a desenvolver conhecimentos avançados.

Engenharia de dados

A engenharia de dados está no centro da criação de pipelines de dados dimensionáveis, e a Databricks oferece ferramentas poderosas para apoiar esse trabalho. Para aprimorar suas habilidades nessa área:

| Área de foco | Principais atividades e metas de aprendizado |

|---|---|

| Conheça o Delta Lake | Entenda a função do Delta Lake em garantir a confiabilidade e a consistência dos dados com recursos como transações ACID e imposição de esquemas Explore como o Delta Lake facilita o processamento de dados em lote e de fluxo contínuo em uma plataforma unificada Pratique a criação, a consulta e a otimização de tabelas Delta para análise de alto desempenho |

| Mergulhe no processamento de fluxo | Estude o Spark Structured Streaming para criar pipelines de dados em tempo real Experimente casos de uso como processamento de fluxo de eventos, análise de logs e painéis em tempo real Saiba como integrar dados de streaming com o Delta Lake para o gerenciamento contínuo do fluxo de dados |

Aprendizado de máquina

O ecossistema de aprendizado de máquina da Databricks acelera o desenvolvimento e a implementação de modelos. Para se especializar nessa área:

| Área de foco | Principais atividades e metas de aprendizado |

|---|---|

| Mestre MLflow | Use o MLflow para rastrear experimentos, registrar parâmetros e avaliar métricas de seus modelos Saiba mais sobre o MLflow Model Registry para gerenciar modelos durante todo o ciclo de vida, do desenvolvimento à produção Explore recursos avançados, como o suporte GenAI para criar aplicativos como chatbots e resumo de documentos |

| Foco na implantação | Pratique a implantação de modelos de aprendizado de máquina como APIs REST ou usando estruturas como Azure ML e Amazon SageMaker Experimente o Databricks Model Serving para dimensionar implantações de forma eficiente |

| Incorporar bibliotecas avançadas | Use o TensorFlow, o PyTorch ou o Hugging Face Transformers para criar modelos sofisticados no Databricks. |

Obter certificação

As certificações validam sua experiência e fazem com que você se destaque no mercado de trabalho. A Databricks oferece várias certificações adaptadas a diferentes funções e níveis de habilidade:

| Certificação | Descrição |

|---|---|

| Desenvolvedor Associado Certificado da Databricks para o Apache Spark | Projetada para desenvolvedores, essa certificação se concentra em conceitos de programação do Spark, APIs DataFrame e Spark SQL. |

| Associado de Engenheiro de Dados Certificado da Databricks | Abrange as principais habilidades, como a criação de pipelines de dados confiáveis usando o Delta Lake e a otimização do armazenamento de dados para análise. |

| Cientista de dados profissional certificado da Databricks | Para profissionais avançados, essa certificação testa sua capacidade de criar, implementar e monitorar modelos de aprendizado de máquina usando as ferramentas da Databricks. |

Recursos de aprendizado da Databricks

Cursos e tutoriais

- Databricks Academy: Oferece caminhos de treinamento oficiais que abrangem tópicos essenciais como engenharia de dados, aprendizado de máquina e Databricks SQL. Perfeito para você obter certificações e dominar as ferramentas da Databricks.

- DataCamp: Oferece introduções amigáveis para iniciantes ao Databricks e guias avançados focados na obtenção de certificações.

- Coursera e edX: Apresenta cursos das principais instituições e especialistas do setor com foco nos fluxos de trabalho do Databricks e na programação do Spark.

- Udemy: Oferece cursos econômicos sobre tópicos como pipelines de ETL, Delta Lake e fundamentos de Databricks.

- Recursos da comunidade: Explore blogs, canais do YouTube (como Databricks ou TheSeattleGuy) e tutoriais de usuários experientes para obter aprendizado prático.

Documentação e suporte da comunidade

- Documentação da Databricks: Um recurso abrangente para você entender os recursos da plataforma, as APIs e as práticas recomendadas. Inclui tutoriais, perguntas frequentes e guias para ajudar usuários iniciantes e avançados.

- Databricks Community Edition: Um ambiente gratuito para você testar e aprender sobre a Databricks sem precisar de uma conta na nuvem.

- Fóruns de usuários: Junte-se aos fóruns da comunidade da Databricks ou participe de discussões em plataformas como o Stack Overflow para solucionar problemas e compartilhar conhecimento.

- Repositórios do GitHub: Acesse projetos de código aberto, notebooks de exemplo e trechos de código compartilhados pelos engenheiros da Databricks e pela comunidade como o desafio 30 days of Databricks.

Folhas de consulta e guias de referência

- Folhas de dicas do Spark Command: Use a folha de consulta dos comandos Spark da Standford para aprimorar sua experiência de aprendizado.

- Início rápido do Delta Lake: Guias para download para configurar o Delta Lake para armazenamento e transações de dados eficientes.

- Guias de API e CLI da Databricks: Use-os para gerenciar seu ambiente Databricks de forma programática.

Para dominar o Databricks de forma eficaz, é essencial que você utilize uma combinação de cursos estruturados, documentação oficial e materiais de referência rápida. Abaixo estão os principais recursos que podem orientar sua jornada de aprendizado e apoiá-lo à medida que você adquire experiência.

Mantendo-se atualizado com a Databricks

Aprendizagem contínua

Manter-se atualizado com a Databricks é essencial, pois a plataforma evolui frequentemente com novos recursos e aprimoramentos.

- Atualize suas habilidades: Revisite regularmente os conceitos fundamentais, como Spark, Delta Lake e MLflow, e explore as atualizações para se manter à frente.

- Experimente os novos recursos: Utilize a Community Edition gratuita ou ambientes sandbox para testar ferramentas e recursos introduzidos recentemente.

- Explore as opções de certificação: A Databricks oferece programas de certificação que validam suas habilidades e ajudam você a se manter alinhado com as práticas mais recentes do setor.

Acompanhar blogs e notícias

- Blog oficial da Databricks: Mantenha-se informado sobre anúncios de produtos, práticas recomendadas e histórias de sucesso no blog oficial da Databricks.

- Plataformas de notícias tecnológicas: Siga fontes como TechCrunch, InfoWorld e Medium para saber como a Databricks está impulsionando a inovação em todos os setores.

Envolvimento com a comunidade

- Participe de grupos de usuários: Participe de grupos voltados para a Databricks no Meetup, LinkedIn ou Discord para compartilhar conhecimento e aprender de forma colaborativa.

- Participar de conferências: Eventos como o Databricks Summit são excelentes para fazer networking e explorar casos de uso de ponta.

- Participe dos fóruns: Participe de discussões em plataformas como o Stack Overflow, os fóruns da comunidade Databricks e os subreddits de engenharia de dados do Reddit.

Assinatura do DataFramed

Assine o podcast DataFramed para obter insights sobre as últimas tendências e ouvir entrevistas com especialistas. Um ótimo episódio relacionado à Databricks que eu recomendo apresenta até mesmo o CTO da Databricks: [IA e a pilha de dados moderna] Como a Databricks está transformando o armazenamento de dados e a IA com Ari Kaplan, evangelista-chefe e Robin Sutara, CTO de campo da Databricks.

Assine o DataFramed

Assine o DataFramed onde quer que você receba seus podcasts.

Conclusão

A Databricks capacita os profissionais a solucionar desafios e abrir oportunidades de carreira. Estou feliz por ter aprendido o Databricks e incentivo você a continuar estudando. Lembre-se de:

-

Defina suas metas: Alinhe seu caminho de aprendizado com objetivos específicos, seja em engenharia de dados, IA ou análise.

-

Utilize os recursos: Aproveite os cursos estruturados, as edições comunitárias e os projetos práticos para ganhar experiência.

-

Mantenha-se engajado: Acompanhe as atualizações, participe da comunidade Databricks e adote o aprendizado contínuo para se manter à frente.

Josep é cientista de dados e gerente de projetos no Conselho de Turismo da Catalunha, usando dados para melhorar a experiência dos turistas na Catalunha. Sua experiência inclui o gerenciamento de armazenamento e processamento de dados, juntamente com análises avançadas e a comunicação eficaz de insights de dados.

Ele também é um educador dedicado, lecionando no programa de mestrado em Big Data da Universidade de Navarra e contribuindo regularmente com artigos perspicazes sobre ciência de dados para o Medium e o KDNuggets.

Ele é bacharel em Engenharia Física pela Universidade Politécnica da Catalunha e mestre em Sistemas Interativos Inteligentes pela Universidade Pompeu Fabra.

Atualmente, ele está empenhado em tornar as tecnologias relacionadas a dados mais acessíveis a um público mais amplo por meio da publicação ForCode'Sake no Medium.

Perguntas frequentes ao aprender a usar o Databricks

O que é a Databricks e por que ela é importante para os profissionais de dados?

A Databricks é uma plataforma de análise aberta para criar, implementar e manter soluções de dados, análise e IA em escala. Sua integração com os principais provedores de nuvem (AWS, Azure, GCP) e ferramentas robustas fazem dele um divisor de águas para os profissionais de dados, simplificando o processamento de big data e permitindo análises avançadas e aprendizado de máquina.

Quais são as três principais vantagens de aprender a usar o Databricks?

Crescimento na carreira: Alta demanda e escassez de profissionais qualificados; 2) Aplicações amplas: Permite a transformação de dados, a análise avançada e o aprendizado de máquina; 3) Vantagem competitiva: Oferece compatibilidade com AWS, Azure, GCP e integra-se perfeitamente ao Apache Spark.

Quais são os principais recursos que fazem da Databricks uma plataforma abrangente?

Os principais recursos incluem uma plataforma de dados unificada que combina engenharia de dados, análise e aprendizado de máquina, integração do Apache Spark para processamento distribuído, Delta Lake para consistência de dados, MLflow para gerenciar ciclos de vida de aprendizado de máquina e ferramentas de colaboração, como notebooks interativos.

Como os iniciantes podem começar a usar a Databricks?

Os iniciantes podem começar definindo suas metas de aprendizado, inscrevendo-se na Databricks Community Edition gratuita, explorando a interface (espaços de trabalho, clusters, notebooks) e trabalhando em projetos práticos, como a criação de pipelines de ETL ou experiências com o MLflow.

Como os profissionais podem se manter atualizados com a Databricks?

Mantenha-se atualizado revisando regularmente os conceitos principais, como Delta Lake e MLflow, experimentando os novos recursos da Community Edition, acompanhando o blog oficial da Databricks e interagindo com a comunidade da Databricks por meio de fóruns, conferências e grupos de usuários.