Cours

Databricks est une plateforme analytique ouverte pour construire, déployer et maintenir des solutions de données, d'analyse et d'IA à l'échelle. Il est construit sur Apache Spark et s'intègre à l'un des trois principaux fournisseurs de cloud (AWS, Azure ou GCP), ce qui nous permet de gérer et de déployer l'infrastructure cloud en notre nom tout en offrant toutes les applications de science des données que vous pouvez imaginer.

Aujourd'hui, j'aimerais vous présenter une introduction complète à Databricks, couvrant ses fonctionnalités principales, ses applications pratiques et ses parcours d'apprentissage structurés pour vous aider à démarrer. De la mise en place de votre environnement à la maîtrise du traitement, de l'orchestration et de la visualisation des données, vous trouverez tout ce dont vous avez besoin pour démarrer avec Databricks.

Pourquoi apprendre Databricks ?

Apprendre Databricks et avoir des bases solides dans ce domaine peut avoir plusieurs avantages pour vous :

Les applications de Databricks sont nombreuses

Databricks a des applications étendues qui permettent aux entreprises de transformer les données, de les nettoyer, de les traiter et d'optimiser les grands ensembles de données pour en tirer des enseignements. Il permet des analyses avancées pour une meilleure prise de décision grâce à l'exploration et à la visualisation des données ; il soutient le développement et le déploiement de modèles prédictifs et de solutions d'IA.

Les bases de données vous donneront une longueur d'avance

Databricks offre un avantage concurrentiel grâce à sa compatibilité avec le cloud. Construit sur Apache Spark, il s'intègre aux meilleurs outils de données comme AWS, Azure et Google Cloud. La maîtrise de Databricks vous positionne en tant que leader dans tous les secteurs d'activité qui s'intéressent aux données.

Caractéristiques principales de Databricks

Databricks est une plateforme complète pour l'ingénierie des données, l'analyse et l'apprentissage automatique, combinant cinq caractéristiques principales qui améliorent l'évolutivité, la collaboration et l'efficacité du flux de travail.

Caractéristiques principales de Databricks. Image par l'auteur.

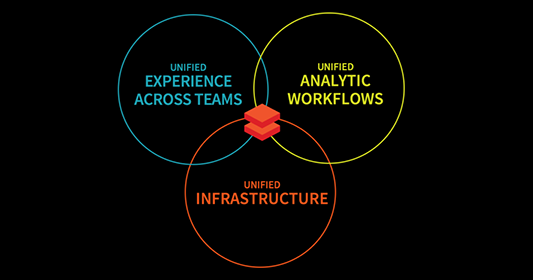

Plate-forme de données unifiée

Databricks combine les trois flux de travail d'ingénierie des données, de science des données et d'apprentissage automatique en une seule plateforme. Cela simplifie encore le traitement des données, la formation des modèles et le déploiement. En unifiant ces domaines, Databricks accélère les initiatives d'IA, aidant les entreprises à transformer des données cloisonnées en informations exploitables tout en favorisant la collaboration.

Intégration d'Apache Spark

Apache Spark, le principal framework de calcul distribué, est profondément intégré à Databricks. Cela permet à Databricks de gérer automatiquement la configuration de Spark. Les utilisateurs peuvent donc se concentrer sur l'élaboration de solutions de données sans se soucier de la configuration.

En outre, la puissance de traitement distribuée de Spark est idéale pour les tâches de big data, et Databricks l'améliore avec une sécurité, une évolutivité et une optimisation de niveau entreprise.

Delta Lake

Delta Lake est l'épine dorsale de l'architecture Lakehouse de Databricks, qui ajoute des fonctionnalités telles que les transactions ACID, l'application des schémas et la cohérence des données en temps réel (). Cela garantit la fiabilité et la précision des données, ce qui fait de Delta Lake un outil essentiel pour la gestion des données par lots et en continu.

MLflow

MLflow est une plateforme open-source permettant de gérer l'ensemble du cycle de vie de l'apprentissage automatique. Du cursus des expériences à la gestion du déploiement des modèles, MLflow simplifie le processus de construction et d'opérationnalisation des modèles de ML.

De plus, avec les dernières intégrations pour les outils d'IA générative comme OpenAI et Hugging Face, MLflow étend ses capacités pour inclure des applications de pointe telles que les chatbots, la synthèse de documents et l'analyse des sentiments.

Outils de collaboration

Databricks favorise la collaboration grâce à :

- Carnets de notes interactifs: Combinez du code, du markdown et des visuels pour documenter les flux de travail et partager des informations de manière transparente.

- Partage en temps réel: Collaborez en direct sur les carnets de notes pour un retour d'information instantané et un travail d'équipe rationalisé.

- Fonctionnalités du contrôle de version: Cursus des modifications et intégration à Git pour une gestion de projet sécurisée et efficace.

Comment commencer à apprendre Databricks

Démarrer avec Databricks peut être à la fois excitant et accablant. C'est pourquoi la première étape de l'apprentissage d'une nouvelle technologie consiste à bien comprendre vos objectifs - pourquoi vous voulez l'apprendre et comment vous comptez l'utiliser.

Fixez des objectifs clairs

Avant de vous lancer, définissez ce que vous souhaitez réaliser avec Databricks.

Vous cherchez à rationaliser le traitement des big data en tant qu'ingénieur de données ? Ou bien vous concentrez-vous sur l'exploitation de ses capacités de ML pour construire et déployer des modèles prédictifs ?

En définissant vos principaux objectifs, vous pouvez créer un plan d'apprentissage ciblé en conséquence. Voici quelques conseils en fonction de votre aspiration principale :

- Si vous vous concentrez sur l'ingénierie des données, découvrez en priorité les outils d'ingestion, de transformation et de gestion des données de Databricks, ainsi que son intégration transparente avec Apache Spark et Delta Lake.

- Si vous vous concentrez sur l'apprentissage automatique, concentrez-vous sur la compréhension de MLflow pour le suivi des expériences, la gestion des modèles et le déploiement, ainsi que sur l'exploitation du support intégré de la plateforme pour des bibliothèques telles que TensorFlow et PyTorch.

Commencez par l'essentiel :

Démarrer avec Databricks peut être plus facile que vous ne le pensez. Pour ce faire, je vous guiderai dans une approche pas à pas, afin que vous puissiez facilement vous familiariser avec les éléments essentiels de la plateforme.

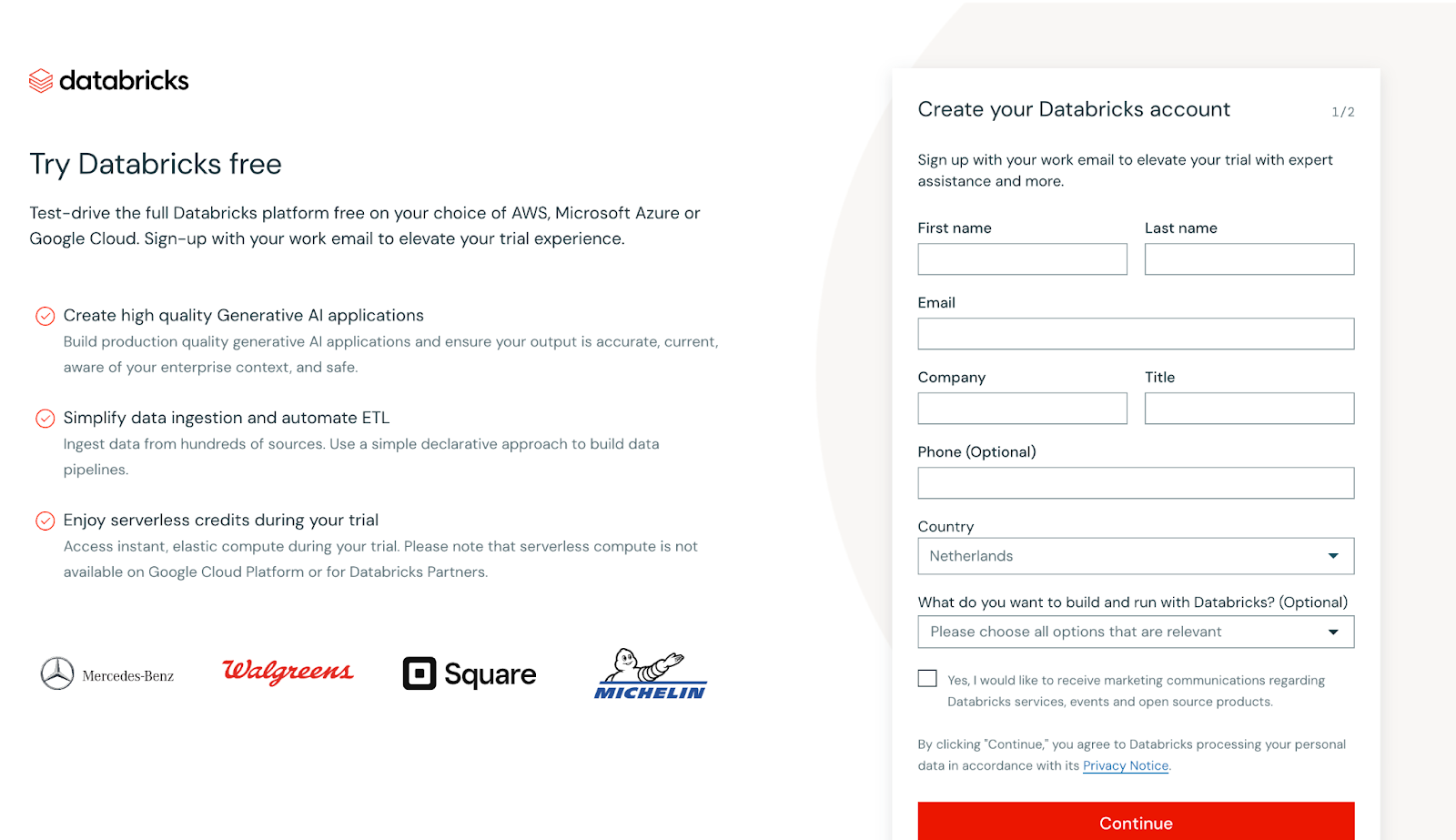

Inscrivez-vous gratuitement

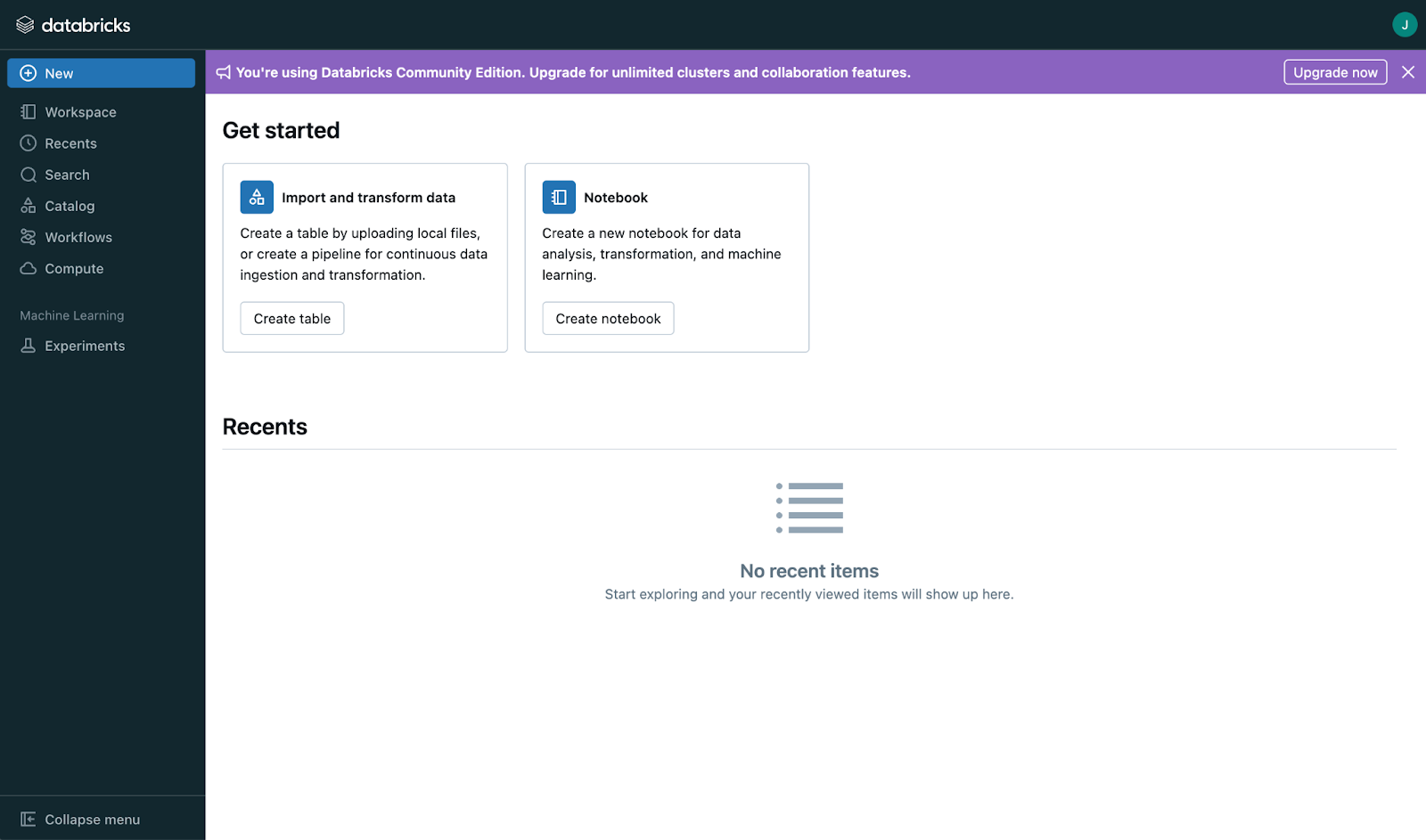

Commencez par créer un compte gratuit sur Databricks Community Editionqui vous permet d'accéder gratuitement aux fonctionnalités de base de la plateforme. Cette édition est parfaite pour une exploration pratique, vous permettant d'expérimenter les espaces de travail, les clusters et les carnets de notes sans avoir besoin d'un abonnement payant.

Capture d'écran de la vue principale de l'inscription à Databricks. Image par l'auteur

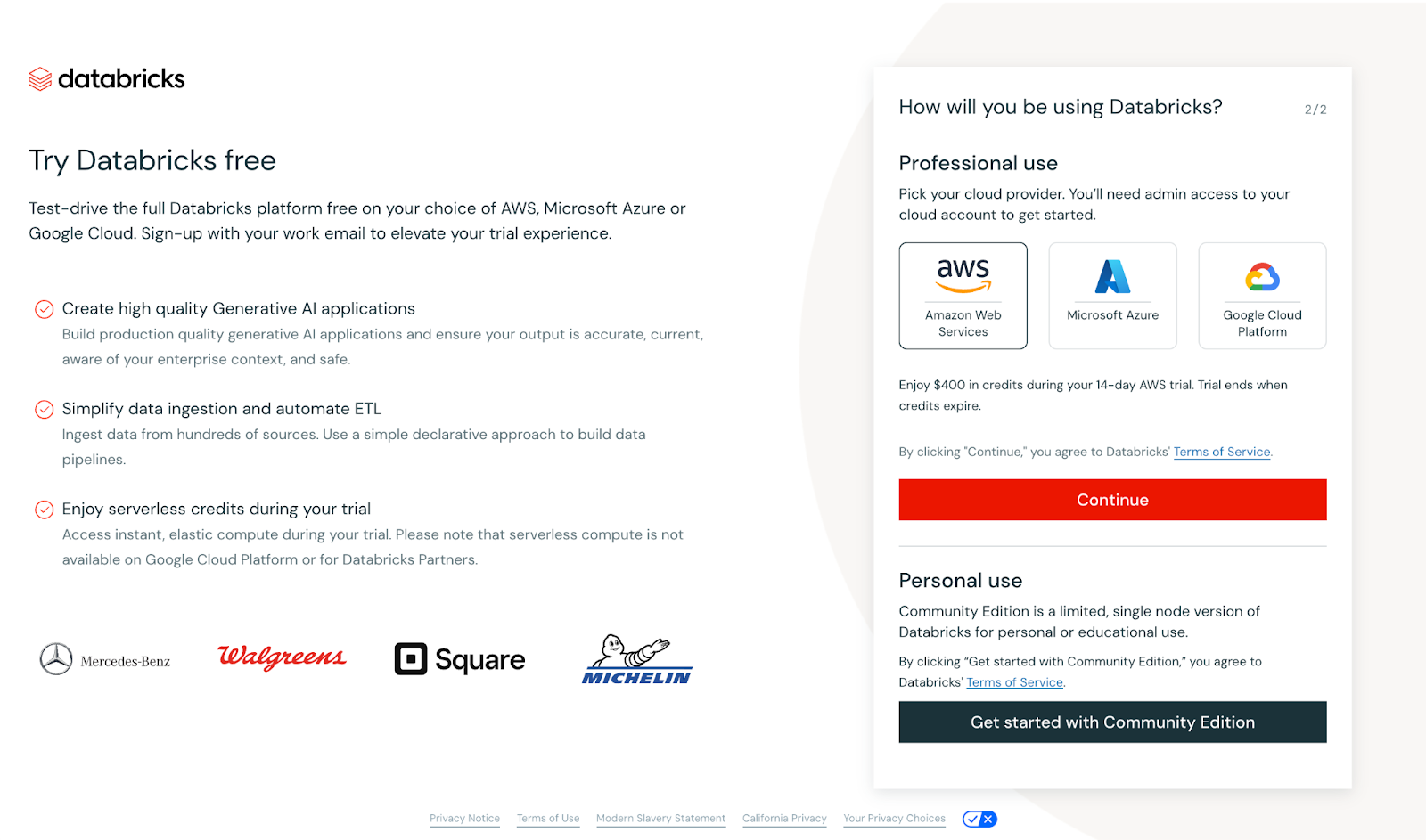

Une fois que vous avez indiqué vos coordonnées, l'écran suivant s'affiche.

Capture d'écran de la vue principale de l'inscription à Databricks. Image par l'auteur

Dans ce cas, vous serez invité à configurer un fournisseur de cloud ou à poursuivre avec l'édition communautaire. Pour rester accessible, nous utiliserons l'édition communautaire. Bien qu'elle offre moins de fonctionnalités que la version Enterprise, elle est idéale pour les petits cas d'utilisation tels que les tutoriels et ne nécessite pas l'installation d'un fournisseur de cloud.

Après avoir sélectionné l'édition communautaire, vérifiez votre adresse électronique. Une fois vérifié, vous serez accueilli par un tableau de bord principal qui ressemble à celui-ci :

Capture d'écran de la page principale de Databricks. Image par l'auteur

Commencez par l'interface

Une fois connecté, prenez le temps de comprendre la présentation. À première vue, l'interface peut sembler basique, mais une fois que vous l'aurez explorée plus avant ou que vous aurez mis à jour votre compte, vous découvrirez de nombreuses fonctionnalités intéressantes :

- Espaces de travail : C'est ici que vous organisez vos projets, vos carnets et vos fichiers. Considérez-le comme la plaque tournante de tout votre travail.

- Ordinateurs portables: Écrire et exécuter du code dans différents langages de programmation au sein d'un même carnet.

- Gestion des clusters: Il s'agit de groupes de machines virtuelles qui traitent les données. Ils fournissent la puissance de calcul dont vous avez besoin pour des tâches telles que les transformations de données et l'apprentissage automatique.

- Gestion des tableaux: Organiser et analyser efficacement des données structurées.

- Création du tableau de bord: Créez des tableaux de bord interactifs directement dans l'espace de travail pour visualiser les informations.

- Édition collaborative: Travaillez sur des carnets de notes en temps réel avec vos coéquipiers pour une collaboration transparente.

- Contrôle de version: Cursus des modifications apportées aux carnets de notes et gestion des versions sans effort.

- Planification des tâches: Automatisez l'exécution des carnets et des scripts à des intervalles spécifiques pour rationaliser les flux de travail.

Apprendre les concepts de base

Databricks comporte trois concepts de base qui resteront fondamentaux pour tout professionnel désireux de les maîtriser :

- Les grappes d'entreprises : Véritable colonne vertébrale des Databricks, les clusters sont des environnements informatiques qui exécutent votre code. Apprenez à les créer, à les configurer et à les gérer en fonction de vos besoins de traitement.

- Emplois : Automatisez les tâches répétitives en créant des tâches qui exécutent vos carnets ou vos scripts selon un calendrier, rationalisant ainsi les flux de travail.

- Cahiers : Il s'agit de documents interactifs dans lesquels vous écrivez et exécutez du code, visualisez les résultats et les documentez. Les notebooks prennent en charge plusieurs langages comme Python, SQL et Scala, ce qui les rend polyvalents pour diverses tâches.

Plan d'apprentissage Databricks

Voici mon idée d'un plan d'apprentissage en trois étapes.

Étape 1 : Maîtriser les fondamentaux de Databricks

Commencez votre voyage en construisant une base solide dans Databricks Essentials.

Gestion des données

La gestion efficace des données est au cœur de toute plateforme de données, et Databricks simplifie ce processus grâce à des outils robustes de chargement, de transformation et d'organisation des données à grande échelle. Voici un aperçu des principaux aspects de la gestion des données dans Databricks :

Chargement des données

Databricks prend en charge une grande variété de sources de données, ce qui facilite l'acquisition de données à partir de formats structurés, semi-structurés et non structurés.

- Formats de données pris en charge : CSV, JSON, Parquet, ORC, Avro, etc.

- Sources des données : Les systèmes de stockage dans le cloud comme AWS S3, Azure Data Lake et Google Cloud Storage, ainsi que les bases de données relationnelles et les API.

- Chargeur automatique : Fonctionnalité de Databricks qui simplifie le chargement des données à partir du stockage dans le cloud de manière évolutive et incrémentale, parfaite pour gérer des ensembles de données en croissance continue.

Transformer les données

Une fois vos données ingérées, Databricks fournit des outils puissants pour les nettoyer et les transformer afin de les préparer à l'analyse ou aux flux de travail d'apprentissage automatique.

- DataFrame : Ces derniers fournissent un moyen intuitif d'effectuer des transformations, à l'instar de SQL ou de pandas en Python. Vous pouvez filtrer, agréger et joindre des ensembles de données en toute simplicité.

- SparkSQL : Pour ceux qui sont familiers avec SQL, Databricks vous permet d'interroger et de manipuler vos données directement à l'aide de commandes SQL.

- Lac Delta : Améliorez les transformations de données grâce à la prise en charge par Delta Lake de l'application des schémas, de la gestion des versions et de la cohérence en temps réel.

Gestion des données

Databricks permet une gestion transparente de vos données à travers les différentes étapes du flux de travail.

- La maison des données : Databricks combine le meilleur des lacs de données et des entrepôts de données, offrant une plateforme unique pour tous les besoins en matière de données.

- Partitionnement : Optimisez les performances et le stockage en partitionnant vos ensembles de données pour accélérer les requêtes et le traitement.

- Traitement des métadonnées : Databricks assure automatiquement le suivi et la mise à jour des métadonnées de vos ensembles de données, ce qui simplifie la gouvernance des données et l'optimisation des requêtes.

Les bases d'Apache Spark

Familiarisez-vous avec les concepts fondamentaux de Spark, notamment :

- RDDs (Resilient Distributed Datasets) : La structure de données fondamentale pour l'informatique distribuée.

- DataFrame : Abstractions de haut niveau pour les données structurées, permettant un traitement et une analyse efficaces.

- SparkSQL : Une interface SQL pour l'interrogation et la manipulation de données dans Spark.

Ressources suggérées

- Académie Databricks : Commencez par le parcours d'apprentissage Fondamentaux pour des leçons guidées.

- Suivez le cours DataCamp Introduction to DataBricks pour démarrer et comprendre les bases de cette plateforme.

- Vous pouvez également utiliser la documentation habituelle de votre Cloud-Provider pour démarrer avec Databricks. Par exemple, Azure propose un bon contenu d'introduction à Databricks.

Étape 2 : Mettez la main à la pâte avec Databricks

La meilleure façon d'apprendre un nouvel outil, y compris Databricks, est la pratique. En appliquant les concepts que vous avez appris à des scénarios du monde réel, vous allez non seulement gagner en confiance, mais aussi approfondir votre compréhension des puissantes capacités de la plateforme.

Participez à des mini-projets

Les projets pratiques sont un excellent moyen d'explorer les fonctionnalités de Databricks tout en développant des compétences clés. Voici quelques projets de départ à envisager :

- Construire un projet d'ingénierie des données de bout en bout

- Suivez un flux de travail complet d'ingénierie des données en mettant en œuvre un processus ETL sur Databricks.

- Extrayez les données d'un service de stockage cloud, tel que AWS S3 ou Azure Blob Storage.

- Transformez les données à l'aide de Spark pour des tâches telles que le nettoyage, la déduplication et les agrégations.

- Chargez les données traitées dans un tableau Delta pour une interrogation et un stockage efficaces.

- Ajoutez de la valeur en créant un tableau de bord ou un rapport qui visualise les informations tirées des données traitées.

- Référence: Suivez ce projet ici.

Vous trouverez de nombreux autres projets (de niveau intermédiaire à avancé) sur le site web suivant consacré à l'apprentissage basé sur des projets. Ces projets permettent non seulement de renforcer les concepts de base, mais aussi de vous préparer à des flux de travail plus complexes dans le domaine de l'ingénierie des données et de l'apprentissage automatique.

Utilisez les laboratoires de Databricks Community Edition

La Databricks Community Edition offre un environnement gratuit, basé sur le cloud, parfait pour l'expérimentation. Utilisez-le pour accéder :

- Laboratoires préconstruits : Des laboratoires pratiques conçus pour vous enseigner des compétences clés telles que le travail avec des clusters, des ordinateurs portables et Delta Lake.

- Cahiers interactifs : Entraînez-vous à coder directement dans les carnets Databricks, qui prennent en charge Python, SQL, Scala et R.

- Caractéristiques de la collaboration : Expérimentez des outils de collaboration en temps réel pour simuler des projets en équipe.

Mettez en valeur vos compétences

La création d'un portefeuille diversifié est un excellent moyen de mettre en valeur votre expertise. Documenter et présenter vos projets est tout aussi important que de les construire. Utilisez GitHub ou un site web personnel pour :

- Fournissez une description détaillée de chaque projet, y compris les objectifs, les outils utilisés et les résultats.

- Partagez les référentiels de code avec une documentation claire pour les rendre accessibles aux autres.

- Incluez des éléments visuels tels que des captures d'écran, des diagrammes ou des tableaux de bord pour illustrer les résultats.

- Rédigez un article de blog ou un résumé de projet pour mettre en évidence les défis, les solutions et les principaux enseignements.

En combinant l'expérience pratique avec un portfolio soigné, vous démontrerez efficacement votre expertise et vous vous démarquerez dans l'écosystème compétitif d'Azure.

Étape 3 : Approfondir vos compétences dans des domaines spécialisés

- Ingénierie des données: Recommandez de vous concentrer sur le traitement des lacs et des cours d'eau du delta.

- Machine Learning: Suggérer d'étudier MLflow pour le suivi et le déploiement des modèles.

- Certifications: Listez les certifications telles que Databricks Certified Associate Developer for Apache Spark et Databricks Certified Professional Data Scientist.

Une fois que vous avez maîtrisé les principes fondamentaux de Databricks et acquis une expérience pratique, l'étape suivante consiste à vous concentrer sur les domaines spécialisés qui correspondent à vos objectifs de carrière. Que vous soyez intéressé par l'ingénierie des données, l'apprentissage automatique ou l'obtention de certifications pour valider vos compétences, cette étape vous aidera à acquérir une expertise avancée.

Ingénierie des données

L'ingénierie des données est au cœur de la construction de pipelines de données évolutifs, et Databricks offre des outils puissants pour soutenir ce travail. Pour améliorer vos compétences dans ce domaine :

| Domaine d'intervention | Activités clés et objectifs d'apprentissage |

|---|---|

| Apprendre le lac Delta | Comprendre le rôle de Delta Lake dans la garantie de la fiabilité et de la cohérence des données grâce à des fonctionnalités telles que les transactions ACID et l'application des schémas Découvrir comment Delta Lake facilite le traitement des données par lots et en continu sur une plateforme unifiée S'entraîner à créer, interroger et optimiser les tableaux Delta pour des analyses de haute performance. |

| Plongez dans le traitement des flux | Étudiez le streaming structuré Spark pour créer des pipelines de données en temps réel Expérimentez des cas d'utilisation tels que le traitement des flux d'événements, l'analyse des journaux et les tableaux de bord en temps réel Apprenez à intégrer les données en streaming avec Delta Lake pour la gestion des flux de données en continu. |

Apprentissage automatique

L'écosystème d'apprentissage automatique de Databricks accélère le développement et le déploiement des modèles. Se spécialiser dans ce domaine :

| Domaine d'intervention | Activités clés et objectifs d'apprentissage |

|---|---|

| Maître MLflow | Utilisez MLflow pour suivre les expériences, enregistrer les paramètres et évaluer les métriques de vos modèles Découvrez le registre de modèles MLflow pour gérer les modèles tout au long de leur cycle de vie, du développement à la production Explorez les fonctionnalités avancées comme la prise en charge de GenAI pour créer des applications telles que des chatbots et des résumés de documents. |

| L'accent mis sur le déploiement | Entraînez-vous à déployer des modèles d'apprentissage automatique en tant qu'API REST ou en utilisant des frameworks tels que Azure ML et Amazon SageMaker Expérimentez Databricks Model Serving pour mettre à l'échelle les déploiements de manière efficace. |

| Incorporer des bibliothèques avancées | Utilisez TensorFlow, PyTorch ou les transformateurs Hugging Face pour construire des modèles sophistiqués au sein de Databricks. |

Obtenir un certificat

Les certifications valident votre expertise et vous distinguent sur le marché du travail. Databricks propose plusieurs certifications adaptées à différents rôles et niveaux de compétences :

| Certification | Description |

|---|---|

| Développeur associé certifié Databricks pour Apache Spark | Conçue pour les développeurs, cette certification se concentre sur les concepts de programmation Spark, les API DataFrame et Spark SQL. |

| Databricks Certified Data Engineer Associate | Il couvre des compétences clés telles que la construction de pipelines de données fiables à l'aide de Delta Lake et l'optimisation du stockage des données pour l'analyse. |

| Databricks Certified Professional Data Scientist (Scientifique de données professionnel certifié) | Pour les praticiens avancés, cette certification teste votre capacité à construire, déployer et surveiller des modèles d'apprentissage automatique à l'aide des outils Databricks. |

Ressources pédagogiques Databricks

Cours et tutoriels

- Académie Databricks: Offre des parcours de formation officiels couvrant des sujets fondamentaux tels que l'ingénierie des données, l'apprentissage automatique et Databricks SQL. Parfait pour obtenir des certifications et maîtriser les outils Databricks.

- DataCamp: Fournit des introductions conviviales à Databricks pour les débutants et des guides avancés axés sur l'obtention de certifications.

- Coursera et edX: Présentez des cours dispensés par des institutions de premier plan et des experts du secteur, axés sur les flux de travail Databricks et la programmation Spark.

- Udemy: Offre des cours rentables sur des sujets tels que les pipelines ETL, Delta Lake et les principes fondamentaux de Databricks.

- Ressources communautaires: Explorez les blogs, les chaînes YouTube (comme Databricks ou TheSeattleGuy) et les tutoriels d'utilisateurs expérimentés pour un apprentissage pratique.

Documentation et soutien communautaire

- Documentation Databricks: Une ressource complète pour comprendre les fonctionnalités de la plateforme, les API et les meilleures pratiques. Comprend des tutoriels, des FAQ et des guides pour aider les débutants et les utilisateurs avancés.

- Databricks Community Edition: Un environnement gratuit pour tester et apprendre Databricks sans avoir besoin d'un compte cloud.

- Forums d'utilisateurs: Rejoignez les forums de la communauté Databricks ou participez aux discussions sur des plateformes telles que Stack Overflow pour le dépannage et le partage des connaissances.

- Dépôts GitHub: Accédez à des projets open-source, à des carnets d'exemples et à des extraits de code partagés par les ingénieurs de Databricks et la communauté comme le défi des 30 jours de Databricks.

Aide-mémoire et guides de référence

- Aide-mémoire de la commande Spark: Utilisez l 'antisèche des commandes Spark de Standford pour améliorer votre expérience d'apprentissage.

- Démarrage rapide du lac Delta: Guides téléchargeables pour configurer Delta Lake pour un stockage de données et des transactions efficaces.

- Guides de l'interface de programmation et de l'API de Databricks: Utilisez-les pour gérer votre environnement Databricks de manière programmatique.

Pour maîtriser efficacement Databricks, il est essentiel d'utiliser une combinaison de cours structurés, de documentation officielle et de matériel de référence rapide. Vous trouverez ci-dessous des ressources clés qui peuvent vous guider dans votre parcours d'apprentissage et vous aider à développer votre expertise.

Rester à jour avec Databricks

Apprentissage continu

Il est essentiel de rester à jour avec Databricks, car la plateforme évolue fréquemment avec de nouvelles fonctionnalités et améliorations.

- Rafraîchissez vos compétences: Revenez régulièrement sur des concepts fondamentaux comme Spark, Delta Lake et MLflow, et explorez les mises à jour pour garder une longueur d'avance.

- Expérimentez de nouvelles fonctionnalités: Utilisez l'édition communautaire gratuite ou les environnements sandbox pour tester les outils et les fonctionnalités récemment introduits.

- Explorez les options de certification: Databricks propose des programmes de certification qui valident vos compétences et vous aident à rester en phase avec les dernières pratiques de l'industrie.

Suivre les blogs et les actualités

- Blog officiel de Databricks: Restez informé des annonces de produits, des meilleures pratiques et des histoires de réussitedans le blog officiel de Databricks.

- Plateformes d'actualités technologiques: Suivez des sources telles que TechCrunch, InfoWorld et Medium pour découvrir comment Databricks stimule l'innovation dans tous les secteurs.

S'engager avec la communauté

- Rejoindre des groupes d'utilisateurs: Participez à des groupes axés sur Databricks sur Meetup, LinkedIn ou Discord pour partager vos connaissances et apprendre en collaboration.

- Participez à des conférences: Les événements tels que le Databricks Summit sont excellents pour créer des réseaux et explorer des cas d'utilisation de pointe.

- Participez aux forums: Participez à des discussions sur des plateformes telles que Stack Overflow, les forums de la communauté Databricks et les subreddits de Reddit sur l'ingénierie des données.

S'abonner à DataFrame

Abonnez-vous au podcast DataFrame pour découvrir les dernières tendances et écouter les interviews d'experts. Un excellent épisode lié à Databricks que je vous recommande met même en scène le CTO de Databricks : [ AI and the Modern Data Stack] How Databricks is Transforming Data Warehousing and AI avec Ari Kaplan, Head Evangelist & Robin Sutara, Field CTO at Databricks.

S'abonner à DataFramed

Abonnez-vous à DataFramed, quel que soit l'endroit où vous recevez vos podcasts.

Conclusion

Databricks permet aux professionnels de relever des défis et de saisir des opportunités de carrière. Je suis heureux d'avoir appris Databricks, et je vous encourage à continuer à étudier. N'oubliez pas de :

-

Définissez vos objectifs: Alignez votre parcours d'apprentissage sur des objectifs spécifiques, que ce soit en matière d'ingénierie des données, d'IA ou d'analyse.

-

Utilisez les ressources: Tirez parti des cours structurés, des éditions communautaires et des projets pratiques pour acquérir de l'expérience.

-

Restez engagé: Suivez les mises à jour, participez à la communauté Databricks et adoptez la formation continue pour rester à la pointe.

Josep est data scientist et chef de projet à l'Office du tourisme de Catalogne, où il utilise les données pour améliorer l'expérience des touristes en Catalogne. Son expertise comprend la gestion du stockage et du traitement des données, associée à des analyses avancées et à la communication efficace des données.

Il est également un éducateur dévoué, enseignant le programme de Master Big Data à l'Université de Navarre, et contribuant régulièrement à des articles perspicaces sur la science des données sur Medium et KDNuggets.

Il est titulaire d'une licence en ingénierie physique de l'université polytechnique de Catalogne et d'une maîtrise en systèmes interactifs intelligents de l'université Pompeu Fabra.

Actuellement, il s'engage avec passion à rendre les technologies liées aux données plus accessibles à un public plus large par le biais de la publication ForCode'Sake sur Medium.

Questions fréquemment posées lors de l'apprentissage de Databricks

Qu'est-ce que Databricks et pourquoi est-il important pour les professionnels des données ?

Databricks est une plateforme analytique ouverte pour construire, déployer et maintenir des solutions de données, d'analyse et d'IA à l'échelle. Son intégration avec les principaux fournisseurs de cloud (AWS, Azure, GCP) et ses outils robustes changent la donne pour les professionnels des données en rationalisant le traitement des big data et en permettant des analyses avancées et l'apprentissage automatique.

Quels sont les trois principaux avantages de l'apprentissage de Databricks ?

Croissance de la carrière : Demande élevée et pénurie de professionnels qualifiés ; 2) Applications étendues : Permet la transformation des données, l'analyse avancée et l'apprentissage automatique ; 3) Avantage concurrentiel : Offre une compatibilité avec AWS, Azure, GCP, et s'intègre de manière transparente avec Apache Spark.

Quelles sont les caractéristiques clés qui font de Databricks une plateforme complète ?

Les principales caractéristiques sont une plateforme de données unifiée combinant l'ingénierie des données, l'analytique et l'apprentissage automatique, l'intégration d'Apache Spark pour le traitement distribué, Delta Lake pour la cohérence des données, MLflow pour la gestion des cycles de vie de l'apprentissage automatique et des outils collaboratifs comme les carnets de notes interactifs.

Comment les débutants peuvent-ils commencer avec Databricks ?

Les débutants peuvent commencer par définir leurs objectifs d'apprentissage, s'inscrire à l'édition communautaire gratuite de Databricks, explorer l'interface (espaces de travail, clusters, carnets de notes) et travailler sur des projets pratiques tels que la construction de pipelines ETL ou l'expérimentation avec MLflow.

Comment les professionnels peuvent-ils rester informés sur Databricks ?

Restez à jour en revisitant régulièrement les concepts de base tels que Delta Lake et MLflow, en expérimentant les nouvelles fonctionnalités de la Community Edition, en suivant le blog officiel de Databricks et en vous engageant auprès de la communauté Databricks par le biais de forums, de conférences et de groupes d'utilisateurs.