Kurs

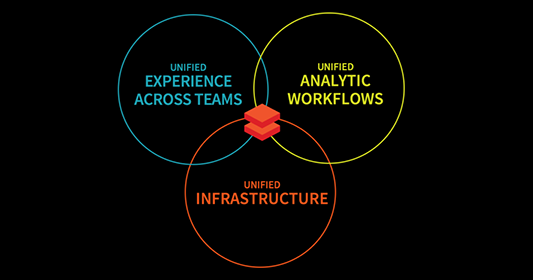

Databricks ist eine offene Analyseplattform für den Aufbau, den Einsatz und die Pflege von Daten, Analysen und KI-Lösungen in großem Maßstab. Es basiert auf Apache Spark und lässt sich mit jedem der drei großen Cloud-Anbieter (AWS, Azure oder GCP) integrieren. So können wir die Cloud-Infrastruktur in unserem Namen verwalten und bereitstellen und gleichzeitig jede erdenkliche Data Science-Anwendung anbieten.

Heute möchte ich dir eine umfassende Einführung in Databricks geben, die die wichtigsten Funktionen, praktische Anwendungen und strukturierte Lernpfade für den Einstieg umfasst. Von der Einrichtung deiner Umgebung bis zur Beherrschung von Datenverarbeitung, Orchestrierung und Visualisierung findest du hier alles, was du für den Einstieg in Databricks brauchst.

Warum Databricks lernen?

Wenn du Databricks lernst und über ein solides Fundament verfügst, kann das mehrere positive Vorteile für dich haben:

Databricks hat viele Anwendungen

Databricks verfügt über ein breites Spektrum an Anwendungen, die es Unternehmen ermöglichen, Daten umzuwandeln, zu bereinigen, zu verarbeiten und große Datenmengen zu optimieren, um Erkenntnisse zu gewinnen. Es ermöglicht fortschrittliche Analysen für bessere Entscheidungen durch Datenexploration und -visualisierung; es unterstützt die Entwicklung und den Einsatz von Vorhersagemodellen und KI-Lösungen.

Databricks verschaffen dir einen Vorteil

Databricks bietet einen Wettbewerbsvorteil durch seine Cloud-Kompatibilität. Es basiert auf Apache Spark und lässt sich mit führenden Datentools wie AWS, Azure und Google Cloud integrieren. Wenn du Databricks beherrschst, bist du in jeder Branche, die sich mit Daten beschäftigt, führend.

Hauptmerkmale von Databricks

Databricks ist eine umfassende Plattform für Data Engineering, Analytik und maschinelles Lernen, die fünf Hauptfunktionen zur Verbesserung der Skalierbarkeit, Zusammenarbeit und Workflow-Effizienz vereint.

Die wichtigsten Merkmale von Databricks. Bild vom Autor.

Einheitliche Datenplattform

Databricks vereint alle drei Arbeitsabläufe für Data Engineering, Data Science und maschinelles Lernen in einer einzigen Plattform. Dies vereinfacht die Datenverarbeitung, die Modellschulung und den Einsatz weiter. Durch die Vereinheitlichung dieser Bereiche beschleunigt Databricks KI-Initiativen und hilft Unternehmen dabei, isolierte Daten in verwertbare Erkenntnisse zu verwandeln und gleichzeitig die Zusammenarbeit zu fördern.

Apache Spark Integration

Apache Spark, das führende Framework für verteiltes Rechnen, ist eng mit Databricks integriert. So kann Databricks die Spark-Konfiguration automatisch übernehmen. So können sich die Nutzer auf die Erstellung von Datenlösungen konzentrieren, ohne sich um die Einrichtung kümmern zu müssen.

Außerdem ist die verteilte Rechenleistung von Spark ideal für Big-Data-Aufgaben, und Databricks erweitert sie um Sicherheit, Skalierbarkeit und Optimierung auf Unternehmensebene.

Delta Lake

Delta Lake ist das Rückgrat der Lakehouse-Architektur von Databricks, die Funktionen wie ACID-Transaktionen, Schema-Enforcement und Echtzeit-Datenkonsistenz bietet . Dies gewährleistet die Zuverlässigkeit und Genauigkeit der Daten und macht Delta Lake zu einem wichtigen Werkzeug für die Verwaltung von Batch- und Streaming-Daten.

MLflow

MLflow ist eine Open-Source-Plattform für die Verwaltung des gesamten Lebenszyklus von Machine Learning. Von der Nachverfolgung von Experimenten bis zur Verwaltung der Modellbereitstellung vereinfacht MLflow den Aufbau und die Anwendung von ML-Modellen.

Mit den neuesten Integrationen für generative KI-Tools wie OpenAI und Hugging Face erweitert MLflow seine Möglichkeiten um innovative Anwendungen wie Chatbots, Dokumentenzusammenfassung und Sentimentanalyse.

Tools für die Zusammenarbeit

Databricks fördert die Zusammenarbeit durch:

- Interaktive Notizbücher: Kombiniere Code, Markdown und visuelle Darstellungen, um Arbeitsabläufe zu dokumentieren und Erkenntnisse nahtlos zu teilen.

- Real-Time Sharing: Arbeite live an Notebooks für sofortiges Feedback und optimierte Teamarbeit.

- Funktionen der Versionskontrolle: Verfolge Änderungen und integriere sie in Git für ein sicheres und effizientes Projektmanagement.

Wie man Databricks lernt

Der Einstieg in Databricks kann sowohl spannend als auch überwältigend sein. Deshalb ist der erste Schritt beim Erlernen einer neuen Technologie, dass du dir über deine Ziele im Klaren bist - warum du sie lernen willst und wie du sie nutzen willst.

Klare Ziele setzen

Bevor du einsteigst, solltest du definieren, was du mit Databricks erreichen willst.

Willst du als Dateningenieur/in die Verarbeitung von Big Data optimieren? Oder konzentrierst du dich darauf, die ML-Funktionen zu nutzen, um Vorhersagemodelle zu erstellen und einzusetzen?

Wenn du deine Hauptziele definierst, kannst du einen gezielten Lernplan erstellen. Hier sind einige Tipps, die von deinem Hauptziel abhängen:

- Wenn dein Schwerpunkt auf Data Engineering liegt, dann solltest du dich vorrangig über die Databricks-Tools für die Datenaufnahme, -umwandlung und -verwaltung sowie über die nahtlose Integration mit Apache Spark und Delta Lake informieren.

- Wenn dein Schwerpunkt auf maschinellem Lernen liegt, konzentriere dich darauf, MLflow für die Nachverfolgung von Experimenten, die Modellverwaltung und den Einsatz zu verstehen und die integrierte Unterstützung der Plattform für Bibliotheken wie TensorFlow und PyTorch zu nutzen.

Beginne mit den Grundlagen:

Der Einstieg in Databricks kann einfacher sein, als du vielleicht denkst. Dazu werde ich dich Schritt für Schritt anleiten, damit du dich leicht mit den Grundlagen der Plattform vertraut machen kannst.

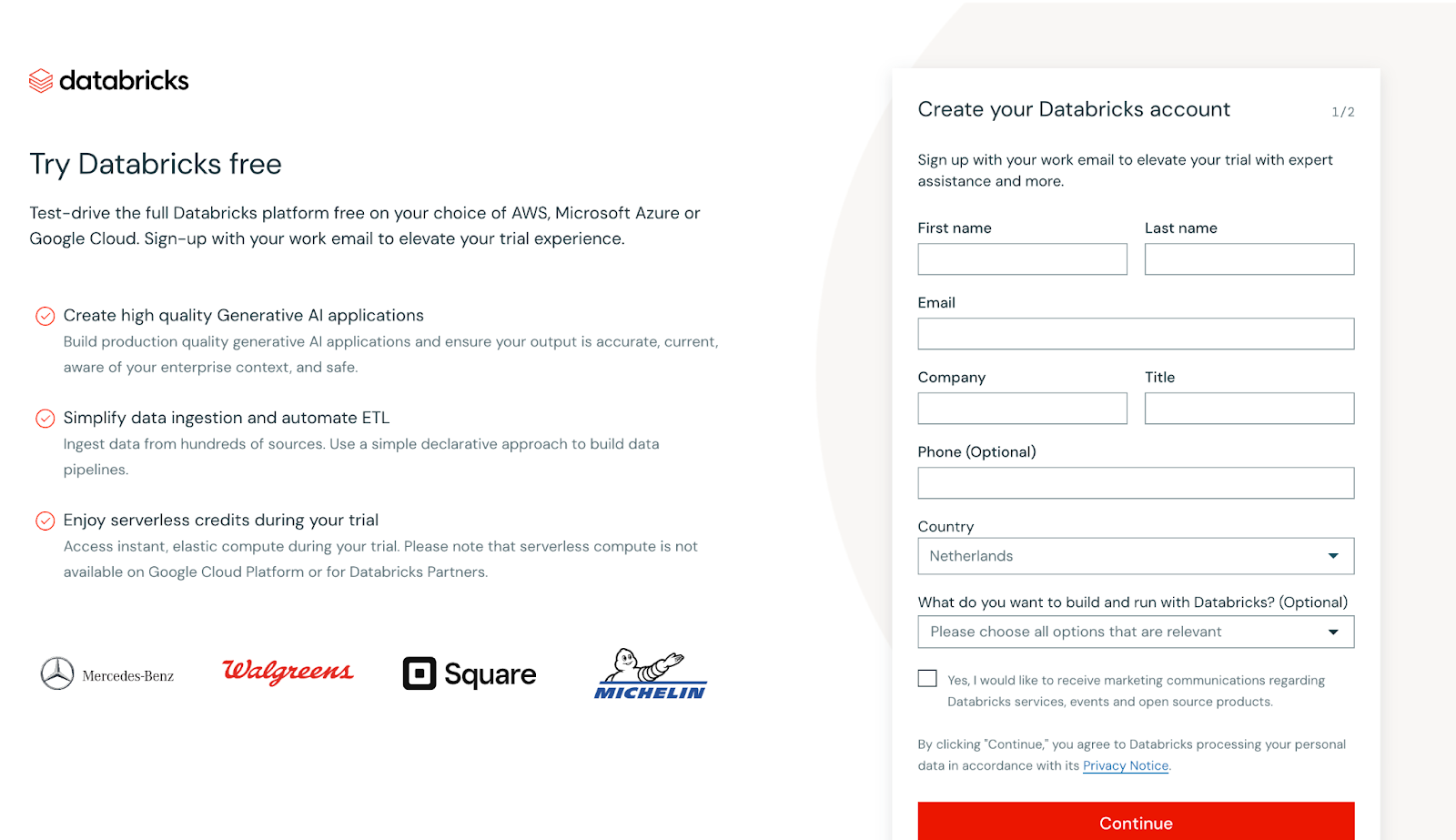

Kostenlos anmelden

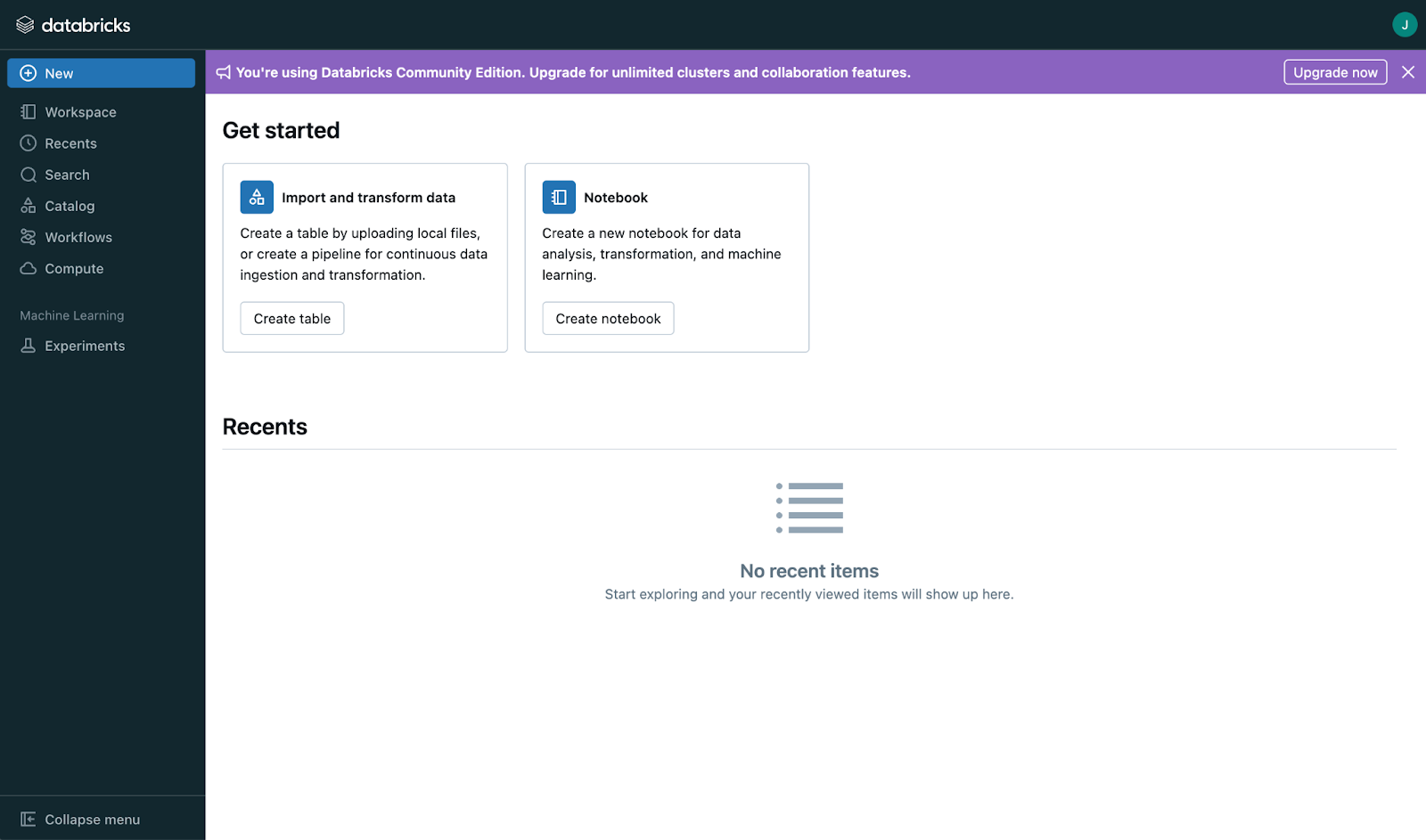

Beginnen Sie mit der Erstellung eines kostenlosen Kontos bei Databricks Community Editionan, mit dem du kostenlos auf die wichtigsten Funktionen der Plattform zugreifen kannst. Diese Edition ist perfekt für die praktische Erkundung, denn sie ermöglicht es dir, mit Workspaces, Clustern und Notizbüchern zu experimentieren, ohne dass du ein kostenpflichtiges Abonnement benötigst.

Screenshot der Hauptansicht der Databricks-Anmeldung. Bild vom Autor

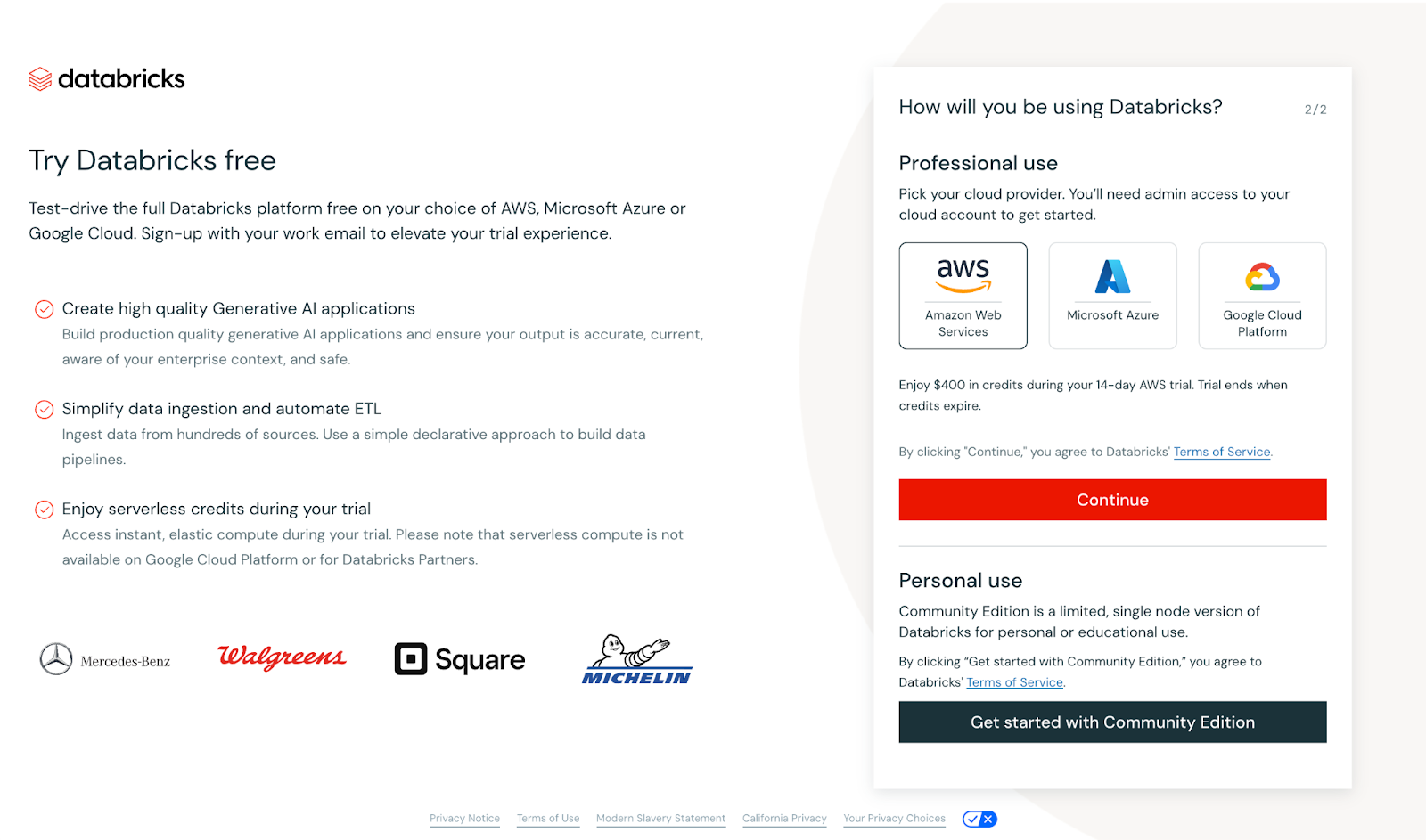

Sobald du deine Daten eingegeben hast, erscheint die folgende Ansicht.

Screenshot der Hauptansicht der Databricks-Anmeldung. Bild vom Autor

In diesem Fall wirst du aufgefordert, entweder einen Cloud-Anbieter einzurichten oder mit der Community Edition fortzufahren. Um die Dinge zugänglich zu halten, werden wir die Community Edition verwenden. Sie bietet zwar weniger Funktionen als die Enterprise-Version, ist aber ideal für kleinere Anwendungsfälle wie Tutorials und erfordert keine Einrichtung bei einem Cloud-Anbieter.

Nachdem du die Community Edition ausgewählt hast, verifiziere deine E-Mail-Adresse. Sobald du verifiziert bist, wirst du mit einem Haupt-Dashboard begrüßt, das wie folgt aussieht:

Screenshot der Hauptseite von Databricks. Bild vom Autor

Beginne mit der Schnittstelle

Wenn du eingeloggt bist, nimm dir Zeit, um das Layout zu verstehen. Auf den ersten Blick mag die Benutzeroberfläche einfach erscheinen, aber wenn du sie weiter erkundest oder dein Konto erweiterst, wirst du viele tolle Funktionen entdecken:

- Arbeitsräume: Hier organisierst du deine Projekte, Notizbücher und Dateien. Sieh es als Drehscheibe für deine gesamte Arbeit.

- Notizbücher: Schreibe und führe Code in verschiedenen Programmiersprachen innerhalb desselben Notebooks aus.

- Cluster Management: Das sind Gruppen von virtuellen Maschinen, die die Datenverarbeitung übernehmen. Sie bieten die Rechenleistung, die du für Aufgaben wie Datenumwandlung und maschinelles Lernen brauchst.

- Tabelle Management: Organisiere und analysiere strukturierte Daten effizient.

- Erstellung des Dashboards: Erstelle interaktive Dashboards direkt im Arbeitsbereich, um Erkenntnisse zu visualisieren.

- Gemeinsame Bearbeitung: Arbeite in Echtzeit mit deinen Teamkollegen an deinen Notizbüchern, um nahtlos zusammenzuarbeiten.

- Versionskontrolle: Verfolge die Änderungen in deinem Lernpfad und verwalte mühelos alle Versionen.

- Job Scheduling: Automatisiere die Ausführung von Notizbüchern und Skripten in bestimmten Intervallen für optimierte Arbeitsabläufe.

Kernkonzepte lernen

Databricks hat drei Kernkonzepte, die für jeden Profi, der sie beherrschen will, grundlegend bleiben:

- Clusters: Cluster sind das Rückgrat von Databricks. Sie sind Rechenumgebungen, die deinen Code ausführen. Hier erfährst du, wie du sie erstellen, konfigurieren und verwalten kannst, damit sie deinen Anforderungen entsprechen.

- Jobs: Automatisiere sich wiederholende Aufgaben, indem du Jobs erstellst, die deine Notizbücher oder Skripte nach einem Zeitplan ausführen und so die Arbeitsabläufe rationalisieren.

- Notizbücher: Das sind interaktive Dokumente, in denen du Code schreibst und ausführst, Ergebnisse visualisierst und Ergebnisse dokumentierst. Notebooks unterstützen mehrere Sprachen wie Python, SQL und Scala, was sie für verschiedene Aufgaben vielseitig einsetzbar macht.

Databricks Lernplan

Hier ist meine Idee für einen dreistufigen Lernplan.

Schritt 1: Meistere die Grundlagen von Databricks

Beginne deine Reise, indem du ein starkes Fundament in Databricks Essentials aufbaust.

Datenmanagement

Die effektive Verwaltung von Daten ist das Herzstück jeder Datenplattform. Databricks vereinfacht diesen Prozess mit robusten Tools zum Laden, Umwandeln und Organisieren von Daten in großem Umfang. Hier findest du einen Überblick über die wichtigsten Aspekte der Datenverwaltung in Databricks:

Daten laden

Databricks unterstützt eine Vielzahl von Datenquellen und macht es einfach, Daten aus strukturierten, halbstrukturierten und unstrukturierten Formaten aufzunehmen.

- Unterstützte Datenformate: CSV, JSON, Parquet, ORC, Avro, und mehr.

- Datenquellen: Cloud-Speicher-Systeme wie AWS S3, Azure Data Lake und Google Cloud Storage sowie relationale Datenbanken und APIs.

- Auto Lader: Eine Funktion von Databricks, die das Laden von Daten aus dem Cloud-Speicher auf skalierbare, inkrementelle Weise vereinfacht und sich perfekt für den Umgang mit ständig wachsenden Datensätzen eignet.

Daten umwandeln

Sobald deine Daten eingelesen sind, bietet Databricks leistungsstarke Tools zur Bereinigung und Umwandlung, um sie für Analysen oder maschinelle Lernprozesse vorzubereiten.

- DataFrames: Diese bieten eine intuitive Möglichkeit, Transformationen durchzuführen, ähnlich wie SQL oder Pandas in Python. Du kannst Datensätze ganz einfach filtern, aggregieren und verbinden.

- SparkSQL: Wenn du mit SQL vertraut bist, kannst du mit Databricks deine Daten direkt mit SQL-Befehlen abfragen und manipulieren.

- Delta Lake: Verbessere die Datentransformationen mit Delta Lakes Unterstützung für Schemaerzwingung, Versionierung und Echtzeitkonsistenz.

Daten verwalten

Databricks ermöglicht eine nahtlose Verwaltung deiner Daten über verschiedene Phasen des Workflows hinweg.

- Data Lakehouse: Databricks kombiniert das Beste aus Data Lakes und Data Warehouses und bietet eine einzige Plattform für alle Datenanforderungen.

- Partitionierung: Optimiere die Leistung und den Speicherplatz, indem du deine Datensätze für schnellere Abfragen und Verarbeitung partitionierst.

- Umgang mit Metadaten: Databricks verfolgt und aktualisiert automatisch die Metadaten deiner Datensätze und vereinfacht so die Datenverwaltung und Abfrageoptimierung.

Apache Spark Grundlagen

Mache dich mit den Kernkonzepten von Spark vertraut, z. B:

- RDDs (Resilient Distributed Datasets): Die grundlegende Datenstruktur für verteiltes Rechnen.

- DataFrames: High-Level-Abstraktionen für strukturierte Daten, die eine effiziente Verarbeitung und Analyse ermöglichen.

- SparkSQL: Eine SQL-Schnittstelle für die Abfrage und Manipulation von Daten in Spark.

Vorgeschlagene Ressourcen

- Databricks Academy: Beginne mit dem Lernpfad "Grundlagen" für geführte Lektionen.

- Folge dem DataCamp-Kurs Einführung in DataBricks, um die Grundlagen dieser Plattform zu verstehen.

- Du kannst auch deine übliche Cloud-Provider-Dokumentation verwenden, um mit Databricks zu beginnen. Auf Azure gibt es zum Beispiel einige gute Einführungen in Databricks.

Schritt 2: Praktische Erfahrungen mit Databricks

Der beste Weg, ein neues Tool zu lernen, auch Databricks, ist die praktische Anwendung. Indem du die gelernten Konzepte auf reale Szenarien anwendest, baust du nicht nur Selbstvertrauen auf, sondern vertiefst auch dein Verständnis für die leistungsstarken Funktionen der Plattform.

Beteilige dich an Miniprojekten

Praktische Projekte sind eine hervorragende Möglichkeit, die Funktionen von Databricks zu erkunden und gleichzeitig wichtige Fähigkeiten zu entwickeln. Hier sind ein paar erste Projekte, die du in Betracht ziehen kannst:

- Aufbau eines End-to-End Data Engineering Projekts

- Verfolge einen kompletten Data-Engineering-Workflow, indem du einen ETL-Prozess auf Databricks implementierst.

- Extrahiere Daten aus einem Cloud-Speicherdienst, z. B. AWS S3 oder Azure Blob Storage.

- Transformiere die Daten mit Spark für Aufgaben wie Bereinigung, Deduplizierung und Aggregationen.

- Lade die verarbeiteten Daten in eine Delta-Tabelle, um sie effizient abzufragen und zu speichern.

- Schaffe Mehrwert, indem du ein Dashboard oder einen Bericht erstellst, der die Erkenntnisse aus den verarbeiteten Daten visualisiert.

- Referenz: Verfolge dieses Projekt hier.

Viele weitere Projekte (von der Mittelstufe bis zu den Fortgeschrittenen) findest du auf der folgenden Website über das Lernen anhand von Projekten. Diese Projekte helfen nicht nur, die Kernkonzepte zu festigen, sondern bereiten dich auch auf komplexere Arbeitsabläufe im Bereich Data Engineering und maschinelles Lernen vor.

Databricks Community Edition Labs verwenden

Die Databricks Community Edition bietet eine kostenlose, cloudbasierte Umgebung, die sich perfekt zum Experimentieren eignet. Verwende es für den Zugang:

- Vorgefertigte Labore: Praktische Übungen, in denen du wichtige Fähigkeiten wie die Arbeit mit Clustern, Notebooks und Delta Lake erlernst.

- Interaktive Notizbücher: Übe das Kodieren direkt in Databricks Notebooks, die Python, SQL, Scala und R unterstützen.

- Kollaborative Eigenschaften: Experimentiere mit Tools für die Zusammenarbeit in Echtzeit, um teambasierte Projekte zu simulieren.

Präsentiere deine Fähigkeiten

Ein vielfältiges Portfolio ist eine gute Möglichkeit, dein Fachwissen zu präsentieren. Das Dokumentieren und Präsentieren deiner Projekte ist genauso wichtig wie ihr Bau. Verwende GitHub oder eine persönliche Website:

- Beschreibe jedes Projekt ausführlich, einschließlich der Ziele, der verwendeten Instrumente und der Ergebnisse.

- Teile Code-Repositories mit klarer Dokumentation, um sie für andere zugänglich zu machen.

- Füge visuelle Elemente wie Screenshots, Diagramme oder Dashboards hinzu, um die Ergebnisse zu veranschaulichen.

- Schreibe einen Blogbeitrag oder eine Projektzusammenfassung, in der du Herausforderungen, Lösungen und wichtige Erkenntnisse darstellst.

Indem du praktische Erfahrungen mit einem ausgefeilten Portfolio kombinierst, kannst du dein Fachwissen effektiv unter Beweis stellen und dich im wettbewerbsintensiven Azure-Ökosystem abheben.

Schritt 3: Vertiefung deiner Fähigkeiten in speziellen Bereichen

- Data Engineering: Empfehlen Sie, sich auf den Deltasee und die Flussverarbeitung zu konzentrieren.

- Maschinelles Lernen: Schlage vor, MLflow für die Modellverfolgung und -bereitstellung zu studieren.

- Zertifizierungen: Nenne Zertifizierungen wie Databricks Certified Associate Developer for Apache Spark und Databricks Certified Professional Data Scientist.

Wenn du die Grundlagen von Databricks beherrschst und praktische Erfahrungen gesammelt hast, kannst du dich im nächsten Schritt auf spezielle Bereiche konzentrieren, die deinen Karrierezielen entsprechen. Egal, ob du dich für Data Engineering oder maschinelles Lernen interessierst oder Zertifizierungen erwerben möchtest, um deine Fähigkeiten zu bestätigen, dieser Schritt wird dir helfen, fortgeschrittenes Fachwissen aufzubauen.

Datentechnik

Data Engineering ist das Herzstück beim Aufbau skalierbarer Datenpipelines, und Databricks bietet leistungsstarke Tools zur Unterstützung dieser Arbeit. Um deine Fähigkeiten in diesem Bereich zu verbessern:

| Schwerpunktbereich | Schlüsselaktivitäten und Lernziele |

|---|---|

| Delta Lake lernen | Die Rolle von Delta Lake bei der Sicherstellung der Datenzuverlässigkeit und -konsistenz mit Funktionen wie ACID-Transaktionen und Schemaerzwingung Erfahre, wie Delta Lake die Batch- und Streaming-Datenverarbeitung auf einer einheitlichen Plattform erleichtert Übe das Erstellen, Abfragen und Optimieren von Delta-Tabellen für Hochleistungsanalysen |

| Eintauchen in die Stream-Verarbeitung | Studiere Spark Structured Streaming, um Echtzeit-Datenpipelines aufzubauen Experimentiere mit Anwendungsfällen wie Event Stream Processing, Log Analytics und Echtzeit-Dashboards Lerne, wie du Streaming-Daten mit Delta Lake für ein kontinuierliches Datenflussmanagement integrierst |

Maschinelles Lernen

Das Ökosystem für maschinelles Lernen von Databricks beschleunigt die Entwicklung und Bereitstellung von Modellen. Sich auf diesen Bereich zu spezialisieren:

| Schwerpunktbereich | Schlüsselaktivitäten und Lernziele |

|---|---|

| Meister MLflow | Nutze MLflow, um Experimente zu verfolgen, Parameter zu protokollieren und Metriken deiner Modelle auszuwerten Lerne die MLflow Model Registry kennen, um Modelle während ihres gesamten Lebenszyklus zu verwalten, von der Entwicklung bis zur Produktion Entdecke fortgeschrittene Funktionen wie die GenAI-Unterstützung für die Erstellung von Anwendungen wie Chatbots und Dokumentenzusammenfassung |

| Fokus auf Einsatz | Übe die Bereitstellung von Machine Learning-Modellen als REST-APIs oder mit Frameworks wie Azure ML und Amazon SageMaker Experimentiere mit Databricks Model Serving, um Bereitstellungen effizient zu skalieren |

| Erweiterte Bibliotheken einbinden | Verwende TensorFlow, PyTorch oder Hugging Face Transformers, um anspruchsvolle Modelle in Databricks zu erstellen. |

Zertifiziert werden

Zertifizierungen bestätigen dein Fachwissen und heben dich auf dem Arbeitsmarkt hervor. Databricks bietet verschiedene Zertifizierungen an, die auf unterschiedliche Rollen und Qualifikationsstufen zugeschnitten sind:

| Zertifizierung | Beschreibung |

|---|---|

| Databricks Certified Associate Developer für Apache Spark | Diese Zertifizierung richtet sich an Entwickler und konzentriert sich auf Spark-Programmierkonzepte, DataFrame-APIs und Spark SQL. |

| Databricks Certified Data Engineer Associate | Er vermittelt wichtige Fähigkeiten wie den Aufbau zuverlässiger Datenpipelines mit Delta Lake und die Optimierung der Datenspeicherung für Analysen. |

| Databricks Certified Professional Data Scientist | Für fortgeschrittene Praktiker prüft diese Zertifizierung deine Fähigkeit, Machine-Learning-Modelle mit Databricks-Tools zu erstellen, einzusetzen und zu überwachen. |

Databricks Lernressourcen

Kurse und Tutorials

- Databricks Academy: Bietet offizielle Schulungen zu Kernthemen wie Data Engineering, maschinelles Lernen und Databricks SQL an. Perfekt, um Zertifizierungen zu erlangen und die Databricks-Tools zu beherrschen.

- DataCamp: bietet einsteigerfreundliche Einführungen in Databricks und Anleitungen für Fortgeschrittene, die sich auf den Erwerb von Zertifizierungen konzentrieren.

- Coursera und edX: Kurse von führenden Institutionen und Branchenexperten, die sich auf Databricks Workflows und Spark-Programmierung konzentrieren.

- Udemy: Bietet kostengünstige Kurse zu Themen wie ETL-Pipelines, Delta Lake und Databricks-Grundlagen.

- Community Resources: Erkunde Blogs, YouTube-Kanäle (wie Databricks oder TheSeattleGuy) und Tutorials von erfahrenen Nutzern, um praktisch zu lernen.

Dokumentation und Unterstützung durch die Gemeinschaft

- Databricks Dokumentation: Eine umfassende Ressource zum Verständnis von Plattformfunktionen, APIs und Best Practices. Hier findest du Tutorials, FAQs und Anleitungen, die Anfängern und fortgeschrittenen Nutzern gleichermaßen helfen.

- Databricks Community Edition: Eine kostenlose Umgebung zum Testen und Lernen von Databricks, ohne dass du ein Cloud-Konto brauchst.

- Benutzerforen: Tritt den Community-Foren von Databricks bei oder beteilige dich an Diskussionen auf Plattformen wie Stack Overflow, um Fehler zu beheben und Wissen zu teilen.

- GitHub Repositories: Greife auf Open-Source-Projekte, Beispiel-Notizbücher und Codeschnipsel zu, die von Databricks-Ingenieuren und der Community geteilt werden wie die 30-Tage-Databricks-Challenge.

Spickzettel und Leitfäden

- Spark Command Cheat Sheets: Nutze den Spark-Befehlsleitfaden von Standford, um deine Lernerfahrung zu verbessern.

- Delta Lake Schnellstart: Leitfäden zum Herunterladen, um Delta Lake für effiziente Datenspeicherung und Transaktionen einzurichten.

- Databricks CLI- und API-Anleitungen: Verwende diese für die programmatische Verwaltung deiner Databricks-Umgebung.

Um Databricks effektiv zu beherrschen, ist es wichtig, eine Mischung aus strukturierten Kursen, offizieller Dokumentation und Quick-Reference-Materialien zu nutzen. Im Folgenden findest du wichtige Ressourcen, die dich auf deiner Lernreise begleiten und dich beim Aufbau von Fachwissen unterstützen können.

Mit Databricks auf dem Laufenden bleiben

Kontinuierliches Lernen

Es ist wichtig, mit Databricks auf dem Laufenden zu bleiben, da die Plattform häufig mit neuen Funktionen und Verbesserungen weiterentwickelt wird.

- Frische deine Fähigkeiten auf: Überprüfe regelmäßig grundlegende Konzepte wie Spark, Delta Lake und MLflow und erforsche Aktualisierungen, um auf dem neuesten Stand zu bleiben.

- Experimentiere mit neuen Funktionen: Nutze die kostenlose Community Edition oder Sandbox-Umgebungen, um neu eingeführte Tools und Funktionen zu testen.

- Erkunde die Zertifizierungsoptionen: Databricks bietet Zertifizierungsprogramme an, die deine Fähigkeiten bestätigen und dir helfen, auf dem neuesten Stand der Branche zu bleiben.

Blogs und Nachrichten folgen

- Databricks Offizieller Blog: Bleib auf dem Laufenden über Produktankündigungen, Best Practices undErfolgsgeschichten im offiziellen Blog von Databricks.

- Tech News Plattformen: Folge Quellen wie TechCrunch, InfoWorld und Medium, um zu erfahren, wie Databricks Innovationen in verschiedenen Branchen vorantreibt.

Mit der Gemeinde zusammenarbeiten

- Benutzergruppen beitreten: Nimm an Databricks-spezifischen Gruppen auf Meetup, LinkedIn oder Discord teil, um Wissen zu teilen und gemeinsam zu lernen.

- Besuche Konferenzen: Veranstaltungen wie der Databricks Summit sind hervorragend geeignet, um Kontakte zu knüpfen und innovative Anwendungsfälle zu erkunden.

- Nimm an Foren teil: Beteilige dich an Diskussionen auf Plattformen wie Stack Overflow, Databricks Community-Foren und den Reddit-Subreddits für Datentechnik.

Abonnieren von DataFrame

Abonniere den DataFramed-Podcast, um Einblicke in die neuesten Trends zu erhalten und Experteninterviews zu hören. Eine großartige Databricks-Episode, die ich empfehle, enthält sogar den CTO von Databricks: [AI and the Modern Data Stack] How Databricks is Transforming Data Warehousing and AI mit Ari Kaplan, Head Evangelist & Robin Sutara, Field CTO bei Databricks.

DataFramed abonnieren

Abonniere DataFramed, wo auch immer du deine Podcasts hörst.

Fazit

Databricks befähigt Fachkräfte, Herausforderungen zu lösen und Karrierechancen zu nutzen. Ich bin froh, dass ich Databricks gelernt habe, und ich ermutige dich, weiter zu lernen. Denk daran:

-

Definiere deine Ziele: Richte deinen Lernweg auf bestimmte Ziele aus, egal ob es um Data Engineering, KI oder Analytik geht.

-

Nutze die Ressourcen: Nutze strukturierte Kurse, Community-Editionen und praktische Projekte, um Erfahrungen zu sammeln.

-

Engagiert bleiben: Verfolge die Updates, beteilige dich an der Databricks-Community und lerne ständig dazu, um immer einen Schritt voraus zu sein.

Josep ist Data Scientist und Projektmanager beim katalanischen Fremdenverkehrsamt und nutzt Daten, um die Erfahrungen von Touristen in Katalonien zu verbessern. Sein Fachwissen umfasst das Management von Datenspeicherung und -verarbeitung, gekoppelt mit fortschrittlichen Analysen und der effektiven Kommunikation von Datenerkenntnissen.

Er ist auch ein engagierter Pädagoge, der den Big-Data-Masterstudiengang an der Universität von Navarra unterrichtet und regelmäßig aufschlussreiche Artikel über Datenwissenschaft auf Medium und KDNuggets veröffentlicht.

Er hat einen BS in technischer Physik von der Polytechnischen Universität von Katalonien und einen MS in intelligenten interaktiven Systemen von der Universität Pompeu Fabra.

Derzeit engagiert er sich leidenschaftlich dafür, datenbezogene Technologien durch die Medium-Publikation ForCode'Sake einem breiteren Publikum zugänglich zu machen.

Häufig gestellte Fragen beim Erlernen von Databricks

Was ist Databricks, und warum ist es für Datenexperten wichtig?

Databricks ist eine offene Analyseplattform für den Aufbau, den Einsatz und die Pflege von Daten, Analysen und KI-Lösungen in großem Maßstab. Die Integration mit den wichtigsten Cloud-Anbietern (AWS, Azure, GCP) und die robusten Tools machen die Software zu einem Wendepunkt für Datenexperten, da sie die Verarbeitung von Big Data rationalisiert und fortschrittliche Analysen und maschinelles Lernen ermöglicht.

Was sind die drei wichtigsten Vorteile beim Erlernen von Databricks?

Karriereentwicklung: Hohe Nachfrage und Mangel an qualifizierten Fachkräften; 2) Breite Einsatzmöglichkeiten: Ermöglicht Datenumwandlung, erweiterte Analysen und maschinelles Lernen; 3) Wettbewerbsvorteil: Bietet Kompatibilität mit AWS, Azure und GCP und lässt sich nahtlos mit Apache Spark integrieren.

Welche wichtigen Funktionen machen Databricks zu einer umfassenden Plattform?

Zu den wichtigsten Funktionen gehören eine einheitliche Datenplattform, die Data Engineering, Analytik und maschinelles Lernen vereint, die Integration von Apache Spark für verteilte Verarbeitung, Delta Lake für Datenkonsistenz, MLflow für die Verwaltung von Lebenszyklen des maschinellen Lernens und kollaborative Tools wie interaktive Notizbücher.

Wie können Anfänger mit Databricks anfangen?

Anfänger können damit beginnen, ihre Lernziele zu definieren, sich für die kostenlose Databricks Community Edition anzumelden, die Benutzeroberfläche (Arbeitsbereiche, Cluster, Notizbücher) zu erkunden und an praktischen Projekten wie dem Aufbau von ETL-Pipelines oder dem Experimentieren mit MLflow zu arbeiten.

Wie können Fachleute mit Databricks auf dem Laufenden bleiben?

Bleib auf dem Laufenden, indem du regelmäßig Kernkonzepte wie Delta Lake und MLflow wiederholst, mit den neuen Funktionen der Community Edition experimentierst, den offiziellen Blog von Databricks verfolgst und dich in Foren, Konferenzen und Benutzergruppen mit der Databricks-Community austauscht.